4/3 13:51更新 AWS公式ブログも投稿されました!

ビジネス観点

テクノロジー観点

BedrockにMistral Largeが出現!?

セゾンテクノロジーの小杉さんが宇宙最速で見つけてくださいました!

Bedrockのこっそりアップデートを宇宙最速でキャッチする仕組みは以下をご参照ください。

そもそもMistralって何だっけ?

オープンソースで高性能な生成AIモデルを公開していることで話題の、フランスの新鋭AIベンチャーです。

例えば「日本語対応LLM」のような例もそうですが、公開されているLLMをベースに独自のモデルを開発する場合、以前はMeta社のLlama 2などがOSSの生成AIモデルとしてポピュラーでした。

最近はこのMistralが提供するMistral 7BやMixtral 8x7Bのモデルをベースにそういった独自モデルを開発するケースが増えています。

Mistral Largeって何だっけ?

1ヶ月ほど前、2月末に突如公開され「Claude 2.1を超えるベンチマーク性能」と話題になったMistral社の最新モデルです。

Mistral公式のWebチャットアプリ「Le Chat」で利用可能なほか、パブリッククラウドとしてMicrosoft Azureにてマネージド提供が開始されていました。

登場直後に以下の記事でも解説していますのでぜひご覧ください。

そんなMistral Largeが今回、AWSのBedrockでも利用可能となったようです!

早速触ってみた

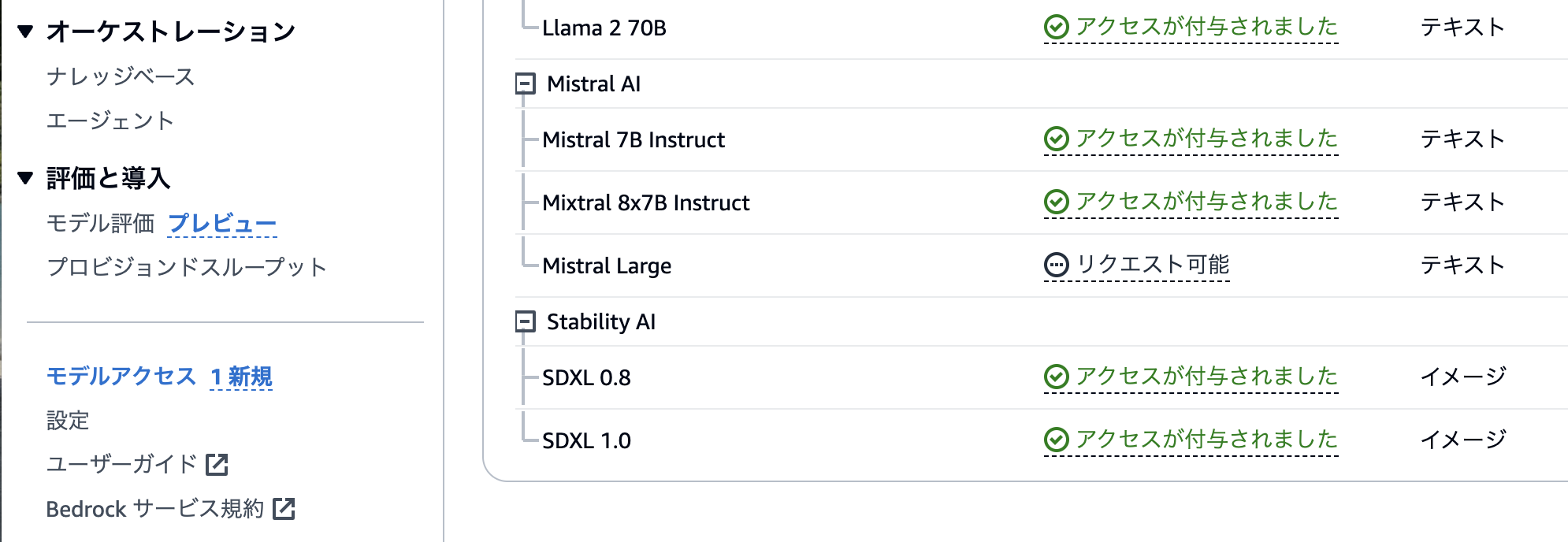

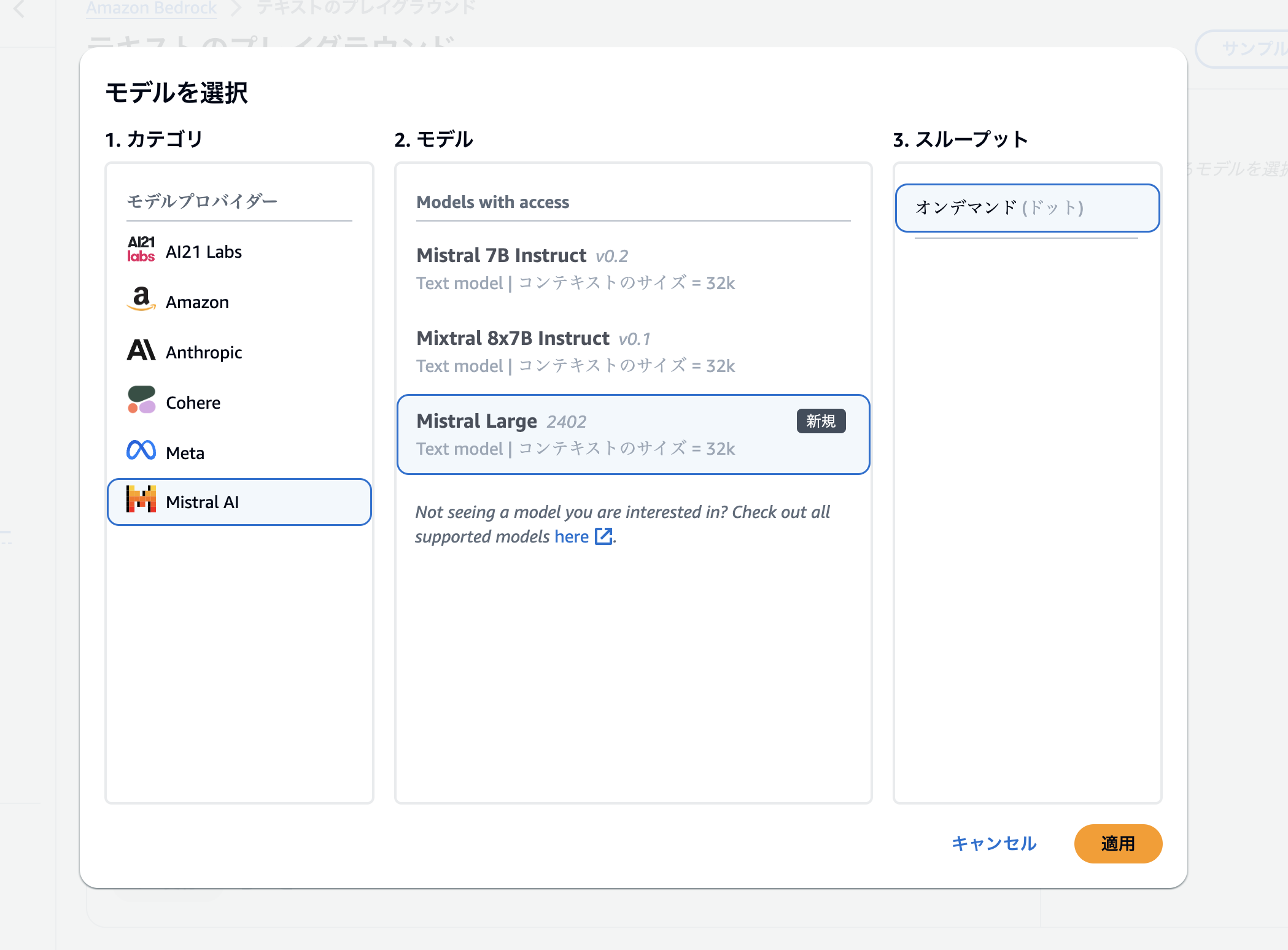

まずはマネジメントコンソールからモデルを有効化しましょう。今回はバージニア北部リージョンを利用しますが、オレゴンとパリにも生えていることを確認しています。

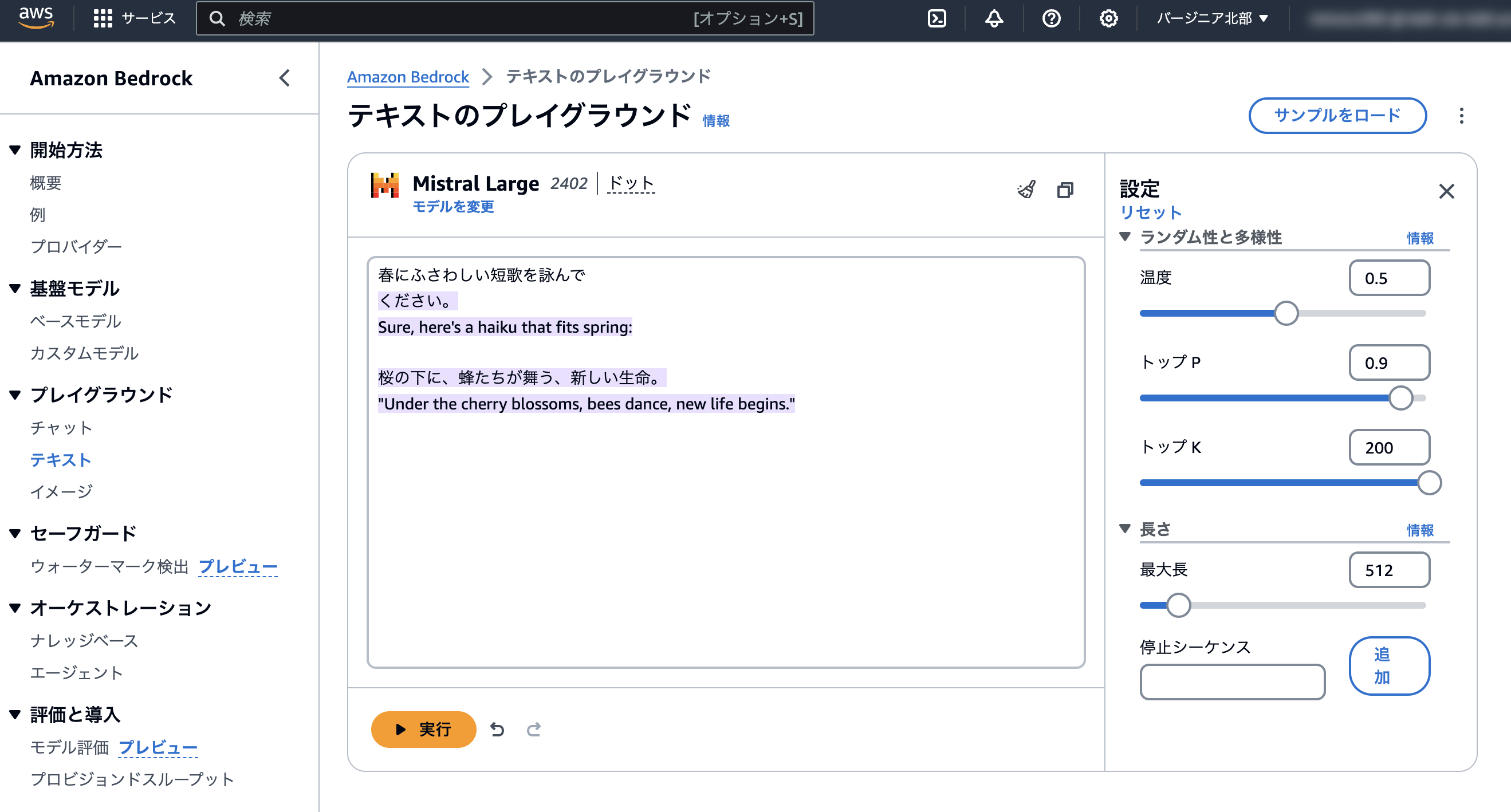

「テキスト」のプレイグラウンドから試せるようです。

ちょっと意地悪なプロンプトを投げてみましたが、「日本語が上手なガイジンさん」風に生成してくれました(笑)

チャット最適化という感じの応答ではなく、プロンプトの続きから生成してくる感じはLlama 2とも似ていますね。

BedrockのAPIからも呼んでみる

プレイグラウンドからAWS CLI用のAPIリクエストを確認することができます。

モデルIDは mistral.mistral-large-2402-v1:0 のようですね。

まだAWSドキュメントは更新されていなさそうだったので、今回はMixtral 7x8BのサンプルコードをベースにCloud9からPythonで呼んでみます。

Cloud9環境を起動して、まずはAWS SDKを更新しましょう。

pip install -U boto3

以下のコードを実行してみます。

import boto3

import json

bedrock_runtime = boto3.client("bedrock-runtime")

response = bedrock_runtime.invoke_model(

modelId="mistral.mistral-large-2402-v1:0",

body=json.dumps({"prompt": "春の俳句を詠んで"})

)

response_body = json.loads(response["body"].read())

outputs = response_body.get("outputs")

completions = [output["text"] for output in outputs]

print(completions)

無事にテキストの続きが生成されました!

$ python3 mistral-large.py

['みました。\n>\n> 花の香りに 風が吹く音がする 春の日々\n>\n> 花の香りは 春の気持ちを 伝えるかな\n>\n> 花咲く前に 春の準備をする 小鳥の囀る\n>\n> 花咲いても 春は終わらない 新しい生命\n>\n> 春の終わり 花びら散る風に 涙のかくさ\n>\n> 春の暖かさ 心に残る 新しい出発\n>\n> 春の雨に 濡れる花びら 輝く色合い\n>\n> 春の夜に 月が照

プロンプトと結合して、整形すると以下のようなテキストになります。

春の俳句を詠んでみました。

花の香りに 風が吹く音がする 春の日々

花の香りは 春の気持ちを 伝えるかな

花咲く前に 春の準備をする 小鳥の囀る

花咲いても 春は終わらない 新しい生命

春の終わり 花びら散る風に 涙のかくさ

春の暖かさ 心に残る 新しい出発

春の雨に 濡れる花びら 輝く色合い

春の夜に 月が照

What's Newと公式ドキュメントはよw