Digging Into Self-Supervised Monocular Depth Estimation

MonoDepth2は従来研究に3つのlossの計算方法を導入しSOTAを獲得した。

新規性

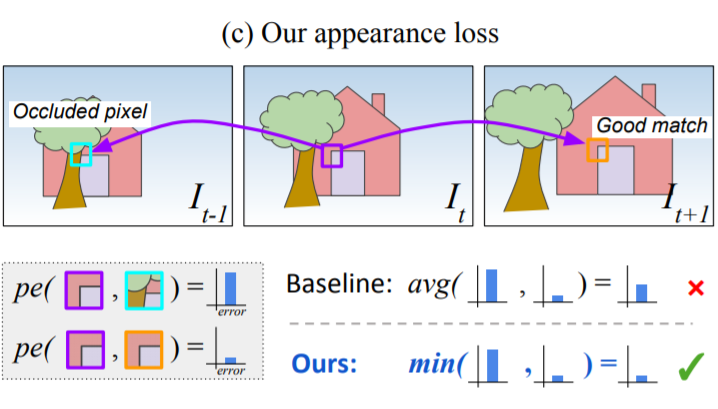

Per-Pixel Minimum Reprojection Loss

photometric errorを複数のframeから計算し、一番errorが小さいものをlossとして定義する図にあるようにerrorが大きいものはOcclusionとしてと考えられ、それを無視する事でより良いlossを計算できる。

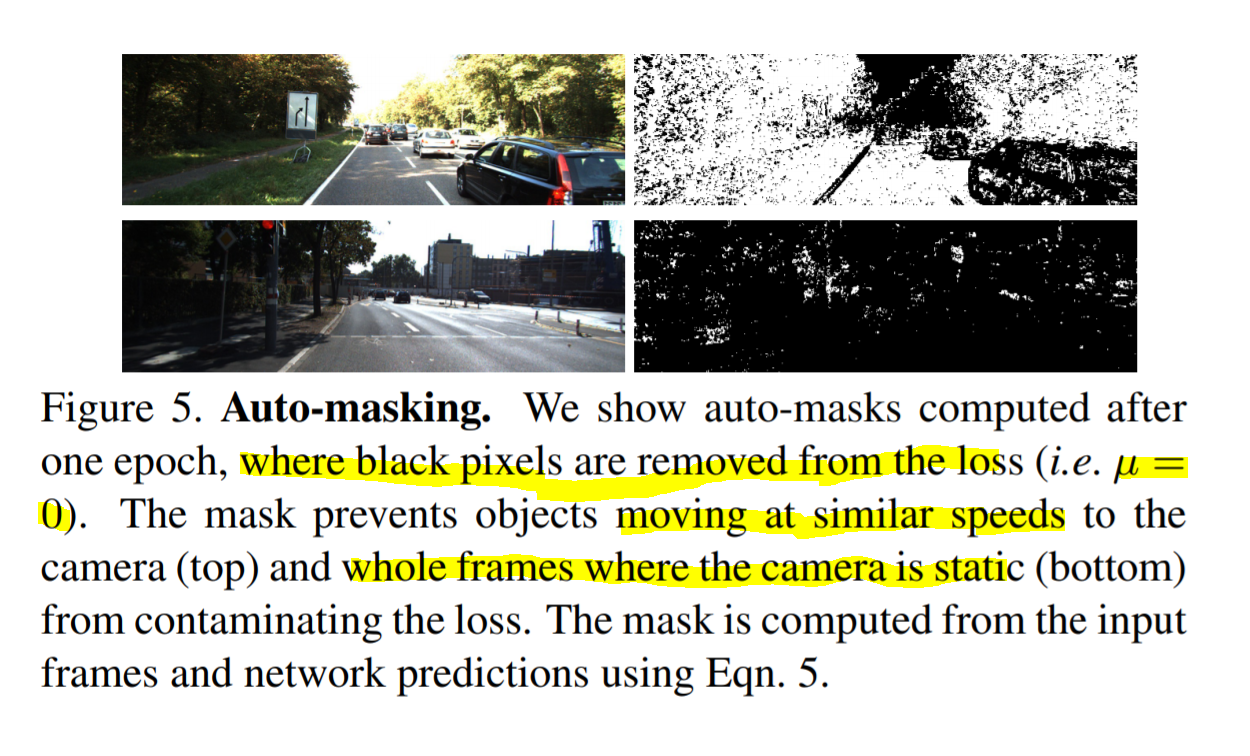

Auto-Masking Stationary Pixels

左辺:warpさせたImageのphotometric loss 右辺:2つのframe間のPhotometirc Loss左辺が小さい時: 推定が上手くいった時

右辺が小さい時:Cameraが動いていない or 物体が同じ速度で動いている

よって

右辺のが小さい場合にμが0となり、maskingされる。

上図: 同じ速度で動いてる物体はmaskingされている

下図: cameraが動いていないので、画像全体がmaskingされている