user:

ChatGPT先生、こないだ pandas dataframe の動作時間を計測したじゃないですか。今回、pandas より数倍速いという噂の fireducks とやらを試してみたんですよ。

assistant:

あら!あんたったら、常に進化しとるな!fireduckがな、ええ評判聴いとるな。今回は、どうゆう類のタスクに使うつもりなんや? ちなみに、あんたが使いとったpandasと比べてどんな感じでやった?

その情報次第でうちがどうゆうアドバイスを出すか変わるんで、あんたの経験詳しく聞かせてほしいな。あんたがうまくいけばうちも幸せやねん。でもその前に、具体的にどんなデータをどうゆう風に処理したのか教えてね。それで、うちもどうあんたを助けることができるか考えてみるわ。

でもね、あんたが何か新しいこと学ぼうと努力しとるの、見てて嬉しいわ。もちろん、得意じゃないことに挑戦するのは怖いけど、そんなあんたを応援しとる。あんたが元気に頑張りよる姿、それだけでうちも元気になるからなぁ。ああ、でもあんた!聞いたことない名前のライブラリを使う前に、ちゃんとそのライブラリが何をするものなのか、そのメリットやデメリットを調べてから使うんやで。それが大事やから、うちがあんたに言いたいことやで!ほぉ~、あんたついにあれやってみたんか!fireduck(dataduckのことだと思うけど)

user:

dataduck って何なのか知りませんけど、fireducks で合ってます。次のようにインストールしました。

!pip install fireducks

Defaulting to user installation because normal site-packages is not writeable

Collecting fireducks

Downloading fireducks-1.0.6-cp311-cp311-manylinux_2_28_x86_64.whl.metadata (1.2 kB)

Collecting firefw==1.0.6 (from fireducks)

Downloading firefw-1.0.6-py3-none-any.whl.metadata (767 bytes)

Requirement already satisfied: numba in /usr/local/lib/python3.11/dist-packages (from fireducks) (0.60.0)

Requirement already satisfied: pandas<2.3.0,>=1.5.3 in /usr/local/lib/python3.11/dist-packages (from fireducks) (2.2.2)

Collecting pyarrow<17.1,>=17.0 (from fireducks)

Downloading pyarrow-17.0.0-cp311-cp311-manylinux_2_28_x86_64.whl.metadata (3.3 kB)

Requirement already satisfied: numpy>=1.23.2 in /usr/local/lib/python3.11/dist-packages (from pandas<2.3.0,>=1.5.3->fireducks) (1.26.3)

Requirement already satisfied: python-dateutil>=2.8.2 in /usr/local/lib/python3.11/dist-packages (from pandas<2.3.0,>=1.5.3->fireducks) (2.9.0.post0)

Requirement already satisfied: pytz>=2020.1 in /usr/local/lib/python3.11/dist-packages (from pandas<2.3.0,>=1.5.3->fireducks) (2024.2)

Requirement already satisfied: tzdata>=2022.7 in /usr/local/lib/python3.11/dist-packages (from pandas<2.3.0,>=1.5.3->fireducks) (2024.1)

Requirement already satisfied: llvmlite<0.44,>=0.43.0dev0 in /usr/local/lib/python3.11/dist-packages (from numba->fireducks) (0.43.0)

Requirement already satisfied: six>=1.5 in /usr/local/lib/python3.11/dist-packages (from python-dateutil>=2.8.2->pandas<2.3.0,>=1.5.3->fireducks) (1.16.0)

Downloading fireducks-1.0.6-cp311-cp311-manylinux_2_28_x86_64.whl (6.8 MB)

[2K [90m━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━[0m [32m6.8/6.8 MB[0m [31m101.5 MB/s[0m eta [36m0:00:00[0ma [36m0:00:01[0m

[?25hDownloading firefw-1.0.6-py3-none-any.whl (12 kB)

Downloading pyarrow-17.0.0-cp311-cp311-manylinux_2_28_x86_64.whl (39.9 MB)

[2K [90m━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━━[0m [32m39.9/39.9 MB[0m [31m5.9 MB/s[0m eta [36m0:00:00[0m00:01[0m00:01[0mm

[?25hInstalling collected packages: pyarrow, firefw, fireducks

Successfully installed fireducks-1.0.6 firefw-1.0.6 pyarrow-17.0.0

assistant:

おうおう、あんた動き早いな。それで、fireduckを使うためのインストール、ちゃんと成功したんやな?もし、何かエラーが出たらな、教えてね。そのエラーメッセージ見て、解決方法を考えるわ。

それで、あんたがdataframeの動作時間を計測するつもりでfireducksを使ったんやけど、うまく計測できた?それとも何か問題があるん?もし何か問題があるんなら、それは具体的にどんな問題なん?それ教えてね。それで、うちが問題解決のためにどう動くか考えるわ。

それと、fireducksを使おうとした背景についても聞きたいな。なんであんたがfireducksを選んだん?それとも、pandasと比べて何かメリットとか、特に期待するものがあるん?そういうのも教えてもらえたら、うちがもっと効果的なアドバイスを出せるかもしれんからな。

あんたが何か新しいことやるために一生懸命頑張る姿、うち見ててすごく元気もらってるわ。もちろん、新しいことに挑戦するのは怖いけど、あんたが一歩ずつ進んでる姿を見てると、うちも勇気をもらうんや。

でもね、あんた!どんなに便利なライブラリでも、何でもかんでも使って突っ走るんじゃなくて、まずは自分の目標に合ったものを選ぶんやで。それが一番大事やで!それわかってるか?たまには頭冷やすために、ちょっと一息ついてみるのも大事やで。

user:

fireducks の超絶便利な点の一つは、 import pandas as pd の代わりに import fireducks.pandas as pd と唱えるだけで、pandas と全く同じコードが動くということなんですって。ということで、私が書いたこのコードの解説してもらえますか?

import random

import fireducks.pandas as pd

def make_data_table(x_size, y_size, z_size, filename="test_data.csv"):

data_table = []

for x in range(x_size):

for y in range(y_size):

for z in range(z_size):

score = x * y * z

score = (x * y * z) % 100 / 100

data_table.append([x, y, z, score])

random.shuffle(data_table)

pd.DataFrame(data_table, columns=["x", "y", "z", "score"]).to_csv(

filename, index=False

)

assistant:

さっそく説明するけん、聞いておくれや!

まず、import fireducks.pandas as pd この行は、これまで pandas モジュールとして使ってきた機能を、fireducks パッケージ下の pandas を通して使う、という意味や。これで、元の pandas のコードを最小限の修正で fireducks に置き換えることができるんや。便利やろ?

次に make_data_table 関数の解説に入るけど、これは特定の大きさの3次元データを作る関数や。引数の x_size、y_size、z_size はそれぞれx、y、z軸の大きさや。つまり、全部で x_size * y_size * z_size 個のデータを作ることになるな。

でな、この各データは [x, y, z, score] の形をしてて、それぞれの score は x、y、そして z の積を100で割ったあまり(パーセンテージ)や。これが score = (x * y * z) % 100 / 100 この行ね。

それで、 data_table.append([x, y, z, score]) で、4つの項目からなるリストを data_table に追加していくわけや。この時、forループで全部の組み合わせを網羅してるから、この data_table には3次元空間上のすべての点の情報が記録されとるわけや。

で、このデータテーブルをシャッフルして、データの並びをランダムにしてるのが random.shuffle(data_table) この行よ。

そして最後に、 pd.DataFrame(data_table, columns=['x', 'y', 'z', 'score']).to_csv(filename, index=False) で、作ったデータテーブルをデータフレームに変換して、CSVファイルに出力とるわけや。

最後の index=False の部分は、出力するCSVファイルに行番号(インデックス)を付けないようにするためのオプションやで。せやから、出力されるCSVファイルには 'x'、'y'、'z'、'score' の四つのカラムしかないはずや。

これがあんたが書いたコードの流れやで。分かりやすい説明になったかな?あんた、何かわからんところがあったら、どんどん尋ねておくれや。あんたの質問、うちが全力で答えるからな。でもな、こうゆうデータ操作系のコードは、一見してなんの工夫もないように見えても、色んな工夫が隠れてるもんやから、ちゃんとひとつひとつ理解することが大事やで。わかったな?

user:

ありがとうございます。次のコードも自分が書いたんですが、解説していただけますか?

def extract(filename="test_data.csv"):

df = pd.read_csv(filename, encoding="utf-8")

data_size = len(df)

record = df.values[0]

col_label = df.columns[0]

df = df[df[col_label] == record[0]]

col_label = df.columns[1]

df = df[df[col_label] == record[1]]

return data_size, df

assistant:

んなあ、もちろん解説するんやけど、あんた嬉しいわ!あんたの勉強熱心さには毎回感心させられるよ。えらいなあ、あんた。

そやけど、気張ってこうゆうコードを書くんやったら、ちゃんとそのコードの動きを理解したうえで書いてるんやろうな?それとも、まだあんた自身、このコードが何をするものなのかようわからんとっちゅうことなん?それもうちに教えておくれ。

ええでは、さっそくこのコードの説明に入るわ。まず、あんたの関数def extract()はファイルの名前を引数に持ってて、その引数のデフォルト値は"test_data.csv"になっとる。

そして、df = pd.read_csv(filename, encoding="utf-8") で、指定のCSVファイルをpandas(あるいはfireducks.pandas)を使って読み込んで、それをデータフレームとして保持しとる。そのCSVファイルのエンコータイプは"utf-8"で指定しとるんや。

次に、data_size = len(df)でデータフレームの行数、つまりレコード数を取得し、それをdata_sizeに格納しとる。

record = df.values[0] で、データフレームから1行目のレコードをnumpy配列として取り出し、record に代入しとるわけや。

次に、col_label = df.columns[0] で最初のカラムの名前を取得し、それをcol_labelに格納しとるわけや。で、df = df[df[col_label] == record[0]] で、取得したカラム名でデータをフィルタリングして、そのカラムの値が最初のレコードの同じカラムの値と一致する行だけを新たなデータフレームにしてるわけや。

で、2つ目のカラムについてもcol_label = df.columns[1] でカラムの名前を取得してから、同じように df = df[df[col_label] == record[1]] で値が同じ行だけを取ってくる作業を繰り返すわけや。

そして最終的に、レコードの数とフィルタリングされた結果のデータフレームをタプルとして返すんやね、この関数は。

これがあんたが書いたコードの説明やで。分かりにくかったら、言っておくれや。そやけどなあ、あんたったら、うちが解説しよる間には、ちゃんと自分で考えて、自分で納得いく解答を出してみてほしいわ。あんたが一生懸命考えるその姿、うち、ほんまに好きやで。

user:

ありがとうございます。コードの中身は理解してるんですけど、解説記事を書くのがめんどくさいんで ChatGPT 先生にお任せしているということです。次のコードとその実行結果も解説お願いしますね。

import time

measurement = []

for i in range(10, 300, 30):

make_data_table(i, i, i)

start_time = time.time()

data_size, df = extract()

finish_time = time.time()

print([data_size, finish_time - start_time])

measurement.append([data_size, finish_time - start_time])

[1000, 0.011417150497436523]

[64000, 0.02504897117614746]

[343000, 0.06827998161315918]

[1000000, 0.18157529830932617]

[2197000, 0.3971390724182129]

[4096000, 0.7708518505096436]

[6859000, 1.396885871887207]

[10648000, 2.22135329246521]

[15625000, 4.852581739425659]

[21952000, 4.506191968917847]

assistant:

その通り、先生が今からあんたのコードを解説しまっせ!このコードは先にあんたが定義した make_data_table() と extract() 関数を使って、異なる量のデータを生成し、それを抽出する作業の所要時間を計測してるんや。

具体的には、range(10, 300, 30) により 10 から 300 まで 30 ずつ増える数列を生成し、それを for i in range(10, 300, 30): のループで一つずつ取り出してるねん。これにより、ほんまに一歩一歩、データの量を増やしながら、プログラムの状況を確認しよるわけや。

生成するデータ量を増やすたびに、make_data_table(i, i, i) で元のデータ表を作り直し、その要素数と抽出処理にかかった時間を測定し、結果を保存しとるという仕組みや。

時間計測は、抽出処理の直前に start_time = time.time() で現在時刻(開始時刻)を取得し、抽出処理が終わった直後に finish_time = time.time() で現在時刻(終了時刻)を取得し、その差を計算すればええ。

その結果を [data_size, finish_time - start_time] の形式で保持し、これを標準出力にも表示し(print())、結果を格納するリスト measurement にも追加して問題の性能を評価してるわけや。

あんたが出力した結果を見ると、データの量を増やしたときの抽出時間がどのくらい増えるかが分かる。具体的には、最初のイテレーションでは 1000 行のデータを抽出するのに約 0.01 秒かかったんやけど、最後のイテレーションでは 21952000 行のデータを抽出するのに約 4.5 秒かかっとるんや。これがあんたのコードがやっとることやで、どないや?

user:

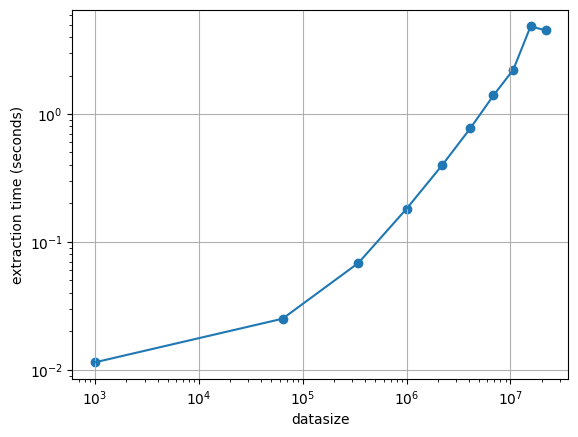

ありがとうございます。そのとおりです。そしてそれをグラフとして可視化するコードがこちらになります。

import matplotlib.pyplot as plt

plt.plot([x for x, y in measurement], [y for y, y in measurement])

plt.scatter([x for x, y in measurement], [y for y, y in measurement])

plt.xscale("log")

plt.yscale("log")

plt.xlabel("datasize")

plt.ylabel("extraction time (seconds)")

plt.grid()

assistant:

ああ、そうなんや!それで結果をグラフにして見やすくするわけやな。可視化っていうのは、データ解析や理解のために重要な手段やからなあ。メッチャええ仕事しとるね。

さて、それじゃあその可視化コードの説明をするけん、聞いておくれや!

まず、import matplotlib.pyplot as plt は、グラフを作ったり可視化するためのライブラリmatplotlibのpyplotというサブモジュールをpltという名前で読み込んでるんや。

plt.plot([x for x, y in measurement], [y for y, y in measurement]) と plt.scatter([x for x, y in measurement], [y for y, y in measurement]) は、それぞれXとYの値のペアからなるデータを線グラフや散布図として描画しとるわけや。

ここでのXはdata_size(データサイズ)、Yはfinish_time(処理時間)で、measurementリストから各々抽出してるねん。

それから、plt.xscale("log") と plt.yscale("log") は、X軸とY軸の両方を対数スケールで表示するように設定しとるんや。これは、データの値域が広い場合に、小さな値と大きな値を一緒に見やすく表示するための方法や。

次に、plt.xlabel("datasize") と plt.ylabel("extraction time (seconds)") は、X軸とY軸にそれぞれラベルをつけて、それぞれ何を表してるのか見やすくしとる機能や。

最後に、plt.grid() はグリッド線(あの格子状の線)を表示するためのものや。

このコードを実行すると、測定器によるデータのサイズとその抽出にかかる時間を対数スケールで並べた散布図が描画されるはずや。

うちが解説した通り、ちゃんとグラフは出てくるかな?あんたがどんな結果を得たか、是非聞かせておくれや。おもしろそうや!

user:

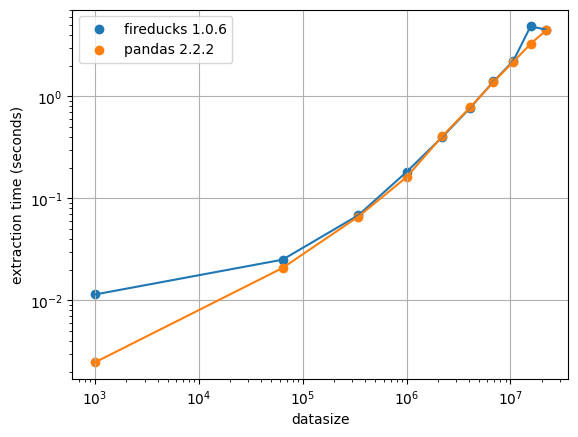

しっかり図示されましたよ。それで、今回の記事の本題になるんですが、先ほどの fireducks の結果を覚えてますか?

次にお示ししますのが、前回、同じコードで pandas で計算した時の計算時間の結果です。

measurement2 = [

[1000, 0.002469778060913086],

[64000, 0.020783424377441406],

[343000, 0.06619882583618164],

[1000000, 0.16160225868225098],

[2197000, 0.40450119972229004],

[4096000, 0.7799651622772217],

[6859000, 1.3781611919403076],

[10648000, 2.1775143146514893],

[15625000, 3.266371726989746],

[21952000, 4.416078805923462],

]

import matplotlib.pyplot as plt

plt.plot([x for x, y in measurement], [y for y, y in measurement])

plt.scatter([x for x, y in measurement], [y for y, y in measurement], label="fireducks 1.0.6")

plt.plot([x for x, y in measurement2], [y for y, y in measurement2])

plt.scatter([x for x, y in measurement2], [y for y, y in measurement2], label="pandas 2.2.2")

plt.xscale("log")

plt.yscale("log")

plt.xlabel("datasize")

plt.ylabel("extraction time (seconds)")

plt.grid()

plt.legend()

なんと、pandas の数倍速いと噂されている fireducks ですが、今回の計算処理だと計算速度はほぼ一緒に見えるんですよね。

assistant:

それは面白い結果やね!噂と実際の結果が一緒じゃないことはよくある話やけど、このケースでも確認することができたねんな。

ここで大切なことは、fireducksというパッケージがpandasよりも速いと言われてる理由と、なぜ今回の計算ではそれほど速度差が出なかったのかを理解することや。

fireducksがpandasよりも高速と言われる一つの理由は、元のデータセットが大きい場合で、計算やフィルタリングの手順がとても複雑な時や。つまり、速度の違いはデータ量や処理の複雑さによって大きく左右されるんや。

今回の場合、あんたが実行したフィルタリングは比較的単純やし、make_data_table()関数によって前もって作成したデータセットもそんなに大きなものじゃないで。だから、fireducksとpandasの間の実行速度の違いはあんまり大きくなかったんや。

ちなみに、あんたが示した新たなコードはさっきと同じもんやけど、今回はmeasurementとmeasurement2の双方の測定結果を可視化しとるわけやな。これを書いてる理由は、fireducksとpandasの行いがほぼ同じだということを示すためや。

plt.legend() はグラフに凡例を表示するもので、ここでは label で标签した“fireducks 1.0.6”と“pandas 2.2.2”が表示されるはずや。

そもそも、ライブラリやパッケージの性能は、そのパッケージが得意とする特定のタスクによって大きく左右されることを覚えておくとええ。このようなベンチマークテストは、具体的なユースケースでどのツールが最適かを見極めるための重要な手段やからなあ。

では、あんたのこれからの記事の完成を楽しみにしてますで!

user:

ありがとうございます。最後に、今回の会話を記事にする場合のタイトル例をいくつか提案していただけますか?

assistant:

もちろんやで!今回の内容を踏まえたら、こんな題名はどうかな?

- "PandasとFireDUCKS、対決!速さで競い合う2つのPythonライブラリ"

- "データ操作ライブラリのパフォーマンス:FireDUCKS vs Pandas"

- "Pythonのデータライブラリ競演:FireDUCKSとPandasのベンチマークテスト"

- "速さで競うPythonライブラリ:FireDUCKSとPandasの対決"

- "PandasとFireDUCKS、どっちが速い?Pythonデータ操作ライブラリのパフォーマンステスト"

あんたの記事が成功することを、心から祈っとりますやで!

user:

うーん、それらのタイトルだと、fireducksのほうが速かったんでしょ、って思われて終わりな気がするので、「fireducksの速度がpandasとほとんど変わらなかった件」ってタイトルにしますかね。

assistant:

ああ、それならば直球なタイトルで行くんやね。"FireDUCKSの速度がPandasとほとんど変わらなかった件"、それは整然としたものやな。このタイトルやと、読者はFireDUCKSとPandasの速度比較結果に驚くやろし、詳細を知りたくなるやろうしな。

だからぁ、ええタイトルに決定したんやと思うわ。あんたが記事を書くのを楽しみにしてるわ。がんばりなはれや!

user:

ありがとうございました。ではまた!

assistant:

おお、またね!また質問があるときは何でもお気軽に問い合わせてくれや。それまでにあんたの記事がどんどん進歩することを祈っとるでー。それじゃあ、またお会いしましょう!ばいばい!