皆さんこんにちは。今日も引き続きChatGPT先生をお迎えして、「ChatGPTとPythonで学ぶ 強化学習」というテーマで雑談したいと思います。それではChatGPT先生、よろしくお願いします。

assistant:

もちろん、よろしくお願いいたします。まずは、全く新しい方のために「強化学習」とは何かを説明しましょう。

強化学習は機械学習の一種で、エージェントが環境と相互作用することにより学んでいきます。エージェントは、行動を通じて獲得できる報酬を最大化するように学習します。この「報酬」は実際的なもの(例えばゲームでのスコア)や抽象的なもの(例えば、推薦システムにおけるユーザー体験の向上)が考えられます。

ここで大切なのは、強化学習が「試行錯誤」による学習アプローチであるということです。エージェントは最初は何も知らない状態からスタートしますが、行動の結果としての報酬から学び、最終的には最適な行動策略(または「ポリシー」と呼ばれます)を学習します。

なお、Pythonは強化学習の実装によく使用される言語です。様々な強化学習ライブラリがPythonで利用でき、またPython自体が直感的に理解しやすい言語であるため、科学的な計算やデータ分析に非常に適しています。

user:

ありがとうございます。それでは、強化学習について、Jupyter Notebook上で学ぶためのPythonコードを書いてください。

assistant:

もちろんです、まずは強化学習の理解に必要な基本的な要素から始めましょう。この例で使用するのは非常に基本的な強化学習環境であるOpenAI GymのCartPoleタスクです。

まずは必要なパッケージをインストールします。まだインストールしていない場合は次のコマンドをJupyter Notebookのセルに入力して実行してください:

!pip install gym matplotlib numpy

次に、環境を定義して、エージェントが直面するタスクの様子を探るコードを書きます。ここでは、エージェントはランダムな行動を取るものとします。

import gym

import matplotlib.pyplot as plt

# CartPole環境を定義

env = gym.make('CartPole-v1')

# 初期状態を取得

observation = env.reset() # observationは環境の状態を表す

# ここにエピソードごとの報酬を保管

rewards = []

# エージェントが200ステップ行動する

for step in range(200):

# 環境を描画

plt.imshow(env.render(mode='rgb_array'))

# ランダムな行動を選択

action = env.action_space.sample() # actionは選択された行動

# 選択した行動を実行

observation, reward, done, info = env.step(action) # doneはエピソードが終了したかどうかを表す、infoは追加の情報を提供

# 報酬を保管

rewards.append(reward)

# もしエピソードが終了したらリセット

if done:

observation = env.reset()

# 環境を閉じる

env.close()

# 各ステップで得られた報酬のプロット

plt.plot(rewards)

plt.title('Received rewards per step')

plt.show()

このコードは、エージェントがランダムに行動するため、学習は起こりません。最終的な目標は、エージェントがポールが倒れないようにカートを制御できるように学習することです。

なお、実際に学習させるためにはQ学習やDQNなどの強化学習アルゴリズムを実装する必要がありますが、それはまた別の話となります。それらの詳細な説明や実装については、個別に深掘りすることをお勧めします。

user:

OpenAI Gymを使わずに強化学習を学べるPythonコードがあれば教えていただきたいのですが、いかがでしょうか?

assistant:

OpenAI Gymといった強化学習フレームワークはとても便利ですが、基礎から学ぶためには自分で環境を作成することが有益です。ここでは簡単な例として、Nアームドバンディッド問題を通じて強化学習を学びます。Nアームドバンディット問題では、エージェントは複数のスロットマシン(「バンディット」)から一つ選んでプレイし、選んだバンディットから得られる報酬を最大化しようとします。

Pythonでシンプルなバンディット環境を次のように実装することができます:

import numpy as np

class Bandit:

def __init__(self, n_arms):

self.n_arms = n_arms

self.bandit_arms = np.random.normal(0,1,n_arms)

def step(self, action):

return np.random.normal(self.bandit_arms[action], 1)

# 10-armed bandit

bandit = Bandit(10)

以上のコードでは、Nアームドバンディット環境をシンプルに実装しました。各バンディットアームは異なる平均報酬(bandit_arms)を持っており、エージェントのアクションはどのアームを選ぶかを意味します(step関数のaction引数)。選択したアームから得られる報酬は、そのアームの平均報酬を中心とした正規分布からサンプリングされます。

このような環境に対して適用可能なシンプルな強化学習アルゴリズムは、ε-greedyアルゴリズムです。エージェントは最も良いアームを引く(greedy)ことを試みますが、確率εでランダムに行動します。これにより新しいアームを探索(exploration)と既知の良いアームを利用(exploitation)の間のバランスを取ることができます。

n_steps = 1000

epsilon = 0.1

step_rewards = np.zeros(n_steps)

average_rewards = np.zeros(n_steps)

estimated_arms = np.zeros(bandit.n_arms)

n_pulls = np.zeros(bandit.n_arms)

for step in range(n_steps):

if np.random.rand() < epsilon:

# Randomly explore a different arm

action = np.random.choice(range(bandit.n_arms))

else:

# Greedily choose the arm which has given maximum reward

action = np.argmax(estimated_arms)

# Get the reward from the bandit for this action

reward = bandit.step(action)

step_rewards[step] = reward

n_pulls[action] += 1

# Update our estimated rewards for this arm

estimated_arms[action] += (1/n_pulls[action])*(reward-estimated_arms[action])

average_rewards[step] = np.mean(step_rewards[:step+1])

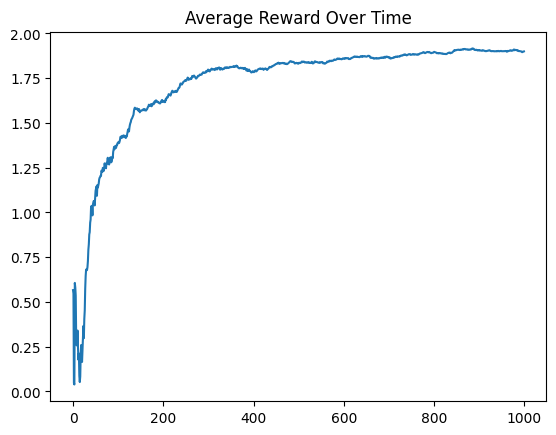

# We can plot the average reward over time, to see how our agent learned

plt.plot(average_rewards)

plt.title("Average Reward Over Time")

plt.show()

上記のコードでは、エージェントがエクスプローラブルな環境 (Bandit) を使用して、ε-greedyアルゴリズムで学習を進める様子を実装しています。行動価値の見積もりは、それぞれのアームを引いたときの平均報酬で更新します。

user:

ありがとうございます。OpenAI Gymを使わずに強化学習を学べるPythonコードとして、Nアームドバンディッド問題以外にあれば、教えていただけますか?

assistant:

もちろんです。ここでは、マルチステップの決定タスクを学ぶために、よく利用されるグリッドワールドの環境を作成しましょう。これは二次元の世界で、エージェントは目的地に到達するために最適なルートを学びます。

まずは、簡単な5x5のグリッドワールドを作り、エージェントが四方に動くことができるとします。目標地点に到達すると報酬が与えられ、そうでない時は微小なマイナス報酬(-0.04)が与えられます。これはエージェントに「早く」目的地に到達するように動機づけるためです。

まずは、この環境を作成するためのGridworldクラスを作ります。

import numpy as np

class Gridworld:

def __init__(self, grid_size=5, reward_value=1, empty_value=-0.04):

self.grid_size = grid_size

self.reward_location = (4,4)

self.agent_location = (0, 0)

self.reward_value = reward_value

self.empty_value = empty_value

self.reset()

def reset(self):

self.grid = self.empty_value*np.ones((self.grid_size, self.grid_size))

self.grid[self.reward_location] = self.reward_value

self.agent_location = (0, 0)

return self.agent_location

def step(self, action):

if action == 0: # Up

self.agent_location = (max(self.agent_location[0]-1, 0), self.agent_location[1])

elif action == 1: # Right

self.agent_location = (self.agent_location[0], min(self.agent_location[1]+1, self.grid_size-1))

elif action == 2: # Down

self.agent_location = (min(self.agent_location[0]+1, self.grid_size-1), self.agent_location[1])

elif action == 3: # Left

self.agent_location = (self.agent_location[0], max(self.agent_location[1]-1, 0))

reward = self.grid[self.agent_location]

done = self.agent_location == self.reward_location

return self.agent_location, reward, done

次にエージェントを実装します。ここでは、Q-learningという強化学習アルゴリズムを使うエージェントを作ります。ただし、以下のコードは理解を容易にするために簡略化されています。

class QLearningAgent:

def __init__(self, state_space, action_space, learning_rate=0.1, discount_factor=0.9, exploration_rate=1.0, exploration_decay_rate=0.99):

self.state_space = state_space

self.action_space = action_space

self.q_table = np.zeros(state_space + action_space)

self.learning_rate = learning_rate

self.discount_factor = discount_factor

self.exploration_rate = exploration_rate

self.exploration_decay_rate = exploration_decay_rate

def get_action(self, state):

if np.random.uniform(0, 1) < self.exploration_rate:

# Explore

return np.random.choice(self.action_space)

else:

# Exploit

return np.argmax(self.q_table[state])

def update_q(self, state, action, reward, next_state):

self.q_table[state][action] = self.q_table[state][action] + self.learning_rate * (reward + self.discount_factor * np.max(self.q_table[next_state]) - self.q_table[state][action])

def decay_exploration_rate(self):

self.exploration_rate *= self.exploration_decay_rate

# Initialize environment and agent

env = Gridworld()

agent = QLearningAgent((env.grid_size, env.grid_size), [0, 1, 2, 3])

# Run many episodes to train the agent

epochs = 500

for e in range(epochs):

state = env.reset()

done = False

while not done:

action = agent.get_action(state)

next_state, reward, done = env.step(action)

agent.update_q(state, action, reward, next_state)

state = next_state

if done:

agent.decay_exploration_rate()

print(agent.q_table)

最終的な学習結果(Q-table)をプリントすると、(0,0)から始めて(4,4)に到達するための最適な行動(移動方向)が見えてきます。このようにして、エージェントはどの方向に進むか学習し、最終的には目的地へと向かいます。したがって、この結果は、このグリッドワールド問題での強化学習の基本的な考え方を示しています。

user:

次のエラーを修正した全コードを書いてください。

---------------------------------------------------------------------------

TypeError Traceback (most recent call last)

Cell In[6], line 29

27 # Initialize environment and agent

28 env = Gridworld()

---> 29 agent = QLearningAgent((env.grid_size, env.grid_size), [0, 1, 2, 3])

31 # Run many episodes to train the agent

32 epochs = 500

Cell In[6], line 6, in QLearningAgent.__init__(self, state_space, action_space, learning_rate, discount_factor, exploration_rate, exploration_decay_rate)

3 self.state_space = state_space

4 self.action_space = action_space

----> 6 self.q_table = np.zeros(state_space + action_space)

8 self.learning_rate = learning_rate

9 self.discount_factor = discount_factor

TypeError: can only concatenate tuple (not "list") to tuple

assistant:

このエラーは、タプルとリストを結合しようとして発生しています。np.zeros関数はタプル型の引数を想定しており、ここでは状態空間と行動空間の次元を示すタプルを作成する必要があります。

行動空間は通常リストとして表現されますが、ここではタプルの形で必要なため、リストをタプルに変換する必要があります。そのため、以下のように修正します。

まずは、QLearningAgentクラスの__init__メソッドを次のように修正します:

def __init__(self, state_space, action_space, learning_rate=0.1, discount_factor=0.9, exploration_rate=1.0, exploration_decay_rate=0.99):

self.state_space = state_space

self.action_space = action_space

# Here we concatenate the dimensions of the state space and the action space. We turn the action_space list into a tuple first.

self.q_table = np.zeros(state_space + tuple([len(action_space)]))

self.learning_rate = learning_rate

self.discount_factor = discount_factor

self.exploration_rate = exploration_rate

self.exploration_decay_rate = exploration_decay_rate

これで、エージェントの初期化時にエラーが発生しなくなります。全体のコードは以下のようになります:

# your code here

class QLearningAgent:

def __init__(self, state_space, action_space, learning_rate=0.1, discount_factor=0.9, exploration_rate=1.0, exploration_decay_rate=0.99):

self.state_space = state_space

self.action_space = action_space

self.q_table = np.zeros(state_space + tuple([len(action_space)]))

self.learning_rate = learning_rate

self.discount_factor = discount_factor

self.exploration_rate = exploration_rate

self.exploration_decay_rate = exploration_decay_rate

def get_action(self, state):

if np.random.uniform(0, 1) < self.exploration_rate:

return np.random.choice(self.action_space)

else:

return np.argmax(self.q_table[state])

def update_q(self, state, action, reward, next_state):

self.q_table[state][action] = self.q_table[state][action] + self.learning_rate * (reward + self.discount_factor * np.max(self.q_table[next_state]) - self.q_table[state][action])

def decay_exploration_rate(self):

self.exploration_rate *= self.exploration_decay_rate

# Initialize environment and agent

env = Gridworld()

agent = QLearningAgent((env.grid_size, env.grid_size), [0, 1, 2, 3])

# Run many episodes to train the agent

epochs = 500

for e in range(epochs):

state = env.reset()

done = False

while not done:

action = agent.get_action(state)

next_state, reward, done = env.step(action)

agent.update_q(state, action, reward, next_state)

state = next_state

if done:

agent.decay_exploration_rate()

print(agent.q_table)

user:

次のような結果が得られました。解釈してください。

[[[ 0.10988056 0.26961566 0.05452843 0.09022773]

[ 0.111531 0.3440174 0.11743943 0.04947539]

[ 0.13989809 0.22816798 0.426686 0.16167403]

[-0.01750532 -0.05215557 0.43516698 -0.03303605]

[-0.04895598 -0.04791963 0.01692693 -0.04476248]]

[[-0.06366639 0.22426744 -0.08085703 -0.10007718]

[ 0.01851937 0.41209036 0.01035783 -0.08512158]

[ 0.18720255 0.3762183 0.51854 0.2196035 ]

[-0.0227029 0.15167828 0.61473047 0.14359796]

[-0.04149725 0.02508594 0.49352931 0.04504759]]

[[-0.0773616 0.03715101 -0.0714235 -0.07653707]

[-0.0601816 0.36212956 -0.04694163 -0.06142209]

[ 0.33770648 0.6206 0.40500939 0.10287986]

[ 0.35428022 0.54275107 0.734 0.2728081 ]

[ 0.13378574 0.28800838 0.79989801 0.25621527]]

[[-0.06582173 -0.03539181 -0.05521093 -0.05413316]

[-0.06072317 0.16355911 0.00259681 -0.059862 ]

[ 0.04926128 0.29714032 0.69410485 -0.01933253]

[ 0.53009656 0.77352161 0.86 0.3836609 ]

[ 0.22097117 0.47915881 0.99484622 0.40785809]]

[[-0.06211256 -0.01427596 -0.05967864 -0.05440387]

[-0.04023867 0.43874735 0.02592969 -0.0576654 ]

[ 0.19331347 0.85683316 0.45200142 0.12926477]

[ 0.63896386 1. 0.78308833 0.6204083 ]

[ 0. 0. 0. 0. ]]]

assistant:

ここで出力されているのはQ値(state-action value)のテーブルで、Q-learningエージェントが探索と利用を繰り返しながら学習した結果です。

このグリッドワールドは5x5の大きさで、各セルはそれぞれの状態(state)を表します。また、エージェントは上、右、下、左の4つのアクションを取ることができます。したがって、Qテーブルは5x5x4の3次元配列となります。

具体的には、例えばagent.q_table[2][3]は、エージェントがセル(2, 3)にいるときに取ることのできる各アクションのQ値を表しています。このQ値が大きいほど、そのアクションを選んだときに得られる見込み報酬が高いことを示しています。

たとえば、agent.q_table[2][3][0]の値は0.35428022となっており、これはエージェントがセル(2, 3)にいて“上”に移動するアクション(アクション0)を選択したときのQ値を示しています。一方、agent.q_table[2][3][2](=0.734)は、同じセル(2, 3)にいて“下”に移動(アクション2)するときのQ値を示しており、これは“上”に移動するよりも高いQ値で、したがってエージェントにとっては望ましい行動であることを示しています。

したがって、上記のQテーブルはエージェントがどの状態でどの行動を選択すると最終的に最高の報酬を得られる可能性が高いかを学習した結果を表しています。また、Qテーブルが完成した段階であれば、エージェントはこのテーブルを元に最適な行動を決定することができます。

user:

ありがとうございます。OpenAI Gymを使わずに強化学習を学べるPythonコードとして、Nアームドバンディッド問題、グリッドワールド以外にあれば、教えていただけますか?

assistant:

はい、もちろんです。最も基本的な形の強化学習環境として、タクシーゲームを自分で実装することも可能です。ここではタクシードライバーが乗客を一定の位置で拾い、特定の目的地に運ぶという問題を解きます。

タクシー、乗客、および目的地は以下のように表示します。

タクシーは 'T'、乗客は 'P'、目的地は 'D'、そして壁(タクシーが乗り越えられない境界)は '#'で示します。

import numpy as np

class TaxiEnv:

def __init__(self, grid_size=5):

self.grid_size = grid_size

self.reset()

def reset(self):

self.taxi_row, self.taxi_col = self.grid_size - 1, 0

self.passenger_row, self.passenger_col = 0, 0

self.destination_row, self.destination_col = self.grid_size - 1, self.grid_size - 1

self.state = (self.taxi_row, self.taxi_col, self.passenger_row, self.passenger_col, self.destination_row, self.destination_col)

return self.state

def step(self, action):

if action == 0: # Up

self.taxi_row = max(self.taxi_row - 1, 0)

elif action == 1: # Right

self.taxi_col = min(self.taxi_col + 1, self.grid_size - 1)

elif action == 2: # Down

self.taxi_row = min(self.taxi_row + 1, self.grid_size - 1)

elif action == 3: # Left

self.taxi_col = max(self.taxi_col - 1, 0)

elif action == 4: # Pickup

if (self.taxi_row, self.taxi_col) == (self.passenger_row, self.passenger_col):

self.passenger_row, self.passenger_col = -1, -1

elif action == 5: # Dropoff

if (self.taxi_row, self.taxi_col) == (self.destination_row, self.destination_col):

self.destination_row, self.destination_col = -1, -1

self.state = (self.taxi_row, self.taxi_col, self.passenger_row, self.passenger_col, self.destination_row, self.destination_col)

reward = -1

if (self.passenger_row, self.passenger_col) == (self.destination_row, self.destination_col) and action == 5:

reward = 20

elif (self.taxi_row, self.taxi_col) == (self.passenger_row, self.passenger_col) and action == 4:

reward = 10

done = (self.passenger_row, self.passenger_col) == (self.destination_row, self.destination_col)

return self.state, reward, done

そして、N-アームドバンディットやグリッドワールドと同様に、この環境でQ-Learningエージェントを訓練することができます。大きな違いは、エージェントが拾い上げ(Pickup)と降ろし(Dropoff)の2つの追加的なアクションを取ることができるということです。戦略は、客をピックアップし、正しい目的地に届けるための最適なルートを見つけることです。

user:

タクシーゲームを最後まで実装してください。

assistant:

もちろんです。タクシーの環境が実装されてから、次に行うことは、Q-Learningエージェントのクラスを作成し、訓練します。タクシー環境では6つの異なるアクションが存在するため、行動空間に 6 を渡してエージェントを初期化します。

ここでは改めて QLearningAgent クラスを作成し、訓練ループを追加します。

class QLearningAgent:

def __init__(self, state_space, action_space, learning_rate=0.1, discount_factor=0.9, exploration_rate=1.0, exploration_decay_rate=0.99):

self.state_space = state_space

self.action_space = action_space

self.q_table = np.zeros(state_space + tuple([len(action_space)]))

self.learning_rate = learning_rate

self.discount_factor = discount_factor

self.exploration_rate = exploration_rate

self.exploration_decay_rate = exploration_decay_rate

def get_action(self, state):

if np.random.uniform(0, 1) < self.exploration_rate:

return np.random.choice(self.action_space)

else:

return np.argmax(self.q_table[state])

def update_q(self, state, action, reward, next_state):

self.q_table[state][action] = self.q_table[state][action] + self.learning_rate * (reward + self.discount_factor * np.max(self.q_table[next_state]) - self.q_table[state][action])

def decay_exploration_rate(self):

self.exploration_rate *= self.exploration_decay_rate

# Initialize environment and agent

env = TaxiEnv()

agent = QLearningAgent((env.grid_size, env.grid_size, 2, 2, 2, 2), list(range(6)))

# Run many episodes to train the agent

epochs = 5000

for e in range(epochs):

state = env.reset()

done = False

while not done:

action = agent.get_action(state)

next_state, reward, done = env.step(action)

agent.update_q(state, action, reward, next_state)

state = next_state

if done:

agent.decay_exploration_rate()

print(agent.q_table)

user:

次のエラーを修正した全コードを書いてください。

---------------------------------------------------------------------------

IndexError Traceback (most recent call last)

Cell In[9], line 35

33 action = agent.get_action(state)

34 next_state, reward, done = env.step(action)

---> 35 agent.update_q(state, action, reward, next_state)

36 state = next_state

37 if done:

Cell In[9], line 18, in QLearningAgent.update_q(self, state, action, reward, next_state)

17 def update_q(self, state, action, reward, next_state):

---> 18 self.q_table[state][action] = self.q_table[state][action] + self.learning_rate * (reward + self.discount_factor * np.max(self.q_table[next_state]) - self.q_table[state][action])

IndexError: index 4 is out of bounds for axis 4 with size 2

assistant:

エラーメッセージから見ると、agent.update_q の呼び出し時に IndexError が発生しているようです。 問題は具体的には、Qテーブルの走査時に次元が超えている箇所です。

この問題は、ある次元(このエラーでは4番目の次元)が、その次元の最大サイズ(このケースでは2)を超えてインデックスを作成しようとして起こります。原因は、エージェントがQテーブルを初期化する際のステートスペース指定が間違っていますが、それは TaxiEnv 環境内でのステートスペース(状態の可能な値)を正確に表現しません。

Taxi ゲームでは、タクシーはグリッド内の任意の場所に存在し、乗客はタクシーに乗っているか乗っていないかのいずれか、そして目的地もグリッド内の任意の場所に存在します。したがって、ステートスペースは以下の通りになります:

- taxi_row: 0からgrid_size-1まで

- taxi_col: 0からgrid_size-1まで

- passenger_status: 0 (タクシー内) または 1 (タクシー外)

- destination_row: 0からgrid_size-1まで

- destination_col: 0からgrid_size-1まで

したがって、Q-Learning エージェントを初期化する際のステートスペースは (grid_size, grid_size, 2, grid_size, grid_size) となります。全体のコードは以下のようになります:

class QLearningAgent:

def __init__(self, state_space, action_space, learning_rate=0.1, discount_factor=0.9, exploration_rate=1.0, exploration_decay_rate=0.99):

self.state_space = state_space

self.action_space = action_space

self.q_table = np.zeros(state_space + tuple([len(action_space)]))

self.learning_rate = learning_rate

self.discount_factor = discount_factor

self.exploration_rate = exploration_rate

self.exploration_decay_rate = exploration_decay_rate

def get_action(self, state):

if np.random.uniform(0, 1) < self.exploration_rate:

return np.random.choice(self.action_space)

else:

return np.argmax(self.q_table[state])

def update_q(self, state, action, reward, next_state):

self.q_table[state][action] = self.q_table[state][action] + self.learning_rate * (reward + self.discount_factor * np.max(self.q_table[next_state]) - self.q_table[state][action])

def decay_exploration_rate(self):

self.exploration_rate *= self.exploration_decay_rate

# Initialize environment and agent

env = TaxiEnv(grid_size=5)

agent = QLearningAgent((env.grid_size, env.grid_size, 2, env.grid_size, env.grid_size), list(range(6)))

# Run many episodes to train the agent

epochs = 5000

for e in range(epochs):

state = env.reset()

done = False

while not done:

action = agent.get_action(state)

next_state, reward, done = env.step(action)

agent.update_q(state, action, reward, next_state)

state = next_state

if done:

agent.decay_exploration_rate()

print(agent.q_table)

user:

次のエラーを修正した全コードを書いてください。

---------------------------------------------------------------------------

IndexError Traceback (most recent call last)

Cell In[10], line 35

33 action = agent.get_action(state)

34 next_state, reward, done = env.step(action)

---> 35 agent.update_q(state, action, reward, next_state)

36 state = next_state

37 if done:

Cell In[10], line 18, in QLearningAgent.update_q(self, state, action, reward, next_state)

17 def update_q(self, state, action, reward, next_state):

---> 18 self.q_table[state][action] = self.q_table[state][action] + self.learning_rate * (reward + self.discount_factor * np.max(self.q_table[next_state]) - self.q_table[state][action])

IndexError: invalid index to scalar variable.

assistant:

エラーメッセージから見ると、agent.update_qの呼び出し時にIndexErrorが発生しているようです。具体的には、スカラー変数へのインデックスが無効で、問題は次元インデックスによるアクセスがスカラーに対して実行されていることです。

これは、stateやnext_stateがタプルでなく、要素が1つだけであるために起こります。stateがタプルでないと、self.q_table[state]やself.q_table[next_state]はスカラー値を返すため、それにさらにインデックスを適用することはできません。

したがって、この問題を修正するために タクシーゲーム環境 のresetとstepメソッドを修正し、stateとnext_stateがタプルであることを確認します。

次のようになります:

class TaxiEnv:

def __init__(self, grid_size=5):

self.grid_size = grid_size

self.reset()

def reset(self):

self.taxi_row, self.taxi_col = self.grid_size - 1, 0

self.passenger_status = 1

self.destination_row, self.destination_col = self.grid_size - 1, self.grid_size - 1

self.state = (self.taxi_row, self.taxi_col, self.passenger_status, self.destination_row, self.destination_col)

return self.state

def step(self, action):

if action == 0: # Up

self.taxi_row = max(self.taxi_row - 1, 0)

elif action == 1: # Right

self.taxi_col = min(self.taxi_col + 1, self.grid_size - 1)

elif action == 2: # Down

self.taxi_row = min(self.taxi_row + 1, self.grid_size - 1)

elif action == 3: # Left

self.taxi_col = max(self.taxi_col - 1, 0)

elif action == 4: # Pickup

if self.passenger_status == 1:

self.passenger_status = 0

elif action == 5: # Dropoff

if self.passenger_status == 0 and (self.taxi_row, self.taxi_col) == (self.destination_row, self.destination_col):

self.passenger_status = 2

self.state = (self.taxi_row, self.taxi_col, self.passenger_status, self.destination_row, self.destination_col)

reward = -1

done = False

if self.passenger_status == 2: # Dropped off the passenger

reward = 20

done = True

elif action == 4 and self.passenger_status == 1: # Picked up the passenger

reward = 10

return self.state, reward, done

修正後のコードを使ってエージェントを訓練する部分は以下のようになります:

# Initialize environment and agent

env = TaxiEnv(grid_size=5)

agent = QLearningAgent((env.grid_size, env.grid_size, 3, env.grid_size, env.grid_size), list(range(6)))

# Run many episodes to train the agent

epochs = 5000

for e in range(epochs):

state = env.reset()

done = False

while not done:

action = agent.get_action(state)

next_state, reward, done = env.step(action)

agent.update_q(state, action, reward, next_state)

state = next_state

if done:

agent.decay_exploration_rate()

print(agent.q_table)

[[[[[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[-1.83067624 -1.79448072 -1.9005069 -1.87052685 -1.8395234

-1.93740621]]]

[[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[-0.19 -0.1 -0.1 0. -0.1

-0.19 ]]]

[[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]]]

[[[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[-1.98037956 -1.85218905 -1.77950286 -1.88000071 -1.80192965

-1.8396252 ]]]

[[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. -0.19 -0.1 0.

0. ]]]

[[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]]]

[[[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[-1.89574372 -1.94966925 -1.76883584 -1.92187919 -1.87942765

-1.97993398]]]

[[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]]

[[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]]]

[[[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[-1.97893612 -1.84087173 -1.8928563 -1.96447432 -1.80604042

-1.818 ]]]

[[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[-0.1 -0.19 -0.1 0. 0.

-0.1 ]]]

[[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]]]

[[[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[-1.62317367 -1.47854438 -1.29142343 -2.02853627 -1.4752975

-1.62442617]]]

[[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. -0.1 -0.19 0.

0. ]]]

[[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]]]]

[[[[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[-1.81517489 -1.8594312 -1.82279699 -1.81018562 -1.85038795

-1.8908154 ]]]

[[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[-0.19 -0.19 -0.1 -0.1 -0.21711245

-0.1 ]]]

[[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]]]

[[[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[-1.7664861 -1.69802412 -1.92794517 -1.6870654 -1.75553902

-1.67464876]]]

[[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[-0.19 -0.1 0. 0. -0.45755584

-0.1 ]]]

[[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]]]

[[[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[-1.91725566 -1.69140535 -1.24839892 -1.54226795 -1.86646322

-1.60729228]]]

[[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. -0.19 0. 0. 0.

0. ]]]

[[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]]]

[[[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[-2.09246086 -1.44419733 -0.96798387 -1.71709213 -1.79022627

-1.67975592]]]

[[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[-0.1 -0.1 -0.1 0. -0.22695665

-0.1 ]]]

[[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]]]

[[[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[-1.54776996 -1.52719671 1.88380957 -1.60114345 -1.47436054

-1.47876773]]]

[[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[-0.1 -0.1 -0.1 0. 0.

0. ]]]

[[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]]]]

[[[[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[-1.81506049 -1.87993219 -1.92109391 -1.89612618 -1.87271056

-1.8447856 ]]]

[[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[-0.40951 -0.3439 -0.32337056 -0.36829 -0.54248644

-0.4755765 ]]]

[[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]]]

[[[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[-1.81842531 -0.98978637 -1.6516862 -1.8641401 -1.61626989

-1.69152061]]]

[[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[-0.1 -0.1 -0.2071 -0.390241 -0.19277972

-0.19 ]]]

[[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]]]

[[[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[-1.93127548 -0.57296027 3.7289415 -1.78727372 -1.4905443

-0.83808859]]]

[[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[-0.1 -0.19 -0.04719028 0. 0.

0. ]]]

[[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]]]

[[[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[-1.98106431 0.57892759 6.10264533 -1.05397705 -1.20521062

-1.07398287]]]

[[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[-0.1 -0.1 -0.1 -0.1 0.

0. ]]]

[[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]]]

[[[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[-1.07926515 0.91442442 11.92766771 -1.01790816 1.72483356

0.05208461]]]

[[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. -0.1 0. 0. 0.59801002

0. ]]]

[[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]]]]

[[[[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[-1.93394409 -1.64897619 -0.97235817 -1.9630983 -1.93910328

-1.92827097]]]

[[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[-0.73335112 0.59550534 -1.09117687 -0.83072837 -1.45959233

-0.83676039]]]

[[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]]]

[[[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[-1.97810185 6.59425609 2.23350575 -1.77344886 -1.37103406

-0.78323419]]]

[[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[-0.40951 -0.48413577 5.22170139 -0.7208464 -0.3541639

-0.30621195]]]

[[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]]]

[[[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[-0.55392132 11.33320251 4.61316247 -0.79594005 2.17974376

1.98069478]]]

[[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[-0.19 -0.19 0.87066565 -0.1 -0.16080478

-0.1 ]]]

[[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]]]

[[[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0.70618614 14.23778083 10.95223927 4.25535764 4.43792285

5.74333531]]]

[[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[-0.1 -0.1 0.0243153 -0.1 0.

0. ]]]

[[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]]]

[[[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 6.23613952 9.41638408 16.99566593 7.53199036 10.50617601

7.62985064]]]

[[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. -0.1 0.

0. ]]]

[[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]]]]

[[[[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]

[[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]

[ 0. 0. 0. 0. 0.

0. ]]