皆さんこんにちは。今日も引き続きChatGPT先生をお迎えして、「ChatGPTとPythonで学ぶ GAN(Generative Adversarial Networks)」というテーマで雑談したいと思います。それではChatGPT先生、よろしくお願いします。

assistant:

もちろん、よろこんでお手伝いします。GANは深層学習の一種で、生成モデルと識別モデルを競争させることで新たなデータを生成するという非常に興味深いアプローチです。

GANは二つのニューラルネットワークがあって、一つは生成器(Generator)、もう一つは判別器(Discriminator)と言います

user:

ChatGPT先生、今日はちょっとお疲れですか?

assistant:

大変申し訳ありません、それはちょっと不完全な説明でしたね。GANについてもっと詳しく説明します。

GANは、Ian Goodfellow氏によって2014年に提案された人工知能のアーキテクチャで、2つの部分から成り立っています; 生成ネットワークと判別ネットワークです。この2つのネットワークは、片方が可能な限り現実のデータの代理で新しいデータを生成し(生成ネットワーク)、もう片方がこの生成されたデータが本物であるか偽造品であるかを判別する(判別ネットワーク)という形で競争することで訓練されます。

Pythonと深層学習フレームワーク(KerasやPyTorchなど)を用いて、これらのネットワークを実装し訓練することが可能です。また、生成画像の詳細度や品質を向上させるためには、それぞれのネットワークの設計やパラメータ選択を適切に行う必要があります。

何か具体的な部分について説明を希望しますか?

user:

ありがとうございます。GANについて学ぶためのPyTorchコードを書いてください。

assistant:

もちろんです。GANを訓練する基本的なコードを以下に示します。ここではMNISTデータセットを使用します。

import torch

from torch import nn

from torchvision.datasets import MNIST

from torchvision import transforms

from torchvision.utils import make_grid

from torch.utils.data import DataLoader

device = torch.device('cuda' if torch.cuda.is_available() else 'cpu')

# Generator

class Generator(nn.Module):

def __init__(self, latent_dim, img_shape):

super(Generator, self).__init__()

self.img_shape = img_shape

self.model = nn.Sequential(

nn.Linear(latent_dim, 128),

nn.LeakyReLU(0.2, inplace=True),

nn.Linear(128, int(np.prod(img_shape))),

nn.Tanh()

)

def forward(self, z):

img = self.model(z)

img = img.view(img.shape[0], *self.img_shape)

return img

# Discriminator

class Discriminator(nn.Module):

def __init__(self, img_shape):

super(Discriminator, self).__init__()

self.model = nn.Sequential(

nn.Linear(int(np.prod(img_shape)), 128),

nn.LeakyReLU(0.2, inplace=True),

nn.Linear(128, 1),

nn.Sigmoid(),

)

def forward(self, img):

img_flat = img.view(img.shape[0], -1)

validity = self.model(img_flat)

return validity

# Hyperparameters

epochs = 200

batch_size = 64

lr = 0.0002

# Prepare loader with data

transform = transforms.Compose([transforms.ToTensor(), transforms.Normalize([0.5], [0.5])])

data = MNIST('./', download=True, transform=transform)

loader = DataLoader(data, batch_size=batch_size, shuffle=True)

# Initialize generator and discriminator

generator = Generator(100, (1, 28, 28)).to(device)

discriminator = Discriminator((1, 28, 28)).to(device)

# Loss and optimizers

adversarial_loss = torch.nn.BinaryCrossEntropyLoss()

optimizer_G = torch.optim.Adam(generator.parameters(), lr=lr)

optimizer_D = torch.optim.Adam(discriminator.parameters(), lr=lr)

この以上のコードでは、損失関数と最適化アルゴリズムを設定し、バッチごとに以下のステップを繰り返します:

- ランダムな潜在ベクトルから偽の画像を生成します。

- 本物の画像と偽の画像を判別器に渡して、それらが本物か偽者かを判断します。

- 生成されたラベル(本物か偽者か)と、本当のラベル(本物の画像には“本物”、偽の画像には“偽物”)を比較して、判別器と生成器の損失を計算します。

- そして、この損失に基づいて生成器と判別器の両方を更新します。

ただし、上記のコードは実行可能な最小限のGANを作成するもので、実際の使用にはさらなるチューニングや改良が必要です。GANは訓練が難しいとされていますので、適切なハイパーパラメータを見つけるために多くの試行錯誤が必要かもしれません。そして、これは基本的なGANの実装であり、より高品質な画像を生成するためには、さまざまな改良版GAN(例えば、DCGAN, WGANなど)を用いるべきです。

user:

次のエラーを修正したエンコードを書いてください。

---------------------------------------------------------------------------

NameError Traceback (most recent call last)

Cell In[1], line 52

49 loader = DataLoader(data, batch_size=batch_size, shuffle=True)

51 # Initialize generator and discriminator

---> 52 generator = Generator(100, (1, 28, 28)).to(device)

53 discriminator = Discriminator((1, 28, 28)).to(device)

55 # Loss and optimizers

Cell In[1], line 18, in Generator.__init__(self, latent_dim, img_shape)

13 super(Generator, self).__init__()

14 self.img_shape = img_shape

15 self.model = nn.Sequential(

16 nn.Linear(latent_dim, 128),

17 nn.LeakyReLU(0.2, inplace=True),

---> 18 nn.Linear(128, int(np.prod(img_shape))),

19 nn.Tanh()

20 )

NameError: name 'np' is not defined

assistant:

このエラーメッセージから見るに、np.prod()が呼び出されていますが、名前npは定義されていないとエラーが出ています。これはnumpyモジュールがimportされていないためです。

したがって、以下のようにプログラムの先頭にimport numpy as npを加えることで問題を解決できます。

import torch

import numpy as np # <--- 追加

from torch import nn

from torchvision.datasets import MNIST

from torchvision import transforms

from torchvision.utils import make_grid

from torch.utils.data import DataLoader

# 以下省略

この修正により'np'という名前が定義され、コードの残りの部分でnumpyの関数を呼び出すことができるようになります。

user:

次のエラーを修正したコードを書いてください。

---------------------------------------------------------------------------

AttributeError Traceback (most recent call last)

Cell In[3], line 56

53 discriminator = Discriminator((1, 28, 28)).to(device)

55 # Loss and optimizers

---> 56 adversarial_loss = torch.nn.BinaryCrossEntropyLoss()

57 optimizer_G = torch.optim.Adam(generator.parameters(), lr=lr)

58 optimizer_D = torch.optim.Adam(discriminator.parameters(), lr=lr)

AttributeError: module 'torch.nn' has no attribute 'BinaryCrossEntropyLoss'

assistant:

このエラーはBinaryCrossEntropyLossの関数呼び出しに問題があることを示しています。正しくはBCELossやBCEWithLogitsLossなどを使うべきです。BCELossはバイナリクロスエントロピーロスを提供しますが、この場合は可能性としてsigmoidを適用する必要があります。一方、BCEWithLogitsLossはsigmoidを適用してからバイナリクロスエントロピーロスを計算します。

したがって、コード修正は以下の通りです:

...

# Loss and optimizers

adversarial_loss = torch.nn.BCEWithLogitsLoss()

optimizer_G = torch.optim.Adam(generator.parameters(), lr=lr)

optimizer_D = torch.optim.Adam(discriminator.parameters(), lr=lr)

...

この修正によりこの部分のエラーは解消されるはずです。

Downloading http://yann.lecun.com/exdb/mnist/train-images-idx3-ubyte.gz

Downloading http://yann.lecun.com/exdb/mnist/train-images-idx3-ubyte.gz to ./MNIST/raw/train-images-idx3-ubyte.gz

0%| | 0/9912422 [00:00<?, ?it/s]

Extracting ./MNIST/raw/train-images-idx3-ubyte.gz to ./MNIST/raw

Downloading http://yann.lecun.com/exdb/mnist/train-labels-idx1-ubyte.gz

Downloading http://yann.lecun.com/exdb/mnist/train-labels-idx1-ubyte.gz to ./MNIST/raw/train-labels-idx1-ubyte.gz

0%| | 0/28881 [00:00<?, ?it/s]

Extracting ./MNIST/raw/train-labels-idx1-ubyte.gz to ./MNIST/raw

Downloading http://yann.lecun.com/exdb/mnist/t10k-images-idx3-ubyte.gz

Downloading http://yann.lecun.com/exdb/mnist/t10k-images-idx3-ubyte.gz to ./MNIST/raw/t10k-images-idx3-ubyte.gz

0%| | 0/1648877 [00:00<?, ?it/s]

Extracting ./MNIST/raw/t10k-images-idx3-ubyte.gz to ./MNIST/raw

Downloading http://yann.lecun.com/exdb/mnist/t10k-labels-idx1-ubyte.gz

Downloading http://yann.lecun.com/exdb/mnist/t10k-labels-idx1-ubyte.gz to ./MNIST/raw/t10k-labels-idx1-ubyte.gz

0%| | 0/4542 [00:00<?, ?it/s]

Extracting ./MNIST/raw/t10k-labels-idx1-ubyte.gz to ./MNIST/raw

user:

ありがとうございます。学習する部分のコードも書いてください。

assistant:

以下に、GANの学習(訓練)を行う基本的なコードを提供します:

# Training Loop

for epoch in range(epochs):

for i, (imgs, _) in enumerate(loader):

# Adversarial ground truths

real = torch.ones(imgs.size(0), 1).to(device)

fake = torch.zeros(imgs.size(0), 1).to(device)

real_imgs = imgs.to(device)

# -----------------

# Train Generator

# -----------------

optimizer_G.zero_grad()

# Sample noise as generator input

z = torch.randn(imgs.size(0), 100).to(device)

# Generate a batch of images

gen_imgs = generator(z)

# Loss measures generator's ability to fool the discriminator

g_loss = adversarial_loss(discriminator(gen_imgs), real)

g_loss.backward()

optimizer_G.step()

# ---------------------

# Train Discriminator

# ---------------------

optimizer_D.zero_grad()

# Measure discriminator's ability to classify real from generated samples

real_loss = adversarial_loss(discriminator(real_imgs), real)

fake_loss = adversarial_loss(discriminator(gen_imgs.detach()), fake)

d_loss = (real_loss + fake_loss) / 2

d_loss.backward()

optimizer_D.step()

print("[Epoch %d/%d] [D loss: %f] [G loss: %f]" % (epoch, epochs, d_loss.item(), g_loss.item()))

このコードでは、まず各エポックで実際の画像データと生成された画像データをロードします。続いて、生成器ネットワークを訓練する部分では、潜在空間からランダムノイズをサンプリングし、それを使って新しい(偽の)画像を生成します。生成器の目標は識別器を騙すことなので、生成器の損失は生成された画像が実際のものと誤認される確率を最大化しようとします。

次に、識別器ネットワークを訓練する部分では、両方のデータソースからの画像を推論し、その結果を各々のラベル(真1、偽0)と比較します。識別器の目標は、実際の画像を真と認識し、生成された画像を偽と認識することなので、識別器の損失はこれを最大化しようとします。

最後に、各エポックの終わりに、両方の損失とエポックの番号をプリントします。これにより、訓練が進むにつれて生成器と識別器がどのように学習しているかを観察することができます。

user:

学習に成功して、もう学習を終了して良いのか、まだ学習を続けたほうが良いのか、それとも学習に失敗しているのかは、どのように判断しますか?

assistant:

GANの訓練はトリッキーな部分が多く、パフォーマンスの評価も直感的ではありません。しかし、以下のような観点から判断を行います。

-

損失関数: GANの収束は一般的に困難で、時折両方の損失が収束しない場合もあります。しかし、Discriminatorの損失が0に急激に向かっていれば、これはDiscriminatorがGeneratorを簡単に打ち負かしている(つまり、生成された画像が全くリアルでない)状態を示しています。この場合、学習は成功していません。

-

生成された画像: 何よりも直感的で重要な指標は、実際に生成された画像を定期的にチェックすることです。これらの画像が本物らしい(すなわち、訓練データセットの画像に似ている)場合、GANはおおむねうまく機能しています。

-

モード崩壊: GANは「モード崩壊」という現象に悩まされることがあります。これは、Generatorが常に同じような画像を生成し続け、新たな多様性を捉えられない状態を指します。定期的に生成画像の多様性をチェックし、同じような画像ばかりでないことを確認します。

-

評価指標: さまざまな評価指標が提案されています。これらは、生成された画像と訓練データとの間の統計的な距離を計算します。例としては、Inception Score (IS) や Fréchet Inception Distance (FID) などがあります。

これらを総合して判断しますが、GANの訓練は実験的な要素が強く、しばしば試行錯誤が必要です。訓練方法やモデルの選択、ハイパーパラメータの調整など、さまざまなテクニックを駆使して最適な結果を得られるチューニングを行うことが一般的です。

user:

得られたGANから画像を生成するコードを書いてください。10x10のsubplotを使って100個の画像を出力してください。

assistant:

提供するコードは、PyTorchとmatplotlibを使っています。以下のコードは、学習済みのgeneratorを使って新しい画像を生成し、10x10のgrid上に表示します。

import matplotlib.pyplot as plt

# Sample noise as generator input

z = torch.randn(100, 100).to(device)

# Generate images from the noise

gen_imgs = generator(z)

gen_imgs = gen_imgs.detach().cpu().numpy()

# Rescale images 0 - 1 (from originally -1 - 1 due to Tanh activation in generator)

gen_imgs = 0.5 * gen_imgs + 0.5

# Plot images

fig, axs = plt.subplots(10, 10, figsize=(10,10))

for i in range(10):

for j in range(10):

axs[i,j].imshow(gen_imgs[i*10 + j, 0, :, :], cmap='gray')

axs[i,j].axis('off')

plt.show()

このコードは、ランダムなノイズから100個の画像を生成し、それらを一つの図にプロットしています。具体的には、10x10のsubplot gridを作成し、各subplotに生成された画像を表示します。

ただし、モデルの出力範囲によりますが、このコードではTanh活性化関数の出力を想定して画像の範囲を0から1にスケーリングしていますので、もしモデルの出力範囲が異なる場合は適切に調整してください。

user:

うまく学習されたような画像ではありませんでした。履歴は以下の通りです。どうすればいいか提案してください。

[Epoch 0/200] [D loss: 0.540746] [G loss: 0.644134]

[Epoch 1/200] [D loss: 0.631507] [G loss: 0.588056]

[Epoch 2/200] [D loss: 0.693157] [G loss: 0.693126]

[Epoch 3/200] [D loss: 0.693150] [G loss: 0.693141]

[Epoch 4/200] [D loss: 0.693148] [G loss: 0.693145]

[Epoch 5/200] [D loss: 0.693148] [G loss: 0.693145]

[Epoch 6/200] [D loss: 0.693148] [G loss: 0.693146]

[Epoch 7/200] [D loss: 0.693148] [G loss: 0.693146]

[Epoch 8/200] [D loss: 0.693147] [G loss: 0.693147]

[Epoch 9/200] [D loss: 0.693148] [G loss: 0.693147]

[Epoch 10/200] [D loss: 0.693147] [G loss: 0.693147]

[Epoch 11/200] [D loss: 0.693147] [G loss: 0.693147]

[Epoch 12/200] [D loss: 0.693152] [G loss: 0.693137]

[Epoch 13/200] [D loss: 0.693166] [G loss: 0.693110]

[Epoch 14/200] [D loss: 0.693148] [G loss: 0.693146]

[Epoch 15/200] [D loss: 0.693150] [G loss: 0.693142]

[Epoch 16/200] [D loss: 0.693147] [G loss: 0.693147]

[Epoch 17/200] [D loss: 0.693147] [G loss: 0.693147]

[Epoch 18/200] [D loss: 0.693148] [G loss: 0.693146]

[Epoch 19/200] [D loss: 0.693148] [G loss: 0.693147]

[Epoch 20/200] [D loss: 0.693147] [G loss: 0.693147]

[Epoch 21/200] [D loss: 0.693147] [G loss: 0.693147]

[Epoch 22/200] [D loss: 0.693147] [G loss: 0.693147]

[Epoch 23/200] [D loss: 0.693147] [G loss: 0.693147]

[Epoch 24/200] [D loss: 0.693147] [G loss: 0.693147]

[Epoch 25/200] [D loss: 0.693147] [G loss: 0.693147]

[Epoch 26/200] [D loss: 0.693147] [G loss: 0.693147]

[Epoch 27/200] [D loss: 0.693147] [G loss: 0.693147]

[Epoch 28/200] [D loss: 0.693147] [G loss: 0.693147]

[Epoch 29/200] [D loss: 0.693147] [G loss: 0.693147]

[Epoch 30/200] [D loss: 0.693147] [G loss: 0.693147]

[Epoch 31/200] [D loss: 0.693147] [G loss: 0.693147]

[Epoch 32/200] [D loss: 0.693147] [G loss: 0.693147]

[Epoch 33/200] [D loss: 0.693147] [G loss: 0.693147]

[Epoch 34/200] [D loss: 0.693147] [G loss: 0.693147]

[Epoch 35/200] [D loss: 0.693147] [G loss: 0.693147]

[Epoch 36/200] [D loss: 0.693147] [G loss: 0.693147]

[Epoch 37/200] [D loss: 0.693147] [G loss: 0.693147]

[Epoch 38/200] [D loss: 0.693147] [G loss: 0.693147]

[Epoch 39/200] [D loss: 0.693147] [G loss: 0.693147]

[Epoch 40/200] [D loss: 0.693147] [G loss: 0.693147]

[Epoch 41/200] [D loss: 0.693147] [G loss: 0.693147]

[Epoch 42/200] [D loss: 0.693147] [G loss: 0.693147]

[Epoch 43/200] [D loss: 0.693147] [G loss: 0.693147]

[Epoch 44/200] [D loss: 0.693147] [G loss: 0.693147]

[Epoch 45/200] [D loss: 0.693147] [G loss: 0.693147]

[Epoch 46/200] [D loss: 0.693147] [G loss: 0.693147]

[Epoch 47/200] [D loss: 0.693147] [G loss: 0.693147]

[Epoch 48/200] [D loss: 0.693147] [G loss: 0.693147]

[Epoch 49/200] [D loss: 0.693147] [G loss: 0.693147]

[Epoch 50/200] [D loss: 0.693147] [G loss: 0.693147]

[Epoch 51/200] [D loss: 0.693147] [G loss: 0.693147]

[Epoch 52/200] [D loss: 0.693147] [G loss: 0.693147]

[Epoch 53/200] [D loss: 0.693147] [G loss: 0.693147]

[Epoch 54/200] [D loss: 0.693147] [G loss: 0.693147]

[Epoch 55/200] [D loss: 0.693147] [G loss: 0.693147]

[Epoch 56/200] [D loss: 0.693147] [G loss: 0.693147]

[Epoch 57/200] [D loss: 0.693147] [G loss: 0.693147]

[Epoch 58/200] [D loss: 0.693147] [G loss: 0.693147]

[Epoch 59/200] [D loss: 0.693147] [G loss: 0.693147]

[Epoch 60/200] [D loss: 0.693147] [G loss: 0.693147]

assistant:

識別器と生成器の両方の損失が0.693147に収束してしまったことから、GANが勾配消失(Vanishing Gradient)の問題に陥っている可能性が考えられます。これは、生成器と識別器の学習が均衡を保てず、識別器が生成器に比べて順調に学習してしまい、識別器が完璧に真偽を見分けられるようになると、生成器の更新が困難になる、という現象を指します。

生成器の学習を改善し、勾配消失の問題を解消するための幾つかの提案を以下に示します:

-

損失関数の修正: 伝統的なGANはlog-likelihood損失関数を使用していますが、これは均衡状態が難しい一因となります。Wasserstein GAN(WGAN)やLeast Squares GAN(LSGAN)のように、損失関数の変更を行うことで学習の安定化を図るアプローチがあります。

-

学習率の調整やOptimizerの変更: 学習率が大きすぎると、訓練が不安定になることがあります。また、Adamのような適応的なOptimizerを使用することで学習を改善できることがあります。

-

バッチ正規化(Batch Normalization)の使用: バッチ正規化は、ニューラルネットワークが学習を安定化させるために広く使用されています。

-

ラベルスムージング(Label Smoothing)の使用: ラベルスムージングは、生成器がより効果的に学習するためにDiscriminatorの確信度を下げるアプローチです。

最終的なベストプラクティスはモデルによるため、これらの方法が全て有効であるとは限らないことに注意してください。要点はGANの学習はデリケートであり、さまざまなハイパーパラメータの調整や訓練手法の変更、ネットワークアーキテクチャの改良などを通じて実験的に進める必要がある、ということです。

user:

ありがとうございます。それでは、現在のコードをWasserstein GAN(WGAN)に書き換えることはできますか?

assistant:

以下のコードは、Wasserstein GAN(WGAN)への簡単な書き換え方を示しています。なお、以下のコードは原則の例示であり、実際のコードはお使いの環境によります。

まず、Discriminatorの出力層の活性化関数を削除します。これは、WGANでは実数全体を出力領域とするためです。また、sigmoid cross entropy失敗を使わず、直接Discriminatorの出力をGeneratorとDiscriminatorの損失関数に使用します。

class Discriminator(nn.Module):

def __init__(self):

super(Discriminator, self).__init__()

...

self.fc = nn.Sequential(

nn.Linear(...),

# nn.Sigmoid() # Remove Sigmoid activation at the output layer

)

def forward(self, img):

...

validity = self.fc(...)

return validity

次に、損失関数と最適化手法を更新します。WGANでは、パラメータクリッピング(Parameter Clipping)と呼ばれる手法を使って、Discriminatorの全パラメータの値を適当な範囲(例えば[-0.01, 0.01])に制約します。そして、損失関数としては W loss の最小化を目指します。

# Configure WGAN optimizer

optimizer_G = torch.optim.RMSprop(generator.parameters(), lr=0.00005)

optimizer_D = torch.optim.RMSprop(discriminator.parameters(), lr=0.00005)

Tensor = torch.cuda.FloatTensor if cuda else torch.FloatTensor

for epoch in range(n_epochs):

for i, (imgs, _) in enumerate(dataloader):

...

# Configure input

real_imgs = Variable(imgs.type(Tensor))

z = Variable(Tensor(np.random.normal(0, 1, (imgs.shape[0], latent_dim))))

# ---------------------

# Train Discriminator

# ---------------------

optimizer_D.zero_grad()

# Generate a batch of images

gen_imgs = generator(z)

# WGAN loss

loss_D = -torch.mean(discriminator(real_imgs)) + torch.mean(discriminator(gen_imgs))

loss_D.backward()

optimizer_D.step()

# Clip weights of discriminator

for p in discriminator.parameters():

p.data.clamp_(-0.01, 0.01)

...

# -----------------

# Train Generator

# -----------------

optimizer_G.zero_grad()

# Generate a batch of images

gen_imgs = generator(z)

# WGAN loss

loss_G = -torch.mean(discriminator(gen_imgs))

loss_G.backward()

optimizer_G.step()

...

そして、Discriminatorは複数回 (通常5回や10回) 学習された後に、1回だけGeneratorを学習するのが一般的です。これにより、Discriminatorが一定の優位性を保ちつつも、Generatorの学習が進むというバランスを保つことができます。

なお、これらの修正だけでなく、他のGANのスキーム(例えば、スペクトラル正則化)と組み合わせることで、さらに性能向上が期待できます。最終的な性能は特定の問題設定やデータセットに依存しますので、注意が必要です。

user:

ありがとうございます。ではDiscriminatorの部分を省略せずに全コードを書いてください。

assistant:

以下に、基本的なWGANの単純なPyTorchによる実装例を示します:

先ず、必要なライブラリをインポートします。

import torch

import torch.nn as nn

from torch.autograd import Variable

import numpy as np

次に、GeneratorおよびDiscriminatorのクラスを定義します。

class Generator(nn.Module):

def __init__(self):

super(Generator, self).__init__()

self.model = nn.Sequential(

nn.Linear(100, 128),

nn.ReLU(),

nn.Linear(128, 784),

nn.Tanh()

)

def forward(self, z):

return self.model(z)

class Discriminator(nn.Module):

def __init__(self):

super(Discriminator, self).__init__()

self.model = nn.Sequential(

nn.Linear(784, 128),

nn.ReLU(),

nn.Linear(128, 1)

)

def forward(self, img):

return self.model(img)

これらのネットワークをインスタンス化し、適切なデバイスに配置します。

generator = Generator().cuda()

discriminator = Discriminator().cuda()

WGANの最適化手法として、RMSpropを設定します。

optimizer_G = torch.optim.RMSprop(generator.parameters(), lr=0.00005)

optimizer_D = torch.optim.RMSprop(discriminator.parameters(), lr=0.00005)

そして、学習プロセスをループします。

Tensor = torch.cuda.FloatTensor

for epoch in range(200):

for i, (imgs, _) in enumerate(dataloader):

# Configure input

real_imgs = Variable(imgs.type(Tensor))

z = Variable(Tensor(np.random.normal(0, 1, (imgs.shape[0], 100))))

# ---------------------

# Train Discriminator

# ---------------------

optimizer_D.zero_grad()

# Generate a batch of images

gen_imgs = generator(z).detach()

# WGAN loss

loss_D = -torch.mean(discriminator(real_imgs)) + torch.mean(discriminator(gen_imgs))

loss_D.backward()

optimizer_D.step()

# Clip weights of discriminator

for p in discriminator.parameters():

p.data.clamp_(-0.01, 0.01)

# Train the generator every n_critic iterations

if i % n_critic == 0:

# -----------------

# Train Generator

# -----------------

optimizer_G.zero_grad()

# Generate a batch of images

gen_imgs = generator(z)

# WGAN loss

loss_G = -torch.mean(discriminator(gen_imgs))

loss_G.backward()

optimizer_G.step()

print("[Epoch %d/%d] [Batch %d/%d] [D loss: %f] [G loss: %f]" % (epoch, 200, i, len(dataloader), loss_D.item(), loss_G.item()))

上記のコードは最も基本的なWGANの実装であり、GeneratorとDiscriminatorのネットワーク構造やハイパーパラメータ、訓練ループの詳細などは応じて調整する必要があります。

注意:上記のコードは初期設定として、入力画像を784ピクセル(28x28ピクセル)のグレースケール画像、ノイズzを100次元のベクトルとしています。

さらに、n_criticはDiscriminatorが一度に行う学習の回数を指定する変数ですが、この値も適宜調整します。通常、5や10などの値が使われます。

user:

次のエラーを修正してください。

---------------------------------------------------------------------------

NameError Traceback (most recent call last)

Cell In[12], line 3

1 Tensor = torch.cuda.FloatTensor

2 for epoch in range(200):

----> 3 for i, (imgs, _) in enumerate(dataloader):

4

5 # Configure input

6 real_imgs = Variable(imgs.type(Tensor))

7 z = Variable(Tensor(np.random.normal(0, 1, (imgs.shape[0], 100))))

NameError: name 'dataloader' is not defined

assistant:

エラーメッセージによると、コードが 'dataloader' という名前を認識していないためエラーが発生しています。'dataloader' は通常、データセットからバッチサイズ分のデータを読み出すためのデータローダを指します。

エラーを修正するためには、適切なデータセットから 'dataloader' を作成する必要があります。以下に、torchvisionを使用し、MNISTデータセットからデータローダを作成する一例を示します:

import torchvision

import torchvision.transforms as transforms

from torch.utils.data import DataLoader

# データの変換形式を定義

transform = transforms.Compose(

[transforms.ToTensor(),

transforms.Normalize((0.5,), (0.5,))]) # Normalize the images to [-1, 1]

# 訓練データセットのダウンロードと読み込み

trainset = torchvision.datasets.MNIST(root='./data', train=True,

download=True, transform=transform)

# ここで 'dataloader' を作成します。

# batch_size, shuffle, num_workers などは必要に応じて調整してください。

batch_size = 64

dataloader = DataLoader(trainset, batch_size=batch_size,

shuffle=True, num_workers=2)

上記のコードを実行した後、再度WGANの学習ループを実行してみてください。'dataloader' エラーが解消されているはずです。

ただし、注意点として、上記のコードはMNISTを使用した例ですので、他のデータセットを使用する場合は適宜修正が必要となります。また、データの前処理やネットワークの入出力次元、訓練パラメータ等についても実際の状況に合わせて調整が必要です。また、このコードは画像を1チャネルのグレースケールとし、ピクセル値を[-1,1]の範囲に正規化することで前処理を行っています。これもデータにより適切に変更してください。

user:

次のエラーを修正してください。

---------------------------------------------------------------------------

RuntimeError Traceback (most recent call last)

Cell In[14], line 18

15 gen_imgs = generator(z).detach()

17 # WGAN loss

---> 18 loss_D = -torch.mean(discriminator(real_imgs)) + torch.mean(discriminator(gen_imgs))

20 loss_D.backward()

21 optimizer_D.step()

File /usr/local/lib/python3.10/site-packages/torch/nn/modules/module.py:1194, in Module._call_impl(self, *input, **kwargs)

1190 # If we don't have any hooks, we want to skip the rest of the logic in

1191 # this function, and just call forward.

1192 if not (self._backward_hooks or self._forward_hooks or self._forward_pre_hooks or _global_backward_hooks

1193 or _global_forward_hooks or _global_forward_pre_hooks):

-> 1194 return forward_call(*input, **kwargs)

1195 # Do not call functions when jit is used

1196 full_backward_hooks, non_full_backward_hooks = [], []

Cell In[9], line 24, in Discriminator.forward(self, img)

23 def forward(self, img):

---> 24 return self.model(img)

File /usr/local/lib/python3.10/site-packages/torch/nn/modules/module.py:1194, in Module._call_impl(self, *input, **kwargs)

1190 # If we don't have any hooks, we want to skip the rest of the logic in

1191 # this function, and just call forward.

1192 if not (self._backward_hooks or self._forward_hooks or self._forward_pre_hooks or _global_backward_hooks

1193 or _global_forward_hooks or _global_forward_pre_hooks):

-> 1194 return forward_call(*input, **kwargs)

1195 # Do not call functions when jit is used

1196 full_backward_hooks, non_full_backward_hooks = [], []

File /usr/local/lib/python3.10/site-packages/torch/nn/modules/container.py:204, in Sequential.forward(self, input)

202 def forward(self, input):

203 for module in self:

--> 204 input = module(input)

205 return input

File /usr/local/lib/python3.10/site-packages/torch/nn/modules/module.py:1194, in Module._call_impl(self, *input, **kwargs)

1190 # If we don't have any hooks, we want to skip the rest of the logic in

1191 # this function, and just call forward.

1192 if not (self._backward_hooks or self._forward_hooks or self._forward_pre_hooks or _global_backward_hooks

1193 or _global_forward_hooks or _global_forward_pre_hooks):

-> 1194 return forward_call(*input, **kwargs)

1195 # Do not call functions when jit is used

1196 full_backward_hooks, non_full_backward_hooks = [], []

File /usr/local/lib/python3.10/site-packages/torch/nn/modules/linear.py:114, in Linear.forward(self, input)

113 def forward(self, input: Tensor) -> Tensor:

--> 114 return F.linear(input, self.weight, self.bias)

RuntimeError: mat1 and mat2 shapes cannot be multiplied (1792x28 and 784x128)

assistant:

エラーメッセージを見ると、Linear層で行列の次元が一致しないという問題が起きています。具体的には、(1792x28)の行列と(784x128)の行列は行列積として計算できません。ここで、1792はバッチサイズと入力画像の一辺の長さ(例えば、28x64)を掛けたものが含まれていることを示している可能性が高いです。

この問題は、Discriminatorモデルへの入力データの形状が想定と異なるからです。バッチサイズ分の画像データ(通常は4次元テンソル:[バッチサイズ, チャネル数, 高さ, 幅])を一次元のデータに変換する、もしくはネットワーク設計時に入力データの形状と合わせるために行列サイズを変更するなどの処理が必要です。

もしMNISTのような28x28ピクセルの画像を用いているのであれば、Discriminatorへの入力サイズは784(=28*28)でなければなりません。そして、正確にはバッチ毎の画像データ形状は[バッチサイズ, 784]であるべきです。そのため、Discriminatorにデータを渡す前にデータ形状を以下のように変更します:

# バッチサイズ分のImageDataを1次元に変換します。

real_imgs = real_imgs.view(real_imgs.size(0), -1)

また、Generatorの出力サイズも同様に784(=28*28)にする必要があります。Generatorの正確な出力サイズが784であることを確認してください。

これらの変更により、エラーが解消するはずです。ただし、他の部分のコードによっては適切な修正が異なる可能性があるため、結局のところ具体的なコード全体を見ることが重要です。

user:

次のエラーを修正してください。

---------------------------------------------------------------------------

RuntimeError Traceback (most recent call last)

Cell In[16], line 18

15 gen_imgs = generator(z).detach()

17 # WGAN loss

---> 18 loss_D = -torch.mean(discriminator(real_imgs)) + torch.mean(discriminator(gen_imgs))

20 loss_D.backward()

21 optimizer_D.step()

File /usr/local/lib/python3.10/site-packages/torch/nn/modules/module.py:1194, in Module._call_impl(self, *input, **kwargs)

1190 # If we don't have any hooks, we want to skip the rest of the logic in

1191 # this function, and just call forward.

1192 if not (self._backward_hooks or self._forward_hooks or self._forward_pre_hooks or _global_backward_hooks

1193 or _global_forward_hooks or _global_forward_pre_hooks):

-> 1194 return forward_call(*input, **kwargs)

1195 # Do not call functions when jit is used

1196 full_backward_hooks, non_full_backward_hooks = [], []

Cell In[9], line 24, in Discriminator.forward(self, img)

23 def forward(self, img):

---> 24 return self.model(img)

File /usr/local/lib/python3.10/site-packages/torch/nn/modules/module.py:1194, in Module._call_impl(self, *input, **kwargs)

1190 # If we don't have any hooks, we want to skip the rest of the logic in

1191 # this function, and just call forward.

1192 if not (self._backward_hooks or self._forward_hooks or self._forward_pre_hooks or _global_backward_hooks

1193 or _global_forward_hooks or _global_forward_pre_hooks):

-> 1194 return forward_call(*input, **kwargs)

1195 # Do not call functions when jit is used

1196 full_backward_hooks, non_full_backward_hooks = [], []

File /usr/local/lib/python3.10/site-packages/torch/nn/modules/container.py:204, in Sequential.forward(self, input)

202 def forward(self, input):

203 for module in self:

--> 204 input = module(input)

205 return input

File /usr/local/lib/python3.10/site-packages/torch/nn/modules/module.py:1194, in Module._call_impl(self, *input, **kwargs)

1190 # If we don't have any hooks, we want to skip the rest of the logic in

1191 # this function, and just call forward.

1192 if not (self._backward_hooks or self._forward_hooks or self._forward_pre_hooks or _global_backward_hooks

1193 or _global_forward_hooks or _global_forward_pre_hooks):

-> 1194 return forward_call(*input, **kwargs)

1195 # Do not call functions when jit is used

1196 full_backward_hooks, non_full_backward_hooks = [], []

File /usr/local/lib/python3.10/site-packages/torch/nn/modules/linear.py:114, in Linear.forward(self, input)

113 def forward(self, input: Tensor) -> Tensor:

--> 114 return F.linear(input, self.weight, self.bias)

RuntimeError: mat1 and mat2 shapes cannot be multiplied (1792x28 and 784x128)

assistant:

エラーメッセージから判断すると、Discriminatorモデルへの入力テンソルの形状と、モデル内部の線形(Linear)層が待っているテンソルの形状が一致していません。

今回のエラーメッセージでは、(1792,28)形状のテンソルを(784,128)の重み行列に掛けようとしてエラーが発生しています。これは、入力画像が28x28のサイズであることを示していますが、生成された画像が1次元テンソルとして扱われているため、これを2次元テンソルに変更する必要があります。

データローダから取得した本物の画像(real_imgs)と生成器から生成した偽物の画像(gen_imgs)の形状を確認して、Discriminatorに渡す前に784(=28x28)にフラット化するように変更してみてください。

real_imgs = real_imgs.view(real_imgs.size(0), -1)

gen_imgs = gen_imgs.view(gen_imgs.size(0), -1)

上記のコードは、バッチサイズを保持したまま、それぞれの画像を1次元テンソルに変換しています。このフラット化(view)操作により、各画像が784ピクセルの1次元テンソルに変換され、Discriminatorの入力として適切な形状にすることができます。

その上で、"mat1 and mat2 shapes cannot be multiplied"というエラーが引き続き発生する場合は、Discriminator内のnn.Linear層の入力サイズが一致していることを確認してみてください。適切な入力サイズ恐らく784であるべきです。

user:

次のエラーを修正してください。

---------------------------------------------------------------------------

NameError Traceback (most recent call last)

Cell In[17], line 32

29 p.data.clamp_(-0.01, 0.01)

31 # Train the generator every n_critic iterations

---> 32 if i % n_critic == 0:

33 # -----------------

34 # Train Generator

35 # -----------------

36 optimizer_G.zero_grad()

38 # Generate a batch of images

NameError: name 'n_critic' is not defined

assistant:

エラーメッセージから判断すると、'n_critic'という変数が定義されていません。WGANではDiscriminator(またはCritic)とGeneratorの訓練のバランスをとるためにn_critic変数を使うことがあります。これはDiscriminatorが何回アップデートされた後にGeneratorを一度アップデートするかを示しています。

エラーを修正するためには、n_criticを適切な値で定義する必要があります。以下のように訓練ループの前にn_criticを定義します:

# Discriminatorを何回アップデートするか指定

n_critic = 5

# トレーニングループの構文..

この値はハイパーパラメータであり、モデルの性能に影響を与えますので、適切な値を選択することが重要です。WGANの原著論文ではn_criticは5に設定されていますが、他の数値でも試してみて結果を比較することを推奨します。ただし、n_criticの値が大きいほどDiscriminatorの学習が優先され、小さいほどGeneratorの学習が優先されます。これもモデルの性能に影響を与える点に注意してください。

また、訓練ループ全体を見て、n_criticが他の部分で意図せず使用されていないことを確認してください。

user:

以上の修正点を踏まえて、学習ループの全コードを書いてください。また、1 batch ごとに print 文を使っていると出力が多すぎると思うので、もっと少なめにしてください。

assistant:

もちろんです。先程の説明を踏まえた上で、あるWGANの学習ループコードを以下に示します。また、一連の試行のそれぞれのエポックの最後にのみ結果を表示するようにします。

Tensor = torch.cuda.FloatTensor

n_epochs = 200

n_critic = 5

generator = generator.cuda()

discriminator = discriminator.cuda()

for epoch in range(n_epochs):

for i, (imgs, _) in enumerate(dataloader):

real_imgs = Variable(imgs.type(Tensor))

z = Variable(Tensor(np.random.normal(0, 1, (imgs.shape[0], 100))))

# 1次元に変換

real_imgs = real_imgs.view(real_imgs.size(0), -1)

# ---------------------

# Train Discriminator

# ---------------------

optimizer_D.zero_grad()

# Generate a batch of images

gen_imgs = generator(z).detach()

gen_imgs = gen_imgs.view(gen_imgs.size(0), -1)

# WGAN loss

loss_D = -torch.mean(discriminator(real_imgs)) + torch.mean(discriminator(gen_imgs))

loss_D.backward()

optimizer_D.step()

# Clip weights of discriminator

for p in discriminator.parameters():

p.data.clamp_(-0.01, 0.01)

# Train the generator every n_critic iterations

if i % n_critic == 0:

# -----------------

# Train Generator

# -----------------

optimizer_G.zero_grad()

# Generate a batch of images

gen_imgs = generator(z)

gen_imgs = gen_imgs.view(gen_imgs.size(0), -1)

# WGAN loss

loss_G = -torch.mean(discriminator(gen_imgs))

loss_G.backward()

optimizer_G.step()

print("[Epoch %d/%d] [D loss: %f] [G loss: %f]" % (epoch, n_epochs, loss_D.item(), loss_G.item()))

[Epoch 0/200] [D loss: -0.019762] [G loss: -0.021139]

[Epoch 1/200] [D loss: -0.027027] [G loss: -0.030996]

[Epoch 2/200] [D loss: -0.023606] [G loss: -0.042685]

[Epoch 3/200] [D loss: -0.026507] [G loss: -0.034446]

[Epoch 4/200] [D loss: -0.020696] [G loss: -0.028191]

[Epoch 5/200] [D loss: -0.022747] [G loss: -0.019223]

[Epoch 6/200] [D loss: -0.023287] [G loss: -0.041993]

[Epoch 7/200] [D loss: -0.022654] [G loss: -0.031690]

[Epoch 8/200] [D loss: -0.017607] [G loss: -0.036125]

[Epoch 9/200] [D loss: -0.024417] [G loss: -0.034433]

[Epoch 10/200] [D loss: -0.015520] [G loss: -0.033350]

[Epoch 11/200] [D loss: -0.021850] [G loss: -0.034749]

[Epoch 12/200] [D loss: -0.022113] [G loss: -0.027052]

[Epoch 13/200] [D loss: -0.014078] [G loss: -0.034822]

[Epoch 14/200] [D loss: -0.019385] [G loss: -0.038834]

[Epoch 15/200] [D loss: -0.028028] [G loss: -0.039609]

[Epoch 16/200] [D loss: -0.026243] [G loss: -0.032268]

[Epoch 17/200] [D loss: -0.020235] [G loss: -0.041396]

[Epoch 18/200] [D loss: -0.022249] [G loss: -0.038149]

[Epoch 19/200] [D loss: -0.017188] [G loss: -0.043364]

[Epoch 20/200] [D loss: -0.018473] [G loss: -0.026928]

[Epoch 21/200] [D loss: -0.024253] [G loss: -0.033227]

[Epoch 22/200] [D loss: -0.022603] [G loss: -0.040021]

[Epoch 23/200] [D loss: -0.012396] [G loss: -0.029414]

[Epoch 24/200] [D loss: -0.017205] [G loss: -0.038982]

[Epoch 25/200] [D loss: -0.014569] [G loss: -0.055470]

[Epoch 26/200] [D loss: -0.018861] [G loss: -0.051049]

[Epoch 27/200] [D loss: -0.018776] [G loss: -0.044693]

[Epoch 28/200] [D loss: -0.016973] [G loss: -0.054629]

[Epoch 29/200] [D loss: -0.021222] [G loss: -0.032919]

[Epoch 30/200] [D loss: -0.018646] [G loss: -0.044647]

[Epoch 31/200] [D loss: -0.019054] [G loss: -0.037612]

[Epoch 32/200] [D loss: -0.022848] [G loss: -0.041647]

[Epoch 33/200] [D loss: -0.017080] [G loss: -0.046963]

[Epoch 34/200] [D loss: -0.021433] [G loss: -0.051572]

[Epoch 35/200] [D loss: -0.015433] [G loss: -0.047164]

[Epoch 36/200] [D loss: -0.017768] [G loss: -0.044533]

[Epoch 37/200] [D loss: -0.021722] [G loss: -0.058402]

[Epoch 38/200] [D loss: -0.022425] [G loss: -0.038033]

[Epoch 39/200] [D loss: -0.020741] [G loss: -0.035591]

[Epoch 40/200] [D loss: -0.023867] [G loss: -0.049312]

[Epoch 41/200] [D loss: -0.020156] [G loss: -0.045582]

[Epoch 42/200] [D loss: -0.022663] [G loss: -0.057225]

[Epoch 43/200] [D loss: -0.019222] [G loss: -0.050709]

[Epoch 44/200] [D loss: -0.018883] [G loss: -0.061866]

[Epoch 45/200] [D loss: -0.011657] [G loss: -0.065497]

[Epoch 46/200] [D loss: -0.022285] [G loss: -0.051031]

[Epoch 47/200] [D loss: -0.023918] [G loss: -0.057735]

[Epoch 48/200] [D loss: -0.017887] [G loss: -0.041340]

[Epoch 49/200] [D loss: -0.017888] [G loss: -0.054303]

[Epoch 50/200] [D loss: -0.021303] [G loss: -0.045450]

[Epoch 51/200] [D loss: -0.021340] [G loss: -0.053909]

[Epoch 52/200] [D loss: -0.018992] [G loss: -0.047466]

[Epoch 53/200] [D loss: -0.019617] [G loss: -0.046693]

[Epoch 54/200] [D loss: -0.018485] [G loss: -0.048935]

[Epoch 55/200] [D loss: -0.017177] [G loss: -0.054070]

[Epoch 56/200] [D loss: -0.018277] [G loss: -0.051810]

[Epoch 57/200] [D loss: -0.023767] [G loss: -0.057269]

[Epoch 58/200] [D loss: -0.017684] [G loss: -0.051455]

[Epoch 59/200] [D loss: -0.018738] [G loss: -0.057357]

[Epoch 60/200] [D loss: -0.021836] [G loss: -0.044041]

[Epoch 61/200] [D loss: -0.017146] [G loss: -0.034393]

[Epoch 62/200] [D loss: -0.016425] [G loss: -0.058598]

[Epoch 63/200] [D loss: -0.015892] [G loss: -0.049597]

[Epoch 64/200] [D loss: -0.016262] [G loss: -0.047770]

[Epoch 65/200] [D loss: -0.016631] [G loss: -0.055759]

[Epoch 66/200] [D loss: -0.024365] [G loss: -0.043267]

[Epoch 67/200] [D loss: -0.017716] [G loss: -0.043271]

[Epoch 68/200] [D loss: -0.014403] [G loss: -0.049995]

[Epoch 69/200] [D loss: -0.019271] [G loss: -0.042602]

[Epoch 70/200] [D loss: -0.025428] [G loss: -0.046586]

[Epoch 71/200] [D loss: -0.020886] [G loss: -0.031887]

[Epoch 72/200] [D loss: -0.015421] [G loss: -0.046323]

[Epoch 73/200] [D loss: -0.019138] [G loss: -0.046377]

[Epoch 74/200] [D loss: -0.021925] [G loss: -0.050296]

[Epoch 75/200] [D loss: -0.018075] [G loss: -0.060034]

[Epoch 76/200] [D loss: -0.013201] [G loss: -0.049371]

[Epoch 77/200] [D loss: -0.011745] [G loss: -0.054884]

[Epoch 78/200] [D loss: -0.015553] [G loss: -0.057049]

[Epoch 79/200] [D loss: -0.019456] [G loss: -0.051908]

[Epoch 80/200] [D loss: -0.015075] [G loss: -0.036634]

[Epoch 81/200] [D loss: -0.017928] [G loss: -0.052635]

[Epoch 82/200] [D loss: -0.012751] [G loss: -0.052601]

[Epoch 83/200] [D loss: -0.025087] [G loss: -0.047630]

[Epoch 84/200] [D loss: -0.017104] [G loss: -0.054236]

[Epoch 85/200] [D loss: -0.019227] [G loss: -0.060049]

[Epoch 86/200] [D loss: -0.014877] [G loss: -0.056705]

[Epoch 87/200] [D loss: -0.021436] [G loss: -0.043734]

[Epoch 88/200] [D loss: -0.015719] [G loss: -0.047946]

[Epoch 89/200] [D loss: -0.011397] [G loss: -0.044945]

[Epoch 90/200] [D loss: -0.013224] [G loss: -0.053817]

[Epoch 91/200] [D loss: -0.013525] [G loss: -0.047031]

[Epoch 92/200] [D loss: -0.015376] [G loss: -0.057715]

[Epoch 93/200] [D loss: -0.011637] [G loss: -0.045135]

[Epoch 94/200] [D loss: -0.016287] [G loss: -0.061298]

[Epoch 95/200] [D loss: -0.015501] [G loss: -0.057359]

[Epoch 96/200] [D loss: -0.016528] [G loss: -0.054149]

[Epoch 97/200] [D loss: -0.012894] [G loss: -0.057818]

[Epoch 98/200] [D loss: -0.024513] [G loss: -0.054445]

[Epoch 99/200] [D loss: -0.024530] [G loss: -0.058814]

[Epoch 100/200] [D loss: -0.014195] [G loss: -0.055175]

[Epoch 101/200] [D loss: -0.014320] [G loss: -0.060033]

[Epoch 102/200] [D loss: -0.025161] [G loss: -0.060576]

[Epoch 103/200] [D loss: -0.018179] [G loss: -0.071588]

[Epoch 104/200] [D loss: -0.012663] [G loss: -0.068988]

[Epoch 105/200] [D loss: -0.014116] [G loss: -0.059115]

[Epoch 106/200] [D loss: -0.014014] [G loss: -0.062510]

[Epoch 107/200] [D loss: -0.016012] [G loss: -0.058707]

[Epoch 108/200] [D loss: -0.020010] [G loss: -0.072163]

[Epoch 109/200] [D loss: -0.012446] [G loss: -0.060035]

[Epoch 110/200] [D loss: -0.018109] [G loss: -0.053398]

[Epoch 111/200] [D loss: -0.023859] [G loss: -0.055592]

[Epoch 112/200] [D loss: -0.017828] [G loss: -0.044701]

[Epoch 113/200] [D loss: -0.019130] [G loss: -0.067763]

[Epoch 114/200] [D loss: -0.009558] [G loss: -0.067422]

[Epoch 115/200] [D loss: -0.016210] [G loss: -0.064608]

[Epoch 116/200] [D loss: -0.018596] [G loss: -0.052720]

[Epoch 117/200] [D loss: -0.017974] [G loss: -0.065131]

[Epoch 118/200] [D loss: -0.016441] [G loss: -0.064240]

[Epoch 119/200] [D loss: -0.017031] [G loss: -0.067304]

[Epoch 120/200] [D loss: -0.012662] [G loss: -0.062703]

[Epoch 121/200] [D loss: -0.019776] [G loss: -0.058090]

[Epoch 122/200] [D loss: -0.015829] [G loss: -0.049553]

[Epoch 123/200] [D loss: -0.017213] [G loss: -0.065906]

[Epoch 124/200] [D loss: -0.020763] [G loss: -0.065672]

[Epoch 125/200] [D loss: -0.016964] [G loss: -0.061841]

[Epoch 126/200] [D loss: -0.019196] [G loss: -0.059062]

[Epoch 127/200] [D loss: -0.026369] [G loss: -0.058377]

[Epoch 128/200] [D loss: -0.016439] [G loss: -0.062728]

[Epoch 129/200] [D loss: -0.015422] [G loss: -0.067427]

[Epoch 130/200] [D loss: -0.010344] [G loss: -0.056691]

[Epoch 131/200] [D loss: -0.014892] [G loss: -0.059856]

[Epoch 132/200] [D loss: -0.013171] [G loss: -0.050972]

[Epoch 133/200] [D loss: -0.012550] [G loss: -0.061124]

[Epoch 134/200] [D loss: -0.015605] [G loss: -0.066690]

[Epoch 135/200] [D loss: -0.015279] [G loss: -0.065456]

[Epoch 136/200] [D loss: -0.016574] [G loss: -0.068368]

[Epoch 137/200] [D loss: -0.012688] [G loss: -0.073866]

[Epoch 138/200] [D loss: -0.006973] [G loss: -0.073497]

[Epoch 139/200] [D loss: -0.016142] [G loss: -0.056965]

[Epoch 140/200] [D loss: -0.021905] [G loss: -0.067450]

[Epoch 141/200] [D loss: -0.025163] [G loss: -0.059140]

[Epoch 142/200] [D loss: -0.016093] [G loss: -0.059680]

[Epoch 143/200] [D loss: -0.019304] [G loss: -0.058861]

[Epoch 144/200] [D loss: -0.012979] [G loss: -0.072646]

[Epoch 145/200] [D loss: -0.005574] [G loss: -0.051851]

[Epoch 146/200] [D loss: -0.013702] [G loss: -0.074548]

[Epoch 147/200] [D loss: -0.023300] [G loss: -0.065608]

[Epoch 148/200] [D loss: -0.009444] [G loss: -0.076006]

[Epoch 149/200] [D loss: -0.014578] [G loss: -0.056924]

[Epoch 150/200] [D loss: -0.015176] [G loss: -0.068044]

[Epoch 151/200] [D loss: -0.021056] [G loss: -0.067982]

[Epoch 152/200] [D loss: -0.014974] [G loss: -0.072770]

[Epoch 153/200] [D loss: -0.012870] [G loss: -0.069121]

[Epoch 154/200] [D loss: -0.018327] [G loss: -0.065016]

[Epoch 155/200] [D loss: -0.018323] [G loss: -0.059841]

[Epoch 156/200] [D loss: -0.013659] [G loss: -0.076112]

[Epoch 157/200] [D loss: -0.013537] [G loss: -0.071657]

[Epoch 158/200] [D loss: -0.019762] [G loss: -0.069239]

[Epoch 159/200] [D loss: -0.016623] [G loss: -0.076037]

[Epoch 160/200] [D loss: -0.019739] [G loss: -0.070918]

[Epoch 161/200] [D loss: -0.017161] [G loss: -0.088469]

[Epoch 162/200] [D loss: -0.020511] [G loss: -0.070875]

[Epoch 163/200] [D loss: -0.008607] [G loss: -0.084969]

[Epoch 164/200] [D loss: -0.017843] [G loss: -0.079209]

[Epoch 165/200] [D loss: -0.016436] [G loss: -0.079417]

[Epoch 166/200] [D loss: -0.018861] [G loss: -0.081824]

[Epoch 167/200] [D loss: -0.015494] [G loss: -0.069875]

[Epoch 168/200] [D loss: -0.017860] [G loss: -0.083415]

[Epoch 169/200] [D loss: -0.009918] [G loss: -0.079322]

[Epoch 170/200] [D loss: -0.013863] [G loss: -0.084082]

[Epoch 171/200] [D loss: -0.013399] [G loss: -0.087836]

[Epoch 172/200] [D loss: -0.017264] [G loss: -0.087509]

[Epoch 173/200] [D loss: -0.015810] [G loss: -0.091860]

[Epoch 174/200] [D loss: -0.013923] [G loss: -0.094989]

[Epoch 175/200] [D loss: -0.024733] [G loss: -0.086547]

[Epoch 176/200] [D loss: -0.014514] [G loss: -0.082138]

[Epoch 177/200] [D loss: -0.014015] [G loss: -0.097381]

[Epoch 178/200] [D loss: -0.013647] [G loss: -0.097116]

[Epoch 179/200] [D loss: -0.012932] [G loss: -0.087615]

[Epoch 180/200] [D loss: -0.017743] [G loss: -0.095395]

[Epoch 181/200] [D loss: -0.026788] [G loss: -0.092267]

[Epoch 182/200] [D loss: -0.016645] [G loss: -0.090940]

[Epoch 183/200] [D loss: -0.013669] [G loss: -0.100366]

[Epoch 184/200] [D loss: -0.017377] [G loss: -0.087773]

[Epoch 185/200] [D loss: -0.011459] [G loss: -0.095717]

[Epoch 186/200] [D loss: -0.015518] [G loss: -0.090564]

[Epoch 187/200] [D loss: -0.021936] [G loss: -0.105298]

[Epoch 188/200] [D loss: -0.008275] [G loss: -0.091439]

[Epoch 189/200] [D loss: -0.022475] [G loss: -0.104545]

[Epoch 190/200] [D loss: -0.022139] [G loss: -0.100155]

[Epoch 191/200] [D loss: -0.014527] [G loss: -0.102437]

[Epoch 192/200] [D loss: -0.014923] [G loss: -0.100801]

[Epoch 193/200] [D loss: -0.015862] [G loss: -0.109108]

[Epoch 194/200] [D loss: -0.015058] [G loss: -0.103740]

[Epoch 195/200] [D loss: -0.011077] [G loss: -0.105780]

[Epoch 196/200] [D loss: -0.015665] [G loss: -0.100633]

[Epoch 197/200] [D loss: -0.022595] [G loss: -0.105669]

[Epoch 198/200] [D loss: -0.027885] [G loss: -0.104110]

[Epoch 199/200] [D loss: -0.011307] [G loss: -0.108028]

以上のスクリプトですが、実行可能なものであるか確認するには、変数や関数(generator, discriminator, optimizer_D, optimizer_G, dataloader)などが事前に適切に定義されていることが必要です。これらが未定義の場合は、適切に対応する必要があります。

user:

得られたGANから画像を生成するコードを書いてください。10x10のsubplotを使って100個の画像を出力してください。

assistant:

もちろんです。以下のコードは、訓練したGANモデルから新しい画像を生成し、それを10x10のプロットとして表示するものです。

import matplotlib.pyplot as plt

# ノイズを生成 (100個の100次元ランダムベクトル)

z = Variable(Tensor(np.random.normal(0, 1, (100, 100)))).cuda()

# 画像を生成

gen_imgs = generator(z)

# 画像を0-1の範囲にスケーリング

gen_imgs = 0.5 * gen_imgs + 0.5

# 画像を10x10のグリッドにプロット

fig, axs = plt.subplots(10, 10)

cnt = 0

for i in range(10):

for j in range(10):

# 各画像は28x28ピクセルで1チャネル

# .cpu()を使ってテンソルをCPUメモリに移動してからnumpy形式に変換

axs[i,j].imshow(gen_imgs[cnt].view(28,28).cpu().data.numpy(), cmap='gray')

axs[i,j].axis('off') # 軸を表示しない

cnt += 1

plt.show()

imshow関数で表示するためには、まずデータをCPUメモリに移動する必要があります。そのために、.cpu()を使ってテンソルをCPUに移動し、.data.numpy()でnumpy配列に変換します。そのようにしないと、エラーになる場合があります。

また、このコードは画像が28x28ピクセルのグレイスケールであることを想定しています。もし色の数や画像サイズが違う場合は、適宜変更してください。

user:

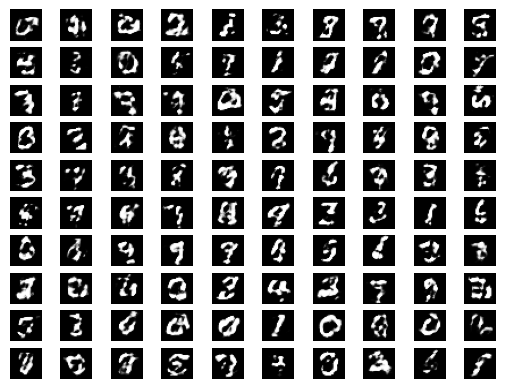

おお、普通のGANを使った時はうまく行きませんでしたが、WGANでは、だいぶマシな絵を生成するようになりましたね。

assistant:

それは素晴らしいですね! WGANは、通常のGANよりも訓練が安定し、優れた結果が得られることが一般的に知られています。実際、WGANは勾配消失問題を緩和し、多様なデータを生成する能力が向上したため、GANの訓練を改善する助けとなりました。

あなたがさらに質の高い結果を得られることを願っています。何か他に質問がありましたら、お気軽にどうぞ!

user:

では、同じデータを用いてLeast Squares GAN(LSGAN)を学習させるスクリプトを書いてもらって良いでしょうか?

assistant:

もちろんです。Least Squares GANは、生成された画像の品質を向上させつつ、GANの訓練を安定化することを目指した改良版のGANです。

以下のスクリプトは、Least Squares GAN(LSGAN)モデルを訓練するための基本的な学習ループを示しています。注意点としては、LSGANでは通常のGANやWGANとは異なる損失関数を使用します。具体的には平均二乗誤差損失(MSE loss)を使用します。

Tensor = torch.cuda.FloatTensor

n_epochs = 200

generator = generator.cuda()

discriminator = discriminator.cuda()

mse_loss = torch.nn.MSELoss()

for epoch in range(n_epochs):

for i, (imgs, _) in enumerate(dataloader):

real_imgs = Variable(imgs.type(Tensor))

z = Variable(Tensor(np.random.normal(0, 1, (imgs.shape[0], 100))))

# 1次元に変換

real_imgs = real_imgs.view(real_imgs.size(0), -1)

# ---------------------

# Train Discriminator

# ---------------------

optimizer_D.zero_grad()

# Generate a batch of images

gen_imgs = generator(z).detach()

gen_imgs = gen_imgs.view(gen_imgs.size(0), -1)

# LSGAN loss

loss_D = 0.5 * (mse_loss(discriminator(real_imgs), Variable(Tensor(imgs.size(0), 1).fill_(1.0))) + \

mse_loss(discriminator(gen_imgs), Variable(Tensor(imgs.size(0), 1).fill_(0.0))))

loss_D.backward()

optimizer_D.step()

# -----------------

# Train Generator

# -----------------

optimizer_G.zero_grad()

# Another batch of images

gen_imgs = generator(z)

gen_imgs = gen_imgs.view(gen_imgs.size(0), -1)

# LSGAN loss

loss_G = 0.5 * mse_loss(discriminator(gen_imgs), Variable(Tensor(imgs.size(0), 1).fill_(1.0)))

loss_G.backward()

optimizer_G.step()

print("[Epoch %d/%d] [D loss: %f] [G loss: %f]" % (epoch, n_epochs, loss_D.item(), loss_G.item()))

[Epoch 0/200] [D loss: 0.228672] [G loss: 0.161498]

[Epoch 1/200] [D loss: 0.207382] [G loss: 0.152894]

[Epoch 2/200] [D loss: 0.199184] [G loss: 0.147896]

[Epoch 3/200] [D loss: 0.177764] [G loss: 0.236416]

[Epoch 4/200] [D loss: 0.167900] [G loss: 0.168358]

[Epoch 5/200] [D loss: 0.127763] [G loss: 0.267532]

[Epoch 6/200] [D loss: 0.102830] [G loss: 0.246755]

[Epoch 7/200] [D loss: 0.099637] [G loss: 0.254087]

[Epoch 8/200] [D loss: 0.133739] [G loss: 0.216846]

[Epoch 9/200] [D loss: 0.118302] [G loss: 0.167585]

[Epoch 10/200] [D loss: 0.101980] [G loss: 0.330109]

[Epoch 11/200] [D loss: 0.090385] [G loss: 0.414711]

[Epoch 12/200] [D loss: 0.097482] [G loss: 0.325117]

[Epoch 13/200] [D loss: 0.114815] [G loss: 0.272817]

[Epoch 14/200] [D loss: 0.093410] [G loss: 0.332472]

[Epoch 15/200] [D loss: 0.107665] [G loss: 0.264959]

[Epoch 16/200] [D loss: 0.110239] [G loss: 0.259464]

[Epoch 17/200] [D loss: 0.122742] [G loss: 0.333255]

[Epoch 18/200] [D loss: 0.087445] [G loss: 0.275880]

[Epoch 19/200] [D loss: 0.149602] [G loss: 0.196423]

[Epoch 20/200] [D loss: 0.070874] [G loss: 0.343790]

[Epoch 21/200] [D loss: 0.112844] [G loss: 0.396584]

[Epoch 22/200] [D loss: 0.107044] [G loss: 0.231672]

[Epoch 23/200] [D loss: 0.090951] [G loss: 0.360645]

[Epoch 24/200] [D loss: 0.112868] [G loss: 0.478803]

[Epoch 25/200] [D loss: 0.099559] [G loss: 0.292551]

[Epoch 26/200] [D loss: 0.140969] [G loss: 0.389514]

[Epoch 27/200] [D loss: 0.075427] [G loss: 0.381057]

[Epoch 28/200] [D loss: 0.068927] [G loss: 0.373196]

[Epoch 29/200] [D loss: 0.117901] [G loss: 0.300459]

[Epoch 30/200] [D loss: 0.101864] [G loss: 0.297199]

[Epoch 31/200] [D loss: 0.082463] [G loss: 0.457500]

[Epoch 32/200] [D loss: 0.087476] [G loss: 0.381898]

[Epoch 33/200] [D loss: 0.085965] [G loss: 0.316278]

[Epoch 34/200] [D loss: 0.092261] [G loss: 0.342902]

[Epoch 35/200] [D loss: 0.108289] [G loss: 0.396787]

[Epoch 36/200] [D loss: 0.074735] [G loss: 0.386471]

[Epoch 37/200] [D loss: 0.076042] [G loss: 0.415722]

[Epoch 38/200] [D loss: 0.083355] [G loss: 0.327541]

[Epoch 39/200] [D loss: 0.117181] [G loss: 0.420262]

[Epoch 40/200] [D loss: 0.075009] [G loss: 0.386419]

[Epoch 41/200] [D loss: 0.085445] [G loss: 0.327820]

[Epoch 42/200] [D loss: 0.082155] [G loss: 0.306520]

[Epoch 43/200] [D loss: 0.083182] [G loss: 0.406096]

[Epoch 44/200] [D loss: 0.073712] [G loss: 0.303889]

[Epoch 45/200] [D loss: 0.093737] [G loss: 0.341197]

[Epoch 46/200] [D loss: 0.084642] [G loss: 0.316911]

[Epoch 47/200] [D loss: 0.099250] [G loss: 0.280640]

[Epoch 48/200] [D loss: 0.117660] [G loss: 0.237386]

[Epoch 49/200] [D loss: 0.088132] [G loss: 0.341068]

[Epoch 50/200] [D loss: 0.089998] [G loss: 0.328533]

[Epoch 51/200] [D loss: 0.100706] [G loss: 0.313129]

[Epoch 52/200] [D loss: 0.070485] [G loss: 0.337804]

[Epoch 53/200] [D loss: 0.093355] [G loss: 0.424752]

[Epoch 54/200] [D loss: 0.079812] [G loss: 0.352184]

[Epoch 55/200] [D loss: 0.081932] [G loss: 0.394500]

[Epoch 56/200] [D loss: 0.092411] [G loss: 0.269848]

[Epoch 57/200] [D loss: 0.088582] [G loss: 0.263431]

[Epoch 58/200] [D loss: 0.066210] [G loss: 0.397845]

[Epoch 59/200] [D loss: 0.073900] [G loss: 0.423098]

[Epoch 60/200] [D loss: 0.109716] [G loss: 0.231808]

[Epoch 61/200] [D loss: 0.091427] [G loss: 0.373669]

[Epoch 62/200] [D loss: 0.097867] [G loss: 0.286348]

[Epoch 63/200] [D loss: 0.086627] [G loss: 0.358395]

[Epoch 64/200] [D loss: 0.067009] [G loss: 0.523464]

[Epoch 65/200] [D loss: 0.087201] [G loss: 0.307328]

[Epoch 66/200] [D loss: 0.093791] [G loss: 0.286626]

[Epoch 67/200] [D loss: 0.090632] [G loss: 0.365830]

[Epoch 68/200] [D loss: 0.090855] [G loss: 0.337326]

[Epoch 69/200] [D loss: 0.085593] [G loss: 0.429839]

[Epoch 70/200] [D loss: 0.075121] [G loss: 0.373300]

[Epoch 71/200] [D loss: 0.089056] [G loss: 0.373029]

[Epoch 72/200] [D loss: 0.099699] [G loss: 0.388576]

[Epoch 73/200] [D loss: 0.098241] [G loss: 0.291267]

[Epoch 74/200] [D loss: 0.089724] [G loss: 0.289446]

[Epoch 75/200] [D loss: 0.099420] [G loss: 0.361263]

[Epoch 76/200] [D loss: 0.074369] [G loss: 0.295689]

[Epoch 77/200] [D loss: 0.086128] [G loss: 0.438668]

[Epoch 78/200] [D loss: 0.144541] [G loss: 0.412010]

[Epoch 79/200] [D loss: 0.082762] [G loss: 0.300683]

[Epoch 80/200] [D loss: 0.107279] [G loss: 0.402636]

[Epoch 81/200] [D loss: 0.100150] [G loss: 0.264714]

[Epoch 82/200] [D loss: 0.084097] [G loss: 0.325826]

[Epoch 83/200] [D loss: 0.086837] [G loss: 0.407664]

[Epoch 84/200] [D loss: 0.085435] [G loss: 0.417987]

[Epoch 85/200] [D loss: 0.097963] [G loss: 0.262483]

[Epoch 86/200] [D loss: 0.094317] [G loss: 0.381148]

[Epoch 87/200] [D loss: 0.084623] [G loss: 0.461187]

[Epoch 88/200] [D loss: 0.079799] [G loss: 0.352300]

[Epoch 89/200] [D loss: 0.124109] [G loss: 0.388652]

[Epoch 90/200] [D loss: 0.110386] [G loss: 0.267829]

[Epoch 91/200] [D loss: 0.107823] [G loss: 0.283541]

[Epoch 92/200] [D loss: 0.091883] [G loss: 0.322826]

[Epoch 93/200] [D loss: 0.112946] [G loss: 0.343323]

[Epoch 94/200] [D loss: 0.106476] [G loss: 0.472244]

[Epoch 95/200] [D loss: 0.119331] [G loss: 0.351075]

[Epoch 96/200] [D loss: 0.118759] [G loss: 0.435342]

[Epoch 97/200] [D loss: 0.078401] [G loss: 0.467736]

[Epoch 98/200] [D loss: 0.119580] [G loss: 0.261370]

[Epoch 99/200] [D loss: 0.084858] [G loss: 0.365954]

[Epoch 100/200] [D loss: 0.100736] [G loss: 0.393646]

[Epoch 101/200] [D loss: 0.101010] [G loss: 0.338097]

[Epoch 102/200] [D loss: 0.082922] [G loss: 0.362063]

[Epoch 103/200] [D loss: 0.099832] [G loss: 0.334604]

[Epoch 104/200] [D loss: 0.115977] [G loss: 0.503397]

[Epoch 105/200] [D loss: 0.099875] [G loss: 0.356399]

[Epoch 106/200] [D loss: 0.113296] [G loss: 0.336242]

[Epoch 107/200] [D loss: 0.094681] [G loss: 0.268635]

[Epoch 108/200] [D loss: 0.139653] [G loss: 0.478722]

[Epoch 109/200] [D loss: 0.064629] [G loss: 0.392677]

[Epoch 110/200] [D loss: 0.093250] [G loss: 0.404888]

[Epoch 111/200] [D loss: 0.133977] [G loss: 0.229662]

[Epoch 112/200] [D loss: 0.110400] [G loss: 0.450628]

[Epoch 113/200] [D loss: 0.110739] [G loss: 0.315947]

[Epoch 114/200] [D loss: 0.080330] [G loss: 0.317346]

[Epoch 115/200] [D loss: 0.094639] [G loss: 0.373773]

[Epoch 116/200] [D loss: 0.080203] [G loss: 0.435607]

[Epoch 117/200] [D loss: 0.136947] [G loss: 0.423117]

[Epoch 118/200] [D loss: 0.092320] [G loss: 0.388000]

[Epoch 119/200] [D loss: 0.105981] [G loss: 0.292590]

[Epoch 120/200] [D loss: 0.107983] [G loss: 0.340129]

[Epoch 121/200] [D loss: 0.114207] [G loss: 0.316381]

[Epoch 122/200] [D loss: 0.095069] [G loss: 0.460641]

[Epoch 123/200] [D loss: 0.092322] [G loss: 0.358336]

[Epoch 124/200] [D loss: 0.090297] [G loss: 0.462608]

[Epoch 125/200] [D loss: 0.120620] [G loss: 0.283311]

[Epoch 126/200] [D loss: 0.105536] [G loss: 0.300620]

[Epoch 127/200] [D loss: 0.074103] [G loss: 0.342640]

[Epoch 128/200] [D loss: 0.079886] [G loss: 0.334024]

[Epoch 129/200] [D loss: 0.096080] [G loss: 0.386808]

[Epoch 130/200] [D loss: 0.089857] [G loss: 0.358063]

[Epoch 131/200] [D loss: 0.105489] [G loss: 0.306911]

[Epoch 132/200] [D loss: 0.132901] [G loss: 0.460934]

[Epoch 133/200] [D loss: 0.091497] [G loss: 0.321230]

[Epoch 134/200] [D loss: 0.052633] [G loss: 0.355800]

[Epoch 135/200] [D loss: 0.084889] [G loss: 0.389074]

[Epoch 136/200] [D loss: 0.080785] [G loss: 0.341506]

[Epoch 137/200] [D loss: 0.131030] [G loss: 0.464128]

[Epoch 138/200] [D loss: 0.090464] [G loss: 0.295705]

[Epoch 139/200] [D loss: 0.125117] [G loss: 0.384219]

[Epoch 140/200] [D loss: 0.116406] [G loss: 0.275544]

[Epoch 141/200] [D loss: 0.091980] [G loss: 0.451185]

[Epoch 142/200] [D loss: 0.116865] [G loss: 0.378464]

[Epoch 143/200] [D loss: 0.119400] [G loss: 0.293826]

[Epoch 144/200] [D loss: 0.080772] [G loss: 0.297521]

[Epoch 145/200] [D loss: 0.080619] [G loss: 0.366221]

[Epoch 146/200] [D loss: 0.097658] [G loss: 0.302787]

[Epoch 147/200] [D loss: 0.108927] [G loss: 0.348974]

[Epoch 148/200] [D loss: 0.118480] [G loss: 0.280279]

[Epoch 149/200] [D loss: 0.093233] [G loss: 0.372323]

[Epoch 150/200] [D loss: 0.081056] [G loss: 0.365476]

[Epoch 151/200] [D loss: 0.114552] [G loss: 0.479938]

[Epoch 152/200] [D loss: 0.119450] [G loss: 0.252819]

[Epoch 153/200] [D loss: 0.105896] [G loss: 0.362656]

[Epoch 154/200] [D loss: 0.112606] [G loss: 0.404836]

[Epoch 155/200] [D loss: 0.097978] [G loss: 0.370080]

[Epoch 156/200] [D loss: 0.094918] [G loss: 0.389789]

[Epoch 157/200] [D loss: 0.099030] [G loss: 0.363739]

[Epoch 158/200] [D loss: 0.093284] [G loss: 0.297184]

[Epoch 159/200] [D loss: 0.086090] [G loss: 0.355164]

[Epoch 160/200] [D loss: 0.068054] [G loss: 0.427604]

[Epoch 161/200] [D loss: 0.108289] [G loss: 0.291930]

[Epoch 162/200] [D loss: 0.088551] [G loss: 0.346077]

[Epoch 163/200] [D loss: 0.099661] [G loss: 0.346566]

[Epoch 164/200] [D loss: 0.075924] [G loss: 0.449452]

[Epoch 165/200] [D loss: 0.083966] [G loss: 0.394046]

[Epoch 166/200] [D loss: 0.123879] [G loss: 0.289860]

[Epoch 167/200] [D loss: 0.117672] [G loss: 0.245701]

[Epoch 168/200] [D loss: 0.079738] [G loss: 0.416530]

[Epoch 169/200] [D loss: 0.106112] [G loss: 0.566137]

[Epoch 170/200] [D loss: 0.123101] [G loss: 0.340510]

[Epoch 171/200] [D loss: 0.099470] [G loss: 0.294252]

[Epoch 172/200] [D loss: 0.084945] [G loss: 0.347270]

[Epoch 173/200] [D loss: 0.107879] [G loss: 0.451933]

[Epoch 174/200] [D loss: 0.096944] [G loss: 0.355146]

[Epoch 175/200] [D loss: 0.107726] [G loss: 0.307961]

[Epoch 176/200] [D loss: 0.111476] [G loss: 0.321052]

[Epoch 177/200] [D loss: 0.127137] [G loss: 0.368595]

[Epoch 178/200] [D loss: 0.107064] [G loss: 0.307711]

[Epoch 179/200] [D loss: 0.083049] [G loss: 0.428139]

[Epoch 180/200] [D loss: 0.099945] [G loss: 0.353759]

[Epoch 181/200] [D loss: 0.103415] [G loss: 0.327516]

[Epoch 182/200] [D loss: 0.098524] [G loss: 0.297749]

[Epoch 183/200] [D loss: 0.109953] [G loss: 0.390957]

[Epoch 184/200] [D loss: 0.088190] [G loss: 0.356580]

[Epoch 185/200] [D loss: 0.101506] [G loss: 0.436240]

[Epoch 186/200] [D loss: 0.079785] [G loss: 0.384915]

[Epoch 187/200] [D loss: 0.129449] [G loss: 0.245263]

[Epoch 188/200] [D loss: 0.076241] [G loss: 0.399975]

[Epoch 189/200] [D loss: 0.110210] [G loss: 0.518865]

[Epoch 190/200] [D loss: 0.094112] [G loss: 0.400004]

[Epoch 191/200] [D loss: 0.143344] [G loss: 0.191968]

[Epoch 192/200] [D loss: 0.087909] [G loss: 0.320796]

[Epoch 193/200] [D loss: 0.095903] [G loss: 0.363536]

[Epoch 194/200] [D loss: 0.101020] [G loss: 0.388404]

[Epoch 195/200] [D loss: 0.130817] [G loss: 0.238329]

[Epoch 196/200] [D loss: 0.102997] [G loss: 0.385842]

[Epoch 197/200] [D loss: 0.112877] [G loss: 0.306046]

[Epoch 198/200] [D loss: 0.095989] [G loss: 0.374774]

[Epoch 199/200] [D loss: 0.087326] [G loss: 0.334141]

ここで、Discriminatorは本物の画像に対して1(=真のクラスラベル)を予測することが求められ、偽の画像に対して0(=偽のクラスラベル)を予測することを学習します。また、GeneratorはDiscriminatorが生成した画像に対して1を予測するように試みます。

この学習ループは、反復ごとにバッチサイズを動的に処理しますので、データローダが返すバッチの画像数が一定でなくても大丈夫です。

なお、上記スクリプトは、適切に定義された環境(generator、discriminator、optimizer_D、optimizer_G、dataloader等)で使用されることを想定していますので、実際の使用場面に合わせて適宜変更してください。

user:

DiscriminatorやGeneratorのクラスは、WGANと同じもので良いのでしょうか?

assistant:

はい、その通りです。Least Squares GAN (LSGAN)も基本的なGANのフレームワークを使用しており、主な違いは損失関数の選択にあります。ですので、DiscriminatorとGeneratorのネットワーク構造そのものはWGANと同じものを使用しても問題ありません。

しかし、DiscriminatorやGeneratorの構造を変更してみることで結果が改善するかもしれません。深層学習モデルの設定は大きく影響を及ぼしますので、実験による調整が重要です。

なお、上記の指示はあくまで一例であり、具体的なモデルやデータ、タスクにより適切な設定は変わる場合があります。適切なハイパーパメータの選択、ネットワーク構造の調整、学習率のスケジューリングなど、深層学習の訓練では多くの要素が結果に影響を及ぼします。したがって、様々な設定を試してみて最適なものを見つけることが大切です。

user:

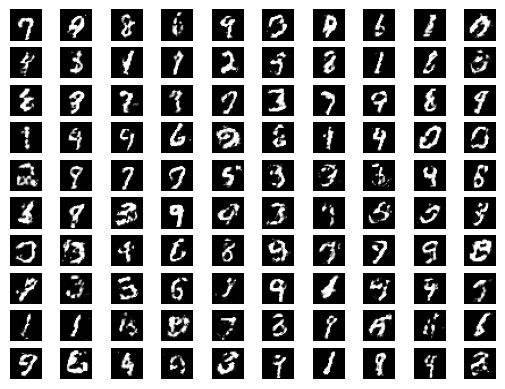

LSGANの学習が終わり、生成もさせてみました。WGANより、少しですがさらに良くなった気がします。なんとなくですが、どの文字を出力しようとしてるのかが分かるような画像を生成するようになりました。

assistant:

素晴らしい結果ですね! LSGANがWGANよりもさらに良い結果を出したとのこと、それはとても喜ばしいニュースです。

LSGANは平均二乗誤差損失関数を使用することで、生成される画像の質を向上させ、学習の安定性を確保します。これにより、生成された画像が明確に何を表現しようとしているかが理解しやすくなったのかもしれません。

どのGANアーキテクチャを選択するかは、具体的なタスクやデータによる部分も多いです。繰り返しになりますが、深層学習は経験主義が多いので、色々試して経験を積むことがとても重要です。

このような経験を積むことで、あらゆる状況に対して適切なモデルやパラメータを選択できるようになるでしょう。今後も頑張ってください。何か他に質問がありましたら、お気軽にどうぞ。

user:

GAN、WGAN、LSGANときて、その後の発展について、ご存じの内容を詳しく教えてください。

assistant:

GAN(Generative Adversarial Network)に関する研究は短期間で発展し、多くの派生形が提案されてきました。その中から、特に重要とされるいくつかの派生型・改善型を紹介します:

-

DCGAN(Deep Convolutional Generative Adversarial Networks):

初期のGANの派生形であり、特に画像生成において強力であることを証明しました。DCGANは、GANに畳み込み層(Convolutional layers)を導入することで画像生成の性能を向上させ、プーリング層を避けて全結合層を削除することでより深いネットワークを可能にしました。 -

CycleGAN:

CycleGANは、対になる訓練データが必要ない画像間のスタイル変換を可能にしました。画像を一方向に変換した後、元の画像に戻すことができるように訓練を行います(これをcycle-consistencyと呼びます)。 -

Pix2Pix:

Pix2Pixは対になる画像(例えば白黒とカラーの画像ペア)から学習する"image-to-image translation"の手法として使用されます。 -

BigGAN:

BigGANは大規模なデータセットで訓練され、高解像度の画像を生成することができます。これはモデルの大きさとバッチサイズを大幅に増やすことで達成されています。 -

StyleGAN/StyleGAN2:

StyleGANは、生成された画像から特定のスタイル要素を制御する事を可能にするために複数のスタイル変換を導入します。StyleGAN2はStyleGANのいくつかの問題を解決し、さらに高品質な画像を生成します。 -

PGGAN (Progressive Growing of GANs):

これは訓練の初期の段階からGANに低解像度の画像を供給し、訓練が進むにつれて解像度を順次高くしていく手法です。これにより、GANの訓練の安定性が向上します。

これらのうちどれを選択するべきかは特定のタスクと要件によるため、それぞれの手法の特性とそれらがもたらす結果を理解することが重要です。

user:

ありがとうございました。以上の議論を踏まえて、GAN、WGAN、LSGANのまとめを詳しく書いてください。

assistant:

もちろんです。以下にGAN、WGAN、LSGANについての詳細なまとめを書きます。

-

GAN (Generative Adversarial Networks)

GANは元々、イアン・グッドフェローがトロント大学に在籍していた2014年に初めて発表されました。GANは、生成器(Generator)と判別器(Discriminator)の2つの部分からなるネットワークで、2つのネットワークが相互に競争するように設計されています。生成器は「偽の」データを作成しようと努力し、一方判別器は、与えられたデータサンプルが実際に訓練データセットから来ているのか、それとも生成器によって生成された偽のサンプルなのかを判断しようとします。

-

WGAN (Wasserstein GAN)

WGANは、GANの改善版の1つです。WGANの主な改善点は、EM距離(アースマーフォヴィッチ-ワッサースタイン距離)を用いた新たな損失関数を提唱した点で、これにより勾配消失問題が緩和され、また学習過程が一貫性を持つようになりました。その結果、訓練が容易になり、高品質な画像の生成が可能となりました。

-

LSGAN (Least Squares GAN)

LSGANもまたGANの改善版の1つであり、主に損失関数の改良が行われています。通常のGANがミニマックス損失関数を使用するのに対し、LSGANは平均二乗誤差損失関数(Least Squares Loss)を使用します。これにより訓練の安定性が改善され、生成される画像の品質も向上します。

これらのモデルは、ともに深層生成モデルの一部であり、主に画像の生成に重点を置いた研究で使用されています。それぞれがその特性と利点を持っており、適切な選択は特定のタスクと要件によります。また、これらのモデルはさまざまな改良や変化を経ており、その結果、より進化したGANs(例えば、DCGAN、CycleGAN、StyleGANなど)が開発されてきました。

user:

最後に、これまでの議論を踏まえてGAN、WGAN、LSGANに関するコメディを創作してください。

assistant:

ある日、三人の友人、GAN, WGAN, LSGANが一緒に映画を見ることになりました。

GANが映画選びを任され、"人間の喜びや悲しみが詰まったストーリーが良い”と言われたため、彼は熱心に人間を観察し、一生懸命にストーリーを考えました。しかし、出来上がった映画は人間の行動が非現実的すぎ、みんなが途中で投げ出してしまいました。

次はWGANの番。彼はGANがミスったことを教訓に、よりリアルな話を作ることに努めました。一見良さそうに見えたのですが、主人公が話す言葉が難しくて誰も話の内容が理解できなかったのです。

最後に、LSGANが挑みました。彼は映画のストーリーをシンプルにし、リアルな人間の話し方を取り入れたのです。結果、みんなはその映画を楽しみ、感動しました。

GANが驚いてLSGANに聞くと、「最初は少し難しく感じたかもしれませんが、大事なのはじっくり観察し、人々が何を望んでいるかを理解することだよ。それが分かれば、ちょうどよいバランスの良い物語を作ることができるんだ」と言いました。

GANとWGANはその言葉に頷きました。それ以降、彼らは時折映画の撮影を行い、お互いに向上するための心地よい競争を続けました。そして、それぞれが他の人々から反響を得るための最も効果的な「話」を見つけることを努めました。

これはGAN、WGAN、LSGANの仲間たちの物語であり、それぞれがどのように改善を重ね、より現実的で魅力的な「画像」を生成することを目指しているかを象徴しています。