ある朝、子供が「1が出来た!」と叫んだ。

なんのことかと振り返るとチーズ食パンを食べていたら、1という数字になったそうな・・・。確かにね、言われてみればそんな感じ。と、その時思わず、この前の手書き文字を学習させたAIなら分かってくれるのかしら?と余計な考えが浮かび試すことに。

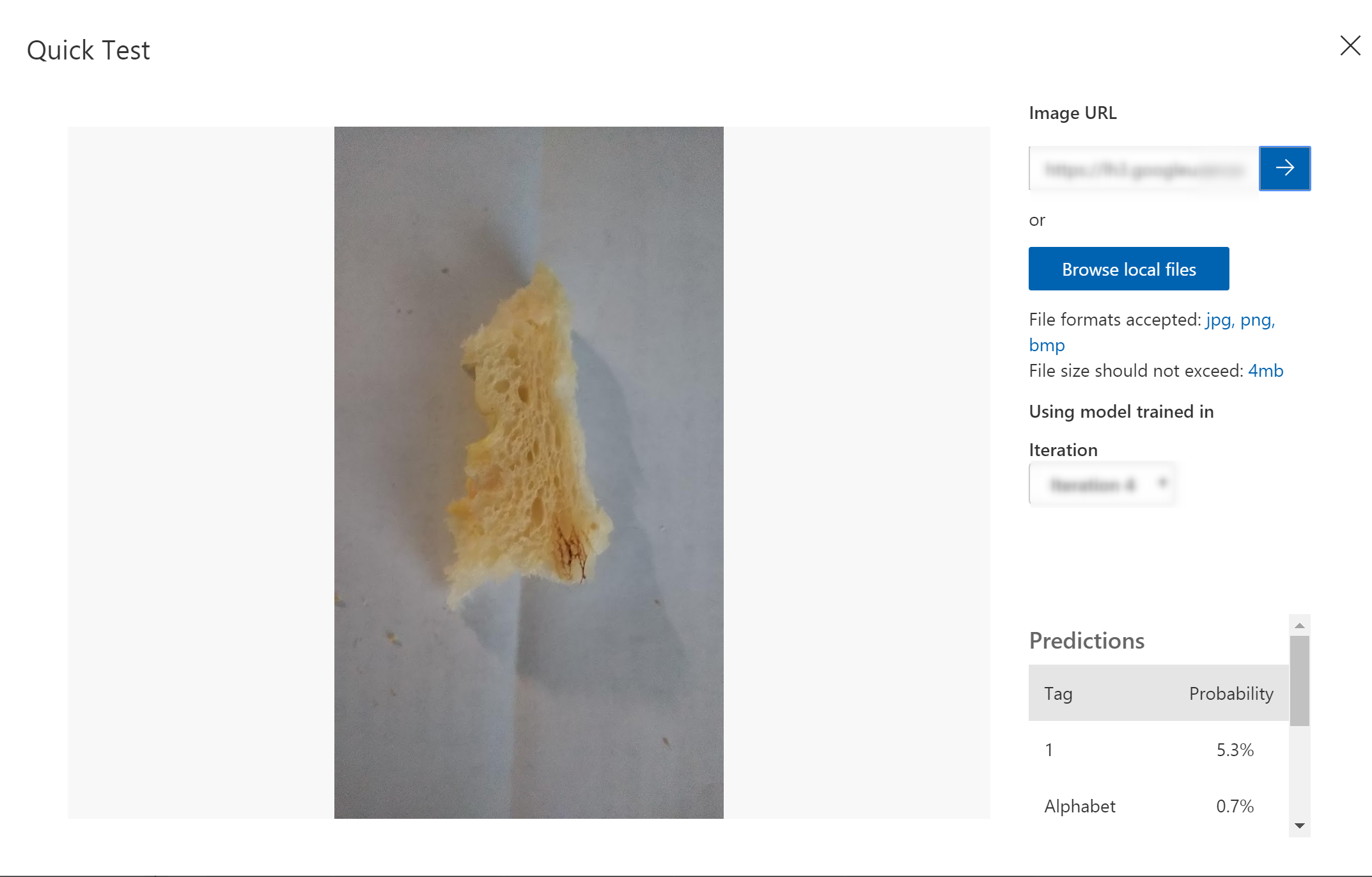

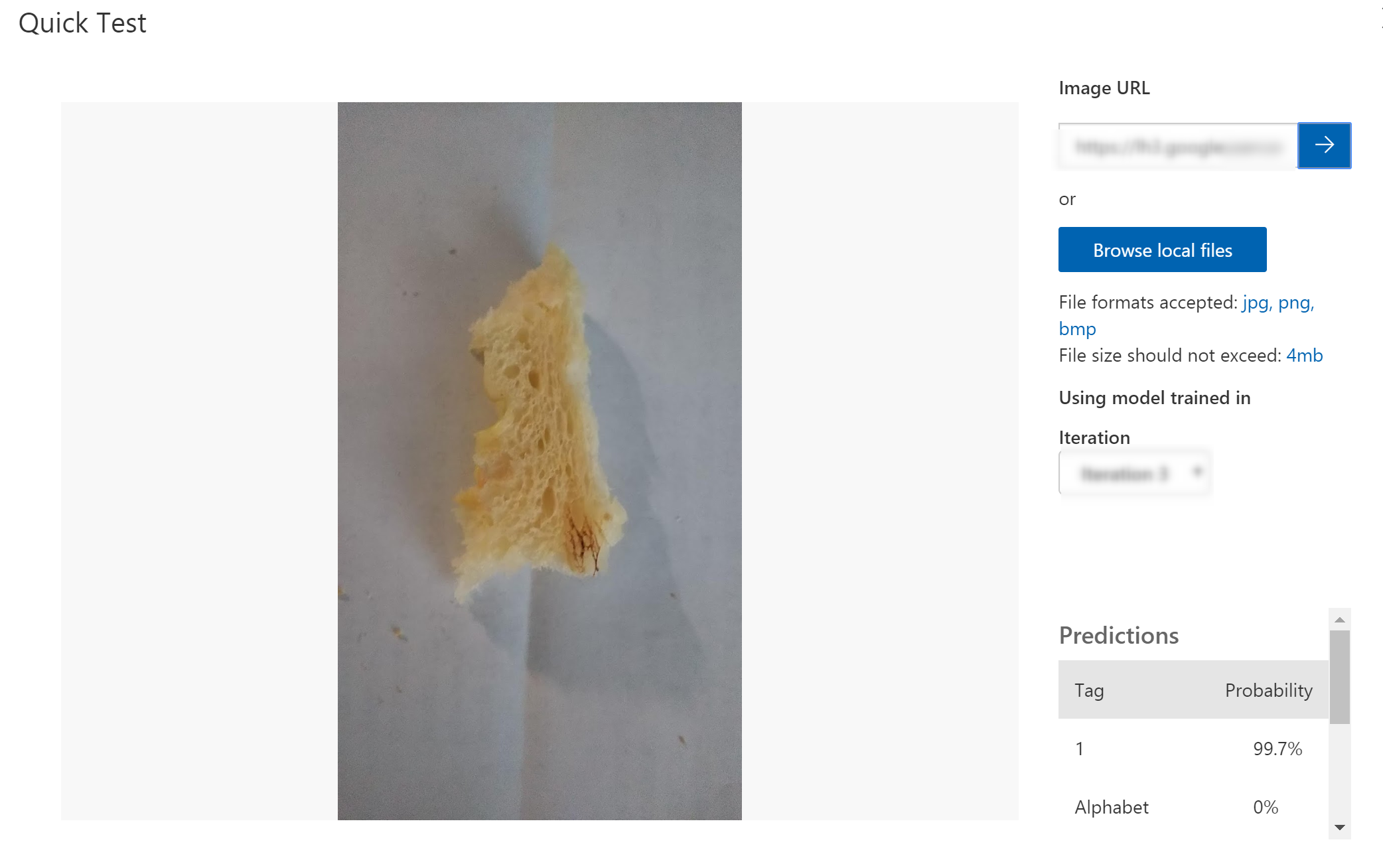

もちろん結果は✖。当たり前ですよね~。インクと食パンでは違いますもの。無茶ぶりにAIも1%の確率でアルファベットです」って全く無意味な回答をしてくれてました(笑)。そこで!この1%がどこまで改善できるか挑戦してみることにしました。

方法

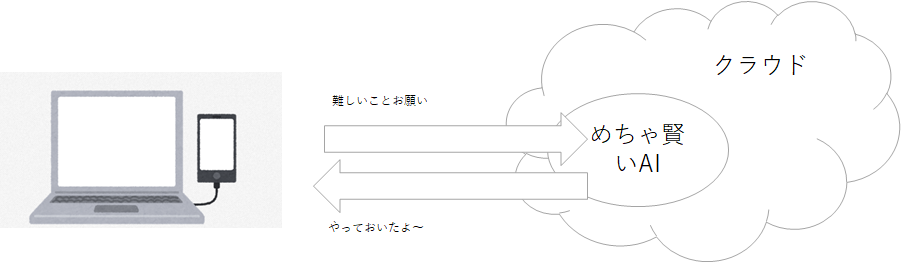

前回の記事で作成したAIにいろんな画像を追加して精度をあげます。因みにMicrosoft AzureのCustom Vision Serviceはクラウド上にある自前のコンピューターで確立できないめちゃ賢いAIを部分的にお借りできるシステム。

AI学習と結果

Try1.まずは色々な「1」を学習してもらうべく、[Unsplush](https://unsplash.com

/)から「1」に関係する写真をいただき、ひたすら学習させる。

結果は1が3%!。まだまだ低いけど、少なくとも1が最初に出てきた(一応最初の3倍の確率に向上してる(笑)。

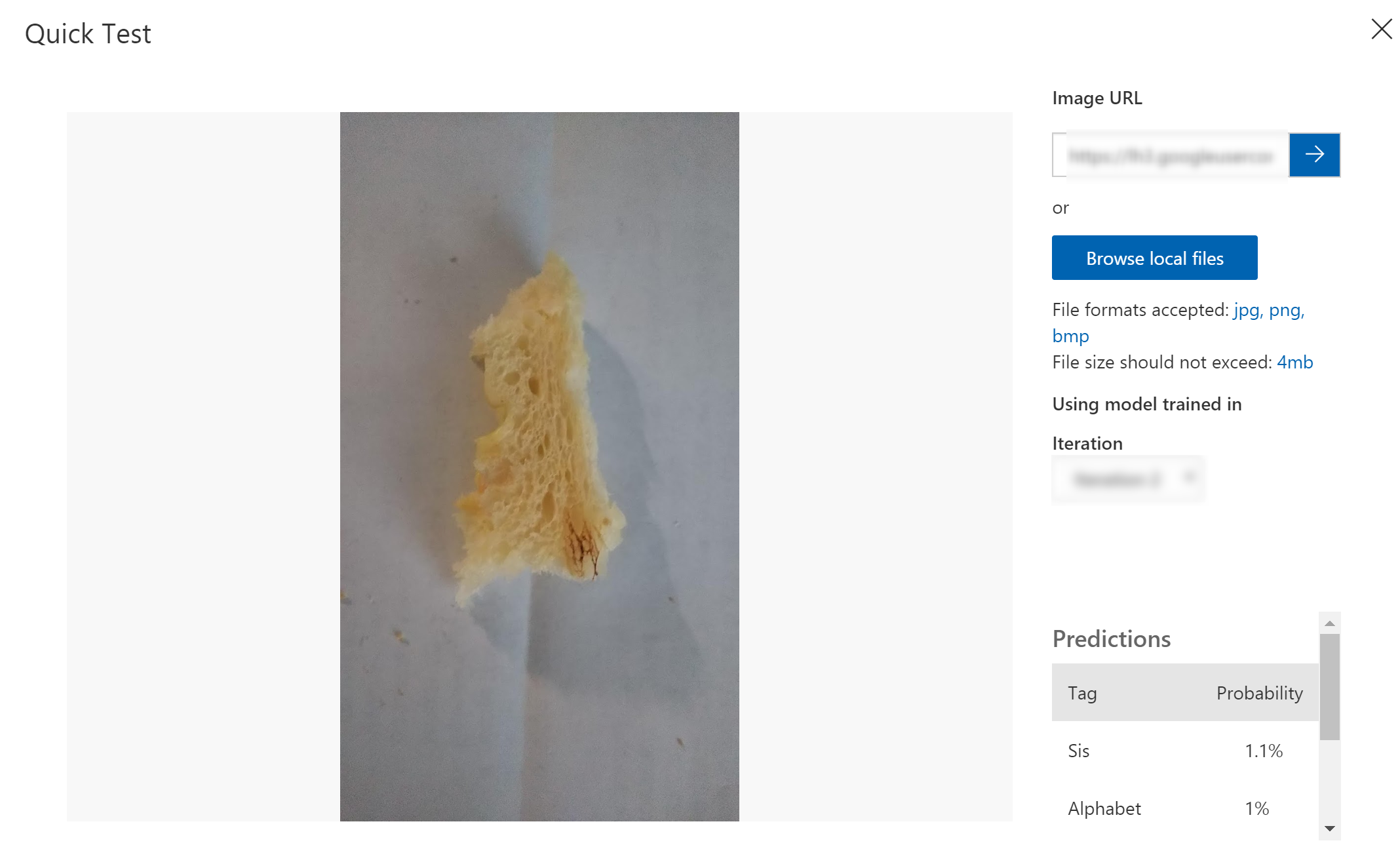

Try2.ある一定を超えると情報量が増えてもあまり変わらなかったので「1」ではない数字のサンプルを学習させてみた。

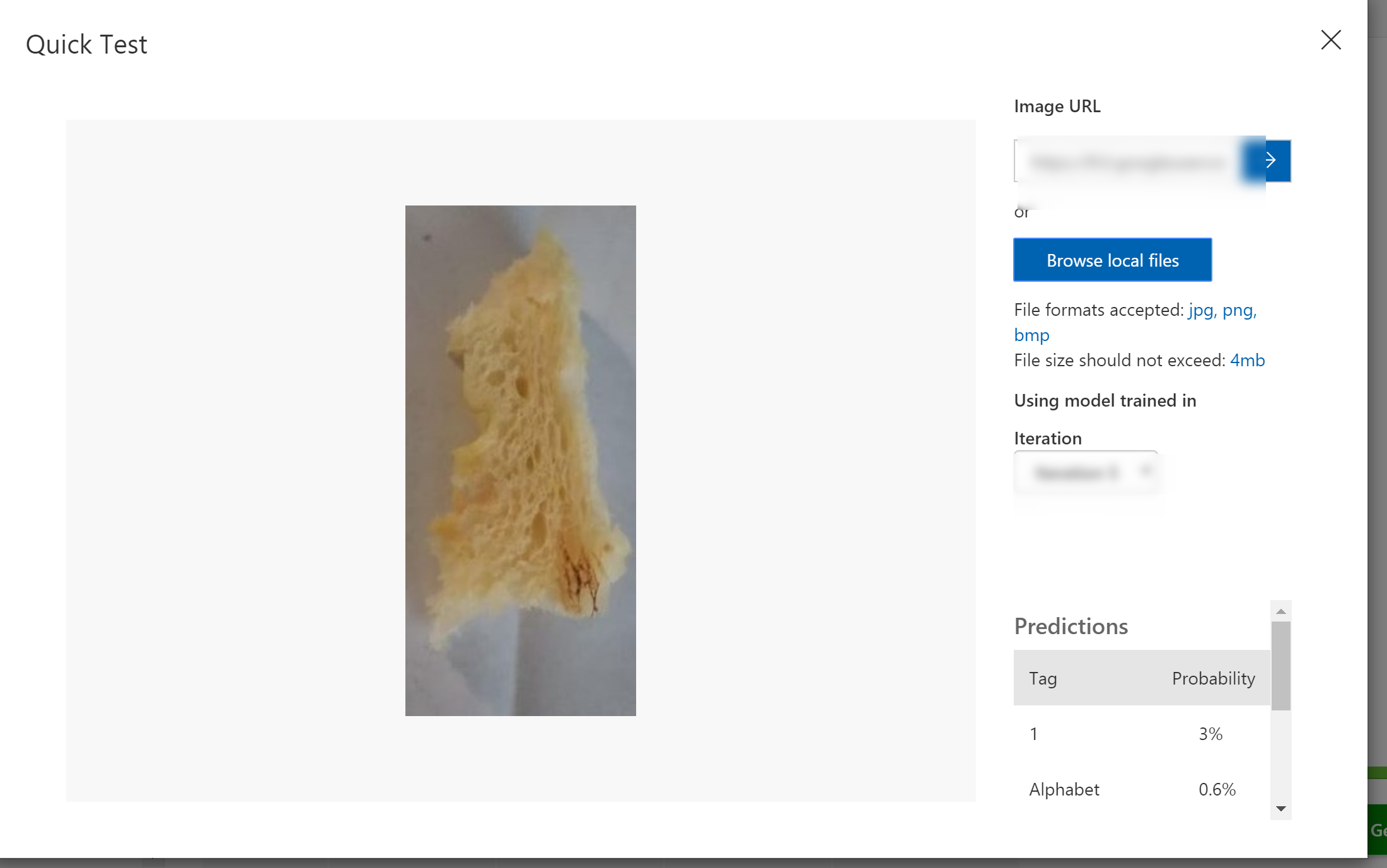

Try3.やっぱり食パンの画像が必要かな?ということで下の写真を「1」として追加。

なんと一気に99%まで精度が向上。AIって1枚の画像でもこんなに変わるんですね。驚きです。

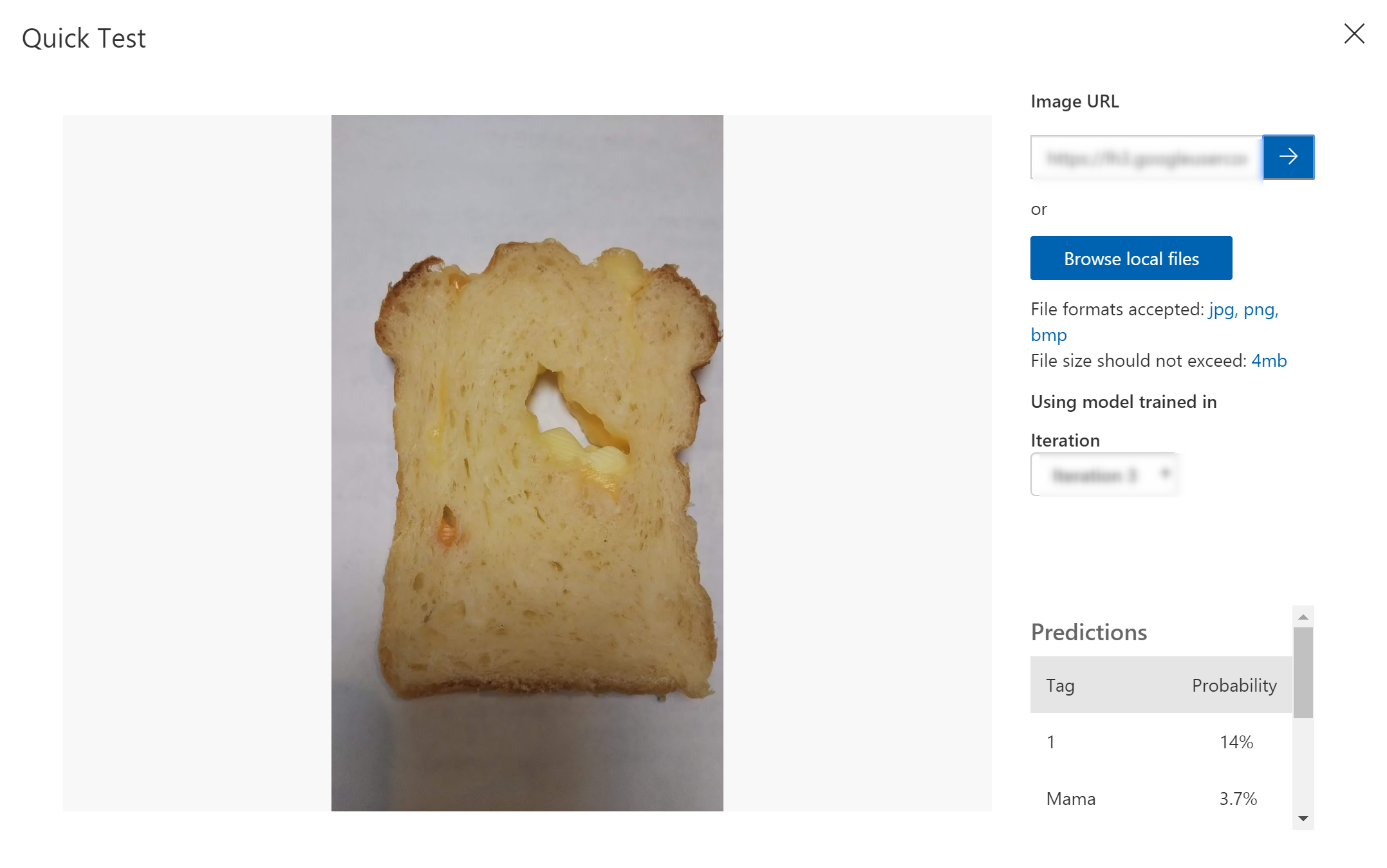

かといって食パン=1になるわけではないようで、1枚のパンは14%くらいしか精度はありませんでした。

まとめ

当たり前だし、巷でも言われていることですが、あらためて機械学習はサンプルの質が重要だということが体感できました。今回の場合は、食パンという素材の質感が非常にKEYとなりましたが、画像認識で何を識別するかによって違うと思うので引き続きいろんなもので実験してみたいと思います。

クリスマスだけに今晩はパネトーネでチャレンジしてみようかな。