こんにちは。

株式会社ワントゥーテンという会社で空間演出エンジニアをやってるまるです。

TouchDesigner Advent Calendar 2024 24日目は、

「OAK-DカメラをTouchDesignerでの始め方講座」です!

軽く去年の記事でも概要に触れていましたが、まだ触ったことのない方へ向けて、OAK-Dカメラの魅力やTouchDesignerでの利用方法について詳しくご紹介していきます。

※記事内で使用されている画像や動画は全て引用元に著作権が帰属します。

1. OAK-Dとは?

DepthAIプラットフォームの概要

OAK-Dは、Luxonis社が開発したDepthAIプラットフォームを基盤とした空間AIカメラであり、深度データ、AI推論、RGBカメラ機能を一体化したデバイスです。

これにより、1台のカメラでさまざまなデータをリアルタイムで取得し、処理できるのが大きな特徴です。

OAK-Dの主要機能

OAKカメラは主に以下の機能を備えています。

-

RGBカメラ: 高解像度な映像を取得可能で、カラー映像と深度データを組み合わせた多様なアプリケーションに対応します。

-

ステレオデプス: 左右のカメラからの映像を用いて高精度な深度マップをリアルタイムで生成します。この機能により、対象物の距離や形状を正確に把握可能です。

-

AI推論: 内蔵されたMyriad X VPUにより、物体認識やポーズ推定などのAI推論をオンデバイスで実行します。これにより、外部サーバーに依存せずリアルタイム処理が可能です。

OAK-Dカメラはたくさんの種類がありますが、基本的に上記機能はどの製品にも備わっています。

その他、USB版以外にPoE版。広角レンズ版、ドットプロジェクター、低照度IR対応のPro版なども販売されています。

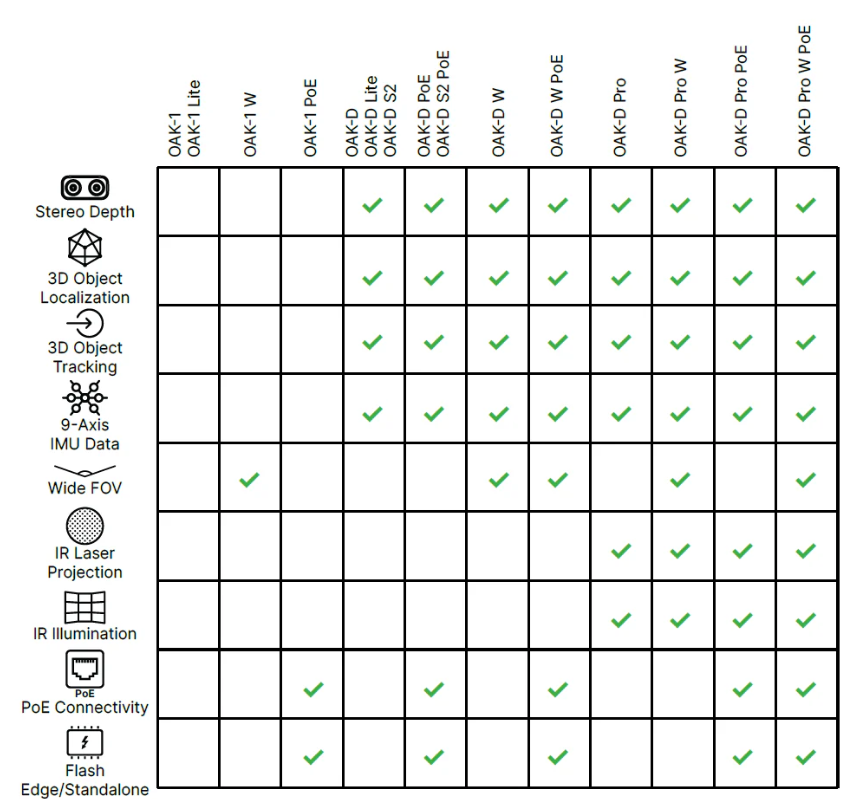

ハードウェア比較表

以下が一般的なデバイスの比較表です。

(追記)OAK-D Liteには9軸IMUは内蔵されていないはずです。

OAK-D LiteはOAK-Dと異なりRGBカメラも35fpsまでしか出ませんので、同列に併記してる辺り 「あくまでざっくりとした表」 と理解いただいたほうがいいかもです。

また、こちらの表には記載がないですが、ステレオデプスより震度情報を高精度で補足したいユースケースの為に、ToF版も公式サイトでは販売されています。

但し、後述のTouchdesignerで使えるオペレータとしては深度モデルをサポートするカメラの Time-of-Flight バージョンは、2024年現在開発中とのことです。

会社で使う分にはProシリーズ、

個人で軽く触ってみたい方にはLiteシリーズがおすすめです。

私は2021年にKickStarterで販売開始されたときにSuperEarlyで買っていたので、なんとこのLiteシリーズが1万円ちょっとで買えました。

今はスイッチサイエンスで2.7万円ほどになっていますが、それでも3万以下でこのカメラのエントリーモデルを変えてしまうのは本当に驚異的です。

具体的に何ができるのか、次項でみていきましょう。

2.すぐに使えるライブラリ群を一部紹介

OAK-Dには充実したライブラリがそろっている為、この空間AIカメラを購入するだけですぐにAI推論を使ったカメラ処理が可能になります。

以下に幾つかできることのサンプルを紹介していきます。

ラベル付けされたオブジェクトの3次元座標認識

テキストOCR検出

ラベル付け人物推定

年齢・性別推定

感情認識

ハンドトラッキング

ハンドジェスチャー認識

姿勢推定

人混み推定

顔検出ぼかし

マスク着用検知

ソーシャルディスタンス推定

火災検知

はい。めちゃくちゃありますね。

ここに書いたものでもまだまだ一例ですが、デバイス一つ買うだけでこれだけのことがインスタレーションに組み込めるようになります。

ワクワクしてきませんか?

いいですね、では早速使い方をみていきましょう!

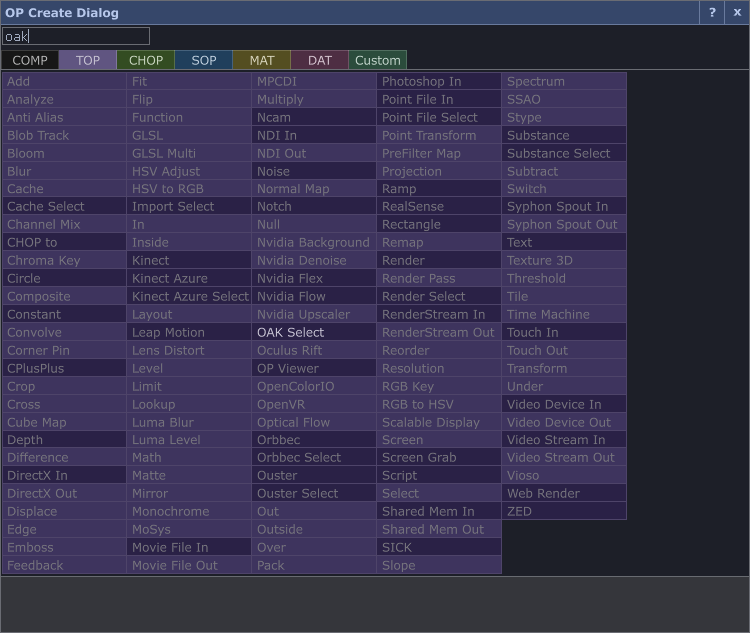

3. TouchDesignerで利用可能なOAK-D関連のOP

Touchdesignerでは、昨年2023年12月のTouchDesignerバージョン2023.11290アップデートで、OAK-D対応の新しいオペレーターたちが満を持して登場しました。

それまではdepthai-experimentsやdepthai-pythonといったライブラリ群を使ってコードベースで導入をするしかありませんでしたが、このアップデートによりノードベースで以下の機能が利用可能になりました:

- OAK Device CHOP: OAK-Dカメラからデータを取得し、リアルタイムで管理。

- OAK Select CHOP: 深度データやAI推論結果を選択し、TouchDesigner内で利用可能。

- OAK Select TOP: RGB映像や深度データをTexture Operatorとして扱い、映像処理に活用。

それぞれ詳しく見ていきましょう。

3-1. OAK Device CHOP

概要

OAK Device CHOPは、TouchDesignerとOAK-Dカメラを接続するための基本的なオペレーターです。このCHOPを通じて、カメラデバイスを初期化し、データを取得します。後述の2つのOPに情報を渡すために、最初に使うやつになります。

Parameters - OAK タブ

-

Active

- このパラメーターをオンにすると、OAK Device CHOPがアクティブになります。

-

Sensor

- ドロップダウンリストから接続されているOAK Deviceを選択します。内部的にはMXIDという固有のデバイスIDや、IPアドレスによる指定も可能です。

-

Refresh Sensor List

- 利用可能なセンサーのリストを更新します。新しく接続されたデバイスをリストに反映させる際に使用します。

-

Initialize

- OAK Deviceを初期化します。このプロセスにより、デバイスが使用可能な状態になります。初期化に成功すると、createPipeline()コールバックが実行されます。

-

Start

- デバイスのデータストリームを開始します。

-

Play

- TouchDesignerがカメラからの新しいメッセージを処理するかどうかを切り替えます。

-

Go to Done

- 特定のプロセスが完了した際にPulseされます。

-

Callbacks DAT

- このOAK Device CHOPに関連付けられたコールバックを含むDATへのパスを指定します。OAK Device CHOP追加時に自動的に生成されます。

Parameters - Stream In タブ

概要

Stream Inタブは、TouchDesignerからOAKカメラへ画像ストリームを送信する設定を行います。ここでは、送信するストリーム名、頻度、そして送信する画像のTOPオペレーターを指定できます。

-

Name stream0name

- 送信するテクスチャのストリーム名を指定します。このストリームはDepthAIパイプライン内で、XLinkInノードを作成して初期化する必要があります。

- 例:

stream0nameに「stream0」などの名前を指定し、この名前でテクスチャが受け取られるストリームを作成します。

-

Frequency (Hz) stream0frequency

- 送信するテクスチャの送信頻度(Hz)を指定します。このパラメーターにより、画像がOAKカメラに送信される間隔が決まります。

- 例: 30Hzに設定すれば、1秒間に30回画像が送信されることになります。

-

TOP stream0top

- 送信する画像が含まれるTOPオペレーターを指定します。このTOPオペレーターにある画像が、指定された頻度でOAKカメラに送信されます。

- 例:

stream0topに「myTOP」と指定すれば、そのTOPオペレーターの画像が送信されます。

注意事項

- ストリーム名が空欄の場合、画像は送信されません。

- TouchDesignerでは、送信前に自動的にBGR形式に画像を変換しますが、他の形式が必要な場合は、DepthAIパイプライン内のImageManipノードを使用して変換を行います。

3-2. OAK Select CHOP

概要

OAK Select CHOPは、OAK Device CHOPから取得された複数のデータストリームの中から特定の信号を選択して抽出するためのオペレーターです。

例えば、深度マップデータや物体検出結果をCHOP形式でTouchDesigner内に取り込む際に使用します。

Parameters - OAK タブ

-

Active

- このパラメーターをオンにすると、OAK Select CHOPがアクティブになります。

-

Device

- データを取得する対象のOAK Device CHOPを指定します。

-

Signal Name

- 抽出したいデータストリームの名前を指定します。 OAKD Device CHOPのCallbacksスクリプト内で記述されているhoge.setStreamName("depth_map")のようなストリーム名を指定します。

-

Play

- CHOPのデータ取得を再生または停止します。

-

Callbacks DAT

- このOAK DSelect CHOPに関連付けられたコールバックを含むDATへのパスを指定します。OAK Select CHOP追加時に自動的に生成されます。

3-3. OAK Select TOP

概要

OAK Select TOPは、OAK Device CHOPから受信した映像のRGBフレームデータや深度マップなどの画像ストリームを選択し、TouchDesigner内で利用可能にするオペレーターです。

これにより、ビジュアルデータをTOPネットワークでそのまま処理することができます。

Parameters - OAK タブ

-

Active

- このパラメーターをオンにすると、OAK Select TOPがアクティブになります。

-

Device

- データを取得する対象のOAK Device CHOPを指定します。

-

Stream Name

- 抽出したいデータストリームの名前を指定します。 OAKD Device CHOPのCallbacksスクリプト内で記述されているhoge.setStreamName("rgb")のようなストリーム名を指定します。

-

Cache Size

- Queue Sizeパラメーターに相当します。2を選択すると、新しいデータを書き込みながらユーザーに画像を非同期的に表示できます。

-

Output Index

- Cache TOPのOutput Indexパラメーターを模倣しています。より複雑なDepthAIパイプライン(例: ハンドトラッキング)を使用する場合、トラッキングデータがRGB画像よりも遅れてTouchDesignerに届くことがあります。負の値を指定することで、画像を遅延させ、トラッキングデータと同期できます。

6, Limit Max

- ストリームが深度画像(かつストリーム名に"depth"が含まれる場合)である場合、最大の"z-depth"を制限するのに役立ちます。この値はメートルで測定されます。

-

Output Format

- TouchDesignerでDepthAIがまだ提供しない基本的な画像処理を適用できます。例えば、Output Formatが"Point Cloud"で、ストリームが深度ストリームかつストリーム名に"depth"が含まれる場合、OAK Selectで取得された画像は深度画像とカメラの内因性行列を基に生成された32ビットのXYZポイントクラウドになります。

4.基本的な使い方

サンプルのtoeはC:/Program Files/Derivative/TouchDesigner.2024.xxxxx/Samples/OAKに含まれています。

ここではOAK-D Liteを使って簡単な使い方を説明します。

試しに具志堅用高さんのボクシングの動画で姿勢推定を行ってみましょう。

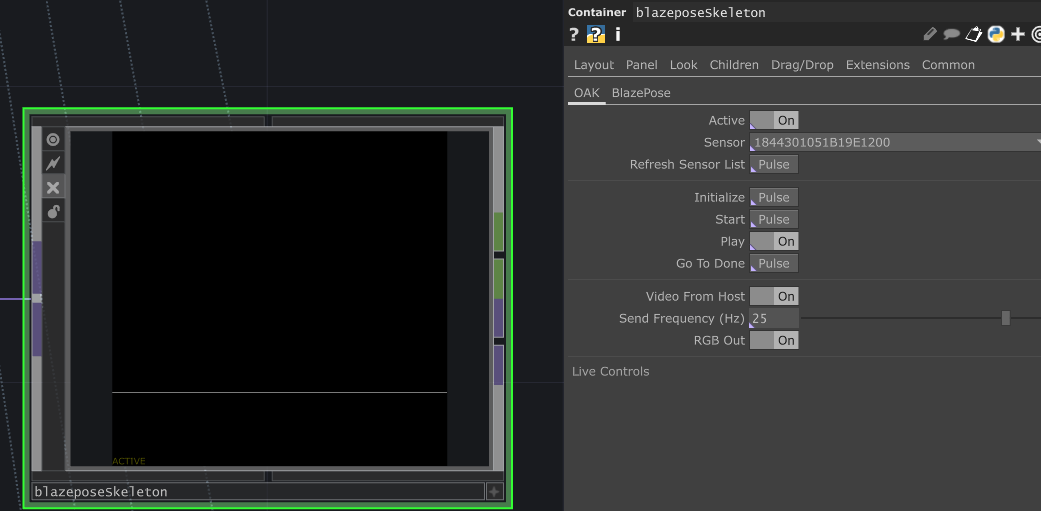

今回使うのはこちらの blazeposeSkeleton です。

4-1.デバイスを接続する

USBケーブル(もしくはPoE)にてPCにOKA-Dカメラが接続されていると、sensorにデバイスのリストが表示されます。繋がっているはずなのに表示されない場合は、再接続してRefreshしましょう。

cameraのデバイスが選べたら、Startを押します。

Initializeは押さなくてもStartを押したら一緒に動いてくれます。

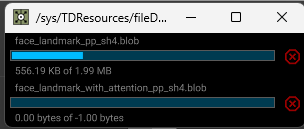

初めて押すときは、以下のような形でblobファイルのダウンロードが行われます。

blobファイルは、YOLOなどのNNモデルデータになります。

Touchdesigner上でOPをポチポチやるだけで必要なモデルデータをDLしてくれるのは有難いですね。

お手持ちのPyTorch (ONNX) / TensorFlow / Caffe / OpenVINO ZOO モデルなどがあれば、こちらのサイトでOAK-Dカメラに使えるblobファイルにWeb上でConvertしてくれます。

4-2.デバイスの初期化とストリーミングを行う

作業に戻りましょう。

Startボタンを押すと、まず最初に左下に黄色の文字でINITIALIZINGと表示されます。

少し待つと緑色のRUNNNING(playing)に切り替わります。

何も表示されないように見えますが、中ではしっかりとうごいています。

In TOPで処理したい映像を渡してあげる必要があるので、再生したいTOPを繋ぎます。

出てきましたね。

たったこれだけです。簡単でしょ?

5.中身の説明

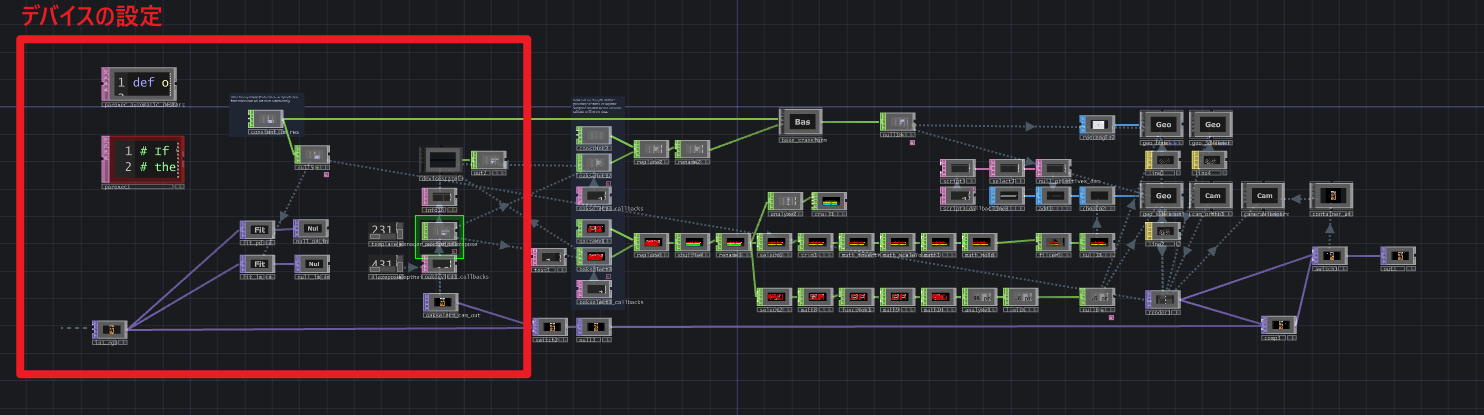

blazeposeSkeleton COMPの中身は以下のようになっています。

多少の違いはありますが、大まかな流れは一緒なのでこれを使って軽く説明します。

5-1.デバイスまわりの設定

まず、左の赤枠部分でデバイスの設定を行っています。

元ソースはこちらのgeaxgx氏のリポジトリにありますが、同じ処理をOAK Devic CHOPのCallbacks DATに絡める形で追記されています。

入力されたソースを、指定された解像度にダウンスケーリングして処理させています。

defaultの値は1152x648になっています。

4Kなどで行いたいときには、それなりのCuDA対応GPU搭載PCが必要になります。

5-2.姿勢データの取得

続いて真ん中の赤枠部分で、主に姿勢座標の推定や変換を行っています。

manager_outというストリームを取得し、

元のサンプルから⑤番目のサンプルごとに取得して5個のチャンネルに分けて形成しています。

上から、順にtx,ty,tz,presence,visibilityをあらわしますが、visibikityは使われていません。

レンダリング時に使用されている値は4つです。

5-3.合成し最終結果を出力

最後に、アウトプット処理です。

元の動画フレームと合算させています。

同様の手順で、他のCOMPも試せます。まずはいろいろ弄ってみましょう。

慣れてくると、この辺りのドキュメントを参考にcallbacks DATの中を自分で弄りまわすのがオススメです。

いろいろ組み合わせてみると楽しいです。

6.みんなも空間センシングやろうぜ

ということで、今回はTouchdesignerでのOAK-Dカメラを利用してみようチュートリアルでした。

今年のアドカレもイブ狙ったらまさかの比嘉さんとTsumikiRoomさんに挟まれてました。

具志堅さんは沖縄繋がりで選んだことにしときます。(後付け)

どなたかのお役に立ちましたなら幸いです。

また、弊社ワントゥーテンでは一緒にぶっとんだものをつくってくれる

エンジニアの方を募集しています!

求人されてない職種でも面白い人は特別枠でとってもらえるので、我こそはという方は是非チャレンジください!

リファラル採用も行っておりますので、

ブログ記載の連絡先にコンタクト貰えればお繋ぎも可能です😊

ということで明日はうちの上司、TsumikiRoom先輩の記事になります!乞うご期待✨

お読みいただきありがとうございました~。