目次

- 人工知能の歴史と変遷(研究の方向性と順序の再確認)

- はじめに(Show and Tellとは)

- LSTM(Long Short Term Memory)とは?

- RNN(Recurrent Neural Network)の問題点

- LSTMの特徴: Forget Gate(忘却ゲート)

- 参考資料

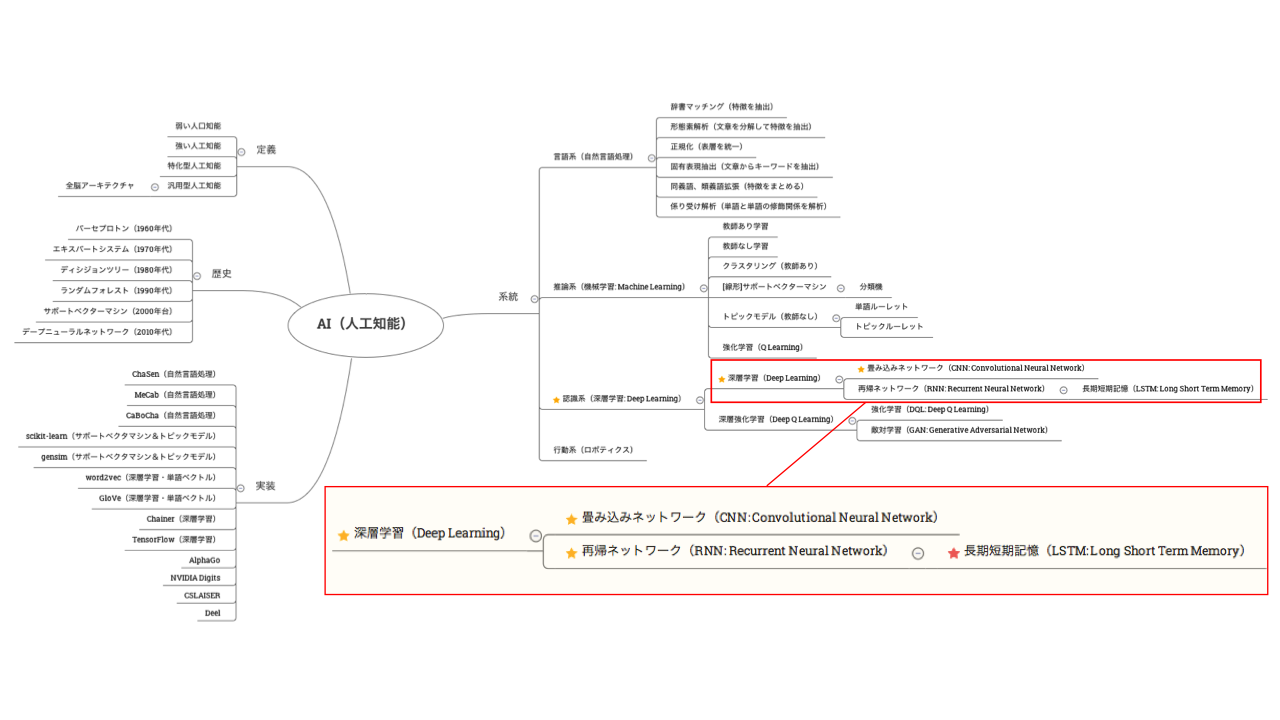

人工知能の歴史と変遷

はじめに

Show and Tellとは?

主に北米で行われる教育科目の一つで、オーストラリアでも一般的である。普通は、小学校の低学年の授業で実施され、小さな児童に公述のスキルを教えるための技術である。たいてい、児童はなにか家からひとつ道具を持って行き、みんなに「なぜその道具を特に選んだか、どこで手に入れたか、その他、関連する情報」について説明する。Wikipediaから引用

Show and Tell: A Neural Image Caption Generator

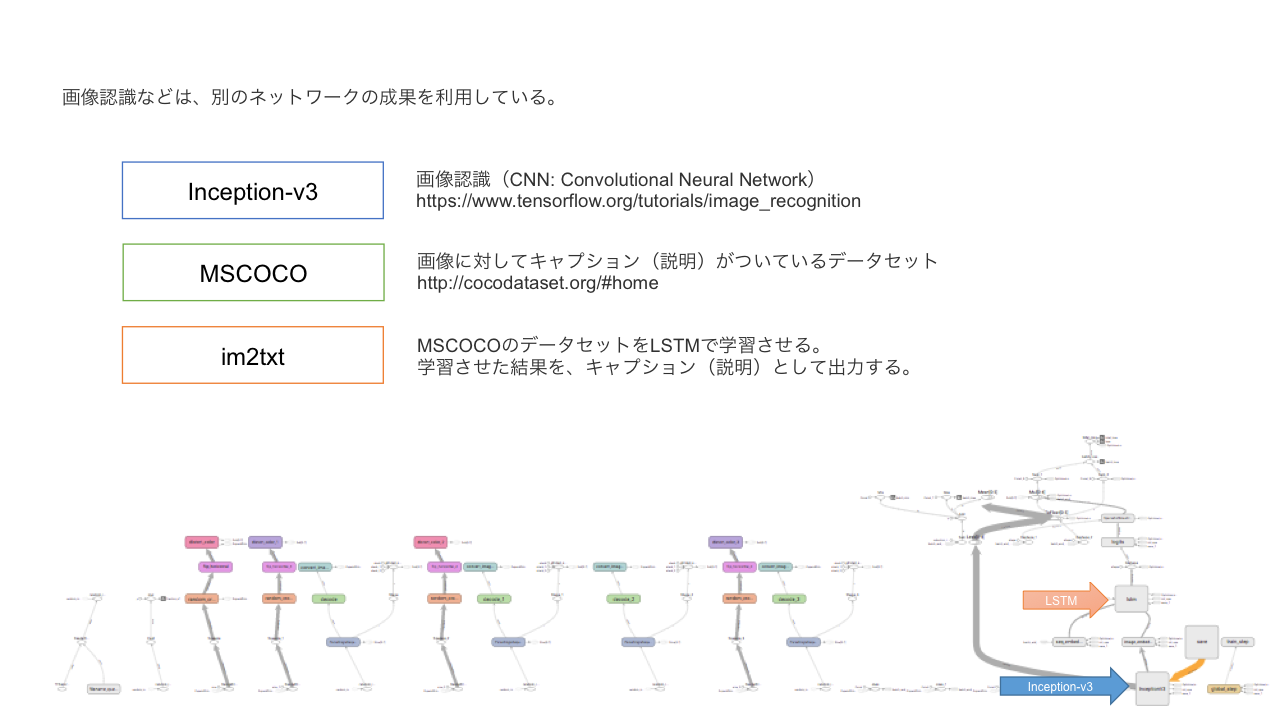

どんなネットワークなのか

LSTM(Long Short Term Memory: 長・短期記憶)とは?

CNN(Convolutional Neural Network)と、RNN(Recurrent Neural Network)のおさらい

- CNN: 画像識別などに適する

- RNN: 音声、言語、動画などの系列データに適する

RNN(Recurrent Neural Network)の問題点

- 10分程度の短期的な記憶保持することができるが、勾配消失が大きい(爆発するか、消滅するか)

- 例)短期的な株価の予測には適しているが、長期の経済成長を見越した判断などには不向き。

- 例)チャットボッドなど、短期間では、矛盾がないような会話ができても、一時間前に話した内容を加味することが難しい。

LSTM(Long Short Term Memory)の概要

- 上記、RNNの問題点を克服し、長期にわたる記憶を実現する方法の一つ。

- 基本的な入出力層は、RNNと同じで、中間層がメモリユニットというものに置き換えられる。

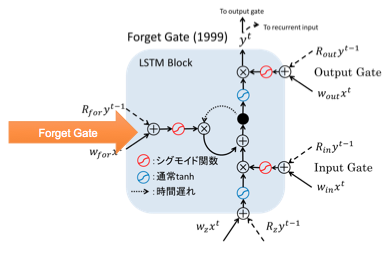

LSTMの特徴:Forget Gate(忘却ゲート)

LTMSの変遷

- Original 95,97 Hochreiter & Schmidhuber

- Forget Gate 99 Gers & Schmidhuber

- Peephole Connection 00 Gers & Schmidhuber

- Full Gradient 05 Graves & Schemidhuber

メモリユニット内のForget Gate

RNNの中間層を増やせば、永遠に記憶させることも可能だが、

ただ長く保持すれば良いということではないので、適切に解放する必要がある。

これにより、より長い文脈を捉えた、推定が可能になる。