はじめに

inscapeさんが企画運用されているAPS〈組込みCPU比較検討プラットフォーム〉で、BLIP2の研究員を募集されてましたので、興味があったため参加いたしました。

以下では、この募集の課題である「クラウド環境へBLIP2のデータをあげてみる」のクリアを最終目的に、ADZS-BF707-BLIP2を使ってみた際の作業記録です。

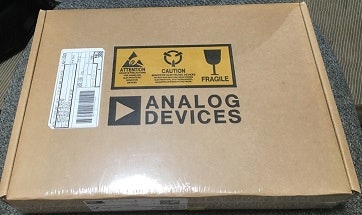

開封

まずは開封。思ったより大きい箱でとどきました。

中には、ボード本体以外に、ACアダプターやケーブル、ICE-1000 emulatorに三脚等が入っていました。

説明書類は1枚だけで、Webから取得しろとのこと。開発環境のCrossCore Embedded Studioの180日評価ライセンスのIDが書かれた紙も入っていました。

準備

次に、必要なソフトウェア一式を落としてきます。

- CrossCore Embedded Studio

- ソフト開発しなくても、ファームウエアの書換等で必要になります。

- BLIP2 Board Support Package

- CrossCore Embedded StudioをBLIP2のボード向けに設定するのに必要になります

- ADVisionSensorController GUI

- BLIP2を試すのに必要なアプリケーション

次に、CrossCore Embedded Studioをインストールし、以下のマニュアルに沿ってCrossCore Embedded StudioをBLIP2用に設定します。

- ADZS-BF707-BLIP Board Evaluation System Manual

BLIP2のボードとICE-1000をつなげるとこんな感じ。

この際、PCと接続されるUSBケーブルの数は3本(mini 2本にmicro 1本。mini 2本はセットに同梱されているが、microは別途用意する必要があり。ただし、ACを使用すれば不要かもしれない。試してないので想像。)になるのに注意です。

ファーム書換しない、通常利用時はICE-1000はいらないので、USBケーブルは2本になります。

試しに使ってみる

ADVisionSensorController GUIをインストールして、実際につかってみます。基本的な操作は、「CMOSセンサーのコンフィグレーションを変えてみる」をみると理解できます。

ただ、最初につまづいたのは、動画にあるように「Enable VOS」ボタンを押してみても矩形での動体認識がでない状態でした。

※これを解決するのに非常に時間がかかってしまいました。。。

アプリについてきたUserGuideを読んでみたところ、検出モードには「VoS(Video Occupancy Sensor)」と「IoS(Indoor Occupancy Sensor)」の2つがあるようで、矩形で検出物を表示するのはVoSの時のようです。

いま、どちらが採用されているかは、キャプチャー画面の右上のアイコン形状で区別できるとのこと。

VoSの時は色付きバーが表示され、

IoSの時はランプ型のアイコンが表示されるとのこと。

結果、現状はIoSで動作していることがわかりました。では、どのようにVoSに変更するのか、またUserGuideとにらめっこしたところ、Firmwareを入れ替える必要があることに気が付きました。

UserGuideに従ってFirmwareの入れ替えをすすめ、デフォルトのフォルダー(Flash)配下の"VOS_Outdoors_realtime_BLIP2.dxe"に入れ替えることで、無事に矩形表示が現れました。

Firmwareの入れ替え時ですが、GeneralConfigurations.xmlにあるCCES_versionタグの値を、インストールしたCrossCore Embedded Studioのバージョンに変更しておく必要があります。私の場合は、2.1.0となっていたので 2.6.0としました。

検出するものを決める

BLIP2のアルゴリズムはいじらず、そのまま利用できそうな例として以下をを考えてみました。

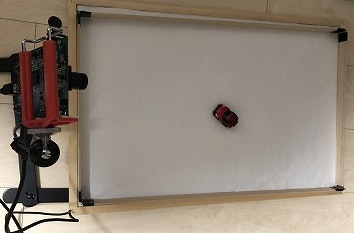

「TOMYのチョロQ Q-eyesを走らせて、その動きをモニタリングしてみる。」

チョロQを用意した走行フィールド上を走らせ、BLIP2で認識してみたところ、うまく認識されているようですので、このBLOB情報をSPIで繋げたArduinoから取得してみようとしました。

※ただ、先に結果を書いておきますと、BLOB情報をSPIで取得することができずにまだ実現できておりませんm(_ _)m

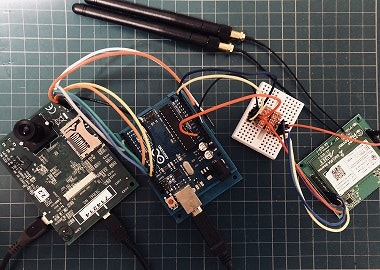

Arduinoとの接続

これについては、マイコン(Arduino)とBLIP2をSPI接続してみるの内容を参考に作業しました。

とりあえず試したい!という場合は、このサイトから対応Firmwareがあがっているのでそちらを使えばよいです。

まずは、公開されているスケッチ(APS_BLIP2.ino)をそのまま使うことで「Occupancy」の値を取得することができました。次に、このスケッチを改良して、BLOB情報を取得してみようと思いました。

SPIの仕様は、Video Occupancy Sensor, Blackfinのインストール先のdocフォルダに

- SPI_Communication_Protocol.pdf

に書かれていました。

これを参考にスケッチを改良してみたのですが、残念ながら、上手く動かすことができませんでした。

※SEND BLOB INFOを送信しても、トリガーの割り込みが発生しない状態

今回はクラウドにデータをあげるところまでをやってみることですので、ここで詰まっていても仕方ないため、以降は「Occupancy」のデータをあげてみることに方針転換しました。

クラウドにデータをあげる

次に、BLIP2から取得したデータをクラウドにあげてみます。

まず最初に思いついたのは、Azure IoT HubにMQTTでデータをあげる方法です。これを実現するために、ESP-WROOM-02を使用しようと思い、手持ちのBoard1をArduino IDEで使用できるようにして、サンプルのスケッチを試してみました。

しかしながら、結果としてはサンプルのスケッチは動作しませんでした。トリガーの割り込みが上がってきませんでした。

他の手を考えてみたところ、手持ちのものではクラウド環境へBLIP2のデータをあげてみると同等のさくらのIoT Platform βがあったので、これを使ってみました。

手持ちは、sakura.io シールド for Arduinoではなく、ブレイクアウトボード(検証ボード)だったため、Arduinoで使用するためにI2Cのレベル変換(5v <-> 1.8v)をロジックレベル双方向変換モジュールを使って行いました。

運用する場合は、Arduino UNOを小型のArduino Pro Miniにすれば、すべてを評価ボードの裏側に実装できるかと思います。

※J2のWSNピンが逆向きならよかったのですが

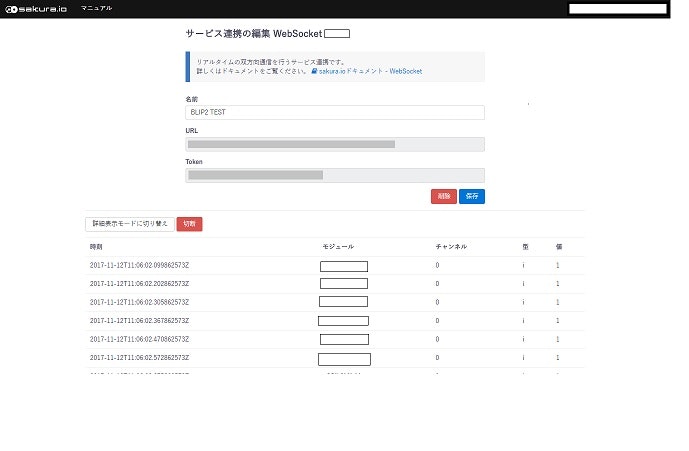

ここから先は簡単で、まずは、sakura.ioのWebサイトでモジュールを登録、WebSocketのサービスを作成して表示しておきます。

次に、サンプルのスケッチ(BLIP2_IOT.ino)をArduinoに書き込み起動し、sakura.ioがオンラインになるまで待ちます。その後、BLIP2のアプリを動作すると、以下のようにOccupancyの値が表示されました。

最後に

sakura.ioを使えば、APSさんが公開されているサンプルを使って、BLIP2からの情報を非常に簡単にクラウドに繋げることができました。

一方、他の方法だといろいろと対応が必要になる感じです。が、あまり時間がとれずに根本解析を行っていないので、もう少し時間をかければ解決できると思います。

また、VoSとIoSのようにBLIP2本来の用語や操作方法についての情報がもう少しあると発想が広がるかと思いました。