概要

DFPC: Data flow driven pruning of coupled channels without data.

- 概要:DFPC. データ無し枝刈りで枝分かれネットワークに対応

- 新規性:枝分かれに対応したSaliency(チャネル毎の重要度)を求める。

- キモ:Algorithm1で計算する。

- 評価:ResNetで実験した。

Globally Optimal Training of Neural Networks with Threshold Activation Functions

- 概要:Threshold activation (ReLU6など) 付きのネットワークの学習方法

- 新規性:Threshold activation付きのネットワークの最適解を学習する方法を与えた。

- キモ:重み正則化付きLASSOで学習する。(15)式のように変換して最適化する。

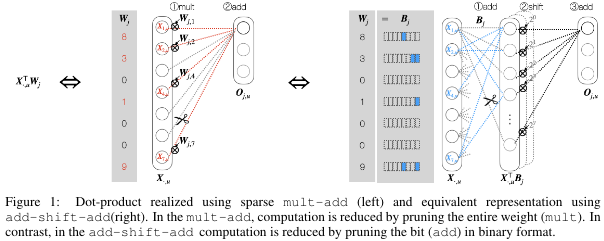

Bit-Pruning: A Sparse Multiplication-Less Dot-Product

NTK-SAP: Improving neural network pruning by aligning training dynamics

- 概要:NTK-SAP. Foresight pruning (学習前枝刈り)

- 新規性:NASで使われているNeural Target Kernelを用いた枝刈り

- キモ:最適化では収束速度はHessianの最大・最小だけではなく固有値の分布に依存することを参考にして、NTKの条件数ではなく固有値スプクトラムに注目した。固有値スペクトラムをトレースノルムで近似して解いた。

- 評価:ResNet等でSNIP, SynFlow等と比較した。

Trainability Preserving Neural Pruning

- 概要:Filter枝刈りの改良

- 新規性:DNNのTrainabilityを保存する初めてのFilter枝刈り。

(枝刈りするとTrainabilityが下がる。Trainabilityが下がると学習率を小さくしないと収束しなくなるので、収束が遅くなり精度が下がる) - キモ:グラム行列が小さいフィルタは0に行くように枝刈りする。

- 評価:学習率を。0.01と0.001で変えて、ありなしで実験した。

-

画像や数式は論文から引用しています。 ↩