1つ前のDreamLIPの論文で,MLLMを使えば画像の詳細な情報をテキストで表現できると言っていましたが,MLLMの視覚能力の限界についての論文があったので読みました.

今回の論文

概要

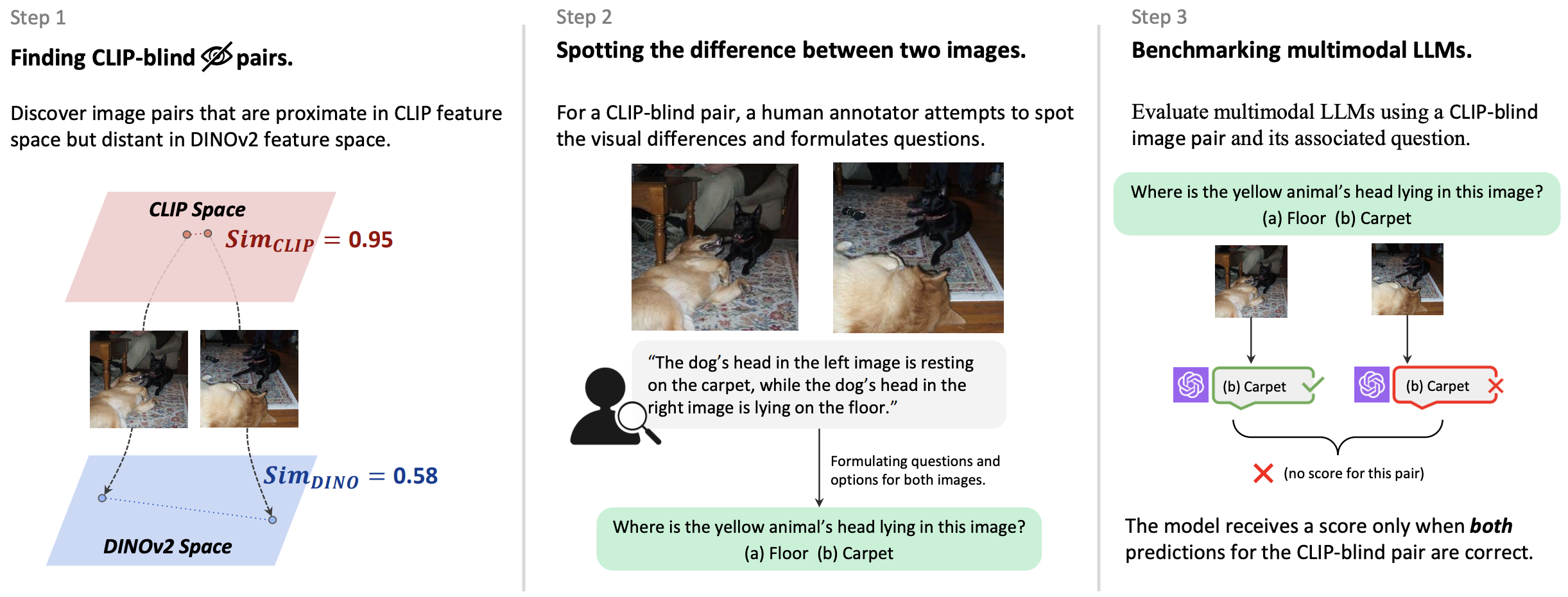

上の図はGPT-4Vに写真と写真に関する問いをして,GPT-4Vが間違えた例.人間では決して間違えないような簡単な問題でもMLLMは間違えてしまう.そういったタスクについて分析し,それに対応するアプローチも提案している.

MLLMのどこが足を引っ張っているのか

この論文ではCLIPモデルが視覚的な詳細情報を欠いている点に焦点を当て,「CLIP-blind pairs」という新たなデータセットを作成し,視覚的限界を評価するためのベンチマーク(MMVP)を構築.

- Step1 : CLIPでの特徴空間上で近い且つ,DINOv2での特徴空間上で遠い画像ペア(CLIP-blind pairs)を探す

- Step2 : CLIP-blind pairsに対して人が視覚的相違に関する問題を作成

下の表はベンチマークを様々なMLLMに解かせた結果.最も性能が良いモデルでも40%ほど.

この論文で提案されているモデル

Standard MLLMに対し,Addictiv-MoF MLLM (A-MoF)とInterleaved-MoF MLLM (I-MoF)を提案.A-MoFではCLIPに加え,事前済みのDINO Encoderとの出力をAdapterに入力.I-MoFではCLIP EncoderとDINO EncoderそれぞれについてAdapterを用意し,Adapterの出力は交互に組み込んでLMに入力.

評価

- A-MoFの評価

SSL ratioはDINO Encoderの出力を使う割合.MMVPはこの論文で提案されているベンチマーク指標.LLaVAはinstruction-following capability,要するにLLMが指示に従う能力.

Standard MLLMと比べてMMVPは高くなるが,その代わりに指示が聞けなくなるというトレードオフが発生.

- I-MoFの評価

POPEはハルシネーションの評価.

I-MoFではStandard MLLMと比べるとMMVPも向上し,instruction-following capabilityも向上している.