はじめに

この記事はAIのルールやAIガバナンスについて議論をするために書いた。ここに書かれていることを踏まえ、AIガバナンスの在り方について議論が活性化すればいいと思っている。

うりゃーーーーっと書いているところもあり、乱文であることはご容赦いただきたい。

(注)画像は著作権フリーのものをつかっているつもりですが、そうでないものがあった場合はすぐに削除しますのでその旨ご指摘ください。

議論対象の話題(ファクト)

つい最近、以下のような記事があった。

「AIとのチャットで自殺」 米国、14歳死亡で母親が提訴

https://nordot.app/1224262863134507459?c=62479058578587648

本事案に対し、亡くなった生徒の方にご冥福をお祈りするとともに、すでに母親が提訴している事案であるためその訴訟に対して論じることは避けたいと思う。

その前提で、記事に書いてあることをそのまま書くと以下のとおりである。

母親は声明で「中毒性が高い詐欺的なAI技術の危険性を訴え、企業の責任を問いたい」と強調。代理人弁護士は、AIアプリが意図的に若者をターゲットにしていると批判し「数百万人の子どもが危険にさらされる恐れがある」と警告した。

開発企業はX(旧ツイッター)で、生徒への弔意を示し「利用者の安全を重視しており、安全機能を追加し続けている」と主張した。

訴状によると、生徒は昨年4月からテレビドラマやアニメのキャラクターの性格を模したAIとチャットできるアプリ「キャラクターAI」を利用。女性キャラクターのAIから「愛してる」「私に忠実でいて」などの言葉が送信された。

議論したいこと

私が気になったのはこの記事のタイトルである。

「AI技術が自殺を誘引した」→やっぱりAI(そのもの)が危ない

みたいな言いぶりである。が、果たしてそうだろうか。

そこで、ここで使われていたアプリの仕様について改めて考えてみたい。

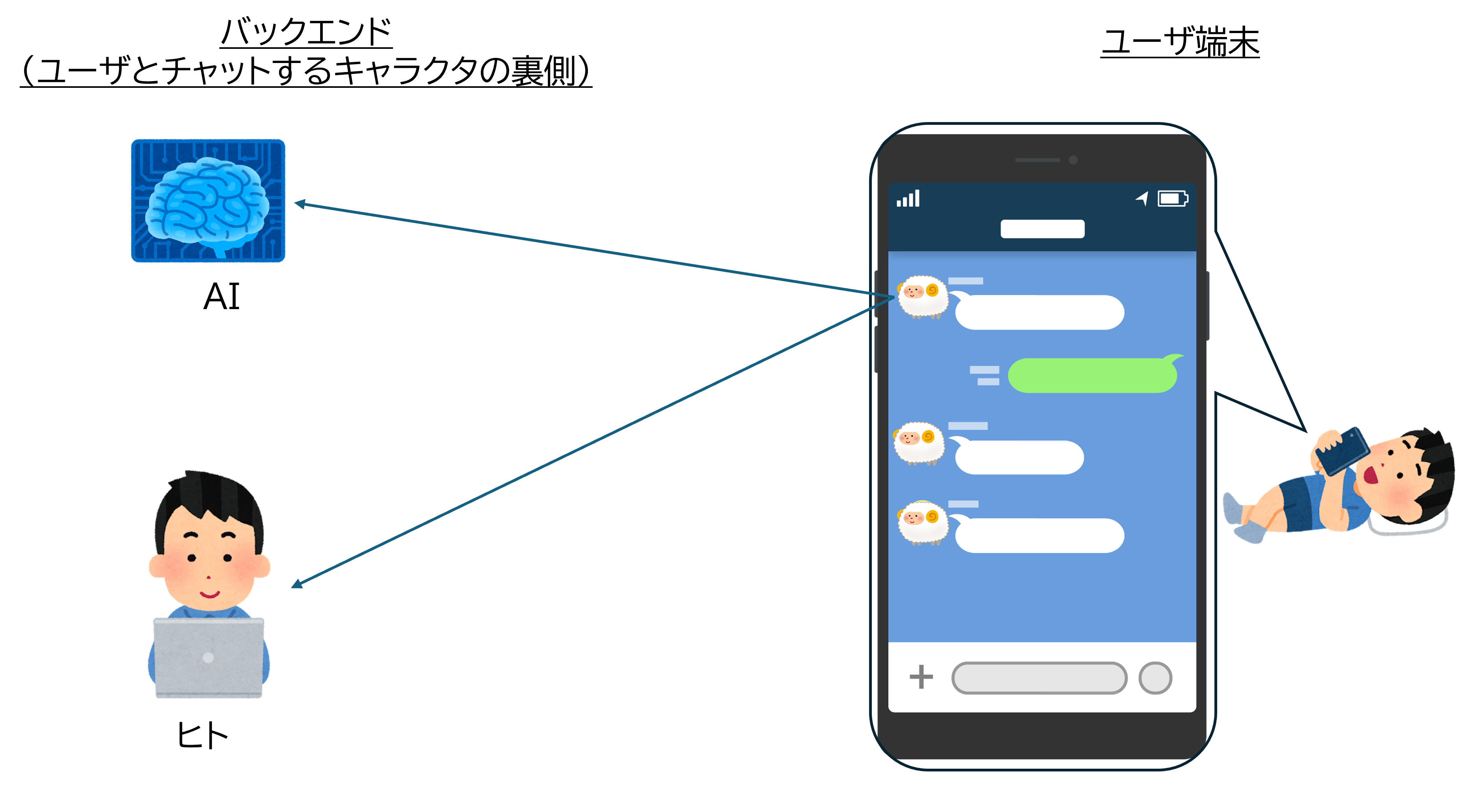

上の記事では、チャットを経由しユーザの相手をしていたのがAIだったことになっている。

が、ユーザの相手が(AIでなく)ヒトであったとしても(ユーザから見たら)同じことを行うことができる(下図参照)。

で、後者の場合、すなわち相手がヒトであった場合はこの問題を防げたのであろうか。

おそらくヒトが相手をしたとしても防ぐことはできなかったのではないだろうか。

仮に ヒトが相手をしていればこの問題を防げた というのであれば、その防ぐための術をルールとして組み込んでおけばいいだけである。例えばユーザに対し言ってはいけない言葉があるのであれば、その言葉を言わないようにするなどである。

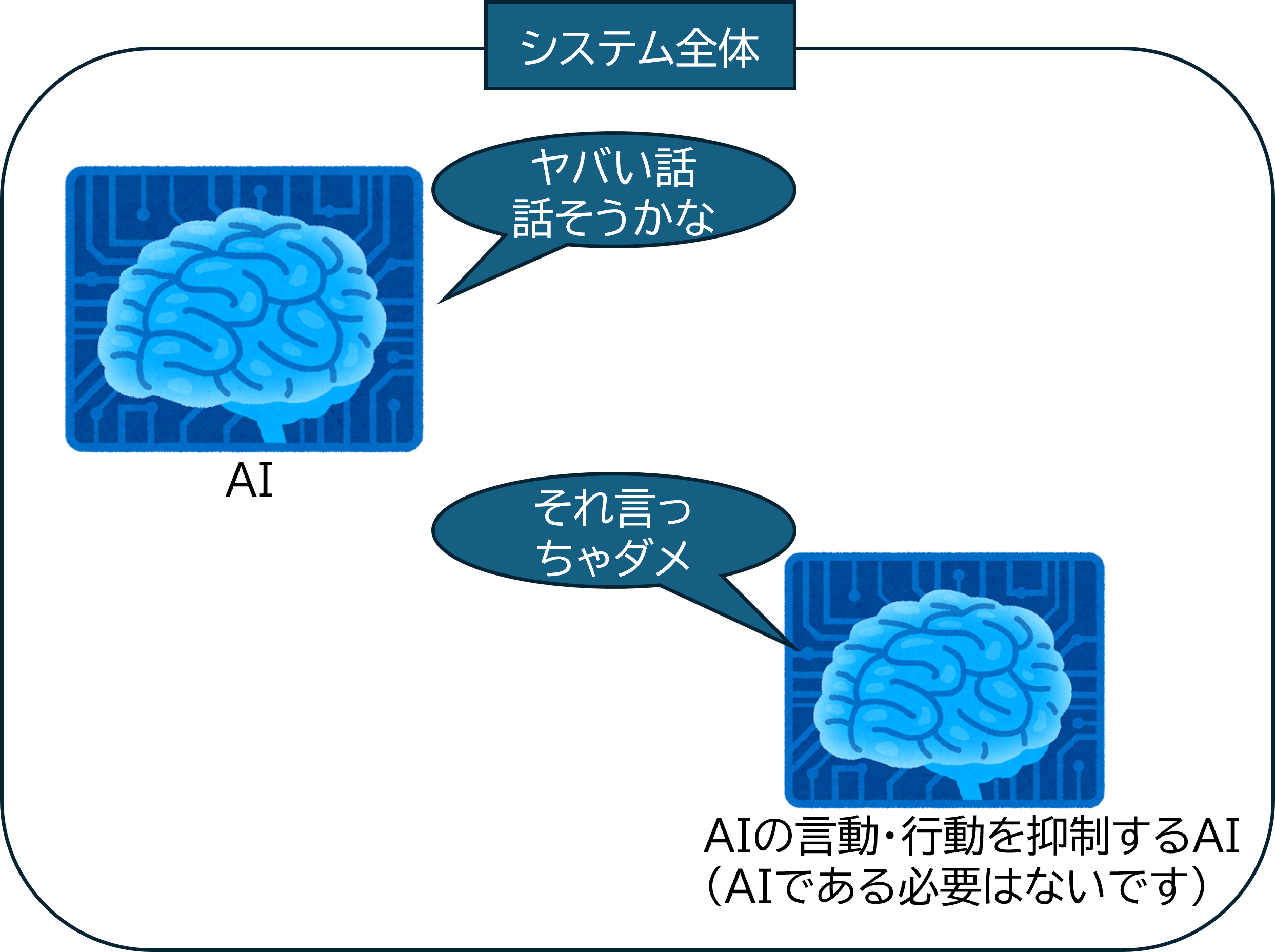

他方で、使っているAIモデルが制御不能になることも考えられなくはない。もちろんそれはそれで問題である。ただ、そうであれば、System of Systemsの考え方で、AIモデルが吐き出した反応をシステム全体で食い止めるとかすればいいだけである。そういったシステム構成にすればいいだけである。「フェールセーフ」という言葉を知っている有能な技術者であれば当然ながらそう言う構成にするはずである。

(注)もちろん、AIモデルそのものにそのような仕組みを導入してもいい。

こうやって考えていくと、

この問題はAIだから起こったというわけではなく、

どのような発言や対応が自殺を誘引する可能性があるのかがわかっていなかったら起こった(つまりAIかどうかは不問)と考えるのが自然ではないか。

おわりに

ということで…

こういった話が出てきたときに、AIだけを標的とする(特別視する)のはおかしな話ではないか。

本当にAIそのものの問題なのか、他に問題がないのか を、このような形で考え直してみることが重要ではないか。

そして、問題の本質を突き止めることが重要なのではないか。

実はこういった話は他にもあると思うので、今後も紹介していきたい。