はじめに

元々GoogleではCloudVisionという画像解析用APIが提供されていましたが、今回は動画解析APIが公開されました。(ベータ版)

アルファ版の利用には申請が必要ですが、デモ版であれば特に登録不要で利用可能です。

早速試してみましょう。

デモ版

デモ版は下記リンクから利用可能です。

Cloud Video Intelligence

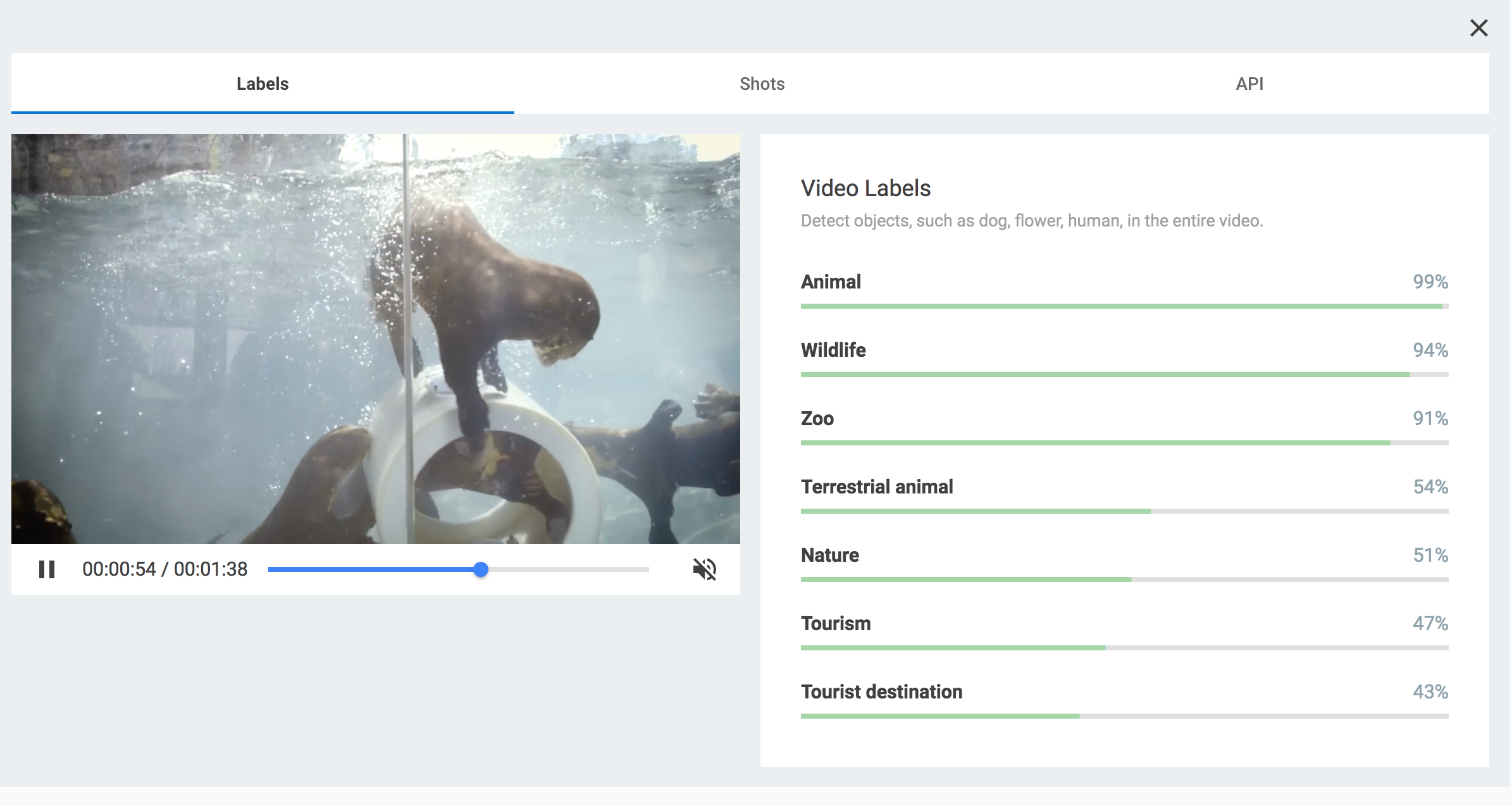

下記画像のAnimalsはデモ版用に提供されている動画なのでそのまま利用できます。これを用いて分析すると「Labels」/「Shots」/「API」の三種類の結果が出力されます。

Labels

Labelsは動画全ての中で得た要素とその信頼度を表すスコアです。

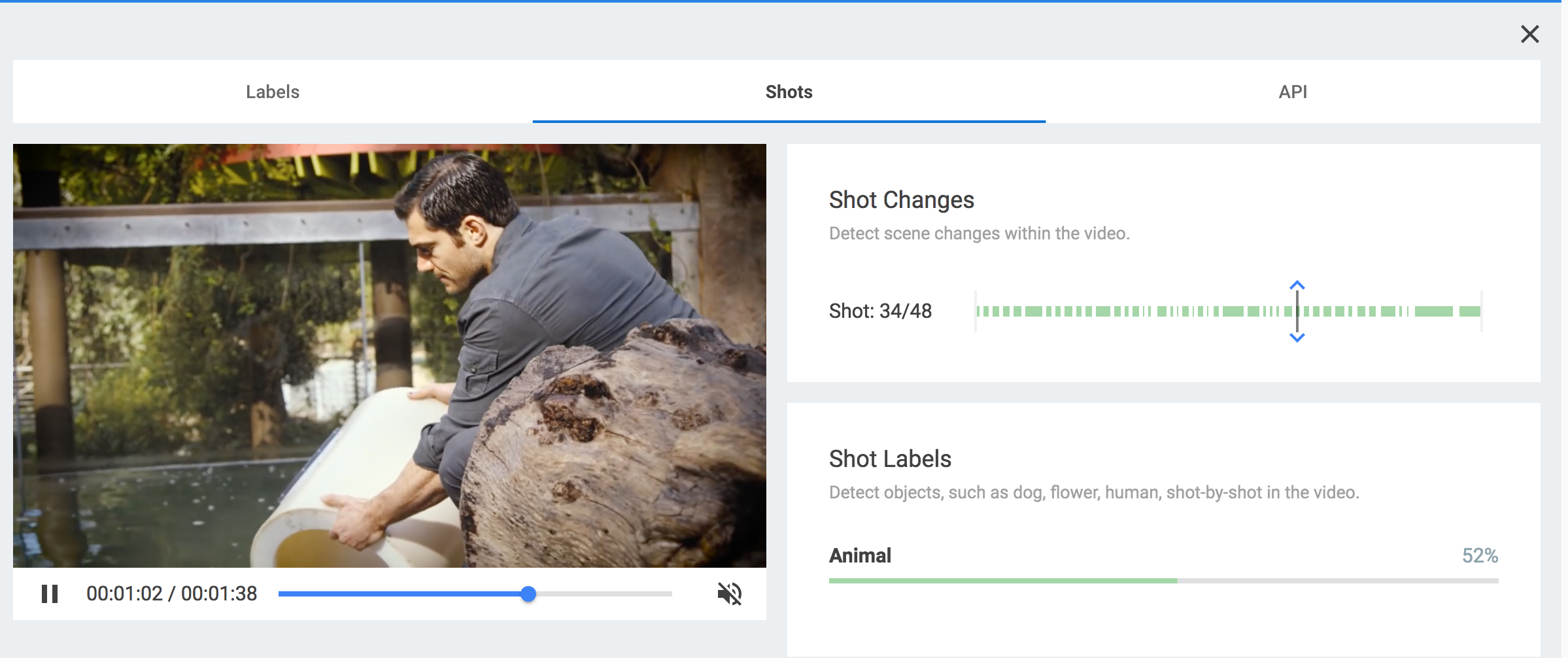

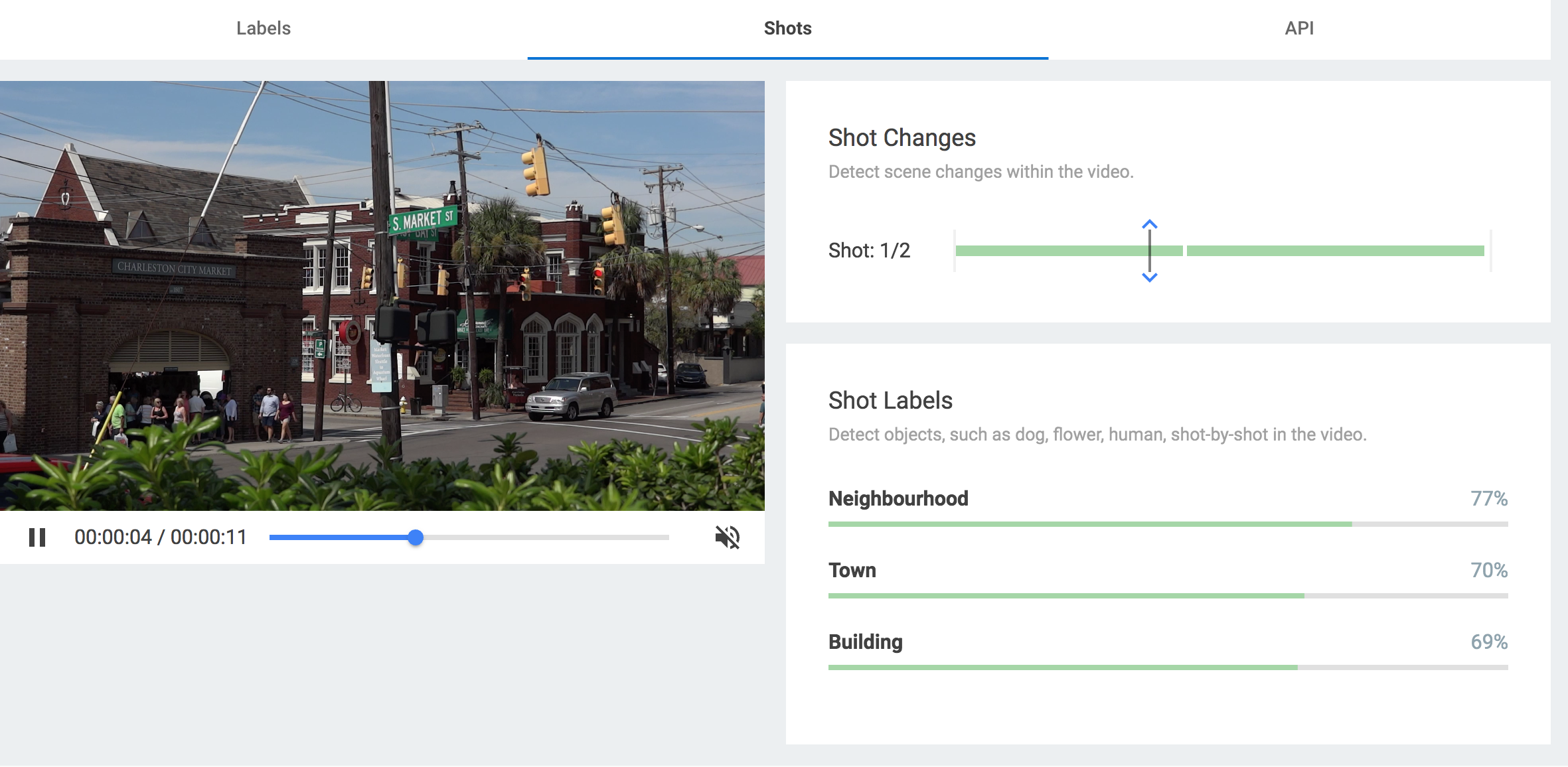

Shots

Shotsは動画の中でシーンが切り替わる毎に、自動で区切られそのシーンごとに要素と信頼度を表すスコアが出力されます。これはすごい!

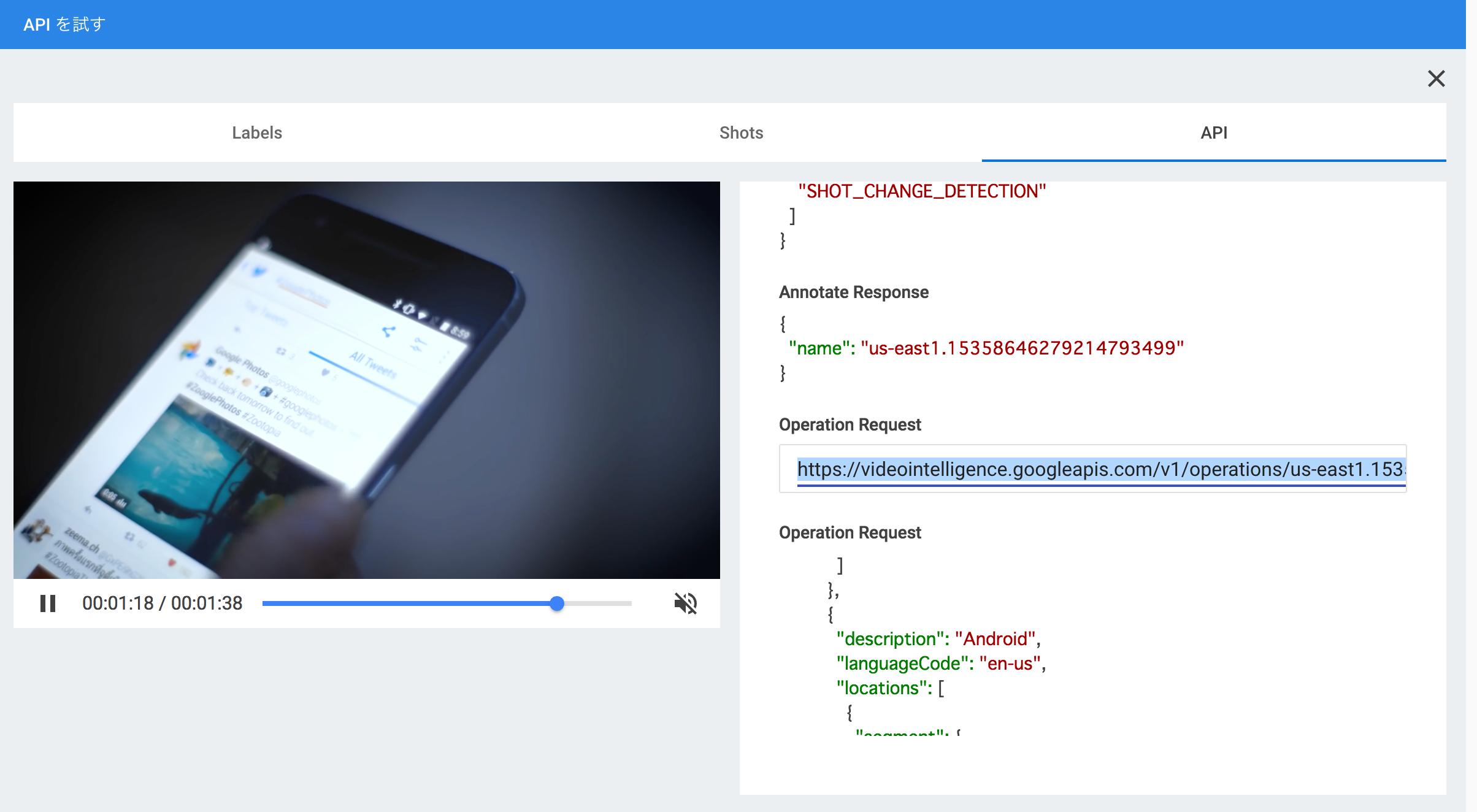

API

こちらは実際に使用する際のAPIへのリクエストと、レスポンスが表示されます。

別の動画を試す

GoogleCloudStorageへの登録は必要ですが、自分で用意した動画を試すことも可能です。GoogleCloudStorageにアップロード動画リンクのバケット名以下をコピーして「Custom Google Cloud Storage」のURL欄に貼り付けます。

※分析を行うためにはGoogleCloudStorageにアップロードした動画を必ず公開状態にする必要があります。

今回は、下記動画を試してみましょう。

検証用動画

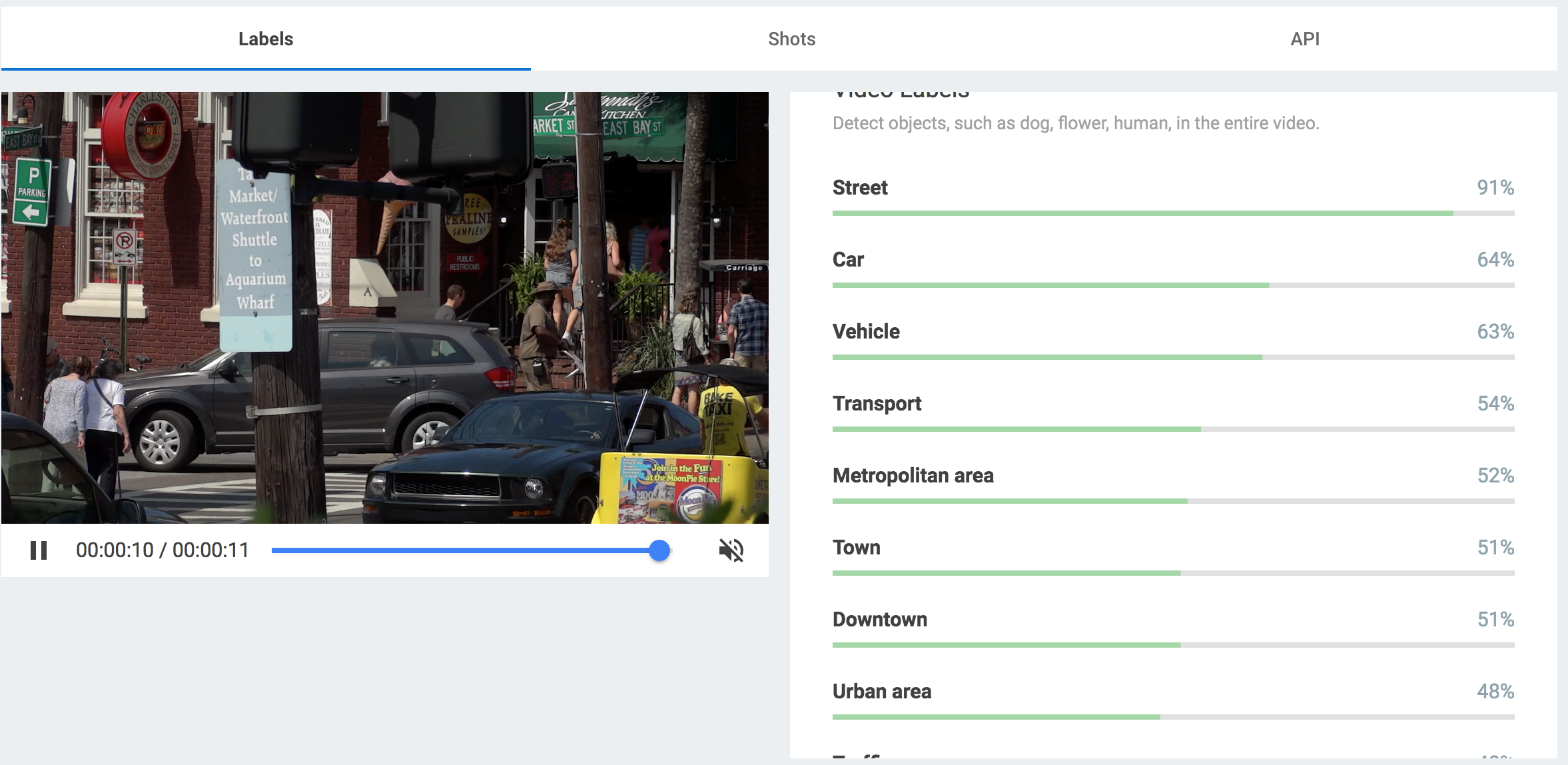

Labels

人間が見ても違和感がないレベルで、出力されていますね。またMetropolitan area, Urban areaが出力されていることから、画像のオブジェクト単体で判断しているわけではなさそうです。

Shots

これは動画のシーンが、遠目からの交差点を写したシーンから、アップでのシーンに切り替わる瞬間の2枚を示したものですが、「Shot Changes」にもきっちりと認識されています。

それぞれの「Shot Labels」を比較すると、取得したラベルも異なっています。

面白いのが、後者のシーンで「Taxicab」が取得できていますが、パッと見るとタクシーは出現していないように見えます。しかしよく見ると動画5秒付近で、三輪タクシーが横切っていることが確認できます。これは一般的なタクシー(車)ではなくバイクで牽引しているようなものなので、おそらく物体の形状からでなく文字列抽出も行って判断しているんでしょうか。

今後

特定のケース、例えば「動画が短い」かつ「対象オブジェクトが少ない」など条件が重なると全く取得できない場合もありましたが、殆どの動画に対してはすぐにでも実用可能なレベルで精度が高いと感じました。

既にアルファ版の申請開始しているので、興味のある方は是非申請して利用してみてください。