2010年にGoogleやFacebookといった名だたる米国IT企業がAI/ディープラーニングの研究機関を設立するなど大規模な投資が話題となり、2015年にはAIの実用化が本格化しました。FacebookのMomentsやSkypeのTranslator、そしてGoogle Photosなど米国IT企業がAIを活用したサービスを公開し始め、トヨタやリクルートなど日本企業のAI/機械学習の研究機関設立の発表も相次ぎました。このトレンドはやはり、ここ数年のディープラーニングの目覚ましい技術的ブレークスルーが寄与しているのでしょう。この投稿では2015年に起こった技術的に進歩したことを解説するとともに、AI技術研究の最先端にいる研究者たちが考える2016年のトレンド予測を読み解いていきます。

なぜ2015年がAI実用化の元年だったのか?

ディープラーニングの技術自体は決して新しいものではありません。大部分のコンセプトは数十年も前に提案されたものです。それがなぜ昨年、実用化の波が押しよせたのでしょうか。理由としては、従来のニューラルネットワークをうまく「組み合わせる」方法によってアルゴリズムの性能が飛躍的に上がり、大手IT企業などで活用され始めたことが直接的に寄与していますが、他分野の技術的進歩も大きく寄与しています。例えば、

- クラウド・コンピューティングは数年前に比べ、より複雑な情報をハンドリングできるようになった、またより安価になった

- アルゴリズムを学習させるためのデータボリュームが大幅に増えた

- 安価で性能の良いソフトフェア開発ツールが飛躍的に発達した

その結果、「ニューラル・ネットワーク」の構築コストがとんでもなく高額なレベルから比較的安価なレベルまで落ちてきました。そして多くのIT企業が巨額投資をすることでAI技術開発が活発化し、2015年のビジネスシーンでの実用化につながったのです。

具体的にどれだけ技術進歩しているの?

「ではどのくらい機械が賢くなったの?」という質問がとんできそうなので下記で、いくつかの角度から時系列データを見比べて、どれだけアルゴリズムが進歩しているのかを見てみましょう。

図表データのソースはこちら

画像認識のエラー率

2012年の画像認識コンペILSVRCでディープラーニング技術が専門家を驚かせて以降、画像認識の誤差は年々ものすごい速さで減り続けています (ちなみにこのディープラーニング技術を使ったチーム全員は現在Googleで働いています)。また2015年の誤差は5%を切っています。この数値は人間による分類作業時の誤差と同じレベルです(もしくは場合によりそれよりも低い)。人間の仕事を機械が奪う、という類の記事が増えたのもこの技術的進歩が関係しているのでしょう。

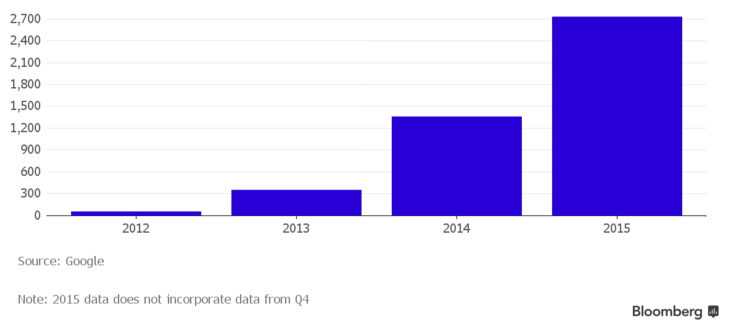

GoogleのAI技術を率いたプロジェクト数

TensorFlowやGoogle Photoなどディープラーニング活用が活発な印象のあるGoogleでは、ものすごい速さでAI技術が社内のプロジェクトに浸透しているのがわかります。2015年では実に2700ものプロジェクトがAIを活用しています。GoogleはAIに巨額投資を行っていますが、この数値で本気度がわかりますね。

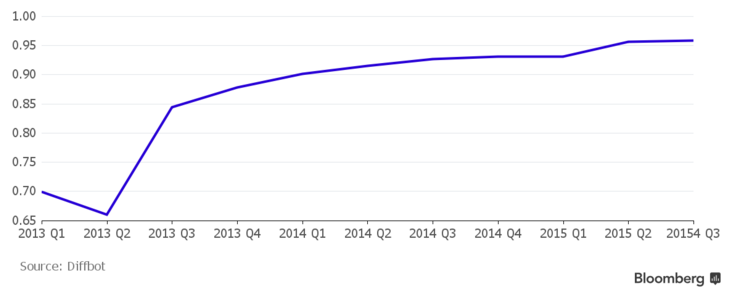

Webを見るAIの視力

AIを使ったクローリングサービスを提供するDiffbotが公開するデータによるとWeb上からほしい情報を抽出する時のエラー率は5%を切っています。近い将来には、コーディングができないビジネスパーソンも、Webデータの収集・入力作業を簡単に自動化できるようになるかもしれません。

さて、これまでは2015年がなぜAIにとってすばらしい1年だったのかを見てきました。次に、2016年には何が起こるのかを技術の最先端にいる人達の言葉を見ながら考えてみましょう。

AI専門家が予測する2016年とその後

下記で、最先端をいくAI技術の専門家のコメントの中からいくつか紹介したいと思います。ソースはこちら

Ilya Sutskever, OpenAIリサーチディレクター

今日のモデルと比べて、もっと少ないデータ量で学習でき、よりディープなモデルが現れるでしょう。また教師なし学習モデルも飛躍的によくなります。その結果、スピーチ、画像認識の分野でより正解率が上がると予測します。

Sven Behnke, University of Bonn教授

ディープラーニング技術がMulti-modal学習に使われ始めるでしょう。その結果、ロボティックス、データマイニング、ナレッジ・ディスカバリーなどの新たなドメインで活用されると思います。

Christian Szegedy, Googleシニア・リサーチ・サイエンティスト

今日のディープラーニング・アルゴリズムは理論的に現実可能なパフォーマンスの領域とは程遠いところに位置します。私は、今後安いスマートフォンやタブレットでも動くアルゴリズムが開発されると確信しています。

Pieter Abbeel, UC Berkeley助教授, Gradescope共同代表

ディープラーニング一つとってもたくさんのことが言えます。教師あり学習では既存のアルゴリズムをどうやってアウトパフォームできるか。また例えば動画分野でもディープラーニングが使われるようになります。

Eli David, Deep Instinct CTO

ディープラーニングは更に多くのドメインで使われるでしょう。また教師なし学習分野は大きく進歩すると考えています。

Ian Goodfellow, Googleシニア・リサーチ・サイエンティスト

5年以内に動画の概要説明や短編版の自動生成ができるようになるでしょう。また、医療分野でよりディープラーニング技術が使われる、例えば新薬の開発に使われたりするかもしれません。

Koray Kavukcuoglu & Alex Graves, Google DeepMindリサーチ・サイエンティスト

教師なし学習と強化学習分野でディープラーニング技術が活用され始めるでしょう。また、学習に他のデータセット組み合わせるなどMultimodalな方法が面白いですね。

いかがでしたか?この抜粋したコメントから、研究者が注目するトピックとして多かったものに、

- ディープラーニングの教師なし学習と強化学習分野への活用

- 動画、テキストデータを組み合わすなどのMultimodal学習

- 更にディープで複雑なニューラルネットワークの構築活動

- 上記の技術的な進歩により、新薬開発などさらに多くのドメインでの活用が可能

があげられるのではないでしょうか。例えば、動画の短編版の自動生成や概要生成はYoutubeなど動画サービスのユーザーエクスペリエンスを向上させそうですね。そして、日々の生活で欠かせないスマートフォンなどのデバイス上で動くディープラーニングアルゴリズムが開発される日もそう遠くはないかもしれません。

今回の投稿ではカバーできなかったディープラーニングのトレンドやトピックがあると思いますので、お気づきになられた方はぜひぜひコメントでシェアしてください ![]()