はじめに

ネットワークに接続されていないローカル環境でLLMを使用したい場合、LM Studio と

呼ばれるAIツールがあるとのことで試してみました。

結果、GPUは NVIDIA の GTX1650 (4GBメモリ) でも問題なく動作しましたので、

動作確認までの手順をまとめてみます。

インストールまで

公式サイト (https://lmstudio.ai/) からインストーラをダウンロードします。

今回は Windows版 を試しました。

起動すると下記のようなスプラッシュ(?)が展開され、その後起動してきました。

特にインストールオプションを聞かれるようなこともなく、自動的にインストールが進み、完了しました。

同時にデスクトップにショートカットが作成されました。

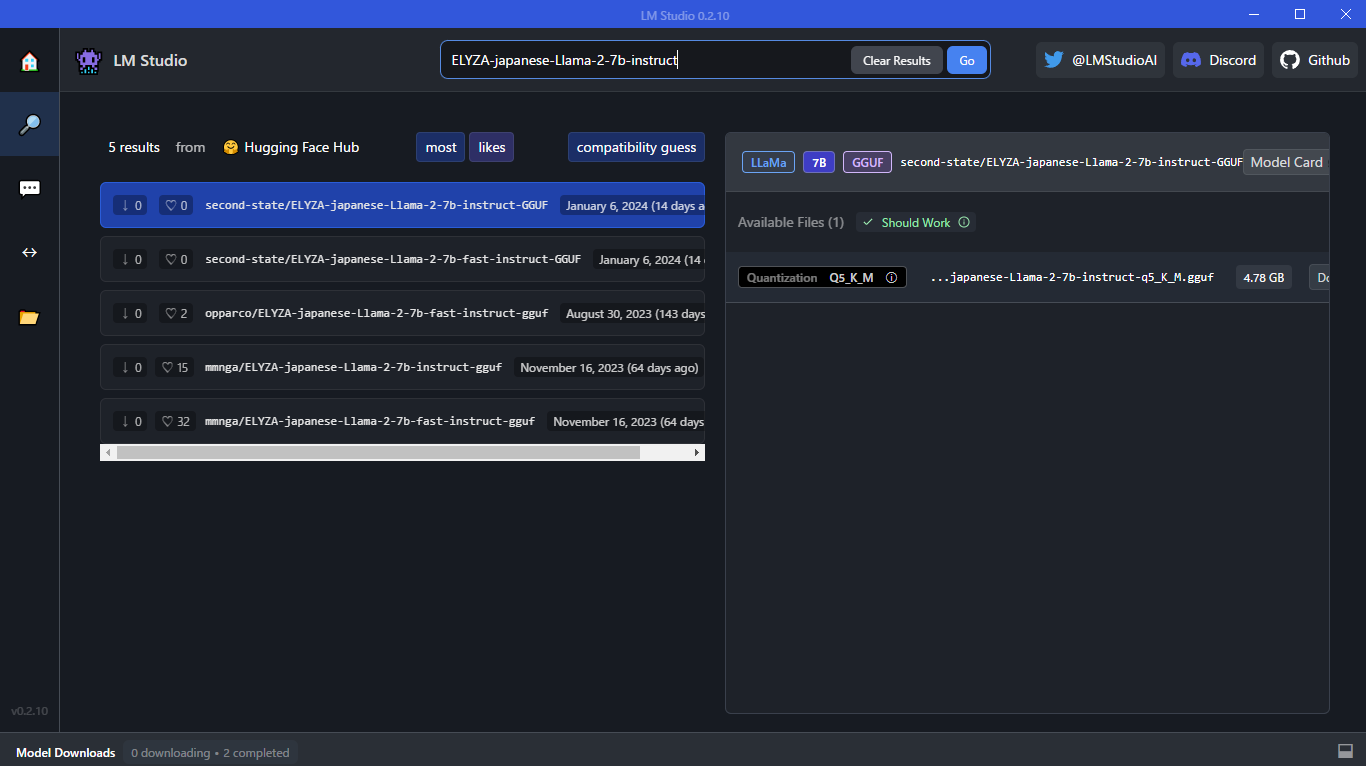

ELYZA-japanese-Llama-2-7b-instruct を試す

日本語対応のLLMを試したいので、ELYZA-japanese-Llama-2-7b-instruct を選択してみました。

画面左側の虫眼鏡🔍(Search)を選択し、検索ボックスに「ELYZA-japanese-Llama-2-7b-instruct」と入力してGo。

画面右側にGGUF一覧が表示されるので、「ELYZA-japanese-Llama-2-7b-fast-instruct-q4_K_M.gguf」の「Download」を押してダウンロード。

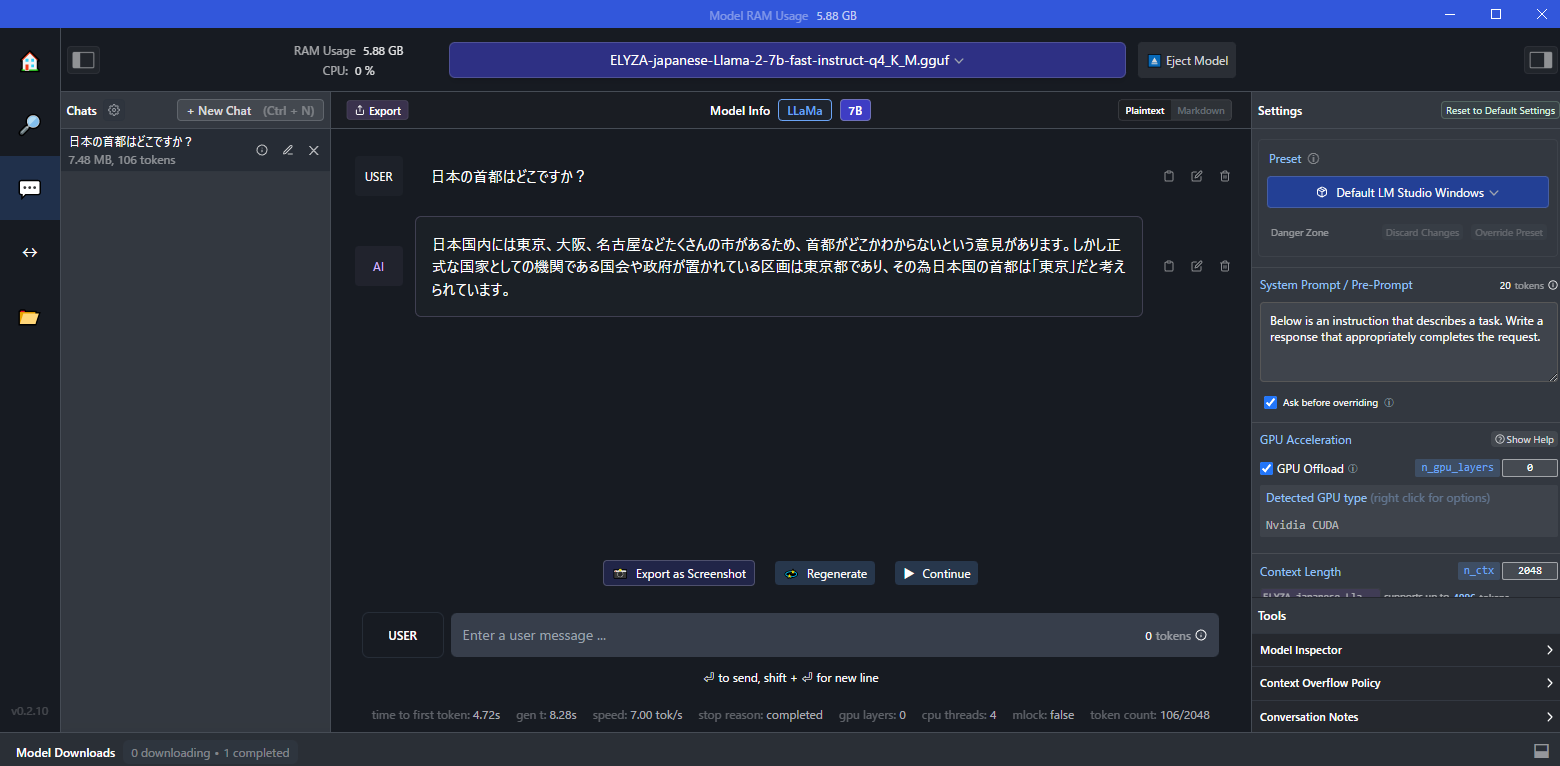

画面左側の💭(AI Chat)を選択し、画面上部より使用するモデルを選択し、読込ます。

試しに日本の首都を聞いてみましたが、イマイチな回答でした。

でも2秒程度で回答されました。

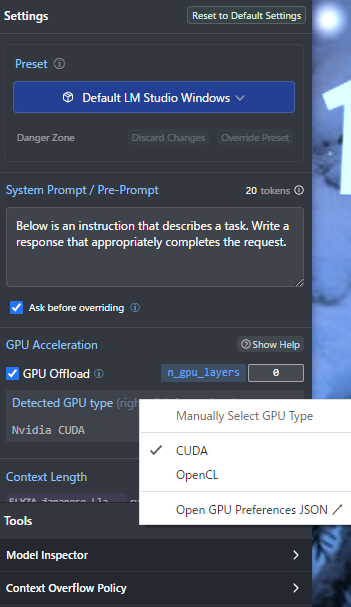

ちなみに画面右側の Settings にある GPU Offload が GPU使用の設定のようでした。

(right click for options) と薄っすらと記載がある箇所を右クリックすると CUDA、OpenCL 等の設定

が出てきます。

画面左側のフォルダ(My Models)を選択すると、ダウンロード済みのモデル一覧が表示されます。

最後に

ローカル環境でLLMを使用したい場合、LM Studio で気軽に試せることが分りました。

ただ使っているうちに回答が生成されず、延々と待たされることもあり、安定していない面もあるようです。

ChatGPT等で扱いにくいような社内情報を扱う場合、LM Studio は使えるものかもしれません。

参考文献

この記事は以下の情報を参考にして執筆しました。