この記事は Power Platform Day Winter '19 C-4 : Data Flow 101 で話す内容についてまとめています。

データフローとは

2019 年 12 月時点で私が認識する限り以下の 3 つがあります。

※尚、英語表記では Data Flow, dataflow, dataflows など揺れがありますが、検索するときは dataflow で大丈夫です。

いずれも GUI ベースのローコードで Extract, Transform, Load (ETL) を実現する機能を提供しています。

ETL

Extract: データを Excel や SQL サーバー、Databricks などのデータソースから取得する。

Transform: 取得したデータを集計や分割、型変換など、必要に応じて変換する。

Load: 変形したデータをデータの格納先に保存する。

なぜデータフローが必要か

それぞれのサービスによって少し背景が異なります。

Azure Data Factory (ADF) のデータフロー

Power Platform ではありませんが、データフロー繋がりで紹介します。

ADF は Azure が提供する ETL/ELT サービスであり、パイプラインを GUI で定義できるオーサリングツールです。そのためデータ変換のプロセスは Databricks や SQL Server など実行環境が必要であり、ADF からは実行環境に対してデータを受け渡すことしかできませんでした。

しかし ADF 内でもデータ変形を定義できるようにするため、Azure Data Factory データフローが追加されました。

※実際の処理は別途 VM が実行環境として使われる。

ADF はもともと Extract と Load の機能を持っているため、Azure Data Factory マッピングデータフローはデータ変換の部分のみ提供します。また ADF のデータフローは、現時点で以下の 2 種類があります。

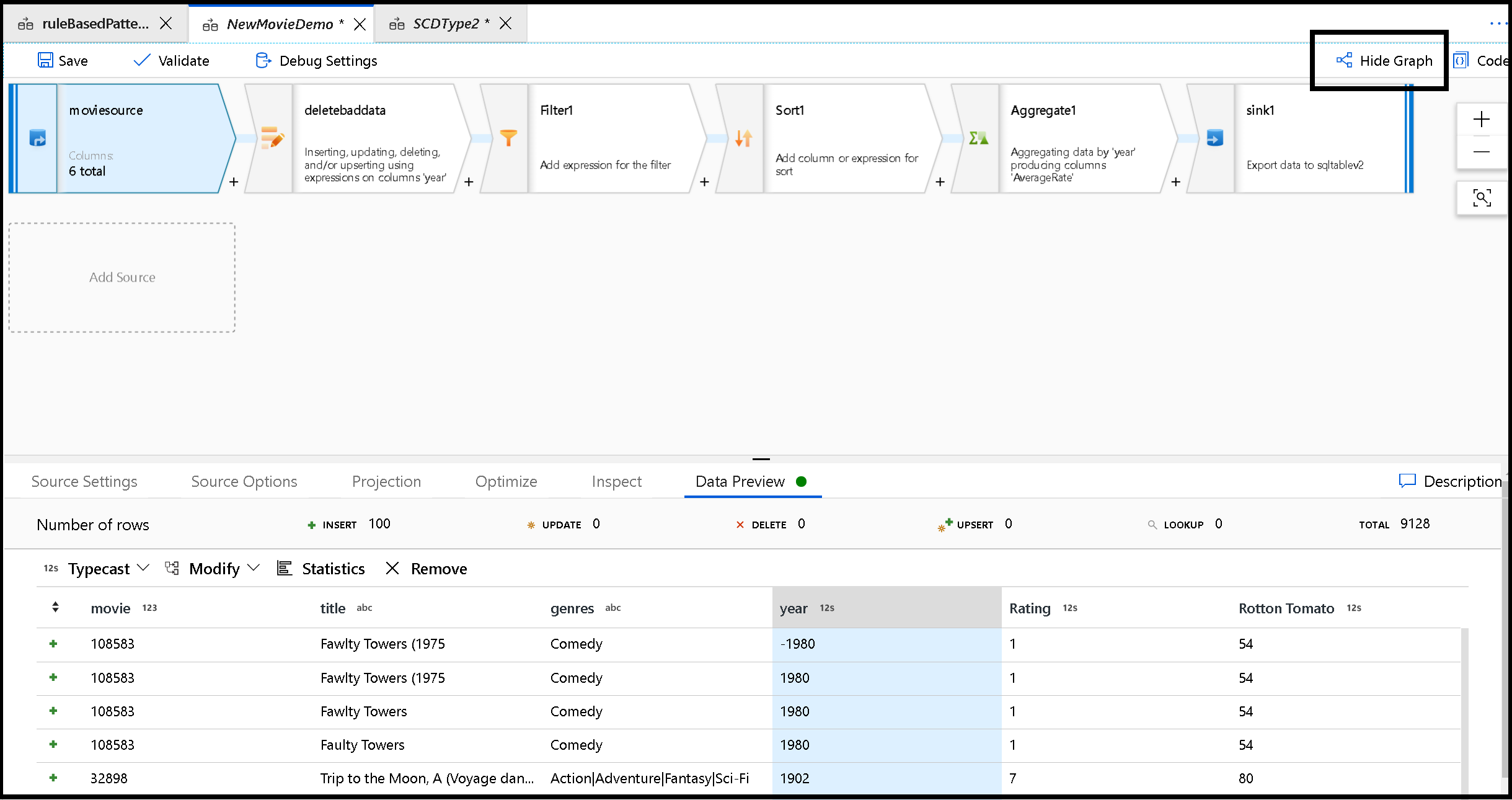

ADF マッピングデータフロー

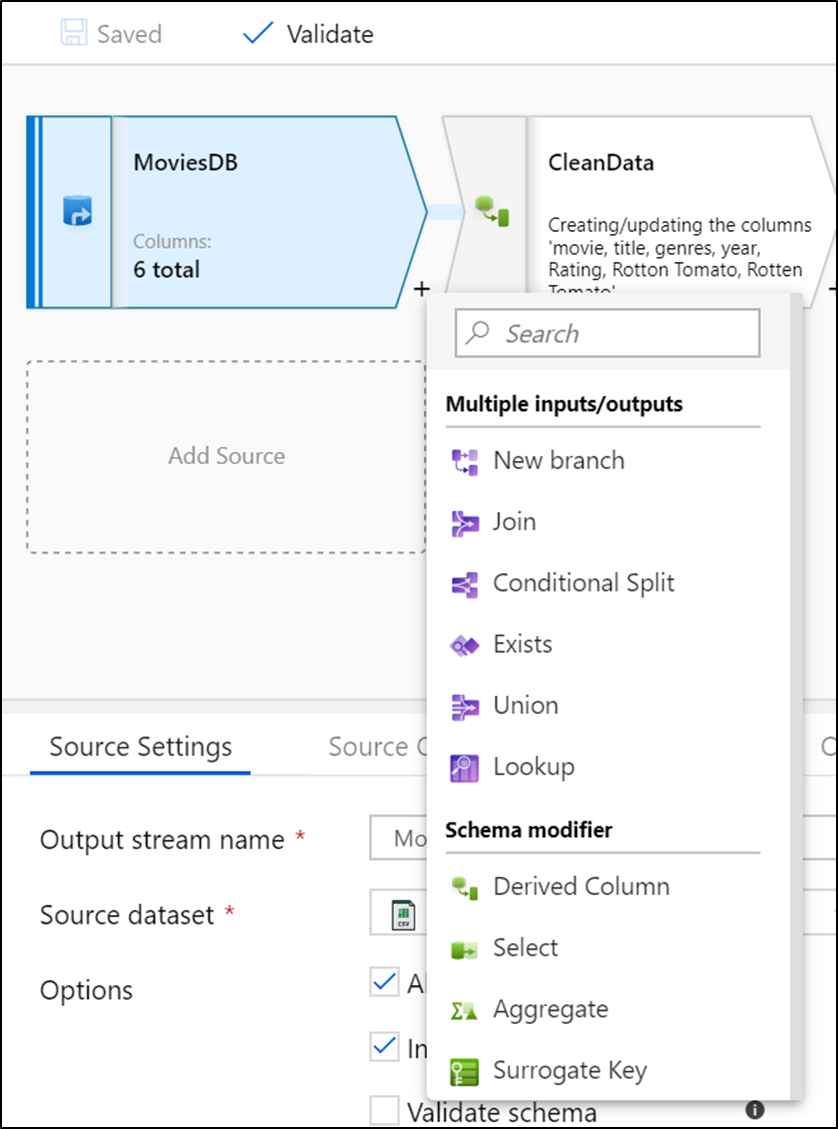

マッピングデータフローでは集計や分割、結合などの各処理をキャンバス上にそれぞれ変換ストリームという単位で配置していきます。

[キャンバス]

[変換ストリーム]

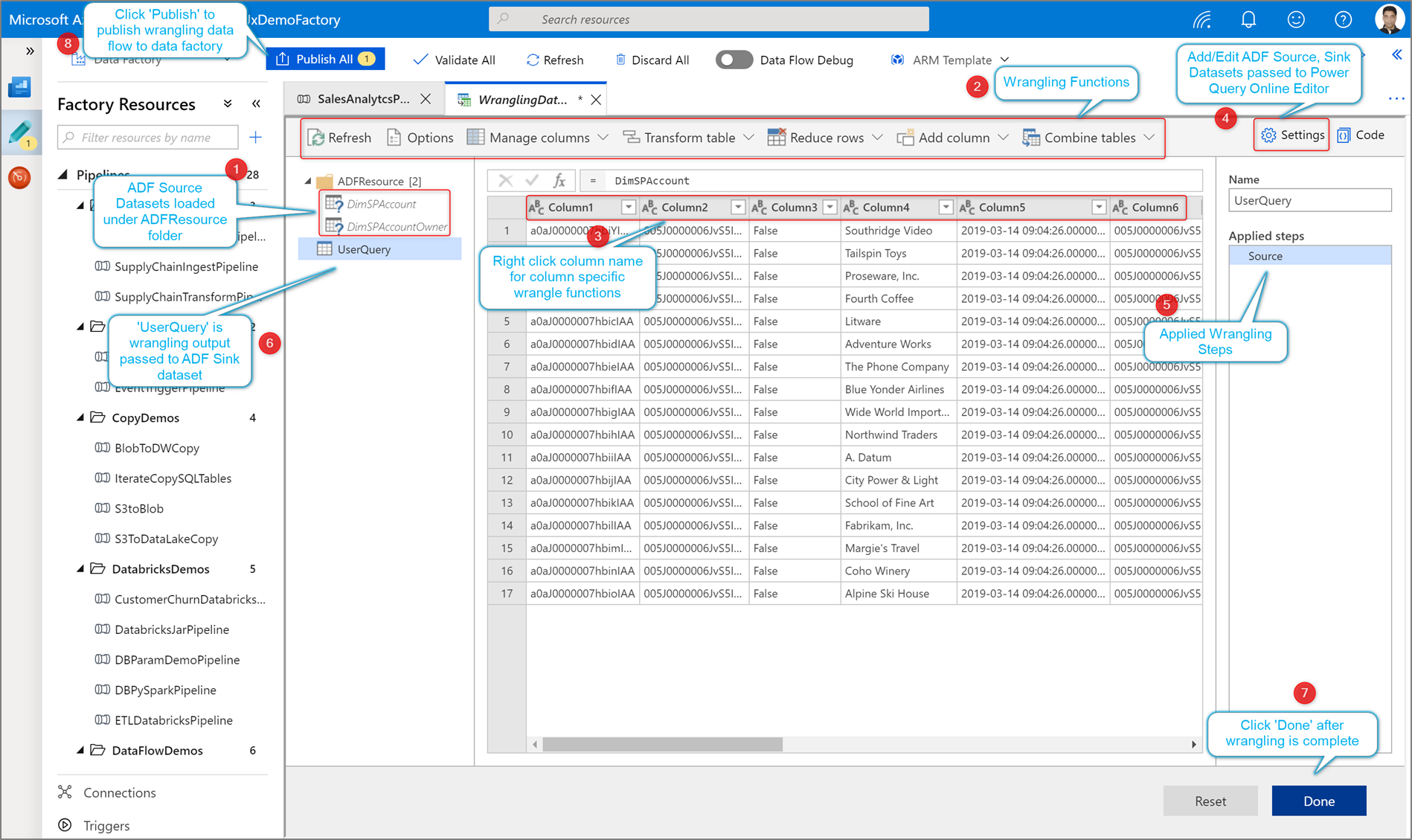

ADF ラングリングデータフロー

ラングリングデータフローでは、みんな大好き Power クエリーが使えます。Power クエリーは、以前から Excel で活用されており、最近では Power BI でも使われる例のあれです。

Power BI のデータフロー

Power BI でデータを利用する場合、いくつか課題があります。

- Data Warehouse の柔軟性が足りない

- データセットの柔軟性が足りない

Data Warehouse (DWH) の柔軟性が足りない

会社や組織全体で利用するために用意された DWH には大量のデータがあるものの、個人やチームでデータを分析する場合にいくつかの理由でデータが不足することがあります。

- 手元にあるデータや他のデータソースを追加したい

- 計算列を追加したい

Power BI のデータセットはこれらの問題を解決する機能があり、Power BI ユーザーはデータを取得する場合、同時にデータを Power クエリーで変換したり、他のテーブルと結合したりしてきました。

データセットの柔軟性が足りない

作成したデータセットは pbix ファイルに紐づいていることからいくつか制限があります。

- 他データセットを参照できるが、追加や削除、または他のデータソースを使うなど内容を変更できない

- データセットの定義をコピーした場合、管理性が下がる

- Machine Learning サービスなどでデータを使いたい場合にデータセットが再利用できない

Power BI データフローを使うとこれらの問題が解決できます。

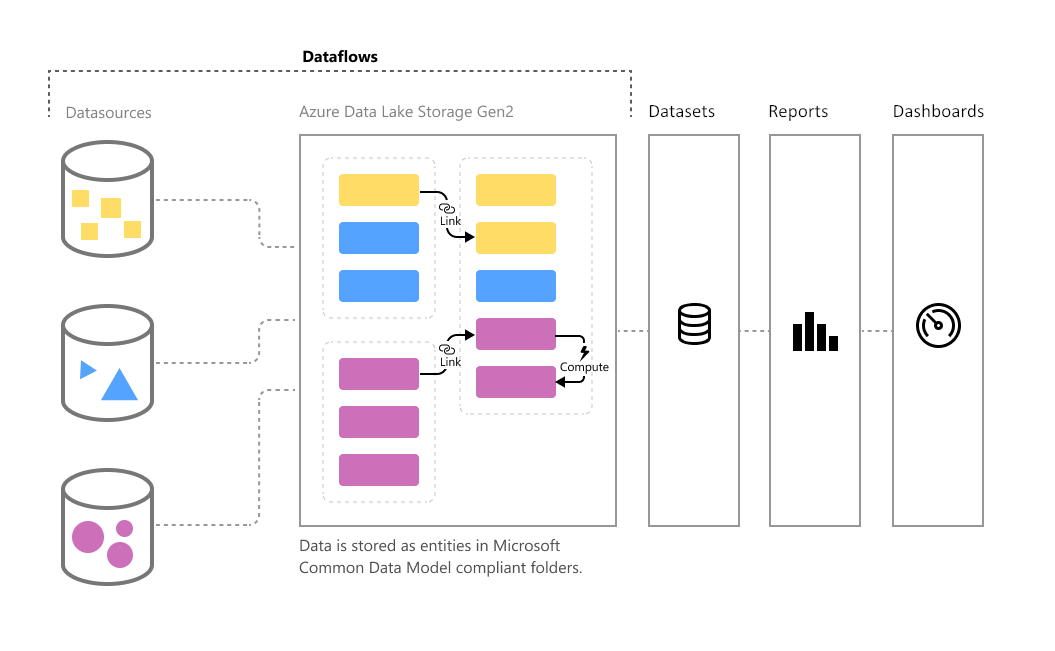

Power BI データフローはデータセットの前段階のコンポーネントとして機能し、ユーザーが自分でデータを集めてくることができるレイヤーを提供します。

他データセットを参照できるが、追加や削除、または他のデータソースを使うなど内容を変更できない

- データフローはデータセットを同じ機能でデータスキーマと変換を定義できる

- データフローをデータソースにして、そこからデータセットを作れるため柔軟性を確保できる

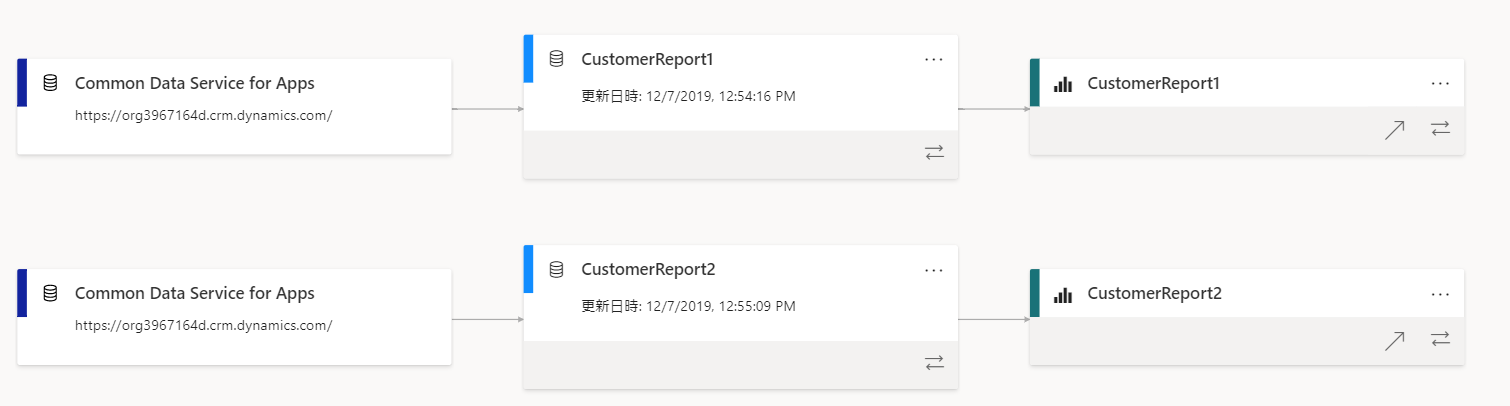

[データセットをデータソースにした場合]

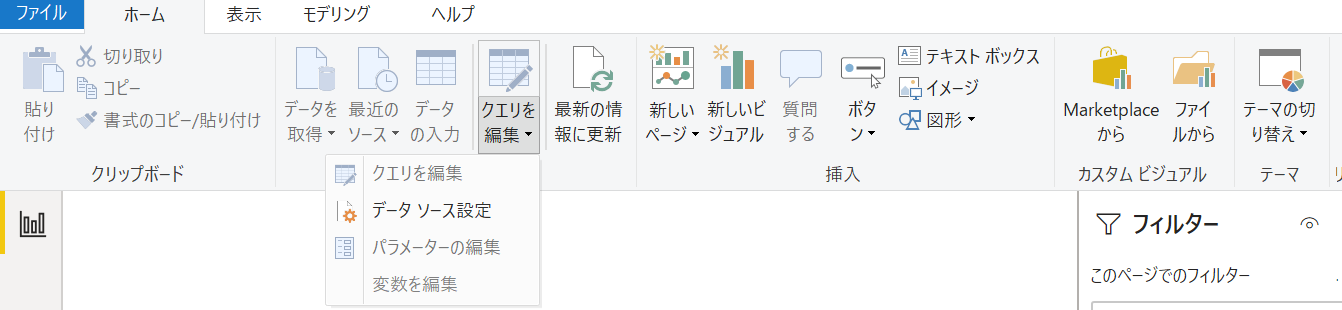

データの取得やクエリの編集などすべてができない。

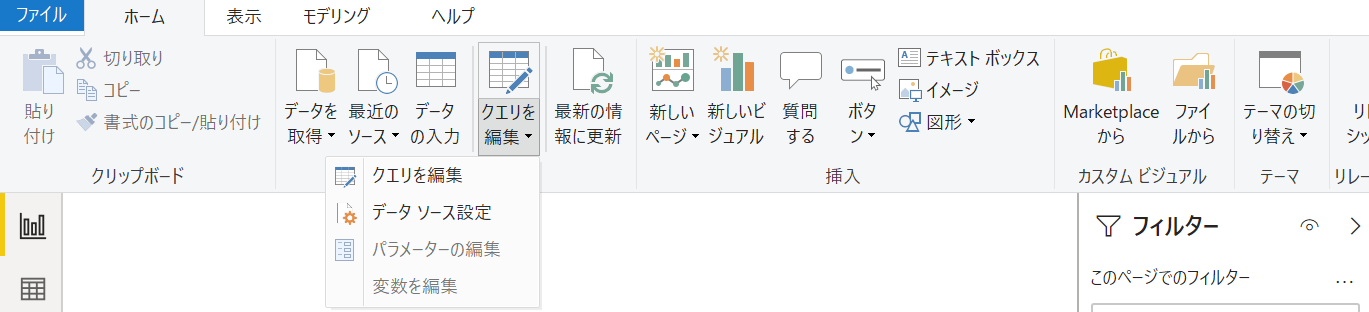

[データフローをデータソースにした場合]

新規にデータセットを作った場合と同じように、すべてを編集できる。

データセットの定義をコピーした場合、管理性が下がる

データフローはデータセットと同じ Power クエリーが使えるため、データセットをデータフローに一元化できる。

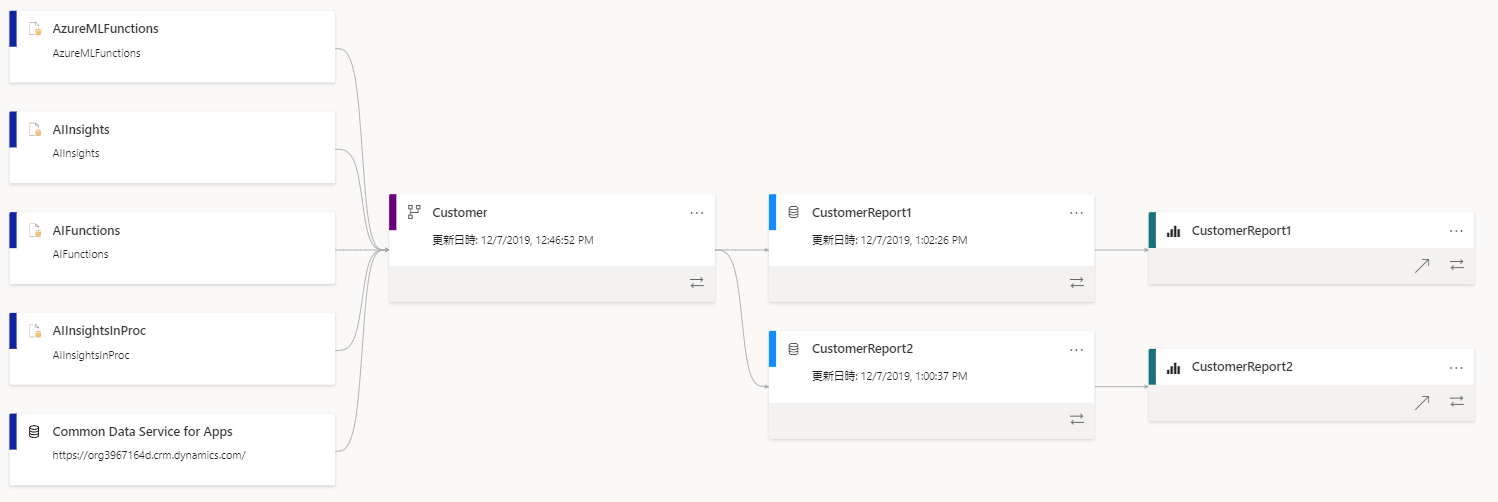

[データセットから作っている場合]

二つのデータセットが別れて存在しているため、片方を変更した場合に、もう一方は変更が反映されない。

[データフローからデータセットを作っている場合]

二つのデータセットが一つのデータフローにつながっているため、変更はデータフローで行えば両方のデータセットに反映される。

Machine Learning サービスなどでデータを使いたい場合にデータセットが再利用できない

データフローのデータ保存先を Azure Data Lake Storage Gen2 にすることができます。また出力されたデータは Common Data Model に基づく形式で保存されるため、再利用性が高くなります。詳細は データフロー ストレージ用の Azure Data Lake Storage Gen2 の接続 を参照してください。

Power BI データフローの作成

基本的に、Power BI データフロー作成は定義の作成であるため、データフローの作成後、データの読み込みを行う必要があります。自動リフレッシュの設定はデータセットより頻繁に行えるなど機能的に有利な点があります。

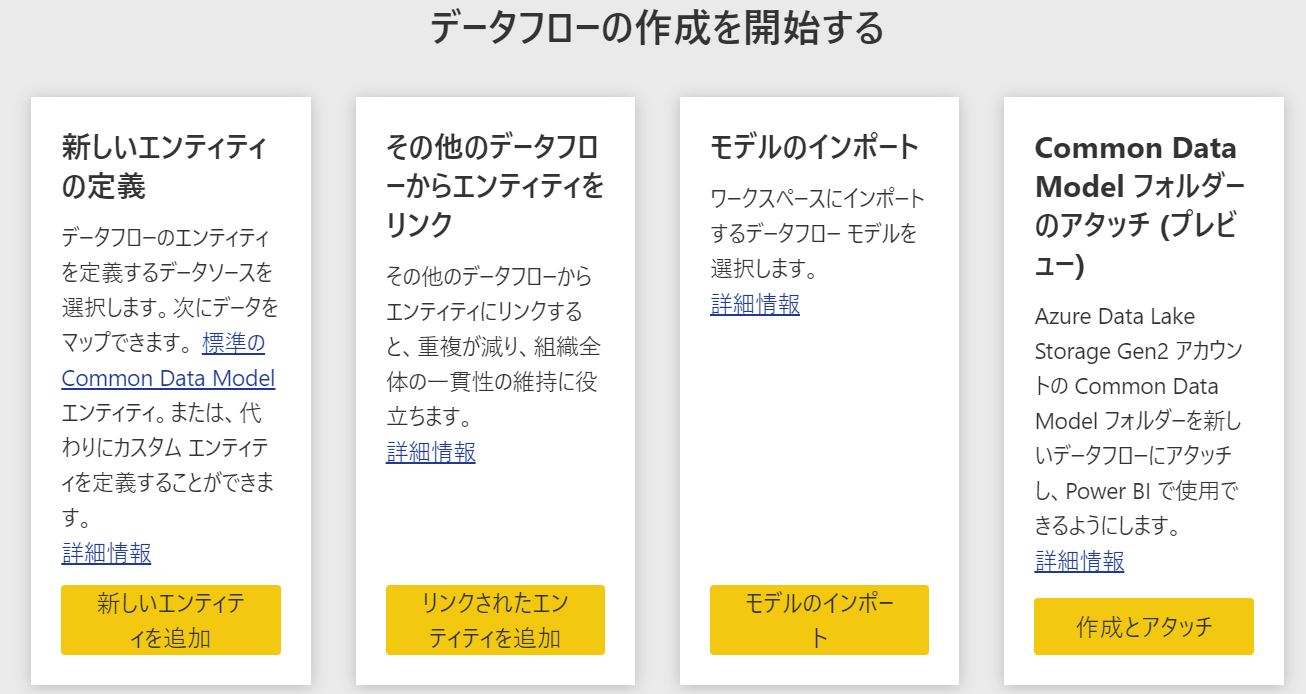

現時点で以下の 4 つの方法でデータフローを作成できます。

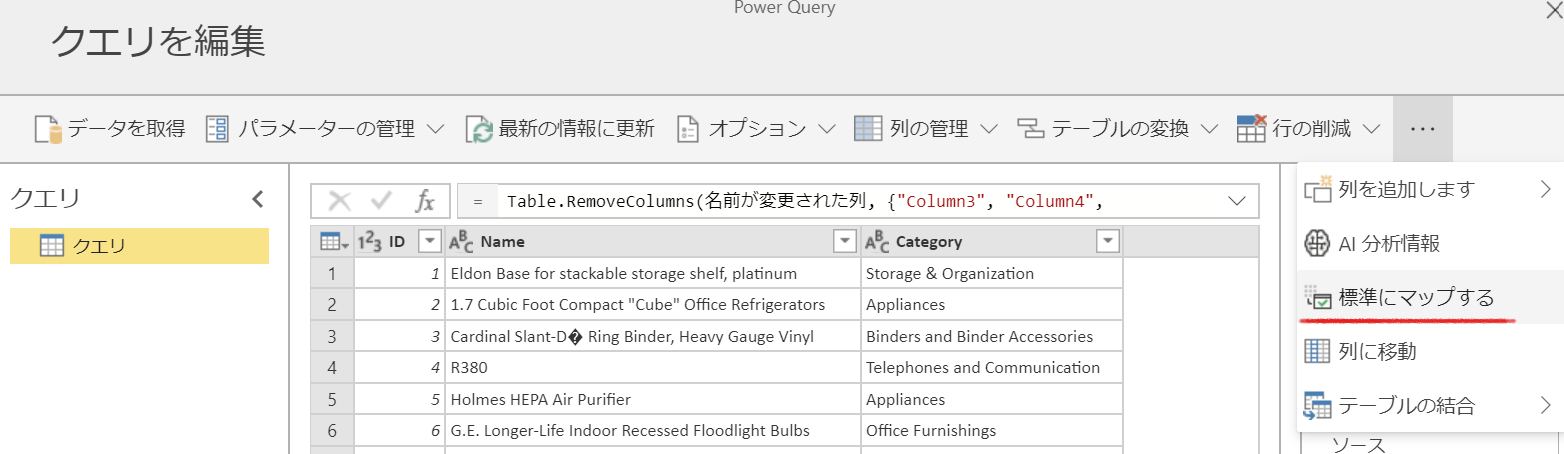

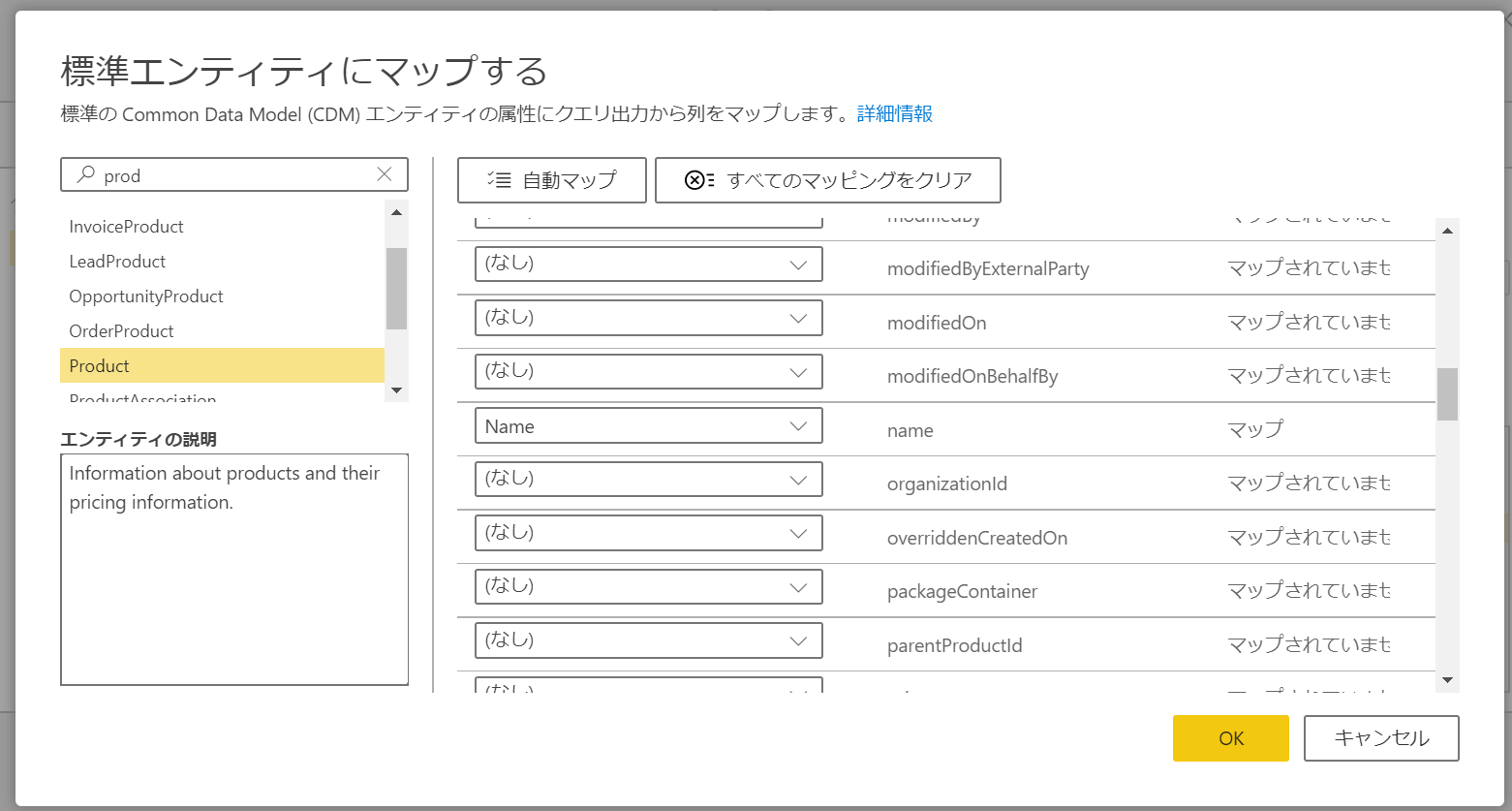

新しいエンティティの定義

現在のデータセットと同じ作り方でデータフローが作れる、一番基本的なパターンです。データのスキーマはこれまで通り自分で設定することもできますし、Common Data Model の標準エンティティのスキーマにマップすることもできます。

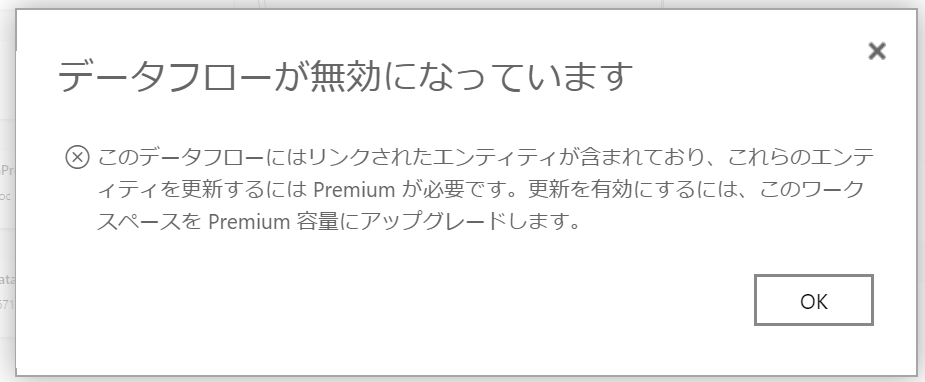

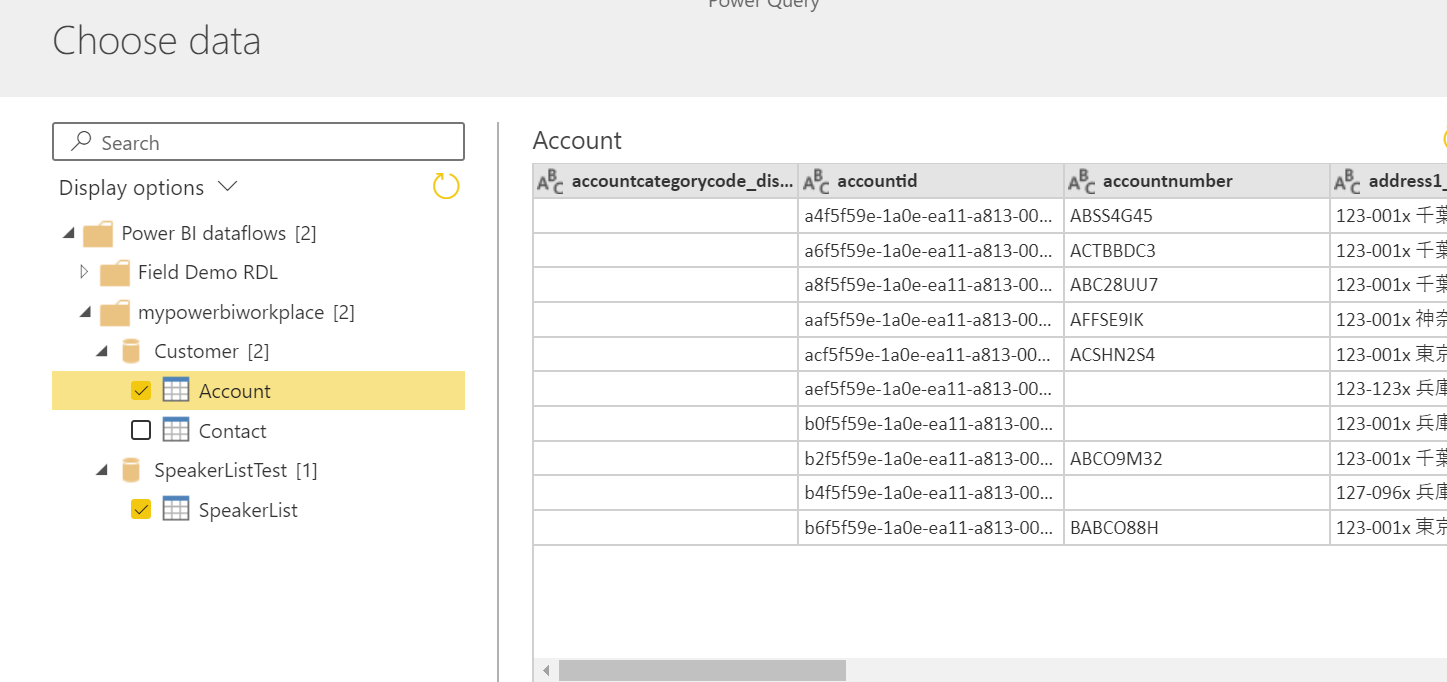

その他のデータフローからエンティティをリンク

複数のデータフローからエンティティを参照するデータフローを作りたい場合に使います。以下の例では Customer データフローから Account エンティティを、SpeakerList データフローから SpearkerList エンティティをリンクしています。

参照: Power BI のデータフロー間でエンティティをリンクする

モデルのインポート

データフローの定義を再利用したい場合、エクスポートしたモデル定義を読み込むことができます。

[モデル定義 json のエクスポート]

[データフロー作成でモデルをインポート]

Common Data Model フォルダーのアタッチ

既に Azure Data Lake Storage Gent2 に Common Data Model 形式でデータがある場合、データごとアタッチすることができます。これは他の方法と異なり、フローの定義もデータのロードも必要がなく、すぐにデータが使えるメリットがありますが、データの管理は Power BI 側ではなく、Azure 側となります。

Power Platform のデータフロー

Power Platform のデータフローは、Common Data Service の機能として提供され、Power Apps や Power BI での利用の他、Azure Data サービスや AI サービスなど、他のビッグデータを必要とするサービスからもデータを使う事を目的としています。

Power Platform のデータフローは以下 2 つの出力先をサポートします。

- Common Data Service

- Azure Data Lake Gen2 の Common Data Model フォルダ

Power BI データフロー同様、データソースは各種コネクタが利用でき、データ変換は Power クエリが使えます。

Azure Data Lake Gen2 との接続

Azure Data Lake Gen2 は Azure 側のリソースであるため、事前の準備が必要です。詳細は

Azure Data Lake Storage Gen2 をデータフロー ストレージに接続するを参照してください。

尚、考慮事項と制限に重要なことが記述されているため、確認してから作業を行ってください。

考慮事項と制限

データフロー ストレージを使用する際に留意すべき考慮事項と制限がいくつかあります。

データフロー ストレージ用の Azure Data Lake Store Gen2 アカウントのリンクは、既定の環境ではサポートされていません。

データフロー ストレージの場所をデータフロー用に構成したら、変更することはできません。

既定では、環境のどのメンバーも Power Platform Dataflows Connector を使用してデータフロー データにアクセスできます。 ただし、データフローの所有者のみが Azure Data Lake Storage Gen2 のファイルに直接アクセスできます。 追加のユーザーがレイクのデータフロー データに直接アクセスすることを承認するには、Data Lake 内または Data Lake 自体のデータフローの CDM フォルダにそれらのユーザーを承認する必要があります。

データフローが削除されると、レイクの CDM フォルダも削除されます。

Power BI Desktop からの読込み

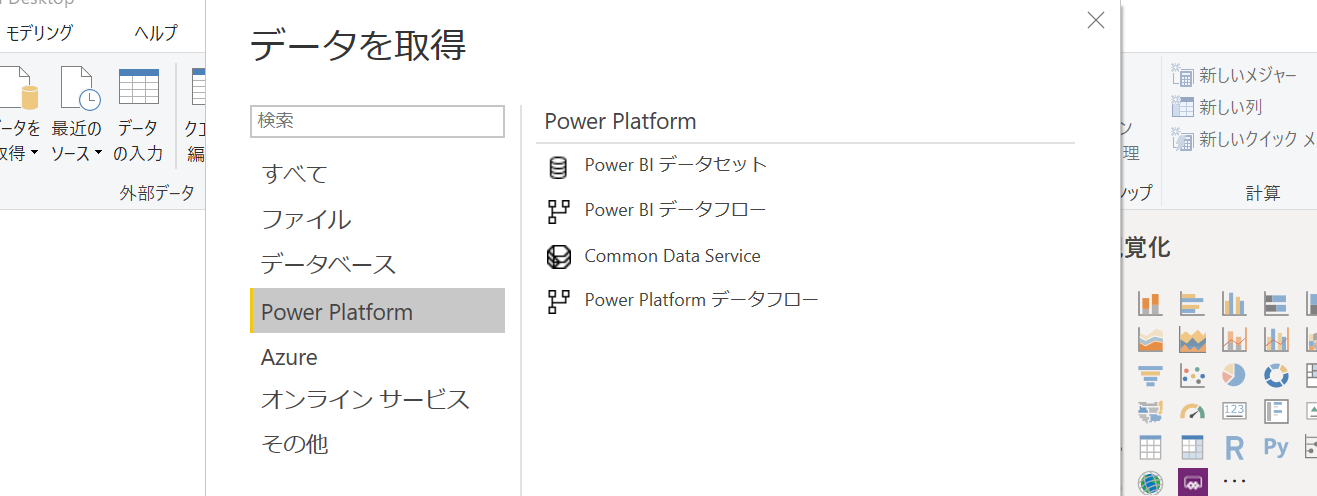

最後に作成したデータフローを Power BI Desktop で読み込みます。

最新のツールでは、以下のように Power Platform カテゴリが追加されており、これまでの Power BI データセットとデータフローに加え、Power Platform データフローと CDS が追加されました。

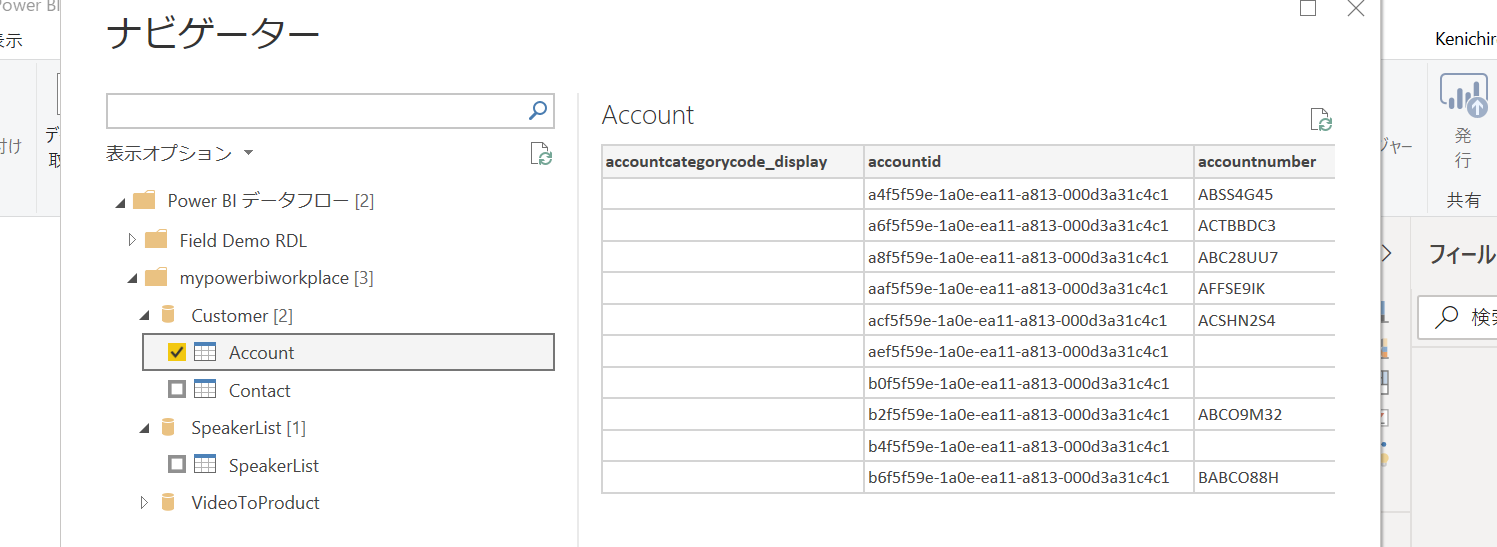

Power BI データフローの読込み

接続時にデータフローがあるワークプレースを選択して、データフローを選択します。

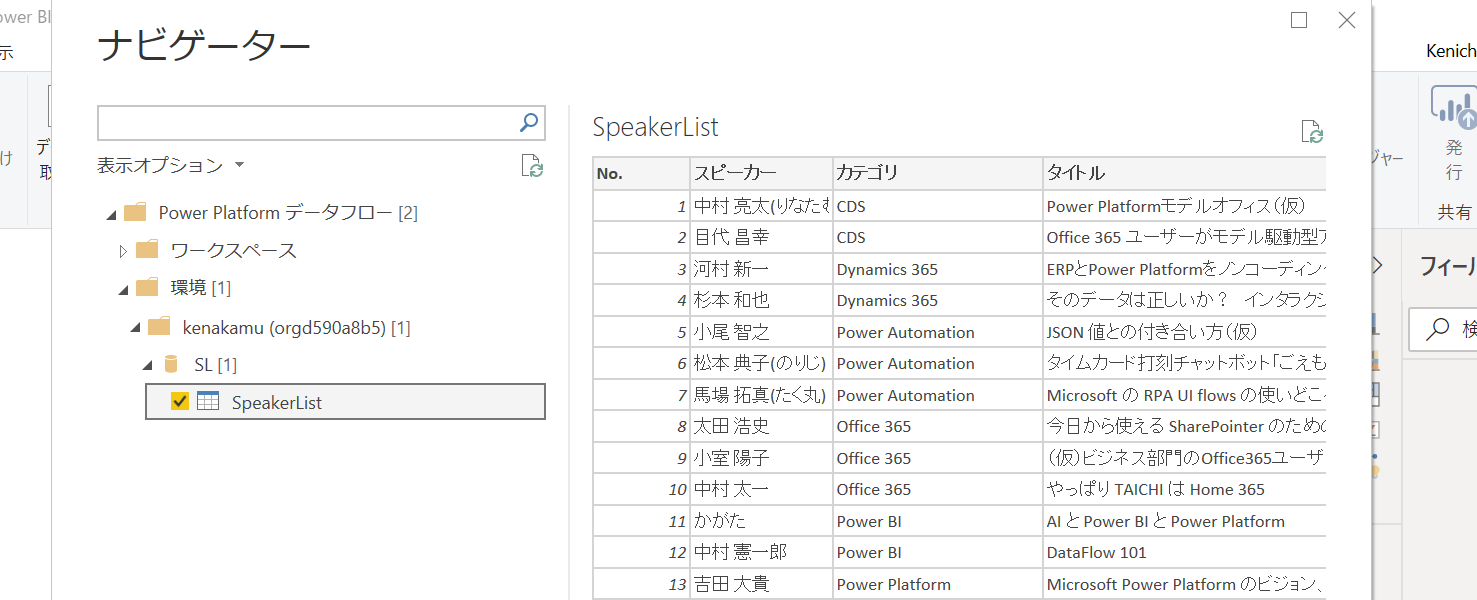

Power Platform データフローの読込み

接続時にデータフローがある環境を選択して、データフローを選択します。

※ Power Platform データフローには Power BI データフローも出てきます。

まとめ

データフローを使えば、これまで一つの pbix や PowerApps アプリに閉じていたデータソースが、より柔軟にかつ強力に利用、共有できます。またデータの重複や不整合もなくなり、より精度の高いデータを利用できるため、是非手元の環境でも触ってみてください。