はじめに

ViveProEyeが発表され、みゅみゅ教授によるアイトラッキングのあるバーチャルキャスト実験放送があり、アイトラッキングの素敵っぷりをバリバリに感じ取りました。

どうにかしてアイトラッキングがしたい、と思って探してたところtobii eye tracker 4cという素敵デバイスを見つけたのを購入して試してみた結果、なかなかいい感じだったのでそのレビューや実装手法を本記事に記していきます。

記事内の僕の作成したスクリプトのライセンスはCC0とします。

tobii eye tracker 4c

tobii eye tracker 4cとはTobii社が開発した視線入力装置で、アイトラッキングとヘッドトラッキングを同時に行うことができます。公式ではPCゲーム用デバイスと説明されており、ゲームでの利用を想定しているようです。実際、FPSゲームなどのゲーム実況で使われていることが多いみたいですね。ですが、バッチリ開発向けにSDKやAPIが用意されているので、エンジニアの皆さんにも安心です。

公式サイトでも購入できますが、Amazonでも購入でき、日本国内でも簡単に入手することができます。お値段も2万程度で性能の割には価格が非常に抑えられていていいですね。一日ですぐ届くのもありがたいです。

動画参考:【BF1】FPSプロゲーマーの目線の動き方を可視化してみた 【実況】

スペック(公式サイトの紹介を日本語化して一部抜粋)

| 大きさ | 17 x 15 x 335 mm (0.66 x 0.6 x 13.1 in) |

| 最大画面サイズ | 16:9の縦横比で27インチ(21:9の縦横比で30インチ) |

| 動作距離 | 20 - 37 "/ 50 - 95 cm |

| OSの互換性 | Windows 7、8.1、10(64ビットのみ) |

| CPU負荷 | 1%(Core i7) |

| Illuminator | 近赤外線(NIR 850nm) |

| 動作推奨スペック | 2.0 GHz, Intel i5 or i7, 8 GB RAM |

Vの開発や現場で使うことを想定してスペックをレビューしておきます。

大きさ

座って配信する場合には問題なさそうですが、フルトラッキングで動き回る場合は難しそうですね。ヘルメットみたいなものを被って顔前に置く手法も考えられますが、それにしては大きすぎます。座ってのゲームや雑談配信、上半身のみで解決するシステムに組み込むことを想定した方が良いです。

最大画面サイズ

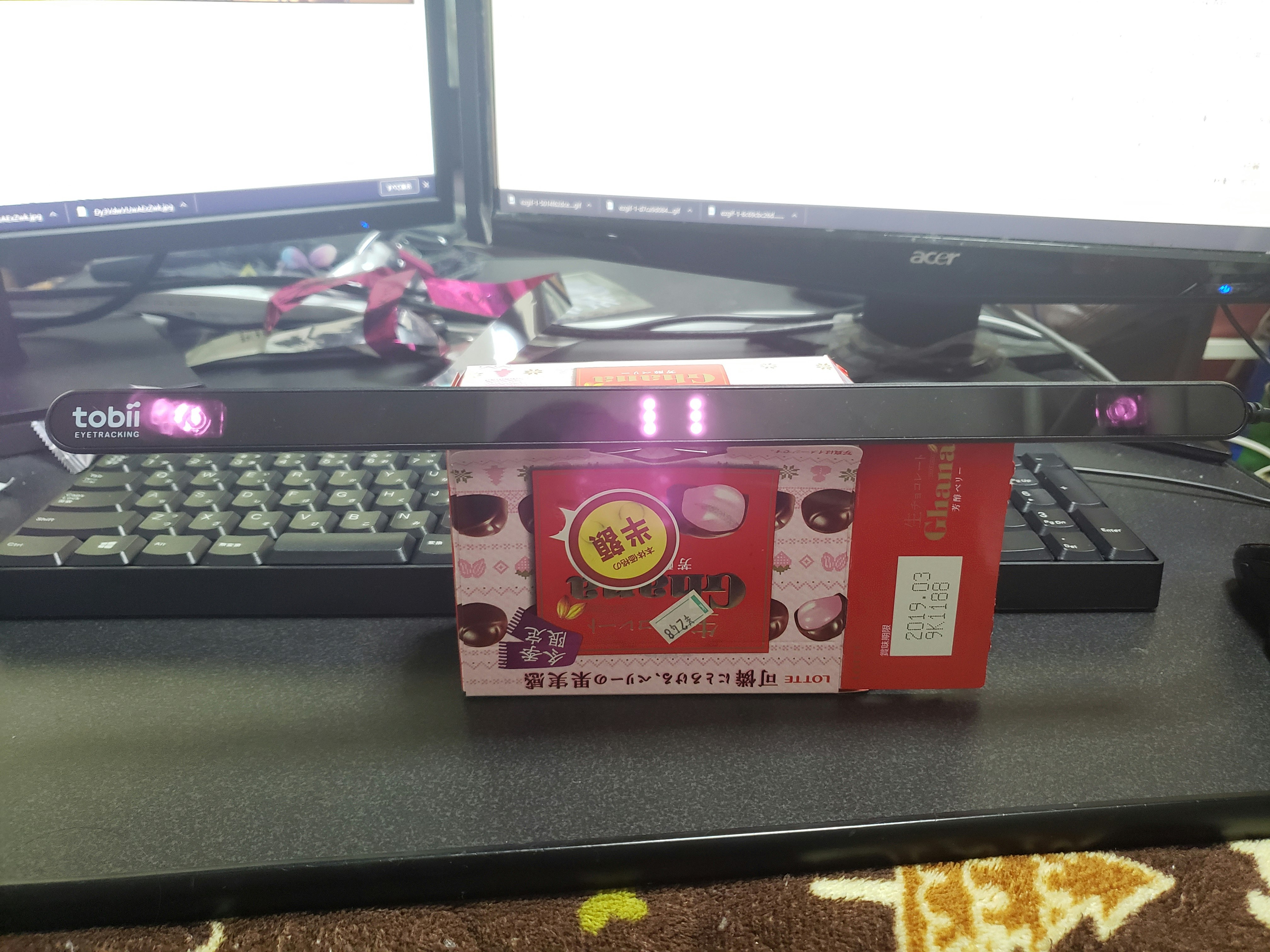

モニターの下部に張り付けて使用することを前提としているため、こういう記載があります。別に無視しても動作はするので、視線の値変動を取得したいだけなら気にしないで大丈夫そうです。ただし、無視すると「モニターのどこを見てるか」という情報はもちろん崩れます。ちなみに僕は適当にお菓子の箱(ガーナチョコ)の上に乗っけて使ったり雑に机の上に置いたまま使ったりしました。

動作距離

思ったより距離を取らないと動いてくれないなという感じです。フェイストラッキングのために別途にカメラなどで顔を撮影をしている場合は、顔とカメラの位置配置でちょっと苦労しそうです。僕はフェイストラッキング用のカメラが遠くなり、顔が小さく(特徴点の値変動も小さくなる)なってしまって少し苦労しました。また、前屈みになってモニターに近づくとトラッキングが外れることが多かったので少し不便に感じました。

OSの互換性

大丈夫そう。この対象に洩れてるPCはぜひバージョンアップしよう。

CPU負荷

負荷は軽いですね。UnityでVtuberシステムに組み込んでも大幅にフレームレートが落ちることはないと思います。

Illuminator

赤外線が用いられているので要注意です。LeapMotionやViveなどに干渉して精度を落とす可能性があります。

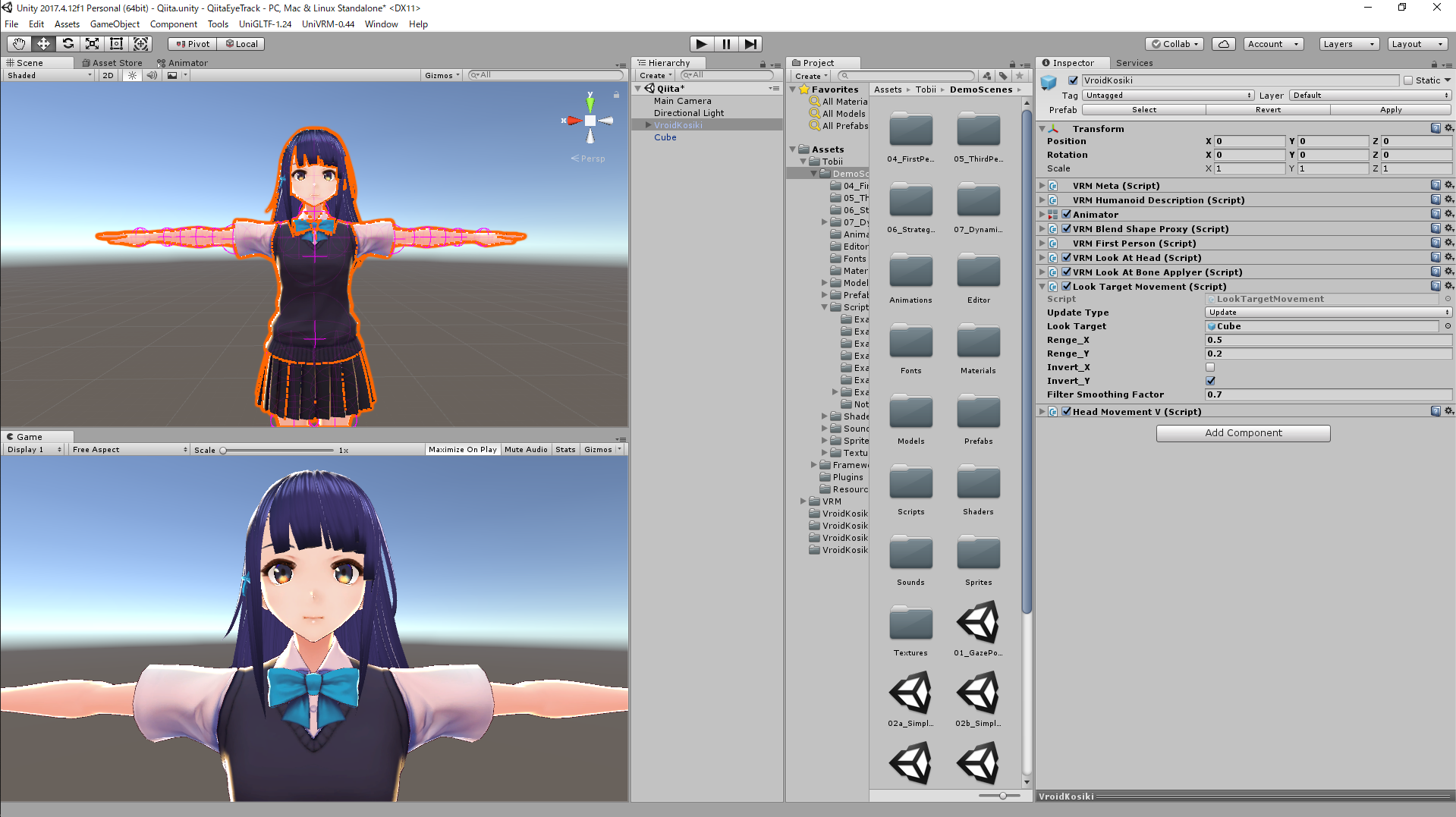

VRMモデルにアイトラッキングとヘッドトラッキングを実装

Unityを用いてVRMモデルにtobii eye tracker 4cで取得したアイトラッキングとヘッドトラッキングデータを適応させ、現実の動きとモデルの動きをリアルタイムに同期させます。

動作環境

- Windows 10 Home

- Unity2017.4.12f1

- tobii eye tracker 4c

- Tobii Eye Tracking Core Software v2.13.4

- TobiiUnitySDKForDesktop_4.0.3

- PCスペック

- GPU :GTX1080

- CPU :Corei7 8700K

- メモリ:16GB

セットアップ

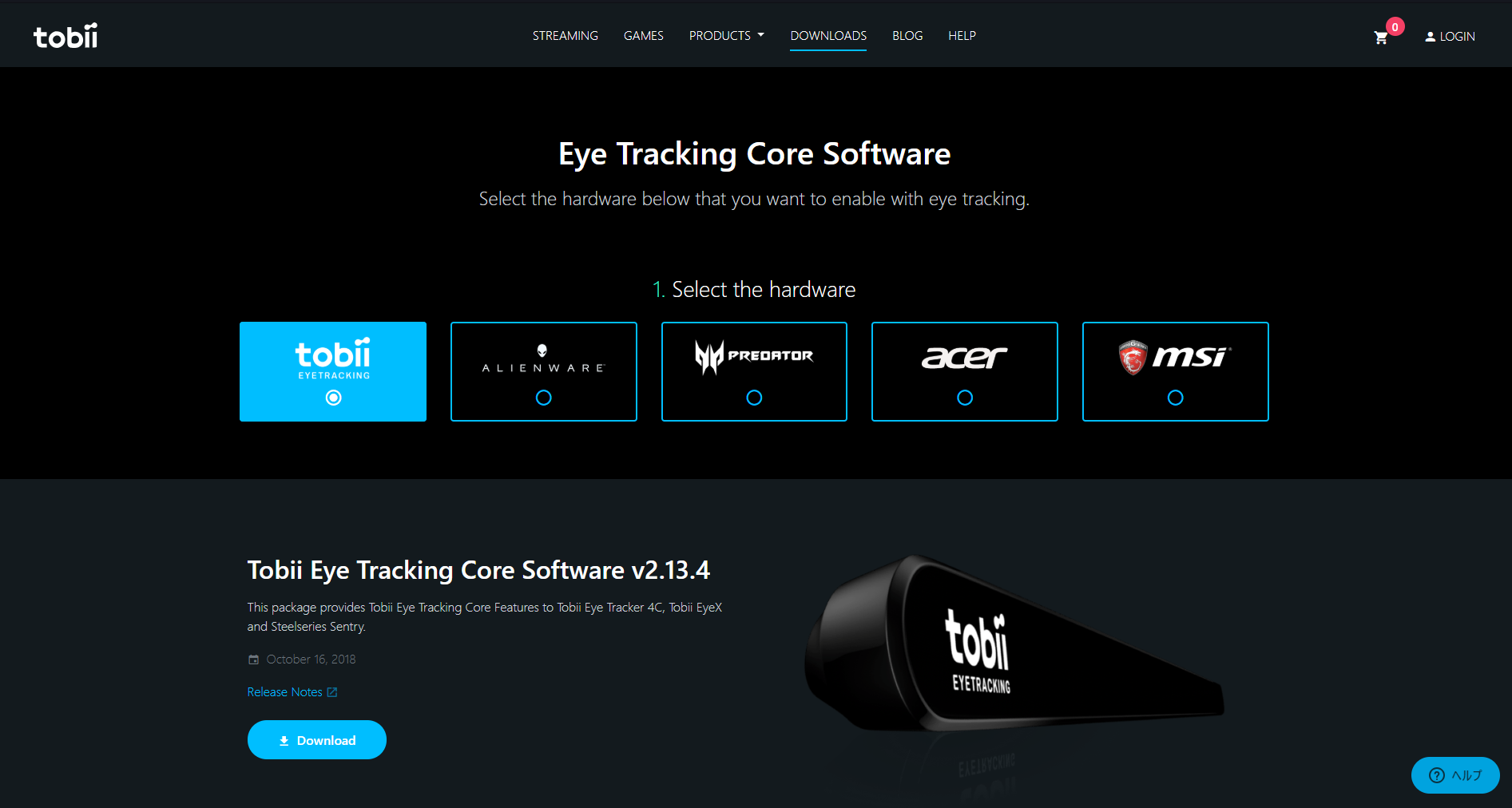

1.Tobii Eye Tracking Core Softwareをインストール

こちらからTobii EYETRACKINGを選択し、Tobii Eye Tracking Core SoftwareをDLしてインストールします。正常に完了すれば、これでtobii eye tracker 4cをPCが認識できるようになります。

2. TobiiUnitySDKForDesktopを入手

こちらからTobiiUnitySDKForDesktop_4.0.3.unitypackageをダウンロードします。

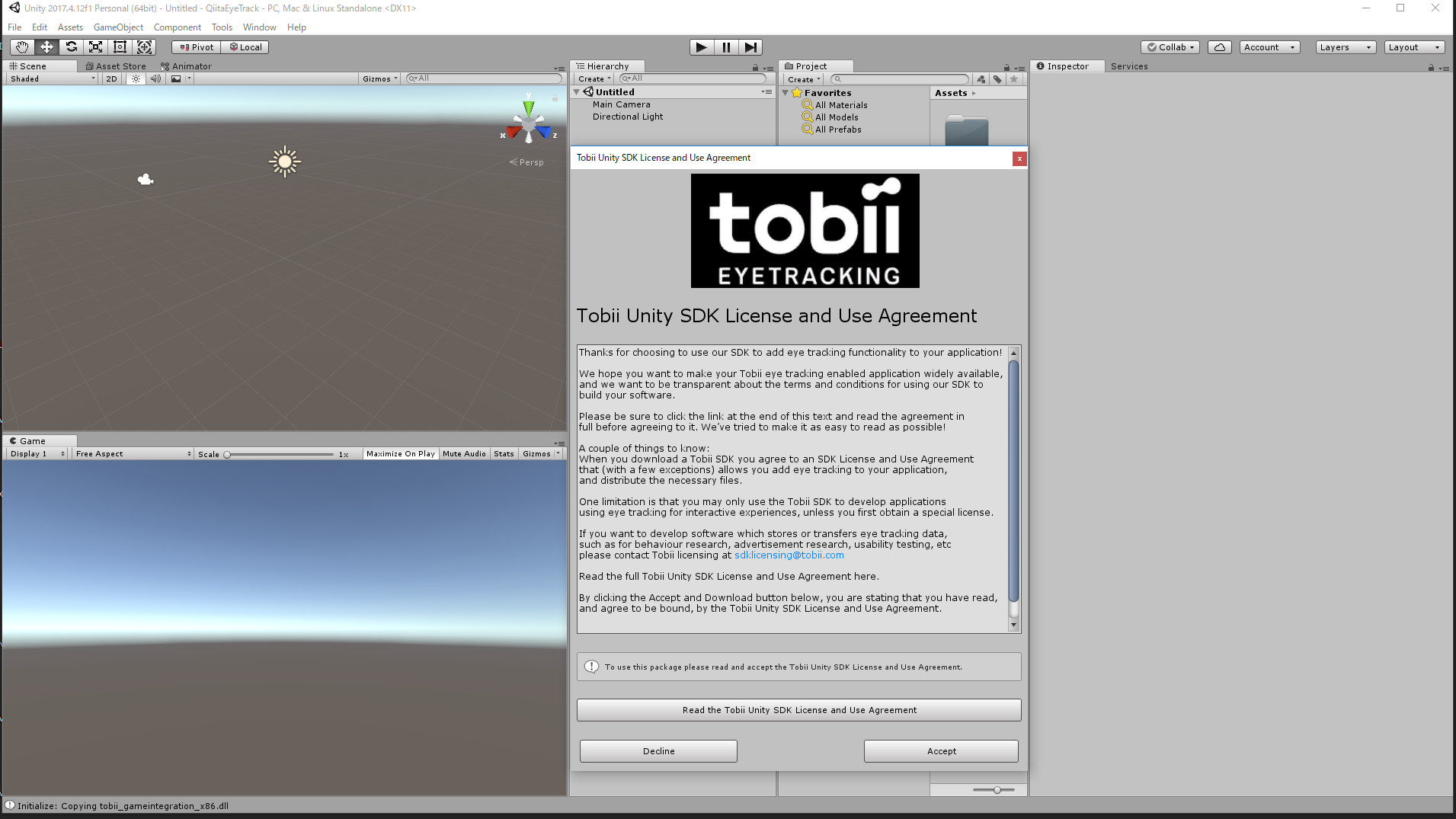

3.UnityにTobiiUnitySDKForDesktop_4.0.3.unitypackageをインポート

先ほどDLしたTobiiUnitySDKForDesktop_4.0.3.unitypackageをUnityにインポートします。インポートするとライセンスの同意を求められるので、ライセンスに目を通した上で同意して進みましょう。対話的利用(アイトラッキングデータをユーザー入力として利用するソフトウェア)によるアプリケーションの開発においては特別なライセンスは必要ありませんが、分析用途(アイトラッキングデータを保存または転送する)には別途ライセンスが必要なので注意しましょう。Vtuber的な利用は許諾の範囲だと考えられますが、収益に関する記述は見つからなかったため、活動に利用される方は公式フォーラムなどから確認を取った方が良いと思います。

4.VRMモデルを配置

こちらからUniVRMのunitypackageを入手し、Unityにインポートします。モデルは何でもいいですが、VroidHubから入手するのが楽だと思います。UniVRMが正常にインポートされていれば、vrmファイルを読み込むだけで、prefabが自動で生成されるはずです。

これでセットアップは終わりました。次項で実装していきます。

実装

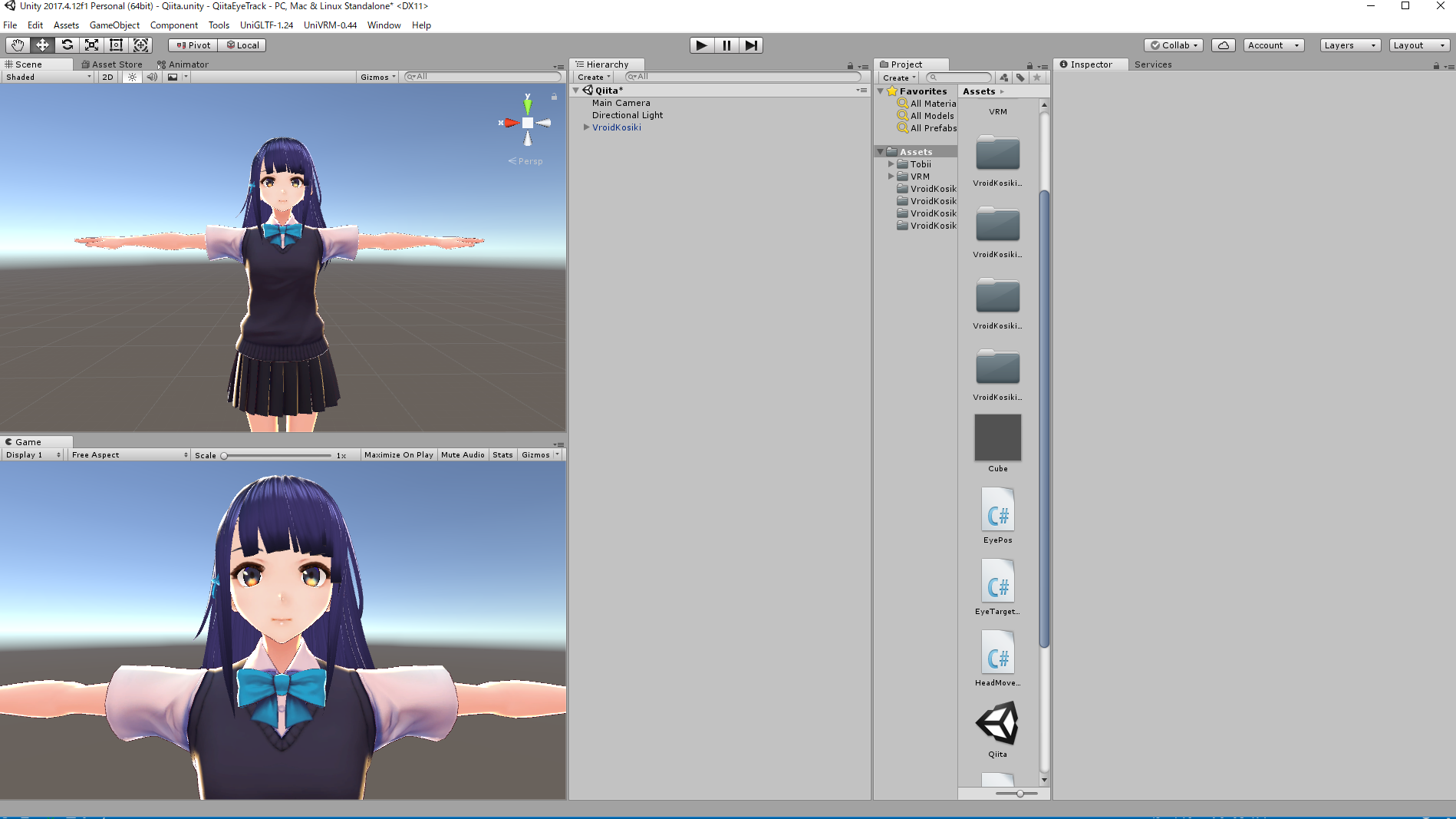

セットアップができたプロジェクトのシーンにVRMモデル配置しておきましょう。モデルは千駄ヶ谷 渋ちゃんをお借りしました。

ヘッドトラッキング

TobiiAPIに頭の向きを取得できるGetHeadPose()メソッドが用意されているので、これを使うだけでほぼ終わりです。

TobiiUnitySDKForDesktopのサンプルシーンUserPresenceAndHeadPoseにあるHeadMovement.csを参考に以下のようなスクリプトを作成しました。

using UnityEngine;

using Tobii.Gaming;

namespace TobiiEyeTracking{

public class HeadMovementV : MonoBehaviour

{

public Transform Neck;

public float Responsiveness = 10f;

void Update()

{

var headPose = TobiiAPI.GetHeadPose();

if (headPose.IsRecent())

{

Neck.transform.localRotation = Quaternion.Lerp(Neck.transform.localRotation, headPose.Rotation, Time.unscaledDeltaTime * Responsiveness);

}

}

}

}

GetHeadPose()メソッドで取得した値をLerp()を使って徐々に適応させることで滑らかな動きを実現しています。

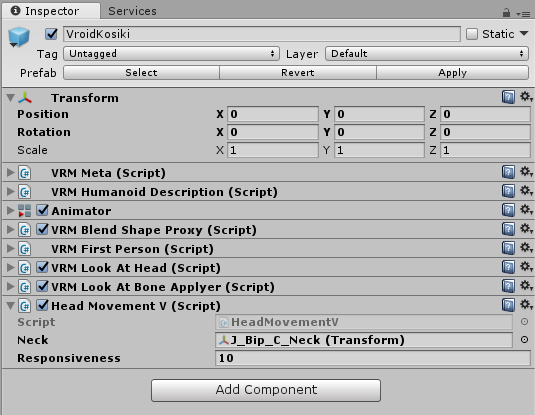

モデルに上記スクリプトをアタッチし、Neckにモデルの首にあたるオブジェクトのTransformをセットすればヘッドトラッキングのセットアップ完了です。

アイトラッキング

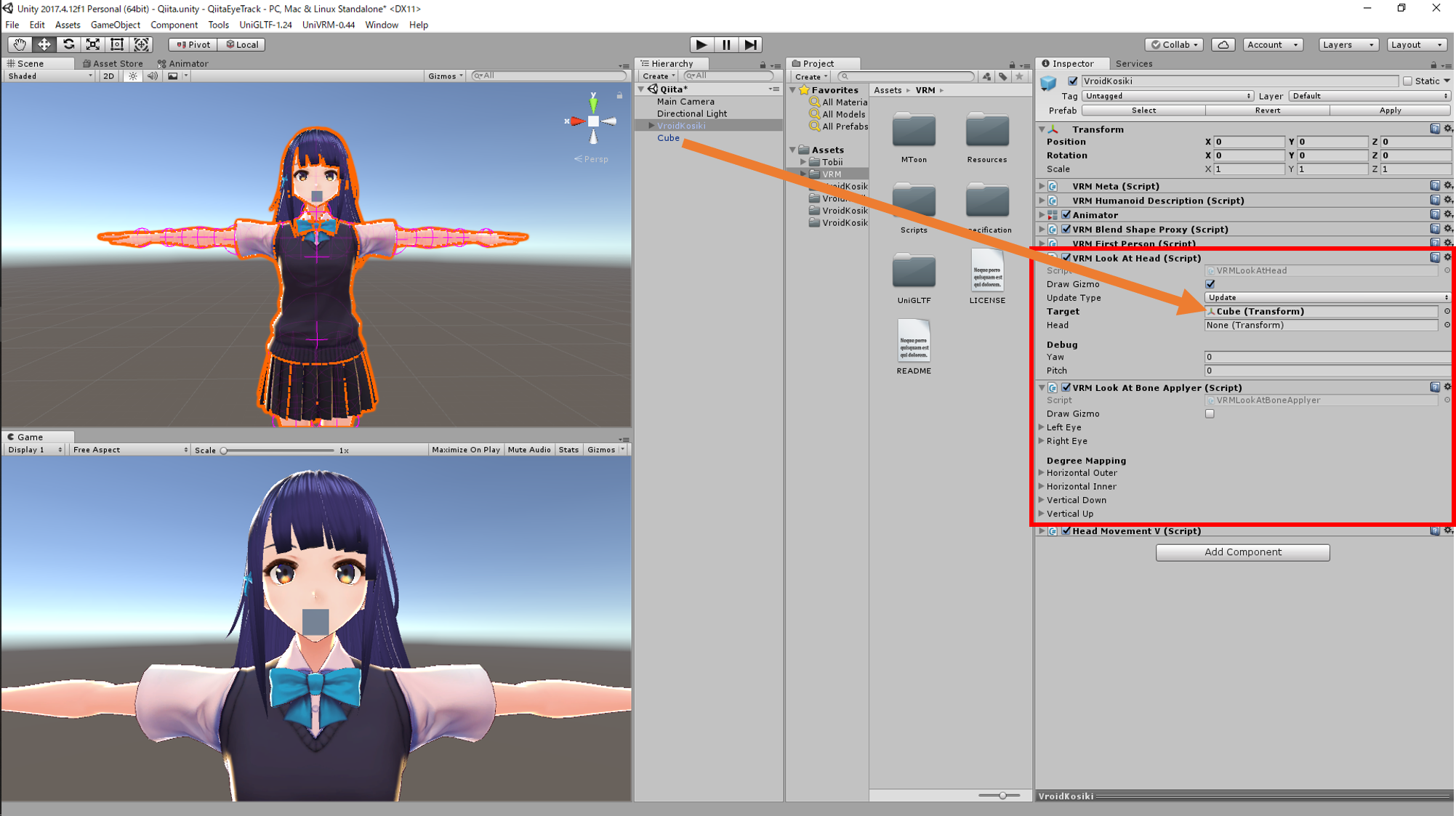

VRMには視線追従を行ってくれるVRMLookAtHeadとVRMLookAtBoneApplyerコンポーネントがあるのでこちらを活用します。VRMLookAtHeadのTargetに注視したいオブジェクトをセットするとそのオブジェクトを視線追従し続けるようになります。何でもいいので注視用オブジェクト(例ではCube)を作成し、顔前正面に配置して、そのCubeをVRMLookAtHeadのTargetにセットします。

これでVRMモデルがこの注視用オブジェクトを視線追従してくれるようになりました。次に、この注視用オブジェクトを視線情報に応じて動かします。先ほどの操作でVRMモデルは注視用オブジェクトの動きを目で追うようになったので、この注視用オブジェクトに視線情報と同じ動きをさせることができればアイトラッキング成功となるわけですね。

視線情報の取得にはTobiiAPIに視線の座標位置を取得できるGetGazePoint()メソッドが用意されているので、そちらを用いて以下のようなスクリプトを作成しました。

using System.Collections;

using System.Collections.Generic;

using UnityEngine;

using Tobii.Gaming;

namespace TobiiEyeTracking{

public enum UpdateType{

None,

Update,

LateUpdate,

}

public class LookTargetMovement : MonoBehaviour {

public UpdateType UpdateType = UpdateType.Update;

public GameObject LookTarget;

private Vector3 StartPos;

public float Renge_X;

public float Renge_Y;

public bool Invert_X;

public bool Invert_Y;

public float FilterSmoothingFactor = 0.15f;

private bool _hasHistoricPoint;

private Vector3 _historicPoint;

void Start () {

StartPos = LookTarget.transform.position;

}

void Update () {

if (UpdateType == UpdateType.Update){

GazePoint gazePoint = TobiiAPI.GetGazePoint();

Renge_X = Mathf.Abs(Renge_X)*(Invert_X ? 1 : -1);

Renge_Y = Mathf.Abs(Renge_Y)*(Invert_Y ? 1 : -1);

Vector3 gazePointInWorld = new Vector3(StartPos.x+((gazePoint.Viewport.x-0.5f)*Renge_X),StartPos.y+((gazePoint.Viewport.y-0.5f)*Renge_Y),StartPos.z);

LookTarget.transform.position = Smoothify(gazePointInWorld);

}

}

void LateUpdate () {

if (UpdateType == UpdateType.LateUpdate){

GazePoint gazePoint = TobiiAPI.GetGazePoint();

Renge_X = Mathf.Abs(Renge_X)*(Invert_X ? 1 : -1);

Renge_Y = Mathf.Abs(Renge_Y)*(Invert_Y ? 1 : -1);

Vector3 gazePointInWorld = new Vector3(StartPos.x+((gazePoint.Viewport.x-0.5f)*Renge_X),StartPos.y+((gazePoint.Viewport.y-0.5f)*Renge_Y),StartPos.z);

LookTarget.transform.position = Smoothify(gazePointInWorld);

}

}

private Vector3 Smoothify(Vector3 point)

{

if (!_hasHistoricPoint)

{

_historicPoint = point;

_hasHistoricPoint = true;

}

var smoothedPoint = new Vector3(

point.x * (1.0f - FilterSmoothingFactor) + _historicPoint.x * FilterSmoothingFactor,

point.y * (1.0f - FilterSmoothingFactor) + _historicPoint.y * FilterSmoothingFactor,

point.z);

_historicPoint = smoothedPoint;

return smoothedPoint;

}

}

}

GazePoint.Viewportにより、ビューポート座標で視線を取得しています。TobiiAPiにはビューポート座標の他にもスクリーン座標で取得するGazePoint.Screen、GUI座標で取得するGazePoint.GUIも用意されています。今回は、解像度に依存したくないのとピクセルで返ってくると計算が複雑になるのでGazePoint.Viewportを用いました(0~1で返ってきて計算が楽)。

次に、GazePoint.Viewportで取得した視線の座標位置を元に、注視用オブジェクトの座標を指定範囲内(Renge_X,Renge_Y)で求めています。そのまま値を反映させると急に眼が動いて怖く見えてしまうので、前回の座標と加減算をして平滑化処理を行っています。

下図のようにスクリプトをアタッチし、パラメータを調整しました。また、注視用オブジェクトのMeshを非表示にして画面内に映らないようにしています。

実行結果

結果gifでは視線を分かりやすくするために、Tobii公式から提供されているTobiiGhostというアプリで視線を可視化しています。VRMLookAtBoneApplyerコンポーネントで目の可動域などの設定ができるので、白目をよく向いてしまう場合はそちらのパラメータを調整しましょう。

雑記Q&A

わざわざ項目作って書くほどでもない情報を雑多に書き記していきます。

Q,眼鏡でも大丈夫ですか。

A.大丈夫でした。あまり精度の低下は感じませんでした。記事内のGifもかなりプリズムの強い眼鏡を付けたままやっているものです。

Q.TobiiSDKのサンプルに用意されているGazePlotter.cs(視線情報に応じてパーティクルを動かしてくれる)で注視用オブジェクトを動かせば良かったのでは。

A.視線情報をスクリーン座標で取った後Camera.ScreenToWorldPoint()メソッドでワールド座標に変換しており、座標がカメラに依存してしまっています。そのため、VRMモデルが正面を向いていない場合、VRMモデルが正面にいない場合、カメラが複数ある場合などを想定したときに不都合だったので使いませんでした。

Q.何で公式の説明通りにモニター下部にtobii eye tracker 4cを設置しないのですか

A.検証という意味合いも強いですが、僕のモニターの下部が斜めになっていて、綺麗に張り付いてくれなかったためです。また、起動していると赤外線が目立って普段作業には使いたくなかったため、移動可能なところに設置したかったからです。

画像はバレンタインの売れ残りで手に入れた半額ガーナ空箱。めちゃくちゃ有能。抜群の安定性と哀しみを持つ。

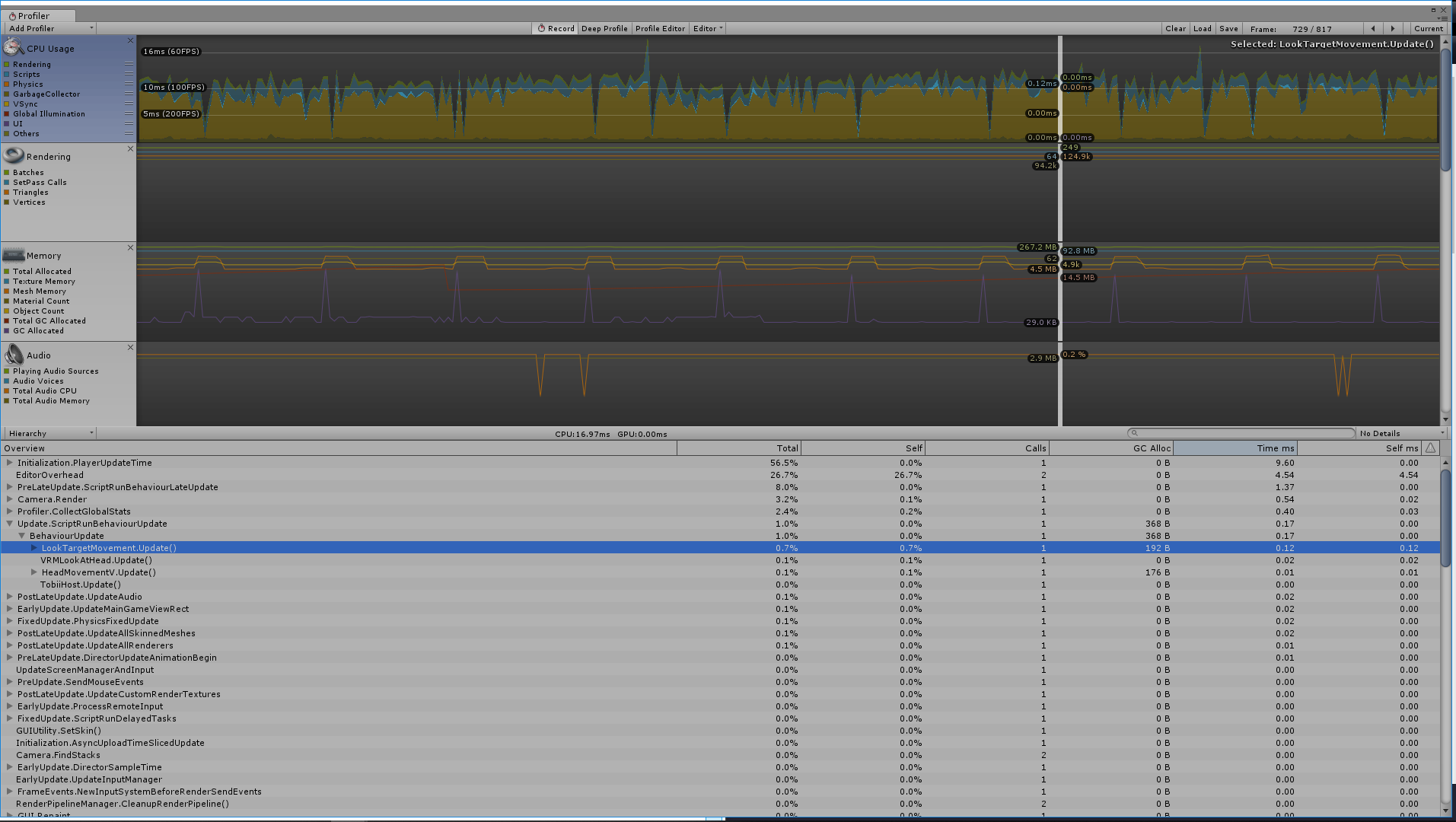

Q.処理負荷についてもうちょっと詳しく

A.本記事で作成した千駄ヶ谷 渋モデルとCubeを配置し、千駄ヶ谷 渋モデルにデフォルトでアタッチされているスクリプトとHeadMovementV.csとLookTargetMovement.csが動作しているシーンのフレームレートが79~88fpsくらいでした(動作PCスペックについては動作環境項参照)。同じシーンでHeadMovementV.csとLookTargetMovement.csを非アクティブにし、tobii eye tracker 4cをUSBからぶっこ抜いたシーンのフレームレートが80~90fpsくらいでした。僕の環境だと1~3fpsくらい落とすというところでしょうか。

Plofilerで確認してもあまり負荷をかけているようには見えませんね。

おわりに

自分が趣味で拡張して遊んでいるVtuberシステムに組み込んでもみましたが、とてもプレゼンスが上がって良かったです。見ている場所が分かるので、アイデア次第で面白い演出を入れることもできそうです。また、処理が非常に軽く、実装もお手軽なのもとても良いですね。OpenCVとDlibによる画像処理は処理が非常に重く、学習データのライセンス問題の解決が大変でした。

ViveProEyeの発売が楽しみですね!!

アイトラッキング実装できた実験で惨敗する僕 pic.twitter.com/lBKSNsaBBL

— かいき (@kaikiofkaiki) February 17, 2019