ダーツが狙ったところに刺さるかどうか、投げた直後、つまり刺さる直前にお知らせすることで、0.2秒待てば分かることを0.2秒前に知って一喜一憂するためのアプリを作りました。

何を作ったか

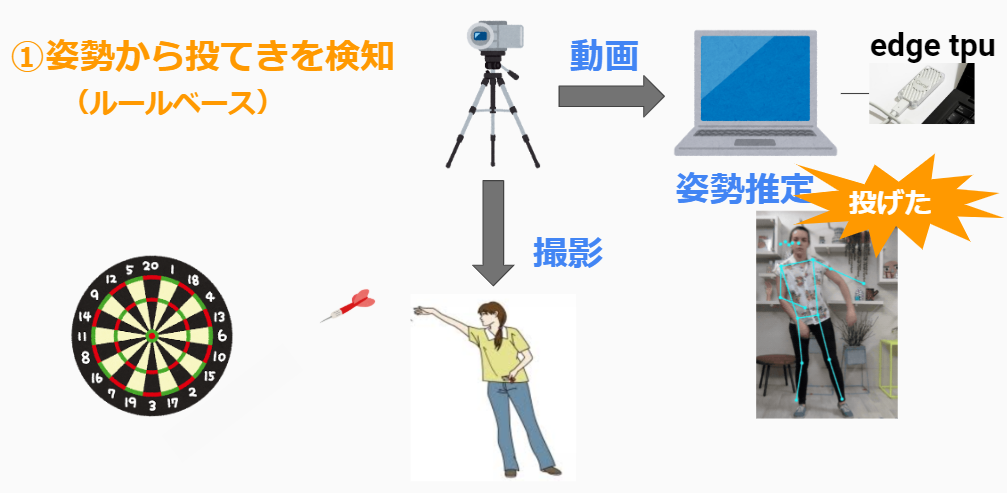

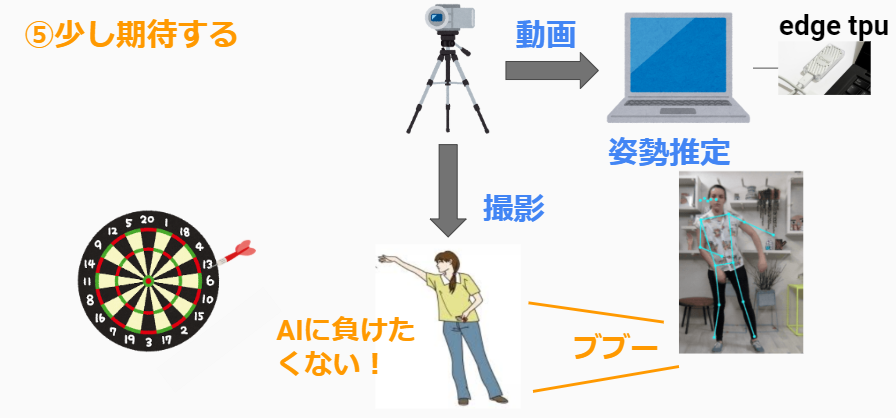

まず、的に向かってダーツを投げましょう。その様子をカメラで撮影し、その映像をもとにPCで姿勢推定を行います。推定された姿勢をもとに、ルールベースでダーツを投げたことをPCで検知します。

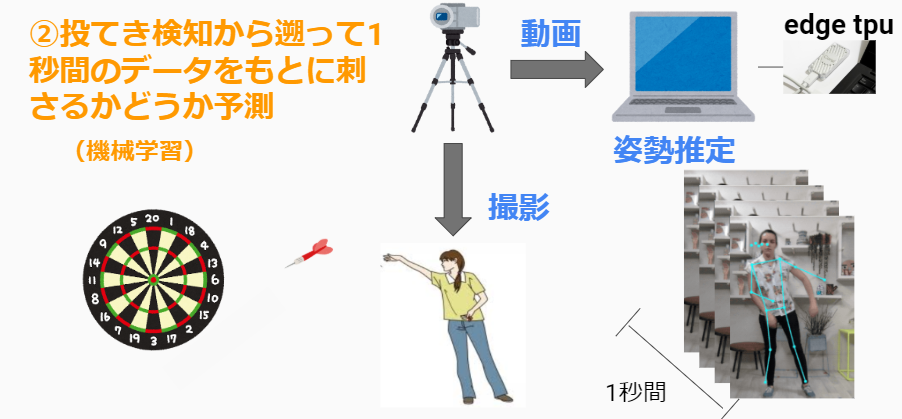

投てきを検知したら、1秒分のデータをさかのぼって機械学習モデルに入力し、ダーツがブル(中心)に刺さるのかどうか予測します。その際、Edge TPUという高速で機械学習の予測を行うデバイスを利用します。

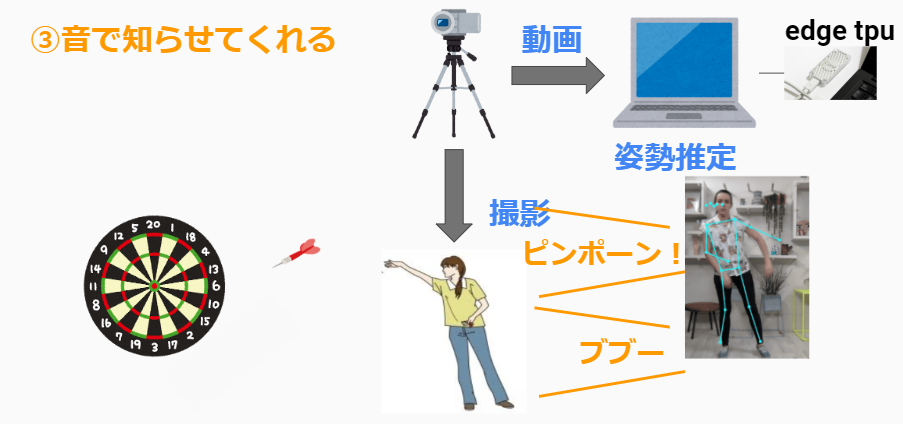

機械学習の判定の結果、ブルに刺さると思ったら「ピンポーン」外れると予測されたら「ブブー」と音がなって知らせてくれます。この時点でまだダーツは刺さっていません。

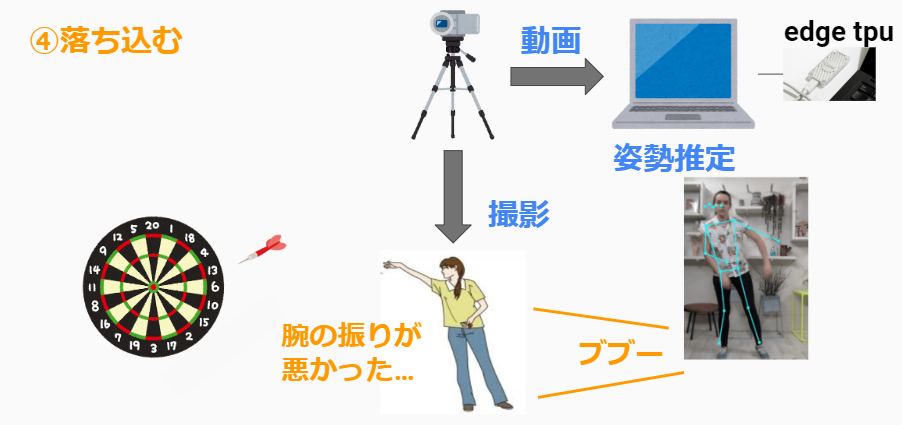

もし、外れると予測されたら悲しいですよね。まだダーツは刺さっていませんが、気分も落ち込むことでしょう。

しかし、人間、AIには負けたくないものです。人間はAIよりも優れていると信じてやみません。「AIなんかに自分の未来を予測されてなるものか!」と運命に抗いはじめました。この時点でまだダーツは刺さっていません

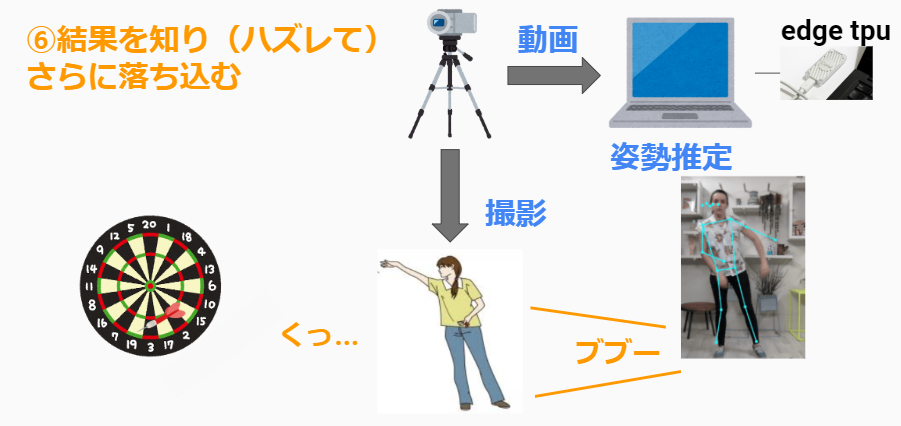

直後、本当にダーツがハズれたところに刺さった場合、少し期待した自分を思うと余計落ち込みます。

というプロダクトです。ご覧の通り、

0.2秒待てばわかることを0.2秒前に知って一喜一憂するためのアプリとなっています

技術について

ハードウェア

WEBカメラ

logicoolの普通のWebカメラ

- 1030p

- 30 fps

- USB 2.0

Coral's Edge TPU

Edge TPU は、Google が開発した TensorFlow Lite 形式の機械学習モデルを高速に演算(推論)するための ASIC のことです。

GCP と Edge TPU でつくるインテリジェント IoT 基盤

とにかく、めっちゃ早く機械学習の予測ができる

詳しくは上記記事をお読みになってください。

PC

Macbook Pro 2017

ソフトウェア

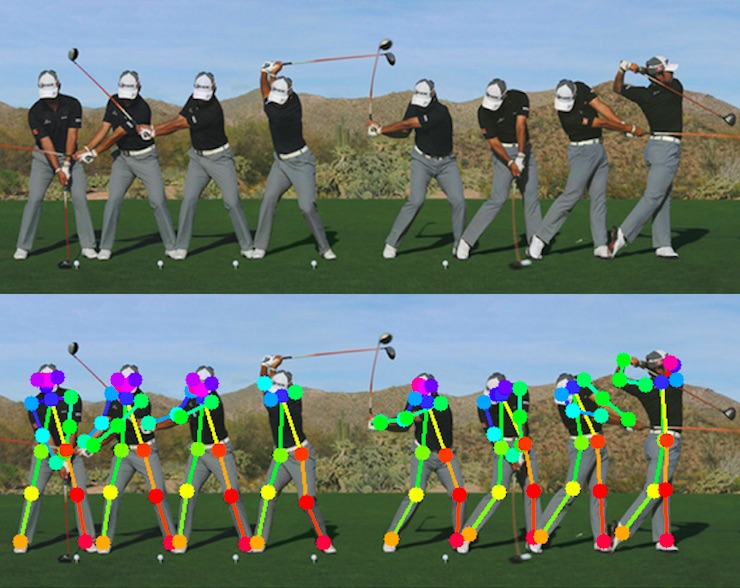

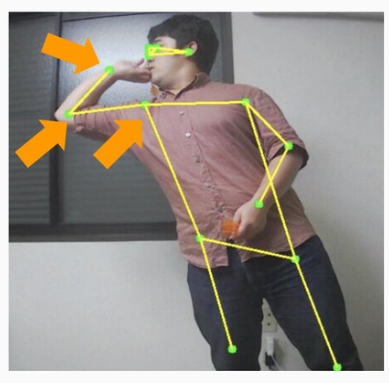

姿勢推定

PoseNetを利用

- 画像や動画をインプットとして人間䛾姿勢

をデータ化する - AIが画像を読み取り、関節䛾位置を推定

する - オープンソース䛾ライブラリが公開されて

おり、商用利用も可能

機械学習

- 説明変数(インプットデータ)

- 手首、肘、肩の各座標

- 最大値、最小値、平均、標

準偏差(テキトーです)

- 最大値、最小値、平均、標

- 手首、肘、肩の各座標

- 目的変数(予測するもの)

- ブルに刺さるかどうか

- データ量**(めっちゃ少ない)**

- ブル(命中):約40

- ハズレ:約200

- 手法

- ランダムフォレスト

結果

ダーツBULL命中予測マシン

— fujitako (@fujitako03) December 9, 2019

うまく予測できたバージョンhttps://t.co/UiWeXHwJq0

ダーツBULL命中予測マシン

— fujitako (@fujitako03) December 9, 2019

ダメダメバージョンhttps://t.co/DMq2wkJ4nf

①驚きの予測精度!

全然当たりません。正解率約50%(ランダムと同じ)

②驚きの予測速度!

刺さる前に間に合いません。刺さったあとに刺さるかどうかの予測を教えてくれます。知ってるわ!ってなります。

ごめんなさいタイトル詐欺です。本当はタイトルのものを作りたかったんです。ごめんなさい。

要するに

ダーツを投げたあとにランダムに音が鳴るおもちゃが爆誕しました!

反省

-

カメラの性能不足

- カメラのFPS(1秒間に何フレーム撮影するか)が30では足りなかった

- もっとスローモーション撮影などに対応したカメラが必要

- カメラからPCにデータを送るケーブルがUSB2.0ではなく3.0を使うべき

- その後の処理が早くても、データが届かないと何もできない

- カメラのFPS(1秒間に何フレーム撮影するか)が30では足りなかった

-

ブルに刺さったデータ不足

- 筆者の実力不足

今後

変な機械を作っている暇があったらダーツの練習に当てていこうと思います

この内容は Sports Analytics Meetupというイベントで発表したものです。他の皆さんはこの発表と違って非常にためになる発表をされており、とても勉強になるMeetupです。

弊社アドベントカレンダーでも、25日に今年のM-1分析を発表するので、是非見てください!