GPU非搭載のWindows/MacからローカルLLMコーディングする手順まとめ

今回は、UbuntuマシンでLM Studioを利用してOpenAI互換のAPIを立ち上げ、WindowsマシンのVSCodeから利用できるようにするまでの手順をまとめます。

🌟 ゴール

GPU非搭載端末のVSCodeでローカルAIコーディングする

✅ 検証環境

LLMサーバ(Ubuntu側)

- OS: Ubuntu 24.04

- GPU: GeForce RTX 5060 Ti(VRAM 16GB)

- ソフトウェア: LM Studio 0.3.15-11 x64

- モデル: Qwen3-30B-A3B-GGUF Q3_K_L

検証端末(Windows側)

- OS: Windows 11

- ソフトウェア: VSCode 1.99.3

- VSCode拡張機能: Continue

✅ 前提条件

- UbuntuでLM Studioをインストール済み

- WindowsとUbuntuは同一ネットワーク(同じWi-FiやLAN)上に接続されている

🛠️ 作業手順

1. Ubuntu側のLM Studio設定を確認

LM Studioを起動し、下タブでUser以外が選択されている事を確認

左タブ開発者から以下を有効化:

- Server Port → 1234(デフォルト)

- ローカルネットワークでサービング(Serve on local network) → ✅ チェック

- CORSを有効にする → ✅ チェック(ブラウザやアプリからの接続用)

-

Status: Stopped → Runningに変更

これにより、Ubuntuは 0.0.0.0 でバインドしLANに公開されます。

2. UbuntuのIPアドレスを確認

ifconfigコマンド等で確認。Wi-Fiなら wlp5s0、有線なら enp4s0 を確認。例:

inet 192.168.x.x netmask 255.255.255.0

この場合、Windowsからアクセス出来るエンドポイントURLは:

http://192.168.x.x:1234/v1/chat/completions

3. Ubuntuのファイアウォール(ufw)を設定

Ubuntuでは外部接続がブロックされていることが多いので、以下でポート1234を開放:

sudo ufw allow 1234

sudo ufw reload

ステータス確認:

sudo ufw status

4. Ubuntu側でローカル確認

Ubuntu上で一度接続確認:

curl http://192.168.x.x:1234/v1/models

モデル一覧が返ればOK。

5. Windows側から接続確認

Windowsのブラウザで:

http://192.168.x.x:1234/v1/models

同様にモデル一覧が返ればOK。

6. VSCodeのContinue設定例

C:\Users\ユーザー名\.continue\config.yaml のmodelsに以下を追加:

models:

- name: LM Studio Local

provider: openai

model: qwen3-30b-a3b

apiBase: http://192.168.x.x:1234/v1

apiKey: EMPTY

roles:

- chat

- edit

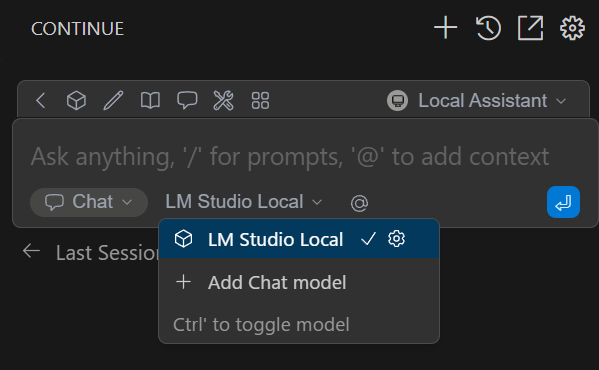

7. VSCodeのContinueでLM Studio Localを選択

LM Studio Localを選択し、ChatやEditで会話が返ればOK。

⚠️ よくあるハマりポイント

- 「ローカルネットワークでサービング」を有効化していない

-

ufwがポートを閉じている - Wi-Fiルーターがクライアント間通信をブロックしている(ゲストWi-Fiでは特に要注意)

- 設定ファイルのproviderにopenai以外を指定している

🔚 まとめ

- LM Studioのネットワーク公開設定を有効化する

- Ubuntuのファイアウォールを解放する

- 正しいIPでWindowsから接続する

- Continueの接続設定をする