初めてのアドカレです。

導入

今年の夏ごろから本格的にQiitaの記事投稿を始め、気づけば60本程度記事を投稿していました。それなりに見てもらえているようで、読者の皆様には感謝しております。

それなりに投稿数が増えてきた中、以下の記事を読んで「Qiitaの記事分析も自然言語だけでやれないかなー」と思い、実際にやってみました。

準備

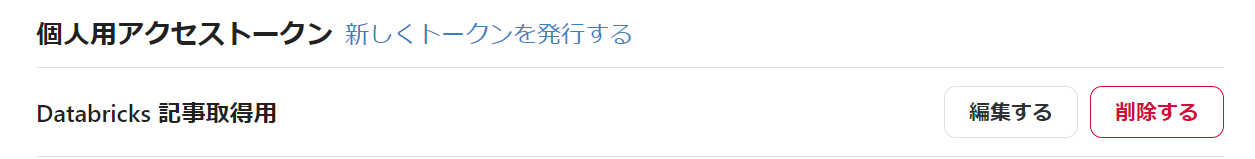

QiitaからAPIアクセス用のトークンを発行しておきます。

(設定メニューのアプリケーションタブより)

発行したアクセストークンを、Databricksのシークレットとして登録します。

シークレットについては以下を確認ください。

今回はスコープをqiita、キーをapi_tokenという名前で登録します。

Step1. Qiitaから記事一覧の取得

適当にノートブックを作成し、アシスタントに以下を指示します。

Qiitaから投稿記事の一覧を取得してください。

取得に必要なAPIキーはdbutilsのシークレットから取得してください。スコープはqiita、キーはapi_tokenです。

ページ当たり100件のデータを取得してください。

QiitaのAPIから記事一覧を取得するコードを生成してくれます。

というか、QiitaのAPIコールも普通に生成できるんだ。。。

こちらのコードをノートブックのセルに反映して実行。

import requests

import json

import os

# Get API key from secrets

api_key = dbutils.secrets.get(scope="qiita", key="api_token")

# Set endpoint and parameters

url = "https://qiita.com/api/v2/authenticated_user/items?page=1&per_page=100" # ページあたりの取得件数を100件にしてください。

headers = {"Authorization": f"Bearer {api_key}"}

# Send request

response = requests.get(url, headers=headers)

# Get response as JSON and parse

items = json.loads(response.text)

エラーなく処理が完了できました。

ただ、取得結果を表示してないので、追加の指示を入れます。

得られた記事の一覧をpysparkのデータフレームに変換して表示してください。

pysparkのデータフレームに変換して表示する処理が追加されました。

import pandas as pd

# Get API key from secrets

api_key = dbutils.secrets.get(scope="qiita", key="api_token")

# Set endpoint and parameters

url = "https://qiita.com/api/v2/authenticated_user/items?page=1&per_page=100"

headers = {"Authorization": f"Bearer {api_key}"}

# Send request

response = requests.get(url, headers=headers)

# Get response as JSON and parse

items = json.loads(response.text)

# Convert to pandas DataFrame

items_df = pd.json_normalize(items)

# Convert to PySpark DataFrame

spark_df = spark.createDataFrame(items_df)

# Show PySpark DataFrame

display(spark_df)

実行すると、結果が表示されます。

うん、すごい楽。驚きました。

それではデータも取れたので、集計・可視化していってみましょう。

※ ここからは全て画像で結果を表示。

Step2. ページビュー Top10表示

読まれている記事のTop10を表示してみます。

コードを実行すると以下の結果が表示されます。

ページビュー数は恥ずかしいので隠させてもらいました。

ただ、正しくTop10の記事タイトルが表示されています。

なお、現時点で一番読まれているのは以下の記事です。

※ Langchain周りの内容が古くなってきているので、注意が必要。。。

FUDAの金融データ活用チャレンジのコンペに参加した際の記事も多くの方に読んでもらえていました。感謝です。

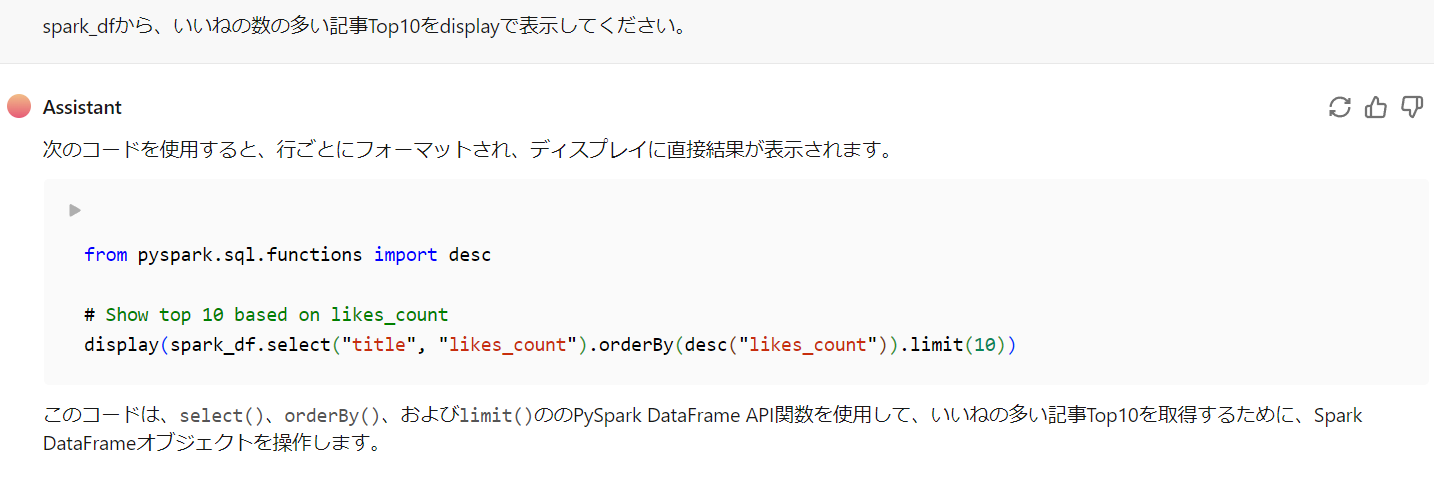

Step3. いいね数のTop10表示

同様にいいねの数Top10も表示してみます。

日本語のいいねという言葉だけで適切な項目を選んでくれました。すごー。

こちらだと2番目に以下の記事が来ていました。

勉強メモでお恥ずかしい限りですが、ありがたいです。

Step4. 曜日ごとの投稿件数合計

何曜日に投稿している頻度が高いのかを知るために、曜日ごとの投稿件数を見てみます。

実行すると月曜日始まりでソートした上でちゃんと表示できました。

Databricksならアシスタントを使わずともノーコードでグラフ化もできます。

土日がやはり一番多く投稿していますね。

金曜もそれなりに投稿しているのは少し驚き。だいたい飲んでいるのに。

Step5. タグごとのページビュー件数

タグごとのページビュー数を集計してみます。

タグは辞書型データのリスト形式で保管されているため、少しややこしいデータ構造となっているのですが、正しく集計できるのでしょうか。

実は指示に結構苦労したのですが、ちゃんと集計できました。

グラフも出してみます。

私の投稿のほとんどがDatabricksやLLMタグが付いているため、ページビュー数はこれらがダントツで多いです。

個人的な期待感としては、MLflowが日本でもっと普及して欲しいと思っているので、MLflowタグが付いた記事がもっと読まれると嬉しい。

まとめ

Databricksのアシスタント機能や可視化機能を使うだけで基本的な分析ができてしまいました。

(QiitaのAPIコールを普通にできたのが一番の驚きでした)

実際のところ、結構プロンプトの試行錯誤をしています。もしかしたら、それなりにコードが書ける人でないと適切な指示出しは難しいかもしれません。

しかし、それなりに正しいコードをバンバン生成できるので、生成されたコードを見ながら人が学習し、よりよい指示を出したり、コード自体も書けるようにステップを踏んでいける気がします。

やはりLLMの登場によって、開発の仕方は変わっていくなと改めて実感しました。

来年のアドベントカレンダーの時期には、どのように変わっているのか、未来が楽しみで仕方ありません。