n番煎じで恐縮ですが、流行に乗っかる形で試してみました!

※txt2imgの方です。

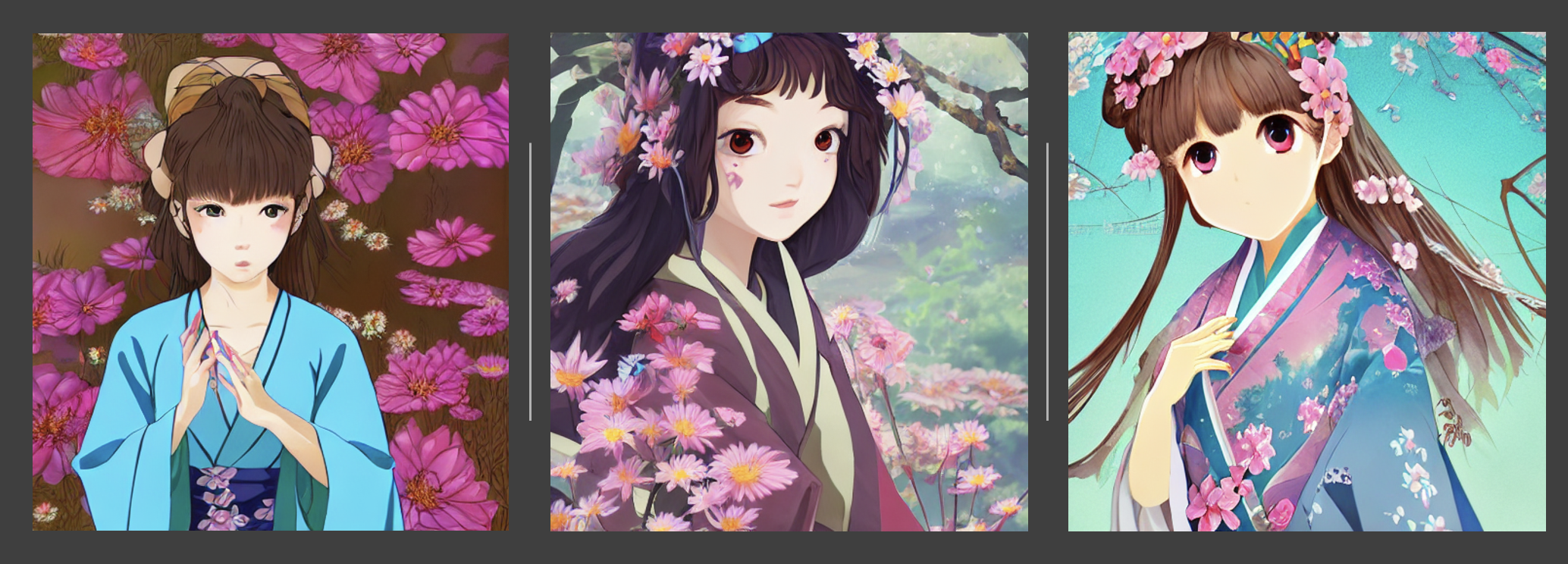

Prompt: 可愛い着物の女の子

Concept kawaii girl wearing kimono, beautiful face, thickly painted, flowers blooming, bird's eye view

動作環境

- ブラウザ:Vivaldi

- PC: Mac OS Big Sur

- CPU:3.5 GHz Dual-Core Intel Core i7

- メモリ:16GB

※Google Colaboratoryでやるのでブラウザ以外あまり関係ないですが一応記載

導入手順

▼Hugging Faceにて

1. ログインor新規登録

2. Access Token取得

- Role:

Read

3. HuggingfaceにてModelを選択。内容確認後、Acceptする。

※ライセンスはCreative ML OpenRAIL-Mライセンスです。

▼Google Colaboratoryにて

1. 準備

- ノートの新規作成

-

編集->ノートブックの設定を開く - ハードウェア アクセラレータにて、

GPUを選択する。

2. stable-diffusion-v1-4 のインストール

-

diffusers-0.2.4

-

ftfy-6.1.1

-

huggingface-hub-0.9.0

-

tokenizers-0.12.1

-

transformers-4.21.2

#コピペ !pip install diffusers==0.2.4 transformers scipy ftfy

※Linuxのコマンドは!始まりにする。

3. パイプラインを準備する

#コピペ

from diffusers import StableDiffusionPipeline

# 取得したトークンを使用してください

MY_TOKEN = "hf_xxxx"

pipe = StableDiffusionPipeline.from_pretrained("CompVis/stable-diffusion-v1-4", use_auth_token=MY_TOKEN)

pipe.to("cuda")

4. プロンプトを渡す

#コピペ

#着物を着た可愛い女の子

prompt = "Cute girl with kimono costumue"

image = pipe(prompt)["sample"][0]

image.save(f"output.png")

所感

- 導入は10分程度、設定にもよるが画像生成1枚あたり30秒以内

(CPUのみだと1枚あたり20分) - 動かしたくてもGPUスペックいる問題 -> Google Colaboratory

- プロンプトはコツがいる

https://ossan-gamer.net/post-81566/

※参考にさせていただきました!

欲しい絵を出すためには、シーン(カメラがあってライティング、被写体、マテリアルがどうで)の情報をいかにうまく具体的に言葉で与えるかと、テイストや品質に影響する単語をうまく付与するかが重要で、結果が大きく変わるなあと思いました。

今後

-

img2img試してみたいです。

https://github.com/CompVis/stable-diffusion/blob/main/scripts/img2img.py -

プロンプトをいろいろ変えて楽しんでみようと思います!

以上