この記事では、ComfyUIとWan2.1を使用して動画を変換する手順を説明します。

| 環境 | . |

|---|---|

| OS | Windows11 |

| GPU | RTX3090 |

1. 背景

ComfyUI は、Stable Diffusion や関連モデルを GUI で操作するためのオープンソースツールです。

Wan2.1は、アリババが開発したオープンソースの動画生成AIモデルで、テキストや画像から高品質な動画を生成できる点が特徴です。独自の3D VAEと拡散DiTを採用し、高速かつ高品質な動画生成を実現しています。

2. 環境構築

以下の手順で ComfyUI と必要なカスタムノード、モデルファイルをセットアップします。

2.1 ComfyUI のインストール

- ComfyUI の GitHub ページ の「Direct Link to Download」から Windows Portable 版をダウンロードします。

- ダウンロードした ZIP ファイルを解凍し、任意のフォルダに配置します。

2.2 ComfyUI-Manager のインストール

ComfyUI-Manager は、カスタムノードや依存関係を簡単に管理するための拡張機能です。

- 解凍したフォルダ内でコマンドプロンプトを開きます。

- フォルダ内で右クリック →

ターミナルを開く

- フォルダ内で右クリック →

- ComfyUI-Manager をクローンします:

git clone https://github.com/ltdrdata/ComfyUI-Manager.git

2.3 ComfyUI の起動

-

ComfyUI_windows_portableフォルダ内のrun_nvidia_gpu.batをダブルクリックして起動します。 - 初回起動時に依存関係(Python パッケージなど)が自動的にインストールされます。

2.4 ワークフローのインポート

- 以下のワークフローファイルをダウンロードします:

- ComfyUI のウェブインターフェース を開き、ダウンロードしたworkflowファイルをドラッグアンドドロップして読み込みます。

2.5 ComfyUI とカスタムノードの更新

- ComfyUI インターフェース右上の「Manager」ボタンをクリックします。

- 「Update: ComfyUI Nighty Version」を選択し、「Update ComfyUI」をクリックします。

- 更新後、ブラウザでページを再読み込み(F5 またはリロード)します。

- 「Install Missing Custom Nodes」を開き、表示されるすべてのノードをインストールします。

- バージョンはデフォルトのままで問題ありません。

- インストール後、「Restart」をクリックして ComfyUI を再起動します。

- ノードがすべて正しく読み込まれていることを確認します。

3. モデルファイルの配置

Wan2.1 モデルおよび関連ファイルを、Hugging Face からダウンロードし、適切なフォルダに配置します。

3.1 モデルファイルのダウンロードと配置

以下のファイルをダウンロードし、指定されたフォルダに格納します。ファイル名を変更する場合は注意してください。

| ファイル | ダウンロード元 | 格納先フォルダ |

|---|---|---|

diffusion_pytorch_model.safetensors |

リンク | ComfyUI_windows_portable\ComfyUI\models\diffusion_models |

wan_2.1_vae.safetensors |

リンク | ComfyUI_windows_portable\ComfyUI\models\vae |

clip_vision_h.safetensors |

リンク | ComfyUI_windows_portable\ComfyUI\models\clip_vision |

umt5_xxl_fp8_e4m3fn_scaled.safetensors |

リンク | ComfyUI_windows_portable\ComfyUI\models\text_encoders |

3.2 Depth-Anything モデルの配置

- 以下のファイルをダウンロードします:

- ファイルを以下に格納します:

ComfyUI_windows_portable\ComfyUI\custom_nodes\comfyui_controlnet_aux\ckpts\depth-anything\Depth-Anything-V2-Large

4. 動画変換の準備

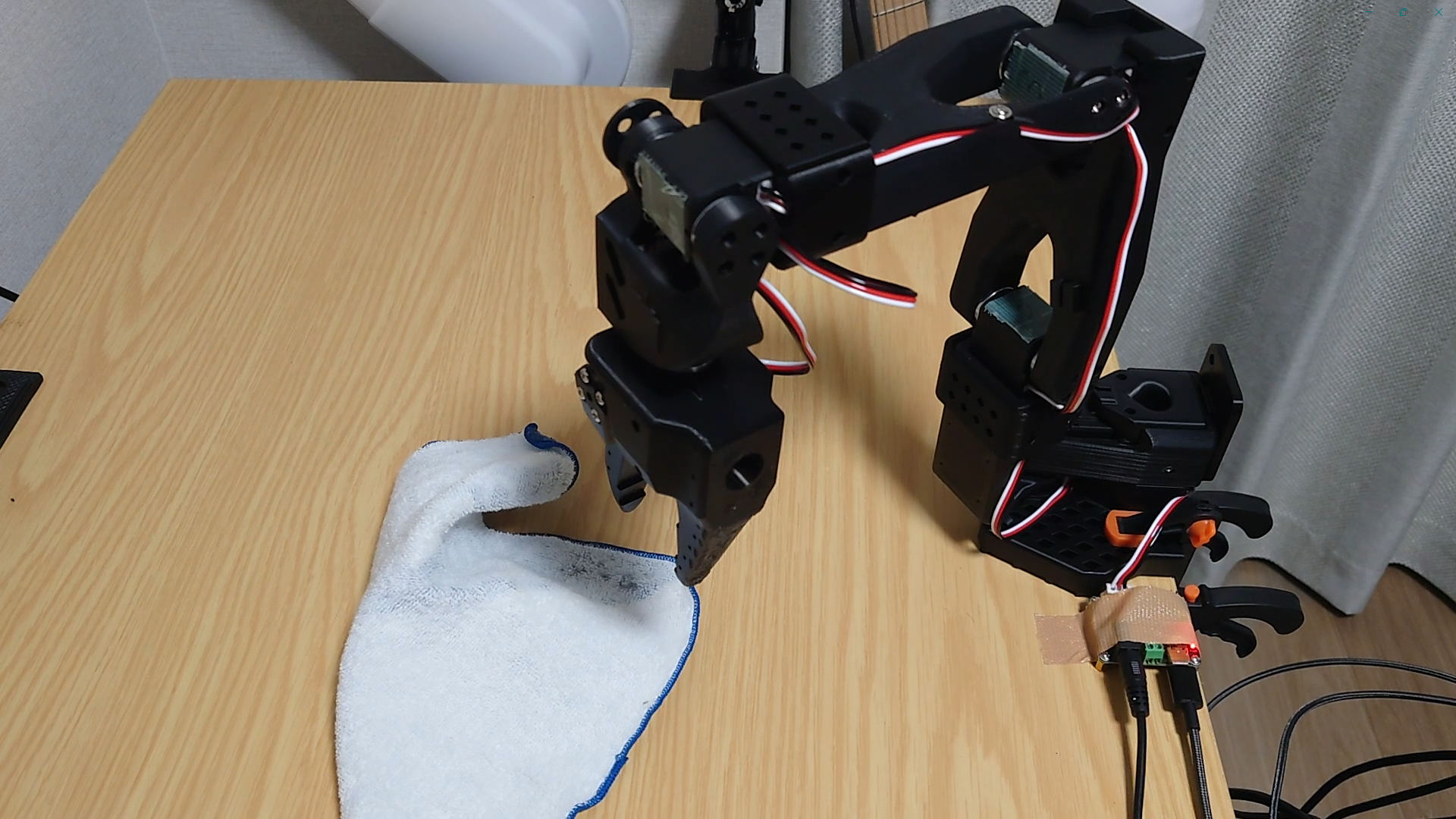

動画変換を行う前に、入力動画と置き換える画像を準備します。

4.1 入力動画の準備

- 変換したい動画ファイルを用意します

- 動画からフレームを抽出します(FFmpeg や動画編集ソフトを使用)

- 例: FFmpeg コマンドでフレーム抽出

ffmpeg -i input.mp4 -vf "select=eq(n\,100)" -vframes 1 frame_100.jpg

- 例: FFmpeg コマンドでフレーム抽出

- 抽出したフレームを元に、Gemini 2.0 Flash (Image Generation) などを利用して別の画像を生成します。

Original Generated

4.2 ワークフロー設定

- ComfyUI のワークフロー内で「Load Video」ノードを使用して入力動画を読み込みます。

- 動画サイズと長さを調整します:

- ControlNet の設定:

- 生成した画像をアップロードします:

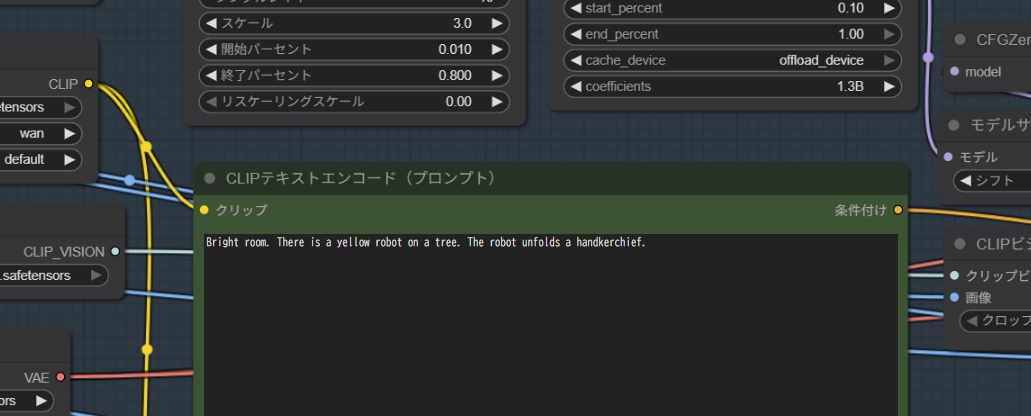

- ポジティブプロンプトを調整します:

5. 動画生成の実行

- すべての設定が完了したら、

実行するをクリックします - 生成処理が開始され、GPU の性能や動画の長さに応じて数分から数時間かかります

- 生成された動画は、ComfyUI の出力フォルダ(通常は

ComfyUI_windows_portable\ComfyUI\output)に保存されます

6. まとめ

この記事では、ComfyUIとWan2.1を使用してvideo to videoを実行する手順を解説しました。

こちらは今回生成した動画を編集したものです。

7. 参考