はじめに

- 本記事では UiPath GenAIアクティビティ にて最近追加されました 画像分析アクティビティ と オブジェクトを検出アクティビティ の利用方法について説明します。

- 従来の コンテンツを生成アクティビティ ではテキストの入出力のみが可能でしたが、画像分析アクティビティおよびオブジェクトを検出アクティビティでは画像とテキストを入力する、いわゆる マルチモーダル を扱えるようになりました。

- これらのアクティビティによって指定画像の説明文生成や画像内の文字列抽出など、画像を元にしたテキスト処理が可能になります。

UiPath GenAIアクティビティとは?

-

UiPath GenAIアクティビティとは生成AIアプリの開発をローコードで実現可能な機能群(パッケージ)であり、UiPathのSaaS型サービスであるAutomation Cloud環境にて利用可能です。

-

また生成AIアプリに必須となる大規模言語モデル(LLM)はUiPath社が管理・運用しているものを利用するため、ユーザー側で新たにデプロイする必要はなく、Automation Cloudアカウントがあればすぐに利用開始できます。

-

利用可能なアクティビティ一覧は こちら をご参照ください。

UiPath GenAIアクティビティはAutomation CloudのCommunity版でも現在利用可能ですが、今後 AIユニット ライセンスが必要となる可能性があります。

本番利用にあたってはライセンスのご購入をご検討ください。

画像分析アクティビティ

まず 画像分析アクティビティ の利用手順について説明します。このアクティビティでは指定画像に関する説明文の生成や文字抽出などのテキスト処理を行うことができます。

大まかな利用手順は次の通りです。

- 処理対象の画像を準備

- Integration ServiceにてGenAIアクティビティのコネクタを作成

- 画像分析アクティビティを使う① (画像のPublic URLを指定)

- 画像分析アクティビティを使う② (OneDrive上の画像ファイルを指定)

1. 処理対象の画像を準備

処理対象となる画像を指定フォーマットに従って準備します。

- 利用する言語モデルごとに処理可能な画像フォーマットが決まっています。

| 言語モデル | 画像フォーマット |

|---|---|

| GPT-4o | PNG, JPEG, WEBP, GIF (ただしアニメーションGIFは除く) |

| Gemini 1.5 Flash | PNG, JPEG |

| Gemini 1.5 Pro | PNG, JPEG |

- 上記以外の画像フォーマットの場合にはあらかじめ画像ツールなどを使ってPNGやJPEGなどに変換しておきます。

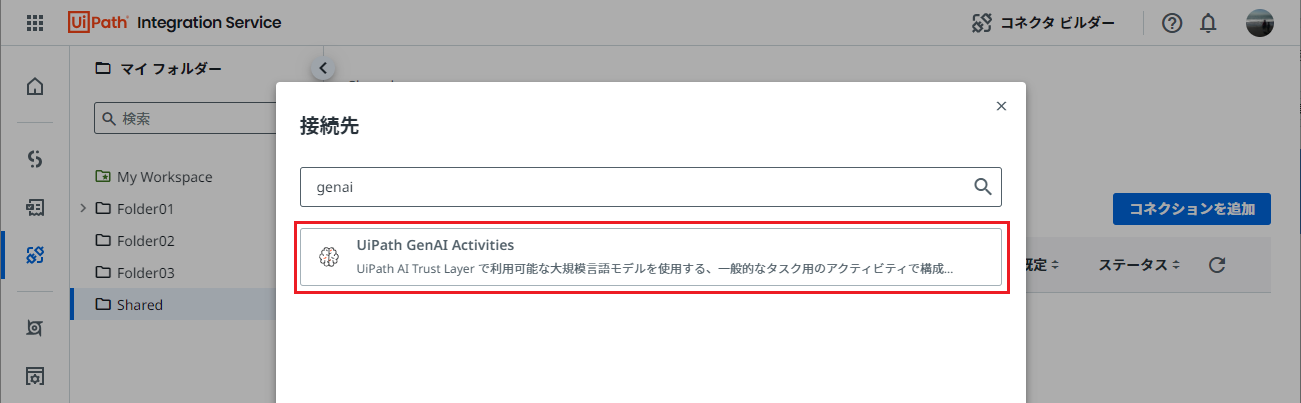

2. Integration ServiceにてGenAIアクティビティのコネクタを作成

GenAIアクティビティを利用するためにコネクタを作成します。

-

Automation Cloud にサインインし、Integration Serviceの管理画面に遷移します。

3. 画像分析アクティビティを使う① (画像のPublic URLを指定)

画像分析を行うためのワークフローを作成します。ここではインターネット上に公開されている画像を使用します。

-

新しいプロジェクト をクリックして、新規ワークフローを作成し、オートメーションのトリガーとして「手動のオートメーション」を選択します。

-

画像分析 アクティビティにて次のように値をセットします。

- モデル名:

gpt-4o-2024-05-13 - プロンプト: 質問文を入力します。今回の例では画像に関する説明文を生成したいので「

指定した画像について日本語で説明してください」と入力します。 - 画像の種類:

Public URL - パブリック URL:

https://collectionapi.metmuseum.org/api/collection/v1/iiif/39799/140190/main-image- ここでは メトロポリタン美術館 の葛飾北斎の 神奈川沖浪裏 の画像URLを直接指定しています。

- ここでは メトロポリタン美術館 の葛飾北斎の 神奈川沖浪裏 の画像URLを直接指定しています。

- モデル名:

-

- 下記のような回答が出力されていることを確認します。

この画像は、葛飾北斎の代表作「富嶽三十六景」の一つである「神奈川沖浪裏」です。 この浮世絵は巨大な波が押し寄せる瞬間を描き、波の力強さと動きを巧みに表現しています。 波の中に小舟がいくつか乗り上げ、漕ぎ手たちが必死に波に立ち向かっている様子が描かれています。 背景には穏やかな富士山が見え、対照的な静と動が強調されています。 全体として、自然の猛威と人間の小ささ、そして日本のアイコンである富士山の美しさが見事に融合した作品です。

このように指定画像の説明文を生成することが可能です。

4. 画像分析アクティビティを使う② (OneDrive上の画像ファイルを指定)

次にOneDrive上の画像ファイルを分析する手順について説明します。今回の例では画像内の表を読み取ってCSV形式で出力します。

-

OneDrive上のファイルにアクセスするには、Microsoft OneDrive & SharePoint のコネクタを作成します。左メニューよりIntegration Serviceの画面に遷移します。

-

Microsoft OneDrive & SharePoint コネクタを選択し、Microsoft OneDrive & SharePointに接続 をクリックします。

-

環境は既定値の Office 365 (default) を選択して 接続 をクリックし、Microsoftアカウントにてサインインします。

-

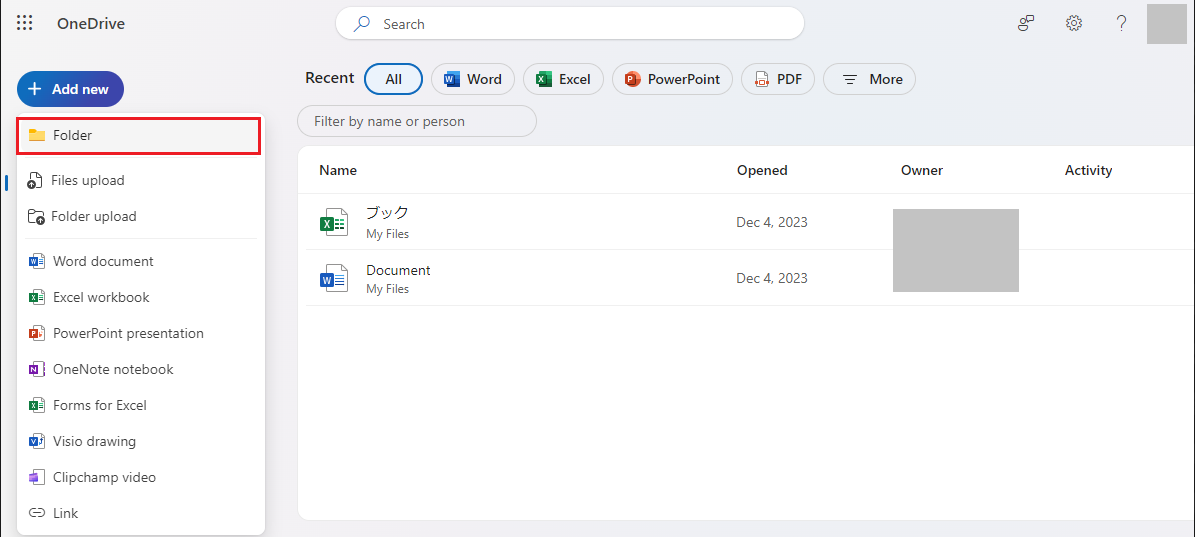

次に同じMicrosoftアカウントにてOneDrive (

https://*-my.sharepoint.com) にサインインし、テスト用のフォルダーを作成します。

-

Imagesというフォルダーを作成し、テスト用の画像をアップロードします。

- ここでは UiPathプロダクトライフサイクル > 自動化 の表の一部を画像にしたものを使用します。

- ここでは UiPathプロダクトライフサイクル > 自動化 の表の一部を画像にしたものを使用します。

-

Studio Webにて別のワークフローを作成し、手動トリガーを選択します。(+)をクリックし、Microsoft 365の ファイル/フォルダーを取得 アクティビティを追加します。

-

ファイル/フォルダーを取得 アクティビティにて ファイルまたはフォルダー のアイコンをクリックし、先ほどアップロードした画像ファイルを指定して保存します。

-

(+)をクリックして、画像分析 アクティビティを追加し、次のように設定します。

-

その他のプロパティを表示 クリックし、最大トークン数を

4096に変更します。これは応答文のトークン上限の既定値では出力が途中で途切れてしまう可能性があるため、上限値を増加させています。

-

(+)をクリックし、メッセージをログ を選択します。

-

下記のような回答が出力されていることを確認します。

製品,バージョン,サポート モデル,初回リリース日,メインストリーム サポート終了日,延長サポート終了日 Studio StudioX,2024.10.1,LTS,2024年7月1日,2026年7月1日,2027年7月1日 Studio StudioX,2023.10.8,LTS,2023年10月25日,2025年10月25日,2026年10月25日 Studio StudioX,2023.4.9,LTS,2023年4月27日,2025年4月27日,2026年4月27日 Studio StudioX,2022.10.14,LTS,2022年10月27日,2024年10月27日,2025年10月27日 Studio StudioX,2022.4.10,LTS,2022年5月9日,2024年5月9日,2025年5月9日 Studio StudioX,2021.10.10,LTS,2021年10月27日,2023年10月27日,2024年10月27日 Studio StudioX,2020.10.15*,LTS,2020年10月28日,2022年10月28日,2023年10月28日 Data Service 次の値に含まれる Automation Suite,2023.10.5,LTS,2023年11月3日,2025年11月3日,2026年11月3日 Data Service 次の値に含まれる Automation Suite,2023.4.8,LTS,2023年4月26日,2025年4月26日,2026年4月26日 Data Service 次の値に含まれる Automation Suite,2022.10.13,LTS,2022年11月14日,2024年11月14日,2025年11月14日 Data Service 次の値に含まれる Automation Suite,2022.4.14,LTS,2022年5月23日,2024年5月23日,2025年5月23日 Document Understanding 次の値に含まれる Automation Suite,2023.10.5,LTS,2023年11月3日,2025年11月3日,2026年11月3日 Document Understanding 次の値に含まれる Automation Suite,2023.4.8,LTS,2023年4月26日,2025年4月26日,2026年4月26日 Document Understanding 次の値に含まれる Automation Suite,2022.10.13,LTS,2022年11月14日,2024年11月14日,2025年11月14日 Document Understanding 次の値に含まれる Automation Suite,2022.4.14,LTS,2022年5月23日,2024年5月23日,2025年5月23日 Document Understanding 次の値に含まれる Automation Suite,2021.10.10,LTS,2021年11月3日,2023年11月3日,2024年11月3日

このようにOneDrive上の画像から文字列を抽出して特定のフォーマットで出力することが可能です。

オブジェクトを検出アクティビティ

-

次に オブジェクトを検出アクティビティ の利用方法について説明します。上記で説明した 画像分析アクティビティ は画像内のすべての文字を抽出できましたが、特定オブジェクト(エンティティ)に関する文字列をピンポイントで抽出するには オブジェクトを検出アクティビティ が便利です。

-

例として不動産物件の間取り図から各部屋の広さを検出してみます。サンプルは イラストACのサイト より拝借します。

-

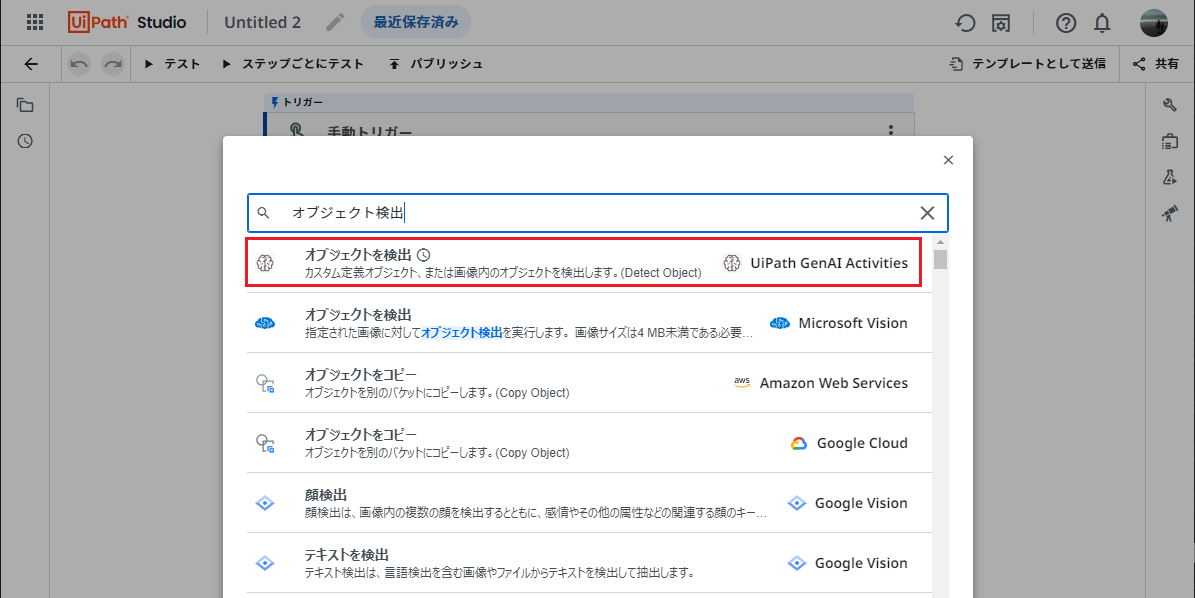

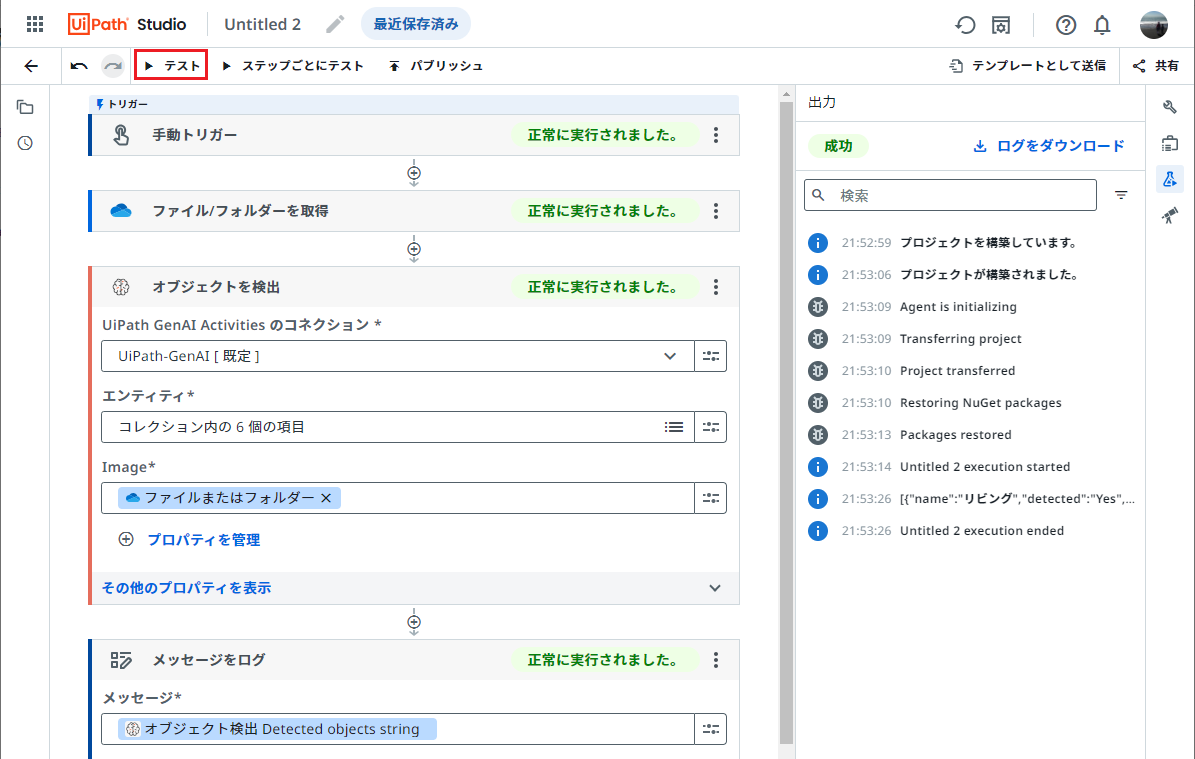

Studio Webにて 新しいプロジェクト をクリックして、新規ワークフローを作成し、オートメーションのトリガーとして「手動のオートメーション」を選択します。

-

(+)をクリックし、Microsoft 365の ファイル/フォルダーを取得 を選択し、ファイルとして

madori.jpgを指定して保存します。

-

オブジェクトを検出 アクティビティにて、エンティティ > その他を表示 > ディクショナリ ビルダー をクリックします。

-

検出するエンティティ(今回の例では各部屋の情報)を Entity name (検出対象のエンティティ名) と Description (エンティティを検出するための指示や説明文) のペアで次のように指定して保存します。

-

(+)をクリックし、メッセージをログ を選択します。

-

下記のような回答がJSON形式で出力されていることを確認します。

[ { "name": "リビング", "detected": "Yes", "details": "広さ9.0畳" }, { "name": "ダイニング", "detected": "Yes", "details": "広さ8.5畳" }, { "name": "キッチン", "detected": "Yes", "details": "広さ5.0畳" }, { "name": "洋室", "detected": "Yes", "details": "広さ10畳" }, { "name": "和室", "detected": "Yes", "details": "広さ6.0畳" }, { "name": "クローゼット", "detected": "Yes", "details": "有" } ] -

定義されたエンティティが検出された場合は

"detected": "Yes"となります。detailsフィールドで各エンティティの情報が正しいか確認してみましょう。 -

余力があれば他の間取り図を読み込ませてワークフロー内の

Entity nameの項目やDescriptionの記述を調整すると良いでしょう。

このように オブジェクトを検出アクティビティ は指定したオブジェクト(エンティティ)と指示文・説明文によって、画像内のエンティティの有無や関連する情報を抽出してJSON形式で出力することができます。

おわりに

今回はUiPath GenAIアクティビティに最近追加されました 画像分析アクティビティ と オブジェクトを検出アクティビティ を利用して、指定画像に関する説明文生成や画像内の特定文字を抽出する手順について説明しました。ぜひ皆さんも様々なユースケースでGenAIアクティビティをお試しください!