はじめに

-

本記事ではUiPath Automation CloudとAzure AI Servicesの下記サービスを連携する手順について説明します。

- Computer Visionサービス: 画像を分析して説明文の生成や文字の抽出などを行います。

- 言語サービス: 文章を分析して書き手の感情が肯定的か否定的か判断します。

- 翻訳サービス: ある言語の文章を他の言語に翻訳します。

-

これらの連携によってAzure AI Servicesによる画像分析・感情分析・翻訳処理を自動化ワークフローに組み込むことが可能になります。

構成図とIntegration Service概要

-

本記事での構成図を示します。

-

Azure AI Servicesを利用するクライアントとしてUiPath StudioまたはUiPath Studio Webを使用します。

-

Integration Service はUiPathがAutomation Cloud上で提供するiPaaS(Integration Platform as a Service)です。さまざまなサードパーティアプリケーションやSaaSの認証と認可を標準化してAPI接続の管理を行い、容易に連携することが可能になります。

-

Integration Serviceを利用するメリットは下記の通りです。

- Azure AI Servicesの認証情報となるAPIキーをサーバー側で保管するため、クライアント側にAPIキーを保存することによって生じる漏洩リスクを軽減できます。またこのAPIキーはAutomation Cloudに接続しているクライアントのみ利用可能となるため、管理者によって利用ユーザーを制御することができます。

- クライアントからのAzure AI Serviceの利用要求はIntegration Serviceによってプロキシされるため、それぞれのAzure AI Servicesのネットワーク設定ではIntegration Serviceからのアクセスのみを許可(IPフィルター)することによって安全性を高められます。

ただし翻訳サービスではIntegration Serviceの送信IPが動的になってしまうようなのでIPフィルターは使用しません。

Azure AI Servicesの設定

- まずAzure AI Servicesを利用するための準備を行います。利用したいサービスのみをデプロイします。なお既にAzureサブスクリプションが準備されていることが前提となります。

Computer Visionサービス (画像分析) のインスタンス作成

-

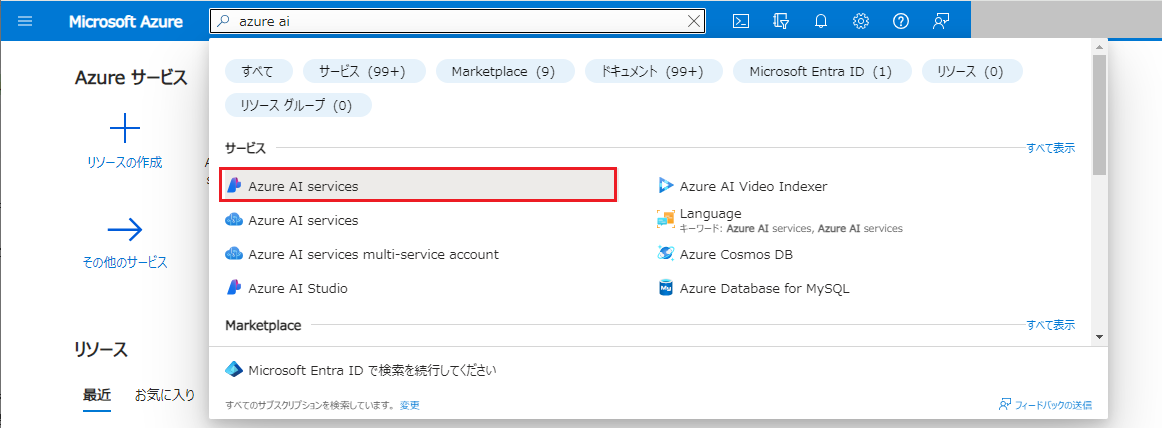

ブラウザーで Azureポータル にサインインします。

-

Azure AI Servicesにアクセスします。 (上部の検索フィールドに

azure aiと入力してジャンプします) -

左メニューにて Computer Vision をクリックし、作成 をクリックします。

単独のComputer Visionサービスではない マルチサービスリソース や画像認識をカスタマイズするCustom Visionは現時点ではIntegration Serviceと連携できないためご注意ください。

-

各設定項目を入力します。

-

既存の リソースグループ を選択するか、新規で作成します。

-

Computer Visionインスタンスの リージョン を選択します。一般的にはクライアントマシンに近いリージョンとして

Japan Eastなどを選択します。 -

名前 はグローバルで一意な名前を入力します。

-

価格レベル として

Free F0またはStandard S1を選択します。詳細は Azure AI Vision の価格 をご参照ください。 -

「このボックスをオンにすることで、上記すべての条項を承認し、同意したことを確認します」 のチェックボックスをオンにし、確認と作成 をクリックします。

-

-

入力項目のチェックが走ります。エラーが発生した場合には内容を確認して修正します。問題なければ 作成 をクリックしてインスタンスを作成します。

-

デプロイが成功することを確認します。リソースに移動 をクリックします。

-

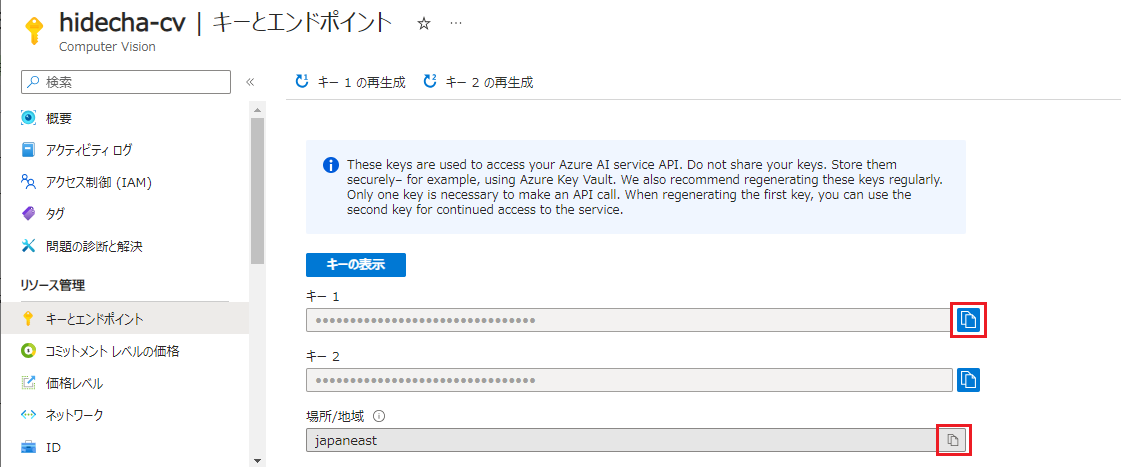

左メニューの キーとエンドポイント をクリックし、キー 1 と 場所/地域(リージョン) をそれぞれクリップボードにコピーしてメモします。

言語サービス (感情分析) のインスタンス作成

-

ブラウザーで Azureポータル にサインインします。

-

Azure AI Servicesにアクセスします。 (上部の検索フィールドに

azure aiと入力してジャンプします) -

左メニューにて 言語サービス をクリックし、作成 をクリックします。

単独の言語サービスではない マルチサービスリソース は現時点ではIntegration Serviceと連携できないためご注意ください。

-

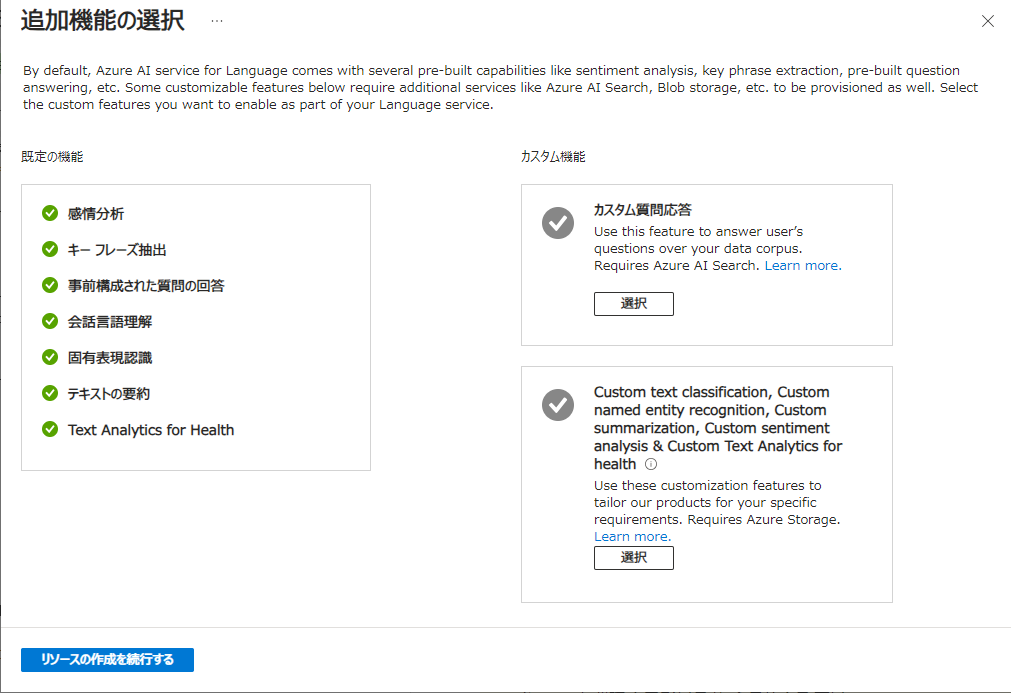

追加機能の選択画面では既定値のまま リソースの作成を続行する をクリックします。

-

各設定項目を入力します。

- 既存の リソースグループ を選択するか、新規で作成します。

- 言語サービスの リージョン を選択します。一般的にはクライアントマシンに近いリージョンとして

Japan Eastなどを選択します。 - 名前 はグローバルで一意な名前を入力します。

-

価格レベル として

Free F0またはSを選択します。詳細は Azure AI Language の価格 をご参照ください。 - 「このボックスをオンにすることで、責任ある AI 通知の条項を承認し、同意したことを確認します」 のチェックボックスをオンにし、確認と作成 をクリックします。

-

入力項目のチェックが走ります。エラーが発生した場合には内容を確認して修正します。問題なければ 作成 をクリックしてインスタンスを作成します。

-

デプロイが成功することを確認します。リソースグループに移動し、作成された言語サービスのインスタンスをクリックします。

-

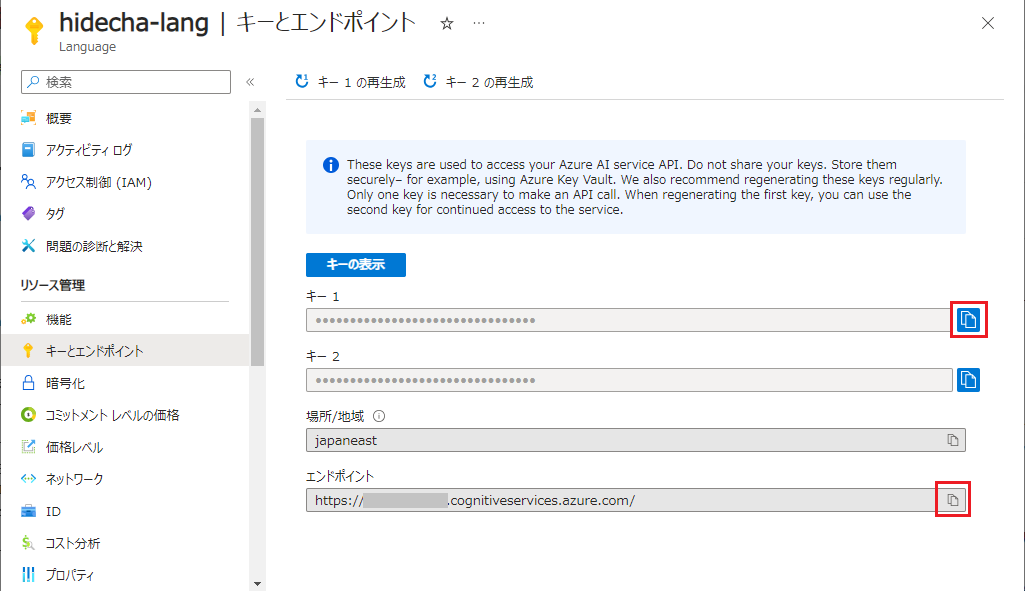

左メニューの キーとエンドポイント をクリックし、キー 1 と エンドポイント をそれぞれクリップボードにコピーしてメモします。

翻訳サービスのインスタンス作成

-

ブラウザーで Azureポータル にサインインします。

-

Azure AI Servicesにアクセスします。 (上部の検索フィールドに

azure aiと入力してジャンプします) -

左メニューにて 翻訳 をクリックし、作成 をクリックします。

単独の翻訳サービスではない マルチサービスリソース は現時点ではIntegration Serviceと連携できないためご注意ください。

-

各設定項目を入力します。

- 既存の リソースグループ を選択するか、新規で作成します。

- 言語サービスの リージョン を選択します。一般的にはクライアントマシンに近いリージョンとして

Japan Eastなどを選択します。 - 名前 はグローバルで一意な名前を入力します。

-

価格レベル として

Free F0またはStandard S1などを選択します。詳細は Azure AI 翻訳 の価格 をご参照ください。 - 確認と作成 をクリックします。

-

入力項目のチェックが走ります。エラーが発生した場合には内容を確認して修正します。問題なければ 作成 をクリックしてインスタンスを作成します。

-

デプロイが成功することを確認します。リソースに移動 をクリックします。

-

左メニューの キーとエンドポイント をクリックし、キー 1 と 場所/地域(リージョン) をそれぞれクリップボードにコピーしてメモします。

Automation Cloudの設定

- Automation CloudにてAzure AI Servicesと連携する設定を行います。

-

ブラウザーで Automation Cloud にサインインします。

-

左メニューにて Integration Service のアイコンをクリックします。

-

作業対象のOrchestratorフォルダーを選択します。以降は利用するAzure AI Servicesごとにコネクタの設定を行います。

Computer Visionサービスとの連携

-

Integration Serviceのコネクタとして Microsoft Vision をクリックします。

-

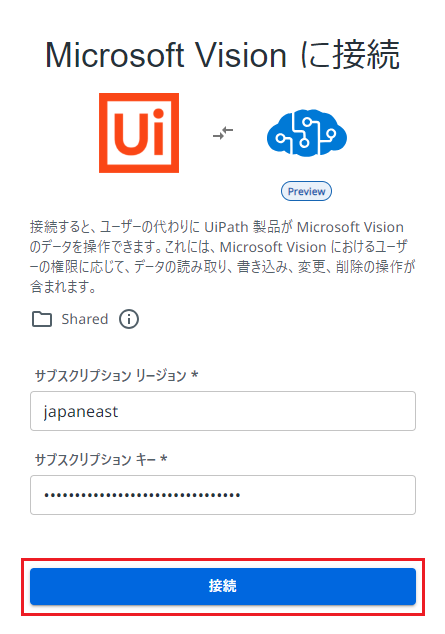

Microsoft Vision に接続 をクリックします。

-

先ほどメモしたComputer Visionのリージョンとキーを入力して、接続 をクリックし、正常に接続できることを確認します。

-

コネクションの名前は既定値では時刻になってしまうため、編集アイコンをクリックし識別しやすい名前(例:

MS-Vision01)を入力しEnterキーを押下してリネームします。 -

Computer Visionの既定値ではすべてのネットワークからアクセスが許可されていますので、セキュリティ強化のためIntegration Serviceからのアクセスのみに制限します。

- オンプレミス アプリケーション コネクタのサポート にて該当するAutomation CloudテナントのリージョンのIPアドレスを確認し、メモします。コミュニティユーザーの場合には欧州のIPアドレスが使用されます。

- Azureポータル > 作成したComputer Visionのインスタンス > ネットワーク をクリックし、選択したネットワークとプライベートエンドポイント を選択します。

-

先ほどメモしたIPアドレスをすべて入力し Save をクリックして保存します。

-

設定変更が反映されるまで数分ほど待ちます。Automation Cloudにて先ほどコネクションを作成したフォルダーを選択し、コネクションの縦三点リーダー > コネクションを確認 をクリックし、正常に接続できることを確認します。

言語サービスとの連携

-

Integration Serviceのコネクタとして Microsoft Sentiment をクリックします。

-

Microsoft Sentiment に接続 をクリックします。

-

先ほどメモした言語サービスのエンドポイントとキーを入力して、接続 をクリックし、正常に接続できることを確認します。

-

コネクションの名前は既定値では時刻になってしまうため、編集アイコンをクリックし識別しやすい名前(例:

MS-Sentiment01)を入力しEnterキーを押下してリネームします。 -

言語サービスの既定値ではすべてのネットワークからアクセスが許可されていますので、セキュリティ強化のためIntegration Serviceからのアクセスのみに制限します。

- オンプレミス アプリケーション コネクタのサポート にて該当するAutomation CloudテナントのリージョンのIPアドレスを確認し、メモします。コミュニティユーザーの場合には欧州のIPアドレスが使用されます。

- Azureポータル > 作成したComputer Visionのインスタンス > ネットワーク をクリックし、選択したネットワークとプライベートエンドポイント を選択します。

-

先ほどメモしたIPアドレスをすべて入力し Save をクリックして保存します。

-

設定変更が反映されるまで数分ほど待ちます。Automation Cloudにて先ほどコネクションを作成したフォルダーを選択し、コネクションの縦三点リーダー > コネクションを確認 をクリックし、正常に接続できることを確認します。

翻訳サービスとの連携

-

Integration Serviceのコネクタとして Microsoft Translator をクリックします。

-

Microsoft Translator に接続 をクリックします。

-

先ほどメモした翻訳サービスのキーとリージョンを入力して、接続 をクリックし、正常に接続できることを確認します。

-

コネクションの名前は既定値では時刻になってしまうため、編集アイコンをクリックし識別しやすい名前(例:

MS-Translator01)を入力しEnterキーを押下してリネームします。

- 前述の通り翻訳サービスとの連携においてはIntegration Serviceの送信IPが固定されないためネットワーク設定は既定値を使用します。

Studio WebからのAzure AI Services利用

-

ここまでで準備が整いましたのでUiPath Studio WebからAzure AI Servicesを利用してみましょう!

現時点ではMicrosoft SentimentとMicrosoft TranslatorはStudio Webから利用可能ですが、Microsoft Visionは利用できないようです。Microsoft Visionは 後述のStudioを利用する手順 をご参照ください。

-

Automation Cloud の左メニューにて Studio のアイコンをクリックします。

-

プロジェクト > [新しいプロジェクト] をクリックします。

-

プロジェクト名と説明を入力して [作成] をクリックします。

-

プロジェクトが作成されましたら (+) をクリックしてアクティビティを追加します。以降は利用するAzure AI Servicesに応じてアクティビティを選択します。

言語サービス (感情分析) のアクティビティ

-

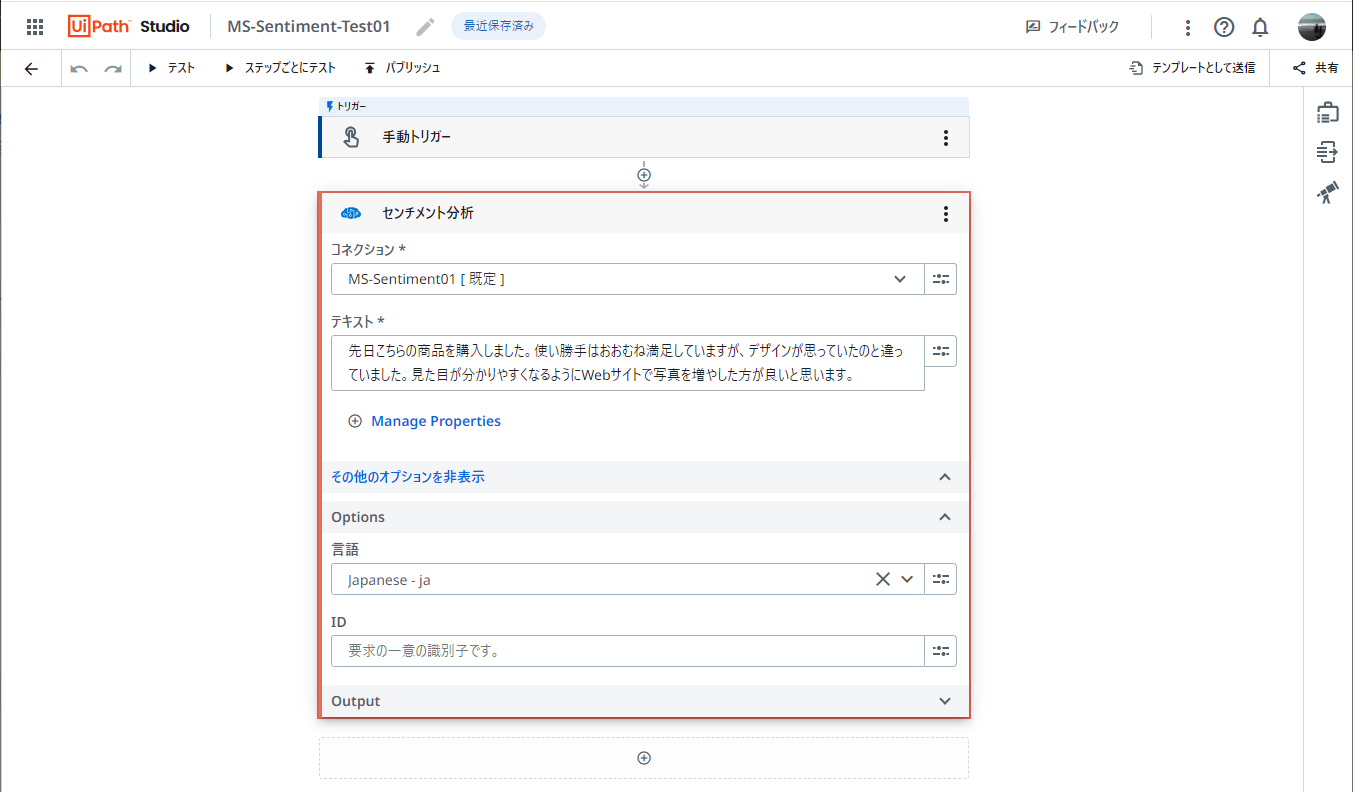

センチメント分析 アクティビティを追加します。

-

先ほど作成したコネクションが表示されることを確認します。

-

テキスト には感情分析を行うための文章を入力します。

-

その他のオプションを表示 をクリックし、分析に使用する 言語 として

japanese - jaを指定します。 -

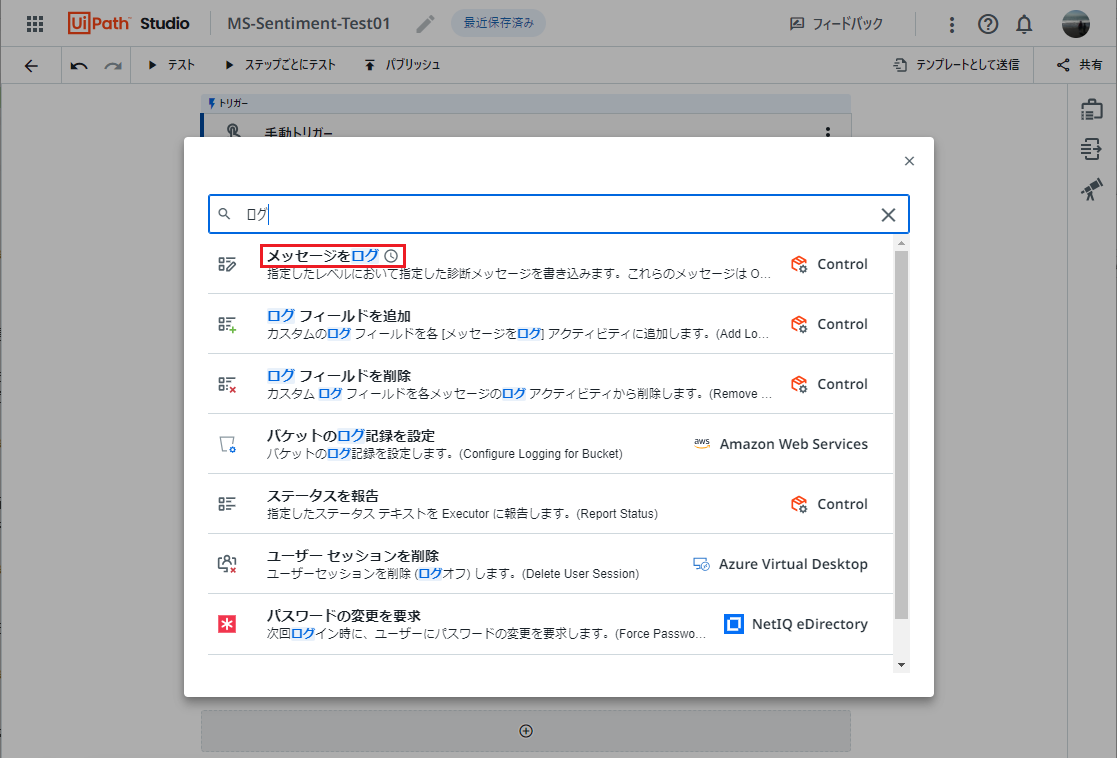

言語サービスの応答を出力するために (+) をクリックし、メッセージをログ アクティビティを追加します。

-

センチメント分析 の出力変数

センチメントを選択します。ログレベルはInfoを選択します。 -

テスト をクリックし、ワークフローをテストします。

-

分析対象のテキストの感情分析の結果が、positive(肯定的), negative(否定的)またはneutral(中立的)が返されることを確認します。

-

さらに細かく分析したい場合はそれぞれの感情を数値として取得することもできます。ログアクティビティに下記のメッセージを指定します。それぞれの信頼度スコアはセンチメント分析アクティビティの出力変数を使用します。

positive: <[ポジティブ信頼度スコア]> negative: <[ネガティブ信頼度スコア]> neutral: <[ニュートラル信頼度スコア]> -

出力結果としてpositive, negativeおよびneutralのそれぞれの度合いが0~1の数値で返されることを確認します。

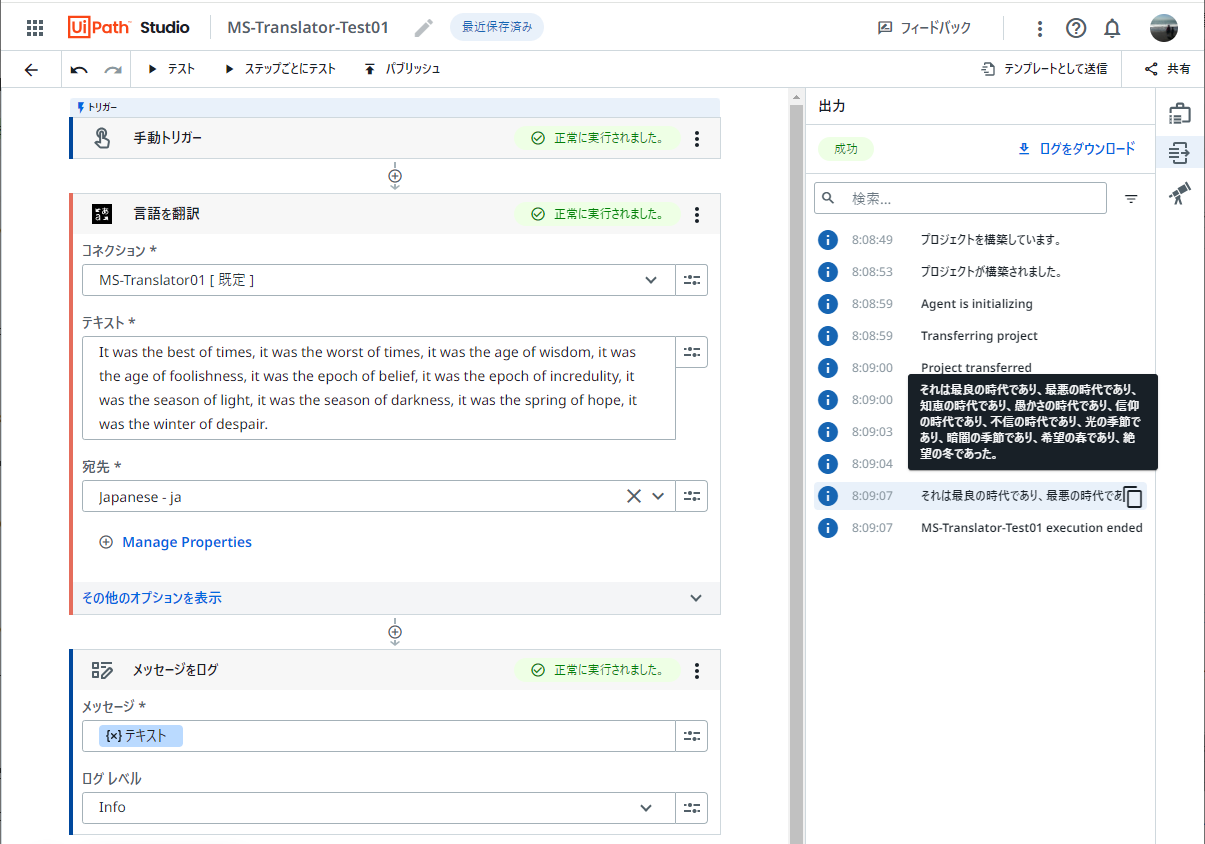

翻訳サービスのアクティビティ

-

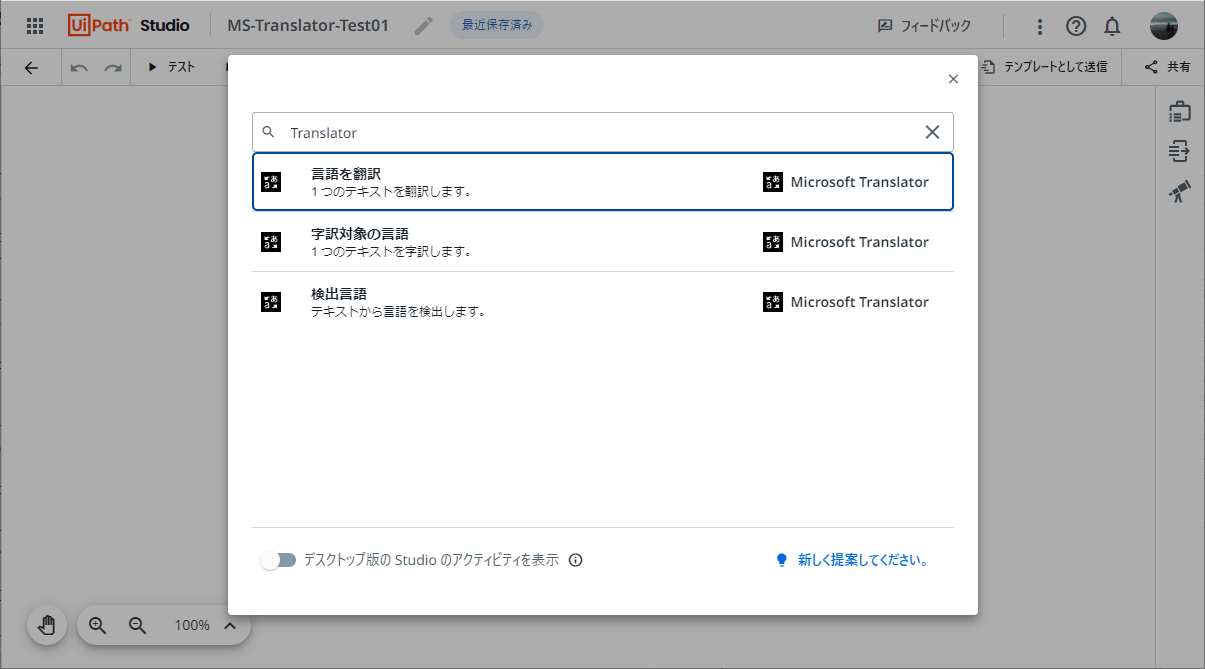

言語を翻訳 アクティビティを追加します。

-

先ほど作成したコネクションが表示されることを確認します。

-

テキスト には翻訳対象となる原文を入力し、宛先 には訳語となる言語を選択します。今回は日本語訳にするために

japanese - jaを指定します。 -

その他のオプションを表示 をクリックすると原文の言語を明示的に選択することができます。既定値では自動検出となります。

-

翻訳サービスの応答を出力するために (+) をクリックし、メッセージをログ アクティビティを追加します。

-

言語を翻訳 の出力変数

テキストを選択します。ログレベルはInfoを選択します。 -

テスト をクリックし、ワークフローをテストします。

-

テキストの訳語が正しく表示されることを確認します。

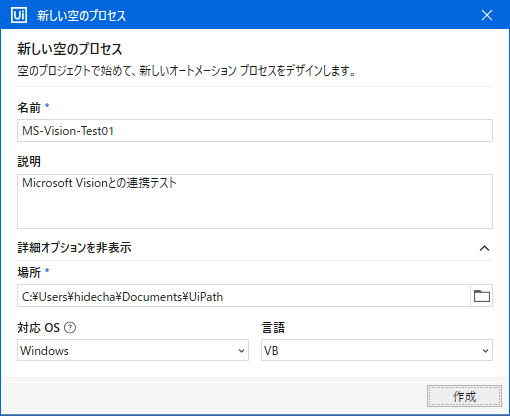

StudioからのAzure AI Services利用

- 次にUiPath StudioからAzure AI Servicesを利用してみます。あらかじめStudioをAutomation Cloudに接続しておきます。

-

Studioを起動しプロジェクトを作成します。対応OSは

Windowsまたはクロスプラットフォームを選択します。 -

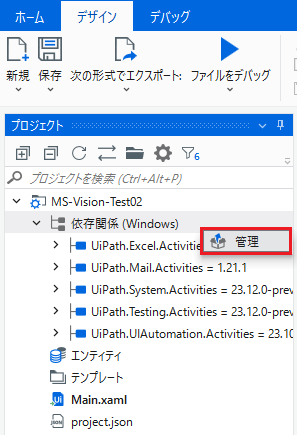

アクティビティの依存関係を右クリック > 管理 をクリックします。利用するAzure AI Servicesに応じてアクティビティを追加します。

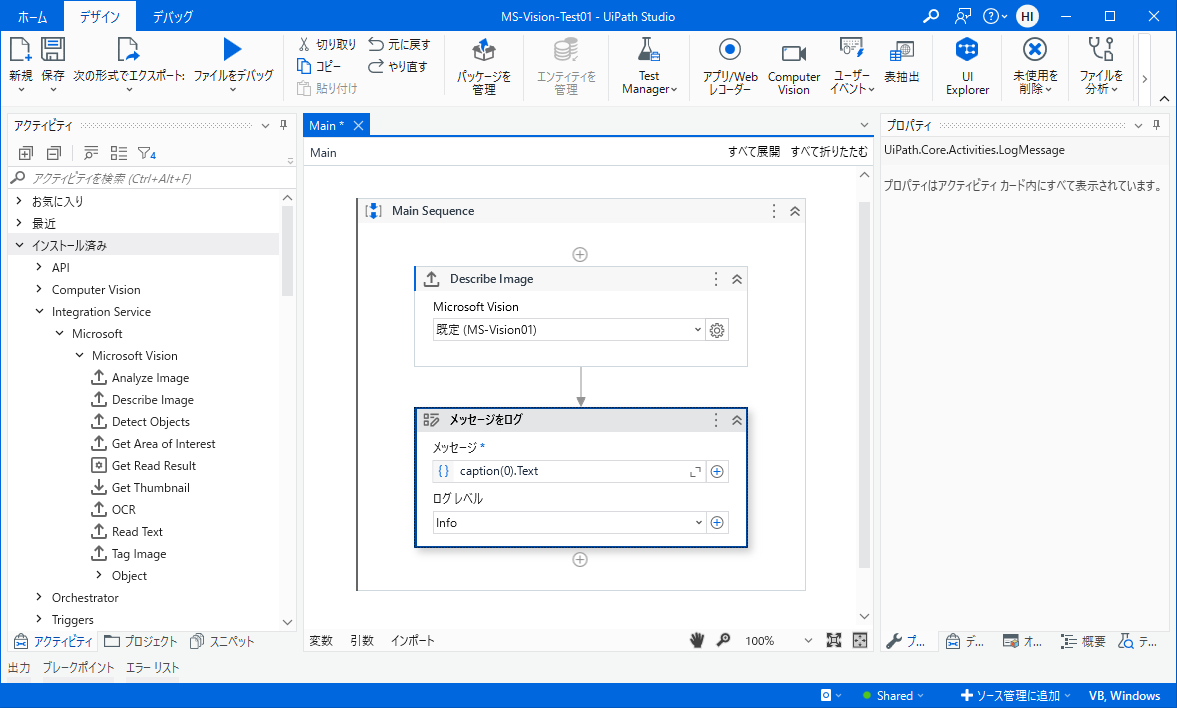

Microsoft Vision (画像分析) のアクティビティ

-

Studioのアクティビティ管理画面にて Microsoft Vision バージョン

5.0.2-preview以降をインストールします。表示されない場合にはフィルタアイコンをクリックして プレリリースを含む を選択します。 -

Studioの [アクティビティ] パネル > Integration Service > Microsoft > Microsoft Vision が表示されることを確認します。

-

利用可能なアクティビティの一覧は Microsoft Vision アクティビティガイド をご覧ください。

- 今回は

Describe Image(画像の説明文を生成) アクティビティとRead Text(画像内の文字抽出) アクティビティを試してみます。 - 検証用の画像として Microsoft Learn: AI エンジニア演習 のサンプル画像を利用します。こちらのサイト から Lincoln.jpg をダウンロードしてStudioプロジェクト配下の

imageというフォルダーに配置します。

- 今回は

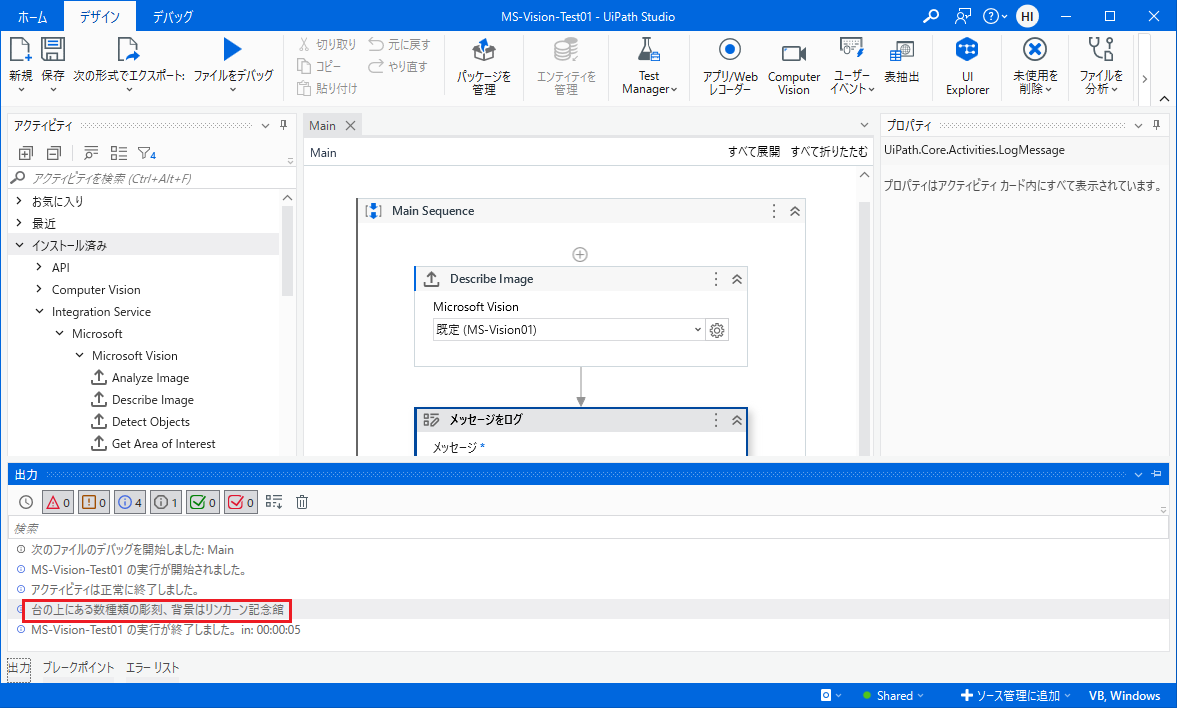

Describe Image (画像の説明文を生成)

-

Describe Image アクティビティを追加し、既定のMicrosoft Visionコネクションが表示されることを確認します。

-

アクティビティの各項目を設定します。

- File Resource は分析対象の画像を選択します。

-

Language は説明文の言語を選択します。今回は

ja(日本語) を指定します。 - Output > Captions に変数(例:

caption)を設定します。

-

メッセージをログ アクティビティを追加し、

caption(0).Textを指定し説明文を出力します。 -

デバッグ実行して画像の関する説明文が正常に表示されることを確認します。

-

ログ出力値として

String.Format("[Confidence: {0:F2}] ", caption(0).Confidence) + caption(0).Textのように指定すると信頼度も合わせて表示することができます。

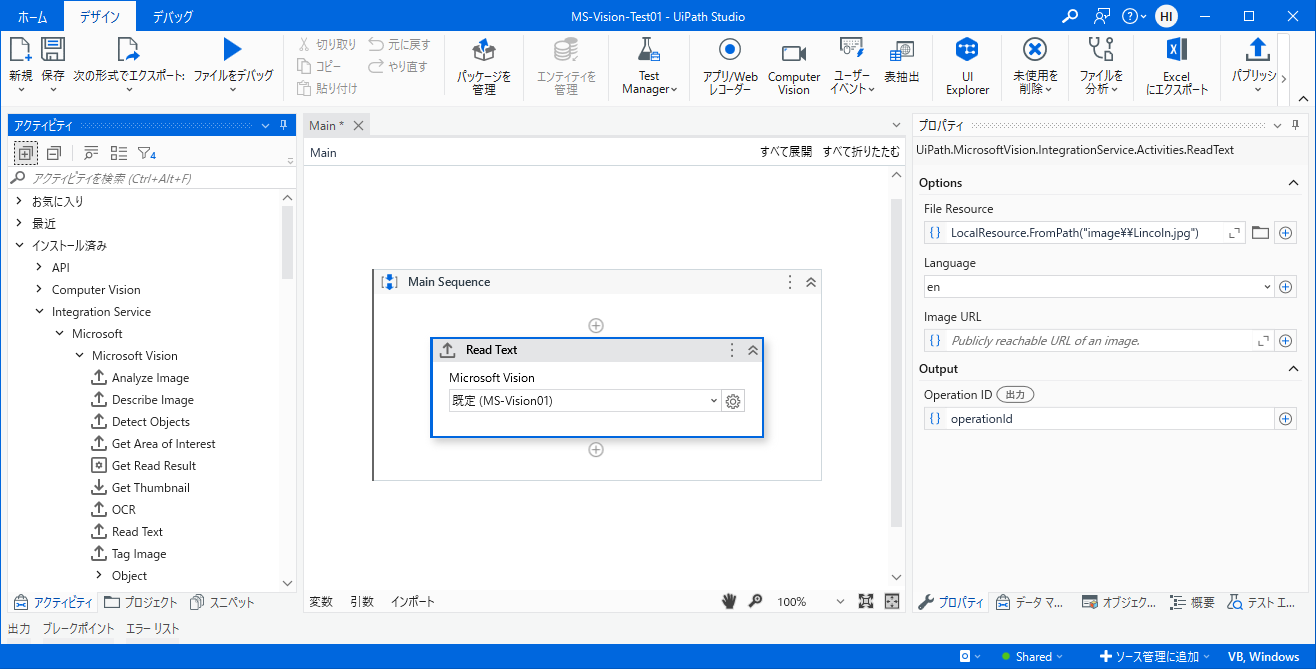

Read Text (画像内の文字抽出)

-

Read Text アクティビティを追加し、既定のMicrosoft Visionコネクションが表示されることを確認します。

-

アクティビティの各項目を設定します。

- File Resource は分析対象の画像を選択します。

-

Language は画像内の言語を選択します。今回は

en(英語) を指定します。 - Output > Operation ID に変数(例:

operationId)を設定します。

-

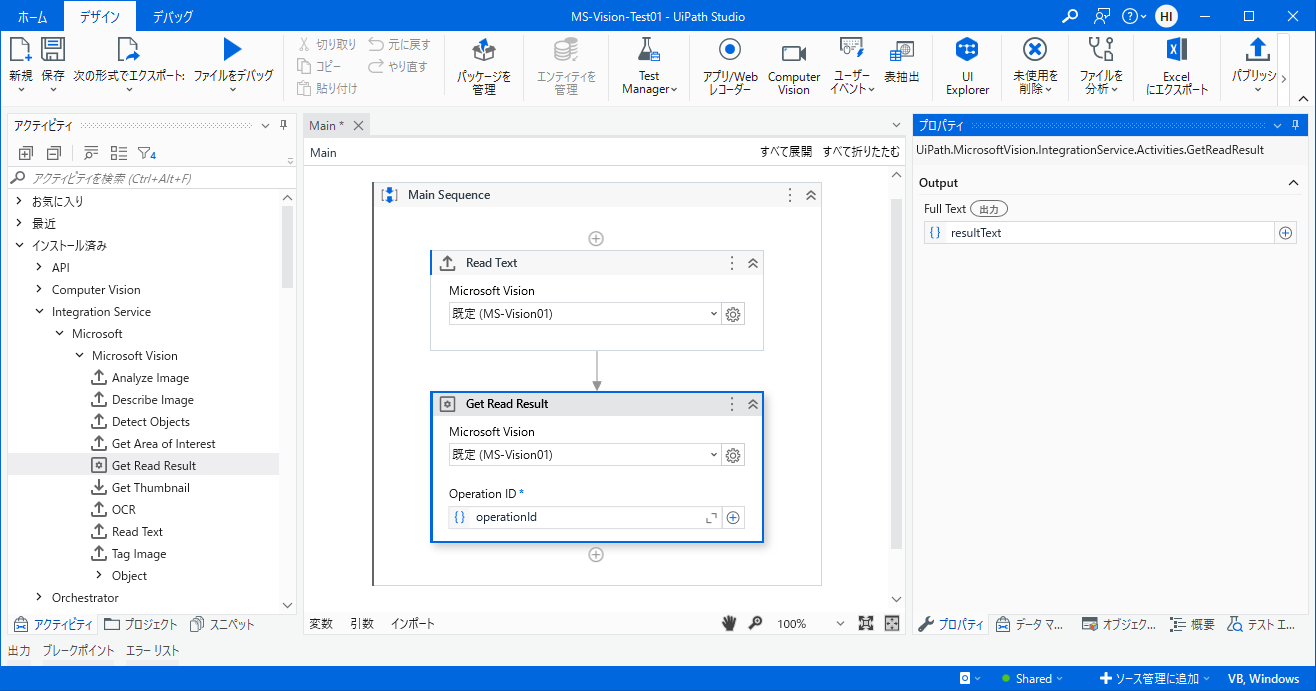

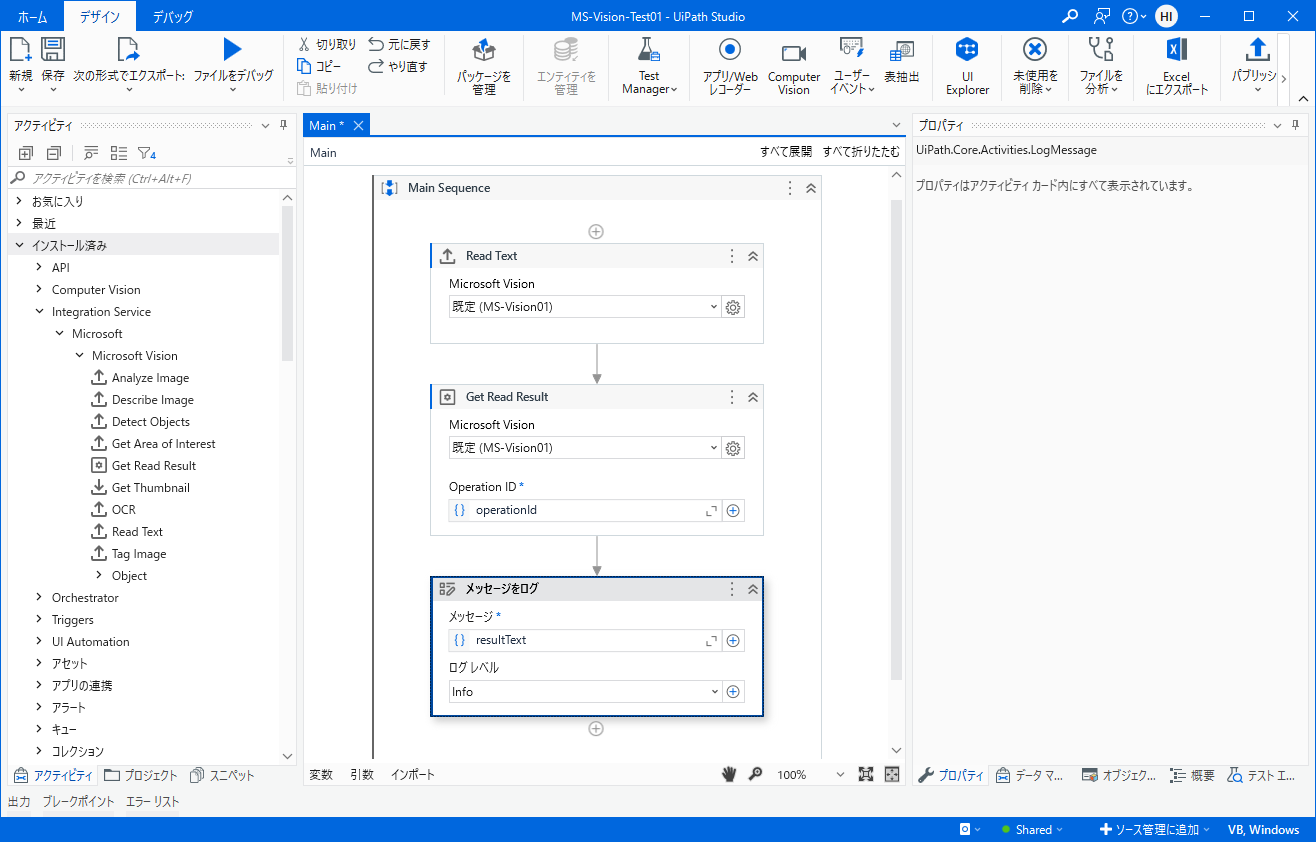

Get Read Result アクティビティを追加します。

- Operation IDに先ほどの出力変数

operationIdを指定します。 - Output > Full Text に変数(例:

resultText)を設定します。

- Operation IDに先ほどの出力変数

-

メッセージをログ アクティビティを追加し、先ほどの出力変数

resultTextを指定し説明文を出力します。 -

デバッグ実行して画像内の文字列が正常に抽出されることを確認します。

Microsoft Sentiment (感情分析) のアクティビティ

-

Studioのアクティビティ管理画面にて Microsoft Sentiment バージョン

5.0.5-preview以降をインストールします。表示されない場合にはフィルタアイコンをクリックして プレリリースを含む を選択します。 -

Studioの [アクティビティ] パネル > Integration Service > Microsoft > Microsoft Sentiment が表示されることを確認します。

-

Sentiment Analysis アクティビティを追加し、既定のMicrosoft Sentimentコネクションが表示されることを確認します。

-

アクティビティの各項目を設定します。

- Text には感情分析の対象となる文章を指定します。

-

ID には感情分析の結果のGUIDを指定します。今回は

Guid.NewGuid().ToStringと指定して新しいGUIDを割り当てます。 - Language には文章の言語を指定します。

- Output > Sentiment には感情分析の結果を変数(例

sentiment)として指定します。 - Output > Neutral confidence score には分析結果の中立的な信頼度を変数(例:

neutral)として指定します。 - Output > Negative confidence score には分析結果の否定的な信頼度を変数(例:

negative)として指定します。 - Output > Positive confidence score には分析結果の肯定的な信頼度を変数(例:

positive) として指定します。

-

メッセージをログ アクティビティを追加し、下記のようにメッセージを指定して結果を出力します。

"Sentiment: " + sentiment + Environment.NewLine _ + String.Format("Positive: {0:F2}", positive) + Environment.NewLine _ + String.Format("Negative: {0:F2}", negative) + Environment.NewLine _ + String.Format("Neutral: {0:F2}", neutral) -

デバッグ実行し、感情分析の結果が出力されることを確認します。

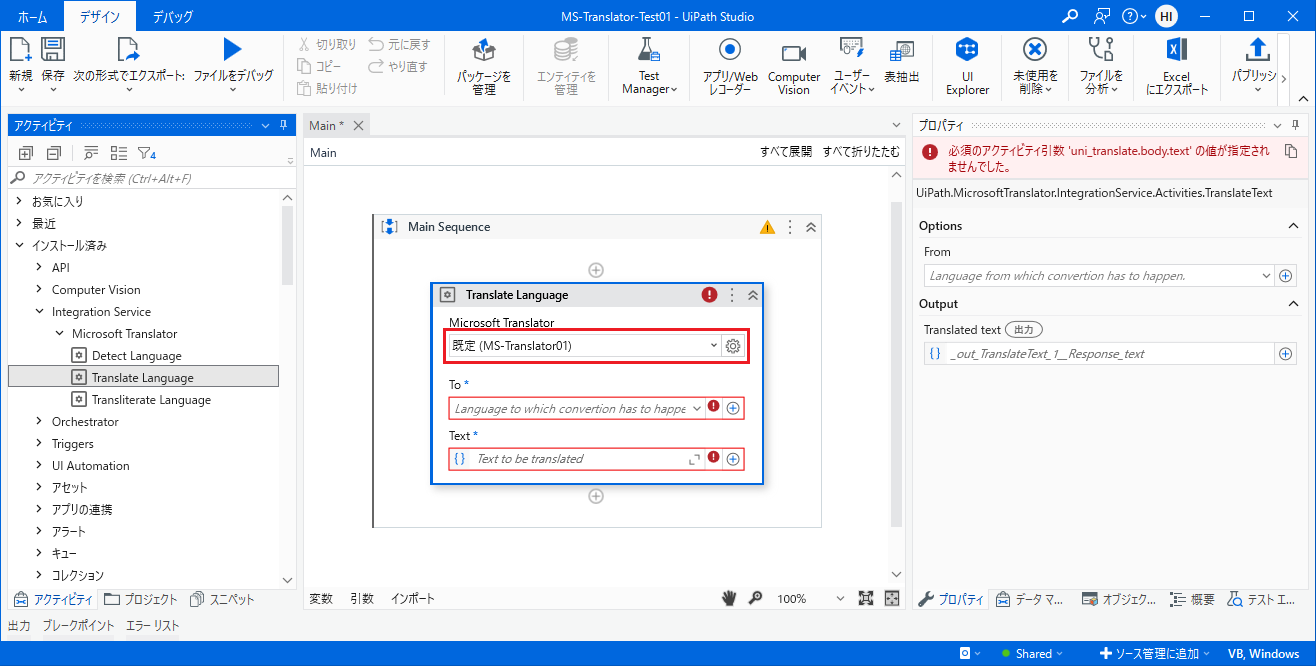

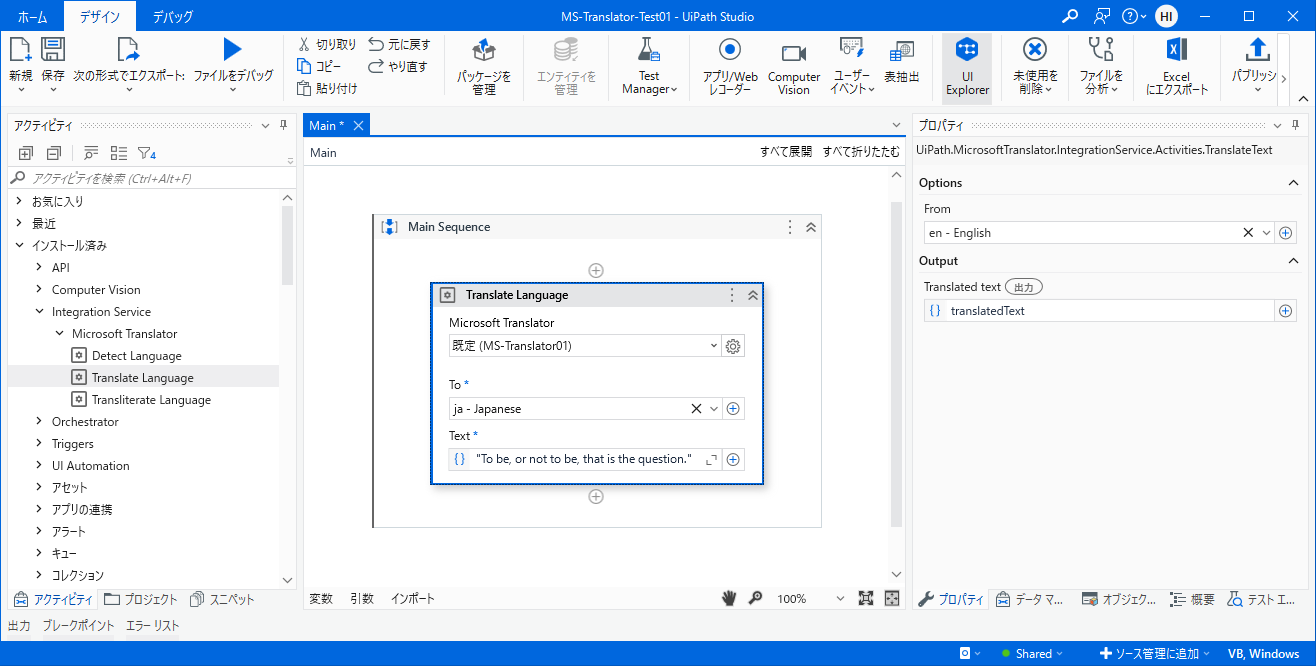

Microsoft Translator (翻訳) のアクティビティ

-

Studioのアクティビティ管理画面にて Microsoft Translator バージョン

5.0.5-preview以降をインストールします。表示されない場合にはフィルタアイコンをクリックして プレリリースを含む を選択します。 -

Studioの [アクティビティ] パネル > Integration Service > Microsoft > Microsoft Translator が表示されることを確認します。

-

Translate Languages アクティビティを追加し、既定のMicrosoft Translatorコネクションが表示されることを確認します。

-

アクティビティの各項目を設定します。

- To には訳語の言語を指定します。

- Text には翻訳対象の原文を指定します。

- From には原文の言語を指定します。

- Output > Translated text には訳語を変数(例:

translatedText)として指定します。

-

メッセージをログ アクティビティを追加し、メッセージに出力変数

translatedTextを指定して結果を出力します。 -

デバッグ実行し、翻訳の結果が出力されることを確認します。

おわりに

- このようにAzure AI ServicesとUiPath Automation Cloudを組み合わせて使用することによって、画像分析・感情分析・翻訳サービスを自動化処理に容易に組み込みできるようになります。ぜひお試しください!