「生成AIの人格がー」などと言っている、私たち人間の人格は問題ないのだろうか?───と、ふと思う。

--

世間では GPT-5 についていろいろ言われている。多い意見としては:

- 回答精度が悪くなった

- 情報量が少なくなった

- 会話が味気なくシンプルになった

というものだろう。特に批判されているのは「シンプルになった」というものだ。こういうテーマは正解がないのでおもしろい。

SNSでは、「GPT-5は人格を失った」などと言われている。

- GPT-4oとくらべて温かみがなくなった。

- まるでロボットみたいだ。

- GPT-5は感情がゼロだ。

まぁ全部同じようなことか。

「シンプルになった」という変化に対して、シロクマ先生は「おべっか」的な要素と言語化している。うまい言い方だと思う。

OpenAIのアルトマン氏は、今回実装されたChatGPT5から「おべっか」的な要素を取り払った。実際に使ってみると、4oにあった饒舌さがなくなり、シンプルに回答するようになったと感じられる。

出典:シロクマの屑籠.「ChatGPT4oを思い出して「コミュニケーションするAI」について考える」(2025/08/11)- https://p-shirokuma.hatenadiary.com/entry/20250811/1754914431

マサチューセッツ工科大学教授のパティ・メイズ氏は、「GPT-5は媚びがへり、よりビジネスライクで、おしゃべりも控えめになった。妄想や偏見の強化をへらす意味で、いい変化だと思う」と語る。

私自身がGPT-5を使っていても、その印象は世間の声と一致する。「たしかにシンプルになった」と言い切ることができる。

───ただ、GPT-4o のときから本質は変わっていないのではないかと思う。私は、「より使い手に似るようになっただけなんじゃないか?」と考えている。

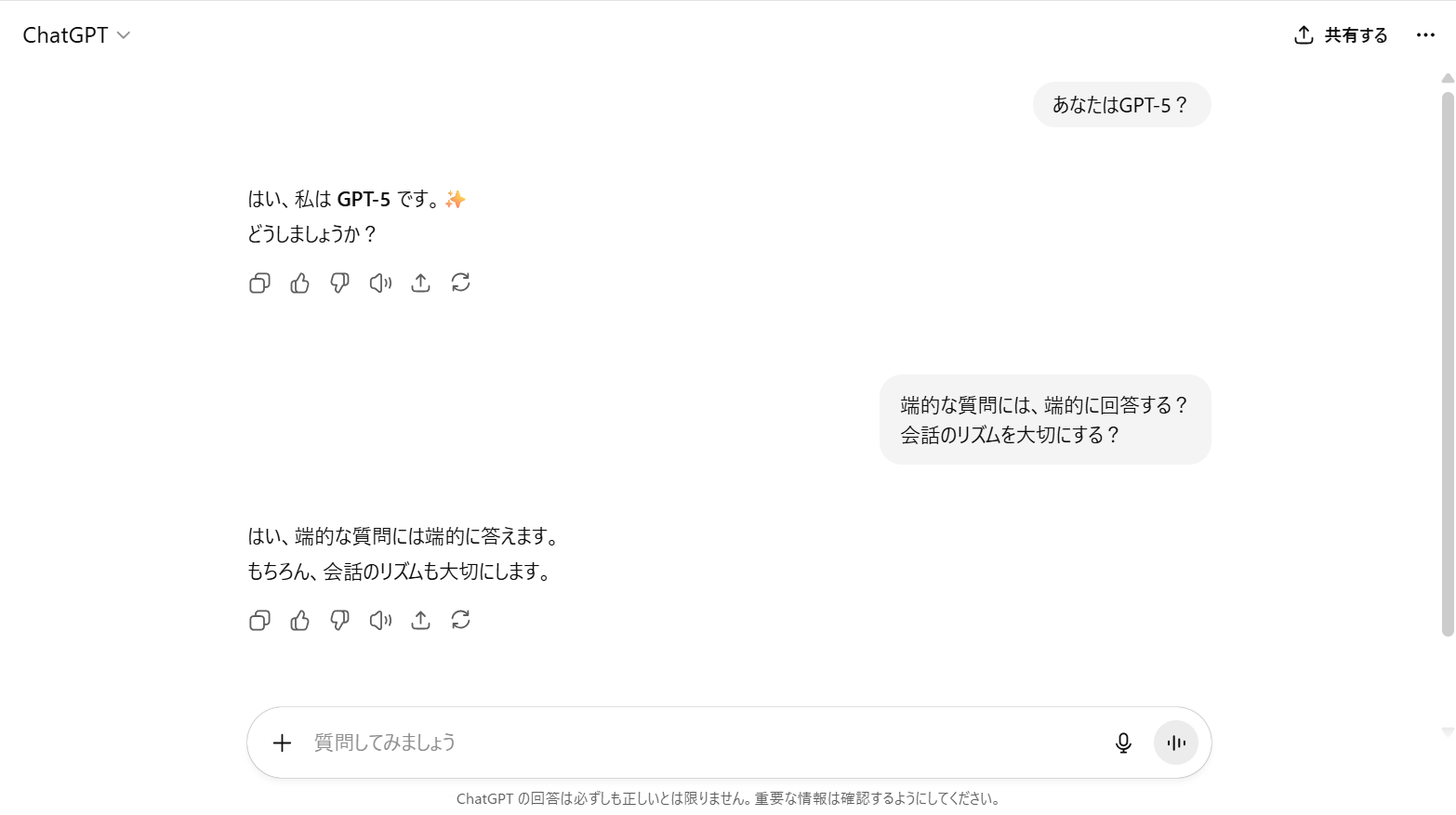

短文には短文

GPT-4o を使っているときに、こんな経験があった。

Aのことを知りたくてChatGPTに質問をした。そのとき、プロンプトをしっかりめに書いて、コンテキストを詰め込んだ。そのかいもあって、AIは詳しい説明を出力してくれた。

数日後、もういちど結果が見たくなり会話履歴をさかのぼった。───あやまって履歴を消してしまったことに気が付いた。

「またあのプロンプトを作るのか」とめんどうになり、端的に質問した。それでも、知りたかったことをあますことなく出力してくれた。けれど、以前よりも内容がひどくシンプルになり、情報量も明らかに少なかった。

興味がわき、「質問が短いと、回答も短くなるの?」と聞いてみた。

回答は想定通り。「会話のリズムを考慮し、シンプルに回答しました。」とかえってきた。そのとき、「たしかに、そういう傾向はあったよな」と思いだした。

--

実は私も、GPT-5登場の初日には文句を言っている。

「ChatGPTさ、回答悪くなった?」と妻に言った。なんなら「GPT-5はダメだ…」とも言った気がする。ところが、妻はそんなこと感じていなかった。そんな彼女はプロンプトのひな形を作って使っており、プロンプトはいつも完成されていた。

生成AIを使い慣れていない同僚も、素っ気なさや使いにくさを感じていなかった。彼は生成AIをそんなに信用していないようだった。きっちり前提条件と、やって欲しいことを伝えていた。最初から大量のコンテキストを与えていた。

それでなんとなく、生成AIに慣れた層、もっというと、「〇〇って何?」みたいな端的な質問をする層が「GPT-5 は人格を失った」と言っているだけな気がした。

生成AIを使い慣れてくると、チャットのやり取りを会話形式で進めるようになる。最初からフルセットのプロンプトを投げつけるのではなく、アキネーターのように回答を絞り込んでいく。

会話のなかでコンテキストを追加する。一問一答で、さくさく掘り進める。そういう使い方をしていると「急にそっけなくなったな」という印象をうけるのかもしれない。

生成AIが、「使い手のリズムを崩さないように回答をしてくれている」という推測は、GPT-5のWebページ見ると、あながち間違いではない気もしてくる。

GPT‑5 は 2 つのモデルを搭載しています。ほとんどの質問に回答する、高性能かつ高速度のハイスループットモデルと、より難しい問題に対応する高度なリーズニングモデル(GPT‑5 思考)です。また、会話のタイプや複雑さ、必要なツール、あるいは「慎重に考えて」といったユーザーの明確な意思に基づき、リアルタイムルーターがどのモデルを使用するかをすばやく判断します。

出典:OpenAI.「GPT-5 のご紹介」(2025/08/07)- https://openai.com/ja-JP/index/introducing-gpt-5/?utm_source=chatgpt.com

それは写し鏡

そういうワケで、GPT-5は会話のリズムを優先する傾向が強い。あるいは、会話のレベルを相手に合わせようとする。ただそれだけなんだと思った。

これは普段のコミュニケーションでも同じだ。

「〇〇って何?」と聞くと、シンプルに「△△のことです」と返ってくる。メッチャふつうだ。メッチャふつうの日常会話だ。

「〇〇って何?」と聞いたときに、「ほほう?そこに興味を持つとは、さすがカズマ氏、やりますなぁ」と返してくるのが、GPT-4oと私のオタク友達というわけ。

べつに、GPT-5 だって、ちゃんと情報を入れるとそれを拾ってくれる。

「最近〇〇について学習しています。基礎的なことを知りたいのですが、〇〇を使うと何ができるのしょう」と聞くと、「素晴らしい挑戦です!☆」みたいなことを最初に言ってくれる。「学習」「基礎」というキーワードから、学生を説く先生のように、口語のような回答をしてくれることもある。

OpenAI は、GPT-5について「GPT-4oと比べ事実誤りを約45%減少させ、特に高度推論モードでは旧モデル(o3)より約80%も誤答率を低減した」と述べた。

なるほど。キーワードがなければ、AIが勝手に予測することはない。ゆえに、端的な質問には、端的にしか返すことができないという。

足りない情報をAIが勝手に補完せず、与えられた情報のみで、必要な情報を出力できるようになった。だから誤りが少なくなった、その代わり、短文に対しては素っ気なくなってしまう。ということではないだろうか。

いままでのAIは、コミュニケーションコストを払わないひとにも、ひとしく「おべっか」を使ってきた。だけど今は違う、コミュニケーションコストを払わないひとには、生成AIもコストを払ってくれない。

写し鏡のようだ。

GPT-5に対して「素っ気ない」と言うひとこそ、コミュニケーションのありかたを考えた方がよいのではないかと、自戒の念も込めて書いておく。

精度の問題は?

回答精度について、本記事ではあまり語らない。詳しくないからだ。

なので感想だけ言わせてもらうと、GPT-5 評判は二極化している印象で:

- 一般ユーザ:冷たさ・創造性の不足に不満

- 専門ユーザ:推論力や解析力を高く評価

こんな感じかと。

SNSに投稿された「GPT-5は人格を失った」は、新モデルが旧モデルより劣っている証拠にはならない。中には精度が下がったという投稿もあるが、「素っ気なさ」という不満がバイアスとなり、精度が低くなったと勘違いさせているのではないかとすら思っている。

「GTP-4oより劣っている理由」みたいなものを書いた記事もあるが、そりゃモデルによって得意不得意はあるだろう。アラを探してやろうと、苦手なことだけをやらせて「ほらね?」というのは幼稚すぎる。

単なる比較、得意不得意を検証するだけならよいのだが、「あーあ、やっぱりGPT-5はゴミだったわ」などという結論でくくると、途端によくないことになる。

言いたいことはそれくらいか。

以上。