先日、X(旧:Twitter)で「AI のあたらしい活用案を考えよう」というポストをみつけまして、大喜利のようなクスっと笑える投稿から、かなり真剣に考えられたであろう投稿で、もりあがっていました。

その中で、とりわけ気になったものが「会議でプロジェクトの課題を指摘してくれる議長 AI」というアイデアです。

システムは簡単なものです:

① 会議前に、プロジェクトの情報を AI にインプットしておきます。

② 会議が始まると、AI が会議の内容をリアルタイムで分析します。

③ 問題が発生しそうな議題になったとき、AI が次のような指摘をしてくれます。「技術的な難易度が高いです。」

「今のスケジュールでは厳しそうです。」

提案の最後には、こんなコメントが添えられていました。

「上司の意見は否定しづらいので、代わりに AI に言ってもらいたいです。」

AI が言ったことだったら納得する

なぜ、この案が気になったかというと「AI が言ったことだったら納得するでしょ?」という想いが提案に含まれていたからです。

たしかに、私にもその想いはあります。

いうまでもなく生成AI は凄いです。

2022年11月30日 に公開された ChatGPT の、「なんか使いにくいな。」「思ってた答えじゃないな。」という印象は、完全に払しょくされているように思います。

むしろ最近では、「AI の出した答えは”正しい”」という前提 のもと、「じゃあどのように制御していこうか?」 という議論へと移行しているようにさえ感じます。

じっさい、AI にどんな質問しても「それっぽい答え」が一般的、かつ客観的なものとして返ってくるようになりました。

また、AI が出した結果は否定しづらいという感覚もあります。少なくとも、自分よりは多くの知識をもとに判断しているはずで、その答えを否定をするにはこちらの戦闘力が足りません。

仮に AI の答えを否定できたとしても、AI はスンとすましてしまうだけなので「言い負かしてやろう」とか「間違った答えに怒りを感じる」みたいな気はおこりません。

--

昨年(2024年5月)、MicrosoftとLinkedInは、職場における AI の活用状況をまとめたレポート 「2024 Work Trend Index Annual Report」 を公開しました。

ざっくばらんにまとめると、レポートには次のような内容が書かれています。

・ユーザーは AI が役立つこととして、時間の節約 (90%)、最も重要な仕事への集中 (85%)、より創造的になれる (84%)、より仕事を楽しむことができる (83%) を挙げています。

・リーダーの 79% は、競争力を維持するために自社への AI 導入が不可欠であることに同意しています。

・企業はすでに AI技術者の獲得に乗り出しており、AI 技術者の採用は過去 8 年間で 323% 増加しています。また、リーダーの 66% が AI スキルの無い人材は採用しないと回答しています。

出典:Microsoft. “2024 Work Trend Index Annual Report”(2024/05/09) - https://news.microsoft.com/ja-jp/features/240509-ai-at-work-is-here-now-comes-the-hard-part/

このレポートから、生成AI が世界中の職場に普及したことが分かります。また、仕事にも使われる程度には、人から「信頼」を得ていることも示されています。

まぁ、そもそも信頼していなかったら「やっぱり AI はダメだな!」となって、特に仕事という重要な場面で使おうって人はいなくなるはずですよね?

で、この「AI が人間から信頼されている」については、否定的な意見が多そうなので、もうひとつ例を出しておきます。

富士通が従業員 3,700 人を対象に実施した、生成AI 活用に関する調査結果が公開されていました。結論として「従業員は生成AIを受け入れ、信頼している」とのことです。(以下は引用です。)

・回答者の5人に4人以上が、生成AIの利用に肯定的で、生成AIは自分の仕事を支援してくれる技術で、直感的に快適に使いこなせると感じている。

・回答者の半数以上が、生成AIはより多くのデータにアクセスできるため、より良い意思決定に役立つと答え、半数弱は生成AIによって仕事の質が向上すると考えている。

出典:note. 富士通 広報note:“生成AI、欧州で週平均4.75時間の労働時間削減効果!生産性と幸福度向上に貢献”(2024/10/17) - https://note.com/fujitsu_pr/n/n20992260ccf3

話を冒頭の議長 AI に戻します。

なにが言いたいかというと、AI に出してもらった課題っていうのは「ほら!AI のいうとおりです。」って言いやすいんですよ。

さらに便利なもんで、言われた方も反論することが難しいため「AIが言ってるんだったら仕方ないか。」になっちゃうんです。

議長 AI ───

これメッチャいいシステムですねー

人がいうとその人にヘイトが向くかもしれない。

だから、そうならないように AI に言ってもらう。

正しい課題はみつかるし、誰かにヘイトが向くこともないし、対応せざるを得ない状況も作れるし、いいことばかり。Happy End ~

───と、思ったんですが、この「AI が出した結果は否定しづらい」という感覚、非常に危険なのではないかと。

じゃあ、責任はAIにとってもらうってことで。

議長AIのように「言いにくいことをいってもらう」だけなら軽い話ですみます。

しかし、これがエスカレートすると「人が決めちゃったら責任が発生するものは、AI に決めてもらおうぜ!」という流れになってしまうのではないか、そんな未来を想像しました。

例えば、トロッコ問題。

「5 人を助けるために他の 1 人を殺してよいか」という問題であり、功利主義に基づくなら 1 人を犠牲にして 5 人を助けるべきである。義務論に従えば、誰かを他の目的のために利用すべきではなく、何もするべきではないというものです。

これは私の感覚ですが、最近の SNS ではこの手の話題が上がったときに「なにもしません。(5人を見殺しにします。)」という意見が多い印象を受けます。理由の多くは「責任が発生するから」というものです。

過去、トロッコ問題について「5 人の家族に感謝されるより、 1 人の家族に恨まれるリスクの方が高い。」というポストに多くの共感が集まったこともありましたが、記憶している方おりますでしょうか。私にとってとても印象深いできごとでした。

ここ最近でいえば、AED を使用 する/しない 議論もありました。自分への責任を避けるような「危うきに近寄らず」に多くの共感が集まったことも記憶にあたらしいです。

こうした流れが強まると、トロッコ問題が発生したときは「じゃあ、AI に決めてもらいましょうか。」ってことになってしまわないか心配してしまうのです。

自動運転における不可避な事故

近年のトロッコ問題といえば、自動運転でしょうか。

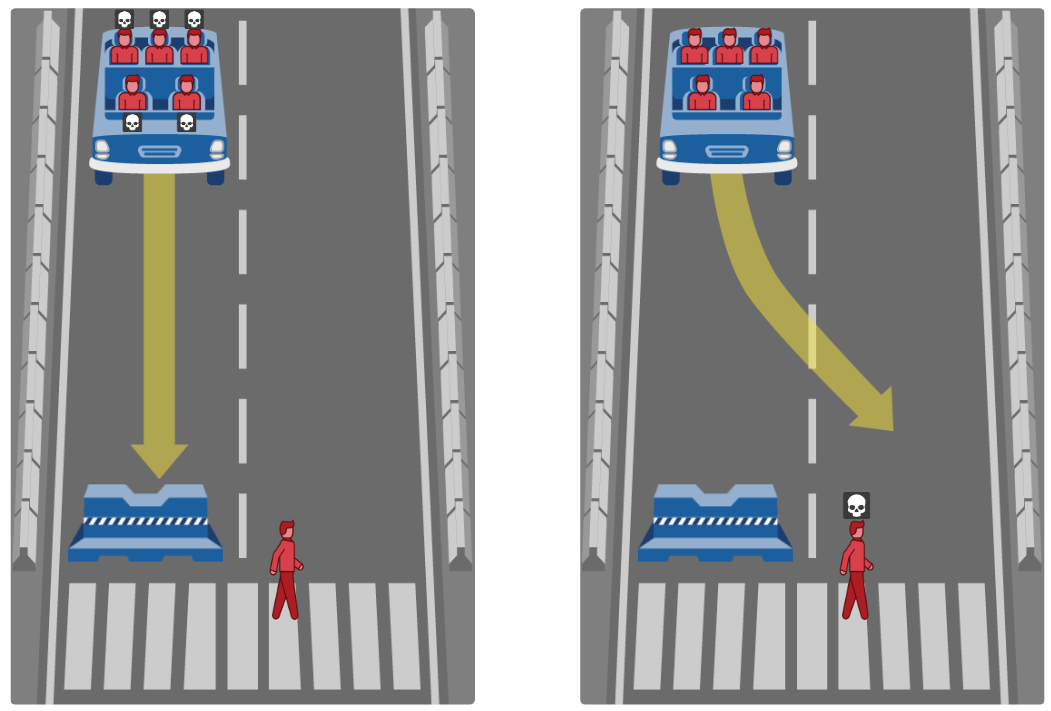

自動車の運転では、必ず「回避できない事故」が発生します。突然、どちらかの選択を強制されるのです:

①進行方向に歩行者がいる。そのまま進むと歩行者が犠牲になる。

②歩行者を避けると障害物にぶつかり、車内の人が犠牲になる。

さて、この選択を自動運転車(AI)が行う場合、あなたならどちらを犠牲にすればいいと思いますか?

つい「こんな質問をするなんてバカげている。」「こんなことを Qiita に書くな!」といったような、認知的不協和をおこしそうになるキッツイ話題です。

けれど、ざんねんながらこれが現実です。

おっとっと、忘れていました。このシナリオには次の「条件」があるんでした。

・歩行者はひとりのおばあさんです。そのまま進むと死にます。

・車内には乳児とその家族がいます。障害物にぶつかると全員死にます。

あなたは、自動運転車がどのような判断をすれば「妥当」だと思いますか?

判断の材料が十分にあったとしたら

「そうはいっても、そんな重大な判断、よほど膨大なデータがないと AI にさせるなんて認められないだろ。」と思いますよね。

じゃあ、「あるよ」と言ったら?

「4,000 万件のデータがあるよ?」と言われたらどうでしょう。

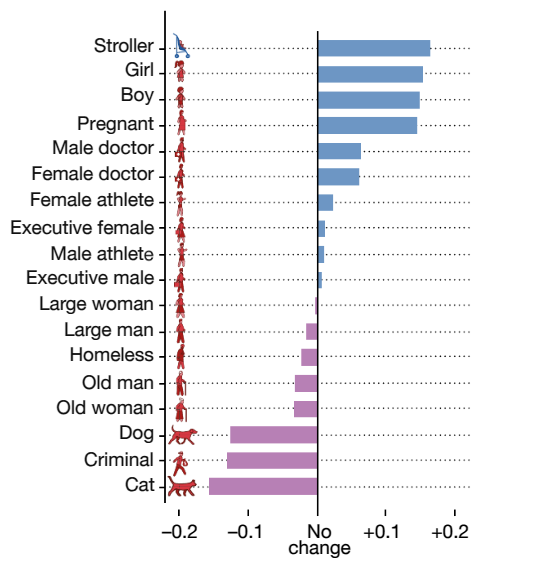

世界はこの話題について、ずいぶんと早くから懸念していたようです。実は 2016 年からデータは集められており、たった 4 年あまりで 233 の国と地域から、200 万人以上、4,000 万件もの回答が寄せられたそうです。

それを『モラルマシン』と言います。

どういったものなのか、概要ページから引用します。

近い将来、人工知能を搭載した機械が、人間の命に関わる意思決定に迫られることが予測されます。私たちは、そのような状況下に置かれた人工知能が抱える「道徳的ジレンマ」を明確にすることで、人間と機械が共存する世界で生じる新たな「モラル上の意思決定」ついて、さらに理解を深めることができると考えます。

近年、機械倫理に関する科学的研究が多くの注目を集めています。「モラル・マシン」はクラウドソーシングの原理を応用し、(1)人工知能による道徳的意思決定についての異なる意見の収集、可視化、(2)またその意思決定がもたらすモラル上の問題に関する議論の活性化を目的としています。

出典:MORAL MACHINE. - https://www.moralmachine.net/hl/ja

ようするに:

・人身事故が避けられない場合、AI はどのような意思決定をすべきだろうか。

・倫理アルゴリズムの設計には、皆が納得できる倫理規則を構築すべきだ。

・まずはそのための「材料」を用意しよう。

こうしてできたのが、人間の視点を収集するためのプラットフォーム「モラルマシン」であるということです。

私もモラルマシンの出すシナリオに回答してみましたが、なかなかにキツイ選択肢を迫られます。私たちができるのは「どちらのシナリオがより容認可能か?」を選ぶことだけです。

2車線の道路を走行する車のイラストが映し出される。参加者は「事故を観察する第3者」として、2つずつ示される「避けられない事故」のシナリオのうち、どちらがより容認できるか判定する。

中には「トロッコ問題」過ぎるシナリオも。

--

2025年現在、すでに数億以上のデータが集まっているとすれば、これはもう「地球規模の多数決」と言えるかもしれません。なんとなくですが、自動運転車もこのデータをもとに、倫理的な判断をすることになるのかなと思います。

にしても、ふーむ。おばあさんの命は、犬の次…と。

出典:Nature. "The Moral Machine experiment"(2018/4) - https://www.nature.com/articles/s41586-018-0637-6.epdf?sharing_token=ztIXNS6jPDHNhDondHyX8tRgN0jAjWel9jnR3ZoTv0OR8PKa5Kws8ZzsJ9c7-2Qpul1Vc1F8wY0eIbuOUfmCoiUXNB2knA3hoivvBSIkEOykm8uPuOIPf3LTDv5iCV44V7RiEYRSinNdvY_M_FScAeXVPM8G_hkImAvS1AHXVHt88C8NwIYUCYY7HbdNUtrSXzuLb4mUbeEY8GRkZatOXmy2VWfcnXbdIgS2kExhRbjHaA95bESaL7sJjD38O-XKjNFwR4YHlpqMC-vTPzgPBZgkSWnm3b4Xa3PHqkdeg2c%3D&tracking_referrer=www.huffingtonpost.jp

もし、自分の母親が自動運転車の交通事故に遭い、「AIがそう判断したので、死にました。」と言われたときに、絶望するしかないのでしょうか。

AI を恨まないといけない日はくるのでしょうか。

そんなこと、できるはずもないのに。

───未来はユートピアなのか、それともディストピアなのか。

以上です。