ReLU関数について

- ReLU関数(Rectified Linear Unit function)

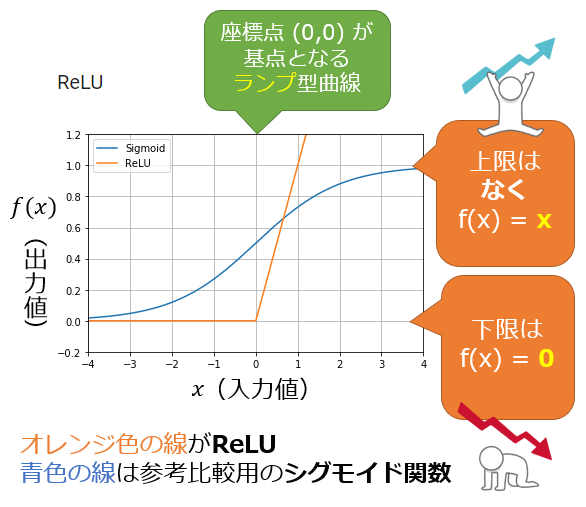

- 関数への入力値が0以下の場合には出力値が常に0、入力値が0より上の場合には出力値が入力値と同じ値となる関数である

- シグモイド関数は「-1」〜「1」しか出力を行わないが、ReLU関数は上限がない関数なので、その分学習の速度が早くなる、また計算式がシンプルであるのも早くなる理由である

- 座標点(0, 0)を基点として、ランプ型曲線のグラフになるため、ランプ関数(ramp function)とも呼ばれる

- ReLU関数は活性化関数の中でも隠れ層で非常に利用されている関数である

- 微分係数の最大値が1.0であるので、勾配消失問題を解消できる

- 0以下は常に0となるので、ニューロン群の活性化が疎になり、発火しないニューロン(=生体ニューロンに近い動作)も表現できることで精度が向上しやすい

参考サイト

https://atmarkit.itmedia.co.jp/ait/articles/2003/11/news016.html