目的

深層学習に関して、自分なりに理解しているが、

理解が間違えている(間違えていることに気づいていないわけだが)ところや、理解しづらいところとか沢山あり、

たまに、偶然、関心事にちょっとひびく資料に出会うことがある。

⇒見失うので、記事で残す。

面白いと思った資料

資料1 『深層学習の汎化に関する 数理的研究の進展』

| コメント |

|---|

| 一層一層示されているのが面白かった。 |

|

再構成困難というのが(表現が)興味深かった。 深層学習の説明性等で、可視化を試みる例があるが、この資料は、1層1層示されているので、参考になる気がした。 |

| コメント |

|---|

| 「丸暗記」うんぬんの言葉遣いが面白かった。 |

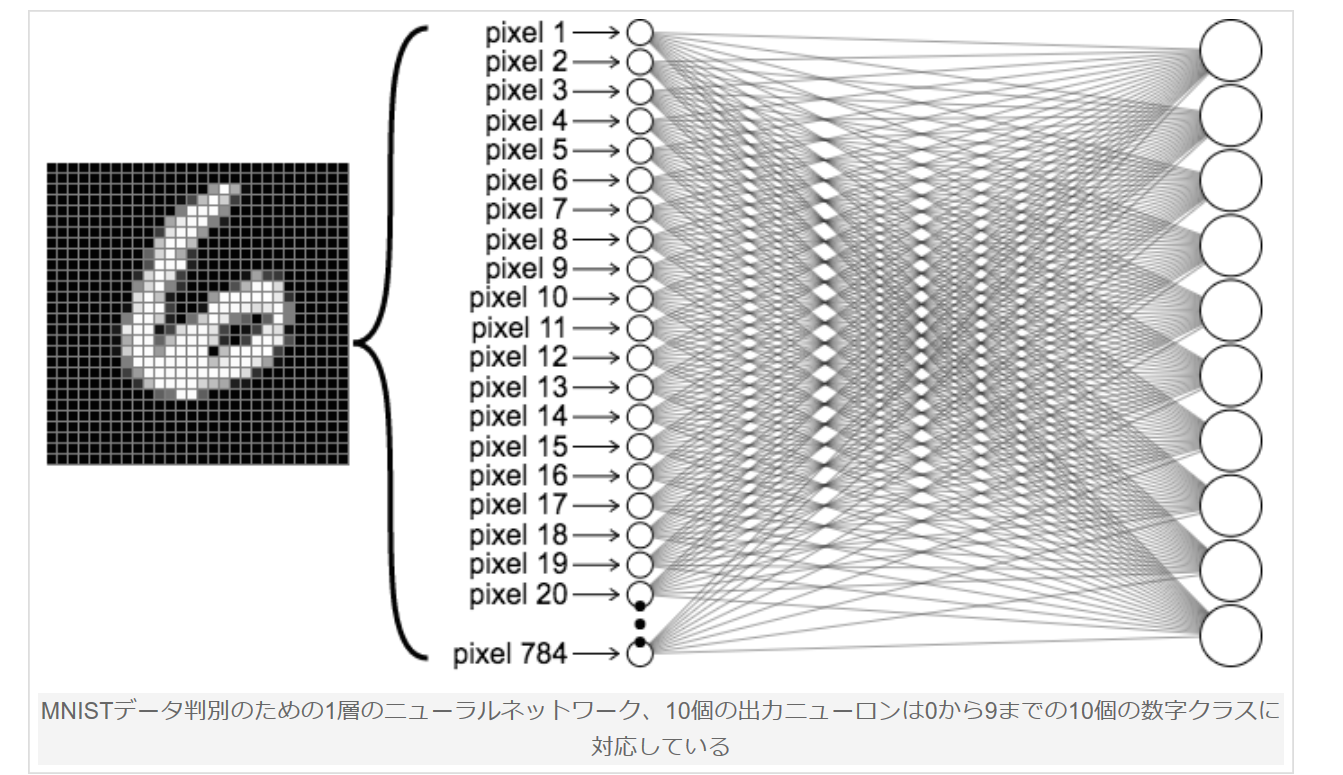

資料2 『ニューラルネットワークの中をのぞく』

https://ml4a.github.io/ml4a/jp/looking_inside_neural_nets/

| コメント |

|---|

| 1層というのが斬新(訓練した結果が示されている)。 |

| 少し関連するが、 |

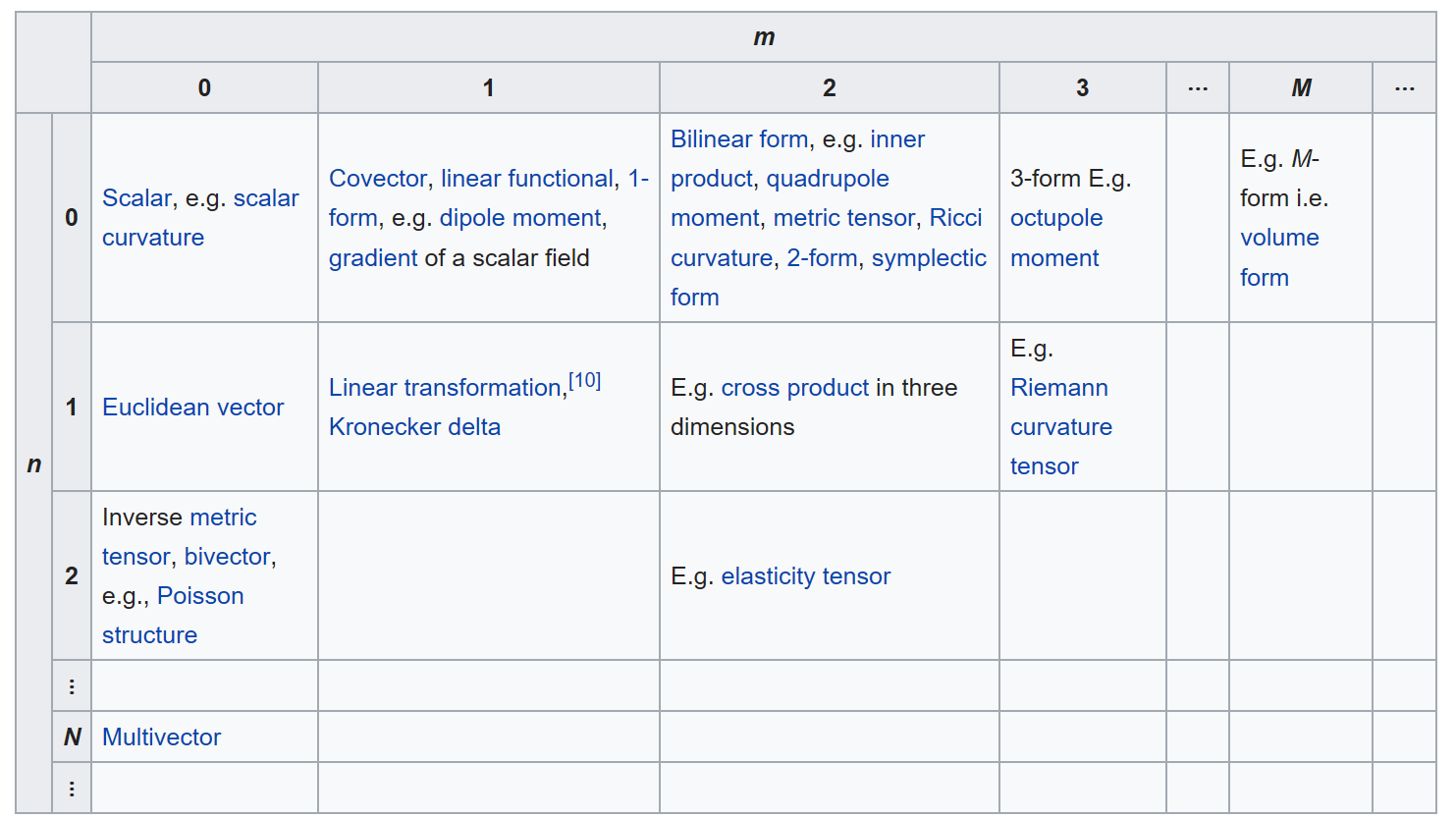

資料3 『Tensor』

https://en.wikipedia.org/wiki/Tensor

| コメント |

|---|

| tensorflowの名称などで、tensor(テンソル)という言葉が、深層学習に絡むような、絡まないような感じであるが、テンソル自体が、わりとわかりにくいので、収まりが悪い。 |

| テンソルの例を示したこの表は、参考になる。(表の大半は、深層学習とは無関係であるが。) |

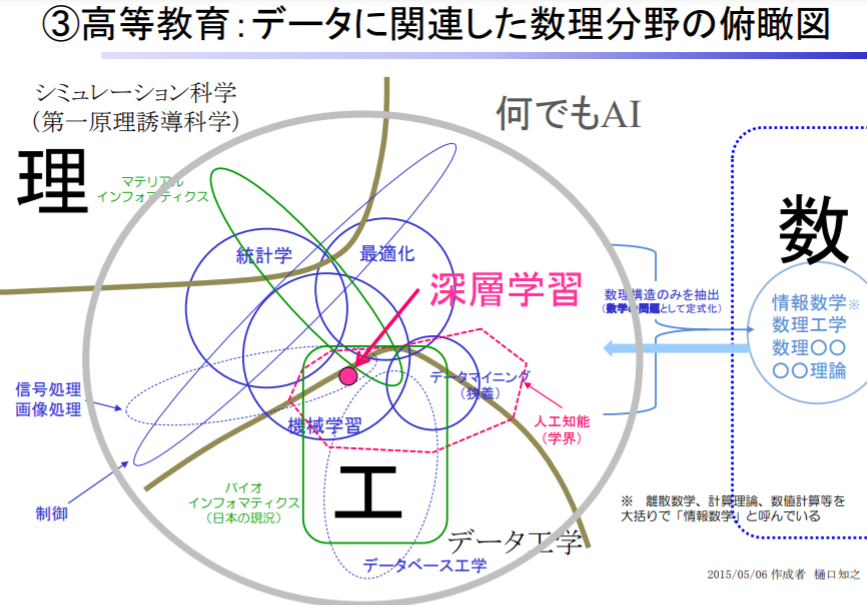

資料4 ディープラーニングの理論解析、ニューラルネットの未解決問題の解明へ大きく前進 PFN岡野原氏によるAI解説:第43回

(1)なぜディープラーニングは学習できるのか

(2)なぜディープラーニングは汎化するのか

| コメント |

|---|

| 専門家の間では、この類が十分に議論されていることを、今一度、認識した。 |

| ->強烈な実成果(実際のメリット)が出ると、初めて、検討がされていたことが認識されると思う。今は、それに該当するものがない?、もしくは、目立っていないと思う。 |

資料5 畳み込みニューラルネットワークの高精度化と高速化

| コメント |

|---|

| **ネットワークモデルの変遷(の図)**が示されている。意外とそのような図は見ないので、すばらしいのでは? |

| また、この方の発信、沢山のあるので、レベルが高いのだと思う。図を貼りたい気もしたが、、、上記のを直接みて下さい。 |

| 今後何度か、ちらちら、見る気がする |

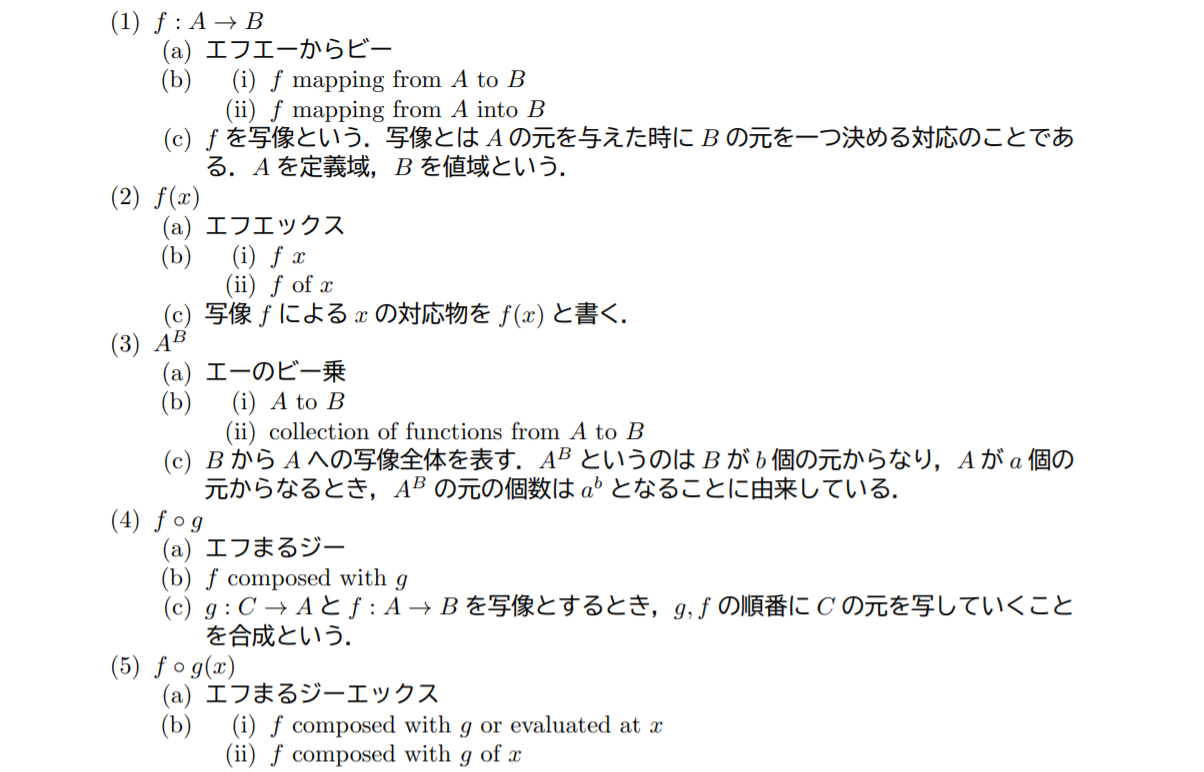

資料6 数式の読み方,大学で学ぶ数学公式

以下、一例を引用。

| コメント |

|---|

| 読み方がわかると、理解が深まり、思考が進むのでは? |

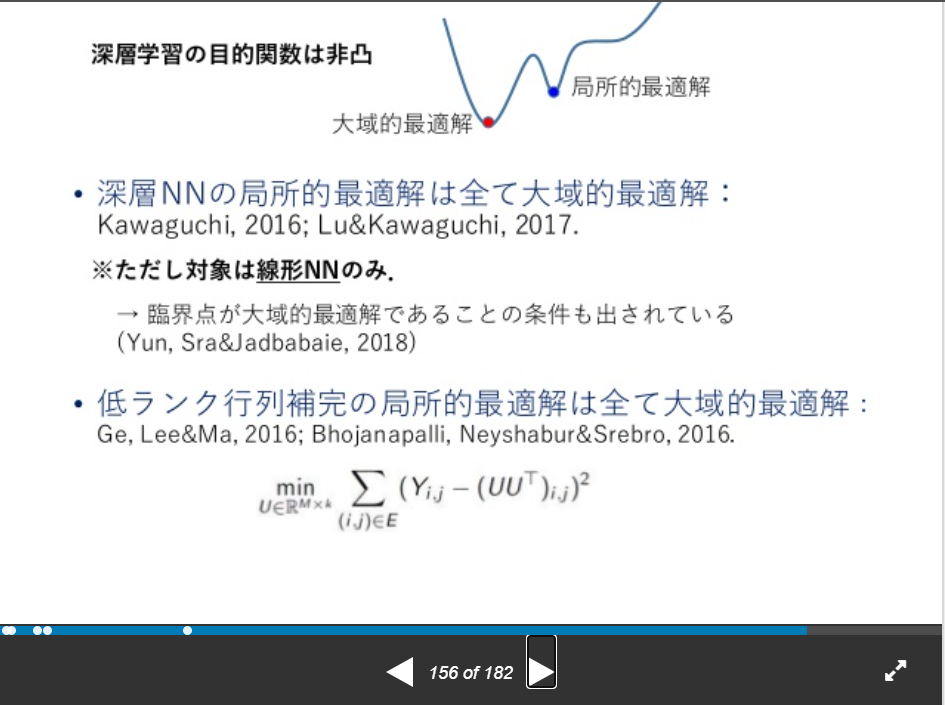

資料7 『深層学習の数理』

| コメント |

|---|

| すみません、内容、全く理解できていません。 |

| タイトル、深層学習の数理通りの内容。182ページもある。 |

| このあたりが大まかに理解できるといいのだが。。。 |

| 『深層NNの局所的最適解は全て大域的最適解』と書かれているが、なぜ、そんな都合のいい話になるのだろう?? |

資料8 『ベイズモデリングと歩んだ30年』

| コメント |

|---|

| 帰納とか演繹という単語が出てたので。。。 |

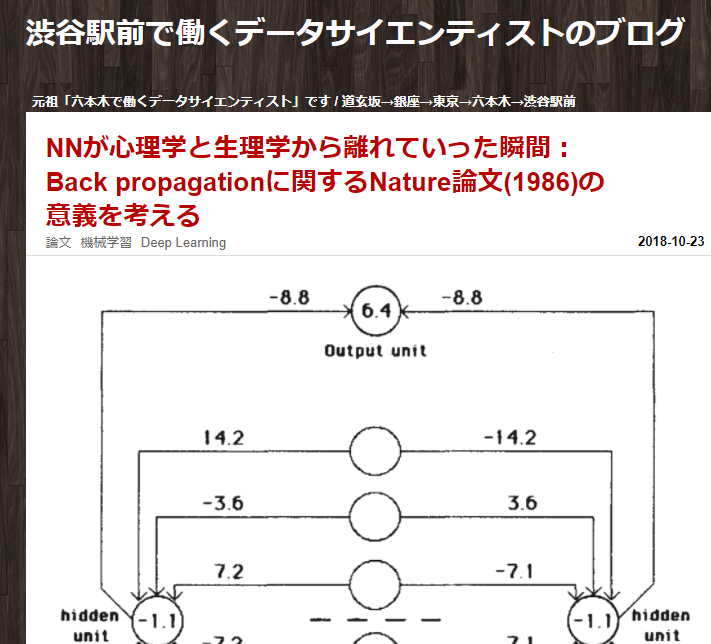

資料9 『NNが心理学と生理学から離れていった瞬間:Back propagationに関するNature論文(1986)の意義を考える』

| コメント |

|---|

| 『NNが心理学と生理学から離れていった瞬間:Back propagationに関するNature論文(1986)の意義を考える』とういう興味深いタイトルで、内容も面白い。 |

まとめ

特にありません。コメントなどあれば、お願いします。