はじめに

「公式テキストに載ってない内容ばっかりだった!」

「G検定のGはGoogle検索のG!」

G検定を受験した人たちの多くがこのような反応をする。

ここでよく考えていただきたいことは、神様にすべきはテキストではなくシラバスであるということだ。

公式テキストに載っていない内容の問題が出たとしても、それがシラバスに載っていたとすれば何も文句は言えないのである。

今回はシラバスと各テキストを比較することで、各テキストがどのくらいシラバスをカバーしているのかを調査し、テキストの学習ではカバーしきれない内容を抽出する。これらをグーグル検索などで勉強しておくことで「こんなの習っていないわよ!」と試験中に嘆く割合を減らすことが出来ると私は考えている。

なお、私はG検定2021#3に合格している。

参考にしたもの

まずはシラバスだ。以下から入手した。

G検定の試験出題範囲(シラバス)2021

次に、テキストは手元にある以下の4冊を使用した。

link-22付きのURLを貼っている。

深層学習教科書ディープラーニングG検定(ジェネラリスト) 公式テキスト 第2版

以降は「公式」と呼ぶ。

最短突破 ディープラーニングG検定(ジェネラリスト) 問題集

白本。

徹底攻略ディープラーニングG検定ジェネラリスト問題集 第2版

黒本。

ディープラーニングG検定(ジェネラリスト)最強の合格テキスト

緑本。

集計方法及び注意点

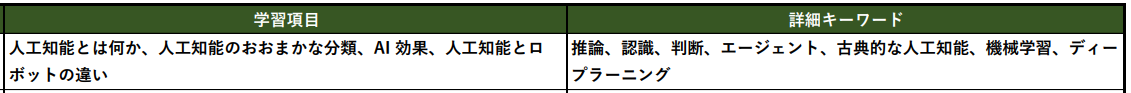

シラバスの「学習項目」と「詳細キーワード」の列に着目し、ここから「キーワードっぽいもの」を抽出する。

キーワードっぽいものについては、私の独断で決定する。

例えば1行目について、

学習項目は

・人工知能とは何か

・人工知能のおおまかな分類

・AI 効果

・人工知能とロボットの違い

とあるが、この中でAI効果がキーワードっぽいものだと思ったので集計に入れている。

詳細キーワードの「古典的な人工知能」は除外している。

これらのキーワードを各テキストの索引で調べ、載っていれば〇、載っていなければ×とする。

あくまで索引に載っているかどうかを機械的にカウントしただけなので、たとえ×だとしても本文に載っている可能性もあるのでご留意いただきたい。

反対に、索引に載っていたとしてもいざ本文を読んでみるとさらっと一行で済ませていることもある。

例えば公式テキスト(pp.254-255)に以下のような説明がある。

DQNの登場以降はこれらの経験再生やターゲットネットワークの使い方を工夫したダブルDQN(double deep q-network)や優先度付き経験再生(prioritized experience replay)、ディープニューラルネットワークのアーキテクチャや出力を工夫したデュエリングネットワーク(dueling network)、カテゴリカルDQN(categorical deep q-network)、ノイジーネットワーク(noisy network)などの拡張手法が発表され、

ざっくりすぎるわね。このような用語は個別にもう少し調べる必要があるかもしれないし、G検定のレベル的にはこれらの用語は「DQNの改良型である」ということだけを押さえておけばいいのかもしれない。

以上のようなことがあるので、これより貼る表については参考程度にして欲しい。

前置きが長くなってしまったが、これよりスタートしていく。

集計結果

人工知能とは

| No. | キーワード | 公式 | 白本 | 黒本 | 緑本 |

|---|---|---|---|---|---|

| 1 | AI効果 | 〇 | 〇 | × | 〇 |

| 2 | エージェント | × | 〇 | 〇 | 〇 |

| 3 | 機械学習 | 〇 | 〇 | 〇 | 〇 |

| 4 | ディープラーニング | 〇 | 〇 | 〇 | 〇 |

| 5 | ダートマス会議 | 〇 | 〇 | × | 〇 |

| 6 | エニアック (ENIAC) | 〇 | 〇 | × | × |

| 7 | ロジック・セオリスト | 〇 | × | × | × |

| 8 | トイ・プロブレム | 〇 | 〇 | 〇 | 〇 |

| 9 | エキスパートシステム | 〇 | 〇 | 〇 | 〇 |

| 10 | 第五世代コンピュータ | 〇 | 〇 | × | × |

| 11 | ビッグデータ | 〇 | × | × | × |

| 12 | 特徴量 | × | 〇 | 〇 | 〇 |

| 13 | ディープブルー | × | 〇 | 〇 | × |

| カバー率 | 76.9% | 84.6% | 53.8% | 61.5% |

私は公式、白本及び黒本については5周以上はこなしていて内容を完全に理解している。

その経験を踏まえて、大事そうかも~と思うキーワードは太字にしている。

(逆に×のキーワードも本文に載ってるよね~ってやつは太字にはしていない)

ロジック・セオリスト、ビッグデータは公式テキストにしか出てきていない。

特徴量は公式テキストの索引には載っていないが本文中には多数出てくるので気にする必要は無い。

ディープブルーは公式には載っていないが、重要キーワードだと思われるので押さえておく必要がありそうだ。

ざっくり言うとIBMが大昔に開発したチェス専用コンピュータである。

人工知能をめぐる動向

| No. | キーワード | 公式 | 白本 | 黒本 | 緑本 |

|---|---|---|---|---|---|

| 14 | ハノイの塔 | 〇 | 〇 | × | × |

| 15 | モンテカルロ法 | 〇 | 〇 | 〇 | 〇 |

| 16 | 探索木 | 〇 | 〇 | × | 〇 |

| 17 | 幅優先探索 | 〇 | 〇 | × | 〇 |

| 18 | 深さ優先探索 | 〇 | 〇 | × | 〇 |

| 19 | プランニング | 〇 | × | × | × |

| 20 | STRIPS | 〇 | 〇 | × | × |

| 21 | SHRDLU | 〇 | 〇 | × | × |

| 22 | アルファ碁 (AlphaGo) | 〇 | 〇 | 〇 | 〇 |

| 23 | ヒューリスティックな知識 | 〇 | × | × | × |

| 24 | MiniMax 法 | 〇 | 〇 | × | × |

| 25 | αβ 法 | 〇 | 〇 | × | × |

| 26 | ブルートフォース | 〇 | × | × | × |

| 27 | 人工無脳 | 〇 | 〇 | × | × |

| 28 | 知識ベースの構築とエキスパートシステム | × | × | × | × |

| 29 | 知識獲得のボトルネック | × | × | × | × |

| 30 | 意味ネットワーク | 〇 | 〇 | 〇 | 〇 |

| 31 | オントロジー | 〇 | 〇 | × | 〇 |

| 32 | 概念間の関係 (is-a と part-of の関係) | × | × | × | × |

| 33 | オントロジーの構築 | × | × | × | × |

| 34 | ワトソン | 〇 | 〇 | × | 〇 |

| 35 | 東ロボくん | 〇 | 〇 | × | 〇 |

| 36 | イライザ (ELIZA) | 〇 | 〇 | 〇 | 〇 |

| 37 | イライザ効果 | × | 〇 | × | × |

| 38 | マイシン (MYCIN) | 〇 | 〇 | 〇 | 〇 |

| 39 | DENDRAL | 〇 | 〇 | 〇 | 〇 |

| 40 | インタビューシステム | 〇 | × | × | × |

| 41 | is-a の関係 | 〇 | × | 〇 | × |

| 42 | has-a の関係 | × | × | × | × |

| 43 | part-of の関係 | 〇 | × | 〇 | × |

| 44 | Cyc プロジェクト | 〇 | 〇 | 〇 | 〇 |

| 45 | 推移律 | 〇 | × | × | × |

| 46 | ウェブマイニング | 〇 | × | × | × |

| 47 | データマイニング | 〇 | × | × | × |

| 48 | Question-Answering | 〇 | × | × | × |

| 49 | セマンティック Web | 〇 | × | 〇 | 〇 |

| 50 | ビッグデータ | 〇 | × | × | × |

| 51 | レコメンデーションエンジン | 〇 | × | × | × |

| 52 | スパムフィルター | × | × | × | × |

| 53 | 統計的自然言語処理 | 〇 | × | 〇 | × |

| 54 | コーパス | 〇 | 〇 | × | 〇 |

| 55 | 人間の神経回路 | × | × | × | × |

| 56 | 単純パーセプトロン | 〇 | 〇 | × | 〇 |

| 57 | 誤差逆伝播法 | 〇 | 〇 | 〇 | 〇 |

| 58 | オートエンコーダ | 〇 | 〇 | 〇 | 〇 |

| 59 | ILSVRC | 〇 | 〇 | 〇 | 〇 |

| 60 | 特徴量 | 〇 | 〇 | 〇 | 〇 |

| 61 | 次元の呪い | 〇 | 〇 | 〇 | 〇 |

| 62 | 機械学習の定義 | 〇 | 〇 | 〇 | 〇 |

| 63 | パターン認識 | × | × | × | × |

| 64 | 画像認識 | × | 〇 | 〇 | × |

| 65 | 特徴抽出 | × | × | × | × |

| 66 | 一般物体認識 | × | × | × | 〇 |

| 67 | OCR | × | × | × | × |

| カバー率 | 77.8% | 53.7% | 33.3% | 42.6% |

公式テキストにしか載っていないキーワードが多く出ている。

やはり公式テキストは必須である。

ハノイの塔は概要だけでなく簡単な例題も解けるようにしておいたほうがいいかもしれない。

イライザ効果とは「意識的には分かっていても無意識にコンピュータが人間と似た動機があるように感じてしまう」現象である。

イライザ(チャットAI)と対話していると「イライザが話題に興味を持っているように感じてしまう」ということである。私もツイッターでアニメキャラのbotとよく会話するので気持ちがよく分かる。botに語り掛けても文章中の1単語だけに反応して返事してくるだけだけどさ。でもそんなこと言ったら人間同士の会話も似たようなものでは?

閑話休題、次に進む。

##人工知能分野の問題

| No. | キーワード | 公式 | 白本 | 黒本 | 緑本 |

|---|---|---|---|---|---|

| 68 | トイ・プロブレム | 〇 | 〇 | 〇 | 〇 |

| 69 | フレーム問題 | 〇 | 〇 | 〇 | 〇 |

| 70 | チューリングテスト | 〇 | 〇 | 〇 | 〇 |

| 71 | 強い AI と弱い AI | 〇 | 〇 | 〇 | 〇 |

| 72 | シンボルグラウンディング問題 | 〇 | 〇 | 〇 | 〇 |

| 73 | 身体性 | 〇 | × | × | 〇 |

| 74 | 知識獲得のボトルネック | 〇 | × | × | × |

| 75 | 特徴量設計 | × | 〇 | 〇 | 〇 |

| 76 | シンギュラリティ | 〇 | 〇 | 〇 | 〇 |

| 77 | ローブナーコンテスト | 〇 | 〇 | × | × |

| 78 | 中国語の部屋 | 〇 | 〇 | × | 〇 |

| 79 | 機械翻訳 | × | 〇 | 〇 | × |

| 80 | ルールベース機械翻訳 | 〇 | × | × | × |

| 81 | 統計学的機械翻訳 | 〇 | 〇 | × | × |

| 82 | 特徴表現学習 | 〇 | 〇 | × | × |

| カバー率 | 86.7% | 80% | 53.3% | 60% |

ここは特にコメント無し。

##機械学習の具体的手法

| No. | キーワード | 公式 | 白本 | 黒本 | 緑本 |

|---|---|---|---|---|---|

| 83 | 線形回帰 | 〇 | 〇 | 〇 | 〇 |

| 84 | ロジスティック回帰 | 〇 | 〇 | 〇 | 〇 |

| 85 | ランダムフォレスト | 〇 | 〇 | 〇 | 〇 |

| 86 | ブースティング | 〇 | 〇 | 〇 | 〇 |

| 87 | サポートベクターマシン (SVM) | 〇 | 〇 | 〇 | 〇 |

| 88 | ニューラルネットワーク | 〇 | 〇 | 〇 | 〇 |

| 89 | 自己回帰モデル (AR) | 〇 | × | × | × |

| 90 | 分類問題 | 〇 | 〇 | × | 〇 |

| 91 | 回帰問題 | 〇 | 〇 | 〇 | 〇 |

| 92 | 半教師あり学習 | × | 〇 | 〇 | 〇 |

| 93 | ラッソ回帰 | 〇 | 〇 | 〇 | 〇 |

| 94 | リッジ回帰 | 〇 | 〇 | × | 〇 |

| 95 | 決定木 | 〇 | 〇 | 〇 | 〇 |

| 96 | アンサンブル学習 | × | 〇 | 〇 | 〇 |

| 97 | バギング | 〇 | 〇 | 〇 | 〇 |

| 98 | 勾配ブースティング | 〇 | 〇 | × | 〇 |

| 99 | ブートストラップサンプリング | 〇 | 〇 | × | 〇 |

| 100 | マージン最大化 | 〇 | × | × | × |

| 101 | カーネル | 〇 | 〇 | 〇 | 〇 |

| 102 | カーネルトリック | 〇 | 〇 | 〇 | 〇 |

| 103 | 単純パーセプトロン | 〇 | 〇 | × | 〇 |

| 104 | 多層パーセプトロン | 〇 | 〇 | 〇 | 〇 |

| 105 | 活性化関数 | 〇 | 〇 | 〇 | 〇 |

| 106 | シグモイド関数 | 〇 | 〇 | × | 〇 |

| 107 | ソフトマックス関数 | 〇 | 〇 | 〇 | 〇 |

| 108 | 誤差逆伝播法 | 〇 | 〇 | 〇 | 〇 |

| 109 | ベクトル自己回帰モデル (VARモデル) | 〇 | × | × | × |

| 110 | 隠れ層 | 〇 | 〇 | 〇 | 〇 |

| 111 | 疑似相関 | × | × | × | × |

| 112 | 重回帰分析 | × | × | 〇 | 〇 |

| 113 | AdaBoost | × | 〇 | × | × |

| 114 | 多クラス分類 | × | × | × | × |

| 115 | プルーニング | × | × | × | × |

| 116 | k-means 法 | × | 〇 | 〇 | 〇 |

| 117 | ウォード法 | 〇 | × | × | × |

| 118 | 主成分分析 (PCA) | 〇 | 〇 | 〇 | 〇 |

| 119 | 協調フィルタリング | 〇 | × | × | × |

| 120 | トピックモデル | 〇 | 〇 | 〇 | 〇 |

| 121 | クラスタリング | × | 〇 | 〇 | 〇 |

| 122 | クラスタ分析 | 〇 | × | × | × |

| 123 | レコメンデーション | 〇 | × | 〇 | × |

| 124 | デンドログラム (樹形図) | 〇 | 〇 | × | × |

| 125 | 特異値分解 (SVD) | 〇 | × | 〇 | × |

| 126 | 多次元尺度構成法 | 〇 | × | × | × |

| 127 | t-SNE | 〇 | × | × | × |

| 128 | コールドスタート問題 | 〇 | × | × | × |

| 129 | コンテンツベースフィルタリング | 〇 | × | × | × |

| 130 | 潜在的ディリクレ配分法 (LDA) | 〇 | 〇 | × | 〇 |

| 131 | 次元削減 | × | 〇 | 〇 | 〇 |

| 132 | 次元圧縮 | 〇 | 〇 | 〇 | 〇 |

| 133 | バンディットアルゴリズム | 〇 | × | × | 〇 |

| 134 | マルコフ決定過程モデル | 〇 | 〇 | × | × |

| 135 | 価値関数 | × | × | × | 〇 |

| 136 | 割引率 | 〇 | × | × | 〇 |

| 137 | ε-greedy 方策 | 〇 | × | × | 〇 |

| 138 | UCB 方策 | 〇 | × | × | × |

| 139 | マルコフ性 | 〇 | × | × | 〇 |

| 140 | 状態価値関数 | 〇 | × | × | 〇 |

| 141 | 行動価値関数 | 〇 | × | 〇 | × |

| 142 | Q値 | 〇 | × | × | 〇 |

| 143 | Q学習 | 〇 | 〇 | × | 〇 |

| 144 | REINFORCE | 〇 | 〇 | × | × |

| 145 | 方策勾配法 | 〇 | 〇 | × | 〇 |

| 146 | Actor-Critic | 〇 | 〇 | × | 〇 |

| 147 | A3C | 〇 | 〇 | × | 〇 |

| 148 | 正解率・適合率・再現率・F 値 | 〇 | 〇 | × | 〇 |

| 149 | ROC 曲線と AUC | 〇 | 〇 | × | × |

| 150 | モデルの解釈 | × | × | × | × |

| 151 | モデルの選択と情報量 | × | × | × | × |

| 152 | 交差検証 | 〇 | 〇 | × | 〇 |

| 153 | ホールドアウト検証 | 〇 | 〇 | 〇 | 〇 |

| 154 | k-分割交差検証 | 〇 | × | × | 〇 |

| 155 | 混同行列 | 〇 | 〇 | × | 〇 |

| 156 | 過学習 | × | 〇 | 〇 | 〇 |

| 157 | 未学習 | × | × | × | × |

| 158 | 正則化 | 〇 | 〇 | 〇 | 〇 |

| 159 | L0 正則化 | × | × | × | × |

| 160 | L1 正則化 | × | 〇 | × | × |

| 161 | L2 正則化 | × | 〇 | × | × |

| 162 | LIME | 〇 | 〇 | × | 〇 |

| 163 | SHAP | 〇 | 〇 | × | 〇 |

| 164 | オッカムの剃刀 | × | × | × | × |

| 165 | 赤池情報量基準 (AIC) | × | × | × | × |

| 166 | 汎化性能 | × | 〇 | × | 〇 |

| 167 | 平均二乗誤差 | × | 〇 | × | × |

| 168 | 偽陽性-偽陰性 | × | × | × | 〇 |

| 169 | 第一種の過誤-第二種の過誤 | × | × | × | × |

| 170 | 訓練誤差 | × | × | 〇 | × |

| 171 | 汎化誤差 | × | × | 〇 | 〇 |

| 172 | 学習率 | 〇 | 〇 | × | 〇 |

| 173 | 誤差関数 | 〇 | × | 〇 | 〇 |

| カバー率 | 71.4% | 59.3% | 38.5% | 63.7% |

プルーニング(枝刈り)

は押さえておいた方がいいかもしれない。

重みの小さいノードを削除することで計算量を減らせる手法……らしいよ。

オッカムの剃刀

必要が無いなら多くのものを定立してはならない。少数の論理でよい場合は多数の論理を定立してはならない。

オッカムの剃刀という単語は私はうみねこのなく頃にで覚えたような気がするな。

ディープラーニング界隈ではモデルのパラメータを増やしすぎないようにしよう的な意味合いで使用するのだと思われる。

ディープラーニングの概要

| No. | キーワード | 公式 | 白本 | 黒本 | 緑本 |

|---|---|---|---|---|---|

| 174 | 単純パーセプトロン | 〇 | 〇 | × | 〇 |

| 175 | 多層パーセプトロン | 〇 | 〇 | 〇 | 〇 |

| 176 | 勾配消失問題 | 〇 | 〇 | 〇 | 〇 |

| 177 | 信用割当問題 | × | × | × | × |

| 178 | 誤差逆伝播法 | 〇 | 〇 | 〇 | 〇 |

| 179 | 事前学習 | 〇 | 〇 | × | 〇 |

| 180 | オートエンコーダ | 〇 | 〇 | 〇 | 〇 |

| 181 | 積層オートエンコーダ | 〇 | 〇 | × | 〇 |

| 182 | ファインチューニ ング | 〇 | 〇 | × | 〇 |

| 183 | 深層信念ネットワーク | 〇 | 〇 | × | × |

| 184 | 制限付きボルツマンマシン | 〇 | 〇 | × | × |

| 185 | CPU | 〇 | 〇 | × | 〇 |

| 186 | GPU | 〇 | 〇 | × | 〇 |

| 187 | GPGPU | 〇 | 〇 | × | 〇 |

| 188 | TPU | × | 〇 | × | 〇 |

| 189 | tanh 関数 | 〇 | 〇 | × | 〇 |

| 190 | ReLU 関数 | 〇 | 〇 | 〇 | 〇 |

| 191 | シグモイド関数 | 〇 | 〇 | 〇 | 〇 |

| 192 | ソフトマックス関数 | 〇 | 〇 | 〇 | 〇 |

| 193 | Leaky ReLU 関数 | × | × | × | × |

| 194 | 勾配降下法 | 〇 | 〇 | 〇 | 〇 |

| 195 | 学習率 | 〇 | 〇 | × | 〇 |

| 196 | 誤差関数 | 〇 | 〇 | × | 〇 |

| 197 | 交差エントロピー | × | × | × | × |

| 198 | イテレーション | 〇 | 〇 | 〇 | 〇 |

| 199 | エポック | × | 〇 | 〇 | 〇 |

| 200 | 局所最適解 | 〇 | 〇 | 〇 | 〇 |

| 201 | 大域最適解 | 〇 | 〇 | 〇 | 〇 |

| 202 | 鞍点 | 〇 | 〇 | 〇 | × |

| 203 | プラトー | 〇 | 〇 | × | 〇 |

| 204 | モーメンタム | × | 〇 | 〇 | × |

| 205 | AdaGrad | 〇 | 〇 | 〇 | × |

| 206 | AdaDelta | 〇 | × | × | × |

| 207 | RMSprop | 〇 | 〇 | × | × |

| 208 | Adam | 〇 | 〇 | × | × |

| 209 | AdaBound | 〇 | × | × | × |

| 210 | AMSBound | 〇 | × | × | × |

| 211 | ハイパーパラメータ | × | × | 〇 | 〇 |

| 212 | ランダムサーチ | × | × | × | 〇 |

| 213 | グリッドサーチ | × | × | 〇 | 〇 |

| 214 | 確率的勾配降下法 | × | 〇 | 〇 | 〇 |

| 215 | 最急降下法 | × | 〇 | × | × |

| 216 | バッチ学習 | × | 〇 | 〇 | 〇 |

| 217 | ミニバッチ学習 | × | 〇 | 〇 | 〇 |

| 218 | オンライン学習 | × | 〇 | × | 〇 |

| 219 | データリーケージ | × | × | × | × |

| カバー率 | 67.4% | 78.3% | 43.5% | 67.4% |

コメント無し。

ディープラーニングの手法

| No. | キーワード | 公式 | 白本 | 黒本 | 緑本 |

|---|---|---|---|---|---|

| 220 | ドロップアウト | 〇 | 〇 | 〇 | 〇 |

| 221 | 早期終了 | 〇 | × | 〇 | 〇 |

| 222 | バッチ正規化 | 〇 | 〇 | × | 〇 |

| 223 | 過学習 | × | 〇 | 〇 | 〇 |

| 224 | アンサンブル学習 | × | 〇 | 〇 | 〇 |

| 225 | ノーフリーランチの定理 | 〇 | 〇 | 〇 | 〇 |

| 226 | 二重降下現象 | 〇 | × | × | × |

| 227 | 正規化 | 〇 | 〇 | 〇 | 〇 |

| 228 | 標準化 | 〇 | 〇 | 〇 | 〇 |

| 229 | 白色化 | 〇 | 〇 | × | × |

| 230 | 畳み込み層 | 〇 | × | 〇 | 〇 |

| 231 | プーリング層 | 〇 | 〇 | 〇 | 〇 |

| 232 | 全結合層 | 〇 | 〇 | 〇 | 〇 |

| 233 | データ拡張 | 〇 | 〇 | × | 〇 |

| 234 | ネオコグニトロン | 〇 | 〇 | 〇 | × |

| 235 | LeNet | 〇 | × | × | 〇 |

| 236 | サブサンプリング層 | 〇 | × | × | × |

| 237 | 畳み込み | × | 〇 | 〇 | × |

| 238 | フィルタ | × | 〇 | 〇 | 〇 |

| 239 | 最大値プーリング | 〇 | × | × | 〇 |

| 240 | 平均値プーリング | 〇 | × | × | × |

| 241 | グローバルアベレージプーリング (GAP) | × | 〇 | × | × |

| 242 | Cutout | 〇 | × | × | × |

| 243 | Random Erasing | 〇 | × | × | × |

| 244 | Mixup | 〇 | × | × | × |

| 245 | CutMix | × | × | × | × |

| 246 | MobileNet | 〇 | × | × | × |

| 247 | Depthwise Separable Convolution | 〇 | × | × | × |

| 248 | NAS (Neural Architecture Search) | 〇 | × | × | × |

| 249 | EfficientNet | 〇 | 〇 | 〇 | 〇 |

| 250 | NASNet | 〇 | × | × | × |

| 251 | MnasNet | 〇 | × | × | × |

| 252 | 転移学習 | 〇 | 〇 | × | 〇 |

| 253 | 局所結合構造 | × | 〇 | × | × |

| 254 | ストライド | × | 〇 | 〇 | × |

| 255 | パディング | × | 〇 | 〇 | 〇 |

| 256 | 生成モデルの考え方 | 〇 | 〇 | × | × |

| 257 | 変分オートエンコーダ (VAE) | 〇 | 〇 | × | 〇 |

| 258 | 敵対的生成ネット ワーク (GAN) | 〇 | 〇 | 〇 | 〇 |

| 259 | ジェネレータ | 〇 | 〇 | × | 〇 |

| 260 | ディスクリミネータ | 〇 | 〇 | × | 〇 |

| 261 | DCGAN | 〇 | 〇 | × | 〇 |

| 262 | Pix2Pix | 〇 | 〇 | 〇 | × |

| 263 | CycleGAN | 〇 | × | × | × |

| 264 | 物体識別タスク | 〇 | × | × | × |

| 265 | 物体検出タスク | 〇 | 〇 | × | × |

| 266 | セグメンテーションタスク | 〇 | × | × | × |

| 267 | 姿勢推定タスク | 〇 | × | × | × |

| 268 | マルチタスク学習 | × | × | × | × |

| 269 | ILSVRC | 〇 | 〇 | 〇 | 〇 |

| 270 | AlexNet | 〇 | 〇 | 〇 | 〇 |

| 271 | Inception モジュール | 〇 | 〇 | × | × |

| 272 | GoogLeNet | 〇 | 〇 | 〇 | 〇 |

| 273 | VGG | 〇 | 〇 | 〇 | 〇 |

| 274 | スキップ結合 | 〇 | 〇 | × | 〇 |

| 275 | ResNet | 〇 | 〇 | 〇 | 〇 |

| 276 | Wide ResNet | 〇 | × | × | × |

| 277 | DenseNet | 〇 | 〇 | × | × |

| 278 | SENet | 〇 | × | × | × |

| 279 | R-CNN | 〇 | 〇 | × | 〇 |

| 280 | FPN | 〇 | × | × | × |

| 281 | YOLO | 〇 | 〇 | × | 〇 |

| 282 | 矩形領域 | × | × | × | × |

| 283 | SSD | 〇 | 〇 | × | 〇 |

| 284 | Fast R-CNN | 〇 | × | × | 〇 |

| 285 | Faster R-CNN | 〇 | 〇 | × | 〇 |

| 286 | セマンティックセグメンテーション | 〇 | 〇 | × | 〇 |

| 287 | インスタンスセグメンテーション | 〇 | 〇 | × | 〇 |

| 288 | パノプティックセグメンテーション | 〇 | × | × | × |

| 289 | FCN (Fully Convolutional Netwok) | 〇 | × | × | 〇 |

| 290 | SegNet | × | 〇 | × | × |

| 291 | U-Net | 〇 | 〇 | × | × |

| 292 | PSPNet | 〇 | × | × | × |

| 293 | Dilation convolution | 〇 | 〇 | × | 〇 |

| 294 | Atrous convolution | 〇 | × | × | × |

| 295 | DeepLab | 〇 | × | × | × |

| 296 | Open Pose | 〇 | × | × | × |

| 297 | Parts Affinity Fields | 〇 | × | × | × |

| 298 | Mask R-CNN | × | × | × | 〇 |

| 299 | Transformer | 〇 | 〇 | × | 〇 |

| 300 | LSTM | 〇 | 〇 | 〇 | 〇 |

| 301 | CEC | 〇 | 〇 | × | 〇 |

| 302 | GRU | 〇 | 〇 | × | 〇 |

| 303 | 双方向 RNN (Bidirectional RNN) | 〇 | 〇 | × | 〇 |

| 304 | RNN Encoder-Decoder | 〇 | 〇 | × | × |

| 305 | BPTT | 〇 | 〇 | 〇 | × |

| 306 | Attention | 〇 | 〇 | × | 〇 |

| 307 | A-D 変換 | × | × | × | 〇 |

| 308 | パルス符号変調器 (PCM) | × | × | × | × |

| 309 | 高速フーリエ変換 (FFT) | × | × | × | 〇 |

| 310 | スペクトル包絡 | 〇 | × | × | 〇 |

| 311 | メル周波数ケプストラム係数 (MFCC) | 〇 | 〇 | 〇 | 〇 |

| 312 | フォルマント | 〇 | × | × | × |

| 313 | フォルマント周波数 | 〇 | × | × | 〇 |

| 314 | 音韻 | 〇 | × | × | 〇 |

| 315 | 音素 | 〇 | 〇 | × | × |

| 316 | 音声認識エンジン | × | × | × | 〇 |

| 317 | 隠れマルコフモデル | 〇 | 〇 | 〇 | 〇 |

| 318 | WaveNet | × | 〇 | × | 〇 |

| 319 | メル尺度 | × | 〇 | 〇 | × |

| 320 | N-gram | 〇 | × | × | × |

| 321 | BoW (Bag-of-Words) | 〇 | 〇 | × | 〇 |

| 322 | ワンホットベクトル | 〇 | 〇 | 〇 | 〇 |

| 323 | TF-IDF | 〇 | 〇 | 〇 | 〇 |

| 324 | 単語埋め込み | 〇 | × | × | 〇 |

| 325 | 局所表現 | 〇 | × | × | 〇 |

| 326 | 分散表現 | 〇 | 〇 | × | 〇 |

| 327 | word2vec | 〇 | 〇 | 〇 | 〇 |

| 328 | スキップグラム | × | × | × | 〇 |

| 329 | CBOW | × | × | × | 〇 |

| 330 | fastText | 〇 | × | × | 〇 |

| 331 | ELMo | 〇 | 〇 | × | 〇 |

| 332 | 言語モデル | 〇 | × | 〇 | × |

| 333 | CTC | 〇 | 〇 | 〇 | × |

| 334 | Seq2Seq | 〇 | 〇 | × | 〇 |

| 335 | Source-Target Attention | 〇 | × | × | 〇 |

| 336 | Encoder-Decoder Attention | 〇 | 〇 | × | × |

| 337 | Self-Attention | 〇 | 〇 | × | 〇 |

| 338 | 位置エンコーディング | 〇 | × | × | × |

| 339 | GPT | 〇 | × | × | 〇 |

| 340 | GPT-2 | 〇 | 〇 | × | 〇 |

| 341 | GPT-3 | 〇 | × | × | 〇 |

| 342 | BERT | 〇 | 〇 | 〇 | 〇 |

| 343 | GLUE | 〇 | × | × | × |

| 344 | Vision Transformer | × | × | × | × |

| 345 | 構文解析 | × | 〇 | 〇 | 〇 |

| 346 | 形態要素解析 | × | 〇 | 〇 | 〇 |

| 347 | DQN | 〇 | 〇 | 〇 | 〇 |

| 348 | ダブル DQN | 〇 | 〇 | × | 〇 |

| 349 | デュエリングネットワーク | 〇 | 〇 | × | 〇 |

| 350 | ノイジーネットワー ク | 〇 | × | × | 〇 |

| 351 | Rainbow | 〇 | 〇 | × | 〇 |

| 352 | モンテカルロ木探索 | 〇 | 〇 | × | 〇 |

| 353 | アルファ碁 (AlphaGo) | 〇 | 〇 | 〇 | 〇 |

| 354 | アルファ碁ゼロ (AlphaGo Zero) | 〇 | 〇 | × | 〇 |

| 355 | アルファゼロ (Alpha Zero) | 〇 | 〇 | × | 〇 |

| 356 | マルチエージェント強化学習 | 〇 | × | × | × |

| 357 | OpenAI Five | 〇 | × | × | × |

| 358 | アルファスター (AlphaStar) | 〇 | × | × | 〇 |

| 359 | 状態表現学習 | 〇 | × | × | × |

| 360 | 連続値制御 | 〇 | × | × | × |

| 361 | 報酬成形 | 〇 | × | × | × |

| 362 | オフライン強化学習 | 〇 | × | × | × |

| 363 | sim2real | 〇 | × | × | × |

| 364 | ドメインランダマイゼーション | 〇 | × | × | × |

| 365 | 残差強化学習 | 〇 | × | × | × |

| 366 | Grad-CAM | 〇 | × | × | 〇 |

| 367 | CAM | × | × | × | × |

| 368 | エッジAI | × | × | × | × |

| 369 | 蒸留 | 〇 | × | 〇 | 〇 |

| 370 | モデル圧縮 | × | × | × | × |

| 371 | 量子化 | × | × | × | 〇 |

| 372 | プルーニング | × | × | × | × |

| カバー率 | 81% | 52.6% | 25.5% | 57.2% |

ストライド

ストライドとはフィルタをスライドさせる量のことである。

256×256の画像にパディング1をして2×2のフィルタをストライド2で適用すると、適用後の画像サイズはいくつになる?

黒本に計算の演習が載っているので一回くらいは解いていたほうがいいかもしれない。

CycleGANはググっても分からなかったよ。

私の屍を乗り越えて頑張って理解して欲しい。

ディープラーニングの社会実装に向けて

| No. | キーワード | 公式 | 白本 | 黒本 | 緑本 |

|---|---|---|---|---|---|

| 373 | AI による経営課題の解決と利益の創出 | × | × | × | × |

| 374 | 法の順守 | × | × | × | × |

| 375 | ビッグデータ | 〇 | × | × | × |

| 376 | IoT | 〇 | × | × | × |

| 377 | RPA | 〇 | × | × | × |

| 378 | ブロックチェーン | × | × | × | × |

| 379 | CRISP-DM | 〇 | × | × | × |

| 380 | MLOps | 〇 | × | × | × |

| 381 | BPR | 〇 | × | × | 〇 |

| 382 | クラウド | 〇 | × | × | 〇 |

| 383 | Web API | 〇 | × | × | × |

| 384 | データサイエンティスト | 〇 | × | × | × |

| 385 | プライバシー・バイ・デザイン | 〇 | × | × | 〇 |

| 386 | オープンデータセット | 〇 | × | × | 〇 |

| 387 | 個人情報保護法 | 〇 | 〇 | 〇 | 〇 |

| 388 | 不正競争防止法 | 〇 | × | 〇 | 〇 |

| 389 | 著作権法 | 〇 | 〇 | 〇 | 〇 |

| 390 | 特許法 | × | × | 〇 | 〇 |

| 391 | 個別の契約 | × | × | × | × |

| 392 | データの網羅性 | × | × | × | × |

| 393 | 転移学習 | 〇 | 〇 | × | 〇 |

| 394 | サンプリング・バイアス | 〇 | × | × | 〇 |

| 395 | 産学連携 | 〇 | × | × | × |

| 396 | オープン・イノベーション | 〇 | × | × | × |

| 397 | AI・データの利用に関する契約ガイドライン | 〇 | × | × | × |

| 398 | アノテーション | 〇 | × | × | × |

| 399 | 匿名加工情報 | 〇 | 〇 | 〇 | 〇 |

| 400 | カメラ画像利活用ガイドブック | 〇 | × | × | × |

| 401 | ELSI | 〇 | × | × | 〇 |

| 402 | ライブラリ | × | × | × | 〇 |

| 403 | Python | × | × | × | 〇 |

| 404 | Docker | 〇 | × | × | × |

| 405 | Jupyter Notebook | 〇 | × | × | 〇 |

| 406 | 説明可能 AI (XAI) | 〇 | 〇 | 〇 | 〇 |

| 407 | フィルターバブル | 〇 | 〇 | × | 〇 |

| 408 | FAT | 〇 | × | × | 〇 |

| 409 | PoC | 〇 | × | × | × |

| 410 | 著作物 | 〇 | × | × | 〇 |

| 411 | データベースの著作物 | 〇 | × | × | 〇 |

| 412 | 営業秘密 | 〇 | × | 〇 | 〇 |

| 413 | 限定利用データ | 〇 | × | 〇 | 〇 |

| 414 | オープンデータに関する運用除外 | × | × | × | × |

| 415 | 秘密管理 | 〇 | × | 〇 | × |

| 416 | 個人情報 | 〇 | × | 〇 | 〇 |

| 417 | GDPR | 〇 | 〇 | × | 〇 |

| 418 | 十分性制定 | 〇 | × | × | × |

| 419 | 敵対的な攻撃(Adversarial attacks) | 〇 | × | 〇 | 〇 |

| 420 | ディープフェイク | 〇 | × | 〇 | × |

| 421 | フェイクニュース | 〇 | × | × | × |

| 422 | アルゴリズムバイアス | 〇 | × | × | × |

| 423 | ステークホルダーのニーズ | × | × | × | × |

| 424 | コーポレートガバナンス | 〇 | × | × | × |

| 425 | 内部統制の更新 | 〇 | × | × | × |

| 426 | シリアス・ゲーム | × | × | × | × |

| 427 | 炎上対策とダイバーシティ | × | × | × | × |

| 428 | AI と安全保障・軍事技術 | × | × | × | × |

| 429 | 透明性レポート | 〇 | 〇 | 〇 | × |

| 430 | よりどころとする原則や指針 | × | × | × | × |

| 431 | Partnership on AI | × | × | × | × |

| 432 | 運用の改善やシステムの改修 | × | × | × | × |

| カバー率 | 73.3% | 13.3% | 21.7% | 41.7% |

公式テキスト以外のテキストの壊滅的状況!

法律や倫理の問題が難しいという声もよく聞くが、(テキストに出てこないので分からないのは)それはそうという感じである。

この辺は白本はスカスカだ。

黒本に有用そうな問題が多く出ているので、法律関係は黒本で対策しよう。

カメラ画像利活用ガイドブックは絶対に目を通しておくべきである。

数理・統計

| No. | キーワード | 公式 | 白本 | 黒本 | 緑本 |

|---|---|---|---|---|---|

| 433 | 統計検定3級程度の基礎的キーワードと計算問題 |

さらっと一行で凄まじいことが書いてある。

「計算問題」と書いてあるので、分散や標準偏差の計算くらいは出来るようになっていたほうがいいかもしれない。

まとめ

カバー率をまとめると、以下のようになった。

| No. | 大項目 | 公式 | 白本 | 黒本 | 緑本 |

|---|---|---|---|---|---|

| 1 | 人工知能とは | 76.9% | 84.6% | 53.8% | 61.5% |

| 2 | 人工知能をめぐる動向 | 77.8% | 53.7% | 33.3% | 42.6% |

| 3 | 人工知能分野の問題 | 86.7% | 80% | 53.3% | 60% |

| 4 | 機械学習の具体的手法 | 71.4% | 59.3% | 38.5% | 63.7% |

| 5 | ディープラーニングの概要 | 67.4% | 78.3% | 43.5% | 67.4% |

| 6 | ディープラーニングの手法 | 81% | 52.6% | 25.5% | 57.2% |

| 7 | ディープラーニングの社会実装に向けて | 73.3% | 13.3% | 21.7% | 41.7% |

| 8 | 統計検定3級程度の基礎的キーワードと計算問題 | - | - | - | - |

公式テキストは公式なだけあって優秀な結果となった。

白本もかなり良い。

次に、公式テキストに載っていないキーワードを抽出してみる。

| No. | 大項目 | 公式 | 白本 | 黒本 | 緑本 |

|---|---|---|---|---|---|

| 2 | エージェント | × | 〇 | 〇 | 〇 |

| 12 | 特徴量 | × | 〇 | 〇 | 〇 |

| 13 | ディープブルー | × | 〇 | 〇 | × |

| 28 | 知識ベースの構築とエキスパートシステム | × | × | × | × |

| 32 | 概念間の関係 (is-a と part-of の関係) | × | × | × | × |

| 33 | オントロジーの構築 | × | × | × | × |

| 37 | イライザ効果 | × | 〇 | × | × |

| 42 | has-a の関係 | × | × | × | × |

| 52 | スパムフィルター | × | × | × | × |

| 55 | 人間の神経回路 | × | × | × | × |

| 63 | パターン認識 | × | × | × | × |

| 64 | 画像認識 | × | 〇 | 〇 | × |

| 65 | 特徴抽出 | × | × | × | × |

| 66 | 一般物体認識 | × | × | × | 〇 |

| 67 | OCR | × | × | × | × |

| 75 | 特徴量設計 | × | 〇 | 〇 | 〇 |

| 79 | 機械翻訳 | × | 〇 | 〇 | × |

| 92 | 半教師あり学習 | × | 〇 | 〇 | 〇 |

| 96 | アンサンブル学習 | × | 〇 | 〇 | 〇 |

| 111 | 疑似相関 | × | × | × | × |

| 112 | 重回帰分析 | × | × | 〇 | 〇 |

| 113 | AdaBoost | × | 〇 | × | × |

| 114 | 多クラス分類 | × | × | × | × |

| 115 | プルーニング | × | × | × | × |

| 116 | k-means 法 | × | 〇 | 〇 | 〇 |

| 121 | クラスタリング | × | 〇 | 〇 | 〇 |

| 131 | 次元削減 | × | 〇 | 〇 | 〇 |

| 135 | 価値関数 | × | × | × | 〇 |

| 150 | モデルの解釈 | × | × | × | × |

| 151 | モデ ルの選択と情報量 | × | × | × | × |

| 156 | 過学習 | × | 〇 | 〇 | 〇 |

| 157 | 未学習 | × | × | × | × |

| 159 | L0 正則化 | × | × | × | × |

| 160 | L1 正則化 | × | 〇 | × | × |

| 161 | L2 正則化 | × | 〇 | × | × |

| 164 | オッカムの剃刀 | × | × | × | × |

| 165 | 赤池情報量基準 (AIC) | × | × | × | × |

| 166 | 汎化性能 | × | 〇 | × | 〇 |

| 167 | 平均二乗誤差 | × | 〇 | × | × |

| 168 | 偽陽性-偽陰性 | × | × | × | 〇 |

| 169 | 第一種の過誤-第二種の過誤 | × | × | × | × |

| 170 | 訓練誤差 | × | × | 〇 | × |

| 171 | 汎化誤差 | × | × | 〇 | 〇 |

| 177 | 信用割当問題 | × | × | × | × |

| 188 | TPU | × | 〇 | × | 〇 |

| 193 | Leaky ReLU 関数 | × | × | × | × |

| 197 | 交差エントロピー | × | × | × | × |

| 199 | エポック | × | 〇 | 〇 | 〇 |

| 204 | モーメンタム | × | 〇 | 〇 | × |

| 211 | ハイパーパラメータ | × | × | 〇 | 〇 |

| 212 | ランダムサーチ | × | × | × | 〇 |

| 213 | グリッドサーチ | × | × | 〇 | 〇 |

| 214 | 確率的勾配降下法 | × | 〇 | 〇 | 〇 |

| 215 | 最急降下法 | × | 〇 | × | × |

| 216 | バッチ学習 | × | 〇 | 〇 | 〇 |

| 217 | ミニバッチ学習 | × | 〇 | 〇 | 〇 |

| 218 | オンライン学習 | × | 〇 | × | 〇 |

| 219 | データリーケージ | × | × | × | × |

| 223 | 過学習 | × | 〇 | 〇 | 〇 |

| 224 | アンサンブル学習 | × | 〇 | 〇 | 〇 |

| 237 | 畳み込み | × | 〇 | 〇 | × |

| 238 | フィルタ | × | 〇 | 〇 | 〇 |

| 241 | グローバルアベレージプーリング (GAP) | × | 〇 | × | × |

| 245 | CutMix | × | × | × | × |

| 253 | 局所結合構造 | × | 〇 | × | × |

| 254 | ストライド | × | 〇 | 〇 | × |

| 255 | パディング | × | 〇 | 〇 | 〇 |

| 268 | マルチタスク学習 | × | × | × | × |

| 282 | 矩形領域 | × | × | × | × |

| 290 | SegNet | × | 〇 | × | × |

| 298 | Mask R-CNN | × | × | × | 〇 |

| 307 | A-D 変換 | × | × | × | 〇 |

| 308 | パルス符号変調器 (PCM) | × | × | × | × |

| 309 | 高速フーリエ変換 (FFT) | × | × | × | 〇 |

| 316 | 音声認識エンジン | × | × | × | 〇 |

| 318 | WaveNet | × | 〇 | × | 〇 |

| 319 | メル尺度 | × | 〇 | 〇 | × |

| 328 | スキップグラム | × | × | × | 〇 |

| 329 | CBOW | × | × | × | 〇 |

| 344 | Vision Transformer | × | × | × | × |

| 345 | 構文解析 | × | 〇 | 〇 | 〇 |

| 346 | 形態要素解析 | × | 〇 | 〇 | 〇 |

| 367 | CAM | × | × | × | × |

| 368 | エッジAI | × | × | × | × |

| 370 | モデル圧縮 | × | × | × | × |

| 371 | 量子化 | × | × | × | 〇 |

| 372 | プルーニング | × | × | × | × |

| 373 | AI による経営課題の解決と利益の創出 | × | × | × | × |

| 374 | 法の順守 | × | × | × | × |

| 378 | ブロックチェーン | × | × | × | × |

| 390 | 特許法 | × | × | 〇 | 〇 |

| 391 | 個別の契約 | × | × | × | × |

| 392 | データの網羅性 | × | × | × | × |

| 402 | ライブラリ | × | × | × | 〇 |

| 403 | Python | × | × | × | 〇 |

| 414 | オープンデータに関する運用除外 | × | × | × | × |

| 423 | ステークホルダーのニーズ | × | × | × | × |

| 426 | シリアス・ゲーム | × | × | × | × |

| 427 | 炎上対策とダイバーシティ | × | × | × | × |

| 428 | AI と安全保障・軍事技術 | × | × | × | × |

| 430 | よりどころとする原則や指針 | × | × | × | × |

| 431 | Partnership on AI | × | × | × | × |

| 432 | 運用の改善やシステムの改修 | × | × | × | × |

公式テキストのみで勝負に挑みたい人は、上記のキーワードをググっておくと良さそうだ。

とは言ったものの、公式テキストだけでは問題演習量が圧倒的に不足するため、何らかの問題集をやってoutputを鍛えたほうが良いと思われる。

一冊だけ選ぶなら白本である。

黒本はカバー率が低いし、問題のレベルも試験本番より簡単なので微妙。

しかしながら法律関係の問題はしっかりしているため、この分野だけ勉強するために黒本を買うのはアリだと思われる。

緑本は全体的にカバー率が低い結果となった。最も分厚い本なだけに残念である。

CNNとかRNNみたいな、どの本にも載っている内容について詳しく説明した「小学生向け国語辞典」という印象。