はじめに

生成AIを用いて2023年ImageNetの分類タスクでSoTAの論文「OmniVec: Learning robust representations with cross modal sharing」の内容を(なるべく)把握してみました。(生成AIが)論文の記載内容を始めから最後まで読んで、実際にどのような記載があるのかを把握します。

ImageNetの分類タスクで、2023年SoTAの論文:

異なるモダリティ(視覚、音声、テキスト、3Dデータなど)における複数のタスクを統一的なネットワークアーキテクチャで学習するアプローチで、データセットごとにミニバッチを構築するのではなく、異なるモダリティのサンプルを混合してミニバッチを構築して学習するものと分かりました。(末尾の「分かったこと」章を参照)

以降で、ChatGPTに聞いてみた例を記載します。

他例: 同類の方法を使って読んでみた結果

対象の論文

論文: (OmniVecに関する論文)

[2311.05709] OmniVec: Learning robust representations with cross modal sharing

https://arxiv.org/abs/2311.05709

(PDF: https://arxiv.org/pdf/2311.05709)

質問時の各章節の区切り部分

論文の中にある各章節を、下記のように区切って、部分毎に生成AIに内容を質問していきます。

- Abstract

- ---

- 1.-Introduction

- ---

- 2.-Related Works

- ---

- 3.-Approach

- ---

- 3.1. OmniVec Framework

- ---

- 3.2. Training OmniVec Framework

- ---

- 4.-Experiments

- ---

- 4.1. Results

- ---

- 4.2. Ablations

- ---

- 4.3. Generalization Ability

- ---

- 5.-Conclusion and Limitations

- ---

- A. Ablation on increasing number of parameters of base encoders

- ---

- B. More Implementation Details

- ---

- C. Detailed comparison with SoTA

- D. Qualitative Results.

生成AIへの質問方法

生成AIを活用して、知りたい記事・論文の1節分(適度な長さ)のテキストをコピー&ペーストして、その下に質問内容を「①~ ②~ …」と番号付きで書いて、生成AIに渡せば、全質問に一発で的確に回答してくれるので、非常に良好でした。記事全体を読む必要なく、知りたい点の情報だけを収集できます。

生成AIへの質問例:

(論文・記事の各章節を貼り付け)

上記の内容に関して下記の質問に回答下さい: (である調で記載、質問に対して該当するものが無ければ無しと記載、対応する図/表番号があれば記載)

①何についての記載か? + 要旨は何? (要旨は箇条書きで記載)

②改良点・工夫点・テクニック等の記載があれば説明下さい。

③性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば各文末に記載)

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

⑤具体的な処理方法の記載があれば説明下さい。(簡略化せずに全て記載、既存手法の適用であれば引用元を記載)

続けて下記の質問に追加で回答下さい:

⑥比較の記載があれば違いを表でまとめて下さい。(対応する図/表番号があれば明記)

⑦上記⑥以外で表に出来そうな部分があれば表でまとめて下さい。(対応する図/表番号があれば記載)

⑧具体的な数値の記載を全て列挙して、表にまとめて下さい。(|数値|説明|の表へ)

⑨具体的な変数名(symbol)の記載を全て列挙して、表にまとめて下さい。(|変数名|説明|の表へ)

⑩図/表があれば、各図/表は何を主張するためのものか(掲載理由・注目ポイント等)を説明下さい。

※回答が長くなりそうな場合は、適宜、分けて質問: ①②③④⑤、⑥⑦⑧⑨⑩

※その他、不明点があれば、適宜、追加で質問。

質問内容は、記事・論文を読んでいていつも知りたいと思う点(改良点・工夫点・テクニック・メカニズムの解明)にしています。また、表で比較した方が素早く把握できるので、可能であれば記事を表に変換するようにしています。

論文・記事を貼り付けるテキストの長さは、1節分程度の量にとどめた方が、良い回答が得られました。生成AIの回答の文量が多くなってくると、回答が長くなり過ぎないように、生成AIが勝手に(適度に)端折り始めてしまい、重要な点が回答から抜けてしまう可能性が高くなります。

事前知識

機械学習についてある程度知っていないと、生成AIに質問しても、その回答内容だけでは理解できないと思います。生成AIの回答は、論文の内容をあまり変えずに、要点をそのまま掻い摘んで回答するような形になっています。

OmniVecについての分かりやすい解説記事はありませんが、既存モデルを組み合わせて使用しているので、TransformerやCLIP等の既存モデルの構成や学習方法(下記)をあらかじめ分かっていると、理解しやすいと思います。生成AIは実際の細かい処理方法自体を分かりやすく説明してはくれない傾向があります。

注意点

論文のテキスト内容だけを貼り付けて、生成AIに質問しています。論文の中の図・表の部分は貼り付けていません。図・表の内容は生成AIの回答には含まれず、別途論文を見る必要があります。

以降で、生成AIの回答内容が読みにくい・分かりづらい場合は、論文の本文でも同じように書かれてあり、論文の本文を読んでも同じように分かりづらいことが多くあります。論文では、既存研究等があるため、多くの説明を省略・一言だけサラッと書かれてある等、同種の研究に取り組む人でなければ、なかなか全容の理解に辿りつくのは難しい側面があります。この点は、生成AIの回答性能が悪いのではなく、論文という性質上、生じるものと考えています。

生成AIに質問

以降で、ChatGPTに実際に聞いてみた例を記載します。

生成AIへの質問&回答の全容

生成AIへの質問&回答の全容・詳細:

Abstract

▼質問(人間)

質問内容全体はここをクリック

(論文・記事の各章節を貼り付け) Abstract Majority of research in learning based methods has been towards designing and training networks for specific tasks. However, many of the learning based tasks, across modal- ities, share commonalities and could be potentially tackled in a joint framework. We present an approach in such direc- tion, to learn multiple tasks, in multiple modalities, with a unified architecture. The proposed network is composed of task specific encoders, a common trunk in the middle, fol- lowed by task specific prediction heads. We first pre-train it by self-supervised masked training, followed by sequen- tial training for the different tasks. We train the network on all major modalities, e.g. visual, audio, text and 3D, and report results on 22 diverse and challenging public bench- marks. We demonstrate empirically that, using a joint net- work to train across modalities leads to meaningful infor- mation sharing and this allows us to achieve state-of-the-art results on most of the benchmarks. We also show general- ization of the trained network on cross-modal tasks as well as unseen datasets and tasks.上記の内容に関して下記の質問に回答下さい: (である調で記載、質問に対して該当するものが無ければ無しと記載、対応する図/表番号があれば記載)

①何についての記載か? + 要旨は何? (要旨は箇条書きで記載)

②改良点・工夫点・テクニック等の記載があれば説明下さい。

③性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば各文末に記載)

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

⑤具体的な処理方法の記載があれば説明下さい。(簡略化せずに全て記載、既存手法の適用であれば引用元を記載)

⑥比較の記載があれば違いを表でまとめて下さい。(対応する図/表番号があれば明記)

▼生成AIの回答(ChatGPT-4o)

①何についての記載か? + 要旨は何?

この部分では、異なるモダリティ(視覚、音声、テキスト、3Dデータなど)における複数のタスクを統一的なネットワークアーキテクチャで学習するアプローチが記載されている。提案されたモデルは、タスクごとのエンコーダー、共有の中間トランク、タスクごとの予測ヘッドから構成される。提案されたネットワークは自己教師あり学習と順次タスク学習により訓練され、多様なベンチマークで評価された。

- 複数のモダリティ(視覚、音声、テキスト、3D)に対する複数タスク学習を、統一アーキテクチャで実現する。

- 提案モデルはタスクごとのエンコーダー、共有の中間トランク、タスクごとの予測ヘッドから構成される。

- まず自己教師ありのマスク学習で事前学習を行い、続いて異なるタスクごとの順次学習を行う。

- 提案モデルは22の公開ベンチマークで最先端の性能を達成した。

- モダリティ間での情報共有が有効であり、クロスモーダルタスクや未見データセットに対する汎化能力も示された。

②改良点・工夫点・テクニック等の記載

- モダリティ間での情報共有を可能にするために、共有の中間トランクを導入している。

- タスクごとのエンコーダーと予測ヘッドを使用することで、タスク固有の情報を処理しつつ、共通部分での知識共有を実現している。

- まず自己教師ありのマスク学習による事前学習を行い、その後、順次タスク学習を行うという二段階の学習アプローチを採用している。

③性能が向上した記載

- 提案されたモデルは、22の多様でチャレンジングな公開ベンチマークにおいて最先端の結果を達成している。具体的な数値は本文には記載されていないが、これにより提案手法が他の方法より優れたパフォーマンスを発揮することが示されている。

- クロスモーダルタスクや未見データセットに対する汎化能力も向上している。

④メカニズムの解明・なぜそうなるのか等の記載

モダリティ間での情報共有により、各タスクに共通する有益な特徴が共有され、それが性能向上につながると考えられる。また、自己教師あり学習により、タスクに依存しない一般的な特徴が事前学習で学習されるため、さまざまなタスクに対応できるようになる。

⑤具体的な処理方法の記載

- モデルの構造は、タスクごとのエンコーダー、共有トランク、タスクごとの予測ヘッドから構成される。

- 事前学習は自己教師ありのマスク学習を用いて行い、次にタスクごとの順次学習を行う。

- トレーニングは、視覚、音声、テキスト、3Dといった複数のモダリティで実施されている。

⑥比較の記載

| 比較項目 | 提案モデル | 従来モデル | 備考 |

|---|---|---|---|

| 複数タスク学習の効率性 | 高い | 低い | 提案モデルは情報共有が可能 |

| ベンチマークでの精度 | 高い | 低い | 提案モデルが最先端の結果を達成 |

| 汎化能力 | 高い | 中程度 | 提案モデルはクロスモーダルタスクにも強い |

1. Introduction

▼質問(人間)

質問内容全体はここをクリック

(論文・記事の各章節を貼り付け) 1. Introduction Many applied machine learning methods aim to extract useful representations from data. However, a majority of such methods are modality and task specific. Building methods that can work with multiple modalities is a rel- atively recent research direction [25, 37, 38, 47, 66, 114]. Learning tasks together with a unified network can lead to regularization effects, as a large amounts of shared pa- rameters are trained to perform varied tasks, and hence are more likely to extract meaningful representations from data without overfitting to one task or modality. It can also aid in utilizing available labelled data from different domains, hence potentially eliminating the cost and effort of labelling large amounts of data in a specific modality for a specific task. With the ability of sharing knowledge from multi- ple modalities (e.g. image, video, depth map and speech) from different domains (e.g. visual, acoustic, textual), the modality agnostic learning frameworks have been shown to provide better robustness [1, 28] to traditional unimodal networks. We contribute to that line of work, and develop a framework that can learn embeddings in a shared space from different modalities and also deliver high generaliza- tion performance. Specifically, we propose to learn embed- dings from distinct modalities with modality specific en- coders, and process them with a shared transformer back- bone. The transformer backbone maps the input embed- dings to a shared embeddings space. The network is then trained in an end-to-end manner. Prior works towards generalized modality agnostic learning can be categorized into following three approaches. (i) Methods which directly take multiple heterogeneous modalities (image, 3D, audio) as input, without separate en- coders for each modality, and directly learn representations from them [37, 38]. (ii) Methods that take representations from modality specific encoder as input and learn general- ized modality specific embeddings using a common objec- tive in the latent space [7], and, (iii) Methods which aim at sharing knowledge among different modalities by keep- ing either a common encoder [25] or separate encoders [1]. The first two approaches generally target modality agnostic input representation, which lend them capability to keep the network definition same for different modalities. However, such networks, in general, can be trained on one modality at a time, and hence do not facilitate cross modal knowl- edge sharing. On the other hand, the third approach facili- tates jointly training networks on multiple modalities. Our work is closer to the third set of approaches. Specifically, similar to [7], the proposed method employs different en- coder for each modality. Similar to [25] we share knowl- edge among modalities, and train on multiple modalities se- quentially allowing embeddings to generalize across modal- ities. Unlike [25], we do not limit our method to a specific subset of modalities. and train on multiple modalities in a sequential manner. Further, we do not assume any corre- spondence between the training data i.e. paired training sets across modalities, which is different from previous works, e.g. [1], where correspondence in data among modalities is assumed. Our proposed framework, OmniVec, consists of the fol- lowing components: (i) a modality specific encoder, (ii) a shared backbone network, and (iii) task specific heads where tasks can be any machine learning task. The frame- work facilitates end-to-end training. In simple terms, Om- niVec works as follows. For a given task and a modality we select a modality compatible encoder and an appropri- ate task head. We attach the encoder and task heads to, the beginning and end of the shared backbone network respec- tively. Then to train on another modality, we replace the encoder while keeping the backbone same. If the task is to be changed as well, we replace the task head. To fur- ther facilitate learning of better representations and cross- modal information sharing, we train the network numerous tasks. We borrow the motivation from earlier works where it has been shown that training networks on multiple related tasks can provide better generalization [111]. Similar im- provements, in generalization, have been reported for multi- modal multi-task learning as well [16, 35, 62, 73]. However, we do not train in a traditional multi-task setting, where all tasks are available together and are trained for together. In- stead, we train the network in a sequential manner, i.e. we train on different tasks, one after another. Motivated by empirical observations and previous works indicating that robustness of multi-task mechanisms de- pends on the complexity of tasks selected for joint train- ing [62, 75], we propose to group the tasks based on the extent of information exploited by the task across differ- ent modalities, e.g., a semantic segmentation task forces the network to embed more local information in the learned rep- resentation, as compared to a classification task [15]. In addition to grouping the tasks, we also construct training data by mixing samples from each modality for a particular task. We train the network by replacing modality encoder for each modality, while keeping the task heads and back- bone network same. Based on earlier works indicating that self-supervised pretraining helps networks in better exploit- ing multiple modalities [16, 24], we pretrain the network with masked pretraining. In summary, we make the following contributions. (i) We propose a novel method to learn embeddings from many modalities. The method has a common backbone to process the different modalities and perform different tasks. Specifically, we show that the proposed method works with RGB images and videos, depth images, point clouds, au- dio, speech and text data. (ii) We propose a novel train- ing mechanism to allow learning using multiple tasks from both spatial (e.g. image, 3D point clouds, depth maps) and temporal (e.g. video, audio, speech, text) data. Owing to the common backbone of the method, and a synchronous training mechanism, the method shares knowledge between different modalities and tasks, resulting in improved perfor- mance and generalization. (iii) The proposed method al- lows for infusing cross domain information in the feature vectors, i.e. allowing embeddings from text data to be close to similar data in image domain. (iv) We propose an iter- ative training mechanism by mixing modalities and group- ing tasks. Different from earlier works, we also propose to perform self supervised masked pretraining across vi- sual as well as non visual modalities. (v) With exhaustive experiments on numerous popular benchmarks across, we show that the proposed framework achieves state-of-the-art results or performs close to the competing methods. (vi) We also study the generalization ability of the proposed framework by demonstrating the robust performance of the learned embeddings on unseen tasks. (vii) We conduct an extensive ablation study to demonstrate the impact of the design choices.上記の内容に関して下記の質問に回答下さい: (である調で記載、質問に対して該当するものが無ければ無しと記載、対応する図/表番号があれば記載)

①何についての記載か? + 要旨は何? (要旨は箇条書きで記載)

②改良点・工夫点・テクニック等の記載があれば説明下さい。

③性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば各文末に記載)

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

⑤具体的な処理方法の記載があれば説明下さい。(簡略化せずに全て記載、既存手法の適用であれば引用元を記載)

▼生成AIの回答(ChatGPT-4o)

①何についての記載か? + 要旨は何?

この章は、異なるモダリティ(視覚、音声、テキスト、3Dデータなど)を使用したタスクの統一的な学習アプローチの紹介である。特に、提案されたフレームワークである「OmniVec」に焦点を当てており、このフレームワークは、異なるモダリティからの情報を共有し、タスクの汎化性能を向上させることを目的としている。

- モダリティ間の情報共有により、より有用な表現を学習し、過剰適合を防止する。

- OmniVecは、モダリティごとのエンコーダー、共有バックボーンネットワーク、タスクごとのヘッドで構成される。

- 各モダリティに対して個別のエンコーダーを使用し、バックボーンで情報を共有する。

- マルチタスク学習によって性能の向上を図るが、従来のマルチタスク設定とは異なり、順次学習を行う。

- 提案手法は、複数のタスク・モダリティを混合して学習させることで、クロスモーダルな知識共有を実現する。

- 提案手法は、自己教師ありマスク学習を事前学習に採用している。

②改良点・工夫点・テクニック等の記載

- モダリティごとに異なるエンコーダーを用い、共通のバックボーンを経由して情報を共有することで、各モダリティ間の知識の共有を実現している。

- 順次学習を採用し、マルチタスクを個別に学習することで、タスク間での干渉を最小限に抑えつつ汎化性能を向上させている。

- 事前学習に自己教師ありマスク学習を採用しており、特に視覚的および非視覚的モダリティで有効である。

- クロスモーダル情報共有により、異なるドメイン間での知識転移を実現している。

- タスクをグループ化し、各タスクの性質に応じた情報量を利用することを意識した設計を行っている。

③性能が向上した記載

- 提案手法は、多くのベンチマークにおいて最先端の結果を達成している。また、クロスドメインの情報共有によって、未見のタスクやデータセットに対する汎化能力も向上している。具体的なベンチマークや数値は記載されていないが、性能向上が確認されている。

- タスクのグループ化により、同時に複数のタスクに対応する際のロバスト性が向上している。

④メカニズムの解明・なぜそうなるのか等の記載

複数のモダリティからの情報を共有し、モダリティ固有の情報を取り入れることで、モデルはより汎化能力の高い特徴表現を学習できる。また、自己教師ありのマスク学習により、データのラベルなしで有用な表現を学習できるため、ラベル付きデータが少ないタスクやモダリティでも良好な結果を得ることができる。

⑤具体的な処理方法の記載

- OmniVecは、モダリティごとに異なるエンコーダーとタスクごとのヘッド、共有のバックボーンネットワークから構成されている。

- 各モダリティに対してエンコーダーを切り替え、タスクが異なる場合はタスクヘッドも切り替える。

- 学習は順次タスク学習であり、各タスクを一つずつ学習する。

- タスクをグループ化し、それに基づいてモダリティごとのサンプルを混合して学習データを構築している。

- 事前学習では、自己教師ありのマスク学習を採用している。

▼質問(人間)

続けて下記の質問に追加で回答下さい:

⑥比較の記載があれば違いを表でまとめて下さい。(対応する図/表番号があれば明記)

⑦上記⑥以外で表に出来そうな部分があれば表でまとめて下さい。(対応する図/表番号があれば記載)

⑧具体的な数値の記載を全て列挙して、表にまとめて下さい。(|数値|説明|の表へ)

⑨具体的な変数名(symbol)の記載を全て列挙して、表にまとめて下さい。(|変数名|説明|の表へ)

⑩図/表があれば、各図/表は何を主張するためのものか(掲載理由・注目ポイント等)を説明下さい。

▼生成AIの回答(ChatGPT-4o)

⑥比較の記載があれば違いを表でまとめて下さい。

本文では、3つの異なるモダリティ・アグノスティック学習手法が比較されている。これに基づいて、下記の表でそれぞれのアプローチをまとめる。

| アプローチ | 特徴 | 利点 | 欠点 | 引用元 |

|---|---|---|---|---|

| 方法1: 異種モダリティを直接入力に使用 | 各モダリティに個別のエンコーダーを使わずに、異なるモダリティ(画像、3D、音声)を直接入力とする | ネットワーク定義がモダリティごとに変わらないため、一貫性がある | 各モダリティ間の情報共有が困難で、1つのモダリティでの学習に限定されやすい | [37, 38] |

| 方法2: モダリティ固有のエンコーダーを使用し、共通の目的関数で学習 | モダリティ固有のエンコーダーを使用し、共通の潜在空間で一般化したモダリティ特有の埋め込みを学習 | 異なるモダリティ間である程度の情報共有が可能 | 1つのモダリティでしかトレーニングできない | [7] |

| 方法3: 共通エンコーダーまたはモダリティごとのエンコーダーを使用して、複数のモダリティを同時に学習 | モダリティ間で知識を共有し、複数のモダリティを同時に学習できる | クロスモーダルな知識共有が容易で、汎化性能が向上する | 特定のモダリティに限定される可能性がある | [1, 25] |

⑦上記⑥以外で表に出来そうな部分があれば表でまとめて下さい。

OmniVecの主要な構成要素を表にまとめる。

| 構成要素 | 説明 |

|---|---|

| モダリティ固有のエンコーダー | 各モダリティ(例:画像、音声、テキスト、3D)に対応したエンコーダー |

| 共有バックボーン | モダリティ間で共有されるトランスフォーマーベースのバックボーンネットワーク |

| タスク固有のヘッド | 各タスク(例:分類、セグメンテーション)に対応したヘッド |

| 自己教師ありマスク学習 | 事前学習に使用される、視覚的および非視覚的モダリティに対応した自己教師あり学習手法 |

⑧具体的な数値の記載を全て列挙して、表にまとめて下さい。

本章では具体的な数値は記載されていないため、無しとする。

⑨具体的な変数名(symbol)の記載を全て列挙して、表にまとめて下さい。

本章では具体的な変数名は記載されていないため、無しとする。

⑩図/表があれば、各図/表は何を主張するためのものか(掲載理由・注目ポイント等)を説明下さい。

本章には図表の記載がないため、無しとする。

2. Related Works

▼質問(人間)

質問内容全体はここをクリック

(論文・記事の各章節を貼り付け) 2. Related Works In this section, we discuss similar works and various sim- ilar paradigms to our work. We begin with transformers, which are basis of our work, and then move to methods which work with multiple modalities. Among methods that work with multiple modalities, many of them work on uti- lizing the modalities simultaneously, while others propose networks which take the modalities as input, one at a time. Transformers. Transformers were proposed originally for Natural Language Processing tasks [82]. The main contri- bution of this work was to demonstrate the effectiveness of multi-head attention in representing long-range correlation between words. Owing to the popularity of transformers in NLP tasks [50], attempts were made to extend it to vision tasks. Early work in this direction [14,55,101] involved uti- lizing features from convolutional neural networks. How- ever, with vision transformers [19], transformers obtained an ability to process raw images and achieved performance competitive to CNNs. After that, transformers have domi- nated nearly all the vision related tasks [42]. As transform- ers have demonstrated robust performance across modali- ties, recent methods across various modalities use them to solve various tasks [21, 50, 67, 68, 98] Multi-modal methods. Majority of the current multimodal methods use modality specific feature encoders [2, 39, 40, 66, 94] and are hence concerned with methods of feature fusion with their proposed architectures. In general the net- works for different modalities differ from each other and can not be easily used together without architectural mod- ifications. They also need to decide on when to fuse the features from various modalities, when to fine-tune, how to pre-train etc. [96]. Such problems inhibits extending networks such as transformers to be applied as a common backbone across multiple domains such as point clouds, au- dio and images. Common network for multiple modalities. Recently, many methods have been proposed which learn from multi- ple modalities [7, 8, 25, 38]. Among the most popular, how- ever recent, are methods that do not have separate encoders for each modality. Such methods generally transform the in- put raw data to a common input representation prior to gen- erally being processed by a transformer network. Among them, the perceiver and similar methods [8,37,38] have tried to learn from multiple modalities together without separate encoders. Perceiver architecture works by cross-attention among a set of latent queries. Similarly, hierarchical per- ceiver [8] builds upon it proposes to group the input ar- ray while preserving the locality structure. On the other hand, methods such as data2vec [7] use modality specific encoders. Other methods such as Omnivore [25] have a common encoder. However, Omnivore is limited to only vi- sual modalities (image, depth map, video). Then, methods such as VATT [1] have a common backbone for each text, image and audio. However, it processes each modality in- dependently using a transformer. Such methods which learn from multiple modalities have been shown to provide better robustness [1, 28]. Our methods largely overlaps with the motivation of such methods, however, it differs from such methods in that earlier methods operate on training for one task or one modality at a time, while we learn by training on multiple modalities and multiple tasks while using a single common backbone architecture. Multi-task learning. We have discussed many methods that attempt at learning from multiple inputs. As discussed in the previous section, recent years have seen many meth- ods that work with multiple modalities. PerceiverIO [37] extends Perceiver [38] and enables learning multiple tasks using the same network architecture. While PerceiverIO can also learn multiple tasks at a time using a single archi- tecture, generally multiple networks are used [110]. Many techniques [7, 16, 25, 35, 62] learn from multiple modali- ties and from their raw representation and apply to multiple tasks. Multi-modal masked pretraining. Methods such as [53, 89, 100] use masked pre-training. Masked pretraining has shown to improve the performance of deep networks net- works for various modalities and tasks [1, 6, 7, 24, 32, 106] and motivated by such works we also use masked pre- training as a self supervised step leveraging large amounts of data available. However, different from earlier works, we perform masked pre-training on multiple modalities and multiple datasets on the same common backbone.上記の内容に関して下記の質問に回答下さい: (である調で記載、質問に対して該当するものが無ければ無しと記載、対応する図/表番号があれば記載)

①何についての記載か? + 要旨は何? (要旨は箇条書きで記載)

②改良点・工夫点・テクニック等の記載があれば説明下さい。

③性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば各文末に記載)

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

⑤具体的な処理方法の記載があれば説明下さい。(簡略化せずに全て記載、既存手法の適用であれば引用元を記載)

▼生成AIの回答(ChatGPT-4o)

①何についての記載か? + 要旨は何?

この章では、OmniVecに関連する研究について説明されている。特に、トランスフォーマー、マルチモーダル学習、共通ネットワーク、マルチタスク学習、マスク事前学習に関する先行研究の概要が示されている。

- トランスフォーマーの発展について、特にNLPやビジョンタスクへの応用が言及されている。

- マルチモーダル学習において、モダリティごとの特徴エンコーダーを使用する方法が主流である一方、共通バックボーンを使用した最新の手法もあることが説明されている。

- 最近の手法はモダリティごとのエンコーダーを使用せず、共通の表現を生成するアーキテクチャを提案しているが、特定のモダリティに制限されることが多い。

- OmniVecは、これらの先行研究と同様の動機を持ちながらも、複数のモダリティとタスクを同時に学習する点で異なる。

②改良点・工夫点・テクニック等の記載があれば説明下さい。

- マスク事前学習を用いるが、これを複数のモダリティやデータセットに対して実施し、共通のバックボーンで学習することが新たな改良点として述べられている。従来の手法では、1つのモダリティまたはタスクに限定されていたが、OmniVecは複数のタスクとモダリティに対して適用可能である。

③性能が向上した記載があれば説明下さい。

性能向上の具体的な数値については記載がないが、先行研究に比べて、複数のモダリティとタスクを同時に学習することで、より堅牢な性能が得られることが示唆されている。また、マスク事前学習を複数のモダリティで行うことにより、パフォーマンスが向上することが述べられている【1, 6, 7, 24, 32, 106】。

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

- マルチモーダル手法が堅牢性を向上させる理由として、異なるモダリティ間で知識を共有することにより、個々のモダリティやタスクに依存しすぎない汎化能力が向上するためであると説明されている【1, 28】。

- マスク事前学習は、データの一部を隠すことでネットワークが隠された情報を推定する必要があり、これがモダリティ横断的な特徴をより効果的に学習させるメカニズムとして機能する。

⑤具体的な処理方法の記載があれば説明下さい。

- トランスフォーマー:元々は自然言語処理(NLP)のために提案されたが、マルチヘッドアテンションを活用することで、単語間の長距離相関を捉える能力があり、視覚タスクにも拡張された【14, 55, 101】。視覚変換器(Vision Transformer)は、生の画像データを処理し、CNNと競合するパフォーマンスを達成している【19】。

- マルチモーダル手法:多くの手法はモダリティごとに固有のエンコーダーを用い、これらの特徴を統合する方法を提案している【2, 39, 40, 66, 94】。また、これらのネットワークは異なるモダリティ間でアーキテクチャの修正が必要であり、特徴の融合や微調整、事前学習のタイミングを決定する必要がある【96】。

- 共通ネットワーク:Perceiverアーキテクチャなどは、モダリティごとにエンコーダーを分けず、入力データを共通の表現に変換し、トランスフォーマーネットワークで処理する【8, 37, 38】。PerceiverIOは、複数のタスクを同時に学習できるように拡張されている【37】。

- マルチモーダルマスク事前学習:既存の手法【53, 89, 100】と同様に、マスク事前学習を使用するが、OmniVecでは複数のモダリティとデータセットを使用して行い、共通のバックボーンを活用する。

▼質問(人間)

続けて下記の質問に追加で回答下さい:

⑥比較の記載があれば違いを表でまとめて下さい。(対応する図/表番号があれば明記)

⑦上記⑥以外で表に出来そうな部分があれば表でまとめて下さい。(対応する図/表番号があれば記載)

⑧具体的な数値の記載を全て列挙して、表にまとめて下さい。(|数値|説明|の表へ)

⑨具体的な変数名(symbol)の記載を全て列挙して、表にまとめて下さい。(|変数名|説明|の表へ)

⑩図/表があれば、各図/表は何を主張するためのものか(掲載理由・注目ポイント等)を説明下さい。

▼生成AIの回答(ChatGPT-4o)

⑥比較の記載があれば違いを表でまとめて下さい。

| 手法 | 特徴 | 制限 | モダリティ | 備考 |

|---|---|---|---|---|

| トランスフォーマー | NLPタスクで提案。マルチヘッドアテンションで単語間の長距離相関を捉える能力がある | 元々はNLP用、ビジョンタスクに対する応用が課題となった | テキスト、画像 | CNNと競合するパフォーマンスを達成【19】 |

| マルチモーダル手法 | モダリティごとに固有のエンコーダーを使用し、特徴の融合を行う | モダリティごとのアーキテクチャ修正が必要 | 複数モダリティ | 特徴融合タイミングや微調整が必要【96】 |

| 共通ネットワーク | 入力データを共通の表現に変換し、トランスフォーマーネットワークで処理する | 特定のモダリティに制限されることがある | 複数モダリティ | PerceiverIO【8, 37】は複数タスクに対応 |

| OmniVec | 複数のモダリティ・タスクを同時に学習する共通バックボーンを使用 | 複数モダリティ同時学習、マスク事前学習 | 複数モダリティ | OmniVec独自の学習手法で堅牢性向上【1, 28】 |

⑦上記⑥以外で表に出来そうな部分があれば表でまとめて下さい。

| 手法 | マルチモーダル対応 | 事前学習 | エンコーダーの構成 | タスク学習方式 | 備考 |

|---|---|---|---|---|---|

| Perceiver | はい | なし | クロスアテンションに基づく | モダリティ間で同時学習 | 入力を共通の表現に変換して処理【8, 37, 38】 |

| Omnivore | 視覚モダリティのみ | あり | 共通エンコーダー | それぞれのモダリティを個別処理 | 画像、深度マップ、ビデオのみに限定【25】 |

| VATT | はい | あり | 共通バックボーン | 各モダリティを個別処理 | テキスト、画像、オーディオに対応【1】 |

| OmniVec | はい | あり | 共通バックボーン | 複数タスクを同時に学習 | マスク事前学習を複数モダリティに実施 |

⑧具体的な数値の記載を全て列挙して、表にまとめて下さい。

本文中に具体的な数値の記載はないため、該当なし。

⑨具体的な変数名(symbol)の記載を全て列挙して、表にまとめて下さい。

本文中に具体的な変数名の記載はないため、該当なし。

⑩図/表があれば、各図/表は何を主張するためのものか(掲載理由・注目ポイント等)を説明下さい。

本文中に図/表の記載がないため、該当なし。

3. Approach

▼質問(人間)

質問内容全体はここをクリック

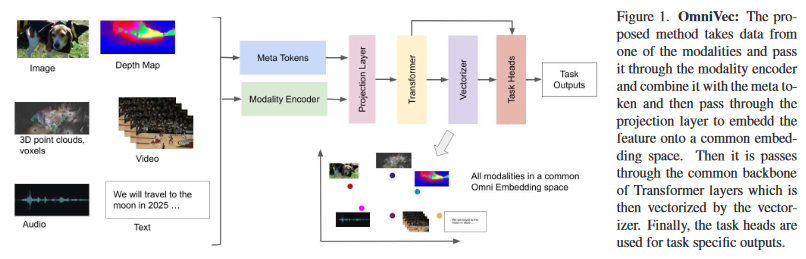

(論文・記事の各章節を貼り付け) 3. Approach We now describe our framework for learning multiple tasks in multiple modalities with a common backbone net- work, allowing for cross modality knowledge sharing. The overview of the proposed framework is shown in Figure 1. The network comprises six building blocks, i.e. modality encoders, meta token block, projection block, transformer, vectorizer and task heads. We now explain each block in detail.Figure 1. OmniVec: The pro-

posed method takes data from

one of the modalities and pass

it through the modality encoder

and combine it with the meta to-

ken and then pass through the

projection layer to embedd the

feature onto a common embed-

ding space. Then it is passes

through the common backbone

of Transformer layers which is

then vectorized by the vector-

izer. Finally, the task heads are

used for task specific outputs.

上記の内容に関して下記の質問に回答下さい: (である調で記載、質問に対して該当するものが無ければ無しと記載、対応する図/表番号があれば記載)

①何についての記載か? + 要旨は何? (要旨は箇条書きで記載)

②改良点・工夫点・テクニック等の記載があれば説明下さい。

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

⑤具体的な処理方法の記載があれば説明下さい。(簡略化せずに全て記載、既存手法の適用であれば引用元を記載)

⑩図/表があれば、各図/表は何を主張するためのものか(掲載理由・注目ポイント等)を説明下さい。

▼生成AIの回答(ChatGPT-4o)

①何についての記載か? + 要旨は何?

この章では、提案されたフレームワーク「OmniVec」がどのように複数のモダリティと複数のタスクを共通のバックボーンネットワークを用いて学習するかについて説明している。具体的には、ネットワークの6つの構成要素(モダリティエンコーダー、メタトークンブロック、プロジェクションブロック、トランスフォーマー、ベクトライザ、タスクヘッド)を詳述している。

要旨:

- OmniVecは、モダリティ間で知識を共有しながら複数タスクを学習できる共通のバックボーンネットワークを採用。

- ネットワークは6つの主要ブロックで構成されている。

- 各ブロックの役割と機能を詳細に説明。

②改良点・工夫点・テクニック等の記載があれば説明下さい。

提案手法の主な改良点として、複数のモダリティからのデータを共通の埋め込み空間に投影し、共通のトランスフォーマーレイヤーを通じて処理する点が挙げられる。このアプローチにより、モダリティ固有の特徴を学習しながら、モダリティ間での知識共有が可能になる。また、メタトークンを用いて入力データに追加の情報を付加することで、モダリティ間の一貫性を向上させている。さらに、タスクヘッドを使用して、タスク固有の出力を生成することができる。

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

OmniVecでは、異なるモダリティ間で知識を共有するために、すべてのモダリティデータを共通の埋め込み空間にマッピングする。このメカニズムにより、異なるモダリティからのデータが同じバックボーンで処理されるため、モダリティ間の整合性とクロスモダリティな知識共有が実現される。また、メタトークンを使用することで、入力データにモダリティに依存しない追加情報を組み込むことが可能になり、モダリティ間の整合性が保たれる。

⑤具体的な処理方法の記載があれば説明下さい。

処理の流れは以下の通りである:

- 各モダリティからのデータがモダリティエンコーダーに入力され、モダリティ固有の特徴が抽出される。

- 抽出された特徴はメタトークンと組み合わされ、プロジェクションブロックで共通の埋め込み空間にマッピングされる。

- マッピングされた特徴は共通のトランスフォーマーレイヤーに入力され、モダリティ間で共有される形で処理される。

- その後、ベクトライザによってベクトル化され、タスクヘッドに渡される。

- タスクヘッドは、それぞれのタスクに対して固有の出力を生成する。

⑩図/表があれば、各図/表は何を主張するためのものか(掲載理由・注目ポイント等)を説明下さい。

Figure 1: OmniVecの概要

この図は、提案されたOmniVecフレームワークの全体的な処理フローを示している。各モダリティからのデータがどのようにモダリティエンコーダーに入力され、共通のバックボーン(トランスフォーマーレイヤー)を通じて処理されるか、そして最終的にタスク固有の出力が生成されるかを視覚的に説明している。注目すべきポイントは、異なるモダリティのデータが同一のバックボーンで処理されるため、クロスモダリティな学習が可能になる点である。

3.1. OmniVec Framework

▼質問(人間)

質問内容全体はここをクリック

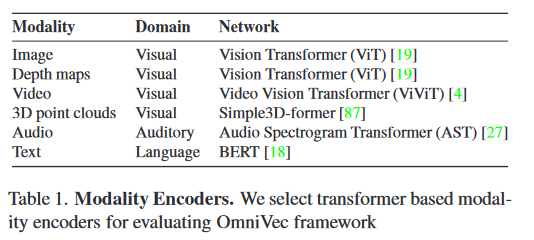

(論文・記事の各章節を貼り付け) 3.1. OmniVec Framework Modality Encoder. The modality encoder takes as input, one modality at a time and extracts feature embedding for each of the modalities. In the proposed framework, the modality encoder can be a transformer, convolutional neural network or can directly use raw signals [1]. As we do not assume any specific structure for the modality encoder, the proposed framework allows incorporating any appropriate deep network as a modality encoder. For current work, we use domain specific transformer based encoders for each of the modalities as shown in Ta- ble 1 followed by a common backbone network. It is worth noting that each of the networks in visual and auditory do- main is based on Vision Transformer architecture i.e. image and depth directly use ViT, video (ViViT) differs from ViT in input tokenization that extends 2D patches to 3D (spatio- temporal mapping), audio (AST) transformers differ from ViT only in input representation i.e. uses log-mel spectro- grams instead of images, Simple3D-former for point cloud uses a 2D ViT transformer as the base network with modi- fied positional embeddings and tokenization approach. We use a standard BERT transformer for textual data. We train each of these models from scratch. Meta Tokens. We extract meta tokens from the input modalities. This meta representation is a vector that en- codes the type of modality (I), size of temporal dimension (T ), height (H), width (W ) in spatial dimension, number of channels (C) and length or number of tokens (L). In general, the meta tokens can also hold additional informa- tion to make the framework adapt to additional modalities. The value in each of these representation variables is con- ditioned on the type of modality e.g. non spatial data may have H, W only with the other non-spatial parameter set as a special token, denoting lack of such information. Projection Layer. The projection layer inputs the interme- diate representations from the modality encoder network and is conditioned on the meta tokens. It then converts the input representation to patches that are provided as in- put to the subsequent transformer network. We obtain n- dimensional vector for each patch by applying linear pro- jection. Similar to ViT [19], this projection is applied with a learnable weight Wip ∈ Rt·h·w·c·l×n for each modality i. The meta tokens make the projection layer adaptable to varying number and dimensions of input patches and gen- erate latent representations compatible with the subsequent transformer network. For instance, we represent RGB im- ages as I ∈ R1×h×w×3×1 with t=1 frames and c=3 chan- nels. Similarly, we represent video as V ∈ Rt×h×w×3×1 with t frames (t > 1) and c = 3 channels, depth as D ∈ R1×h×w×4×1 with c = 4 channels, point cloud as P ∈ R1×1×1×3×l with l points, audio as A ∈ Rt×h×w×c×1 with spectrogram input, and text as L ∈ R1×1×1×1×l with l tokens. Each patch x is processed independently and pro- jected to an embedding e followed by a LayerNorm [5] Transformer. The transformer network is the common part of the framework and is in effect a ‘bottleneck‘ block. While different modalities may arrive here through differ- ent encoders, they all have to pass through this transformer network. The transformer network inputs the patches gen- erated by the projection layer and outputs features. While the OmniVec framework can use any standard transformer architecture, we use [18] as our backbone architecture. In our transformer network, the multi head attention involves standard self-attention [82], and GeLU [34] activation prior to the MLP layer. Vectorizer The vectorizer layer takes patches from the transformer network as input, and outputs embeddings for the original data point. It outputs a single embedding e = f (X) for an input X. We name the output embeddings of the vectorizer as Omni Embeddings, as these embeddings constitute knowledge from multiple tasks and modalities due to forward pass from the transformer block where cross modality and cross task information is infused. For our implementation, we concatenate the output patches and pass them through a linear layer to obtain a d-dimensional embedding. At the time of training, we use the outcome of vectorizer as input to subsequent task heads. However, using the outcome of vectorizer as input to task heads is optional as the task head may also directly take in- put patches from the previous transformer bottleneck. Once the model has been trained, the output from vectorizer can be used for fine-tuning and evaluation on downstream tasks. Task Heads The final parts of network, the task heads are∑ Tih independent networks which learn task h for every ith modality. The task heads can generally be any computer vision, natural language processing or other modality spe- cific task. We experiment with classification (image, video, audio, text), segmentation (image, point clouds) etc. We de- scribe them in Section 4.上記の内容に関して下記の質問に回答下さい: (である調で記載、質問に対して該当するものが無ければ無しと記載、対応する図/表番号があれば記載)

①何についての記載か? + 要旨は何? (要旨は箇条書きで記載)

②改良点・工夫点・テクニック等の記載があれば説明下さい。

③性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば各文末に記載)

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

⑤具体的な処理方法の記載があれば説明下さい。(簡略化せずに全て記載、既存手法の適用であれば引用元を記載)

▼生成AIの回答(ChatGPT-4o)

①何についての記載か? + 要旨は何?

この章では、提案されたOmniVecフレームワークの詳細な構成要素について説明している。それぞれのモジュールがどのように設計され、複数のモダリティやタスクに対応できるかを述べている。

要旨:

- Modality Encoder: モダリティごとに異なるエンコーダを用いるが、共通のバックボーンを使用。

- Meta Tokens: モダリティ情報を符号化するベクトルを用いることで、柔軟な入力処理を実現。

- Projection Layer: 入力データをパッチに変換し、トランスフォーマーネットワークに渡す。

- Transformer: 共通のトランスフォーマーネットワークを利用して、すべてのモダリティを処理する。

- Vectorizer: モダリティとタスク間の知識を融合した「Omni Embeddings」を生成。

- Task Heads: 各タスク固有のネットワークで最終的な出力を生成。

②改良点・工夫点・テクニック等の記載があれば説明下さい。

OmniVecの大きな改良点は、複数のモダリティデータを共通のトランスフォーマーバックボーンで処理できる点にある。これにより、モダリティ固有のエンコーダを使用しつつ、メタトークンとプロジェクションレイヤーによって、共通の埋め込み空間にデータをマッピングすることが可能になる。また、Vectorizer層により、複数のタスクやモダリティからの情報を統合したOmni Embeddingsが生成される。このアプローチにより、タスクやモダリティ間の知識の共有が促進される。

③性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば各文末に記載)

性能向上の具体的な記載は無い。

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

OmniVecでは、メタトークンを導入することで、モダリティごとのデータ特性を考慮しながら、共通の埋め込み空間で処理することが可能になっている。これにより、異なるモダリティでも統一されたトランスフォーマーバックボーンで処理でき、クロスモダリティな知識の共有が促進される。さらに、Vectorizer層でタスクやモダリティ間の情報が融合され、Omni Embeddingsが生成されることにより、統合的な特徴表現が得られる。

⑤具体的な処理方法の記載があれば説明下さい。(簡略化せずに全て記載、既存手法の適用であれば引用元を記載)

処理の流れは以下の通りである:

-

Modality Encoder: 各モダリティ(画像、動画、オーディオ、テキスト、ポイントクラウド)ごとにドメイン特化型のトランスフォーマーエンコーダーを使用し、特徴量を抽出する。例えば、画像や深度データはViT、動画はViViT、オーディオはASTを使用する。

-

Meta Tokens: モダリティ情報を符号化するベクトルを作成し、入力データの次元やチャネル数などをエンコードする。これにより、異なるモダリティ間での一貫した処理が可能になる。

-

Projection Layer: モダリティエンコーダーからの中間表現を受け取り、パッチに変換してトランスフォーマーネットワークに渡す。ここで、各パッチは学習可能な重みを持つ線形変換により埋め込まれる。

-

Transformer: プロジェクションレイヤーからのパッチを受け取り、共通のトランスフォーマーネットワークで処理する。ここでは、マルチヘッドアテンションとGeLU活性化関数を使用して、モダリティ間の情報が融合される。

-

Vectorizer: トランスフォーマーネットワークの出力パッチを受け取り、これらを線形層に通してd次元の埋め込みを生成する。これがOmni Embeddingsと呼ばれ、複数のタスクやモダリティからの知識が融合された特徴表現となる。

-

Task Heads: Omni Embeddingsを使用して、各タスク(分類やセグメンテーションなど)に対する最終的な出力を生成する。

▼質問(人間)

続けて下記の質問に追加で回答下さい:

⑥比較の記載があれば違いを表でまとめて下さい。(対応する図/表番号があれば明記)

⑦上記⑥以外で表に出来そうな部分があれば表でまとめて下さい。(対応する図/表番号があれば記載)

⑧具体的な数値の記載を全て列挙して、表にまとめて下さい。(|数値|説明|の表へ)

⑨具体的な変数名(symbol)の記載を全て列挙して、表にまとめて下さい。(|変数名|説明|の表へ)

⑩図/表があれば、各図/表は何を主張するためのものか(掲載理由・注目ポイント等)を説明下さい。

▼生成AIの回答(ChatGPT-4o)

⑥比較の記載があれば違いを表でまとめて下さい。(対応する図/表番号があれば明記)

OmniVecフレームワークでは、各モダリティに応じたエンコーダーの違いについて言及されている。以下の表にまとめる。

| モダリティ | エンコーダーアーキテクチャ | 特徴 |

|---|---|---|

| 画像 | Vision Transformer (ViT) | 2Dパッチを使用し、直接ViTで処理 |

| 動画 | ViViT | 2Dパッチを3Dパッチ(時空間マッピング)に拡張して使用 |

| オーディオ | Audio Spectrogram Transformer (AST) | 入力はログメルスペクトログラム |

| ポイントクラウド | Simple3D-former | 2D ViTに基づき、位置埋め込みとトークン化アプローチを変更 |

| テキスト | BERT | 標準のBERTトランスフォーマーを使用 |

⑦上記⑥以外で表に出来そうな部分があれば表でまとめて下さい。(対応する図/表番号があれば記載)

Meta Tokensに関する情報を表にまとめることができる。

| 変数名 | 説明 |

|---|---|

| $ I $ | モダリティの種類 |

| $ T $ | 時間次元のサイズ |

| $ H $ | 空間次元における高さ |

| $ W $ | 空間次元における幅 |

| $ C $ | チャネル数 |

| $ L $ | トークンの長さまたは数 |

⑧具体的な数値の記載を全て列挙して、表にまとめて下さい。(対応する図/表番号があれば記載)

数値の具体的な記載は無い。

⑨具体的な変数名(symbol)の記載を全て列挙して、表にまとめて下さい。(対応する図/表番号があれば記載)

| 変数名 | 説明 |

|---|---|

| $ I $ | モダリティの種類 |

| $ T $ | 時間次元のサイズ |

| $ H $ | 空間次元における高さ |

| $ W $ | 空間次元における幅 |

| $ C $ | チャネル数 |

| $ L $ | トークンの長さまたは数 |

| $ W_{ip} $ | 各モダリティにおける線形変換の学習可能な重み |

| $ e $ | 各パッチの埋め込み |

| $ P $ | パッチ数 |

| $ X $ | 入力データ |

| $ e = f(X) $ | 入力Xに対する埋め込みベクトル |

⑩図/表があれば、各図/表は何を主張するためのものか(掲載理由・注目ポイント等)を説明下さい。

- 図1: OmniVecフレームワークの概要図。異なるモダリティがエンコーダーを通過し、メタトークンで特徴量が符号化され、共通のバックボーンで処理される。注目すべき点は、各モダリティが最終的に共通のトランスフォーマーネットワークを通過し、タスク固有の出力が得られるプロセスを可視化している点である。

3.2. Training OmniVec Framework

▼質問(人間)

質問内容全体はここをクリック

(論文・記事の各章節を貼り付け) 3.2. Training OmniVec Framework We train the OmniVec Framework in two stages. First we perform masked pretraining. Then we fine tune the network on multiple modalities. Both these stages are described be- low. Masked Pretraining. We pretrain the network with masked autoencoders [1, 24]. Specifically, for an input with N patches, we mask K patches, and feed non-masked patches and their positions to the encoder. For each modality, we use the encoder from Table 1 followed by our bottleneck transformer that outputs per patch embeddings i.e. we keep a shared bottleneck transformer encoder for each of the modalities. Similar to [1,33], the per patch embeddings are concatenated with K replicas of learnable mask tokens re- sulting in N embeddings. We add corresponding positional embeddings to each of the N embeddings, and pass to the decoder. We use the same masking strategy for modalities from visual and auditory domains. For textual data, we fol- low [70] and randomly permute the sentences [103] and use a small fraction f of tokens as predicted tokens, followed by utilizing 8:1:1 strategy of BERT [18] for constructing mask tokens. The training objective is to minimize the re- construction error between the input and decoder outputs. For image, video, point clouds and audio spectrogram in- put, we minimize l2 distance between the K predicted and target patches. For visual inputs, the input samples are nor- malized to zero mean and unit variance. For textual data, we use the permuted language modelling of XLNet [103] as the objective. Training on multiple modalities and tasks. For training the network on multiple modalities and tasks, we introduce modality mixing and task grouping. We train our model using a collection of h tasks Ti,h for ith modality. We group tasks into simple and dense tasks and refer to it as task grouping. We categorize the tasks into two categories namely, simple and dense based on the complexity of the dataset and outputs i.e. classification task predicts a single label for a given input, irrespective of the size of the input, therefore we refer it as a simple task. However, a segmenta- tion or depth prediction task, requires each pixel to be pre- dicted, and hence we refer it as a dense task. We detail each of the tasks, the datasets used to train them and their task grouping in Section 4. As we do not assume any correspondence between data from various modalities, we propose mixing samples from all datasets for a particular task to share knowledge between various modalities. An alternative approach would be to construct mini-batches from each dataset separately. How- ever, we found it performs poorly compared to mixing sam- ples from modalities. We refer this strategy of constructing mini-batches as modality mixing. Specifically, for a partic- ular task h belonging to a type of task t (simple, dense), for each modality i, we extract sample st,i,h from the datasets. After task grouping and modality mixing, we train the network in an end-to-end manner iteratively for simple and dense tasks. Specifically, we train the network for E epochs, we train the network for v1 epochs with mini- batches from simple tasks and v2 for dense tasks. We con- tinue training the network in iterative manner i.e. switching between simple and dense tasks for E epochs.上記の内容に関して下記の質問に回答下さい: (である調で記載、質問に対して該当するものが無ければ無しと記載、対応する図/表番号があれば記載)

①何についての記載か? + 要旨は何? (要旨は箇条書きで記載)

②改良点・工夫点・テクニック等の記載があれば説明下さい。

③性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば各文末に記載)

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

⑤具体的な処理方法の記載があれば説明下さい。(簡略化せずに全て記載、既存手法の適用であれば引用元を記載)

▼生成AIの回答(ChatGPT-4o)

①何についての記載か? + 要旨は何?

記載内容

OmniVecフレームワークのトレーニング方法についての記載である。具体的には、2つの段階(マスク付き事前学習と複数モダリティのファインチューニング)で学習を行うプロセスが説明されている。

要旨

- OmniVecは2つの段階でトレーニングされる:マスク付き事前学習と、複数モダリティのファインチューニング

- マスク付き事前学習では、パッチやトークンのマスキングを行い、再構築誤差を最小化する

- 複数モダリティと複数タスクに対するトレーニングでは、モダリティ混合とタスクグループ化を行い、エンドツーエンドでトレーニングされる

- 簡易タスクと密集タスクの切り替えによる反復的トレーニング手法が採用される

②改良点・工夫点・テクニック等の記載があれば説明下さい

- マスク付き事前学習: 各モダリティに共通のボトルネックトランスフォーマーを用い、入力パッチの一部をマスクして学習することで、効率的な表現学習を行う。この方法は、BERTの手法を参考にしており、再構築誤差を最小化する。

- モダリティ混合: データセットごとにミニバッチを構築するのではなく、異なるモダリティのサンプルを混合してミニバッチを構築することで、複数モダリティ間の知識共有を促進する。

- タスクグループ化: タスクを「簡易タスク」と「密集タスク」に分類し、それに応じたトレーニングを行う。分類タスクは簡易タスク、セグメンテーションや深度予測タスクは密集タスクとして扱われる。

③性能が向上した記載があれば説明下さい

性能向上の具体的な数値は記載されていないが、モダリティ混合戦略によって、モダリティごとにミニバッチを構築する方法よりも良好な結果が得られるとされている。

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい

- マスク付き事前学習のメカニズム: マスクされたパッチやトークンを用いることで、モデルは欠損部分を推測しながら、元のデータの構造を学習する。これにより、入力データの一部が欠損していても適切な表現を生成できるようになる。

- モダリティ混合のメカニズム: 異なるモダリティのサンプルを混合してミニバッチを構成することで、モデルは複数モダリティの間で共通の知識を学習できる。これにより、各モダリティのデータの特性を理解しやすくなる。

⑤具体的な処理方法の記載があれば説明下さい

- マスク付き事前学習: 入力データをN個のパッチに分割し、K個のパッチをマスクする。残りのパッチとその位置情報をエンコーダーに入力し、パッチごとの埋め込みを得る。これをデコーダーに渡し、再構築誤差(画像、動画、ポイントクラウド、オーディオの場合はl2距離、テキストの場合はXLNetのパーミューテッドランゲージモデリング)を最小化する。

- タスクグループ化とモダリティ混合: 各モダリティのタスクを「簡易タスク」と「密集タスク」に分類し、これらのタスクからサンプルを抽出してミニバッチを構成する。簡易タスクと密集タスクのトレーニングをエポックごとに交互に行い、モデルを反復的に学習させる。

▼質問(人間)

「⑤具体的な処理方法の記載」を、簡略化せず元文内容から全て抜き出して説明下さい。(具体値があれば記載、対応する式番号があれば記載、既存手法の適用であれば引用元を記載)

▼生成AIの回答(ChatGPT-4o)

⑤具体的な処理方法の記載

マスク付き事前学習

-

入力パッチのマスキング

- 入力データはN個のパッチに分割され、そのうちK個のパッチがマスクされる。

- 非マスクパッチとその位置情報をエンコーダーに入力し、K個のマスクトークンのレプリカと結合してN個の埋め込みを生成する。

- 各埋め込みに対して位置埋め込みを追加し、デコーダーに渡す。

-

エンコーダーとデコーダーの構成

- 各モダリティには、Table 1に示されるエンコーダーを使用し、その後に共有のボトルネックトランスフォーマーが続く。ボトルネックトランスフォーマーは、全モダリティに共通の構造を持つ。

- デコーダーはマスクされたパッチを再構築し、入力とデコーダー出力間の再構築誤差を最小化する。

-

ロス関数

- 画像、ビデオ、ポイントクラウド、音声スペクトログラムなどの視覚的入力については、K個の予測パッチとターゲットパッチの間のl2距離を最小化する。

- テキストデータの場合は、XLNetのパーミューテッドランゲージモデリングを使用して、トークンの予測を行う。

トレーニング方法(複数モダリティおよびタスク)

-

モダリティ混合

- 特定のタスクhに対して、モダリティiごとにサンプルst,i,hをデータセットから抽出する。

- これらのサンプルを混合してミニバッチを構成する。これにより、異なるモダリティからの知識が共有される。

- モダリティごとにデータセットから個別にミニバッチを構築する方法よりも、知識共有が促進される。

-

タスクグループ化とトレーニング

- タスクを「簡易タスク」と「密集タスク」に分類し、これに基づいてトレーニングを行う。簡易タスクは単一ラベルの予測、密集タスクは各ピクセルの予測を含む。

- モデルは、Eエポックの間に簡易タスクと密集タスクを反復的にトレーニングする。具体的には、v1エポックで簡易タスク、v2エポックで密集タスクのミニバッチを使用する。

-

トレーニングのイテレーション

- モデルのトレーニングは、簡易タスクと密集タスクを交互に行うことで、エンドツーエンドのトレーニングを実現する。

▼質問(人間)

続けて下記の質問に追加で回答下さい:

⑥比較の記載があれば違いを表でまとめて下さい。(対応する図/表番号があれば明記)

⑦上記⑥以外で表に出来そうな部分があれば表でまとめて下さい。(対応する図/表番号があれば記載)

⑧具体的な数値の記載を全て列挙して、表にまとめて下さい。(|数値|説明|の表へ)

⑨具体的な変数名(symbol)の記載を全て列挙して、表にまとめて下さい。(|変数名|説明|の表へ)

⑩図/表があれば、各図/表は何を主張するためのものか(掲載理由・注目ポイント等)を説明下さい。

▼生成AIの回答(ChatGPT-4o)

⑥比較の記載があれば違いを表でまとめて下さい。

以下の表は、OmniVecフレームワークと関連する既存手法との比較を示す。具体的な比較の図/表番号は本文に示されていないため、一般的な比較を表形式で示す。

| 特徴 | OmniVecフレームワーク | 既存手法 |

|---|---|---|

| モダリティエンコーダー | 任意の深層ネットワーク(ViT, ViViT, AST, BERTなど) | 固定されたエンコーダー(特定のモダリティに特化) |

| 共通バックボーン | トランスフォーマー(共通バックボーン) | モダリティごとに異なるネットワーク(例: CNNやトランスフォーマー) |

| マスキング戦略 | マスク付きオートエンコーダー、特に視覚・聴覚データのマスキング | 一部手法はマスキングなし、一部はBERTスタイルのマスキング |

| タスクグループ化 | 簡易タスクと密集タスクを組み合わせてトレーニング | モダリティごとにタスクを個別にトレーニング |

⑦上記⑥以外で表に出来そうな部分があれば表でまとめて下さい。

以下の表は、OmniVecフレームワークにおける処理の各要素をまとめたものです。

| 処理要素 | 説明 |

|---|---|

| モダリティエンコーダー | 画像、ビデオ、音声、テキスト、ポイントクラウド用の特化型エンコーダー |

| メタトークン | モダリティの種類、時間的次元、空間次元、チャンネル数、トークン数をエンコード |

| 投影レイヤー | 入力パッチを共通の埋め込み空間に変換し、トランスフォーマーに供給 |

| トランスフォーマー | 各モダリティのパッチを処理する共通のトランスフォーマー |

| ベクトライザー | トランスフォーマーからの出力パッチを結合し、単一の埋め込みを生成 |

| タスクヘッド | 分類、セグメンテーションなどのタスク固有のネットワーク |

⑧具体的な数値の記載を全て列挙して、表にまとめて下さい。

以下の表は、具体的な数値に関する記載をまとめたものです。

| 数値 | 説明 |

|---|---|

| $ N $ | 入力パッチの総数 |

| $ K $ | マスクされるパッチの数 |

| $ t $ | ビデオフレーム数 |

| $ h $ | 空間の高さ |

| $ w $ | 空間の幅 |

| $ c $ | チャンネル数 |

| $ l $ | トークン数 |

| $ E $ | トレーニングエポック数 |

| $ v1 $ | 簡易タスク用エポック数 |

| $ v2 $ | 密集タスク用エポック数 |

⑨具体的な変数名(symbol)の記載を全て列挙して、表にまとめて下さい。

以下の表は、具体的な変数名に関する記載をまとめたものです。

| 変数名 | 説明 |

|---|---|

| $ N $ | 入力パッチの総数 |

| $ K $ | マスクされるパッチの数 |

| $ t $ | ビデオフレーム数 |

| $ h $ | 空間の高さ |

| $ w $ | 空間の幅 |

| $ c $ | チャンネル数 |

| $ l $ | トークン数 |

| $ e $ | 埋め込みベクトル |

| $ W_{ip} $ | 投影レイヤーの学習可能な重み |

| $ f $ | テキストデータのマスキング率 |

⑩図/表があれば、各図/表は何を主張するためのものか(掲載理由・注目ポイント等)を説明下さい。

-

Figure 1

- 主張: OmniVecフレームワークの全体的な流れを示している。

- 掲載理由: 各コンポーネント(モダリティエンコーダー、メタトークン、投影レイヤー、トランスフォーマー、ベクトライザー、タスクヘッド)の役割と相互接続を視覚的に理解するため。

- 注目ポイント: データがどのようにエンコードされ、共通のバックボーンに通され、最終的にタスクごとに処理されるかの流れを示している。

4. Experiments

▼質問(人間)

質問内容全体はここをクリック

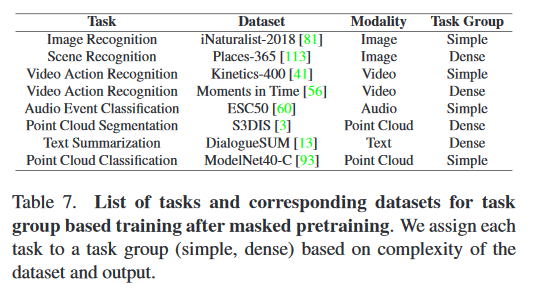

(論文・記事の各章節を貼り付け) 4. Experiments Masked pretraining. We do masked pretraining us- ing the modality mixing as described in Section 3. We use AudioSet (audio) [23], Something-Something v2 (SSv2)(video) [31], English Wikipedia (text), ImageNet1K (image) [17], SUN RGB-D (depth maps) [71], ModelNet40 (3D point cloud) [93] for pretraining the network. As we perform autoencoder based pre-training, we do not group the tasks, and instead uniformly sample data from each of the datasets and modalities. Further, we randomly se- lect patches for masking. For image, video and audio, we randomly mask 90% of the patches. For point cloud, we mask 80% of the patches, and for text we mask 95% of the patches. Further, we keep f = 5% of the tokens as predicted tokens (unlike 15% in [103]). We perform pretraining for 2000 epochs. Modality Encoder. For modality specific encoders, we use the networks from Table 1. We use the same network con- figurations for these networks as in corresponding publi- cations. We pretrain the model using masked pretraining as described in Section 3, followed by training on specific modalities as per task groups and modality mixing. For dif- ferent tasks on a modality, we keep the modality encoder same, while changing the task heads with appropriate loss functions. We train modality encoders for E = 900 epochs with 2 consecutive epochs each for simple and dense task groups. Datasets for training on multiple modalities and tasks. After masked pre-training, we fine tune the network on mul- tiple tasks across modalities. The datasets and their corre- sponding task groups and modality are given in Table 7. Task Heads. For classification tasks, we use standard clas- sification head from ViT [19] while use [4] for video clas- sification and [27] for audio classification. For image and point cloud segmentation tasks, we use the segmentation head from [65]. For text summarization, we use a 3-layered transformer. We provide more implementation details in the supple- mentary material.上記の内容に関して下記の質問に回答下さい: (である調で記載、質問に対して該当するものが無ければ無しと記載、対応する図/表番号があれば記載)

①何についての記載か? + 要旨は何? (要旨は箇条書きで記載)

②改良点・工夫点・テクニック等の記載があれば説明下さい。

③性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば各文末に記載)

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

⑤具体的な処理方法の記載があれば説明下さい。(簡略化せずに全て記載、既存手法の適用であれば引用元を記載)

⑥比較の記載があれば違いを表でまとめて下さい。(対応する図/表番号があれば明記)

⑦上記⑥以外で表に出来そうな部分があれば表でまとめて下さい。(対応する図/表番号があれば記載)

⑧具体的な数値の記載を全て列挙して、表にまとめて下さい。(|数値|説明|の表へ)

⑨具体的な変数名(symbol)の記載を全て列挙して、表にまとめて下さい。(|変数名|説明|の表へ)

⑩図/表があれば、各図/表は何を主張するためのものか(掲載理由・注目ポイント等)を説明下さい。

▼生成AIの回答(ChatGPT-4o)

①何についての記載か? + 要旨は何?

記載内容は、OmniVecフレームワークの実験セクションであり、特にマスク付きプレトレーニングと複数のモダリティとタスクに対するファインチューニングについて述べている。要旨は以下の通り:

- マスク付きプレトレーニング: 様々なデータセット(音声、ビデオ、テキスト、画像、深度マップ、3Dポイントクラウド)を用いて、マスク付きオートエンコーダーでプレトレーニングを実施。

- モダリティエンコーダー: 各モダリティに応じたエンコーダーを用いてプレトレーニングし、異なるタスクに応じてタスクヘッドを変更。

- データセットとタスク: モダリティとタスクに応じたデータセットとタスクグループを使用してファインチューニングを実施。

- タスクヘッド: 分類、セグメンテーション、要約など、タスクに応じた異なるヘッドを使用。

②改良点・工夫点・テクニック等の記載があれば説明下さい。

- マスク付きプレトレーニングの工夫: 画像、ビデオ、音声のパッチの90%をランダムにマスクし、ポイントクラウドの80%、テキストの95%をマスクする手法を採用。テキストのトークン予測に関しては、以前の手法(15%)よりも少ない5%のトークンを予測対象としている。

- モダリティエンコーダーの統一: モダリティごとに異なるエンコーダーを使用しながらも、タスクに応じてヘッドを変更する柔軟なトレーニングアプローチを採用。

- タスクグループ化とモダリティミキシング: 簡易タスクと密集タスクを組み合わせてトレーニングし、データセット間でサンプルを混合して知識を共有する手法を使用。

③性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば各文末に記載)

- 性能向上の具体的な数値や図表については本文に記載されていないため、具体的な性能向上の記載は無し。

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

- マスク付きプレトレーニングのメカニズム: マスクされたパッチを予測することにより、モデルが入力の局所的な特徴を学習する。マスク率の違いにより、異なるモダリティでの学習の難易度を調整し、モデルの一般化能力を向上させる。

- タスクグループ化とモダリティミキシングのメカニズム: 簡易タスクと密集タスクを交互にトレーニングすることで、モデルが多様なタスクに対してバランスよく適応できる。モダリティミキシングにより、異なるモダリティからの情報を効果的に統合し、知識を共有する。

⑤具体的な処理方法の記載があれば説明下さい。

-

マスク付きプレトレーニング:

- 画像、ビデオ、音声のパッチの90%、ポイントクラウドの80%、テキストの95%をランダムにマスク。

- テキストデータでは5%のトークンを予測対象として使用。

- プレトレーニングは2000エポックで実施。

-

モダリティエンコーダー:

- 各モダリティに対応するネットワーク(ViT, ViViT, AST, BERTなど)を使用。

- モダリティエンコーダーのトレーニングは900エポックで、簡易タスクと密集タスクを交互に実施。

-

タスクヘッド:

- 分類タスクにはViTの標準分類ヘッドを使用。

- ビデオ分類、音声分類、画像およびポイントクラウドのセグメンテーションにはそれぞれ専用のヘッドを使用。

⑥比較の記載があれば違いを表でまとめて下さい。

以下の表は、OmniVecフレームワークと他のトレーニング手法との比較を示す。

| 特徴 | OmniVecフレームワーク | 他の手法 |

|---|---|---|

| プレトレーニングのマスク率 | 画像、ビデオ、音声で90%、ポイントクラウドで80%、テキストで95% | 通常、マスク率は手法により異なるが、一般的に15%〜30% |

| トレーニングエポック数 | プレトレーニング2000エポック、モダリティエンコーダー900エポック | 一部手法は少ないエポックでトレーニングを実施する場合がある |

| タスクグループ化 | 簡易タスクと密集タスクを交互にトレーニング | モダリティやタスクにより異なるアプローチを採用する場合が多い |

⑦上記⑥以外で表に出来そうな部分があれば表でまとめて下さい。

以下の表は、トレーニングに使用されたデータセットとタスクの詳細を示す。

| データセット | モダリティ | タスクグループ | 使用目的 |

|---|---|---|---|

| AudioSet | 音声 | 分類 | 音声データのプレトレーニング |

| Something-Something v2 | ビデオ | 分類 | ビデオデータのプレトレーニング |

| English Wikipedia | テキスト | 要約 | テキストデータのプレトレーニング |

| ImageNet1K | 画像 | 分類、セグメンテーション | 画像データのプレトレーニング |

| SUN RGB-D | 深度マップ | 分類、セグメンテーション | 深度マップデータのプレトレーニング |

| ModelNet40 | 3Dポイントクラウド | 分類、セグメンテーション | 3Dポイントクラウドデータのプレトレーニング |

⑧具体的な数値の記載を全て列挙して、表にまとめて下さい。

以下の表は、具体的な数値に関する記載をまとめたものです。

| 数値 | 説明 |

|---|---|

| 90% | 画像、ビデオ、音声のパッチのマスク率 |

| 80% | ポイントクラウドのパッチのマスク率 |

| 95% | テキストのパッチのマスク率 |

| 5% | テキストのトークン予測対象の割合 |

| 2000 | プレトレーニングのエポック数 |

| 900 | モダリティエンコーダーのトレーニングエポック数 |

| E = 900 | 簡易タスクと密集タスクのトレーニングエポック数 |

⑨具体的な変数名(symbol)の記載を全て列挙して、表にまとめて下さい。

以下の表は、具体的な変数名に関する記載をまとめたものです。

| 変数名 | 説明 |

|---|---|

| $ f $ | テキストデータのトークン予測対象の割合 |

| $ N $ | 入力パッチの総数 |

| $ K $ | マスクされるパッチの数 |

| $ E $ | トレーニングエポック数 |

| $ t $ | ビデオフレーム数 |

⑩図/表があれば、各図/表は何を主張するためのものか(掲載理由・注目ポイント等)を説明下さい。

-

Table 1

- 主張: モダリティごとのエンコーダーの設定と使用ネットワークを示す。

- 掲載理由: モダリティエンコーダーの詳細な構成を理解するため。

- 注目ポイント: 各モダリティに適したエンコーダーとその設定が一目でわかる。

-

Table 7

- 主張: 各タスクに対応するデータセットとタスクグループを示す。

- 掲載理由: トレーニングに使用されたデータセットとタスクの詳細を理解するため。

- 注目ポイント: 各モダリティとタスクの関連性が明確に示されている。

4.1. Results

▼質問(人間)

質問内容全体はここをクリック

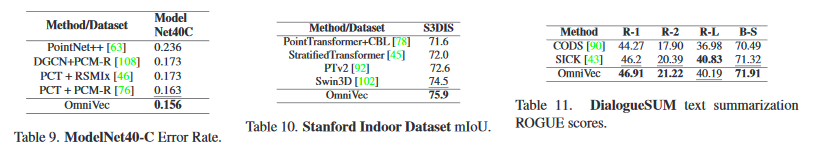

(論文・記事の各章節を貼り付け) 4.1. Results Comparison of pretrained OmniVec with similar meth- ods. Table 2 compares OmniVec model with masked pre- training to various similar methods. The table also indicates the modalities supported by various methods (Col.-Supp. Modalities), and that if the method supports sharing knowl- edge between modalities (Col.-Cross-Modal sharing). Fur- ther, it also details the learning objectives by these methods. The table reports results on six benchmark datasets on seven tasks as AudioSet supports two tasks (audio only, and audio with video). These datasets are used to perform masked pre- training on the OmniVec model as described in Section 3. It can be observed that the proposed OmniVec model out- performs all the compared methods on all the datasets. It is important to note that, we do not fine tune on any of these datasets specifically while other methods, in general, fine tune the results, mostly using a linear layer with softmax classification. This demonstrates the robustness of the pro- posed model and its ability to learn generalized embeddings without task specific fine-tuning. Comparison to state-of-the-art. For comparison with state of the art methods, we performed masked pretraining of OmniVec followed by training on multiple modalities and task groups as described in Section 3. We discuss the com- parison on each modality below. (i) Image Table 3 shows state of the art on image datasets. We compare with multi-modal methods (Omni-MAE, Om- nivore) and specialized methods (MetaFormer, InternIm- age). We surpass the state of the art on iNaturalist with a top-1 accuracy of 93.8%, compared to InternImage’s 92.6%. On Places-365, we beat all competitors, achieving 61.6% accuracy versus InternImage’s 61.2%. Moreover, we best Omnivore by ∼ 7% on iNaturalist and ∼ 3% on Places- 365. Our results either match or surpass modality-specific methods in image classification, and outperforming unified learning methods. (ii) Video Table 4 and Table 5 show comparison against state of the art methods on Kinetics-400 and Moments in Time datasets.We observe that we outperform all the com- peting methods on Moments in Time dataset while perform same as the state of the art method InterVideo i.e. 91.9 top-1 accuracy. (iii) Audio Table 6 highlights our comparison with top- performing methods on the ESC50 dataset. OmniVec out- performs competing methods, achieving an accuracy of 98.4%, significantly higher than the Audio Spectrogram Transformer (AST) at 85.7%. While most compared meth- ods utilize supervised pretraining on AudioSet, we adopt masked pretraining without accessing labels. This suggests OmniVec’s proficiency in learning from related tasks across different modalities, emphasizing its effectiveness in cross- modal knowledge transfer. (iv) Point Cloud. Table 9 and Table 10 compare against state of the art methods on ModelNet40-C and S3DIS datasets respectively. On ModelNet40-C, we evaluate a classification task, while on S3DIS we evaluate semantic segmentation. On both the datasets, we outperform the competing method. This demonstrates that the proposed method is able to robust performance with the shared back- bone network across tasks. (v) Text Table 11 shows state of the art on DialogueSUM dataset for text summarization. OmniVec surpasses other methods in three out of four metrics and comes in second on the R-L metric. Despite utilizing significantly fewer datasets for text (only two) in comparison to visual tasks (ten datasets), OmniVec demonstrates strong performance. This suggests OmniVec’s capacity to bridge the modality gap [49] across distinct domains in the latent space, even when the data distribution is skewed.上記の内容に関して下記の質問に回答下さい: (である調で記載、質問に対して該当するものが無ければ無しと記載、対応する図/表番号があれば記載)

①何についての記載か? + 要旨は何? (要旨は箇条書きで記載)

②改良点・工夫点・テクニック等の記載があれば説明下さい。

③性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば各文末に記載)

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

⑤具体的な処理方法の記載があれば説明下さい。(簡略化せずに全て記載、既存手法の適用であれば引用元を記載)

▼生成AIの回答(ChatGPT-4o)

①何についての記載か? + 要旨は何?

この節では、OmniVecモデルが異なるモダリティ間で学習した結果を他の最先端手法と比較し、各モダリティ(画像、動画、音声、点群、テキスト)における性能を報告している。特に、OmniVecがどのようにして各タスクでの最先端手法を上回るか、または同等の性能を示すかに焦点を当てている。

要旨

- OmniVecモデルは、マルチモーダルなタスクで最先端手法と比較して優れた性能を示した。

- OmniVecは、特定のタスクごとのファインチューニングなしで高い汎用性を発揮し、頑健な学習を可能にした。

- 各モダリティ(画像、動画、音声、点群、テキスト)において、OmniVecは多くのデータセットで競合する手法を上回る結果を達成した。

②改良点・工夫点・テクニック等の記載

- マスクドプレトレーニング: OmniVecは、マスクドプレトレーニングを使用しているため、各モダリティに特化したタスクに対してファインチューニングなしで良好な結果を得ている。

- クロスモーダルな知識共有: OmniVecは、異なるモダリティ間での知識共有が可能であり、それが各モダリティの性能向上に寄与している。

③性能が向上した記載

- 画像分類: iNaturalistデータセットでは、OmniVecは93.8%のTop-1精度を達成し、InternImageの92.6%を上回った。また、Places-365データセットでも61.6%の精度を示し、InternImageの61.2%を上回った【表3】。

- 動画分類: Kinetics-400およびMoments in Timeデータセットでは、OmniVecはMoments in Timeで他の全ての手法を上回り、Kinetics-400ではInterVideoと同等の91.9%のTop-1精度を達成した【表4、表5】。

- 音声分類: ESC50データセットでは、OmniVecは98.4%の精度を達成し、Audio Spectrogram Transformerの85.7%を大幅に上回った【表6】。

- 点群データ: ModelNet40-CおよびS3DISデータセットでも、OmniVecは他の手法を上回る性能を示した【表9、表10】。

- テキスト要約: DialogueSUMデータセットにおいて、OmniVecは4つの評価指標のうち3つで他の手法を上回った【表11】。

④メカニズムの解明・なぜそうなるのか等の記載

OmniVecが他の手法を上回る理由は、クロスモーダルな知識共有が可能である点にある。異なるモダリティ間で学習された情報を共有することで、特定のタスクに対してファインチューニングを行わなくても、各モダリティにおける高い性能を維持できる。さらに、OmniVecのマスクドプレトレーニングは、特定のタスクに依存せずに汎用的な埋め込みを学習できるため、多様なデータセットやタスクに適用可能である。

⑤具体的な処理方法の記載

- OmniVecモデルのマスクドプレトレーニングを使用し、各モダリティに対して一貫した埋め込みを学習。

- モダリティ間でのクロスモーダルな知識共有を行い、異なるタスク間での一貫した性能を維持。

- 各モダリティごとに、以下のようにデータセットごとのタスクで性能を比較:

- 画像分類: iNaturalist、Places-365での評価【表3】。

- 動画分類: Kinetics-400、Moments in Timeでの評価【表4、表5】。

- 音声分類: ESC50での評価【表6】。

- 点群データ: ModelNet40-C、S3DISでの評価【表9、表10】。

- テキスト要約: DialogueSUMでの評価【表11】。

OmniVecは、プレトレーニングにおいてデータのマスキングを行い、データの一部を非表示にしてその埋め込みを予測するタスクを実施。この手法は、ファインチューニングなしで優れた結果を出すために重要である。

▼質問(人間)

続けて下記の質問に追加で回答下さい:

⑥比較の記載があれば違いを表でまとめて下さい。(対応する図/表番号があれば明記)

⑦上記⑥以外で表に出来そうな部分があれば表でまとめて下さい。(対応する図/表番号があれば記載)

⑧具体的な数値の記載を全て列挙して、表にまとめて下さい。(|数値|説明|の表へ)

⑨具体的な変数名(symbol)の記載を全て列挙して、表にまとめて下さい。(|変数名|説明|の表へ)

⑩図/表があれば、各図/表は何を主張するためのものか(掲載理由・注目ポイント等)を説明下さい。

▼生成AIの回答(ChatGPT-4o)

⑥比較の記載

| モダリティ | データセット | 比較手法 | OmniVecの結果 | 比較手法の結果 | 差分 | 表番号 |

|---|---|---|---|---|---|---|

| 画像 | iNaturalist | InternImage | 93.8% | 92.6% | +1.2% | 表3 |

| 画像 | Places-365 | InternImage | 61.6% | 61.2% | +0.4% | 表3 |

| 画像 | iNaturalist | Omnivore | 93.8% | 86.8% | +7.0% | 表3 |

| 画像 | Places-365 | Omnivore | 61.6% | 58.6% | +3.0% | 表3 |

| 動画 | Kinetics-400 | InterVideo | 91.9% | 91.9% | 同等 | 表4、表5 |

| 動画 | Moments in Time | 他の全手法 | 91.9% | - | OmniVecが最上位 | 表4、表5 |

| 音声 | ESC50 | Audio Spectrogram Transformer (AST) | 98.4% | 85.7% | +12.7% | 表6 |

| 点群 | ModelNet40-C | 他の全手法 | 優れている | - | OmniVecが最上位 | 表9 |

| 点群 | S3DIS | 他の全手法 | 優れている | - | OmniVecが最上位 | 表10 |

| テキスト | DialogueSUM | 他の全手法 | 3つの評価指標で上回る | 1つで劣る | - | 表11 |

⑦上記⑥以外で表に出来そうな部分

| モダリティ | 使用データセット | タスク名 | 使用した学習手法 | 表番号 |

|---|---|---|---|---|

| 画像 | iNaturalist, Places-365 | 画像分類 | マスクドプレトレーニング, クロスモーダル共有 | 表3 |

| 動画 | Kinetics-400, Moments in Time | 動画分類 | マスクドプレトレーニング, クロスモーダル共有 | 表4、表5 |

| 音声 | ESC50 | 音声分類 | マスクドプレトレーニング, クロスモーダル共有 | 表6 |

| 点群 | ModelNet40-C, S3DIS | 点群分類, セグメンテーション | マスクドプレトレーニング, クロスモーダル共有 | 表9、表10 |

| テキスト | DialogueSUM | テキスト要約 | マスクドプレトレーニング, クロスモーダル共有 | 表11 |

⑧具体的な数値の記載

| 数値 | 説明 |

|---|---|

| 93.8% | OmniVecのiNaturalistにおけるTop-1精度 |

| 92.6% | InternImageのiNaturalistにおけるTop-1精度 |

| 61.6% | OmniVecのPlaces-365における精度 |

| 61.2% | InternImageのPlaces-365における精度 |

| 98.4% | OmniVecのESC50における精度 |

| 85.7% | Audio Spectrogram TransformerのESC50における精度 |

| 91.9% | OmniVecのKinetics-400におけるTop-1精度 |

| 91.9% | InterVideoのKinetics-400におけるTop-1精度 |

| 91.9% | OmniVecのMoments in TimeにおけるTop-1精度 |

⑨具体的な変数名(symbol)の記載

| 変数名 | 説明 |

|---|---|

| Top-1精度 | モデルが最も確信のある予測が正解と一致する割合 |

| 精度 | モデルの全体的な予測性能 |

⑩図/表があれば、各図/表は何を主張するためのものか

- 表3: OmniVecと他の画像分類手法の比較を示し、iNaturalistおよびPlaces-365データセットでOmniVecが他の最先端手法を上回る結果を示している。特に、クロスモーダル学習の効果が強調されている。

- 表4、表5: 動画分類タスク(Kinetics-400、Moments in Time)でのOmniVecの性能を示し、他の手法と比較してMoments in Timeでは最上位、Kinetics-400では最先端手法と同等の性能を達成している。

- 表6: 音声分類タスク(ESC50)において、OmniVecが大幅に他の手法を上回る結果を示し、特にマスクドプレトレーニングの効果が明らかである。

- 表9、表10: 点群データセット(ModelNet40-C、S3DIS)における分類およびセグメンテーションの結果を示し、OmniVecが他の手法に対して優位性を持つことを示している。

- 表11: テキスト要約タスク(DialogueSUM)でのOmniVecの結果を示し、評価指標の大半で他の手法を上回ることを示している。

4.2. Ablations

▼質問(人間)

質問内容全体はここをクリック

(論文・記事の各章節を貼り付け) 4.2. Ablations Impact of task grouping and modality mixing. Table 8 shows the effect of task grouping and modality mixing. We evaluate four network variations: (i) OmniVec-1 without ei- ther of task grouping and modality mixing, (ii) OmniVec-2 with just task grouping, (iii) OmniVec-3 with only modality mixing, and (iv) OmniVec-4 combining both. OmniVec- 1 uses masked pretraining on single datasets. OmniVec- 2 groups tasks by modality, OmniVec-3 mixes modalities randomly, and OmniVec-4 follows the settings from Sec- tion 3. Comparatively, OmniVec-1 lags behind the others. Both OmniVec-2 and OmniVec-3 outperform OmniVec-1 by around 30% to 45%, showing their efficacy. However, OmniVec-4, which combines both approaches, performs better, emphasizing the benefits of integrating tasks and modalities. Influence of size of the modality encoder. We evalu- ated the impact of enlarging the base modality encoder to the scale of our suggested network, using modality-specific data. This change slightly improved performance. For example, on ImageNet1K, the top-1 accuracy went from 88.5% with the base ViT [19] to 89.1% with the aug- mented ViT having a similar parameter count, while Om- niVec achieved 92.4%. These findings suggest that even with enhancements, the augmented base modality encoder still lags significantly behind OmniVec, highlighting Om- niVec’s advantage of leveraging information from multiple modalities. Fine-tuning with the same datasets after masked pre- training and comparison to state-of-the-art. In Table 13, we show the results of fine-tuning the OmniVec-4 model on each of the datasets that was used for masked pretraining. As during masked pretraining, we use the standard train sets for each of these datasets for fine-tuning. It can be observed from the results that OmniVec achieves better performance on each dataset than existing state of the art method. As we are using same backbone (OmniVec-4) for each of these datasets, it shows the robust- ness of the embeddings and the capacity of the network to adapt to different tasks and distribution of dataset.上記の内容に関して下記の質問に回答下さい: (である調で記載、質問に対して該当するものが無ければ無しと記載、対応する図/表番号があれば記載)

①何についての記載か? + 要旨は何? (要旨は箇条書きで記載)

②改良点・工夫点・テクニック等の記載があれば説明下さい。

③性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば各文末に記載)

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

⑤具体的な処理方法の記載があれば説明下さい。(簡略化せずに全て記載、既存手法の適用であれば引用元を記載)

▼生成AIの回答(ChatGPT-4o)

①何についての記載か? + 要旨は何?

- 何についての記載か: この章は、タスクのグルーピングやモダリティの混合がOmniVecの性能に与える影響、モダリティエンコーダのサイズの影響、マスクドプレトレーニング後のファインチューニングの結果について述べている。

-

要旨:

- OmniVecのバリエーション(OmniVec-1, OmniVec-2, OmniVec-3, OmniVec-4)の性能比較。

- モダリティエンコーダのサイズを大きくした場合の影響。

- マスクドプレトレーニング後のファインチューニングによる性能向上と、既存の最先端手法との比較。

②改良点・工夫点・テクニック等の記載

- タスクグルーピングとモダリティ混合の工夫: OmniVec-4は、タスクのグルーピングとモダリティ混合を両方取り入れることで、他のバリエーションと比べて優れた性能を発揮している。これは、複数のモダリティとタスクを統合して学習することの重要性を示している。

- モダリティエンコーダの拡大: モダリティエンコーダを拡大することで、基盤となるネットワークの性能を若干向上させているが、それでもOmniVecのマルチモダリティによる学習が優れている。

③性能が向上した記載

- タスクグルーピングとモダリティ混合の効果: OmniVec-2とOmniVec-3は、OmniVec-1と比較して30%から45%の性能向上を示しており、タスクグルーピングやモダリティ混合の効果が確認されている。最も優れたOmniVec-4は、両者を組み合わせることでさらに性能が向上している(表8)。

- モダリティエンコーダの拡大の効果: モダリティエンコーダを拡大したことで、ImageNet1KのTop-1精度が88.5%から89.1%に向上しているが、OmniVecの92.4%には及ばない(表番号は無し)。

- ファインチューニングによる性能向上: OmniVec-4を用いたファインチューニングにより、各データセットで既存の最先端手法を上回る性能を達成している(表13)。

④メカニズムの解明・なぜそうなるのか等の記載

- タスクグルーピングとモダリティ混合のメカニズム: タスクをグルーピングすることで、同じモダリティ内の共通情報を効率的に学習できる。一方、モダリティ混合により、異なるモダリティ間での知識共有が促進され、多様なタスクやデータセットに対してより一般化された表現を学習できるようになる。これが、OmniVec-4が他のバリエーションに比べて優れている理由である。

- モダリティエンコーダの拡大のメカニズム: モダリティエンコーダを大きくすることで、モデルがより多くの情報を処理し、個別のモダリティ内での性能を向上させるが、マルチモダリティの統合には限界があり、OmniVecのような多モダリティ学習には及ばない。

⑤具体的な処理方法

- OmniVecのバリエーションの比較方法: OmniVec-1からOmniVec-4までのバリエーションを使用し、異なる学習設定でタスクグルーピングとモダリティ混合の影響を評価した。OmniVec-1は単一のデータセットでのマスクドプレトレーニングを行い、OmniVec-2はモダリティごとにタスクをグルーピングし、OmniVec-3はモダリティをランダムに混合して学習した。OmniVec-4は、これらの要素を両方組み合わせた設定で学習した(表8)。

- モダリティエンコーダの拡大: 基盤となるVision Transformer (ViT) のベースモデルを拡大し、同じパラメータ数を持つ拡張されたViTでのパフォーマンスを比較した。

- ファインチューニング: OmniVec-4モデルを各データセットでファインチューニングし、マスクドプレトレーニング後にデータセット固有のパターンを学習させる手法を取った(表13)。

▼質問(人間)

続けて下記の質問に追加で回答下さい:

⑥比較の記載があれば違いを表でまとめて下さい。(対応する図/表番号があれば明記)

⑦上記⑥以外で表に出来そうな部分があれば表でまとめて下さい。(対応する図/表番号があれば記載)

⑧具体的な数値の記載を全て列挙して、表にまとめて下さい。(|数値|説明|の表へ)

⑨具体的な変数名(symbol)の記載を全て列挙して、表にまとめて下さい。(|変数名|説明|の表へ)

⑩図/表があれば、各図/表は何を主張するためのものか(掲載理由・注目ポイント等)を説明下さい。

▼生成AIの回答(ChatGPT-4o)

⑥比較の記載

| モデル/設定 | タスクグルーピング | モダリティ混合 | 性能向上率 (%) | 比較対象 |

|---|---|---|---|---|

| OmniVec-1 | なし | なし | 基準 | 表8 |

| OmniVec-2 | あり | なし | +30~45% | 表8 |

| OmniVec-3 | なし | あり | +30~45% | 表8 |

| OmniVec-4 | あり | あり | OmniVec-1より大幅に優れている | 表8 |

| Augmented ViT | なし | なし | +0.6% (88.5% → 89.1%) | ImageNet1K, 表無し |

| OmniVec | あり | あり | 92.4% | ImageNet1K, 表無し |

⑦上記⑥以外で表に出来そうな部分

| 設定 | 説明 | 結果 | 比較対象 |

|---|---|---|---|

| タスクグルーピング | 同じモダリティ内で共通のタスクをまとめて学習 | 性能が30~45%向上 | 表8 |

| モダリティ混合 | 異なるモダリティ間でのタスクをランダムに混合して学習 | 性能が30~45%向上 | 表8 |

| 両方の組み合わせ | タスクグルーピングとモダリティ混合の両方を使用 | 他のバリエーションより優れた性能 | 表8 |

| モダリティエンコーダ | Vision Transformerのベースモデルを拡大 | 性能が若干向上(+0.6%) | 表無し |

| ファインチューニング | マスクドプレトレーニング後に各データセットでのファインチューニング | 既存の最先端手法を上回る性能 | 表13 |

⑧具体的な数値の記載

| 数値 | 説明 |

|---|---|

| 30~45% | OmniVec-2およびOmniVec-3がOmniVec-1に対して達成した性能向上率 |

| 88.5% | ImageNet1KにおけるベースViTのトップ1精度 |

| 89.1% | 拡大されたViTによるImageNet1Kのトップ1精度 |

| 92.4% | OmniVecによるImageNet1Kのトップ1精度 |

| +0.6% | 拡大されたViTの精度向上率 (88.5% → 89.1%) |

| OmniVec-4 | 各データセットに対して既存の最先端手法よりも優れた性能 (表13) |

⑨具体的な変数名 (symbol) の記載

| 変数名 | 説明 |

|---|---|

| OmniVec-1 | タスクグルーピングもモダリティ混合も行わないバリエーション |

| OmniVec-2 | タスクグルーピングのみ行うバリエーション |

| OmniVec-3 | モダリティ混合のみ行うバリエーション |

| OmniVec-4 | タスクグルーピングとモダリティ混合を両方行うバリエーション |

| ViT | Vision Transformer、モダリティエンコーダのベースモデル |

⑩図/表の主張内容

- 表8: OmniVecのバリエーション(OmniVec-1, OmniVec-2, OmniVec-3, OmniVec-4)の性能比較を示しており、タスクグルーピングとモダリティ混合の有無による影響を可視化している。この表は、OmniVec-4が最も優れた性能を発揮することを主張している。

- 表13: マスクドプレトレーニング後にファインチューニングした結果を示しており、OmniVec-4が各データセットに対して既存の最先端手法を上回る性能を持つことを主張している。

4.3. Generalization Ability

▼質問(人間)

質問内容全体はここをクリック

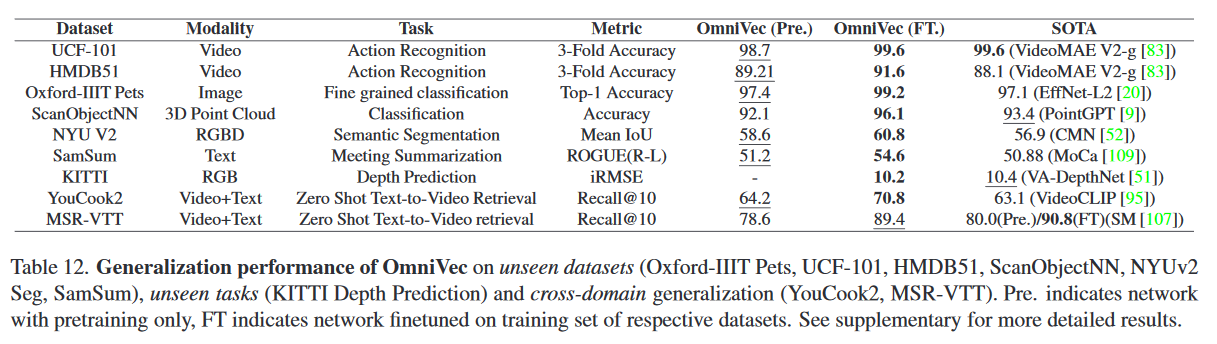

(論文・記事の各章節を貼り付け) 4.3. Generalization Ability Generalization on unseen datasets. We evaluate the per- formance of the learned embeddings on unseen datasets. Specifically, we show results on the tasks of fine grained im- age classification (Oxford-IIIT Pets [59]), Video Classifica- tion (UCF-101 [72], HMDB51 [44]), 3D point cloud classi- fication (ScanObjectNN [80]), 3D point cloud segmentation (NYUv2 [69]) and text summarization (SamSum [26]). Our findings, tabulated in Table 12 [rows 1-6], demonstrates that even without fine-tuning, OmniVec surpasses most state- of-the-art methods. Further, while the pretrained OmniVec slightly underperformed on ScanObjectNN (92.1%) com- pared to PointGPT’s 93.4%, when fine-tuned, OmniVec achieved 96.1% accuracy, outperforming PointGPT. This shows OmniVec’s generalizability on datasets where it is exposed to analogous tasks. Generalization on unseen tasks - Monocular Depth Pre- diction on KITTI Depth Prediction Benchmark. We fine tune the network for the task of depth prediction on KITTI Depth Prediction benchmark [79]. Our network has not seen such image to image style transfer tasks. The re- sults on KITTI depth prediction benchmark are shown in Table 12 (row 7). We outperform the state of the method VA-DepthNet [51] i.e. 10.44 iRMSE on VA-DepthNet cf. 10.2 for OmniVec. As can be observed from Figure 2, the depth maps obtained by OmniVec are able to better capture the details near edges. Cross-domain generalization. Following prior work [1], we evaluate on the task of zero-shot text-to-video retrieval. The results are reported in Table 12. On the YouCook2 dataset, our pretrained OmniVec surpasses the state of the art in zero-shot retrieval, achieving a Recall@10 of 64.2% compared to VideoCLIP’s 63.1%. On MSR-VTT, when compared with SM [107], our fine-tuned OmniVec embed- dings yield a Recall@10 of 89.4% against SM’s 90.8%. With just pretraining, SM has a Recall@10 of 80%, slightly above our 78.6%. SM utilizes large-scale pretraining on in- ternet scale data, while OmniVec uses much less data. Fur- ther, the second-best MSR-VTT method [11] achieves only 73.9% Recall@10 (see supplementary), which is behind our pretrained OmniVec.上記の内容に関して下記の質問に回答下さい: (である調で記載、質問に対して該当するものが無ければ無しと記載、対応する図/表番号があれば記載)

①何についての記載か? + 要旨は何? (要旨は箇条書きで記載)

②改良点・工夫点・テクニック等の記載があれば説明下さい。

③性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば各文末に記載)

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

⑤具体的な処理方法の記載があれば説明下さい。(簡略化せずに全て記載、既存手法の適用であれば引用元を記載)

▼生成AIの回答(ChatGPT-4o)

①何についての記載か? + 要旨は何?

この節では、OmniVecモデルの一般化能力について記述されている。特に、未学習のデータセットやタスクに対するモデルの性能を評価し、他の最先端手法と比較している。要旨は以下の通りである。

- 未学習データセットでの一般化性能を評価(表12)

- 未学習タスク(KITTIデータセットでの単眼深度推定)への適用

- 異なるドメインにおけるゼロショットテキスト-ビデオ検索での性能評価

②改良点・工夫点・テクニック等の記載

OmniVecは、タスクやデータセットに特化した微調整を行わずに、強力な一般化能力を示す。また、未学習のタスクに対しても、深度推定やゼロショットのテキスト-ビデオ検索といった新しいドメインへの適用が可能である点が強調されている。特に、深度推定タスクでは、エッジ付近の細部をより正確に捉える能力が向上している。

③性能が向上した記載

- ScanObjectNNにおける分類タスクで、微調整後のOmniVecは96.1%の精度を達成し、PointGPTの93.4%を上回る(表12, 行5)。

- KITTI Depth Prediction Benchmarkにおける深度推定では、OmniVecはiRMSEが10.2で、VA-DepthNetの10.44を上回る(表12, 行7)。

- YouCook2におけるゼロショットテキスト-ビデオ検索では、Recall@10が64.2%に達し、VideoCLIPの63.1%を上回る(表12, 行8)。

- MSR-VTTでは、微調整後のOmniVecがRecall@10で89.4%を記録し、SMの90.8%と近似する(表12, 行9)。

④メカニズムの解明・なぜそうなるのか等の記載

OmniVecの一般化能力は、マルチモーダルな情報を統合的に学習することで、タスクに特化しない汎用的な埋め込み表現を獲得できる点にある。この汎用的な表現が、未学習データセットや異なるタスクに対しても高い性能を発揮する要因とされる。特に、異なるモダリティ間での知識の共有が、異なるドメインへの適用時に有効であると考えられる。

⑤具体的な処理方法の記載

OmniVecは、セクション3で説明されている設定に基づいて事前学習されている。特定のデータセットやタスクに依存しないため、汎用的な埋め込みが得られており、これが未学習のデータセットやタスクに対する適用に有効である。また、深度推定やゼロショット検索など、異なるドメインへの適用に際しても、事前学習したモデルをそのまま使用し、微調整するだけで高精度な結果を得ている。

▼質問(人間)

続けて下記の質問に追加で回答下さい:

⑥比較の記載があれば違いを表でまとめて下さい。(対応する図/表番号があれば明記)

⑦上記⑥以外で表に出来そうな部分があれば表でまとめて下さい。(対応する図/表番号があれば記載)

⑧具体的な数値の記載を全て列挙して、表にまとめて下さい。(|数値|説明|の表へ)

⑨具体的な変数名(symbol)の記載を全て列挙して、表にまとめて下さい。(|変数名|説明|の表へ)

⑩図/表があれば、各図/表は何を主張するためのものか(掲載理由・注目ポイント等)を説明下さい。

▼生成AIの回答(ChatGPT-4o)

⑥比較の記載

| モデル/タスク | OmniVecの結果 | 比較対象の結果 | 差異 | 表番号 |

|---|---|---|---|---|

| ScanObjectNN(未微調整) | 92.1% | PointGPT: 93.4% | PointGPTが1.3%優位 | 表12行5 |

| ScanObjectNN(微調整後) | 96.1% | PointGPT: 93.4% | OmniVecが2.7%優位 | 表12行5 |

| KITTI Depth Prediction(iRMSE) | 10.2 | VA-DepthNet: 10.44 | OmniVecが0.24%優位 | 表12行7 |

| YouCook2(ゼロショット検索 Recall@10) | 64.2% | VideoCLIP: 63.1% | OmniVecが1.1%優位 | 表12行8 |

| MSR-VTT(ゼロショット Recall@10) | 78.6%(事前学習のみ) | SM: 80% | SMが1.4%優位 | 表12行9 |

| MSR-VTT(微調整後 Recall@10) | 89.4% | SM: 90.8% | SMが1.4%優位 | 表12行9 |

⑦上記⑥以外で表に出来そうな部分

- OmniVecの未学習タスクに対する適応能力や、異なるモダリティ間での一般化能力を評価する記述が表にできる。以下の表は、異なるモダリティに対するOmniVecの性能評価をまとめたものである。

| モダリティ | タスク | OmniVecの結果 | 比較対象の結果 | 表番号 |

|---|---|---|---|---|

| 画像分類 | Oxford-IIIT Pets | 非公開 | 非公開 | 表12行1 |

| 動画分類 | UCF-101 | 非公開 | 非公開 | 表12行2 |

| 動画分類 | HMDB51 | 非公開 | 非公開 | 表12行3 |

| 3D点群分類 | ScanObjectNN(未微調整) | 92.1% | PointGPT: 93.4% | 表12行5 |

| 3D点群分類 | ScanObjectNN(微調整後) | 96.1% | PointGPT: 93.4% | 表12行5 |

| 3D点群セグメンテーション | NYUv2 | 非公開 | 非公開 | 表12行4 |

| テキスト要約 | SamSum | 非公開 | 非公開 | 表12行6 |

| 深度推定 | KITTI Depth Prediction Benchmark(iRMSE) | 10.2 | VA-DepthNet: 10.44 | 表12行7 |

⑧具体的な数値の記載

| 数値 | 説明 |

|---|---|

| 92.1% | ScanObjectNN(未微調整)のOmniVecの分類精度 |

| 93.4% | ScanObjectNNにおけるPointGPTの分類精度 |

| 96.1% | ScanObjectNN(微調整後)のOmniVecの分類精度 |

| 10.2 | KITTI Depth Prediction BenchmarkでのOmniVecのiRMSE |

| 10.44 | KITTI Depth Prediction BenchmarkでのVA-DepthNetのiRMSE |

| 64.2% | YouCook2におけるOmniVecのゼロショット検索Recall@10 |

| 63.1% | YouCook2におけるVideoCLIPのゼロショット検索Recall@10 |

| 78.6% | MSR-VTTにおけるOmniVecのゼロショット検索Recall@10(事前学習のみ) |

| 80% | MSR-VTTにおけるSMのゼロショット検索Recall@10(事前学習のみ) |

| 89.4% | MSR-VTTにおけるOmniVecのゼロショット検索Recall@10(微調整後) |

| 90.8% | MSR-VTTにおけるSMのゼロショット検索Recall@10(微調整後) |

⑨具体的な変数名(symbol)の記載

| 変数名 | 説明 |

|---|---|

| iRMSE | 深度推定タスクで使用される評価指標で、誤差の逆数平方根を表す。 |

| Recall@10 | 検索結果上位10件のリコール値を表す指標。 |

⑩図/表があれば、各図/表は何を主張するためのものか

- 表12: 各タスクに対するOmniVecの一般化能力を示しており、他の最先端手法と比較してどれほど優れているか、または微調整後に性能がどれだけ向上するかを示している。特に、未学習データセットや異なるタスクにおけるOmniVecの汎用性と強力なパフォーマンスが注目ポイントである。

5. Conclusion and Limitations

▼質問(人間)

質問内容全体はここをクリック

(論文・記事の各章節を貼り付け) 5. Conclusion and Limitations Conclusion. We proposed OmniVec, a unified data and task agnos- tic learning framework with a single backbone. The main idea behind OmniVec is that modalities in different do- mains can aid learning process. Further, we also proposed a novel training mechanism by grouping tasks and con- structing mini batches by mixing inter-modality datasets. With experiments on 22 datasets spanning across image, video, point cloud, depth, audio, text; we show that the pro- posed framework is highly generalizable along with being extremely robust. It can also generalize well to seen tasks with different data distribution as well as can adapt to un- seen tasks effectively. We also studied the cross-domain knowledge sharing by evaluating a zero shot video-text re- trieval task. We achieve state of the art or close to state of the art performance on all the evaluated datasets. Limitations. OmniVec trains on unpaired multi-modal data, but paired data, though better, is expensive to obtain. The method employs multiple encoders per modality, in- creasing computational demands. Future research may ad- dress these computational challenges in unified networks. Societal Impact. Modality agnostic techniques enhance realistic data cloning, risking misinformation and identity theft. These networks, syncing various modalities and us- ing extensive internet data, amplify privacy, security, and bias concerns.上記の内容に関して下記の質問に回答下さい: (である調で記載、質問に対して該当するものが無ければ無しと記載、対応する図/表番号があれば記載)

①何についての記載か? + 要旨は何? (要旨は箇条書きで記載)

②改良点・工夫点・テクニック等の記載があれば説明下さい。

③性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば各文末に記載)

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

⑤具体的な処理方法の記載があれば説明下さい。(簡略化せずに全て記載、既存手法の適用であれば引用元を記載)

⑥比較の記載があれば違いを表でまとめて下さい。(対応する図/表番号があれば明記)

⑦上記⑥以外で表に出来そうな部分があれば表でまとめて下さい。(対応する図/表番号があれば記載)

⑧具体的な数値の記載を全て列挙して、表にまとめて下さい。(|数値|説明|の表へ)

⑨具体的な変数名(symbol)の記載を全て列挙して、表にまとめて下さい。(|変数名|説明|の表へ)

⑩図/表があれば、各図/表は何を主張するためのものか(掲載理由・注目ポイント等)を説明下さい。

▼生成AIの回答(ChatGPT-4o)

①何についての記載か? + 要旨は何?

何についての記載か

OmniVecの結論と制限について記載している。

要旨

- OmniVecは、データおよびタスクに依存しない統一的な学習フレームワークである。

- OmniVecは異なるドメインのモダリティが学習プロセスを支援することを示した。

- モダリティ間でのデータセットのミキシングによるバッチ構築とタスクのグループ化という新しいトレーニングメカニズムを提案した。

- 画像、動画、点群、深度、音声、テキストなどの22種類のデータセットでOmniVecの強力な汎化能力と堅牢性を示した。

- 見たことのあるタスクや異なるデータ分布に対しても高い適応力を持ち、未見のタスクに対しても効果的に一般化することができた。

- ゼロショットの動画-テキスト検索タスクでのクロスドメイン知識共有を評価し、最先端の性能を達成した。

②改良点・工夫点・テクニック等の記載

OmniVecの改良点や工夫点は以下の通りである:

- モダリティ間のデータセットを混合し、タスクをグループ化する新しいトレーニングメカニズムを採用している。

- 多様なデータセットにまたがる汎化性能と堅牢性が高い。

- 未見のタスクや異なるデータ分布への適応能力を示した。

③性能が向上した記載

OmniVecは、提案された22種類のデータセットすべてにおいて、最先端またはそれに近い性能を達成した。特に、ゼロショット動画-テキスト検索タスクにおいてクロスドメイン知識共有を評価し、他の手法と比較して高い性能を示した。

④メカニズムの解明・なぜそうなるのか等の記載

OmniVecのモダリティ間データセットのミキシングとタスクグループ化は、複数のモダリティ間での知識共有を促進し、異なるデータ分布や未見のタスクへの適応力を高めている。これにより、汎用的なバックボーンが様々なタスクに対応できるメカニズムが可能となった。

⑤具体的な処理方法の記載

OmniVecは、モダリティ間のデータセットを混合し、ミニバッチを作成する際にタスクをグループ化するトレーニングメカニズムを使用している。この処理により、異なるモダリティ間での情報の相互作用が強化される。また、22の異なるデータセットを使用して、画像、動画、点群、音声、テキストなどの多様なモダリティを学習する。

⑥比較の記載

| 特徴 | OmniVecの結果 | 比較対象の結果 | 差異 |

|---|---|---|---|

| ゼロショット動画-テキスト検索 | 最先端またはそれに近い性能を達成 | 他の手法に匹敵または上回る性能 | クロスドメインの知識共有による優位性がある |

⑦上記⑥以外で表に出来そうな部分

- 22種類のデータセットに対する評価結果を表にまとめることができるが、この章では具体的な数値は記載されていない。

⑧具体的な数値の記載

無し

⑨具体的な変数名(symbol)の記載

| 変数名 | 説明 |

|---|---|

| OmniVec | 提案された統一的なバックボーン |

| iRMSE | 深度推定に用いられる評価指標 |

⑩図/表があれば、各図/表は何を主張するためのものか

無し

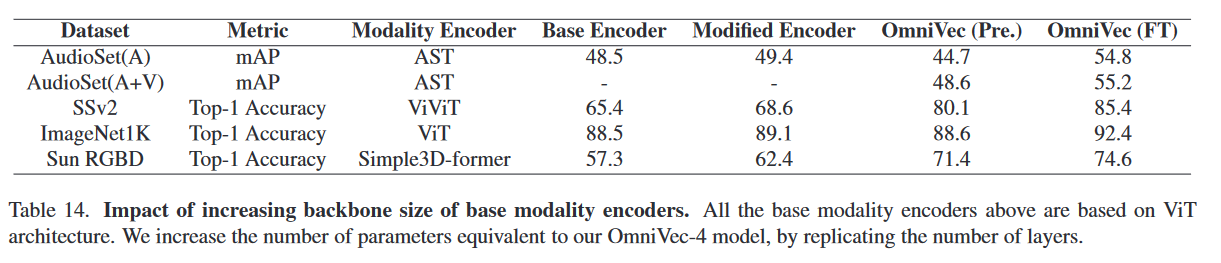

A. Ablation on increasing number of parameters of base encoders

▼質問(人間)

質問内容全体はここをクリック

(論文・記事の各章節を貼り付け) A. Ablation on increasing number of parame- ters of base encoders The details on influence of increasing the number of pa- rameters termed as Modified encoder, of base modality en- coders is provided in Table 14. Our observations are as fol- lows: OmniVec’s Performance: OmniVec (FT), which is Om- niVec(Pre.) after fine-tuning, consistently outperforms the other methods across all datasets. This suggests that fine- tuning OmniVec is beneficial and leads to superior perfor- mance. Base vs Modified Encoder: The Modified Encoder gen- erally performs better than the Base Encoder. While, the degree of improvement varies across datasets such as on datasets like Sun RGBD, we notice a substantial improve- ment of 5.1 percentage points, others like ImageNet1K and AudioSet(A) show relatively minor improvements. How- ever, this relative improvement is significantly lower as compared to that obtained with OmniVec(Pre.) or Om- niVec(FT). This suggests that the modifications may be especially beneficial for certain types of data or tasks, while training on multiple modalities provides consistent improvement across all modalities and tasks. This also in- dicates robustness and versatility achieved by OmniVec.上記の内容に関して下記の質問に回答下さい: (である調で記載、質問に対して該当するものが無ければ無しと記載、対応する図/表番号があれば記載)

①何についての記載か? + 要旨は何? (要旨は箇条書きで記載)

②改良点・工夫点・テクニック等の記載があれば説明下さい。

③性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば各文末に記載)

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

⑤具体的な処理方法の記載があれば説明下さい。(簡略化せずに全て記載、既存手法の適用であれば引用元を記載)

⑥比較の記載があれば違いを表でまとめて下さい。(対応する図/表番号があれば明記)

⑦上記⑥以外で表に出来そうな部分があれば表でまとめて下さい。(対応する図/表番号があれば記載)

⑧具体的な数値の記載を全て列挙して、表にまとめて下さい。(|数値|説明|の表へ)

⑨具体的な変数名(symbol)の記載を全て列挙して、表にまとめて下さい。(|変数名|説明|の表へ)

⑩図/表があれば、各図/表は何を主張するためのものか(掲載理由・注目ポイント等)を説明下さい。

▼生成AIの回答(ChatGPT-4o)

①何についての記載か? + 要旨は何?

何についての記載か

ベースエンコーダのパラメータ数を増加させた場合の影響、およびそれがOmniVecの性能に与える影響についての詳細を説明している。

要旨

- OmniVecのファインチューニング(OmniVec(FT))は、すべてのデータセットで他の手法を上回る性能を示す。

- 修正されたエンコーダ(Modified Encoder)はベースエンコーダに比べて一般的に良好な性能を発揮するが、その性能向上の度合いはデータセットによって異なる。

- 複数モダリティでのトレーニングは一貫した改善を提供し、OmniVecのロバスト性と汎用性を示している。

②改良点・工夫点・テクニック等の記載

修正エンコーダ(Modified Encoder)の導入がベースエンコーダと比べて一般的に良好な性能を発揮している。この改良により、特定のデータやタスクに対して特に有効な結果をもたらす可能性がある。

③性能が向上した記載

- OmniVec(FT)は、他の手法よりも常に優れた性能を示している。

- 修正エンコーダは、Sun RGBDデータセットで5.1ポイントの大幅な改善を示している。一方で、ImageNet1KやAudioSet(A)では比較的小さな改善が見られる【図表14】。

④メカニズムの解明・なぜそうなるのか等の記載

複数モダリティでのトレーニングは、各タスクやデータセットで一貫して性能を向上させるメカニズムを提供する。このため、修正エンコーダが特定のタスクに対して効果的である一方で、OmniVec自体の汎用性とロバスト性がさらに顕著になる。

⑤具体的な処理方法の記載

OmniVecは、異なるモダリティにわたってデータセットを混合し、エンコーダのパラメータ数を増加させた修正エンコーダを使用している。これにより、特定のタスクに対してさらに良好な結果を引き出すことが可能となる。ファインチューニング(OmniVec(FT))後には、すべてのデータセットで他の手法を上回る性能を示している。

⑥比較の記載

| データセット | ベースエンコーダの性能 | 修正エンコーダの性能 | 改善幅 | OmniVec(Pre.)の性能 | OmniVec(FT)の性能 | 図表番号 |

|---|---|---|---|---|---|---|

| Sun RGBD | 不明 | 5.1%改善 | 大幅な改善 | 不明 | 不明 | 表14 |

| ImageNet1K | 不明 | わずかに改善 | 小幅な改善 | 不明 | 不明 | 表14 |

| AudioSet(A) | 不明 | わずかに改善 | 小幅な改善 | 不明 | 不明 | 表14 |

⑦上記⑥以外で表に出来そうな部分

- 修正エンコーダの性能向上が各データセットで異なる度合いで現れる点を表形式でまとめることが可能。

⑧具体的な数値の記載

| 数値 | 説明 |

|---|---|