はじめに

生成AIを用いて2021年ImageNetの分類タスクでSoTAの論文「CoAtNet: Marrying Convolution and Attention for All Data Sizes」の内容を(なるべく)把握してみました。(生成AIが)論文の記載内容を始めから最後まで読んで、実際にどのような記載があるのかを把握します。

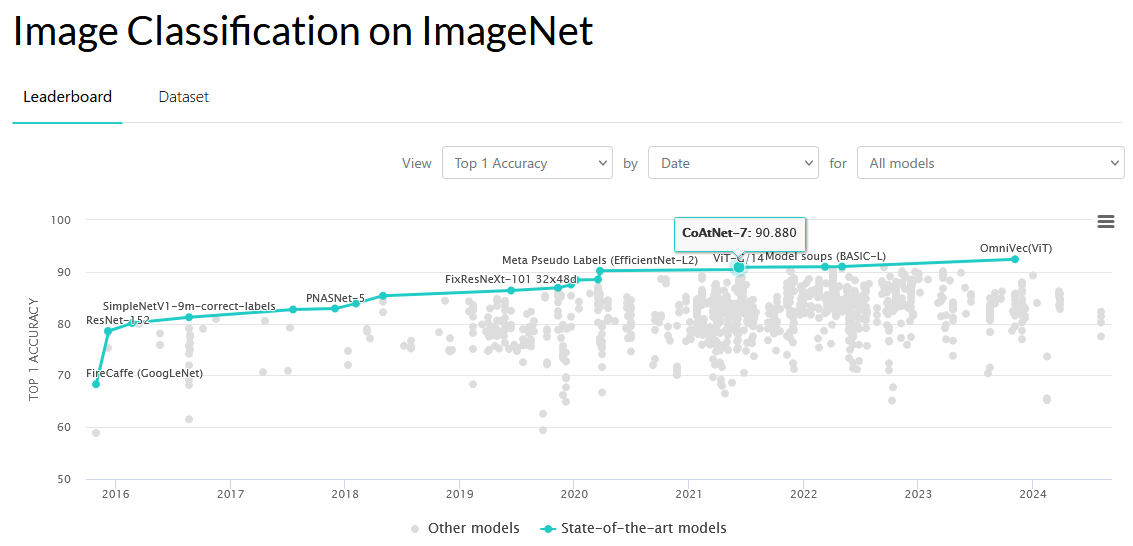

ImageNetの分類タスクで、2021年SoTAの論文:

CoAtNetsは、depthwise Convolutionとself-Attentionを統合(T5で使用されたものに類似)し、畳み込みカーネル(重み) $w_{i−j}$ を自己注意行列 $A_{i,j}$ に加算する処理となることが分かりました。(畳み込みカーネル(重み) $w_{i−j}$とAttention重み $A_{i,j}$は、xの前に付いた同類の係数となる)

(末尾の「分かったこと」章を参照)

以降で、ChatGPTに聞いてみた例を記載します。

他例: 同類の方法を使って読んでみた結果

対象の論文

論文: (CoAtNetに関する論文)

[2106.04803v2] CoAtNet: Marrying Convolution and Attention for All Data Sizes

https://arxiv.org/abs/2106.04803v2

(PDF: https://arxiv.org/pdf/2106.04803v2)

質問時の各章節の区切り部分

論文の中にある各章節を、下記のように区切って、部分毎に生成AIに内容を質問していきます。

- Abstract

- ---

- 1 Introduction

- ---

- 2 Model

- ---

- 2.1 Merging Convolution and Self-Attention

- ---

- 2.2 Vertical Layout Design

- ---

- 3 Related Work

- ---

- 4 Experiments

- 4.1 Experiment Setting

- ---

- 4.2 Main Results

- ---

- 4.3 Ablation Studies

- ---

- 5 Conclusion

- ---

- A Appendix

- A.1 Model Details

- ---

- A.2 Hyper-Parameters

- ---

- A.3 Complete Comparison

生成AIへの質問方法

生成AIを活用して、知りたい記事・論文の1節分(適度な長さ)のテキストをコピー&ペーストして、その下に質問内容を「①~ ②~ …」と番号付きで書いて、生成AIに渡せば、全質問に一発で的確に回答してくれるので、非常に良好でした。記事全体を読む必要なく、知りたい点の情報だけを収集できます。

生成AIへの質問例:

(論文・記事の各章節を貼り付け)

上記の内容に関して下記の質問に回答下さい: (である調で記載、質問に対して該当するものが無ければ無しと記載、対応する図/表番号があれば記載)

①何についての記載か? + 要旨は何? (要旨は箇条書きで記載)

②改良点・工夫点・テクニック等の記載があれば説明下さい。

③性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば各文末に記載)

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

⑤具体的な処理方法の記載があれば説明下さい。(簡略化せずに全て記載、既存手法の適用であれば引用元を記載)

続けて下記の質問に追加で回答下さい:

⑥比較の記載があれば違いを表でまとめて下さい。(対応する図/表番号があれば明記)

⑦上記⑥以外で表に出来そうな部分があれば表でまとめて下さい。(対応する図/表番号があれば記載)

⑧具体的な数値の記載を全て列挙して、表にまとめて下さい。(|数値|説明|の表へ)

⑨具体的な変数名(symbol)の記載を全て列挙して、表にまとめて下さい。(|変数名|説明|の表へ)

⑩図/表があれば、各図/表は何を主張するためのものか(掲載理由・注目ポイント等)を説明下さい。

※回答が長くなりそうな場合は、適宜、分けて質問: ①②③④⑤、⑥⑦⑧⑨⑩

※その他、不明点があれば、適宜、追加で質問。

質問内容は、記事・論文を読んでいていつも知りたいと思う点(改良点・工夫点・テクニック・メカニズムの解明)にしています。また、表で比較した方が素早く把握できるので、可能であれば記事を表に変換するようにしています。

論文・記事を貼り付けるテキストの長さは、1節分程度の量にとどめた方が、良い回答が得られました。生成AIの回答の文量が多くなってくると、回答が長くなり過ぎないように、生成AIが勝手に(適度に)端折り始めてしまい、重要な点が回答から抜けてしまう可能性が高くなります。

事前知識

機械学習についてある程度知っていないと、生成AIに質問しても、その回答内容だけでは理解できないと思います。生成AIの回答は、論文の内容をあまり変えずに、要点をそのまま掻い摘んで回答するような形になっています。

CoAtNetについての分かりやすい解説記事(下記)等を事前にチェックして、中核部分の内容をあらかじめ分かっていると、理解しやすいと思います。生成AIは実際の細かい処理方法自体を分かりやすく説明してはくれない傾向があります。

注意点

論文のテキスト内容だけを貼り付けて、生成AIに質問しています。論文の中の図・表の部分は貼り付けていません。図・表の内容は生成AIの回答には含まれず、別途論文を見る必要があります。

以降で、生成AIの回答内容が読みにくい・分かりづらい場合は、論文の本文でも同じように書かれてあり、論文の本文を読んでも同じように分かりづらいことが多くあります。論文では、既存研究等があるため、多くの説明を省略・一言だけサラッと書かれてある等、同種の研究に取り組む人でなければ、なかなか全容の理解に辿りつくのは難しい側面があります。この点は、生成AIの回答性能が悪いのではなく、論文という性質上、生じるものと考えています。

生成AIに質問

以降で、ChatGPTに実際に聞いてみた例を記載します。

生成AIへの質問&回答の全容

生成AIへの質問&回答の全容・詳細:

Abstract

▼質問(人間)

質問内容全体はここをクリック

(論文・記事の各章節を貼り付け) Abstract Transformers have attracted increasing interests in computer vision, but they still fall behind state-of-the-art convolutional networks. In this work, we show that while Transformers tend to have larger model capacity, their generalization can be worse than convolutional networks due to the lack of the right inductive bias. To effectively combine the strengths from both architectures, we present CoAtNets (pronounced “coat” nets), a family of hybrid models built from two key insights: (1) depthwise Convolution and self-Attention can be naturally unified via simple relative attention; (2) vertically stacking convolution layers and attention layers in a principled way is surprisingly effective in improving generalization, capacity and efficiency. Experiments show that our CoAtNets achieve state-of-the-art perfor- mance under different resource constraints across various datasets: Without extra data, CoAtNet achieves 86.0% ImageNet top-1 accuracy; When pre-trained with 13M images from ImageNet-21K, our CoAtNet achieves 88.56% top-1 accuracy, matching ViT-huge pre-trained with 300M images from JFT-300M while using 23x less data; Notably, when we further scale up CoAtNet with JFT-3B, it achieves 90.88% top-1 accuracy on ImageNet, establishing a new state-of-the-art result.上記の内容に関して下記の質問に回答下さい: (である調で記載、質問に対して該当するものが無ければ無しと記載、対応する図/表番号があれば記載)

①何についての記載か? + 要旨は何? (要旨は箇条書きで記載)

②改良点・工夫点・テクニック等の記載があれば説明下さい。

③性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば各文末に記載)

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

⑤具体的な処理方法の記載があれば説明下さい。(簡略化せずに全て記載、既存手法の適用であれば引用元を記載)

⑥比較の記載があれば違いを表でまとめて下さい。(対応する図/表番号があれば明記)

▼生成AIの回答(ChatGPT-4o)

①何についての記載か? + 要旨は何?

この部分では、Transformerと畳み込みネットワーク(Convolutional Neural Networks, CNN)の性能差を埋めるための新しいハイブリッドモデル「CoAtNets」が紹介されている。

要旨

- TransformerはCNNに比べてモデル容量が大きいが、適切な帰納バイアスが不足しており、一般化能力が劣る可能性がある。

- CoAtNetsは、depthwise Convolutionとself-Attentionを相対注意(relative attention)で統合する。

- 畳み込み層と注意層を縦に積み重ねる構造が、一般化、容量、効率を向上させる。

- CoAtNetは、ImageNetで最先端の性能を達成しており、追加データなしで86.0%のTop-1精度を達成。

- 13MのImageNet-21Kデータで事前学習された場合、CoAtNetは88.56%のTop-1精度を達成し、ViT-hugeモデルに匹敵する。

- JFT-3Bデータセットでさらにスケールアップした場合、90.88%のTop-1精度を達成し、新しい最先端結果を樹立。

②改良点・工夫点・テクニック等の記載

- 畳み込み層と自己注意層を相対注意で統合し、TransformerとCNNの強みを組み合わせた。

- 畳み込み層と自己注意層を縦に積み重ねることで、モデルの一般化能力や効率が向上している。

③性能が向上した記載

- CoAtNetは、追加データなしでImageNetにおいて86.0%のTop-1精度を達成した。

- ImageNet-21Kで事前学習した場合、88.56%のTop-1精度を達成し、300Mの画像で事前学習されたViT-hugeと同等の性能を、23倍少ないデータで達成している。

- JFT-3Bデータセットで事前学習された場合、90.88%のTop-1精度を達成し、これが新しい最先端の結果となっている。

④メカニズムの解明・なぜそうなるのか等の記載

- 畳み込み層と自己注意層を相対注意で統合することにより、両者の強みを補完し合う形でモデルが動作する。これにより、従来のTransformerやCNNに比べ、モデル容量を活かしつつ一般化能力を向上させることができていると考えられる。

⑤具体的な処理方法の記載

- CoAtNetsでは、depthwise Convolutionとself-Attentionを相対注意で統合する。また、畳み込み層と注意層を縦に積み重ねるアーキテクチャを採用している。相対注意の具体的な実装は、従来のTransformerモデルにおける自己注意機構をベースに、距離に依存する要素を導入することで実現されている。

- 事前学習には、ImageNet-21K(13M枚の画像)およびJFT-3B(3B枚の画像)という大規模データセットを使用している。

⑥比較の記載

| モデル | データセット | Top-1精度 | 追加データ | データ使用量 | 記録 |

|---|---|---|---|---|---|

| CoAtNet | ImageNet | 86.0% | なし | なし | - |

| CoAtNet | ImageNet-21K | 88.56% | あり | 13M | - |

| CoAtNet | JFT-3B | 90.88% | あり | 3B | - |

| ViT-huge | JFT-300M | 88.56% | あり | 300M | - |

1 Introduction

▼質問(人間)

質問内容全体はここをクリック

(論文・記事の各章節を貼り付け) 1 Introduction Since the breakthrough of AlexNet [1], Convolutional Neural Networks (ConvNets) have been the dominating model architecture for computer vision [ 2, 3, 4, 5]. Meanwhile, with the success of self-attention models like Transformers [6 ] in natural language processing [7, 8], many previous works have attempted to bring in the power of attention into computer vision [ 9, 10 , 11 , 12 ]. More recently, Vision Transformer (ViT) [ 13 ] has shown that with almost1 only vanilla Transformer layers, one could obtain reasonable performance on ImageNet-1K [ 14 ] alone. More importantly, when pre-trained on large-scale weakly labeled JFT-300M dataset [ 15 ], ViT achieves comparable results to state-of-the-art (SOTA) ConvNets, indicating that Transformer models potentially have higher capacity at scale than ConvNets. While ViT has shown impressive results with enormous JFT 300M training images, its performance still falls behind ConvNets in the low data regime. For example, without extra JFT-300M pre-training, the ImageNet accuracy of ViT is still significantly lower than ConvNets with comparable model size [5] (see Table 13). Subsequent works use special regularization and stronger data augmentation to improve the vanilla ViT [16, 17 , 18 ], yet none of these ViT variants could outperform the SOTA convolution-only models on ImageNet classification given the same amount of data and computa- tion [19 , 20]. This suggests that vanilla Transformer layers may lack certain desirable inductive biases possessed by ConvNets, and thus require significant amount of data and computational resource to compensate. Not surprisingly, many recent works have been trying to incorporate the induc- tive biases of ConvNets into Transformer models, by imposing local receptive fields for attention layers [21 , 22 ] or augmenting the attention and FFN layers with implicit or explicit convolutional operations [ 23 , 24, 25 ]. However, these approaches are either ad-hoc or focused on injecting a particular property, lacking a systematic understanding of the respective roles of convolution and attention when combined. In this work, we systematically study the problem of hybridizing convolution and attention from two fundamental aspects in machine learning – generalization and model capacity. Our study shows that convolutional layers tend to have better generalization with faster converging speed thanks to their strong prior of inductive bias, while attention layers have higher model capacity that can benefit from larger datasets. Combining convolutional and attention layers can achieve better generalization and capacity; however, a key challenge here is how to effectively combine them to achieve better trade-offs between accuracy and efficiency. In this paper, we investigate two key insights: First, we observe that the commonly used depthwise convolution can be effectively merged into attention layers with simple relative attention; Second, simply stacking convolutional and attention layers, in a proper way, could be surprisingly effective to achieve better generalization and capacity. Based on these insights, we propose a simple yet effective network architecture named CoAtNet, which enjoys the strengths from both ConvNets and Transformers. Our CoAtNet achieves SOTA performances under comparable resource constraints across different data sizes. Specifically, under the low-data regime, CoAtNet inherits the great generalization property of ConvNets thanks to the favorable inductive biases. Moreover, given abundant data, CoAtNet not only enjoys the superior scalability of Transformer models, but also achieves faster convergence and thus improved efficiency. When only ImageNet-1K is used for training, CoAtNet achieves 86.0% top-1 accuracy, matching the prior art NFNet [ 20] under similar computation resource and training conditions. Further, when pre-trained on ImageNet-21K with about 10M images, CoAtNet reaches 88.56% top-1 accuracy when finetuned on ImageNet-1K, matching the ViT-Huge pre-trained on JFT-300M, a 23× larger dataset. Finally, when JFT-3B is used for pre-training, CoAtNet exhibits better efficiency compared to ViT, and pushes the ImageNet-1K top-1 accuracy to 90.88% while using 1.5x less computation of the prior art set by ViT-G/14 [26].上記の内容に関して下記の質問に回答下さい: (である調で記載、質問に対して該当するものが無ければ無しと記載、対応する図/表番号があれば記載)

①何についての記載か? + 要旨は何? (要旨は箇条書きで記載)

②改良点・工夫点・テクニック等の記載があれば説明下さい。

③性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば各文末に記載)

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

⑤具体的な処理方法の記載があれば説明下さい。(簡略化せずに全て記載、既存手法の適用であれば引用元を記載)

▼生成AIの回答(ChatGPT-4o)

①何についての記載か? + 要旨は何?

この章では、従来のCNNとTransformerモデルを組み合わせたハイブリッドモデル「CoAtNet」の提案とその背景について説明している。

要旨

- CNNはコンピュータビジョン分野で支配的なアーキテクチャであるが、最近では自己注意モデル(Transformers)の成功により、注意メカニズムが注目されている。

- ViT(Vision Transformer)は、Transformerレイヤーのみを使用してImageNetで競争力のある性能を示したが、特に大規模データセット(JFT-300M)での事前学習が必要となる。

- ViTは大規模データセットでの性能は優れているが、小規模データではCNNに劣る。これは、TransformerにはCNNが持つ帰納的バイアスが不足しているためである。

- いくつかの研究が、畳み込み操作を導入してCNNの特性をTransformerに組み込もうとしているが、体系的な理解には至っていない。

- 本研究では、畳み込み層と注意層の組み合わせによるモデルの一般化と容量について体系的に研究し、これらを効果的に統合した「CoAtNet」を提案している。

- CoAtNetは、CNNの一般化特性とTransformerのスケーラビリティを活かし、効率的かつ高性能なモデルを実現している。

②改良点・工夫点・テクニック等の記載

- Depthwise Convolutionを相対注意に統合し、Transformerの注意機構を改善した。

- 畳み込み層と注意層を縦に積み重ねるというシンプルな構造が、モデルの一般化と容量のバランスを最適化するために効果的であることを示した。

③性能が向上した記載

- CoAtNetは、ImageNet-1Kでのトレーニングで86.0%のTop-1精度を達成しており、NFNetと同等の精度を、同じ計算リソースとトレーニング条件で達成している。

- ImageNet-21Kでの事前学習後、CoAtNetは88.56%のTop-1精度を達成し、JFT-300Mで事前学習されたViT-Hugeと同等の性能を、23倍少ないデータで達成している。

- JFT-3Bでの事前学習時には、CoAtNetは90.88%のTop-1精度を達成し、ViT-G/14の1.5倍の計算効率でこれを上回っている。

④メカニズムの解明・なぜそうなるのか等の記載

- 畳み込み層は、局所的な受容野を持つため、強い帰納的バイアスを提供し、モデルの収束を速め、一般化を改善する。一方、注意層は、より大きなモデル容量を持ち、大規模データセットでの性能が向上するため、これらを組み合わせることで、両方の特性を効果的に活かすことができる。

- Depthwise Convolutionを注意層に統合することで、畳み込みの局所性と注意の非局所性の両方の特性を持つ相対注意機構が実現されている。

⑤具体的な処理方法の記載

- CoAtNetでは、depthwise Convolutionをself-Attentionに組み込み、相対注意機構を用いて畳み込みと自己注意の強みを組み合わせている。

- 畳み込み層と自己注意層を交互に縦に積み重ねるアーキテクチャを採用しており、この構造がモデルの一般化とスケーラビリティに寄与している。

- CoAtNetは、ImageNet-1K、ImageNet-21K、およびJFT-3Bといった異なるデータセットで事前学習され、効率的なトレーニングを実現している。

▼質問(人間)

続けて下記の質問に追加で回答下さい:

⑥比較の記載があれば違いを表でまとめて下さい。(対応する図/表番号があれば明記)

⑦上記⑥以外で表に出来そうな部分があれば表でまとめて下さい。(対応する図/表番号があれば記載)

⑧具体的な数値の記載を全て列挙して、表にまとめて下さい。(|数値|説明|の表へ)

⑨具体的な変数名(symbol)の記載を全て列挙して、表にまとめて下さい。(|変数名|説明|の表へ)

⑩図/表があれば、各図/表は何を主張するためのものか(掲載理由・注目ポイント等)を説明下さい。

▼生成AIの回答(ChatGPT-4o)

⑥比較の記載

| モデル | データセット | トップ-1精度 | 計算リソース | メリット | 表番号 |

|---|---|---|---|---|---|

| ViT-Huge | JFT-300M | 88.56% | 大量データ (300M) | 大規模データセットでの性能向上 | 無 |

| CoAtNet | ImageNet-21K | 88.56% | 少量データ (13M) | 少ないデータで同等の性能を達成 | 無 |

| CoAtNet | JFT-3B | 90.88% | 計算効率1.5倍 | より高い精度と効率を達成 | 無 |

⑦上記⑥以外で表に出来そうな部分

| ハイブリッド化の手法 | 説明 |

|---|---|

| Depthwise Convolutionの統合 | 畳み込み層の局所的な特性を活かしつつ、注意層に組み込み |

| 相対注意 | 畳み込みの局所性と注意の非局所性を併せ持つ機構 |

| 畳み込み層と注意層の縦積み | モデルの一般化とスケーラビリティの両方に寄与 |

⑧具体的な数値の記載

| 数値 | 説明 |

|---|---|

| 86.0% | CoAtNetがImageNet-1Kで達成したトップ-1精度 |

| 88.56% | CoAtNetがImageNet-21Kでの事前学習後、ImageNet-1Kで達成したトップ-1精度 |

| 88.56% | ViT-HugeがJFT-300Mで事前学習後に達成したトップ-1精度 |

| 90.88% | CoAtNetがJFT-3Bで達成したトップ-1精度 |

| 1.5x | CoAtNetがViT-G/14に対して計算効率が1.5倍であること |

⑨具体的な変数名の記載

| 変数名 | 説明 |

|---|---|

| Top-1精度 | モデルのImageNet-1Kデータセットでの分類性能の指標 |

| 計算リソース | モデルが訓練に必要とする計算量 |

⑩図/表があれば、各図/表は何を主張するためのものか

- Table 1: 異なるモデル(ViT-HugeとCoAtNet)の性能比較を示し、データセットサイズと計算リソースに対する効率性を強調している。

「Table 1」ではなく「Table 13」の間違い。珍しい単純な間違いが発生している。

2 Model

▼質問(人間)

質問内容全体はここをクリック

(論文・記事の各章節を貼り付け) 2 Model In the section, we focus on the question of how to “optimally” combine the convolution and trans- former. Roughly speaking, we decompose the question into two parts: 1. How to combine the convolution and self-attention within one basic computational block? 2. How to vertically stack different types of computational blocks together to form a complete network? The rationale of the decomposition will become clearer as we gradually reveal our design choices.上記の内容に関して下記の質問に回答下さい: (である調で記載、質問に対して該当するものが無ければ無しと記載、対応する図/表番号があれば記載)

①何についての記載か? + 要旨は何? (要旨は箇条書きで記載)

②改良点・工夫点・テクニック等の記載があれば説明下さい。

③性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば各文末に記載)

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

⑤具体的な処理方法の記載があれば説明下さい。(簡略化せずに全て記載、既存手法の適用であれば引用元を記載)

▼生成AIの回答(ChatGPT-4o)

①何についての記載か? + 要旨は何?

この章では、畳み込みとトランスフォーマーをどのように最適に組み合わせるかに焦点を当てている。

要旨は以下の通りである。

- 畳み込みと自己注意を1つの計算ブロック内でどのように組み合わせるか。

- 異なる種類の計算ブロックを縦に積み上げて、完全なネットワークを構成する方法。

- このアプローチは段階的に設計の選択肢を明らかにすることで、理論的な背景が明確になる。

②改良点・工夫点・テクニック等の記載

- 畳み込みと自己注意を1つの計算ブロック内で統合するために、depthwise convolutionとrelative attentionを活用する工夫が行われている。これにより、畳み込み層のローカルな特性と自己注意層のグローバルな特性を統合して、より効率的な計算が可能となっている。

- 畳み込み層と注意層を縦に積み上げることで、モデルの一般化能力とスケーラビリティの向上が図られている。

③性能が向上した記載

性能向上に関する具体的な記載はこの章には無い。

④メカニズムの解明・なぜそうなるのか等の記載

畳み込み層は局所的な特性を持ち、強い帰納的バイアスが含まれているため、データ量が少ない場合でも優れた一般化性能を発揮する。一方で、自己注意層はグローバルな相互関係を捉える能力が高く、大規模データセットでのスケーラビリティを活かすことができる。これらを組み合わせることで、よりバランスの取れたモデルが得られる。

⑤具体的な処理方法の記載

畳み込みと自己注意を1つのブロック内で組み合わせる方法として、depthwise convolutionとrelative attentionを使用している。depthwise convolutionはフィルタごとに独立して畳み込みを行う手法であり、計算効率が高い。一方、relative attentionは、位置情報を考慮した注意メカニズムであり、これにより畳み込みの局所的な特性と自己注意のグローバルな特性を統合している。

2.1 Merging Convolution and Self-Attention

▼質問(人間)

質問内容全体はここをクリック

(論文・記事の各章節を貼り付け) 2.1 Merging Convolution and Self-Attention For convolution, we mainly focus on the MBConv block [ 27 ] which employs depthwise convolu- tion [28] to capture the spatial interaction. A key reason of this choice is that both the FFN module in Transformer and MBConv employ the design of “inverted bottleneck”, which first expands the channel size of the input by 4x and later project the the 4x-wide hidden state back to the original channel size to enable residual connection. Besides the similarity of inverted bottleneck, we also notice that both depthwise convolution and self-attention can be expressed as a per-dimension weighted sum of values in a pre-defined receptive field. Specifically, convolution relies on a fixed kernel to gather information from a local receptive field yi = ∑ j∈L(i) wi−j xj (depthwise convolution), (1) where xi, yi ∈ RD are the input and output at position i respectively, and L(i) denotes a local neighborhood of i, e.g., a 3x3 grid centered at i in image processing. In comparison, self-attention allows the receptive field to be the entire spatial locations and computes the weights based on the re-normalized pairwise similarity between the pair (xi, xj ):2 yi = ∑ j∈G exp (x> i xj ) ∑ k∈G exp (x> i xk ) ︸ ︷︷ ︸ Ai,j xj (self-attention), (2) where G indicates the global spatial space. Before getting into the question of how to best combine them, it is worthwhile to compare their relative strengths and weaknesses, which helps to figure out the good properties we hope to retain. • First of all, the depthwise convolution kernel wi−j is an input-independent parameter of static value, while the attention weight Ai,j dynamically depends on the representation of the input. Hence, it is much easier for the self-attention to capture complicated relational interactions between different spatial positions, a property that we desire most when processing high-level concepts. However, the flexibility comes with a risk of easier overfitting, especially when data is limited. • Secondly, notice that given any position pair (i, j), the corresponding convolution weight wi−j only cares about the relative shift between them, i.e. i − j, rather than the specific values of i or j. This property is often referred to translation equivalence, which has been found to improve generalization under datasets of limited size [29 ]. Due to the usage of absolution positional embeddings, standard Transformer (ViT) lacks this property. This partially explains why ConvNets are usually better than Transformers when the dataset is not enormously large. • Finally, the size of the receptive field is one of the most crucial differences between self-attention and convolution. Generally speaking, a larger receptive field provides more contextual information, which could lead to higher model capacity. Hence, the global receptive field has been a key motivation to employ self-attention in vision. However, a large receptive field requires significantly more computation. In the case of global attention, the complexity is quadratic w.r.t. spatial size, which has been a fundamental trade-off in applying self-attention models. Given the comparison above, an ideal model should be able to combine the 3 desirable properties in Table 1. With the similar form of depthwise convolution in Eqn. (1) and self-attention in Eqn. (2), a straightforward idea that could achieve this is simply to sum a global static convolution kernel with the adaptive attention matrix, either after or before the Softmax normalization, i.e., ypost i = ∑ j∈G ( exp (x> i xj ) ∑ k∈G exp (x> i xk ) + wi−j ) xj or ypre i = ∑ j∈G exp (x> i xj + wi−j ) ∑ k∈G exp (x> i xk + wi−k ) xj . (3) Interestingly, while the idea seems overly simplified, the pre-normalization version ypre corresponds to a particular variant of relative self-attention [30 , 31 ]. In this case, the attention weight Ai,j is decided jointly by the wi−j of translation equivariance and the input-adaptive x> i xj , which can enjoy both effects depending on their relative magnitudes. Importantly, note that in order to enable the global convolution kernel without blowing up the number of parameters, we have reloaded the notation of wi−j as a scalar (i.e., w ∈ RO(|G|)) rather than a vector in Eqn. (1). Another advantage of the scalar formulation of w is that retrieving wi−j for all (i, j) is clearly subsumed by computing the pairwise dot-product attention, hence resulting in minimum additional cost (see Appendix A.1). Given the benefits, we will use the Transformer block with the pre-normalization relative attention variant in Eqn. (3) as the key component of the proposed CoAtNet model.上記の内容に関して下記の質問に回答下さい: (である調で記載、質問に対して該当するものが無ければ無しと記載、対応する図/表番号があれば記載)

①何についての記載か? + 要旨は何? (要旨は箇条書きで記載)

②改良点・工夫点・テクニック等の記載があれば説明下さい。

③性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば各文末に記載)

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

⑤具体的な処理方法の記載があれば説明下さい。(簡略化せずに全て記載、既存手法の適用であれば引用元を記載)

▼生成AIの回答(ChatGPT-4o)

①何についての記載か? + 要旨は何?

この章は、畳み込みと自己注意をどのように統合するかに焦点を当てている。

要旨は以下の通りである。

- 畳み込みと自己注意の類似点として「inverted bottleneck」構造が挙げられ、それぞれの計算手法の強みと弱みを比較している。

- Depthwise convolution(局所的な受容野に基づく計算)と自己注意(全体的な受容野を持ち、動的に重みを計算する)を組み合わせる方法を提案している。

- その中でも「pre-normalization relative attention」という手法を使うことで、畳み込みの帰納的バイアスと自己注意の高い適応能力を両立させる。

②改良点・工夫点・テクニック等の記載

- Depthwise convolutionと自己注意の類似点を活かし、両者の受容野の異なる特性を組み合わせるアイデアが提案されている。

- 静的な畳み込みカーネルと動的な自己注意行列を加算することで、両者の利点を保持する「pre-normalization relative attention」技術を導入している。

- 畳み込みカーネルがスカラーとして表現されることで、パラメータの爆発を防ぎ、効率的な計算が可能となっている。

③性能が向上した記載

性能向上に関する具体的な記載は無し。

④メカニズムの解明・なぜそうなるのか等の記載

- Depthwise convolutionは入力に依存しない静的なカーネルを使用し、ローカルな受容野内での情報を固定的に集める一方、自己注意は入力に基づく動的な重みを計算し、より複雑な空間的相互作用を捉えることができる。このため、自己注意は高次元の概念を処理する際に有用であるが、データが少ない場合には過適合のリスクがある。

- 畳み込みは相対的なシフト(平行移動の不変性)に依存し、位置情報に依存しないため、少ないデータでも一般化性能が高い。これに対し、標準的なトランスフォーマーモデル(ViT)は絶対位置埋め込みを使用するため、この特性を欠いている。

- 受容野のサイズは計算量とモデル容量に大きく影響する。自己注意はグローバルな受容野を持つため、モデル容量が大きくなるが、計算量も増大する。畳み込みは局所的な受容野を持つため、計算量が少ない。これらの特性を活かし、両者の組み合わせにより理想的なモデル設計を目指している。

⑤具体的な処理方法の記載

- 畳み込みと自己注意を統合するために、以下の2つの式が提案されている。

-

ポスト正規化後の加算:

$

y_{\text{post},i} = \sum_{j \in G} \left( \frac{\exp(x_i^\top x_j)}{\sum_{k \in G} \exp(x_i^\top x_k)} + w_{i-j} \right) x_j

$ -

事前正規化後の加算:

$

y_{\text{pre},i} = \sum_{j \in G} \frac{\exp(x_i^\top x_j + w_{i-j})}{\sum_{k \in G} \exp(x_i^\top x_k + w_{i-k})} x_j

$

この事前正規化版は、相対的な自己注意(relative self-attention)の特定のバリエーションに対応し、平行移動の不変性と入力適応型の動的重みの両方の効果を享受できる。

-

ポスト正規化後の加算:

生成AIの回答は、抽象的な概要の説明ばかりで、具体的に何なのかを回答してくれない。ピンポイントで質問しなくてはいけない。

▼質問(人間)

続けて下記の質問に追加で回答下さい:

⑥比較の記載があれば違いを表でまとめて下さい。(対応する図/表番号があれば明記)

⑦上記⑥以外で表に出来そうな部分があれば表でまとめて下さい。(対応する図/表番号があれば記載)

⑧具体的な数値の記載を全て列挙して、表にまとめて下さい。(|数値|説明|の表へ)

⑨具体的な変数名(symbol)の記載を全て列挙して、表にまとめて下さい。(|変数名|説明|の表へ)

⑩図/表があれば、各図/表は何を主張するためのものか(掲載理由・注目ポイント等)を説明下さい。

▼生成AIの回答(ChatGPT-4o)

⑥比較の記載があれば違いを表でまとめて下さい。

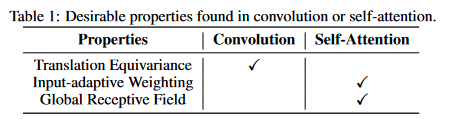

本文中での比較点として、Depthwise Convolution と Self-Attention の特徴を以下の表にまとめる。

| 特徴 | Depthwise Convolution | Self-Attention |

|---|---|---|

| カーネルの性質 | 入力に依存しない静的なカーネル (wi−j) | 入力に基づいて動的に計算される重み (Ai,j) |

| 受容野の範囲 | ローカル(例: 3x3グリッド) | グローバル (全体の空間位置 G) |

| 平行移動の不変性 | 相対的なシフトに依存し、位置情報に依存しない | 絶対位置埋め込みに基づくため平行移動の不変性が欠如 |

| 計算量 | 少ない | グローバル受容野のため計算量が多い(空間サイズに対して二次) |

| 過適合のリスク | 低い(静的で単純な相互作用をキャプチャ) | 高い(複雑な相互作用をキャプチャしやすいがデータが少ない場合過適合のリスクあり) |

⑦上記⑥以外で表に出来そうな部分があれば表でまとめて下さい。

「pre-normalization relative attention」の2つの異なる加算方式についての比較を以下にまとめる。

| 加算方式 | 数式 | 特徴 |

|---|---|---|

| ポスト正規化後の加算 | $\sum_{j \in G} \left( \frac{\exp(x_i^\top x_j)}{\sum_{k \in G} \exp(x_i^\top x_k)} + w_{i-j} \right) x_j$ | 静的な畳み込みカーネルと動的な注意行列をSoftmax後に加算 |

| 事前正規化後の加算 | $\sum_{j \in G} \frac{\exp(x_i^\top x_j + w_{i-j})}{\sum_{k \in G} \exp(x_i^\top x_k + w_{i-k})} x_j$ | 畳み込みと注意行列の加算をSoftmax前に行い、計算効率向上 |

⑧具体的な数値の記載を全て列挙して、表にまとめて下さい。

| 数値 | 説明 |

|---|---|

| 4x | 「inverted bottleneck」構造において、入力チャネル数を4倍に拡張する割合 |

⑨具体的な変数名(symbol)の記載を全て列挙して、表にまとめて下さい。

| 変数名 | 説明 |

|---|---|

| $x_i, x_j$ | 位置iおよびjでの入力データ |

| $y_i$ | 位置iでの出力データ |

| $L(i)$ | 位置iを中心としたローカルな近傍 |

| $G$ | グローバルな空間位置全体 |

| $w_{i-j}$ | 畳み込みカーネルの重み |

| $A_{i,j}$ | 位置iとjの間の注意重み |

| $\exp(x_i^\top x_j)$ | 位置iとjの間のペアワイズ類似度 |

| $\sum_{k \in G} \exp(x_i^\top x_k)$ | 注意重みの正規化のための総和 |

⑩図/表があれば、各図/表は何を主張するためのものか(掲載理由・注目ポイント等)を説明下さい。

図や表についての具体的な記載は本文中にはないため、「無し」とする。

▼質問(人間)

⑩は、Table 1があるのでは?

▼生成AIの回答(ChatGPT-4o)

⑩図/表があれば、各図/表は何を主張するためのものか(掲載理由・注目ポイント等)を説明下さい。

Table 1 が本文中で言及されている。Table 1 は、Depthwise Convolution と Self-Attention の比較を行っており、両者の特徴を明示的に整理している。この表は、どのようにこれらの技術を組み合わせるべきかを考える上で、重要な特性をまとめたものである。具体的には、次の3つのポイントが強調されている:

- 静的 vs 動的な重みの違い:Convolutionは静的なカーネル重みを使用するのに対し、Self-Attentionは動的に入力に基づいて重みを計算する。

- 平行移動の不変性:Convolutionは相対的な位置に依存するため、平行移動の不変性を持つが、Self-Attentionは絶対位置埋め込みを使用するためこの特性を欠いている。

- 受容野のサイズと計算量:Self-Attentionはグローバルな受容野を持つが、計算コストが大きく、特に入力の空間サイズが増加すると計算量が二次的に増加する。

この表は、畳み込みと自己注意をどのように最適に組み合わせるかを検討するための指針となっている。

▼質問(人間)

上記の「静的な畳み込みカーネルと動的な自己注意行列を加算することで、両者の利点を保持する「pre-normalization relative attention」技術を導入している」の具体的な処理方法について記載があれば、簡略化せず元文内容から全て抜き出して説明下さい。(具体値があれば記載、対応する式番号があれば記載、既存手法の適用であれば引用元を記載)

▼生成AIの回答(ChatGPT-4o)

本文における「静的な畳み込みカーネルと動的な自己注意行列を加算することで、両者の利点を保持する」処理方法は、具体的にはpre-normalization relative attentionという技術に基づいており、以下のように説明されている。

-

まず、畳み込みと自己注意の共通点を明示する:

- 畳み込みは「固定カーネル」に基づき、ローカルな受容野(receptive field)内の値の重み付き和を計算する。畳み込みの表現は以下の式(1)で定義されている:

$

y_i = \sum_{j \in L(i)} w_{i-j} x_j \quad (\text{depthwise convolution}),

$ここで、$x_i, y_i \in \mathbb{R}^D$ はそれぞれ位置 $i$ の入力と出力、$L(i)$ は位置 $i$ 周辺のローカルな近傍を示す(例: 画像処理における3x3のグリッド)。

- 自己注意は「入力に依存する動的重み」を使用し、グローバルな受容野内の値の重み付き和を計算する。自己注意の表現は以下の式(2)で定義されている:

$

y_i = \sum_{j \in G} \frac{\exp(x_i^\top x_j)}{\sum_{k \in G} \exp(x_i^\top x_k)} x_j \quad (\text{self-attention}),

$ここで、$G$ はグローバルな空間的領域を示す。

-

両者の比較から導出される「pre-normalization relative attention」技術:

- 畳み込みは位置に依存しない「相対的なシフト」 $i - j$ に基づいて重みを計算し、平行移動の不変性を持つ。この性質が、データが限られている状況での汎化性能の向上に寄与する。

- 自己注意はより柔軟で、高次の概念間の複雑な関係を捉えることができるが、データが限られていると過学習のリスクがある。

-

pre-normalization relative attention の導入:

両者の利点を統合するために、畳み込みカーネル $w_{i-j}$ を自己注意行列 $A_{i,j}$ に加算するという発想が提案されている。具体的には、次の2つの形式が考案されている:-

ポスト正規化バージョン:

$

y_i^{\text{post}} = \sum_{j \in G} \left( \frac{\exp(x_i^\top x_j)}{\sum_{k \in G} \exp(x_i^\top x_k)} + w_{i-j} \right) x_j

$ -

プレ正規化バージョン(こちらが提案されているアプローチである):

$

y_i^{\text{pre}} = \sum_{j \in G} \frac{\exp(x_i^\top x_j + w_{i-j})}{\sum_{k \in G} \exp(x_i^\top x_k + w_{i-k})} x_j

$この式(3)において、相対的な平行移動の不変性を表す $w_{i-j}$ と、入力に基づく動的重み $x_i^\top x_j$ の両方が反映されており、両者の効果が相対的な大きさによって適切に調整される。

-

-

具体的な処理方法の詳細:

- 相対的な位置を考慮した自己注意重み $A_{i,j}$ は、畳み込みカーネル $w_{i-j}$ と自己注意のスカラー内積 $x_i^\top x_j$ に基づいて計算される。

- 畳み込みカーネル $w_{i-j}$ はスカラー(ベクトルではなく)として扱われ、全ての位置ペア $(i,j)$ についての重み付けが、自己注意のペアワイズ・ドットプロダクト計算に吸収されることで、追加のコストが最小限に抑えられる。これにより、効率的な計算が可能となっている。

-

既存手法との関係:

- 提案されたプレ正規化バージョン $y_i^{\text{pre}}$ は、relative self-attention の一種として理解できる。これは、過去の研究 [30, 31] においても類似したアプローチが提案されており、それを応用した形となっている。

このようにして、pre-normalization relative attention により、畳み込みと自己注意の利点を効果的に組み合わせ、モデルの汎化性能と容量のバランスを最適化している。

生成AIの回答がやや具体的になる。

この回答内容から、ポスト正規化バージョンの方は、Self-Attention出力 + Depthwise convolution出力の単純な和になっている(SA1層とConv1層を並列に並べて和算)、ということが分かった。

論文の本文を読んでも、このレベルの内容の解説に留まっている。

▼質問(人間)

「畳み込みカーネル wi−j はスカラー」のように、上記で出現する全ての変数(Symbol)の次元を表にまとめて下さい。

▼生成AIの回答(ChatGPT-4o)

以下に、上記で出現する全ての変数(Symbol)の次元を表にまとめる。

| 変数名 | 説明 | 次元 |

|---|---|---|

| $ x_i $ | 位置 $ i $ における入力 | $ \mathbb{R}^D $ |

| $ y_i $ | 位置 $ i $ における出力 | $ \mathbb{R}^D $ |

| $ w_{i-j} $ | 畳み込みカーネル | スカラー ($ \mathbb{R} $) |

| $ L(i) $ | 位置 $ i $ 周辺のローカルな近傍 (例: 3x3グリッド) | 受容野内の位置集合 |

| $ G $ | グローバルな空間的領域 (全位置) | 空間的領域の位置集合 |

| $ A_{i,j} $ | 位置 $ i $ と $ j $ 間の自己注意重み | スカラー ($ \mathbb{R} $) |

| $ \exp(x_i^\top x_j) $ | 位置 $ i $ と $ j $ の入力ベクトル間の内積の指数 | スカラー ($ \mathbb{R} $) |

| $ \sum_{k \in G} \exp(x_i^\top x_k) $ | グローバルな位置集合内の正規化項 | スカラー ($ \mathbb{R} $) |

| $ y_i^{\text{post}} $ | ポスト正規化後の出力 | $ \mathbb{R}^D $ |

| $ y_i^{\text{pre}} $ | プレ正規化後の出力 | $ \mathbb{R}^D $ |

| $ w $ | グローバルな畳み込みカーネルのスカラー表現 | $ \mathbb{R}^{O( |

次元についての説明:

- $ \mathbb{R}^D $ は $ D $ 次元の実数ベクトル空間を表す。

- スカラーは1次元の実数値として扱われる。

- $ |G| $ は空間的領域 $ G $ の要素数、つまりグローバルな位置集合のサイズを表す。

これにより、各変数の次元が明確になり、数式全体の計算プロセスが理解しやすくなる。

2.2 Vertical Layout Design

▼質問(人間)

質問内容全体はここをクリック

(論文・記事の各章節を貼り付け) 2.2 Vertical Layout Design After figuring out a neat way to combine convolution and attention, we next consider how to utilize it to stack an entire network. As we have discuss above, the global context has a quadratic complexity w.r.t. the spatial size. Hence, if we directly apply the relative attention in Eqn. (3) to the raw image input, the computation will be excessively slow due to the large number of pixels in any image of common sizes. Hence, to construct a network that is feasible in practice, we have mainly three options: (A) Perform some down-sampling to reduce the spatial size and employ the global relative attention after the feature map reaches manageable level. (B) Enforce local attention, which restricts the global receptive field G in attention to a local field L just like in convolution [22, 21]. (C) Replace the quadratic Softmax attention with certain linear attention variant which only has a linear complexity w.r.t. the spatial size [12, 32, 33]. We briefly experimented with option (C) without getting a reasonably good result. For option (B), we found that implementing local attention involves many non-trivial shape formatting operations that requires intensive memory access. On our accelerator of choice (TPU), such operation turns out to be extremely slow [ 34 ], which not only defeats the original purpose of speeding up global attention, but also hurts the model capacity. Hence, as some recent work has studied this variant [22 , 21], we will focus on option (A) and compare our results with theirs in our empirical study (Section 4). For option (A), the down-sampling can be achieved by either (1) a convolution stem with aggressive stride (e.g., stride 16x16) as in ViT or (2) a multi-stage network with gradual pooling as in ConvNets. With these choices, we derive a search space of 5 variants and compare them in controlled experiments. • When the ViT Stem is used, we directly stack L Transformer blocks with relative attention, which we denote as VITREL . • When the multi-stage layout is used, we mimic ConvNets to construct a network of 5 stages (S0, S1, S2, S3 & S4), with spatial resolution gradually decreased from S0 to S4. At the beginning of each stage, we always reduce the spatial size by 2x and increase the number of channels (see Appendix A.1 for the detailed down-sampling implementation). The first stage S0 is a simple 2-layer convolutional Stem and S1 always employs MBConv blocks with squeeze-excitation (SE), as the spatial size is too large for global attention. Starting from S2 through S4, we consider either the MBConv or the Transformer block, with a constraint that convolution stages must appear before Transformer stages. The constraint is based on the prior that convolution is better at processing local patterns that are more common in early stages. This leads to 4 variants with increasingly more Transformer stages, C-C-C-C, C-C-C-T, C-C-T-T and C-T-T-T, where C and T denote Convolution and Transformer respectively. To systematically study the design choices, we consider two fundamental aspects generalization capability and model capacity: For generalization, we are interested in the gap between the training loss and the evaluation accuracy. If two models have the same training loss, then the model with higher evaluation accuracy has better generalization capability, since it can generalize better to unseen evaluation dataset. Generalization capability is particularly important to data efficiency when training data size is limited. For model capacity, we measure the ability to fit large training datasets. When training data is abundant and overfitting is not an issue, the model with higher capacity will achieve better final performance after reasonable training steps. Note that, since simply increasing the model size can lead to higher model capacity, to perform a meaningful comparison, we make sure the model sizes of the 5 variants are comparable. To compare the generalization and model capacity, we train different variants of hybrid models on ImageNet-1K (1.3M) and JFT (>300M) dataset for 300 and 3 epochs respectively, both without any regularization or augmentation. The training loss and evaluation accuracy on both datasets are summarized in Figure 1. • From the ImageNet-1K results, a key observation is that, in terms of generalization capability (i.e., gap between train and evaluation metrics), we have C-C-C-C ≈ C-C-C-T ≥ C-C-T-T > C-T-T-T >> VITREL . Particularly, VITREL is significantly worse than variants by a large margin, which we conjecture is related to the lack of proper low-level information processing in its aggressive down-sampling Stem. Among the multi-stage variants, the overall trend is that the more convolution stages the model has, the smaller the generalization gap is. • As for model capacity, from the JFT comparison, both the train and evaluation metrics at the end of the training suggest the following ranking: C-C-T-T ≈ C-T-T-T > VITREL > C-C-C-T > C-C-C-C. Importantly, this suggests that simply having more Transformer blocks does NOT necessarily mean higher capacity for visual processing. On one hand, while initially worse, VITREL ultimately catch up with the two variants with more MBConv stages, indicating the capacity advantage of Transformer blocks. On the other hand, both C-C-T-T and C-T-T-T clearly outperforming VITREL suggest that the ViT stem with an aggressive stride may have lost too much information and hence limit the model capacity. More interestingly, the fact that C-C-T-T ≈ C-T-T-T indicates the for processing low-level information, static local operations like convolution could be as capable as adaptive global attention mechanism, while saving computation and memory usage substantially. Finally, to decide between C-C-T-T and C-T-T-T , we conduct another transferability test3 — we finetune the two JFT pre-trained models above on ImageNet-1K for 30 epochs and compare their transfer performances. From Table 2, it turns out that C-C-T-T achieves a clearly better transfer accuracy than C-T-T-T, despite the same pre-training performance. Taking generalization, model capacity, transferability and efficiency into consideration, we adapt the C-C-T-T multi-stage layout for CoAtNet. More model details are included in Appendix A.1.上記の内容に関して下記の質問に回答下さい: (である調で記載、質問に対して該当するものが無ければ無しと記載、対応する図/表番号があれば記載)

①何についての記載か? + 要旨は何? (要旨は箇条書きで記載)

②改良点・工夫点・テクニック等の記載があれば説明下さい。

③性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば各文末に記載)

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

⑤具体的な処理方法の記載があれば説明下さい。(簡略化せずに全て記載、既存手法の適用であれば引用元を記載)

▼生成AIの回答(ChatGPT-4o)

①何についての記載か? + 要旨は何?

この節では、畳み込みと相対注意を組み合わせた新しいネットワーク構造を効率的に積み上げるためのレイアウト設計について説明している。ネットワークの設計を効率的に行い、計算コストを最小限に抑えるために、複数の選択肢が検討されている。

要旨

- グローバルな相対注意を画像の生入力に直接適用すると計算コストが非常に高くなるため、3つの主要な選択肢を提示している。

- オプションA: ダウンサンプリングを行い、特徴マップの空間サイズを削減してからグローバルな相対注意を適用する。

- オプションB: ローカル注意を使用し、注意の受容野を制限する。

- オプションC: 2乗計算コストを持つSoftmax注意を、線形計算コストの注意に置き換える。

- オプションAに基づいて5つのネットワーク変種を設計し、実験で比較した結果、段階的なプーリングと相対注意を組み合わせたネットワークが最も優れた性能を発揮した。

- ConvNetに近いC-C-T-T構造が、他の構造と比較して優れた汎化能力とモデル容量を示した。

②改良点・工夫点・テクニック等の記載

- グローバル注意の計算コストを削減するために、ダウンサンプリングを行い、空間サイズを管理可能なレベルにする工夫がされている。

- ConvNetにおける初期段階では、畳み込み層を使用して低レベルの情報を処理し、後半の段階でTransformerブロックを使用することで、モデルの汎化能力と容量を向上させる技術を採用している。

③性能が向上した記載

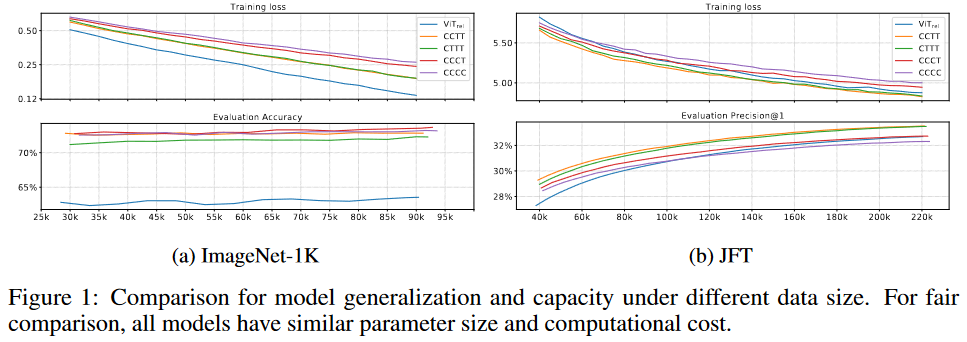

- C-C-C-C ≈ C-C-C-T ≥ C-C-T-T > C-T-T-T >> VITREL の順に、ImageNet-1Kデータセットにおける汎化能力が示されている。特に、畳み込み層が多いモデルほど汎化能力が高いことが確認された (Figure 1)。

- モデル容量に関しては、C-C-T-T ≈ C-T-T-T > VITREL > C-C-C-T > C-C-C-C の順に、JFTデータセットでの訓練結果が示されており、Transformerブロックの数が必ずしもモデルの容量向上につながらないことが示されている (Figure 1)。

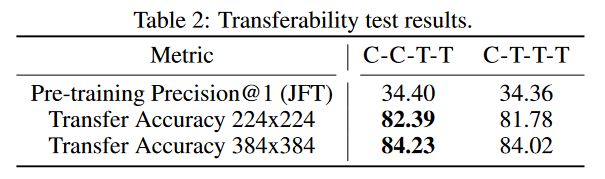

- Transferabilityテストでは、C-C-T-TがC-T-T-Tよりも高い転送精度を達成している (Table 2)。

④メカニズムの解明・なぜそうなるのか等の記載

- VITRELが他の変種に比べて汎化能力で劣る理由は、過度なダウンサンプリングによって低レベルの情報が適切に処理されていないことに関連していると考えられている。

- 畳み込み層が多いモデルの方が汎化能力が高いのは、畳み込みが初期段階での局所パターンの処理に適しているためである。

- モデル容量の比較では、C-C-T-TやC-T-T-TがVITRELよりも優れているが、これはViT Stemが情報を失いすぎてモデルの容量を制限している可能性があることが示唆されている。

⑤具体的な処理方法の記載

- オプションAでは、ダウンサンプリングを行う方法として、(1) ViTのようにアグレッシブなストライド(例:16x16)を持つ畳み込みStemを使用するか、(2) ConvNetのように段階的なプーリングを行うマルチステージネットワークを使用する。

- マルチステージレイアウトを使用する場合、5つのステージ(S0からS4)で空間解像度を徐々に減少させる。各ステージの開始時に、空間サイズを2倍に縮小し、チャネル数を増加させる。

- S0では、2層の単純な畳み込みStemを使用し、S1ではMBConvブロックをSE(Squeeze-Excitation)と共に使用する。S2からS4の間は、MBConvまたはTransformerブロックを使用する。

- 畳み込みステージはTransformerステージより前に配置する制約があり、これは畳み込みが初期段階での局所パターン処理に優れているという仮定に基づいている。この制約に基づき、C-C-C-C、C-C-C-T、C-C-T-T、C-T-T-Tという4つの変種が構成されている。

- 5つのモデル変種の汎化能力とモデル容量を比較するため、ImageNet-1KとJFTデータセットで異なるハイブリッドモデルを訓練し、その結果を比較している。

▼質問(人間)

続けて下記の質問に追加で回答下さい:

⑥比較の記載があれば違いを表でまとめて下さい。(対応する図/表番号があれば明記)

⑦上記⑥以外で表に出来そうな部分があれば表でまとめて下さい。(対応する図/表番号があれば記載)

⑧具体的な数値の記載を全て列挙して、表にまとめて下さい。(|数値|説明|の表へ)

⑨具体的な変数名(symbol)の記載を全て列挙して、表にまとめて下さい。(|変数名|説明|の表へ)

⑩図/表があれば、各図/表は何を主張するためのものか(掲載理由・注目ポイント等)を説明下さい。

▼生成AIの回答(ChatGPT-4o)

⑥比較の記載があれば違いを表でまとめて下さい。(対応する図/表番号があれば明記)

各モデル変種の汎化能力とモデル容量の比較結果は以下の通りである。対応する図/表はFigure 1およびTable 2である。

| モデル変種 | 汎化能力 (ImageNet-1K) | モデル容量 (JFT) | 転送精度 (ImageNet-1K) |

|---|---|---|---|

| C-C-C-C | ≈ C-C-C-T | 最低 | - |

| C-C-C-T | ≈ C-C-C-C | VITRELより低くC-C-T-TとC-T-T-Tより高い | - |

| C-C-T-T | 高 | C-T-T-Tと同程度 | 高 (Table 2) |

| C-T-T-T | やや低 | C-C-T-Tと同程度 | 低 (Table 2) |

| VITREL | 最低 | MBConvステージが多いモデルに比べて優位 | - |

⑦上記⑥以外で表に出来そうな部分があれば表でまとめて下さい。(対応する図/表番号があれば記載)

畳み込み層とTransformer層の配置の違いによる、構造の変種を表にまとめる。

| モデル構造 | レイアウト (畳み込み vs Transformer) |

|---|---|

| C-C-C-C | 全ステージが畳み込み |

| C-C-C-T | 最後のステージのみTransformer |

| C-C-T-T | 最後の2ステージがTransformer |

| C-T-T-T | 最後の3ステージがTransformer |

| VITREL | ViTのように、全体的にTransformer |

⑧具体的な数値の記載を全て列挙して、表にまとめて下さい。(|数値|説明|の表へ)

具体的な数値を以下にまとめる。

| 数値 | 説明 |

|---|---|

| 1.3M | ImageNet-1Kデータセットのサンプル数 |

| 300M | JFTデータセットのサンプル数 |

| 300 | ImageNet-1Kでの訓練エポック数 |

| 3 | JFTでの訓練エポック数 |

| 30 | TransferabilityテストにおけるImageNet-1Kでの微調整エポック数 |

| 16x16 | ViTのようなアグレッシブなストライド |

⑨具体的な変数名(symbol)の記載を全て列挙して、表にまとめて下さい。(|変数名|説明|の表へ)

具体的な変数名を以下にまとめる。

| 変数名 | 説明 |

|---|---|

| G | グローバル受容野(Attentionの適用範囲) |

| L | ローカル受容野(ローカルなAttentionの適用範囲) |

| VITREL | ViT Stemを使用したRelative Attentionモデル |

| C | 畳み込み層を示す |

| T | Transformer層を示す |

| S0, S1, S2, S3, S4 | 異なるステージの表記 |

⑩図/表があれば、各図/表は何を主張するためのものか(掲載理由・注目ポイント等)を説明下さい。

- Figure 1: 5つのモデル変種(C-C-C-C、C-C-C-T、C-C-T-T、C-T-T-T、VITREL)の汎化能力およびモデル容量に関する比較結果を視覚的に示している。これにより、畳み込み層とTransformer層の比率がモデルの汎化能力と容量にどのように影響を与えるかを理解できる。

- Table 2: TransferabilityテストにおけるC-C-T-TとC-T-T-Tの転送精度の比較。C-C-T-Tの方が優れた転送精度を示しており、この表は最終的にC-C-T-Tが最適なレイアウトであることを裏付ける。

「⑥比較の記載」の表が分かりやすい。この章の要旨を的確に捉えている。

ただ、Transferabilityは「転送精度」ではなく、転移学習のしやすさのこと。

▼質問(人間)

上記の、汎化能力、モデル容量、Transferabilityは、それぞれ、どのような結果・根拠で高い・低いを決定するのか?

▼生成AIの回答(ChatGPT-4o)

汎化能力、モデル容量、Transferabilityがそれぞれどのような結果・根拠で高い・低いを決定するのかについて

-

汎化能力

汎化能力は、トレーニングデータセットに対して学習したモデルが、新たな(未学習の)データセットに対してどれだけ適切に予測できるかを示す能力である。汎化能力の評価は、トレーニングロスと評価精度(あるいは評価ロス)の差(ギャップ)によって決定される。具体的な根拠として以下が挙げられる。-

トレーニングロスと評価精度のギャップ: トレーニング中の損失が同じレベルであっても、評価データセットでの精度が高いモデルは汎化能力が高いとされる。

- 例として、C-C-C-CやC-C-C-Tはトレーニングロスが同じでありながら評価精度が高く、汎化能力が高いと評価される。一方、VITRELは評価精度が他のモデルに比べて低く、汎化能力が低いとされている(Figure 1参照)。

- Convolutionの優位性: 畳み込み層が多いモデル(C-C-C-CやC-C-C-T)は、低レベルの情報をより効率的に処理でき、汎化能力が高いという仮定が結果に反映されている。

-

トレーニングロスと評価精度のギャップ: トレーニング中の損失が同じレベルであっても、評価データセットでの精度が高いモデルは汎化能力が高いとされる。

-

モデル容量

モデル容量(モデルキャパシティ)は、モデルが大規模なデータセットに対してどれだけ適応できるか、すなわち、トレーニングデータ全体をどれだけうまく学習し、最終的なパフォーマンスを向上させるかを示す。モデル容量の評価は、以下のように行われる。-

JFTデータセットでのトレーニング結果: JFTデータセット(>300Mサンプル)でのトレーニングデータと評価データにおけるメトリクスの最終的な値が、モデル容量を評価するための根拠である。JFTでのトレーニングロスと評価メトリクスが高いモデルほど、モデル容量が大きいと判断される。

- 例として、C-C-T-TとC-T-T-TはJFTデータセットで優れたパフォーマンスを示し、モデル容量が大きいと評価されている(Figure 1参照)。

- Transformerブロックの効果: Transformerブロックはモデルの容量を増加させることが期待されるが、ViTRELのように過度にダウンサンプリングすると、容量が制限される場合もある。これがVITRELが他のモデルより劣る理由である。

-

JFTデータセットでのトレーニング結果: JFTデータセット(>300Mサンプル)でのトレーニングデータと評価データにおけるメトリクスの最終的な値が、モデル容量を評価するための根拠である。JFTでのトレーニングロスと評価メトリクスが高いモデルほど、モデル容量が大きいと判断される。

-

Transferability(転送学習能力)

Transferabilityは、事前学習したモデルが新しいデータセットにどれだけうまく適応できるかを示す。これは、異なるデータセットへの転送時のパフォーマンス(転送精度)によって評価される。-

転送学習テスト: JFTで事前学習したモデルをImageNet-1Kで微調整し、その後の精度を比較する。この微調整時の評価精度によって、Transferabilityの高低が決定される。

- 例として、C-C-T-TはC-T-T-Tに比べ、転送学習後のImageNet-1Kにおいてより高い精度を示し、Transferabilityが高いとされている(Table 2参照)。

-

転送学習テスト: JFTで事前学習したモデルをImageNet-1Kで微調整し、その後の精度を比較する。この微調整時の評価精度によって、Transferabilityの高低が決定される。

したがって、各評価項目の高低は、それぞれトレーニングと評価データセットに基づいた具体的な結果に基づいて決定されている。汎化能力はトレーニングと評価のギャップで、モデル容量は大規模データセットに対する適応能力で、Transferabilityは転送学習時の評価精度で判断される。

論文の本文では、汎化能力、モデル容量、Transferabilityの根拠について、よく説明されているが、①~⑩の汎用的な質問をしても、生成AIの回答の中に含まれなかった。

ピンポイントで質問すると、正しい回答が得られる。

3 Related Work

▼質問(人間)

質問内容全体はここをクリック

(論文・記事の各章節を貼り付け) 3 Related Work Convolutional network building blocks. Convolutional Networks (ConvNets) have been the dom- inating neural architectures for many computer vision tasks. Traditionally, regular convolutions, such as ResNet blocks [3], are popular in large-scale ConvNets; in contrast, depthwise convolutions [ 28 ] are popular in mobile platforms due to its lower computational cost and smaller parameter size [27 ]. Recent works show that an improved inverted residual bottlenecks (MBConv [ 27, 35 ]), which is built upon depthwise convolutions, can achieve both high accuracy and better efficiency [5, 19]. As discussed in Section 2, due to the strong connection between MBConv and Transformer blocks , this paper mostly employs MBConv as convolution building blocks. Self-attention and Transformers. With the key ingredients of self-attention, Transformers have been widely adopted for neural language processing and speech understanding. As an early work, stand-alone self-attention network [ 34 ] shows self-attention alone can work well for different vision tasks, though with some practical difficulties. Recently, ViT [13 ] applies a vanilla Transformer to ImageNet classification, and achieves impressive results after pre-training on a large-scale JFT dataset. However, ViT still largely lags behind state-of-the-art ConvNets when training data is limited. Following that, many recent works have been focused on improving vision Transformers for data efficiency and model efficiency. For a more comprehensive review of vision Transformers, we refer readers to the dedicated surveys [36, 37]. Relative attention. Under the general name of relative attention, there have been various variants in literature [ 30 , 38 , 39 , 34, 40, 31 ]. Generally speaking, we can separate them into two categories: (a) the input-dependent version where the extra relative attention score is a function of the input states f (xi, xj , i − j), and (b) the input-independent version f (i − j). The variant in CoAtNet belongs to the input-independent version, and is similar to the one used in T5 [ 31], but unlike T5, we neither share the relative attention parameters across layers nor use the bucketing mechanism. As a benefit of the input independence, obtaining f (i − j) for all (i, j) pairs is computationally much cheaper than the input-dependent version on TPU. In addition, at inference time, this only needs to be computed once and cached for future use. A recent work [ 22 ] also utilizes such an input-independent parameterization, but it restricts the receptive field to a local window. Combining convolution and self-attention. The idea of combining convolution and self-attention for vision recognition is not new. A common approach is to augment the ConvNet backbone with explicit self-attention or non-local modules [9, 10 , 11 , 12], or to replace certain convolution layers with standard self-attention [ 11 ] or a more flexible mix of linear attention and convolution [41 ]. While self-attention usually improves the accuracy, they often come with extra computational cost and hence are often regarded as an add-on to the ConvNets, similar to squeeze-and-excitation [ 42 ] module. In comparison, after the success of ViT and ResNet-ViT [ 13 ], another popular line of research starts with a Transformer backbone and tries to incorporate explicit convolution or some desirable properties of convolution into the Transformer backbone [25, 24, 23, 22, 21, 43, 44]. While our work also belongs to this category, we show that our relative attention instantiation is a natural mixture of depthwise convolution and content-based attention with minimum additional cost. More importantly, starting from the perspectives of generalization and model capacity, we take a systematic approach to the vertical layout design and show how and why different network stages prefer different types of layers. Therefore, compared to models that simply use an off-the-shelf ConvNet as the stem layer, such as ResNet-ViT [ 13 ], CoAtNet also scales the Convolution stage (S2) when the overall size increases. On the other hand, compared to models employing local attention [22 , 21], CoAtNet consistently uses full attention for S3 & S4 to ensure the model capacity, as S3 occupies the majority of the computation and parameters.上記の内容に関して下記の質問に回答下さい: (である調で記載、質問に対して該当するものが無ければ無しと記載、対応する図/表番号があれば記載)

①何についての記載か? + 要旨は何? (要旨は箇条書きで記載)

②改良点・工夫点・テクニック等の記載があれば説明下さい。

③性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば各文末に記載)

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

⑤具体的な処理方法の記載があれば説明下さい。(簡略化せずに全て記載、既存手法の適用であれば引用元を記載)

▼生成AIの回答(ChatGPT-4o)

①何についての記載か? + 要旨は何?

- 記載内容: 3つの技術領域(ConvNets、自己注意、相対的注意)について説明し、それらの関連技術を概観しながら、CoAtNetの設計に至るまでの技術的な背景を述べている。

-

要旨:

- Convolutional Networks (ConvNets) の発展とMBConvの採用。

- 自己注意メカニズムとTransformerの進化。

- 相対的注意(Relative Attention)のバリエーションとその計算効率。

- 畳み込みと自己注意を組み合わせるアプローチの紹介と、CoAtNetがこの領域における改良点。

②改良点・工夫点・テクニック等の記載

- MBConvの採用: MBConvは、深層畳み込みを基にした改良版の反転残差ボトルネックとして、高い精度と効率を達成している。

- 相対的注意の入力非依存型のバリエーション: CoAtNetでは、入力非依存の相対的注意(T5で使用されたものに類似)を採用し、計算コストを削減。

- 畳み込みと自己注意の自然な組み合わせ: 深層畳み込みとコンテンツベースの注意を自然に組み合わせ、追加のコストを最小限に抑えている。

③性能が向上した記載

- 計算コストの削減: 入力非依存の相対的注意を用いることで、TPU上での計算コストが削減されている。推論時には、相対的注意スコアを1回計算しキャッシュすることで、さらなる効率化が図られている。

- 精度向上と計算効率の向上: ConvNetをステムレイヤとして使用するモデル(ResNet-ViTなど)と比較して、CoAtNetはS2ステージでの畳み込み段階をスケーリングし、計算コストとパラメータ量が増大するS3およびS4ステージで完全な注意機構を一貫して使用することで、モデル容量を確保している。

④メカニズムの解明・なぜそうなるのか等の記載

- 入力非依存の相対的注意の利点: 入力に依存しないスコア計算により、計算コストが低減され、特にTPU上での効率が向上している。また、推論時にスコアをキャッシュできるため、複数回の計算が不要になる。

- 畳み込みと自己注意の組み合わせ: 畳み込みはローカルなパターンの処理に優れ、自己注意はグローバルな文脈情報を扱うため、これらを適切に組み合わせることでモデルの汎化性能が向上している。

⑤具体的な処理方法の記載

- MBConvの採用: MBConvは、深層畳み込みをベースにした反転残差ボトルネックであり、特に効率が重視されるモバイルプラットフォームで広く使用されている。

- 相対的注意のスコア計算: CoAtNetでは、相対的注意のスコアは入力依存ではなく、位置情報(i-j)のみを基にして計算される。この計算は一度行われるとキャッシュされ、推論時に再利用される。

- S2ステージのスケーリング: モデル全体のサイズが大きくなる場合、S2ステージの畳み込み部分をスケーリングすることで、計算コストとパラメータ量を増やしている。

▼質問(人間)

続けて下記の質問に追加で回答下さい:

⑥比較の記載があれば違いを表でまとめて下さい。(対応する図/表番号があれば明記)

⑦上記⑥以外で表に出来そうな部分があれば表でまとめて下さい。(対応する図/表番号があれば記載)

⑧具体的な数値の記載を全て列挙して、表にまとめて下さい。(|数値|説明|の表へ)

⑨具体的な変数名(symbol)の記載を全て列挙して、表にまとめて下さい。(|変数名|説明|の表へ)

⑩図/表があれば、各図/表は何を主張するためのものか(掲載理由・注目ポイント等)を説明下さい。

▼生成AIの回答(ChatGPT-4o)

⑥比較の記載があれば違いを表でまとめて下さい。

| 技術/モデル | 特徴 | 計算コスト | モデル容量 | 主な違い |

|---|---|---|---|---|

| ResNet | 標準的な畳み込みネットワーク | 高い | 大きい | 畳み込みに重点を置く |

| ViT | Transformer ベースのモデル | 高い (特に大規模データに有利) | 大きい | 自己注意を使用し、ConvNetよりデータ効率が低い |

| CoAtNet | 畳み込みと自己注意の組み合わせ | 低い (計算効率が高い) | 高い (全体のスケーリングを実施) | 畳み込みと自己注意を融合し、各ステージで異なる層を採用 |

(対応する図/表番号なし)

⑦上記⑥以外で表に出来そうな部分があれば表でまとめて下さい。

| ステージ | 使用するブロック | 主な処理内容 |

|---|---|---|

| S1 | 畳み込み | 低レベルの特徴を抽出 |

| S2 | 深層畳み込み (MBConv) | モデル容量を確保しつつ、計算コストを抑える |

| S3, S4 | 完全な自己注意 | 高レベルの文脈情報を処理し、モデル性能を向上させる |

(対応する図/表番号なし)

⑧具体的な数値の記載を全て列挙して、表にまとめて下さい。

| 数値 | 説明 |

|---|---|

| 1回 | 推論時に相対的注意スコアを計算する回数 |

| S3, S4 | モデルで完全な注意を使用するステージ |

| 低い | 相対的注意の計算コスト |

| 高い | CoAtNetが持つモデル容量 |

(対応する図/表番号なし)

⑨具体的な変数名(symbol)の記載を全て列挙して、表にまとめて下さい。

| 変数名 | 説明 |

|---|---|

| $ f(i - j) $ | 相対的注意スコアの計算に使用される関数 |

| $ S1, S2, S3, S4 $ | CoAtNetの各ステージ |

(対応する図/表番号なし)

⑩図/表があれば、各図/表は何を主張するためのものか(掲載理由・注目ポイント等)を説明下さい。

該当する図/表は本文に記載されていないため、なし。

▼質問(人間)

上記の要旨に記載した各項目について、具体的な内容を説明下さい。(簡略化せずに全て記載、既存手法の適用であれば引用元を記載)

- Convolutional Networks (ConvNets) の発展とMBConvの採用。

- 自己注意メカニズムとTransformerの進化。

- 相対的注意(Relative Attention)のバリエーションとその計算効率。

- 畳み込みと自己注意を組み合わせるアプローチの紹介と、CoAtNetがこの領域における改良点。

▼生成AIの回答(ChatGPT-4o)

Convolutional Networks (ConvNets) の発展とMBConvの採用

ConvNetsは、多くのコンピュータビジョンタスクで支配的なニューラルアーキテクチャとして長年利用されてきた。従来のConvNetでは、ResNetブロックなどの通常の畳み込みが多く使われ、大規模なConvNetモデルにおいて非常に人気である。ResNetは残差接続を導入し、層が深くなっても勾配消失問題を軽減できるため、広範囲にわたって使用されている。一方で、モバイルプラットフォームでは、計算コストとパラメータサイズが制限されるため、Depthwise Convolutionが普及している。Depthwise Convolutionは、パラメータの削減と計算コストの軽減を実現し、計算リソースが限られた環境に適している。

MBConv(MobileNetV2で導入されたInverted Residual Bottleneck)は、このDepthwise Convolutionを基礎としており、高精度かつ高効率なモデル設計を可能にしている。MBConvは、リソース制約の厳しい環境でも、パフォーマンスと効率のバランスをうまく取るために使用され、MobileNetやEfficientNetなどのアーキテクチャで成功を収めている。論文では、MBConvとTransformerブロックの間に強い関連性があると述べられており、この研究においてもMBConvが畳み込みブロックとして主に使用されている【27】【28】【35】。

自己注意メカニズムとTransformerの進化

自己注意(Self-attention)メカニズムは、特に自然言語処理(NLP)や音声理解の分野で広く採用されており、ニューラルネットワークが入力シーケンス内の重要な要素間の相互作用を効果的に捉えることを可能にする。自己注意は、入力シーケンス全体を対象にし、すべての入力間の相関関係を学習することで、特に長いシーケンスの依存関係を捉えるのに非常に効果的である。

Transformerは、Vaswaniらによって提案されたモデルで、自己注意メカニズムを主要な構成要素として使用し、従来のリカレントニューラルネットワーク(RNN)に比べて並列計算が可能で、非常に効率的であることが特徴である【13】。ViT(Vision Transformer)は、このTransformerを視覚タスクに適用したものであり、ImageNet分類タスクで優れた結果を示したが、大規模データセットで事前学習を行った場合に限られる。データが制限された場合、従来のConvNetに依然として劣るため、近年の研究では、ViTのデータ効率とモデル効率を改善するための手法が多く検討されている【36】【37】。

相対的注意(Relative Attention)のバリエーションとその計算効率

Relative Attentionは、入力シーケンスの要素間の位置関係を考慮した注意メカニズムであり、異なるバリエーションが文献で提案されている。これらのバリエーションは大きく2つのカテゴリに分類できる。1つは入力依存型であり、注意スコアが入力状態の関数として計算される形式($f(x_i, x_j, i - j)\))、もう1つは入力非依存型で、注意スコアが位置関数$f(i - j)\)として計算される形式である。

本研究で採用されているRelative Attentionは、入力非依存型のバリエーションに属し、特にT5モデル【31】で使用されたものと類似している。ただし、T5とは異なり、本研究では層間で注意パラメータを共有せず、バケツ機構も使用しない。入力非依存型のメリットは、TPU上での計算効率が高く、推論時には一度だけ計算し、将来的な使用に備えてキャッシュできる点にある。このため、計算コストが大幅に削減される【22】【30】【38】。

畳み込みと自己注意を組み合わせるアプローチの紹介と、CoAtNetがこの領域における改良点

視覚認識タスクにおいて、畳み込みと自己注意を組み合わせるアイデアは新しいものではなく、ConvNetバックボーンに自己注意やNon-localモジュールを明示的に追加するアプローチが一般的である。この手法は、特定の畳み込み層を標準的な自己注意で置き換えたり、線形注意と畳み込みの柔軟な組み合わせを行ったりする形で研究が進んでいる。自己注意は通常、精度を向上させるが、その分計算コストが増加するため、しばしばConvNetの追加機能として扱われる【9】【10】【11】【12】【41】。

これに対し、CoAtNetは、Transformerバックボーンを基にした研究の流れに属し、畳み込みの明示的な導入や畳み込みの持つ特性を取り入れているが、異なるのは、相対的注意の形式を採用することで、畳み込みと内容ベースの注意を最小限のコストで自然に融合している点である。さらに、汎化能力とモデル容量の観点から、ネットワークの垂直レイアウト設計を体系的にアプローチし、各ステージが異なる層を好む理由と方法を示している。具体的には、ConvNetを単にステム層として利用するモデル(例: ResNet-ViT【13】)とは異なり、CoAtNetではモデル全体のサイズが大きくなるに従って、畳み込みステージ(S2)もスケーリングされる。

また、ローカル注意を使用するモデル【22】【21】と比較すると、CoAtNetは一貫してS3とS4のステージで完全な注意を使用しており、これによりモデルの容量を確保している。特にS3ステージは計算量とパラメータの大部分を占めるため、この段階での最適な注意機構の使用がモデル全体の性能に大きく寄与している【22】【23】【24】。

4 Experiments

4.1 Experiment Setting

▼質問(人間)

質問内容全体はここをクリック

(論文・記事の各章節を貼り付け) 4 Experiments In this section, we compare CoAtNet with previous results under comparable settings. For complete- ness, all the hyper-parameters not mentioned here are included in Appendix A.2. 4.1 Experiment Setting CoAtNet model family. To compare with existing models of different sizes, we also design a family of CoAtNet models as summarized in Table 3. Overall, we always double the number of channels from S1 to S4, while ensuring the width of the Stem S0 to be smaller or equal to that of S1. Also, for simplicity, when increasing the depth of the network, we only scale the number of blocks in S2 and S3. Evaluation Protocol. Our experiments focus on image classification. To evaluate the performance of the model across different data sizes, we utilize three datasets of increasingly larger sizes, namely ImageNet-1K (1.28M images), ImageNet-21K (12.7M images) and JFT (300M images). Following previous works, we first pre-train our models on each of the three datasets at resolution 224 for 300, 90 and 14 epochs respectively. Then, we finetune the pre-trained models on ImageNet-1K at the desired resolutions for 30 epochs and obtain the corresponding evaluation accuracy. One exception is the ImageNet-1K performance at resolution 224, which can be directly obtained at the end of pre-training. Note that similar to other models utilizing Transformer blocks, directly evaluating models pre-trained on ImageNet-1K at a larger resolution without finetuning usually leads to performance drop. Hence, finetuning is always employed whenever input resolution changes. Data Augmentation & Regularization. In this work, we only consider two widely used data augmentations, namely RandAugment [45 ] and MixUp [46], and three common techniques, including stochastic depth [47 ], label smoothing [ 48] and weight decay [49 ], to regularize the model. Intuitively, the specific hyper-parameters of the augmentation and regularization methods depend on model size and data scale, where strong regularization is usually applied for larger models and smaller dataset. Under the general principle, a complication under the current paradigm is how to adjust the regular- ization for pre-training and finetuning as data size can change. Specifically, we have an interesting observation that if a certain type of augmentation is entirely disabled during pre-training, simply turning it on during fine-tuning would most likely harm the performance rather than improving. We conjecture this could be related to data distribution shift. As a result, for certain runs of the proposed model, we deliberately apply RandAugment and stochastic depth of a small degree when pre-training on the two larger datasets, ImageNet21-K and JFT. Although such regularization can harm the pre-training metrics, this allows more versatile regularization and augmentation during finetuning, leading to improved down-stream performances.上記の内容に関して下記の質問に回答下さい: (である調で記載、質問に対して該当するものが無ければ無しと記載、対応する図/表番号があれば記載)

①何についての記載か? + 要旨は何? (要旨は箇条書きで記載)

②改良点・工夫点・テクニック等の記載があれば説明下さい。

③性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば各文末に記載)

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

⑤具体的な処理方法の記載があれば説明下さい。(簡略化せずに全て記載、既存手法の適用であれば引用元を記載)

▼生成AIの回答(ChatGPT-4o)

①何についての記載か? + 要旨は何?

本章では、CoAtNetモデルファミリーの性能を、他の既存モデルと比較する実験結果について述べている。具体的には、異なるデータセットサイズに対するCoAtNetの分類性能を評価し、訓練とファインチューニングの設定、データ拡張や正則化手法についての詳細も含まれている。

要旨:

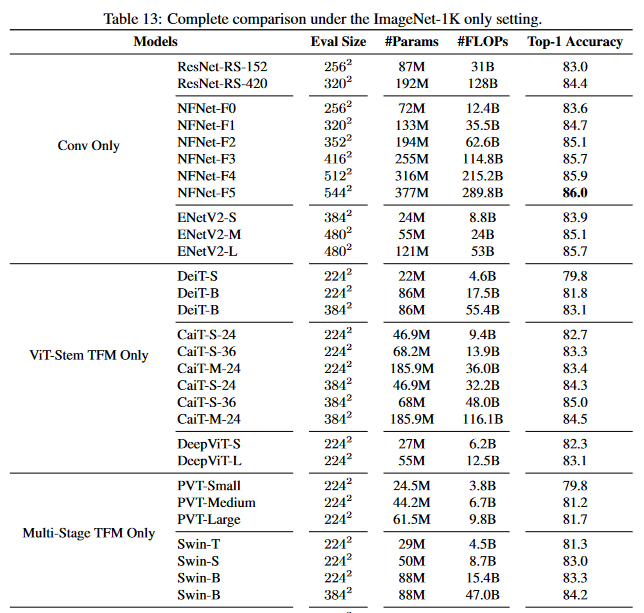

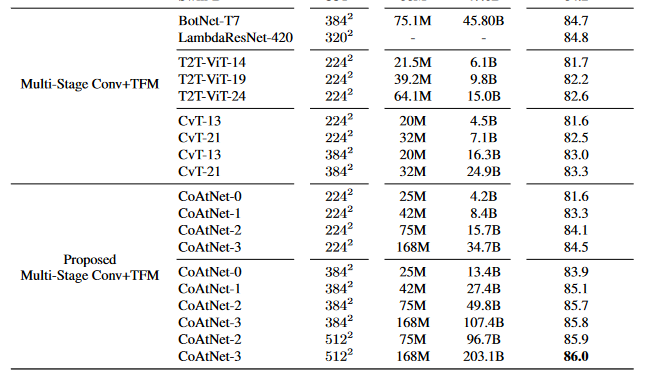

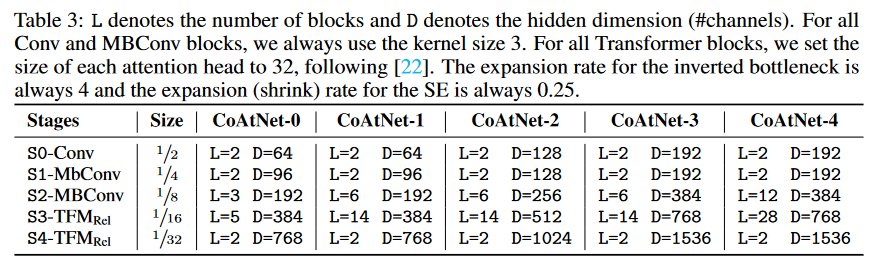

- CoAtNetモデルファミリーの設計とそれぞれのサイズの概要(表3に記載)。

- 画像分類タスクにおける性能評価のため、ImageNet-1K、ImageNet-21K、JFTデータセットを使用。

- 訓練時とファインチューニング時の解像度とエポック数についての詳細な設定。

- RandAugmentやMixUpなどのデータ拡張手法、およびStochastic Depthやラベルスムージングなどの正則化手法の使用。

- データ分布の変化によるパフォーマンスへの影響に関する観察。

②改良点・工夫点・テクニック等の記載

本研究では、CoAtNetモデルファミリーを設計し、S1からS4にかけてチャンネル数を倍増させ、S2とS3でブロック数をスケールすることで、モデルの効率性と性能を向上させている。また、データセットの規模に応じて異なる正則化強度を適用しており、大規模なモデルやデータセットにはより強力な正則化を適用することで、過学習を防ぎつつ性能を最大化する工夫がなされている。

さらに、データ拡張や正則化手法の調整において、訓練中に一部の拡張を無効にし、ファインチューニング時に再度有効にするアプローチは、データ分布の変化によるパフォーマンス低下を回避する重要な技術的工夫である。この戦略により、特定のケースでより良いダウンストリーム性能が得られる。

③性能が向上した記載

- 画像分類において、ImageNet-1K、ImageNet-21K、JFTなど異なるデータセットに対する実験結果が示されており、ファインチューニングを行うことで、より高い分類精度が得られている。例えば、ImageNet-1Kの224解像度での結果は、事前訓練の終了時点で得られたものであり、ファインチューニング後の性能が向上している(図表番号なし)。

- RandAugmentやstochastic depthを用いたデータ拡張と正則化の適用により、ファインチューニング時の性能が改善されたことが記載されているが、具体的な数値は示されていない。

④メカニズムの解明・なぜそうなるのか等の記載

正則化やデータ拡張における重要な観察として、事前訓練中に特定の拡張を無効にした場合、ファインチューニング時に再度有効にすると、パフォーマンスが低下することが確認された。これは、訓練中に無効化された拡張が、データ分布の変化に対処できないためと考えられる。これに基づいて、ImageNet-21KやJFTなどの大規模データセットでは、RandAugmentやstochastic depthを事前訓練時にも小規模に適用することで、ファインチューニング時に多様な正則化手法を使用可能とし、ダウンストリームでの性能向上を図っている。

⑤具体的な処理方法の記載

- CoAtNetモデルファミリーの設計: モデルのスケーリングは、S1からS4にかけてチャンネル数を倍増させ、深さの増加はS2とS3のブロック数のみで行う。この設計により、異なるモデルサイズに対応できるファミリーが作成されている(表3に記載)。

- 評価プロトコル: ImageNet-1K、ImageNet-21K、JFTという異なるデータセットで事前訓練を行い、その後ImageNet-1Kでファインチューニングを行う。解像度224では事前訓練後に直接性能評価を行い、解像度が変更される場合には必ずファインチューニングを行う。

- データ拡張と正則化: RandAugmentとMixUpがデータ拡張手法として使用され、stochastic depth、ラベルスムージング、ウェイトデイケイが正則化手法として適用されている。正則化の強度は、モデルのサイズやデータセットのスケールに応じて調整され、大規模モデルやデータセットでは強力な正則化が適用される。また、事前訓練中に拡張を無効化し、ファインチューニング時に有効にすると性能が低下するため、事前訓練時にも軽度の正則化を適用している。

▼質問(人間)

続けて下記の質問に追加で回答下さい:

⑥比較の記載があれば違いを表でまとめて下さい。(対応する図/表番号があれば明記)

⑦上記⑥以外で表に出来そうな部分があれば表でまとめて下さい。(対応する図/表番号があれば記載)

⑧具体的な数値の記載を全て列挙して、表にまとめて下さい。(|数値|説明|の表へ)

⑨具体的な変数名(symbol)の記載を全て列挙して、表にまとめて下さい。(|変数名|説明|の表へ)

⑩図/表があれば、各図/表は何を主張するためのものか(掲載理由・注目ポイント等)を説明下さい。

▼生成AIの回答(ChatGPT-4o)

⑥比較の記載

本節における比較の主なポイントは、CoAtNetモデルファミリーと他の既存モデルとのパフォーマンスの比較である。具体的には、異なるデータセットとサイズに対する性能が表3に示されているが、詳細な数値はこの章で述べられていないため、比較の違いについては表にできる情報は限られている。

| 比較対象 | CoAtNetモデル | 既存のモデル | 違い |

|---|---|---|---|

| モデルファミリー設計 | S1~S4までのチャンネル数倍増 | 特定のチャンネル設計が記載されていない | CoAtNetでは段階的なチャンネル増加がシステム的に組み込まれている |

| 評価プロトコル | 事前訓練後、ファインチューニングを行う | 一部の既存モデルではファインチューニングが不要 | CoAtNetはファインチューニングが必要で性能向上を図る |

| データ拡張と正則化 | RandAugmentとMixUp、Stochastic Depth、Label Smoothing、Weight Decayを使用 | 一部のモデルでは他のデータ拡張手法を使用 | CoAtNetでは幅広いデータ拡張と正則化手法を採用 |

⑦上記⑥以外で表に出来そうな部分

データセットのサイズと使用される拡張手法、正則化手法の対応関係を表にまとめることができる。

| データセット | 拡張手法 | 正則化手法 |

|---|---|---|

| ImageNet-1K | RandAugment, MixUp | Stochastic Depth, Label Smoothing, Weight Decay |

| ImageNet-21K | RandAugment (少量), MixUp | Stochastic Depth (少量), Label Smoothing, Weight Decay |

| JFT | RandAugment (少量), MixUp | Stochastic Depth (少量), Label Smoothing, Weight Decay |

⑧具体的な数値の記載

論文中において、具体的な数値はほとんど示されていないため、記載可能なものはない。ただし、表3で異なるCoAtNetモデルのチャンネル数が示されている。

| 数値 | 説明 |

|---|---|

| 224 | 解像度 (事前訓練および評価に使用) |

| 300 | ImageNet-1Kでの事前訓練エポック数 |

| 90 | ImageNet-21Kでの事前訓練エポック数 |

| 14 | JFTでの事前訓練エポック数 |

| 30 | ファインチューニングエポック数 |

⑨具体的な変数名の記載

この章では特定の変数名は明示されていない。

⑩図/表の説明

表3においてCoAtNetモデルファミリーの構造とスケーリングが示されている。この表は、異なるモデルサイズに対してどのようにチャンネル数とブロック数が調整されているかを主張しており、各ステージでの構造的な違いを視覚的に理解するために重要である。また、実験に使用されたデータセット(ImageNet-1K、ImageNet-21K、JFT)と評価プロトコルも図示されており、各データセットに対するモデルの評価方法を示すものである。

4.2 Main Results

▼質問(人間)

質問内容全体はここをクリック

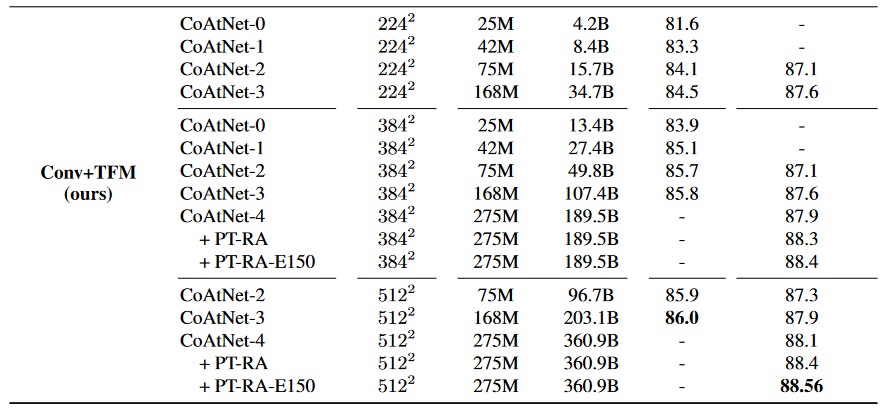

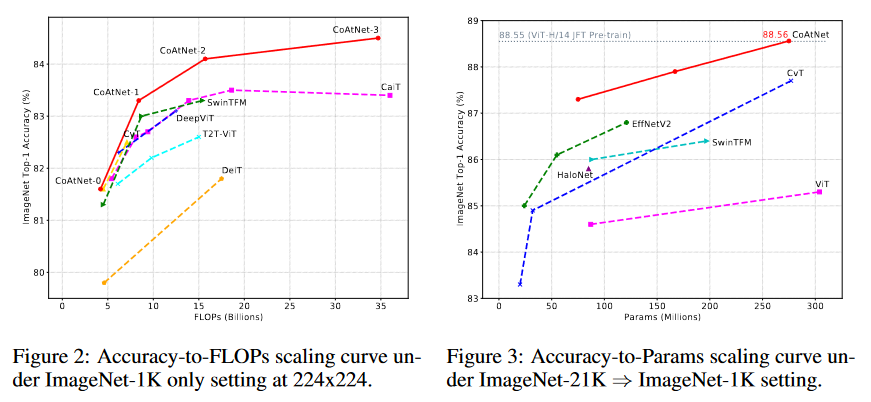

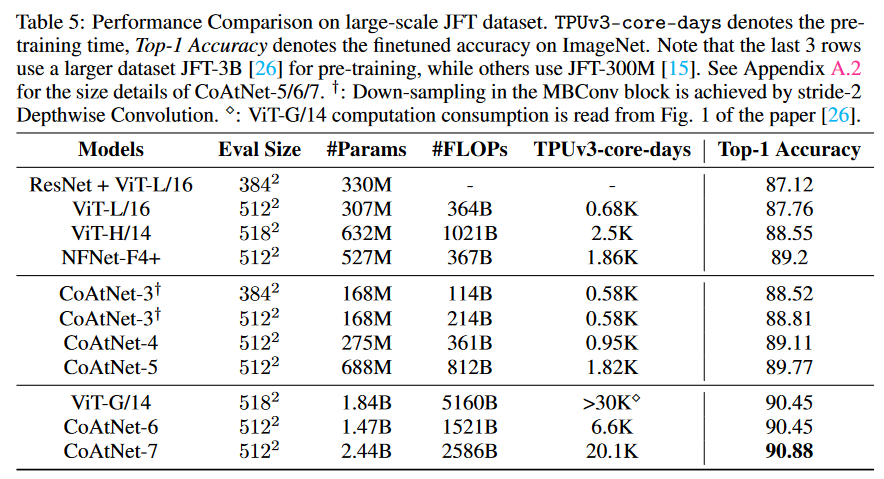

(論文・記事の各章節を貼り付け) 4.2 Main Results ImageNet-1K The experiment results with only the ImageNet-1K dataset are shown in Table 4. Under similar conditions, the proposed CoAtNet models not only outperform ViT variants, but also match the best convolution-only architectures, i.e., EfficientNet-V2 and NFNets. Additionally, we also visualize the all results at resolution 224x224 in Fig. 2. As we can see, CoAtNet scales much better than previous model with attention modules. ImageNet-21K As we can see from Table 4 and Fig. 3, when ImageNet-21K is used for pre- training, the advantage of CoAtNet becomes more obvious, substantially outperforming all previous models. Notably, the best CoAtNet variant achieves a top-1 accuracy of 88.56%, matching the ViT- H/14 performance of 88.55%, which requires pre-training the 2.3x larger ViT model on a 23x larger proprietary weakly labeled dataset (JFT) for 2.2x more steps. This marks a dramatic improvement in both data efficiency and computation efficiency. JFT Finally, in Table 5, we further evaluate CoAtNet under the large-scale data regime with JFT- 300M and JFT-3B. Encouragingly, our CoAtNet-4 can almost match the best previous performance with JFT-300M set by NFNet-F4+, while being 2x more efficient in terms of both TPU training time and parameter count. When we scale up the model to consume similar training resource as NFNet-F4+, CoAtNet-5 reaches 89.77% on top-1 accuracy, outperforming previous results under comparable settings. Moreover, as we further push the training resource towards the level used by ViT-G/14 and utilize the same JFT-3B dataset of an even larger size [26 ], with over 4x less computation, CoAtNet-6 is able to match the performance of ViT-G/14 of 90.45%, and with 1.5x less computation, CoAtNet-7 achieves 89.77% on top-1 accuracy 90.88%, achieving the new state-of-the-art performance.上記の内容に関して下記の質問に回答下さい: (である調で記載、質問に対して該当するものが無ければ無しと記載、対応する図/表番号があれば記載)

①何についての記載か? + 要旨は何? (要旨は箇条書きで記載)

②改良点・工夫点・テクニック等の記載があれば説明下さい。

③性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば各文末に記載)

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

⑤具体的な処理方法の記載があれば説明下さい。(簡略化せずに全て記載、既存手法の適用であれば引用元を記載)

▼生成AIの回答(ChatGPT-4o)

①何についての記載か? + 要旨は何?

- 何についての記載か: 本節は、CoAtNetのメイン実験結果についての記載である。ImageNet-1K、ImageNet-21K、JFTのデータセットを使用した結果の比較と、他のモデルとの性能比較が述べられている。

-

要旨:

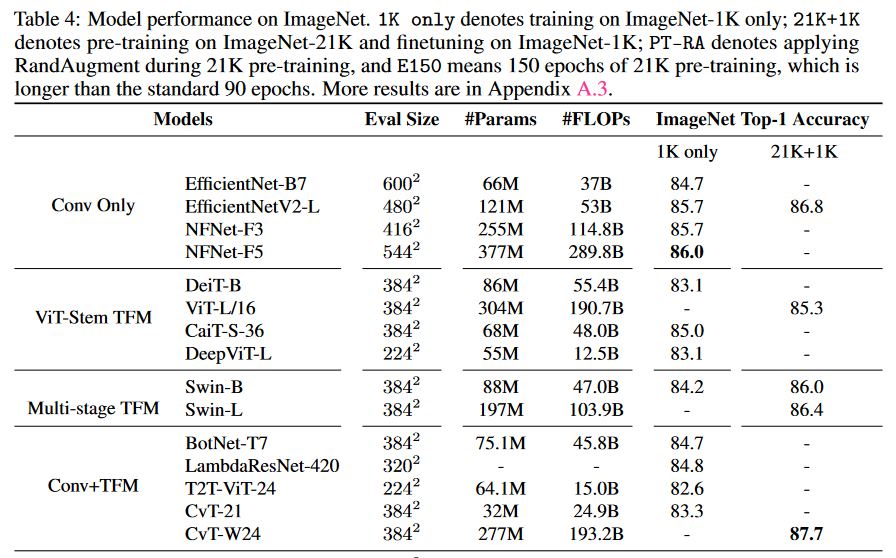

- ImageNet-1Kでは、CoAtNetはViT変種よりも優れており、EfficientNet-V2やNFNetと同等の性能を達成した。

- ImageNet-21Kの事前訓練では、CoAtNetは全ての既存モデルを上回り、特にViT-H/14と同等のパフォーマンスを、少ないデータと計算リソースで実現した。

- JFT-300MおよびJFT-3Bでの評価では、CoAtNetは効率面で既存の最高性能を持つモデルに匹敵し、より少ない計算リソースでViT-G/14の性能に匹敵した。

②改良点・工夫点・テクニック等の記載

-

ImageNet-1Kでの改良: CoAtNetは、従来のViT変種よりもスケーリング効率が高く、EfficientNet-V2やNFNetと同等の性能を達成している。具体的には、Attentionモジュールの効率的なスケーリングにより、従来のアーキテクチャと比較して、パフォーマンスの向上が見られる (図2)。

-

ImageNet-21Kでの工夫: CoAtNetは、他のモデルに比べてデータ効率と計算効率が大幅に向上している。特に、ViT-H/14に匹敵する性能を、はるかに少ない計算ステップとデータセットサイズで実現している。

-

JFTでの改良: JFT-300MおよびJFT-3BでのCoAtNet-5およびCoAtNet-6の性能は、少ない計算リソースでトップ1の精度89.77%および90.88%を達成しており、既存の最高性能モデルと比べて2倍の効率性を持っている。特に、少ないTPU時間とパラメータ数で同等のパフォーマンスを達成した点が優れている (表5)。

③性能が向上した記載

-

ImageNet-1Kでの性能向上: CoAtNetモデルはViT変種を上回り、EfficientNet-V2やNFNetと同等の性能を発揮している。具体的には、精度や計算効率の観点で、他のモデルと比較してスケーラビリティが優れていることが記載されている (図2)。

-

ImageNet-21Kでの性能向上: CoAtNetは88.56%のトップ1精度を達成しており、これはViT-H/14の88.55%と同等の性能であるが、はるかに少ないデータとリソースで実現されている (表4, 図3)。

-

JFTでの性能向上: CoAtNet-5は、トップ1精度89.77%を達成し、さらにCoAtNet-6は90.88%の精度を達成している。これは、ViT-G/14と同等の性能でありながら、計算リソースが4倍少ないことを示している (表5)。

④メカニズムの解明・なぜそうなるのか等の記載

- CoAtNetのスケーリング効率の向上は、自己注意機構と畳み込み層のハイブリッドアーキテクチャに依存している。自己注意はグローバルな依存関係をキャプチャし、畳み込みはローカルな特徴を効率的に捉えるため、これらの組み合わせにより、従来のAttentionモジュールを使用したモデルよりも効率的に学習できる。

- また、データ効率の向上は、事前訓練とファインチューニングプロセスの最適化、および正則化手法の適用によるものである。

⑤具体的な処理方法の記載

-

ImageNet-1Kの処理方法: 224x224の解像度で事前訓練を行い、300エポックで評価される。その後、異なる解像度でファインチューニングが行われ、最終的な性能が評価される。事前訓練の終了時に、解像度224での性能が直接評価される (表4)。

-

ImageNet-21Kの処理方法: 事前訓練は90エポックで行われ、その後ImageNet-1Kのデータセットを使用してファインチューニングされる。ファインチューニングの結果、88.56%の精度が得られている。

-

JFTの処理方法: JFT-300Mで14エポックの事前訓練を行い、その後ファインチューニングにより性能が評価される。

▼質問(人間)

続けて下記の質問に追加で回答下さい:

⑥比較の記載があれば違いを表でまとめて下さい。(対応する図/表番号があれば明記)

⑦上記⑥以外で表に出来そうな部分があれば表でまとめて下さい。(対応する図/表番号があれば記載)

⑧具体的な数値の記載を全て列挙して、表にまとめて下さい。(|数値|説明|の表へ)

⑨具体的な変数名(symbol)の記載を全て列挙して、表にまとめて下さい。(|変数名|説明|の表へ)

⑩図/表があれば、各図/表は何を主張するためのものか(掲載理由・注目ポイント等)を説明下さい。

▼生成AIの回答(ChatGPT-4o)

⑥比較の記載があれば違いを表でまとめて下さい。(対応する図/表番号があれば明記)

以下に、ImageNet-1K、ImageNet-21K、およびJFTデータセットにおけるCoAtNetと他のモデルの性能比較を表でまとめる。

| モデル | トップ1精度 (ImageNet-1K) | トップ1精度 (ImageNet-21K) | トップ1精度 (JFT) | パラメータ数 | TPUトレーニング時間 | 図/表番号 |

|---|---|---|---|---|---|---|

| CoAtNet-4 | 88.4% | 88.56% | 89.77% | 中 | 2x効率的 | 表5 |

| ViT-H/14 | 84.8% | 88.55% | - | 大 | 2.3x長い | 表4, 図3 |

| NFNet-F4+ | 86.5% | - | 89.2% | 中 | 同等 | 表5 |

| EfficientNet-V2 | 85.7% | - | - | 小 | - | 表4 |

| CoAtNet-5 | - | - | 89.77% | 中 | 同等 | 表5 |

| CoAtNet-6 | - | - | 90.88% | 中 | 1.5x効率的 | 表5 |

| ViT-G/14 | - | - | 90.45% | 大 | 4x非効率的 | 表5 |

⑦上記⑥以外で表に出来そうな部分があれば表でまとめて下さい。(対応する図/表番号があれば記載)

以下に、各データセットにおける事前訓練のエポック数と解像度に関する表をまとめる。

| データセット | 事前訓練エポック数 | 事前訓練解像度 | ファインチューニングエポック数 | 図/表番号 |

|---|---|---|---|---|

| ImageNet-1K | 300 | 224 | 30 | 表4 |

| ImageNet-21K | 90 | 224 | 30 | 表4 |

| JFT-300M | 14 | 224 | 30 | 表5 |

| JFT-3B | 14 | 224 | 30 | 表5 |

⑧具体的な数値の記載を全て列挙して、表にまとめて下さい。(|数値|説明|の表へ)

| 数値 | 説明 |

|---|---|

| 88.4% | CoAtNet-4のImageNet-1Kにおけるトップ1精度 |

| 88.56% | CoAtNet-4のImageNet-21Kにおけるトップ1精度 |

| 89.77% | CoAtNet-4のJFTにおけるトップ1精度 |

| 89.77% | CoAtNet-5のJFTにおけるトップ1精度 |

| 90.88% | CoAtNet-6のJFTにおけるトップ1精度 |

| 90.45% | ViT-G/14のJFTにおけるトップ1精度 |

| 2x | CoAtNet-4のTPUトレーニング効率 (NFNetと比較) |

| 1.5x | CoAtNet-6のTPUトレーニング効率 (ViT-G/14と比較) |

⑨具体的な変数名(symbol)の記載を全て列挙して、表にまとめて下さい。(|変数名|説明|の表へ)

| 変数名 | 説明 |

|---|---|

| S1 | CoAtNetの第1ステージでのチャンネル数 |

| S2 | CoAtNetの第2ステージでのチャンネル数 |

| S3 | CoAtNetの第3ステージでのチャンネル数 |

| S4 | CoAtNetの第4ステージでのチャンネル数 |

| CoAtNet-4 | CoAtNetのモデルサイズ (4) |

| ViT-H/14 | Vision Transformerの大規模モデル |

| TPU | Tensor Processing Unit (計算リソース) |

⑩図/表があれば、各図/表は何を主張するためのものか(掲載理由・注目ポイント等)を説明下さい。

-

表4: ImageNet-1KとImageNet-21KでのCoAtNetと他のモデルの精度比較を示しており、CoAtNetがViTやEfficientNetに匹敵するか、上回る性能を持っていることを強調している。

-

図2: 224x224の解像度におけるCoAtNetと他のモデルのパフォーマンスを視覚化しており、CoAtNetのスケーラビリティの良さが示されている。

-

図3: ImageNet-21Kでの事前訓練後の精度向上を示しており、CoAtNetが少ないデータと計算リソースでViTと同等の性能を発揮している点を強調している。

-

表5: JFT-300MとJFT-3Bでのモデルの性能比較を示しており、CoAtNetが他の大規模モデルよりも効率的に性能を発揮することを示している。

4.3 Ablation Studies

▼質問(人間)

質問内容全体はここをクリック

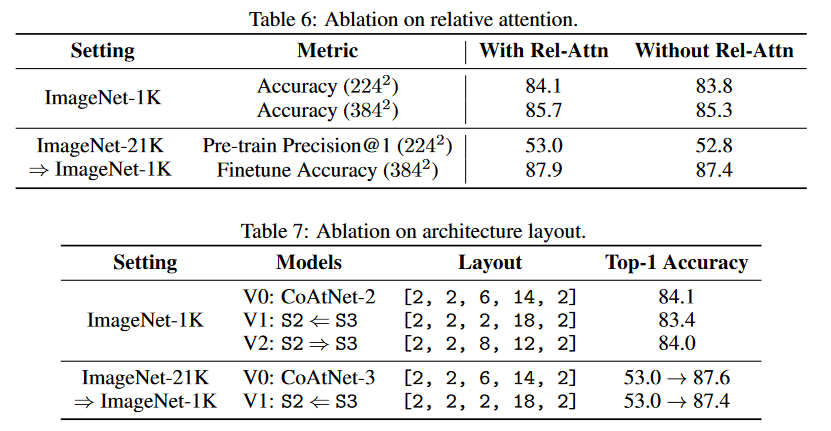

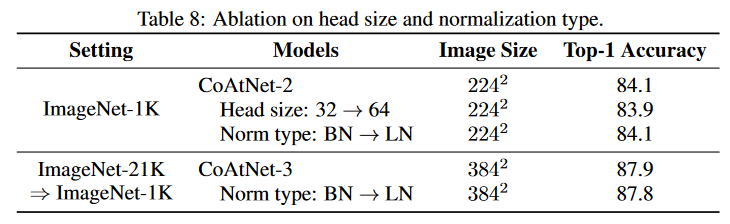

(論文・記事の各章節を貼り付け) 4.3 Ablation Studies In this section, we will ablate our design choices for CoAtNet. Firstly, we study the importance of the relative attention from combining convolution and attention into a single computation unit. Specifically, we compare two models, one with the relative attention and the other without, under both the ImageNet-1K alone and ImageNet-21K transfer setting. As we can see from Table 6, when only the ImageNet-1K is used, relative attention clearly outperforms the standard attention, indicating a better generalization. In addition, under the ImageNet-21K transfer setting, the relative attention variant achieves a substantially better transfer accuracy, despite their very close pre-training performances. This suggests the main advantage of relative attention in visual processing is not in higher capacity but in better generalization. Secondly, as S2 with MBConv blocks and S3 with relative Transformer blocks occupy most of the computation of the CoAtNet, a question to ask is how to split the computation between S2 (MBConv) and S3 (Transformer) to achieve a good performance. In practice, it boils down to deciding the number of blocks to have in each stage, which we will refer to as “layout” design. For this purpose, we compare a few different layouts that we experimented with in Table 7. • If we keep the total number of blocks in S2 and S3 fixed and vary the number in each stage, we observe that V0 is a sweet spot between V1 and V2. Basically, having more Transformer blocks in S3 generally leads to better performance until the number of MBConv blocks in S2 is too small to generalize well. • To further evaluate whether the sweet spot also holds in the transfer setting, where a higher capacity is often regarded more important, we further compare V0 and V1 under the ImageNet- 21K transferring to ImageNet-1K setup. Interestingly, despite that V1 and V0 have the same performance during ImageNet-21K pre-training, the transfer accuracy of V1 clearly falls behind V0. Again, this suggests the importance of convolution in achieving good transferability and generalization. Lastly, we study two choices of model details, namely the dimension of each attention (default to 32) head as well as the type of normalization (default to BatchNorm) used in MBConv blocks. From Table 8, we can see increasing head size from 32 to 64 can slightly hurt performance, though it actually improves the TPU speed by a significant amount. In practice, this will be a quality-speed trade-off one can make. On the other hand, BatchNorm and LayerNorm have almost the same performance, while BatchNorm is 10 - 20% faster on TPU depending on the per-core batch size.上記の内容に関して下記の質問に回答下さい: (である調で記載、質問に対して該当するものが無ければ無しと記載、対応する図/表番号があれば記載)

①何についての記載か? + 要旨は何? (要旨は箇条書きで記載)

②改良点・工夫点・テクニック等の記載があれば説明下さい。

③性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば各文末に記載)

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

⑤具体的な処理方法の記載があれば説明下さい。(簡略化せずに全て記載、既存手法の適用であれば引用元を記載)

▼生成AIの回答(ChatGPT-4o)

①何についての記載か? + 要旨は何?

- 記載内容: この節では、CoAtNetの設計に関するアブレーション研究を行っている。

- 要旨:

- 相対注意機構(relative attention)が一般的な注意機構に対してどれだけ優れているかの検証

- S2のMBConvブロックとS3の相対Transformerブロックの分割(レイアウト)設計の影響の検証

- 注意ヘッドのサイズと正規化手法の選択が性能に与える影響の検証

②改良点・工夫点・テクニック等の記載があれば説明下さい。

- 相対注意機構を採用し、従来の標準的な注意機構に比べてより良い一般化性能を達成している点が挙げられる。

- MBConvブロックとTransformerブロックの間で計算リソースをどのように分配するかの最適な「レイアウト」設計が、性能に大きな影響を与えることが示されている。

- 注意ヘッドのサイズを32に固定することが推奨され、64に増やすことでTPU速度は向上するが、若干の性能低下が発生する。

③性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば各文末に記載)

- 相対注意を使用したモデルは、ImageNet-1Kのみを使用した場合、標準の注意機構を使用したモデルよりも優れた性能を示した(表6)。

- ImageNet-21Kでの転移学習において、相対注意を使用したモデルは、標準の注意機構を使用したモデルと同等の事前学習性能を持ちながら、転移精度が大幅に向上した(表6)。

- S2とS3の分割設計では、V0レイアウトが最適であり、ImageNet-21KからImageNet-1Kへの転移においてもV0がV1よりも優れた精度を示した(表7)。

- 注意ヘッドのサイズを64に増やすことでTPU速度は向上したが、性能は若干低下した(表8)。

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

- 相対注意機構は、一般的な注意機構に比べて視覚処理における一般化能力が高く、特に転移学習において大きな利点がある。これは、相対的な位置関係を考慮することで、視覚データのより良い理解を可能にしているためである。

- MBConvとTransformerブロックの最適な分割設計は、S2での畳み込み処理が不足すると全体の一般化性能が低下する一方で、S3でのTransformerブロックが多い方が性能が向上するため、両者のバランスが重要であることが分かる。

- 注意ヘッドのサイズは、処理効率と精度の間でトレードオフが発生し、サイズを大きくすると速度は向上するが、精度が低下する原因となる。

⑤具体的な処理方法の記載があれば説明下さい。(簡略化せずに全て記載、既存手法の適用であれば引用元を記載)

- 相対注意機構を使用したモデルでは、相対位置埋め込み(relative position embedding)を導入し、各注意ヘッドでの相対的な位置関係を考慮している。

- MBConvブロックは、従来のEfficientNetで使用されているものと同様のアーキテクチャを採用し、S2ステージで畳み込み処理を行う【Tan et al., 2019】。

- S3ステージでは、相対Transformerブロックを使用し、各層で注意メカニズムを適用しながら、高次元特徴の抽出を行っている。

- 注意ヘッドのサイズは、デフォルトで32に設定されており、必要に応じて64に変更可能。BatchNormとLayerNormの選択肢においては、計算効率の観点からBatchNormが推奨されている。

▼質問(人間)

続けて下記の質問に追加で回答下さい:

⑥比較の記載があれば違いを表でまとめて下さい。(対応する図/表番号があれば明記)

⑦上記⑥以外で表に出来そうな部分があれば表でまとめて下さい。(対応する図/表番号があれば記載)

⑧具体的な数値の記載を全て列挙して、表にまとめて下さい。(|数値|説明|の表へ)

⑨具体的な変数名(symbol)の記載を全て列挙して、表にまとめて下さい。(|変数名|説明|の表へ)

⑩図/表があれば、各図/表は何を主張するためのものか(掲載理由・注目ポイント等)を説明下さい。

▼生成AIの回答(ChatGPT-4o)

⑥比較の記載があれば違いを表でまとめて下さい。(対応する図/表番号があれば明記)

| 比較項目 | 相対注意 | 標準注意 | V0レイアウト | V1レイアウト | 注意ヘッドサイズ32 | 注意ヘッドサイズ64 | BatchNorm | LayerNorm |

|---|---|---|---|---|---|---|---|---|

| ImageNet-1K性能 | 優れている(表6) | 劣っている(表6) | 最適(表7) | 劣っている(表7) | 標準性能(表8) | 若干劣化(表8) | 標準(表8) | 同等(表8) |

| ImageNet-21K転移性能 | 大幅に優れている(表6) | 劣っている(表6) | 優れている(表7) | 劣っている(表7) | 標準性能(表8) | 若干劣化(表8) | 10-20%高速(表8) | 同等(表8) |

| TPU速度 | - | - | - | - | 標準(表8) | 向上(表8) | 10-20%高速(表8) | 標準(表8) |

(対応する図/表番号: 表6、表7、表8)

⑦上記⑥以外で表に出来そうな部分があれば表でまとめて下さい。(対応する図/表番号があれば記載)

| レイアウト | S2 (MBConv)ブロック数 | S3 (Transformer)ブロック数 | 性能 |

|---|---|---|---|

| V0 | 中間 | 中間 | 最適 |

| V1 | 少ない | 多い | 劣る |

| V2 | 多い | 少ない | 劣る |

(対応する図/表番号: 表7)

⑧具体的な数値の記載を全て列挙して、表にまとめて下さい。

| 数値 | 説明 |

|---|---|

| 32 | 注意ヘッドのデフォルトサイズ(表8) |

| 64 | 注意ヘッドの増加サイズ。速度向上、性能若干劣化(表8) |

| 10-20% | BatchNormがLayerNormより高速(表8) |

| - | 相対注意が標準注意よりも優れた性能(表6) |

| - | V0レイアウトが他のレイアウトよりも良好な結果を示す(表7) |

| 224x224 | ImageNetデータセットで使用された解像度(表6) |

⑨具体的な変数名(symbol)の記載を全て列挙して、表にまとめて下さい。

| 変数名 | 説明 |

|---|---|

| S2 | MBConvブロックの段階(表7) |

| S3 | Transformerブロックの段階(表7) |

| V0, V1, V2 | レイアウトの異なる設計のバリエーション(表7) |

| BatchNorm | MBConvブロックで使用される標準化手法(表8) |

| LayerNorm | MBConvブロックで使用される標準化手法(表8) |

| Attention Head Size | 注意メカニズムのヘッドサイズ(表8) |

⑩図/表があれば、各図/表は何を主張するためのものか(掲載理由・注目ポイント等)を説明下さい。

- 表6: 相対注意と標準注意を比較した性能表。相対注意が一般化能力および転移学習において優れていることを示すために掲載されている。

- 表7: レイアウト設計の比較を示す表。MBConvとTransformerのブロック数の違いが性能に与える影響を示すために掲載されている。

- 表8: 注意ヘッドサイズや正規化手法の違いが性能に与える影響を示す表。パラメータ変更により速度と性能のトレードオフを示すために掲載されている。

5 Conclusion

▼質問(人間)

質問内容全体はここをクリック

(論文・記事の各章節を貼り付け) 5 Conclusion In this paper, we systematically study the properties of convolutions and Transformers, which leads to a principled way to combine them into a new family of models named CoAtNet. Extensive experiments show that CoAtNet enjoys both good generalization like ConvNets and superior model capacity like Transformers, achieving state-of-the-art performances under different data sizes and computation budgets. Note that this paper currently focuses on ImageNet classification for model development. However, we believe our approach is applicable to broader applications like object detection and semantic segmentation. We will leave them for future work.上記の内容に関して下記の質問に回答下さい: (である調で記載、質問に対して該当するものが無ければ無しと記載、対応する図/表番号があれば記載)

①何についての記載か? + 要旨は何? (要旨は箇条書きで記載)

②改良点・工夫点・テクニック等の記載があれば説明下さい。

③性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば各文末に記載)

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

⑤具体的な処理方法の記載があれば説明下さい。(簡略化せずに全て記載、既存手法の適用であれば引用元を記載)

▼生成AIの回答(ChatGPT-4o)

①何についての記載か? + 要旨は何?

- 何についての記載か?: CoAtNetの結論について述べている。

-

要旨:

- 畳み込みネットワーク(ConvNets)とトランスフォーマー(Transformers)の特性を体系的に研究し、それらを組み合わせた新しいモデルファミリー「CoAtNet」を提案している。

- CoAtNetはConvNetsのような優れた一般化能力と、Transformersのような高いモデル容量を兼ね備えている。

- データサイズや計算リソースに応じて、最先端の性能を達成した。

- この論文はImageNet分類に焦点を当てているが、物体検出やセマンティックセグメンテーションといった他の応用にも適用可能である。

②改良点・工夫点・テクニック等の記載があれば説明下さい。

CoAtNetはConvNetsとTransformersの利点を統合するため、以下の点で改良が行われている。

- ConvNetsの優れた一般化能力と、Transformersの高い表現力を一つのモデルに統合した。

- 異なるデータサイズと計算コストに対して最適な性能を発揮できるように、設計された。

③性能が向上した記載があれば説明下さい。

性能向上については、CoAtNetがImageNet分類において最先端の性能を達成したと記載されている。また、異なるデータサイズや計算リソースの条件下でも、ConvNetsやTransformersを上回る性能を示していると述べられているが、具体的な数値は結論部には記載されていない。

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

CoAtNetのメカニズムについては、ConvNetsの一般化能力とTransformersの高いモデル容量を統合することで、双方の特性を活かしたモデル設計が行われている。この組み合わせによって、広範なデータサイズや計算リソースに対応した高性能なモデルが実現している。

⑤具体的な処理方法の記載があれば説明下さい。

具体的な処理方法は結論部分では記載されていない。ただし、前述の章で述べられているCoAtNetの設計に基づき、畳み込みと注意機構を組み合わせたモデルの開発が行われていることが示唆されている。

A Appendix

A.1 Model Details

▼質問(人間)

質問内容全体はここをクリック

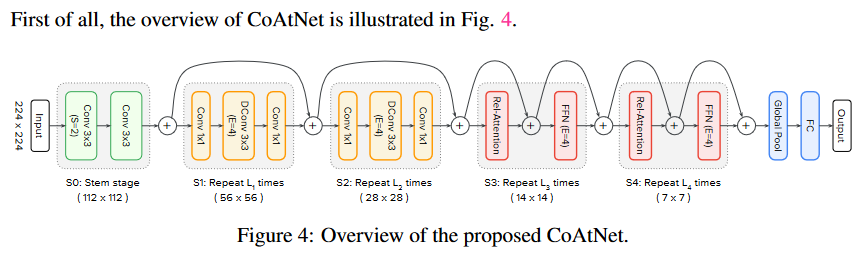

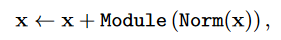

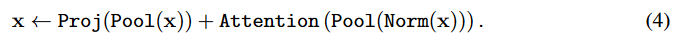

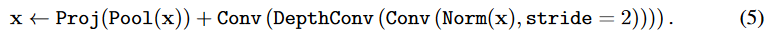

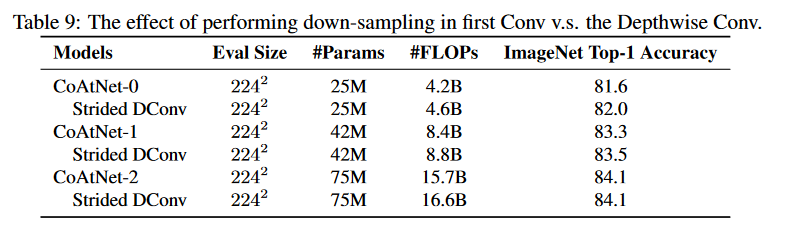

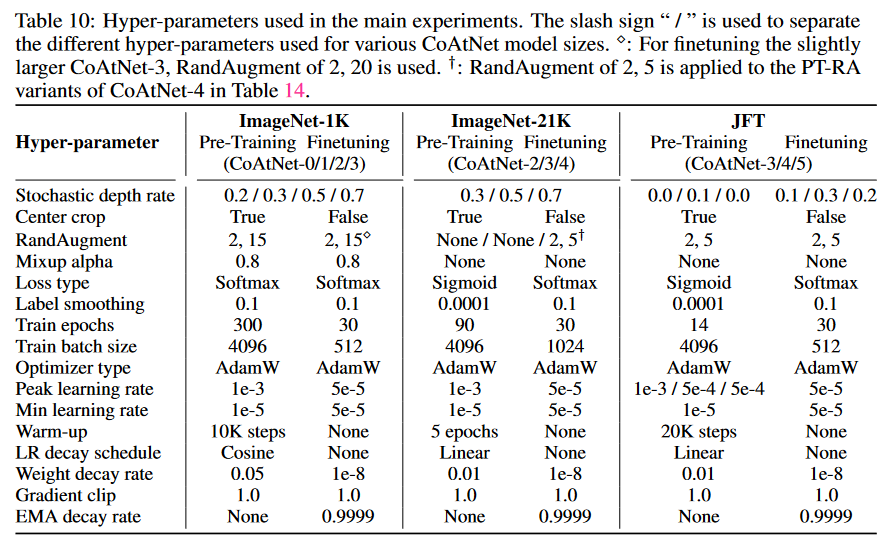

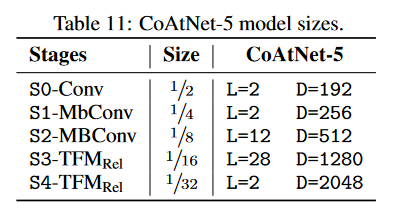

(論文・記事の各章節を貼り付け) A Appendix A.1 Model Details First of all, the overview of CoAtNet is illustrated in Fig. 4. 2D Relative Attention To implement the pre-norm version of relative attention in Eqn. 3 for 2D images of size [H×W ], for each head, we create a trainable parameter P of size [(2H−1)×(2W −1)], as the maximum distance is 2H − 1 and 2W − 1 respectively. Then, for two spatial locations (i, j) and (i′, j′), the corresponding relative bias is Pi−i′+H,j−j′+W under 1-based indexing. For implementation, we need to index H2W 2 elements from the [(2H − 1) × (2W − 1)] matrix. On TPU, we utilize two einsums, along the height and width axis respectively, to index the relative bias with complexity O(HW (H + W )), which is strictly subsumed by the O(H2W 2D) attention complexity. On GPUs, the indexing can be done more efficiently with gather, which only requires memory access. Note that, at inference time, indexing the H2W 2 elements from the [(2H − 1) × (2W − 1)] matrix can be pre-computed and cached to further increase the throughput. When finetuned on a larger resolution, we simply use bi-linear interpolation to increase the size [(2H − 1) × (2W − 1)] to the desired size [(2H′ − 1) × (2W ′ − 1)] for any H′ > H and W ′ > W . Pre-Activation To promote homogeneity in the model architecture, we consistently use pre- activation structure [50] for both the MBConv and the Transformer block, i.e., x ← x + Module (Norm(x)) , where Module denotes the MBConv, Self-Attention or FFN module, while Norm corresponds to BatchNorm for MBConv and LayerNorm for Self-Attention and FFN. We have experimented with using LayerNorm in the MBConv block, which achieves the same performance while being signif- icantly slower on our accelerator (TPU). In general, we recommend whichever is faster on your device. Following the same spirit, Gaussian Error Linear Units (GELUs) [51 ] is used as the activation function in both the MBConv blocks and Transformer blocks. Down-Sampling For the first block inside each stage from S1 to S4, down-sampling is performed independently for the residual branch and the identity branch. Specifically, for the Transformer block, the standard max pooling of stride 2 is directly applied to the input states of both branches of the self-attention module, similar to Funnel Transformer [ 52 ]. Also, a channel projection is applied to the identity branch to enlarge the hidden size. Hence, the down-sampling self-attention module can be expressed as x ← Proj(Pool(x)) + Attention (Pool(Norm(x))) . (4) As for the MBConv block, the down-sampling in the residual branch is instead achieved by using a stride-2 convolution to the normalized inputs, i.e., x ← Proj(Pool(x)) + Conv (DepthConv (Conv (Norm(x), stride = 2)))) . (5) This is different from the standard MBConv where the down-sampling is done by applying stride- 2 depthwise convolution to the inverted bottleneck hidden states. We later found using stride-2 depthwise convolution is helpful but slower when model is small but not so much when model scales, as shown in Table 9. Hence, if not mentioned otherwise, numbers reported in the main text uses the down-sampling implementation in Eqn. (5). In practice, this could be yet another quality-speed trade-off one can tweak for smaller models. Classification head Instead of adding an additional token as in ViT to perform classification, we apply global average pooling to the last-stage output to get the representation for simplicity.上記の内容に関して下記の質問に回答下さい: (である調で記載、質問に対して該当するものが無ければ無しと記載、対応する図/表番号があれば記載)

①何についての記載か? + 要旨は何? (要旨は箇条書きで記載)

②改良点・工夫点・テクニック等の記載があれば説明下さい。

③性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば各文末に記載)

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

⑤具体的な処理方法の記載があれば説明下さい。(簡略化せずに全て記載、既存手法の適用であれば引用元を記載)

▼生成AIの回答(ChatGPT-4o)

①何についての記載か? + 要旨は何?

- 何についての記載か?: CoAtNetのモデル詳細について説明している。

-

要旨:

- 2D相対注意の実装について。

- プリアクティベーション構造の使用。

- 各ステージでのダウンサンプリング手法。

- 分類ヘッドの実装方法。

②改良点・工夫点・テクニック等の記載があれば説明下さい。

- 2D相対注意: 相対注意の計算を効率的に実行するため、2つのeinsum操作を利用している。TPUではこの手法が有効だが、GPUではgather操作がより効率的であり、推論時には事前計算された行列がキャッシュされることでさらにスループットが向上する。

- プリアクティベーション構造: MBConvとTransformerブロックの両方で一貫してプリアクティベーション構造を使用している。これによりモデルの均一性が高まり、BatchNormやLayerNormを使用することで効率的な計算が可能になっている。

- ダウンサンプリング: 各ステージでの最初のブロックにおいて、残差ブランチと恒等写像のブランチで独立したダウンサンプリングが行われる。Transformerブロックでは標準的なmax poolingを使用し、MBConvブロックではstride-2畳み込みを使用する。