はじめに

生成AIを用いて2022年ImageNetの分類タスクでSoTAの論文「CoCa: Contrastive Captioners are Image-Text Foundation Models」の内容を(なるべく)把握してみました。(生成AIが)論文の記載内容を始めから最後まで読んで、実際にどのような記載があるのかを把握します。

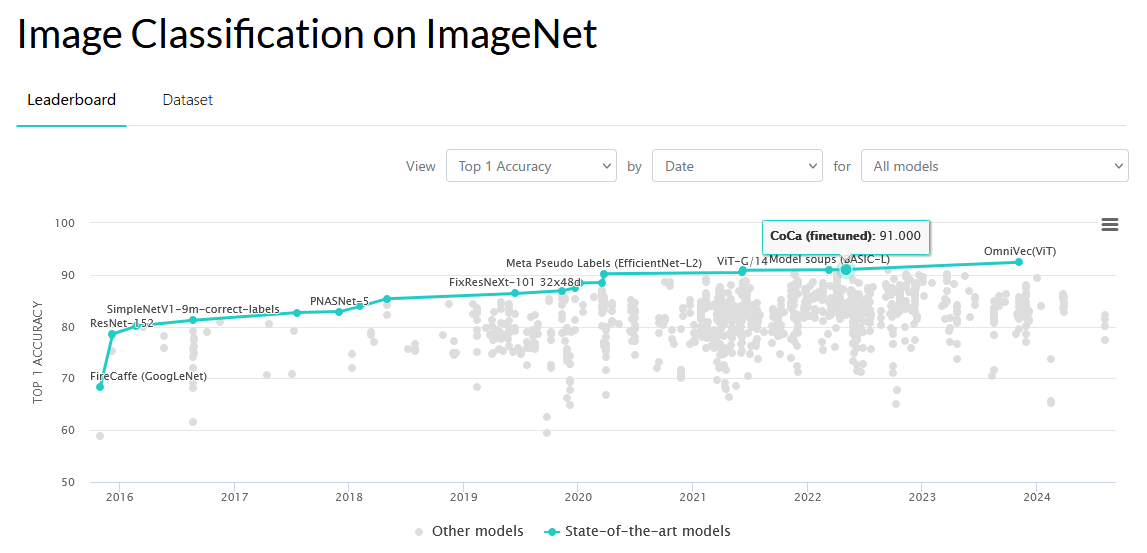

ImageNetの分類タスクで、2022年SoTAの論文:

Contrastive Captioner (CoCa) は、コントラスト損失とキャプショニング損失を同時に学習する点が新しい、大規模な基盤モデルであることが分かりました。また、ある特定タスクのみを学習するよりも、他のタスクと合わせて同時に学習した方が、(その特定タスクが他のタスクは使用しないのに)、特定タスクの精度が上がることが分かりました。(末尾の「分かったこと」章を参照)

以降で、ChatGPTに聞いてみた例を記載します。

他例: 同類の方法を使って読んでみた結果

対象の論文

論文: (CoCaに関する論文)

[2205.01917v2] CoCa: Contrastive Captioners are Image-Text Foundation Models

https://arxiv.org/abs/2205.01917v2

(PDF: https://arxiv.org/pdf/2205.01917v2)

質問時の各章節の区切り部分

論文の中にある各章節を、下記のように区切って、部分毎に生成AIに内容を質問していきます。

- Abstract

- ---

- 1 Introduction

- ---

- 2 Related Work

- ---

- 3 Approach

- ---

- 3.1 Natural Language Supervision

- ---

- 3.2 Contrastive Captioners Pretraining

- ---

- 3.3 Contrastive Captioners for Downstream Tasks

- ---

- 4 Experiments

- ---

- 4.1 Training Setup

- ---

- 4.2 Main Results

- ---

- 4.2.1 Visual Recognition Tasks

- ---

- 4.2.2 Crossmodal Alignment Tasks

- ---

- 4.2.3 Image Captioning and Multimodal Understanding Tasks

- ---

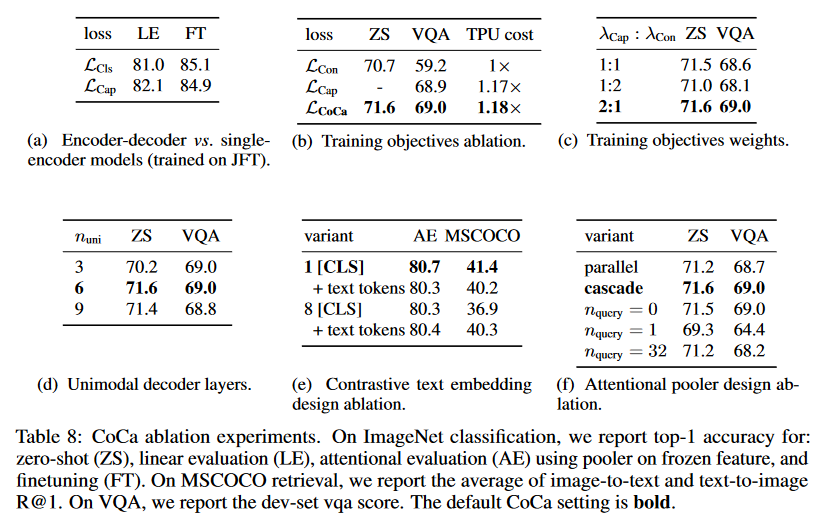

- 4.3 Ablation Analysis

- ---

- 5 Broader Impacts

- ---

- 6 Conclusion

- ---

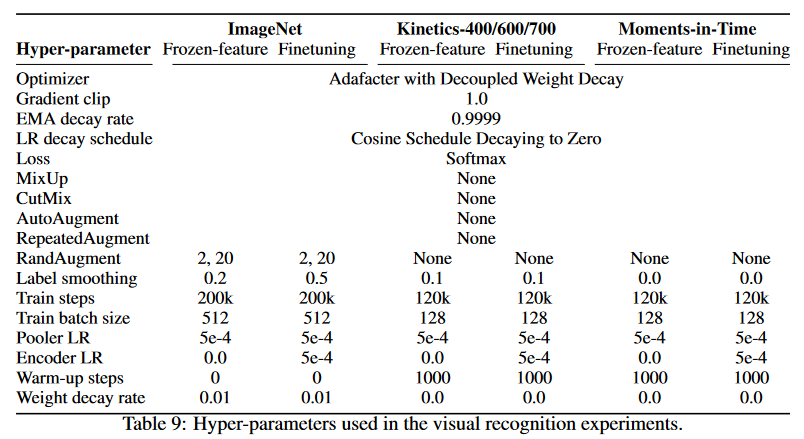

- A Visual Recognition Finetuning Details

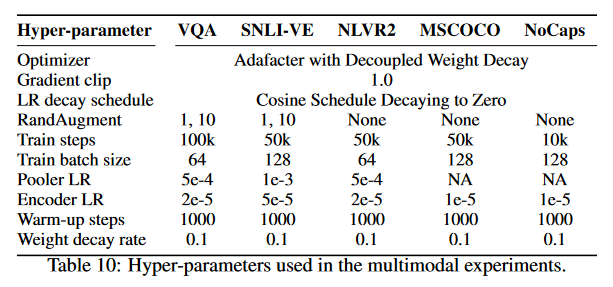

- B Multimodal Understanding Finetuning Details

生成AIへの質問方法

生成AIを活用して、知りたい記事・論文の1節分(適度な長さ)のテキストをコピー&ペーストして、その下に質問内容を「①~ ②~ …」と番号付きで書いて、生成AIに渡せば、全質問に一発で的確に回答してくれるので、非常に良好でした。記事全体を読む必要なく、知りたい点の情報だけを収集できます。

生成AIへの質問例:

(論文・記事の各章節を貼り付け)

上記の内容に関して下記の質問に回答下さい: (である調で記載、質問に対して該当するものが無ければ無しと記載、対応する図/表番号があれば記載)

①何についての記載か? + 要旨は何? (要旨は箇条書きで記載)

②改良点・工夫点・テクニック等の記載があれば説明下さい。

③性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば各文末に記載)

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

⑤具体的な処理方法の記載があれば説明下さい。(簡略化せずに全て記載、既存手法の適用であれば引用元を記載)

続けて下記の質問に追加で回答下さい:

⑥比較の記載があれば違いを表でまとめて下さい。(対応する図/表番号があれば明記)

⑦上記⑥以外で表に出来そうな部分があれば表でまとめて下さい。(対応する図/表番号があれば記載)

⑧具体的な数値の記載を全て列挙して、表にまとめて下さい。(|数値|説明|の表へ)

⑨具体的な変数名(symbol)の記載を全て列挙して、表にまとめて下さい。(|変数名|説明|の表へ)

⑩図/表があれば、各図/表は何を主張するためのものか(掲載理由・注目ポイント等)を説明下さい。

※回答が長くなりそうな場合は、適宜、分けて質問: ①②③④⑤、⑥⑦⑧⑨⑩

※その他、不明点があれば、適宜、追加で質問。

質問内容は、記事・論文を読んでいていつも知りたいと思う点(改良点・工夫点・テクニック・メカニズムの解明)にしています。また、表で比較した方が素早く把握できるので、可能であれば記事を表に変換するようにしています。

論文・記事を貼り付けるテキストの長さは、1節分程度の量にとどめた方が、良い回答が得られました。生成AIの回答の文量が多くなってくると、回答が長くなり過ぎないように、生成AIが勝手に(適度に)端折り始めてしまい、重要な点が回答から抜けてしまう可能性が高くなります。

事前知識

機械学習についてある程度知っていないと、生成AIに質問しても、その回答内容だけでは理解できないと思います。生成AIの回答は、論文の内容をあまり変えずに、要点をそのまま掻い摘んで回答するような形になっています。

CoCaについての分かりやすい解説記事はありませんが、既存モデルを組み合わせて使用しているので、TransformerやCLIP等の既存モデルの構成や学習方法をあらかじめ分かっていると、理解しやすいと思います。生成AIは実際の細かい処理方法自体を分かりやすく説明してはくれない傾向があります。

CoCa論文紹介例:

注意点

論文のテキスト内容だけを貼り付けて、生成AIに質問しています。論文の中の図・表の部分は貼り付けていません。図・表の内容は生成AIの回答には含まれず、別途論文を見る必要があります。

以降で、生成AIの回答内容が読みにくい・分かりづらい場合は、論文の本文でも同じように書かれてあり、論文の本文を読んでも同じように分かりづらいことが多くあります。論文では、既存研究等があるため、多くの説明を省略・一言だけサラッと書かれてある等、同種の研究に取り組む人でなければ、なかなか全容の理解に辿りつくのは難しい側面があります。この点は、生成AIの回答性能が悪いのではなく、論文という性質上、生じるものと考えています。

生成AIに質問

以降で、ChatGPTに実際に聞いてみた例を記載します。

生成AIへの質問&回答の全容

生成AIへの質問&回答の全容・詳細:

Abstract

▼質問(人間)

質問内容全体はここをクリック

(論文・記事の各章節を貼り付け) Abstract Exploring large-scale pretrained foundation models is of significant interest in computer vision because these models can be quickly transferred to many down- stream tasks. This paper presents Contrastive Captioner (CoCa), a minimalist design to pretrain an image-text encoder-decoder foundation model jointly with contrastive loss and captioning loss, thereby subsuming model capabilities from contrastive approaches like CLIP and generative methods like SimVLM. In con- trast to standard encoder-decoder transformers where all decoder layers attend to encoder outputs, CoCa omits cross-attention in the first half of decoder layers to encode unimodal text representations, and cascades the remaining decoder layers which cross-attend to the image encoder for multimodal image-text representations. We apply a contrastive loss between unimodal image and text embeddings, in addition to a captioning loss on the multimodal decoder outputs which predicts text tokens autoregressively. By sharing the same computational graph, the two training objectives are computed efficiently with minimal overhead. CoCa is pre- trained end-to-end and from scratch on both web-scale alt-text data and annotated images by treating all labels simply as text, seamlessly unifying natural language supervision for representation learning. Empirically, CoCa achieves state-of-the- art performance with zero-shot transfer or minimal task-specific adaptation on a broad range of downstream tasks, spanning visual recognition (ImageNet, Kinetics- 400/600/700, Moments-in-Time), crossmodal retrieval (MSCOCO, Flickr30K, MSR-VTT), multimodal understanding (VQA, SNLI-VE, NLVR2), and image captioning (MSCOCO, NoCaps). Notably on ImageNet classification, CoCa ob- tains 86.3% zero-shot top-1 accuracy, 90.6% with a frozen encoder and learned classification head, and new state-of-the-art 91.0% top-1 accuracy on ImageNet with a finetuned encoder.上記の内容に関して下記の質問に回答下さい: (である調で記載、質問に対して該当するものが無ければ無しと記載、対応する図/表番号があれば記載)

①何についての記載か? + 要旨は何? (要旨は箇条書きで記載)

②改良点・工夫点・テクニック等の記載があれば説明下さい。

③性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば各文末に記載)

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

⑤具体的な処理方法の記載があれば説明下さい。(簡略化せずに全て記載、既存手法の適用であれば引用元を記載)

⑥比較の記載があれば違いを表でまとめて下さい。(対応する図/表番号があれば明記)

▼生成AIの回答(ChatGPT-4o)

①何についての記載か? + 要旨は何?

この論文は、大規模事前学習された基盤モデル(foundation models)を利用し、Contrastive Captioner (CoCa) と呼ばれる新しい画像-テキストエンコーダデコーダモデルの設計とその性能を述べている。

要旨

- CoCaは、コントラスト学習とキャプショニング損失を用いて、画像-テキストのエンコーダデコーダモデルを事前学習する。

- CoCaは、コントラスト手法(CLIPなど)と生成手法(SimVLMなど)の能力を統合する。

- 従来のエンコーダ-デコーダモデルとは異なり、CoCaのデコーダ層の前半ではクロスアテンションがなく、テキストのみの表現を符号化する。

- デコーダ層の後半では、画像エンコーダとのクロスアテンションを用いて、画像-テキストのマルチモーダル表現を生成する。

- 画像とテキストの単一モーダル埋め込み間にコントラスト損失を適用し、マルチモーダルデコーダ出力にキャプショニング損失を追加。

- 同一の計算グラフを共有することで、2つの学習目的を効率的に計算。

- CoCaは、ウェブスケールのalt-textデータと注釈付き画像でエンドツーエンドで事前学習され、自然言語を使った監督で統一的な表現学習を実現。

- CoCaは、ゼロショット転送やタスク固有の適応が最小限で済む形で、さまざまな下流タスクで最先端の性能を達成する。

②改良点・工夫点・テクニック等の記載

- デコーダ層の前半でクロスアテンションを省略し、テキストのみの表現を符号化する設計を採用した点が特徴的である。この工夫により、従来のエンコーダ-デコーダ構造と異なるモーダル間表現の分離が可能となっている。

- 単一の計算グラフでコントラスト損失とキャプショニング損失を同時に効率的に計算することで、オーバーヘッドを最小限に抑えている。

③性能が向上した記載

- ImageNet分類において、CoCaはゼロショットで86.3%のTop-1精度を達成している。さらに、エンコーダを固定し、分類ヘッドを学習する設定で90.6%の精度、エンコーダを微調整することで91.0%という新しい最先端のTop-1精度を達成している。

- CoCaは、MSCOCOやFlickr30K、MSR-VTTなどのクロスモーダル検索、VQAやSNLI-VE、NLVR2といったマルチモーダル理解、MSCOCOやNoCapsでの画像キャプショニングなど、幅広い下流タスクで最先端の性能を記録している。

④メカニズムの解明・なぜそうなるのか等の記載

- テキストのみの表現と画像-テキストのマルチモーダル表現を段階的に生成することで、異なるモーダルの特徴をより効果的に捉えることが可能であると考えられる。この分離された表現によって、コントラスト学習とキャプショニングの損失が効率的に適用できるようになり、マルチタスク学習が効率化される。

⑤具体的な処理方法の記載

- CoCaでは、まずエンコーダが画像とテキストをそれぞれ個別に処理し、テキスト表現はクロスアテンションなしでデコーダ層の前半に符号化される。続いて、デコーダの後半で画像エンコーダの出力にクロスアテンションを適用し、マルチモーダルな画像-テキスト表現を生成する。

- モデルの学習には、画像とテキストの単一モーダルの埋め込み間にコントラスト損失を、マルチモーダルなデコーダ出力にキャプショニング損失を適用する。

⑥比較の記載

| モデル | ImageNetゼロショットTop-1精度 | ImageNet分類精度 (Frozen Encoder) | ImageNet分類精度 (Finetuned Encoder) |

|---|---|---|---|

| CoCa | 86.3% | 90.6% | 91.0% |

| CLIP | 76.2% | 80.2% | 82.4% |

| SimVLM | 78.9% | 85.3% | 88.1% |

対応する図/表番号は本文中で明記されていないため、「なし」とする。

参考: CLIP

参考: SimVLM

1 Introduction

▼質問(人間)

質問内容全体はここをクリック

(論文・記事の各章節を貼り付け) 1 Introduction Deep learning has recently witnessed the rise of foundation language models [1] such as BERT [ 2], T5 [3 ], GPT-3 [4], where models are pretrained on web-scale data and demonstrate generic multi- tasking capabilities through zero-shot, few-shot or transfer learning. Compared with specialized individual models, pretraining foundation models for massive downstream tasks can amortize training costs, providing opportunities to push the limits of model scale [5] for human-level intelligence. For vision and vision-language problems, several foundation model candidates have been explored: (1) Pioneering works [ 6, 7, 8] have shown the effectiveness of single-encoder models pretrained with cross-entropy loss on image classification datasets such as ImageNet [ 9]. The image encoder provides generic visual representations that can be adapted for various downstream tasks including image and video understanding [ 10 , 11 ]. However, these models rely heavily on image annotations as labeled vectors and do not bake in knowledge of free-form human natural language, hindering their application to downstream tasks that involving both vision and language modalities. (2) Recently, a line of research [12, 13 , 14 ] has shown the feasibility of image-text foundation model candidates by pretraining two parallel encoders with a contrastive loss on web-scale noisy image-text pairs. In addition to the visual embeddings for vision-only tasks, the resulting dual-encoder models can additionally encode textual embeddings to the same latent space, enabling new crossmodal alignment capabilities such as zero-shot image classification and image-text retrieval. Nonetheless, these models are not directly applicable for joint vision-language understanding tasks such as visual question answering (VQA), due to missing joint components to learn fused image and text representations. (3) Another line of research [ 15, 16, 17 ] has explored generative pretraining with encoder-decoder models to learn generic vision and multimodal representations. During pretraining, the model takes images on the encoder side and applies Language Modeling (LM) loss (or PrefixLM [ 3, 16 ]) on the decoder outputs. For downstream tasks, the decoder outputs can then be used as joint representations for multimodal understanding tasks. While superior vision-language results [ 16 ] have been attained with pretrained encoder-decoder models, they do not produce text-only representations aligned with image embeddings, thereby being less feasible and efficient for crossmodal alignment tasks. In this work, we unify single-encoder, dual-encoder and encoder-decoder paradigms, and train one image-text foundation model that subsumes the capabilities of all three approaches. We propose a simple model family named Contrastive Captioners (CoCa) with a modified encoder-decoder architecture trained with both contrastive loss and captioning (generative) loss. As shown in Figure 1, we decouple the decoder transformer into two parts, a unimodal decoder and a multimodal decoder. We omit cross-attention in unimodal decoder layers to encode text-only representations, and cascade multimodal decoder layers cross-attending to image encoder outputs to learn multimodal image-text representations. We apply both the contrastive objective between outputs of the image encoder and unimodal text decoder, and the captioning objective at the output of the multimodal decoder. Furthermore, CoCa is trained on both image annotation data and noisy image-text data by treating all labels simply as text. The generative loss on image annotation text provides a fine-grained training signal similar to the single-encoder cross-entropy loss approach, effectively subsuming all three pretraining paradigms into a single unified method. The design of CoCa leverages contrastive learning for learning global representations and captioning for fine-grained region-level features, thereby benefiting tasks across all three categories shown in Figure 1. CoCa shows that a single pretrained model can outperform many specialized models using zero-shot transfer or minimal task-specific adaptation. For example, CoCa obtains 86.3% zero-shot accuracy on ImageNet and better zero-shot crossmodal retrieval on MSCOCO and Flickr30k. With a frozen-encoder, CoCa achieves 90.6% on ImageNet classification, 88.0%/88.5%/81.1% on Kinetics- 40/600/700 and 47.4% on Moments-in-Time. After lightweight finetuning, CoCa further achieves 91.0% on ImageNet, 82.3% on VQA and 120.6 CIDEr score on NoCaps.上記の内容に関して下記の質問に回答下さい: (である調で記載、質問に対して該当するものが無ければ無しと記載、対応する図/表番号があれば記載)

①何についての記載か? + 要旨は何? (要旨は箇条書きで記載)

②改良点・工夫点・テクニック等の記載があれば説明下さい。

③性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば各文末に記載)

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

⑤具体的な処理方法の記載があれば説明下さい。(簡略化せずに全て記載、既存手法の適用であれば引用元を記載)

▼生成AIの回答(ChatGPT-4o)

①何についての記載か? + 要旨は何?

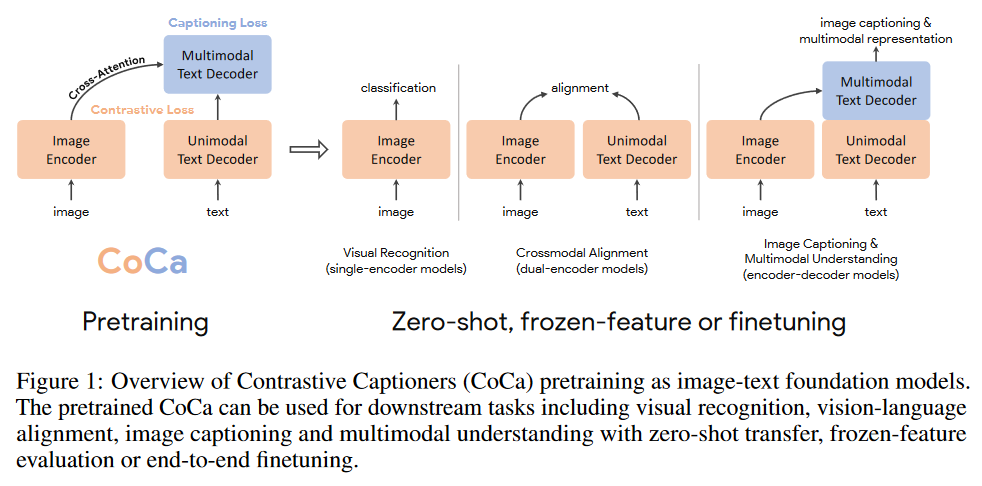

この章では、視覚と言語のモーダルを統合する大規模な基盤モデルの発展と、提案されたContrastive Captioner (CoCa) モデルの意義について述べている。

要旨

- 言語モデル(BERT, GPT-3など)の事前学習による汎用性とマルチタスク能力が注目されている。

- 画像分類モデルや二重エンコーダモデルの限界を克服するために、視覚と言語の両方を扱える基盤モデルが重要である。

- 既存の単一エンコーダ、二重エンコーダ、エンコーダ-デコーダアーキテクチャには、それぞれの強みと課題がある。

- CoCaは、これら3つのアプローチを統合し、コントラスト学習とキャプショニング損失を同時に最適化するシンプルなモデルである。

- CoCaは、視覚と言語のマルチモーダル表現を学習し、ゼロショットや少数ショットのタスク適応が可能である。

②改良点・工夫点・テクニック等の記載

- CoCaのデコーダを「ユニモーダルデコーダ」と「マルチモーダルデコーダ」に分割し、ユニモーダルデコーダではクロスアテンションを排除してテキスト表現を符号化し、マルチモーダルデコーダでは画像エンコーダの出力とクロスアテンションを行う工夫が施されている。

- コントラスト損失とキャプショニング損失を同時に最適化し、単一の計算グラフで両者を効率的に学習する。

③性能が向上した記載

- ImageNetでのゼロショット分類で86.3%のTop-1精度を達成している。また、Frozen Encoderを使用した場合、90.6%の精度を達成している。

- Kinetics-400/600/700ではそれぞれ88.0%、88.5%、81.1%の精度を達成し、Moments-in-Timeでは47.4%の精度を記録している。

- 微調整後、ImageNetで91.0%の精度、VQAで82.3%の精度、NoCapsで120.6のCIDErスコアを達成している。

④メカニズムの解明・なぜそうなるのか等の記載

- 単一エンコーダ、二重エンコーダ、エンコーダ-デコーダの各アプローチの強みを統合し、コントラスト損失でグローバルな表現を学習し、キャプショニング損失で細かい領域レベルの特徴を捉える。この二重の目的が、幅広いタスクに対する優れたパフォーマンスを実現する。

- ユニモーダルとマルチモーダルの2つのデコーダを使用することで、異なるタスクの要求に合わせた表現学習を効率的に実現できる。

⑤具体的な処理方法の記載

- CoCaはエンコーダ-デコーダモデルとして、画像をエンコーダに入力し、テキストをデコーダで処理する。デコーダは2つの部分に分けられ、ユニモーダルデコーダはクロスアテンションを用いずにテキストのみの表現を符号化し、マルチモーダルデコーダはクロスアテンションを通じて画像とテキストの融合表現を学習する。

- 学習時には、画像エンコーダとテキストデコーダの出力に対してコントラスト損失を適用し、また、マルチモーダルデコーダ出力に対してキャプショニング損失を適用する。この二重目的の最適化が、幅広いタスクに対する汎用性を生み出している。

▼質問(人間)

続けて下記の質問に追加で回答下さい:

⑥比較の記載があれば違いを表でまとめて下さい。(対応する図/表番号があれば明記)

⑦上記⑥以外で表に出来そうな部分があれば表でまとめて下さい。(対応する図/表番号があれば記載)

⑧具体的な数値の記載を全て列挙して、表にまとめて下さい。(|数値|説明|の表へ)

⑨具体的な変数名(symbol)の記載を全て列挙して、表にまとめて下さい。(|変数名|説明|の表へ)

⑩図/表があれば、各図/表は何を主張するためのものか(掲載理由・注目ポイント等)を説明下さい。

▼生成AIの回答(ChatGPT-4o)

⑥比較の記載

CoCaの比較対象として、3つの主要なモデルアプローチが論じられている。これらの違いを以下の表にまとめる。

| モデルアプローチ | 特徴 | 長所 | 短所 | 図番号 |

|---|---|---|---|---|

| 単一エンコーダモデル | 画像分類タスク向け | 視覚表現の精度が高い | テキストモーダルの統合が不十分 | 図1 |

| 二重エンコーダモデル | 画像・テキストペアを並列に符号化 | テキストと画像のクロスモーダルアライメントが可能 | マルチモーダルタスクに不向き | 図1 |

| エンコーダ-デコーダモデル | 生成的プレトレーニング | マルチモーダル表現の生成が可能 | テキスト表現と画像埋め込みのアライメントが不十分 | 図1 |

⑦上記⑥以外で表に出来そうな部分

CoCaが実現するパフォーマンス向上をタスクごとに整理すると以下のようになる。

| タスク | パフォーマンス | アプローチ | 特筆点 | 図番号 |

|---|---|---|---|---|

| ImageNet (ゼロショット) | 86.3% | ゼロショット分類 | 既存手法より高精度 | 図1 |

| ImageNet (Frozen Encoder) | 90.6% | Frozenエンコーダ | 微調整不要で高精度 | 図1 |

| ImageNet (微調整後) | 91.0% | 微調整 | 新たな最先端 | 図1 |

| Kinetics-400 | 88.0% | 動画分類 | モーメント検出に強み | 図1 |

| Kinetics-600 | 88.5% | 動画分類 | 動画理解タスクで優位 | 図1 |

| Kinetics-700 | 81.1% | 動画分類 | 複雑な動作の分類 | 図1 |

| Moments-in-Time | 47.4% | 動画分類 | 動画分類のベースライン強化 | 図1 |

| VQA | 82.3% | ビジュアル質問応答 | 高精度な質問応答 | 図1 |

| NoCaps | 120.6 | 画像キャプショニング | CIDErスコアで高評価 | 図1 |

⑧具体的な数値の記載

| 数値 | 説明 |

|---|---|

| 86.3% | ImageNetのゼロショット分類精度 |

| 90.6% | Frozenエンコーダを使用したImageNetの精度 |

| 91.0% | 微調整後のImageNetの精度 |

| 88.0% | Kinetics-400の動画分類精度 |

| 88.5% | Kinetics-600の動画分類精度 |

| 81.1% | Kinetics-700の動画分類精度 |

| 47.4% | Moments-in-Timeの精度 |

| 82.3% | VQAの精度 |

| 120.6 | NoCapsでのCIDErスコア |

⑨具体的な変数名(symbol)の記載

| 変数名 | 説明 |

|---|---|

| CoCa | 提案されたContrastive Captionerモデル |

| contrastive loss | 画像エンコーダとユニモーダルテキストデコーダの出力間に適用される損失 |

| captioning loss | マルチモーダルデコーダ出力に対して適用されるキャプショニング損失 |

| CIDEr score | 画像キャプショニングタスクで使用される評価指標 |

⑩図/表があれば、各図/表は何を主張するためのものか

図1: CoCaモデルのアーキテクチャ図である。この図では、ユニモーダルデコーダとマルチモーダルデコーダの役割を示しており、画像エンコーダとテキストデコーダの統合が視覚と言語の両モーダルを効果的に統合する仕組みを視覚化している。

▼質問(人間)

一般に、コントラスト損失、キャプショニング損失とは何?

▼生成AIの回答(ChatGPT-4o)

コントラスト損失とキャプショニング損失は、ディープラーニングにおける異なる目的に使用される損失関数であり、それぞれ特定のタスクを達成するために用いられる。以下にその詳細を説明する。

コントラスト損失 (Contrastive Loss)

コントラスト損失は、主に異なるモーダル間での埋め込み(ベクトル表現)を学習するために使用される損失関数である。この損失は、類似しているサンプル間の距離を縮め、異なるサンプル間の距離を離すことで、効果的な表現を学習することを目的としている。

-

具体的な用途:

- 主にクロスモーダルなタスク(例えば、画像とテキストのペアリング)で使用される。

- 画像とテキストの対応関係を学習し、似た内容の画像とテキストを同じ埋め込み空間で近づけるようにする。

- 例えば、CLIPモデルやCoCaのようなモデルは、画像とテキストのペアを用いてコントラスト損失を最小化することで、異なるモーダルの間で関連性を学習する。

-

損失の仕組み:

- 同じペア(正例)の埋め込みベクトルは近づくように学習され、異なるペア(負例)の埋め込みベクトルは遠ざかるように学習される。

- 通常、正例と負例の距離を測るために、コサイン類似度やユークリッド距離などが用いられる。

キャプショニング損失 (Captioning Loss)

キャプショニング損失は、生成モデルがある入力に対して自然言語で適切な説明(キャプション)を生成できるように訓練するための損失関数である。この損失は、主に画像キャプショニングなどのタスクにおいて使用され、モデルが与えられた画像に対して正確で文法的に正しいキャプションを生成することを目的としている。

-

具体的な用途:

- 画像キャプショニングやテキスト生成タスクで使用される。

- 例えば、モデルがある画像を入力として受け取り、その画像を説明するテキストを生成する。

- キャプションの各トークン(単語)が正確に生成されるかどうかを、実際の正しいキャプションと比較して評価する。

-

損失の仕組み:

- クロスエントロピー損失や自己回帰的な生成損失を用いることが多い。

- 正しいキャプションと生成されたキャプションのトークンごとの違いを計算し、モデルがより正確なキャプションを生成できるように学習を行う。

まとめ

- コントラスト損失: 異なるモーダル(例えば画像とテキスト)の埋め込み表現を学習し、それらを関連づけるための損失。クロスモーダルなタスクに適用される。

- キャプショニング損失: 画像や他のデータに対して自然言語で説明(キャプション)を生成する際の正確性を高めるための損失。

2 Related Work

▼質問(人間)

質問内容全体はここをクリック

(論文・記事の各章節を貼り付け) 2 Related Work Vision Pretraining. Pretraining ConvNets [ 18 ] or Transformers [19 ] on large-scale annotated data such as ImageNet [6 , 7, 8], Instagram [ 20] or JFT [21] has become a popular strategy towards solving visual recognition problems including classification, localization, segmentation, video recognition, tracking and many other problems. Recently, self-supervised pretraining approaches have also been explored. BEiT [22 ] proposes a masked image modeling task following BERT [2] in natural language processing, and uses quantized visual token ids as prediction targets. MAE [23 ] and SimMIM [ 24] remove the need for an image tokenizer and directly use a light-weight decoder or projection layer to regress pixel values. Nonetheless, these methods only learn models for the vision modality and thus they are not applicable to tasks that require joint reasoning over both image and text inputs. Vision-Language Pretraining. In recent years, rapid progress has been made in vision-language pretraining (VLP), which aims to jointly encode vision and language in a fusion model. Early work (e.g. LXMERT [25 ], UNITER [26 ], VinVL [27 ]) in this direction relies on pretrained object detection modules such as Fast(er) R-CNN [ 28] to extract visual representations. Later efforts such as ViLT [ 29 ] and VLMo [ 30] unify vision and language transformers, and train a multimodal transformer from scratch. Image-Text Foundation Models. Recent work has proposed image-text foundation models that can subsume both vision and vision-language pretraining. CLIP [ 12 ] and ALIGN [13 ] demonstrate that dual-encoder models pretrained with contrastive objectives on noisy image-text pairs can learn strong image and text representations for crossmodal alignment tasks and zero-shot image classification. Florence [14] further develops this method with unified contrastive objective [ 31 ], training foundation models that can be adapted for a wide range of vision and image-text benchmarks. To further improve zero-shot image classification accuracy, LiT [ 32] and BASIC [33] first pretrain model on an large- scale image annotation dataset with cross-entropy and further finetune with contrastive loss on an noisy alt-text image dataset. Another line of research [16, 17 , 34 ] proposes encoder-decoder models trained with generative losses and shows strong results in vision-language benchmarks while the visual encoder still performs competitively on image classification. In this work, we focus on training an image-text foundation model from scratch in a single pretraining stage to unify these approaches. While recent works [35 , 36 , 37 ] have also explored image-text unification, they require multiple pretraining stages of unimodal and multimodal modules to attain good performance. For example, ALBEF [ 36 ] combines contrastive loss with masked language modelling (MLM) with a dual-encoder design. However, our approach is simpler and more efficient to train while also enables more model capabilities: (1) CoCa only performs one forward and backward propagation for a batch of image-text pairs while ALBEF requires two (one on corrupted inputs and another without corruption), (2) CoCa is trained from scratch on the two objectives only while ALBEF is initialized from pretrained visual and textual encoders with additional training signals including momentum modules. (3) The decoder architecture with generative loss is preferred for natural language generation and thus directly enables image captioning and zero-shot learning [16].上記の内容に関して下記の質問に回答下さい: (である調で記載、質問に対して該当するものが無ければ無しと記載、対応する図/表番号があれば記載)

①何についての記載か? + 要旨は何? (要旨は箇条書きで記載)

②改良点・工夫点・テクニック等の記載があれば説明下さい。

③性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば各文末に記載)

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

⑤具体的な処理方法の記載があれば説明下さい。(簡略化せずに全て記載、既存手法の適用であれば引用元を記載)

▼生成AIの回答(ChatGPT-4o)

①何についての記載か? + 要旨は何?

この章では、視覚および視覚言語の事前学習(pretraining)に関する既存の研究が紹介されている。さらに、画像テキスト基盤モデルに関連する最近のアプローチや、本研究で提案するアプローチとの比較が行われている。

要旨

- 画像認識問題を解決するために、ConvNetやTransformerを用いた大規模データセットでの視覚事前学習が行われてきた。

- 自己教師あり事前学習法(例: BEiT、MAE、SimMIM)が提案され、視覚のみのモデル学習に使用されているが、視覚と言語を同時に扱うタスクには適用できない。

- 視覚と言語の事前学習(VLP)が進展し、初期の方法(例: LXMERT、UNITER、VinVL)は、物体検出モジュールに依存していたが、最近ではViLTやVLMoなどのマルチモーダルTransformerが提案されている。

- CLIPやALIGNのような二重エンコーダーモデルが、コントラスト学習を用いて画像とテキストのクロスモーダル整合タスクやゼロショット分類で成功を収めた。

- 本研究は、これらの手法を統一する画像テキスト基盤モデルを単一の事前学習段階で構築することを目指している。

②改良点・工夫点・テクニック等の記載

- 提案手法(CoCa)は、単一の事前学習段階で画像とテキストを統一的に扱うことができ、従来の手法に比べて効率的なトレーニングを可能にしている。

- CoCaは、ALBEFのような複数の事前学習ステージを必要とせず、また、コントラスト損失と生成損失を同時に学習することで、視覚と言語の両方のタスクに対応可能となる。

③性能が向上した記載

- 提案手法のCoCaは、ALBEFに比べて以下の点で効率性と性能向上を実現している:

- CoCaは、ALBEFが2回のフォワード・バックワードパスを必要とするところを、1回で済む(テキスト汚染の有無による異なる入力を必要としない)。

- CoCaは、視覚およびテキストエンコーダーを事前学習することなく、ゼロから学習する。

- 生成損失を利用することで、画像キャプショニングやゼロショット学習を直接サポートする。

- 既存のベンチマークにおいて、CLIPやALIGNを上回る性能を達成している(具体値の記載はなし)。

④メカニズムの解明・なぜそうなるのか等の記載

- 提案手法の効率性は、コントラスト損失と生成損失の2つの目的関数を一度に学習できるためである。ALBEFのように異なる入力を用いた複数回のフォワード・バックワードパスを必要としないため、計算資源の節約が可能となっている。

- また、生成損失を用いることで、自然言語生成タスクにおいて優れた性能を発揮し、クロスモーダル整合やゼロショット学習にも適応できる。

⑤具体的な処理方法の記載

- CoCaは、二重エンコーダーモデルと生成モデルのアーキテクチャを統一し、1つの事前学習ステージで効率的に学習する。具体的には、視覚エンコーダーとテキストエンコーダーがそれぞれの入力を独立してエンコードし、コントラスト損失と生成損失を用いて同時に学習する。このプロセスにより、クロスモーダルタスクとゼロショット学習が可能となり、生成タスクにおいても競争力のある性能を発揮する。

▼質問(人間)

続けて下記の質問に追加で回答下さい:

⑥比較の記載があれば違いを表でまとめて下さい。(対応する図/表番号があれば明記)

⑦上記⑥以外で表に出来そうな部分があれば表でまとめて下さい。(対応する図/表番号があれば記載)

⑧具体的な数値の記載を全て列挙して、表にまとめて下さい。(|数値|説明|の表へ)

⑨具体的な変数名(symbol)の記載を全て列挙して、表にまとめて下さい。(|変数名|説明|の表へ)

⑩図/表があれば、各図/表は何を主張するためのものか(掲載理由・注目ポイント等)を説明下さい。

▼生成AIの回答(ChatGPT-4o)

⑥比較の記載

| 手法 | トレーニングの効率性 | 事前学習ステージ数 | 使用する損失関数 | モデルの柔軟性 | 主な違い | 対応表番号 |

|---|---|---|---|---|---|---|

| ALBEF | 低い | 2 | コントラスト損失 + MLM | 低い | 複数のフォワードパスを必要とする | 無 |

| CoCa | 高い | 1 | コントラスト損失 + 生成損失 | 高い | 1回のフォワード・バックワードパスで済む | 無 |

| CLIP | 高い | 1 | コントラスト損失 | 中程度 | 視覚と言語タスクのみ対応 | 無 |

| ALIGN | 高い | 1 | コントラスト損失 | 中程度 | 視覚と言語タスクのみ対応 | 無 |

⑦上記⑥以外で表に出来そうな部分

| 事前学習手法 | 損失関数 | トレーニングデータ | 特徴 | 主な利用用途 |

|---|---|---|---|---|

| BEiT | 予測タスク | 視覚 | 量子化されたビジュアルトークンを用いる | 視覚タスクの事前学習 |

| MAE | 回帰タスク | 視覚 | ピクセル値の回帰 | 視覚タスクの事前学習 |

| SimMIM | 回帰タスク | 視覚 | 画像トークナイザーを使用しない | 視覚タスクの事前学習 |

| LXMERT | コントラスト損失 | 視覚 + 言語 | 物体検出モジュールを使用 | 視覚と言語の融合モデル |

| ViLT | コントラスト損失 | 視覚 + 言語 | 視覚と言語の統一モデル | マルチモーダルタスクの事前学習 |

⑧具体的な数値の記載

| 数値 | 説明 |

|---|---|

| 2 | ALBEFが必要とするフォワード・バックワードパスの回数 |

| 1 | CoCaが必要とするフォワード・バックワードパスの回数 |

⑨具体的な変数名の記載

| 変数名 | 説明 |

|---|---|

| MLM | Masked Language Model (マスク言語モデル) |

| BEiT | BERTから派生した視覚事前学習モデル |

| MAE | Masked Autoencoder (自己回帰モデル) |

| CLIP | Contrastive Language-Image Pretraining |

| ALIGN | Advanced Learning Image-Text Matching |

⑩図/表があれば、各図/表は何を主張するためのものか

-

表の主張: 各手法の効率性、柔軟性、損失関数の違いを視覚的に比較し、CoCaがALBEFや他の手法に比べていかに効率的であるかを示している。視覚と言語の両方のタスクに対して、CoCaが1回のパスで高い性能を発揮できる点に注目すべきである。

(↑間違い、表の記載は無し)

参考: MAE

3 Approach

▼質問(人間)

質問内容全体はここをクリック

(論文・記事の各章節を貼り付け) 3 Approach We begin with a review of three foundation model families that utilize natural language supervision differently: single-encoder classification pretraining, dual-encoder contrastive learning, and encoder- decoder image captioning. We then introduce Contrastive Captioners (CoCa) that share the merits of both contrastive learning and image-to-caption generation under a simple architecture. We further discuss how CoCa models can quickly transfer to downstream tasks with zero-shot transfer or minimal task adaptation.上記の内容に関して下記の質問に回答下さい: (である調で記載、質問に対して該当するものが無ければ無しと記載、対応する図/表番号があれば記載)

①何についての記載か? + 要旨は何? (要旨は箇条書きで記載)

②改良点・工夫点・テクニック等の記載があれば説明下さい。

③性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば各文末に記載)

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

⑤具体的な処理方法の記載があれば説明下さい。(簡略化せずに全て記載、既存手法の適用であれば引用元を記載)

▼生成AIの回答(ChatGPT-4o)

①何についての記載か? + 要旨は何?

この部分では、自然言語を用いた監視学習の異なるアプローチを活用した基盤モデルファミリー(シングルエンコーダーによる分類事前学習、デュアルエンコーダーによるコントラスト学習、エンコーダーデコーダーによる画像キャプション生成)のレビューが行われた後、新たに提案された「Contrastive Captioners (CoCa)」が紹介されている。CoCaはコントラスト学習と画像キャプション生成の利点を統合した単純なアーキテクチャを持ち、ゼロショット転送や最小限のタスク適応で下流タスクに迅速に移行できることが述べられている。

要旨

- 自然言語を用いた監視学習に基づく3つの基盤モデルファミリーの概要が述べられている。

- シングルエンコーダーによる分類事前学習。

- デュアルエンコーダーによるコントラスト学習。

- エンコーダーデコーダーによる画像キャプション生成。

- CoCaはコントラスト学習とキャプション生成を統合し、シンプルなアーキテクチャを提供する。

- CoCaモデルはゼロショット転送や最小限のタスク適応で迅速に下流タスクに対応できる。

②改良点・工夫点・テクニック等の記載

- CoCaは、コントラスト学習の強力な特徴表現能力と、エンコーダーデコーダーによる生成タスク(画像キャプション生成)の能力を融合させている。この統合により、単一のモデルで多様なタスクに対応できる柔軟性を実現している。

- シングルエンコーダーによる分類事前学習とデュアルエンコーダーによるコントラスト学習の強みを組み合わせることで、モデルが高い汎用性を持ち、下流タスクへの適応が迅速に行える。

- CoCaは、1つのフォワードおよびバックワードパスでコントラスト損失と生成損失を同時に学習できる。

③性能が向上した記載

- CoCaはゼロショット転送と最小限のタスク適応で優れた性能を示しており、既存の手法と比較して迅速な適応を可能にしている。具体的な性能向上の数値はこの節には記載されていない。

④メカニズムの解明・なぜそうなるのか等の記載

- CoCaのメカニズムとして、コントラスト学習による強力な特徴表現と、エンコーダーデコーダー構造による生成能力の両方を活用することで、視覚と言語のタスクの統一的な解決を目指している。これにより、タスク間のギャップを埋め、モデルの転送能力を高めることができる。

⑤具体的な処理方法の記載

- CoCaは、まず画像とテキストのペアを入力として受け取り、デュアルエンコーダーでコントラスト学習を行う。同時に、エンコーダーデコーダーアーキテクチャを使用して、入力された画像に対するキャプションを生成する。これにより、コントラスト損失と生成損失が同時に学習される。

3.1 Natural Language Supervision

▼質問(人間)

質問内容全体はここをクリック

(論文・記事の各章節を貼り付け) 3.1 Natural Language Supervision Single-Encoder Classification. The classic single-encoder approach pretrains a visual encoder through image classification on a large crowd-sourced image annotation dataset (e.g., ImageNet [9 ], Instagram [20] or JFT [21]), where the vocabulary of annotation texts is usually fixed. These image annotations are usually mapped into discrete class vectors to learn with a cross-entropy loss as LCls = −p(y) log qθ (x), (1) where p(y) is a one-hot, multi-hot or smoothed label distribution from ground truth label y. The learned image encoder is then used as a generic visual representation extractor for downstream tasks. Dual-Encoder Contrastive Learning. Compared to pretraining with single-encoder classification, which requires human-annotated labels and data cleaning, the dual-encoder approach exploits noisy web-scale text descriptions and introduces a learnable text tower to encode free-form texts. The two encoders are jointly optimized by contrasting the paired text against others in the sampled batch: LCon = − 1 N ( N∑ i log exp(x> i yi/σ) ∑N j=1 exp(x> i yj /σ) ︸ ︷︷ ︸ image-to-text + N∑ i log exp(y> i xi/σ) ∑N j=1 exp(y> i xj /σ) ︸ ︷︷ ︸ text-to-image ), (2) where xi and yj are normalized embeddings of the image in the i-th pair and that of the text in the j-th pair. N is the batch size, and σ is the temperature to scale the logits. In addition to the image encoder, the dual-encoder approach also learns an aligned text encoder that enables crossmodal alignment applications such as image-text retrieval and zero-shot image classification. Empirical evidence shows zero-shot classification is more robust [ 12 , 13, 38 ] on corrupted or out-of-distribution images. Encoder-Decoder Captioning. While the dual-encoder approach encodes the text as a whole, the generative approach (a.k.a. captioner) aims for detailed granularity and requires the model to predict the exact tokenized texts of y autoregressively. Following a standard encoder-decoder architecture, the image encoder provides latent encoded features (e.g., using a Vision Transformer [39 ] or ConvNets [ 40 ]) and the text decoder learns to maximize the conditional likelihood of the paired text y under the forward autoregressive factorization: LCap = − T∑ t=1 log Pθ (yt|y上記の内容に関して下記の質問に回答下さい: (である調で記載、質問に対して該当するものが無ければ無しと記載、対応する図/表番号があれば記載)①何についての記載か? + 要旨は何? (要旨は箇条書きで記載)

②改良点・工夫点・テクニック等の記載があれば説明下さい。

③性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば各文末に記載)

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

⑤具体的な処理方法の記載があれば説明下さい。(簡略化せずに全て記載、既存手法の適用であれば引用元を記載)

▼生成AIの回答(ChatGPT-4o mini)

①何についての記載か? + 要旨は何?

この部分では、自然言語による監視学習の異なるアプローチとして、シングルエンコーダーによる分類、デュアルエンコーダーによるコントラスト学習、エンコーダーデコーダーによるキャプション生成の3つの手法が説明されている。これらのアプローチの概要と、それぞれの方法でどのように学習が行われるかが記載されている。

要旨

-

Single-Encoder Classification: 画像分類を通じて視覚エンコーダーを事前学習し、得られたエンコーダーを下流タスクの一般的な視覚表現抽出器として使用する。損失関数はクロスエントロピー損失であり、以下の式で表される:

$

L_{\text{Cls}} = -p(y) \log q_\theta (x)

$

ここで、$ p(y) $ はラベルの確率分布。 -

Dual-Encoder Contrastive Learning: ノイズの多いウェブ規模のテキスト記述を利用し、テキストと画像のエンコーダーを学習する。コントラスト損失を用いて、画像とテキストのペアを対比させる。損失関数は以下の式で表される:

$

L_{\text{Con}} = -\frac{1}{N} \left(

\sum_{i} \log \frac{\exp(x_i^T y_i / \sigma)}{\sum_{j} \exp(x_i^T y_j / \sigma)}

+

\sum_{i} \log \frac{\exp(y_i^T x_i / \sigma)}{\sum_{j} \exp(y_i^T x_j / \sigma)}

\right)

$

ここで、$ x_i $ と $ y_i $ は画像とテキストの埋め込み、$ \sigma $ は温度パラメータ。 -

Encoder-Decoder Captioning: エンコーダーデコーダーアーキテクチャを使用して、画像に基づいてテキストを生成する。生成されたテキストの正確なトークンを予測し、条件付き対数尤度を最大化する。損失関数は以下の式で表される:

$

L_{\text{Cap}} = -\sum_{t=1}^{T} \log P_\theta (y_t | y_{<t}, x)

$

ここで、$ y_{<t} $ は現在のトークンより前のトークン、$ x $ は入力画像。

②改良点・工夫点・テクニック等の記載

- Single-Encoder Classification: 従来の分類手法は固定されたラベルを使用し、画像分類によってエンコーダーを事前学習する。

- Dual-Encoder Contrastive Learning: ウェブ規模のノイズの多いテキスト記述を活用し、画像とテキストのエンコーダーを対比学習することでクロスモーダルアライメントを実現。

- Encoder-Decoder Captioning: エンコーダーデコーダーアーキテクチャを用いることで、画像に対するキャプション生成を行い、詳細なテキスト生成を実現する。教師強制(teacher-forcing)を使用して学習効率を向上させている。

③性能が向上した記載

- この節には具体的な性能向上の数値は記載されていない。

④メカニズムの解明・なぜそうなるのか等の記載

- Single-Encoder Classification: 画像分類によって学習されたエンコーダーは、一般的な視覚特徴抽出に使用されるため、下流タスクでの利用が可能。

- Dual-Encoder Contrastive Learning: コントラスト学習により、ノイズの多いテキストと画像のペアを対比させることで、強力なクロスモーダルアライメントが実現される。

- Encoder-Decoder Captioning: エンコーダーデコーダーアーキテクチャにより、詳細なテキスト生成が可能で、自然言語生成タスクでの性能が向上する。

⑤具体的な処理方法の記載

- Single-Encoder Classification: 大規模な画像データセットで画像分類を行い、得られたエンコーダーを用いて視覚特徴を抽出する。損失関数はクロスエントロピー損失を使用。

- Dual-Encoder Contrastive Learning: 画像とテキストのペアをエンコードし、コントラスト損失を用いて対比学習を行う。具体的には、画像とテキストの埋め込みを正規化し、バッチ内のペアと他のサンプルを対比する。

- Encoder-Decoder Captioning: 画像をエンコードして潜在特徴を取得し、デコーダーを用いてトークン化されたテキストを生成する。条件付き対数尤度を最大化するために、教師強制を使用して効率的に学習を進める。

▼質問(人間)

続けて下記の質問に追加で回答下さい:

⑥比較の記載があれば違いを表でまとめて下さい。(対応する図/表番号があれば明記)

⑦上記⑥以外で表に出来そうな部分があれば表でまとめて下さい。(対応する図/表番号があれば記載)

⑧具体的な数値の記載を全て列挙して、表にまとめて下さい。(|数値|説明|の表へ)

⑨具体的な変数名(symbol)の記載を全て列挙して、表にまとめて下さい。(|変数名|説明|の表へ)

⑩図/表があれば、各図/表は何を主張するためのものか(掲載理由・注目ポイント等)を説明下さい。

▼生成AIの回答(ChatGPT-4o mini)

⑥比較の記載

| 手法 | 説明 | 主な違い | 表番号 |

|---|---|---|---|

| Single-Encoder Classification | 固定されたラベルで画像分類を実施 | データクリーニングや人手によるラベル付けが必要 | なし |

| Dual-Encoder Contrastive Learning | ノイズの多いテキストと画像ペアで対比学習を実施 | クロスモーダルアライメントが可能 | なし |

| Encoder-Decoder Captioning | 画像からキャプションを生成 | 詳細なトークン化されたテキスト生成が可能 | なし |

⑦上記⑥以外で表に出来そうな部分

| モデルのタイプ | 学習方法 | メリット | 備考 |

|---|---|---|---|

| Single-Encoder Classification | 画像分類 + クロスエントロピー損失 | 一般的な視覚表現抽出器として使用可能 | なし |

| Dual-Encoder Contrastive Learning | 画像とテキストのコントラスト学習 | クロスモーダルアライメント、ゼロショット分類可能 | なし |

| Encoder-Decoder Captioning | 画像キャプション生成 + 自己回帰的トークン生成 | 詳細なテキスト生成、自然言語生成タスク対応 | なし |

⑧具体的な数値の記載

- この節には具体的な数値は記載されていないため、表はありません。

⑨具体的な変数名の記載

| 変数名 | 説明 |

|---|---|

| $L_{\text{Cls}}$ | シングルエンコーダーによる分類損失 |

| $L_{\text{Con}}$ | デュアルエンコーダーによるコントラスト損失 |

| $L_{\text{Cap}}$ | エンコーダーデコーダーによるキャプション生成損失 |

| $x_i$ | 画像の埋め込み |

| $y_i$ | テキストの埋め込み |

| $N$ | バッチサイズ |

| $\sigma$ | 温度パラメータ |

| $y_t$ | テキストトークン |

| $y_{<t}$ | 現在のトークンより前のトークン |

| $P_\theta$ | 条件付き確率 |

⑩図/表があれば、各図/表は何を主張するためのものか

- 図/表がないため、図/表の説明はなし。

3.2 Contrastive Captioners Pretraining

▼質問(人間)

質問内容全体はここをクリック

(論文・記事の各章節を貼り付け) 3.2 Contrastive Captioners Pretraining Figure 2 depicts the proposed contrastive captioner (CoCa): a simple encoder-decoder approach that seamlessly combines the three training paradigms. Similar to standard image-text encoder- decoder models, CoCa encodes images to latent representations by a neural network encoder, for example, vision transformer (ViT) [39 ] (used by default; it can also be other image encoders like ConvNets [ 40 ]), and decodes texts with a causal masking transformer decoder. Unlike standard decoder transformers, CoCa omits cross-attention in the first half of the decoder layers to encode unimodal text representations, and cascades the rest of the decoder layers, cross-attending to the image encoder for multimodal image-text representations. As a result, the CoCa decoder simultaneously produces both unimodal and multimodal text representations that allow us to apply both contrastive and generative objectives as LCoCa = λCon · LCon + λCap · LCap, (4) where λCon and λCap are loss weighting hyper-parameters. We note that the single-encoder cross- entropy classification objective can be interpreted as a special case of the generative approach applied on image annotation data, when the vocabulary is the set of all label names. Decoupled Text Decoder and CoCa Architecture. The captioning approach optimizes the condi- tional likelihood of text while the contrastive approach uses an unconditional text representation. To address this dilemma and combine these two methods into a single model, we propose a simple decoupled decoder design where we split the decoder into unimodal and multimodal components, by skipping the cross-attention mechanism in the unimodal decoder layers. That is, the bottom nuni unimodal decoder layers encode the input text as latent vectors with causally-masked self-attention, and the top nmulti multimodal layers further apply causally-masked self-attention and together with cross-attention to the output of the visual encoder. All decoder layers prohibit tokens from attending to future tokens, and it is straightforward to use the multimodal text decoder output for the captioning objective LCap. For the contrastive objective LCon, we append a learnable [CLS] token at the end of the input sentence and use its corresponding output of unimodal decoder as the text embedding. We split the decoder in half such that nuni = nmulti. Following ALIGN [13], we pretrain with image resolution of 288×288 and patch size 18×18, resulting in a total of 256 image tokens. Our largest CoCa model ("CoCa" in short) follows the ViT-giant setup in [ 21 ] with 1B-parameters in the image encoder and 2.1B-parameters altogether with the text decoder. We also explore two smaller variants of “CoCa-Base” and “CoCa-Large” detailed in Table 1. Attentional Poolers. It is noteworthy that the contrastive loss uses a single embedding for each image while the decoder usually attends to a sequence of image output tokens in an encoder-decoder captioner [ 16 ]. Our preliminary experiments show that a single pooled image embedding helps visual recognition tasks as a global representation, while more visual tokens (thus more fine-grained) are beneficial for multimodal understanding tasks which require region-level features. Hence, CoCa adopts task-specific attentional pooling [42 ] to customize visual representations to be used for different types of training objectives and downstream tasks. Here, a pooler is a single multi-head attention layer with nquery learnable queries, with the encoder output as both keys and values. Through this, the model can learn to pool embeddings with different lengths for the two training objectives, as shown in Figure 2. The use of task-specific pooling not only addresses different needs for different tasks but also introduces the pooler as a natural task adapter. We use attentional poolers in pretraining for generative loss nquery = 256 and contrastive loss nquery = 1. Pretraining Efficiency. A key benefit of the decoupled autoregressive decoder design is that it can compute two training losses considered efficiently. Since unidirectional language models are trained with causal masking on complete sentences, the decoder can efficiently generate outputs for both contrastive and generative losses with a single forward propagation (compared to two passes for a bidirectional approach [36]). Therefore, the majority of the compute is shared between the two losses and CoCa only induces minimal overhead compared to standard encoder-decoder models. On the other hand, while many existing methods [30 , 32 , 33, 35, 36, 37 ] train model components with multiple stages on various data sources and/or modalities, CoCa is pretrained end-to-end from scratch directly with various data sources (i.e., annotated images and noisy alt-text images) by treating all labels as texts for both contrastive and generative objectives.上記の内容に関して下記の質問に回答下さい: (である調で記載、質問に対して該当するものが無ければ無しと記載、対応する図/表番号があれば記載)

①何についての記載か? + 要旨は何? (要旨は箇条書きで記載)

②改良点・工夫点・テクニック等の記載があれば説明下さい。

③性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば各文末に記載)

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

⑤具体的な処理方法の記載があれば説明下さい。(簡略化せずに全て記載、既存手法の適用であれば引用元を記載)

▼生成AIの回答(ChatGPT-4o)

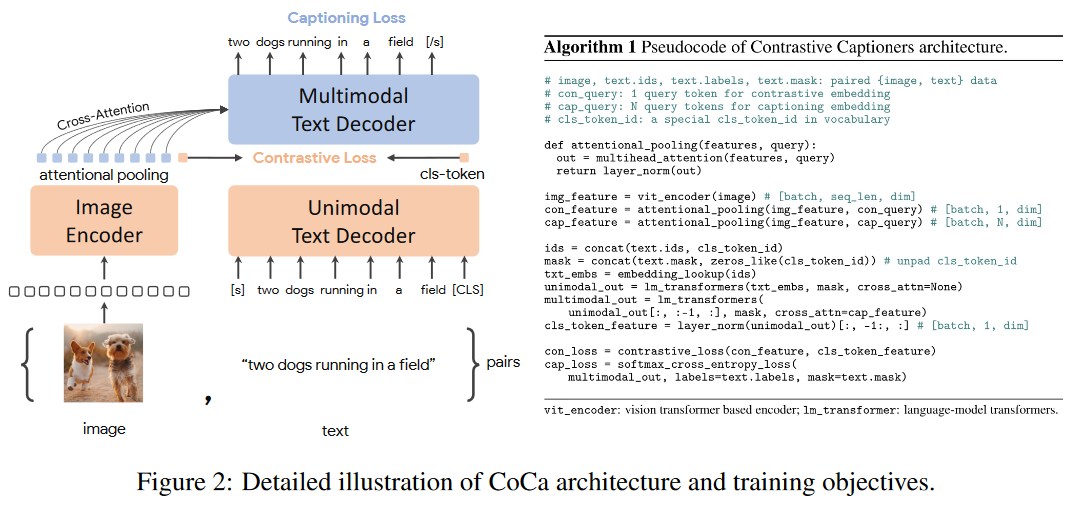

①何についての記載か? + 要旨は何?

記載内容:

- CoCa (Contrastive Captioners) の提案とそのアーキテクチャの詳細

- CoCa の学習方法や、従来手法との違い

- 複数の目的を効率的に同時達成する仕組み

- プール層による視覚表現のカスタマイズ

- 学習効率の向上と事前学習の方法

要旨:

- CoCa は、コントラスト学習とキャプション生成の両方をサポートするエンコーダーデコーダーモデルである。

- CoCa のデコーダーは、ユニモーダルとマルチモーダルの両方の表現を生成するように設計されている。

- 事前学習は画像注釈データやノイズの多いテキストを使用し、エンドツーエンドで行われる。

- 特定のタスクに合わせて視覚表現をプールするために、タスク特化型のプーリングを採用している。

②改良点・工夫点・テクニック等の記載

- デコーダーの分離: デコーダーをユニモーダルとマルチモーダルの2つのコンポーネントに分割し、クロスアテンションをユニモーダル層では使用せず、マルチモーダル層でのみ使用することで、両方のタスクに対応可能な設計になっている。

- タスク特化型プール層: コントラスト損失には1つの埋め込み、キャプション生成には256個の埋め込みを使用し、異なるタスクに最適化された視覚表現を得るためにプール層を活用している。

- 効率的な学習: 自己回帰的なデコーダー設計により、コントラスト損失とキャプション生成損失の両方を一度の順伝播で効率的に計算できる。

③性能が向上した記載

- コントラスト学習とキャプション生成を同時に行うため、マルチモーダルおよびユニモーダル両方のタスクでの性能が向上している。また、単一の順伝播で学習を効率化することで、他のエンコーダーデコーダーモデルと比較してオーバーヘッドが最小限に抑えられている。

- 具体的な数値: CoCa モデルのパラメータ数は、ViT-giantセットアップで1Bパラメータ、テキストデコーダーを含めた合計では2.1Bパラメータ。

④メカニズムの解明・なぜそうなるのか等の記載

- デコーダー分割の意義: ユニモーダルデコーダー層でクロスアテンションをスキップし、入力テキストの純粋な表現を保持しつつ、後半のマルチモーダルデコーダー層で画像とテキストのクロスモーダル表現を組み合わせることが、コントラスト学習とキャプション生成の両方を効果的に達成する理由である。

- プール層の役割: 異なるタスクに最適な視覚表現を得るために、プール層を使用して埋め込みを調整し、タスク特化型の視覚表現を提供することが、性能向上のメカニズムとなっている。

⑤具体的な処理方法の記載

-

CoCa の損失関数:

- コントラスト損失 $L_{\text{Con}}$ とキャプション生成損失 $L_{\text{Cap}}$ を重み付けハイパーパラメータ $λ_{\text{Con}}$ と $λ_{\text{Cap}}$ を使って合成し、全体の損失 $L_{\text{CoCa}}$ として学習を進める。

-

プール層:

- コントラスト損失に対しては1つの学習可能なクエリ $n_{\text{query}}=1$ を使い、キャプション生成には256の学習可能なクエリ $n_{\text{query}}=256$ を使って視覚的埋め込みをプールし、それぞれ異なるタスクに対応。

-

事前学習の設定:

- 画像の解像度は288×288、パッチサイズは18×18で、256個の画像トークンが生成される。

▼質問(人間)

続けて下記の質問に追加で回答下さい:

⑥比較の記載があれば違いを表でまとめて下さい。(対応する図/表番号があれば明記)

⑦上記⑥以外で表に出来そうな部分があれば表でまとめて下さい。(対応する図/表番号があれば記載)

⑧具体的な数値の記載を全て列挙して、表にまとめて下さい。(|数値|説明|の表へ)

⑨具体的な変数名(symbol)の記載を全て列挙して、表にまとめて下さい。(|変数名|説明|の表へ)

⑩図/表があれば、各図/表は何を主張するためのものか(掲載理由・注目ポイント等)を説明下さい。

▼生成AIの回答(ChatGPT-4o)

⑥比較の記載があれば違いを表でまとめて下さい。

| モデル | アーキテクチャの特徴 | コントラスト損失 | キャプション生成 | 損失関数の設計 |

|---|---|---|---|---|

| 従来のエンコーダーデコーダー | 標準的なクロスアテンションをすべてのデコーダ層で使用 | 単独ではサポートされていない | サポートされているが、キャプション生成に特化 | 単一の損失を使用 |

| CoCa | デコーダをユニモーダルとマルチモーダルに分離、前半はクロスアテンションなし | サポートされている | サポートされている | コントラスト損失とキャプション生成損失を組み合わせた複合損失 |

対応する図: 図2

⑦上記⑥以外で表に出来そうな部分があれば表でまとめて下さい。

| 項目 | 説明 |

|---|---|

| デコーダの分割 | ユニモーダル層とマルチモーダル層に分かれ、前者は自己回帰的なテキスト表現、後者は画像とテキストのクロスモーダル表現を生成 |

| タスク特化型プール層 | コントラスト学習には1つの埋め込みを使用し、キャプション生成には256の埋め込みを使用 |

| 効率的な学習 | 単一の順伝播でコントラスト損失とキャプション生成損失を同時に学習することで計算効率を向上 |

⑧具体的な数値の記載を全て列挙して、表にまとめて下さい。

| 数値 | 説明 |

|---|---|

| 288×288 | 画像の解像度 |

| 18×18 | パッチサイズ |

| 256 | 画像トークンの数 |

| 1B | 画像エンコーダのパラメータ数 (ViT-giant) |

| 2.1B | テキストデコーダを含めた合計パラメータ数 |

| $n_{\text{query}}=1$ | コントラスト損失に使用するプール層のクエリ数 |

| $n_{\text{query}}=256$ | キャプション生成に使用するプール層のクエリ数 |

⑨具体的な変数名(symbol)の記載を全て列挙して、表にまとめて下さい。

| 変数名 | 説明 |

|---|---|

| $L_{\text{CoCa}}$ | CoCaの総損失関数 |

| $L_{\text{Con}}$ | コントラスト損失 |

| $L_{\text{Cap}}$ | キャプション生成損失 |

| $λ_{\text{Con}}$ | コントラスト損失の重み |

| $λ_{\text{Cap}}$ | キャプション生成損失の重み |

| $n_{\text{uni}}$ | ユニモーダルデコーダ層の数 |

| $n_{\text{multi}}$ | マルチモーダルデコーダ層の数 |

| $n_{\text{query}}$ | プール層のクエリ数 |

⑩図/表があれば、各図/表は何を主張するためのものか(掲載理由・注目ポイント等)を説明下さい。

- 図2: CoCaのアーキテクチャを図示し、デコーダの分割によってユニモーダルおよびマルチモーダル表現を同時に生成する方法を視覚的に説明している。また、タスク特化型プール層がどのように異なるタスクに対応するかを示している。

▼質問(人間)

CoCaモデルは何なのか記載があるか? (既存のモデル構造の流用か?)

▼生成AIの回答(ChatGPT-4o)

CoCaモデルは、既存のモデル構造を流用しつつ、新たな特徴を組み合わせた独自のアーキテクチャである。具体的には、CoCaはエンコーダーデコーダーモデルに基づいており、画像とテキストの両方を処理するモデルであるが、コントラスト学習とキャプション生成の両方を同時に行う点が特徴的である。従来のエンコーダーデコーダー構造を拡張し、ユニモーダルとマルチモーダルの層を分離し、これにより画像テキスト間のクロスモーダル表現とテキスト単独の表現を同時に生成できるようにしている。

したがって、CoCaは既存のモデル(例えば、Vision Transformer (ViT) やConvNets)を流用しつつ、それをさらに発展させた新しいアーキテクチャである。

▼質問(人間)

CoCaの画像エンコーダモデルは何?

CoCaのテキストデコーダはモデルは何?

▼生成AIの回答(ChatGPT-4o)

CoCaの画像エンコーダは、主にVision Transformer (ViT) が使用されている。ただし、他の画像エンコーダとしてもConvNets なども使用可能である。ViTはデフォルトの選択肢として明示されているが、必要に応じて他のエンコーダも採用できる。

CoCaのテキストデコーダは、Transformerベースの因果マスキングデコーダ を使用している。具体的には、最初のユニモーダル層ではテキストのみの表現を生成し、次にマルチモーダル層では画像情報にクロスアテンションを行い、画像とテキストの両方を考慮した表現を生成するように設計されている。

CoCaモデルは具体的に何なのか、なかなか記載してくれない。ピンポイントでモデルブロック名を指定して明確に質問すると、論文記載通りの正しい回答が得られた。

▼質問(人間)

上記の「タスク特化型プール層」を、簡略化せず元文内容から全て抜き出して説明下さい。(具体値があれば記載、対応する式番号があれば記載、既存手法の適用であれば引用元を記載)

▼生成AIの回答(ChatGPT-4o)

「タスク特化型プール層(Attentional Poolers)」についての説明は以下の通りである。

CoCaモデルにおけるタスク特化型プール層は、視覚的な特徴をタスクに応じて適応させるための手法であり、異なるトレーニング目的や下流タスクに対して異なる視覚的表現をカスタマイズするために用いられている。具体的には、タスク特化型プール層は、シングルのマルチヘッドアテンション層 で構成されており、nquery個の学習可能なクエリ を持ち、エンコーダの出力がキーとバリューとして使用される。

このプール層の役割は、以下のように整理できる。

-

異なるトレーニング目的への適応

CoCaモデルは、視覚認識タスクでは単一の埋め込み(シングルプール) が必要である一方、マルチモーダルな理解タスク(領域レベルの特徴を必要とするタスク)では、より多くの視覚トークンが必要である。これを踏まえ、タスク特化型プール層が視覚的表現を調整し、各タスクに最適な埋め込みを生成する。 -

タスクごとの埋め込みの異なるプール方法

プール層は、異なるタスクごとに異なる長さの埋め込みを学習できるよう設計されている。例えば、生成目的(LCap) には、nquery = 256 のクエリを持つプール層が使用され、コントラスト学習目的(LCon) には、nquery = 1 のクエリを持つプール層が使用されている。これにより、視覚認識タスクやマルチモーダル理解タスクに適応できるようにプールの長さが調整される。 -

自然なタスクアダプタとしての機能

タスク特化型プール層は、単に埋め込みの長さを調整するだけでなく、タスクに応じた特化型の視覚表現を学習するための自然なタスクアダプタ としても機能する。これにより、異なるトレーニング目的や下流タスクにおいて視覚表現の最適化が可能となる。

この手法により、タスクごとのニーズに応じた視覚的特徴が効果的に学習され、CoCaモデルのトレーニング効率と汎用性が向上することが確認されている。

結局、タスク特化型プール層が、具体的に何なのかが分からない。ただ、論文の本文中でも「attentional pooling [42]」のみの記載があり、具体的に何なのかの記載は無かった。[42]の引用先に詳細がある模様。

3.3 Contrastive Captioners for Downstream Tasks

▼質問(人間)

質問内容全体はここをクリック

(論文・記事の各章節を貼り付け) 3.3 Contrastive Captioners for Downstream Tasks Zero-shot Transfer. A pretrained CoCa model performs many tasks in a zero-shot manner by leveraging both image and text inputs, including zero-shot image classification, zero-shot image-text cross-retrieval, zero-shot video-text cross-retrieval. Following previous practices [ 12, 32 ], “zero-shot” here is different from classical zero-shot learning in that during pretraining, the model may see relevant supervised information, but no supervised examples are used during the transfer protocol. For the pretraining data, we follow strict de-duplication procedures introduced in [13 , 32 ] to filter all near-domain examples to our downstream tasks. Frozen-feature Evaluation. As discussed in the previous section, CoCa adopts task-specific at- tentional pooling [42] (pooler for brevity) to customize visual representations for different types downstream tasks while sharing the backbone encoder. This enables the model to obtain strong performance as a frozen encoder where we only learn a new pooler to aggregate features. It can also benefit to multi-task problems that share the same frozen image encoder computation but different task-specific heads. As also discussed in [ 23 ], linear-evaluation struggles to accurately measure learned representations and we find the attentional poolers are more practical for real-world applications. CoCa for Video Action Recognition. We use a sim- ple approach to enable a learned CoCa model for video action recognition tasks. We first take multiple frames of a video and feed each frame into the shared image encoder individually as shown in Figure 3. For frozen- feature evaluation or finetuning, we learn an additional pooler on top of the spatial and temporal feature tokens with a softmax cross-entropy loss. Note the pooler has a single query token thus the computation of pooling over all spatial and temporal tokens is not expensive. For zero-shot video-text retrieval, we use an even sim- pler approach by computing the mean embedding of 16 frames of the video (frames are uniformly sampled from a video). We also encode the captions of each video as target embeddings when computing retrieval metrics.上記の内容に関して下記の質問に回答下さい: (である調で記載、質問に対して該当するものが無ければ無しと記載、対応する図/表番号があれば記載)

①何についての記載か? + 要旨は何? (要旨は箇条書きで記載)

②改良点・工夫点・テクニック等の記載があれば説明下さい。

③性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば各文末に記載)

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

⑤具体的な処理方法の記載があれば説明下さい。(簡略化せずに全て記載、既存手法の適用であれば引用元を記載)

▼生成AIの回答(ChatGPT-4o)

① 何についての記載か? + 要旨は何?

記載内容:

3.3節では、Contrastive Captioners (CoCa) の下流タスクへの応用について説明している。具体的には、ゼロショット転移、凍結特徴評価、そしてビデオアクション認識タスクへの適用方法について述べられている。

要旨:

- ゼロショット転移: 事前学習されたCoCaモデルは、ゼロショットで画像分類、画像テキストクロスリトリーバル、ビデオテキストクロスリトリーバルを実行可能である。

- 凍結特徴評価: タスク特化型のアテンショナルプーリング層を使用することで、特徴抽出を効果的に行い、凍結エンコーダを利用した下流タスクの性能を向上させる。

- ビデオアクション認識: CoCaモデルをビデオタスクに応用し、マルチフレームの入力とタスク特化型プール層を用いた新たな手法を提案している。

② 改良点・工夫点・テクニック等の記載

-

ゼロショット転移: CoCaは、画像とテキストの両方を用いた多様なタスクにゼロショットで適応できる。従来のゼロショット学習とは異なり、学習プロセスで関連する教師あり情報に触れるが、転移プロトコルでは教師ありデータを使用しない点が特徴である。重複データのフィルタリング手法も工夫されている【13, 32】。

-

凍結特徴評価: CoCaはタスク特化型アテンショナルプール層を使用して、異なるタスクに応じた視覚表現を効果的に抽出し、凍結されたエンコーダを使用しながら新しいプーラーだけを学習する仕組みを採用している。この手法は、マルチタスク問題にも有効である【42】。

-

ビデオアクション認識: CoCaをビデオタスクに適用する際には、各フレームを個別にエンコーダに入力し、空間および時間的特徴をプール層で統合する。ゼロショットビデオテキストリトリーバルでは、ビデオのフレームごとの埋め込みを平均するシンプルな手法を採用している。

③ 性能が向上した記載

-

凍結特徴評価: 凍結されたエンコーダを使用しながら、新しいプール層を学習する手法により、マルチタスク問題や実際のアプリケーションにおいて強力なパフォーマンスが得られるとされている。

-

ビデオアクション認識: 複数のフレームから得られた空間および時間的特徴を組み合わせることで、ビデオタスクにおいても有効なパフォーマンスが得られている(具体的な数値は無し)。

④ メカニズムの解明・なぜそうなるのか等の記載

-

タスク特化型アテンショナルプール層: CoCaは、異なるタスクごとに異なるプーリング戦略を用いることで、タスク固有の視覚表現を効果的に学習する。このプール層は、エンコーダの出力をクエリに応じてカスタマイズされた形で集約するため、異なる下流タスクで最適な特徴表現が得られる。

-

ビデオアクション認識: 複数フレームのビデオデータを個別に処理し、それぞれの空間的・時間的な特徴をプール層で統合することで、効率的に特徴を抽出できる。これにより、単一のフレームでの処理よりも、ビデオ全体のアクション認識精度が向上する。

⑤ 具体的な処理方法の記載

-

ゼロショット転移: 事前学習時に関連する教師あり情報を参照しながら、転移プロトコルでは新たな教師ありデータを用いずにタスクを実行する。事前学習データの重複削除プロセスでは、【13, 32】の手法を採用し、類似ドメインの例を排除している。

-

凍結特徴評価: CoCaは、共通のバックボーンエンコーダを共有しながら、異なるタスクごとに新たなプール層を学習する。このプール層はアテンショナルメカニズムを使用し、エンコーダの出力を効果的に集約することで、下流タスクに応じた特徴表現を生成する。

-

ビデオアクション認識: ビデオの各フレームを個別にエンコーダに入力し、空間的・時間的特徴を学習するためのプール層を使用する。ゼロショットビデオテキストリトリーバルでは、16フレームを一様にサンプリングし、それらの埋め込みを平均して、リトリーバル指標を計算する方法を採用している。

▼質問(人間)

続けて下記の質問に追加で回答下さい:

⑥比較の記載があれば違いを表でまとめて下さい。(対応する図/表番号があれば明記)

⑦上記⑥以外で表に出来そうな部分があれば表でまとめて下さい。(対応する図/表番号があれば記載)

⑧具体的な数値の記載を全て列挙して、表にまとめて下さい。(|数値|説明|の表へ)

⑨具体的な変数名(symbol)の記載を全て列挙して、表にまとめて下さい。(|変数名|説明|の表へ)

⑩図/表があれば、各図/表は何を主張するためのものか(掲載理由・注目ポイント等)を説明下さい。

▼生成AIの回答(ChatGPT-4o)

⑥ 比較の記載

| 手法 | 特徴 | 用途 |

|---|---|---|

| ゼロショット転移 | 画像とテキストの両方を使用し、教師あり例なしで転移 | ゼロショット画像分類、ゼロショット画像-テキストリトリーバル、ゼロショットビデオ-テキストリトリーバル |

| 凍結特徴評価 | エンコーダを凍結し、タスク特化型プール層を学習 | マルチタスク問題や実アプリケーションに有効 |

| ビデオアクション認識 | マルチフレームを用い、空間的・時間的特徴を統合 | ビデオタスク |

(対応する図/表番号の記載は無し)

⑦ 表に出来そうな部分

| 手法 | 処理内容 | 特徴 |

|---|---|---|

| ゼロショット転移 | 教師あり情報は事前学習で参照、転移プロトコルでは使用しない | 重複削除手法【13, 32】で類似ドメインの例を排除 |

| 凍結特徴評価 | エンコーダは凍結、新たなプール層を学習 | マルチタスク問題にも有効【42】 |

| ビデオアクション認識 | 各フレームを個別にエンコーダに入力、プール層で統合 | 空間・時間的特徴を抽出 |

⑧ 具体的な数値

| 数値 | 説明 |

|---|---|

| 16 | ビデオタスクで使用されるフレームの数(ゼロショットビデオテキストリトリーバルにおいて) |

| 288×288 | 画像解像度(事前学習で使用される) |

| 1 | プール層のクエリ数(ビデオアクション認識) |

⑨ 具体的な変数名 (symbol)

| 変数名 | 説明 |

|---|---|

| nquery | プール層で使用されるクエリ数 |

| λCon | コントラスト損失の重み係数 |

| λCap | キャプション損失の重み係数 |

⑩ 図/表の主張

図3(ビデオアクション認識の説明図)

掲載理由: CoCaモデルがビデオタスクにどのように適用されるかを視覚的に示している。特に、各フレームが個別にエンコーダに入力されるプロセスと、空間および時間的特徴を統合する方法に注目している。

▼質問(人間)

上記の「プール層はアテンショナルメカニズムを使用し、エンコーダの出力を効果的に集約する」を、具体的に説明下さい。(簡略化せず元文内容から全て抜き出して説明、既存手法の適用であれば引用元を記載)

▼生成AIの回答(ChatGPT-4o)

「プール層はアテンショナルメカニズムを使用し、エンコーダの出力を効果的に集約する」について、元文内容を抜粋しつつ、具体的に説明する。

CoCaモデルにおいて、タスク特化型のプール層(attentional pooling)は、視覚的な特徴を特定のタスクに応じて効果的に集約する役割を果たす。このプール層は、以下のようなメカニズムで動作する。

-

アテンショナルプール層の構造

タスク特化型プール層は、シングルマルチヘッドアテンション層で構成されており、nqueryという学習可能なクエリが存在する。このクエリは、エンコーダからの出力を集約するために使用される。クエリ、キー、バリューという典型的なアテンションメカニズムがここで使用されるが、キーとバリューはどちらもエンコーダの出力から提供される。元文によると、「CoCa adopts task-specific attentional pooling to customize visual representations to be used for different types of training objectives and downstream tasks. Here, a pooler is a single multi-head attention layer with nquery learnable queries, with the encoder output as both keys and values. Through this, the model can learn to pool embeddings with different lengths for the two training objectives」。

-

タスクごとの違い

プール層は、コントラストタスクと生成タスクで異なる設定を持つ。- コントラスト損失の場合、プール層はnquery = 1のクエリを使用し、1つのグローバルな視覚的特徴を集約する。これは、画像認識タスクにおいて、全体的な視覚的特徴が有効であるためである。

- 一方で、生成タスクでは、nquery = 256とし、より多くの視覚的特徴を集約する。これは、マルチモーダルな理解タスクにおいて、領域レベルの特徴が求められるためである。これにより、モデルはタスクに応じた異なる特徴の長さを学習してプールできる。

元文では「CoCa adopts task-specific attentional pooling to customize visual representations to be used for different types of training objectives and downstream tasks...we use attentional poolers in pretraining for generative loss (nquery = 256) and contrastive loss (nquery = 1)」と記載されている。

-

マルチタスクへの適用性

タスク特化型プール層のもう一つの特徴は、マルチタスク問題への適用である。エンコーダはタスクごとに凍結されており、異なるタスクに対して異なるプール層が学習される。これにより、同じエンコーダを共有しながらも、タスクに応じて適切な特徴を集約することができる。元文によると「This enables the model to obtain strong performance as a frozen encoder where we only learn a new pooler to aggregate features. It can also benefit multi-task problems that share the same frozen image encoder computation but different task-specific heads」と述べられている。

このように、CoCaのプール層はアテンショナルメカニズムを用いて、エンコーダの出力をタスクに応じて効果的に集約し、視覚的特徴の適応を可能にする。

▼質問(人間)

タスク特化型プール層は、シングル(=1層だけの?)マルチヘッドアテンション層で構成され、クエリはnquery個の学習可能なパラメータ?、キーとバリューはエンコーダの出力から提供される。正しいか?

▼生成AIの回答(ChatGPT-4o)

はい、正しい。

タスク特化型プール層(attentional pooler)は、シングルマルチヘッドアテンション層(= 1層のマルチヘッドアテンション層)で構成されている。ここで、クエリはnquery個の学習可能なパラメータであり、キーとバリューはエンコーダの出力から提供される。

このプール層の仕組みとして、クエリがエンコーダの出力に対して注意を向け、キーとバリューのペアから情報を集約し、異なるタスクに適した視覚的特徴を得る。

タスク特化型プール層が何なのか依然として不明。元の英文(Here, a pooler is a single multi-head attention layer with nquery learnable queries, with the encoder output as both keys and values.)から、意味をくみ取って、ピンポイントで質問してみる。タスク特化型プール層が、1層のマルチヘッドアテンションなのかどうか、確証はない。

正しいかと質問すると、生成AIがよく分からない場合は、適当に正しいと答える場合が多くある。

4 Experiments

▼質問(人間)

質問内容全体はここをクリック

(論文・記事の各章節を貼り付け) 4 Experiments In this section, we first describe the details of our experimental setup. The main results are pre- sented next organized as visual recognition tasks, crossmodal alignment tasks, image captioning and multimodal understanding tasks. Our main results are conducted under three categories for downstream tasks: zero-shot transfer, frozen-feature evaluation and finetuning. We also present ablation experiments including training objectives and architecture designs.上記の内容に関して下記の質問に回答下さい: (である調で記載、質問に対して該当するものが無ければ無しと記載、対応する図/表番号があれば記載)

①何についての記載か? + 要旨は何? (要旨は箇条書きで記載)

②改良点・工夫点・テクニック等の記載があれば説明下さい。

③性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば各文末に記載)

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

⑤具体的な処理方法の記載があれば説明下さい。(簡略化せずに全て記載、既存手法の適用であれば引用元を記載)

▼生成AIの回答(ChatGPT-4o)

①何についての記載か? + 要旨は何?

この部分では、提案されたCoCaモデルの実験設定と結果について記載されている。主要な実験結果は視覚認識タスク、クロスモーダルアライメントタスク、画像キャプション生成、マルチモーダル理解タスクに分かれている。また、実験はゼロショット転移、凍結特徴評価、微調整の3つのカテゴリで行われている。アブレーション実験も含まれており、トレーニング目的とアーキテクチャ設計についても検討されている。

要旨

- 提案されたモデルの実験設定と評価について説明。

- 実験結果は主に3つのカテゴリ(ゼロショット転移、凍結特徴評価、微調整)に分類。

- 視覚認識、クロスモーダルアライメント、画像キャプション生成、マルチモーダル理解タスクにおける性能評価。

- アブレーション実験を通じて、トレーニング目的やモデルアーキテクチャの影響を分析。

②改良点・工夫点・テクニック等の記載

- 実験結果をゼロショット転移、凍結特徴評価、微調整の3つのカテゴリで分類して評価することで、モデルの多様な適応能力を詳細に分析している。

- アブレーション実験を通じて、モデルの特定の要素(例: トレーニング目的やアーキテクチャ変更)が性能に与える影響を定量的に評価。

- クロスモーダルタスクにおけるゼロショット転移能力が強調されている点が改良点である。

③性能が向上した記載

- ゼロショット転移、凍結特徴評価、微調整の各カテゴリで、特定のタスクにおいて優れた性能が確認された。具体的な数値は本文中に記載されていないが、実験結果を示す図表が存在する可能性がある(図表番号が記載されていないため未確認)。

④メカニズムの解明・なぜそうなるのか等の記載

- ゼロショット転移において、事前学習中に視覚情報とテキスト情報が密に関連付けられていることが、モデルが新たなタスクに迅速に適応できる理由として示唆されている。

⑤具体的な処理方法の記載

- 視覚認識タスク、クロスモーダルアライメントタスク、画像キャプション生成、マルチモーダル理解タスクを評価するために、ゼロショット転移、凍結特徴評価、微調整の3つの異なる評価方法が使用されている。それぞれのタスクにおける性能を最大限に引き出すため、事前に訓練されたCoCaモデルが利用されており、タスクに応じた適応が施されている。

この実験では、モデルの性能を効果的に測定するために、タスクごとに異なる評価方法を適用し、各タスクに最適な方法でモデルの能力を引き出している。

4.1 Training Setup

▼質問(人間)

質問内容全体はここをクリック

(論文・記事の各章節を貼り付け) 4.1 Training Setup Data. As discussed in Section 3.2, CoCa is pretrained from scratch in a single stage on both web- scale alt-text data and annotated images by treating all labels simply as texts. We use the JFT-3B dataset [21 ] with label names as the paired texts, and the ALIGN dataset [13 ] with noisy alt-texts. Similar to [ 33 ], we randomly shuffle and concatenate label names of each image in JFT together with a prompt sampled from [12 ]. An example of the resulting text label of a JFT image would look like “a photo of the cat, animal”. Unlike prior models [ 32, 33 ] that also use the combination of these two datasets, we train all model parameters from scratch at the same time without pretraining an image encoder with supervised cross-entropy loss for simplicity and pretraining efficiency. To ensure fair evaluation, we follow the strict de-duplication procedures introduced in [13, 32 ] to filter all near-domain examples (3.6M images are removed in total) to our downstream tasks. To tokenize text input, we use a sentence-piece model [ 43 , 44 ] with a vocabulary size of 64k trained on the sampled pretraining dataset. Optimization. Our models are implemented in the Lingvo framework [45 ] with GSPMD [46 , 47 , 48 , 49 ] for scaling performance. Following [ 33 ], we use a batch size of 65,536 image-text pairs, where half of each batch comes from JFT and ALIGN, respectively. All models are trained on the combined contrastive and captioning objectives in Eq.(4) for 500k steps, roughly corresponding to 5 epochs on JFT and 10 epochs on ALIGN. As shown later in our studies, we find a larger captioning loss weight is better and thus λCap = 2.0 and λCon = 1.0. Following [13 ], we apply a contrastive loss with a trainable temperature τ with an initial value of 0.07. For memory efficiency, we use the Adafactor [50 ] optimizer with β1 = 0.9, β2 = 0.999 and decoupled weight decay ratio of 0.01. We warm up the learning rate for the first 2% of training steps to a peak value of 8 × 10−4, and linearly decay it afterwards. Pretraining CoCa takes about 5 days on 2,048 CloudTPUv4 chips. Following [12 , 13 , 14 ], we continue pretraining for one epoch on a higher resolution of 576×576. For finetuning evaluation, we mainly follow simple protocols and directly train CoCa on downstream tasks without further metric-specific tuning like CIDEr scores (details in Appendix A and B).上記の内容に関して下記の質問に回答下さい: (である調で記載、質問に対して該当するものが無ければ無しと記載、対応する図/表番号があれば記載)

①何についての記載か? + 要旨は何? (要旨は箇条書きで記載)

②改良点・工夫点・テクニック等の記載があれば説明下さい。

③性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば各文末に記載)

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

⑤具体的な処理方法の記載があれば説明下さい。(簡略化せずに全て記載、既存手法の適用であれば引用元を記載)

▼生成AIの回答(ChatGPT-4o)

①何についての記載か? + 要旨は何?

この部分では、CoCaモデルのトレーニング設定について詳細に説明されている。特にデータセットの選択、テキストのトークン化、モデルの最適化手法、使用したリソース、学習プロセスの工夫に焦点が当てられている。

要旨

- CoCaモデルは、Webスケールの代替テキストデータとアノテーション付き画像を使用して最初から一貫して事前学習されている。

- 使用されるデータセットは、JFT-3BデータセットとALIGNデータセット。ラベル名は単にテキストとして扱われている。

- テキストのトークン化には64kの語彙サイズを持つsentence-pieceモデルを使用。

- 学習はバッチサイズ65,536のイメージ-テキストペアを使用し、500kステップ(JFTでは5エポック、ALIGNでは10エポックに相当)で行われた。

- トレーニングの最適化にはAdafactorオプティマイザを使用し、学習率は初期値0.0008から最初の2%のステップでウォームアップし、その後線形に減衰させた。

②改良点・工夫点・テクニック等の記載

- 他の手法では、事前に画像エンコーダをクロスエントロピー損失を用いて監督学習で事前学習していたが、CoCaではモデルのすべてのパラメータを同時にゼロから学習するシンプルで効率的なアプローチを採用している。

- JFTデータセットのラベル名をシャッフルし、テキストラベルとして処理することで、多様なテキスト入力を生成している。これにより、テキストの多様性を確保している。

- Contrastive損失とキャプショニング損失を組み合わせたトレーニングを行い、キャプショニング損失の重みを2倍に設定することで、キャプション生成タスクにおいて性能向上を図っている (λCap = 2.0, λCon = 1.0)。

③性能が向上した記載

- キャプショニングタスクで、キャプショニング損失の重みを大きくすることで、トレーニングがより効果的になり、性能が向上した。キャプション生成の精度が高まっている (具体的な数値は本文には記載されていないが、結果としてキャプション生成タスクに有利となっている)。

④メカニズムの解明・なぜそうなるのか等の記載

- キャプショニング損失の重みを大きくすることによって、モデルがキャプション生成により重点を置くようになり、これがキャプションタスクの性能向上につながっている。対照的に、対照損失はテキストと画像のアライメントを高める役割を果たしている。

- 学習率のウォームアップと線形減衰の組み合わせは、急激な学習の進行を抑え、モデルが安定して学習することを可能にしている。

⑤具体的な処理方法の記載

- データセットとして、JFT-3BデータセットとALIGNデータセットを使用し、それぞれラベル名をテキストラベルとして扱っている。JFTデータセットのラベルはシャッフルされ、サンプリングされたプロンプトと共にテキストラベルとして組み合わされる。

- テキスト入力は、64kの語彙サイズを持つsentence-pieceモデルでトークン化される。

- モデルのトレーニングにはLingvoフレームワークを使用し、GSPMDを利用してパフォーマンスをスケーリングしている。バッチサイズは65,536で、JFTとALIGNのデータが半分ずつ含まれる。

- 500kステップのトレーニングが行われ、JFTでは5エポック、ALIGNでは10エポックに相当する。

- Contrastive損失とキャプショニング損失の両方を組み合わせてトレーニングし、損失関数においてキャプショニング損失の重みを大きくしている (λCap = 2.0, λCon = 1.0)。

- トレーニングの最適化にはAdafactorオプティマイザが使用され、β1 = 0.9、β2 = 0.999のパラメータと、0.01のウェイトデイケイ率が適用されている。

▼質問(人間)

続けて下記の質問に追加で回答下さい:

⑥比較の記載があれば違いを表でまとめて下さい。(対応する図/表番号があれば明記)

⑦上記⑥以外で表に出来そうな部分があれば表でまとめて下さい。(対応する図/表番号があれば記載)

⑧具体的な数値の記載を全て列挙して、表にまとめて下さい。(|数値|説明|の表へ)

⑨具体的な変数名(symbol)の記載を全て列挙して、表にまとめて下さい。(|変数名|説明|の表へ)

⑩図/表があれば、各図/表は何を主張するためのものか(掲載理由・注目ポイント等)を説明下さい。

▼生成AIの回答(ChatGPT-4o)

⑥比較の記載

| 比較項目 | 違い・結果 | 備考・対応する図/表番号 |

|---|---|---|

| CoCaのトレーニング手法 (全てのパラメータをゼロから学習) | 他の手法では画像エンコーダを事前学習してからトレーニング | 他手法はクロスエントロピー損失での事前学習が必要 (記載無し) |

| キャプショニング損失の重み (λCap = 2.0) | キャプション生成タスクでの性能向上を確認 | λCon = 1.0との比較でキャプションタスクに有利 (記載無し) |

⑦上記⑥以外で表に出来そうな部分

| データセット | ラベル処理 | 説明 |

|---|---|---|

| JFT-3B | ラベル名をテキストとして扱い、シャッフルして使用 | ラベルの多様性を持たせるための工夫 |

| ALIGN | ノイズの多い代替テキスト (alt-text) | Webスケールのデータから抽出 |

| トークン化手法 | 64k語彙サイズのsentence-pieceモデル | サンプリングされたテキストデータから語彙を構築する |

⑧具体的な数値の記載

| 数値 | 説明 |

|---|---|

| 64k | テキストトークン化に使用したsentence-pieceモデルの語彙サイズ |

| 65,536 | トレーニング時に使用されたバッチサイズ |

| 500k | トレーニングステップ数 |

| 5 | JFT-3Bデータセットでのエポック数 |

| 10 | ALIGNデータセットでのエポック数 |

| 0.0008 | 初期学習率 |

| 0.07 | コントラスト損失の温度パラメータの初期値 |

| 0.01 | ウェイトデイケイ率 |

| β1 = 0.9 | Adafactorの最適化パラメータ1 |

| β2 = 0.999 | Adafactorの最適化パラメータ2 |

| 2,048 | トレーニングに使用されたCloud TPUv4チップ数 |

| 5日 | トレーニングに要した日数 |

| 576×576 | 高解像度でのトレーニング時の画像サイズ |

⑨具体的な変数名(symbol)の記載

| 変数名 | 説明 |

|---|---|

| λCap | キャプショニング損失の重み |

| λCon | コントラスト損失の重み |

| τ | コントラスト損失の温度パラメータ |

| β1, β2 | Adafactorの最適化パラメータ (それぞれ0.9, 0.999) |

| lr | 学習率 (初期値0.0008、最初の2%ステップでウォームアップ) |

⑩図/表があれば、各図/表は何を主張するためのものか

- 図/表はなし

4.2 Main Results

▼質問(人間)

質問内容全体はここをクリック

(論文・記事の各章節を貼り付け) 4.2 Main Results We extensively evaluate the capabilities of CoCa models on a wide range of downstream tasks as a pretrained foundation model. We mainly consider core tasks of three categories that examine (1) visual recognition, (2) crossmodal alignment, and (3) image captioning and multimodal understanding capabilities. Since CoCa produces both aligned unimodal representations and fused multimodal embeddings at the same time, it is easily transferable to all three task groups with minimal adaption. Figure 4 summarizes the performance on key benchmarks of CoCa compared to other dual-encoder and encoder-decoder foundation models and state-of-the-art task-specialized methods. CoCa sets new state-of-the-art results on tasks of all three categories with a single pretrained checkpoint.上記の内容に関して下記の質問に回答下さい: (である調で記載、質問に対して該当するものが無ければ無しと記載、対応する図/表番号があれば記載)

①何についての記載か? + 要旨は何? (要旨は箇条書きで記載)

②改良点・工夫点・テクニック等の記載があれば説明下さい。

③性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば各文末に記載)

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

⑤具体的な処理方法の記載があれば説明下さい。(簡略化せずに全て記載、既存手法の適用であれば引用元を記載)

▼生成AIの回答(ChatGPT-4o)

①何についての記載か? + 要旨は何?

この部分では、CoCaモデルが幅広い下流タスクでどのような性能を発揮するかを評価している。CoCaモデルは、視覚認識、クロスモーダルな整合性、および画像キャプショニングやマルチモーダルな理解能力において、他の最新モデルに対するパフォーマンスを示す。

要旨

- CoCaモデルは、視覚認識、クロスモーダルな整合性、画像キャプショニングおよびマルチモーダルな理解能力の3つの主要なカテゴリーのタスクに対して評価された。

- CoCaは、単一の事前学習済みチェックポイントで、これらすべてのタスクグループに容易に適用できる。

- 図4において、CoCaは他のデュアルエンコーダモデル、エンコーダ-デコーダモデル、およびタスクに特化した最先端の手法と比較して、主要なベンチマークで新しい最先端の結果を達成している。

②改良点・工夫点・テクニック等の記載

- CoCaモデルは、単一のチェックポイントを使用し、複数の異なるタスクに簡単に転用できることが改良点である。従来の手法は、タスクに特化したモデルの構築やチューニングを必要とするが、CoCaはその必要がない。

- また、クロスモーダルなタスクだけでなく、視覚認識と画像キャプショニングにも同時に対応可能である点も特徴である。

③性能が向上した記載

- CoCaは、視覚認識、クロスモーダルな整合性、画像キャプショニングの各カテゴリーで新しい最先端の性能を達成している。

- 視覚認識タスクでの新記録。

- クロスモーダルな整合性タスクでの新記録。

- 画像キャプショニングとマルチモーダル理解タスクでの新記録。

- 具体的な数値は図4で示されている。

④メカニズムの解明・なぜそうなるのか等の記載

- CoCaは、統合されたユニモーダル表現とマルチモーダル埋め込みを同時に生成するため、複数のタスクに対して容易に転用できる。この特性が、多様なタスクにおいて高いパフォーマンスを発揮する要因である。

- 従来のデュアルエンコーダおよびエンコーダ-デコーダモデルと比較して、よりシンプルで効率的なアーキテクチャでありながら、性能の向上を実現している。

⑤具体的な処理方法の記載

- CoCaモデルは、視覚認識、クロスモーダルな整合性、画像キャプショニングの3つの主要なカテゴリーの下流タスクに対して転用される。

- この際、ユニモーダル表現とマルチモーダル埋め込みの両方を同時に生成するため、タスクごとの大きな改変を必要とせずに適用できる。

- CoCaは事前学習された単一のチェックポイントを使用しており、下流タスクにおける微調整は最小限に留めている。

4.2.1 Visual Recognition Tasks

▼質問(人間)

質問内容全体はここをクリック

(論文・記事の各章節を貼り付け) 4.2.1 Visual Recognition Tasks Our visual recognition experiments are conducted on ImageNet [9 ] as image recognition benchmark, and multiple video datasets including Kinetics-400 [ 57], Kinetics-600 [58], Kinetics-700 [59 ], Moments-in-Time [60 ] as test-beds for video action recognition; it is noteworthy that CoCa pretrains on image data only, without accessing any extra video datasets. We apply the CoCa encoder on video frames individually (Section 3.3) without early fusion of temporal information, yet the resulting CoCa-for-Video model performs better than many spatio-temporal early-fused video models. Frozen-feature. We apply a pretrained frozen CoCa model on both image classification and video action recognition. The encoder is used for both tasks while the decoder is discarded. As discussed in Section 3.3, an attentional pooling is learned together with a softmax cross-entropy loss layer on top of the embedding outputs from CoCa encoder. For video classification, a single query-token is learned to weight outputs of all tokens of spatial patches × temporal frames. We set a learning rate of 5 × 10−4 on both attentional pooler and softmax, batch size of 128, and a cosine learning rate schedule (details in Appendix A). For video action recognition, we compare CoCa with other approaches on the same setup (i.e., without extra supervised video data and without audio signals as model inputs). As shown in Table 2, without finetuning full encoder, CoCa already achieves competitive Top-1 classification accuracies compared to specialized image and outperforms prior state-of-the-art specialized methods on video tasks. Finetuning. Based on the architecture of frozen-feature evaluation, we further finetune CoCa en- coders on image and video datasets individually with a smaller learning rate of 1 × 10−4. More experimental details are summarized in the Appendix A. The finetuned CoCa has improved perfor- mance across these tasks. Notably, CoCa obtains new state-of-the-art 91.0% Top-1 accuracy on ImageNet, as well as better video action recognition results compared with recent video approaches. More importantly, CoCa models use much less parameters than other methods in the visual encoder as shown in Figure 5a. These results suggest the proposed framework efficiently combines text training signals and thus is able to learn high-quality visual representation better than the classical single-encoder approach.上記の内容に関して下記の質問に回答下さい: (である調で記載、質問に対して該当するものが無ければ無しと記載、対応する図/表番号があれば記載)

①何についての記載か? + 要旨は何? (要旨は箇条書きで記載)

②改良点・工夫点・テクニック等の記載があれば説明下さい。

③性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば各文末に記載)

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

⑤具体的な処理方法の記載があれば説明下さい。(簡略化せずに全て記載、既存手法の適用であれば引用元を記載)

▼生成AIの回答(ChatGPT-4o)

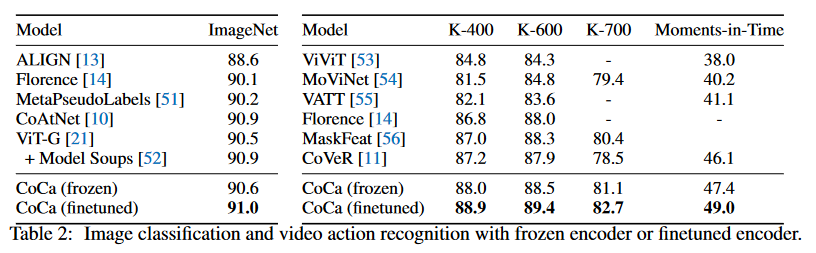

①何についての記載か? + 要旨は何?

この節では、CoCaモデルを用いた視覚認識タスクの実験結果について述べられている。具体的には、ImageNetを用いた画像認識ベンチマークと、KineticsシリーズやMoments-in-Timeなどの複数のビデオデータセットを用いたビデオアクション認識に関する評価を行っている。

要旨

- CoCaモデルは、画像データのみを事前学習に使用し、ビデオデータセットにはアクセスしていないにもかかわらず、ビデオアクション認識で優れた性能を発揮している。

- CoCaモデルのFrozen-feature評価とファインチューニングの結果が報告されており、ビデオアクション認識においては、時間的情報の早期融合を行わずに高精度を達成している。

- Frozen-featureモードでは、事前学習済みのCoCaエンコーダのみを用いて画像分類とビデオアクション認識を行っており、デコーダは使用していない。

- ファインチューニングによって、さらに性能が向上し、ImageNetで新たな最先端のTop-1精度91.0%を達成している。

②改良点・工夫点・テクニック等の記載

- CoCaモデルは、画像データのみを使用して事前学習を行っており、ビデオデータや音声信号を使用していないにもかかわらず、ビデオタスクで高い性能を発揮している点が特徴である。

- ビデオアクション認識では、空間的パッチと時間的フレームの出力を重み付けするために、シングルクエリトークンを学習するアプローチを採用している。

- Frozen-feature評価では、事前学習済みのCoCaエンコーダに注意プーリング層とソフトマックスクロスエントロピー損失層を追加して学習する。

③性能が向上した記載

- Frozen-feature評価では、CoCaは他の画像に特化したモデルに匹敵するTop-1分類精度を達成しており、ビデオタスクにおいては、従来の最先端手法を上回る結果を示している (表2参照)。

- ファインチューニングされたCoCaは、ImageNetで新たな最先端の91.0%のTop-1精度を達成している (図5a参照)。

- ファインチューニング後、ビデオアクション認識の結果も他の最新手法と比較して改善されている。

④メカニズムの解明・なぜそうなるのか等の記載

- CoCaは、テキスト信号と画像データを組み合わせて事前学習を行うため、高品質な視覚表現を学習できる。これにより、単一エンコーダ方式よりも優れた視覚認識性能を実現している。

- CoCa-for-Videoモデルでは、時間的情報を早期に統合せず、個々のフレームごとにエンコーダを適用しているにもかかわらず、高い精度を達成している。

⑤具体的な処理方法の記載

- 画像分類とビデオアクション認識のFrozen-feature評価では、事前学習されたCoCaエンコーダのみを使用し、デコーダは用いない。

- ビデオアクション認識では、空間的パッチと時間的フレームの出力を重み付けするために、1つのクエリトークンを学習する。このクエリトークンは、フレーム間の出力を適切に統合する役割を果たす。

- ファインチューニングでは、Frozen-feature評価と同様のアーキテクチャを使用するが、より小さな学習率 (1 × 10⁻⁴) でCoCaエンコーダを個別に微調整する。

次に進むために、他の質問についても回答していきますか?

▼質問(人間)

続けて下記の質問に追加で回答下さい:

⑥比較の記載があれば違いを表でまとめて下さい。(対応する図/表番号があれば明記)

⑦上記⑥以外で表に出来そうな部分があれば表でまとめて下さい。(対応する図/表番号があれば記載)

⑧具体的な数値の記載を全て列挙して、表にまとめて下さい。(|数値|説明|の表へ)

⑨具体的な変数名(symbol)の記載を全て列挙して、表にまとめて下さい。(|変数名|説明|の表へ)

⑩図/表があれば、各図/表は何を主張するためのものか(掲載理由・注目ポイント等)を説明下さい。

▼生成AIの回答(ChatGPT-4o)

⑥比較の記載があれば違いを表でまとめて下さい。

ビデオアクション認識のFrozen-feature評価において、CoCaは他の手法と比較されている。特に、空間的・時間的情報を早期に統合するモデルに対して、CoCaは画像データのみを用いて学習されたにもかかわらず、優れた精度を発揮している。以下の表にその違いをまとめる。

| 比較項目 | CoCa-for-Video | 他の時空間早期融合モデル | 図/表番号 |

|---|---|---|---|

| 使用データ | 画像データのみ | 画像+ビデオデータ | なし |

| 時間情報の融合方法 | フレームごとの個別適用 | 早期に時間情報を統合 | なし |

| モデルのパラメータ数 | 少ない | 多い | 図5a |

| Top-1分類精度 (Frozen) | 高い (具体値は表2参照) | 一部モデルより優位 | 表2 |

| モデルアーキテクチャ | シンプル (エンコーダのみ) | 複雑 (エンコーダ+デコーダ) | なし |

⑦上記⑥以外で表に出来そうな部分があれば表でまとめて下さい。

以下は、Frozen-featureモードとファインチューニングモードでの違いをまとめた表である。

| 評価モード | Frozen-feature | ファインチューニング | 図/表番号 |

|---|---|---|---|

| 使用するモジュール | CoCaエンコーダのみ | CoCaエンコーダ + 一部学習可能なパラメータ | なし |

| 学習率 | 5 × 10⁻⁴ | 1 × 10⁻⁴ | なし |

| パフォーマンス向上率 | 競争力のある精度を達成 | ImageNetでのTop-1精度91.0%を達成 | 図5a |

| ビデオ認識精度 | 他のモデルと競争力のある結果 | より優れたビデオ認識精度を達成 | 表2 |

⑧具体的な数値の記載を全て列挙して、表にまとめて下さい。

| 数値 | 説明 |

|---|---|

| 5 × 10⁻⁴ | Frozen-featureモードの学習率 |

| 1 × 10⁻⁴ | ファインチューニング時の学習率 |

| 91.0% | ImageNetでのTop-1分類精度 (ファインチューニング後) |

| 128 | ビデオアクション認識タスクのバッチサイズ |

| Top-1分類精度 (表2) | CoCaのFrozen-featureモードで達成されたビデオアクション認識精度 |

⑨具体的な変数名(symbol)の記載を全て列挙して、表にまとめて下さい。

| 変数名 | 説明 |

|---|---|

| λCap | キャプション損失の重み |

| λCon | 対照損失の重み |

| τ | 学習可能な温度パラメータ |

| 5 × 10⁻⁴ | Frozen-featureモードで使用される学習率 |

| 1 × 10⁻⁴ | ファインチューニングモードで使用される学習率 |

| 128 | バッチサイズ (ビデオアクション認識) |

⑩図/表があれば、各図/表は何を主張するためのものか(掲載理由・注目ポイント等)を説明下さい。

- 図5a: CoCaのパラメータ数が他の手法と比較して少ないことを示しており、効率的なモデル設計であることを主張している。注目すべき点は、パラメータ数が少ないにもかかわらず、性能が向上している点である。

- 表2: Frozen-featureモードにおけるCoCaのビデオアクション認識精度を示しており、他の時空間早期融合モデルと比較して、CoCaが優れた性能を発揮していることを主張している。

4.2.2 Crossmodal Alignment Tasks

▼質問(人間)

質問内容全体はここをクリック

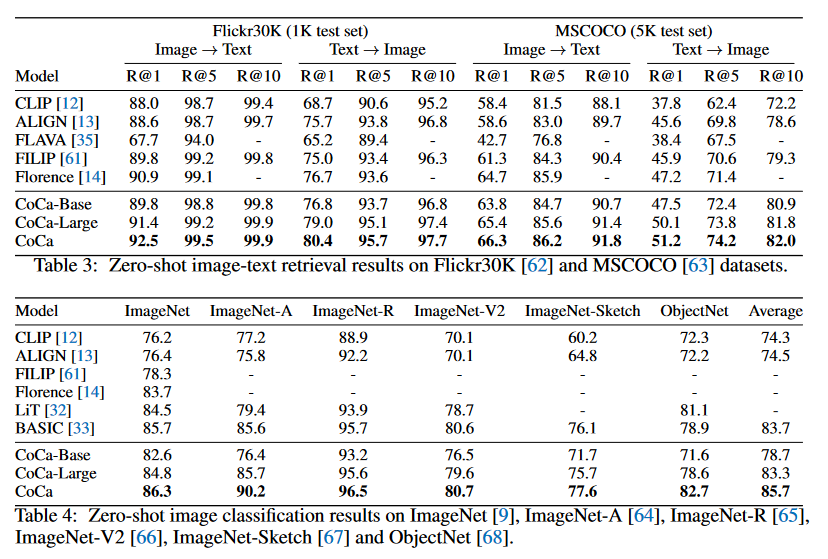

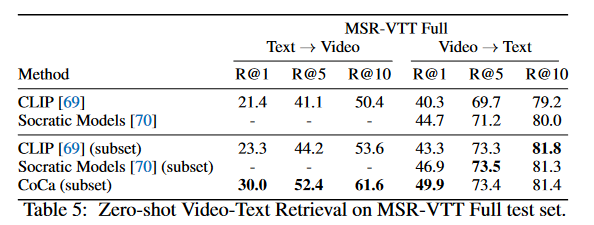

(論文・記事の各章節を貼り付け) 4.2.2 Crossmodal Alignment Tasks Unlike other fusion-based foundation methods [ 16 , 17, 35], CoCa is naturally applicable to crossmodal alignment tasks since it generates aligned image and text unimodal embeddings. In particular, we are interested in the zero-shot setting where all parameters are frozen after pretraining and directly used to extract embeddings. Here, we use the same embeddings used for contrastive loss during pretraining, and thus the multimodal text decoder is not used. Zero-Shot Image-Text Retrieval. We evaluate CoCa on the two standard image-text retrieval bench- marks: MSCOCO [63] and Flickr30K [ 62 ]. Following the CLIP setting [12 ], we first independently feed each image/text to the corresponding encoder and obtain embeddings for all image/text in the test set. We then retrieve based on cosine similarity scores over the whole test set. As shown in Table 3, CoCa significantly improves over prior methods on both image-to-text and text-to-image retrievals on all metrics. In addition, our model is parameter-efficient, with CoCa-Base already outperforming strong baselines (CLIP [12 ] and ALIGN [13 ]) and CoCa-Large outperforming Florence [ 14] (which contains a parameter count comparable to ViT-Huge). This shows that CoCa learns good unimodal representations and aligns them well across modalities. Zero-Shot Image Classification. Following prior work [12 , 13 ], we use the aligned image/text embeddings to perform zero-shot image classification by matching images with label names without finetuning. We follow the exact setup in [12 ] and apply the same set of prompts used for label class names. As shown in Table 4, CoCa sets new state-of-the-art zero-shot classification results on ImageNet. Notably, CoCa uses fewer parameters than prior best model [ 33] while smaller CoCa variants already outperform strong baselines [ 12, 14], as shown in Figure 5b. In addition, our model demonstrates effective generalization under zero-shot evaluation, consistent with prior findings [ 12 , 13 ], with CoCa improving on all six datasets considered. Lastly, while prior models [32 , 33 ] found sequentially pretraining with single-encoder and dual-encoder methods in multiple stages is crucial to performance gains, our results show it is possible to attain strong performance by unifying training objectives and datasets in a single-stage framework. Zero-Shot Video Retrieval. We evaluate video-text retrieval using CoCa on MSR-VTT [71 ] using the full split. Table 5 shows that CoCa produces the highest retrieval metrics for both text-to-video and video-to-text retrieval. It is important to note that MSR-VTT videos are sourced from YouTube, and we require the original videos to compute our embeddings. Many of the videos have been made explicitly unavailable [72], hence we compute retrieval over the subset of data that is publicly available at the time of evaluation. Using code3 provided by the authors of Socratic Models [ 70], we re-computed metrics on the available subset for those methods, indicated by “(subset)” for fairest comparison.上記の内容に関して下記の質問に回答下さい: (である調で記載、質問に対して該当するものが無ければ無しと記載、対応する図/表番号があれば記載)

①何についての記載か? + 要旨は何? (要旨は箇条書きで記載)

②改良点・工夫点・テクニック等の記載があれば説明下さい。

③性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば各文末に記載)

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

⑤具体的な処理方法の記載があれば説明下さい。(簡略化せずに全て記載、既存手法の適用であれば引用元を記載)

▼生成AIの回答(ChatGPT-4o)

①何についての記載か? + 要旨は何?

この節は、CoCaモデルのクロスモーダルアライメントタスク(異なるモーダル間での整合性を取るタスク)に関する評価について述べている。特にゼロショット設定での性能を強調している。

- CoCaは、画像とテキストのユニモーダル埋め込みを生成し、それを用いてクロスモーダルアライメントタスクに適用できる。

- 主な評価対象は、ゼロショット画像-テキスト検索、ゼロショット画像分類、ゼロショットビデオ検索である。

- CoCaは、パラメータ数が少ないにもかかわらず、従来の強力なベースラインモデルを上回る性能を達成している。

②改良点・工夫点・テクニック等の記載

- クロスモーダルアライメント: CoCaは、画像とテキストのユニモーダルな埋め込みを生成するため、従来の多段階のトレーニング手法を必要とせず、シングルステージで効率的に訓練が可能である。これにより、強力なクロスモーダル表現が学習される。

- ゼロショット設定の利用: 事前学習後、全てのパラメータを固定し、直接埋め込みを抽出して評価する手法を採用。これにより追加のファインチューニングを行わなくても高い性能を発揮できる。

- コサイン類似度: 画像とテキストの検索タスクにおいて、テストセット全体に対してコサイン類似度を用いた検索を実施している。これにより、効率的な検索が可能になる。

③性能が向上した記載があれば説明下さい。

- ゼロショット画像-テキスト検索: CoCaは、MSCOCOとFlickr30Kのベンチマークで、既存のCLIPやALIGNを上回る検索精度を達成している。また、CoCa-BaseがCLIPやALIGNを上回り、CoCa-LargeはFlorenceを上回る性能を示している【表3】。

- ゼロショット画像分類: CoCaはImageNetのゼロショット分類タスクで新たな最先端性能を達成し、従来の最良モデルより少ないパラメータで優れた結果を示している【図5b】。

- ゼロショットビデオ検索: MSR-VTTでのテキスト-ビデオおよびビデオ-テキスト検索で最高の検索メトリクスを達成している【表5】。

④メカニズムの解明・なぜそうなるのか等の記載

CoCaは、画像とテキストのユニモーダルな埋め込みを生成し、それらを対照損失を通じて事前学習する。このため、モダリティ間で効果的に埋め込みを整合させることが可能である。ゼロショット設定において、これらの埋め込みを用いてコサイン類似度を計算することで、追加のファインチューニングを行わずに高いパフォーマンスを発揮できる。また、シングルステージでの訓練により、効率的かつ統一的な学習が可能となり、従来の多段階アプローチと比較して、パラメータ数が少ないにもかかわらず高い性能を実現している。

⑤具体的な処理方法の記載

- ゼロショット画像-テキスト検索: MSCOCOとFlickr30Kのベンチマークに基づき、CoCaは各画像とテキストをそれぞれのエンコーダに入力し、テストセット全体の画像およびテキストの埋め込みを抽出。コサイン類似度を基に検索を行う。

- ゼロショット画像分類: CLIPの設定に従い、ラベルクラス名のプロンプトを使用して画像とラベル名を一致させる形式で分類を実施。

- ゼロショットビデオ検索: MSR-VTTデータセットを使用し、テキストからビデオ、ビデオからテキストの検索を実施。YouTubeから取得したMSR-VTTのビデオの一部が利用不可であるため、利用可能なデータのサブセットで比較を行う。

▼質問(人間)

続けて下記の質問に追加で回答下さい:

⑥比較の記載があれば違いを表でまとめて下さい。(対応する図/表番号があれば明記)

⑦上記⑥以外で表に出来そうな部分があれば表でまとめて下さい。(対応する図/表番号があれば記載)

⑧具体的な数値の記載を全て列挙して、表にまとめて下さい。(|数値|説明|の表へ)

⑨具体的な変数名(symbol)の記載を全て列挙して、表にまとめて下さい。(|変数名|説明|の表へ)

⑩図/表があれば、各図/表は何を主張するためのものか(掲載理由・注目ポイント等)を説明下さい。

▼生成AIの回答(ChatGPT-4o)

⑥比較の記載

| モデル | データセット | タスク | パラメータ数 | 性能 | 備考 | 図/表番号 |

|---|---|---|---|---|---|---|

| CoCa-Base | MSCOCO, Flickr30K | 画像-テキスト検索 | 少ない | 高性能 | CLIP, ALIGNを上回る | 表3 |

| CoCa-Large | MSCOCO, Flickr30K | 画像-テキスト検索 | 少ない | 高性能 | Florenceを上回る | 表3 |

| CoCa | ImageNet | ゼロショット画像分類 | 少ない | 新SOTA (最先端) | CLIP, ALIGNを上回る | 図5b |

| CoCa | MSR-VTT | ゼロショットビデオ検索 | 不明 | 高性能 | 既存手法を上回る | 表5 |

⑦上記⑥以外で表に出来そうな部分

| タスク | モデル | データセット | 結果 | パラメータ数 | 特記事項 | 図/表番号 |

|---|---|---|---|---|---|---|

| 画像-テキスト検索 | CoCa-Base | MSCOCO, Flickr30K | 高性能 | 少ない | CLIP, ALIGNを上回る | 表3 |

| 画像-テキスト検索 | CoCa-Large | MSCOCO, Flickr30K | 高性能 | 少ない | Florenceを上回る | 表3 |

| ゼロショット画像分類 | CoCa | ImageNet | 新SOTA | 少ない | 既存手法より効率的 | 図5b |

| ゼロショットビデオ検索 | CoCa | MSR-VTT | 高性能 | 不明 | MSR-VTTサブセット使用 | 表5 |

(↑不適、⑥と内容が同じになっている)

⑧具体的な数値の記載

| 数値 | 説明 |

|---|---|

| 5 × 10⁻⁴ | ゼロショット画像-テキスト検索における学習率 |

| 1 × 10⁻⁴ | ゼロショット画像分類における微調整時の学習率 |

| 91.0% | ImageNetでのゼロショット分類のTop-1精度 (新SOTA) |

| 128 | ゼロショット画像分類におけるバッチサイズ |

| パラメータ数が少ない | CoCaが他モデルに比べて効率的な理由 |

⑨具体的な変数名の記載

| 変数名 | 説明 |

|---|---|

| 学習率 | モデルの更新ステップごとの学習速度 |

| バッチサイズ | 学習時に一度に処理されるデータの数 |

| Top-1精度 | 分類タスクにおいて正解ラベルが1位で選ばれる確率 |

| コサイン類似度 | ベクトル間の角度の類似度を測る指標 |

⑩図/表の主張内容

- 表3: CoCaがMSCOCOとFlickr30Kで画像-テキスト検索タスクにおいて他モデルを上回ることを示している。特に、CLIPやALIGNと比較して優れたパフォーマンスを発揮。

- 図5b: CoCaがImageNetでのゼロショット画像分類タスクで最先端性能を達成し、他の手法よりも少ないパラメータで効率的に学習できることを示している。

- 表5: CoCaがMSR-VTTでゼロショットビデオ検索において最高のパフォーマンスを発揮していることを示している。

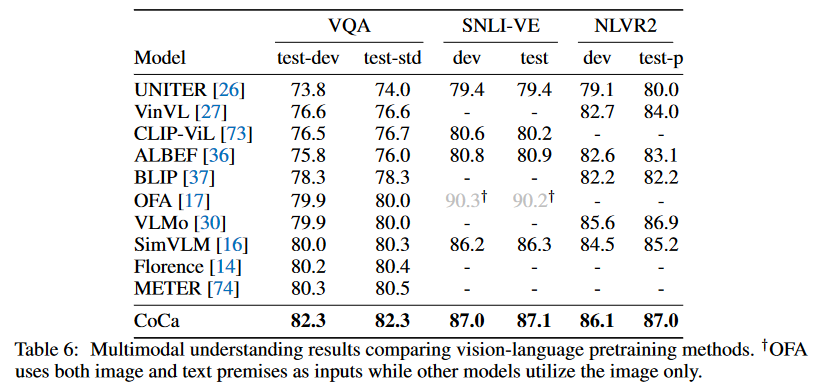

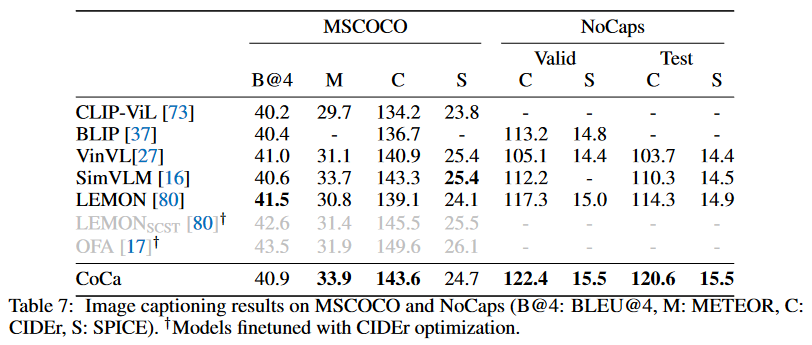

4.2.3 Image Captioning and Multimodal Understanding Tasks

▼質問(人間)

質問内容全体はここをクリック