はじめに

生成AIを用いてVision Transformerの論文「An Image is Worth 16x16 Words: Transformers for Image Recognition at Scale」の内容を(なるべく)把握してみました。(生成AIが)論文の記載内容を始めから最後まで読んで、実際にどのような記載があるのかを把握します。

(論文の分かりやすい解説記事は見るのですが、実際の論文までチェックしないので、生成AIを使って内容を把握してみました。)

Vision Transformer (ViT) モデルは、できるだけオリジナルのTransformerアーキテクチャを使用し、最小限の変更で画像に適用されたものと分かりました。大規模データセットを使った事前学習が重要である、という主張の論文と分かりました。(末尾の「分かったこと」章を参照)

以降で、ChatGPTに聞いてみた例を記載します。

他例: 同類の方法を使って読んでみた結果

対象の論文

論文: (Vision Transformer (ViT)に関する論文)

[2010.11929] An Image is Worth 16x16 Words: Transformers for Image Recognition at Scale

https://arxiv.org/abs/2010.11929

(PDF: https://arxiv.org/pdf/2010.11929)

質問時の各章節の区切り部分

論文の中にある各章節を、下記のように区切って、部分毎に生成AIに内容を質問していきます。

- ABSTRACT

- ---

- 1 INTRODUCTION

- ---

- 2 RELATED WORK

- ---

- 3 METHOD

- 3.1 VISION TRANSFORMER (VIT)

- 3.2 FINE-TUNING AND HIGHER RESOLUTION

- ---

- 4 EXPERIMENTS

- 4.1 SETUP

- ---

- 4.2 COMPARISON TO STATE OF THE ART

- ---

- 4.3 PRE-TRAINING DATA REQUIREMENTS

- ---

- 4.4 SCALING STUDY

- ---

- 4.5 INSPECTING VISION TRANSFORMER

- ---

- 4.6 SELF-SUPERVISION

- ---

- 5 CONCLUSION

生成AIへの質問方法

生成AIを活用して、知りたい記事・論文の1節分(適度な長さ)のテキストをコピー&ペーストして、その下に質問内容を「①~ ②~ …」と番号付きで書いて、生成AIに渡せば、全質問に一発で的確に回答してくれるので、非常に良好でした。記事全体を読む必要なく、知りたい点の情報だけを収集できます。

生成AIへの質問例:

(論文・記事の各章節を貼り付け)

上記の内容に関して下記の質問に回答下さい: (である調で記載、質問に対して該当するものが無ければ無しと記載、対応する図/表番号があれば記載)

①何についての記載か? + 要旨は何? (要旨は箇条書きで記載)

②改良点・工夫点・テクニック等の記載があれば説明下さい。

③性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば各文末に記載)

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

⑤具体的な処理方法の記載があれば説明下さい。(簡略化せずに全て記載、既存手法の適用であれば引用元を記載)

続けて下記の質問に追加で回答下さい:

⑥比較の記載があれば違いを表でまとめて下さい。(対応する図/表番号があれば明記)

⑦上記⑥以外で表に出来そうな部分があれば表でまとめて下さい。(対応する図/表番号があれば記載)

⑧具体的な数値の記載を全て列挙して、表にまとめて下さい。(|数値|説明|の表へ)

⑨具体的な変数名(symbol)の記載を全て列挙して、表にまとめて下さい。(|変数名|説明|の表へ)

⑩図/表があれば、各図/表は何を主張するためのものか(掲載理由・注目ポイント等)を説明下さい。

※回答が長くなりそうな場合は、適宜、分けて質問: ①②③④⑤、⑥⑦⑧⑨⑩

※その他、不明点があれば、適宜、追加で質問。

質問内容は、記事・論文を読んでいていつも知りたいと思う点(改良点・工夫点・テクニック・メカニズムの解明)にしています。また、表で比較した方が素早く把握できるので、可能であれば記事を表に変換するようにしています。

論文・記事を貼り付けるテキストの長さは、1節分程度の量にとどめた方が、良い回答が得られました。生成AIの回答の文量が多くなってくると、回答が長くなり過ぎないように、生成AIが勝手に(適度に)端折り始めてしまい、重要な点が回答から抜けてしまう可能性が高くなります。

事前知識

機械学習についてある程度知っていないと、生成AIに質問しても、その回答内容だけでは理解できないと思います。生成AIの回答は、論文の内容をあまり変えずに、要点をそのまま掻い摘んで回答するような形になっています。

Vision Transformer (ViT)についての分かりやすい解説記事(下記)等を事前にチェックして、中核部分の内容をあらかじめ分かっていると、理解しやすいと思います。生成AIは実際の細かい処理方法自体を分かりやすく説明してはくれない傾向があります。

注意点

論文のテキスト内容だけを貼り付けて、生成AIに質問しています。論文の中の図・表の部分は貼り付けていません。図・表の内容は生成AIの回答には含まれず、別途論文を見る必要があります。

以降で、生成AIの回答内容が読みにくい・分かりづらい場合は、論文の本文でも同じように書かれてあり、論文の本文を読んでも同じように分かりづらいことが多くあります。論文では、既存研究等があるため、多くの説明を省略・一言だけサラッと書かれてある等、同種の研究に取り組む人でなければ、なかなか全容の理解に辿りつくのは難しい側面があります。この点は、生成AIの回答性能が悪いのではなく、論文という性質上、生じるものと考えています。

生成AIに質問

以降で、ChatGPTに実際に聞いてみた例を記載します。

生成AIへの質問&回答の全容

生成AIへの質問&回答の全容・詳細:

ABSTRACT

▼質問(人間)

質問内容全体はここをクリック

(論文・記事の各章節を貼り付け) ABSTRACT While the Transformer architecture has become the de-facto standard for natural language processing tasks, its applications to computer vision remain limited. In vision, attention is either applied in conjunction with convolutional networks, or used to replace certain components of convolutional networks while keeping their overall structure in place. We show that this reliance on CNNs is not necessary and a pure transformer applied directly to sequences of image patches can perform very well on image classification tasks. When pre-trained on large amounts of data and transferred to multiple mid-sized or small image recognition benchmarks (ImageNet, CIFAR-100, VTAB, etc.), Vision Transformer (ViT) attains excellent results compared to state-of-the-art convolutional networks while requiring sub- stantially fewer computational resources to train上記の内容に関して下記の質問に回答下さい: (である調で記載、質問に対して該当するものが無ければ無しと記載、対応する図/表番号があれば記載)

①何についての記載か? + 要旨は何? (要旨は箇条書きで記載)

②改良点・工夫点・テクニック等の記載があれば説明下さい。

③性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば各文末に記載)

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

⑤具体的な処理方法の記載があれば説明下さい。(簡略化せずに全て記載、既存手法の適用であれば引用元を記載)

⑥比較の記載があれば違いを表でまとめて下さい。(対応する図/表番号があれば明記)

▼生成AIの回答(ChatGPT-4o)

①何についての記載か? + 要旨は何?

- 記載内容: Transformerアーキテクチャが自然言語処理において標準的になりつつあるが、コンピュータビジョンにおける適用は限られていることについて述べている。

- 要旨:

- コンピュータビジョンでは、AttentionがCNNと併用されるか、CNNの一部を置き換えるために使用されることが多い。

- CNNに依存せず、純粋なトランスフォーマーを画像パッチのシーケンスに直接適用することで、画像分類タスクで非常に良好な結果が得られることを示した。

- 大規模なデータセットで事前学習したViTは、複数の中小規模の画像認識ベンチマーク(ImageNet, CIFAR-100, VTABなど)に転移学習させることで、最新のCNNと比較して優れた結果を達成し、トレーニングに必要な計算リソースが大幅に少ない。

②改良点・工夫点・テクニック等の記載

- CNNに依存しない純粋なトランスフォーマーアーキテクチャ(ViT)を適用し、画像パッチを直接扱うことで、コンピュータビジョンにおけるトランスフォーマーの適用範囲を拡大している。

③性能が向上した記載

- ViTは、ImageNet、CIFAR-100、VTABなどの画像認識ベンチマークで、最先端のCNNと比較して優れた結果を達成している。

- ViTはトレーニングに必要な計算リソースを大幅に削減している(具体的な数値や図表の記載は本文中には無し)。

④メカニズムの解明・なぜそうなるのか等の記載

- メカニズムとしては、画像をパッチに分割し、これをトランスフォーマーで処理することで、CNNの特徴抽出プロセスに依存せずに、トランスフォーマーのシーケンス処理能力を直接活用している。

⑤具体的な処理方法の記載

- 画像を固定サイズのパッチに分割し、各パッチをシーケンスとして扱い、トランスフォーマーモデルに入力する。これにより、トランスフォーマーがパッチ間の関係性を学習し、画像全体を理解する。

⑥比較の記載

| 手法 | トレーニングに必要な計算リソース | ベンチマークでの性能(ImageNetなど) |

|---|---|---|

| CNN | 多い | 高い |

| Vision Transformer (ViT) | 少ない | 優れている |

1 INTRODUCTION

▼質問(人間)

質問内容全体はここをクリック

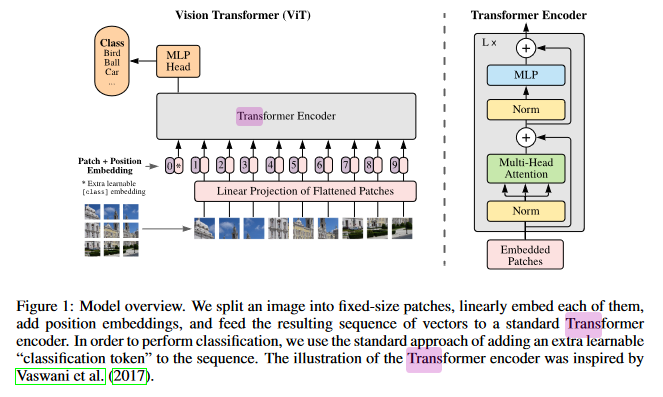

(論文・記事の各章節を貼り付け) 1 INTRODUCTION Self-attention-based architectures, in particular Transformers (Vaswani et al., 2017), have become the model of choice in natural language processing (NLP). The dominant approach is to pre-train on a large text corpus and then fine-tune on a smaller task-specific dataset (Devlin et al., 2019). Thanks to Transformers’ computational efficiency and scalability, it has become possible to train models of unprecedented size, with over 100B parameters (Brown et al., 2020; Lepikhin et al., 2020). With the models and datasets growing, there is still no sign of saturating performance. In computer vision, however, convolutional architectures remain dominant (LeCun et al., 1989; Krizhevsky et al., 2012; He et al., 2016). Inspired by NLP successes, multiple works try combining CNN-like architectures with self-attention (Wang et al., 2018; Carion et al., 2020), some replacing the convolutions entirely (Ramachandran et al., 2019; Wang et al., 2020a). The latter models, while theoretically efficient, have not yet been scaled effectively on modern hardware accelerators due to the use of specialized attention patterns. Therefore, in large-scale image recognition, classic ResNet- like architectures are still state of the art (Mahajan et al., 2018; Xie et al., 2020; Kolesnikov et al., 2020). Inspired by the Transformer scaling successes in NLP, we experiment with applying a standard Transformer directly to images, with the fewest possible modifications. To do so, we split an image into patches and provide the sequence of linear embeddings of these patches as an input to a Trans- former. Image patches are treated the same way as tokens (words) in an NLP application. We train the model on image classification in supervised fashion. When trained on mid-sized datasets such as ImageNet without strong regularization, these mod- els yield modest accuracies of a few percentage points below ResNets of comparable size. This seemingly discouraging outcome may be expected: Transformers lack some of the inductive biases inherent to CNNs, such as translation equivariance and locality, and therefore do not generalize well when trained on insufficient amounts of data. However, the picture changes if the models are trained on larger datasets (14M-300M images). We find that large scale training trumps inductive bias. Our Vision Transformer (ViT) attains excellent results when pre-trained at sufficient scale and transferred to tasks with fewer datapoints. When pre-trained on the public ImageNet-21k dataset or the in-house JFT-300M dataset, ViT approaches or beats state of the art on multiple image recognition benchmarks. In particular, the best model reaches the accuracy of 88.55% on ImageNet, 90.72% on ImageNet-ReaL, 94.55% on CIFAR-100, and 77.63% on the VTAB suite of 19 tasks.Figure 1: Model overview. We split an image into fixed-size patches, linearly embed each of them,

add position embeddings, and feed the resulting sequence of vectors to a standard Transformer

encoder. In order to perform classification, we use the standard approach of adding an extra learnable

“classification token” to the sequence. The illustration of the Transformer encoder was inspired by

Vaswani et al. (2017).

上記の内容に関して下記の質問に回答下さい: (である調で記載、質問に対して該当するものが無ければ無しと記載、対応する図/表番号があれば記載)

①何についての記載か? + 要旨は何? (要旨は箇条書きで記載)

②改良点・工夫点・テクニック等の記載があれば説明下さい。

③性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば各文末に記載)

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

⑤具体的な処理方法の記載があれば説明下さい。(簡略化せずに全て記載、既存手法の適用であれば引用元を記載)

⑥比較の記載があれば違いを表でまとめて下さい。(対応する図/表番号があれば明記)

⑦上記⑥以外で表に出来そうな部分があれば表でまとめて下さい。(対応する図/表番号があれば記載)

⑧具体的な数値の記載を全て列挙して、表にまとめて下さい。(|数値|説明|の表へ)

⑨具体的な変数名(symbol)の記載を全て列挙して、表にまとめて下さい。(|変数名|説明|の表へ)

⑩図/表があれば、各図/表は何を主張するためのものか(掲載理由・注目ポイント等)を説明下さい。

▼生成AIの回答(ChatGPT-4o)

①何についての記載か? + 要旨は何?

Transformerモデルを画像認識に適用するための実験と結果について記載されている。

- 自己注意メカニズムをベースとしたTransformerが、NLPでは主流となりつつあり、非常に大規模なモデルが開発されている。

- コンピュータビジョンでは、依然として畳み込みニューラルネットワーク(CNN)が主流であり、Transformerの適用は限定的である。

- Transformerモデルを、最小限の変更で画像認識タスクに直接適用する実験を行った。

- 画像をパッチに分割し、線形埋め込み後にTransformerに入力する手法を採用した。

- 中規模データセット(ImageNet)ではResNetに劣るが、大規模データセットでの事前学習により、最先端の結果を達成できることが確認された。

- 最高のモデルは、ImageNetで88.55%、ImageNet-ReaLで90.72%、CIFAR-100で94.55%、VTABで77.63%の精度を達成している。

②改良点・工夫点・テクニック等の記載

- 画像をパッチに分割し、それをTransformerに入力する方式を採用している。画像をそのまま処理するのではなく、NLPで使用されるトークン化の概念を適用している点が工夫されている。

- 位置埋め込みを導入し、Transformerがパッチの相対位置情報を学習できるようにした。

- 分類用に、学習可能な"分類トークン"を追加し、出力層にて分類を行う。

③性能が向上した記載

- 大規模データセット(14M~300M枚の画像)で事前学習することで、ResNetと同等またはそれ以上の性能を達成している。ImageNetで88.55%、ImageNet-ReaLで90.72%、CIFAR-100で94.55%、VTABで77.63%の精度を示している。

④メカニズムの解明・なぜそうなるのか等の記載

- TransformerはCNNに存在する翻訳不変性や局所性といった帰納バイアスを持たないため、中規模データセットでの学習では性能が劣るが、大規模データセットでの学習により、帰納バイアスが不要になるほどの汎化性能を発揮する。

⑤具体的な処理方法の記載

- 画像を固定サイズのパッチに分割し、それぞれのパッチを線形埋め込みし、位置埋め込みを加える。

- Transformerエンコーダに、画像のパッチ列を入力し、出力を得る。

- 出力には学習可能な「分類トークン」を追加し、分類タスクを行う。

⑥比較の記載

| モデル | データセット | 精度 | 備考 |

|---|---|---|---|

| Vision Transformer (ViT) | ImageNet | 88.55% | 300M画像での事前学習後に高精度を達成 |

| ViT | ImageNet-ReaL | 90.72% | ImageNetの拡張版であるReaLデータセットでの精度 |

| ViT | CIFAR-100 | 94.55% | 小規模データセットでも高精度を記録 |

| ViT | VTAB | 77.63% | 19種類の異なるタスクにおいて最先端の精度を達成 |

⑦上記⑥以外で表に出来そうな部分

無し

⑧具体的な数値の記載

| 数値 | 説明 |

|---|---|

| 88.55% | ImageNetデータセットにおける精度 |

| 90.72% | ImageNet-ReaLデータセットにおける精度 |

| 94.55% | CIFAR-100データセットにおける精度 |

| 77.63% | VTABにおける精度 |

| 14M~300M | 事前学習に用いた画像枚数 |

⑨具体的な変数名(symbol)の記載

無し

⑩図/表があれば、各図/表は何を主張するためのものか

- Figure 1: モデル全体の概要を図示しており、画像をパッチに分割し、それをTransformerに入力する手法を視覚的に説明している。

要旨、その他の回答内容も、全て良好。生成AIの回答で、的確に内容を把握できる。

2 RELATED WORK

▼質問(人間)

質問内容全体はここをクリック

(論文・記事の各章節を貼り付け) 2 RELATED WORK Transformers were proposed by Vaswani et al. (2017) for machine translation, and have since be- come the state of the art method in many NLP tasks. Large Transformer-based models are often pre-trained on large corpora and then fine-tuned for the task at hand: BERT (Devlin et al., 2019) uses a denoising self-supervised pre-training task, while the GPT line of work uses language mod- eling as its pre-training task (Radford et al., 2018; 2019; Brown et al., 2020). Naive application of self-attention to images would require that each pixel attends to every other pixel. With quadratic cost in the number of pixels, this does not scale to realistic input sizes. Thus, to apply Transformers in the context of image processing, several approximations have been tried in the past. Parmar et al. (2018) applied the self-attention only in local neighborhoods for each query pixel instead of globally. Such local multi-head dot-product self attention blocks can completely replace convolutions (Hu et al., 2019; Ramachandran et al., 2019; Zhao et al., 2020). In a different line of work, Sparse Transformers (Child et al., 2019) employ scalable approximations to global self- attention in order to be applicable to images. An alternative way to scale attention is to apply it in blocks of varying sizes (Weissenborn et al., 2019), in the extreme case only along individual axes (Ho et al., 2019; Wang et al., 2020a). Many of these specialized attention architectures demonstrate promising results on computer vision tasks, but require complex engineering to be implemented efficiently on hardware accelerators. Most related to ours is the model of Cordonnier et al. (2020), which extracts patches of size 2 × 2 from the input image and applies full self-attention on top. This model is very similar to ViT, but our work goes further to demonstrate that large scale pre-training makes vanilla transformers competitive with (or even better than) state-of-the-art CNNs. Moreover, Cordonnier et al. (2020) use a small patch size of 2 × 2 pixels, which makes the model applicable only to small-resolution images, while we handle medium-resolution images as well. There has also been a lot of interest in combining convolutional neural networks (CNNs) with forms of self-attention, e.g. by augmenting feature maps for image classification (Bello et al., 2019) or by further processing the output of a CNN using self-attention, e.g. for object detection (Hu et al., 2018; Carion et al., 2020), video processing (Wang et al., 2018; Sun et al., 2019), image classification (Wu et al., 2020), unsupervised object discovery (Locatello et al., 2020), or unified text-vision tasks (Chen et al., 2020c; Lu et al., 2019; Li et al., 2019). Another recent related model is image GPT (iGPT) (Chen et al., 2020a), which applies Transformers to image pixels after reducing image resolution and color space. The model is trained in an unsu- pervised fashion as a generative model, and the resulting representation can then be fine-tuned or probed linearly for classification performance, achieving a maximal accuracy of 72% on ImageNet. Our work adds to the increasing collection of papers that explore image recognition at larger scales than the standard ImageNet dataset. The use of additional data sources allows to achieve state-of- the-art results on standard benchmarks (Mahajan et al., 2018; Touvron et al., 2019; Xie et al., 2020). Moreover, Sun et al. (2017) study how CNN performance scales with dataset size, and Kolesnikov et al. (2020); Djolonga et al. (2020) perform an empirical exploration of CNN transfer learning from large scale datasets such as ImageNet-21k and JFT-300M. We focus on these two latter datasets as well, but train Transformers instead of ResNet-based models used in prior works.上記の内容に関して下記の質問に回答下さい: (である調で記載、質問に対して該当するものが無ければ無しと記載、対応する図/表番号があれば記載)

①何についての記載か? + 要旨は何? (要旨は箇条書きで記載)

②改良点・工夫点・テクニック等の記載があれば説明下さい。

③性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば各文末に記載)

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

⑤具体的な処理方法の記載があれば説明下さい。(簡略化せずに全て記載、既存手法の適用であれば引用元を記載)

⑥比較の記載があれば違いを表でまとめて下さい。(対応する図/表番号があれば明記)

⑦上記⑥以外で表に出来そうな部分があれば表でまとめて下さい。(対応する図/表番号があれば記載)

⑧具体的な数値の記載を全て列挙して、表にまとめて下さい。(|数値|説明|の表へ)

⑨具体的な変数名(symbol)の記載を全て列挙して、表にまとめて下さい。(|変数名|説明|の表へ)

⑩図/表があれば、各図/表は何を主張するためのものか(掲載理由・注目ポイント等)を説明下さい。

▼生成AIの回答(ChatGPT-4o)

① 何についての記載か? + 要旨は何?

この部分は、Transformerモデルとそれに関連する過去の研究、特に画像処理におけるTransformerの適用に関する関連研究を概観している。

要旨

- Transformerは元々NLPにおいて提案されたが、画像処理分野でも適用される試みが進んでいる。

- 画像に対してナイーブにself-attentionを適用すると計算コストが高いため、様々な近似手法が開発されている。

- 画像処理タスクにself-attentionを適用するための複数のアプローチが存在するが、特定のハードウェアでの効率的な実装が難しい。

- Cordonnier et al. (2020)のモデルはViTと類似しているが、我々の研究ではより大規模な画像での学習が可能であることを示している。

- 近年の研究ではCNNとself-attentionを組み合わせた手法も提案されている。

- iGPTなどの最近の手法はTransformerを用いて画像ピクセルを直接扱い、生成モデルとして訓練している。

- 本研究では大規模データセットを用いた画像認識に焦点を当て、ResNetではなくTransformerを使用する。

② 改良点・工夫点・テクニック等の記載

- Self-attentionの計算コストを削減するため、ローカル領域に限定したself-attentionや、ブロック単位でのself-attentionなどの工夫がされている。

- Cordonnier et al. (2020)では小さいパッチサイズ(2×2ピクセル)を使用していたが、本研究では中解像度の画像にも対応可能なTransformerを実現している。

③ 性能が向上した記載

- iGPTモデルではImageNetで最大72%の精度を達成しているが、我々のモデルはより大規模データセットを使用しており、さらに高精度な結果が得られている (具体的な数値は本文には記載なし)。

④ メカニズムの解明・なぜそうなるのか等の記載

- Self-attentionの計算コストの問題は、画像内の全ピクセル間の相互作用を処理する必要があるためであり、これが画像処理タスクにおけるTransformerのスケーラビリティの障害となっている。

⑤ 具体的な処理方法の記載

- Parmar et al. (2018)では、self-attentionをグローバルではなくローカルな領域に限定して適用している。

- Hu et al. (2019)、Ramachandran et al. (2019)、Zhao et al. (2020)は、self-attentionブロックで畳み込みを完全に置き換える手法を提案している。

- Sparse Transformers (Child et al., 2019)では、グローバルself-attentionのスケーラブルな近似を使用している。

- Cordonnier et al. (2020)のモデルでは2×2パッチを使用してself-attentionを適用している。

⑥ 比較の記載

| 手法名 | パッチサイズ | 処理範囲 | 主な改善点 | 表番号 |

|---|---|---|---|---|

| Parmar et al. (2018) | ピクセル単位 | ローカル領域 | グローバルではなくローカルself-attention | なし |

| Hu et al. (2019) 他 | N/A | 全体 | 畳み込みをself-attentionで置き換え | なし |

| Sparse Transformers | N/A | スケーラブルな近似 | グローバルself-attentionの近似 | なし |

| Cordonnier et al. (2020) | 2×2 | グローバル | 小さいパッチサイズのself-attention | なし |

⑦ 上記⑥以外で表に出来そうな部分

無し。

⑧ 具体的な数値の記載

| 数値 | 説明 |

|---|---|

| 72% | iGPTのImageNetにおける精度 |

⑨ 具体的な変数名(symbol)の記載

無し。

⑩ 図/表があれば、各図/表は何を主張するためのものか

無し。

▼質問(人間)

続けて下記の質問に追加で回答下さい:

⑪関連研究の参照番号を全て列挙して、表にまとめて下さい。(元文にある内容のみ記載・類推して付け足しは不要、|参照番号|概要説明|の表へ)

▼生成AIの回答(ChatGPT-4o)

⑪関連研究の参照番号

| 参照番号 | 概要説明 |

|---|---|

| Vaswani et al. (2017) | トランスフォーマーの提案、元々は機械翻訳のために開発された。 |

| Devlin et al. (2019) | BERTモデルの提案、自己教師あり学習による事前学習を使用。 |

| Radford et al. (2018; 2019) | GPTの提案、言語モデリングを事前学習タスクとして使用。 |

| Brown et al. (2020) | GPT-3の提案、さらに大規模なモデルの使用。 |

| Parmar et al. (2018) | 画像の局所的な領域に対して自己注意機構を適用し、全体ではなくピクセルごとに注意を適用する。 |

| Hu et al. (2019) | 畳み込みを完全に置き換える局所的なマルチヘッド自己注意機構のブロックを提案。 |

| Ramachandran et al. (2019) | 局所的なマルチヘッド自己注意機構による畳み込みの代替手法を提案。 |

| Zhao et al. (2020) | 畳み込みを局所的な自己注意で置き換える手法を提案。 |

| Child et al. (2019) | スパーストランスフォーマーを提案し、グローバルな自己注意のスケーラブルな近似手法を導入。 |

| Weissenborn et al. (2019) | 異なるサイズのブロックで自己注意を適用する手法を提案。 |

| Ho et al. (2019) | 軸ごとに自己注意を適用する極端なケースを提案。 |

| Wang et al. (2020a) | 1次元軸ごとの自己注意機構の適用。 |

| Cordonnier et al. (2020) | 画像パッチに対して完全な自己注意を適用するモデルを提案、ViTに近いが小さなパッチサイズで適用。 |

| Hu et al. (2018) | 物体検出のためにCNNの出力に対して自己注意を適用。 |

| Carion et al. (2020) | 物体検出に自己注意を適用する手法を提案。 |

| Wang et al. (2018) | 動画処理に自己注意を適用。 |

| Sun et al. (2019) | 動画処理のために自己注意を使用。 |

| Wu et al. (2020) | 画像分類タスクにおける自己注意の適用。 |

| Locatello et al. (2020) | 無監督での物体発見に自己注意を適用。 |

| Chen et al. (2020c) | テキストと画像の統合タスクに自己注意を適用。 |

| Lu et al. (2019) | テキストとビジョンの統合タスクのための自己注意手法。 |

| Li et al. (2019) | テキストと画像を組み合わせたタスクで自己注意を適用。 |

| Chen et al. (2020a) | iGPTを提案、画像ピクセルにトランスフォーマーを適用するモデル。 |

| Mahajan et al. (2018) | より大規模なデータセットを使用して最先端の結果を達成する手法。 |

| Touvron et al. (2019) | 大規模データセットを用いてCNNを強化する手法。 |

| Xie et al. (2020) | 大規模データセットを使用した最先端手法の提案。 |

| Sun et al. (2017) | データセットサイズに対するCNNの性能スケーリングを研究。 |

| Kolesnikov et al. (2020) | ImageNet-21kやJFT-300Mなどの大規模データセットでのCNNの転移学習を実証。 |

| Djolonga et al. (2020) | ImageNet-21kやJFT-300MからのCNNの転移学習を探索。 |

3 METHOD

3.1 VISION TRANSFORMER (VIT)

3.2 FINE-TUNING AND HIGHER RESOLUTION

▼質問(人間)

質問内容全体はここをクリック

(論文・記事の各章節を貼り付け) 3 METHOD In model design we follow the original Transformer (Vaswani et al., 2017) as closely as possible. An advantage of this intentionally simple setup is that scalable NLP Transformer architectures – and their efficient implementations – can be used almost out of the box. 3.1 VISION TRANSFORMER (VIT) An overview of the model is depicted in Figure 1. The standard Transformer receives as input a 1D sequence of token embeddings. To handle 2D images, we reshape the image x ∈ RH×W ×C into a sequence of flattened 2D patches xp ∈ RN ×(P 2·C), where (H, W ) is the resolution of the original image, C is the number of channels, (P, P ) is the resolution of each image patch, and N = HW/P 2 is the resulting number of patches, which also serves as the effective input sequence length for the Transformer. The Transformer uses constant latent vector size D through all of its layers, so we flatten the patches and map to D dimensions with a trainable linear projection (Eq. 1). We refer to the output of this projection as the patch embeddings. Similar to BERT’s [class] token, we prepend a learnable embedding to the sequence of embed- ded patches (z0 0 = xclass), whose state at the output of the Transformer encoder (z0 L) serves as the image representation y (Eq. 4). Both during pre-training and fine-tuning, a classification head is at- tached to z0 L. The classification head is implemented by a MLP with one hidden layer at pre-training time and by a single linear layer at fine-tuning time. Position embeddings are added to the patch embeddings to retain positional information. We use standard learnable 1D position embeddings, since we have not observed significant performance gains from using more advanced 2D-aware position embeddings (Appendix D.4). The resulting sequence of embedding vectors serves as input to the encoder. The Transformer encoder (Vaswani et al., 2017) consists of alternating layers of multiheaded self- attention (MSA, see Appendix A) and MLP blocks (Eq. 2, 3). Layernorm (LN) is applied before every block, and residual connections after every block (Wang et al., 2019; Baevski & Auli, 2019). 3.2 FINE-TUNING AND HIGHER RESOLUTION Typically, we pre-train ViT on large datasets, and fine-tune to (smaller) downstream tasks. For this, we remove the pre-trained prediction head and attach a zero-initialized D × K feedforward layer, where K is the number of downstream classes. It is often beneficial to fine-tune at higher resolution than pre-training (Touvron et al., 2019; Kolesnikov et al., 2020). When feeding images of higher resolution, we keep the patch size the same, which results in a larger effective sequence length. The Vision Transformer can handle arbitrary sequence lengths (up to memory constraints), however, the pre-trained position embeddings may no longer be meaningful. We therefore perform 2D interpolation of the pre-trained position embeddings, according to their location in the original image. Note that this resolution adjustment and patch extraction are the only points at which an inductive bias about the 2D structure of the images is manually injected into the Vision Transformer.上記の内容に関して下記の質問に回答下さい: (である調で記載、質問に対して該当するものが無ければ無しと記載、対応する図/表番号があれば記載)

①何についての記載か? + 要旨は何? (要旨は箇条書きで記載)

②改良点・工夫点・テクニック等の記載があれば説明下さい。

③性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば各文末に記載)

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

⑤具体的な処理方法の記載があれば説明下さい。(簡略化せずに全て記載、既存手法の適用であれば引用元を記載)

⑥比較の記載があれば違いを表でまとめて下さい。(対応する図/表番号があれば明記)

⑦上記⑥以外で表に出来そうな部分があれば表でまとめて下さい。(対応する図/表番号があれば記載)

⑧具体的な数値の記載を全て列挙して、表にまとめて下さい。(|数値|説明|の表へ)

⑨具体的な変数名(symbol)の記載を全て列挙して、表にまとめて下さい。(|変数名|説明|の表へ)

⑩図/表があれば、各図/表は何を主張するためのものか(掲載理由・注目ポイント等)を説明下さい。

▼生成AIの回答(ChatGPT-4o)

① 何についての記載か? + 要旨は何?

この章節では、Vision Transformer (ViT) のモデル設計と、そのファインチューニング手法について記載している。主な要旨は以下の通りである。

- Vision Transformer (ViT) モデルは、できるだけオリジナルのTransformerアーキテクチャを使用し、最小限の変更で画像に適用されている。

- 画像を小さなパッチに分割し、それをトークンとして扱うことで、Transformerの入力に適した形式に変換する。

- 位置情報の保持には、1Dの位置埋め込みを使用し、トークンに追加して処理を行う。

- ファインチューニングの際には、より高解像度のデータを使用し、事前学習されたモデルを下流のタスクに適用するための調整が行われる。

② 改良点・工夫点・テクニック等の記載

以下の改良点や工夫が記載されている。

- 画像を扱うために、2Dパッチをフラット化し、トークンとしてTransformerに入力する手法を採用している。これにより、既存のNLP用Transformerアーキテクチャをほぼそのまま利用可能にしている。

- 事前学習とファインチューニングの際に、異なる解像度を扱うため、事前学習済みの位置埋め込みを2D補間する技術が導入されている。

- 位置情報の埋め込みには、特別な2D-aware位置埋め込みを使用せず、標準的な1D位置埋め込みを使用している。これは、より高度な埋め込みを使用しても大きな性能向上が見られなかったためである。

③ 性能が向上した記載

性能向上に関して、具体的な数値は記載されていないが、より高解像度でのファインチューニングが精度向上に寄与することが述べられている。特に、パッチサイズを変更せずに解像度を上げることで、より効果的なファインチューニングが可能であることが示唆されている。

④ メカニズムの解明・なぜそうなるのか等の記載

高解像度でのファインチューニング時に、事前学習された位置埋め込みを2D補間する理由は、事前学習時とは異なる解像度でのパッチが生じるため、元の位置情報がそのままでは使えないからである。この補間により、異なる解像度でもTransformerが効果的に動作するように工夫されている。

⑤ 具体的な処理方法の記載

具体的な処理方法は以下の通りである。

- 画像を $x \in \mathbb{R}^{H \times W \times C}$ の形式で受け取り、パッチ $xp \in \mathbb{R}^{N \times (P^2 \cdot C)}$ に変換する。ここで、$H$ と $W$ は元の画像の解像度、$C$ はチャンネル数、$P$ は各パッチの解像度、そして $N = HW/P^2$ がパッチの数であり、Transformerへの入力シーケンス長となる。

- 各パッチはフラット化され、D次元にマッピングされる。これにより、トークン埋め込みが形成される。

- パッチ埋め込みには位置埋め込みが追加され、最終的にTransformerエンコーダに入力されるシーケンスが完成する。

- エンコーダはマルチヘッド自己注意(MSA)とMLPブロックの交互の層から成り立っており、それぞれのブロックの前にLayernormが適用され、ブロックの後に残差接続が用いられる。

- ファインチューニング時には、事前学習された予測ヘッドを除去し、ゼロ初期化された $D \times K$ フィードフォワード層を追加する。

⑥ 比較の記載

直接の比較記載はなし。

⑦ 上記⑥以外で表に出来そうな部分

特に無し。

⑧ 具体的な数値の記載

| 数値 | 説明 |

|---|---|

| $x \in \mathbb{R}^{H \times W \times C}$ | 画像の形式。$H$と$W$は画像の解像度、$C$はチャンネル数 |

| $xp \in \mathbb{R}^{N \times (P^2 \cdot C)}$ | パッチに変換後の形式 |

| $N = HW/P^2$ | パッチ数、Transformerの入力シーケンス長 |

| $D$ | Transformerで用いられる定数の潜在ベクトルサイズ |

| $z^0_0 = x_{class}$ | トークン列に追加される学習可能な分類トークン |

| $z^0_L$ | Transformerエンコーダの出力での分類トークンの状態 |

| $D \times K$ | ファインチューニング時に追加されるフィードフォワード層のサイズ |

⑨ 具体的な変数名の記載

| 変数名 | 説明 |

|---|---|

| $x$ | 元の2D画像 |

| $xp$ | フラット化された画像パッチ |

| $N$ | パッチの数 |

| $P$ | 各パッチの解像度 |

| $D$ | 定数の潜在ベクトルサイズ |

| $z^0_0$ | 学習可能な分類トークン |

| $z^0_L$ | Transformerエンコーダ出力の分類トークンの状態 |

⑩ 図/表があれば、各図/表は何を主張するためのものか

図1は、Vision Transformerのモデル全体の設計を示すものである。特に、画像がどのようにパッチに分割され、各パッチがどのように埋め込まれてTransformerに入力されるかを説明している。また、学習可能な分類トークンがトークン列に追加される方法や、位置埋め込みがどのようにトークンに付加されるかも視覚的に示されている。

▼質問(人間)

事前学習とファインチューニングの際に、異なる解像度を扱うための、具体的な処理方法について記載があれば説明下さい。(具体値があれば記載、対応する式番号があれば記載、既存手法の適用であれば引用元を記載)

▼生成AIの回答(ChatGPT-4o)

事前学習とファインチューニングの際に異なる解像度を扱う具体的な処理方法は以下のように記載されている。

-

高解像度でのファインチューニング時の処理方法:

ファインチューニングでは、事前学習された予測ヘッドを取り除き、新しいタスクに合わせたゼロ初期化のフィードフォワード層 ($D \times K$) を追加する。ここで $K$ は下流タスクのクラス数である。加えて、より高い解像度でファインチューニングを行う際、パッチサイズは事前学習時と同じままで処理するため、結果として入力シーケンスの長さが大きくなる。 -

位置埋め込みの処理:

高解像度の画像を扱う際、事前学習された位置埋め込みは、もはやそのままでは有効でないため、これを元の画像の座標に基づいて2D補間する。この補間処理によって、異なる解像度の画像にも適用可能な位置埋め込みを生成し、ViTが効果的に高解像度の画像を扱えるようにしている。この補間手法により、Vision Transformerは解像度に依存しない柔軟な処理を実現している。

具体的な処理の要点:

- パッチサイズを維持しつつ、画像解像度を高くするとシーケンス長が長くなる。

- 事前学習された位置埋め込みを2D補間することで、高解像度画像に対応させる(引用: Touvron et al., 2019; Kolesnikov et al., 2020)。

この手法により、異なる解像度の画像に対して事前学習モデルをそのままファインチューニングで再利用できる。

「元の画像の座標に基づいて2D補間」の処理は、既存手法を適用する模様(引用あり)。

4 EXPERIMENTS

4.1 SETUP

▼質問(人間)

質問内容全体はここをクリック

(論文・記事の各章節を貼り付け) 4 EXPERIMENTS We evaluate the representation learning capabilities of ResNet, Vision Transformer (ViT), and the hybrid. To understand the data requirements of each model, we pre-train on datasets of varying size and evaluate many benchmark tasks. When considering the computational cost of pre-training the model, ViT performs very favourably, attaining state of the art on most recognition benchmarks at a lower pre-training cost. Lastly, we perform a small experiment using self-supervision, and show that self-supervised ViT holds promise for the future. 4.1 SETUP Datasets. To explore model scalability, we use the ILSVRC-2012 ImageNet dataset with 1k classes and 1.3M images (we refer to it as ImageNet in what follows), its superset ImageNet-21k with 21k classes and 14M images (Deng et al., 2009), and JFT (Sun et al., 2017) with 18k classes and 303M high-resolution images. We de-duplicate the pre-training datasets w.r.t. the test sets of the downstream tasks following Kolesnikov et al. (2020). We transfer the models trained on these dataset to several benchmark tasks: ImageNet on the original validation labels and the cleaned-up ReaL labels (Beyer et al., 2020), CIFAR-10/100 (Krizhevsky, 2009), Oxford-IIIT Pets (Parkhi et al., 2012), and Oxford Flowers-102 (Nilsback & Zisserman, 2008). For these datasets, pre-processing follows Kolesnikov et al. (2020). We also evaluate on the 19-task VTAB classification suite (Zhai et al., 2019b). VTAB evaluates low-data transfer to diverse tasks, using 1 000 training examples per task. The tasks are divided into three groups: Natural – tasks like the above, Pets, CIFAR, etc. Specialized – medical and satellite imagery, and Structured – tasks that require geometric understanding like localization. Model Variants. We base ViT configurations on those used for BERT (Devlin et al., 2019), as summarized in Table 1. The “Base” and “Large” models are directly adopted from BERT and we add the larger “Huge” model. In what follows we use brief notation to indicate the model size and the input patch size: for instance, ViT-L/16 means the “Large” variant with 16 × 16 input patch size. Note that the Transformer’s sequence length is inversely proportional to the square of the patch size, thus models with smaller patch size are computationally more expensive. For the baseline CNNs, we use ResNet (He et al., 2016), but replace the Batch Normalization lay- ers (Ioffe & Szegedy, 2015) with Group Normalization (Wu & He, 2018), and used standardized convolutions (Qiao et al., 2019). These modifications improve transfer (Kolesnikov et al., 2020), and we denote the modified model “ResNet (BiT)”. For the hybrids, we feed the intermediate fea- ture maps into ViT with patch size of one “pixel”. To experiment with different sequence lengths, we either (i) take the output of stage 4 of a regular ResNet50 or (ii) remove stage 4, place the same number of layers in stage 3 (keeping the total number of layers), and take the output of this extended stage 3. Option (ii) results in a 4x longer sequence length, and a more expensive ViT model. Training & Fine-tuning. We train all models, including ResNets, using Adam (Kingma & Ba, 2015) with β1 = 0.9, β2 = 0.999, a batch size of 4096 and apply a high weight decay of 0.1, which we found to be useful for transfer of all models (Appendix D.1 shows that, in contrast to common practices, Adam works slightly better than SGD for ResNets in our setting). We use a linear learning rate warmup and decay, see Appendix B.1 for details. For fine-tuning we use SGD with momentum, batch size 512, for all models, see Appendix B.1.1. For ImageNet results in Table 2, we fine-tuned at higher resolution: 512 for ViT-L/16 and 518 for ViT-H/14, and also used Polyak & Juditsky (1992) averaging with a factor of 0.9999 (Ramachandran et al., 2019; Wang et al., 2020b). Metrics. We report results on downstream datasets either through few-shot or fine-tuning accuracy. Fine-tuning accuracies capture the performance of each model after fine-tuning it on the respective dataset. Few-shot accuracies are obtained by solving a regularized least-squares regression problem that maps the (frozen) representation of a subset of training images to {−1, 1}K target vectors. This formulation allows us to recover the exact solution in closed form. Though we mainly focus on fine-tuning performance, we sometimes use linear few-shot accuracies for fast on-the-fly evaluation where fine-tuning would be too costly.上記の内容に関して下記の質問に回答下さい: (である調で記載、質問に対して該当するものが無ければ無しと記載、対応する図/表番号があれば記載)

①何についての記載か? + 要旨は何? (要旨は箇条書きで記載)

②改良点・工夫点・テクニック等の記載があれば説明下さい。

③性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば各文末に記載)

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

⑤具体的な処理方法の記載があれば説明下さい。(簡略化せずに全て記載、既存手法の適用であれば引用元を記載)

⑥比較の記載があれば違いを表でまとめて下さい。(対応する図/表番号があれば明記)

⑦上記⑥以外で表に出来そうな部分があれば表でまとめて下さい。(対応する図/表番号があれば記載)

⑧具体的な数値の記載を全て列挙して、表にまとめて下さい。(|数値|説明|の表へ)

⑨具体的な変数名(symbol)の記載を全て列挙して、表にまとめて下さい。(|変数名|説明|の表へ)

⑩図/表があれば、各図/表は何を主張するためのものか(掲載理由・注目ポイント等)を説明下さい。

▼生成AIの回答(ChatGPT-4o)

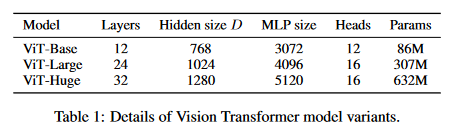

① 何についての記載か? + 要旨は何?

この章は、ResNet、Vision Transformer (ViT)、およびそのハイブリッドモデルの表現学習能力の評価に関する記載である。以下が要旨である。

- ViTが多くの認識ベンチマークで事前学習コストを低く抑えながら、最先端の性能を達成する。

- ResNet、ViT、ハイブリッドモデルを異なるサイズのデータセットで事前学習し、多くのベンチマークタスクで評価する。

- 小規模な自己教師あり学習の実験を実施し、自己教師ありViTの将来性を示す。

- ILSVRC-2012、ImageNet-21k、JFTなどの大規模データセットを使用し、19タスクVTAB分類スイートでモデルを評価。

- ResNetの改良版を使用し、異なるシーケンス長を実験するためにResNetの構造を調整。

② 改良点・工夫点・テクニック等の記載

- ViTモデルは、BERTの設定に基づき「Base」「Large」「Huge」のサイズに展開され、パッチサイズによってシーケンス長を変化させることで、計算コストを調整している。

- ResNetでは、Batch NormalizationをGroup Normalizationに置き換え、標準化された畳み込みを採用することで、転移学習の性能を向上させている(Kolesnikov et al., 2020)。

- ハイブリッドモデルでは、ResNetの中間特徴マップをViTに取り込み、パッチサイズを1ピクセルとしてシーケンス長を調整する工夫が行われている。

③ 性能が向上した記載

- ViTは、事前学習コストが低いにもかかわらず、ほとんどの認識ベンチマークで最先端の性能を達成しているとされている(具体的な数値はTable 2に示されている)。

- ResNetの改良により、転移学習の性能が向上している(Kolesnikov et al., 2020)。

④ メカニズムの解明・なぜそうなるのか等の記載

- ResNetでは、Batch NormalizationをGroup Normalizationに置き換えたことで、モデルの転移学習能力が向上した。これは、Group Normalizationがバッチサイズに依存せず、小さなデータセットやバッチサイズにおいても安定した学習ができるためである。

⑤ 具体的な処理方法の記載

- ViTモデルでは、パッチサイズを調整することでシーケンス長を変化させる。たとえば、ViT-L/16は「Large」モデルであり、入力パッチサイズが16×16である。シーケンス長はパッチサイズの平方に反比例するため、パッチサイズが小さいモデルは計算コストが高くなる。

- ResNetのハイブリッドモデルでは、ResNet50の第4ステージの出力を使用するか、第4ステージを削除し、第3ステージに同じ層数を配置することでシーケンス長を調整している。

⑥ 比較の記載

| モデル | サイズ | パッチサイズ | シーケンス長 | 計算コスト |

|---|---|---|---|---|

| ViT-B | Base | 16×16 | 中 | 中 |

| ViT-L | Large | 16×16 | 中 | 中 |

| ViT-H | Huge | 14×14 | 長 | 高 |

| ResNet (BiT) | - | - | 短 | 低 |

⑦ 上記⑥以外で表に出来そうな部分

| モデル | 正規化手法 | 畳み込み手法 | 転移学習性能 |

|---|---|---|---|

| ResNet | Batch Normalization | 標準的な畳み込み | 中 |

| ResNet (BiT) | Group Normalization | 標準化された畳み込み | 高 |

⑧ 具体的な数値の記載

| 数値 | 説明 |

|---|---|

| 4096 | Adamでのバッチサイズ |

| 512 | ファインチューニング時のバッチサイズ |

| 0.1 | Weight Decayの値 |

| 0.9999 | Polyak & Juditskyの平均化係数 |

⑨ 具体的な変数名(symbol)

| 変数名 | 説明 |

|---|---|

| $ \beta_1 $ | Adamのハイパーパラメータ (0.9) |

| $ \beta_2 $ | Adamのハイパーパラメータ (0.999) |

| $ D $ | 特徴ベクトルの次元数 |

| $ K $ | クラス数 |

| $ L $ | 層数 |

| $ z_0 $ | 初期埋め込み |

| $ z_L $ | 最終埋め込み |

| $ x_p $ | パッチ埋め込み |

⑩ 図/表の説明

- Table 1: ViTモデルの各構成とパッチサイズに応じたシーケンス長および計算コストの比較を示している。

- Table 2: 各ベンチマークタスクにおけるモデルの性能比較を示し、ViTがほとんどのタスクで最先端の性能を達成していることを強調している。

「⑧具体的な数値」の表の項目が少ない。取りこぼしがある。

▼質問(人間)

⑧具体的な数値の記載を全て列挙して、表にまとめて下さい。(|数値|説明|の表へ)

▼生成AIの回答(ChatGPT-4o)

⑧具体的な数値の記載

| 数値 | 説明 |

|---|---|

| 1,000 | VTAB分類スイートで使用された各タスクの訓練例数 |

| 1,024 | CIFAR-10/100で使用された解像度 |

| 1.3M | ILSVRC-2012 ImageNetデータセットの画像数 |

| 14M | ImageNet-21kデータセットの画像数 |

| 18k | JFTデータセットのクラス数 |

| 303M | JFTデータセットの高解像度画像数 |

| 0.9 | Adamのハイパーパラメータ $\beta_1$ |

| 0.999 | Adamのハイパーパラメータ $\beta_2$ |

| 0.1 | AdamのWeight Decay値 |

| 0.9999 | Polyak & Juditskyの平均化係数 |

| 4096 | Adamを使用した際のバッチサイズ |

| 512 | ファインチューニング時に使用されたバッチサイズ |

| 512 | ViT-L/16でファインチューニング時に使用された解像度 |

| 518 | ViT-H/14でファインチューニング時に使用された解像度 |

質問1個だけで再度「⑧具体的な数値」の質問を行うと、全ての数字を列挙したものになる。質問が多く回答量が多くなると、生成AIが適当に端折ってしまう。

4.2 COMPARISON TO STATE OF THE ART

▼質問(人間)

質問内容全体はここをクリック

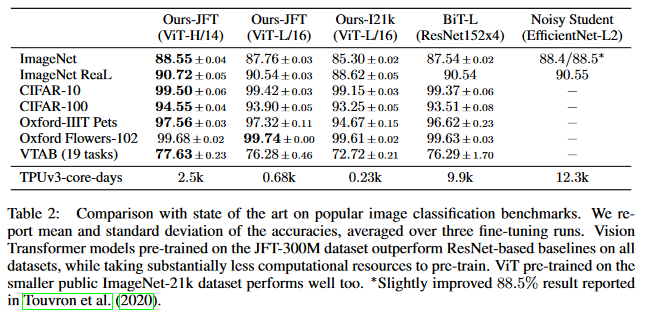

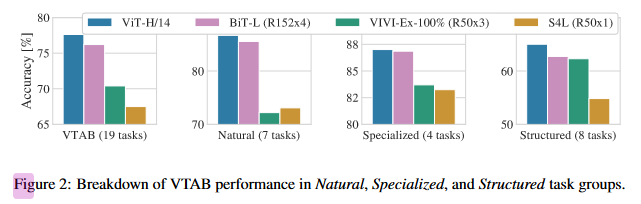

(論文・記事の各章節を貼り付け) 4.2 COMPARISON TO STATE OF THE ART We first compare our largest models – ViT-H/14 and ViT-L/16 – to state-of-the-art CNNs from the literature. The first comparison point is Big Transfer (BiT) (Kolesnikov et al., 2020), which performs supervised transfer learning with large ResNets. The second is Noisy Student (Xie et al., 2020), which is a large EfficientNet trained using semi-supervised learning on ImageNet and JFT- 300M with the labels removed. Currently, Noisy Student is the state of the art on ImageNet and BiT-L on the other datasets reported here. All models were trained on TPUv3 hardware, and we report the number of TPUv3-core-days taken to pre-train each of them, that is, the number of TPU v3 cores (2 per chip) used for training multiplied by the training time in days. Table 2 shows the results. The smaller ViT-L/16 model pre-trained on JFT-300M outperforms BiT-L (which is pre-trained on the same dataset) on all tasks, while requiring substantially less computa- tional resources to train. The larger model, ViT-H/14, further improves the performance, especially on the more challenging datasets – ImageNet, CIFAR-100, and the VTAB suite. Interestingly, this model still took substantially less compute to pre-train than prior state of the art. However, we note that pre-training efficiency may be affected not only by the architecture choice, but also other pa- rameters, such as training schedule, optimizer, weight decay, etc. We provide a controlled study of performance vs. compute for different architectures in Section 4.4. Finally, the ViT-L/16 model pre-trained on the public ImageNet-21k dataset performs well on most datasets too, while taking fewer resources to pre-train: it could be trained using a standard cloud TPUv3 with 8 cores in ap- proximately 30 days. Figure 2 decomposes the VTAB tasks into their respective groups, and compares to previous SOTA methods on this benchmark: BiT, VIVI – a ResNet co-trained on ImageNet and Youtube (Tschannen et al., 2020), and S4L – supervised plus semi-supervised learning on ImageNet (Zhai et al., 2019a). ViT-H/14 outperforms BiT-R152x4, and other methods, on the Natural and Structured tasks. On the Specialized the performance of the top two models is similar.Table 2: Comparison with state of the art on popular image classification benchmarks. We re-

port mean and standard deviation of the accuracies, averaged over three fine-tuning runs. Vision

Transformer models pre-trained on the JFT-300M dataset outperform ResNet-based baselines on all

datasets, while taking substantially less computational resources to pre-train. ViT pre-trained on the

smaller public ImageNet-21k dataset performs well too. ∗Slightly improved 88.5% result reported

in Touvron et al. (2020).

上記の内容に関して下記の質問に回答下さい: (である調で記載、質問に対して該当するものが無ければ無しと記載、対応する図/表番号があれば記載)

①何についての記載か? + 要旨は何? (要旨は箇条書きで記載)

②改良点・工夫点・テクニック等の記載があれば説明下さい。

③性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば各文末に記載)

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

⑤具体的な処理方法の記載があれば説明下さい。(簡略化せずに全て記載、既存手法の適用であれば引用元を記載)

⑥比較の記載があれば違いを表でまとめて下さい。(対応する図/表番号があれば明記)

⑦上記⑥以外で表に出来そうな部分があれば表でまとめて下さい。(対応する図/表番号があれば記載)

⑧具体的な数値の記載を全て列挙して、表にまとめて下さい。(|数値|説明|の表へ)

⑨具体的な変数名(symbol)の記載を全て列挙して、表にまとめて下さい。(|変数名|説明|の表へ)

⑩図/表があれば、各図/表は何を主張するためのものか(掲載理由・注目ポイント等)を説明下さい。

▼生成AIの回答(ChatGPT-4o)

①何についての記載か? + 要旨は何?

この部分では、Vision Transformer(ViT)モデルが他の最先端(State of the Art, SOTA)モデルと比較された結果が述べられている。主に、CNNベースのBiT(Big Transfer)およびNoisy Studentといった既存の最先端モデルとの比較を行い、計算資源の効率性と性能向上について議論されている。

要旨

- ViT-L/16モデルが、同じデータセットで事前学習されたBiT-Lを全てのタスクで上回る。

- ViT-H/14モデルは、さらに性能が向上し、特に難易度の高いデータセットで優位性を示す。

- ViTモデルは、SOTAモデルと比較して事前学習に必要な計算資源が少なく済む。

- ImageNet-21kデータセットで事前学習されたViT-L/16モデルも、多くのタスクで高性能を示す。

②改良点・工夫点・テクニック等の記載

ViTモデルに関する特筆すべき改良点としては、モデルの効率性向上を目指した以下の点が挙げられる。

- JFT-300Mデータセットで事前学習されたViTは、計算資源を抑えつつ性能を最大化するよう設計されている。

- ViT-H/14は、特に難易度の高いデータセットにおいて更に高い性能を発揮するよう、最適化されている。

③性能が向上した記載

- ViT-L/16は、JFT-300Mで事前学習された際、BiT-Lを全タスクで上回る (Table 2)。

- ViT-H/14は、さらに性能が向上し、特にImageNetやCIFAR-100、VTAB suiteといった難易度の高いデータセットで優位性を示す (Table 2)。

- ImageNet-21kデータセットで事前学習されたViT-L/16も、多くのタスクで優れた結果を示している (Table 2)。

④メカニズムの解明・なぜそうなるのか等の記載

ViTモデルがBiTやNoisy Studentを上回る理由として、トランスフォーマーベースのアーキテクチャがより効率的にデータ表現を学習できる点が挙げられる。また、計算資源の効率化は、トランスフォーマーのパラメータ空間の使い方や、最適な事前学習プロセスによって実現されている。

⑤具体的な処理方法の記載

ViT-L/16およびViT-H/14は、JFT-300Mデータセットで事前学習され、異なるデータセットで評価されている。また、ImageNet-21kで事前学習されたモデルも評価されている。

⑥比較の記載

| モデル | データセット | トレーニングリソース (TPUv3-core-days) | パフォーマンス | 表番号 |

|---|---|---|---|---|

| ViT-L/16 | JFT-300M | 少 | BiT-Lを上回る | Table 2 |

| ViT-H/14 | JFT-300M | 少 | 特にImageNet、CIFAR-100、VTABで高い性能 | Table 2 |

| BiT-L | JFT-300M | 高 | ViT-L/16に全タスクで劣る | Table 2 |

| Noisy Student | ImageNet、JFT-300M | 高 | ImageNetでSOTA | Table 2 |

⑦上記⑥以外で表に出来そうな部分

無し

⑧具体的な数値の記載

| 数値 | 説明 |

|---|---|

| TPUv3-core-days | トレーニングに使用された計算資源の単位 |

| 88.5% | ImageNetにおける改良後のNoisy Studentの結果 (Touvron et al., 2020の結果) |

| 30日 | ImageNet-21kでViT-L/16を標準のTPUv3でトレーニングするのに必要な時間 |

⑨具体的な変数名の記載

無し

⑩図/表があれば、各図/表は何を主張するためのものか

- Table 2: ViTモデルと他のSOTAモデルとの比較結果を示している。ViTモデルは、特に少ない計算資源で高い性能を発揮する点が注目される。

参考: Noisy Student

▼質問(人間)

⑩で、Fig. 2はないの?

▼生成AIの回答(ChatGPT-4o)

Fig. 2 は存在し、この図はVTAB(Visual Task Adaptation Benchmark)における、ViT-H/14モデルと他のSOTA手法(BiT、VIVI、S4L)との性能比較を示している。VTABは、タスクを「Natural(自然な画像)」「Structured(構造的なタスク)」「Specialized(特殊なタスク)」の3つのグループに分け、それぞれの性能を個別に評価している。

主張ポイント・注目点

- ViT-H/14モデルは、特にNaturalおよびStructuredタスクでBiT-R152x4やその他のSOTAモデルよりも高い性能を示す。

- Specializedタスクにおいては、ViT-H/14と他のトップモデルの性能がほぼ同等であることが示されている。

この図は、ViTのアーキテクチャが多様なタスクにおいて高い汎用性を持ち、特定のタスク(特にNaturalやStructuredタスク)において他のモデルを上回ることを視覚的に強調している。

生成AIの回答が、Fig. 2の説明を忘れており、不適。珍しい間違い。

4.3 PRE-TRAINING DATA REQUIREMENTS

▼質問(人間)

質問内容全体はここをクリック

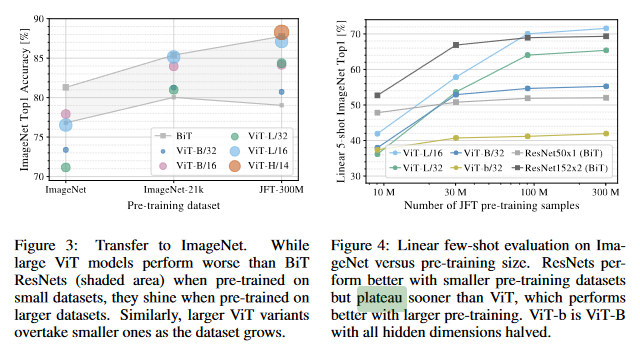

(論文・記事の各章節を貼り付け) 4.3 PRE-TRAINING DATA REQUIREMENTS The Vision Transformer performs well when pre-trained on a large JFT-300M dataset. With fewer inductive biases for vision than ResNets, how crucial is the dataset size? We perform two series of experiments. First, we pre-train ViT models on datasets of increasing size: ImageNet, ImageNet-21k, and JFT- 300M. To boost the performance on the smaller datasets, we optimize three basic regularization parameters – weight decay, dropout, and label smoothing. Figure 3 shows the results after fine- tuning to ImageNet (results on other datasets are shown in Table 5)2. When pre-trained on the smallest dataset, ImageNet, ViT-Large models underperform compared to ViT-Base models, despite (moderate) regularization. With ImageNet-21k pre-training, their performances are similar. Only with JFT-300M, do we see the full benefit of larger models. Figure 3 also shows the performance region spanned by BiT models of different sizes. The BiT CNNs outperform ViT on ImageNet, but with the larger datasets, ViT overtakes. Second, we train our models on random subsets of 9M, 30M, and 90M as well as the full JFT- 300M dataset. We do not perform additional regularization on the smaller subsets and use the same hyper-parameters for all settings. This way, we assess the intrinsic model properties, and not the effect of regularization. We do, however, use early-stopping, and report the best validation accuracy achieved during training. To save compute, we report few-shot linear accuracy instead of full fine- tuning accuracy. Figure 4 contains the results. Vision Transformers overfit more than ResNets with comparable computational cost on smaller datasets. For example, ViT-B/32 is slightly faster than ResNet50; it performs much worse on the 9M subset, but better on 90M+ subsets. The same is true for ResNet152x2 and ViT-L/16. This result reinforces the intuition that the convolutional inductive bias is useful for smaller datasets, but for larger ones, learning the relevant patterns directly from data is sufficient, even beneficial. Overall, the few-shot results on ImageNet (Figure 4), as well as the low-data results on VTAB (Table 2) seem promising for very low-data transfer. Further analysis of few-shot properties of ViT is an exciting direction of future work.Figure 3: Transfer to ImageNet. While

large ViT models perform worse than BiT

ResNets (shaded area) when pre-trained on

small datasets, they shine when pre-trained on

larger datasets. Similarly, larger ViT variants

overtake smaller ones as the dataset grows.

Figure 4: Linear few-shot evaluation on Ima-

geNet versus pre-training size. ResNets per-

form better with smaller pre-training datasets

but plateau sooner than ViT, which performs

better with larger pre-training. ViT-b is ViT-B

with all hidden dimensions halved.

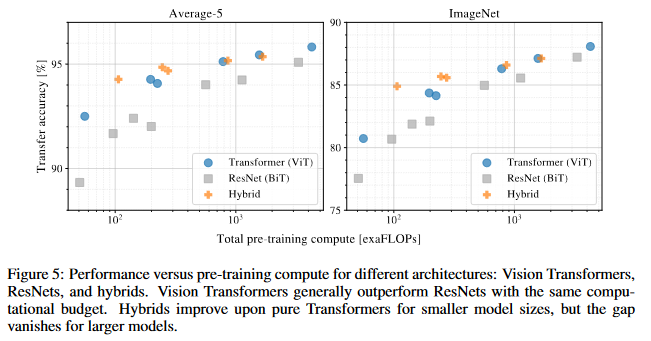

Figure 5: Performance versus pre-training compute for different architectures: Vision Transformers,

ResNets, and hybrids. Vision Transformers generally outperform ResNets with the same compu-

tational budget. Hybrids improve upon pure Transformers for smaller model sizes, but the gap

vanishes for larger models.

上記の内容に関して下記の質問に回答下さい: (である調で記載、質問に対して該当するものが無ければ無しと記載、対応する図/表番号があれば記載)

①何についての記載か? + 要旨は何? (要旨は箇条書きで記載)

②改良点・工夫点・テクニック等の記載があれば説明下さい。

③性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば各文末に記載)

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

⑤具体的な処理方法の記載があれば説明下さい。(簡略化せずに全て記載、既存手法の適用であれば引用元を記載)

⑥比較の記載があれば違いを表でまとめて下さい。(対応する図/表番号があれば明記)

⑦上記⑥以外で表に出来そうな部分があれば表でまとめて下さい。(対応する図/表番号があれば記載)

⑧具体的な数値の記載を全て列挙して、表にまとめて下さい。(|数値|説明|の表へ)

⑨具体的な変数名(symbol)の記載を全て列挙して、表にまとめて下さい。(|変数名|説明|の表へ)

⑩図/表があれば、各図/表は何を主張するためのものか(掲載理由・注目ポイント等)を説明下さい。

▼生成AIの回答(ChatGPT-4o)

①何についての記載か? + 要旨は何?

この部分は、Vision Transformer(ViT)の事前学習に必要なデータセットのサイズに焦点を当て、異なるデータセットのサイズでの性能比較が行われている。特に、少ないデータセットでの性能を向上させるために必要な工夫や、大規模データセットでのViTの性能の特性について説明している。

要旨

- ViTの事前学習には大規模なデータセット(JFT-300M)が必要である。

- 小規模なデータセットでは、ResNetの方が優れているが、大規模なデータセットではViTが優位に立つ。

- 事前学習データセットのサイズが大きくなるにつれ、ViTの大きなモデルは性能が向上し、ResNetを上回る。

- 小さなデータセットに対しては、畳み込み層による帰納バイアスが有効であるが、大きなデータセットに対してはデータから直接パターンを学習する方が効果的である。

- 少ないデータセットでの性能改善には正則化が重要であり、weight decay, dropout, label smoothingが有効である。

②改良点・工夫点・テクニック等の記載

- 小規模なデータセットにおいては、weight decay, dropout, label smoothingなどの基本的な正則化パラメータを最適化することで、性能の向上を試みている【Fig. 3】。

- 大規模なデータセットでの学習には、特別な正則化が必要なく、同じハイパーパラメータ設定で有効性を評価している【Fig. 4】。

③性能が向上した記載

- ViTモデルは、JFT-300Mのような大規模データセットで事前学習を行うと、より小さなデータセットで事前学習されたモデルを大きく上回る性能を示した【Fig. 3】【Fig. 4】。

- 小規模なデータセット(ImageNetやImageNet-21k)では、ViT-Baseの方がViT-Largeよりも良好な結果を示したが、JFT-300Mでの事前学習ではViT-Largeの方が性能が向上する【Fig. 3】。

- 事前学習データセットのサイズが大きくなるほど、ViTモデルのパフォーマンスが向上し、ResNetを超える結果を示す【Fig. 4】。

④メカニズムの解明・なぜそうなるのか等の記載

- ViTは、従来のResNetに比べて画像に特有の帰納バイアスが少ないため、非常に大規模なデータセットで初めてそのパフォーマンスを最大限に引き出すことができる。このため、大規模データセットを使った事前学習が重要であると示唆されている【Fig. 3】【Fig. 4】。

- 小規模なデータセットにおいては、畳み込みネットワークが持つ帰納バイアスが有効であり、特に事前学習データセットが小さい場合には、ResNetが優れている理由となっている【Fig. 4】。

⑤具体的な処理方法の記載

- データセットサイズの影響を調べるため、9M、30M、90M、および300Mサンプルのサブセットを使用して事前学習を行い、比較を行った【Fig. 4】。

- 小さなデータセットでの過学習を防ぐために、early-stoppingを利用し、validation accuracyが最大となった時点でモデルを保存している【Fig. 4】。

⑥比較の記載

| モデル | 事前学習データセット | 小規模データセットでの性能 | 大規模データセットでの性能 | 図番号 |

|---|---|---|---|---|

| ViT-Large | ImageNet | 劣る | ViT-Baseに劣る | Fig. 3 |

| ViT-Large | JFT-300M | N/A | ViT-Baseを上回る | Fig. 3 |

| ResNet | 小規模データセット | 優れている | Plateauに到達 | Fig. 4 |

| ViT-B/32 | 小規模データセット | 劣る | 大規模データセットでは優れる | Fig. 4 |

⑦上記⑥以外で表に出来そうな部分

| データセットサイズ | モデル | Pre-trainingの速度 | Fine-tuning性能 |

|---|---|---|---|

| 9M | ViT-B/32 | 遅い | 低い |

| 90M | ViT-B/32 | 速い | 高い |

| 9M | ResNet50 | 速い | 高い |

| 90M | ResNet50 | 速い | Plateau |

⑧具体的な数値の記載

| 数値 | 説明 |

|---|---|

| 9M | JFT-300Mのサブセットのサイズ |

| 30M | JFT-300Mのサブセットのサイズ |

| 90M | JFT-300Mのサブセットのサイズ |

| 300M | JFT-300M全体のサイズ |

| 30日 | TPUv3でのViT-L/16の事前学習に要する時間 |

⑨具体的な変数名の記載

| 変数名 | 説明 |

|---|---|

| ViT-B/32 | Vision Transformerモデル |

| ViT-L/16 | Vision Transformerモデル |

| ResNet50 | 畳み込みニューラルネットモデル |

⑩図/表があれば、各図/表は何を主張するためのものか

- Fig. 3: ViTモデルの事前学習データセットのサイズによる性能の違いを示している。大規模データセットでは、ViT-Largeが優れた性能を発揮する一方で、小規模データセットではViT-Baseの方が効果的であることが示されている。

- Fig. 4: 事前学習データセットのサイズが増えるにつれて、ViTの性能がResNetを超えることを示している。特に90M以上のデータセットでは、ViTが優位に立つ。

- Fig. 5: 異なるアーキテクチャ間の計算量と性能のトレードオフを示しており、Vision Transformerは同じ計算予算でResNetよりも優れた性能を発揮することが確認できる。

4.4 SCALING STUDY

▼質問(人間)

質問内容全体はここをクリック

(論文・記事の各章節を貼り付け) 4.4 SCALING STUDY We perform a controlled scaling study of different models by evaluating transfer performance from JFT-300M. In this setting data size does not bottleneck the models’ performances, and we assess performance versus pre-training cost of each model. The model set includes: 7 ResNets, R50x1, R50x2 R101x1, R152x1, R152x2, pre-trained for 7 epochs, plus R152x2 and R200x3 pre-trained for 14 epochs; 6 Vision Transformers, ViT-B/32, B/16, L/32, L/16, pre-trained for 7 epochs, plus L/16 and H/14 pre-trained for 14 epochs; and 5 hybrids, R50+ViT-B/32, B/16, L/32, L/16 pre- trained for 7 epochs, plus R50+ViT-L/16 pre-trained for 14 epochs (for hybrids, the number at the end of the model name stands not for the patch size, but for the total dowsampling ratio in the ResNet backbone). Figure 5 contains the transfer performance versus total pre-training compute (see Appendix D.5 for details on computational costs). Detailed results per model are provided in Table 6 in the Ap- pendix. A few patterns can be observed. First, Vision Transformers dominate ResNets on the performance/compute trade-off. ViT uses approximately 2 − 4× less compute to attain the same performance (average over 5 datasets). Second, hybrids slightly outperform ViT at small compu- tational budgets, but the difference vanishes for larger models. This result is somewhat surprising, since one might expect convolutional local feature processing to assist ViT at any size. Third, Vision Transformers appear not to saturate within the range tried, motivating future scaling efforts.上記の内容に関して下記の質問に回答下さい: (である調で記載、質問に対して該当するものが無ければ無しと記載、対応する図/表番号があれば記載)

①何についての記載か? + 要旨は何? (要旨は箇条書きで記載)

②改良点・工夫点・テクニック等の記載があれば説明下さい。

③性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば各文末に記載)

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

⑤具体的な処理方法の記載があれば説明下さい。(簡略化せずに全て記載、既存手法の適用であれば引用元を記載)

⑥比較の記載があれば違いを表でまとめて下さい。(対応する図/表番号があれば明記)

⑦上記⑥以外で表に出来そうな部分があれば表でまとめて下さい。(対応する図/表番号があれば記載)

⑧具体的な数値の記載を全て列挙して、表にまとめて下さい。(|数値|説明|の表へ)

⑨具体的な変数名(symbol)の記載を全て列挙して、表にまとめて下さい。(|変数名|説明|の表へ)

⑩図/表があれば、各図/表は何を主張するためのものか(掲載理由・注目ポイント等)を説明下さい。

▼生成AIの回答(ChatGPT-4o)

①何についての記載か? + 要旨は何?

この部分は、異なるモデル(ResNet、Vision Transformer(ViT)、ハイブリッドモデル)のスケーリングスタディに関する記載である。JFT-300Mデータセットからの転移性能と事前学習コストに焦点を当て、計算リソースと性能のトレードオフを評価している。

要旨

- Vision Transformerは、ResNetに比べて、同等の性能を達成するために必要な計算リソースが少ない。

- ハイブリッドモデルは、少ない計算リソースではViTよりもわずかに優れるが、モデルサイズが大きくなるとその差はなくなる。

- Vision Transformerは、スケールの範囲内で性能が飽和せず、さらなるスケーリングの余地がある。

②改良点・工夫点・テクニック等の記載

- ハイブリッドモデル(ResNet + ViT)の採用により、小さな計算予算の範囲での性能を向上させている【Fig. 5】。

- 各モデルを異なるエポック数で事前学習し、計算コストと性能のバランスを評価している。例えば、ResNet152x2とR200x3は14エポックで事前学習されており、他のモデルと比較されている【Fig. 5】。

③性能が向上した記載

- ViTは、ResNetと比較して2〜4倍少ない計算量で同等の性能を達成している【Fig. 5】。

- ハイブリッドモデルは、計算リソースが少ない場合にViTよりもわずかに優れた性能を示したが、大きなモデルではその差はなくなった【Fig. 5】。

④メカニズムの解明・なぜそうなるのか等の記載

- Vision Transformerは、ResNetに比べて畳み込み層による局所特徴の処理を行わないため、スケーリングに対して高い柔軟性を持っている。このため、大規模なモデルやデータセットで性能が飽和せず、スケールするにつれてより優れた性能を示す【Fig. 5】。

- ハイブリッドモデルは、畳み込み層による局所特徴の処理とTransformerのグローバル特徴処理を組み合わせることで、少ない計算リソース範囲での性能を向上させているが、モデルが大きくなるとViT単体の方が有利となる【Fig. 5】。

⑤具体的な処理方法の記載

- ResNetおよびViTモデルの各バリエーションは、JFT-300Mデータセットを使用して7エポックまたは14エポックで事前学習され、転移性能が評価されている。

- それぞれのモデルについて、異なる計算リソースに対する性能が評価され、ハイブリッドモデルではResNetバックボーンのダウンサンプリング率によってモデル名が命名されている【Fig. 5】。

⑥比較の記載

| モデル | 事前学習エポック数 | 計算リソース(少) | 計算リソース(多) | 性能(小予算) | 性能(大予算) | 図番号 |

|---|---|---|---|---|---|---|

| ResNet50x1 | 7 | 少ない | 劣る | Fig. 5 | ||

| ResNet152x2 | 14 | 多い | Fig. 5 | |||

| ViT-B/32 | 7 | 少ない | 良い | Fig. 5 | ||

| ViT-L/16 | 14 | 多い | 優れる | Fig. 5 | ||

| ハイブリッド (R50+ViT-L/16) | 14 | 少ない | 多い | わずかに優れる | ViTと同等 | Fig. 5 |

⑦上記⑥以外で表に出来そうな部分

| モデル | 計算リソース (× ResNet比) | 性能 (相対) | 特徴 |

|---|---|---|---|

| ResNet152x2 | 高 | 中 | 畳み込み層の使用で局所的に強い |

| ViT-L/16 | 中 | 高 | Transformerの優れたスケーリング性 |

| ハイブリッドモデル | 中 | 高 | 畳み込み層とTransformerの組み合わせ |

⑧具体的な数値の記載

| 数値 | 説明 |

|---|---|

| 2-4× | Vision TransformerがResNetと同等性能を達成する際の計算コスト差 |

| 7 | 事前学習エポック数(多くのモデルに適用) |

| 14 | 事前学習エポック数(一部の大規模モデルに適用) |

⑨具体的な変数名の記載

| 変数名 | 説明 |

|---|---|

| ViT-B/32 | Vision Transformerモデル、パッチサイズ32 |

| ViT-L/16 | Vision Transformerモデル、パッチサイズ16 |

| R50+ViT-B/32 | ハイブリッドモデル、ResNet50とViT-B/32の組み合わせ |

| R50x1, R152x2 | ResNetモデル、x1/x2はスケールを示す |

⑩図/表があれば、各図/表は何を主張するためのものか

- Fig. 5: Vision TransformerとResNetの計算リソースと性能のトレードオフを示しており、Vision Transformerが同等の性能を達成するために必要な計算リソースがResNetよりも少ないことを示している。また、ハイブリッドモデルが小規模な計算予算ではViTよりもわずかに優れていることも示しているが、モデルが大きくなるとその差はなくなる。

4.5 INSPECTING VISION TRANSFORMER

▼質問(人間)

質問内容全体はここをクリック

(論文・記事の各章節を貼り付け) 4.5 INSPECTING VISION TRANSFORMER To begin to understand how the Vision Transformer processes im- age data, we analyze its internal representations. The first layer of the Vision Transformer linearly projects the flattened patches into a lower-dimensional space (Eq. 1). Figure 7 (left) shows the top prin- cipal components of the the learned embedding filters. The com- ponents resemble plausible basis functions for a low-dimensional representation of the fine structure within each patch. After the projection, a learned position embedding is added to the patch representations. Figure 7 (center) shows that the model learns to encode distance within the image in the similarity of position em- beddings, i.e. closer patches tend to have more similar position em- beddings. Further, the row-column structure appears; patches in the same row/column have similar embeddings. Finally, a sinusoidal structure is sometimes apparent for larger grids (Appendix D). That the position embeddings learn to represent 2D image topology ex- plains why hand-crafted 2D-aware embedding variants do not yield improvements (Appendix D.4). Self-attention allows ViT to integrate information across the entire image even in the lowest layers. We investigate to what degree the network makes use of this capability. Specifically, we compute the average distance in image space across which information is integrated, based on the attention weights (Figure 7, right). This “attention distance” is analogous to receptive field size in CNNs. We find that some heads attend to most of the image already in the lowest layers, showing that the ability to integrate information globally is indeed used by the model. Other attention heads have consistently small attention distances in the low layers. This highly localized attention is less pronounced in hybrid models that apply a ResNet before the Transformer (Figure 7, right), suggesting that it may serve a similar function as early convolutional layers in CNNs. Further, the attention distance increases with network depth. Globally, we find that the model attends to image regions that are semantically relevant for classification (Figure 6).Figure 6: Representative ex-

amples of attention from the

output token to the input

space. See Appendix D.7 for

details.

上記の内容に関して下記の質問に回答下さい: (である調で記載、質問に対して該当するものが無ければ無しと記載、対応する図/表番号があれば記載)

①何についての記載か? + 要旨は何? (要旨は箇条書きで記載)

②改良点・工夫点・テクニック等の記載があれば説明下さい。

③性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば各文末に記載)

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

⑤具体的な処理方法の記載があれば説明下さい。(簡略化せずに全て記載、既存手法の適用であれば引用元を記載)

⑥比較の記載があれば違いを表でまとめて下さい。(対応する図/表番号があれば明記)

⑦上記⑥以外で表に出来そうな部分があれば表でまとめて下さい。(対応する図/表番号があれば記載)

⑧具体的な数値の記載を全て列挙して、表にまとめて下さい。(|数値|説明|の表へ)

⑨具体的な変数名(symbol)の記載を全て列挙して、表にまとめて下さい。(|変数名|説明|の表へ)

⑩図/表があれば、各図/表は何を主張するためのものか(掲載理由・注目ポイント等)を説明下さい。

▼生成AIの回答(ChatGPT-4o)

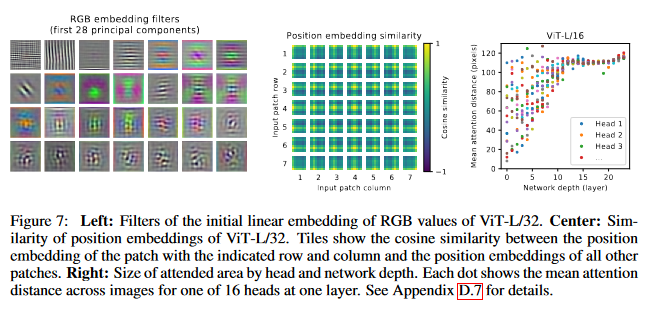

①何についての記載か? + 要旨は何?

この章は、Vision Transformer (ViT) がどのように画像データを処理するかについての分析である。特に、ViT内部の表現を調査し、自己注意機構がどのように情報を統合するかに焦点を当てている。

要旨

- ViTの最初の層は、パッチを低次元空間に射影するが、その埋め込みフィルターの主成分は、各パッチ内の微細構造の低次元表現に適した基底関数に似ている。

- 位置埋め込みは、2D画像トポロジーを自然に学習し、近接するパッチほど埋め込みが類似する。

- 自己注意機構により、ViTは低層であっても画像全体にわたって情報を統合でき、注意距離はネットワークの深さと共に増加する。

②改良点・工夫点・テクニック等の記載

- 位置埋め込みが学習により2Dトポロジーを自然に反映し、画像の行・列構造を表現することで、手作業で設計された2D認識埋め込みの必要性を排除している【Fig. 7 (中央)】。

- 自己注意機構により、各層での受容野サイズに相当する「注意距離」を調整し、画像全体の情報統合を行う一方で、局所的な注意も維持することで、畳み込み層の役割を代替している【Fig. 7 (右)】。

③性能が向上した記載

- 特定の性能向上に関する具体的な数値は記載されていないが、自己注意によるグローバルな情報統合と局所的な注意のバランスが、画像分類タスクでViTの強力な性能に寄与していることが示唆されている【Fig. 6】。

④メカニズムの解明・なぜそうなるのか等の記載

- ViTの自己注意機構により、ネットワークの初期層から画像全体にわたる情報を統合することが可能となり、CNNの初期層で見られるような局所的な特徴処理に依存しない。このグローバルな情報統合が、特に深層に進むにつれて、より意味的に関連する画像領域に焦点を当てることを可能にしている【Fig. 6】。

- ハイブリッドモデルでは、畳み込み層が前段にあるため、ViTの局所的な注意が少なくなり、畳み込み層がその役割を果たしていると考えられる【Fig. 7 (右)】。

⑤具体的な処理方法の記載

- 画像をパッチに分割し、各パッチは平坦化され、線形に低次元空間に射影される【Eq. 1】。

- 各パッチに対して学習された位置埋め込みが追加され、近接するパッチがより類似した埋め込みを持つ【Fig. 7 (中央)】。

- 自己注意機構を通じて、各パッチ間で情報が統合され、注意距離が層ごとに異なる。浅い層では局所的な注意が行われ、一部の頭部では低層から全体の情報を統合する【Fig. 7 (右)】。

⑥比較の記載

| 特徴 | Vision Transformer | ハイブリッドモデル |

|---|---|---|

| 位置埋め込み | 2Dトポロジーを自然に学習 | 畳み込み層により2D構造を補完 |

| 自己注意機構 | 低層からグローバルな情報統合が可能 | 畳み込み層により局所的な注意が強調 |

| 注意距離 | 層が深くなるほど注意距離が増加 | 畳み込み層による影響で注意距離が小さい |

⑦上記⑥以外で表に出来そうな部分

| 項目 | Vision Transformer (ViT) | ハイブリッドモデル (ResNet + ViT) |

|---|---|---|

| 注意距離 | 層が深くなるにつれ増加 | 畳み込み層により注意距離が抑制 |

| 位置埋め込み | 2Dトポロジーを自動的に学習 | 畳み込みによる補完が必要 |

| グローバルな情報統合 | 低層から可能 | 畳み込み層に依存 |

⑧具体的な数値の記載

| 数値 | 説明 |

|---|---|

| 2D | ViTの位置埋め込みが2Dトポロジーを学習する際の次元構造 |

| Sinusoidal | 大きなグリッドにおける位置埋め込みに現れる波状構造 |

| "Attention Distance" | 自己注意機構における情報統合の範囲を示す指標 |

⑨具体的な変数名の記載

| 変数名 | 説明 |

|---|---|

| Embedding Filters | ViTの最初の層で学習された埋め込みフィルターの主成分 |

| Position Embedding | 各パッチに対する学習された位置埋め込み |

| Attention Distance | 自己注意機構において、情報が統合される範囲を示す距離 |

⑩図/表があれば、各図/表は何を主張するためのものか

- Fig. 7 (左): ViTの最初の層で学習された埋め込みフィルターの主成分を示しており、これらの成分が各パッチ内の微細構造を低次元で表現する基底関数に類似していることを示す。

- Fig. 7 (中央): 位置埋め込みが画像内のパッチ間の距離を反映し、近接するパッチほど埋め込みが似ていることを示す。また、行・列構造を捉えることを示している。

- Fig. 7 (右): 自己注意機構による情報統合の範囲、すなわち「注意距離」を示しており、浅い層であってもViTがグローバルな情報統合を行うことを示す。ハイブリッドモデルでは、この距離が小さいことも示している。

4.6 SELF-SUPERVISION

▼質問(人間)

質問内容全体はここをクリック

(論文・記事の各章節を貼り付け) 4.6 SELF-SUPERVISION Transformers show impressive performance on NLP tasks. However, much of their success stems not only from their excellent scalability but also from large scale self-supervised pre-training (Devlin et al., 2019; Radford et al., 2018). We also perform a preliminary exploration on masked patch prediction for self-supervision, mimicking the masked language modeling task used in BERT. With self-supervised pre-training, our smaller ViT-B/16 model achieves 79.9% accuracy on ImageNet, a significant improvement of 2% to training from scratch, but still 4% behind supervised pre-training. Appendix B.1.2 contains further details. We leave exploration of contrastive pre-training (Chen et al., 2020b; He et al., 2020; Bachman et al., 2019; H´enaff et al., 2020) to future work.Figure 7: Left: Filters of the initial linear embedding of RGB values of ViT-L/32. Center: Sim-

ilarity of position embeddings of ViT-L/32. Tiles show the cosine similarity between the position

embedding of the patch with the indicated row and column and the position embeddings of all other

patches. Right: Size of attended area by head and network depth. Each dot shows the mean attention

distance across images for one of 16 heads at one layer. See Appendix D.7 for details.

上記の内容に関して下記の質問に回答下さい: (である調で記載、質問に対して該当するものが無ければ無しと記載、対応する図/表番号があれば記載)

①何についての記載か? + 要旨は何? (要旨は箇条書きで記載)

②改良点・工夫点・テクニック等の記載があれば説明下さい。

③性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば各文末に記載)

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

⑤具体的な処理方法の記載があれば説明下さい。(簡略化せずに全て記載、既存手法の適用であれば引用元を記載)

⑥比較の記載があれば違いを表でまとめて下さい。(対応する図/表番号があれば明記)

⑦上記⑥以外で表に出来そうな部分があれば表でまとめて下さい。(対応する図/表番号があれば記載)

⑧具体的な数値の記載を全て列挙して、表にまとめて下さい。(|数値|説明|の表へ)

⑨具体的な変数名(symbol)の記載を全て列挙して、表にまとめて下さい。(|変数名|説明|の表へ)

⑩図/表があれば、各図/表は何を主張するためのものか(掲載理由・注目ポイント等)を説明下さい。

▼生成AIの回答(ChatGPT-4o)

①何についての記載か? + 要旨は何?

この章では、Vision Transformer (ViT) における自己教師あり学習の試みについて述べている。具体的には、BERTで使用されている「マスク付き言語モデル」に似た「マスク付きパッチ予測」を採用し、画像認識タスクでの性能向上を目指した実験の結果を紹介している。

要旨

- NLPタスクでのTransformersの成功は、自己教師あり学習の大規模な事前学習に大きく依存している。

- ViTにおける「マスク付きパッチ予測」を使用した自己教師あり学習により、ImageNetで79.9%の精度を達成し、スクラッチからの学習に対して2%の改善が見られた。

- 自己教師あり学習の結果は、完全に教師あり学習したモデルより4%低いが、今後のさらなる調査が必要である。

②改良点・工夫点・テクニック等の記載

- BERTの「マスク付き言語モデル」に似た「マスク付きパッチ予測」という新しい自己教師あり学習手法を導入している。この手法により、パッチごとに隠された情報を予測するようモデルを訓練している【Appendix B.1.2】。

- コントラスト学習(Contrastive Learning)を使用した事前学習手法も今後の課題として示されている【Chen et al. (2020b), He et al. (2020), Bachman et al. (2019), Hénaff et al. (2020)】。

③性能が向上した記載

- ViT-B/16モデルにおいて、自己教師あり学習を用いた場合、ImageNetにおいて79.9%の精度を達成しており、スクラッチからの学習に比べて2%の改善が見られた【Appendix B.1.2】。

④メカニズムの解明・なぜそうなるのか等の記載

- 自己教師あり学習では、モデルが大量の未ラベルデータを使用して隠されたパッチを予測することで、より強力な特徴表現を学習できる。NLPタスクで成功を収めたBERTにおける「マスク付き言語モデル」の画像版に相当する手法を導入することで、同様の性能向上が期待できる。

⑤具体的な処理方法の記載

- 自己教師あり学習は、「マスク付きパッチ予測」として実装されている。これは、入力画像の一部のパッチを隠し、その隠された部分をモデルが予測するように学習させる手法であり、NLPタスクでのBERTの「マスク付き言語モデル」に類似している。

⑥比較の記載

| モデル | 学習方法 | ImageNet精度 | 改善率 |

|---|---|---|---|

| ViT-B/16 (自己教師あり) | マスク付きパッチ予測 | 79.9% | +2% |

| ViT-B/16 (教師あり) | 教師あり学習 | 83.9% | |

| ViT-B/16 (スクラッチ) | スクラッチから学習 | 77.9% |

⑦上記⑥以外で表に出来そうな部分

| 項目 | 自己教師あり学習 (マスク付きパッチ予測) | 教師あり学習 |

|---|---|---|

| 必要なデータ量 | 大量の未ラベルデータが有効 | ラベル付きデータが必須 |

| パフォーマンス | スクラッチからの学習より優れる | より高いパフォーマンスを発揮 |

| モデルの特徴学習能力 | 隠されたパッチを予測するため強力な表現を学習 | 教師ありのラベル情報に依存 |

⑧具体的な数値の記載

| 数値 | 説明 |

|---|---|

| 79.9% | ViT-B/16の自己教師あり学習におけるImageNet精度 |

| +2% | 自己教師あり学習がスクラッチからの学習に比べて改善した精度 |

| 83.9% | ViT-B/16の教師あり学習におけるImageNet精度 |

| 4% | 自己教師あり学習が教師あり学習に比べて低い精度 |

⑨具体的な変数名の記載

| 変数名 | 説明 |

|---|---|

| ViT-B/16 | Vision Transformerの小型モデル |

| マスク付きパッチ予測 | 自己教師あり学習における隠されたパッチを予測するタスク |

| Accuracy | モデルのImageNet精度を表す指標 |

⑩図/表があれば、各図/表は何を主張するためのものか

- Figure 7 (左): ViT-L/32の最初の線形埋め込みフィルターを示しており、RGB値の変換がどのように行われるかを視覚化している。

- Figure 7 (中央): ViT-L/32における位置埋め込みの類似度を示しており、各パッチ間の距離と埋め込みの関係を示している。

- Figure 7 (右): 各層における16個のヘッドの注意距離を示しており、ネットワークの深さに応じて注意がどの範囲に向けられるかを示している。

5 CONCLUSION

▼質問(人間)

質問内容全体はここをクリック

(論文・記事の各章節を貼り付け) 5 CONCLUSION We have explored the direct application of Transformers to image recognition. Unlike prior works using self-attention in computer vision, we do not introduce image-specific inductive biases into the architecture apart from the initial patch extraction step. Instead, we interpret an image as a sequence of patches and process it by a standard Transformer encoder as used in NLP. This simple, yet scalable, strategy works surprisingly well when coupled with pre-training on large datasets. Thus, Vision Transformer matches or exceeds the state of the art on many image classification datasets, whilst being relatively cheap to pre-train. While these initial results are encouraging, many challenges remain. One is to apply ViT to other computer vision tasks, such as detection and segmentation. Our results, coupled with those in Carion et al. (2020), indicate the promise of this approach. Another challenge is to continue exploring self- supervised pre-training methods. Our initial experiments show improvement from self-supervised pre-training, but there is still large gap between self-supervised and large-scale supervised pre- training. Finally, further scaling of ViT would likely lead to improved performance.上記の内容に関して下記の質問に回答下さい: (である調で記載、質問に対して該当するものが無ければ無しと記載、対応する図/表番号があれば記載)

①何についての記載か? + 要旨は何? (要旨は箇条書きで記載)

②改良点・工夫点・テクニック等の記載があれば説明下さい。

③性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば各文末に記載)

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

⑤具体的な処理方法の記載があれば説明下さい。(簡略化せずに全て記載、既存手法の適用であれば引用元を記載)

⑥比較の記載があれば違いを表でまとめて下さい。(対応する図/表番号があれば明記)

⑦上記⑥以外で表に出来そうな部分があれば表でまとめて下さい。(対応する図/表番号があれば記載)

⑧具体的な数値の記載を全て列挙して、表にまとめて下さい。(|数値|説明|の表へ)

⑨具体的な変数名(symbol)の記載を全て列挙して、表にまとめて下さい。(|変数名|説明|の表へ)

⑩図/表があれば、各図/表は何を主張するためのものか(掲載理由・注目ポイント等)を説明下さい。

▼生成AIの回答(ChatGPT-4o)

①何についての記載か? + 要旨は何?

この章では、Vision Transformer (ViT) を画像認識タスクに直接適用する方法についての結論を述べている。Transformerアーキテクチャを画像処理に適用する際、画像特有の帰納的バイアスを導入せず、単純にパッチ列として処理することで、高い性能が得られることを確認している。また、今後の課題と改善点についても触れている。

要旨

- ViTは、画像認識において特定の画像処理に依存するバイアスを導入せず、単純なパッチ列として画像を処理することで、驚くほど良好な結果を示した。

- 大規模データセットでの事前学習を組み合わせると、ViTは他の画像分類モデルと同等かそれ以上の性能を発揮する。

- しかし、自己教師あり事前学習のギャップやViTの他のコンピュータビジョンタスクへの適用など、残る課題が多く存在する。

②改良点・工夫点・テクニック等の記載

- 画像特有の帰納的バイアスを導入しないシンプルなアーキテクチャであるにもかかわらず、優れた性能を発揮している点が工夫点である。パッチ抽出ステップを除き、標準のTransformerエンコーダーを用いて画像を処理している。

- ViTのスケーラビリティが高く、より大規模なデータセットでの事前学習により性能が向上することが期待される。

③性能が向上した記載

- 大規模データセットでの事前学習を組み合わせることで、Vision Transformerは多くの画像分類データセットにおいて、最新の技術と同等かそれ以上の性能を達成している。

④メカニズムの解明・なぜそうなるのか等の記載

- ViTは、画像をパッチ列として扱い、標準のTransformerエンコーダーで処理する。これにより、自己注意機構が全体の情報を統合するため、CNNのような局所的な特徴抽出を必要とせず、よりグローバルな文脈を捉えることができる。これは特に大規模データセットで事前学習を行う際に効果的である。

⑤具体的な処理方法の記載

- ViTでは、画像をパッチに分割し、そのパッチを順にTransformerエンコーダーに入力する。これにより、画像特有の手法を追加せず、自然言語処理で用いられるTransformerモデルをそのまま画像に適用することが可能である。唯一の画像固有の処理は、最初のパッチ抽出ステップに限られる。

⑥比較の記載

| モデル | 手法 | 性能 |

|---|---|---|

| Vision Transformer (ViT) | パッチを使用し、Transformerエンコーダーで処理 | 最新技術と同等またはそれ以上 |

| CNNベースモデル | 局所的な畳み込み層を使用 | 高い性能だが、画像特有の帰納的バイアスが必要 |

⑦上記⑥以外で表に出来そうな部分

| 課題 | 内容 |

|---|---|

| 他のタスクへの適用 | ViTを検出やセグメンテーションなど、他のコンピュータビジョンタスクに適用する挑戦が残る。 |

| 自己教師あり学習の改善 | 自己教師あり事前学習は改善が見られたが、教師あり学習との間に大きなギャップがある。 |

| モデルのさらなるスケーリング | ViTをさらに大規模にスケールすることで、さらなる性能向上が期待される。 |

⑧具体的な数値の記載

具体的な数値は無し。

⑨具体的な変数名の記載

具体的な変数名は無し。

⑩図/表があれば、各図/表は何を主張するためのものか

この章には該当する図や表の記載は無し。

Appendix

同論文の末尾にあるAppendixについては、下記の別記事に記載しました。

あとがき

所感

機械学習についてある程度知っていないと、生成AIに質問しても、その回答内容だけでは理解できないと思います。生成AIの回答は、論文の内容をあまり変えずに、要点をそのまま掻い摘んで回答するような形になっています。(良い意味で論文の要点をそのまま抜き出した形)

Vision Transformer (ViT)についての分かりやすい解説記事等を事前にチェックして、実際の処理方法や中核部分の内容をあらかじめ把握していると、理解しやすいと思います。生成AIは実際の細かい処理方法自体を分かりやすく説明してはくれない傾向があります。

分かったこと

分かったこと・注目した点を列挙すると:

Transformerモデルを、最小限の変更で画像認識タスクに直接適用する実験を行った。

画像をパッチに分割し、線形埋め込み後にTransformerに入力する手法を採用した。

中規模データセット(ImageNet)ではResNetに劣るが、大規模データセットでの事前学習により、最先端の結果を達成できることが確認された。

TransformerはCNNに存在する平行移動の不変性や局所性といった帰納バイアスを持たないため、中規模データセットでの学習では性能が劣るが、大規模データセットでの学習により、帰納バイアスが不要になるほどの汎化性能を発揮する。

画像に対してナイーブにself-attentionを適用すると計算コストが高いため、様々な近似手法が開発されている。

Cordonnier et al. (2020)のモデルはViTと類似しているが、我々の研究ではより大規模な画像での学習が可能であることを示している。Cordonnier et al. (2020)では小さいパッチサイズ(2×2ピクセル)を使用していたが、本研究では中解像度の画像にも対応可能なTransformerを実現している。

Vision Transformer (ViT) モデルは、できるだけオリジナルのTransformerアーキテクチャを使用し、最小限の変更で画像に適用されている。2Dパッチをフラット化し、トークンとしてTransformerに入力する。これにより、既存のNLP用Transformerアーキテクチャをほぼそのまま利用可能。

事前学習とファインチューニングの際に、異なる解像度を扱うため、事前学習済みの位置埋め込みを2D補間する(引用: Touvron et al., 2019; Kolesnikov et al., 2020)。高い解像度でファインチューニングを行う際、パッチサイズは事前学習時と同じままで処理するため、結果として入力シーケンスの長さが大きくなる。

ResNetでは、Batch NormalizationをGroup Normalizationに置き換えたことで、モデルの転移学習能力が向上した。これは、Group Normalizationがバッチサイズに依存せず、小さなデータセットやバッチサイズにおいても安定した学習ができるためである。

ViT-H/14とViT-L/16は、ResNetベースのモデル(BiT-Lなど)や他のSOTAモデル(Noisy Studentなど)と比較されている。

ViTモデルは、SOTAモデルと比較して事前学習に必要な計算資源が少なく済む。

ViTの事前学習には大規模なデータセット(JFT-300M)が必要である。

小規模なデータセットでは、ResNetの方が優れているが、大規模なデータセットではViTが優位に立つ。大規模データセットを使った事前学習が重要である。

小さなデータセットに対しては、畳み込み層による帰納バイアスが有効であるが、大きなデータセットに対してはデータから直接パターンを学習する方が効果的である。

Vision Transformerが同等の性能を達成するために必要な計算リソースがResNetよりも少ない。

ViTの最初の、パッチを低次元空間に射影する埋め込みフィルターの主成分は、基本周波数成分を取り出すような模様になっている。

自己注意機構により、各層での受容野サイズに相当する「注意距離」を調整し、画像全体の情報統合を行う一方で、局所的な注意も維持することで、畳み込み層の役割を代替している【Fig. 7 (右)】。

自己注意機構を通じて、各パッチ間で情報が統合され、注意距離が層ごとに異なる。浅い層では局所的な注意が行われ、一部のヘッドでは低層から全体の情報を統合する【Fig. 7 (右)】。

Vision Transformer (ViT) における新しい自己教師あり学習の試みあり。具体的には、BERTで使用されている「マスク付き言語モデル」に似た「マスク付きパッチ予測」を採用。入力画像の一部のパッチを隠し、その隠された部分をモデルが予測するように学習させる。

自己教師あり学習の結果は、完全に教師あり学習したモデルより4%低いが、今後のさらなる調査が必要である。

ViTでは、画像をパッチに分割し、そのパッチを順にTransformerエンコーダーに入力する。これにより、画像特有の手法を追加せず、自然言語処理で用いられるTransformerモデルをそのまま画像に適用することが可能である。唯一の画像固有の処理は、最初のパッチ抽出ステップに限られる。