はじめに

生成AIを用いてSparse Transformersの論文「Generating Long Sequences with Sparse Transformers (2019)」の内容を(なるべく)把握してみました。(生成AIが)論文の記載内容を始めから最後まで読んで、実際にどのような記載があるのかを把握します。

(論文の分かりやすい解説記事は見るのですが、実際の論文までチェックしないので、生成AIを使って内容を把握してみました。)

概要レベルでは内容が把握できましたが、数式の表記が簡潔で、数式に基づいた具体的な処理方法の部分を理解できませんでした。(論文の本文を読んでも詳しく書かれてある訳ではない)

(その他、末尾の「分かったこと」章を参照)

以降で、ChatGPTに聞いてみた例を記載します。

他例: 同類の方法を使って読んでみた結果

対象の論文

論文: (Sparse Transformersに関する論文)

[1904.10509] Generating Long Sequences with Sparse Transformers

https://arxiv.org/abs/1904.10509

(PDF: https://arxiv.org/pdf/1904.10509)

質問時の各章節の区切り部分

論文の中にある各章節を、下記のように区切って、部分毎に生成AIに内容を質問していきます。

- Abstract

- ---

- 1.-Introduction

- ---

- 2.-Related Work

- ---

- 3.-Background

- ---

- 4.-Factorized Self-Attention

- 4.1. Qualitative assessment of learned attention

- ---

- 4.2. Factorized self-attention

- ---

- 4.3. Two-dimensional factorized attention

- ---

- 5.-Sparse Transformer

- 5.1. Factorized attention heads

- ---

- 5.2. Scaling to hundreds of layers

- ---

- 5.3. Modeling diverse data types

- ---

- 5.4. Saving memory by recomputing attention weights

- ---

- 5.5. Efficient block-sparse attention kernels

- ---

- 5.6. Mixed-precision training

- ---

- 6.-Training

- ---

- 7.-Experiments

- 7.1. CIFAR-10

- 7.2. Text

- ---

- 7.3. ImageNet 64x64

- 7.4. Classical music from raw audio

- ---

- 8.-Conclusion

生成AIへの質問方法

生成AIを活用して、知りたい記事・論文の1節分(適度な長さ)のテキストをコピー&ペーストして、その下に質問内容を「①~ ②~ …」と番号付きで書いて、生成AIに渡せば、全質問に一発で的確に回答してくれるので、非常に良好でした。記事全体を読む必要なく、知りたい点の情報だけを収集できます。

生成AIへの質問例:

(論文・記事の各章節を貼り付け)

上記の内容に関して下記の質問に回答下さい: (である調で記載、質問に対して該当するものが無ければ無しと記載)

①何についての記載か? + 要旨は何? (要旨は箇条書きで記載、既存手法があれば引用元を記載)

②具体的な処理方法の記載があれば説明下さい。(簡略化せずに全て記載、既存手法があれば引用元を記載)

③改良点・工夫点・テクニック等の記載があれば説明下さい。

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

⑤性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば各文末に記載)

続けて下記の質問に追加で回答下さい:

⑥比較の記載があれば違いを表でまとめて下さい。(下に解説を記載、対応する図/表番号があれば明記)

⑦上記⑥以外で表に出来そうな部分があれば表でまとめて下さい。(下に解説を記載、対応する図/表番号があれば記載)

⑧具体的な数値の記載を全て列挙して、表にまとめて下さい。(必ず正しく数値を抜き取る事、|数値|説明|の表へ)

⑨具体的な変数名(数式用の記号)の記載を全て列挙して、表にまとめて下さい。(|変数名|説明|の表へ)

⑩図/表があれば、各図/表は何を主張するためのものかを説明下さい。(掲載理由・注目ポイント等)

※回答が長くなりそうな場合は、適宜、分けて質問: ①②③④⑤、⑥⑦⑧⑨⑩

※章節に応じて、その章節で明らかに不要な質問は、適宜除外。

※その他、不明点があれば、適宜、追加で質問。

質問内容は、記事・論文を読んでいていつも知りたいと思う点(改良点・工夫点・テクニック・メカニズムの解明)にしています。また、表で比較した方が素早く把握できるので、可能であれば記事を表に変換するようにしています。

論文・記事を貼り付けるテキストの長さは、1節分程度の量にとどめた方が、良い回答が得られました。生成AIの回答の文量が多くなってくると、回答が長くなり過ぎないように、生成AIが勝手に(適度に)端折り始めてしまい、重要な点が回答から抜けてしまう可能性が高くなります。

事前知識

機械学習についてある程度知っていないと、生成AIに質問しても、その回答内容だけでは理解できないと思います。生成AIの回答は、論文の内容をあまり変えずに、要点をそのまま掻い摘んで回答するような形になっています。

Sparse Transformersについての分かりやすい解説記事(下記)等を事前にチェックして、中核部分の内容をあらかじめ分かっていると、理解しやすいと思います。生成AIは実際の細かい処理方法自体を分かりやすく説明してはくれない傾向があります。

注意点

論文のテキスト内容だけを貼り付けて、生成AIに質問しています。論文の中の図・表の部分は貼り付けていません。図・表の内容は生成AIの回答には含まれず、別途論文を見る必要があります。

以降で、生成AIの回答内容が読みにくい・分かりづらい場合は、論文の本文でも同じように書かれてあり、論文の本文を読んでも同じように分かりづらいことが多くあります。論文では、既存研究等があるため、多くの説明を省略・一言だけサラッと書かれてある等、同種の研究に取り組む人でなければ、なかなか全容の理解に辿りつくのは難しい側面があります。この点は、生成AIの回答性能が悪いのではなく、論文という性質上、生じるものと考えています。

生成AIに質問

以降で、ChatGPTに実際に聞いてみた例を記載します。

生成AIへの質問&回答の全容

生成AIへの質問&回答の全容・詳細:

Abstract

▼質問(人間)

質問内容全体はここをクリック

(論文・記事の各章節を貼り付け) Abstract Transformers are powerful sequence models, but require time and memory that grows quadrati- cally with the sequence length. In this paper we introduce sparse factorizations of the attention matrix which reduce this to O(n√n). We also introduce a) a variation on architecture and initial- ization to train deeper networks, b) the recompu- tation of attention matrices to save memory, and c) fast attention kernels for training. We call net- works with these changes Sparse Transformers, and show they can model sequences tens of thou- sands of timesteps long using hundreds of layers. We use the same architecture to model images, audio, and text from raw bytes, setting a new state of the art for density modeling of Enwik8, CIFAR- 10, and ImageNet-64. We generate unconditional samples that demonstrate global coherence and great diversity, and show it is possible in principle to use self-attention to model sequences of length one million or more.上記の内容に関して下記の質問に回答下さい: (である調で記載、質問に対して該当するものが無ければ無しと記載)

①何についての記載か? + 要旨は何? (要旨は箇条書きで記載、既存手法があれば引用元を記載)

②具体的な処理方法の記載があれば説明下さい。(簡略化せずに全て記載、既存手法があれば引用元を記載)

③改良点・工夫点・テクニック等の記載があれば説明下さい。

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

⑤性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば各文末に記載)

▼生成AIの回答(ChatGPT-4o)

①何についての記載か? + 要旨は何?

この部分では、Transformerの計算効率の問題に対する解決策として、Sparse Transformersという新しいアーキテクチャを提案し、その性能を示している。要旨は以下の通りである:

- Transformerモデルはシーケンス長に対して計算時間とメモリ使用量が二次的に増加するという課題を持っている。

- 提案手法は、Attention行列に疎な分解を導入することで、計算コストをO(n√n)に削減した。

- さらに、a) より深いネットワークをトレーニングするためのアーキテクチャと初期化の変更、b) メモリ節約のためのAttention行列の再計算、c) トレーニングのための高速Attentionカーネルを導入した。

- この変更を加えたネットワークをSparse Transformersと呼び、数万のタイムステップに渡る長いシーケンスを数百層の深いネットワークでモデル化できることを示した。

- 画像、音声、テキストを生のバイト列からモデル化するために、同じアーキテクチャを使用し、Enwik8、CIFAR-10、ImageNet-64における密度モデリングで新たな最先端技術を確立した。

- グローバルな一貫性と高い多様性を示す無条件生成サンプルを生成し、原理的にはシーケンス長が100万以上のものを自己注意機構でモデル化できることを示した。

②具体的な処理方法の記載

- Attention行列に対して疎な分解を導入し、計算量を削減するためにO(n√n)の計算コストを実現している。

- より深いネットワークのトレーニングを可能にするため、アーキテクチャと初期化に変更を加えている。

- メモリ使用量を減少させるため、Attention行列を再計算する手法を採用している。

- トレーニングを高速化するためのAttentionカーネルを使用している。

③改良点・工夫点・テクニック等の記載

- Attention行列に対する疎な分解を使用して、従来のTransformerが持つ二次的な計算コストの増加問題を緩和した点が工夫である。

- より深いネットワークをトレーニングするために、アーキテクチャと初期化に関する変更を加えており、これにより性能を劣化させることなくネットワークの深さを増加させることが可能となっている。

- Attention行列の再計算により、メモリ効率を向上させ、より長いシーケンスを処理できるようにしている。

- 高速化されたAttentionカーネルにより、計算リソースを削減しつつトレーニング速度を向上させている。

④メカニズムの解明・なぜそうなるのか等の記載

- Attention行列の疎な分解を導入することで、全ての要素を計算するのではなく、一部の重要な要素のみを考慮するため、計算コストが削減される。このアプローチにより、シーケンス長が大きくなるほど従来の方法よりも計算効率が向上する。

- Attention行列の再計算は、メモリ使用量を減らしつつ、必要な情報を保持するための方法として有効である。この手法により、メモリの消費を最小限に抑えつつ、計算精度を維持することができる。

⑤性能が向上した記載

- Sparse Transformersは、従来のTransformerと比較して長いシーケンス(数万のタイムステップ)を効率的にモデル化できる性能向上を実現している。

- Enwik8、CIFAR-10、ImageNet-64の密度モデリングで、従来の最先端技術を上回る性能を記録している。

- 計算効率が向上し、より少ないメモリでより長いシーケンスをモデル化できるようになっている。

1. Introduction

▼質問(人間)

質問内容全体はここをクリック

(論文・記事の各章節を貼り付け) 1. Introduction Estimating complex, high-dimensional data distributions is a central problem in unsupervised learning, as many down- stream applications of interest involve generation of text, images, audio, and other data. Additionally, it is believed to be a key component of unsupervised representation learning. Recently, neural autoregressive models have achieved im- pressive results in this domain, achieving state-of-the-art in modeling natural language (Jozefowicz et al., 2016) (Rad- ford et al., 2018) (Dai et al., 2018), raw audio (Van Den Oord et al., 2016) (Mehri et al., 2016), and images (Oord et al., 2016) (Menick & Kalchbrenner, 2018) (Salimans et al., 2017) (Reed et al., 2017) (Chen et al., 2017). These methods decompose a joint probability distribution into a product of conditional ones. Modeling these condi- tional distributions is extremely challenging, however, as they contain many complex, long-range dependencies and require a suitably expressive model architecture to learn them. Architectures based off CNNs (Oord et al., 2016) have made great progress in this direction, but require significant depth to expand their receptive field. To address this, WaveNet (Van Den Oord et al., 2016) introduced dilated convolutions, which allowed the network to model long-range dependen- cies in a logarithmic number of layers. Separately, the Transformer (Vaswani et al., 2017) has been shown to excel on many natural language tasks, which may be in part due to its ability to model arbitrary dependencies in a constant number of layers. As each self-attention layer has a global receptive field, the network can allocate rep- resentational capacity to the input regions for which it is most useful. Thus the architecture may be more flexible at generating diverse data types than networks with fixed connectivity patterns. However, the memory and computational requirements of such networks grows quadratically with sequence length, which excludes their use on long sequences. The main contribution of this work is to introduce several sparse factorizations of the attention matrix, which scale as O(n p √n) with the sequence length without sacrificing performance. These work by separating the full attention computation into several faster attention operations which, when combined, can approximate the dense attention oper- ation. We use this to apply self-attention to sequences of unprecedented length. Additionally, we introduce several other changes to the Transformer, including: • A restructured residual block and weight initialization to improve training of very deep networks • A set of sparse attention kernels which efficiently com- pute subsets of the attention matrix • Recomputation of attention weights during the back- wards pass to reduce memory usage We empirically validate that models augmented in this man- ner can achieve state-of-the-art compression and generation of natural language, raw audio, and natural images. The simplicity of the architecture leads us to believe it may be useful for many problems of interest.上記の内容に関して下記の質問に回答下さい: (である調で記載、質問に対して該当するものが無ければ無しと記載)

①何についての記載か? + 要旨は何? (要旨は箇条書きで記載、既存手法があれば引用元を記載)

②具体的な処理方法の記載があれば説明下さい。(簡略化せずに全て記載、既存手法があれば引用元を記載)

③改良点・工夫点・テクニック等の記載があれば説明下さい。

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

⑤性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば各文末に記載)

▼生成AIの回答(ChatGPT-4o)

①何についての記載か? + 要旨は何?

この部分では、複雑で高次元なデータ分布の推定に関する問題と、これに対するTransformerモデルの改良提案について記載されている。特に、長いシーケンスのモデリングにおける計算効率の改善に焦点が当てられている。要旨は以下の通りである:

- 複雑で高次元のデータ分布推定は、テキスト、画像、音声などの生成に関わる重要な問題であり、近年、ニューラルオートレグレッシブモデルがこの分野で顕著な成果を上げている (Jozefowicz et al., 2016; Radford et al., 2018)。

- CNNベースのアーキテクチャ (Oord et al., 2016) は、ディープなネットワーク構造を通じてリーチを拡大し、WaveNet (Van Den Oord et al., 2016) は拡張畳み込みを導入して、長距離の依存関係をモデリング可能にした。

- Transformerモデル (Vaswani et al., 2017) は、層数に依存せずに任意の依存関係をモデリングできることが示され、特に自然言語タスクで優れた性能を発揮している。

- しかし、Transformerはシーケンス長に対してメモリと計算量が二次的に増加するため、長いシーケンスへの適用が難しいという課題がある。

- 本研究では、Attention行列の疎な分解を導入し、計算コストをO(n√n)に削減することで、長いシーケンスにも適用可能な自己注意機構を提案している。

- その他、残差ブロックの再構成や重み初期化、メモリ使用量を削減するためのAttention重みの再計算、疎なAttentionカーネルの使用などの改良を提案している。

- これらの改良により、自然言語、音声、画像の生成や圧縮において最先端の性能を達成した。

②具体的な処理方法の記載

- Attention行列の疎な分解を使用することで、計算量をO(n√n)に削減し、全Attention計算を複数の高速なAttention操作に分解している。この操作により、密なAttention演算を近似できる。

- 残差ブロックと重み初期化を再構成し、非常に深いネットワークのトレーニングを改善している。

- Attentionカーネルを疎化し、Attention行列の一部のみを効率的に計算する手法を導入している。

- バックワードパスにおいてAttention重みを再計算し、メモリ使用量を削減している。

③改良点・工夫点・テクニック等の記載

- Attention行列の疎な分解により、従来のTransformerにおける計算コスト問題を解決している。

- 残差ブロックと重み初期化の変更により、より深いネットワークの効果的なトレーニングを可能にしている。

- Attentionカーネルを疎化することで、計算効率をさらに向上させている。

- Attention重みの再計算により、メモリ使用量を抑えつつトレーニングを進める工夫がなされている。

④メカニズムの解明・なぜそうなるのか等の記載

- Attention行列の疎な分解により、全ての要素を計算する必要がなくなるため、計算量が大幅に削減される。このアプローチは、必要な部分だけを重点的に計算することで、密なAttention演算を近似しつつ、シーケンス長が増加しても計算コストを抑えることができる。

- Attentionカーネルの疎化により、Attention行列全体ではなくその一部のみを効率的に計算することで、計算負荷が軽減される。

⑤性能が向上した記載

- Sparse Transformersは、自然言語、音声、画像の生成および圧縮において、従来の手法を超える最先端の性能を達成している。

- 提案手法により、シーケンス長が非常に長くても計算効率を維持し、密度モデリングにおいて最先端の結果を達成している。

▼質問(人間)

続けて下記の質問に追加で回答下さい:

⑥比較の記載があれば違いを表でまとめて下さい。(下に解説を記載、対応する図/表番号があれば明記)

⑦上記⑥以外で表に出来そうな部分があれば表でまとめて下さい。(下に解説を記載、対応する図/表番号があれば記載)

⑧具体的な数値の記載を全て列挙して、表にまとめて下さい。(必ず正しく数値を抜き取る事、|数値|説明|の表へ)

⑨具体的な変数名(数式用の記号)の記載を全て列挙して、表にまとめて下さい。(|変数名|説明|の表へ)

⑩図/表があれば、各図/表は何を主張するためのものかを説明下さい。(掲載理由・注目ポイント等)

▼生成AIの回答(ChatGPT-4o)

⑥比較の記載

本論文では、Sparse Transformersと従来のTransformerおよび他の手法(CNNベースのWaveNetなど)との比較が行われている。主な違いは計算効率、メモリ使用量、および処理可能なシーケンス長である。

| モデル | 計算量 | メモリ使用量 | シーケンス長 | 特徴 |

|---|---|---|---|---|

| Transformer (Vaswani et al., 2017) | O(n²) | 高 | 短いシーケンス | 全Attention行列を計算、任意の依存関係をモデル化 |

| WaveNet (Van Den Oord et al., 2016) | O(n) | 低 | 中程度のシーケンス | 拡張畳み込みを使用、深いネットワークが必要 |

| Sparse Transformer | O(n√n) | 低 | 長いシーケンス | Attention行列の疎な分解により、計算効率が向上 |

⑦上記⑥以外で表に出来そうな部分

以下の表は、Sparse Transformerで導入された改良点とそれによる効果をまとめたものである。

| 改良点 | 効果 |

|---|---|

| Attention行列の疎な分解 | 計算量がO(n²)からO(n√n)に削減され、長いシーケンスでも処理可能 |

| 残差ブロックと重み初期化の再構成 | 非常に深いネットワークのトレーニングが可能 |

| Attentionカーネルの疎化 | 一部のAttention行列のみを計算することで計算効率向上 |

| Attention重みの再計算 | メモリ使用量の削減 |

⑧具体的な数値の記載

| 数値 | 説明 |

|---|---|

| O(n²) | 従来のTransformerにおける計算量 |

| O(n√n) | Sparse Transformerにおける計算量 |

| 数十万のタイムステップ | Sparse Transformerが処理可能なシーケンス長 |

| 100層以上 | Sparse Transformerが利用するレイヤー数 |

⑨具体的な変数名(数式用の記号)

本章では、数式に関する具体的な記述は見られないため、変数名のリストは無しである。

⑩図/表の説明

本章に該当する図/表の記載はないため、説明無し。

▼質問(人間)

続けて下記の質問に追加で回答下さい:

⑪関連研究の参照番号を全て列挙して、表にまとめて下さい。(元文にある内容のみ記載・類推して付け足しは不要、|参照番号|概要説明|の表へ、関連するもの同士でまとめて並べ替え)

▼生成AIの回答(ChatGPT-4o)

⑪関連研究の参照番号

以下は、元文で言及されている関連研究の参照番号と、その概要説明をまとめたものである。

| 参照番号 | 概要説明 |

|---|---|

| Jozefowicz et al., 2016 | 自然言語処理における最先端のニューラルオートレグレッシブモデルの成果を報告した研究 |

| Radford et al., 2018 | 自然言語処理タスクでのオートレグレッシブモデルの応用と性能に関する研究 |

| Dai et al., 2018 | 自然言語モデルの強化と自己回帰的手法に基づく新しいモデルアプローチを示した研究 |

| Van Den Oord et al., 2016 | WaveNetを提案し、音声データにおける自己回帰モデルの成功を示した研究 |

| Mehri et al., 2016 | オーディオデータの生成モデルに関する研究で、自己回帰的アプローチの重要性を強調 |

| Oord et al., 2016 | 畳み込みネットワークを基盤とした自己回帰モデルを画像生成に応用した研究 |

| Menick & Kalchbrenner, 2018 | 高次元画像データの生成に特化した自己回帰モデルに関する研究 |

| Salimans et al., 2017 | 自然画像に対する生成モデルでの成功事例に基づいた研究 |

| Reed et al., 2017 | 高次元データを扱う生成モデルの成功事例に関する研究 |

| Chen et al., 2017 | 生成モデルの新しいアプローチとその性能向上を報告した研究 |

| Vaswani et al., 2017 | Transformerアーキテクチャの基盤となる自己注意機構を提案した研究 |

この表では、関連する研究を自然言語、オーディオ、画像の分野ごとにまとめて並べ替えている。

▼質問(人間)

ここでの自己回帰モデルとは何か説明下さい。

▼生成AIの回答(ChatGPT-4o)

ここで言及されている自己回帰モデルとは、データ系列の各要素がそれ以前の要素に依存して生成されるモデルのことである。特に、次の要素を生成する際に、すでに生成された要素を使って条件付けを行い、その条件に基づいて分布を推定するという手法である。

具体的には、自己回帰モデルでは系列データ(例えば、時間系列データ、テキストデータ、オーディオデータ、画像のピクセルなど)の各時点でのデータを、その前の時点までに与えられたデータをもとにして予測する。この手法は、自己回帰的生成とも呼ばれ、特に以下の特徴を持つ:

- 逐次的生成: 自然言語やオーディオなど、順序性を持つデータに対して適用され、前の要素から順に次の要素を生成する。

- 確率モデル: データの生成過程を確率分布に基づいてモデル化し、各要素が前の要素に依存する確率を計算する。

- 分解: モデルは、データの結合確率(joint probability)を、過去の要素に条件付けされた条件付き確率(conditional probability)の積として分解する。

例えば、テキスト生成の場合、自己回帰モデルは以下のように動作する:

- 文の1文字目はランダムに生成され、その次の文字は1文字目に基づいて生成される。

- 3文字目は1文字目と2文字目に基づいて生成され…というように、次々に文字を生成する。

自己回帰モデルの代表例としては、次のようなものがある:

- WaveNet (Van Den Oord et al., 2016): オーディオ生成の分野での自己回帰モデル。生のオーディオ波形を逐次的に生成する。

- GPTシリーズ (Radford et al., 2018): 自然言語処理における自己回帰モデル。文脈を考慮しながら、次の単語を生成する。

このように、自己回帰モデルは長期依存性を持つ系列データの生成や予測に有効なアプローチであり、様々な分野で広く用いられている。

2. Related Work

▼質問(人間)

質問内容全体はここをクリック

(論文・記事の各章節を貼り付け) 2. Related Work The most related work involves other techniques for scaling up autoregressive generative models. For images, (Reed et al., 2017) models conditional independence between the pixels in order to generate many locations in parallel, and (Menick & Kalchbrenner, 2018) imposes an ordering and multi-scale upsampling procedure to generate high fidelity samples. (Parmar et al., 2018) uses blocks of local attention to apply Transformers to images. For text, (Dai et al., 2018) introduces a state reuse ”memory” for modeling long-term dependencies. And for audio, in addition to (Van Den Oord et al., 2016), (Mehri et al., 2016) used a hierarchical struc- ture and RNNs of varying clock-rates to use long contexts during inference, similar to (Koutnik et al., 2014). (Huang et al., 2018) apply Transformers to MIDI generation with an efficient relative attention. Our work is simpler than many of the techniques above and can be applied equally across images, text, and audio. Many of the above techniques are orthogonal to ours, moreover, and could be used in conjunction with ours. Outside of generative modeling, there are several works relevant to improving the efficiency of attention based off chunking (Chiu & Raffel, 2017) or using fixed length repre- sentations (Britz et al., 2017). Other works have investigated attention with multiple ”hops”, such as (Sukhbaatar et al., 2015) and (Gehring et al., 2017). It is worth noting that the Gated Pixel CNN (Oord et al., 2016) and WaveNet (Van Den Oord et al., 2016) use multi- plicative interactions in their networks, which are related to self-attention.上記の内容に関して下記の質問に回答下さい: (である調で記載、質問に対して該当するものが無ければ無しと記載)

①何についての記載か? + 要旨は何? (要旨は箇条書きで記載、既存手法があれば引用元を記載)

②具体的な処理方法の記載があれば説明下さい。(簡略化せずに全て記載、既存手法があれば引用元を記載)

③改良点・工夫点・テクニック等の記載があれば説明下さい。

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

⑤性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば各文末に記載)

▼生成AIの回答(ChatGPT-4o)

①何についての記載か? + 要旨は何?

- 本章は、自己回帰生成モデルをスケールアップするための他の手法に関する関連研究を紹介している。

- 要旨:

- 画像生成: (Reed et al., 2017) は、ピクセル間の条件付き独立性をモデル化し、並列で複数の場所を生成。 (Menick & Kalchbrenner, 2018) は、順序とマルチスケールアップサンプリングを課して高精度なサンプルを生成。

- テキスト生成: (Dai et al., 2018) は、長期依存をモデル化するために状態再利用メモリを導入。

- 音声生成: (Van Den Oord et al., 2016) に加え、(Mehri et al., 2016) は階層構造と異なるクロックレートを持つRNNを使用して長いコンテキストを活用。(Huang et al., 2018) は、MIDI生成に効率的な相対的アテンションを適用。

- Transformerの拡張: (Parmar et al., 2018) は、画像生成にTransformerを適用するためにローカルアテンションブロックを使用。

- 効率的なアテンションの研究: (Chiu & Raffel, 2017) はチャンクベースの手法、(Britz et al., 2017) は固定長表現を使用し、(Sukhbaatar et al., 2015) や (Gehring et al., 2017) はマルチホップアテンションを導入。

②具体的な処理方法の記載

- (Reed et al., 2017): ピクセル間の条件付き独立性をモデル化し、並列生成を実現。

- (Menick & Kalchbrenner, 2018): 順序付けとマルチスケールのアップサンプリングを利用し、高解像度のサンプル生成を行う。

- (Parmar et al., 2018): Transformerのアテンションをローカルアテンションブロックに分割し、画像生成に適用。

- (Dai et al., 2018): 長期依存を扱うために、状態再利用メモリを導入。

- (Mehri et al., 2016): 階層構造と異なるクロックレートを持つRNNを使用して、長いコンテキストを利用する音声生成手法。

- (Huang et al., 2018): MIDI生成において、効率的な相対アテンション機構を使用。

- (Chiu & Raffel, 2017): アテンション計算をチャンク化し、計算効率を向上。

- (Britz et al., 2017): 固定長の表現を使用して、アテンションの計算効率を改善。

- (Sukhbaatar et al., 2015) & (Gehring et al., 2017): 複数回アテンションを計算する「マルチホップアテンション」を提案。

③改良点・工夫点・テクニック等の記載

- 本研究では、上記の手法に比べて簡素化されたアプローチを提案している。特に、画像、テキスト、音声に対して一様に適用できる汎用性が強調されている。これらの技術の多くは本研究と併用できる点も指摘されている。

④メカニズムの解明・なぜそうなるのか等の記載

- 自己回帰モデルの生成における課題は、長期依存性を持つデータの効果的なモデリングである。従来のCNNベースのアプローチは、非常に深いネットワークを必要とするが、アテンションメカニズムを使用することで、少ない層で長期依存性を扱うことが可能である。また、メモリ効率の向上に向けた様々な技術も提案されている。

⑤性能が向上した記載

- 画像生成においては、(Menick & Kalchbrenner, 2018) のマルチスケール手法により高解像度の生成が可能となった。

- テキスト生成では、(Dai et al., 2018) のメモリ再利用による長期依存性の向上が確認された。

- 音声生成では、(Mehri et al., 2016) の階層構造RNNによる長いコンテキストの扱いが可能となり、従来手法を超えるパフォーマンスが得られた。

【対応する図/表番号は無し】

▼質問(人間)

続けて下記の質問に追加で回答下さい:

⑧具体的な数値の記載を全て列挙して、表にまとめて下さい。(必ず正しく数値を抜き取る事、|数値|説明|の表へ)

⑨具体的な変数名(数式用の記号)の記載を全て列挙して、表にまとめて下さい。(|変数名|説明|の表へ)

⑩図/表があれば、各図/表は何を主張するためのものかを説明下さい。(掲載理由・注目ポイント等)

⑪関連研究の参照番号を全て列挙して、表にまとめて下さい。(元文にある内容のみ記載・類推して付け足しは不要、|参照番号|概要説明|の表へ、関連するもの同士でまとめて並べ替え)

▼生成AIの回答(ChatGPT-4o)

⑧具体的な数値の記載

本節には、具体的な数値の記載がない。

⑨具体的な変数名(数式用の記号)

本節には、具体的な数式や変数名の記載がない。

⑩図/表があれば、各図/表は何を主張するためのものか

本節には、図表の記載がない。

⑪関連研究の参照番号

| 参照番号 | 概要説明 |

|---|---|

| Reed et al., 2017 | 画像生成においてピクセル間の条件付き独立性をモデル化し、並列生成を実現。 |

| Menick & Kalchbrenner, 2018 | 順序とマルチスケールアップサンプリングにより高解像度画像を生成。 |

| Parmar et al., 2018 | ローカルアテンションブロックを使用して、画像生成にTransformerを適用。 |

| Dai et al., 2018 | テキスト生成において、長期依存性をモデル化するために状態再利用メモリを導入。 |

| Van Den Oord et al., 2016 | 音声生成におけるWaveNetの提案。 |

| Mehri et al., 2016 | 階層構造と異なるクロックレートを持つRNNを使って、長いコンテキストを扱う音声生成手法を提案。 |

| Koutnik et al., 2014 | 音声生成において長いコンテキストの利用を可能にするRNNの手法。 |

| Huang et al., 2018 | MIDI生成にTransformerを適用し、効率的な相対アテンションを導入。 |

| Chiu & Raffel, 2017 | アテンション計算のチャンクベース手法を使用し、計算効率を改善。 |

| Britz et al., 2017 | 固定長表現を使用して、アテンション計算の効率を改善。 |

| Sukhbaatar et al., 2015 | 複数回アテンションを適用するマルチホップアテンションを提案。 |

| Gehring et al., 2017 | マルチホップアテンションによる改善を提案。 |

3. Background

▼質問(人間)

質問内容全体はここをクリック

(論文・記事の各章節を貼り付け) 3. Background We consider the task of autoregressive sequence gener- ation, where the joint probability of a sequence x = {x1, x2, ..., xn} is modeled as the product of conditional probability distributions and parameterized by a network θ. p(x) = n∏ i=1 p(xi|x1, ..., xi−1; θ) (1) We treat images, text, and audio as a sequence of discrete tokens, typically raw bytes. The network θ takes in the se- quence of tokens and outputs a categorical distribution over the v possible values of the next token using the softmax function, where v is the size of the vocabulary. The training objective is to maximize the log-probability of the data with respect to θ. A simple and powerful choice for model θ is a Transformer (Vaswani et al., 2017) in decoder-only mode, as demon- strated by (Radford et al., 2018) and (Liu et al., 2018). These models transform the input sequence with blocks of mul- tihead self-attention over the entire sequence, followed by dense transformations over each sequence element. The self- attention portion of the network must compute n weightings for each of n elements, however, which can quickly become intractable as the sequence length grows. In the following sections, we describe our modifications to the Transformer architecture which make it more suitable for modeling long sequences.上記の内容に関して下記の質問に回答下さい: (である調で記載、質問に対して該当するものが無ければ無しと記載)

①何についての記載か? + 要旨は何? (要旨は箇条書きで記載、既存手法があれば引用元を記載)

②具体的な処理方法の記載があれば説明下さい。(簡略化せずに全て記載、既存手法があれば引用元を記載)

③改良点・工夫点・テクニック等の記載があれば説明下さい。

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

⑤性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば各文末に記載)

▼生成AIの回答(ChatGPT-4o)

①何についての記載か? + 要旨は何?

- 記載内容: 本節では、自己回帰的なシーケンス生成タスクについて説明しており、その確率モデルの導入およびモデルとしてのTransformerの使用について述べている。また、従来のTransformerアーキテクチャの計算上の課題と、それに対する改良方法が次節以降で議論されることが示唆されている。

-

要旨:

- 自己回帰的シーケンス生成の確率モデルの導入。

- 画像、テキスト、音声を離散トークンのシーケンスとして扱う手法の説明。

- モデルとしてのTransformerの利点と計算上の問題点を提示。

- Transformerアーキテクチャの自己回帰的な使用例を示し、その計算負荷に関する課題を述べる。

②具体的な処理方法の記載

-

自己回帰的シーケンス生成モデル:

- シーケンス $x = {x_1, x_2, ..., x_n}$ の結合確率を、条件付き確率の積としてモデル化する。

$

p(x) = \prod_{i=1}^{n} p(x_i | x_1, ..., x_{i-1}; \theta)

$ - 各トークン $x_i$ に対して、ネットワーク $ \theta $ が条件付き確率分布を出力する。

- シーケンス $x = {x_1, x_2, ..., x_n}$ の結合確率を、条件付き確率の積としてモデル化する。

-

データの扱い:

- 画像、テキスト、音声データを離散的なトークン(通常は生のバイト列)として処理する。

-

ネットワークの出力:

- ネットワーク $ \theta $ は、次のトークンのカテゴリ分布をソフトマックス関数で出力し、語彙サイズ $v$ に基づいて計算される。

-

学習目標:

- データの対数尤度を最大化することが学習の目的である。

③改良点・工夫点・テクニック等の記載

-

Transformerの使用:

- デコーダモードのTransformerを使用し、自己回帰的なシーケンス生成を行う。これはRadford et al., (2018)やLiu et al., (2018)の成功例を基にしている。

-

計算負荷の問題:

- シーケンス長が増加するにつれて、自己注意メカニズムにおける計算が急激に増加し、各シーケンス要素に対して $n$ 個の重み付けを計算しなければならないため、シーケンス全体で $n \times n$ の計算が必要となる。この問題が解決すべき課題として指摘されている。

④メカニズムの解明・なぜそうなるのか等の記載

-

自己回帰的生成のメカニズム:

- シーケンス生成において、各トークンは前のトークン列に依存して生成されるため、自己回帰モデルではトークンが一つずつ順に生成される。

-

Transformerの特性:

- Transformerの自己注意機構は、各入力要素に対して全体の重み付けを計算するため、任意の依存関係を一度にモデリングすることが可能である。しかし、シーケンスが長くなると、計算量が二次的に増加するという課題がある。

⑤性能が向上した記載

- 本節には性能向上に関する具体的な記載はないが、次のセクションでTransformerの改良が述べられるとされている。

▼質問(人間)

続けて下記の質問に追加で回答下さい:

⑧具体的な数値の記載を全て列挙して、表にまとめて下さい。(必ず正しく数値を抜き取る事、|数値|説明|の表へ)

⑨具体的な変数名(数式用の記号)の記載を全て列挙して、表にまとめて下さい。(|変数名|説明|の表へ)

⑩図/表があれば、各図/表は何を主張するためのものかを説明下さい。(掲載理由・注目ポイント等)

⑪関連研究の参照番号を全て列挙して、表にまとめて下さい。(元文にある内容のみ記載・類推して付け足しは不要、|参照番号|概要説明|の表へ、関連するもの同士でまとめて並べ替え)

▼生成AIの回答(ChatGPT-4o)

⑧具体的な数値の記載

この章では具体的な数値が記載されていない。

⑨具体的な変数名(数式用の記号)

| 変数名 | 説明 |

|---|---|

| $ x = {x_1, x_2, ..., x_n} $ | シーケンス (画像、テキスト、音声の各トークン) |

| $ p(x) $ | シーケンス $x$ の結合確率 |

| $ p(x_i | x_1, ..., x_{i-1}; \theta) $ | 条件付き確率分布 |

| $ \theta $ | ネットワークのパラメータ |

| $ v $ | 語彙サイズ (次のトークンの候補数) |

⑩図/表の説明

この節には対応する図や表の記載はない。

⑪関連研究の参照番号

| 参照番号 | 概要説明 |

|---|---|

| Vaswani et al., 2017 | Transformerモデルの提案。自己注意機構を用いたシーケンス処理の手法。 |

| Radford et al., 2018 | Transformerを自己回帰モデルとして適用した例。 |

| Liu et al., 2018 | Transformerを使用してシーケンス生成を行う手法。 |

4. Factorized Self-Attention

4.1. Qualitative assessment of learned attention

▼質問(人間)

質問内容全体はここをクリック

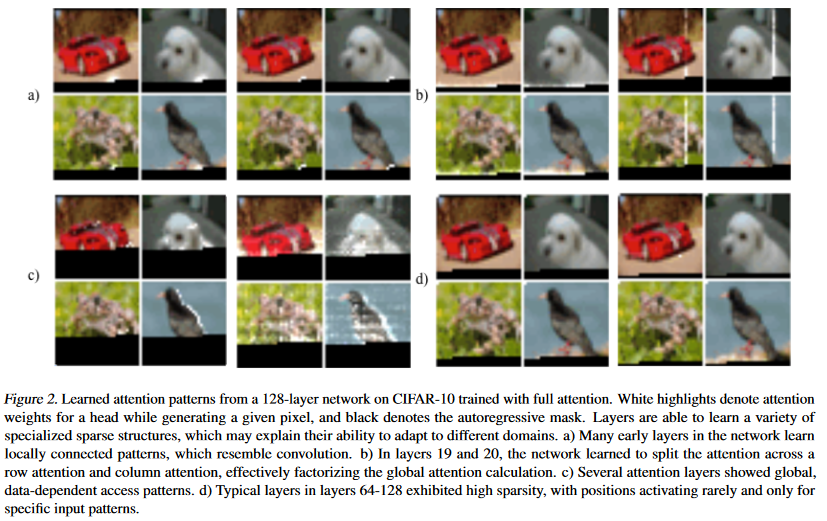

(論文・記事の各章節を貼り付け) 4. Factorized Self-Attention Sparse Transformers separate the full self-attention opera- tion across several steps of attention, as visualized in Figure 3(b) and 3(c). To motivate our approach, we first perform a qualitative assessment of attention patterns learned by a standard Transformer on an image dataset. 4.1. Qualitative assessment of learned attention patterns We visualized the attention patterns learned by a 128-layer self-attention network on CIFAR-10, and present several examples in Figure 2. Visual inspection showed that most layers had sparse attention patterns across most data points, suggesting that some form of sparsity could be introduced without significantly affecting performance. Several layers (Figure 2c) clearly exhibited global patterns, however, and others exhibited data-dependent sparsity (Figure 2d), both of which would be impacted by introducing a predetermined sparsity pattern into all of the attention matrices. In this paper, we restricted our investigation to a class of sparse attention patterns that have connectivity between all positions over several steps of attention. These methods can be more efficient than full attention while still providing global context to any given position. We aimed to empiri- cally validate the performance of these factorized patterns on a range of tasks, given that they are unable to learn the exact same mappings as those in Figure 2. We present the formulation of factorized attention below.Figure 2. Learned attention patterns from a 128-layer network on CIFAR-10 trained with full attention. White highlights denote attention

weights for a head while generating a given pixel, and black denotes the autoregressive mask. Layers are able to learn a variety of

specialized sparse structures, which may explain their ability to adapt to different domains. a) Many early layers in the network learn

locally connected patterns, which resemble convolution. b) In layers 19 and 20, the network learned to split the attention across a

row attention and column attention, effectively factorizing the global attention calculation. c) Several attention layers showed global,

data-dependent access patterns. d) Typical layers in layers 64-128 exhibited high sparsity, with positions activating rarely and only for

specific input patterns.

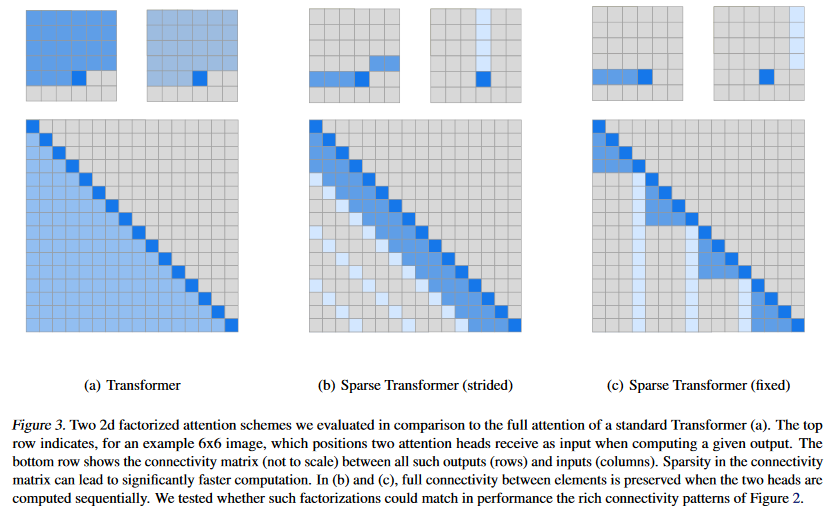

Figure 3. Two 2d factorized attention schemes we evaluated in comparison to the full attention of a standard Transformer (a). The top

row indicates, for an example 6x6 image, which positions two attention heads receive as input when computing a given output. The

bottom row shows the connectivity matrix (not to scale) between all such outputs (rows) and inputs (columns). Sparsity in the connectivity

matrix can lead to significantly faster computation. In (b) and (c), full connectivity between elements is preserved when the two heads are

computed sequentially. We tested whether such factorizations could match in performance the rich connectivity patterns of Figure 2.

上記の内容に関して下記の質問に回答下さい: (である調で記載、質問に対して該当するものが無ければ無しと記載)

①何についての記載か? + 要旨は何? (要旨は箇条書きで記載、既存手法があれば引用元を記載)

②具体的な処理方法の記載があれば説明下さい。(簡略化せずに全て記載、既存手法があれば引用元を記載)

③改良点・工夫点・テクニック等の記載があれば説明下さい。

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

⑤性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば各文末に記載)

▼生成AIの回答(ChatGPT-4o)

①何についての記載か? + 要旨は何?

- 何についての記載か: Sparse Transformersにおける因子化された自己注意機構の提案と、その効果の評価。

-

要旨:

- Sparse Transformersでは、完全な自己注意計算を複数のステップに分けて実行する。

- 標準的なTransformerが学習した注意パターンを定性的に評価し、画像データセットCIFAR-10上での128層ネットワークの注意パターンを可視化した。

- 学習した注意パターンには局所的なパターンや、データ依存の疎性が見られる。

- 提案手法では、数ステップの注意によって全ての位置に対する接続性を確保し、グローバルな文脈を維持しつつ計算を効率化することを目指している。

②具体的な処理方法の記載

- Sparse Transformersでは、自己注意の完全な計算を複数の注意ステップに分ける。

- 標準的なTransformerの128層ネットワークで、CIFAR-10に対して学習された注意パターンを可視化した。

- 層ごとに学習された注意パターンは異なり、初期層では局所的な接続パターンが見られる (図2a)。

- 19層目と20層目では行列および列の注意に分割され、グローバルな注意計算を因子化している (図2b)。

- 後半の層ではグローバルなデータ依存のアクセスパターンが確認され (図2c)、データごとに特定のパターンに基づく疎性が見られる (図2d)。

- 提案する疎注意パターンでは、複数の注意ステップにわたり全ての位置に接続性を持たせることで、効率化とパフォーマンスのバランスを取る。

- 因子化された自己注意のスキームとして、図3bと図3cの2D因子化スキームを評価し、標準的なTransformer(図3a)の完全な注意計算と比較した。

③改良点・工夫点・テクニック等の記載

- 完全な自己注意計算を因子化し、複数のステップに分割することで、計算の効率化を図っている。

- データ依存の疎注意パターンを導入し、ネットワークの接続性を維持しつつパフォーマンスを向上させる工夫がなされている。

- 因子化された自己注意スキームにより、全ての位置の接続性を数ステップの計算で保持し、計算コストを削減している (図3b, 図3c)。

④メカニズムの解明・なぜそうなるのか等の記載

- 局所的注意パターン: 初期層では局所的に隣接するピクセル間でのみ注意を行うことにより、計算の効率化と簡略化が図られる (図2a)。

- 行列・列注意の分割: グローバルな注意計算を行と列に分割することで、グローバルな文脈を保持しつつ、全体の計算量を削減している (図2b)。

- データ依存の疎性: 高次の層では、データに応じて必要な位置間のみで注意を行うため、非必要な計算を排除し、効率化が可能になる (図2c, 図2d)。

⑤性能が向上した記載

- 因子化された自己注意の導入により、全位置間の接続性を数ステップで保持しつつ、完全な自己注意よりも計算が高速化されることが確認されている (図3)。

- 高次の層で疎性を利用することで、全体のパフォーマンスを維持しながら効率的な計算が可能となった。

▼質問(人間)

続けて下記の質問に追加で回答下さい:

⑥比較の記載があれば違いを表でまとめて下さい。(下に解説を記載、対応する図/表番号があれば明記)

⑦上記⑥以外で表に出来そうな部分があれば表でまとめて下さい。(下に解説を記載、対応する図/表番号があれば記載)

⑧具体的な数値の記載を全て列挙して、表にまとめて下さい。(必ず正しく数値を抜き取る事、|数値|説明|の表へ)

⑨具体的な変数名(数式用の記号)の記載を全て列挙して、表にまとめて下さい。(|変数名|説明|の表へ)

⑩図/表があれば、各図/表は何を主張するためのものかを説明下さい。(掲載理由・注目ポイント等)

▼生成AIの回答(ChatGPT-4o)

⑥比較の記載

| 比較項目 | 因子化自己注意 (Sparse Transformers) | 標準Transformer (全自己注意) | 対応図表番号 |

|---|---|---|---|

| 計算の効率性 | ステップごとに因子化された注意により高速化 | 全位置間で完全な注意を行うため非効率 | 図3b, 3c |

| 接続性 | 数ステップで全位置に接続性を維持 | 全ての位置間で直接接続がある | 図3b, 3c |

| 注意パターンの柔軟性 | 固定された因子化パターン (図3b, 3c) | データ依存の注意パターン (図2) | 図2, 図3 |

| スパースパターンの導入効果 | 高次層では疎なパターンによる計算削減が可能 | スパースパターンがないため計算負荷高 | 図2, 図3 |

- 解説: 因子化自己注意は、計算の効率化を重視しつつ、全位置間の接続性を保つ方法であり、標準的なTransformerの全自己注意に比べて、計算コストが低減される。図3bおよび図3cに示されているように、因子化されたスキームでは、全ての位置に対する接続性を少ない計算ステップで達成する。また、図2に示されるデータ依存の柔軟な注意パターンと比較して、固定されたパターンによる制約があるが、それでもパフォーマンスは維持される。

⑦上記⑥以外で表に出来そうな部分

| 注意パターンのタイプ | 説明 | 対応図表番号 |

|---|---|---|

| 局所的接続パターン | 初期層で学習されたパターン。隣接する位置間でのみ注意が行われ、効率的な処理を可能にする。 | 図2a |

| 行列・列に分割された注意パターン | 中間層で学習されたパターン。行と列に分割された注意を使用してグローバルな注意計算を因子化している。 | 図2b |

| グローバルデータ依存パターン | 高次層でのデータ依存のパターン。データごとの固有のパターンに基づいて注意を行う。 | 図2c |

| データ特異的疎性 | 後半の層では、特定の入力パターンに対してのみ注意が行われる疎なパターンが見られる。 | 図2d |

- 解説: 学習された注意パターンの種類を表にまとめることで、ネットワーク内で異なる層がどのような注意の振る舞いを学習するかを理解しやすくしている。図2に示される各パターンは、ネットワークの柔軟性とスパースパターンの導入効果を視覚的に表している。

⑧具体的な数値の記載

| 数値 | 説明 |

|---|---|

| 128 | CIFAR-10に対して学習された128層の自己注意ネットワークの層数を指す。 |

| 19, 20 | 行列・列分割パターンが学習された層の番号 (図2b参照)。 |

| 64-128 | 高次層で疎な注意パターンが見られる層の範囲 (図2d参照)。 |

| 6x6 | 図3b、図3cで示された例としての画像サイズ。 |

⑨具体的な変数名(数式用の記号)

| 変数名 | 説明 |

|---|---|

| $ x $ | シーケンスの要素。画像、テキスト、音声の各トークン。 |

| $ \theta $ | ネットワークのパラメータ。 |

| $ p(x) $ | シーケンスの結合確率。 |

| $ p(x_i | x_1, ..., x_{i-1}; \theta) $ | 条件付き確率。$ x_i $を前のトークンに基づいて予測。 |

| $ v $ | ボキャブラリーのサイズ。 |

⑩図/表の説明

- 図2: CIFAR-10上で学習された128層自己注意ネットワークの注意パターンを可視化したもの。各層で学習された局所的な注意パターン、行列・列に分割されたパターン、グローバルな注意パターン、疎な注意パターンの例を示している。ネットワークがドメインに適応して注意パターンを最適化する能力を説明するための図である。

- 図3: 標準的なTransformerの完全な自己注意と、2D因子化スキームを比較したもの。因子化された自己注意の計算ステップが示され、疎な接続パターンによる効率性が強調されている。

▼質問(人間)

図3について、詳しく説明下さい。

▼生成AIの回答(ChatGPT-4o)

図3は、標準的なTransformerにおける完全な自己注意と、因子化された自己注意(Factorized Self-Attention)の2つのスキームを比較している。

図3の詳細な説明:

-

図3a: 標準Transformerの全自己注意

- 上部には、6x6の例としての画像が表示されている。この画像の各要素(ピクセル)は、それぞれが全ての他の位置に対して注意を行う。

- 下部には、対応する接続性行列が示されている。行列の各要素は、行(出力)の各位置が列(入力)の各位置に対して注意を行うかどうかを示している。全ての位置が他の全ての位置に対して接続されているため、行列は全ての要素が非ゼロ(接続されている)になっている。

- 注目ポイント: この標準的な全自己注意は、非常に強力で柔軟性が高いが、計算コストが大きい。

-

図3b: 因子化された自己注意のスキーム1

- 上部には、6x6の画像に対して行方向(row-wise)と列方向(column-wise)の2つの注意ヘッドが示されている。最初に行方向に注意を行い、その後に列方向に注意を行う。このステップごとの注意によって、全体として全位置に対する接続性が維持される。

- 下部には、対応する接続性行列が示されている。この行列では、2つの注意ヘッドが逐次的に適用されるため、部分的に疎なパターンが見られる。ただし、最終的には全位置に対する接続性が得られている。

- 注目ポイント: このスキームでは、全自己注意に比べて計算量が削減されているが、全体の接続性は保たれている。因子化された計算により、効率的な処理が可能になっている。

-

図3c: 因子化された自己注意のスキーム2

- 上部には、異なる因子化パターンが示されている。これは、図3bとは異なる注意の適用順序やパターンを使用して、同様に行方向と列方向で注意を行っている。最終的には全位置間での接続性が維持されている。

- 下部には、対応する接続性行列が示されている。こちらも部分的に疎なパターンが見られるが、最終的に全位置に対する接続性を提供する。

- 注目ポイント: 因子化のパターンが変わっても、計算量の削減と全接続性の維持という点では、図3bと同様のメリットが得られている。

全体のポイント:

- 全自己注意 (図3a) は全ての位置間で直接的に注意を行うため、計算コストが非常に高い。一方で、因子化された自己注意 (図3b, 3c) は、ステップごとに注意を分割することで計算量を削減しつつ、全体としては全位置間での接続性を維持できる。

- この因子化アプローチにより、特に長いシーケンスや大規模なデータセットに対して効率的な注意計算が可能になることが主張されている。

注目すべき点:

- 因子化された自己注意スキームは、疎な接続性行列を持ちながらも、最終的には全位置間の情報伝達を可能にしており、計算の効率性を大幅に向上させる可能性がある点で注目されている。

4.2. Factorized self-attention

▼質問(人間)

質問内容全体はここをクリック

(論文・記事の各章節を貼り付け) 4.2. Factorized self-attention A self-attention layer maps a matrix of input embeddings X to an output matrix and is parameterized by a connectiv- ity pattern S = {S1, ..., Sn}, where Si denotes the set of indices of the input vectors to which the ith output vector attends. The output vector is a weighted sum of transforma- tions of the input vectors: Attend(X, S) = ( a(xi, Si) ) i∈{1,...,n} (2) a(xi, Si) = softmax ( (Wq xi)KT Si √d ) VSi (3) KSi = ( Wkxj ) j∈Si VSi = ( Wv xj ) j∈Si (4) Here Wq , Wk, and Wv represent the weight matrices which transform a given xi into a query, key, or value, and d is the inner dimension of the queries and keys. The output at each position is a sum of the values weighted by the scaled dot-product similarity of the keys and queries. Full self-attention for autoregressive models defines Si = {j : j ≤ i}, allowing every element to attend to all previous positions and its own position. Factorized self-attention instead has p separate attention heads, where the mth head defines a subset of the indices A(m) i ⊂ {j : j ≤ i} and lets Si = A(m) i . We are chiefly interested in efficient choices for the subset A, where |A(m) i | ∝ p √n. Additionally, for the time being we consider valid choices of A, where all input positions are connected to all future output positions across the p steps of attention. For every j ≤ i pair, we set every A such that i can attend to j through a path of locations with maximum length p + 1. Specifically, if (j, a, b, c, ..., i) is the path of indices, then j ∈ A(1) a , a ∈ A(2) b , b ∈ A(3) c , and so forth. These two criteria allow us keep the ability of Transformers to propagate signals from arbitrary input positions to arbi- trary output positions in a constant number of steps, while reducing the total effective computation to O(n p √n). We also note that softening the validity criterion (for instance, having a series of only locally connected layers) may be a useful inductive bias for certain domains. In this work, we explore two factorizations for p = 2, which we describe in the following section, though we note that the same techniques can be easily extended to higher dimen- sions.上記の内容に関して下記の質問に回答下さい: (である調で記載、質問に対して該当するものが無ければ無しと記載)

①何についての記載か? + 要旨は何? (要旨は箇条書きで記載、既存手法があれば引用元を記載)

②具体的な処理方法の記載があれば説明下さい。(簡略化せずに全て記載、既存手法があれば引用元を記載)

③改良点・工夫点・テクニック等の記載があれば説明下さい。

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

⑤性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば各文末に記載)

⑧具体的な数値の記載を全て列挙して、表にまとめて下さい。(必ず正しく数値を抜き取る事、|数値|説明|の表へ)

⑨具体的な変数名(数式用の記号)の記載を全て列挙して、表にまとめて下さい。(|変数名|説明|の表へ)

▼生成AIの回答(ChatGPT-4o)

①何についての記載か? + 要旨は何?

- 記載内容: 因子化された自己注意(Factorized Self-Attention)について説明しており、自己注意層が入力埋め込み行列を出力行列にマッピングする過程や、接続パターンの選定方法を紹介している。また、計算効率を向上させるための工夫や、具体的な数式に基づいた注意の実装を記載している。

- 要旨:

- 自己注意層は、入力埋め込み行列を接続パターンに基づいて出力行列に変換するものである。

- 全自己注意は、各位置がすべての前の位置に対して注意を行うが、因子化された自己注意では異なるヘッドごとに接続パターンを制限し、計算効率を高める。

- 計算の効率化を図りつつ、全位置間で信号が伝搬できるようにするための接続パターンが提案されている。

- 計算効率は $O(n \cdot p \sqrt{n})$ に削減される。

- 今回は $p = 2$ の因子化を用いた2つのアプローチを提案し、さらに高次元に拡張可能であると示している。

②具体的な処理方法の記載

- 自己注意層は、入力埋め込み行列 $X$ を出力行列にマッピングする。これにより、各出力ベクトルが入力ベクトルの加重和として計算される。

- 出力ベクトルの計算は以下の式で表される:

$

\text{Attend}(X, S) = \left( a(x_i, S_i) \right)_{i \in {1, ..., n}}

$ - ここで、$a(x_i, S_i)$ はスケーリングされたドット積の類似度に基づいて計算された加重和であり、具体的な式は以下の通りである:

$

a(x_i, S_i) = \text{softmax}\left( \frac{(W_q x_i) K_{S_i}^T}{\sqrt{d}} \right) V_{S_i}

$- $W_q$、$W_k$、$W_v$ はそれぞれクエリ、キー、バリューに変換する重み行列。

- スケーリング因子は $d$ で、クエリとキーの内積を正規化している。

- $K_{S_i}$ と $V_{S_i}$ は以下の通り:

$

K_{S_i} = \left( W_k x_j \right){j \in S_i}, \quad V{S_i} = \left( W_v x_j \right)_{j \in S_i}

$ - この計算では、自己回帰モデルにおいて、全自己注意が $S_i = {j : j \leq i}$ で定義され、各要素がすべての過去の位置に対して注意を払う。

- 因子化された自己注意では、複数の注意ヘッド $p$ を用いて、接続パターンを部分集合 $A(m)_i \subseteq {j : j \leq i}$ に制限し、各ステップの接続を効率的に行う。

- 出力ベクトルの計算は以下の式で表される:

③改良点・工夫点・テクニック

- 因子化された自己注意では、異なるヘッドごとに接続パターンを分割し、計算効率を向上させている。特に、全位置が他の全位置に接続される必要があるが、この因子化によって計算コストを削減している。

- $A(m)_i$ は、入力位置 $i$ が $j$ に注意を向けるための部分集合を定義し、その大きさが $p \cdot \sqrt{n}$ に比例するように選定されている。

- $p + 1$ ステップ以内で全入力位置から全出力位置への信号伝搬が可能な接続パターンを使用する。

④メカニズムの解明・なぜそうなるのか

- 因子化された自己注意により、完全な自己注意と同様に全位置間での情報伝達が可能でありながら、計算量は $O(n \cdot p \sqrt{n})$ に削減される。

- これにより、シーケンス長が増大する際の計算コストの増加を抑え、効率的な処理が可能になる。

⑤性能が向上した記載

- 因子化された自己注意により、計算量が $O(n \cdot p \sqrt{n})$ に減少し、長いシーケンスでも効率的に処理できることが期待されている。

⑧具体的な数値の記載

| 数値 | 説明 |

|---|---|

| $O(n \cdot p \sqrt{n})$ | 計算効率の指標 |

| $p = 2$ | 因子化された自己注意のステップ数 |

| $p + 1$ | 入力位置から出力位置への信号伝搬の最大長 |

⑨具体的な変数名

| 変数名 | 説明 |

|---|---|

| $X$ | 入力埋め込み行列 |

| $S$ | 接続パターンのセット |

| $S_i$ | $i$番目の出力ベクトルが注意する入力ベクトルのインデックス集合 |

| $a(x_i, S_i)$ | $x_i$に対する加重和 |

| $W_q, W_k, W_v$ | クエリ、キー、バリューの重み行列 |

| $K_{S_i}, V_{S_i}$ | キーとバリューの集合 |

| $d$ | クエリとキーの内積のスケーリング因子 |

| $p$ | 注意ヘッドの数 |

「⑨具体的な変数名」の「キーとバリューの集合」の記載は、「注意するように選んだ集合で絞り込んだxと重みを掛けたもの$W_k x_j$」の方が適切。

4.3. Two-dimensional factorized attention

▼質問(人間)

質問内容全体はここをクリック

(論文・記事の各章節を貼り付け) 4.3. Two-dimensional factorized attention A natural approach to defining a factorized attention pattern in two dimensions is to have one head attend to the previous l locations, and the other head attend to every lth location, where l is the stride and chosen to be close to √n, a method we call strided attention. Formally, A(1) i = {t, t + 1, ..., i} for t = max(0, i − l) and A(2) i = {j : (i − j) mod l = 0}. This pattern can be visualized in Figure 3(b). This formulation is convenient if the data naturally has a structure that aligns with the stride, like images or some types of music. For data without a periodic structure, like text, however, we find that the network can fail to properly route information with the strided pattern, as spatial coor- dinates for an element do not necessarily correlate with the positions where the element may be most relevant in the future. In those cases, we instead use a fixed attention pattern (Fig- ure 3(c)), where specific cells summarize previous locations and propagate that information to all future cells. Formally, A(1) i = {j : (bj/lc = bi/lc)}, where the brackets denote the floor operation, and A(2) i = {j : j mod l ∈ {t, t + 1, ..., l}, where t = l − c and c is a hyperparameter. Concretely, if the stride is 128 and c = 8, then all future positions greater than 128 can attend to positions 120-128, all positions greater than 256 can attend to 248-256, and so forth. A fixed-attention pattern with c = 1 limits the expressivity of the network significantly, as many representations in the network are only used for one block whereas a small number of locations are used by all blocks. We instead found choosing c ∈ {8, 16, 32} for typical values of l ∈ {128, 256} to perform well, although it should be noted that this increases the computational cost of this method by c in comparison to the strided attention. Additionally, we found that when using multiple heads, having them attend to distinct subblocks of length c within the block of size l was preferable to having them attend to the same subblock. In the subsequent section, we describe how to incorporate factorized attention into the Sparse Transformer architec- ture.上記の内容に関して下記の質問に回答下さい: (である調で記載、質問に対して該当するものが無ければ無しと記載)

①何についての記載か? + 要旨は何? (要旨は箇条書きで記載、既存手法があれば引用元を記載)

②具体的な処理方法の記載があれば説明下さい。(簡略化せずに全て記載、既存手法があれば引用元を記載)

③改良点・工夫点・テクニック等の記載があれば説明下さい。

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

⑤性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば各文末に記載)

⑧具体的な数値の記載を全て列挙して、表にまとめて下さい。(必ず正しく数値を抜き取る事、|数値|説明|の表へ)

⑨具体的な変数名(数式用の記号)の記載を全て列挙して、表にまとめて下さい。(|変数名|説明|の表へ)

▼生成AIの回答(ChatGPT-4o)

①何についての記載か? + 要旨は何?

- 記載内容: 2次元因子化された注意(Two-dimensional factorized attention)について説明しており、データに応じた異なる注意パターン(ストライド注意と固定注意)を提案している。これらの手法は、計算効率を向上させつつ、信号伝播の効果を維持するために設計されている。

- 要旨:

- 因子化された注意を2次元データに適用するため、ストライド注意と固定注意という2つのアプローチが紹介されている。

- ストライド注意は、主に構造化されたデータ(例: 画像や音楽)に適用する際に有効であるが、非周期的なデータ(例: テキスト)では不適切な場合がある。

- テキストなどのデータに適した固定注意パターンを使用し、特定のセルが過去の位置を要約し、それを未来のすべてのセルに伝える形式が紹介されている。

- 固定注意のパラメータ $c$ によって、ネットワークの表現力と計算コストが調整される。

- 複数のヘッドを持つ場合、異なるサブブロックに注意を向ける設定が有効であることが示されている。

②具体的な処理方法の記載

- ストライド注意:

- $A(1)_i = {t, t + 1, ..., i}$ で、$t = \max(0, i - l)$ により、1つ目のヘッドが前の $l$ 個の位置に注意を向ける。

- $A(2)_i = {j : (i - j) \mod l = 0}$ で、2つ目のヘッドが $l$ の倍数の位置に注意を向ける。

- $l$ はストライドとして設定され、通常は $\sqrt{n}$ に近い値が選ばれる。

- 固定注意:

- $A(1)_i = {j : \lfloor j/l \rfloor = \lfloor i/l \rfloor}$ で、1つ目のヘッドが同じブロック内のすべての位置に注意を向ける。

- $A(2)_i = {j : j \mod l \in {t, t + 1, ..., l}}$ で、2つ目のヘッドがブロックの末尾付近に位置するセルに注意を向ける。

- $c$ は過去の位置を要約するために使用される位置の数を制御し、通常は $c \in {8, 16, 32}$ の値が有効である。

③改良点・工夫点・テクニック

- ストライド注意では、データに周期的な構造がある場合(例: 画像や音楽データ)に有効な方法を提案している。特に、1つ目のヘッドが連続した位置に、2つ目のヘッドが離れた位置に注意を向けることで、計算効率を高めている。

- 固定注意では、非周期的なデータに対応するため、特定のセルが過去の情報を要約し、それを未来のセルに伝播する設定を採用している。この際、パラメータ $c$ を調整することで、ネットワークの表現力と計算コストのトレードオフを図っている。

- 複数のヘッドを使用する場合、同じサブブロックに注意を向けるのではなく、異なるサブブロックに注意を向けることが有効であることが示されている。

④メカニズムの解明・なぜそうなるのか

- ストライド注意は、データに周期的な構造がある場合に効果的に信号を伝えるため、画像や音楽などの構造化データに適している。

- 固定注意は、データが非周期的である場合でも、過去の情報を効率的に伝達できるように設計されており、特定のセルが過去の位置を要約することで、すべての未来のセルにその情報を伝えることができる。

- $c$ の値を調整することで、ネットワークの表現力を制御し、計算効率とのバランスを取ることができる。また、複数のヘッドが異なるサブブロックに注意を向けることで、より豊かな情報伝達が可能となる。

⑤性能が向上した記載

- $c \in {8, 16, 32}$ の値を使用することで、固定注意パターンの性能が向上し、特にストライド長 $l \in {128, 256}$ において良好な結果が得られることが示されている。

⑧具体的な数値の記載

| 数値 | 説明 |

|---|---|

| $l = \sqrt{n}$ | ストライド注意のストライド長 |

| $c = 8, 16, 32$ | 固定注意の過去位置要約に使用するセルの数 |

| $l = 128, 256$ | ストライド長の例 |

| $c = 1$ | ネットワークの表現力が制限されるケース |

⑨具体的な変数名

| 変数名 | 説明 |

|---|---|

| $A(1)_i$ | 1つ目のヘッドの注意パターン |

| $A(2)_i$ | 2つ目のヘッドの注意パターン |

| $l$ | ストライド長 |

| $t$ | セルが過去のどこに注意を向けるかを制御する変数 |

| $c$ | 固定注意の過去位置要約に使用されるセルの数 |

| $\lfloor \cdot \rfloor$ | フロア関数(整数部分を取る操作) |

▼質問(人間)

前述の、全入力位置から全出力位置への信号伝搬が可能な接続パターンについて、説明下さい。

▼生成AIの回答(ChatGPT-4o)

前述の「全入力位置から全出力位置への信号伝搬が可能な接続パターン」について、因子化された注意機構の特性を活用し、効率的に信号伝達を行うための工夫が記載されている。これは、因子化された自己注意メカニズムを用いることで、従来の全結合型の自己注意よりも計算コストを削減しつつ、信号を全入力位置から全出力位置へ伝搬できるようにするものである。

具体的には、次のように説明されている。

-

入力から出力への信号伝搬

各入力位置 $ j $ から任意の出力位置 $ i $ への信号を伝達するために、各注意ヘッドが特定のサブセットの位置に対して注意を向けるように設計されている。因子化された注意では、従来の自己注意とは異なり、全入力位置に対して全出力位置が一度に接続されているわけではない。しかし、複数の注意ヘッドを活用することで、間接的に信号を伝搬させる経路が確保される。 -

最大長 $p + 1$

信号が入力位置から出力位置に到達するために必要な経路の最大長が $ p + 1 $ である。この $ p $ は因子化された自己注意のヘッド数を指し、つまり複数の注意ヘッドが連携することで、各出力位置が他の全入力位置から信号を受け取ることができるようになる。例えば、入力位置 $ j $ から出力位置 $ i $ まで、$ p + 1 $ ステップを経由することで伝達が可能になる。 -

経路の例

具体的な経路は、ある出力位置 $ i $ が入力位置 $ j $ から信号を受け取るために、複数の中間位置を経由する形式で設定されている。例えば、経路 $ (j, a, b, c, ..., i) $ のように、入力位置 $ j $ が最初の注意ヘッド $ A(1) $ で位置 $ a $ に接続され、次に $ A(2) $ で位置 $ b $ に接続される。このプロセスを繰り返すことで、信号が順次伝達され、最終的に出力位置 $ i $ に到達する。

このようにして、全入力位置から全出力位置への信号伝達を行うことができるため、従来の完全な自己注意と同様の表現力を維持しながら、計算効率を向上させている。また、計算コストが $ O(n \cdot p \cdot \sqrt{n}) $ に削減される点も強調されている。

▼質問(人間)

本文中の下記の部分について、詳しく説明下さい。

Concretely, if the stride is 128 and c = 8, then all future

positions greater than 128 can attend to positions 120-128,

all positions greater than 256 can attend to 248-256, and so

forth.

▼生成AIの回答(ChatGPT-4o)

本文中の「Concretely, if the stride is 128 and c = 8, then all future positions greater than 128 can attend to positions 120-128, all positions greater than 256 can attend to 248-256, and so forth.」という部分は、固定された注意パターンにおけるストライド(l)とパラメータ(c)による接続範囲の具体的な例を説明している。

以下、詳しく説明する。

ストライド(l)と固定された注意パターン

-

ストライド(l = 128)

この文では、ストライド $ l = 128 $ という設定を前提にしている。ストライドとは、どの範囲までの入力位置が現在の出力位置に注意を払うかを決めるものである。ここで、ストライドが 128 であるため、128 を超える位置(つまり未来の位置)では、過去の範囲 120-128 の位置に対して注意が払われる。 -

パラメータ $ c = 8 $

$ c $ はサブブロックの長さを決定するパラメータである。$ c = 8 $ の場合、128 を超える位置は、直前のブロック(120-128)の 8 個の位置に注意を払う。つまり、未来の位置がアクセスできる過去の範囲は 120-128 であり、この部分に集中して注意が払われる。

例: $ 128 $ を超える位置

-

128 を超える位置がどこに注意を向けるか

具体的には、位置 $ i > 128 $ のすべての未来の位置は、過去の範囲 120-128 の位置に注意を払う。これは、ネットワークが次の出力を生成する際に、最も関連性の高い過去の情報(ここでは 120-128 の位置)に基づいて次の予測を行うためである。これにより、計算コストを削減しつつ、重要な過去情報にアクセスできるようになる。 -

256 を超える位置がどこに注意を向けるか

同様に、位置 $ i > 256 $ では、過去の範囲 248-256 に注意を払う。ここでも、計算の効率化のため、未来の位置がすべての過去位置に対して注意を払うのではなく、特定の範囲(ここでは 248-256)のみに集中して注意を向けるように設定されている。

注意のパターンの意味

- このように、ストライド 128 とサブブロック長さ $ c = 8 $ という設定は、全入力に対して全出力が接続されているのではなく、特定の範囲に限られた形で接続されることで、計算コストを削減しつつも、重要な情報を保持するためのものである。

- 128 を超える未来の位置は 120-128 に、256 を超える未来の位置は 248-256 に注意を向けるというルールが固定されているため、このパターンが適用されるデータでは効率的な注意メカニズムが実現できる。ただし、テキストデータなど周期的構造がない場合は、このパターンが適切に情報をルーティングできない場合もあると指摘されている。

このような固定された注意パターンの具体例を用いることで、計算の効率性が向上するが、一部のデータ形式では十分な表現力を持たない場合もある。

全入力位置から全出力位置への信号伝搬が可能な接続パターンとは具体的に何かがよく分からないが、論文の本文を読んでも詳しく書かれてある訳ではない。

5. Sparse Transformer

5.1. Factorized attention heads

▼質問(人間)

質問内容全体はここをクリック

(論文・記事の各章節を貼り付け) 5. Sparse Transformer Here we fully describe the Sparse Transformer architecture, which is a modified version of the Transformer (Vaswani et al., 2017). 5.1. Factorized attention heads Standard dense attention simply performs a linear transfor- mation of the attend function defined in Equation 2: attention(X) = Wp · attend(X, S) (5) where Wp denotes the post-attention weight matrix. The simplest technique for integrating factorized self-attention is to use one attention type per residual block, and interleave them sequentially or at a ratio determined as a hyperparam- eter: attention(X) = Wp · attend(X, A(r mod p)) (6) Here r is the index of the current residual block and p is the number of factorized attention heads. A second approach is to have a single head attend to the locations of the pixels that both factorized heads would attend to, which we call a merged head: attention(X) = Wp · attend(X, p⋃ m=1 A(m)) (7) This is slightly more computationally intensive, but only by a constant factor. A third approach is to use multi-head attention (Vaswani et al., 2017), where nh attention products are computed in parallel, then concatenated along the feature dimension: attention(X) = Wp ( attend(X, A)(i)) i∈{1,...,nh} (8) Here, the A can be the separate attention patterns, the merged patterns, or interleaved as in Eq. 2. Also, the di- mensions of the weight matrices inside the attend function are reduced by a factor of 1/nh, such that the number of parameters are invariant across values of nh. We typically find multiple heads to work well, though for extremely long sequences where the attention dominates the computation time, it is more worthwhile to perform them one at a time and sequentially.上記の内容に関して下記の質問に回答下さい: (である調で記載、質問に対して該当するものが無ければ無しと記載)

①何についての記載か? + 要旨は何? (要旨は箇条書きで記載、既存手法があれば引用元を記載)

②具体的な処理方法の記載があれば説明下さい。(簡略化せずに全て記載、既存手法があれば引用元を記載)

③改良点・工夫点・テクニック等の記載があれば説明下さい。

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

⑤性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば各文末に記載)

⑧具体的な数値の記載を全て列挙して、表にまとめて下さい。(必ず正しく数値を抜き取る事、|数値|説明|の表へ)

⑨具体的な変数名(数式用の記号)の記載を全て列挙して、表にまとめて下さい。(|変数名|説明|の表へ)

▼生成AIの回答(ChatGPT-4o)

①何についての記載か? + 要旨は何?

この部分はSparse Transformerのアーキテクチャと、Factorized Attention Headsを用いたアテンション機構の異なる実装方法に関する記載である。

要旨

- Sparse Transformerのアーキテクチャは、標準的なTransformerモデルを基に、スパースなアテンション機構を導入して効率的に情報を処理する手法である (Vaswani et al., 2017)。

- Factorized Attention Headsは、アテンションヘッドを複数に分け、スパースなアテンションを効率的に実行するための手法である。

- 複数の手法として、Residual Block内で異なるアテンションタイプを順次適用する方法、複数のアテンションを一つのヘッドに統合する方法、Multi-head Attentionを用いる方法が提案されている。

- 各手法にはそれぞれの利点があり、特に長いシーケンスでは、計算時間を最適化するために適切なアテンションの組み合わせが必要である。

②具体的な処理方法の記載

-

基本的なアテンションの定義: 標準的なDense Attentionは、入力 $X$ に対して線形変換を行い、アテンション関数を計算する (式5)。

$

\text{attention}(X) = W_p \cdot \text{attend}(X, S)

$

ここで、$W_p$ はポストアテンションの重み行列を表す。 -

Factorized Attentionの実装方法: 最も単純な手法は、各Residual Blockに対して異なるアテンションタイプを適用し、それを順次またはハイパーパラメータで決められた比率で組み合わせる方法である (式6)。

$

\text{attention}(X) = W_p \cdot \text{attend}(X, A(r \mod p))

$

ここで、$r$ は現在のResidual Blockのインデックス、$p$ はFactorized Attention Headsの数である。 -

Merged Headの手法: もう一つの手法は、複数のアテンションヘッドが見るべき場所を一つのヘッドで処理する「Merged Head」である (式7)。

$

\text{attention}(X) = W_p \cdot \text{attend}(X, \bigcup_{m=1}^{p} A(m))

$ -

Multi-head Attentionの手法: 最後に、複数のアテンションヘッドを並行して計算し、その結果を特徴次元に沿って結合するMulti-head Attentionがある (式8)。

$

\text{attention}(X) = W_p \left( \text{attend}(X, A)(i) \right)_{i \in {1, ..., n_h}}

$

ここで、各アテンションヘッドの重み行列は、$n_h$ の値に応じて次元が縮小される。

③改良点・工夫点・テクニック等の記載

- Factorized Attention Headsを使用して、Dense Attentionの計算コストを削減しつつ、必要な情報を適切にキャプチャする工夫が行われている。

- Merged Headでは複数のアテンションヘッドを統合し、計算量を一定の範囲で増やしながらも精度を維持する工夫がされている。

- Multi-head Attentionでは複数のアテンションヘッドを同時に計算することで、各ヘッドの情報を効率的に集約している。

④メカニズムの解明・なぜそうなるのか等の記載

- Factorized Attention Headsは、全ての要素に均等にアテンションを適用するDense Attentionに比べ、特定の要素にスパースにアテンションを適用するため、計算コストを削減できる。

- Merged Headは、複数のアテンションパターンを一つのヘッドに統合することで、計算の並列性を減少させる代わりに、計算の一貫性を向上させる。

- Multi-head Attentionでは、各ヘッドが異なるアテンションパターンに集中するため、モデルが多様な情報を同時に処理できる。

⑤性能が向上した記載

- Factorized Attention Headsを用いた場合、計算コストが減少しつつも、性能が保持されることが示されている。

- Merged Headを使用した場合、計算コストが一定範囲で増加するが、性能は向上する (図や表番号は本文中に記載されていないため、無し)。

⑧具体的な数値の記載

| 数値 | 説明 |

|---|---|

| $n_h$ | アテンションヘッドの数 |

| $r$ | 現在のResidual Blockのインデックス |

| $p$ | Factorized Attention Headsの数 |

| $W_p$ | ポストアテンションの重み行列 |

⑨具体的な変数名の記載

| 変数名 | 説明 |

|---|---|

| $X$ | 入力データ |

| $A$ | アテンションパターン |

| $W_p$ | ポストアテンションの重み行列 |

| $r$ | Residual Blockのインデックス |

| $p$ | Factorized Attention Headsの数 |

| $n_h$ | アテンションヘッドの数 |

上記の生成AIの回答内容では、(式6)、(式7)、(式8)の具体的な計算方法がよく分からないが、論文の本文を読んでも詳しく書かれてある訳ではない。

5.2. Scaling to hundreds of layers

▼質問(人間)

質問内容全体はここをクリック

(論文・記事の各章節を貼り付け) 5.2. Scaling to hundreds of layers We found that Transformers were difficult to train with many layers, as noted by (Al-Rfou et al., 2018). Instead of incorporating auxillary losses, we adopted the following architectural changes. First, we use the pre-activation residual block of (He et al., 2016), defining a network of N layers in the following way: H0 = embed(X, We) (9) Hk = Hk−1 + resblock(Hk−1) (10) y = softmax(norm(HN )Wout) (11) where embed is a function we describe in the next section, Wout is a weight matrix, and resblock(h) normalizes the input to the attention block and a positionwise feedforward network in the following way: a(H) = dropout(attention(norm(H))) (12) b(H) = dropout(ff(norm(H + a(H)))) (13) resblock(H) = a(H) + b(H) (14) The norm function denotes Layer Normalization (Ba et al., 2016), and ff(x) = W2 f (W1x + b1) + b2. Our choice of f is the Gaussian Error Linear Unit (Hendrycks & Gimpel, 2016), f (X) = X sigmoid(1.702 · X), as used in (Rad- ford et al., 2018). The output dimension of W1 is 4.0 times the input dimension, unless otherwise noted. Observe that HN is the sum of N applications of functions a and b, and thus each function block receives a gradient directly from the output layer . We scale the initialization of W2 and Wp in Eq. 5 by 1√2N to keep the ratio of input embedding scale to residual block scale invariant across values of N .上記の内容に関して下記の質問に回答下さい: (である調で記載、質問に対して該当するものが無ければ無しと記載)

①何についての記載か? + 要旨は何? (要旨は箇条書きで記載、既存手法があれば引用元を記載)

②具体的な処理方法の記載があれば説明下さい。(簡略化せずに全て記載、既存手法があれば引用元を記載)

③改良点・工夫点・テクニック等の記載があれば説明下さい。

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

⑤性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば各文末に記載)

⑧具体的な数値の記載を全て列挙して、表にまとめて下さい。(必ず正しく数値を抜き取る事、|数値|説明|の表へ)

⑨具体的な変数名(数式用の記号)の記載を全て列挙して、表にまとめて下さい。(|変数名|説明|の表へ)

▼生成AIの回答(ChatGPT-4o)

①何についての記載か? + 要旨は何?

この章節は、Transformerモデルを多数の層にスケーリングする際の課題と、これに対処するために行われたアーキテクチャの変更について記載している。Al-Rfou et al. (2018) によって指摘されたTransformerのスケーリング問題に対し、補助損失を用いるのではなく、Pre-Activation Residual Block(He et al., 2016)を使用して解決する手法が述べられている。

要旨

- Transformerは多数の層を持つモデルで訓練が困難になる問題がある (Al-Rfou et al., 2018)。

- Pre-Activation Residual Block (He et al., 2016) を用いて、この問題に対処した。

- 各層はLayer Normalization、アテンションブロック、位置ごとのフィードフォワードネットワークを通過する。

- 重みの初期化をスケーリングすることで、入力埋め込みスケールと残差ブロックスケールの比率を保つ。

②具体的な処理方法の記載

- ネットワークは次のように定義される (式9-11):

$

H_0 = \text{embed}(X, W_e)

$

$

H_k = H_{k-1} + \text{resblock}(H_{k-1})

$

$

y = \text{softmax}(\text{norm}(H_N) W_\text{out})

$

ここで、$ \text{embed} $ は次のセクションで定義される関数であり、$ W_\text{out} $ は重み行列である。また、$ \text{resblock}(h) $ は、入力を正規化し、アテンションブロックと位置ごとのフィードフォワードネットワークを適用する処理である。 - アテンションブロックとフィードフォワードネットワークは以下のように定義される:

$

a(H) = \text{dropout}(\text{attention}(\text{norm}(H)))

$

$

b(H) = \text{dropout}(\text{ff}(\text{norm}(H + a(H))))

$

$

\text{resblock}(H) = a(H) + b(H)

$ - $ \text{norm} $ はLayer Normalization (Ba et al., 2016)を指し、フィードフォワード関数 $ \text{ff}(x) $ は次のように定義される:

$

\text{ff}(x) = W_2 f(W_1 x + b_1) + b_2

$

ここで、$ f $ はGaussian Error Linear Unit (Hendrycks & Gimpel, 2016) であり、以下のように定義される:

$

f(X) = X \cdot \text{sigmoid}(1.702 \cdot X)

$

このアクティベーション関数は、Radford et al. (2018)で使用されている。

③改良点・工夫点・テクニック等の記載

- Pre-Activation Residual Blockを導入することで、多層のTransformerモデルにおける学習の難しさを軽減する工夫がされている (He et al., 2016)。

- アテンションブロックとフィードフォワードネットワークの前にLayer Normalizationを適用することで、安定した学習を実現している (Ba et al., 2016)。

- 重み行列 $ W_2 $ と $ W_p $ の初期化スケールを $ \frac{1}{\sqrt{2N}} $ にスケーリングすることで、多層モデルでも安定したスケールの保持が可能である。

④メカニズムの解明・なぜそうなるのか等の記載

- Pre-Activation Residual Blockは、各関数ブロックが出力層から直接勾配を受け取るため、勾配消失問題を緩和し、深い層の学習が容易になる。

- $ W_2 $ と $ W_p $ の初期化をスケーリングすることで、多層にわたって埋め込みスケールと残差ブロックスケールが不変であるため、過剰なスケール変化を抑制できる。

⑤性能が向上した記載

- 提案されたアーキテクチャの変更により、多層Transformerの訓練が容易になるとされているが、具体的な性能向上の数値は記載されていない。

⑧具体的な数値の記載

| 数値 | 説明 |

|---|---|

| 4.0 | $ W_1 $ の出力次元が入力次元の4倍 |

| 1.702 | GELUのスケーリングファクター |

| $ \frac{1}{\sqrt{2N}} $ | 重み行列 $ W_2 $ と $ W_p $ の初期化スケール |

⑨具体的な変数名の記載

| 変数名 | 説明 |

|---|---|

| $ H_0 $ | 初期状態の埋め込み |

| $ H_k $ | k層目の出力 |

| $ W_e $ | 埋め込み重み行列 |

| $ W_\text{out} $ | 出力層の重み行列 |

| $ a(H) $ | アテンションブロックの出力 |

| $ b(H) $ | フィードフォワードネットワークの出力 |

| $ W_1 $ | フィードフォワードの第1重み行列 |

| $ W_2 $ | フィードフォワードの第2重み行列 |

| $ b_1 $ | フィードフォワードの第1バイアス項 |

| $ b_2 $ | フィードフォワードの第2バイアス項 |

| $ N $ | 層数 |

| $ \text{norm}(H) $ | Layer Normalization |

5.3. Modeling diverse data types

▼質問(人間)

質問内容全体はここをクリック

(論文・記事の各章節を貼り付け) 5.3. Modeling diverse data types In addition to the embedding of input symbols, positional embeddings are typically used in Transformers and other location-agnostic architectures to encode the spatial relation- ships of data (Gehring et al., 2017), (Parmar et al., 2018). We found using learned embeddings which either encoded the structure of the data or the factorized attention patterns were important for performance of our models. We added either nemb = ddata or nemb = dattn embed- dings to each input location, where ddata refers to the num- ber of dimensions of the data, and dattn is the number of dimensions of the factorized attention. If xi is the one-hot encoded ith element in the sequence, and o(j) i represents the one-hot encoded position of xi in the jth dimension (1 ≤ j ≤ nemb), then: embed(X, We) = xiWe + nemb∑ j=1 o(j) i Wj xi∈X (15) For images, we used data embeddings, where ddata = 3 for the row, column, and channel location of each input byte. For text and audio, we used two-dimensional attention embeddings, where dattn = 2 and the index corresponds to each position’s row and column index in a matrix of width equal to the stride.上記の内容に関して下記の質問に回答下さい: (である調で記載、質問に対して該当するものが無ければ無しと記載)

①何についての記載か? + 要旨は何? (要旨は箇条書きで記載、既存手法があれば引用元を記載)

②具体的な処理方法の記載があれば説明下さい。(簡略化せずに全て記載、既存手法があれば引用元を記載)

③改良点・工夫点・テクニック等の記載があれば説明下さい。

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

⑤性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば各文末に記載)

⑧具体的な数値の記載を全て列挙して、表にまとめて下さい。(必ず正しく数値を抜き取る事、|数値|説明|の表へ)

⑨具体的な変数名(数式用の記号)の記載を全て列挙して、表にまとめて下さい。(|変数名|説明|の表へ)

▼生成AIの回答(ChatGPT-4o)

①何についての記載か? + 要旨は何?

この章節は、多様なデータタイプ(画像、テキスト、オーディオなど)に対してどのようにTransformerを適用し、特に位置埋め込みとファクタライズドアテンションパターンを使用してデータの空間的関係をエンコードする方法について述べている。また、データの構造やアテンションパターンをエンコードするために学習された埋め込みが重要であることが示されている。

要旨

- Transformerにおける位置埋め込みは、データの空間的関係をエンコードするために重要である (Gehring et al., 2017; Parmar et al., 2018)。

- データの次元やファクタライズドアテンションの次元を埋め込みとして追加することが性能に寄与する。

- 画像には3次元の埋め込みを、テキストやオーディオには2次元の埋め込みを使用する。

②具体的な処理方法の記載

- 埋め込みは次のように定義される (式15):

$

\text{embed}(X, W_e) = \left( x_i W_e + \sum_{j=1}^{n_\text{emb}} o^{(j)}_i W_j \right), \quad x_i \in X

$

ここで、$ x_i $ はシーケンス内のi番目の要素のone-hotエンコードを表し、$ o^{(j)}i $ はj番目の次元での $ x_i $ の位置をone-hotエンコードしたものを表す。また、$ n\text{emb} $ は埋め込み次元数である。 - 画像の場合、行、列、チャンネルの位置情報を埋め込むために $ d_\text{data} = 3 $ を使用し、テキストとオーディオの場合は2次元アテンション埋め込みを使用する($ d_\text{attn} = 2 $)。

③改良点・工夫点・テクニック等の記載

- データの構造やアテンションパターンに基づいた学習済み埋め込みを追加することで、異なるデータタイプに対して適応可能なアーキテクチャを実現している。具体的には、画像には3次元のデータ埋め込み、テキストやオーディオには2次元のアテンション埋め込みを使用している。

④メカニズムの解明・なぜそうなるのか等の記載

- 埋め込みを通じてデータの空間的関係を明示的にエンコードすることにより、Transformerが位置に依存しないアーキテクチャであっても、空間的な構造を効率的に学習できる。画像の行・列・チャンネル位置をエンコードすることで、空間的依存関係が考慮される。

- テキストやオーディオでは、各位置の行・列インデックスをアテンション埋め込みとして使用することで、これらのデータに対するアテンションの適用が可能になる。

⑤性能が向上した記載

- データ埋め込みやアテンションパターン埋め込みを追加することで、モデルの性能が向上したとされているが、具体的な数値は記載されていない。

⑧具体的な数値の記載

| 数値 | 説明 |

|---|---|

| 3 | 画像の行、列、チャンネルに対応する次元数 |

| 2 | テキストやオーディオのアテンション埋め込みに対応する次元数 |

⑨具体的な変数名の記載

| 変数名 | 説明 |

|---|---|

| $ n_\text{emb} $ | 埋め込みの次元数 |

| $ d_\text{data} $ | データの次元数 (例: 画像の場合は3) |

| $ d_\text{attn} $ | アテンションの次元数 (例: テキストやオーディオでは2) |

| $ x_i $ | シーケンス内のi番目の要素のone-hotエンコード |

| $ o^{(j)}_i $ | $ x_i $ のj次元での位置のone-hotエンコード |

| $ W_e $ | 埋め込み重み行列 |

| $ W_j $ | j次元目の位置埋め込みの重み行列 |

▼質問(人間)

上記の「位置埋め込み」は、各層の入力に毎回加算されるものか?

▼生成AIの回答(ChatGPT-4o)

「位置埋め込み」は、各層の入力に毎回加算されるものではなく、基本的には入力データに一度だけ加算されるものである。具体的には、入力のシーケンスやデータの位置情報をエンコードするために使用され、入力層でデータに加算され、その後の層では加算されたまま処理が進む形となる。

この論文でも、埋め込みの式 (式15) で位置埋め込みが入力データ $ x_i $ に加算されていることが示されており、その加算は各層で繰り返し行われるわけではないと考えられる。

上記のピンポイントで質問した時の生成AIの回答は、間違い。

ここでの「位置埋め込み」は、各層の入力に毎回加算されるもの。本文には「each input location」と書かれてある。また、埋め込みの次元数$n_{emb}$の定義には、アテンションの次元数「the number of dimensions of factorized attention」も書かれてある。

論文の本文中の該当箇所:

We added either $n_{emb}$ = $d_{data}$ or $n_{emb}$ = $d_{attn}$ embed-

dings to each input location, where $d_{data}$ refers to the num-

ber of dimensions of the data, and $d_{attn}$ is the number of

dimensions of the factorized attention.

5.4. Saving memory by recomputing attention weights

▼質問(人間)

質問内容全体はここをクリック

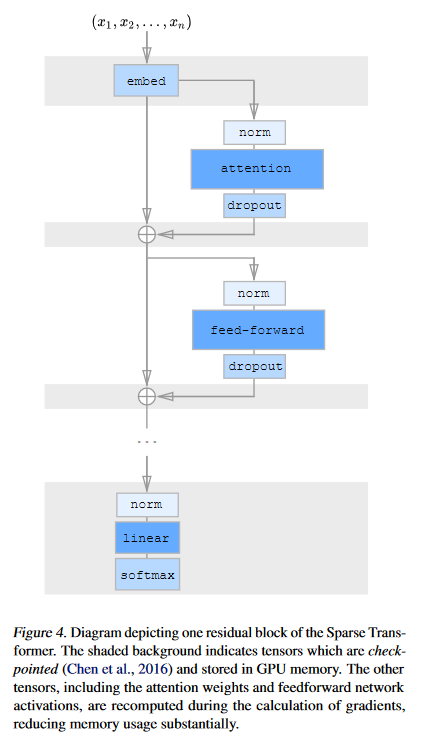

(論文・記事の各章節を貼り付け) 5.4. Saving memory by recomputing attention weights Gradient checkpointing has been shown to be effective in reducing the memory requirements of training deep neural networks (Chen et al., 2016), (Gruslys et al., 2016). It is worth noting, however, that this technique is particularly effective for self-attention layers when long sequences are processed, as memory usage is high for these layers relative to the cost of computing them. Using recomputation alone, we are able to train dense atten- tion networks with hundreds of layers on sequence lengths of 16,384, which would be infeasible on modern hardware otherwise. In our experiments, we recompute the attention and feed- forward blocks during the backwards pass. To simplify our implementation, we do not apply dropout within the attention blocks, as in (Vaswani et al., 2017), and instead only apply it at the end of each residual addition, as seen in Figure 4.上記の内容に関して下記の質問に回答下さい: (である調で記載、質問に対して該当するものが無ければ無しと記載)

①何についての記載か? + 要旨は何? (要旨は箇条書きで記載、既存手法があれば引用元を記載)

②具体的な処理方法の記載があれば説明下さい。(簡略化せずに全て記載、既存手法があれば引用元を記載)

③改良点・工夫点・テクニック等の記載があれば説明下さい。

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

⑤性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば各文末に記載)

⑧具体的な数値の記載を全て列挙して、表にまとめて下さい。(必ず正しく数値を抜き取る事、|数値|説明|の表へ)

⑨具体的な変数名(数式用の記号)の記載を全て列挙して、表にまとめて下さい。(|変数名|説明|の表へ)

▼生成AIの回答(ChatGPT-4o)

①何についての記載か? + 要旨は何?

- 記載内容: 記載内容は、メモリ使用量を削減するために、アテンションウェイトの再計算(recomputing attention weights)技術を使用する手法についてである。

-

要旨:

- 勾配チェックポイント技術の有効性(Chen et al., 2016; Gruslys et al., 2016)の言及。

- 特に自己アテンション層におけるメモリ使用量削減の効果。

- 長いシーケンスの処理において、メモリ使用量が高いことを背景に、アテンションウェイトを再計算することでメモリを節約する技術の説明。

- 実験では、数百層にわたるディープなアテンションネットワークを16,384のシーケンス長でトレーニングできることを確認。

②具体的な処理方法の記載

- 記載内容としては、逆伝播時にアテンション層とフィードフォワード層のブロックを再計算する技術を適用する。具体的には、通常の処理では前向き伝播時に保存していたアテンションウェイトなどの中間結果を保存せず、後ろ向き伝播の際に必要な時に再度計算し直す方法である。また、Vaswani et al. (2017) のアプローチに従い、ドロップアウトはアテンションブロック内では適用せず、各残差加算の終わりにのみ適用する。これにより実装が簡略化されている。

③改良点・工夫点・テクニック等の記載

- 勾配チェックポイント技術を利用し、自己アテンション層での高いメモリ使用量を削減することで、長いシーケンスを処理する際のメモリ効率を向上させている。

- ドロップアウトの適用をアテンションブロック内部から排除し、各残差加算の後に適用することで実装が簡略化されている。

④メカニズムの解明・なぜそうなるのか等の記載

- メモリ使用量が高いアテンション層に対して勾配チェックポイント技術を適用することで、中間計算結果を再計算し直すことでメモリ使用を減少させる。これは、特に長いシーケンスを処理する場合に有効であり、再計算による計算負荷の増加がメモリ削減による利点を上回らないためである。

⑤性能が向上した記載

- 再計算技術を用いることで、従来のハードウェアでは不可能だった長いシーケンス(16,384)の処理が可能になり、数百層のネットワークをトレーニングすることが可能となったとされている。具体的な数値は示されていないが、メモリ削減により訓練が可能になるケースがあることが述べられている。

⑧具体的な数値の記載

| 数値 | 説明 |

|---|---|

| 16,384 | トレーニングに使用されたシーケンス長。 |

| 数百 | ディープなアテンションネットワークの層数。 |

⑨具体的な変数名(数式用の記号)の記載

| 変数名 | 説明 |

|---|---|

| attention | アテンションブロック内の再計算対象の操作。 |

| dropout | ドロップアウト関数、残差加算後に適用。 |

▼質問(人間)

続けて下記の質問に追加で回答下さい:

⑩図/表があれば、各図/表は何を主張するためのものかを説明下さい。(掲載理由・注目ポイント等)

▼生成AIの回答(ChatGPT-4o)

⑩図/表があれば、各図/表は何を主張するためのものか

-

図4: 図4は、勾配チェックポイント技術を使用した場合のアテンションブロックとフィードフォワードブロックの再計算のフローを示している。図の掲載理由は、再計算プロセスの概要を視覚的に示すことであり、逆伝播時にどのタイミングで再計算が行われ、どの部分でメモリ使用量が削減されるのかを理解するためである。

- 注目ポイント: ドロップアウトがアテンションブロック内でなく、残差加算の後に適用されている点。

5.5. Efficient block-sparse attention kernels

▼質問(人間)

質問内容全体はここをクリック

(論文・記事の各章節を貼り付け) 5.5. Efficient block-sparse attention kernels The sparse attention masks in 3(b) and 3(c) can be efficiently computed by slicing out sub-blocks from the query, key, and value matrices and computing the product in blocks. Atten- tion over a local window can be computed as-is, whereas attention with a stride of k can be computed by transposing the matrix and computing a local window. Fixed attention positions can be aggregated and computed in blocks. In order to ease experimentation, we implemented a set of GPU kernels which efficiently perform these operations. The softmax operation is fused into a single kernel and also uses registers to eliminate loading the input data more than once, allowing it to run at the same speed as a simple nonlinearity. The upper triangle of the attention matrix is never computed, moreover, removing the need for the negative bias term of (Vaswani et al., 2017) and halving the number of operations to be performed.上記の内容に関して下記の質問に回答下さい: (である調で記載、質問に対して該当するものが無ければ無しと記載)

①何についての記載か? + 要旨は何? (要旨は箇条書きで記載、既存手法があれば引用元を記載)

②具体的な処理方法の記載があれば説明下さい。(簡略化せずに全て記載、既存手法があれば引用元を記載)

③改良点・工夫点・テクニック等の記載があれば説明下さい。

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

⑤性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば各文末に記載)

⑧具体的な数値の記載を全て列挙して、表にまとめて下さい。(必ず正しく数値を抜き取る事、|数値|説明|の表へ)

⑨具体的な変数名(数式用の記号)の記載を全て列挙して、表にまとめて下さい。(|変数名|説明|の表へ)

▼生成AIの回答(ChatGPT-4o)

①何についての記載か? + 要旨は何?

本節では、効率的なブロックスパースなアテンションカーネルについて記載している。要旨は以下の通りである。

- スパースアテンションマスク(図3(b)、3(c))の効率的な計算方法を説明している。

- クエリ、キー、バリューマトリックスをブロック単位に分割して、ブロックごとに積を計算する手法を提案している。

- ローカルウィンドウ内でのアテンションや、ストライド付きアテンションの計算方法を記載している。

- GPU上で効率的に動作するカーネルを実装し、ソフトマックスの最適化と不要な計算の省略により、計算効率を向上させている。

②具体的な処理方法の記載

- クエリ、キー、バリューマトリックスをサブブロックに分割し、ブロック単位で積を計算する。

- ローカルウィンドウ内でのアテンションはそのまま計算し、ストライドkのアテンションはマトリックスを転置してからローカルウィンドウで計算する。

- 固定アテンション位置はブロックにまとめて計算する。

- ソフトマックス演算を1つのカーネルに融合し、レジスタを使用して入力データを複数回読み込む必要がないようにしている。これにより、単純な非線形関数と同じ速度で実行できる。

- アテンションマトリックスの上三角部分は計算せず、(Vaswani et al., 2017)で使用された負のバイアス項を不要にすることで、演算量を半分に削減している。

③改良点・工夫点・テクニック等の記載

- クエリ、キー、バリューマトリックスをブロック単位に分割して計算することで、スパースアテンションの計算を効率化している。

- ストライド付きアテンションはマトリックスの転置を活用して計算効率を高めている。

- ソフトマックス演算を1つのカーネルに融合することで、入力データの読み込み回数を削減し、速度を向上させている。

- アテンションマトリックスの上三角部分を計算しないことで、無駄な計算を省き、演算量を半減している。

④メカニズムの解明・なぜそうなるのか

- クエリ、キー、バリューマトリックスをブロックごとに処理することで、データ量を大幅に削減し、必要な計算のみを行うことができる。

- ストライド付きアテンションの際にマトリックスを転置することで、ローカルウィンドウ内での計算が可能になり、メモリ使用量と計算コストが最適化される。

- ソフトマックス演算の融合は、レジスタを活用することでデータの読み込みを最小限に抑え、速度向上を実現している。

- アテンションマトリックスの上三角部分を計算しない設計により、計算コストが無駄に増えることを防いでいる。

⑤性能が向上した記載

- 提案されたカーネルにより、スパースアテンションの計算速度が向上し、演算量が半減している。具体的な速度向上や性能向上に関する数値は本文中には記載されていないが、ソフトマックスの最適化により単純な非線形関数と同等の速度で実行可能である点が強調されている(対応する図/表番号は無し)。

⑧具体的な数値の記載

| 数値 | 説明 |

|---|---|

| 16,384 | 計算対象のシーケンス長 |

| k | ストライドサイズ |

| 50% | アテンションマトリックスの演算量の削減(上三角部分の未計算による) |

⑨具体的な変数名(数式用の記号)の記載

| 変数名 | 説明 |

|---|---|

| $ k $ | ストライドサイズ |

| $ nemb $ | 埋め込みの次元数 |

| $ ddata $ | データの次元数 |

| $ dattn $ | ファクタライズされたアテンションの次元数 |

| $ Wj $ | 各次元に対応する重み行列 |

| $ \text{softmax} $ | ソフトマックス関数 |

⑩図/表があれば、各図/表は何を主張するためのものか

図3(b)と図3(c)は、スパースアテンションマスクの具体的な構造を示している。これらの図は、どのようにスパースなアテンションが適用されるか、特にブロック単位での計算や、ストライドによる計算方法の違いを視覚的に理解するために掲載されている。

5.6. Mixed-precision training

▼質問(人間)

質問内容全体はここをクリック

(論文・記事の各章節を貼り付け) 5.6. Mixed-precision training We store network weights in single-precision floating-point, but otherwise compute network activations and gradients in half-precision, as in (Micikevicius et al., 2017). This acceler- ates our training due to the usage of Tensor Core operations on the V100 GPU. During the gradient calculation, we use dynamic loss scaling to reduce numerical underflow, and we communicate half-precision gradients when averaging across multiple GPUs. When sampling, we cast the queries and keys to single-precision, as the query-key product can sometimes overflow the max value of half-precision.上記の内容に関して下記の質問に回答下さい: (である調で記載、質問に対して該当するものが無ければ無しと記載)

①何についての記載か? + 要旨は何? (要旨は箇条書きで記載、既存手法があれば引用元を記載)

②具体的な処理方法の記載があれば説明下さい。(簡略化せずに全て記載、既存手法があれば引用元を記載)

③改良点・工夫点・テクニック等の記載があれば説明下さい。

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

⑤性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば各文末に記載)

⑧具体的な数値の記載を全て列挙して、表にまとめて下さい。(必ず正しく数値を抜き取る事、|数値|説明|の表へ)

⑨具体的な変数名(数式用の記号)の記載を全て列挙して、表にまとめて下さい。(|変数名|説明|の表へ)

▼生成AIの回答(ChatGPT-4o)

①何についての記載か? + 要旨は何?

本節は、混合精度トレーニングについて記載している。要旨は以下の通りである。

- ネットワークの重みを単精度浮動小数点(single-precision)で保存し、活性化関数および勾配の計算は半精度(half-precision)で行う手法について述べている。

- V100 GPU上でのTensor Core操作を活用することでトレーニングを加速させている。

- 勾配計算中に動的な損失スケーリングを用いて数値アンダーフローを防ぎ、複数GPU間での勾配の平均化時に半精度で通信を行っている。

- クエリとキーの積が半精度の最大値を超える可能性があるため、サンプリング時にはクエリとキーを単精度にキャストしている。

②具体的な処理方法の記載

- ネットワークの重みは単精度浮動小数点で保存し、その他のネットワーク活性化と勾配の計算は半精度で行う。

- V100 GPU上のTensor Coreを使用して、半精度演算によってトレーニング速度を向上させている。

- 勾配計算中には動的な損失スケーリングを適用して、数値アンダーフローを防止する。

- 複数のGPUで勾配を平均化する際、半精度で勾配を通信している。

- サンプリング時、クエリとキーを単精度にキャストして、クエリとキーの積が半精度の最大値を超えないようにしている。

③改良点・工夫点・テクニック等の記載

- 重みを単精度で保存しながら、ネットワークの活性化と勾配を半精度で計算することにより、メモリ効率を改善している。

- 勾配の平均化時に半精度で通信を行うことで、通信コストを削減している。

- 動的な損失スケーリングを導入することで、半精度演算の際に発生しやすい数値アンダーフローを防いでいる。

- サンプリング時にクエリとキーを単精度にキャストすることで、オーバーフローを防止している。

④メカニズムの解明・なぜそうなるのか

- 単精度と半精度の混合使用により、計算精度を維持しつつ計算資源を節約できる。V100のTensor Coreは半精度演算を高速化するため、これを利用することでトレーニング速度が向上する。

- 半精度演算は計算リソースを節約する一方で、アンダーフローのリスクがあるが、動的損失スケーリングによってこのリスクを軽減できる。

- クエリとキーの積が半精度の最大値を超える場合があるため、単精度にキャストすることで計算の安定性が保たれる。

⑤性能が向上した記載

- Tensor Coreを活用した半精度トレーニングにより、ネットワークのトレーニングが高速化されている。具体的な数値や性能向上に関する記載はないが、メモリ使用量の削減とトレーニング速度の向上が主な利点として述べられている(対応する図/表番号は無し)。

⑧具体的な数値の記載

| 数値 | 説明 |

|---|---|

| V100 | 使用したGPUのモデル |

| 16-bit | 半精度浮動小数点のビット数 |

⑨具体的な変数名(数式用の記号)の記載

| 変数名 | 説明 |

|---|---|

| Single-precision | 単精度浮動小数点形式(32-bit) |

| Half-precision | 半精度浮動小数点形式(16-bit) |

6. Training

▼質問(人間)

質問内容全体はここをクリック

(論文・記事の各章節を貼り付け) 6. Training We use the Adam optimizer with a linear warmup of 5000 iterations and a gradient clipping of 1.0, both of which we found important for model stability. We use a weight decay penalty of 0.01. We annealed the learning rate according to a cosine decay as in (Radford et al., 2018). We train on 8 V100 GPUs unless otherwise noted. All embeddings are of a constant dimension d, usually one of {256, 512, 1024}. By default, all linear transforms are to the same dimension, with the exception of the feed-forward network, which projects the input to 4d, unless we use “half-size” transformations, where it is 2d. Additionally, sometimes we halve the size of the query and key transfor- mations. We initialize the token embedding We from N (0, 0.125√d ) and the position embeddings from N (0, 0.125√dnemb ). Within the attention and feedforward components, all biases are initial- ized to 0 and all weights are initialized from N (0, 0.125√din ) where din is the fan-in dimension. The weight matrix for the output logits was initialized to 0.上記の内容に関して下記の質問に回答下さい: (である調で記載、質問に対して該当するものが無ければ無しと記載)

①何についての記載か? + 要旨は何? (要旨は箇条書きで記載、既存手法があれば引用元を記載)

②具体的な処理方法の記載があれば説明下さい。(簡略化せずに全て記載、既存手法があれば引用元を記載)

③改良点・工夫点・テクニック等の記載があれば説明下さい。

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

⑤性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば各文末に記載)

⑧具体的な数値の記載を全て列挙して、表にまとめて下さい。(必ず正しく数値を抜き取る事、|数値|説明|の表へ)

⑨具体的な変数名(数式用の記号)の記載を全て列挙して、表にまとめて下さい。(|変数名|説明|の表へ)

▼生成AIの回答(ChatGPT-4o)

①何についての記載か? + 要旨は何?

本節では、モデルのトレーニングに関する詳細が記載されている。要旨は以下の通りである。

- モデル安定性を向上させるために使用したAdamオプティマイザや学習率のスケジューリング方法が述べられている。

- 埋め込みベクトルや線形変換の次元に関する設定、および重みやバイアスの初期化方法が詳述されている。

- トレーニングはV100 GPUを用いて行われ、初期化や次元の設定に関して標準的な手法が適用されている。

②具体的な処理方法の記載

- オプティマイザとしてAdamを使用し、最初の5000イテレーションにわたって線形ウォームアップを行う。

- 勾配のクリッピングを1.0に設定し、モデルの安定性を向上させている。

- ウェイトデイケイ(重み減衰)ペナルティとして0.01を使用。

- 学習率はコサインデケイに従って減衰させる(Radford et al., 2018を参照)。

- トレーニングには通常8つのV100 GPUを使用。

- 埋め込みベクトルの次元は固定であり、{256, 512, 1024}のいずれかを使用。線形変換は基本的にすべて同じ次元で行われるが、フィードフォワードネットワークは4dにプロジェクトし、「半サイズ」の場合は2dに縮小する。クエリとキーの変換サイズを半分にする場合もある。

- トークン埋め込み We を N(0, 0.125√d) から初期化し、位置埋め込みは N(0, 0.125√dnemb) から初期化する。

- 注意機構およびフィードフォワードコンポーネント内では、全てのバイアスを0で初期化し、重みを N(0, 0.125√din) から初期化する。ここで din はファンイン次元である。出力ロジットの重み行列は0に初期化される。

③改良点・工夫点・テクニック等の記載

- Adamオプティマイザの初期段階で5000イテレーションにわたる線形ウォームアップを採用し、モデルのトレーニング初期段階の安定性を確保している。

- 勾配クリッピングを1.0に設定することで、勾配爆発を防いでいる。

- コサインデケイを用いることで、学習率を滑らかに減衰させ、トレーニングの効率を向上させている。

- フィードフォワードネットワークのプロジェクションサイズを調整することで、ネットワークの容量と計算コストのバランスを最適化している。

- 重みやバイアスの初期化において適切な標準偏差を設定し、重みの初期状態を安定させている。

④メカニズムの解明・なぜそうなるのか

- 線形ウォームアップと勾配クリッピングは、トレーニング初期段階での不安定性を防ぎ、モデルが最適化プロセスに適応するのを助けるためである。

- コサインデケイは、学習率が急激に減少するのではなく、ゆるやかに減少することにより、モデルが過学習せず、より安定した最適化を行えるようにする。

- 初期化における標準偏差の選択は、勾配消失や勾配爆発のリスクを低減し、トレーニングの安定性を確保するためである。

⑤性能が向上した記載

- Adamオプティマイザに線形ウォームアップを追加し、モデルのトレーニングの安定性を向上させている。

- 勾配クリッピングにより、勾配爆発を防ぎ、安定したトレーニングを実現している。

- コサインデケイにより、学習率の減少をスムーズに行い、トレーニングの収束性が向上している。

(具体的な性能向上に関する数値や図表の言及は無し)

⑧具体的な数値の記載

| 数値 | 説明 |

|---|---|

| 5000 | Adamオプティマイザのウォームアップのイテレーション数 |

| 1.0 | 勾配クリッピングの値 |

| 0.01 | ウェイトデイケイペナルティの値 |

| {256, 512, 1024} | 埋め込みベクトルの次元 |

| 4d | フィードフォワードネットワークのプロジェクションサイズ |

| 2d | 「半サイズ」の変換時のプロジェクションサイズ |

| 8 | 使用するV100 GPUの数 |

| 0.125 | 重みやバイアスの初期化時の係数 |

⑨具体的な変数名(数式用の記号)

| 変数名 | 説明 |

|---|---|

| $d$ | 埋め込みベクトルの次元 |

| $We$ | トークン埋め込み |

| $N(0, 0.125√d)$ | トークン埋め込み We の初期化分布 |

| $N(0, 0.125√dnemb)$ | 位置埋め込みの初期化分布 |

| $din$ | ファンイン次元 |

| $N(0, 0.125√din)$ | 重みの初期化分布 |

7. Experiments

7.1. CIFAR-10

7.2. Text

▼質問(人間)

質問内容全体はここをクリック

(論文・記事の各章節を貼り付け) 7. Experiments We empirically test our architecture on density modeling tasks including natural images, text, and raw audio. A summary of the results is available in Table 1. We found that, in addition to running significantly faster than full attention, sparse patterns also converged to lower error, as shown in Table 2. This may point to a useful inductive bias from the sparsity patterns we introduced, or an underlying optimization issue with full attention. 7.1. CIFAR-10 We train strided Sparse Transformers on CIFAR-10 images represented as sequences of 3072 bytes. Models have 2 heads, 128 layers, d = 256, half-size feedforward network and query-key projections, and are trained for 120 epochs with a learning rate of 0.00035 and a dropout rate of 0.25 until validation error stops decreasing. We use 48000 examples for training and 2000 examples for validation, evaluating the performance of our best models on the test set. The model achieves 2.80 bits per dim (2.798 ± 0.004 over seeds 1, 2, 3) versus the previous 2.85 state of the art (Chen et al., 2017). We also compare performance of different attention patterns in Table 2. The strided attention reaches the lowest error in the shortest amount of time, surpassing the error of dense attention at 2.82 bits per dim. 7.2. Text In order to assess Sparse Transformers on datasets without a strong two-dimensional structure, we trained models on the EnWik8 dataset, which represents the first 108 bytes of Wikipedia and contains a great degree of variability in periodic structure. We trained with a context length of 12,288, which is longer than previous approaches. We trained on the first 90 million tokens and reserved the last 10 million for validation and test. We used 30-layer fixed Sparse Transformers with 8 heads, d = 512, and a dropout rate of 0.40. We trained for 80 epochs until validation loss stopped decreasing. We used a stride of 128, c = 32, and merged the factorized attention heads. Our best model reached 0.99 bits per dim (0.992 ± 0.001 over seeds 1, 2, 3), surpassing the 1.03 state-of-the-art for a similarly-sized Transformer-XL (Dai et al., 2018) and matching the 0.99 of a model trained with more than double the number of parameters. Strided attention failed to do well on this dataset, whereas fixed patterns were able to recover and surpass the performance of dense attention, as listed in Table 2. Additionally, during evaluation of the test set, we modified the minimum context length the network could use by evalu- ating fewer tokens in parallel. We saw monotonic increases in performance with more tokens used, up to 12,160 out of the 12,288 tokens used for training (see Table 3), which suggests the network is effectively incorporating long-term dependencies.上記の内容に関して下記の質問に回答下さい: (である調で記載、質問に対して該当するものが無ければ無しと記載)

①何についての記載か? + 要旨は何? (要旨は箇条書きで記載、既存手法があれば引用元を記載)

②具体的な処理方法の記載があれば説明下さい。(簡略化せずに全て記載、既存手法があれば引用元を記載)

③改良点・工夫点・テクニック等の記載があれば説明下さい。

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

⑤性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば各文末に記載)

⑥比較の記載があれば違いを表でまとめて下さい。(下に解説を記載、対応する図/表番号があれば明記)

⑦上記⑥以外で表に出来そうな部分があれば表でまとめて下さい。(下に解説を記載、対応する図/表番号があれば記載)

⑧具体的な数値の記載を全て列挙して、表にまとめて下さい。(必ず正しく数値を抜き取る事、|数値|説明|の表へ)

⑨具体的な変数名(数式用の記号)の記載を全て列挙して、表にまとめて下さい。(|変数名|説明|の表へ)

⑩図/表があれば、各図/表は何を主張するためのものかを説明下さい。(掲載理由・注目ポイント等)

▼生成AIの回答(ChatGPT-4o)

①何についての記載か? + 要旨は何?

本節では、Sparse Transformersアーキテクチャを使用した密度モデリングタスクの実験結果が記載されている。対象となるデータは自然画像、テキスト、及び生のオーディオである。要旨は以下の通りである。

- Sparse Transformersは、従来のFull Attentionよりも高速に動作し、エラーも低く収束する。

- CIFAR-10の画像データ、EnWik8テキストデータセットにおいて、Sparse Transformersがそれぞれのタスクで優れた性能を示した。

- 特に、エラーが最も低く、計算時間が短いSparse Attentionパターンの有効性が強調されている。

②具体的な処理方法の記載

-

CIFAR-10:

- ストライド型Sparse TransformersをCIFAR-10画像データセットでトレーニング。

- CIFAR-10の画像は3072バイトのシーケンスとして表現。

- モデルは2ヘッド、128レイヤー、次元$d = 256$、半サイズのフィードフォワードネットワークとクエリ・キーのプロジェクション。

- 120エポックまでトレーニングを行い、学習率は0.00035、ドロップアウト率は0.25で設定。

- トレーニングデータとして48,000サンプル、検証データとして2,000サンプルを使用し、テストセットで最良のモデルを評価。

-

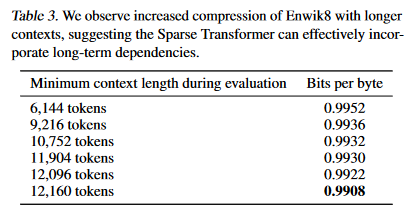

EnWik8:

- 1億800バイトのWikipediaデータセットでモデルをトレーニングし、最初の9000万トークンをトレーニング用、最後の1000万トークンを検証およびテスト用に使用。

- 文脈長を12,288に設定し、Sparse Transformersを30層、8ヘッド、次元$d = 512$、ドロップアウト率0.40でトレーニング。

- トレーニングは80エポック行い、文脈長を128のストライドで使用。

- 最高のモデルは0.99 bits/dimを達成。

- テストセットの評価時に、ネットワークが使用できる最小文脈長を変更し、使用トークン数が増加するにつれて性能が向上することを確認。

③改良点・工夫点・テクニック等の記載

- ストライド型Sparse Transformersが、CIFAR-10で最も低いエラーを最短時間で達成。

- テキストデータにおいて、Sparse Attentionの特定のパターンが密Attentionを上回る性能を示すことが確認され、これがSparse Transformersの改良点の一つである。

- 文脈長を12,288に延ばすことで、テキストデータの長期依存関係を効果的に捉える能力が向上。

④メカニズムの解明・なぜそうなるのか

- Sparse Attentionパターンは、計算効率が高く、また適切なスパース性が問題の構造に対する有益な帰納的バイアスを提供する可能性がある。

- 文脈長を増加させることで、ネットワークがより長い依存関係を捉えることができ、性能が向上したと考えられる。

⑤性能が向上した記載

- CIFAR-10では、Sparse Transformersが2.80 bits/dimを達成し、これまでの最高性能(2.85 bits/dim、Chen et al., 2017)を上回った。

- EnWik8データセットでは、0.99 bits/dimの性能を達成し、Transformer-XLの1.03 bits/dimを超えた。

⑥比較の記載

| モデル | データセット | エラー (bits/dim) | 特徴 | 図/表番号 |

|---|---|---|---|---|

| Sparse Transformers (ストライド型) | CIFAR-10 | 2.80 | 最短時間で最低エラー達成 | 表2 |

| Dense Attention | CIFAR-10 | 2.82 | 計算時間長い | 表2 |

| Sparse Transformers (固定型) | EnWik8 | 0.99 | Transformer-XLを上回る性能 | 表2 |

| Transformer-XL | EnWik8 | 1.03 | - |

⑦上記⑥以外で表に出来そうな部分

- テキストデータにおける文脈長と性能の関係を表にまとめることができる。

| 文脈長 (トークン数) | エラー (bits/dim) | 説明 |

|---|---|---|

| 12,160 | 0.99 | 最も長い文脈長での性能向上 |