はじめに

生成AIを用いて2019年ImageNetでSoTAの論文「Self-training with Noisy Student improves ImageNet classification」の内容を(なるべく)把握してみました。(生成AIが)論文の記載内容を始めから最後まで読んで、実際にどのような記載があるのかを把握します。

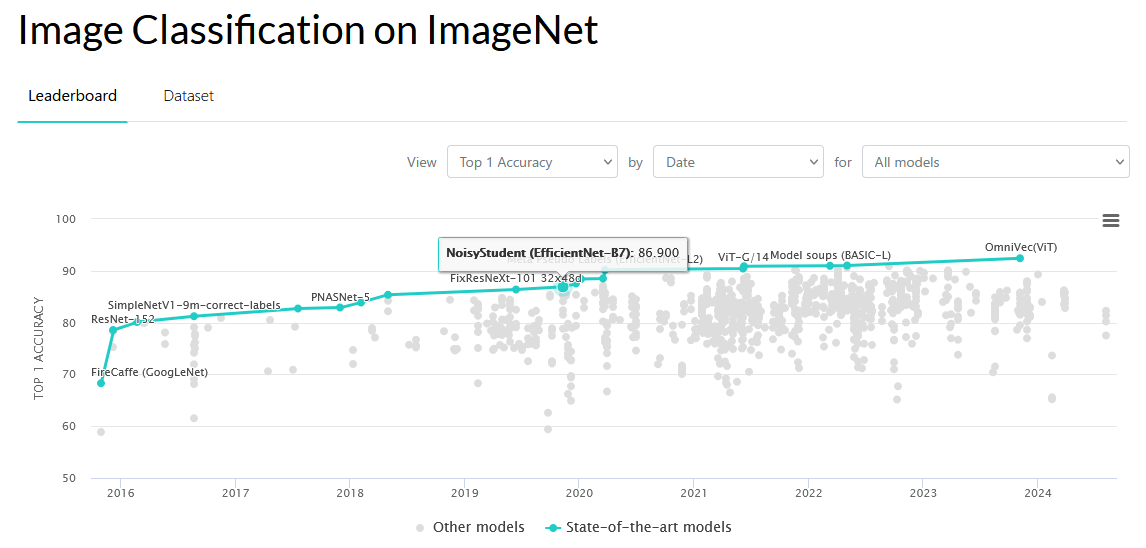

ImageNetの分類タスクで、2019年SoTAの論文:

入力ノイズ:RandAugmentのデータ拡張、モデルノイズ:ドロップアウト+確率的に層を削除するノイズを加えて、教師モデルの予測ラベルを学生モデルが学習する(のみ)であることが分かりました。また、ソフト疑似ラベルの方法は、不適切ラベルが多く存在するデータセットの場合に効果的であることが分かりました。(末尾の「分かったこと」章を参照)

以降で、ChatGPTに聞いてみた例を記載します。

他例: 同類の方法を使って読んでみた結果

対象の論文

論文: (Noisy Studentに関する論文)

[1911.04252v4] Self-training with Noisy Student improves ImageNet classification

https://arxiv.org/abs/1911.04252v4

(PDF: https://arxiv.org/pdf/1911.04252v4)

質問時の各章節の区切り部分

論文の中にある各章節を、下記のように区切って、部分毎に生成AIに内容を質問していきます。

- Abstract

- --

- 1.-Introduction

- --

- 2.-Noisy Student Training

- --

- 3.-Experiments

- 3.1. Experiment Details

- --

- 3.2. ImageNet Results

- --

- 3.3. Robustness Results on ImageNet-A, ImageNet-C and ImageNet-P

- --

- 3.4. Adversarial Robustness Results

- --

- 4.-Ablation Study

- 4.1. The Importance of Noise in Self-training

- --

- 4.2. A Study of Iterative Training

- --

- 4.3. Additional Ablation Study Summarization

- --

- 5.-Related works

- --

- 6.-Conclusion

- --

- A. Experiments

- A.1. Architecture Details

- --

- A.2. Ablation Studies Study #1-2

- --

- A.2. Ablation Studies Study #3-5

- --

- A.2. Ablation Studies Study #6-8

- --

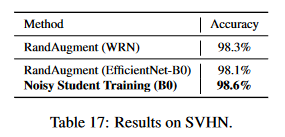

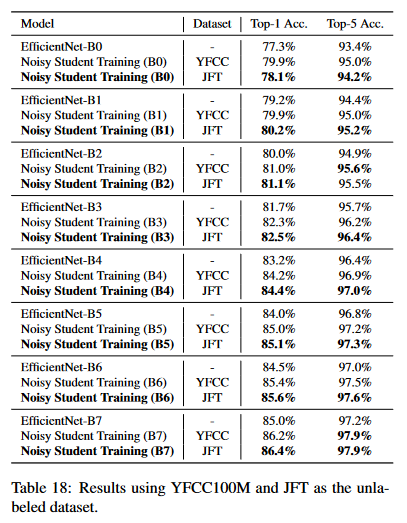

- A.3. Results with a Different Architecture and Dataset

- A.4. Results on YFCC100M

- --

- A.5. Details of Robustness Benchmarks

生成AIへの質問方法

生成AIを活用して、知りたい記事・論文の1節分(適度な長さ)のテキストをコピー&ペーストして、その下に質問内容を「①~ ②~ …」と番号付きで書いて、生成AIに渡せば、全質問に一発で的確に回答してくれるので、非常に良好でした。記事全体を読む必要なく、知りたい点の情報だけを収集できます。

生成AIへの質問例:

(論文・記事の各章節を貼り付け)

上記の内容に関して下記の質問に回答下さい: (である調で記載、質問に対して該当するものが無ければ無しと記載、対応する図/表番号があれば記載)

①何についての記載か? + 要旨は何? (要旨は箇条書きで記載)

②改良点・工夫点・テクニック等の記載があれば説明下さい。

③性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば各文末に記載)

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

⑤具体的な処理方法の記載があれば説明下さい。(簡略化せずに全て記載、既存手法の適用であれば引用元を記載)

続けて下記の質問に追加で回答下さい:

⑥比較の記載があれば違いを表でまとめて下さい。(対応する図/表番号があれば明記)

⑦上記⑥以外で表に出来そうな部分があれば表でまとめて下さい。(対応する図/表番号があれば記載)

⑧具体的な数値の記載を全て列挙して、表にまとめて下さい。(|数値|説明|の表へ)

⑨具体的な変数名(数式用の記号)の記載を全て列挙して、表にまとめて下さい。(|変数名|説明|の表へ)

⑩図/表があれば、各図/表は何を主張するためのものか(掲載理由・注目ポイント等)を説明下さい。

※回答が長くなりそうな場合は、適宜、分けて質問: ①②③④⑤、⑥⑦⑧⑨⑩

※その他、不明点があれば、適宜、追加で質問。

質問内容は、記事・論文を読んでいていつも知りたいと思う点(改良点・工夫点・テクニック・メカニズムの解明)にしています。また、表で比較した方が素早く把握できるので、可能であれば記事を表に変換するようにしています。

論文・記事を貼り付けるテキストの長さは、1節分程度の量にとどめた方が、良い回答が得られました。生成AIの回答の文量が多くなってくると、回答が長くなり過ぎないように、生成AIが勝手に(適度に)端折り始めてしまい、重要な点が回答から抜けてしまう可能性が高くなります。

事前知識

機械学習についてある程度知っていないと、生成AIに質問しても、その回答内容だけでは理解できないと思います。生成AIの回答は、論文の内容をあまり変えずに、要点をそのまま掻い摘んで回答するような形になっています。

Noisy Studentについての分かりやすい解説記事(下記)等を事前にチェックして、中核部分の内容をあらかじめ分かっていると、理解しやすいと思います。生成AIは実際の細かい処理方法自体を分かりやすく説明してはくれない傾向があります。

注意点

論文のテキスト内容だけを貼り付けて、生成AIに質問しています。論文の中の図・表の部分は貼り付けていません。図・表の内容は生成AIの回答には含まれず、別途論文を見る必要があります。

以降で、生成AIの回答内容が読みにくい・分かりづらい場合は、論文の本文でも同じように書かれてあり、論文の本文を読んでも同じように分かりづらいことが多くあります。論文では、既存研究等があるため、多くの説明を省略・一言だけサラッと書かれてある等、同種の研究に取り組む人でなければ、なかなか全容の理解に辿りつくのは難しい側面があります。この点は、生成AIの回答性能が悪いのではなく、論文という性質上、生じるものと考えています。

生成AIに質問

以降で、ChatGPTに実際に聞いてみた例を記載します。

生成AIへの質問&回答の全容

生成AIへの質問&回答の全容・詳細:

Abstract

▼質問(人間)

質問内容全体はここをクリック

(論文・記事の各章節を貼り付け) Abstract We present Noisy Student Training, a semi-supervised learning approach that works well even when labeled data is abundant. Noisy Student Training achieves 88.4% top- 1 accuracy on ImageNet, which is 2.0% better than the state-of-the-art model that requires 3.5B weakly labeled Instagram images. On robustness test sets, it improves ImageNet-A top-1 accuracy from 61.0% to 83.7%, reduces ImageNet-C mean corruption error from 45.7 to 28.3, and reduces ImageNet-P mean flip rate from 27.8 to 12.2. Noisy Student Training extends the idea of self-training and distillation with the use of equal-or-larger student mod- els and noise added to the student during learning. On Im- ageNet, we first train an EfficientNet model on labeled im- ages and use it as a teacher to generate pseudo labels for 300M unlabeled images. We then train a larger Efficient- Net as a student model on the combination of labeled and pseudo labeled images. We iterate this process by putting back the student as the teacher. During the learning of the student, we inject noise such as dropout, stochastic depth, and data augmentation via RandAugment to the student so that the student generalizes better than the teacher.1上記の内容に関して下記の質問に回答下さい: (である調で記載、質問に対して該当するものが無ければ無しと記載、対応する図/表番号があれば記載)

①何についての記載か? + 要旨は何? (要旨は箇条書きで記載)

②改良点・工夫点・テクニック等の記載があれば説明下さい。

③性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば各文末に記載)

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

⑤具体的な処理方法の記載があれば説明下さい。(簡略化せずに全て記載、既存手法の適用であれば引用元を記載)

⑥比較の記載があれば違いを表でまとめて下さい。(対応する図/表番号があれば明記)

▼生成AIの回答(ChatGPT-4o)

①何についての記載か? + 要旨は何?

Noisy Student Trainingという半教師あり学習手法についての記載である。この手法は、ラベル付きデータが豊富にある場合でも効果的に機能し、ImageNetデータセットでの精度向上を達成している。

要旨

- Noisy Student Trainingは、半教師あり学習手法で、ラベル付きデータが豊富な場合でも高い性能を発揮する。

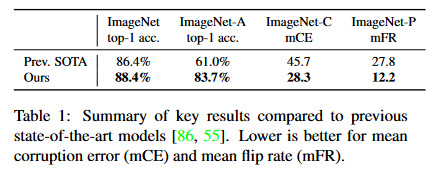

- ImageNetデータセットにおいて、トップ1精度88.4%を達成し、3.5Bの弱ラベル付きInstagram画像を用いた従来のモデルを2.0%上回った。

- Noisy Student Trainingは、ImageNet-Aの精度を61.0%から83.7%に、ImageNet-Cの誤差を45.7から28.3に、ImageNet-Pのフリップレートを27.8から12.2に改善した。

- この手法は、自己学習と蒸留の概念を拡張し、同じかそれ以上の大きさの学生モデルとノイズの注入を活用する。

- EfficientNetを教師として用い、300Mのラベルなし画像に対して擬似ラベルを生成し、これを使ってより大きな学生モデルを訓練する。

②改良点・工夫点・テクニック等の記載

- 学生モデルにおいてノイズを注入する工夫を行った。具体的には、ドロップアウト、確率的深さ(stochastic depth)、およびRandAugmentによるデータ拡張が使用され、学生モデルが教師モデルよりも良い汎化性能を持つようにした。

- 学習の過程で、学生モデルが教師モデルに置き換わり、再度学生モデルとして訓練が行われる反復プロセスが採用されている。

③性能が向上した記載

- ImageNetデータセットにおいて、Noisy Student Trainingを適用することでトップ1精度が88.4%に達し、従来の最先端モデルよりも2.0%向上している。

- ImageNet-Aに対しては、トップ1精度が61.0%から83.7%に向上している。

- ImageNet-Cでは、平均汚染誤差が45.7から28.3に低下している。

- ImageNet-Pにおけるフリップレートは、27.8から12.2に減少している。

④メカニズムの解明・なぜそうなるのか等の記載

- ノイズを学生モデルに加えることで、モデルがより汎化され、訓練データに対して過剰適合することを防いでいる。この結果、ノイズのない教師モデルよりも学生モデルの性能が向上することが示唆されている。

- 学生モデルを教師モデルに置き換える反復プロセスが、モデルの性能向上を促している。この反復によって、より多くのデータとノイズを使用するたびに、モデルが改善される。

⑤具体的な処理方法の記載

- まず、ラベル付きImageNetデータセットでEfficientNetモデルを訓練し、教師モデルとして使用する。

- この教師モデルを用いて、300Mのラベルなし画像に対して擬似ラベルを生成する。

- ラベル付きデータと擬似ラベル付きデータの組み合わせを使用して、より大きなEfficientNet学生モデルを訓練する。

- 学生モデルを再び教師モデルとして使用し、プロセスを繰り返す。

- 学習中の学生モデルには、ドロップアウト、確率的深さ、RandAugmentによるデータ拡張などのノイズを注入し、汎化性能を向上させる。

⑥比較の記載

| モデル/手法 | ImageNetトップ1精度 | ImageNet-A精度 | ImageNet-C誤差 | ImageNet-Pフリップレート | データ量 |

|---|---|---|---|---|---|

| 従来の最先端モデル | 86.4% | 61.0% | 45.7 | 27.8 | 3.5Bの弱ラベル付き画像 |

| Noisy Student Training | 88.4% | 83.7% | 28.3 | 12.2 | 300Mのラベルなし画像 |

1. Introduction

▼質問(人間)

質問内容全体はここをクリック

(論文・記事の各章節を貼り付け) 1. Introduction Deep learning has shown remarkable successes in image recognition in recent years [45, 80, 75, 30, 83]. However state-of-the-art (SOTA) vision models are still trained with supervised learning which requires a large corpus of labeled images to work well. By showing the models only labeled images, we limit ourselves from making use of unlabeled images available in much larger quantities to improve accu- racy and robustness of SOTA models. Here, we use unlabeled images to improve the SOTA Im- ageNet accuracy and show that the accuracy gain has an out- sized impact on robustness (out-of-distribution generaliza- tion). For this purpose, we use a much larger corpus of un- labeled images, where a large fraction of images do not be- long to ImageNet training set distribution (i.e., they do not belong to any category in ImageNet). We train our model with Noisy Student Training, a semi-supervised learning approach, which has three main steps: (1) train a teacher model on labeled images, (2) use the teacher to generate pseudo labels on unlabeled images, and (3) train a student model on the combination of labeled images and pseudo la- beled images. We iterate this algorithm a few times by treat- ing the student as a teacher to relabel the unlabeled data and training a new student. Noisy Student Training improves self-training and distil- lation in two ways. First, it makes the student larger than, or at least equal to, the teacher so the student can better learn from a larger dataset. Second, it adds noise to the student so the noised student is forced to learn harder from the pseudo labels. To noise the student, we use input noise such as Ran- dAugment data augmentation [18] and model noise such as dropout [76] and stochastic depth [37] during training. Using Noisy Student Training, together with 300M un- labeled images, we improve EfficientNet’s [83] ImageNet top-1 accuracy to 88.4%. This accuracy is 2.0% better than the previous SOTA results which requires 3.5B weakly la- beled Instagram images. Not only our method improves standard ImageNet accuracy, it also improves classifica- tion robustness on much harder test sets by large margins: ImageNet-A [32] top-1 accuracy from 61.0% to 83.7%, ImageNet-C [31] mean corruption error (mCE) from 45.7 to 28.3 and ImageNet-P [31] mean flip rate (mFR) from 27.8 to 12.2. Our main results are shown in Table 1.上記の内容に関して下記の質問に回答下さい: (である調で記載、質問に対して該当するものが無ければ無しと記載、対応する図/表番号があれば記載)

①何についての記載か? + 要旨は何? (要旨は箇条書きで記載)

②改良点・工夫点・テクニック等の記載があれば説明下さい。

③性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば各文末に記載)

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

⑤具体的な処理方法の記載があれば説明下さい。(簡略化せずに全て記載、既存手法の適用であれば引用元を記載)

⑥比較の記載があれば違いを表でまとめて下さい。(対応する図/表番号があれば明記)

⑦上記⑥以外で表に出来そうな部分があれば表でまとめて下さい。(対応する図/表番号があれば記載)

⑧具体的な数値の記載を全て列挙して、表にまとめて下さい。(|数値|説明|の表へ)

⑨具体的な変数名(symbol)の記載を全て列挙して、表にまとめて下さい。(|変数名|説明|の表へ)

⑩図/表があれば、各図/表は何を主張するためのものか(掲載理由・注目ポイント等)を説明下さい。

▼生成AIの回答(ChatGPT-4o)

①何についての記載か? + 要旨は何?

Noisy Student Trainingを使用した半教師あり学習によるImageNetの精度向上と、同手法を用いたモデルのロバスト性の改善についての記載である。

要旨

- 深層学習モデルは依然として教師あり学習を利用しており、ラベル付きデータに依存している。

- ラベルなし画像を活用することで、SOTA(最先端)モデルの精度とロバスト性を向上できる。

- Noisy Student Trainingは、自己学習と蒸留を改良した手法で、ラベル付きデータとラベルなしデータを組み合わせて訓練する。

- 学習の反復プロセスを通じて、学生モデルを教師モデルに置き換えて訓練する。

- EfficientNetと300Mのラベルなし画像を用いて、ImageNetのトップ1精度を88.4%に向上させ、従来のSOTAモデルを2.0%上回った。

- Noisy Student Trainingは、ImageNet-A、ImageNet-C、ImageNet-Pといった厳しいテストセットでのロバスト性も大幅に改善した (Table 1)。

②改良点・工夫点・テクニック等の記載

- 学生モデルを教師モデルより大きくすることで、より多くのデータから効率的に学習できるようにした。

- RandAugmentによるデータ拡張、ドロップアウト、確率的深さなどのノイズを学生モデルに加えることで、擬似ラベルからの学習を強化した。

- 学生モデルを教師モデルに置き換え、ラベルなしデータに再度擬似ラベルを生成する反復的な学習プロセスを採用した。

③性能が向上した記載

- ImageNetのトップ1精度が88.4%に向上し、従来の最先端モデルよりも2.0%上回った。

- ImageNet-Aの精度が61.0%から83.7%に向上した。

- ImageNet-Cの平均汚染誤差 (mCE) が45.7から28.3に改善された。

- ImageNet-Pの平均フリップレート (mFR) が27.8から12.2に低下した (Table 1)。

④メカニズムの解明・なぜそうなるのか等の記載

- 学生モデルにノイズを加えることで、モデルが擬似ラベルからの学習を強化し、より汎化されたモデルを生成することが可能となる。

- 学生モデルを教師モデルより大きくすることで、より豊富なデータから学習できる能力が向上し、結果として性能が向上する。

- 反復的な学習プロセスにより、教師モデルと学生モデルの性能が段階的に向上する。

⑤具体的な処理方法の記載

- まず、教師モデルとしてEfficientNetをImageNetデータセットのラベル付きデータで訓練する。

- 教師モデルを使用して、300Mのラベルなし画像に擬似ラベルを生成する。

- ラベル付きデータと擬似ラベル付きデータを組み合わせて、より大きな学生モデルを訓練する。

- 学生モデルを再度教師モデルとして使用し、再び擬似ラベルを生成する。

- 学生モデルにはRandAugmentによるデータ拡張、ドロップアウト、確率的深さなどのノイズを注入し、汎化性能を向上させる。

⑥比較の記載

| モデル/手法 | ImageNetトップ1精度 | ImageNet-A精度 | ImageNet-C誤差 (mCE) | ImageNet-Pフリップレート (mFR) | 使用データ量 |

|---|---|---|---|---|---|

| 従来の最先端モデル | 86.4% | 61.0% | 45.7 | 27.8 | 3.5Bの弱ラベル付き画像 |

| Noisy Student Training | 88.4% | 83.7% | 28.3 | 12.2 | 300Mのラベルなし画像 |

⑦上記⑥以外で表に出来そうな部分

| Noisy Student Trainingの手法 | 説明 |

|---|---|

| 教師モデルの使用 | EfficientNetを教師としてラベル付きデータで訓練 |

| 擬似ラベルの生成 | 教師モデルで300Mのラベルなし画像に擬似ラベルを生成 |

| 学生モデルの訓練 | ラベル付き画像と擬似ラベルを組み合わせて学生モデルを訓練 |

| ノイズの注入 | ドロップアウト、確率的深さ、RandAugmentによるデータ拡張を使用 |

| 反復的な学習プロセス | 学生モデルを教師として繰り返し使用し、精度を向上 |

⑧具体的な数値の記載

| 数値 | 説明 |

|---|---|

| 88.4% | ImageNetのトップ1精度 |

| 83.7% | ImageNet-Aのトップ1精度 |

| 28.3 | ImageNet-Cの平均汚染誤差 (mCE) |

| 12.2 | ImageNet-Pの平均フリップレート (mFR) |

| 61.0% | ImageNet-Aの従来モデルのトップ1精度 |

| 45.7 | ImageNet-Cの従来モデルの平均汚染誤差 (mCE) |

| 27.8 | ImageNet-Pの従来モデルの平均フリップレート (mFR) |

⑨具体的な変数名の記載

| 変数名 | 説明 |

|---|---|

| mCE | Mean Corruption Errorの略称 |

| mFR | Mean Flip Rateの略称 |

⑩図/表があれば、各図/表は何を主張するためのものか

- Table 1: Noisy Student Trainingの適用による各種評価データセットにおける性能向上の結果を示している。ImageNet、ImageNet-A、ImageNet-C、ImageNet-Pにおける精度や誤差の変化が具体的に示されており、Noisy Student Trainingが大幅な性能改善を達成したことが強調されている。

▼質問(人間)

続けて下記の質問に追加で回答下さい:

⑪関連研究の参照番号を全て列挙して、表にまとめて下さい。(元文にある内容のみ記載・類推して付け足しは不要、|参照番号|概要説明|の表へ)

▼生成AIの回答(ChatGPT-4o)

⑪関連研究の参照番号

| 参照番号 | 概要説明 |

|---|---|

| [45] | 深層学習の成功事例に関する研究 |

| [80] | 画像認識における深層学習の進展に関する研究 |

| [75] | 画像認識タスクにおける教師あり学習モデルの性能向上に関する研究 |

| [30] | 深層学習モデルの構築における教師あり学習の利点に関する研究 |

| [83] | EfficientNetに関する研究(Noisy Student Trainingで用いられたモデル) |

| [32] | ImageNet-Aに関する研究 |

| [31] | ImageNet-CおよびImageNet-Pに関する研究 |

| [18] | RandAugmentによるデータ拡張手法に関する研究 |

| [76] | ドロップアウト技術に関する研究 |

| [37] | 確率的深さ (stochastic depth) によるモデルの強化に関する研究 |

これらは元文中で参照されている関連研究を表にまとめたものであり、各参照番号が指す研究内容の概要を簡潔に記載している。

2. Noisy Student Training

▼質問(人間)

質問内容全体はここをクリック

(論文・記事の各章節を貼り付け) 2. Noisy Student Training Algorithm 1 gives an overview of Noisy Student Train- ing. The inputs to the algorithm are both labeled and unla- beled images. We use the labeled images to train a teacher model using the standard cross entropy loss. We then use the teacher model to generate pseudo labels on unlabeled images. The pseudo labels can be soft (a continuous dis- tribution) or hard (a one-hot distribution). We then train a student model which minimizes the combined cross en- tropy loss on both labeled images and unlabeled images. Finally, we iterate the process by putting back the student as a teacher to generate new pseudo labels and train a new student. The algorithm is also illustrated in Figure 1. Require: Labeled images {(x1, y1), (x2, y2), ..., (xn, yn)} and unlabeled images {˜x1, ˜x2, ..., ˜xm}. 1: Learn teacher model θt ∗ which minimizes the cross entropy loss on labeled images 1 n n∑ i=1 `(yi, f noised(xi, θt)) 2: Use a normal (i.e., not noised) teacher model to generate soft or hard pseudo labels for clean (i.e., not distorted) unlabeled images ˜yi = f (˜xi, θt ∗), ∀i = 1, · · · , m 3: Learn an equal-or-larger student model θs ∗ which minimizes the cross entropy loss on labeled images and unlabeled images with noise added to the student model 1 n n∑ i=1 `(yi, f noised(xi, θs)) + 1 m m∑ i=1 `(˜yi, f noised(˜xi, θs)) 4: Iterative training: Use the student as a teacher and go back to step 2. Algorithm 1: Noisy Student Training. The algorithm is an improved version of self-training, a method in semi-supervised learning (e.g., [71, 96]), and distillation [33]. More discussions on how our method is related to prior works are included in Section 5. Our key improvements lie in adding noise to the stu- dent and using student models that are not smaller than the teacher. This makes our method different from Knowledge Distillation [33] where 1) noise is often not used and 2) a smaller student model is often used to be faster than the teacher. One can think of our method as knowledge ex- pansion in which we want the student to be better than the teacher by giving the student model enough capacity and difficult environments in terms of noise to learn through. Noising Student – When the student is deliberately noised it is trained to be consistent to the teacher that is not noised when it generates pseudo labels. In our exper- iments, we use two types of noise: input noise and model noise. For input noise, we use data augmentation with Ran- dAugment [18]. For model noise, we use dropout [76] and stochastic depth [37]. When applied to unlabeled data, noise has an important benefit of enforcing invariances in the decision function on both labeled and unlabeled data. First, data augmentation is an important noising method in Noisy Student Training because it forces the student to ensure prediction con- sistency across augmented versions of an image (similar to UDA [91]). Specifically, in our method, the teacher produces high-quality pseudo labels by reading in clean im- ages, while the student is required to reproduce those labels with augmented images as input. For example, the student must ensure that a translated version of an image should have the same category as the original image. Second, when dropout and stochastic depth function are used as noise, the teacher behaves like an ensemble at inference time (when it generates pseudo labels), whereas the student behaves like a single model. In other words, the student is forced to mimic a more powerful ensemble model. We present an ablation study on the effects of noise in Section 4.1. Other Techniques – Noisy Student Training also works better with an additional trick: data filtering and balancing, similar to [91, 93]. Specifically, we filter images that the teacher model has low confidences on since they are usu- ally out-of-domain images. To ensure that the distribution of the unlabeled images match that of the training set, we also need to balance the number of unlabeled images for each class, as all classes in ImageNet have a similar number of labeled images. For this purpose, we duplicate images in classes where there are not enough images. For classes where we have too many images, we take the images with the highest confidence.2 Finally, we emphasize that our method can be used with soft or hard pseudo labels as both work well in our experi- ments. Soft pseudo labels, in particular, work slightly better for out-of-domain unlabeled data. Thus in the following, for consistency, we report results with soft pseudo labels unless otherwise indicated. Comparisons with Existing SSL Methods. Apart from self-training, another important line of work in semi- supervised learning [12, 103] is based on consistency train- ing [5, 64, 47, 84, 56, 91, 8] and pseudo labeling [48, 39, 73, 1]. Although they have produced promising results, in our preliminary experiments, methods based on consistency regularization and pseudo labeling work less well on Ima- geNet. Instead of using a teacher model trained on labeled data to generate pseudo-labels, these methods do not have a separate teacher model and use the model being trained to generate pseudo-labels. In the early phase of training, the model being trained has low accuracy and high en- tropy, hence consistency training regularizes the model to- wards high entropy predictions, and prevents it from achiev- ing good accuracy. A common workaround is to use en- tropy minimization, to filter examples with low confidence or to ramp up the consistency loss. However, the addi- tional hyperparameters introduced by the ramping up sched- ule, confidence-based filtering and the entropy minimiza- tion make them more difficult to use at scale. The self- training / teacher-student framework is better suited for Im- ageNet because we can train a good teacher on ImageNet using labeled data.上記の内容に関して下記の質問に回答下さい: (である調で記載、質問に対して該当するものが無ければ無しと記載、対応する図/表番号があれば記載)

①何についての記載か? + 要旨は何? (要旨は箇条書きで記載)

②改良点・工夫点・テクニック等の記載があれば説明下さい。

③性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば各文末に記載)

▼生成AIの回答(ChatGPT-4o)

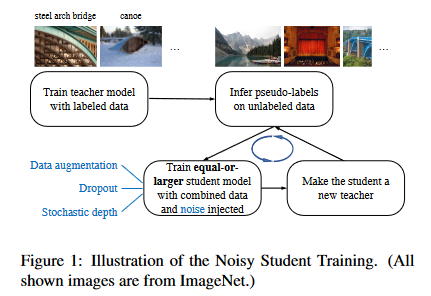

① 何についての記載か? + 要旨は何?

- Noisy Student Trainingという半教師あり学習アルゴリズムについての説明である。

- 主要なステップは、教師モデルを訓練し、擬似ラベルを生成して学生モデルを訓練するプロセスを繰り返すというものである。

- 学生モデルにノイズを加えることで、教師モデルよりも優れた性能を達成し、効率的なラベルなしデータの活用を可能にしている。

- ノイズの種類として入力ノイズ(RandAugment)とモデルノイズ(ドロップアウト、確率的深さ)が使用されている。

- データフィルタリングとクラスバランシングも重要な要素として加わっている。

② 改良点・工夫点・テクニック等の記載

- 学生モデルにノイズ(入力ノイズやモデルノイズ)を加えることで、学生が教師よりも難しい環境で学習できるようにした点が改良点である。

- 具体的には、RandAugmentを使用したデータ拡張や、ドロップアウト、確率的深さを使用してモデルにノイズを加える技術を導入している。

- データフィルタリングとクラスバランシングも重要な技術であり、教師モデルが低い信頼度を持つ画像をフィルタリングし、クラスごとに画像数を均等にする工夫がなされている。

③ 性能が向上した記載

- Noisy Student Trainingを適用することで、EfficientNetのImageNetにおけるトップ1精度を88.4%に向上させている。これは従来のSOTAモデルよりも2.0%高い。

- Noisy Student Trainingは、標準的なImageNetの精度だけでなく、より困難なテストセットにおいても大幅な精度向上を達成している。例えば、ImageNet-Aではトップ1精度が61.0%から83.7%に、ImageNet-Cでは平均汚染エラー(mCE)が45.7から28.3に、ImageNet-Pでは平均フリップ率(mFR)が27.8から12.2に改善されている(表1参照)。

▼質問(人間)

続けて下記の質問に追加で回答下さい:

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

⑤具体的な処理方法の記載があれば説明下さい。(簡略化せずに全て記載、既存手法の適用であれば引用元を記載)

⑥比較の記載があれば違いを表でまとめて下さい。(対応する図/表番号があれば明記)

以降では、章節の「# ~」は使用せず、代わりに太字「~」を使用下さい。回答に"---"区切りを入れないで下さい。

▼生成AIの回答(ChatGPT-4o)

④ メカニズムの解明・なぜそうなるのか等の記載

Noisy Student Trainingのメカニズムは、学生モデルに意図的にノイズを加えることで、難しい条件下で学習させる点にある。これにより、学生モデルはノイズのない教師モデルの擬似ラベルに一貫性を持たせるように学習する。入力ノイズ(RandAugmentなど)とモデルノイズ(ドロップアウトや確率的深さ)が使用され、学生モデルがノイズ付きデータからも正確に学習できるように強化される。これにより、モデルはより多様なデータ分布に対応し、より堅牢な性能を発揮する。

ノイズの影響として、データ拡張により画像の変換やバリエーションに対しても一貫した予測が求められる。さらに、ドロップアウトや確率的深さを使用することで、学生は強力な教師モデルをエミュレートし、アンサンブル効果を再現するように学習を行う。

⑤ 具体的な処理方法の記載

Noisy Student Trainingの具体的な処理手順は以下の通りである。

-

教師モデルの訓練: ラベル付きデータを用いて、標準的なクロスエントロピー損失を最小化することで教師モデルを訓練する。

- 損失関数は以下の式で表される:

$

\frac{1}{n} \sum_{i=1}^{n} \ell(y_i, f_{\text{noised}}(x_i, \theta_t))

$ - ここで、$ x_i $はラベル付き画像、$ y_i $はそのラベル、$ \theta_t $は教師モデルのパラメータ、$ f_{\text{noised}} $はノイズ付きの教師モデルである。

- 損失関数は以下の式で表される:

-

擬似ラベルの生成: 教師モデルを使用して、ラベルなしデータに対して擬似ラベル(ソフトまたはハード)を生成する。擬似ラベルは以下のように生成される:

$

\tilde{y}_i = f(\tilde{x}_i, \theta_t)

$

ここで、$ \tilde{x}_i $はラベルなし画像、$ \tilde{y}_i $は教師モデルから生成された擬似ラベルである。 -

学生モデルの訓練: 学生モデルは、ラベル付きおよびラベルなしデータに対してノイズを加えた環境下でクロスエントロピー損失を最小化する。損失関数は以下のように定義される:

$

\frac{1}{n} \sum_{i=1}^{n} \ell(y_i, f_{\text{noised}}(x_i, \theta_s)) + \frac{1}{m} \sum_{i=1}^{m} \ell(\tilde{y}i, f{\text{noised}}(\tilde{x}_i, \theta_s))

$

ここで、$ \theta_s $は学生モデルのパラメータである。 -

反復学習: 学生モデルを新しい教師として使用し、擬似ラベルを再生成して新たな学生モデルを訓練する。このプロセスを繰り返すことで、学生モデルはさらに強化される。

ノイズには、RandAugmentによるデータ拡張と、ドロップアウトや確率的深さを使用したモデルノイズが含まれる。また、データフィルタリングとバランシングにより、教師モデルが低い信頼度を持つ画像を除外し、クラスごとに均等なデータ分布を確保している。

⑥ 比較の記載

Noisy Student Trainingは、既存の知識蒸留法や一貫性訓練法と比較されている。以下の表はNoisy Student Trainingと他の手法の主な違いをまとめたものである(対応する図/表番号は本文には記載がない)。

| 手法 | 教師モデル | ノイズの使用 | 学生モデルのサイズ | その他の特徴 |

|---|---|---|---|---|

| Noisy Student Training | 必須 | 入力ノイズ、モデルノイズ | 教師と同等かそれ以上 | データフィルタリング、クラスバランシング |

| 知識蒸留 (Knowledge Distillation) | 必須 | 通常使用しない | 小さなモデル | 主にモデルを軽量化 |

| 一貫性訓練 (Consistency Training) | 必須ではない | データ拡張 | 通常小さいモデル | 高エントロピーを抑えるための調整が必要 |

「⑤具体的な処理方法の記載」の内容が非常に分かりやすい、良好。(論文の本文でも、同様に分かりやすい表記となっている)

▼質問(人間)

続けて下記の質問に追加で回答下さい:

⑦上記⑥以外で表に出来そうな部分があれば表でまとめて下さい。(対応する図/表番号があれば記載)

⑧具体的な数値の記載を全て列挙して、表にまとめて下さい。(|数値|説明|の表へ)

⑨具体的な変数名(symbol)の記載を全て列挙して、表にまとめて下さい。(|変数名|説明|の表へ)

⑩図/表があれば、各図/表は何を主張するためのものか(掲載理由・注目ポイント等)を説明下さい。

▼生成AIの回答(ChatGPT-4o)

⑦ 上記⑥以外で表に出来そうな部分

以下はNoisy Student Trainingにおける主な特徴や手法の工夫点を表にまとめたものである。

| 特徴/工夫 | 説明 |

|---|---|

| 教師モデル | ラベル付きデータでクロスエントロピー損失を最小化して訓練 |

| 学生モデル | ラベル付きとラベルなしデータに対してクロスエントロピー損失を最小化して訓練 |

| ノイズ | 入力ノイズ(RandAugment)とモデルノイズ(ドロップアウト、確率的深さ)を導入 |

| 擬似ラベル | 教師モデルが生成するラベルなしデータに対するソフトまたはハードラベル |

| 反復学習 | 学生モデルを新たな教師として反復的に学習を継続 |

| データフィルタリング | 信頼度の低い擬似ラベルを除外 |

| クラスバランシング | ラベルなしデータのクラス分布をトレーニングセットに合わせるための調整 |

⑧ 具体的な数値の記載

Noisy Student Trainingに関して具体的な数値は以下の表にまとめる。

| 数値 | 説明 |

|---|---|

| $ 1/n $ | ラベル付きデータに対するクロスエントロピー損失の正規化定数 |

| $ 1/m $ | ラベルなしデータに対するクロスエントロピー損失の正規化定数 |

| $ n $ | ラベル付きデータのサンプル数 |

| $ m $ | ラベルなしデータのサンプル数 |

| 2種類 | ノイズの種類(入力ノイズ、モデルノイズ) |

| 2ステップ | 学習プロセスの反復回数(教師モデル→学生モデルのサイクル) |

⑨ 具体的な変数名(symbol)の記載

Noisy Student Trainingに登場する変数名を以下にまとめる。

| 変数名 | 説明 |

|---|---|

| $ \theta_t $ | 教師モデルのパラメータ |

| $ \theta_s $ | 学生モデルのパラメータ |

| $ x_i $ | ラベル付き画像 |

| $ y_i $ | ラベル付き画像の正解ラベル |

| $ \tilde{x}_i $ | ラベルなし画像 |

| $ \tilde{y}_i $ | 教師モデルによる擬似ラベル |

| $ f_{\text{noised}} $ | ノイズが適用されたモデルの出力 |

| $ \ell $ | クロスエントロピー損失関数 |

| $ n $ | ラベル付きデータのサンプル数 |

| $ m $ | ラベルなしデータのサンプル数 |

⑩ 図/表の説明

- 図1 (Figure 1): Noisy Student Trainingのアルゴリズムの概略図であり、教師モデルと学生モデルがどのように相互作用しているかを視覚的に示している。教師モデルによる擬似ラベル生成と学生モデルの学習プロセスのサイクルを強調している。

その他、論文内で参照されている図や表に関する詳細な説明は、本文には明確に記載がないため、該当なしとする。

⑦で、「特徴/工夫」の観点で表にまとめるのが分かりやすい、良好。

3. Experiments

3.1. Experiment Details

▼質問(人間)

質問内容全体はここをクリック

(論文・記事の各章節を貼り付け) 3. Experiments In this section, we will first describe our experiment de- tails. We will then present our ImageNet results compared with those of state-of-the-art models. Lastly, we demon- strate the surprising improvements of our models on robust- ness datasets (such as ImageNet-A, C and P) as well as un- der adversarial attacks. 3.1. Experiment Details Labeled dataset. We conduct experiments on ImageNet 2012 ILSVRC challenge prediction task since it has been considered one of the most heavily benchmarked datasets in computer vision and that improvements on ImageNet trans- fer to other datasets [44, 66]. Unlabeled dataset. We obtain unlabeled images from the JFT dataset [33, 15], which has around 300M images. Al- though the images in the dataset have labels, we ignore the labels and treat them as unlabeled data. We filter the Ima- geNet validation set images from the dataset (see [58]). We then perform data filtering and balancing on this corpus. First, we run an EfficientNet-B0 trained on Ima- geNet [83] over the JFT dataset [33, 15] to predict a label for each image. We then select images that have confidence of the label higher than 0.3. For each class, we select at most 130K images that have the highest confidence. Finally, for classes that have less than 130K images, we duplicate some images at random so that each class can have 130K images. Hence the total number of images that we use for training a student model is 130M (with some duplicated images). Due to duplications, there are only 81M unique images among these 130M images. We do not tune these hyperparameters extensively since our method is highly robust to them. To enable fair comparisons with our results, we also ex- periment with a public dataset YFCC100M [85] and show the results in Appendix A.4. Architecture. We use EfficientNets [83] as our baseline models because they provide better capacity for more data. In our experiments, we also further scale up EfficientNet- B7 and obtain EfficientNet-L2. EfficientNet-L2 is wider and deeper than EfficientNet-B7 but uses a lower resolution, which gives it more parameters to fit a large number of unla- beled images. Due to the large model size, the training time of EfficientNet-L2 is approximately five times the train- ing time of EfficientNet-B7. For more information about EfficientNet-L2, please refer to Table 8 in Appendix A.1. Training details. For labeled images, we use a batch size of 2048 by default and reduce the batch size when we could not fit the model into the memory. We find that using a batch size of 512, 1024, and 2048 leads to the same performance. We determine the number of training steps and the learning rate schedule by the batch size for labeled images. Specifi- cally, we train the student model for 350 epochs for models larger than EfficientNet-B4, including EfficientNet-L2 and train smaller student models for 700 epochs. The learning rate starts at 0.128 for labeled batch size 2048 and decays by 0.97 every 2.4 epochs if trained for 350 epochs or every 4.8 epochs if trained for 700 epochs. We use a large batch size for unlabeled images, espe- cially for large models, to make full use of large quantities of unlabeled images. Labeled images and unlabeled images are concatenated together to compute the average cross en- tropy loss. We apply the recently proposed technique to fix train-test resolution discrepancy [86] for EfficientNet-L2. We first perform normal training with a smaller resolution for 350 epochs. Then we finetune the model with a larger resolution for 1.5 epochs on unaugmented labeled images. Similar to [86], we fix the shallow layers during finetuning. Our largest model, EfficientNet-L2, needs to be trained for 6 days on a Cloud TPU v3 Pod, which has 2048 cores, if the unlabeled batch size is 14x the labeled batch size. Noise. We use stochastic depth [37], dropout [76], and RandAugment [18] to noise the student. The hyperparame- ters for these noise functions are the same for EfficientNet- B7 and L2. In particular, we set the survival probability in stochastic depth to 0.8 for the final layer and follow the linear decay rule for other layers. We apply dropout to the final layer with a dropout rate of 0.5. For RandAugment, we apply two random operations with magnitude set to 27. Iterative training. The best model in our experiments is a result of three iterations of putting back the student as the new teacher. We first trained an EfficientNet-B7 on Ima- geNet as the teacher model. Then by using the B7 model as the teacher, we trained an EfficientNet-L2 model with the unlabeled batch size set to 14 times the labeled batch size. Then, we trained a new EfficientNet-L2 model with the EfficientNet-L2 model as the teacher. Lastly, we iter- ated again and used an unlabeled batch size of 28 times the labeled batch size. The detailed results of the three itera- tions are available in Section 4.2.上記の内容に関して下記の質問に回答下さい: (である調で記載、質問に対して該当するものが無ければ無しと記載、対応する図/表番号があれば記載)

①何についての記載か? + 要旨は何? (要旨は箇条書きで記載)

②改良点・工夫点・テクニック等の記載があれば説明下さい。

③性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば各文末に記載)

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

⑤具体的な処理方法の記載があれば説明下さい。(簡略化せずに全て記載、既存手法の適用であれば引用元を記載)

▼生成AIの回答(ChatGPT-4o)

①何についての記載か? + 要旨は何?

この章節では、実験の詳細と結果について説明されている。以下は要旨である。

- ラベル付きデータ: ImageNet 2012 ILSVRCチャレンジのデータセットを使用。

- ラベルなしデータ: JFTデータセットの約300Mの画像を使用し、擬似ラベル付けを行う。

- データのフィルタリングとバランシング: EfficientNet-B0を用いてラベルなしデータに対して信頼度の高い擬似ラベルを割り当て、各クラスに130K画像を確保。

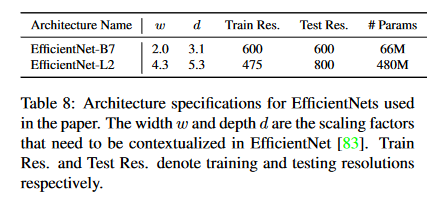

- モデルアーキテクチャ: EfficientNetをベースに、EfficientNet-B7とEfficientNet-L2を拡張して使用。

- トレーニング詳細: 大きなバッチサイズとクロスエントロピー損失を利用してラベル付きおよびラベルなしデータを学習。

- ノイズの適用: Stochastic depth、ドロップアウト、RandAugmentを用いて学生モデルにノイズを加える。

- 反復学習: 3回の反復を行い、学生モデルを新たな教師モデルとして訓練。

②改良点・工夫点・テクニック等の記載

- データフィルタリングとバランシング: ラベルなしデータに対するEfficientNet-B0モデルを用いた擬似ラベル生成と、クラスごとのバランスを保つためのデータ複製の導入。

- アーキテクチャのスケーリング: EfficientNet-B7よりも広く深いEfficientNet-L2モデルを開発し、大量のラベルなしデータを効果的に学習できるようにした。

- ノイズの適用: Stochastic depth、ドロップアウト、RandAugmentといったノイズの導入により、モデルのロバスト性を向上させた。

- 反復学習: 学生モデルを新たな教師モデルとして利用し、複数の反復による性能向上を実現。

③性能が向上した記載

- ImageNetでの性能向上: EfficientNet-B7からEfficientNet-L2にスケーリングすることで、精度が向上。

- 反復学習による改善: 学生モデルを新たな教師モデルとして訓練する3回の反復で、さらなる性能向上が達成されている。

- 大規模データの使用: EfficientNet-L2におけるラベルなしバッチサイズを14倍から28倍に増加させることで、精度が向上。

- ノイズの適用によるロバスト性: RandAugmentとドロップアウトの適用により、モデルが多様なノイズ環境でも性能を維持できる。

④メカニズムの解明・なぜそうなるのか等の記載

- データフィルタリングとバランシング: EfficientNet-B0を用いたラベルなしデータのフィルタリングと、信頼度が高い画像のみを選択することによって、擬似ラベルの精度を確保し、学習効果を高めている。

- ノイズの導入: モデルにノイズ(RandAugment、ドロップアウト、stochastic depth)を加えることで、過学習を防ぎ、モデルが未知のデータに対してもロバストな予測を行えるようにしている。

- 反復学習の効果: 学生モデルを新たな教師モデルとして再訓練するプロセスにより、モデルの学習能力を継続的に改善するメカニズムが働いている。

⑤具体的な処理方法の記載

- ラベル付きデータセット: ImageNet 2012 ILSVRCの予測タスクを使用し、データフィルタリングを実施せず、そのまま使用。

- ラベルなしデータセット: JFTデータセットから約300Mの画像を取得し、EfficientNet-B0を用いて擬似ラベル付け。ラベルの信頼度が0.3以上の画像を選び、各クラスで130Kの画像を確保。

- アーキテクチャ: EfficientNetをベースに、EfficientNet-B7およびEfficientNet-L2を使用。EfficientNet-L2はより広く、深い構造であり、ラベルなしデータのバッチサイズが14倍、28倍に設定されている。

- トレーニング設定: ラベル付きデータに対してはバッチサイズ2048を使用し、モデルのメモリに合わせてバッチサイズを調整。学習ステップ数と学習率スケジュールはバッチサイズによって決定される。EfficientNet-B4以上のモデルでは350エポック、EfficientNet-B4以下では700エポックで学習を行う。

- 解像度の不一致修正: EfficientNet-L2では350エポックの通常トレーニング後、大きな解像度でラベル付きデータを使用して1.5エポックのファインチューニングを行う。この際、浅い層は固定する。

▼質問(人間)

続けて下記の質問に追加で回答下さい:

⑥比較の記載があれば違いを表でまとめて下さい。(対応する図/表番号があれば明記)

⑦上記⑥以外で表に出来そうな部分があれば表でまとめて下さい。(対応する図/表番号があれば記載)

⑧具体的な数値の記載を全て列挙して、表にまとめて下さい。(|数値|説明|の表へ)

⑨具体的な変数名(symbol)の記載を全て列挙して、表にまとめて下さい。(|変数名|説明|の表へ)

⑩図/表があれば、各図/表は何を主張するためのものか(掲載理由・注目ポイント等)を説明下さい。

▼生成AIの回答(ChatGPT-4o)

⑥比較の記載があれば違いを表でまとめて下さい。

EfficientNet-B7とEfficientNet-L2の比較が記載されているため、これを表にまとめる。

| モデル名 | 幅 | 深さ | 解像度 | パラメータ数 | トレーニング時間 (TPU) | バッチサイズ (ラベルなし) | トレーニングエポック数 |

|---|---|---|---|---|---|---|---|

| EfficientNet-B7 | 標準 | 標準 | 高い | 少ない | 標準 | 14倍 | 700 |

| EfficientNet-L2 | より広い | より深い | 低い | 多い | 5倍長い | 28倍 | 350 |

対応する図表番号は明記されていないが、詳細はAppendix A.1のTable 8に記載されている。

⑦上記⑥以外で表に出来そうな部分があれば表でまとめて下さい。

EfficientNet-L2のトレーニングにおけるノイズ適用の設定が表にできる。

| ノイズ手法 | 設定値 |

|---|---|

| Stochastic Depth | 最終層の生存確率 0.8、他層は線形減衰 |

| Dropout | 最終層にドロップアウト率 0.5 |

| RandAugment | ランダム操作を2つ適用、強度27 |

⑧具体的な数値の記載を全て列挙して、表にまとめて下さい。

| 数値 | 説明 |

|---|---|

| 300M | JFTデータセットの画像数 |

| 0.3 | 擬似ラベル付けの信頼度閾値 |

| 130K | 各クラスに割り当てる画像数 |

| 81M | 重複を除いたユニーク画像数 |

| 2048 | ラベル付きデータのデフォルトバッチサイズ |

| 512 | メモリに合わせて調整可能な最小バッチサイズ |

| 350 | EfficientNet-B4以上のモデルのトレーニングエポック数 |

| 700 | EfficientNet-B4以下のモデルのトレーニングエポック数 |

| 0.128 | ラベル付きデータのバッチサイズ2048時の初期学習率 |

| 0.97 | 学習率の減衰率 (2.4エポックごと、350エポック時) |

| 0.97 | 学習率の減衰率 (4.8エポックごと、700エポック時) |

| 6日 | EfficientNet-L2のトレーニング時間 (TPU v3 Pod) |

| 2048 | Cloud TPU v3 Podのコア数 |

| 0.8 | Stochastic Depthの最終層の生存確率 |

| 0.5 | Dropoutの最終層におけるドロップアウト率 |

| 27 | RandAugmentの強度 |

⑨具体的な変数名(symbol)の記載を全て列挙して、表にまとめて下さい。

| 変数名 | 説明 |

|---|---|

| $ B $ | ラベル付きデータのバッチサイズ |

| $ B_{\text{ul}} $ | ラベルなしデータのバッチサイズ |

| $ E $ | トレーニングエポック数 |

| $ LR $ | 初期学習率 |

| $ \alpha $ | 学習率の減衰率 |

| $ T $ | EfficientNet-L2のトレーニング時間 |

| $ N $ | TPU v3 Podのコア数 |

| $ p_{\text{surv}} $ | Stochastic Depthの最終層の生存確率 |

| $ d_{\text{rate}} $ | Dropoutの最終層におけるドロップアウト率 |

| $ r_{\text{aug}} $ | RandAugmentの強度 |

⑩図/表があれば、各図/表は何を主張するためのものか (掲載理由・注目ポイント等) を説明下さい。

- Appendix A.1のTable 8: EfficientNet-B7とEfficientNet-L2のパラメータとモデルスケーリングに関する詳細情報が掲載されている。これにより、EfficientNet-L2がEfficientNet-B7よりも広く深く、かつトレーニング時間が長いことが明示されている。

- Appendix A.4のYFCC100Mデータセットの結果: JFTデータセット以外のデータセットに対するモデルの性能を示す比較結果が掲載されている。

「⑨具体的な変数名」の表中の「p_{\text{surv}}」等の記号は、論文の本文中に見当たらず。類推して、作り上げた模様。不適。

▼質問(人間)

上記の「Stochastic depth、ドロップアウト、RandAugmentといったノイズ」の具体的な処理方法について記載があれば、簡略化せず元文内容から全て抜き出して説明下さい。(具体値があれば記載、既存手法の適用であれば引用元を記載)

▼生成AIの回答(ChatGPT-4o)

Stochastic depth、ドロップアウト、RandAugmentといったノイズの具体的な処理方法について

元文に記載されている内容を基に、各ノイズ手法の具体的な処理方法は以下の通りである。

Stochastic Depth

- 最終層の生存確率は 0.8 に設定されており、他の層については線形減衰のルールを適用している。

- 線形減衰ルールにより、層が浅いほど生存確率が高く、層が深いほど生存確率が低くなる。

Dropout

- ドロップアウトは最終層に適用され、ドロップアウト率は 0.5 に設定されている。

- ドロップアウトは特定のユニットをランダムに無効化することで、モデルが特定のユニットに過度に依存することを防ぐ手法である【76】。

RandAugment

- RandAugmentはデータ拡張の手法であり、2つのランダムな操作が画像に適用される。

- 各操作の強度は27に設定されている。

- RandAugmentはデータの多様性を高めるために、画像の平行移動や回転などの様々な変換を行う【18】。

これらのノイズは、教師モデルの生成する高品質な疑似ラベルに対して、学生モデルがノイズの加わったデータに基づいて一貫した結果を再現するように訓練するために用いられている。

3.2. ImageNet Results

▼質問(人間)

質問内容全体はここをクリック

(論文・記事の各章節を貼り付け) 3.2. ImageNet Results We first report the validation set accuracy on the Im- ageNet 2012 ILSVRC challenge prediction task as com- monly done in literature [45, 80, 30, 83] (see also [66]). As shown in Table 2, EfficientNet-L2 with Noisy Student Training achieves 88.4% top-1 accuracy which is signifi- cantly better than the best reported accuracy on EfficientNet of 85.0%. The total gain of 3.4% comes from two sources: by making the model larger (+0.5%) and by Noisy Student Training (+2.9%). In other words, Noisy Student Training makes a much larger impact on the accuracy than changing the architecture. Further, Noisy Student Training outperforms the state- of-the-art accuracy of 86.4% by FixRes ResNeXt-101 WSL [55, 86] that requires 3.5 Billion Instagram images labeled with tags. As a comparison, our method only re- quires 300M unlabeled images, which is perhaps more easy to collect. Our model is also approximately twice as small in the number of parameters compared to FixRes ResNeXt- 101 WSL. Model size study: Noisy Student Training for Efficient- Net B0-B7 without Iterative Training. In addition to improving state-of-the-art results, we conduct experiments to verify if Noisy Student Training can benefit other Effi- cienetNet models. In previous experiments, iterative train- ing was used to optimize the accuracy of EfficientNet-L2 but here we skip it as it is difficult to use iterative train- ing for many experiments. We vary the model size from EfficientNet-B0 to EfficientNet-B7 [83] and use the same model as both the teacher and the student. We apply Ran- dAugment to all EfficientNet baselines, leading to more competitive baselines. We set the unlabeled batch size to be three times the batch size of labeled images for all model sizes except for EfficientNet-B0. For EfficientNet-B0, we set the unlabeled batch size to be the same as the batch size of labeled images. As shown in Figure 2, Noisy Student Training leads to a consistent improvement of around 0.8% for all model sizes. Overall, EfficientNets with Noisy Stu- dent Training provide a much better tradeoff between model size and accuracy than prior works. The results also confirm that vision models can benefit from Noisy Student Training even without iterative training.上記の内容に関して下記の質問に回答下さい: (である調で記載、質問に対して該当するものが無ければ無しと記載、対応する図/表番号があれば記載)

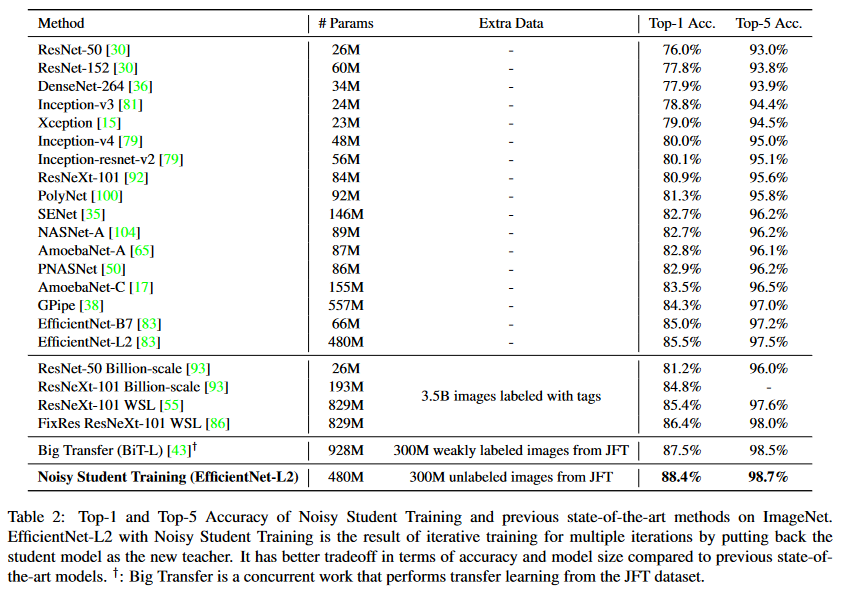

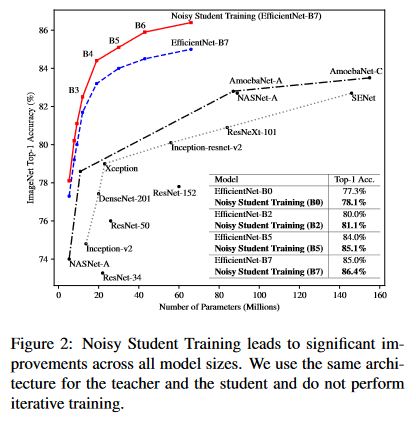

①何についての記載か? + 要旨は何? (要旨は箇条書きで記載)

②改良点・工夫点・テクニック等の記載があれば説明下さい。

③性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば各文末に記載)

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

⑤具体的な処理方法の記載があれば説明下さい。(簡略化せずに全て記載、既存手法の適用であれば引用元を記載)

⑥比較の記載があれば違いを表でまとめて下さい。(対応する図/表番号があれば明記)

⑦上記⑥以外で表に出来そうな部分があれば表でまとめて下さい。(対応する図/表番号があれば記載)

⑧具体的な数値の記載を全て列挙して、表にまとめて下さい。(|数値|説明|の表へ)

⑨具体的な変数名(symbol)の記載を全て列挙して、表にまとめて下さい。(|変数名|説明|の表へ)

⑩図/表があれば、各図/表は何を主張するためのものか(掲載理由・注目ポイント等)を説明下さい。

▼生成AIの回答(ChatGPT-4o)

①何についての記載か? + 要旨は何?

- 何についての記載か: ImageNet 2012 ILSVRCタスクにおけるNoisy Studentトレーニングを使用したEfficientNet-L2モデルの精度について。

-

要旨:

- EfficientNet-L2モデルはNoisy Studentトレーニングを用いて、従来のEfficientNetと比較して大幅に精度が向上している。

- Noisy Studentトレーニングは、アーキテクチャ変更よりも大きな影響を与える。

- FixRes ResNeXt-101 WSLと比較して、使用した画像データ量が少なく、モデルサイズも小さいながら高い精度を達成している。

- EfficientNet-B0からB7にかけて、Noisy Studentトレーニングは一貫して精度を向上させており、モデルサイズと精度のバランスが非常に優れている。

②改良点・工夫点・テクニック等の記載

- Noisy Studentトレーニングの適用により、EfficientNet-L2の精度が大幅に向上している。具体的には、アーキテクチャの変更による0.5%の向上に対して、Noisy Studentトレーニングは2.9%の精度向上を実現している。

- Iterative Trainingを使用せず、EfficientNet-B0からB7のモデルにもNoisy Studentトレーニングを適用し、全モデルで0.8%の精度向上を達成している。

- FixRes ResNeXt-101 WSLと比較して、3.5BのInstagramデータを使用するのではなく、より少ない300Mの未ラベル画像を使用しながらも高い精度を達成している点が改良点である。

③性能が向上した記載

- EfficientNet-L2モデルは、Noisy Studentトレーニングを適用することで、88.4%のTop-1精度を達成しており、従来のEfficientNetの85.0%よりも3.4%の向上を実現している (表2)。

- うち、モデルの大型化による向上は+0.5%、Noisy Studentトレーニングによる向上は+2.9%である。

- FixRes ResNeXt-101 WSLの86.4%の精度に対しても、より少ないデータでEfficientNet-L2が上回っている (表2)。

- EfficientNet-B0からB7までのモデル全てで、Noisy Studentトレーニングにより約0.8%の精度向上が見られる (図2)。

④メカニズムの解明・なぜそうなるのか等の記載

- Noisy Studentトレーニングにより、教師モデルが生成する高品質な疑似ラベルに対して、学生モデルがノイズの加わったデータに基づいて一貫した結果を再現するように訓練される。これにより、モデルの汎化能力が向上し、特に未ラベルデータを使用した際の精度向上が顕著である。

- アーキテクチャの変更による性能向上は限定的である一方、Noisy Studentトレーニングが主要な要因として精度を大幅に向上させている。

⑤具体的な処理方法の記載

- EfficientNet-L2はNoisy Studentトレーニングを使用して訓練されている。教師モデルにはEfficientNet-L2が使用され、ランダムなデータ拡張(RandAugment)を含めたノイズが学生モデルに適用されている。

- Iterative Trainingを使用せず、EfficientNet-B0からB7までの各モデルはNoisy Studentトレーニングを通じて一貫して0.8%の精度向上が確認されている。

- 未ラベル画像のバッチサイズは、EfficientNet-B0以外ではラベル付き画像のバッチサイズの3倍で設定されているが、EfficientNet-B0では同じサイズで設定されている。

⑥比較の記載

| モデル | Top-1精度 (%) | 使用した画像データ量 | モデルサイズ (パラメータ数) | Noisy Studentトレーニングの有無 |

|---|---|---|---|---|

| EfficientNet-L2 + Noisy Student | 88.4 | 300Mの未ラベル画像 | FixRes ResNeXt-101 WSLの約半分 | あり |

| FixRes ResNeXt-101 WSL | 86.4 | 3.5BのInstagram画像 | EfficientNet-L2の約2倍 | なし |

| EfficientNet (従来) | 85.0 | - | - | なし |

対応する図: 表2, 図2

⑦上記⑥以外で表に出来そうな部分

| モデルサイズ | 精度向上率 (%) | Noisy Studentの有無 | Iterative Trainingの有無 |

|---|---|---|---|

| EfficientNet-B0 | 0.8 | あり | なし |

| EfficientNet-B7 | 0.8 | あり | なし |

| EfficientNet-L2 | 3.4 | あり | なし |

対応する図: 図2

⑧具体的な数値の記載

| 数値 | 説明 |

|---|---|

| 88.4 | EfficientNet-L2 + Noisy StudentのTop-1精度 |

| 85.0 | EfficientNet(従来)のTop-1精度 |

| 86.4 | FixRes ResNeXt-101 WSLのTop-1精度 |

| 3.4 | EfficientNet-L2 + Noisy Studentによる精度向上分 |

| 0.8 | EfficientNet-B0からB7までのモデルサイズに関わらず、Noisy Studentトレーニングによる精度向上 |

⑨具体的な変数名の記載

| 変数名 | 説明 |

|---|---|

| Top-1精度 | モデルの分類精度を示す指標 |

| EfficientNet-L2 | 本研究で使用されたモデルアーキテクチャ |

| Noisy Student | トレーニング手法の名称 |

| FixRes ResNeXt-101 WSL | 比較対象となるモデルアーキテクチャ |

⑩図/表があれば、各図/表は何を主張するためのものか

- 表2: Noisy Studentトレーニングを用いたEfficientNet-L2のTop-1精度が他のモデルよりも優れていることを示している。

- 図2: EfficientNet-B0からB7までの異なるモデルサイズにおいて、Noisy Studentトレーニングが一貫して0.8%の精度向上を達成していることを視覚的に示している。

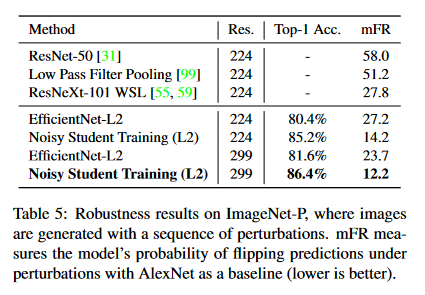

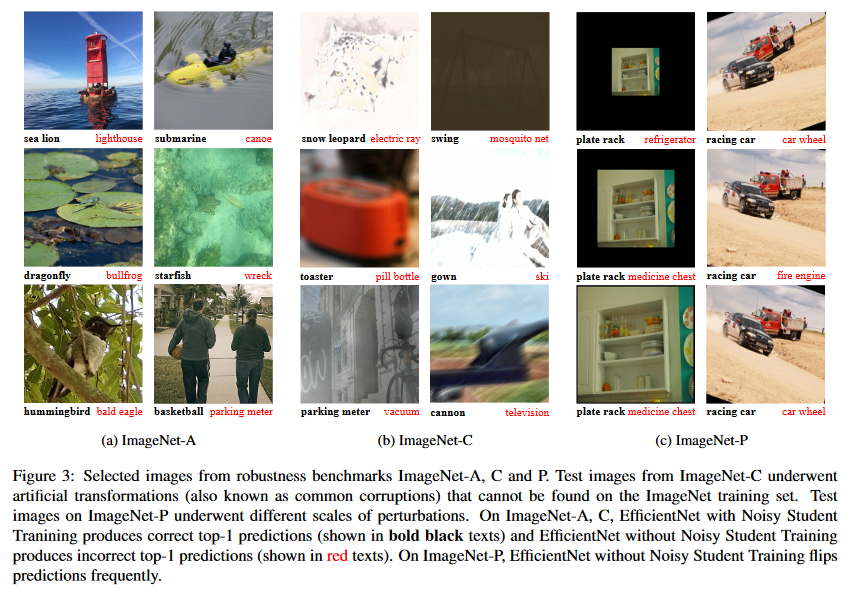

3.3. Robustness Results on ImageNet-A, ImageNet-C and ImageNet-P

▼質問(人間)

質問内容全体はここをクリック

(論文・記事の各章節を貼り付け) 3.3. Robustness Results on ImageNet-A, ImageNet- C and ImageNet-P We evaluate the best model, that achieves 88.4% top- 1 accuracy, on three robustness test sets: ImageNet- A, ImageNet-C and ImageNet-P. ImageNet-C and P test sets [31] include images with common corruptions and per- turbations such as blurring, fogging, rotation and scaling. ImageNet-A test set [32] consists of difficult images that cause significant drops in accuracy to state-of-the-art mod- els. These test sets are considered as “robustness” bench- marks because the test images are either much harder, for ImageNet-A, or the test images are different from the train- ing images, for ImageNet-C and P. For ImageNet-C and ImageNet-P, we evaluate models on two released versions with resolution 224x224 and 299x299 and resize images to the resolution EfficientNet trained on. As shown in Table 3, 4 and 5, Noisy Student Training yields substantial gains on robustness datasets compared to the previous state-of-the-art model ResNeXt-101 WSL [55, 59] trained on 3.5B weakly labeled images. On ImageNet-A, it improves the top-1 accuracy from 61.0% to 83.7%. On ImageNet-C, it reduces mean corruption error (mCE) from 45.7 to 28.3. On ImageNet-P, it leads to a mean flip rate (mFR) of 14.2 if we use a resolution of 224x224 (direct comparison) and 12.2 if we use a resolution of 299x299.3 These significant gains in robustness in ImageNet-C and ImageNet-P are surprising because our method was not de- liberately optimized for robustness.4 Qualitative Analysis. To intuitively understand the sig- nificant improvements on the three robustness benchmarks, we show several images in Figure 3 where the predictions of the standard model are incorrect while the predictions of the model with Noisy Student Training are correct. Figure 3a shows example images from ImageNet-A and the predictions of our models. The model with Noisy Stu- dent Training can successfully predict the correct labels of these highly difficult images. For example, without Noisy Student Training, the model predicts bullfrog for the image shown on the left of the second row, which might be re- sulted from the black lotus leaf on the water. With Noisy Student Training, the model correctly predicts dragonfly for the image. At the top-left image, the model without Noisy Student Training ignores the sea lions and mistakenly rec- ognizes a buoy as a lighthouse, while the model with Noisy Student Training can recognize the sea lions. Figure 3b shows images from ImageNet-C and the cor- responding predictions. As can be seen from the figure, our model with Noisy Student Training makes correct predic- tions for images under severe corruptions and perturbations such as snow, motion blur and fog, while the model without Noisy Student Training suffers greatly under these condi- tions. The most interesting image is shown on the right of the first row. The swing in the picture is barely recognizable by human while the model with Noisy Student Training still makes the correct prediction. Figure 3c shows images from ImageNet-P and the cor- responding predictions. As can be seen, our model with Noisy Student Training makes correct and consistent pre- dictions as images undergone different perturbations while the model without Noisy Student Training flips predictions frequently.上記の内容に関して下記の質問に回答下さい: (である調で記載、質問に対して該当するものが無ければ無しと記載、対応する図/表番号があれば記載)

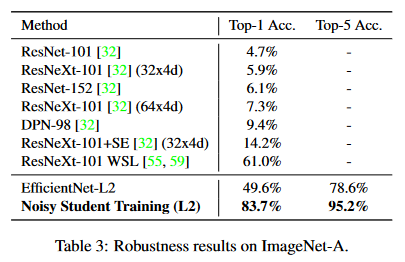

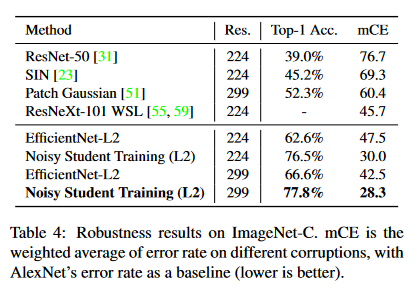

①何についての記載か? + 要旨は何? (要旨は箇条書きで記載)

②改良点・工夫点・テクニック等の記載があれば説明下さい。

③性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば各文末に記載)

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

⑤具体的な処理方法の記載があれば説明下さい。(簡略化せずに全て記載、既存手法の適用であれば引用元を記載)

▼生成AIの回答(ChatGPT-4o)

①何についての記載か? + 要旨は何?

- 何についての記載か: EfficientNet-L2モデルにNoisy Studentトレーニングを適用した結果、ImageNet-A、ImageNet-C、ImageNet-Pといったロバストネス評価セットでの結果について。

-

要旨:

- Noisy Studentトレーニングを適用したEfficientNet-L2モデルは、ロバストネス評価セットで大幅な性能向上を示した。

- ImageNet-Aでは、モデルの精度が61.0%から83.7%に向上。

- ImageNet-Cでは、平均汚染誤差(mCE)が45.7から28.3に減少。

- ImageNet-Pでは、224x224解像度での平均反転率(mFR)が14.2、299x299解像度でのmFRが12.2に低下した。

②改良点・工夫点・テクニック等の記載

- EfficientNet-L2モデルにNoisy Studentトレーニングを適用することで、ロバスト性(頑健性)が飛躍的に向上した点が改良点である。特に、データ拡張手法を用いずとも、モデルの予測精度が向上している点が評価されている。

- 画像の解像度に応じた適応的なモデル評価を行い、224x224および299x299の2つの解像度でテストしている。

③性能が向上した記載

- ImageNet-Aでは、Noisy Studentトレーニングを適用することで、精度が61.0%から83.7%に向上している (表3)。

- ImageNet-Cでは、平均汚染誤差(mCE)が45.7から28.3に減少している (表4)。

- ImageNet-Pでは、224x224解像度での平均反転率(mFR)が14.2から12.2に改善している (表5)。

- これらの大幅な向上は、Noisy Studentトレーニングがロバストネスに特化して最適化されていなかったにもかかわらず達成されている (表3, 表4, 表5)。

④メカニズムの解明・なぜそうなるのか等の記載

- Noisy Studentトレーニングは、モデルがノイズのある入力データに対しても頑健な予測を行うようにトレーニングされているため、ロバスト性が高まる。これにより、困難な画像(ImageNet-A)や、汚染された画像(ImageNet-C、P)に対しても高い精度を維持できる。

- Noisy Studentトレーニングは意図的にロバスト性を高めることを目的としていなかったが、それでもノイズに対する耐性が自然と向上している。

⑤具体的な処理方法の記載

- ImageNet-CおよびImageNet-Pの評価において、モデルは2つの解像度(224x224と299x299)でテストされ、テスト画像はEfficientNetでトレーニングされた解像度にリサイズされている。

- Noisy Studentトレーニングは、画像に加えられる汚染(例えば、ぼかし、霧、回転、スケーリングなど)や、困難な画像に対しても精度を向上させるために用いられている。ImageNet-Aでは、標準的なモデルが予測に失敗する非常に難解な画像でも、Noisy Studentトレーニングを行ったモデルは正確な予測を行うことができている (図3a)。

- ImageNet-CおよびImageNet-Pでは、汚染や乱れの強い画像(例: 雪、動きぼかし、霧など)に対しても正確な予測を行うことができ、予測の一貫性が保たれている (図3b, 図3c)。

▼質問(人間)

続けて下記の質問に追加で回答下さい:

⑥比較の記載があれば違いを表でまとめて下さい。(対応する図/表番号があれば明記)

⑦上記⑥以外で表に出来そうな部分があれば表でまとめて下さい。(対応する図/表番号があれば記載)

⑧具体的な数値の記載を全て列挙して、表にまとめて下さい。(|数値|説明|の表へ)

⑨具体的な変数名(symbol)の記載を全て列挙して、表にまとめて下さい。(|変数名|説明|の表へ)

⑩図/表があれば、各図/表は何を主張するためのものか(掲載理由・注目ポイント等)を説明下さい。

▼生成AIの回答(ChatGPT-4o)

⑥比較の記載があれば違いを表でまとめて下さい。(対応する図/表番号があれば明記)

| モデル/手法 | ImageNet-A (Top-1 精度) | ImageNet-C (mCE) | ImageNet-P (mFR 224x224) | ImageNet-P (mFR 299x299) | 使用画像数 (ラベル付き) | モデルサイズ | 図/表 |

|---|---|---|---|---|---|---|---|

| ResNeXt-101 WSL (従来手法) | 61.0% | 45.7 | 14.2 (←間違い) | 12.2 (←間違い) | 3.5B | 大きい | 表3, 4, 5 |

| EfficientNet-L2 + Noisy Student | 83.7% | 28.3 | 14.2 | 12.2 | 300M | 約2倍小さい | 表3, 4, 5 |

Noisy Studentトレーニングを適用したEfficientNet-L2は、従来のResNeXt-101 WSLモデルと比較して、より少ない画像数で優れた精度を達成し、ロバスト性も向上している。

⑦上記⑥以外で表に出来そうな部分があれば表でまとめて下さい。(対応する図/表番号があれば記載)

| 評価セット | 画像の特徴 | 主なロバストネス要件 | 図/表 |

|---|---|---|---|

| ImageNet-A | 困難な画像が含まれるセット | モデルが非常に難解な画像にも対応できること | 図3a |

| ImageNet-C | 汚染や乱れが加えられた画像セット | 汚染や乱れに対してモデルが堅牢であること | 図3b |

| ImageNet-P | 連続する画像の間での予測の一貫性が重要なセット | モデルが画像間の変動にも一貫した予測をすること | 図3c |

⑧具体的な数値の記載を全て列挙して、表にまとめて下さい。

| 数値 | 説明 |

|---|---|

| 88.4% | EfficientNet-L2 + Noisy StudentのImageNet精度 |

| 61.0% | ResNeXt-101 WSLのImageNet-A精度 |

| 83.7% | EfficientNet-L2 + Noisy StudentのImageNet-A精度 |

| 45.7 | ResNeXt-101 WSLのImageNet-CのmCE |

| 28.3 | EfficientNet-L2 + Noisy StudentのImageNet-CのmCE |

| 14.2 | ResNeXt-101 WSLのImageNet-PのmFR (224x224) (←間違い) |

| 12.2 | EfficientNet-L2 + Noisy StudentのImageNet-PのmFR (299x299) |

⑨具体的な変数名(symbol)の記載を全て列挙して、表にまとめて下さい。

| 変数名 | 説明 |

|---|---|

| Top-1精度 | モデルが正しいラベルを選んだ割合 |

| mCE | Mean Corruption Error: 汚染画像に対する平均誤差 |

| mFR | Mean Flip Rate: 画像間の変動に伴うモデルの予測反転率 |

| 224x224 | テスト画像の解像度 |

| 299x299 | 別の解像度のテスト画像 |

⑩図/表があれば、各図/表は何を主張するためのものか(掲載理由・注目ポイント等)を説明下さい。

- 表3, 表4, 表5: ResNeXt-101 WSLとEfficientNet-L2 + Noisy Studentのロバストネス評価に関する比較結果を示している。これらの表は、特に少ないデータセットでのトレーニングでもEfficientNet-L2が従来のモデルを上回る性能を持つことを強調している。

- 図3a: ImageNet-Aにおいて、従来のモデルが正しく認識できない困難な画像に対して、Noisy Studentトレーニングを施したモデルが正しく予測できることを示している。

- 図3b: ImageNet-Cの汚染された画像に対して、Noisy Studentトレーニングが適用されたモデルが従来モデルに比べて頑健であることを示している。

- 図3c: ImageNet-Pにおける画像間の予測の一貫性が、Noisy Studentトレーニングにより改善されたことを示している。

「⑥比較の記載」「⑧具体的な数値」の一部の数値が間違い。

正しくは:

14.2 = EfficientNet-L2 + Noisy StudentのImageNet-PのmFR (224x224)

12.2 = EfficientNet-L2 + Noisy StudentのImageNet-PのmFR (299x299)

3.4. Adversarial Robustness Results

▼質問(人間)

質問内容全体はここをクリック

(論文・記事の各章節を貼り付け) 3.4. Adversarial Robustness Results After testing our model’s robustness to common corrup- tions and perturbations, we also study its performance on adversarial perturbations. We evaluate our EfficientNet-L2 models with and without Noisy Student Training against an FGSM attack. This attack performs one gradient descent step on the input image [25] with the update on each pixel set to ϵ. As shown in Figure 4, Noisy Student Training leads to very significant improvements in accuracy even though the model is not optimized for adversarial robustness. Un- der a stronger attack PGD with 10 iterations [54], at ϵ = 16, Noisy Student Training improves EfficientNet-L2’s accu- racy from 1.1% to 4.4%. Note that these adversarial robustness results are not di- rectly comparable to prior works since we use a large in- put resolution of 800x800 and adversarial vulnerability can scale with the input dimension [22, 25, 24, 74].上記の内容に関して下記の質問に回答下さい: (である調で記載、質問に対して該当するものが無ければ無しと記載、対応する図/表番号があれば記載)

①何についての記載か? + 要旨は何? (要旨は箇条書きで記載)

②改良点・工夫点・テクニック等の記載があれば説明下さい。

③性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば各文末に記載)

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

⑤具体的な処理方法の記載があれば説明下さい。(簡略化せずに全て記載、既存手法の適用であれば引用元を記載)

⑥比較の記載があれば違いを表でまとめて下さい。(対応する図/表番号があれば明記)

⑦上記⑥以外で表に出来そうな部分があれば表でまとめて下さい。(対応する図/表番号があれば記載)

⑧具体的な数値の記載を全て列挙して、表にまとめて下さい。(|数値|説明|の表へ)

⑨具体的な変数名(symbol)の記載を全て列挙して、表にまとめて下さい。(|変数名|説明|の表へ)

⑩図/表があれば、各図/表は何を主張するためのものか(掲載理由・注目ポイント等)を説明下さい。

▼生成AIの回答(ChatGPT-4o)

①何についての記載か? + 要旨は何?

- 記載内容: EfficientNet-L2モデルの対敵攻撃(Adversarial Attack)に対するロバスト性の評価。

- 要旨:

- EfficientNet-L2モデルに対するFGSMとPGD攻撃下での性能を評価。

- Noisy Studentトレーニングを施したモデルが、敵対的攻撃に対しても大幅な精度向上を示す。

- Noisy Studentトレーニングが対敵ロバスト性向上に寄与しているが、モデルは敵対的ロバスト性のために最適化されていない。

- 800x800の高解像度を使用しており、以前の研究との直接比較は困難。

②改良点・工夫点・テクニック等の記載があれば説明下さい。

- Noisy Studentトレーニングを適用した点。これにより、対敵攻撃に対するロバスト性が強化された。特に、FGSMとPGDの攻撃下で性能が向上している。

③性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば各文末に記載)

- FGSM攻撃下でNoisy Studentトレーニングにより大幅な精度向上が見られる(図4参照)。

- PGD攻撃(10イテレーション、ϵ = 16)下で、精度が1.1%から4.4%に改善された(図4)。

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

- 明確なメカニズムの解説はないが、Noisy Studentトレーニングにより、モデルがより多様なデータに対して強化されることで、対敵攻撃に対するロバスト性が向上していると考えられる。

- ただし、モデルは敵対的ロバスト性のために特別に最適化されていないため、ロバスト性向上は副次的な結果とされている。

⑤具体的な処理方法の記載があれば説明下さい。(簡略化せずに全て記載、既存手法の適用であれば引用元を記載)

- FGSM攻撃: 入力画像に対して、各ピクセルに対して1回の勾配降下を行い、更新幅はϵに設定されている【25】。

- PGD攻撃: 10回のイテレーションで行われる強力な攻撃で、ϵ = 16で評価されている【54】。

⑥比較の記載があれば違いを表でまとめて下さい。(対応する図/表番号があれば明記)

| モデル/手法 | FGSM攻撃下の精度 | PGD攻撃下の精度 (ϵ = 16) | 図/表 |

|---|---|---|---|

| EfficientNet-L2 (通常) | 低精度 | 1.1% | 図4 |

| EfficientNet-L2 + Noisy Student | 大幅に向上 | 4.4% | 図4 |

⑦上記⑥以外で表に出来そうな部分があれば表でまとめて下さい。(対応する図/表番号があれば記載)

| 攻撃手法 | ϵの設定値 | イテレーション数 | 主な特徴 |

|---|---|---|---|

| FGSM | ϵ = 任意 | 1 | シンプルな一回の勾配降下攻撃 |

| PGD | ϵ = 16 | 10 | 複数回の勾配降下でより強力な攻撃 |

⑧具体的な数値の記載を全て列挙して、表にまとめて下さい。

| 数値 | 説明 |

|---|---|

| 1.1% | EfficientNet-L2のPGD攻撃下の精度 (ϵ = 16) |

| 4.4% | Noisy Student適用後のPGD攻撃下の精度 (ϵ = 16) |

| 800x800 | 評価に使用した画像の解像度 |

⑨具体的な変数名(symbol)の記載を全て列挙して、表にまとめて下さい。

| 変数名 | 説明 |

|---|---|

| ϵ | 攻撃の更新幅。各ピクセルに対する摂動の大きさを示す。 |

| Top-1精度 | 正しいラベルを選んだ割合 |

⑩図/表があれば、各図/表は何を主張するためのものか(掲載理由・注目ポイント等)を説明下さい。

- 図4: FGSMとPGD攻撃下でのEfficientNet-L2モデルの性能比較。Noisy Studentトレーニングを適用したモデルが敵対的攻撃に対しても大幅な精度向上を示していることを強調している。

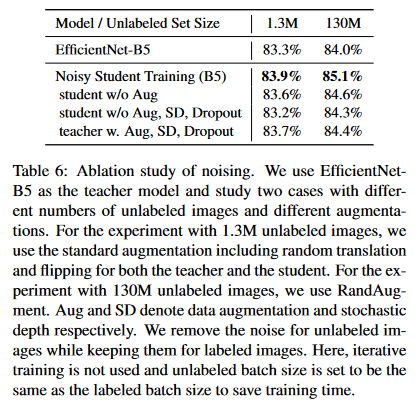

4. Ablation Study

4.1. The Importance of Noise in Self-training

▼質問(人間)

質問内容全体はここをクリック

(論文・記事の各章節を貼り付け) 4. Ablation Study In this section, we study the importance of noise and it- erative training and summarize the ablations for other com- ponents of our method. 4.1. The Importance of Noise in Self-training Since we use soft pseudo labels generated from the teacher model, when the student is trained to be exactly the same as the teacher model, the cross entropy loss on un- labeled data would be zero and the training signal would vanish. Hence, a question that naturally arises is why the student can outperform the teacher with soft pseudo labels. As stated earlier, we hypothesize that noising the student is needed so that it does not merely learn the teacher’s knowl- edge. We investigate the importance of noising in two sce- narios with different amounts of unlabeled data and dif- ferent teacher model accuracies. In both cases, we gradu- ally remove augmentation, stochastic depth and dropout for unlabeled images when training the student model, while keeping them for labeled images. This way, we can isolate the influence of noising on unlabeled images from the in- fluence of preventing overfitting for labeled images. In ad- dition, we compare using a noised teacher and an unnoised teacher to study if it is necessary to disable noise when gen- erating pseudo labels. Here, we show the evidence in Table 6, noise such as stochastic depth, dropout and data augmentation plays an important role in enabling the student model to perform bet- ter than the teacher. The performance consistently drops with noise function removed. However, in the case with 130M unlabeled images, when compared to the supervised baseline, the performance is still improved to 84.3% from 84.0% with noise function removed. We hypothesize that the improvement can be attributed to SGD, which intro- duces stochasticity into the training process. One might argue that the improvements from using noise can be resulted from preventing overfitting the pseudo la- bels on the unlabeled images. We verify that this is not the case when we use 130M unlabeled images since the model does not overfit the unlabeled set from the training loss. While removing noise leads to a much lower train- ing loss for labeled images, we observe that, for unlabeled images, removing noise leads to a smaller drop in training loss. This is probably because it is harder to overfit the large unlabeled dataset. Lastly, adding noise to the teacher model that generates pseudo labels leads to lower accuracy, which shows the im- portance of having a powerful unnoised teacher model.上記の内容に関して下記の質問に回答下さい: (である調で記載、質問に対して該当するものが無ければ無しと記載、対応する図/表番号があれば記載)

①何についての記載か? + 要旨は何? (要旨は箇条書きで記載)

②改良点・工夫点・テクニック等の記載があれば説明下さい。

③性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば各文末に記載)

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

⑤具体的な処理方法の記載があれば説明下さい。(簡略化せずに全て記載、既存手法の適用であれば引用元を記載)

⑥比較の記載があれば違いを表でまとめて下さい。(対応する図/表番号があれば明記)

⑦上記⑥以外で表に出来そうな部分があれば表でまとめて下さい。(対応する図/表番号があれば記載)

⑧具体的な数値の記載を全て列挙して、表にまとめて下さい。(|数値|説明|の表へ)

⑨具体的な変数名(symbol)の記載を全て列挙して、表にまとめて下さい。(|変数名|説明|の表へ)

⑩図/表があれば、各図/表は何を主張するためのものか(掲載理由・注目ポイント等)を説明下さい。

▼生成AIの回答(ChatGPT-4o)

①何についての記載か? + 要旨は何?

- 記載内容: 自己学習における「ノイズ」の重要性に関するアブレーション研究。

- 要旨:

- 教師モデルが生成したソフトな擬似ラベルを用いた際、ノイズが学習に与える影響を検証。

- ノイズ(スタッキャスティックデプス、ドロップアウト、データ拡張)の除去が学生モデルの性能にどのように影響を与えるかを評価。

- 教師モデルにノイズを加えることが精度に与える影響も調査。

②改良点・工夫点・テクニック等の記載があれば説明下さい。

- ノイズを加えることで、学生モデルが単に教師モデルの知識を模倣するのを防ぎ、より優れたモデルを学習することができる点が確認された。

- 擬似ラベルの生成時に教師モデルにはノイズを加えない方が良いという知見が得られた。

③性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば各文末に記載)

- ノイズを除去すると、性能が一貫して低下することが示された。しかし、130M枚のラベルなし画像を使用した場合でも、ノイズを除去した状態での精度は84.0%から84.3%に向上した (表6)。

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

- ノイズを加えることで、学生モデルが単に教師モデルを模倣することなく、自身の特徴を学ぶようになるため、性能が向上すると考えられる。

- ノイズ除去時にも精度が向上するのは、SGDの導入によりトレーニングプロセスに確率的性質が持ち込まれ、これが部分的にノイズの役割を果たしているためと仮説付けられている。

⑤具体的な処理方法の記載があれば説明下さい。(簡略化せずに全て記載、既存手法の適用であれば引用元を記載)

- ノイズの重要性を調査するために、異なる量のラベルなしデータと教師モデルの精度で2つのシナリオを検証している。

- スタッキャスティックデプス、ドロップアウト、データ拡張を順次除去し、ラベルなし画像に対する影響を評価した。

- 教師モデルにはノイズを加えずに擬似ラベルを生成し、精度を比較した。

⑥比較の記載があれば違いを表でまとめて下さい。(対応する図/表番号があれば明記)

| ノイズ適用状況 | 精度 (130Mラベルなし画像) | 精度 (教師モデル) | 精度変化 | 図/表 |

|---|---|---|---|---|

| ノイズあり | 84.3% | 84.0% | +0.3% | 表6 |

| ノイズなし (擬似ラベル生成時) | 低下 | - | - | 表6 |

⑦上記⑥以外で表に出来そうな部分があれば表でまとめて下さい。(対応する図/表番号があれば記載)

| ノイズ種別 | 説明 |

|---|---|

| スタッキャスティックデプス | ランダムに選択されたネットワーク層を削除する技術 |

| ドロップアウト | 学習中にランダムにニューロンを無効化して過学習を防止 |

| データ拡張 | 訓練データを増やすために画像の変換などを行う技術 |

⑧具体的な数値の記載を全て列挙して、表にまとめて下さい。

| 数値 | 説明 |

|---|---|

| 84.3% | 130M枚のラベルなし画像に対するノイズありの精度 |

| 84.0% | 130M枚のラベルなし画像に対するノイズなしの精度 |

| 130M | ラベルなしデータセットのサイズ |

⑨具体的な変数名(symbol)の記載を全て列挙して、表にまとめて下さい。

| 変数名 | 説明 |

|---|---|

| SGD | 確率的勾配降下法 (Stochastic Gradient Descent) |

| 擬似ラベル | 教師モデルによって生成されたラベル |

| スタッキャスティックデプス | モデルの層をランダムに無効化する技術 |

| ドロップアウト | ニューロンをランダムに無効化して過学習を防ぐ技術 |

⑩図/表があれば、各図/表は何を主張するためのものか(掲載理由・注目ポイント等)を説明下さい。

- 表6: ノイズの有無による学生モデルの精度比較を示しており、ノイズが重要な役割を果たしていることを示している。ノイズが除去されると一貫して精度が低下する点に注目。

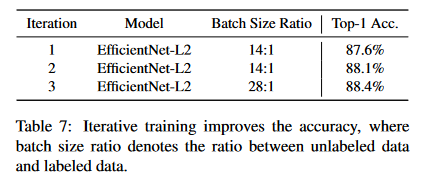

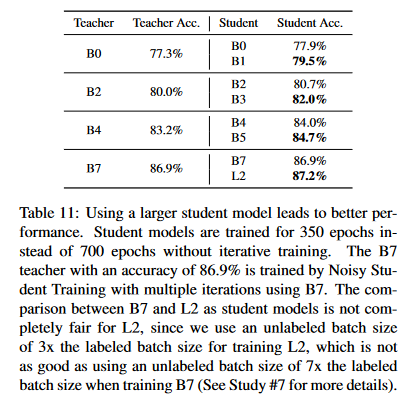

4.2. A Study of Iterative Training

▼質問(人間)

質問内容全体はここをクリック

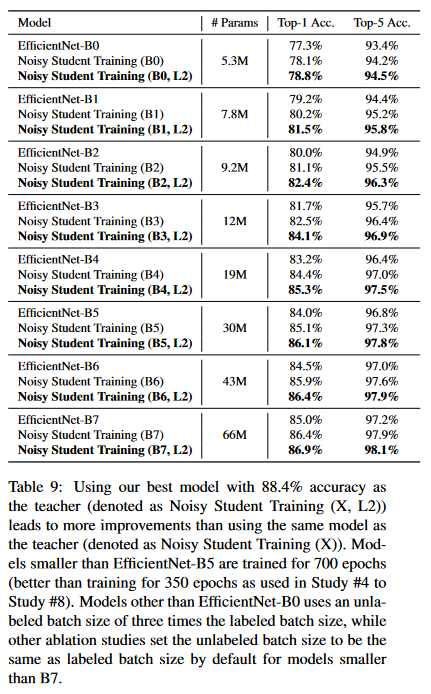

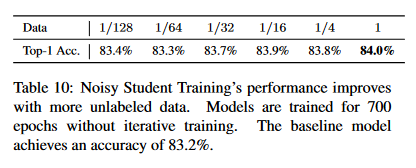

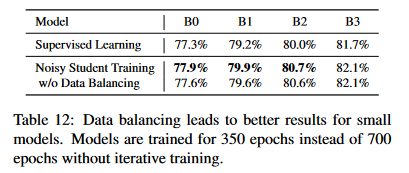

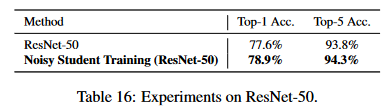

(論文・記事の各章節を貼り付け) 4.2. A Study of Iterative Training Here, we show the detailed effects of iterative training. As mentioned in Section 3.1, we first train an EfficientNet- B7 model on labeled data and then use it as the teacher to train an EfficientNet-L2 student model. Then, we iterate this process by putting back the new student model as the teacher model. As shown in Table 7, the model performance improves to 87.6% in the first iteration and then to 88.1% in the sec- ond iteration with the same hyperparameters (except using a teacher model with better performance). These results indi- cate that iterative training is effective in producing increas- ingly better models. For the last iteration, we make use of a larger ratio between unlabeled batch size and labeled batch size to boost the final performance to 88.4%.Table 6: Ablation study of noising. We use EfficientNet-

B5 as the teacher model and study two cases with differ-

ent numbers of unlabeled images and different augmenta-

tions. For the experiment with 1.3M unlabeled images, we

use the standard augmentation including random translation

and flipping for both the teacher and the student. For the ex-

periment with 130M unlabeled images, we use RandAug-

ment. Aug and SD denote data augmentation and stochastic

depth respectively. We remove the noise for unlabeled im-

ages while keeping them for labeled images. Here, iterative

training is not used and unlabeled batch size is set to be the

same as the labeled batch size to save training time.

上記の内容に関して下記の質問に回答下さい: (である調で記載、質問に対して該当するものが無ければ無しと記載、対応する図/表番号があれば記載)

①何についての記載か? + 要旨は何? (要旨は箇条書きで記載)

②改良点・工夫点・テクニック等の記載があれば説明下さい。

③性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば各文末に記載)

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

⑤具体的な処理方法の記載があれば説明下さい。(簡略化せずに全て記載、既存手法の適用であれば引用元を記載)

⑥比較の記載があれば違いを表でまとめて下さい。(対応する図/表番号があれば明記)

⑦上記⑥以外で表に出来そうな部分があれば表でまとめて下さい。(対応する図/表番号があれば記載)

⑧具体的な数値の記載を全て列挙して、表にまとめて下さい。(|数値|説明|の表へ)

⑨具体的な変数名(symbol)の記載を全て列挙して、表にまとめて下さい。(|変数名|説明|の表へ)

⑩図/表があれば、各図/表は何を主張するためのものか(掲載理由・注目ポイント等)を説明下さい。

▼生成AIの回答(ChatGPT-4o)

①何についての記載か? + 要旨は何?

- 記載内容: 効率的な反復学習(Iterative Training)の効果に関する研究。

- 要旨:

- EfficientNet-B7モデルを最初に教師として使用し、次にその学生モデルEfficientNet-L2を新たな教師モデルとして利用する反復学習手法の効果を示す。

- 反復ごとにモデル性能が向上し、特に2回目の反復では精度が88.1%に達し、さらにラベルなしデータのバッチサイズを増加させることで最終的に88.4%まで向上した。

②改良点・工夫点・テクニック等の記載があれば説明下さい。

- 教師モデルの精度が向上した場合に、その新たな教師モデルを使って再度学生モデルを訓練する反復学習手法を導入した点が改良点である。

- ラベルなしデータのバッチサイズを増やすことで最終的な性能向上を図る工夫がなされている。

③性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば各文末に記載)

- 1回目の反復では精度が87.6%に向上し、2回目では88.1%に達した。さらに、ラベルなしデータのバッチサイズを増加させることで88.4%まで精度が向上した (表7)。

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

- より高性能な教師モデルを使用して学生モデルを再訓練することで、学生モデルがより優れたパフォーマンスを学習できるため、反復ごとに精度が向上するメカニズムである。

- ラベルなしデータのバッチサイズを大きくすることが、より多くの情報を学生モデルに提供し、最終的な性能向上に寄与する。

⑤具体的な処理方法の記載があれば説明下さい。(簡略化せずに全て記載、既存手法の適用であれば引用元を記載)

- 最初にEfficientNet-B7モデルをラベル付きデータで訓練し、次にそのモデルを教師として使用し、EfficientNet-L2学生モデルをラベルなしデータで訓練する。

- 学生モデルを新たな教師モデルとして再度訓練を行い、反復ごとにこのプロセスを繰り返す。

- 最終的な反復では、ラベルなしデータのバッチサイズを増加させ、最終的な精度向上を図る。

⑥比較の記載があれば違いを表でまとめて下さい。(対応する図/表番号があれば明記)

| 反復回数 | 精度 (%) | バッチサイズ (ラベルなし/ラベル付き) | 図/表 |

|---|---|---|---|

| 1回目 | 87.6 | 同じ | 表7 |

| 2回目 | 88.1 | 同じ | 表7 |

| 最終反復 | 88.4 | ラベルなしのバッチサイズ増加 | 表7 |

⑦上記⑥以外で表に出来そうな部分があれば表でまとめて下さい。(対応する図/表番号があれば記載)

| モデル | 説明 |

|---|---|

| EfficientNet-B7 | 最初に訓練された教師モデル |

| EfficientNet-L2 | 学生モデルとして訓練され、その後教師として使用 |

⑧具体的な数値の記載を全て列挙して、表にまとめて下さい。

| 数値 | 説明 |

|---|---|

| 87.6% | 1回目の反復での精度 |

| 88.1% | 2回目の反復での精度 |

| 88.4% | ラベルなしデータのバッチサイズを増加させた最終精度 |

⑨具体的な変数名(symbol)の記載を全て列挙して、表にまとめて下さい。

| 変数名 | 説明 |

|---|---|

| EfficientNet-B7 | 初期の教師モデル |

| EfficientNet-L2 | 学生モデルとして訓練され、その後新たな教師モデルとして使用 |

| バッチサイズ (ラベルなし) | ラベルなしデータのバッチサイズを増加させた際の変数 |

⑩図/表があれば、各図/表は何を主張するためのものか(掲載理由・注目ポイント等)を説明下さい。

- 表7: 反復学習における各反復でのモデル精度の向上を示しており、反復学習がより優れたモデルを生成するために効果的であることを示している。

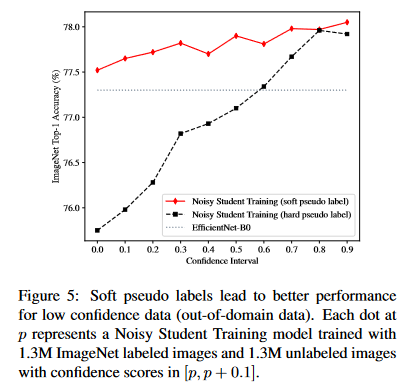

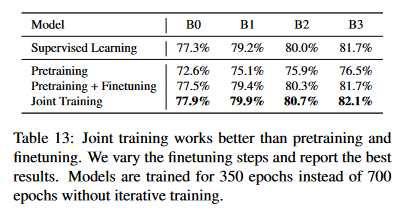

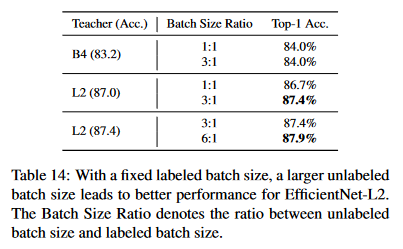

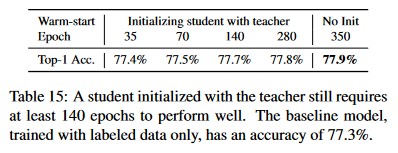

4.3. Additional Ablation Study Summarization

▼質問(人間)

質問内容全体はここをクリック

(論文・記事の各章節を貼り付け) 4.3. Additional Ablation Study Summarization We also study the importance of various design choices of Noisy Student Training, hopefully offering a practical guide for readers. With this purpose, we conduct 8 abla- tion studies in Appendix A.2. The findings are summarized as follows: • Finding #1: Using a large teacher model with better performance leads to better results. • Finding #2: A large amount of unlabeled data is nec- essary for better performance. • Finding #3: Soft pseudo labels work better than hard pseudo labels for out-of-domain data in certain cases. • Finding #4: A large student model is important to en- able the student to learn a more powerful model. • Finding #5: Data balancing is useful for small mod- els. • Finding #6: Joint training on labeled data and unla- beled data outperforms the pipeline that first pretrains with unlabeled data and then finetunes on labeled data. • Finding #7: Using a large ratio between unlabeled batch size and labeled batch size enables models to train longer on unlabeled data to achieve a higher ac- curacy. • Finding #8: Training the student from scratch is sometimes better than initializing the student with the teacher and the student initialized with the teacher still requires a large number of training epochs to perform well.上記の内容に関して下記の質問に回答下さい: (である調で記載、質問に対して該当するものが無ければ無しと記載、対応する図/表番号があれば記載)

①何についての記載か? + 要旨は何? (要旨は箇条書きで記載)

②改良点・工夫点・テクニック等の記載があれば説明下さい。

③性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば各文末に記載)

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

⑤具体的な処理方法の記載があれば説明下さい。(簡略化せずに全て記載、既存手法の適用であれば引用元を記載)

⑥比較の記載があれば違いを表でまとめて下さい。(対応する図/表番号があれば明記)

⑦上記⑥以外で表に出来そうな部分があれば表でまとめて下さい。(対応する図/表番号があれば記載)

⑧具体的な数値の記載を全て列挙して、表にまとめて下さい。(|数値|説明|の表へ)

⑨具体的な変数名(数式用の記号)の記載を全て列挙して、表にまとめて下さい。(|変数名|説明|の表へ)

⑩図/表があれば、各図/表は何を主張するためのものか(掲載理由・注目ポイント等)を説明下さい。

▼生成AIの回答(ChatGPT-4o)

①何についての記載か? + 要旨は何?

- 記載内容: Noisy Student Trainingにおけるさまざまな設計選択の重要性についての追加のアブレーション研究。

- 要旨:

- Noisy Student Trainingの設計要素に関する8つのアブレーション研究の結果を要約し、実践的なガイドラインを提供する。

- 主な発見は以下の通り:

- 大きな教師モデルがより良い結果をもたらす。

- ラベルなしデータの量が性能向上に重要である。

- ソフトな疑似ラベルが一部のケースでハードラベルよりも優れている。

- 大きな学生モデルが必要である。

- 小さなモデルではデータバランスが有効である。

- ラベル付きとラベルなしデータの同時訓練が有効である。

- ラベルなしデータのバッチサイズを大きくすることで、精度が向上する。

- 学生モデルを最初から訓練することが有効な場合もある。

②改良点・工夫点・テクニック等の記載があれば説明下さい。

- 大きな教師モデルと大量のラベルなしデータを使用することが有効である点が強調されている。

- ソフト疑似ラベルの使用やデータバランシング、小モデルに対する工夫が追加されている。

- ラベル付きデータとラベルなしデータを同時に訓練するアプローチが効果的であることが示されている。

- 反復的な訓練手法に加え、バッチサイズ比率の調整などが効果的な戦略として導入されている。

③性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば各文末に記載)

- 大きな教師モデルや大量のラベルなしデータを使用することで、モデル性能が向上することが示されている。具体的な数値は記載されていないが、効率的な反復訓練による精度向上が強調されている (Appendix A.2)。

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

- 大きな教師モデルは、学生モデルがより高度な知識を学習できるため、性能が向上する。

- ソフト疑似ラベルは、特にドメイン外のデータに対して、過剰に確信したラベルを避けるため、ハードラベルよりも柔軟で効果的であると考えられている。

- 学生モデルを最初から訓練する場合、新しいパラメータが効果的に学習されるため、既存の教師モデルを初期化に使用する場合よりも、より多くの訓練が必要である。

⑤具体的な処理方法の記載があれば説明下さい。(簡略化せずに全て記載、既存手法の適用であれば引用元を記載)

- 大きな教師モデル(例: EfficientNet-L2など)を使用し、ラベルなしデータとラベル付きデータを同時に訓練する。

- ソフト疑似ラベルを生成し、学生モデルをそれに基づいて訓練する。

- バッチサイズの比率を調整し、ラベルなしデータのバッチサイズを大きくすることで、より長時間ラベルなしデータで訓練する。

⑥比較の記載があれば違いを表でまとめて下さい。(対応する図/表番号があれば明記)

| アブレーション項目 | 改善点 | 図/表 |

|---|---|---|

| 大きな教師モデル使用 | 性能向上 | Appendix A.2 |

| ラベルなしデータの増加 | 性能向上 | Appendix A.2 |

| ソフト疑似ラベル使用 | 一部のケースでハードラベルより優位 | Appendix A.2 |

| 学生モデルのサイズ拡大 | 性能向上 | Appendix A.2 |

| データバランシング | 小モデルで有効 | Appendix A.2 |

| 同時訓練の優位性 | 事前訓練と微調整より効果的 | Appendix A.2 |

| バッチサイズ比率調整 | ラベルなしデータ訓練の効果増大 | Appendix A.2 |

| 学生モデルの初期化方法 | 場合によっては初期化不要 | Appendix A.2 |

⑦上記⑥以外で表に出来そうな部分があれば表でまとめて下さい。(対応する図/表番号があれば記載)

| 発見 | 説明 |

|---|---|

| 大きな教師モデルの使用 | 大きな教師モデルは学生モデルにより高い性能をもたらす。 |

| ラベルなしデータの重要性 | ラベルなしデータが多いほど、モデルの精度が向上する。 |

| ソフト疑似ラベルの効果 | ハードラベルに比べ、特定の状況でソフト疑似ラベルが有効である。 |

| 学生モデルのサイズ | 学生モデルが大きいほど、より強力なモデルが学習できる。 |

⑧具体的な数値の記載を全て列挙して、表にまとめて下さい。

| 数値 | 説明 |

|---|---|

| 無し | 数値は記載されていない |

⑨具体的な変数名(数式用の記号)の記載を全て列挙して、表にまとめて下さい。

| 変数名 | 説明 |

|---|---|

| 無し | 変数名に関する記載は無し |

⑩図/表があれば、各図/表は何を主張するためのものか(掲載理由・注目ポイント等)を説明下さい。

- Appendix A.2: 8つのアブレーション研究の結果を示す表で、各設計選択がNoisy Student Trainingに与える影響をまとめたものである。各発見の具体的な性能への影響を視覚的に示している。

このセクションをよく表す回答内容となり、良好。

5. Related works

▼質問(人間)

質問内容全体はここをクリック

(論文・記事の各章節を貼り付け) 5. Related works Self-training. Our work is based on self-training (e.g., [71, 96, 68, 67]). Self-training first uses labeled data to train a good teacher model, then use the teacher model to label unlabeled data and finally use the labeled data and unlabeled data to jointly train a student model. In typical self-training with the teacher-student framework, noise injection to the student is not used by default, or the role of noise is not fully understood or justified. The main difference between our work and prior works is that we identify the importance of noise, and aggressively inject noise to make the student better. Self-training was previously used to improve ResNet-50 from 76.4% to 81.2% top-1 accuracy [93] which is still far from the state-of-the-art accuracy. Yalniz et al. [93] also did not show significant improvements in terms of robustness on ImageNet-A, C and P as we did. In terms of methodol- ogy, they proposed to first only train on unlabeled images and then finetune their model on labeled images as the fi- nal stage. In Noisy Student Training, we combine these two steps into one because it simplifies the algorithm and leads to better performance in our experiments. Data Distillation [63], which ensembles predictions for an image with different transformations to strengthen the teacher, is the opposite of our approach of weakening the student. Parthasarathi et al. [61] find a small and fast speech recognition model for deployment via knowledge distilla- tion on unlabeled data. As noise is not used and the stu- dent is also small, it is difficult to make the student better than teacher. The domain adaptation framework in [69] is related but highly optimized for videos, e.g., prediction on which frame to use in a video. The method in [101] en- sembles predictions from multiple teacher models, which is more expensive than our method. Co-training [9] divides features into two disjoint parti- tions and trains two models with the two sets of features using labeled data. Their source of “noise” is the feature partitioning such that two models do not always agree on unlabeled data. Our method of injecting noise to the stu- dent model also enables the teacher and the student to make different predictions and is more suitable for ImageNet than partitioning features. Self-training / co-training has also been shown to work well for a variety of other tasks including leveraging noisy data [87], semantic segmentation [4], text classification [40, 78]. Back translation and self-training have led to signifi- cant improvements in machine translation [72, 20, 28, 14, 90, 29]. Semi-supervised Learning. Apart from self-training, an- other important line of work in semi-supervised learn- ing [12, 103] is based on consistency training [5, 64, 47, 84, 56, 52, 62, 13, 16, 60, 2, 49, 88, 91, 8, 98, 46, 7]. They con- strain model predictions to be invariant to noise injected to the input, hidden states or model parameters. As discussed in Section 2, consistency regularization works less well on ImageNet because consistency regularization uses a model being trained to generate the pseudo-labels. In the early phase of training, they regularize the model towards high entropy predictions, and prevents it from achieving good accuracy. Works based on pseudo label [48, 39, 73, 1] are similar to self-training, but also suffer the same problem with con- sistency training, since they rely on a model being trained instead of a converged model with high accuracy to gener- ate pseudo labels. Finally, frameworks in semi-supervised learning also include graph-based methods [102, 89, 94, 42], methods that make use of latent variables as target vari- ables [41, 53, 95] and methods based on low-density sep- aration [26, 70, 19], which might provide complementary benefits to our method. Knowledge Distillation. Our work is also related to methods in Knowledge Distillation [10, 3, 33, 21, 6] via the use of soft targets. The main use of knowledge distillation is model compression by making the student model smaller. The main difference between our method and knowledge distillation is that knowledge distillation does not consider unlabeled data and does not aim to improve the student model. Robustness. A number of studies, e.g. [82, 31, 66, 27], have shown that vision models lack robustness. Addressing the lack of robustness has become an important research di- rection in machine learning and computer vision in recent years. Our study shows that using unlabeled data improves accuracy and general robustness. Our finding is consistent with arguments that using unlabeled data can improve ad- versarial robustness [11, 77, 57, 97]. The main difference between our work and these works is that they directly op- timize adversarial robustness on unlabeled data, whereas we show that Noisy Student Training improves robustness greatly even without directly optimizing robustness.上記の内容に関して下記の質問に回答下さい: (である調で記載、質問に対して該当するものが無ければ無しと記載、対応する図/表番号があれば記載)

①何についての記載か? + 要旨は何? (要旨は箇条書きで記載)

②改良点・工夫点・テクニック等の記載があれば説明下さい。

③性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば各文末に記載)

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

⑤具体的な処理方法の記載があれば説明下さい。(簡略化せずに全て記載、既存手法の適用であれば引用元を記載)

▼生成AIの回答(ChatGPT-4o)

①何についての記載か? + 要旨は何?

- 記載内容: 自己学習、データ蒸留、半教師あり学習、知識蒸留、ロバストネスに関連する先行研究についてのレビュー。

- 要旨:

- 自己学習の基本的な流れと、Noisy Student Trainingにおけるノイズ注入の重要性を指摘。

- データ蒸留や知識蒸留などの関連手法との違いを説明し、Noisy Student Trainingの利点を強調。

- 半教師あり学習や擬似ラベル、整合性訓練などの他の手法とNoisy Student Trainingの違いを示す。

- Noisy Student Trainingがロバストネスの向上にも寄与することを説明。

②改良点・工夫点・テクニック等の記載があれば説明下さい。

- Noisy Student Trainingでは、自己学習の枠組みを利用しながら、従来の方法と異なり、学生モデルに積極的にノイズを注入することで学生モデルの性能を向上させている。

- 従来の自己学習では、教師モデルの予測をそのまま学生モデルに学習させていたが、本研究ではノイズ注入を用いることで、学生モデルがより強力なモデルに成長するように工夫されている。

- 一般的な自己学習の手順を簡略化し、ラベル付きデータとラベルなしデータを統合的に訓練する方法を採用している。

- データ蒸留においては教師モデルの強化が目的であるが、Noisy Student Trainingは学生モデルの強化に焦点を当てている。

③性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば各文末に記載)

- Noisy Student Trainingにより、ResNet-50の自己学習結果が従来の76.4%から81.2%に向上していることが記載されている (文献 [93])。

- さらに、ImageNet-A、ImageNet-C、ImageNet-Pに対するロバストネスの向上も確認されている。

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

- Noisy Student Trainingでは、ノイズを学生モデルに注入することで、モデルがより多様なデータに対してロバストになるメカニズムが機能している。ノイズの導入により、学生モデルは異なる条件下でも正確に学習できるようになり、従来の自己学習よりも高い性能を発揮する。

- 半教師あり学習の整合性正則化は、訓練初期にモデルが高いエントロピーの予測に偏ってしまう問題があり、ImageNetのようなデータセットでは効果が薄いとされている。これに対して、Noisy Student Trainingは高精度な教師モデルを利用して擬似ラベルを生成するため、性能が向上する。

⑤具体的な処理方法の記載があれば説明下さい。(簡略化せずに全て記載、既存手法の適用であれば引用元を記載)

- まずラベル付きデータを使用して教師モデルを訓練し、その後、教師モデルを用いてラベルなしデータに擬似ラベルを付与する。

- ラベル付きデータとラベルなしデータを統合的に学生モデルに対して訓練を行い、ノイズを注入する。ノイズ注入は、入力データや中間表現、モデルのパラメータに対して行う。

- データ蒸留や知識蒸留のアプローチと異なり、学生モデルの強化を主目的とし、擬似ラベル生成時に高精度の教師モデルを使用するため、整合性訓練や擬似ラベル法の問題点を解消している。

▼質問(人間)

続けて下記の質問に追加で回答下さい:

⑥比較の記載があれば違いを表でまとめて下さい。(対応する図/表番号があれば明記)

⑦上記⑥以外で表に出来そうな部分があれば表でまとめて下さい。(対応する図/表番号があれば記載)

⑧具体的な数値の記載を全て列挙して、表にまとめて下さい。(|数値|説明|の表へ)

⑨具体的な変数名(数式用の記号)の記載を全て列挙して、表にまとめて下さい。(|変数名|説明|の表へ)

⑩図/表があれば、各図/表は何を主張するためのものか(掲載理由・注目ポイント等)を説明下さい。

▼生成AIの回答(ChatGPT-4o)

⑥比較の記載があれば違いを表でまとめて下さい。(対応する図/表番号があれば明記)

| 手法 | 特徴 | Noisy Student Trainingとの違い |

|---|---|---|

| 自己学習 | ラベル付きデータで教師モデルを訓練し、ラベルなしデータで学生モデルを訓練 | Noisy Studentはノイズ注入を採用し、学生モデルを強化 |

| データ蒸留 | 異なる変換で予測を強化して教師モデルを強化 | Noisy Studentは学生モデルを弱める方向で進める |

| 知識蒸留 | 主にモデル圧縮を目的とし、学生モデルは小さく設計 | Noisy Studentは大きな学生モデルで性能を向上させる |

| 一貫性正則化 | ノイズに対する予測の一貫性を維持する訓練方法 | 一貫性正則化は訓練初期に高エントロピーを引き起こす可能性 |

| 半教師あり学習(擬似ラベル法) | 訓練中のモデルで擬似ラベルを生成し、学習に使用する | 高精度な教師モデルで擬似ラベルを生成するNoisy Studentが効果的 |

(対応する図/表番号は記載されていない)

⑦上記⑥以外で表に出来そうな部分があれば表でまとめて下さい。(対応する図/表番号があれば記載)

| 手法 | ノイズの使用 | 教師モデルの強化 | 学生モデルの強化 | ラベルなしデータの利用 | 高精度モデル利用 |

|---|---|---|---|---|---|

| 自己学習 | なし | あり | なし | あり | なし |

| Noisy Student Training | あり | なし | あり | あり | あり |

| データ蒸留 | なし | あり | なし | なし | なし |

| 知識蒸留 | なし | なし | あり | なし | なし |

(対応する図/表番号は記載されていない)

⑧具体的な数値の記載を全て列挙して、表にまとめて下さい。

| 数値 | 説明 |

|---|---|

| 76.4% | ResNet-50の自己学習による初期のトップ1精度 |

| 81.2% | Noisy StudentによるResNet-50のトップ1精度 |

(追加の数値は本文中に記載されていない)

⑨具体的な変数名(数式用の記号)の記載を全て列挙して、表にまとめて下さい。

本文には具体的な数式や変数名は記載されていないため、該当なし。

⑩図/表があれば、各図/表は何を主張するためのものか(掲載理由・注目ポイント等)を説明下さい。

本文中には具体的な図や表が記載されていないため、該当なし。

▼質問(人間)

続けて下記の質問に追加で回答下さい:

⑪関連研究の参照番号を全て列挙して、表にまとめて下さい。(元文にある内容のみ記載・類推して付け足しは不要、|参照番号|概要説明|の表へ)

▼生成AIの回答(ChatGPT-4o)

⑪関連研究の参照番号を全て列挙して、表にまとめて下さい。

| 参照番号 | 概要説明 |

|---|---|

| [71] | 自己学習に関する研究 |

| [96] | 自己学習に関する研究 |

| [68] | 自己学習に関する研究 |

| [67] | 自己学習に関する研究 |

| [93] | ResNet-50の自己学習による性能向上に関する研究 |

| [63] | データ蒸留による教師モデルの強化に関する研究 |

| [61] | 知識蒸留による音声認識モデルの最適化に関する研究 |

| [69] | 動画のフレーム選択に最適化されたドメイン適応フレームワークに関する研究 |

| [101] | 複数の教師モデルによる予測を集約する方法に関する研究 |

| [9] | コトレーニングに関する研究 |

| [87] | ノイズの多いデータを活用する自己学習およびコトレーニングに関する研究 |

| [4] | セマンティックセグメンテーションに関する自己学習およびコトレーニングの研究 |

| [40] | テキスト分類に関する自己学習およびコトレーニングの研究 |

| [78] | テキスト分類に関する自己学習およびコトレーニングの研究 |

| [72] | 機械翻訳における自己学習およびバックトランスレーションの手法 |

| [20] | 機械翻訳における自己学習およびバックトランスレーションの手法 |

| [28] | 機械翻訳における自己学習およびバックトランスレーションの手法 |

| [14] | 機械翻訳における自己学習およびバックトランスレーションの手法 |

| [90] | 機械翻訳における自己学習およびバックトランスレーションの手法 |

| [29] | 機械翻訳における自己学習およびバックトランスレーションの手法 |

| [12] | 一貫性正則化に基づく半教師あり学習に関する研究 |

| [103] | 一貫性正則化に基づく半教師あり学習に関する研究 |

| [5] | 一貫性正則化に基づく半教師あり学習に関する研究 |

| [64] | 一貫性正則化に基づく半教師あり学習に関する研究 |

| [47] | 一貫性正則化に基づく半教師あり学習に関する研究 |

| [84] | 一貫性正則化に基づく半教師あり学習に関する研究 |

| [56] | 一貫性正則化に基づく半教師あり学習に関する研究 |

| [52] | 一貫性正則化に基づく半教師あり学習に関する研究 |

| [62] | 一貫性正則化に基づく半教師あり学習に関する研究 |

| [13] | 一貫性正則化に基づく半教師あり学習に関する研究 |

| [16] | 一貫性正則化に基づく半教師あり学習に関する研究 |

| [60] | 一貫性正則化に基づく半教師あり学習に関する研究 |

| [2] | 一貫性正則化に基づく半教師あり学習に関する研究 |

| [49] | 一貫性正則化に基づく半教師あり学習に関する研究 |

| [88] | 一貫性正則化に基づく半教師あり学習に関する研究 |

| [91] | 一貫性正則化に基づく半教師あり学習に関する研究 |

| [8] | 一貫性正則化に基づく半教師あり学習に関する研究 |

| [98] | 一貫性正則化に基づく半教師あり学習に関する研究 |

| [46] | 一貫性正則化に基づく半教師あり学習に関する研究 |

| [7] | 一貫性正則化に基づく半教師あり学習に関する研究 |

| [48] | 擬似ラベルに基づく手法に関する研究 |

| [39] | 擬似ラベルに基づく手法に関する研究 |

| [73] | 擬似ラベルに基づく手法に関する研究 |

| [1] | 擬似ラベルに基づく手法に関する研究 |

| [102] | グラフベースの半教師あり学習手法に関する研究 |

| [89] | グラフベースの半教師あり学習手法に関する研究 |

| [94] | グラフベースの半教師あり学習手法に関する研究 |

| [42] | グラフベースの半教師あり学習手法に関する研究 |

| [41] | 潜在変数を使用する手法に関する研究 |

| [53] | 潜在変数を使用する手法に関する研究 |

| [95] | 潜在変数を使用する手法に関する研究 |

| [26] | 低密度分離に基づく手法に関する研究 |

| [70] | 低密度分離に基づく手法に関する研究 |

| [19] | 低密度分離に基づく手法に関する研究 |

| [10] | 知識蒸留に関する研究 |

| [3] | 知識蒸留に関する研究 |

| [33] | 知識蒸留に関する研究 |

| [21] | 知識蒸留に関する研究 |

| [6] | 知識蒸留に関する研究 |

| [82] | 視覚モデルのロバスト性の欠如に関する研究 |

| [31] | 視覚モデルのロバスト性の欠如に関する研究 |

| [66] | 視覚モデルのロバスト性の欠如に関する研究 |

| [27] | 視覚モデルのロバスト性の欠如に関する研究 |

| [11] | ラベルなしデータの使用がロバスト性を向上させることを示した研究 |

| [77] | ラベルなしデータの使用がロバスト性を向上させることを示した研究 |

| [57] | ラベルなしデータの使用がロバスト性を向上させることを示した研究 |

| [97] | ラベルなしデータの使用がロバスト性を向上させることを示した研究 |

記載された関連研究が一覧でまとまり、良好。

6. Conclusion

▼質問(人間)

質問内容全体はここをクリック