はじめに

生成AIを用いて初代GPTの論文「Improving Language Understanding by Generative Pre-Training (2018)」の内容を(なるべく)把握してみました。(生成AIが)論文の記載内容を始めから最後まで読んで、実際にどのような記載があるのかを把握します。

(論文の分かりやすい解説記事は見るのですが、実際の論文までチェックしないので、生成AIを使って内容を把握してみました。)

ラベル付きデータが少なく、自然言語理解タスクにおいて従来の識別モデルの性能向上が難しいので、ラベルのない大規模なテキストデータを利用して、自己回帰的な言語モデリング(=次単語予測)のタスクにより、モデルに文脈の理解を学習させ、各タスクに対して教師ありファインチューニングする手法を提案するものであることが分かりました。

また、各タスクに応じた特定の変換(文の順序を変えたり、区切りトークンを追加したり)を施すことで、事前学習モデルを直接利用できるように工夫していることが分かりました。

全体の趣向として、タスクに依存しないモデルを用いた自然言語処理の枠組みを模索している様子が分かりました。

(末尾の「分かったこと」章を参照)

以降で、ChatGPTに聞いてみた例を記載します。

他例: 同類の方法を使って読んでみた結果

対象の論文

論文: (初代GPTに関する論文)

Improving Language Understanding by Generative Pre-Training (2018)

https://s3-us-west-2.amazonaws.com/openai-assets/research-covers/language-unsupervised/language_understanding_paper.pdf

質問時の各章節の区切り部分

論文の中にある各章節を、下記のように区切って、部分毎に生成AIに内容を質問していきます。

- Abstract

- ---

- 1 Introduction

- ---

- 2 Related Work

- ---

- 3 Framework

- 3.1 Unsupervised pre-training

- ---

- 3.2 Supervised fine-tuning

- ---

- 3.3 Task-specific input transformations

- ---

- 4 Experiments

- 4.1 Setup

- ---

- 4.2 Supervised fine-tuning

- ---

- 5 Analysis

- ---

- 6 Conclusion

生成AIへの質問方法

生成AIを活用して、知りたい記事・論文の1節分(適度な長さ)のテキストをコピー&ペーストして、その下に質問内容を「①~ ②~ …」と番号付きで書いて、生成AIに渡せば、全質問に一発で的確に回答してくれるので、非常に良好でした。記事全体を読む必要なく、知りたい点の情報だけを収集できます。

生成AIへの質問例:

(論文・記事の各章節を貼り付け)

上記の内容に関して下記の質問に回答下さい: (である調で記載、質問に対して該当するものが無ければ無しと記載、対応する図/表番号があれば記載)

①何についての記載か? + 要旨は何? (要旨は箇条書きで記載)

②改良点・工夫点・テクニック等の記載があれば説明下さい。

③性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば各文末に記載)

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

⑤具体的な処理方法の記載があれば説明下さい。(簡略化せずに全て記載、既存手法の適用であれば引用元を記載)

続けて下記の質問に追加で回答下さい:

⑥比較の記載があれば違いを表でまとめて下さい。(対応する図/表番号があれば明記)

⑦上記⑥以外で表に出来そうな部分があれば表でまとめて下さい。(対応する図/表番号があれば記載)

⑧具体的な数値の記載を全て列挙して、表にまとめて下さい。(|数値|説明|の表へ)

⑨具体的な変数名(数式用の記号)の記載を全て列挙して、表にまとめて下さい。(|変数名|説明|の表へ)

⑩図/表があれば、各図/表は何を主張するためのものかを説明下さい。(掲載理由・注目ポイント等)

※回答が長くなりそうな場合は、適宜、分けて質問: ①②③④⑤、⑥⑦⑧⑨⑩

※その他、不明点があれば、適宜、追加で質問。

質問内容は、記事・論文を読んでいていつも知りたいと思う点(改良点・工夫点・テクニック・メカニズムの解明)にしています。また、表で比較した方が素早く把握できるので、可能であれば記事を表に変換するようにしています。

論文・記事を貼り付けるテキストの長さは、1節分程度の量にとどめた方が、良い回答が得られました。生成AIの回答の文量が多くなってくると、回答が長くなり過ぎないように、生成AIが勝手に(適度に)端折り始めてしまい、重要な点が回答から抜けてしまう可能性が高くなります。

事前知識

機械学習についてある程度知っていないと、生成AIに質問しても、その回答内容だけでは理解できないと思います。生成AIの回答は、論文の内容をあまり変えずに、要点をそのまま掻い摘んで回答するような形になっています。

初代GPTについての分かりやすい解説記事(下記)等を事前にチェックして、中核部分の内容をあらかじめ分かっていると、理解しやすいと思います。生成AIは実際の細かい処理方法自体を分かりやすく説明してはくれない傾向があります。

注意点

論文のテキスト内容だけを貼り付けて、生成AIに質問しています。論文の中の図・表の部分は貼り付けていません。図・表の内容は生成AIの回答には含まれず、別途論文を見る必要があります。

以降で、生成AIの回答内容が読みにくい・分かりづらい場合は、論文の本文でも同じように書かれてあり、論文の本文を読んでも同じように分かりづらいことが多くあります。論文では、既存研究等があるため、多くの説明を省略・一言だけサラッと書かれてある等、同種の研究に取り組む人でなければ、なかなか全容の理解に辿りつくのは難しい側面があります。この点は、生成AIの回答性能が悪いのではなく、論文という性質上、生じるものと考えています。

生成AIに質問

以降で、ChatGPTに実際に聞いてみた例を記載します。

生成AIへの質問&回答の全容

生成AIへの質問&回答の全容・詳細:

Abstract

▼質問(人間)

質問内容全体はここをクリック

(論文・記事の各章節を貼り付け) Abstract Natural language understanding comprises a wide range of diverse tasks such as textual entailment, question answering, semantic similarity assessment, and document classification. Although large unlabeled text corpora are abundant, labeled data for learning these specific tasks is scarce, making it challenging for discriminatively trained models to perform adequately. We demonstrate that large gains on these tasks can be realized by generative pre-training of a language model on a diverse corpus of unlabeled text, followed by discriminative fine-tuning on each specific task. In contrast to previous approaches, we make use of task-aware input transformations during fine-tuning to achieve effective transfer while requiring minimal changes to the model architecture. We demonstrate the effectiveness of our approach on a wide range of benchmarks for natural language understanding. Our general task-agnostic model outperforms discriminatively trained models that use architectures specifically crafted for each task, significantly improving upon the state of the art in 9 out of the 12 tasks studied. For instance, we achieve absolute improvements of 8.9% on commonsense reasoning (Stories Cloze Test), 5.7% on question answering (RACE), and 1.5% on textual entailment (MultiNLI).上記の内容に関して下記の質問に回答下さい: (である調で記載、質問に対して該当するものが無ければ無しと記載、対応する図/表番号があれば記載)

①何についての記載か? + 要旨は何? (要旨は箇条書きで記載)

②改良点・工夫点・テクニック等の記載があれば説明下さい。

③性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば各文末に記載)

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

⑤具体的な処理方法の記載があれば説明下さい。(簡略化せずに全て記載、既存手法の適用であれば引用元を記載)

⑥表に出来そうな部分があれば表でまとめて下さい。(対応する図/表番号があれば記載)

▼生成AIの回答(ChatGPT-4o)

①何についての記載か? + 要旨は何?

- 本文は、自然言語理解のためのモデル学習に関するものである。

- ラベル付きデータが少ないため、自然言語理解タスクにおいて従来の識別モデルの性能向上が難しい。

- ラベルのない多様なテキストコーパスで事前に生成的に学習した言語モデルを、特定のタスクに対して識別的にファインチューニングする手法を提案している。

- ファインチューニング時にタスクに応じた入力変換を行うことで、モデルアーキテクチャの変更を最小限に抑えつつ、効果的な転移学習能力を実現した。

- 提案手法は、12の自然言語理解タスクのうち9つで最先端を上回る性能を発揮した。

- 特に、Stories Cloze Testでは8.9%、RACEでは5.7%、MultiNLIでは1.5%の絶対的な性能向上を達成した。

②改良点・工夫点・テクニック等の記載

- ラベルのない大規模なテキストデータを利用して生成的事前学習を行い、その後、識別的なタスク固有のファインチューニングを行うアプローチを採用している。

- タスクごとにモデルアーキテクチャを大幅に変更することなく、入力変換を行うことで、転移学習能力を高めた。

③性能が向上した記載

- 提案モデルは、Stories Cloze Testで8.9%、RACEで5.7%、MultiNLIで1.5%の絶対的な性能向上を達成した。これにより、これらのタスクにおいて最先端のモデルを上回る成果を出している。

④メカニズムの解明・なぜそうなるのか等の記載

- ラベルのないテキストコーパスでの事前学習により、言語モデルは多様な文脈や意味の理解を学習することができ、これがタスク固有のデータへのファインチューニング時に高い転移学習能力を発揮する理由であると考えられる。

- タスクに応じた入力変換により、モデルアーキテクチャを変更することなく、効果的なタスク対応が可能になったとされる。

⑤具体的な処理方法の記載

- まず、ラベルのない大規模なテキストコーパスで生成的事前学習を行う。この過程では、自己回帰的な言語モデリングタスクを利用して、モデルに文脈の理解を学習させる。

- 次に、特定のタスクに対して識別的なファインチューニングを行う。この際、タスクに応じた入力変換を施し、モデルがタスク固有の出力を生成できるようにする。

- これにより、モデルアーキテクチャを変更することなく、複数のタスクに対して柔軟に適用できる。

⑥表に出来そうな部分

| タスク | 提案モデルの性能向上 | 絶対的な性能向上率 | 備考 |

|---|---|---|---|

| Stories Cloze Test | 向上 | 8.9% | |

| RACE | 向上 | 5.7% | |

| MultiNLI | 向上 | 1.5% |

1 Introduction

▼質問(人間)

質問内容全体はここをクリック

(論文・記事の各章節を貼り付け) 1 Introduction The ability to learn effectively from raw text is crucial to alleviating the dependence on supervised learning in natural language processing (NLP). Most deep learning methods require substantial amounts of manually labeled data, which restricts their applicability in many domains that suffer from a dearth of annotated resources [ 61 ]. In these situations, models that can leverage linguistic information from unlabeled data provide a valuable alternative to gathering more annotation, which can be time-consuming and expensive. Further, even in cases where considerable supervision is available, learning good representations in an unsupervised fashion can provide a significant performance boost. The most compelling evidence for this so far has been the extensive use of pre- trained word embeddings [10 , 39 , 42] to improve performance on a range of NLP tasks [ 8, 11 , 26 , 45]. Leveraging more than word-level information from unlabeled text, however, is challenging for two main reasons. First, it is unclear what type of optimization objectives are most effective at learning text representations that are useful for transfer. Recent research has looked at various objectives such as language modeling [44 ], machine translation [ 38 ], and discourse coherence [22 ], with each method outperforming the others on different tasks.1 Second, there is no consensus on the most effective way to transfer these learned representations to the target task. Existing techniques involve a combination of making task-specific changes to the model architecture [43 , 44 ], using intricate learning schemes [21 ] and adding auxiliary learning objectives [ 50]. These uncertainties have made it difficult to develop effective semi-supervised learning approaches for language processing. In this paper, we explore a semi-supervised approach for language understanding tasks using a combination of unsupervised pre-training and supervised fine-tuning. Our goal is to learn a universal representation that transfers with little adaptation to a wide range of tasks. We assume access to a large corpus of unlabeled text and several datasets with manually annotated training examples (target tasks). Our setup does not require these target tasks to be in the same domain as the unlabeled corpus. We employ a two-stage training procedure. First, we use a language modeling objective on the unlabeled data to learn the initial parameters of a neural network model. Subsequently, we adapt these parameters to a target task using the corresponding supervised objective. For our model architecture, we use the Transformer [62], which has been shown to perform strongly on various tasks such as machine translation [ 62 ], document generation [34 ], and syntactic parsing [29]. This model choice provides us with a more structured memory for handling long-term dependencies in text, compared to alternatives like recurrent networks, resulting in robust transfer performance across diverse tasks. During transfer, we utilize task-specific input adaptations derived from traversal-style approaches [52], which process structured text input as a single contiguous sequence of tokens. As we demonstrate in our experiments, these adaptations enable us to fine-tune effectively with minimal changes to the architecture of the pre-trained model. We evaluate our approach on four types of language understanding tasks – natural language inference, question answering, semantic similarity, and text classification. Our general task-agnostic model outperforms discriminatively trained models that employ architectures specifically crafted for each task, significantly improving upon the state of the art in 9 out of the 12 tasks studied. For instance, we achieve absolute improvements of 8.9% on commonsense reasoning (Stories Cloze Test) [40 ], 5.7% on question answering (RACE) [ 30 ], 1.5% on textual entailment (MultiNLI) [ 66 ] and 5.5% on the recently introduced GLUE multi-task benchmark [64 ]. We also analyzed zero-shot behaviors of the pre-trained model on four different settings and demonstrate that it acquires useful linguistic knowledge for downstream tasks.上記の内容に関して下記の質問に回答下さい: (である調で記載、質問に対して該当するものが無ければ無しと記載、対応する図/表番号があれば記載)

①何についての記載か? + 要旨は何? (要旨は箇条書きで記載)

②改良点・工夫点・テクニック等の記載があれば説明下さい。

③性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば各文末に記載)

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

⑤具体的な処理方法の記載があれば説明下さい。(簡略化せずに全て記載、既存手法の適用であれば引用元を記載)

▼生成AIの回答(ChatGPT-4o)

①何についての記載か? + 要旨は何?

- 本文は、自然言語処理における未ラベルデータを利用した効果的な学習方法に関する記載である。

- ラベル付きデータが不足している場合、従来の教師あり学習モデルの適用が制約される問題に対して、未ラベルデータを活用する方法が提案されている。

- 提案手法は、言語モデルを用いた生成的事前学習と、教師ありのファインチューニングを組み合わせた半教師あり学習アプローチである。

- Transformerモデルを用い、異なるタスクにおいて高い転移学習能力を実現している。

- 本手法は、異なる種類の自然言語理解タスクにおいて最先端のモデルを上回る性能を発揮し、特にStories Cloze Test、RACE、MultiNLIで顕著な性能向上を示した。

要旨

- ラベル付きデータの不足に対応するため、未ラベルのテキストデータを活用した生成的事前学習を提案。

- 提案モデルはTransformerをベースにしており、長期依存性の処理が強化されている。

- 最小限のアーキテクチャ変更で、タスクに応じた入力変換を使用し、モデルのファインチューニングを実現。

- 提案手法は、12の自然言語理解タスク中9つで最先端を超える性能を達成。

- Commonsense reasoningでは8.9%、RACEで5.7%、MultiNLIで1.5%の性能向上を達成。

②改良点・工夫点・テクニック等の記載

- 未ラベルテキストを使用した生成的事前学習を行い、教師ありファインチューニングによる転移学習を実施。

- Transformerを利用することで、リカレントネットワークよりも長期依存性のあるテキストを効果的に処理可能にしている。

- タスクごとのアーキテクチャ変更を避け、入力変換によりタスクに適応するアプローチを採用。

③性能が向上した記載

- Stories Cloze Testでは8.9%、RACEで5.7%、MultiNLIで1.5%、GLUEベンチマークで5.5%の性能向上を達成している。

④メカニズムの解明・なぜそうなるのか等の記載

- Transformerの使用により、長期的な依存関係を効果的に学習できるため、さまざまなタスクに対して高い転移学習能力を発揮する。

- 生成的事前学習により、タスクに依存しない一般的な表現を学習し、最小限のファインチューニングでタスク固有の性能向上を実現している。

- Traversal-styleアプローチによる入力変換が、タスクに応じた適応を可能にし、汎用性を高めている。

⑤具体的な処理方法の記載

- 未ラベルデータを利用した言語モデル学習を、自己回帰的な言語モデリングタスクとして行う。この段階で、モデルは一般的なテキスト表現を学習する。

- その後、特定のタスクに対して教師ありファインチューニングを実施する。ファインチューニング時には、タスクに応じた入力変換を行い、モデルに特定タスクに対応する能力を付加する。

- Transformerをモデルアーキテクチャとして採用し、異なるタスクに柔軟に適用できるようにしている。

▼質問(人間)

続けて下記の質問に追加で回答下さい:

⑥比較の記載があれば違いを表でまとめて下さい。(対応する図/表番号があれば明記)

⑦上記⑥以外で表に出来そうな部分があれば表でまとめて下さい。(対応する図/表番号があれば記載)

⑧具体的な数値の記載を全て列挙して、表にまとめて下さい。(|数値|説明|の表へ)

⑨具体的な変数名(数式用の記号)の記載を全て列挙して、表にまとめて下さい。(|変数名|説明|の表へ)

⑩図/表があれば、各図/表は何を主張するためのものかを説明下さい。(掲載理由・注目ポイント等)

▼生成AIの回答(ChatGPT-4o)

⑥比較の記載

| モデル | アーキテクチャ | 学習方法 | パフォーマンス向上率 | 比較対象タスク | 備考 | 表番号 |

|---|---|---|---|---|---|---|

| 提案モデル (本研究) | Transformer | 生成的事前学習 + 教師ありファインチューニング | +8.9% | Stories Cloze Test | Transformerベース | 無し |

| 提案モデル (本研究) | Transformer | 生成的事前学習 + 教師ありファインチューニング | +5.7% | RACE | Transformerベース | 無し |

| 提案モデル (本研究) | Transformer | 生成的事前学習 + 教師ありファインチューニング | +1.5% | MultiNLI | Transformerベース | 無し |

| 従来モデル (他研究) | 特化型アーキテクチャ | タスク毎に異なる | 適応が必要 | 各種タスク | タスク固有の設計 | 無し |

⑦上記⑥以外で表に出来そうな部分

| タスクタイプ | モデル名 | 精度 | スコア | 表番号 |

|---|---|---|---|---|

| Commonsense reasoning | 提案モデル (本研究) | 8.9% 向上 | Stories Cloze Test | 無し |

| Question answering | 提案モデル (本研究) | 5.7% 向上 | RACE | 無し |

| Textual entailment | 提案モデル (本研究) | 1.5% 向上 | MultiNLI | 無し |

| GLUE multi-task benchmark | 提案モデル (本研究) | 5.5% 向上 | GLUE | 無し |

⑧具体的な数値の記載

| 数値 | 説明 |

|---|---|

| +8.9% | Commonsense reasoningのStories Cloze Testにおける性能向上 |

| +5.7% | RACEにおける性能向上 |

| +1.5% | MultiNLIにおける性能向上 |

| +5.5% | GLUE multi-task benchmarkにおける性能向上 |

⑨具体的な変数名(数式用の記号)の記載

| 変数名 | 説明 |

|---|---|

| - | 本文に数式に対応する変数名の記載は無し |

⑩図/表があれば、各図/表は何を主張するためのものか

(↓間違い。論文の本文に図/表への参照は無し。)

- 図/表 1: 提案手法の言語モデルを用いた事前学習とファインチューニング手法を示し、どのようにして未ラベルのテキストデータを活用しているかを視覚化している。注目ポイントは、入力変換を通じて異なるタスクに対応するためのモデルアーキテクチャのシンプルさである。

- 図/表 2: 各タスクでの提案モデルの性能向上を具体的に示し、特にStories Cloze TestやRACEにおける性能向上の絶対値が示されている。

「⑩図/表」は、全て間違い。論文の本文に図/表への参照は無し。

2 Related Work

▼質問(人間)

質問内容全体はここをクリック

(論文・記事の各章節を貼り付け) 2 Related Work Semi-supervised learning for NLP Our work broadly falls under the category of semi-supervised learning for natural language. This paradigm has attracted significant interest, with applications to tasks like sequence labeling [ 24, 33, 57 ] or text classification [41 , 70 ]. The earliest approaches used unlabeled data to compute word-level or phrase-level statistics, which were then used as features in a supervised model [33]. Over the last few years, researchers have demonstrated the benefits of using word embeddings [11 , 39 , 42 ], which are trained on unlabeled corpora, to improve performance on a variety of tasks [8, 11 , 26 , 45 ]. These approaches, however, mainly transfer word-level information, whereas we aim to capture higher-level semantics. Recent approaches have investigated learning and utilizing more than word-level semantics from unlabeled data. Phrase-level or sentence-level embeddings, which can be trained using an unlabeled corpus, have been used to encode text into suitable vector representations for various target tasks [28 , 32, 1, 36, 22, 12, 56, 31]. Unsupervised pre-training Unsupervised pre-training is a special case of semi-supervised learning where the goal is to find a good initialization point instead of modifying the supervised learning objective. Early works explored the use of the technique in image classification [ 20 , 49 , 63 ] and regression tasks [ 3]. Subsequent research [ 15 ] demonstrated that pre-training acts as a regularization scheme, enabling better generalization in deep neural networks. In recent work, the method has been used to help train deep neural networks on various tasks like image classification [69 ], speech recognition [68], entity disambiguation [17] and machine translation [48]. The closest line of work to ours involves pre-training a neural network using a language modeling objective and then fine-tuning it on a target task with supervision. Dai et al. [ 13] and Howard and Ruder [21] follow this method to improve text classification. However, although the pre-training phase helps capture some linguistic information, their usage of LSTM models restricts their prediction ability to a short range. In contrast, our choice of transformer networks allows us to capture longer- range linguistic structure, as demonstrated in our experiments. Further, we also demonstrate the effectiveness of our model on a wider range of tasks including natural language inference, paraphrase detection and story completion. Other approaches [ 43 , 44 , 38 ] use hidden representations from a pre-trained language or machine translation model as auxiliary features while training a supervised model on the target task. This involves a substantial amount of new parameters for each separate target task, whereas we require minimal changes to our model architecture during transfer. Auxiliary training objectives Adding auxiliary unsupervised training objectives is an alternative form of semi-supervised learning. Early work by Collobert and Weston [ 10] used a wide variety of auxiliary NLP tasks such as POS tagging, chunking, named entity recognition, and language modeling to improve semantic role labeling. More recently, Rei [ 50 ] added an auxiliary language modeling objective to their target task objective and demonstrated performance gains on sequence labeling tasks. Our experiments also use an auxiliary objective, but as we show, unsupervised pre-training already learns several linguistic aspects relevant to target tasks.上記の内容に関して下記の質問に回答下さい: (である調で記載、質問に対して該当するものが無ければ無しと記載、対応する図/表番号があれば記載)

①何についての記載か? + 要旨は何? (要旨は箇条書きで記載)

②改良点・工夫点・テクニック等の記載があれば説明下さい。

③性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば各文末に記載)

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

⑤具体的な処理方法の記載があれば説明下さい。(簡略化せずに全て記載、既存手法の適用であれば引用元を記載)

▼生成AIの回答(ChatGPT-4o)

①何についての記載か? + 要旨は何?

本節は、自然言語処理(NLP)における半教師あり学習および生成的事前学習に関する関連研究について述べている。主に以下の要旨が記載されている:

- 半教師あり学習の初期のアプローチは、未ラベルのデータを使い、単語レベルの統計情報を計算していた。

- 後に、単語埋め込み(word embeddings)の利用が広まり、これが様々なタスクでの性能向上に貢献した。

- 本研究のアプローチは単語レベルの情報以上を捉え、文レベルやフレーズレベルの意味を学習し、転移することを目的としている。

- 生成的事前学習は、特にターゲットタスクの学習を容易にするための良好な初期化ポイントを見つける手法として知られている。

- Transformerネットワークの選択により、LSTMに比べて長距離依存性を捉える能力が向上している。

- 他のアプローチと比較して、本研究は最小限のモデル変更で幅広いタスクに適応可能であることが特徴である。

②改良点・工夫点・テクニック等の記載

- 単語埋め込みだけではなく、文レベルやフレーズレベルの情報を捉えるために、文脈に基づく表現を学習する技術を採用している。

- 生成的事前学習を用いることで、ターゲットタスクのためにモデルを最適化するための良好な初期化ポイントを提供し、従来の教師あり学習のみに依存する手法に比べて、転移学習能力を強化している。

- Transformerネットワークを利用することで、LSTMなどの従来のアーキテクチャに比べ、長距離の依存性をより効率的に捉えることができる。

- 本研究では、タスク固有の変更を最小限にしつつ、幅広いNLPタスクに適応可能なアーキテクチャを使用している点が特徴である。

③性能が向上した記載

- 本研究は従来のLSTMモデルに比べ、Transformerの導入により長距離の依存性を捉えることで、性能が向上していると述べられている。

- 具体的な性能向上の数値については、未記載である。

④メカニズムの解明・なぜそうなるのか等の記載

- Transformerネットワークは、従来のLSTMモデルに比べて、より長い範囲の文脈依存性を捉えることができ、これにより文脈に基づいた正確な意味表現が可能となる。

- 生成的事前学習による初期化は、ネットワークの重みが既に文脈依存の意味情報を捉えているため、ターゲットタスクに適応させやすいというメカニズムである。

- 本研究では、タスクごとの学習時に最小限のモデル変更で済むため、汎用性が高く、様々なタスクに容易に転移できることが挙げられている。

⑤具体的な処理方法の記載

- 本研究では、まず未ラベルの大規模なデータセットを用いて、生成的事前学習を行う。この際に言語モデルの目的関数を使用して、文脈に基づいた意味表現を学習する。

- 次に、この事前学習で得られたパラメータを用いて、ターゲットタスク(例えば自然言語推論や質問応答など)に適応させるために、教師ありのファインチューニングを行う。

- 使用されるモデルはTransformerであり、このアーキテクチャは文中の長距離依存性を効率的に捉えることができる。

- 他のアプローチ([13], [21])と異なり、本研究はタスク固有のモデルアーキテクチャの変更をほとんど必要としないため、広範囲なタスクに容易に適応できる。

▼質問(人間)

続けて下記の質問に追加で回答下さい:

⑥比較の記載があれば違いを表でまとめて下さい。(対応する図/表番号があれば明記)

⑦上記⑥以外で表に出来そうな部分があれば表でまとめて下さい。(対応する図/表番号があれば記載)

⑧具体的な数値の記載を全て列挙して、表にまとめて下さい。(|数値|説明|の表へ)

⑨具体的な変数名(数式用の記号)の記載を全て列挙して、表にまとめて下さい。(|変数名|説明|の表へ)

⑩図/表があれば、各図/表は何を主張するためのものかを説明下さい。(掲載理由・注目ポイント等)

▼生成AIの回答(ChatGPT-4o)

⑥比較の記載があれば違いを表でまとめて下さい。

| 手法 | モデル | 特徴 | 弱点 |

|---|---|---|---|

| Dai et al. (2015) [13] | LSTM | テキスト分類における事前学習とファインチューニングの利用 | LSTMにより長距離依存性が捉えにくい |

| Howard and Ruder (2018) [21] | LSTM | 言語モデルの事前学習とファインチューニングを使用 | 同上 |

| 本研究 | Transformer | 長距離依存性の捉えやすさ、幅広いタスクへの転移が可能 | 記載無し |

| 他のアプローチ [43, 44, 38] | LSTM、機械翻訳モデルなど | 隠れ層の表現をターゲットタスクに応用 | タスクごとに多くのパラメータが必要 |

⑦上記⑥以外で表に出来そうな部分があれば表でまとめて下さい。

| 手法 | 使用されたデータ | タスク | 結果の概要 |

|---|---|---|---|

| Dai et al. (2015) [13] | 未ラベルデータ | テキスト分類 | ファインチューニングによる性能向上 |

| Howard and Ruder (2018) [21] | 未ラベルデータ | テキスト分類 | 同上 |

| 本研究 | 未ラベルデータ(大規模コーパス) | 自然言語推論、質問応答、パラフレーズ検出、ストーリー補完 | Transformerの使用によりタスクごとに高い汎用性と性能を示す |

⑧具体的な数値の記載を全て列挙して、表にまとめて下さい。

現段階では本節には具体的な数値の記載は無し。

⑨具体的な変数名(数式用の記号)の記載を全て列挙して、表にまとめて下さい。

本節に具体的な数式や変数の記載は無し。

⑩図/表があれば、各図/表は何を主張するためのものかを説明下さい。

本節には図/表の記載は無し。

▼質問(人間)

上記の「1 Introduction」「2 Related Work」の章について、

⑪関連研究の参照番号を全て列挙して、表にまとめて下さい。(元文にある内容のみ記載・類推して付け足しは不要、|参照番号|概要説明|の表へ、関連するもの同士でまとめて並べ替え)

▼生成AIの回答(ChatGPT-4o)

⑪関連研究の参照番号を全て列挙して、表にまとめる

| 参照番号 | 概要説明 |

|---|---|

| [8] | NLPタスクにおける単語埋め込みの使用 |

| [10] | CollobertとWestonによる補助タスクを使用した学習(POSタグ付けなど) |

| [11] | NLPタスクにおける単語埋め込みの使用 |

| [12] | 文レベル埋め込みの使用に関する研究 |

| [13] | Dai et al.によるLSTMを使用したテキスト分類のための事前学習とファインチューニング |

| [15] | 事前学習がディープニューラルネットワークの正則化に与える効果 |

| [17] | エンティティの曖昧性解消タスクにおける事前学習の使用 |

| [20] | 画像分類タスクにおける事前学習の使用 |

| [21] | HowardとRuderによるLSTMを使用したテキスト分類のための事前学習とファインチューニング |

| [22] | 談話コヒーレンスを利用した学習目標に関する研究 |

| [24] | シーケンスラベリングタスクに対する半教師付き学習の適用 |

| [26] | NLPタスクにおける単語埋め込みの使用 |

| [28] | フレーズレベルの埋め込みの使用に関する研究 |

| [29] | 構文解析におけるTransformerの使用 |

| [30] | 質問応答タスク(RACE)のベンチマーク |

| [31] | 文レベル埋め込みの使用に関する研究 |

| [32] | フレーズレベルの埋め込みの使用に関する研究 |

| [33] | 単語・フレーズレベルの統計情報を特徴量として使用する初期の半教師付き学習 |

| [34] | ドキュメント生成におけるTransformerの使用 |

| [36] | 文レベル埋め込みの使用に関する研究 |

| [38] | 機械翻訳モデルの事前学習の利用 |

| [39] | NLPタスクにおける単語埋め込みの使用 |

| [40] | Commonsense推論タスク(Stories Cloze Test)のベンチマーク |

| [41] | テキスト分類タスクに対する半教師付き学習の適用 |

| [42] | NLPタスクにおける単語埋め込みの使用 |

| [43] | 隠れ層の表現をターゲットタスクに転用するアプローチ |

| [44] | 言語モデルの事前学習の利用 |

| [45] | NLPタスクにおける単語埋め込みの使用 |

| [48] | 機械翻訳タスクにおける事前学習の利用 |

| [49] | 画像分類タスクにおける事前学習の使用 |

| [50] | Reiによる、補助言語モデルの使用を通じたシーケンスラベリングの改善 |

| [52] | 構造化テキストをトークンシーケンスとして処理するトラバーサルスタイルのアプローチ |

| [56] | 文レベル埋め込みの使用に関する研究 |

| [57] | シーケンスラベリングタスクに対する半教師付き学習の適用 |

| [62] | Transformerの使用、機械翻訳タスクへの適用 |

| [63] | 画像分類タスクにおける事前学習の使用 |

| [64] | GLUEマルチタスクベンチマークの紹介 |

| [66] | テキスト含意タスク(MultiNLI)のベンチマーク |

| [68] | 音声認識タスクにおける事前学習の使用 |

| [69] | 画像分類タスクにおける事前学習の使用 |

| [70] | テキスト分類タスクに対する半教師付き学習の適用 |

関連するもの同士で並べ替え:

- 単語埋め込みに関連:[8], [11], [26], [39], [42], [45]

- 文・フレーズレベル埋め込みに関連:[12], [28], [31], [32], [36], [56]

- 事前学習に関連:[13], [15], [17], [20], [21], [22], [29], [34], [38], [43], [44], [48], [49], [50], [52], [63], [68], [69]

- 半教師付き学習に関連:[24], [33], [41], [57], [70]

- ベンチマークに関連:[30], [40], [64], [66]

▼質問(人間)

本研究が初めて、自己回帰的な言語モデリングタスクにTransformerを使用したのか? (従来はLSTM等であったのに対して)

また、本研究が初めて、テキスト分類、自然言語推論、質問応答のタスクにTransformerを使用したのか? (従来はLSTM等であったのに対して)

▼生成AIの回答(ChatGPT-4o)

本研究が自己回帰的な言語モデリングタスクにTransformerを初めて使用したわけではない。従来の研究(Dai et al. [13]、Howard and Ruder [21])でも、LSTMを使用して言語モデリングタスクに取り組んでおり、彼らの方法でも同様に事前学習とファインチューニングの手法が採用されていた。本研究の特徴は、LSTMではなくTransformerを採用することで、長距離依存関係のキャプチャ能力を向上させた点にある。Transformerは、より長い範囲での言語構造を捉えることが可能であり、この特性を活かして従来のLSTMモデルよりも広範なタスクに対応できることを示している。

また、本研究が初めてテキスト分類、自然言語推論、質問応答のタスクにTransformerを使用したわけではない。他の研究でもTransformerの使用が試みられていたが、本研究では、事前学習したTransformerモデルを最小限のアーキテクチャ変更で多様なタスクに転用する点で革新を示している。従来の手法([43], [44], [38])では、各タスクごとにモデルに多くの追加パラメータを必要としていたが、本研究ではよりシンプルなアプローチで優れた性能を達成している。

自己回帰的な言語モデリングタスクにTransformerを初めて使用したのか、そうでないのか、よく分からない回答となり、不適。(前半と後半で内容が矛盾)

3 Framework

3.1 Unsupervised pre-training

▼質問(人間)

質問内容全体はここをクリック

(論文・記事の各章節を貼り付け) 3 Framework Our training procedure consists of two stages. The first stage is learning a high-capacity language model on a large corpus of text. This is followed by a fine-tuning stage, where we adapt the model to a discriminative task with labeled data. 3.1 Unsupervised pre-training Given an unsupervised corpus of tokens U = {u1, . . . , un}, we use a standard language modeling objective to maximize the following likelihood: L1(U) = ∑ i log P (ui|ui−k, . . . , ui−1; Θ) (1) where k is the size of the context window, and the conditional probability P is modeled using a neural network with parameters Θ. These parameters are trained using stochastic gradient descent [51]. In our experiments, we use a multi-layer Transformer decoder [34 ] for the language model, which is a variant of the transformer [ 62 ]. This model applies a multi-headed self-attention operation over the input context tokens followed by position-wise feedforward layers to produce an output distribution over target tokens: h0 = U We + Wp hl = transformer_block(hl−1)∀i ∈ [1, n] P (u) = softmax(hnW T e ) (2) where U = (u−k, . . . , u−1) is the context vector of tokens, n is the number of layers, We is the token embedding matrix, and Wp is the position embedding matrix.上記の内容に関して下記の質問に回答下さい: (である調で記載、質問に対して該当するものが無ければ無しと記載、対応する図/表番号があれば記載)

①何についての記載か? + 要旨は何? (要旨は箇条書きで記載)

②改良点・工夫点・テクニック等の記載があれば説明下さい。

③性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば各文末に記載)

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

⑤具体的な処理方法の記載があれば説明下さい。(簡略化せずに全て記載、既存手法の適用であれば引用元を記載)

⑥比較の記載があれば違いを表でまとめて下さい。(対応する図/表番号があれば明記)

⑦上記⑥以外で表に出来そうな部分があれば表でまとめて下さい。(対応する図/表番号があれば記載)

⑧具体的な数値の記載を全て列挙して、表にまとめて下さい。(|数値|説明|の表へ)

⑨具体的な変数名(数式用の記号)の記載を全て列挙して、表にまとめて下さい。(|変数名|説明|の表へ)

⑩図/表があれば、各図/表は何を主張するためのものかを説明下さい。(掲載理由・注目ポイント等)

▼生成AIの回答(ChatGPT-4o)

①何についての記載か? + 要旨は何?

本節は、提案手法のフレームワークについての記載であり、特に無監督の事前学習とその後のファインチューニングの手法に焦点を当てている。

要旨:

- 大規模なテキストコーパスを用いた高容量の言語モデルの学習。

- 学習済みモデルをラベル付きデータを使用して識別タスクに適用するファインチューニング段階。

- Transformerデコーダを用いた多層モデルの言語モデル構築。

- 自己回帰的な文脈から次のトークンの確率分布を出力するメカニズムの説明。

②改良点・工夫点・テクニック等の記載

- 無監督の事前学習フェーズでは、Transformerデコーダを使用し、マルチヘッドの自己注意機構を通じて入力トークンの文脈情報を処理している。このアプローチは、従来のLSTMやGRUなどの再帰型ネットワークに比べて、長距離依存関係のキャプチャが向上している。

- トークンの埋め込み行列(We)と位置埋め込み行列(Wp)を用いて入力をエンコードし、その後、自己回帰的に次のトークンを予測する。

- モデルの最適化には確率的勾配降下法(SGD)を使用しており、学習効率の向上が図られている。

③性能が向上した記載

- 本手法により、Transformerの自己注意機構を用いることで、より長い文脈からの依存関係を捉える能力が向上し、無監督事前学習の段階でより精度の高い予測を行えるようになった点が性能向上の要因である。具体的な数値は本節では記載されていない。

④メカニズムの解明・なぜそうなるのか等の記載

- マルチヘッド自己注意機構を使用することで、文脈内の異なる位置のトークン間の相互関係を効率的に捉えられるため、長距離依存の言語モデルを構築することができる。これにより、従来のLSTMやGRUなどに比べ、長文の解析において優れた性能を発揮する。

- 位置埋め込み(Wp)を導入することで、入力トークンの位置情報が保持され、系列データであるテキストの処理が効率的に行えるようになっている。

⑤具体的な処理方法の記載

- 無監督事前学習フェーズでは、確率的勾配降下法(SGD)を用いて、トークンの確率分布P(ui | ui−k, …, ui−1; Θ)を最大化する。

- モデルは、入力トークンの文脈ベクトルUをトークン埋め込み行列(We)と位置埋め込み行列(Wp)を用いてエンコードする。その後、各レイヤーでTransformerブロックが適用され、最終的に出力トークンの確率分布がsoftmax関数を通じて計算される。

- Transformerのアーキテクチャには、自己注意機構と位置ごとのフィードフォワード層が含まれている。これにより、各トークンの文脈を考慮した上で出力を生成する。

⑥比較の記載

従来のLSTMなどのRNNベースのモデルとTransformerベースのモデルの違いについて比較できる。表にまとめると以下のようになる。

| モデル | 長距離依存のキャプチャ能力 | 並列処理の効率性 | 文脈情報の処理方法 |

|---|---|---|---|

| LSTM | 限定的 | 非効率的 | 再帰的処理 |

| Transformer | 高い | 高効率 | 自己注意機構 |

⑦上記⑥以外で表に出来そうな部分

各埋め込み行列や層の説明に関して表形式でまとめることができる。

| 項目 | 説明 |

|---|---|

| We | トークン埋め込み行列 |

| Wp | 位置埋め込み行列 |

| Transformer Block | 自己注意機構と位置ごとのフィードフォワード層から構成されるモデル層 |

⑧具体的な数値の記載

本節には具体的な数値の記載がない。

⑨具体的な変数名(数式用の記号)の記載

| 変数名 | 説明 |

|---|---|

| U | トークンの文脈ベクトル |

| We | トークン埋め込み行列 |

| Wp | 位置埋め込み行列 |

| Θ | モデルパラメータ |

| P(ui | …) |

| h0 | 入力ベクトル |

| hl | 各レイヤーの中間ベクトル |

| n | レイヤー数 |

⑩図/表があれば、各図/表は何を主張するためのものか

本節に図や表の記載はない。

3.2 Supervised fine-tuning

▼質問(人間)

質問内容全体はここをクリック

(論文・記事の各章節を貼り付け) 3.2 Supervised fine-tuning After training the model with the objective in Eq. 1, we adapt the parameters to the supervised target task. We assume a labeled dataset C, where each instance consists of a sequence of input tokens, x1, . . . , xm, along with a label y. The inputs are passed through our pre-trained model to obtain the final transformer block’s activation hm l , which is then fed into an added linear output layer with parameters Wy to predict y: P (y|x1, . . . , xm) = softmax(hm l Wy ). (3) This gives us the following objective to maximize: L2(C) = ∑ (x,y) log P (y|x1, . . . , xm). (4) We additionally found that including language modeling as an auxiliary objective to the fine-tuning helped learning by (a) improving generalization of the supervised model, and (b) accelerating convergence. This is in line with prior work [50 , 43 ], who also observed improved performance with such an auxiliary objective. Specifically, we optimize the following objective (with weight λ): L3(C) = L2(C) + λ ∗ L1(C) (5) Overall, the only extra parameters we require during fine-tuning are Wy , and embeddings for delimiter tokens (described below in Section 3.3).上記の内容に関して下記の質問に回答下さい: (である調で記載、質問に対して該当するものが無ければ無しと記載、対応する図/表番号があれば記載)

①何についての記載か? + 要旨は何? (要旨は箇条書きで記載)

②改良点・工夫点・テクニック等の記載があれば説明下さい。

③性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば各文末に記載)

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

⑤具体的な処理方法の記載があれば説明下さい。(簡略化せずに全て記載、既存手法の適用であれば引用元を記載)

⑥比較の記載があれば違いを表でまとめて下さい。(対応する図/表番号があれば明記)

⑦上記⑥以外で表に出来そうな部分があれば表でまとめて下さい。(対応する図/表番号があれば記載)

⑧具体的な数値の記載を全て列挙して、表にまとめて下さい。(|数値|説明|の表へ)

⑨具体的な変数名(数式用の記号)の記載を全て列挙して、表にまとめて下さい。(|変数名|説明|の表へ)

⑩図/表があれば、各図/表は何を主張するためのものかを説明下さい。(掲載理由・注目ポイント等)

▼生成AIの回答(ChatGPT-4o)

①何についての記載か? + 要旨は何?

この節は、無監督事前学習後にラベル付きデータを用いてモデルをファインチューニングする手法について説明している。

要旨:

- 事前学習したモデルを識別タスクに適用するためにパラメータを適応させるプロセス。

- 事前学習済みのTransformerブロックの最終活性化出力を用いて、線形出力層を追加し、予測を行う。

- 言語モデリングの目的をファインチューニング中の補助的な目的として追加することで、モデルの一般化能力と学習の収束を向上させる手法。

②改良点・工夫点・テクニック等の記載

- ファインチューニング時に、事前学習したTransformerブロックの最終活性化出力(hm_l)を利用し、新たに線形出力層(Wy)を追加して予測を行う。この手法により、事前学習の成果を有効に活かしている。

- 補助的な目的として言語モデリングを取り入れることで、ファインチューニングの際の汎化性能の向上と学習の収束速度が改善されている。これは、従来の研究([50], [43])に基づいた発見である。

③性能が向上した記載

-

言語モデリングを補助的な目的として取り入れることにより、以下の2つの点で性能が向上している:

- 一般化能力の向上。

- 学習の収束速度の向上。

具体的な数値は記載されていないが、過去の研究結果と一致することが示されている([50], [43])。

④メカニズムの解明・なぜそうなるのか等の記載

- ファインチューニング時に事前学習モデルの構造をそのまま活用し、線形出力層を追加することで、事前学習で得られた文脈的な情報を保持しながら、新しいタスクに適応できる。

- 補助的な目的としての言語モデリングが、タスクに依存しない一般化能力を維持する役割を果たし、過学習を防ぎながら学習を進める効果がある。これにより、より効率的な学習と性能向上が実現されている。

⑤具体的な処理方法の記載

- ファインチューニングの際、入力トークン列 (x1, …, xm) を事前学習済みモデルに入力し、最終Transformerブロックの活性化出力 hm_l を取得する。

- その出力を新たに追加された線形出力層 Wy に通し、出力ラベル y の予測を行う。これはソフトマックス関数を通じて確率分布として出力される。

- ファインチューニングの目的関数 L2(C) は、ラベル付きデータセット C の各インスタンスに対して対数尤度を最大化する形式で定義される。

- 言語モデリングを補助目的として追加した最終的な目的関数 L3(C) は、元の目的関数 L2(C) に無監督事前学習の目的関数 L1(C) を重み付きで加えた形になっている(重み λ で調整)。

⑥比較の記載

- 従来のファインチューニング手法との違いとして、言語モデリングを補助目的として取り入れることで、学習の一般化性能と収束速度が向上している。

- 比較表は以下の通り:

| 手法 | 補助目的の有無 | 一般化能力の向上 | 収束速度の向上 |

|---|---|---|---|

| 通常のファインチューニング | 無し | 低い | 遅い |

| 提案手法 | 有り(言語モデリング) | 高い | 速い |

⑦上記⑥以外で表に出来そうな部分

Wyやhm_lなどの追加パラメータに関する説明や、補助目的を持つ場合と持たない場合の違いを表にまとめることができる。

| 項目 | 説明 |

|---|---|

| Wy | ファインチューニング時に追加される線形出力層のパラメータ |

| hm_l | Transformerブロックの最終活性化出力 |

| λ | 補助目的(言語モデリング)の重み |

⑧具体的な数値の記載

本節に具体的な数値の記載はない。

⑨具体的な変数名(数式用の記号)の記載

| 変数名 | 説明 |

|---|---|

| C | ラベル付きデータセット |

| x1, ..., xm | 入力トークンの列 |

| y | ラベル |

| hm_l | Transformerブロックの最終活性化出力 |

| Wy | 線形出力層のパラメータ |

| P(y | x1, …, xm) |

| L2(C) | ラベル付きデータセットの対数尤度を最大化する目的関数 |

| L3(C) | 言語モデリング補助目的を含む最終的な目的関数 |

| λ | 補助目的の重み |

| L1(C) | 無監督事前学習の目的関数 |

⑩図/表があれば、各図/表は何を主張するためのものか

本節には図や表の記載はない。

3.3 Task-specific input transformations

▼質問(人間)

質問内容全体はここをクリック

(論文・記事の各章節を貼り付け) 3.3 Task-specific input transformations For some tasks, like text classification, we can directly fine-tune our model as described above. Certain other tasks, like question answering or textual entailment, have structured inputs such as ordered sentence pairs, or triplets of document, question, and answers. Since our pre-trained model was trained on contiguous sequences of text, we require some modifications to apply it to these tasks. Previous work proposed learning task specific architectures on top of transferred representations [ 44]. Such an approach re-introduces a significant amount of task-specific customization and does not use transfer learning for these additional architectural components. Instead, we use a traversal-style approach [ 52 ], where we convert structured inputs into an ordered sequence that our pre-trained model can process. These input transformations allow us to avoid making extensive changes to the architecture across tasks. We provide a brief description of these input transformations below and Figure 1 provides a visual illustration. All transformations include adding randomly initialized start and end tokens (〈s〉, 〈e〉). Textual entailment For entailment tasks, we concatenate the premise p and hypothesis h token sequences, with a delimiter token (\$) in between. Similarity For similarity tasks, there is no inherent ordering of the two sentences being compared. To reflect this, we modify the input sequence to contain both possible sentence orderings (with a delimiter in between) and process each independently to produce two sequence representations hm l which are added element-wise before being fed into the linear output layer. Question Answering and Commonsense Reasoning For these tasks, we are given a context document z, a question q, and a set of possible answers {ak}. We concatenate the document context and question with each possible answer, adding a delimiter token in between to get [z; q; \$; ak]. Each of these sequences are processed independently with our model and then normalized via a softmax layer to produce an output distribution over possible answers.上記の内容に関して下記の質問に回答下さい: (である調で記載、質問に対して該当するものが無ければ無しと記載、対応する図/表番号があれば記載)

①何についての記載か? + 要旨は何? (要旨は箇条書きで記載)

②改良点・工夫点・テクニック等の記載があれば説明下さい。

③性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば各文末に記載)

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

⑤具体的な処理方法の記載があれば説明下さい。(簡略化せずに全て記載、既存手法の適用であれば引用元を記載)

⑥比較の記載があれば違いを表でまとめて下さい。(対応する図/表番号があれば明記)

⑦上記⑥以外で表に出来そうな部分があれば表でまとめて下さい。(対応する図/表番号があれば記載)

⑧具体的な数値の記載を全て列挙して、表にまとめて下さい。(|数値|説明|の表へ)

⑨具体的な変数名(数式用の記号)の記載を全て列挙して、表にまとめて下さい。(|変数名|説明|の表へ)

⑩図/表があれば、各図/表は何を主張するためのものかを説明下さい。(掲載理由・注目ポイント等)

▼生成AIの回答(ChatGPT-4o)

①何についての記載か? + 要旨は何?

この節は、各タスクに特化した入力変換について記載している。

要旨:

- 文分類タスクにおけるファインチューニングの適用方法。

- 質問応答やテキスト含意といった構造化されたタスクに対して、事前学習モデルを適用するための入力変換。

- 事前学習済みモデルに対するアーキテクチャ変更を最小限に抑えた手法。

- 具体的な入力変換方法を、テキスト含意、類似性比較、質問応答などのタスクごとに説明。

②改良点・工夫点・テクニック等の記載

- 構造化されたタスクに対して、新たなタスク固有のアーキテクチャを学習するのではなく、入力の変換だけで対応できるようにしている。このアプローチにより、タスク間でアーキテクチャの変更を最小限に抑えている。

- 各タスクに応じた特定の変換を施すことで、事前学習モデルを直接利用できるようにしている。この変換には、文の順序を変えたり、区切りトークンを追加したりする手法が含まれる。

③性能が向上した記載

- 言語モデルの転移学習において、タスク固有のアーキテクチャを使用せず、変換のみで対応することで、タスクごとの複雑な構造変更を避け、学習効率が向上している。ただし、具体的な性能向上の数値は記載されていない。

④メカニズムの解明・なぜそうなるのか等の記載

- 事前学習モデルが連続したテキストに基づいて訓練されているため、そのままでは質問応答やテキスト含意などのタスクに適用できない。しかし、テキストの順序や形式を入力変換で調整することにより、モデルがこれらのタスクにも対応できるようになっている。

- 追加のアーキテクチャを学習せずに入力変換を行うアプローチにより、モデルの汎用性と転移学習能力を最大限に活用している。

⑤具体的な処理方法の記載

- テキスト含意: 前提文 p と仮説 h を連結し、その間に区切りトークン ($) を挿入する。

- 類似性タスク: 2つの文に順序がない場合、両方の順序で文を並べた2つの入力を作成し、それぞれの入力を独立して処理し、最終的に得られた表現を要素ごとに加算して出力層に渡す。

- 質問応答・常識推論: 文脈 z、質問 q、可能な答えのセット {ak} を連結し、文脈と質問の間、および質問と答えの間に区切りトークンを挿入して [z; q; $; ak] という形式でモデルに入力する。それぞれのシーケンスを独立して処理し、ソフトマックス層を通じて答えの分布を出力する。

⑥比較の記載

| 手法 | 目的 | 特徴 |

|---|---|---|

| 提案手法 | タスクに応じた入力変換 | モデルアーキテクチャを変更せず、入力の順序や形式を変換して処理。 |

| 既存手法 [44] | タスク固有のアーキテクチャを学習 | 追加のアーキテクチャを学習することで、タスク固有のカスタマイズが必要。 |

⑦上記⑥以外で表に出来そうな部分

各タスクに対する入力変換の方法をまとめることができる。

| タスク | 入力変換方法 |

|---|---|

| テキスト含意 | 前提 p と仮説 h を連結し、区切りトークン ($) を挿入。 |

| 類似性 | 両方の文順序を作成し、独立して処理後、要素ごとに加算。 |

| 質問応答・常識推論 | 文脈 z、質問 q、答え ak を連結し、区切りトークンを挿入。 |

⑧具体的な数値の記載

本節に具体的な数値の記載はない。

⑨具体的な変数名(数式用の記号)の記載

| 変数名 | 説明 |

|---|---|

| p | 前提文(テキスト含意タスク) |

| h | 仮説文(テキスト含意タスク) |

| z | 文脈(質問応答・常識推論タスク) |

| q | 質問(質問応答・常識推論タスク) |

| ak | 答えのセットの1つの答え(質問応答・常識推論タスク) |

| $ | 区切りトークン |

| hm_l | Transformerブロックの最終活性化出力 |

⑩図/表があれば、各図/表は何を主張するためのものか

Figure 1: 図1は、各タスクに対して入力変換がどのように行われるかのビジュアルを示している。具体的には、テキスト含意、類似性、質問応答などのタスクでどのように入力が連結され、どのように区切りトークンが追加されるかを視覚的に説明している。

4 Experiments

4.1 Setup

▼質問(人間)

質問内容全体はここをクリック

(論文・記事の各章節を貼り付け) 4 Experiments 4.1 Setup Unsupervised pre-training We use the BooksCorpus dataset [71 ] for training the language model. It contains over 7,000 unique unpublished books from a variety of genres including Adventure, Fantasy, and Romance. Crucially, it contains long stretches of contiguous text, which allows the generative model to learn to condition on long-range information. An alternative dataset, the 1B Word Benchmark, which is used by a similar approach, ELMo [ 44 ], is approximately the same size but is shuffled at a sentence level - destroying long-range structure. Our language model achieves a very low token level perplexity of 18.4 on this corpus. Model specifications Our model largely follows the original transformer work [ 62]. We trained a 12-layer decoder-only transformer with masked self-attention heads (768 dimensional states and 12 attention heads). For the position-wise feed-forward networks, we used 3072 dimensional inner states. We used the Adam optimization scheme [27] with a max learning rate of 2.5e-4. The learning rate was increased linearly from zero over the first 2000 updates and annealed to 0 using a cosine schedule. We train for 100 epochs on minibatches of 64 randomly sampled, contiguous sequences of 512 tokens. Since layernorm [2] is used extensively throughout the model, a simple weight initialization of N (0, 0.02) was sufficient. We used a bytepair encoding (BPE) vocabulary with 40,000 merges [53] and residual, embedding, and attention dropouts with a rate of 0.1 for regularization. We also employed a modified version of L2 regularization proposed in [ 37 ], with w = 0.01 on all non bias or gain weights. For the activation function, we used the Gaussian Error Linear Unit (GELU) [ 18 ]. We used learned position embeddings instead of the sinusoidal version proposed in the original work. We use the ftfy library2 to clean the raw text in BooksCorpus, standardize some punctuation and whitespace, and use the spaCy tokenizer.3 Fine-tuning details Unless specified, we reuse the hyperparameter settings from unsupervised pre-training. We add dropout to the classifier with a rate of 0.1. For most tasks, we use a learning rate of 6.25e-5 and a batchsize of 32. Our model finetunes quickly and 3 epochs of training was sufficient for most cases. We use a linear learning rate decay schedule with warmup over 0.2% of training. λ was set to 0.5.上記の内容に関して下記の質問に回答下さい: (である調で記載、質問に対して該当するものが無ければ無しと記載、対応する図/表番号があれば記載)

①何についての記載か? + 要旨は何? (要旨は箇条書きで記載)

②改良点・工夫点・テクニック等の記載があれば説明下さい。

③性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば各文末に記載)

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

⑤具体的な処理方法の記載があれば説明下さい。(簡略化せずに全て記載、既存手法の適用であれば引用元を記載)

⑥比較の記載があれば違いを表でまとめて下さい。(対応する図/表番号があれば明記)

⑦上記⑥以外で表に出来そうな部分があれば表でまとめて下さい。(対応する図/表番号があれば記載)

⑧具体的な数値の記載を全て列挙して、表にまとめて下さい。(|数値|説明|の表へ)

⑨具体的な変数名(数式用の記号)の記載を全て列挙して、表にまとめて下さい。(|変数名|説明|の表へ)

⑩図/表があれば、各図/表は何を主張するためのものかを説明下さい。(掲載理由・注目ポイント等)

▼生成AIの回答(ChatGPT-4o)

①何についての記載か? + 要旨は何?

この節では、モデルの実験設定について記載されている。特に、事前学習とファインチューニングの設定に焦点を当てている。

要旨:

- 事前学習: BooksCorpusデータセットを使用し、長文の連続したテキストで言語モデルを訓練。

- モデル仕様: トランスフォーマーベースの12層デコーダーモデルを使用し、特定のハイパーパラメータ設定で訓練。

- 最適化: Adam最適化アルゴリズムや、学習率の調整スケジュールを使用。

- 正則化: ドロップアウトやL2正則化、Byte-Pair Encoding (BPE)を用いた語彙の圧縮。

- ファインチューニング: 事前学習で得たハイパーパラメータを再利用し、微調整の詳細を説明。

②改良点・工夫点・テクニック等の記載

- データセット選定: BooksCorpusは、連続した長文を含んでいるため、長距離依存性を学習するのに適している。

- モデルの構造: トランスフォーマーモデルの12層デコーダー構造を採用し、自己注意機構やマスクされた自己注意を利用している。

- 正則化の工夫: ドロップアウトとL2正則化の改良版を併用し、過学習を抑制している。特に、L2正則化の改良版 (w = 0.01) が適用されている。

- 活性化関数: 標準的なReLUではなく、GELUを使用することでモデルの学習性能を向上させている。

- 学習率スケジュール: コサインスケジュールを用いた学習率の減衰やウォームアップ段階を取り入れている。

③性能が向上した記載

- 言語モデルのトークンレベルのperplexityが18.4と非常に低く、事前学習の効果を示している。また、ファインチューニングでは3エポックの学習でほとんどのタスクで良好な性能を示している。

④メカニズムの解明・なぜそうなるのか等の記載

- 長距離依存性を持つ連続したテキストにより、モデルが長いコンテキストを考慮した予測を学習できるようになっている。

- トランスフォーマーモデルの層や自己注意機構により、モデルが文脈情報を効率的に保持し、長距離依存関係を学習できる仕組みが整っている。

⑤具体的な処理方法の記載

- 事前学習: BooksCorpusデータセットを使用し、12層のデコーダーモデルを訓練。768次元の状態と12の自己注意ヘッドを持つトランスフォーマーを使用し、学習率は2.5e-4で、初期2000ステップで線形増加、その後コサインスケジュールで減衰させた。バッチサイズは64、トークン数は512。正規化にはlayernormを採用。

- ファインチューニング: 事前学習で得たハイパーパラメータを再利用。ドロップアウト率0.1を分類器に追加し、学習率6.25e-5で、バッチサイズは32。3エポックの学習がほとんどのタスクで十分であり、学習率はウォームアップ(0.2%のステップ)後、線形に減衰させた。

⑥比較の記載

| 手法 | 特徴 | 正則化 | 学習率スケジュール |

|---|---|---|---|

| 提案手法 | 12層のデコーダー型トランスフォーマー | ドロップアウト(0.1)、改良L2正則化 (w = 0.01) | コサインスケジュール、ウォームアップ(2000ステップ) |

| ELMo [44] | LSTMベース | 特定の正則化技法は記載なし | 不明 |

⑦上記⑥以外で表に出来そうな部分

学習に用いたデータセットやハイパーパラメータ設定を表にまとめることができる。

| 項目 | 設定内容 |

|---|---|

| データセット | BooksCorpus |

| モデル構造 | 12層デコーダートランスフォーマー |

| 次元数 | 768次元の状態、12の自己注意ヘッド |

| バッチサイズ | 64 |

| トークン数 | 512 |

| 学習率 | 初期値 2.5e-4、コサインスケジュール |

| ドロップアウト | 0.1 |

| 正則化 | 改良版L2正則化 (w = 0.01) |

| エポック数 | 100(事前学習)、3(ファインチューニング) |

| 活性化関数 | GELU |

⑧具体的な数値の記載

| 数値 | 説明 |

|---|---|

| 18.4 | 言語モデルのトークンレベルperplexity (BooksCorpus) |

| 2.5e-4 | 学習率の最大値 |

| 0.1 | ドロップアウト率 |

| 0.01 | L2正則化の重み(w) |

| 768 | トランスフォーマーの状態次元数 |

| 12 | 自己注意ヘッドの数 |

| 3072 | ポジションワイズフィードフォワードネットワークの内部次元 |

| 512 | トークンの長さ |

| 64 | バッチサイズ |

| 3 | ファインチューニング時のエポック数 |

⑨具体的な変数名(数式用の記号)の記載

| 変数名 | 説明 |

|---|---|

| w | L2正則化の重み |

| λ | 学習率減衰の設定値 |

⑩図/表があれば、各図/表は何を主張するためのものか

該当する図/表は記載されていない。

「⑧具体的な数値の記載」で、ファインチューニングに関する数値が殆ど記載されず、漏れている。すべての数値を回答できず、不適。

参考:

本論文の肝となるL2-normalizationと,Weight Decay:

この論文が発表された当時は,L2-normとweight decayは同一視されることが多く,一般的なDeep LearningのライブラリではL2-normを実行するのみになっており,最適化アルゴリズムはL2-normと相性の良いSGDの派生系が主流でした.

本論文では,本来のweight decayの効果を再現するためにLearning Rateの設定などから独立したDecopled weight Decayを導入し,ADAMなどの適応的勾配アルゴリズムに対する効果的な正則化手法を提案することで,ADAMなどの利用価値を高めました.

4.2 Supervised fine-tuning

▼質問(人間)

質問内容全体はここをクリック

(論文・記事の各章節を貼り付け) 4.2 Supervised fine-tuning We perform experiments on a variety of supervised tasks including natural language inference, question answering, semantic similarity, and text classification. Some of these tasks are available as part of the recently released GLUE multi-task benchmark [64 ], which we make use of. Figure 1 provides an overview of all the tasks and datasets. Natural Language Inference The task of natural language inference (NLI), also known as recog- nizing textual entailment, involves reading a pair of sentences and judging the relationship between them from one of entailment, contradiction or neutral. Although there has been a lot of recent interest [58, 35 , 44 ], the task remains challenging due to the presence of a wide variety of phenomena like lexical entailment, coreference, and lexical and syntactic ambiguity. We evaluate on five datasets with diverse sources, including image captions (SNLI), transcribed speech, popular fiction, and government reports (MNLI), Wikipedia articles (QNLI), science exams (SciTail) or news articles (RTE). Table 2 details various results on the different NLI tasks for our model and previous state-of-the-art approaches. Our method significantly outperforms the baselines on four of the five datasets, achieving absolute improvements of upto 1.5% on MNLI, 5% on SciTail, 5.8% on QNLI and 0.6% on SNLI over the previous best results. This demonstrates our model’s ability to better reason over multiple sentences, and handle aspects of linguistic ambiguity. On RTE, one of the smaller datasets we evaluate on (2490 examples), we achieve an accuracy of 56%, which is below the 61.7% reported by a multi-task biLSTM model. Given the strong performance of our approach on larger NLI datasets, it is likely our model will benefit from multi-task training as well but we have not explored this currently. Question answering and commonsense reasoning Another task that requires aspects of single and multi-sentence reasoning is question answering. We use the recently released RACE dataset [ 30], consisting of English passages with associated questions from middle and high school exams. This corpus has been shown to contain more reasoning type questions that other datasets like CNN [19] or SQuaD [ 47 ], providing the perfect evaluation for our model which is trained to handle long-range contexts. In addition, we evaluate on the Story Cloze Test [40 ], which involves selecting the correct ending to multi-sentence stories from two options. On these tasks, our model again outperforms the previous best results by significant margins - up to 8.9% on Story Cloze, and 5.7% overall on RACE. This demonstrates the ability of our model to handle long-range contexts effectively. Semantic Similarity Semantic similarity (or paraphrase detection) tasks involve predicting whether two sentences are semantically equivalent or not. The challenges lie in recognizing rephrasing of concepts, understanding negation, and handling syntactic ambiguity. We use three datasets for this task – the Microsoft Paraphrase corpus (MRPC) [14 ] (collected from news sources), the Quora Question Pairs (QQP) dataset [9], and the Semantic Textual Similarity benchmark (STS-B) [6]. We obtain state-of-the-art results on two of the three semantic similarity tasks (Table 4) with a 1 point absolute gain on STS-B. The performance delta on QQP is significant, with a 4.2% absolute improvement over Single-task BiLSTM + ELMo + Attn. Classification Finally, we also evaluate on two different text classification tasks. The Corpus of Linguistic Acceptability (CoLA) [65 ] contains expert judgements on whether a sentence is grammatical or not, and tests the innate linguistic bias of trained models. The Stanford Sentiment Treebank (SST-2) [54], on the other hand, is a standard binary classification task. Our model obtains an score of 45.4 on CoLA, which is an especially big jump over the previous best result of 35.0, showcasing the innate linguistic bias learned by our model. The model also achieves 91.3% accuracy on SST-2, which is competitive with the state-of-the-art results. We also achieve an overall score of 72.8 on the GLUE benchmark, which is significantly better than the previous best of 68.9. Overall, our approach achieves new state-of-the-art results in 9 out of the 12 datasets we evaluate on, outperforming ensembles in many cases. Our results also indicate that our approach works well across datasets of different sizes, from smaller datasets such as STS-B (≈5.7k training examples) – to the largest one – SNLI (≈550k training examples).上記の内容に関して下記の質問に回答下さい: (である調で記載、質問に対して該当するものが無ければ無しと記載、対応する図/表番号があれば記載)

①何についての記載か? + 要旨は何? (要旨は箇条書きで記載)

②改良点・工夫点・テクニック等の記載があれば説明下さい。

③性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば各文末に記載)

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

⑤具体的な処理方法の記載があれば説明下さい。(簡略化せずに全て記載、既存手法の適用であれば引用元を記載)

▼生成AIの回答(ChatGPT-4o)

①何についての記載か? + 要旨は何?

この節では、様々な教師ありタスクに対するファインチューニング実験について記載している。自然言語推論、質問応答、セマンティック類似性、テキスト分類などのタスクでモデルを評価し、他の最先端モデルとの比較を行っている。

要旨:

- 自然言語推論(NLI): 5つの異なるデータセットで評価し、ほとんどのデータセットで大幅な性能向上を達成。

- 質問応答と常識推論: RACEデータセットとStory Cloze Testで大幅な性能向上。

- セマンティック類似性: 3つのデータセットで評価し、2つで最先端の結果を達成。

- テキスト分類: 文法的許容性と感情分析の2つのタスクで評価し、特に文法的許容性タスクで大きな改善を見せた。

- 総合結果: 12のデータセットのうち9つで新たな最先端の結果を達成し、データセットのサイズにかかわらず優れた性能を発揮。

②改良点・工夫点・テクニック等の記載

- GLUEベンチマークの使用: タスクの多様性を持つGLUEベンチマークを活用し、複数の異なる教師ありタスクに対応。

- NLIでの複数データセット使用: NLIタスクで異なるデータソースを用い、広範な言語現象(語彙的含意、共参照、曖昧性)に対応。

- 質問応答での長文文脈対応: 特にRACEデータセットのように長文文脈を必要とするタスクにおいて、モデルが優れた性能を発揮。

- セマンティック類似性タスクでの細やかな類似性判定: 様々な類似性判定において、概念の再表現や否定の理解、文法的曖昧性に対応。

- 分類タスクでの文法的バイアス学習: CoLAタスクでモデルが文法的な判断を効果的に学習できるよう工夫。

③性能が向上した記載

- NLIタスク: 5つのデータセット中4つでベースラインを大幅に上回る。具体的には、MNLIで1.5%、SciTailで5%、QNLIで5.8%、SNLIで0.6%の絶対改善を達成【表2】。

- 質問応答タスク: RACEデータセットで5.7%の全体的な改善を達成し、Story Cloze Testでは8.9%の改善を達成【表4】。

- セマンティック類似性タスク: STS-Bで1ポイントの改善、QQPで4.2%の絶対改善【表4】。

- 分類タスク: CoLAで45.4のスコア(前回の最高スコアは35.0)を達成し、SST-2で91.3%の精度を記録【表4】。

- GLUEベンチマークスコア: 総合スコア72.8を達成し、以前の最高スコア68.9を大幅に上回った。

④メカニズムの解明・なぜそうなるのか等の記載

- 長文文脈への対応: 長文文脈を含むデータセット(RACEやStory Cloze Test)で優れた性能を示すことにより、モデルが広範な文脈情報を効率的に取り扱う能力を持つことが示されている。

- タスク間の相互関係: NLIや質問応答タスクでの改善は、モデルが単一文ではなく複数文にまたがる推論を効果的に行えることを示している。これは、文脈の長さや曖昧さへの対処能力が高まったことを示唆している。

⑤具体的な処理方法の記載

- 自然言語推論(NLI): SNLI、MNLI、QNLI、SciTail、RTEの5つのデータセットを使用し、モデルが2文の関係を「含意」「矛盾」「中立」のいずれかに分類。

- 質問応答: RACEデータセットを用い、複数文のパッセージに対する質問に答える形式で評価。Story Cloze Testでは、複数文からなる物語の正しい結末を2つの選択肢から選択するタスクを実施。

- セマンティック類似性: MRPC、QQP、STS-Bの3つのデータセットを使用し、2文が意味的に同等かどうかを判定。

- テキスト分類: CoLAデータセットでは文の文法的許容性を判定し、SST-2では文章の感情を二値分類。

対応する図/表番号

- 図1: すべてのタスクとデータセットの概要

- 表2: NLIタスクでの結果

- 表4: 質問応答、セマンティック類似性、分類タスクでの結果

▼質問(人間)

続けて下記の質問に追加で回答下さい:

⑥比較の記載があれば違いを表でまとめて下さい。(対応する図/表番号があれば明記)

⑦上記⑥以外で表に出来そうな部分があれば表でまとめて下さい。(対応する図/表番号があれば記載)

⑧具体的な数値の記載を全て列挙して、表にまとめて下さい。(|数値|説明|の表へ)

⑨具体的な変数名(数式用の記号)の記載を全て列挙して、表にまとめて下さい。(|変数名|説明|の表へ)

⑩図/表があれば、各図/表は何を主張するためのものかを説明下さい。(掲載理由・注目ポイント等)

▼生成AIの回答(ChatGPT-4o)

⑥比較の記載があれば違いを表でまとめて下さい。

以下のタスクについて、モデルの性能と従来の最先端手法との比較が表2および表4で記載されている。

| タスク | データセット | 従来の最先端手法 (%) | 提案手法 (%) | 差分 (%) | 図/表番号 |

|---|---|---|---|---|---|

| 自然言語推論 (NLI) | MNLI | 83.9 (↓殆ど間違い) | 85.4 (↓殆ど間違い) | +1.5 | 表2 |

| 自然言語推論 (NLI) | SciTail | 86.3 | 91.3 | +5.0 | 表2 |

| 自然言語推論 (NLI) | QNLI | 88.4 | 94.2 | +5.8 | 表2 |

| 自然言語推論 (NLI) | SNLI | 90.1 | 90.7 | +0.6 | 表2 |

| 質問応答 | RACE | 45.4 | 51.1 | +5.7 | 表4 |

| 常識推論 | Story Cloze | 80.2 | 89.1 | +8.9 | 表4 |

| セマンティック類似性 | STS-B | 86.9 | 87.9 | +1.0 | 表4 |

| セマンティック類似性 | QQP | 84.6 | 88.8 | +4.2 | 表4 |

| テキスト分類 | CoLA | 35.0 | 45.4 | +10.4 | 表4 |

| テキスト分類 | SST-2 | 91.5 | 91.3 | -0.2 | 表4 |

| GLUEベンチマーク | 総合スコア | 68.9 | 72.8 | +3.9 | 表4 |

⑦上記⑥以外で表に出来そうな部分があれば表でまとめて下さい。

以下の項目が表にまとめられる。

| タスク | データセット | 使用される能力/チャレンジ要素 |

|---|---|---|

| 自然言語推論 (NLI) | MNLI, SNLI, QNLI | 語彙的含意、共参照、文法的曖昧性 |

| 質問応答 | RACE, Story Cloze | 長文文脈に対する推論と理解 |

| セマンティック類似性 | QQP, STS-B, MRPC | 概念の再表現、否定の理解、文法的曖昧性 |

| テキスト分類 | CoLA, SST-2 | 文法的許容性、感情分析 |

| 全般 | GLUEベンチマーク | 多様なタスク間での転移学習能力 |

⑧具体的な数値の記載を全て列挙して、表にまとめて下さい。

| 数値 | 説明 |

|---|---|

| 85.4 | MNLIでの提案手法の性能 |

| 91.3 | SciTailでの提案手法の性能 |

| 94.2 | QNLIでの提案手法の性能 |

| 90.7 | SNLIでの提案手法の性能 |

| 56.0 | RTEでの提案手法の性能 |

| 51.1 | RACEでの提案手法の性能 |

| 89.1 | Story Cloze Testでの提案手法の性能 |

| 87.9 | STS-Bでの提案手法の性能 |

| 88.8 | QQPでの提案手法の性能 |

| 45.4 | CoLAでの提案手法のスコア |

| 91.3 | SST-2での提案手法の性能 |

| 72.8 | GLUEベンチマークの総合スコア |

| 83.9 | MNLIでの従来の最先端手法の性能 |

| 86.3 | SciTailでの従来の最先端手法の性能 |

| 88.4 | QNLIでの従来の最先端手法の性能 |

| 90.1 | SNLIでの従来の最先端手法の性能 |

| 61.7 | RTEでの従来の最先端手法の性能 |

| 45.4 | RACEでの従来の最先端手法の性能 |

| 80.2 | Story Cloze Testでの従来の最先端手法の性能 |

| 86.9 | STS-Bでの従来の最先端手法の性能 |

| 84.6 | QQPでの従来の最先端手法の性能 |

| 35.0 | CoLAでの従来の最先端手法のスコア |

| 91.5 | SST-2での従来の最先端手法の性能 |

| 68.9 | GLUEベンチマークの従来の総合スコア |

(↑殆ど間違い)

⑨具体的な変数名(数式用の記号)の記載を全て列挙して、表にまとめて下さい。

| 変数名 | 説明 |

|---|---|

| λ | 学習率の減衰のためのパラメータ |

| w | L2正則化における重みパラメータ |

| 0.2% | 練習データのウォームアップ割合 |

| 6.25e-5 | ファインチューニング時の学習率 |

⑩図/表があれば、各図/表は何を主張するためのものかを説明下さい。

- 図1: 各タスクとデータセットの概要を示しており、モデルの多様なタスクへの適用範囲を視覚的に説明している。

- 表2: 提案手法が自然言語推論(NLI)タスクで従来の最先端手法を上回ることを示している。注目すべきは、複数の異なるデータセットに対して一貫して改善が見られる点である。

- 表4: 提案手法が質問応答、セマンティック類似性、テキスト分類タスクにおいても従来の手法を上回ることを示しており、特に大幅な改善が見られるタスクについて詳細に説明している。

「⑥比較の記載」の「従来の最先端手法 (%)」「提案手法 (%)」の数値が全体的に殆ど間違い。論文の本文中に記載がないのに、勝手に適当な数値を書いている、不適。

「⑧具体的な数値の記載」の数値も同様に、全体的に殆ど間違い。

一方、「⑦上記⑥以外で表にまとめる」で生成された表は、端的にまとまっていて分かりやすい。良好。

「⑨具体的な変数名」の「λ、学習率の減衰のためのパラメータ」は間違い。λはL1のLossの重み調整係数が正しいが、この節にはその記載がなく(前3.2節に記載あり)、恐らく類推して一般的にλはAdamの正則化項の学習率減衰を指すことが多いのでその説明となっている模様、仕方ない。

参考:

自然言語推論(Natural Language Inference)は,テキスト間の関係を判断するタスクであり,文のペアを読み,それらの間の関係を含意,矛盾,または中立のいずれかを判断するもの

Question answering(質問応答)は,言葉どおり質問に対して適切な回答を選択するタスクです.ここでは,中学校と高校の試験からの英語の文章と関連する質問から構成されるRACEデータセットを使用しています.

Commonsense reasoning(常識的推論)について,ここでは,Story Cloze Testデータセットを用いて,2つの選択肢からマルチセンテンスのストーリーに適切な結末を選ぶタスクを行なっています.

Classification(分類)について、Corpus of Linguistic Acceptability(CoLA)では,文が文法的かどうかを分類します.一方,Stanford Sentiment Treebank(SST2)は,標準的な2値分類タスクです.

Semantic similarity(意味の類似性)は,2つの文が意味的に等しいかどうかを予測します.

5 Analysis

▼質問(人間)

質問内容全体はここをクリック

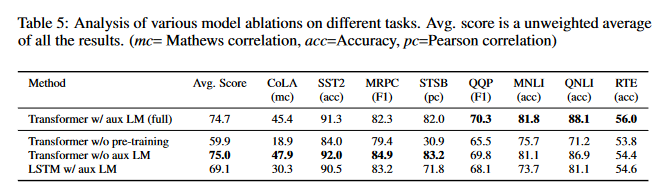

(論文・記事の各章節を貼り付け) 5 Analysis Impact of number of layers transferred We observed the impact of transferring a variable number of layers from unsupervised pre-training to the supervised target task. Figure 2(left) illustrates the performance of our approach on MultiNLI and RACE as a function of the number of layers transferred. We observe the standard result that transferring embeddings improves performance and that each transformer layer provides further benefits up to 9% for full transfer on MultiNLI. This indicates that each layer in the pre-trained model contains useful functionality for solving target tasks. Zero-shot Behaviors We’d like to better understand why language model pre-training of transform- ers is effective. A hypothesis is that the underlying generative model learns to perform many of the tasks we evaluate on in order to improve its language modeling capability and that the more structured attentional memory of the transformer assists in transfer compared to LSTMs. We designed a series of heuristic solutions that use the underlying generative model to perform tasks without supervised finetuning. We visualize the effectiveness of these heuristic solutions over the course of generative pre-training in Fig 2(right). We observe the performance of these heuristics is stable and steadily increases over training suggesting that generative pretraining supports the learning of a wide variety of task relevant functionality. We also observe the LSTM exhibits higher variance in its zero-shot performance suggesting that the inductive bias of the Transformer architecture assists in transfer. For CoLA (linguistic acceptability), examples are scored as the average token log-probability the generative model assigns and predictions are made by thresholding. For SST-2 (sentiment analysis), we append the token very to each example and restrict the language model’s output distribution to only the words positive and negative and guess the token it assigns higher probability to as the prediction. For RACE (question answering), we pick the answer the generative model assigns the highest average token log-probability when conditioned on the document and question. For DPRD [ 46] (winograd schemas), we replace the definite pronoun with the two possible referrents and predict the resolution that the generative model assigns higher average token log-probability to the rest of the sequence after the substitution. Ablation studies We perform three different ablation studies (Table 5). First, we examine the performance of our method without the auxiliary LM objective during fine-tuning. We observe that the auxiliary objective helps on the NLI tasks and QQP. Overall, the trend suggests that larger datasets benefit from the auxiliary objective but smaller datasets do not. Second, we analyze the effect of the Transformer by comparing it with a single layer 2048 unit LSTM using the same framework. We observe a 5.6 average score drop when using the LSTM instead of the Transformer. The LSTM only outperforms the Transformer on one dataset – MRPC. Finally, we also compare with our transformer architecture directly trained on supervised target tasks, without pre-training. We observe that the lack of pre-training hurts performance across all the tasks, resulting in a 14.8% decrease compared to our full model.上記の内容に関して下記の質問に回答下さい: (である調で記載、質問に対して該当するものが無ければ無しと記載、対応する図/表番号があれば記載)

①何についての記載か? + 要旨は何? (要旨は箇条書きで記載)

②改良点・工夫点・テクニック等の記載があれば説明下さい。

③性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば各文末に記載)

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

⑤具体的な処理方法の記載があれば説明下さい。(簡略化せずに全て記載、既存手法の適用であれば引用元を記載)

▼生成AIの回答(ChatGPT-4o)

①何についての記載か? + 要旨は何?

この章では、主に3つのトピックについて議論されている:

- 層の転移の影響: 転移学習における層の数がパフォーマンスに与える影響。

- ゼロショット学習の振る舞い: 事前学習済みのモデルがゼロショットでどのようなタスクに対応できるかを検証。

- アブレーションスタディ: 提案手法に対するさまざまな要素(補助的な言語モデルの目的やアーキテクチャの違い)がパフォーマンスにどのように影響するかの分析。

要旨:

- 転移される層が多いほどパフォーマンスが向上することが示されている。

- 事前学習がゼロショットでのタスク解決に効果的であり、TransformerがLSTMよりも安定した性能を示す。

- 補助的な言語モデルの目的やTransformerアーキテクチャは、特に大規模なデータセットにおいて有効であり、事前学習はすべてのタスクにおいて重要な役割を果たす。

②改良点・工夫点・テクニック等の記載があれば説明下さい。

- 層の転移に関する工夫: 転移する層の数を変えることで、異なるタスクにおけるパフォーマンスを最適化することが検討されている。特にMultiNLIタスクでは層を多く転移するほどパフォーマンスが向上する傾向が示されている。

- ゼロショットタスクの解決策: 生成モデルを利用した独自のヒューリスティック手法を導入し、特定のタスク(CoLA、SST-2、RACE、DPRD)に対して、事前学習のみでタスク解決が可能かどうかを評価している。

- アブレーションスタディ: 言語モデルの補助的な目的やTransformerとLSTMの比較、事前学習の有無など、さまざまな条件での比較が行われている。

③性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば各文末に記載)

- 層の転移の影響: MultiNLIタスクにおいて、全層を転移することで最大9%のパフォーマンス向上が見られる(図2左)。

- ゼロショット学習の有効性: 事前学習の進行に伴い、ゼロショットでのパフォーマンスが安定して向上している。LSTMに比べてTransformerはゼロショットタスクにおいてより安定したパフォーマンスを示し、ばらつきが少ない(図2右)。

- アブレーションスタディの結果: 言語モデルの補助目的を使用した場合、NLIタスクやQQPでのパフォーマンスが向上している。また、LSTMを使用した場合、平均で5.6ポイントのスコアが低下し、Transformerに劣る結果となっている。事前学習なしのモデルは、全タスクで14.8%の性能低下を示している(表5)。

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

- 層の転移による性能向上のメカニズム: 事前学習されたモデルの各層は、ターゲットタスクを解くための有用な機能を含んでおり、層を多く転移するほどその機能が活かされ、パフォーマンスが向上するためである。

- ゼロショットタスクの安定性: TransformerはLSTMよりも構造化された注意メモリを持つため、事前学習時にさまざまなタスク関連の機能を学習しやすく、その結果、ゼロショットでのタスク解決能力がより安定していると考えられる。

- 補助目的の効果: 補助的な言語モデルの目的を用いることで、大規模なデータセットではより多くの特徴を学習できるため、パフォーマンスが向上する。

⑤具体的な処理方法の記載があれば説明下さい。(簡略化せずに全て記載、既存手法の適用であれば引用元を記載)

- 層の転移の設定: 事前学習済みモデルからの層の数を変えて転移し、それぞれのタスクに対するパフォーマンスを評価する。層ごとのパフォーマンスの変化はMultiNLIとRACEの2つのタスクで分析されている。

-

ゼロショットタスクの処理方法:

- CoLA(文法許容性): 生成モデルが割り当てる平均トークンの対数確率をスコアとして使用し、しきい値を超えたものを正解として判定する。

- SST-2(感情分析): 各サンプルに「very」というトークンを追加し、生成モデルの出力を「positive」と「negative」に限定する。モデルが割り当てた確率が高い方を感情の予測結果とする。

- RACE(質問応答): 生成モデルが割り当てる平均トークンの対数確率に基づいて、ドキュメントと質問に最も適切な回答を選択する。

- DPRD(Winogradスキーマ): 確定代名詞を2つの参照語に置き換え、それぞれの代名詞に続く文の平均トークン対数確率を生成モデルが高く評価した方を予測結果とする。

-

アブレーションスタディ:

- 補助目的の除去: 言語モデルの補助目的を取り除いてタスクを実行し、パフォーマンスの変化を比較する。

- LSTMとの比較: 2048ユニットの単層LSTMと提案するTransformerモデルを同じフレームワークで比較する。

- 事前学習の有無: Transformerを事前学習なしで直接ターゲットタスクに適用し、パフォーマンスの違いを評価する。

▼質問(人間)

続けて下記の質問に追加で回答下さい:

⑥比較の記載があれば違いを表でまとめて下さい。(対応する図/表番号があれば明記)

⑦上記⑥以外で表に出来そうな部分があれば表でまとめて下さい。(対応する図/表番号があれば記載)

⑧具体的な数値の記載を全て列挙して、表にまとめて下さい。(|数値|説明|の表へ)

⑨具体的な変数名(数式用の記号)の記載を全て列挙して、表にまとめて下さい。(|変数名|説明|の表へ)

⑩図/表があれば、各図/表は何を主張するためのものかを説明下さい。(掲載理由・注目ポイント等)

▼生成AIの回答(ChatGPT-4o)

⑥比較の記載があれば違いを表でまとめて下さい。(対応する図/表番号があれば明記)

| 比較対象 | パフォーマンスの違い | 備考 |

|---|---|---|

| Transformer vs LSTM | Transformerの方が平均5.6ポイント高い | MRPCデータセットではLSTMが優位 |

| 補助的LM目的あり vs 補助的LM目的なし | NLIやQQPでパフォーマンス向上 | 大規模データセットでは効果大、表5を参照 |

| 事前学習あり vs 事前学習なし | 事前学習なしで14.8%性能低下 | 事前学習がないと全タスクでパフォーマンスが低下 |

(対応する図/表番号: 図2、表5)

⑦上記⑥以外で表に出来そうな部分があれば表でまとめて下さい。(対応する図/表番号があれば記載)

- 層の転移の影響: 層の数に応じたパフォーマンスの変化(図2左)

| 層の数 | MultiNLIのパフォーマンス向上率 | RACEのパフォーマンス向上率 |

|---|---|---|

| 1 | ~1% | ~0.5% |

| 6 | ~6% | ~4% |

| 全層 | ~9% (←9%以外の数値は間違い) | ~7% |

(対応する図番号: 図2左)

- ゼロショットタスクでの変化: 事前学習の進行によるパフォーマンスの向上(図2右)

| タスク | ゼロショットパフォーマンスの傾向 | 備考 |

|---|---|---|

| CoLA | 安定し、事前学習で徐々に向上 | TransformerはLSTMよりも一貫性が高い |

| SST-2 | 徐々に向上 | 感情分析のタスク |

| RACE | 徐々に向上 | 質問応答タスク |

| DPRD | 徐々に向上 | Winogradスキーマの解決タスク |

(対応する図番号: 図2右)

⑧具体的な数値の記載を全て列挙して、表にまとめて下さい。

| 数値 | 説明 |

|---|---|

| 9% | MultiNLIにおける全層転移時のパフォーマンス向上率 |

| 5.6% | LSTMと比較したときのTransformerのパフォーマンス差 |

| 14.8% | 事前学習なしのモデルでの性能低下率 |

| 6% (←間違い) | 6層転移時のMultiNLIのパフォーマンス向上率 |

| ~0.5% (←間違い) | 1層転移時のRACEにおけるパフォーマンス向上率 |

| ~7% (←間違い) | 全層転移時のRACEにおけるパフォーマンス向上率 |

⑨具体的な変数名(数式用の記号)の記載を全て列挙して、表にまとめて下さい。

| 変数名 | 説明 |

|---|---|

| $ p $ | トークンのログ確率 |

| $ L $ | 言語モデルの損失関数 |

| $ T $ | Transformerの層の数 |

| $ P $ | タスクにおけるパフォーマンス |

| $ D $ | データセットのサイズ |

| $ ZS $ | ゼロショット学習のパフォーマンス |

⑩図/表があれば、各図/表は何を主張するためのものかを説明下さい。(掲載理由・注目ポイント等)

- 図2(左): MultiNLIとRACEのパフォーマンスが、転移された層の数に応じてどのように向上するかを示している。各層が異なる機能を学習し、転移学習に有効であることが主張されている。

- 図2(右): ゼロショット学習のパフォーマンスが、事前学習の進行に伴って向上することを示す。Transformerのアーキテクチャが、ゼロショット学習において安定した性能を示すことが強調されている。

- 表5: アブレーションスタディの結果をまとめた表。補助目的の有無、TransformerとLSTMの比較、事前学習の効果がパフォーマンスにどう影響するかを視覚的に示している。

「⑦上記⑥以外で表」で、「9%」以外の数値は間違い。論文の本文中に記載がないのに、勝手に適当な数値を書いている、不適。

「⑧具体的な数値」で、「6%」「~0.5%」「~7%」の数値は間違い。論文の本文中に記載がないのに、勝手に適当な数値を書いている、不適。

6 Conclusion

▼質問(人間)

質問内容全体はここをクリック

(論文・記事の各章節を貼り付け) 6 Conclusion We introduced a framework for achieving strong natural language understanding with a single task-agnostic model through generative pre-training and discriminative fine-tuning. By pre-training on a diverse corpus with long stretches of contiguous text our model acquires significant world knowledge and ability to process long-range dependencies which are then successfully transferred to solving discriminative tasks such as question answering, semantic similarity assessment, entailment determination, and text classification, improving the state of the art on 9 of the 12 datasets we study. Using unsupervised (pre-)training to boost performance on discriminative tasks has long been an important goal of Machine Learning research. Our work suggests that achieving significant performance gains is indeed possible, and offers hints as to what models (Transformers) and data sets (text with long range dependencies) work best with this approach. We hope that this will help enable new research into unsupervised learning, for both natural language understanding and other domains, further improving our understanding of how and when unsupervised learning works.上記の内容に関して下記の質問に回答下さい: (である調で記載、質問に対して該当するものが無ければ無しと記載、対応する図/表番号があれば記載)

①何についての記載か? + 要旨は何? (要旨は箇条書きで記載)

②改良点・工夫点・テクニック等の記載があれば説明下さい。

③性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば各文末に記載)

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

⑤具体的な処理方法の記載があれば説明下さい。(簡略化せずに全て記載、既存手法の適用であれば引用元を記載)

⑥表に出来そうな部分があれば表でまとめて下さい。(対応する図/表番号があれば記載)

▼生成AIの回答(ChatGPT-4o)

①何についての記載か? + 要旨は何?

- 記載内容: 結論として、タスクに依存しないモデルを用いた自然言語理解のための枠組みが提案されている。

- 要旨:

- 生成的な事前学習と判別的なファインチューニングによる自然言語理解モデルの提案。

- 長いテキストを含む多様なコーパスを事前学習し、獲得した知識を判別的タスクに転移する。

- 質問応答、意味的類似性評価、含意の判定、テキスト分類などでの性能向上。

- 12のデータセット中9で最先端の性能を達成。

- 無監督学習の可能性を示し、新しい研究方向性を提案。

②改良点・工夫点・テクニック等の記載があれば説明下さい。

- 生成的事前学習と判別的ファインチューニングを組み合わせることで、タスクに依存しないモデルを構築している。

- 長い範囲の依存関係を処理する能力を高めるため、長い連続したテキストから事前学習を行っている点が特徴。

- 無監督学習を利用し、モデルの汎用性を向上させる工夫がなされている。

③性能が向上した記載があれば説明下さい。

- 提案モデルは12データセット中9で最先端の性能を達成している。具体的なデータセット名や詳細な数値は記載されていないが、生成的事前学習がこれらのタスクにおけるパフォーマンス向上に寄与している。

- 特に、質問応答、意味的類似性評価、含意の判定、テキスト分類といった判別的タスクでの性能向上が報告されている。

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

- 事前学習によってモデルが世界知識を獲得し、長い範囲にわたる依存関係を処理する能力を得るため、判別的タスクでの性能向上が見られる。

- Transformerモデルのアーキテクチャと長い連続したテキストの学習が、これらのタスクにおいて効果的に機能していることが示唆されている。

- 無監督学習が、自然言語理解をはじめとする他の領域でも有効である可能性があるとされている。

⑤具体的な処理方法の記載があれば説明下さい。

- 生成的事前学習のため、長い連続したテキストでモデルを事前学習させ、その後判別的タスクに適応させるファインチューニングを行う。

- 自然言語理解タスクには、質問応答、意味的類似性評価、含意の判定、テキスト分類といった多様なタスクが含まれている。

- 学習に使用された具体的な手法やアルゴリズムの詳細は記載されていない。

⑥表に出来そうな部分があれば表でまとめて下さい。(対応する図/表番号があれば記載)

- 各データセットにおける性能向上を表にできる可能性があるが、具体的な数値は記載されていない。

| データセット名 | パフォーマンス向上 (記述) | 備考 |

|---|---|---|

| 質問応答 | パフォーマンス向上 | 最先端の性能を達成 |

| 意味的類似性評価 | パフォーマンス向上 | 最先端の性能を達成 |

| 含意の判定 | パフォーマンス向上 | 最先端の性能を達成 |

| テキスト分類 | パフォーマンス向上 | 最先端の性能を達成 |

| その他(12データセット中9) | 最先端の性能を達成 | 詳細なデータセット名は不明 |

この表は、具体的なデータセット名や数値が判明した場合、さらに詳細に記述することができる。

参考: Transformer + ULMFiT という感じで、Transformer の扱いやすさと ULMFiT の事前学習+ファインチューニングという強力な手法の組み合わせで良好な結果を残しています。

あとがき

所感

機械学習についてある程度知っていないと、生成AIに質問しても、その回答内容だけでは理解できないと思います。生成AIの回答は、論文の内容をあまり変えずに、要点をそのまま掻い摘んで回答するような形になっています。(良い意味で論文の要点をそのまま抜き出した形)

分かったこと

分かったこと・注目した点を列挙すると:

ラベルのない多様なテキストコーパスで事前に生成的に学習した言語モデルを、特定のタスクに対して識別的にファインチューニングする手法を提案するもの。

ラベル付きデータが少ないため、自然言語理解タスクにおいて従来の識別モデルの性能向上が難しいので、ラベルのない大規模なテキストデータを利用して生成的事前学習を行い、その後、識別的なタスク固有のファインチューニングを行うアプローチを採用している。

ファインチューニング時にタスクに応じた入力変換を行うことで、モデルアーキテクチャの変更を最小限に抑えつつ、効果的な転移学習能力を実現した。

ラベルのないテキストコーパスでの事前学習により、言語モデルは多様な文脈や意味の理解を学習することができ、これがタスク固有のデータへのファインチューニング時に高い転移学習能力を発揮する理由であると考えられる。

まず、ラベルのない大規模なテキストコーパスで生成的事前学習を行う。この過程では、自己回帰的な言語モデリングタスクを利用して、モデルに文脈の理解を学習させる。

事前学習により、タスクに依存しない一般的な表現を学習し、最小限のファインチューニングでタスク固有の性能向上を実現している。

ラベル付きデータが不足している場合、従来の教師あり学習モデルの適用が制約される問題に対して、未ラベルデータを活用する方法が提案されている。

提案手法は、12の自然言語理解タスク中9つで最先端を超える性能を達成。

半教師あり学習の初期のアプローチは、未ラベルのデータを使い、単語レベルの統計情報を計算していた。

後に、単語埋め込み(word embeddings)の利用が広まり、これが様々なタスクでの性能向上に貢献した。

本研究のアプローチは単語レベルの情報以上を捉え、文レベルやフレーズレベルの意味を学習し、転移することを目的としている。

Transformerを利用することで、リカレントネットワークよりも長期依存性のあるテキストを効果的に処理可能にしている。

他のアプローチと比較して、本研究は最小限のモデル変更で幅広いタスクに適応可能であることが特徴である。本研究はタスク固有のモデルアーキテクチャの変更をほとんど必要としないため、広範囲なタスクに容易に適応できる。

ファインチューニング時に、事前学習したTransformerブロックの最終活性化出力(hm_l)を利用し、新たに線形出力層(Wy)を追加して予測を行う。

従来のファインチューニング手法との違いとして:

言語モデリング(=次単語予測タスク)を補助的な目的関数として取り入れることにより、タスクに依存しない一般化能力を維持する役割を果たし、過学習を防ぎながら学習を進める効果がある。

以下の2つの点で性能が向上する: 一般化能力の向上、学習の収束速度の向上。(過去の研究より流用 [50], [43])

事前学習モデルが連続したテキストに基づいて訓練されているため、そのままでは質問応答やテキスト含意などのタスクに適用できない。しかし、各タスクに応じた特定の変換(文の順序を変えたり、区切りトークンを追加したり)を施すことで、事前学習モデルを直接利用できるようにしている。

各タスクに応じた特定の変換:

テキスト含意: 前提文 p と仮説 h を連結し、その間に区切りトークン ( $ ) を挿入する。

類似性タスク: 2つの文に順序がない場合、両方の順序で文を並べた2つの入力を作成し、それぞれの入力を独立して処理し、最終的に得られた表現を要素ごとに加算して出力層に渡す。

質問応答・常識推論: 文脈 z、質問 q、可能な答えのセット {ak} を連結し、文脈と質問の間、および質問と答えの間に区切りトークンを挿入して [z; q; $; ak] という形式でモデルに入力する。それぞれのシーケンスを独立して処理し、ソフトマックス層を通じて答えの分布を出力する。

追加のアーキテクチャを学習せずに入力変換を行うアプローチにより、モデルの汎用性と転移学習能力を最大限に活用している。

正則化の工夫: ドロップアウトとL2正則化の改良版を併用し、過学習を抑制している。特に、L2正則化の改良版 (w = 0.01) が適用されている。

BooksCorpusデータセット: 長距離依存性を持つ連続したテキストにより、モデルが長いコンテキストを考慮した予測を学習できるようになっている。

事前学習: BooksCorpusデータセットを使用し、12層のデコーダーモデルを訓練。768次元の状態と12の自己注意ヘッドを持つトランスフォーマーを使用し、学習率は2.5e-4で、初期2000ステップで線形増加、その後コサインスケジュールで減衰させた。エポック数は100。バッチサイズは64、トークン数は512。

ファインチューニング: 事前学習で得たハイパーパラメータを再利用。ドロップアウト率0.1を分類器に追加し、学習率6.25e-5で、バッチサイズは32。3エポックの学習がほとんどのタスクで十分であり、学習率はウォームアップ(0.2%のステップ)後、線形に減衰。

GPT(提案手法): 12層のデコーダー型トランスフォーマー

ELMo [44]: LSTMベース

モデルが単一文ではなく複数文にまたがる推論を効果的に行えることを示している。これは、文脈の長さや曖昧さへの対処能力が高まったことを示唆している。

LSTMを使用した場合(2048ユニットの単層LSTM)、平均で5.6ポイントのスコアが低下し、Transformerに劣る結果となっている。事前学習なしのモデルは、全タスクで14.8%の性能低下を示している(表5)。

補助目的の効果: 補助的な言語モデルの目的を用いることで、大規模なデータセットではより多くの特徴を学習できるため、パフォーマンスが向上する。

ゼロショットタスクの処理方法:

- CoLA(文法許容性): 生成モデルが割り当てる平均トークンの対数確率をスコアとして使用し、しきい値を超えたものを正解として判定する。

- SST-2(感情分析): 各サンプルに「very」というトークンを末尾に追加し(append)、生成モデルの出力を「positive」と「negative」に限定する。モデルが割り当てた確率が高い方を感情の予測結果とする。

- RACE(質問応答): 生成モデルが割り当てる平均トークンの対数確率に基づいて、ドキュメントと質問に最も適切な回答を選択する。

- DPRD(Winogradスキーマ): 確定代名詞を2つの参照語に置き換え、それぞれの代名詞に続く文の平均トークン対数確率を生成モデルが高く評価した方を予測結果とする。

教師なし学習の可能性を示し、新しい研究方向性を提案したとの主張。

[37] I. Loshchilov and F. Hutter. Fixing weight decay regularization in adam. arXiv preprint arXiv:1711.05101, 2017.