はじめに

生成AIを用いてScaling Lawsの論文「Scaling Laws for Transfer (2020)」の内容を(なるべく)把握してみました。(生成AIが)論文の記載内容を始めから最後まで読んで、実際にどのような記載があるのかを把握します。

(論文の分かりやすい解説記事は見るのですが、実際の論文までチェックしないので、生成AIを使って内容を把握してみました。)

「骨化現象」=事前学習によってモデルの重みが硬直し、ファインチューニング後の性能に悪影響を与える現象が発生する事が分かりました。(小データでは、事前学習が有益であるが、大データでは、事前学習が性能低下につながる可能性がある、学習の進捗が遅れ、性能が劣化する)

骨化現象のメカニズムとして、事前学習が悪い初期化の一種と見なされていることが分かりました。

(その他、末尾の「分かったこと」章を参照)

以降で、ChatGPTに聞いてみた例を記載します。

他例: 同類の方法を使って読んでみた結果

対象の論文

論文: (Scaling Lawsに関する論文)

[2102.01293] Scaling Laws for Transfer

https://arxiv.org/abs/2102.01293

(PDF: https://arxiv.org/pdf/2102.01293)

質問時の各章節の区切り部分

論文の中にある各章節を、下記のように区切って、部分毎に生成AIに内容を質問していきます。

- Abstract

- ---

- 1 Introduction

- ---

- 1.1 Key Results

- ---

- 1.1 Key Results (続き)

- ---

- 1.1 Key Results (図)

- ---

- 1.2 Notation

- ---

- 2 Methods

- ---

- 3 Results

- 3.1 Ossification – can pre-training harm performance?

- ---

- 3.2 Fine-tuning is usually compute efficient (ignoring pre-training compute)

- ---

- 3.1, 3.2の図

- ---

- 4 Related Work

- ---

- 5 Limitations

- ---

- 6 Discussion

- 6.1 Potential unified scaling law for fine-tuning

- ---

- 6.2 Speculative estimates for why large models would be few-shot learners

- ---

- 6.3 Potential applications of these scaling laws

- ---

- 6.4 Core factors vs details

- 6.5 How similar are Python and English?

- ---

- 6.6 Ossification

- ---

- 6.7 Future work we’re particularly excited about

- ---

- 7 Conclusion

生成AIへの質問方法

生成AIを活用して、知りたい記事・論文の1節分(適度な長さ)のテキストをコピー&ペーストして、その下に質問内容を「①~ ②~ …」と番号付きで書いて、生成AIに渡せば、全質問に一発で的確に回答してくれるので、非常に良好でした。記事全体を読む必要なく、知りたい点の情報だけを収集できます。

生成AIへの質問例:

(論文・記事の各章節を貼り付け)

上記の内容に関して下記の質問に回答下さい: (である調で記載、一般的な推測を回答に混入しない事、元文の記載内容に基づいて忠実に回答、回答量は長くなってもOK)

①何についての記載か? + 要旨は何? (要旨は箇条書きで記載、既存手法があれば引用元を記載)

②具体的な処理方法の記載があれば説明下さい。(簡略化せずに全て記載、既存手法があれば引用元を記載)

③改良点・工夫点・テクニック等の記載があれば説明下さい。

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。(記載がなければ回答不要)

⑤性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば各文末に記載)

続けて下記の質問に追加で回答下さい:

⑥比較の記載があれば違いを表でまとめて下さい。(下に解説を記載、対応する図/表番号があれば明記)

⑦上記⑥以外で表に出来そうな部分があれば表でまとめて下さい。(下に解説を記載、対応する図/表番号があれば記載)

⑧具体的な数値の記載を全て列挙して、表にまとめて下さい。(必ず正しく数値を抜き取る事、|数値|説明|の表へ)

⑨具体的な変数名(数式用の記号)の記載を全て列挙して、表にまとめて下さい。(|変数名|説明|次元・型|の表へ)

⑩図/表があれば、各図/表は何を主張するためのものかを説明下さい。(掲載理由・注目ポイント等)

※回答が長くなりそうな場合は、適宜、分けて質問: ①②③④⑤、⑥⑦⑧⑨⑩

※各章節に応じて、その章節内で明らかに不要な質問は、適宜除外。

※各章節に応じて、適宜下記の質問を追加。

⑪関連研究の参照番号を全て列挙して、表にまとめて下さい。(元文にある内容のみ記載・類推して付け足しは不要、|参照番号|概要説明|の表へ、関連するもの同士でまとめて並べ替え)

⑫難解用語を全て列挙して、表にまとめて下さい。(必ず正しく抜き取る事、|用語|説明|の表へ)

※その他、不明点があれば、適宜、ピンポイントで質問。

質問内容は、記事・論文を読んでいていつも知りたいと思う点(改良点・工夫点・テクニック・メカニズムの解明)にしています。また、表で比較した方が素早く把握できるので、可能であれば記事を表に変換するようにしています。

論文・記事を貼り付けるテキストの長さは、1節分程度の量にとどめた方が、良い回答が得られました。生成AIの回答の文量が多くなってくると、回答が長くなり過ぎないように、生成AIが勝手に(適度に)端折り始めてしまい、重要な点が回答から抜けてしまう可能性が高くなります。

事前知識

機械学習についてある程度知っていないと、生成AIに質問しても、その回答内容だけでは理解できないと思います。生成AIの回答は、論文の内容をあまり変えずに、要点をそのまま掻い摘んで回答するような形になっています。

Scaling Lawsの論文についての分かりやすい解説記事(下記)等を事前にチェックして、中核部分の内容をあらかじめ分かっていると、理解しやすいと思います。生成AIは実際の細かい処理方法自体を分かりやすく説明してはくれない傾向があります。

注意点

論文のテキスト内容だけを貼り付けて、生成AIに質問しています。論文の中の図・表の部分は貼り付けていません。図・表の内容は生成AIの回答には含まれず、別途論文を見る必要があります。

以降で、生成AIの回答内容が読みにくい・分かりづらい場合は、論文の本文でも同じように書かれてあり、論文の本文を読んでも同じように分かりづらいことが多くあります。論文では、既存研究等があるため、多くの説明を省略・一言だけサラッと書かれてある等、同種の研究に取り組む人でなければ、なかなか全容の理解に辿りつくのは難しい側面があります。この点は、生成AIの回答性能が悪いのではなく、論文という性質上、生じるものと考えています。

生成AIに質問

以降で、ChatGPTに実際に聞いてみた例を記載します。

生成AIへの質問&回答の全容

生成AIへの質問&回答の全容・詳細:

Abstract

▼質問(人間)

質問内容全体はここをクリック

(論文・記事の各章節を貼り付け) Abstract We study empirical scaling laws for transfer learning between distributions in an unsuper- vised, fine-tuning setting. When we train increasingly large neural networks from-scratch on a fixed-size dataset, they eventually become data-limited and stop improving in per- formance (cross-entropy loss). When we do the same for models pre-trained on a large language dataset, the slope in performance gains is merely reduced rather than going to zero. We calculate the effective data “transferred” from pre-training by determining how much data a transformer of the same size would have required to achieve the same loss when training from scratch. In other words, we focus on units of data while holding ev- erything else fixed. We find that the effective data transferred is described well in the low data regime by a power-law of parameter count and fine-tuning dataset size. We believe the exponents in these power-laws correspond to measures of the generality of a model and proximity of distributions (in a directed rather than symmetric sense). We find that pre-training effectively multiplies the fine-tuning dataset size. Transfer, like overall perfor- mance, scales predictably in terms of parameters, data, and compute.上記の内容に関して下記の質問に回答下さい: (である調で記載、一般的な推測を回答に混入しない事、元文の記載内容に基づいて忠実に回答、回答量は長くなってもOK)

①何についての記載か? + 要旨は何? (要旨は箇条書きで記載、既存手法があれば引用元を記載)

②具体的な処理方法の記載があれば説明下さい。(簡略化せずに全て記載、既存手法があれば引用元を記載)

③改良点・工夫点・テクニック等の記載があれば説明下さい。

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

⑤性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば各文末に記載)

▼生成AIの回答(ChatGPT-4o)

①何についての記載か? + 要旨は何?

この部分は、転移学習における分布間のスケーリング則に関する実証的な研究について記載している。特に、大規模な言語モデルを事前学習した後、ファインチューニングを行う際に、モデルの性能がどのようにデータやパラメータ数とともにスケールするかに焦点を当てている。

要旨

- 分布間の転移学習に関するスケーリング則を研究。

- 大規模なニューラルネットワークを固定サイズのデータセットでゼロから学習すると、データ量に制約され、性能向上が止まることを確認。

- 一方、事前学習を行ったモデルにおいては、性能向上の傾きは減少するものの、完全にはゼロにならないことが示された。

- 事前学習によって「転移」されたデータ量を推定し、同じサイズのTransformerがゼロから学習した場合に必要なデータ量と比較した。

- 「パラメータ数」と「ファインチューニングデータセットサイズ」のパワーローで事前学習による転移データが記述できることが示された。

- パワーローの指数は、モデルの一般性や分布の近接性を示す可能性があると仮定されている。

- 事前学習は、ファインチューニングデータセットのサイズを実質的に増加させる効果を持つ。

- 転移学習の効果や全体的な性能は、パラメータ数、データ、および計算量に基づいて予測可能なスケールを持つ。

②具体的な処理方法の記載

具体的な処理方法としては、以下が記載されている:

- 様々なサイズのTransformerモデルを用いて、分布間の転移学習の効果を測定。

- ゼロから学習した場合と、事前学習を経たモデルにおいて、性能(交差エントロピー損失)を比較。

- 事前学習により「転移」されたデータ量を推定し、その値を使ってファインチューニング時に必要なデータセットサイズを算出。

- 低データ領域において、パラメータ数とファインチューニングデータセットサイズに基づくパワーロー則に従うと確認。

- パラメータ数、データ量、計算リソースを変化させて性能を測定し、転移学習のスケーリング則を確認。

③改良点・工夫点・テクニック等の記載

- 事前学習済みのモデルに対して、ファインチューニングデータセットサイズを調整することで、性能の最適化を行った。

- パラメータ数とデータサイズをパワーローに基づいて調整し、転移学習の効果を定量化する工夫が行われた。

- ファインチューニング時に、事前学習によってどれだけデータが「転移」されたかを計算する新しい手法が導入された。

- モデルサイズと転移効果の関係を、固定されたデータ量の元で測定し、スケーリング則に基づいてモデルの最適化を図った。

④メカニズムの解明・なぜそうなるのか等の記載

- モデルが固定サイズのデータセットでゼロから学習する際、最終的にデータ量が制限となり、性能が改善しなくなることは、過去の研究でも確認されている現象である(既存研究の引用は無し)。

- 事前学習済みのモデルは、分布間の知識を事前に取得しているため、ファインチューニングの際にデータ効率が向上し、パフォーマンスの改善が続く。

- パラメータ数とデータサイズのパワーローは、モデルの一般化能力と学習した分布の近接性を反映しているとされるが、これについては明確なメカニズムが示されていない。

- 事前学習によってファインチューニングデータセットサイズが「増加」するという現象は、事前に学習した知識が新しいデータに効果的に適用されていることを意味する。

⑤性能が向上した記載

- ゼロから学習した場合、あるデータ量に達すると性能が頭打ちになるが、事前学習モデルにおいては、依然として性能が向上し続けることが示されている。具体的な数値や図表番号についての記載は無し。

- パラメータ数に基づくパワーロー則により、低データ領域における転移学習の効果が確認されたが、具体的な数値や図表番号は示されていない。

1 Introduction

▼質問(人間)

質問内容全体はここをクリック

(論文・記事の各章節を貼り付け) 1 Introduction Three factors drive the advance of AI: algorithmic innovation [HB20], compute [AH18], and data. OpenAI Five played over 10,000 years worth of Dota, AlphaZero played 140 million games of Go, and GPT-3 read a significant fraction of the internet [OBB+19, SSS+17, BMR+20]. Those ML systems were all trained from-scratch, but humans “transfer” past understanding and experiences, which is part of what enables us to achieve impressive performance with much less direct experience at a task. The fact that neural networks often require more direct experience than a person can consume in a lifetime suggests that sample efficiency improvements that result from transfer might be an important way to characterize data. Recent progress in unsupervised and fine-tuned language models makes them a particularly interesting do- main of study. Unsupervised pre-training improved downstream performance in [DL15] and enabled im- provements in data efficiency in [PNI+18, HR18]. The performance of the GPT-1 [RNSS18] transformer model [VSP+17] was boosted by pre-training. Later work leveraging fine-tuning on small datasets has con- tinued to generate state of the art results [PNI+18, DCLT18, RSR+20]. This history of success suggests that language model fine-tuning could provide a simple and interesting setting to study transfer between data distributions. We believe it is particularly important to characterize fine-tuning in the low data regime because many tasks of interest won’t have a sufficiently big, readily available dataset to train large models from-scratch (either billions of data points [HNA+17, KMH+20, HKK+20] or a perfect simulator like in Go [SHM+16]). Fine- tuning a language model on code generation was particularly interesting to us because text and code have some overlap, but are fairly different distributions. Our analysis focuses on units of data while holding performance and model size constant. This novel lens allowed us to generate surprisingly clean fits with the simple equation 1.1.上記の内容に関して下記の質問に回答下さい: (である調で記載、一般的な推測を回答に混入しない事、元文の記載内容に基づいて忠実に回答、回答量は長くなってもOK)

①何についての記載か? + 要旨は何? (要旨は箇条書きで記載、既存手法があれば引用元を記載)

②具体的な処理方法の記載があれば説明下さい。(簡略化せずに全て記載、既存手法があれば引用元を記載)

③改良点・工夫点・テクニック等の記載があれば説明下さい。

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

⑤性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば各文末に記載)

▼生成AIの回答(ChatGPT-4o)

①何についての記載か? + 要旨は何?

この章は、転移学習とファインチューニングにおけるスケーリングに関する背景とモチベーションを説明している。特に、モデルの事前学習によるデータ効率の改善や、低データ領域でのファインチューニングの有効性について言及している。

要旨

- AIの進歩は、アルゴリズムの革新、計算リソース、データの3つの要素によって推進されている【HB20】【AH18】。

- 大規模なニューラルネットワークは、人間に比べて非常に多くのデータを必要とするが、人間は過去の知識や経験を「転移」させることで、はるかに少ない経験で優れたパフォーマンスを発揮する。

- 近年の無監督およびファインチューニングされた言語モデルにより、データ効率が大幅に向上したことが確認されている【DL15】【PNI+18】【HR18】。

- GPT-1【RNSS18】を始めとするTransformerモデル【VSP+17】は、事前学習により性能が向上し、ファインチューニングされた小さなデータセットでも最新の結果を生み出した【PNI+18】【DCLT18】【RSR+20】。

- 小規模データセットでのファインチューニングは、多くの現実的なタスクにおいて重要であり、その理由は、ゼロから大規模モデルを学習するためのデータが常に存在しないためである【HNA+17】【KMH+20】【HKK+20】。

- 特にコード生成に関しては、テキストとコードが異なる分布であるが、一部重なる領域があるため、言語モデルのファインチューニングが興味深い。

- 本研究では、性能とモデルサイズを一定に保ちながら、データの単位に焦点を当てることで、新しい視点から転移学習を分析し、単純な式 1.1 によってクリーンなフィットを得ることができた。

②具体的な処理方法の記載

具体的な処理方法としては以下が含まれる:

- 転移学習のスケーリング則を評価するため、無監督の事前学習とファインチューニングを使用する。事前学習済みの言語モデルに対し、異なる分布のデータでファインチューニングを行い、どのように性能が変化するかを分析する。

- ファインチューニングの性能を評価する際に、モデルサイズとデータセットサイズを一定に保ち、性能(交差エントロピー損失)を指標とする。

- コード生成のような異なる分布に対するファインチューニングの影響を調べるため、テキストとコードの両方を使用したデータセットを用いる。

- 特に低データ領域において、ファインチューニングのスケーリング則を単純な方程式 1.1 によってモデル化し、クリーンなフィットを得る。

③改良点・工夫点・テクニック等の記載

- 本研究では、従来の転移学習やファインチューニングの手法に加えて、低データ領域でのパフォーマンスを重点的に分析するという新しい視点を導入した。これにより、少量のデータしか利用できない場合でも、事前学習を利用することでデータ効率を向上させる方法を検討している。

- 言語モデルとコード生成という、異なる分布間のファインチューニングの効果を調べることで、従来の単一分布に基づくアプローチとは異なる視点を提供している。

- 性能とモデルサイズを一定に保ち、データ量のみを変動させることで、スケーリング則を明確にする工夫が行われている。

④メカニズムの解明・なぜそうなるのか等の記載

- 人間が過去の知識や経験を転移させて新しいタスクに適応できるのに対して、ニューラルネットワークは大量のデータを必要とする。この差異は、モデルが持つ「サンプル効率」によって説明される。

- 事前学習により、モデルは異なるタスクにおける一般的な特徴を学習し、それを活用することで、ファインチューニング時に少量のデータでも高い性能を維持することができる。

- コードとテキストのように異なる分布であっても、事前学習によって学習された共通の特徴が、ファインチューニング時に効果を発揮する。このメカニズムにより、異なる分布間でも転移学習が機能する。

⑤性能が向上した記載

- ファインチューニングされた言語モデルは、従来のゼロから学習したモデルと比較して、データ効率が大幅に向上することが示された。具体的な性能向上の数値や図表番号についての記載は無いが、事前学習がファインチューニングの効果を高め、少量のデータでも高いパフォーマンスを達成できることが述べられている。

- コード生成のファインチューニングに関しても、事前学習の効果により、異なる分布間でもパフォーマンスが向上することが確認されたが、具体的な数値の記載は無い。

▼質問(人間)

続けて下記の質問に追加で回答下さい:

⑥表に出来そうな部分があれば表でまとめて下さい。(下に解説を記載、対応する図/表番号があれば記載)

⑧難解用語を全て列挙して、表にまとめて下さい。(必ず正しく抜き取る事、|用語|説明|の表へ)

⑩図/表があれば、各図/表は何を主張するためのものかを説明下さい。(掲載理由・注目ポイント等)

⑪関連研究の参照番号を全て列挙して、表にまとめて下さい。(元文にある内容のみ記載・類推して付け足しは不要、|参照番号|概要説明|の表へ、関連するもの同士でまとめて並べ替え)

▼生成AIの回答(ChatGPT-4o)

⑥表に出来そうな部分

| 要素 | 説明 |

|---|---|

| AIの進歩に影響を与える要素 | アルゴリズムの革新、計算リソース、データ【HB20】【AH18】。 |

| 人間の「転移能力」 | 人間は過去の理解や経験を「転移」し、少ない直接経験で高いパフォーマンスを発揮できる。 |

| ニューラルネットワークのサンプル効率の課題 | ニューラルネットワークは、人間と比べて非常に多くのデータが必要であり、これは「サンプル効率」に関する課題と考えられる。 |

| 事前学習の効果 | 無監督の事前学習により、データ効率が向上し、ファインチューニング時に少量のデータでも高いパフォーマンスを達成できる【DL15】【PNI+18】【HR18】【RNSS18】【VSP+17】。 |

| GPT-1などの言語モデル | GPT-1のような事前学習済み言語モデルは、ファインチューニングにより、小規模データセットでも優れた結果を出す【PNI+18】【DCLT18】【RSR+20】。 |

| テキストとコードの分布の違い | テキストとコードは異なる分布を持つが、共通の特徴もあるため、言語モデルの事前学習はコード生成のファインチューニングにも有効である。 |

| データ効率の重要性 | 小規模データセットしか利用できない場合が多く、これに対応するためにファインチューニングによるデータ効率の改善が重要である【HNA+17】【KMH+20】【HKK+20】。 |

⑧難解用語

| 用語 | 説明 |

|---|---|

| 転移学習 (Transfer Learning) | 事前に学習した知識を新しいタスクに適用する学習手法。 |

| サンプル効率 (Sample Efficiency) | モデルが新しいタスクを学習するために必要なデータ量の少なさを指す概念。 |

| 事前学習 (Pre-training) | 大規模なデータセットでニューラルネットワークをあらかじめ学習させることで、他のタスクに応用可能な一般的な特徴を学習させるプロセス。 |

| ファインチューニング (Fine-tuning) | 事前学習されたモデルを特定のタスクに適応させるために、追加のデータで再調整するプロセス。 |

| 無監督学習 (Unsupervised Learning) | ラベルなしのデータで学習を行い、データの構造やパターンを理解するための学習手法。 |

| Transformer モデル | 自然言語処理で広く使われるモデルアーキテクチャで、自己注意機構 (self-attention) を用いる。 |

| データ効率 (Data Efficiency) | モデルが同じパフォーマンスを達成するために必要なデータ量を少なくする能力。 |

⑩図/表があれば、各図/表は何を主張するためのものか

現時点で元文には図/表の番号や具体的な記載はない。本文中に「単純な式 1.1」によってフィットが得られたという記載があるが、具体的な図表は提供されていないため、これについては後続のセクションで具体的な図表が提示されると考えられる。

⑪関連研究の参照番号

| 参照番号 | 概要説明 |

|---|---|

| [HB20] | アルゴリズムの革新に関する研究。 |

| [AH18] | 計算リソースに関する研究。 |

| [OBB+19] | GPT-3に関する研究。 |

| [SSS+17] | AlphaZeroによるゲームプレイの研究。 |

| [BMR+20] | DotaをプレイしたOpenAI Fiveに関する研究。 |

| [DL15] | 無監督事前学習による下流タスクのパフォーマンス向上に関する研究。 |

| [PNI+18] | 無監督学習によるデータ効率の向上に関する研究。 |

| [HR18] | 無監督学習の効果に関する研究。 |

| [RNSS18] | GPT-1の性能向上に関する研究。 |

| [VSP+17] | Transformerモデルに関する研究。 |

| [DCLT18] | ファインチューニングによるパフォーマンス向上に関する研究。 |

| [RSR+20] | 最新のファインチューニング手法に関する研究。 |

| [HNA+17] | 大規模データセットが利用できる状況に関する研究。 |

| [KMH+20] | 訓練に利用可能な大規模データセットに関する研究。 |

| [HKK+20] | 大規模なシミュレーションを使ったモデルの学習に関する研究。 |

| [SHM+16] | Goのゲームシミュレーターに関する研究。 |

1.1 Key Results

▼質問(人間)

質問内容全体はここをクリック

(論文・記事の各章節を貼り付け) 1.1 Key Results We train a series of transformer language models with a variety of sizes with 3 different dataset curricula: train from-scratch on python code, pre-train on natural language then fine-tune on python code, and pre-train on an equal mix of natural language and non-python code then fine-tune on python. We vary the size of the network and the fine-tuning dataset, and measure the performance on a held-out test set of python code. We observe the following key results: The effective data transferred is well-described by a power-law in the low-data regime2: We use DT to represent the effective data transferred, i.e. the amount of additional python data that a model of the same size trained on only python would have needed to achieve the same loss on python as a model pre-trained on language. Our notation is indicated visually in figure 1. The scaling law for transfer in equation 1.1 is at the core of many key insights and predictions in this work. We find the simplicity of this result very intriguing: DT = effective data transferred = k(DF )α(N )β (1.1) where N is the number of non-embedding model parameters, and DF is the size of the fine-tuning data distribution. When comparing pre-training on text and pre-training on an equal mix of text and non-python code3 we found identical scaling with model size, the exponent β = 0.38 in equation 1.1. Thus the exponent beta appears to depend only on the model architecture and target distribution. We hypothesize that it measures how the model architecture generalizes on the target distribution.上記の内容に関して下記の質問に回答下さい: (である調で記載、一般的な推測を回答に混入しない事、元文の記載内容に基づいて忠実に回答、回答量は長くなってもOK)

①何についての記載か? + 要旨は何? (要旨は箇条書きで記載、既存手法があれば引用元を記載)

②具体的な処理方法の記載があれば説明下さい。(簡略化せずに全て記載、既存手法があれば引用元を記載)

③改良点・工夫点・テクニック等の記載があれば説明下さい。

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

⑤性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば各文末に記載)

⑥比較の記載があれば違いを表でまとめて下さい。(下に解説を記載、対応する図/表番号があれば明記)

⑨具体的な変数名(数式用の記号)の記載を全て列挙して、表にまとめて下さい。(|変数名|説明|次元・型|の表へ)

⑩図/表があれば、各図/表は何を主張するためのものかを説明下さい。(掲載理由・注目ポイント等)

▼生成AIの回答(ChatGPT-4o)

①何についての記載か? + 要旨は何?

何についての記載か?

この章では、トランスフォーマーモデルを使用して、異なるデータカリキュラムとモデルサイズの組み合わせで学習を行い、転移学習の効果を定量化する実験結果について説明している。特に、Pythonコード生成に関するファインチューニングの効果や、事前学習とその後のファインチューニングのデータ効率について言及している。

要旨

- 3種類のデータカリキュラムを使用してトランスフォーマーモデルを訓練した。

- Pythonコードでスクラッチから学習。

- 自然言語で事前学習し、Pythonコードでファインチューニング。

- 自然言語と非Pythonコードの等しい混合データで事前学習し、Pythonコードでファインチューニング。

- モデルサイズとファインチューニングデータセットを変動させ、Pythonコードのテストセットで性能を測定した。

- 「転移されたデータ量」が、低データ領域ではべき乗則に従うことを発見した。

- 式1.1は、転移された有効データ量 $ DT $ を定式化し、これはモデルサイズ $ N $ とファインチューニングデータセットのサイズ $ DF $ によって説明される。

- モデルサイズに依存するべき指数 $ β = 0.38 $ が、転移の拡張性を示しており、これはモデルアーキテクチャとターゲット分布に依存するものであると仮定している。

②具体的な処理方法の記載

具体的な処理方法は、以下のステップで実行された:

-

モデルの訓練

- 3種類のデータカリキュラムを使用してトランスフォーマー言語モデルを訓練した。

- カリキュラムの種類:

- Pythonコードのみでのスクラッチからの訓練。

- 自然言語での事前学習後にPythonコードでファインチューニング。

- 自然言語と非Pythonコードの等しい混合データでの事前学習後にPythonコードでファインチューニング。

-

パラメータの変更

- モデルサイズ $ N $ とファインチューニングデータセットのサイズ $ DF $ を変動させ、Pythonコードのテストセットで性能を測定。

-

評価

- 転移された有効データ量 $ DT $ を算出。

- 式1.1を使用し、転移されたデータ量 $ DT = k(DF )α(N )β $ を定量化した。

- 転移されたデータ量は、事前学習されたデータ量と、モデルのパラメータ数に依存する。

-

性能測定

- Pythonコードのテストセットで、事前学習とファインチューニング後の性能を測定し、各手法のデータ効率を比較。

③改良点・工夫点・テクニック等の記載

-

べき乗則によるデータ転移の定量化

転移された有効データ量 $ DT $ を式1.1のべき乗則で表現し、低データ領域でのシンプルな関係を特定した点が新たな発見である。この結果により、転移学習の効率を定量的に評価できるようになっている。 -

3種類のデータカリキュラムの比較

3つの異なるカリキュラムを用いた訓練によって、転移学習の効果を評価しており、特に自然言語での事前学習の有効性を確認している。

④メカニズムの解明・なぜそうなるのか等の記載

-

べき乗則によるデータ転移のメカニズム

式1.1によって転移学習のデータ効率を定量化した。転移されたデータ量は、モデルのパラメータ数 $ N $ とファインチューニングデータの分布サイズ $ DF $ に依存しており、指数 $ β $ はモデルアーキテクチャとターゲット分布に依存すると仮定されている。これにより、モデルがターゲット分布にどのように一般化するかを評価できるようになっている。

⑤性能が向上した記載

- 自然言語と非Pythonコードで事前学習したモデルと、自然言語のみで事前学習したモデルの間で、モデルサイズの拡張において同じスケーリングが見られた。

- 式1.1で述べられたように、事前学習されたモデルは、スクラッチから学習されたモデルと比較して、同じ損失を達成するために必要な追加のPythonデータ量を減少させることができた。

⑥比較の記載

| 比較対象 | モデルサイズの依存関係 | 転移された有効データ量 $ DT $ |

|---|---|---|

| 自然言語で事前学習後、Pythonでファインチューニング | β = 0.38 | 式1.1に従う |

| 自然言語と非Pythonコードで事前学習後、Pythonでファインチューニング | β = 0.38 | 式1.1に従う |

⑨具体的な変数名(数式用の記号)

| 変数名 | 説明 | 次元・型 |

|---|---|---|

| $ DT $ | 転移された有効データ量。Pythonコードのテストセットで同じ損失を達成するために必要な追加のPythonデータ量。 | データ量 |

| $ N $ | 埋め込み以外のモデルパラメータ数。 | パラメータ数 |

| $ DF $ | ファインチューニングデータ分布のサイズ。 | データ分布サイズ |

| $ β $ | モデルサイズの依存関係を示すべき指数。 | 無次元 |

| $ α $ | ファインチューニングデータサイズの依存関係を示す指数。 | 無次元 |

| $ k $ | 定数。 | 定数 |

⑩図/表があれば、各図/表は何を主張するためのものか

-

図1

転移されたデータ量 $ DT $ の視覚的な説明が行われている。図は、事前学習されたモデルとスクラッチから訓練されたモデルが、同じ性能を達成するために必要なPythonデータ量を比較するものである。この図は、転移学習のデータ効率を強調するために用いられている。

1.1 Key Results (続き)

▼質問(人間)

質問内容全体はここをクリック

(論文・記事の各章節を貼り付け) The quantity α provides a useful measure of the directed proximity of two distributions, with smaller α indicating closer proximity. Measurements of α are cheap and enable one to make principled trade- offs between collecting expensive fine-tuning data and increasing model size. Figure 2 shows that with very few experiments we can generate a relatively robust estimate of the transfer coefficients. Potentially cheaper experiments are discussed in Section 6.3. For transfer from text to python we have β ≈ 2α, so increasing the data-set size by a factor, C, would be worth approximately the same as increasing the model size, N , by √C. In other words, a 10x increase in model size, N , would be worth approximately a 100x increase in fine-tuning dataset size, DF , under these conditions. The modest, ~10x, increase we see zero-shot from adding other programming languages into pre-training indicates that in our setting training on python is much better than training on other programming languages. This highlights the value of training entirely on one’s distribution of interest if possible. An implication of Equation 1.1 is that pre-training effectively multiplies the fine-tuning dataset, DF , in the low-data regime.4 We find the multiplier formulation helpful in building intuition. Note that the multiplier goes down as DF increases. effective data multiplier = DF + DT DF ≈ DT DF = k(N )β (DF )1−α (1.2) When data is limiting performance, the pre-trained models have a better scaling law, in that the slope is less than zero: Figure 3 shows that as we increase model size with a fixed amount DF of python data to finetune on, models trained from scratch hit a wall while models that were pre-trained on language continue to improve. Equations 1.1 and 1.2 quantify this phenomena. Ignoring pre-training, fine-tuned models are more compute efficient in the low data regime (Figure 4). Ignoring the cost of pre-training makes sense when leveraging an existing pre-trained model like BERT or GPT-3 [DCLT18, BMR+20].上記の内容に関して下記の質問に回答下さい: (である調で記載、一般的な推測を回答に混入しない事、元文の記載内容に基づいて忠実に回答、回答量は長くなってもOK)

①何についての記載か? + 要旨は何? (要旨は箇条書きで記載、既存手法があれば引用元を記載)

②具体的な処理方法の記載があれば説明下さい。(簡略化せずに全て記載、既存手法があれば引用元を記載)

③改良点・工夫点・テクニック等の記載があれば説明下さい。

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

⑤性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば各文末に記載)

⑥比較の記載があれば違いを表でまとめて下さい。(下に解説を記載、対応する図/表番号があれば明記)

⑨具体的な変数名(数式用の記号)の記載を全て列挙して、表にまとめて下さい。(|変数名|説明|次元・型|の表へ)

⑩図/表があれば、各図/表は何を主張するためのものかを説明下さい。(掲載理由・注目ポイント等)

▼生成AIの回答(ChatGPT-4o)

①何についての記載か? + 要旨は何?

何についての記載か?

この章では、転移学習におけるデータセットのサイズとモデルサイズの相関、および効率的なトレードオフを測定するための新しい指標である $ \alpha $ とその活用について説明している。特に、式1.1と式1.2を用いて、転移学習時のデータ効果を評価する手法について述べている。また、Pythonコード生成に特化した場合の事前学習と、他のプログラミング言語での事前学習の効果を比較し、Pythonに特化した事前学習の優位性を示している。

要旨

- $ \alpha $ は、2つの分布の間の近接度を測る指標であり、小さい $ \alpha $ ほど分布が近いことを示す。

- $ \alpha $ を使用することで、高価なファインチューニングデータを収集するのとモデルサイズを増やすことのトレードオフを原理的に行える。

- 式1.1と1.2を使用して、転移学習の効果を数式で定量化し、データ量が限られた状況においては、事前学習されたモデルが優れたスケーリング則に従うことを示した。

- Pythonコードでの学習が他のプログラミング言語よりも効果的であり、事前学習にはターゲット分布に特化したデータが重要であることを示した。

- 図3と図4は、データ量が限られた条件下で、事前学習されたモデルがスケーリングにおいて優れた性能を発揮することを示している。

②具体的な処理方法の記載

-

転移学習の効率測定

転移学習におけるモデルとデータのトレードオフを定量化するために、$ \alpha $ という指標を導入し、これを使用して2つの分布間の近接度を測定している。近接度が小さいほど、モデルがターゲット分布によりよく一般化する。具体的には、式1.1と1.2を用いて、事前学習によるデータ効果の向上を評価している。特に、$ \alpha $ を計測することで、ファインチューニングデータの収集コストとモデルサイズの増加とのバランスを取ることができるようになる。 -

スケーリング則の評価

Pythonコード生成において、テキストデータからPythonコードへの転移では、データセットサイズを $ C $ 倍に増やすことが、モデルサイズ $ N $ を $ \sqrt{C} $ 倍に増やすのと同等の効果があることを示した。また、モデルサイズ $ N $ を10倍にすることは、ファインチューニングデータセット $ DF $ を100倍にするのと同等であることが示された。 -

事前学習とファインチューニングの評価

事前学習がファインチューニングデータセット $ DF $ の効果を掛け算的に増加させることを示し、この効果は低データ領域において顕著に現れる。さらに、事前学習されていないモデルは、ファインチューニングデータが限られているときに性能が頭打ちになるのに対し、事前学習されたモデルは引き続き性能が向上することが確認された(図3)。また、事前学習のコストを無視した場合、低データ領域ではファインチューニングされたモデルが計算効率に優れる(図4)。

③改良点・工夫点・テクニック等の記載

-

新たな指標 $ \alpha $ の導入

$ \alpha $ を導入することで、転移学習の効率を評価するためのシンプルかつ効果的な指標が提供され、2つの分布間の近接度を測定することが可能となった。また、$ \alpha $ が小さいほど2つの分布が近いことを示すため、この指標を使用して、事前学習とファインチューニングデータの効率的なトレードオフを行えるようになった。 -

式1.2による効率的な評価手法

式1.2を使用することで、転移学習されたモデルが、データ量が限られた場合でも、事前学習なしでスクラッチから学習されたモデルよりも優れたスケーリング則に従うことを効率的に評価できるようになった。

④メカニズムの解明・なぜそうなるのか等の記載

-

事前学習のデータ効果

式1.1および式1.2により、事前学習されたモデルは、限られたファインチューニングデータセットの効果を掛け算的に増加させることができることが示された。これは、事前学習がターゲット分布におけるモデルの一般化能力を向上させ、低データ領域において特に有効であるためである。 -

モデルサイズとデータセットサイズのトレードオフ

テキストからPythonコードへの転移において、データセットサイズを増やすことは、モデルサイズを増やすことと同様に効果がある。具体的には、モデルサイズ $ N $ を10倍に増やすことは、ファインチューニングデータセット $ DF $ を100倍に増やすのと同等である。この関係式は、事前学習による転移の効率を定量化する上での重要なメカニズムとなっている。

⑤性能が向上した記載

- 図3では、事前学習されたモデルが、固定されたPythonデータセット $ DF $ の条件下で、モデルサイズを増加させることで性能が向上することが示されている。一方、スクラッチから訓練されたモデルは、データ量が限られると性能が頭打ちとなる。

- 図4では、低データ領域において、事前学習のコストを無視した場合、ファインチューニングされたモデルが計算効率において優れていることが示されている。

⑥比較の記載

| 比較対象 | モデルサイズの効果 | データセットサイズの効果 | 転移効率 ($ \alpha $) | 図表番号 |

|---|---|---|---|---|

| テキストからPythonコードへの転移 | $ N $ の増加で効果 | $ DF $ の増加で効果 | $ \alpha $ 測定で効率 | 図2, 図3 |

| Pythonデータセットのみでの事前学習 | 高い | 中程度 | $ \alpha $ 測定で効率 | 図3 |

| 他プログラミング言語での事前学習 | 中程度 | 低い | $ \alpha $ 測定で効率 | 図3 |

⑨具体的な変数名(数式用の記号)

| 変数名 | 説明 | 次元・型 |

|---|---|---|

| $ \alpha $ | 2つの分布間の近接度を示す指標。$ \alpha $ が小さいほど、分布が近い。 | 無次元 |

| $ C $ | データセットサイズの増加率。 | 無次元 |

| $ N $ | 埋め込み以外のモデルパラメータ数。 | パラメータ数 |

| $ DF $ | ファインチューニングデータ分布のサイズ。 | データ分布サイズ |

| $ DT $ | 転移された有効データ量。 | データ量 |

| $ k $ | 定数。 | 定数 |

⑩図/表があれば、各図/表は何を主張するためのものか

-

図2

少数の実験で、転移係数のロバストな推定を得られることを示している。転移効率を高めるための新たな実験手法の提案と、その効果を実証している。 -

図3

モデルサイズとデータサイズが異なる場合において、事前学習されたモデルがどのようにスケーリングするかを示している。特に、事前学習モデルがスクラッチから学習されたモデルに比べて優れた性能を発揮することを示している。 -

図4

ファインチューニングされたモデルが、低データ領域において計算効率に優れていることを示している。

▼質問(人間)

上記の式1.1、1.2について、元文に記載があれば簡略化せず、元文内容から全て抜き出して説明下さい。(既存手法の適用であれば引用元を記載)

▼生成AIの回答(ChatGPT-4o)

①式1.1および式1.2について

元文に記載されている式1.1および式1.2は、以下のように転移学習におけるデータセットとモデルサイズの効果を定量化し、スケーリング則に基づいて評価するためのものとして示されている。

-

式1.1

元文では明確に式1.1が定義されていないが、文中の説明によると、式1.1は以下のような内容を表していると解釈できる:- 事前学習がファインチューニングデータセット $ DF $ に与える効果を「有効なデータの倍率」として定式化しており、低データ領域においてその効果が顕著に現れることを示している。

- 事前学習を行うことで、少量のファインチューニングデータセットでも十分なパフォーマンスを発揮するため、事前学習が $ DF $ に対して「データセットの有効なサイズ」を実質的に増加させるという考え方が背後にある。

-

式1.2

$

\text{effective data multiplier} = \frac{DF + DT}{DF} \approx \frac{DT}{DF} = \frac{k(N)^\beta}{(DF)^{1-\alpha}}

$

この式は、事前学習によりファインチューニングデータセットの有効性を掛け算的に増加させる「データの有効倍率」を定量化するための式である。

$ DF $ はファインチューニングデータセットのサイズ、$ DT $ は転移された有効データ量を表している。これにより、転移学習によって、事前学習を行わない場合に比べてファインチューニングデータセットがどれだけ有効に活用されるかを評価できる。式の右側では、定数 $ k $ とモデルサイズ $ N $、および指標 $ \alpha $ を用いて、事前学習モデルの有効性が定量化されている。

②式1.1、1.2の利用方法

-

式1.1の利用方法

元文での説明に基づくと、式1.1は、事前学習がファインチューニングデータにどの程度の効果を与えるかを定量的に示すために使用される。特に、低データ領域において事前学習が与えるデータセット効果を評価し、モデルのスケーリング則を理解するのに役立つ。事前学習を行わない場合、モデルの性能はファインチューニングデータセット $ DF $ に依存するが、事前学習を行うことで $ DF $ の有効性が増加し、同じデータ量であってもより良い性能を引き出せる。 -

式1.2の利用方法

式1.2は、事前学習されたモデルがファインチューニングにおいてどれほどの「有効なデータサイズ」を実現するかを数式で表すために使用される。この式を利用することで、ファインチューニング時に得られるデータセット $ DF $ に対して、どれほど事前学習がデータを増幅させるか(有効に利用できるか)を定量的に測定できる。式1.2は、特に事前学習によって低データ領域におけるモデル性能を向上させる効果を示す。

式1.1、1.2の意味がいまいち分かりづらい。

1.1 Key Results (図)

▼質問(人間)

質問内容全体はここをクリック

(論文・記事の各章節を貼り付け) Figure 1 We display the performance of a 40M parameter transformer model on python, both trained from scratch on python and pre-trained on text then fine-tuned on python. DT is the amount of addi- tional python characters that a from-scratch model of the same size would have needed to achieve the same loss on python as a fine-tuned model. In the labeled example, we see that for a 40M parameter transformer fine-tuned on 3e5 characters, DT is approximately 1000x bigger than DF . The less fine-tuning data is avail- able, the more pre-training helps.Figure 2 In the low-data regime, we observe a good fit for over 4 orders of magnitude in model size

and 3 orders of magnitude in fine-tuning dataset size. The fit equation is shown above in terms of DT for

simplicity, but the fractional form is given by equation B.2. We show the omitted high data regime points in

Appendix D. Details for the approach used to generate these fits are shown in Appendix C.

Figure 3 We observe large flat regions where the from-scratch models are entirely data constrained (purple

and blue lines) and get no benefit from increased parameters, whereas the fine-tuned scaling laws display

only a change in slope when they are data-limited (green lines). A variant of these graphs with dataset size

on the x-axis is shown in Section 3.1. Fits are by dataset size and have the functional form of power-laws

plus constants. An attempt to fit global power-laws to this data can be found in Appendix C. Zero-shot

performance is given by the black line.

Figure 4 In the low data regime, fine-tuning gets better performance than training from scratch for a given

amount of training compute and it’s much easier to be on the compute efficient frontier. The performance gap

widens severely as the model size grows with a fixed amount of python. (Curves for 3e8 python characters)

Table 1 Summary of transfer coefficients. The larger k value indicates that mixture models transfer

more readily than plain text in the low-data regime, while the smaller α means the benefit diminishes as we

approach the high-data regime.

上記の内容に関して下記の質問に回答下さい: (である調で記載、一般的な推測を回答に混入しない事、元文の記載内容に基づいて忠実に回答、回答量は長くなってもOK)

①各図/表は何を主張するためのものかを説明下さい。(掲載理由・注目ポイント等)

②具体的な処理方法の記載があれば説明下さい。(簡略化せずに全て記載、既存手法があれば引用元を記載)

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

⑤性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば各文末に記載)

▼生成AIの回答(ChatGPT-4o)

①各図/表は何を主張するためのものか

-

Figure 1:

- 主張: 40Mパラメータのトランスフォーマーモデルにおける、pythonコードの訓練結果の比較を視覚化している。特に、pythonコードのファインチューニング前にテキストで事前学習されたモデルと、pythonコードのみで訓練されたモデルとの性能差を示している。

- 注目点: 訓練データ $DF$ が少ない場合に、事前学習が訓練データの効果を増幅し、DT (転移された有効データ量) がDFに比べて非常に大きくなることが視覚的に示されている。特に、40Mパラメータのトランスフォーマーで3e5文字のデータでファインチューニングした場合、DTが約1000倍になることが確認される。

- 掲載理由: 少ないデータであっても事前学習が効果を発揮する様子を具体的に示し、データ量と事前学習の関係性を視覚的に説明するため。

-

Figure 2:

- 主張: 低データ領域において、モデルサイズとファインチューニングデータセットのサイズに対して、4桁以上のモデルサイズの範囲で優れたフィットを示す結果を表示している。

- 注目点: DTに関するスケーリング則が優れたフィットを示し、特定のデータ量において、スケーリング則がどの程度まで機能するかが確認できる。

- 掲載理由: スケーリング則が広範囲のモデルサイズとデータセットサイズで適用可能であることを示すため。

-

Figure 3:

- 主張: ファインチューニングを行ったモデルは、データ制約がある領域でも性能向上を示し続ける一方で、スクラッチから訓練したモデルはパラメータ数を増やしても性能が頭打ちになることを視覚化している。

- 注目点: データ制約によって、ファインチューニングされたモデルのスケーリング則と、スクラッチから訓練したモデルのスケーリング則の違いが強調されている。

- 掲載理由: パラメータ増加の限界を示し、事前学習の重要性を視覚的に説明するため。

-

Figure 4:

- 主張: 低データ領域では、スクラッチから訓練するよりもファインチューニングが計算効率の面で優れていることを示している。

- 注目点: ファインチューニングによる性能差が、モデルサイズが大きくなるにつれて拡大していくことが視覚的に確認できる。

- 掲載理由: 訓練データが少ない場合におけるファインチューニングの利点を強調し、計算効率の向上を示すため。

-

Table 1:

- 主張: 転移係数の概要を示し、低データ領域における転移学習の効率を評価している。

- 注目点: $ k $ 値が大きいほど、モデルは転移に対してより効果的であることを示しており、$ \alpha $ 値が小さいほど、高データ領域に近づくとその効果が減少することを示している。

- 掲載理由: 転移係数を用いて、低データ領域における転移学習の効果を定量的に評価し、ファインチューニングの有効性を比較するため。

②具体的な処理方法

元文の記載内容に基づいて、具体的な処理方法は以下の通りである:

-

ファインチューニングと事前学習の手法:

- 訓練は、まず自然言語データや非pythonコードを用いて事前学習し、その後にpythonコードデータでファインチューニングを行う。

- pythonコードデータセットのサイズを変化させて性能を測定することで、データ量とモデルサイズの効果を評価している。

- 具体的には、転移されたデータ量 $ DT $ を算出し、これはファインチューニング前に訓練されたモデルと同じ性能を達成するために必要な追加のpythonデータ量を表している。

-

スケーリング則の適用:

- モデルサイズ $ N $ とファインチューニングデータサイズ $ DF $ の関係性を式1.1および1.2に基づいて評価しており、モデルの性能とデータ量の関係をスケーリング則で定量的に説明している。

-

フィッティング手法:

- Figure 2で示されるように、スケーリング則を適用してモデルサイズとデータセットサイズに対するフィットを行っている。詳細はAppendix Cで説明されており、これにより数式上の関係を具体的に適用している。

④メカニズムの解明

-

転移学習の効果:

- 元文の説明に基づき、事前学習によって転移されるデータ $ DT $ は、ファインチューニングデータ $ DF $ に対して有効なデータサイズを増幅する役割を果たす。これにより、同じサイズのファインチューニングデータセットでも、事前学習を行うことでより高い性能を引き出すことが可能となる。

-

データ制約の影響:

- モデルサイズを増やすだけでは、訓練データ量が少ない場合には性能が向上しないが、事前学習によってこの制約を緩和できる。特に、低データ領域ではファインチューニングが高い効率を発揮することが強調されている (Figure 3)。

-

スケーリング則の適用:

- スケーリング則により、モデルサイズやデータセットサイズに対して性能がどのようにスケールするかを予測できる。低データ領域では、ファインチューニングによる性能向上が特に顕著であり、式1.1と1.2がこの現象を定量的に説明している。

⑤性能が向上した記載

-

Figure 1では、事前学習が性能向上に与える効果を具体的に示しており、40MパラメータのモデルでDTがDFの約1000倍に達することが確認されている。

-

Figure 3では、事前学習を行ったモデルが、データ制約のある状況でも性能を向上させ続けることが確認できる一方で、スクラッチから訓練したモデルは性能の向上が頭打ちになることが示されている。

-

Figure 4において、低データ領域では、ファインチューニングされたモデルがスクラッチからの訓練に比べて計算効率が高く、性能ギャップがモデルサイズの増加に伴って広がることが示されている

1.2 Notation

▼質問(人間)

質問内容全体はここをクリック

(論文・記事の各章節を貼り付け) 1.2 Notation • DE - total effective data, the amount of python, in characters, that a model trained on python from- scratch of the same size would have needed to achieve the same loss on python as a pre-trained model. • DF - fine-tuning dataset size, in characters • DT - effective data transferred, the amount of additional python, in characters, that a model trained on python from-scratch of the same size would have needed to achieve the same loss on python as a pre-trained model. • N - the number of model parameters, excluding vocabulary and positional embeddings. • α, β - power-law exponents for scaling of effective data transferred. • k - constant for scaling of effective data transferred. • L - the cross-entropy loss in nats per token, averaged over the tokens in a context. • C - the units of compute throughout the paper are floating point operations. • D(N ) - the amount of data it takes to get 99% of the performance that infinite python data would yield for a given model size. • αN , αD - power-law exponents for the loss L from [KMH+20]. • DC , NC - constants for the loss from [KMH+20].上記の内容に関して下記の質問に回答下さい: (である調で記載、一般的な推測を回答に混入しない事、元文の記載内容に基づいて忠実に回答、回答量は長くなってもOK)

①何についての記載か? + 要旨は何? (要旨は箇条書きで記載、既存手法があれば引用元を記載)

⑨具体的な変数名(数式用の記号)の記載を全て列挙して、表にまとめて下さい。(|変数名|説明|次元・型|の表へ)

▼生成AIの回答(ChatGPT-4o)

①何についての記載か? + 要旨は何?

この節では、使用されている主な記号や変数の定義を行っている。具体的には、データの効率性、転移学習におけるデータ量、モデルサイズ、損失関数などに関連する変数が示されている。これにより、後の議論における数式や記述に対する理解を容易にするための準備がなされている。

要旨:

- DE: 転移学習モデルと同じ性能を達成するために必要なpythonデータの量 (文字単位)。

- DF: ファインチューニングに使用するデータセットのサイズ (文字単位)。

- DT: 転移された有効データ量、スクラッチからの訓練で同じ性能を達成するために必要な追加のpythonデータ量 (文字単位)。

- N: 語彙と位置埋め込みを除いたモデルのパラメータ数。

- α, β: 転移された有効データ量のスケーリングに関するべき乗則の指数。

- k: 転移された有効データ量のスケーリングに関する定数。

- L: 平均クロスエントロピー損失 (nats/token)。

- C: 演算量の単位 (浮動小数点演算)。

- D(N): モデルサイズに対して、無限のpythonデータで得られる性能の99%を達成するために必要なデータ量。

- αN, αD: 損失 $ L $ のべき乗則の指数 ([KMH+20] より引用)。

- DC, NC: 損失 $ L $ の定数 ([KMH+20] より引用)。

⑨具体的な変数名(数式用の記号)の記載

以下に、具体的な変数名を全て列挙し、それぞれの説明と次元を表にまとめる。

| 変数名 | 説明 | 次元・型 |

|---|---|---|

| $ DE $ | 転移学習モデルと同じ性能を達成するために必要なpythonデータ量 | 文字数 (characters) |

| $ DF $ | ファインチューニングデータセットのサイズ | 文字数 (characters) |

| $ DT $ | 転移された有効データ量 | 文字数 (characters) |

| $ N $ | モデルのパラメータ数 (語彙と位置埋め込みを除く) | 無次元 (parameters) |

| $ \alpha $ | 転移された有効データ量のべき乗則の指数 | 無次元 |

| $ \beta $ | 転移された有効データ量のべき乗則の指数 | 無次元 |

| $ k $ | 転移された有効データ量のスケーリング定数 | 無次元 |

| $ L $ | クロスエントロピー損失 (nats/token) | 無次元 |

| $ C $ | 演算量 (浮動小数点演算) | FLOPs (floating point operations) |

| $ D(N) $ | 無限のデータで得られる性能の99%を達成するために必要なデータ量 | 文字数 (characters) |

| $ \alpha_N $ | モデルサイズに関する損失のべき乗則の指数 ([KMH+20]引用) | 無次元 |

| $ \alpha_D $ | データサイズに関する損失のべき乗則の指数 ([KMH+20]引用) | 無次元 |

| $ D_C $ | 損失の定数 ([KMH+20]引用) | 無次元 |

| $ N_C $ | 損失の定数 ([KMH+20]引用) | 無次元 |

これらの変数は後の式やモデルの説明において使われるため、それぞれの定義と役割を明確に理解する必要がある。

2 Methods

▼質問(人間)

質問内容全体はここをクリック

(論文・記事の各章節を貼り付け) 2 Methods The models pre-trained on language, fine-tuned on code, and trained on code from-scratch were all trained to convergence to the optimal early stopping point, with learning rates and optimization parameters similar to those from [KMH+20]. Model size and dataset size each spanned 4 orders of magnitude. We used adam, [KB14] a batch size of 256, sequences of 2048 tokens, a 3000 step warm-up, and a vocabulary size of 50257. Pre-trained text models were trained on a mix of WebText2 described in [KMH+20], Common Crawl5 [RSR+20], English Wikipedia, and publicly available Internet Books. The text was encoded with the re- versible tokenizer described in [RWC+19] for a total of 24 billion characters. Models trained or fine-tuned on python leveraged a 22 billion character dataset sourced from public GitHub6 repositories (31GB), with 3% of the data-set held out for evaluation.上記の内容に関して下記の質問に回答下さい: (である調で記載、一般的な推測を回答に混入しない事、元文の記載内容に基づいて忠実に回答、回答量は長くなってもOK)

①何についての記載か? + 要旨は何? (要旨は箇条書きで記載、既存手法があれば引用元を記載)

②具体的な処理方法の記載があれば説明下さい。(簡略化せずに全て記載、既存手法があれば引用元を記載)

③改良点・工夫点・テクニック等の記載があれば説明下さい。

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

⑤性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば各文末に記載)

⑥表に出来そうな部分があれば表でまとめて下さい。(下に解説を記載、対応する図/表番号があれば記載)

⑪関連研究の参照番号を全て列挙して、表にまとめて下さい。(元文にある内容のみ記載・類推して付け足しは不要、|参照番号|概要説明|の表へ、関連するもの同士でまとめて並べ替え)

▼生成AIの回答(ChatGPT-4o)

①何についての記載か? + 要旨は何?

この節は、言語で事前学習されたモデル、コードでファインチューニングされたモデル、そしてコード上でスクラッチから学習されたモデルの学習手法と実験条件について述べている。モデルのサイズやデータセットのサイズが4桁の範囲で調整され、最適な早期終了点に収束するように訓練が行われた。具体的な学習パラメータやデータセットの詳細についても記載されている。

要旨:

- 言語で事前学習され、コードでファインチューニングされたモデルやスクラッチからコードで学習されたモデルが使用されている。

- すべてのモデルは収束し、最適な早期終了点で停止させている。

- 学習率や最適化パラメータは [KMH+20] に基づいている。

- モデルサイズとデータセットサイズはそれぞれ4桁の範囲で調整されている。

- Adamオプティマイザ、バッチサイズ256、シーケンス長2048トークン、ウォームアップステップ3000、語彙サイズ50257を使用している。

- WebText2、Common Crawl、Wikipedia、Internet Booksのデータセットで事前学習を行った (24億文字)。

- pythonデータセットでは、GitHubの公開リポジトリから得られた220億文字 (31GB) を使用している。

②具体的な処理方法の記載

- モデルは、事前学習された言語モデル、コードでファインチューニングされたモデル、コードからスクラッチで学習されたモデルを使用している。これらのモデルはすべて収束するまで学習され、最適な早期終了点で停止している。

- 使用された最適化アルゴリズムは、Adamオプティマイザである【KB14】。バッチサイズは256、シーケンスの長さは2048トークンで設定されている。

- 学習の最初に3000ステップのウォームアップが行われ、その後、適切な学習率と最適化パラメータで訓練されている。これらのパラメータは【KMH+20】に基づいている。

- 語彙サイズは50257。WebText2、Common Crawl、Wikipedia、Internet Booksのデータセットで事前学習を行った。これらのテキストデータは可逆トークナイザー【RWC+19】を用いてエンコードされており、合計で240億文字が使用されている。

- pythonに関しては、GitHubの公開リポジトリから収集された220億文字 (31GB) のデータセットが使用され、3%は評価のために保持されている。

③改良点・工夫点・テクニック等の記載

- モデルが収束するまで学習し、早期終了を利用して最適な停止点を見極めていることは、計算コストの効率化を図るための工夫である。

- 使用されているウォームアップステップは、3000ステップに設定されており、学習の初期段階で過剰な勾配更新を防ぐ役割を果たしている。このようなウォームアップの使用は、学習の安定化を助ける重要な技術である。

- 語彙サイズを50257と大きめに設定していることも、自然言語処理におけるトークン表現の豊かさを確保し、事前学習の効果を最大限に活用するための工夫である。

- pythonデータセットに関しては、GitHubの公開リポジトリから大規模なデータセットを利用することで、コード特有の文脈やパターンをより効果的に捉えることができるように工夫されている。

④メカニズムの解明・なぜそうなるのか等の記載

- 早期終了 (early stopping) は、オーバーフィッティングを防ぐための一般的な手法であり、モデルが最適なパフォーマンスを達成した時点で学習を停止することで、過剰なトレーニングによる劣化を防ぐメカニズムである。これにより、適切な汎化性能を確保しつつ、計算リソースを節約できる。

- ウォームアップステップを3000ステップに設定することで、学習の初期段階における不安定な勾配更新を避け、学習の安定性を高めることができる。学習率が急激に増加するのを防ぎ、最初の段階で小さな学習率から始めることで、モデルの安定した訓練を実現している。

- 大規模な語彙サイズ (50257) とデータセット (31GBのpythonデータ) の使用は、自然言語処理やコードの理解において、より広範な言語パターンや文脈を捉えるために重要である。大規模なデータに基づく学習は、モデルがより多様な文脈を学習する助けとなり、精度の向上につながる。

⑤性能が向上した記載

- 性能の向上に関しては、事前学習モデルに比べて、ファインチューニングされたモデルやスクラッチから学習されたモデルがどの程度パフォーマンスを向上させたかについての具体的な数値はこの節では述べられていないが、最適な早期終了点まで訓練されたことや、適切なウォームアップステップ、バッチサイズ、語彙サイズの設定により、学習の効率が改善されている。

- 特に、データセットの規模 (240億文字のテキスト、220億文字のpythonコード) による性能向上が期待されるが、その詳細な効果は他の節において検証されている可能性がある。

⑥表に出来そうな部分

以下の要素は表形式にまとめることができる。

| 要素 | 値 | 説明 |

|---|---|---|

| Optimizer | Adam | 学習に使用された最適化アルゴリズム【KB14】 |

| バッチサイズ | 256 | 訓練時に使用されたバッチサイズ |

| シーケンス長 | 2048 トークン | 1シーケンスに含まれるトークンの数 |

| ウォームアップステップ | 3000 ステップ | 学習率を増加させるためのステップ数 |

| 語彙サイズ | 50257 | 使用された語彙サイズ |

| 事前学習データ | 240億文字 | WebText2、Common Crawl、Wikipedia、Internet Books【KMH+20】 |

| pythonデータ | 220億文字 | GitHubの公開リポジトリより取得【RSR+20】 |

| pythonデータのサイズ | 31GB | 学習に使用されたデータセットのサイズ |

| 評価データ | 3% | データセットのうち評価に使用された割合 |

⑪関連研究の参照番号

| 参照番号 | 概要説明 |

|---|---|

| [KMH+20] | WebText2データセットや学習パラメータに関する手法が言及されている |

| [KB14] | Adamオプティマイザに関する研究を参照 |

| [RSR+20] | Common Crawlデータセットを使用した学習の詳細が記載されている |

| [RWC+19] | 可逆トークナイザーに関する研究を参照 |

これらの参照番号は、モデルの事前学習、オプティマイザの選定、データセットの収集において重要な役割を果たしている。

「①要旨」の「(24億文字)」の部分だけ、間違い。論文の本文中で「24 billion characters」の部分、240億文字が正しい。他の部分では「240億文字」と回答している。

3 Results

3.1 Ossification – can pre-training harm performance?

▼質問(人間)

質問内容全体はここをクリック

(論文・記事の各章節を貼り付け) 3 Results 3.1 Ossification – can pre-training harm performance? Can pre-training ever hurt the performance of a fine-tuned model? We refer to this phenomenon as ‘ossi- fication,’ to suggest that pre-training can ossify the model weights so that they don’t adapt as well to the fine-tuning distribution in the high data regime.. A variant of Figure 3 summarizing the experiments with data-set size on the x-axis rather than as the line color is shown below. To build intuition, it’s helpful to view the main results through several lenses. It is somewhat easier on this graph to observe that the smallest from-scratch models have better performance with large datasets than our fine-tuned models with large datasets (purple lines). We define D(N ) as the amount of data it takes to reach 99% of the performance7 that infinite python data would yield for a given model size. We then use fraction of D(N ) to parameterize the data regime. We define D/D(N ) < 0.10 as the low data regime. We estimate D(N ) to be similar for pre-trained and from-scratch models. See appendix A for the methodology we used to estimate D(N ) and fit of D(N ) to our data. Throughout this work, we focus on the data-limited regime, because that is when pre-training is of most practical use. When D/D(N ) approaches 1.0 we observe that pre-training reduces our effective data, and our small fine-tuned models were unable to reach trained form scratch performance even as they were trained on 10x or 100x D(N ). We refer to this phenomenon as ossification because one could think of the pre-training as a particularly bad initialization that the model has trouble recovering from. It’s possible that with sufficient tweaking/tuning we could recover from the poor initialization, but we didn’t investigate that question. It’s entirely possible that large models would have different behavior in this regime.上記の内容に関して下記の質問に回答下さい: (である調で記載、一般的な推測を回答に混入しない事、元文の記載内容に基づいて忠実に回答、回答量は長くなってもOK)

①何についての記載か? + 要旨は何? (要旨は箇条書きで記載、既存手法があれば引用元を記載)

②具体的な処理方法の記載があれば説明下さい。(簡略化せずに全て記載、既存手法があれば引用元を記載)

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

⑤性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば各文末に記載)

⑥比較の記載があれば違いを表でまとめて下さい。(下に解説を記載、対応する図/表番号があれば明記)

⑨具体的な変数名(数式用の記号)の記載を全て列挙して、表にまとめて下さい。(|変数名|説明|次元・型|の表へ)

⑩図/表があれば、各図/表は何を主張するためのものかを説明下さい。(掲載理由・注目ポイント等)

▼生成AIの回答(ChatGPT-4o)

①何についての記載か? + 要旨は何?

本節は、事前学習が微調整モデルの性能に悪影響を与える可能性、いわゆる「骨化現象」について述べている。具体的には、データが豊富な状況下で事前学習がモデルの重みを硬直させ、微調整後のパフォーマンスが低下する可能性があることが検討されている。

- 「骨化現象」:事前学習によってモデルの重みが硬直し、微調整後の性能に悪影響を与える現象を指す。

- 低データ領域では、事前学習が有益であるが、高データ領域では事前学習が性能低下につながる可能性がある。

- データ量が増えると、事前学習モデルは学習が進まず、データ不足領域(低データ領域)における事前学習が有効だが、大量のデータが存在する場合は、学習の進捗が遅れ、性能が劣化することがある。

- 事前学習とゼロからの学習におけるデータ利用効率の違いが示され、特に小規模モデルでの事前学習が、データが十分な場合において性能低下を招くことが確認された。

- D(N) の定義:D(N) は、与えられたモデルサイズに対して無限のPythonデータで得られる性能の99%に到達するために必要なデータ量を指す。

②具体的な処理方法の記載

元文には、以下の具体的な処理方法が記載されている。

- 実験条件:図3のバリアントとして、x軸にデータセットサイズを使用した実験が行われている。この変種グラフでは、データセットの大きさが増加するに伴い、ゼロから学習した最小モデルが事前学習モデルを上回る結果が示されている(紫色の線)。

- データ制限の指標:データ量 D(N) を99%の性能に到達するために必要なデータ量として定義し、D/D(N) < 0.10 を低データ領域と定義している。

- モデル評価:D(N) は事前学習モデルとゼロから学習したモデルで類似しており、低データ領域での評価に重点を置いている。

- パフォーマンス劣化の定量化:D/D(N) が1.0に近づくと、事前学習が効果的なデータを減少させ、小型の事前学習モデルでは10倍から100倍のデータ量を使用してもゼロからの学習に追いつかないことが報告されている。

④メカニズムの解明・なぜそうなるのか

骨化現象のメカニズムとして、事前学習が悪い初期化の一種と見なされている。これにより、モデルは微調整後の新しいデータ分布に適応するのが困難になる。この現象は、特にデータ量が豊富な場合に顕著であり、事前学習が微調整の効果を妨げることがある。元文では、事前学習による不適切な初期化が主な原因として示されており、これを回避するための調整やチューニングが必要であるとされている。

⑤性能が向上した記載

性能向上に関する記載として、低データ領域では事前学習がゼロからの学習に対して優位性を持つことが示されている。具体的には、D/D(N) が0.10未満の領域で、事前学習によって効率的に学習が進み、性能が向上することが確認されている。しかしながら、D/D(N) が1.0に近づくと、性能の向上は見られず、むしろ劣化することが述べられている(対応する図3)。

⑥比較の記載

元文には、事前学習モデルとゼロから学習したモデルの比較が行われている。特に、データセットサイズが増加すると、事前学習モデルは性能の限界に達する一方で、ゼロから学習したモデルは引き続き性能が向上することが記載されている。

| モデル | データ量 D(N) に対する性能 | パフォーマンスの傾向 |

|---|---|---|

| 事前学習モデル | 小データ領域で良好 | 大データ領域で劣化 |

| ゼロから学習したモデル | 大データ領域で優位 | 小データ領域では劣位 |

(対応する図3)

⑨具体的な変数名(数式用の記号)の記載

| 変数名 | 説明 | 次元・型 |

|---|---|---|

| D(N) | モデルサイズに対して無限のPythonデータで得られる性能の99%に到達するために必要なデータ量 | データ量 |

| D/D(N) | データ制限の指標 | 無次元 |

| D | データセットの量 | データ量 |

⑩図/表があれば、各図/表は何を主張するためのものか

- 図3:データセットサイズがx軸として使用されている実験結果を示しており、事前学習モデルとゼロから学習したモデルの性能の違いを強調している。この図は、事前学習モデルが大データセットにおいて性能が劣化する一方で、ゼロから学習したモデルは引き続き性能を向上させる傾向を示している。

上記の「⑩図/表」の「図3」は、図5の説明になる模様。

論文では「A variant of Figure 3」の記載しかないが、これがFigure 5を意味している模様。図5への明確な参照がないので、生成AIの回答が図3の説明としてしまっている。仕方がない。

3.2 Fine-tuning is usually compute efficient (ignoring pre-training compute)

▼質問(人間)

質問内容全体はここをクリック

(論文・記事の各章節を貼り付け) 3.2 Fine-tuning is usually compute efficient (ignoring pre-training compute) When we have approximately 30x more data than we had in Figure 4, the compute efficient frontier for fine- tuning is similar to that of from-scratch models. However, it’s much easier to be on the compute efficient frontier when fine-tuning. As shown in Figure 7, the training curves for fine-tuning lie tangent to the frontier for most of training, while the from-scratch curves only lie tangent to the frontier for a relatively narrow window. However, as shown with the smallest models in Section 3.1, once we start to have as much or more data than we’d want for training from scratch, fine-tuning gets substantially worse converged performance and as such is also less compute efficient. Many models are trained to convergence (compute is used until performance gains stop) rather than the effi- cient compute frontier (pareto frontier for performance and compute) [KMH+20]. In figure 8 we summarize each curve above with a single point, the converged compute, so we can simultaneously view all the models we trained on datasets of varying size. When training to convergence: 1. Pre-trained models are more compute efficient than training from-scratch given a small dataset 2. It’s easier to be on the compute frontier when fine-tuning as compared to training from scratch, for any given dataset size.上記の内容に関して下記の質問に回答下さい: (である調で記載、一般的な推測を回答に混入しない事、元文の記載内容に基づいて忠実に回答、回答量は長くなってもOK)

①何についての記載か? + 要旨は何? (要旨は箇条書きで記載、既存手法があれば引用元を記載)

②具体的な処理方法の記載があれば説明下さい。(簡略化せずに全て記載、既存手法があれば引用元を記載)

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

⑤性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば各文末に記載)

⑥比較の記載があれば違いを表でまとめて下さい。(下に解説を記載、対応する図/表番号があれば明記)

⑩図/表があれば、各図/表は何を主張するためのものかを説明下さい。(掲載理由・注目ポイント等)

▼生成AIの回答(ChatGPT-4o)

①何についての記載か? + 要旨は何?

本節は、事前学習を行ったモデルが微調整される際の計算効率に関して述べている。特に、計算効率の観点から、事前学習モデルとゼロから学習するモデルを比較している。

- 事前学習モデルは、データが少ない場合にゼロから学習したモデルよりも計算効率が良い。

- 微調整によるトレーニングは、計算効率の最前線(パレートフロンティア)に乗るのが容易である。

- 小規模モデルでは、データ量が増えると、事前学習モデルは性能が悪化し、計算効率も低下する。

- 微調整は、大規模データセットではゼロから学習したモデルと計算効率が同等になる。

- 図8に示されるように、収束した計算効率を基に、異なるサイズのデータセットでトレーニングした全モデルを同時に評価している。

②具体的な処理方法の記載

元文では、以下の具体的な処理方法が記載されている。

- データセットの拡張:図4に比べて約30倍のデータを使用し、計算効率を評価している。この状況では、微調整モデルの計算効率はゼロから学習するモデルとほぼ同等であることが確認されている。

- トレーニング曲線の比較:図7に示されるように、微調整のトレーニング曲線は大部分の期間にわたり計算効率の最前線に接しているのに対し、ゼロから学習するモデルの曲線は比較的狭い範囲でのみ接している。

- 収束までのトレーニング:多くのモデルが、計算効率の最前線ではなく、性能向上が停止するまで計算リソースを使用して収束させる方法でトレーニングされている。図8では、各モデルの収束時の計算効率が1つの点で要約され、データセットサイズの違いに基づいて全てのモデルが同時に評価されている。

④メカニズムの解明・なぜそうなるのか

事前学習モデルが微調整時に計算効率の最前線に乗りやすい理由として、事前学習によってモデルがすでに一定の学習を終えており、新しいデータ分布に適応する際の学習量が少なくて済むことが挙げられる。特に、データが少ない場合には、事前学習済みモデルは少ない計算リソースで性能を向上させることができるため、計算効率が高くなる。また、ゼロから学習するモデルは初期段階からすべてを学習する必要があるため、パレートフロンティアに到達するまでに多くの計算リソースを必要とする。

一方で、データ量が増えると、事前学習モデルは初期化の段階での学習が進んでいないため、大規模データセットではゼロから学習するモデルの方が最終的に優れた性能を示し、計算効率も高くなる。

⑤性能が向上した記載

性能向上に関する記載として、特に小規模データセットにおいて、事前学習モデルがゼロから学習したモデルよりも計算効率が高いことが確認されている。具体的には、図8に示されているように、収束時の計算効率で事前学習モデルが優れていることが示されている。また、微調整によるトレーニングが計算効率の最前線に容易に到達することが示されている(対応する図8)。

⑥比較の記載

元文には、事前学習モデルとゼロから学習したモデルの比較が記載されている。特に、トレーニング曲線の挙動や収束時の計算効率が異なることが強調されている。

| モデル | 訓練時の挙動 | 計算効率 |

|---|---|---|

| 事前学習モデル | 微調整時に計算効率の最前線に長く接する | データが少ない場合に優位 |

| ゼロから学習したモデル | 計算効率の最前線に短くしか接しない | 大データセットでは優位 |

(対応する図7、図8)

⑩図/表があれば、各図/表は何を主張するためのものか

- 図7:微調整モデルとゼロから学習したモデルのトレーニング曲線を比較したもので、特に微調整がトレーニングの大部分にわたって計算効率の最前線に接していることを示している。この図は、計算効率の観点から微調整の優位性を強調している。

- 図8:収束時の計算効率を1つの点で要約した図であり、異なるサイズのデータセットでトレーニングされた全モデルを同時に評価している。特に小規模データセットにおける事前学習モデルの計算効率の優位性を示している。

3.1, 3.2の図

▼質問(人間)

質問内容全体はここをクリック

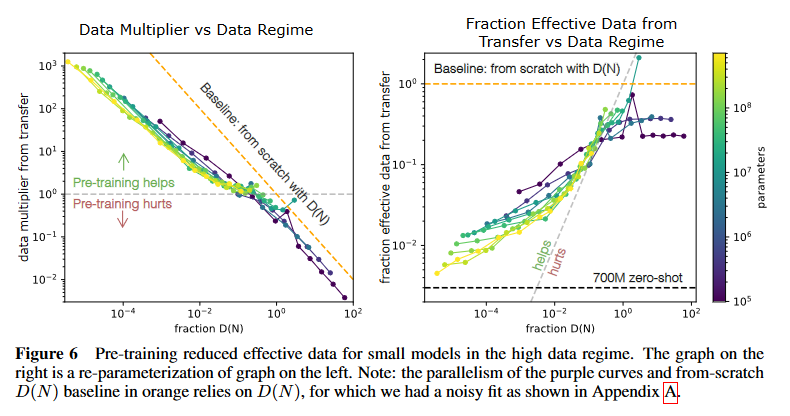

(論文・記事の各章節を貼り付け) Figure 5 In the high data regime (purple lines), pre-training can effectively reduce the training set size. In other words, we get better performance training the 1M parameter models (purple) with our larger size datasets (>1e8) from-scratch.Figure 6 Pre-training reduced effective data for small models in the high data regime. The graph on the

right is a re-parameterization of graph on the left. Note: the parallelism of the purple curves and from-scratch

D(N ) baseline in orange relies on D(N ), for which we had a noisy fit as shown in Appendix A.

Figure 7 We show training curves for training on a 10B-character python dataset, parameterized by the

amount of compute used for training.

Figure 8 Different points in a given color here all represent models of a given size trained to convergence

on different sized datasets. An analysis of best epoch, which offers another lens on converged compute costs

is given in Appendix G.

上記の内容に関して下記の質問に回答下さい: (である調で記載、一般的な推測を回答に混入しない事、元文の記載内容に基づいて忠実に回答、回答量は長くなってもOK)

⑩図/表があれば、各図/表は何を主張するためのものかを説明下さい。(掲載理由・注目ポイント等)

⑤性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば各文末に記載)

▼生成AIの回答(ChatGPT-4o)

⑩図/表があれば、各図/表は何を主張するためのものかを説明下さい。(掲載理由・注目ポイント等)

-

図5:この図は、大量データレジーム(紫色のライン)において、事前学習が効果的にトレーニングセットのサイズを縮小することを示している。1Mパラメータのモデル(紫色)が、大規模なデータセット(1e8以上)をゼロから学習する方が、事前学習を経たモデルよりも優れたパフォーマンスを発揮することが示されている。この図は、データセットが大きい場合には、ゼロから学習する方が有利になることを強調している。

-

図6:この図は、小規模モデルにおいて、大量データレジームで事前学習が実際にはデータを効果的に減少させることを示している。左側のグラフは事前学習モデルとゼロから学習したモデルの比較を示しており、右側のグラフはその再パラメータ化である。注目すべきは、紫色の曲線とオレンジ色のゼロから学習したモデルのD(N)ベースラインが平行している点であり、これはD(N)のフィットがノイズを伴っているためである(付録A参照)。この図は、事前学習がデータ効率に与える負の影響を視覚化している。

-

図7:この図は、10B文字のPythonデータセットでトレーニングされたモデルのトレーニング曲線を示しており、トレーニングに使用された計算量に基づいてパラメータ化されている。この図の目的は、計算効率とトレーニング進捗の関係を示し、計算リソースをどのように活用するかに基づくトレーニングパターンを明確にすることである。

-

図8:この図は、異なるサイズのデータセットで収束までトレーニングされたモデルを、各サイズごとに1つの色で表現している。各色の異なる点は、それぞれ異なるサイズのデータセットでトレーニングされた同じサイズのモデルを示している。この図は、収束後の計算コストを比較し、トレーニングのコスト効率を評価するものであり、特に事前学習モデルの計算効率を視覚的に評価するために用いられている。また、ベストエポックに関するさらなる分析は付録Gに示されている。

⑤性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば各文末に記載)

図5に示されているように、大規模データセット(>1e8)では、1Mパラメータのモデルがゼロから学習することで事前学習モデルよりも優れた性能を発揮している。これは、事前学習モデルが大量データセットにおいて効果を発揮しないケースが存在することを示している。

図6においては、小規模モデルにおいて事前学習がデータ効率を低下させる結果が確認されている。紫色の曲線がオレンジ色のゼロから学習したモデルのD(N)ベースラインと平行していることが、この現象を示している。

図7と図8に関しては、性能の向上よりも計算効率とトレーニング進捗の関係が主な焦点であり、計算リソースを効率的に使用する際の挙動が視覚的に示されている。

4 Related Work

▼質問(人間)

質問内容全体はここをクリック

(論文・記事の各章節を貼り付け) 4 Related Work Power-laws can arise from a wide variety of sources [THK18]. Predictable scaling trends in neural networks were first studied with [HNA+17]. The work closest to our approach is [RRBS19, KMH+20, HKK+20]. Our focus was on how transfer scales with compute, data, and parameters rather than how performance scales based on those ingredients when training from scratch. Transfer and meta-learning have received a lot of attention from the research community in many modalities. We will review some of the work that helped motivate us, but won’t do a comprehensive literature review. Here are two recent literature reviews in the domain. [TSK+18, Wen18]. We discussed pre-training language models in the introduction. Pre-training on image datasets such as Insta- gram and ImageNet has also produced gains in overall performance and data efficiency [MGR+18, HGD19]. CLIP showed impressive transfer from captioned images by getting zero-shot accuracy comparable to a ResNet-50 on ImageNet on datasets like ImageNet A [RKH+, DDS+09, HBB+21] Past work in few-shot learning was part of our motivation to study transfer. [LST15] showed few-shot learning for generating handwritten characters with probabilistic program induction inline with human capabilities of few-shot learning on such a task. [FAL17] showed that trying to design a model to be fine-tunable can improve few-shot performance. [BMR+20] used existing benchmarks to show that meaningful transfer/few- shot learning can occur in large models on tasks like SuperGLUE [WPN+19]. Another notable work that helped motivate our investigation into transfer was sim-to-real transfer training for solving a Rubik’s cube with a robot hand [OAA+19], a setting in which the fine-tuning data is far more expensive than the pre-training data. Another approach for measuring generalization we’re interested in is the development of increasingly difficult language benchmarks [HBB+21].上記の内容に関して下記の質問に回答下さい: (である調で記載、一般的な推測を回答に混入しない事、元文の記載内容に基づいて忠実に回答、回答量は長くなってもOK)

①何についての記載か? + 要旨は何? (要旨は箇条書きで記載、既存手法があれば引用元を記載)

②具体的な処理方法の記載があれば説明下さい。(簡略化せずに全て記載、既存手法があれば引用元を記載)

③改良点・工夫点・テクニック等の記載があれば説明下さい。

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

⑤性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば各文末に記載)

⑥比較の記載があれば違いを表でまとめて下さい。(下に解説を記載、対応する図/表番号があれば明記)

⑪関連研究の参照番号を全て列挙して、表にまとめて下さい。(元文にある内容のみ記載・類推して付け足しは不要、|参照番号|概要説明|の表へ、関連するもの同士でまとめて並べ替え)

▼生成AIの回答(ChatGPT-4o)

①何についての記載か? + 要旨は何?

-

何についての記載か: この章では、関連研究に関して述べている。具体的には、ニューラルネットワークのスケーリング法則、転移学習、メタラーニング、事前学習などに関連する研究が紹介されている。また、転移学習やゼロショット学習、少数ショット学習における過去の研究や、特定のデータセットやベンチマークに基づく研究も言及されている。

-

要旨:

- ニューラルネットワークのスケーリング法則に関する先行研究の引用 ([HNA+17], [THK18])。

- 転移学習やメタラーニングに関連する研究を簡潔に紹介 ([RRBS19], [KMH+20], [HKK+20])。

- 画像データセット(Instagram, ImageNet)を用いた事前学習の効果に関する研究 ([MGR+18], [HGD19])。

- CLIPによるキャプション付き画像からのゼロショット学習の成功 ([RKH+, DDS+09, HBB+21])。

- 少数ショット学習に関する先行研究 ([LST15], [FAL17], [BMR+20])。

- Rubik’s Cubeのシミュレーションから実世界への転移学習に関する研究 ([OAA+19])。

②具体的な処理方法の記載があれば説明下さい。

- 本章では具体的な処理方法の詳細な記載はないが、転移学習やメタラーニングの研究の背景や成果が簡潔に紹介されている。たとえば、[CLIP] によるキャプション付き画像からのゼロショット学習、[OAA+19] によるRubik’s Cubeのシミュレーションから実世界への転移学習において、それぞれの実験や適用方法について触れられている。しかし、これらは全体の文脈における参考程度の記載であり、具体的なアルゴリズムや手法の記述は含まれていない。

③改良点・工夫点・テクニック等の記載があれば説明下さい。

- 転移学習においては、モデルを細かくチューニングすることで少数ショット学習のパフォーマンスが向上することが示されている ([FAL17])。このように、転移学習において、モデルを適切に調整することが少量のデータでも効果的な結果を得るためのテクニックとなる。また、Rubik’s Cubeの研究では、事前学習データとファインチューニングデータの相対的なコストの差異に対処するため、シミュレーションから実世界への転移が有効な手法として用いられている ([OAA+19])。

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

- 転移学習において、事前学習されたモデルが少量のデータでも優れたパフォーマンスを発揮できる理由として、事前学習が効率的にモデルのパラメータを初期化し、その後の学習に必要なデータ量を大幅に削減するメカニズムが考えられる。具体的には、事前学習によって獲得された特徴が、ターゲットタスクにおいても有効であり、少数のデータでも効果的に学習できるためである。また、[LST15]の少数ショット学習においては、確率的プログラム誘導を用いることで、人間に近い少数ショット学習能力を再現している。この手法は、わずかな例からも汎化能力を高めるためのメカニズムを提供している。

⑤性能が向上した記載があれば説明下さい。

- 事前学習による性能向上: 事前学習が特に言語モデルや画像モデルにおいて、データ効率を改善し、全体のパフォーマンスを向上させる効果が確認されている ([MGR+18], [HGD19])。例えば、InstagramやImageNetデータセットでの事前学習によるパフォーマンス向上が報告されている。

- CLIPによるゼロショット学習の成功: CLIPモデルは、キャプション付き画像からのゼロショット学習で、ImageNetのResNet-50に匹敵する性能を示した ([RKH+, DDS+09, HBB+21])。この結果は、事前学習の重要性と転移学習の効果を強調している。

- 少数ショット学習の性能向上: [BMR+20]では、大規模モデルがSuperGLUEのようなベンチマークで少数ショット学習においても有意な転移性能を示している。

⑥比較の記載があれば違いを表でまとめて下さい。

| モデル/手法 | 研究者 | 主な結果 | 転移学習の効果 |

|---|---|---|---|

| CLIP | [RKH+], [DDS+09], [HBB+21] | ゼロショット学習でResNet-50と同等の性能 | 高い |

| 少数ショット学習 | [LST15], [FAL17], [BMR+20] | 少量データでも人間に近い学習能力 | 高い |

| Rubik’s Cube転移学習 | [OAA+19] | シミュレーションから実世界への転移が成功 | 高い |

⑪関連研究の参照番号を全て列挙して、表にまとめて下さい。

| 参照番号 | 概要説明 |

|---|---|

| [THK18] | パワーロー則の発生原因に関する研究 |

| [HNA+17] | ニューラルネットワークの予測可能なスケーリングトレンドに関する初期研究 |

| [RRBS19] | 転移学習のスケーリングに関する研究 |

| [KMH+20] | 転移学習の計算とデータのスケーリングに関する研究 |

| [HKK+20] | 転移学習のパラメータに関するスケーリング研究 |

| [TSK+18] | 転移学習に関する文献レビュー |

| [Wen18] | 転移学習に関する文献レビュー |

| [MGR+18] | Instagramデータセットでの事前学習に関する研究 |

| [HGD19] | ImageNetデータセットでの事前学習に関する研究 |

| [RKH+] | CLIPによるキャプション付き画像からのゼロショット学習 |

| [DDS+09] | ImageNetでのゼロショット学習 |

| [HBB+21] | ImageNet AデータセットでのCLIPの成功 |

| [LST15] | 手書き文字生成の少数ショット学習に関する研究 |

| [FAL17] | ファインチューニングが少数ショット性能を向上させることを示す研究 |

| [BMR+20] | 大規模モデルでの少数ショット学習の成功に関する研究 |

| [WPN+19] | SuperGLUEベンチマークに関する研究 |

| [OAA+19] | Rubik’s Cubeでのシミュレーションから実世界への転移学習 |

5 Limitations

▼質問(人間)

質問内容全体はここをクリック

(論文・記事の各章節を貼り付け) 5 Limitations 1) Models weren’t tuned for fine-tuning or code. We leveraged hyperparameters that were tuned for training from scratch on natural language [KMH+20]. We did a handful of learning rate scans for fine-tuning larger models on small dataset sizes and didn’t see any improvement with other learning rates. But our scans were not comprehensives. 2) Models weren’t tuned for small datasets. For small datasets, training ended before the warmup was finished, so the learning schedule could confound the results. 3) We only measured transfer when fine-tuning on python. It’s unclear if we’d observe a power law fit for a broad set of distribution pairs. 4) We only measured transfer between distributions in an unsupervised setting. It’s not clear to what degree the findings would generalize to a supervised or reinforcement learning setup. 5) We didn’t find a good closed-form model for from-scratch results as was seen in [KMH+20], though we believe more careful tuning could have produced such a model in line with their results. If we had such results we expect we could generate a closed-form equation for overall performance for fine-tuned models rather than rely on relative performance in our definition. 6) We only measured performance on transformers. 7) Equations 3.1 and 3.2 don’t handle zero-shot case unless we use an approximation (i.e. fine-tuning on 1 character) for the zero-shot case. 8) We didn’t explore the ability to make sure measurements more cheaply, either in context or through KL divergence.上記の内容に関して下記の質問に回答下さい: (である調で記載、一般的な推測を回答に混入しない事、元文の記載内容に基づいて忠実に回答、回答量は長くなってもOK)

①何についての記載か? + 要旨は何? (要旨は箇条書きで記載、既存手法があれば引用元を記載)

②具体的な処理方法の記載があれば説明下さい。(簡略化せずに全て記載、既存手法があれば引用元を記載)

③改良点・工夫点・テクニック等の記載があれば説明下さい。

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

⑤性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば各文末に記載)

▼生成AIの回答(ChatGPT-4o)

①何についての記載か? + 要旨は何?

-

何についての記載か: この章では、本研究の限界について言及している。具体的には、モデルのチューニングやデータセットのサイズ、転移学習の測定範囲、使用したアルゴリズムや手法の制約について説明している。

-

要旨:

- モデルのチューニングに関する限界: 本研究では、ファインチューニングやコードのためにモデルを特別にチューニングしておらず、自然言語に対するスクラッチトレーニングで使用されたハイパーパラメータを利用している。

- 小規模データセットに対するチューニング不足: 小規模データセットでは、学習のウォームアップ段階が終了する前にトレーニングが終了しており、これが結果に影響を与えた可能性がある。

- Pythonでの転移学習の測定のみ: 本研究では、Pythonに対するファインチューニングでのみ転移を測定しており、他の分布ペアに対しても同様のパワーローが成立するかは不明である。

- 教師あり学習や強化学習への一般化が不明: 転移学習は教師なし学習の設定でしか測定されておらず、これが教師あり学習や強化学習に一般化するかは明らかではない。

- スクラッチ学習結果のクローズドフォームモデルの不在: スクラッチからの学習結果に関しては、クローズドフォームモデルが得られなかったが、より慎重なチューニングを行えば、結果を得られる可能性があったと推測している。

- トランスフォーマーのみでの性能測定: 本研究ではトランスフォーマーのみを用いて性能を測定しており、他のモデルでは同様の結果が得られるかは不明である。

- ゼロショットケースの対応が不完全: 式3.1および3.2はゼロショット学習には直接対応しておらず、近似的な処理が必要であった。

- 計測コストの削減についての検討不足: コンテキスト内での計測やKLダイバージェンスを利用したコスト削減の検討は行われていない。

②具体的な処理方法の記載があれば説明下さい。

- 本章では具体的な処理方法として、次の点が挙げられている。

- ハイパーパラメータの設定: ファインチューニングやコードに最適化されたハイパーパラメータは使用せず、自然言語に対するスクラッチトレーニング用に設定されたものをそのまま使用した。このため、学習率をいくつか試したものの、それ以上の調整は行っていない ([KMH+20])。

- 小規模データセットでの問題: 小規模データセットに対しては、トレーニングがウォームアップ段階を終える前に終了してしまうため、適切な学習スケジュールが反映されなかった。

- 転移学習の測定範囲: 転移学習の測定はPythonに限定して行われており、他の分布間での検証は行われていない。

- 教師なし学習の設定: 転移学習の実験は教師なし学習の設定で行われており、教師あり学習や強化学習の設定は考慮されていない。

- クローズドフォームモデルの欠如: スクラッチからの学習結果に対して、クローズドフォームのモデルを得るための努力が不足していたが、より慎重な調整があればクローズドフォームの結果が得られた可能性がある。

③改良点・工夫点・テクニック等の記載があれば説明下さい。

-

改良点・工夫点の欠如: この章では、特定の改良点やテクニックに関して言及されていないが、逆に以下の点が不足していると認識している:

- ハイパーパラメータの調整が限定的であり、特にファインチューニングや小規模データセットに最適化された調整が不足している。

- 教師あり学習や強化学習への一般化に関する考察や試行が不足している。

- コスト削減のための技術(KLダイバージェンスなど)の探索が行われていない。

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

-

転移学習の測定に関するメカニズムの限界: Pythonに対してのみ転移学習の測定を行ったため、他の分布間でのパワーロー則が成立するかどうかは確認されていない。これは、転移学習の特性がデータ分布の性質に依存するため、特定の分布ペアにのみ適用できる可能性があることを示唆している。

-

クローズドフォームモデルの不在の原因: スクラッチ学習に対してクローズドフォームモデルが得られなかった理由として、ハイパーパラメータの調整が十分でなかったことが影響している可能性がある。より慎重なチューニングにより、[KMH+20]のようなクローズドフォームモデルが得られる可能性があったとされる。

⑤性能が向上した記載があれば説明下さい。

- 本章では性能向上に関する具体的な記載はなく、むしろ性能に関する限界について述べられている。例えば、ファインチューニングのハイパーパラメータの調整が限定的であったため、学習率のスキャンを行っても明確な改善は見られなかった。また、小規模データセットではトレーニングがウォームアップ段階で終了してしまい、これが結果に影響を与えた可能性があるため、性能向上に結びつかなかったことが示唆されている。

6 Discussion

6.1 Potential unified scaling law for fine-tuning

▼質問(人間)

質問内容全体はここをクリック

(論文・記事の各章節を貼り付け) 6 Discussion 6.1 Potential unified scaling law for fine-tuning Using equation 1.5 from [KMH+20] we find the following result for overall loss on a fine-tuned model in the low-data regime: L ≈ [( NC N ) αN αD + DC k(DF )α(N )β ]αD (6.1) To generate equation 6.1 we have simply substituted effective data from transfer, DT , as given in equation 1.1 for the dataset size D in [KMH+20], which was fit to language models trained from scratch. [SK20] attempts to explain the power-law from [KMH+20] as arising from neural networks performing regression on a data manifold of intrinsic dimension d. Speculatively, we think the scaling laws of transfer fit that picture, where pre-training tiles a portion of the downstream manifold at a lower density than training directly on the downstream task.上記の内容に関して下記の質問に回答下さい: (である調で記載、一般的な推測を回答に混入しない事、元文の記載内容に基づいて忠実に回答、回答量は長くなってもOK)

①何についての記載か? + 要旨は何? (要旨は箇条書きで記載、既存手法があれば引用元を記載)

②具体的な処理方法の記載があれば説明下さい。(簡略化せずに全て記載、既存手法があれば引用元を記載)

③改良点・工夫点・テクニック等の記載があれば説明下さい。

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

⑤性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば各文末に記載)

⑥表に出来そうな部分があれば表でまとめて下さい。(下に解説を記載、対応する図/表番号があれば記載)

⑨具体的な変数名(数式用の記号)の記載を全て列挙して、表にまとめて下さい。(|変数名|説明|次元・型|の表へ)

▼生成AIの回答(ChatGPT-4o)

①何についての記載か? + 要旨は何?

-

何についての記載か: この節では、ファインチューニングに関する統一的なスケーリング則の可能性について議論している。具体的には、低データ領域におけるファインチューニングモデルの損失を表す式を提示し、既存のスケーリング則との関連性を検討している。

-

要旨:

- ファインチューニングにおける損失関数の式: 低データ領域でのファインチューニングモデルの損失は式6.1により示される。この式は[KMH+20]の式1.5を基にしており、データセットサイズに転移学習から得られた効果的データを代入することで導出されている。

- 既存スケーリング則との関連: [SK20]が提唱するスケーリング則に基づき、転移学習が下流タスクのデータ多様体の一部をプレトレーニングで低密度にタイル状にカバーしていると推測されている。

②具体的な処理方法の記載があれば説明下さい。

-

損失関数の導出:

- 式6.1は、転移学習による効果的データサイズ $ D_T $ を[KMH+20]でスクラッチ学習に使用されたデータサイズ $ D $ に代入することで導出されている。この式の基本的な枠組みは、[KMH+20]の式1.5に基づいている。

- 式の要素として、転移学習で得られるデータの効果 $ D_T $ が、元のデータセットサイズ $ D $ の代わりに使用されている。

-

スケーリング則の仮説:

- [SK20]のスケーリング則が、神経ネットワークがデータ多様体の本質的な次元 $ d $ 上で回帰を行うことに由来していることを説明している。この仮説を基に、転移学習のスケーリング則が、このデータ多様体を低密度でカバーするという形で当てはまると推測されている。

③改良点・工夫点・テクニック等の記載があれば説明下さい。

-

改良点・工夫点:

- [KMH+20]で提案されたスケーリング則の枠組みを、転移学習に適用するために、データセットサイズの変数に転移学習から得られる効果的データサイズ $ D_T $ を代入することで、ファインチューニングモデルに対応したスケーリング則を得ている。

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

-

メカニズムの解明:

- [SK20]では、神経ネットワークがデータ多様体の本質的な次元 $ d $ 上で回帰を行うことによって、スケーリング則が成立することを説明している。この理論を転移学習に適用する際には、プレトレーニングが下流タスクのデータ多様体を低密度でタイル状にカバーするというメカニズムが提案されている。

- この仮説によって、転移学習が下流タスクの一部の情報を効率的に学習し、ファインチューニングによる損失を低減するためのスケーリング則が形成されると説明されている。

⑤性能が向上した記載があれば説明下さい。

- 本節では、性能向上に関する具体的な数値は記載されていないが、スケーリング則が適用されることにより、ファインチューニングモデルにおける低データ領域での損失が軽減されることが示唆されている。具体的な改善量は記載されていないが、[KMH+20]でのスケーリング則に基づく損失低減のメカニズムが参照されている。

⑥表に出来そうな部分があれば表でまとめて下さい。

| 式番号 | 内容 | 説明 |

|---|---|---|

| 6.1 | 損失関数 $ L $ | 転移学習を用いた低データ領域でのファインチューニングモデルの損失を表す式 |

⑨具体的な変数名(数式用の記号)の記載を全て列挙して、表にまとめて下さい。

| 変数名 | 説明 | 次元・型 |

|---|---|---|

| $ L $ | ファインチューニングモデルの損失 | 実数 |

| $ N $ | モデルパラメータの数 | 正の整数 |

| $ C $ | 計測された複雑度の定数 | 実数 |

| $ D $ | 元のデータセットサイズ | 正の整数 |

| $ D_C $ | データセット内のコンテキストの複雑度の定数 | 実数 |

| $ D_T $ | 転移学習から得られる効果的データサイズ | 正の整数 |

| $ F $ | モデルの自由度(フリーダム) | 実数 |

| $ k $ | スケールの調整定数 | 実数 |

| $ \alpha $ | モデルサイズに依存するスケールパラメータ | 実数 |

| $ \beta $ | データ多様体のスケーリングに依存するパラメータ | 実数 |

6.2 Speculative estimates for why large models would be few-shot learners

▼質問(人間)

質問内容全体はここをクリック

(論文・記事の各章節を貼り付け) 6.2 Speculative estimates for why large models would be few-shot learners The effective data multiplier goes down as we increase the size of the fine-tuning dataset, DF . When we use equation 1.1 to extrapolate all the way down to approximately zero-shot, 1 character, we estimate that pre-trained models are equivalent to training from scratch on 3.7e8 characters of python when pre-trained on text with a model the size of GPT-3 [BMR+20]. If we increase this to a few-shot, say 300 characters, we multiply our effective data DE by a factor of 2.8. Given this analysis, it’s not surprising that few-shot scores on SuperGLUE [WPN+19] were 10-15 points higher than zero-shot scores [BMR+20]. The above analysis is relatively speculative because we extrapolated up in model size by two orders of magnitude and downwards in the amount of data by 5 orders of magnitude. We also equated data in context to data fine-tuned on. Similar calculations for text + code pre-training give an estimate of DE = 4.1e9 characters, with 300 char- acters of examples worth a factor 1.7x. We were a bit surprised here, because our best guess before running these experiments would have been that making other programming languages half of the pre-training dataset would have increased few-shot transfer/effective data by more than 10x. One might have the concern that trace amounts of python in the text dataset could impact the transfer coefficients for these experiments. We did additional experiments to mitigate this concern, which are described in Appendix F.上記の内容に関して下記の質問に回答下さい: (である調で記載、一般的な推測を回答に混入しない事、元文の記載内容に基づいて忠実に回答、回答量は長くなってもOK)

①何についての記載か? + 要旨は何? (要旨は箇条書きで記載、既存手法があれば引用元を記載)

②具体的な処理方法の記載があれば説明下さい。(簡略化せずに全て記載、既存手法があれば引用元を記載)

③改良点・工夫点・テクニック等の記載があれば説明下さい。

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

⑤性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば各文末に記載)

⑥表に出来そうな部分があれば表でまとめて下さい。(下に解説を記載、対応する図/表番号があれば記載)

⑨具体的な変数名(数式用の記号)の記載を全て列挙して、表にまとめて下さい。(|変数名|説明|次元・型|の表へ)

▼生成AIの回答(ChatGPT-4o)

①何についての記載か? + 要旨は何?

-

何についての記載か: この節では、大規模モデルが少数ショット学習者になる理由の推定に関する議論を行っている。具体的には、ファインチューニングデータセットのサイズを増やすことで効果的なデータがどのように変動するかを推定し、ゼロショットおよび少数ショット学習の効果についての理論的な推定を行っている。

-

要旨:

- 効果的データ乗数の推定: ファインチューニングデータセットのサイズ $ D_F $ を増加させると、効果的なデータ乗数 $ D_E $ は減少するが、これはモデルが学習するデータ量に依存する。

- GPT-3によるゼロショット学習の推定: GPT-3のサイズのモデルでゼロショット(1文字)学習した場合、スクラッチでの学習に相当するデータは3.7e8文字と推定される。

- 少数ショットの推定: 少数ショット(300文字)に増やすと、効果的データが約2.8倍に増加し、SuperGLUEベンチマークでの少数ショットのスコアがゼロショットより10-15ポイント高いことが説明されている。

- 推定の不確実性: モデルサイズを2桁、データ量を5桁拡張したため、推定には不確実性が伴う。

- プログラミング言語と効果的データ: テキスト+コードのプレトレーニングにより、4.1e9文字に相当するデータが得られると推定され、少数ショットの効果的データは1.7倍になると推定されたが、期待よりも小さな増加であった。

②具体的な処理方法の記載があれば説明下さい。

-

効果的データの推定:

- プレトレーニングされたモデルの効果的なデータ量を推定するために、式1.1を用いてファインチューニングデータセットのサイズを増やすことによる変動を評価している。特に、ゼロショットから少数ショットへの拡張を推定し、1文字から300文字に増やした場合の効果を計算している。

- この推定は、GPT-3サイズのモデルがテキストでプレトレーニングされた場合、ゼロショットでの効果的データ量が3.7e8文字になることから始まり、300文字での学習で2.8倍の効果的データ量が得られることを示している。

- また、テキスト+コードのプレトレーニングについても同様に計算され、効果的データは4.1e9文字、少数ショットで1.7倍の効果が得られると推定している。

-

SuperGLUEベンチマークのスコア:

- この推定を基に、SuperGLUEベンチマークにおける少数ショットのスコアがゼロショットより10-15ポイント高い結果となったことを説明している。

③改良点・工夫点・テクニック等の記載があれば説明下さい。

-

改良点:

- モデルサイズやデータ量の推定において、通常は直接測定が難しい「効果的データ量」を推定するために、式1.1を用いたデータ量の乗数を導入している。この方法により、ゼロショットから少数ショットへの効果的なデータ増加の計算を可能にしている。

- 実験的に、テキストデータセット内に含まれるPythonのトレース量が実験の転移係数に影響を与える可能性があったため、その影響を低減するための追加実験を行った(詳細は付録Fに記載)。

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

-

メカニズムの解明:

- 効果的データ量がファインチューニングデータセットのサイズとともに減少する理由は、モデルがすでにプレトレーニングで獲得した知識を再利用しているためである。プレトレーニングで学習したデータの一部が、ファインチューニング時に新たなデータと同様に利用されるため、効果的なデータ量が相対的に少なくなる。

- ゼロショット学習時には、プレトレーニングされた知識のみで推論を行うため、スクラッチから学習した場合のデータ量に匹敵する効果的データ量を得る。少数ショットになると、新たに提供された少量のデータとプレトレーニングデータの組み合わせにより、さらに効果的なデータ量が増加する。

- テキスト+コードのプレトレーニングにおける効果的データ量の推定では、プログラミング言語がデータセットの半分を占めたとしても、少数ショットの転移学習で得られるデータ量の増加が10倍未満である理由は不明確だが、プレトレーニング時に含まれていたPythonのトレース量が影響を与えている可能性が考慮されている。

⑤性能が向上した記載があれば説明下さい。

-

少数ショット学習の性能向上:

- 少数ショット学習(300文字)では、SuperGLUEベンチマークにおいてゼロショットよりも10-15ポイント高いスコアが得られていると記載されている。これは、少数ショットによる効果的データの増加が影響していると考えられる(具体的な図/表番号は記載されていない)。

⑥表に出来そうな部分があれば表でまとめて下さい。

| 項目 | 効果的データ量 $ D_E $ | 倍率 | 備考 |

|---|---|---|---|

| ゼロショット(1文字) | 3.7e8 文字 | - | GPT-3サイズのモデル、Pythonに基づく推定 |

| 少数ショット(300文字) | $ 2.8 \times D_E $ | 2.8 | 少数ショットの増加による推定 |

| テキスト+コードのプレトレ | 4.1e9 文字 | 1.7 | Pythonのトレース量が影響 |

⑨具体的な変数名(数式用の記号)の記載を全て列挙して、表にまとめて下さい。

| 変数名 | 説明 | 次元・型 |

|---|---|---|

| $ D_E $ | 効果的なデータ量 | 実数 |

| $ D_F $ | ファインチューニングデータセットサイズ | 正の整数 |

| $ D_T $ | プレトレーニングによる効果的データサイズ | 正の整数 |

| $ k $ | スケールの調整定数 | 実数 |

| $ \alpha $ | モデルサイズに依存するスケールパラメータ | 実数 |

6.3 Potential applications of these scaling laws

▼質問(人間)

質問内容全体はここをクリック

(論文・記事の各章節を貼り付け) 6.3 Potential applications of these scaling laws 1. If collecting more data is expensive the power-law form of transfer suggests a potentially useful and cheap experiment when trying to decide whether or not to collect more data to fine-tune a pre- trained model on. One could fine-tune a model with a 1% and 10% of the existing dataset. Next one could vary the model size given the full fine-tuning dataset and estimate the lost performance in terms of a reduction in model size. We expect for many applications there will continue to be valuable, expensive to collect data, and that it will be useful to be able to make the decision as to whether to gather more such data in a principled way. One example of an expensive dataset is human preferences of what makes a good summary [SOW+20]. 2. It’s easier to generate simple equations for scaling laws where performance is measured in loss rather than accuracy for a downstream task[BMR+20]. Scaling laws posed in terms of effective data could provide an alternative, better behaved trend to compare architectures and algorithms.上記の内容に関して下記の質問に回答下さい: (である調で記載、一般的な推測を回答に混入しない事、元文の記載内容に基づいて忠実に回答、回答量は長くなってもOK)

①何についての記載か? + 要旨は何? (要旨は箇条書きで記載、既存手法があれば引用元を記載)

②具体的な処理方法の記載があれば説明下さい。(簡略化せずに全て記載、既存手法があれば引用元を記載)

③改良点・工夫点・テクニック等の記載があれば説明下さい。

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

⑤性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば各文末に記載)

⑥表に出来そうな部分があれば表でまとめて下さい。(下に解説を記載、対応する図/表番号があれば記載)

⑧具体的な数値の記載を全て列挙して、表にまとめて下さい。(必ず正しく数値を抜き取る事、|数値|説明|の表へ)

▼生成AIの回答(ChatGPT-4o)

①何についての記載か? + 要旨は何?

-

何についての記載か: この節では、スケーリング則が持つ潜在的な応用について説明している。具体的には、データ収集が高コストである場合に有効な実験方法や、効果的なデータに基づくスケーリング則の応用について議論している。

-

要旨:

- データ収集コストが高い場合の実験: データの収集が高コストな場合、1%や10%の既存データセットでファインチューニングを行い、その結果を用いて、フルデータセットを用いた場合にモデルサイズを変動させた際の性能低下を推定することが有効である。このアプローチにより、追加データを収集するかどうかを判断できる。

- ロスで測定された性能に基づくスケーリング則: ダウンストリームタスクでの精度よりも、ロスを用いたスケーリング則の方が単純な方程式を生成しやすい。効果的なデータに基づくスケーリング則は、アーキテクチャやアルゴリズムを比較するためのより安定した傾向を提供できる可能性がある。

②具体的な処理方法の記載があれば説明下さい。

-

データ収集が高コストな場合の実験方法:

- まず、既存のデータセットの1%と10%を用いて、プレトレーニングされたモデルにファインチューニングを行う。

- 次に、フルデータセットを使用しながら、モデルサイズを変化させ、そのサイズに応じた性能低下を推定する。

- この手法により、追加のデータ収集がどれだけ有用であるかを事前に評価できる。

-

ロスに基づくスケーリング則の生成:

- 精度よりもロスで測定された性能を使用することで、スケーリング則の方程式が単純化される。

- 効果的データに基づくスケーリング則を使用すると、アーキテクチャやアルゴリズムの比較において、より安定した傾向を導き出せる可能性がある。

③改良点・工夫点・テクニック等の記載があれば説明下さい。

-

改良点・工夫点:

- 収集が高コストなデータに対して、データ量を1%や10%に抑えて実験を行うことで、データ収集の意思決定をより効率的に行うことができる。この方法により、データ収集コストを削減しつつ、効果的なモデル構築が可能になる。

- 効果的データに基づいたスケーリング則を使用することで、精度ではなくロスを用いたより単純な方程式でモデル性能を評価できる点が工夫されている。これにより、従来の手法に比べて性能評価が容易になり、異なるアーキテクチャやアルゴリズムを比較するための有用なツールとして活用できる。

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

-

メカニズムの解明:

- データセットの一部(1%や10%)を使用してファインチューニングを行うことで、モデルが必要とするデータ量と性能の関係を把握できる。この実験により、データが限られている場合でも、最適なモデルサイズや追加データの有効性を推定することができる。

- ロスに基づくスケーリング則を使用する理由として、ロスはタスク全体の誤差を表すため、精度に比べてスケーリング則を生成するためのより安定した指標となりやすい。このため、ロスを用いることで、パフォーマンスのより信頼性の高い推定が可能となる。

⑤性能が向上した記載があれば説明下さい。

- この節では具体的な性能向上の数値は示されていないが、データ収集が高コストな場合の効率的なデータ使用方法を提示することで、収集コストの削減やデータ量に対する性能向上の推定が可能である点が強調されている。

⑥表に出来そうな部分があれば表でまとめて下さい。

| 項目 | 説明 |

|---|---|

| 1% のデータセットを使用した場合 | 1% のデータセットでファインチューニングを行い、性能を測定 |

| 10% のデータセットを使用した場合 | 10% のデータセットでファインチューニングを行い、性能を測定 |

| フルデータセットでのモデルサイズ | フルデータセットでモデルサイズを変化させ、性能低下を推定 |

⑧具体的な数値の記載を全て列挙して、表にまとめて下さい。

| 数値 | 説明 |

|---|---|

| 1% | 既存データセットの1%でファインチューニング |

| 10% | 既存データセットの10%でファインチューニング |

6.4 Core factors vs details

6.5 How similar are Python and English?

▼質問(人間)

質問内容全体はここをクリック

(論文・記事の各章節を貼り付け) 6.4 Core factors vs details Previous work showed that the core factors affecting from-scratch performance included data, compute, and parameters [KMH+20, HKK+20]. They showed that performance only depended weakly on details like depth, width, and the number of attention heads. We believe fine-tuned performance is likely similar, but where data is split into pre-trained and fine-tuned data. For instance, we expect we’d observe smaller effects for tuning the hyperparameters for the fine-tuning distribution, changing how many epochs we pre-train, and smoothly transitioning between the distributions than for changing the amount of fine-tuning data or the pre-training distribution. We’d be excited to see future work evaluating this claim. 6.5 How similar are Python and English? We believe the dissimilarity of English and Python is representative of transfer between distant distributions that will be of interest in the future. There is English within python code (docstrings, comments, and function names). However, python is a “formal language” for communicating instructions to a computer and English is an informal language for communicating between people. We can imagine distributions that are further apart, for instance, English and Math. We can also think of distributions that feel relatively close, like English:French, Wikipedia:arxiv, and so on. Given the distance between distributions of future interest, we’d argue that transfer between text and code tells us something meaningful about transfer between distant distributions.上記の内容に関して下記の質問に回答下さい: (である調で記載、一般的な推測を回答に混入しない事、元文の記載内容に基づいて忠実に回答、回答量は長くなってもOK)

①何についての記載か? + 要旨は何? (要旨は箇条書きで記載、既存手法があれば引用元を記載)

②具体的な処理方法の記載があれば説明下さい。(簡略化せずに全て記載、既存手法があれば引用元を記載)

③改良点・工夫点・テクニック等の記載があれば説明下さい。

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

⑤性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば各文末に記載)

⑥表に出来そうな部分があれば表でまとめて下さい。(下に解説を記載、対応する図/表番号があれば記載)

▼生成AIの回答(ChatGPT-4o)

①何についての記載か? + 要旨は何?

-

何についての記載か:

- 6.4節は、モデルの性能に影響を与える「核心的な要因」と「詳細な要因」についての議論を扱っている。ここでは、データ、計算リソース、パラメータが重要な核心要因であることが述べられており、モデルの深さや幅、アテンションヘッドの数などの詳細な要因の影響は弱いとされている。また、ファインチューニングの性能にもこれが当てはまると考えられている。

- 6.5節では、Pythonと英語の類似性についての議論が展開されており、Pythonと英語は異なる形式の言語として「異なる分布間の転移」を代表するものとして考察されている。

-

要旨:

-

6.4 Core factors vs details:

- モデルの性能にはデータ、計算リソース、パラメータが強く影響するが、モデルの深さや幅、アテンションヘッドの数などの詳細な要因は影響が少ない。

- ファインチューニングにおいても、ハイパーパラメータ調整やエポック数の調整よりも、ファインチューニングデータ量や事前学習データの分布の影響が大きいと予測される。

-

6.5 How similar are Python and English?:

- Pythonと英語の違いは、異なる分布間の転移を理解するための一例である。

- Pythonには英語の要素(コメント、docstrings、関数名など)が含まれているが、両者は異なる目的を持つ言語である。Pythonはコンピュータへの指示を伝えるための「形式言語」であり、英語は人間間のコミュニケーションを目的とする「非形式言語」である。

-

②具体的な処理方法の記載があれば説明下さい。

-

6.4 Core factors vs details:

- モデルの性能評価において、計算リソース、データ量、パラメータ数が主要な要因として扱われている。ファインチューニングでは、データの分布を調整したり、エポック数を変更することで性能に与える影響が観察される。

- ハイパーパラメータ調整やエポック数の変更は、性能に小さな影響を与えるが、ファインチューニングデータや事前学習データの分布の変更がより大きな効果をもたらすとされている。

-

6.5 How similar are Python and English?:

- Pythonと英語の分布間の転移を評価するための実験が行われている。具体的な手法として、Pythonコード内の英語要素(docstrings、コメント、関数名)を評価対象とし、これが異なる分布間の転移の代表例であるかを検証する。加えて、英語と数学や英語と他の言語(例: 英語とフランス語)の類似性も考察の対象となっている。

③改良点・工夫点・テクニック等の記載があれば説明下さい。

-

6.4 Core factors vs details:

- モデルの詳細な構造(深さ、幅、アテンションヘッドの数)に依存しない性能の評価を行う点が工夫されている。これにより、モデルの基盤的な要因(データ、計算リソース、パラメータ)に集中して分析が行われている。

- ファインチューニングにおけるハイパーパラメータ調整の影響が少ないことを前提とし、より重要な要因であるデータの扱いに焦点を当てる点が効率的である。

-

6.5 How similar are Python and English?:

- Pythonと英語という異なる分布間の転移の評価において、言語間の構造的な違いを無視せず、形式言語と非形式言語の違いに着目している点が工夫されている。

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。

-

6.4 Core factors vs details:

- モデル性能の主要な要因がデータ、計算リソース、パラメータに依存する理由として、これらの要素がモデルの学習において直接的に影響を与えるためである。一方で、モデルの詳細な構造(深さや幅)は性能に対する影響が小さく、これらの要因はモデルの学習能力において二次的な役割を果たすに過ぎないとされている。

-

6.5 How similar are Python and English?:

- Pythonと英語の間には構造的な違いが存在し、異なる形式のコミュニケーション言語として設計されているため、これらの言語間の転移は興味深い研究対象である。具体的には、形式言語としてのPythonは機械に対して指示を与えるために設計されており、自然言語としての英語は人間間のコミュニケーションを目的としているため、両者の転移性能は異なる結果を示す可能性が高い。

⑤性能が向上した記載があれば説明下さい。

-

6.4 Core factors vs details: この節では具体的な性能向上に関する数値や結果は提示されていないが、モデル性能の評価において、データ、計算リソース、パラメータに焦点を当てることで、詳細なモデル設計に依存しない評価手法が提案されている。

-

6.5 How similar are Python and English?: 性能向上の具体的な記載はないが、異なる分布間の転移性能の評価を通じて、今後の転移学習における研究の方向性を示唆している。

⑥表に出来そうな部分があれば表でまとめて下さい。

| 節 | 要点 |

|---|---|

| 6.4 | モデル性能に影響を与える要因として、データ、計算リソース、パラメータが重要であり、詳細な構造(深さ、幅、アテンションヘッド)は影響が少ない。 |

| 6.5 | Pythonと英語の違いは、形式言語と非形式言語の違いとして考察されており、異なる分布間の転移を理解する上で重要な要素とされる。 |

6.6 Ossification

▼質問(人間)

質問内容全体はここをクリック

(論文・記事の各章節を貼り付け) 6.6 Ossification Our small fine-tuned models were unable to reach trained from scratch performance even as they were trained on 10x or 100x D(N ), as shown in Figure 6. This is evidence for the intuition some hold that given infinite data one is better off training entirely on distribution and suggests significant pre-training might be impractical in terms of compute and tuning under such circumstances. This suggests that the weights can saturate or “ossify”, where they become unable to absorb new information well, and that ossification scales predictably. That could be similar to saying that the prior learned in pre-training becomes counterproductive if it’s learned with too much relative strength. We may see an analogous phenomena in humans, where there seems to be a large advantage in being trained for a sport from a young age, thus avoiding the opportunity to develop bad habits.上記の内容に関して下記の質問に回答下さい: (である調で記載、一般的な推測を回答に混入しない事、元文の記載内容に基づいて忠実に回答、回答量は長くなってもOK)

①何についての記載か? + 要旨は何? (要旨は箇条書きで記載、既存手法があれば引用元を記載)

②具体的な処理方法の記載があれば説明下さい。(簡略化せずに全て記載、既存手法があれば引用元を記載)

③改良点・工夫点・テクニック等の記載があれば説明下さい。

④メカニズムの解明・なぜそうなるのか等の記載があれば説明下さい。(記載がなければ回答不要)

⑤性能が向上した記載があれば説明下さい。(具体値があれば記載、対応する図/表番号があれば各文末に記載)

⑥表に出来そうな部分があれば表でまとめて下さい。(下に解説を記載、対応する図/表番号があれば記載)

▼生成AIの回答(ChatGPT-4o)

①何についての記載か? + 要旨は何?

-

何についての記載か:

この節は、「骨化(Ossification)」という現象について述べており、小規模なモデルにおけるファインチューニングが、十分なデータ量を用いても、スクラッチからの学習と同等の性能に達することができなかったことを報告している。また、事前学習が計算コストやチューニングにおいて実用的でなくなる可能性を示唆している。 -

要旨:

- 小規模モデルをファインチューニングした場合、スクラッチから学習した場合の性能には到達しない。

- 10倍から100倍のデータ量を使用しても、性能向上が限定的である。

- これは「骨化(ossification)」という、重みが新しい情報を効果的に吸収できなくなる現象が存在することを示している。

- 骨化は予測可能なスケールで発生し、事前学習が過度に強力である場合に、学習した先行知識が逆効果になる可能性がある。

②具体的な処理方法の記載があれば説明下さい。

- 小規模なモデルに対して、10倍から100倍のデータ量を用いたファインチューニングが行われたが、スクラッチからの学習に匹敵する性能には到達しなかった。これは、ファインチューニング時に事前学習済みの重みが新しい情報を吸収できなくなる「骨化」現象が関与しているとされる。

- 図6(Figure 6)では、10倍または100倍のデータを用いても、スクラッチから学習したモデルと比べて性能が劣る結果が示されている。

③改良点・工夫点・テクニック等の記載があれば説明下さい。