音をオノマトペで可視化するアプリの構想

最近、MR(Mixed Reality)技術に触れることがあり、ディスプレイを空中に表示したり、何かを現実に持ち込むことが便利だな〜と感じました。これを利用して、「日常の音をオノマトペで視覚化することで、音の世界を聴覚障害者が体感できるのでは?」と思い立ち、日常の音をオノマトペで可視化し、音を感じさせるアプリを作ることにしました。

実装したいこと

-

日常の音を可視化(オノマトペ)

- 音の発生源に合わせて表示(漫画のようなイメージ)

- 雨、風、車、風鈴、会話

必要なこと

- 音の発生源を特定

- 音の種類を分別

- 音に対応したオノマトペを表示

実装案(軽く)

-

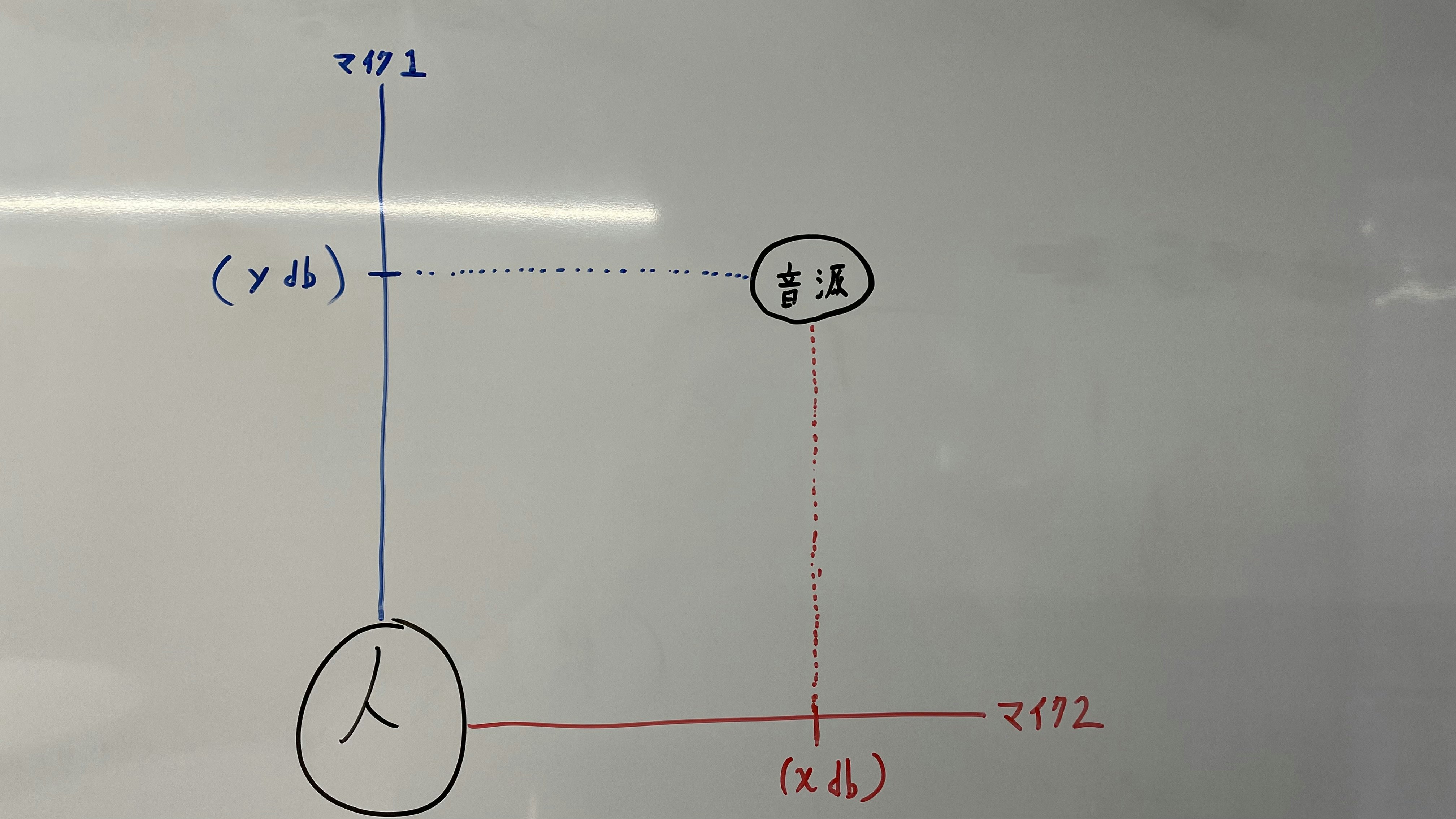

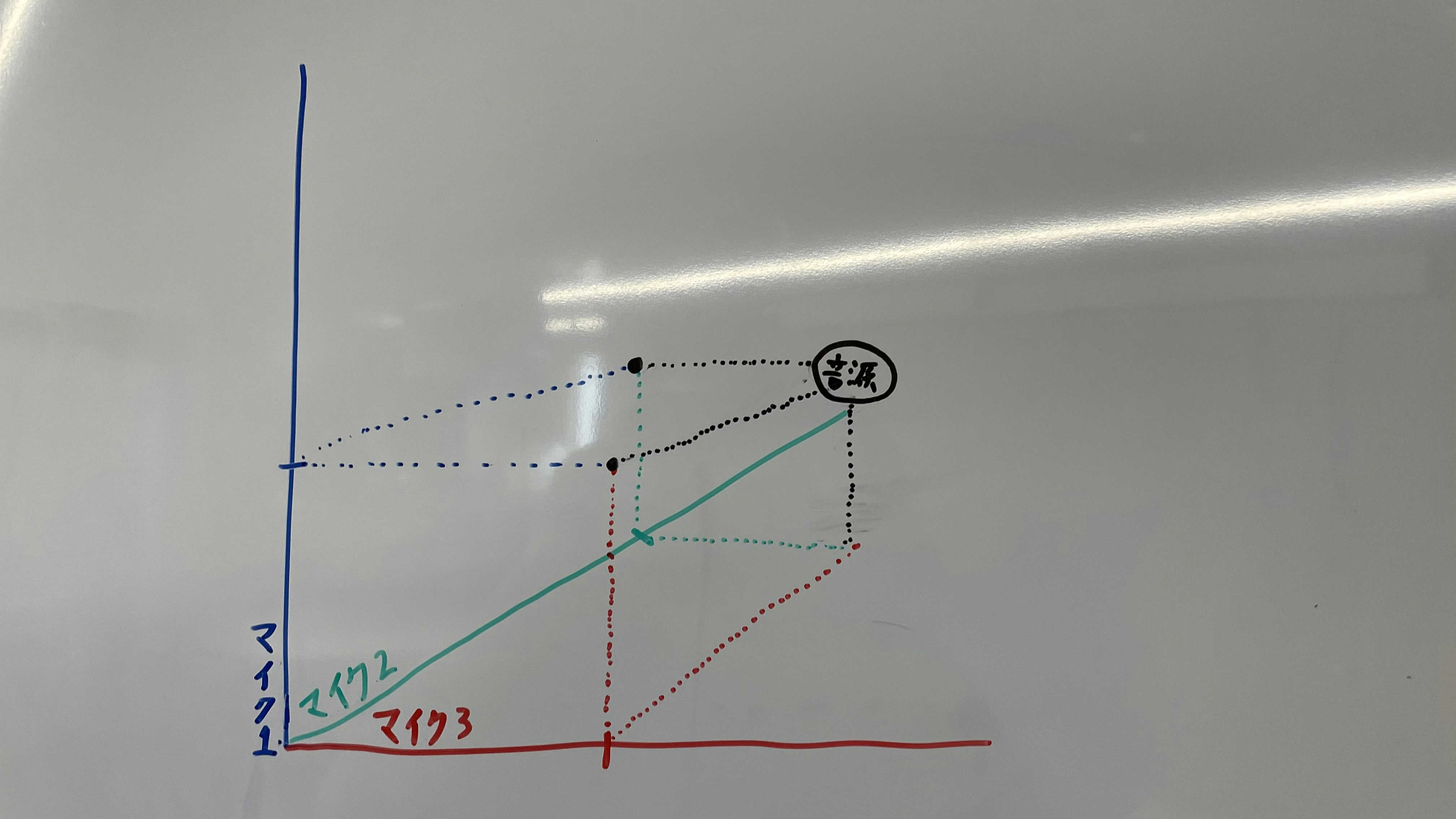

複数のマイクから得た音量データを利用し、音の発生源を特定。

-

特定した音の発生源に対応するオノマトペを表示させる。

問題点

-

マイクの数が多い

- 人の頭を球体として全方位の音に対応するためには、6つのマイクが必要。

- しかし、これはスマートな装着方法ではない。

-

複数の音源を同時に特定できない

- この方法では、一つの音しか特定できない可能性がある。

-

オノマトペの種類が膨大

- 全ての音に対応するオノマトペを準備するには、莫大な時間がかかる。

-

視覚への負担

- 聴覚障害者の視界をオノマトペで埋めてしまうことで、かえって視覚を狭めてしまわないかという懸念がある。

今後の展望

- マイクのみで音の発生源を特定するのではなく、映像と組み合わせて特定する方法が良いかもしれない。

例

- 周囲から車の音がする。

- 視線カメラの映像から車を探す。

- 画面に車が映っていれば、そこにオノマトペを表示。

とにかく手を動かそう 終わり