この記事は2025/5/22に記載しています。最新の情報とは異なる可能性があるため、各種公式ページを参照ください。

Clineでユーザーごとに料金をモニタリングするための、アプリケーション推論プロファイルがサポートされていたので使ってみました。

推論プロファイルとは?

生成AIモデルの呼び出しに関する設定をまとめたリソースです。

リクエストは推論プロファイルを介して、特定モデルの特定リージョン(クロスリージョン推論モデルの場合は複数リージョン先)にルーティングします。

クロスリージョン推論モデル(Claude 3.5 Sonnet v2やClaude 3.7 Sonnetなど)には、システム定義の推論プロファイル(System-defined Inference profile) と呼ばれるAWS側で事前定義されたものが使用されており、これによってクロスリージョン推論を実現しているようです。これは クロスリージョン推論プロファイル と呼ばれています。

アプリケーション推論プロファイルとは?

ユーザーが独自に作成する推論プロファイルのことで、特定のアプリケーションやユースケースに合わせた設定が可能になります。システム定義の推論プロファイルをコピーしてカスタマイズすることができます。

今回はこれを利用することでチームやメンバー単位でBedrock利用状況を管理します。

アプリケーション推論プロファイルにコスト配分タグを設定します。

Amazon Bedrock を使用した生成 AI のコストと使用状況の追跡、配分、管理

事前準備

-

ClineからAmazon Bedrockを呼び出せていること

- Amazon Bedrock基盤モデルへのアクセスリクエスト

- APIを呼び出すのに必要なアクセス許可(

bedrock:InvokeModel,bedrock:InvokeModelWithResponseStreamがあること) - Cline のインストールがされていること

-

推論プロファイル作成に必要なIAM権限が存在すること

以下のポリシーをアタッチする

参考:Amazon Bedrockによって定義されたアクション

{

"Version": "2012-10-17",

"Statement": [

{

"Sid": "Statement1",

"Effect": "Allow",

"Action": [

"bedrock:CreateInferenceProfile",

"bedrock:GetInferenceProfile",

"bedrock:ListInferenceProfiles",

"bedrock:TagResource",

"bedrock:ListTagsForResource"

],

"Resource": [

"arn:aws:bedrock:*:*:application-inference-profile/*"

]

}

]

}

設定手順

1. アプリケーション推論プロファイルの作成

作成例

AWS CLIまたはCloudShellを使って、アプリケーション推論プロファイルを作成します。

--tags にチームと個人のコスト配分タグをつけることによって、個人集計とチーム集計ができるようにしました。他にも環境などに応じて分類したい場合はtagsに追加します。

※ aws bedrockコマンドが利用できるAWS CLIバージョン2.13.0以降である必要があります。

aws bedrock create-inference-profile --region 'ap-northeast-1' \

--inference-profile-name 'teamA-bedrock-bellshun2' \

--model-source '{"copyFrom": "arn:aws:bedrock:ap-northeast-1:<アカウントID>:inference-profile/apac.anthropic.claude-3-5-sonnet-20241022-v2:0"}' \

--tags '[{"key": "Team","value": "teamA"},{"key": "MemberName","value": "bellshun"}]'

補足

- 上記はClaude3.5 Sonnet v2を東京リージョンで設定した例です

- クロスリージョン専用モデルは推論プロファイルを介してモデルにアクセスするため、Claude 3.5 Sonnet v2やClaude 3.7 Sonnetは

--model-sourceに以下のInference profile ARNを指定します(または、aws bedrock list-inference-profiles --type-equals SYSTEM_DEFINED --region ap-northeast-1にて利用モデルのシステム定義の推論プロファイルを探します)

2. Clineの設定

以下コマンドを実行し、作成した推論プロファイルの inferenceProfileArn を取得します。

aws bedrock list-inference-profiles --region 'ap-northeast-1' --type-equals 'APPLICATION'

出力

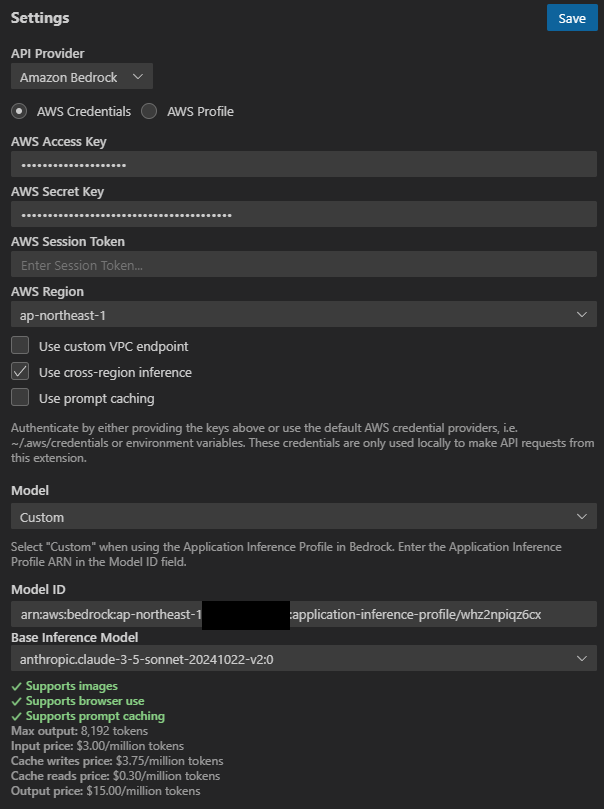

Cline設定画面

ModelをCustomにして、Model IDとBase Inference Modelを設定します。

設定後にClineが通常通り動作していれば完了です。

3. コスト配分タグの有効化

作成してから最大24時間後にタグが現れるようになります。

AWS Billing and Cost Managementの「コスト配分タグ」を選択し、作成したタグ(上記の通りだと「Team」と「MemberName」)を有効化します。

4. AWS Cost ExplorerやCloudWatchメトリクスでモニタリング

3,4の手順は反映までに時間がかかるので気長に待ちます。

タグからコスト配分タグを選択できるようになるので、設定したタグごとのコスト確認が可能になります。

また、Amazon CloudWatchメトリクスでプロファイルごとの呼び出し回数、処理時間、トークン数などを監視できるようになります。Model IDの指定にアプリケーション推論プロファイルのIDを入れることで絞り込むことができます。

(必要に応じて) 推論プロファイルの利用強制

アプリケーション推論プロファイルを指定しないBedrockの直接呼び出しを拒否し、特定の推論プロファイル経由のみ許可するIAMポリシーを設定することが必要な場合もあると思います。

今回は利用人数も限られていたため、アプリケーション推論プロファイル経由でClineを利用するルールをチーム内で定めるのみとしました。

注意

Amazon Bedrock でサポートされている基盤モデル に記載の通り、Claude 3.5 Sonnet v2やClaude 3.7 Sonnetはクロスリージョン推論プロファイルを介してアクセスされるため、リージョンに関するプロジェクト制約がある場合は利用できない可能性があります。

推論プロファイルでサポートされているリージョンとモデル から、どのリージョンにルーティングされるかを確認できます。

例えば、Claude 3.5 Sonnet v2東京リージョンが送信元の場合は、大阪やシドニーリージョンにもルーティングされるので、東京リージョン限定プロジェクトなどでは利用できません。

リアルタイムモニタリングとRate Limitについて

今回の方法では、以下は実現できません。

費用対効果を鑑みて、今回はモニタリングのみ行いました。

- リアルタイムモニタリング

- メンバー毎に、トークン数やコストに対するRate Limit処理

上記のようなより柔軟な制御を必要とする場合は、LangFuseによるリアルタイムな詳細モニタリングとLiteLLMによるProxy導入が有効です。

ちょうど先日以下の記事が公開されており、参考になります。

開発生産性向上とガバナンスの両立を目指した、Cline with Amazon Bedrock と LiteLLM 活用のコツ