前回は Dify のインストールと起動確認 まで実施しました。

今回は、生成AI「Gemini」からの返答を得られるところまで、環境構築を進めていきます。

初期ログイン完了まで

起動直後はユーザーが未登録の状態です。

最初に管理者アカウントを登録し、ログイン可能な状態にしておきます。

① 管理者アカウント情報の入力

管理者アカウントの情報(メールアドレス、ユーザー名、パスワード)を入力します。

その後、「セットアップ」ボタンをクリックします。

管理者アカウントでログインすると、ここで入力したメールアドレス宛にログイン確認のメール(認証コード付き)が送られてきます。

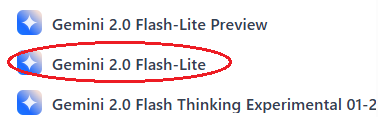

② ログイン

ログイン画面が表示されます。

管理者アカウントの情報(メールアドレス、パスワード)を入力してから、「サインイン」ボタンをクリックします。

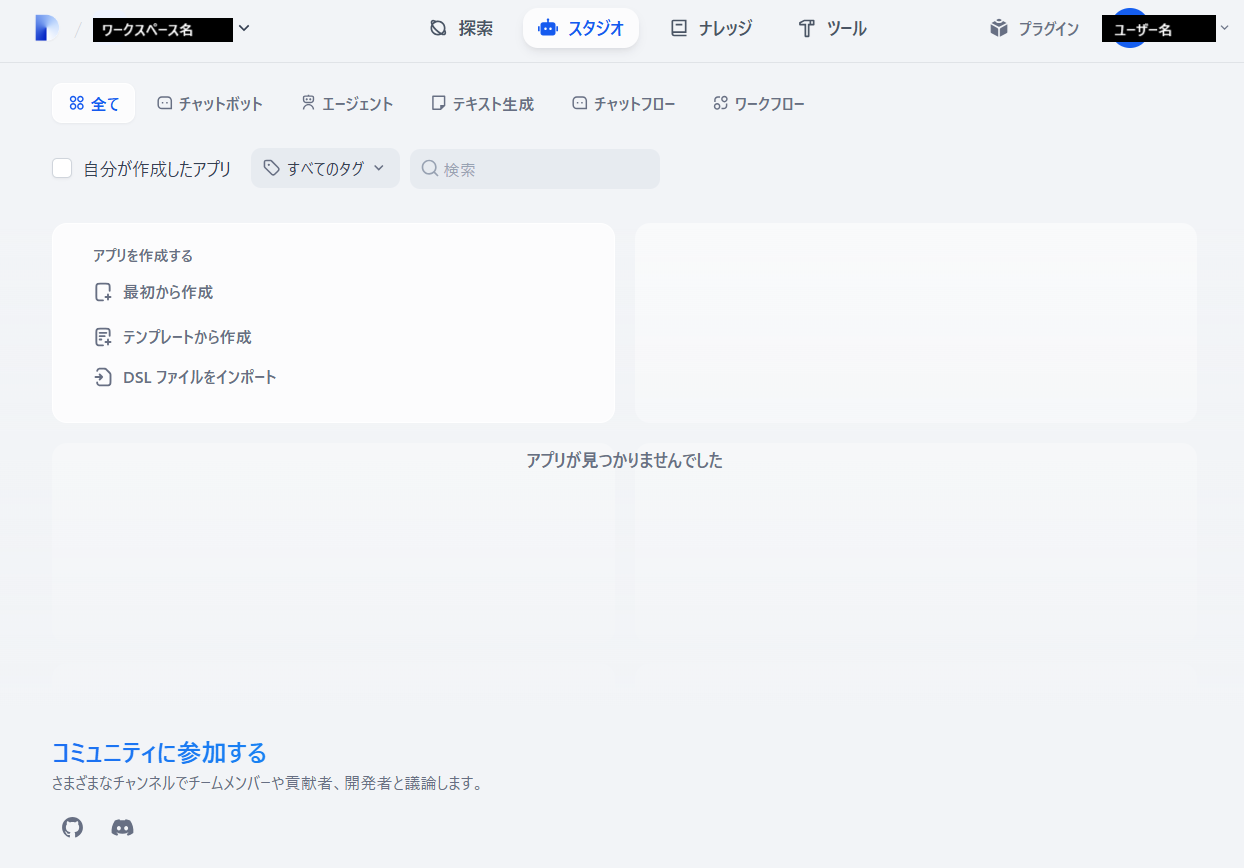

③ スタジオ画面の表示

ログインが成功すると スタジオ画面 が表示されます。

左上の 黒枠部分には「ワークスペース名」が、右上の黒枠内には「ユーザー名」が表示されます。

これで、Dify を利用する準備が整いました。

Gemini APIキー の取得

高性能なAIモデルを無料で幅広く利用できる「Gemini」を利用します。

利用可能なトークン数で制限している他 AIモデルとは異なり、無料枠では「短時間での連続するリクエスト」に制限を設けているようです。

リクエスト数/分 2 - 30 RPM

トークン/分 32,000 - 1,000,000 TPM

リクエスト/日 1,500 RPD

有料枠に変更すると、上記の制限値が大きく緩和されます。

詳細については レート制限 を参照してください。

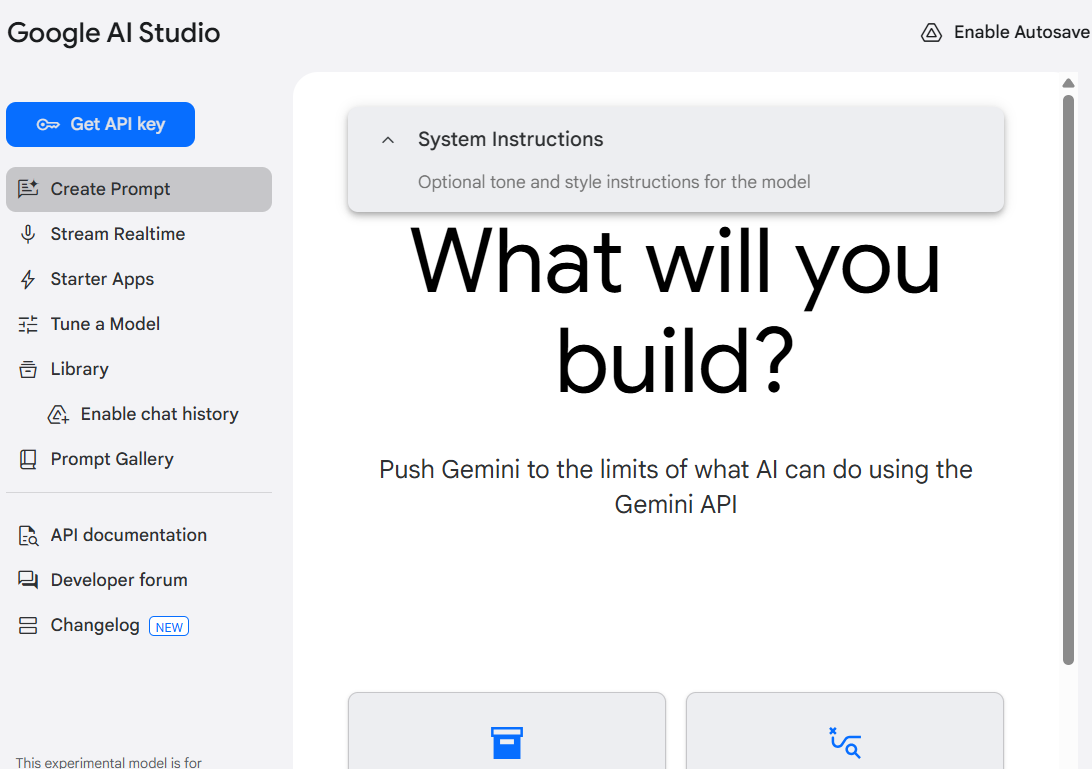

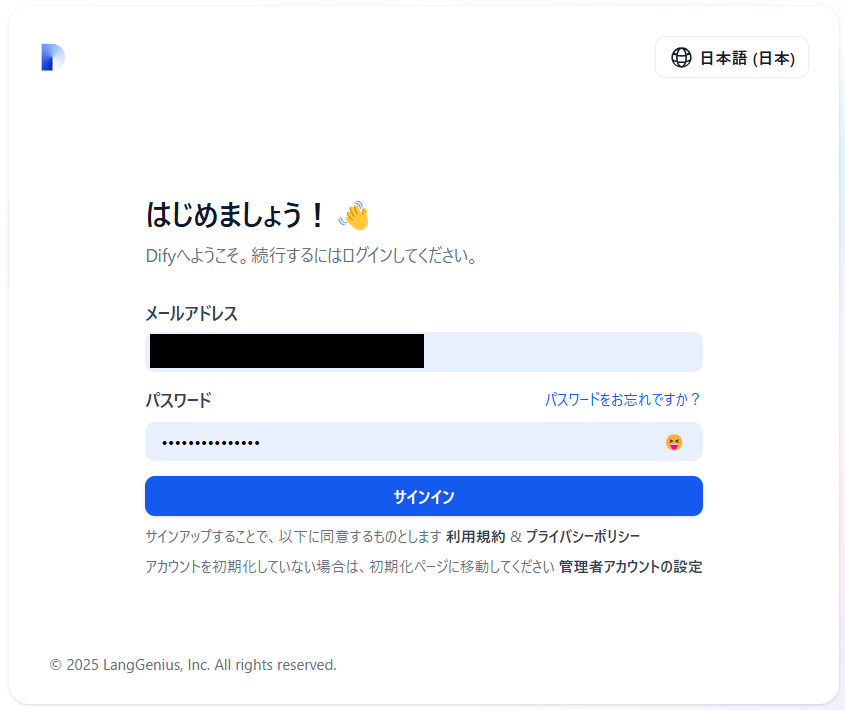

① Google AI Studio の起動

Gemini の APIキー は、Google AI Studio 上で取得します。

左下の「Explore models in Google AI Studio」をクリックすると、Google AI Studio のメイン画面が表示されます。

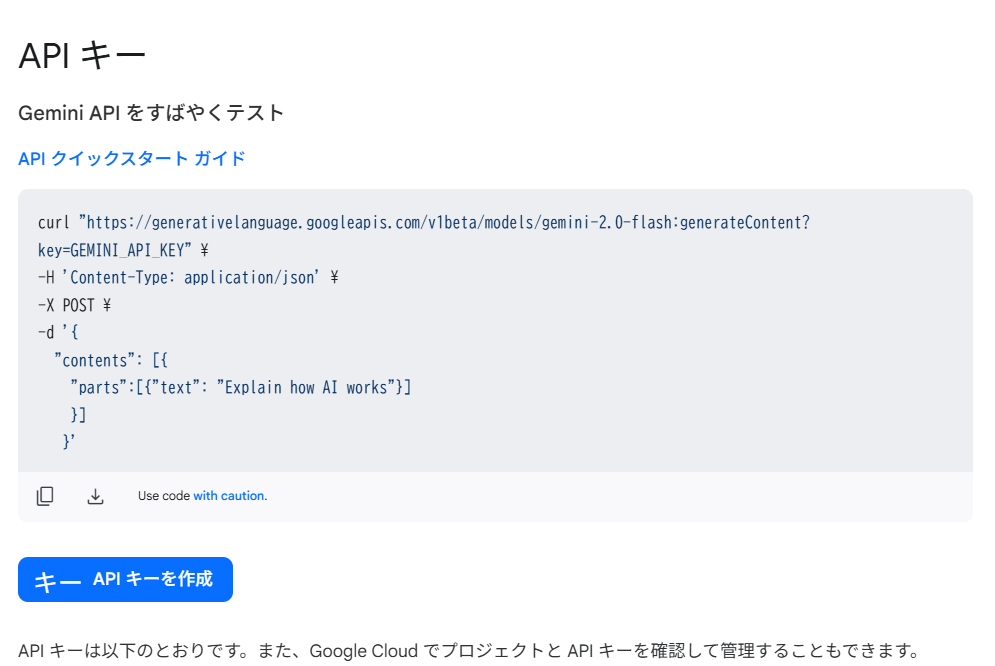

② APIキーの取得

左上の「Get API Key」ボタンをクリックします。

APIキー 画面が表示されたら、「API キーを作成」ボタンをクリックします。

少しの時間の後、生成された API キーが表示されます。

「コピー」ボタンをクリックし、「APIキー」を保存しておきます。

③ API 利用規約の同意

生成した APIキー は、画面の下部に一覧表示されています。

「プラン」列のリンク "お支払い情報を設定 使用状況データを表示" をクリックします。

Google Cloud の「APIとサービス」画面へ切り替わります。

下のポップアップ画面が表示されたら、利用規約にチェックを付けて「同意して続行」をクリックします。

ポップアップ画面が表示されないときは「すでに利用規約に同意済み」ということです。

その場合は、何もする必要はありません。

モデルプロバイダー の新規登録

設定画面からモデルプロバイダーを追加し、先ほど取得した APIキー を登録します。

① アプリ編集画面を表示

Dify スタジオ画面の「アプリを作成する」-「最初から作成」をクリックします。

アプリの種類は「チャットボット」を選択します。

「アプリのアイコンと名前」および「説明」を入力してから、「作成する」ボタンをクリックします。

アプリのアイコンと名前: テストアプリ1

説明 : 最初に作成したチャットボットのアプリ。

アプリを編集するためのオーケストレーション画面が表示されます。

"LLMプロバイダキーが設定されていません"というメッセージが表示されていますが、今は 無視して構いません。

② モデルプロバイダーの選択

右ペイン中央の「設定に移動」ボタンをクリックすると、モデルプロバイダーの一覧が表示されます。

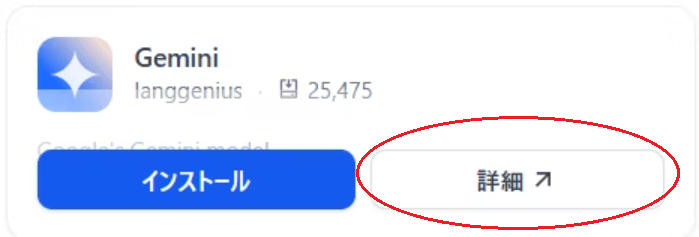

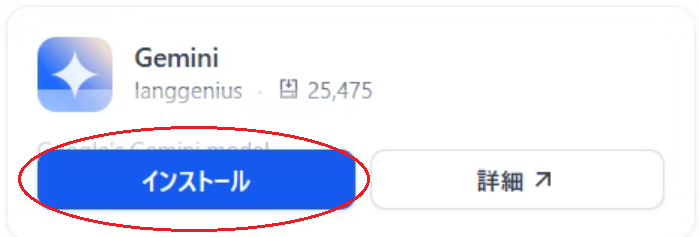

マウスカーソルを「Gemini」枠内へ移動すると、「インストール」「詳細」というボタンが表示されます。

「詳細」ボタンをクリックします。

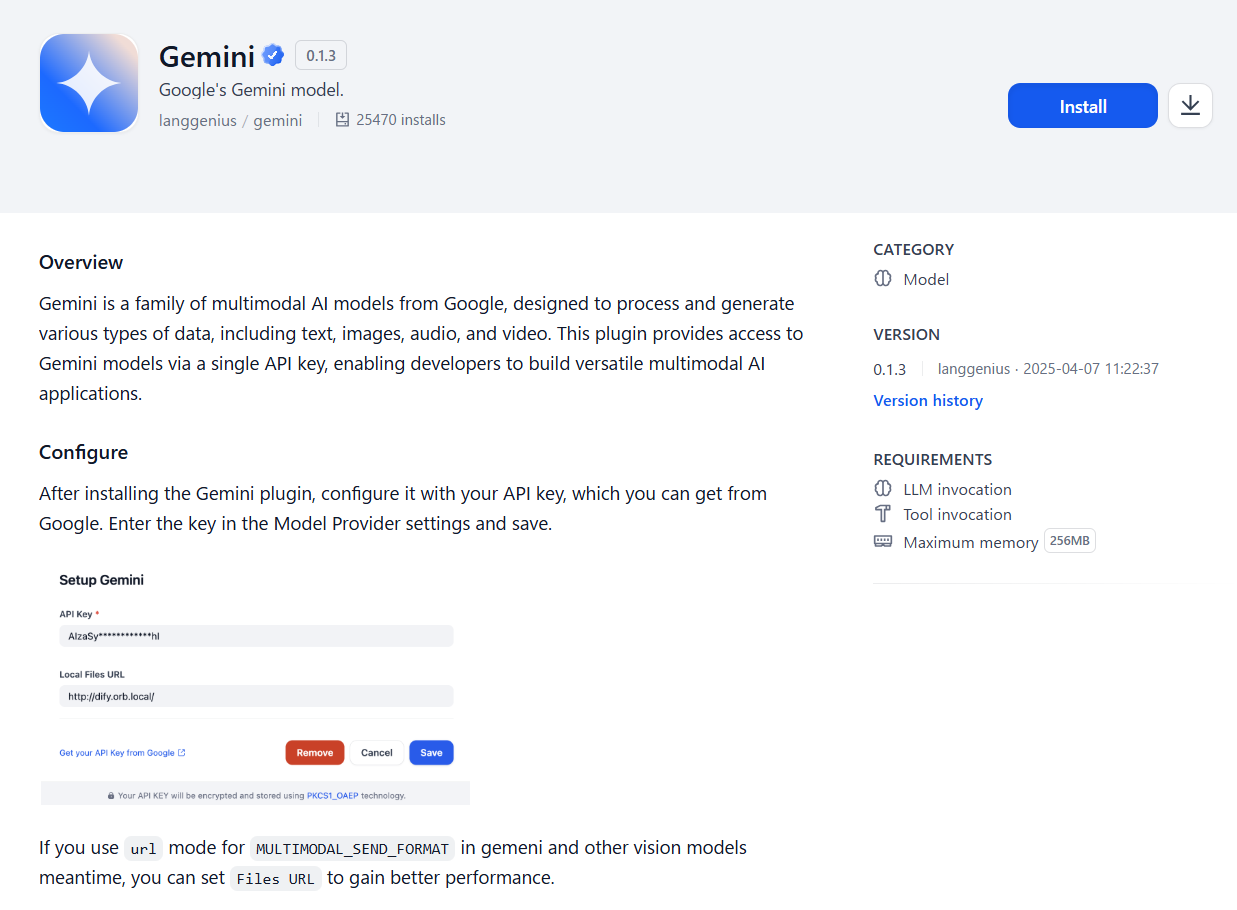

③ モデルプロバイダーの詳細

Overview には「Geminiを使うとマルチモーダル な AIアプリケーションを構築できる」的な文章が表示されています。

が、ここでは 右側の「REQUIREMENTS(要件)」に注目してください。

「最大メモリサイズ」が「256MB」と表示されています。

他の多くのプラグインも 256MB と表示されているので、Gemini 用プロバイダーだけが特別に多いわけではなさそうです。

OpenAI など、いくつかのプラグインでは 1MB でした。

数多くのプラグインを導入して同時に動かす際は、それぞれの消費メモリ量にも気を配る必要があると思います。

④ モデルプロバイダーのインストール

元の「モデルプロバイダー」一覧画面へ戻り、今度は「インストールボタン」の方をクリックします。

詳細画面の「Install」ボタンをクリックすると、「はじめましょう!」画面に戻ってしまいます。

このボタンはクリックしないようにしましょう。

確認画面が表示されたら、「インストール」ボタンをクリックしてください。

⑤ APIキー の登録

モデルプロバイダーの一覧画面に戻ると、「設定中」欄に「Gemini」が表示されています。

右端の「セットアップ」ボタンをクリックします。

設定画面が表示されたら「API Key」欄へ Gemini の APIキー を入力し、「保存」ボタンをクリックします

次のように表示されたら、モデルプロバイダーの登録は終了です。

続けて、「システムモデルの設定」へ進みます。

システムモデルの設定

Dify が使用する既定のモデルを設定します。

少なくとも「システム推論モデル」にはモデルを設定してください。

参照: モデルタイプ

| 名称 | 説明 |

|---|---|

| システム推論モデル | アプリの中で使用するモデル。(チャットなど) |

| 埋め込みモデル | テキストを、意味の似た数値(ベクトル)に変換するモデル。 |

| Rerankモデル | 検索した候補を「意味のあっている順」に並べ直すモデル。 |

| 音声-to-テキストモデル | 音声をテキストに変換するモデル。 |

| テキスト-to-音声モデル | テキストを音声に変換するモデル。 |

① 設定画面の表示

同ボタンの直下に、モデル設定ウィンドウが表示されます。

「システム推論モデル」欄の右端のアイコンをクリックしてください。

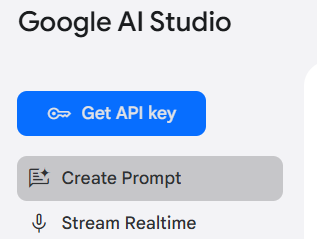

② モデルの選択

Gemini で利用可能なモデルが一覧表示されます。

利用したいモデルをクリックしてください。

参照: モデル バリエーション

多少 精度は落ちるものの、今回は 返答速度の速い「Gemini 2.0 Flash-Lite」を選択します。

「システム推論モデル」欄に「Gemini 2.0 Flash-Lite」と表示されます。

そのまま、モデル設定ウィンドウ下部の「保存」ボタンをクリックしてください。

相変わらず警告メッセージが表示されていますが、ここでは無視しても構いません。

チャットボット動作の確認

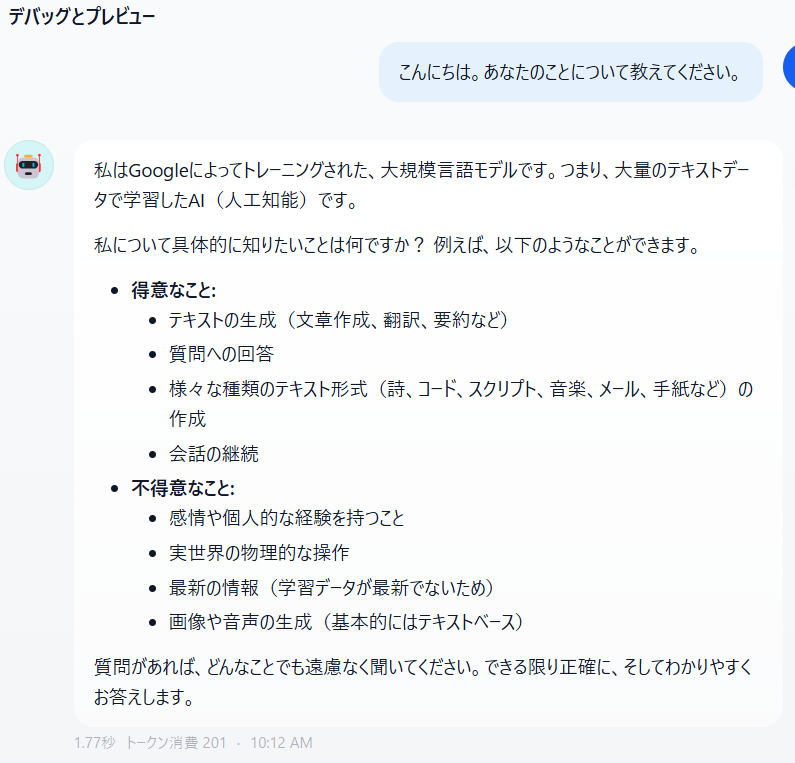

チャットアプリの「デバッグとプレビュー」画面から、モデル「Gemini 2.0 Flash-Lite」との会話を試してみることにします。

① 「デバッグとプレビュー」画面の表示

アプリ「テストアプリ1」の オーケストレート画面 を表示します。

システムモデルを設定したので、警告メッセージは見当たりません。

② モデルの選択

この確認で使用する「モデル」を選択します。

黄色い枠線 の内側をクリックしてください。

マウスポインタを 黄色い枠線 の内側へ移動すると、「廃止予定」というツールチップが表示されます。

おそらく、この UI部品は 近い将来に削除されるものと考えられます。

「システムモデルの設定」と似た画面が表示されます。

ここでも「Gemini 2.0 Flash-Lite」を選択してください。

選択後、「パラメータ」画面が表示されます。

今は無視しても構わないので、このウィンドウ枠外をクリックして画面を閉じてください。

③ テストメッセージの入力

画面下部のテキスト入力欄に、「こんにちは。あなたのことについて教えてください。」と入力してください。

入力後は「Enter」キーを押下、または 入力欄の右端の「青いボタン」をクリックします。

数秒の後、以下のように表示されました。

時間にして 2秒ほど でしょうか。

家庭用のネット回線(Wimax 5G)なので、混み具合によっては応答時間がかなり変動しそうです。

終わりに

生成AIモデル「Gemini」の API を呼び出して、質問に対する返答が得られるところまで辿り着きました。

次回は、サンプルアプリ「テストアプリ1」を「公開」し、アプリとして実行してみることにします。(今回はデバッグ画面から実行しただけなので)