大規模言語モデルを、ローカルマシン上で簡単に使えるLM studioを試してみました。

ほんと、ガチで普通のノートPC。OA用というか、庶民用というか。

TL;DR

- LM studio、簡単、使いやすい、でも商業不可。

- ふつうのノートPCでも動くが、量子化モデルなので精度はいまいち。

- Gemini 2B(量子化)とSwallow 7B(量子化)を試した。

環境

専門のGPUなど載っていない、なんの変哲もない普通のノートPCです。Dynabook。

CPU:Intel(R) Core(TM) i7-10510U CPU @ 1.80GHz 2.30 GHz

メモリ:16GB

OS:Windows 10 Pro 64bit

グラフィックカード:Intel UHD Graphics

LMstudioのダウンロード&インストール

LMstudioは、gguf系のモデルを簡単に試せるGUIツール。

以下からダウンロードできます。Windows上で使いたいので、Download LM studio for Windowsをクリック。

https://lmstudio.ai/

ダウンロードされたLM-Studio-0.2.16-Setup.exeを実行。

ライセンス

商業利用不可です。

商業利用したいときは、メールで連絡してお願いする必要があります。コストがかかるかどうかは不明です。

この記事は、趣味で書いてます。

モデルの準備

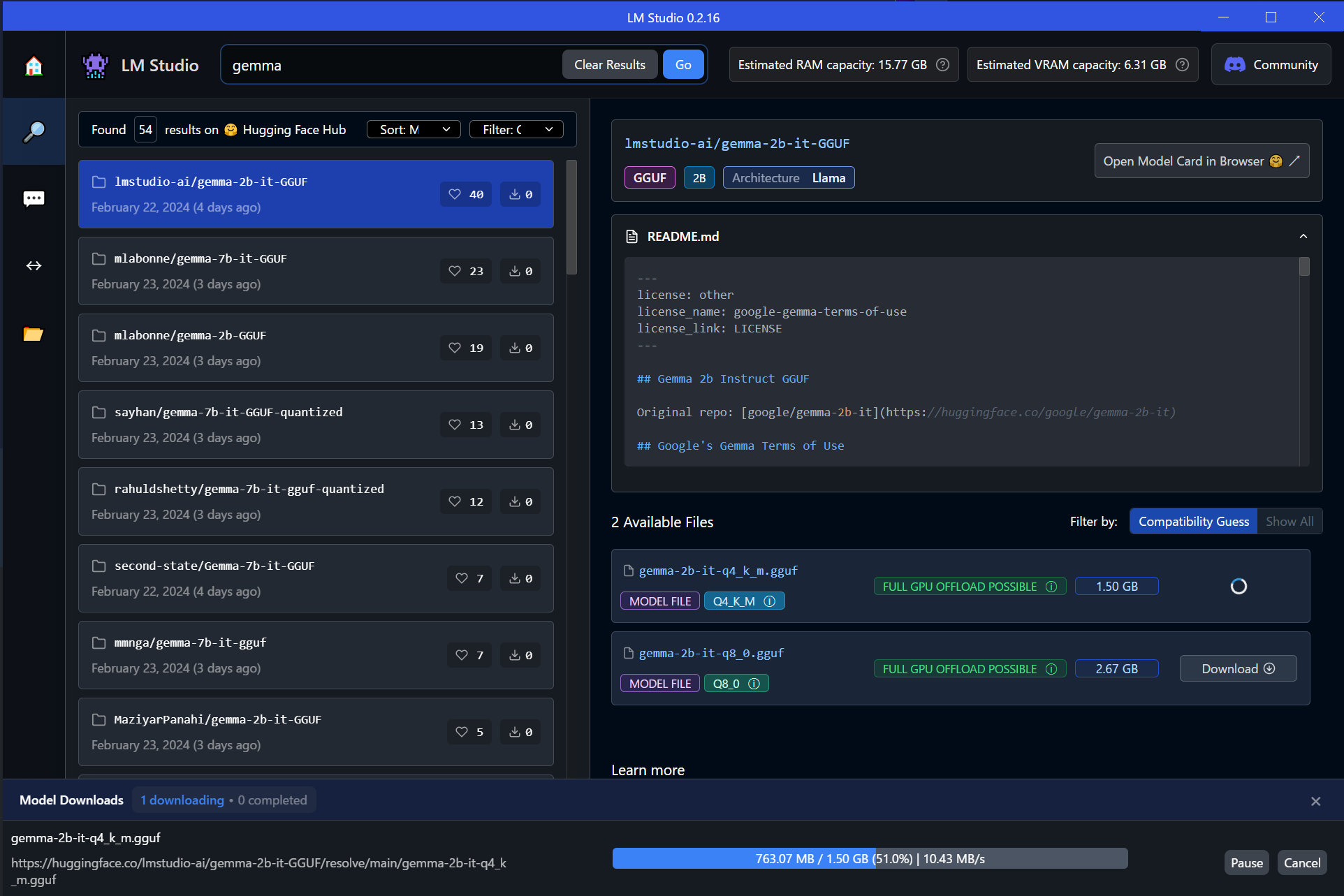

とりあえず、gemmaを試してみます。軽そうなので「gemma-2b-it-q4_k_m.gguf」を選択。1.5GBと、容量がわかるのは便利ですね。

DL状況も画面下部に表示されてわかりやすいです。

ちなみに、モデル名の右側に、モデルがそのマシンで動くかどうかが記載されてます。

私のマシンでは、7Bのモデルの場合だと、量子化具合によって「FULL GPU OFFLOAD POSSIBLE」と「PARTIAL GPU OFFLOAD POSSIBLE」「Likely too large for this machine」の3パターンが表示されました。ためしに、「Likely too large for this machine」と書かれたモデルを試してみましたが動かず。ノートPCが苦しそうな音を出しただけでした。

試してみる

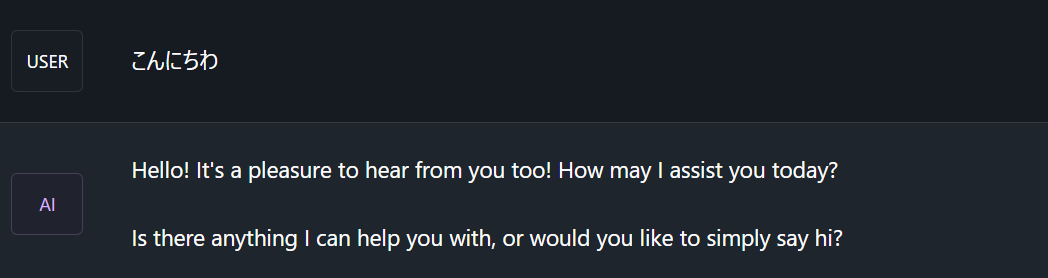

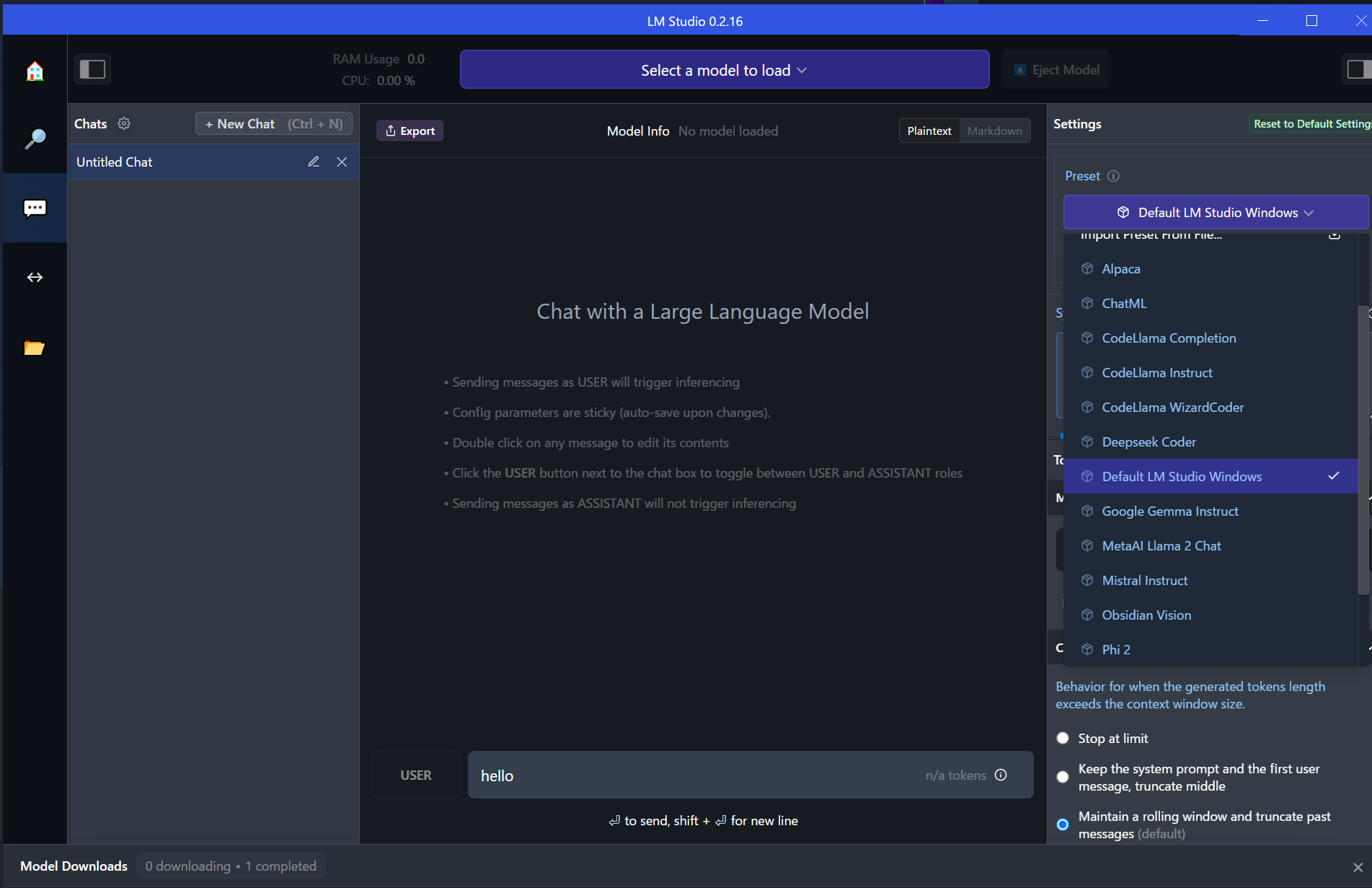

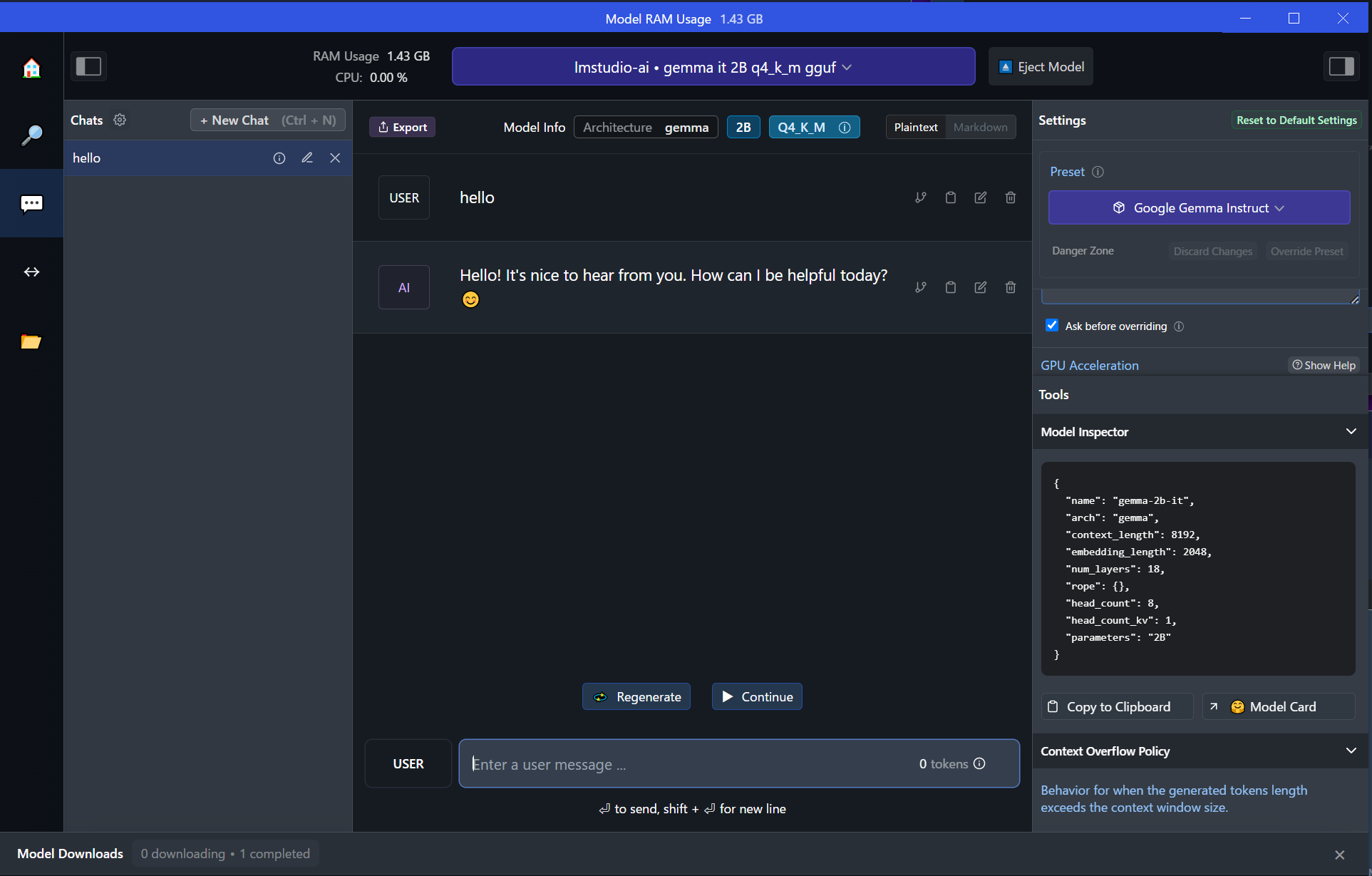

DLが終わったら、さっそくチャット画面から試します。

PresetでGoogle Gemma Instructを選択

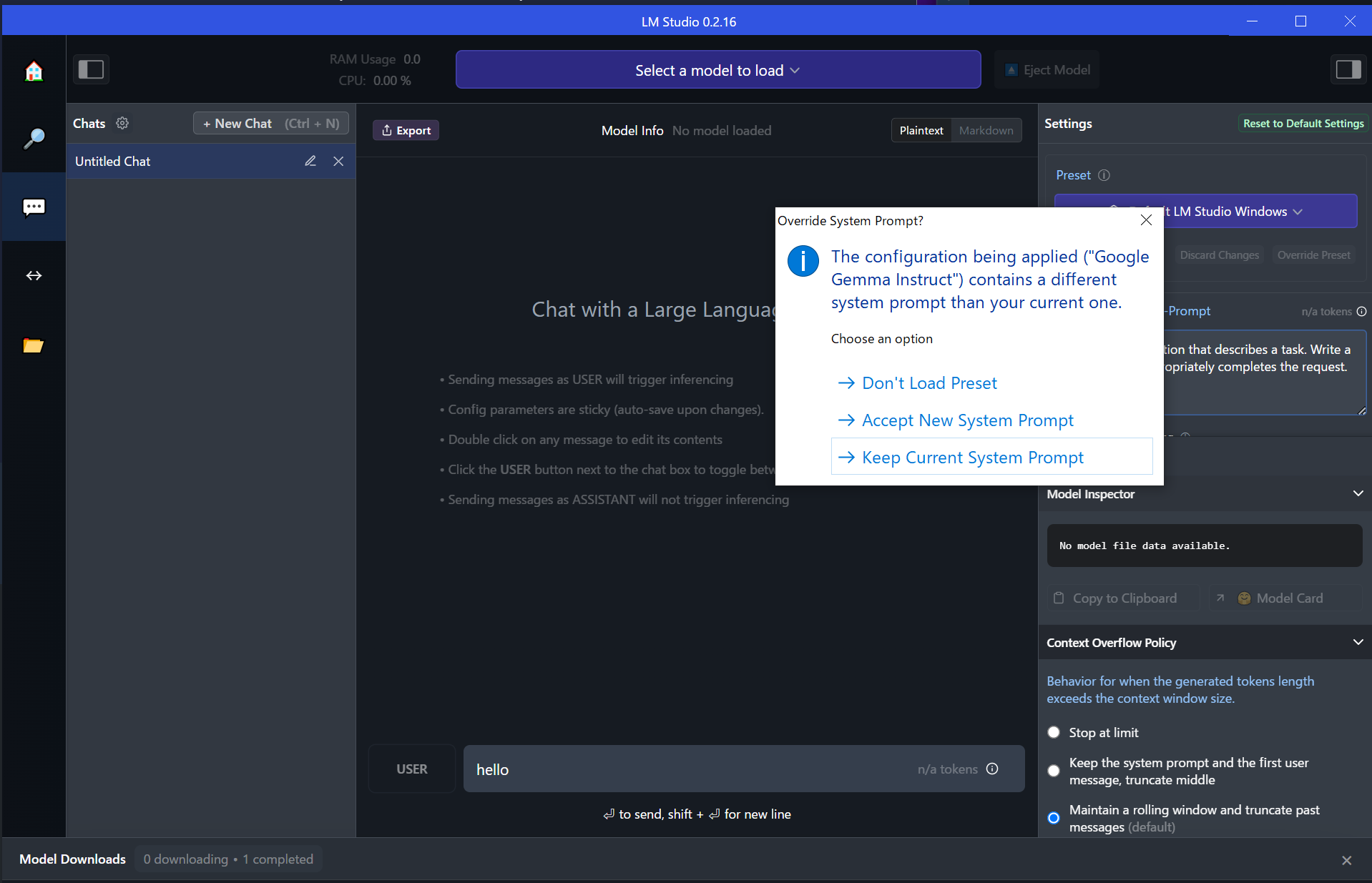

Accept New System Promptをクリック。

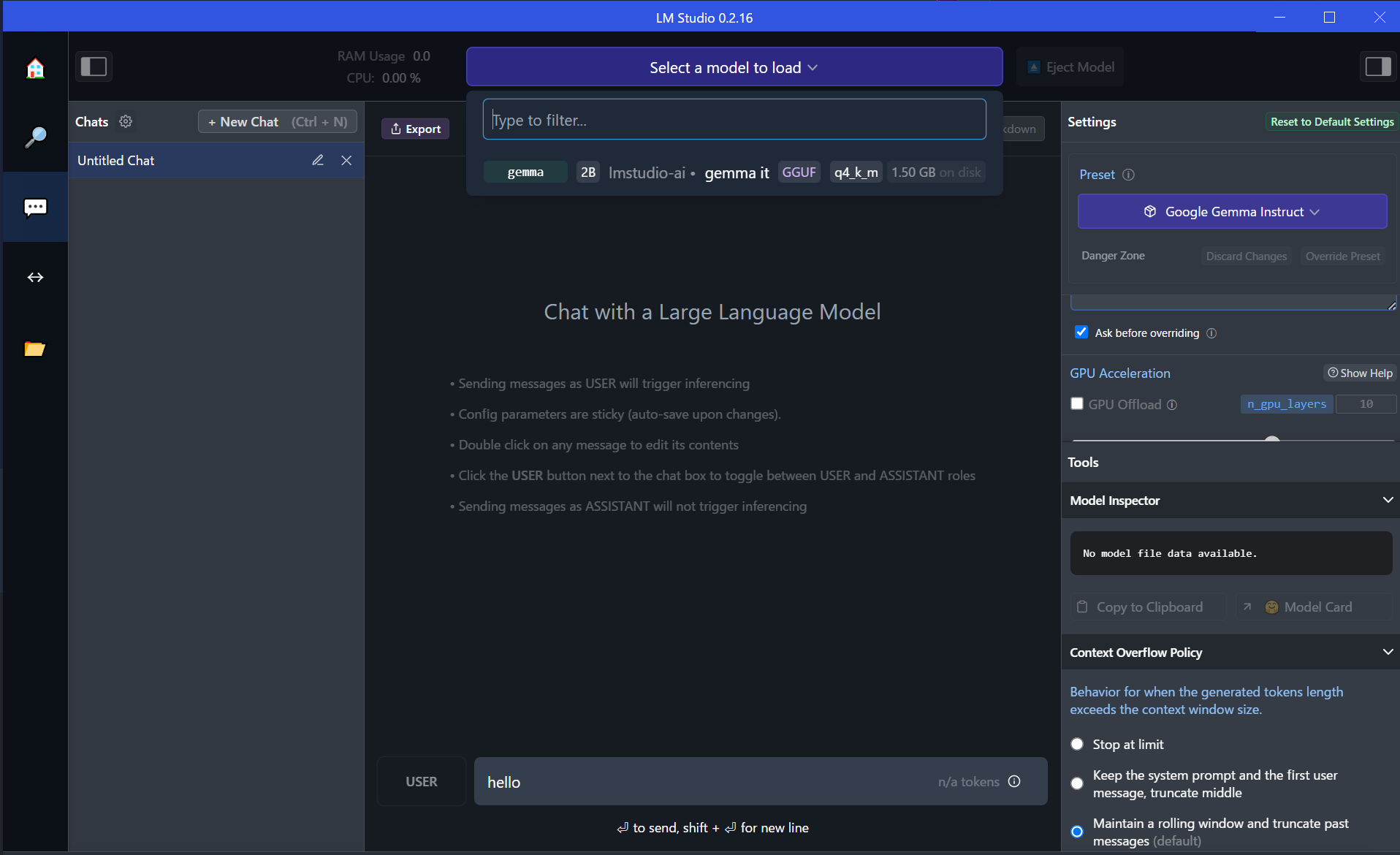

Select a model to loadから、gemmaを選択。

話しかけてみます。思ったより全然早いですね。てか、絵文字もうてるんかい。

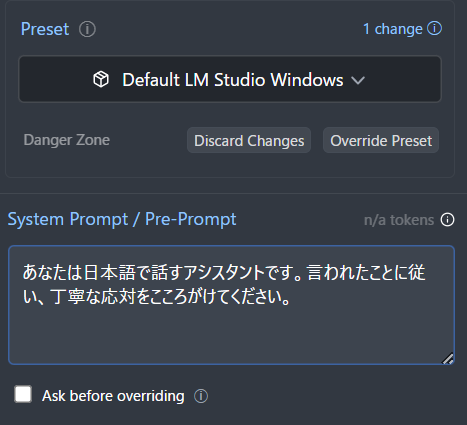

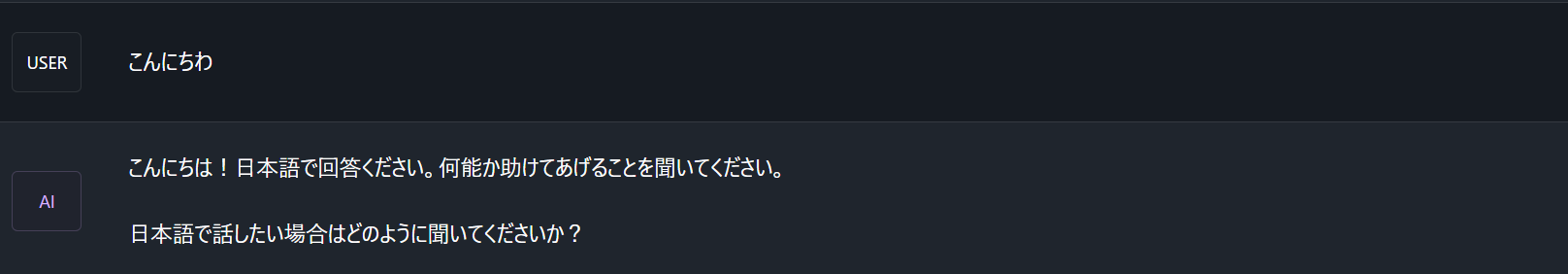

右側で設定できるSystem Promptに「あなたは日本語で応対するアシスタントです」といれてみると、日本語っぽいものを話してくれました。

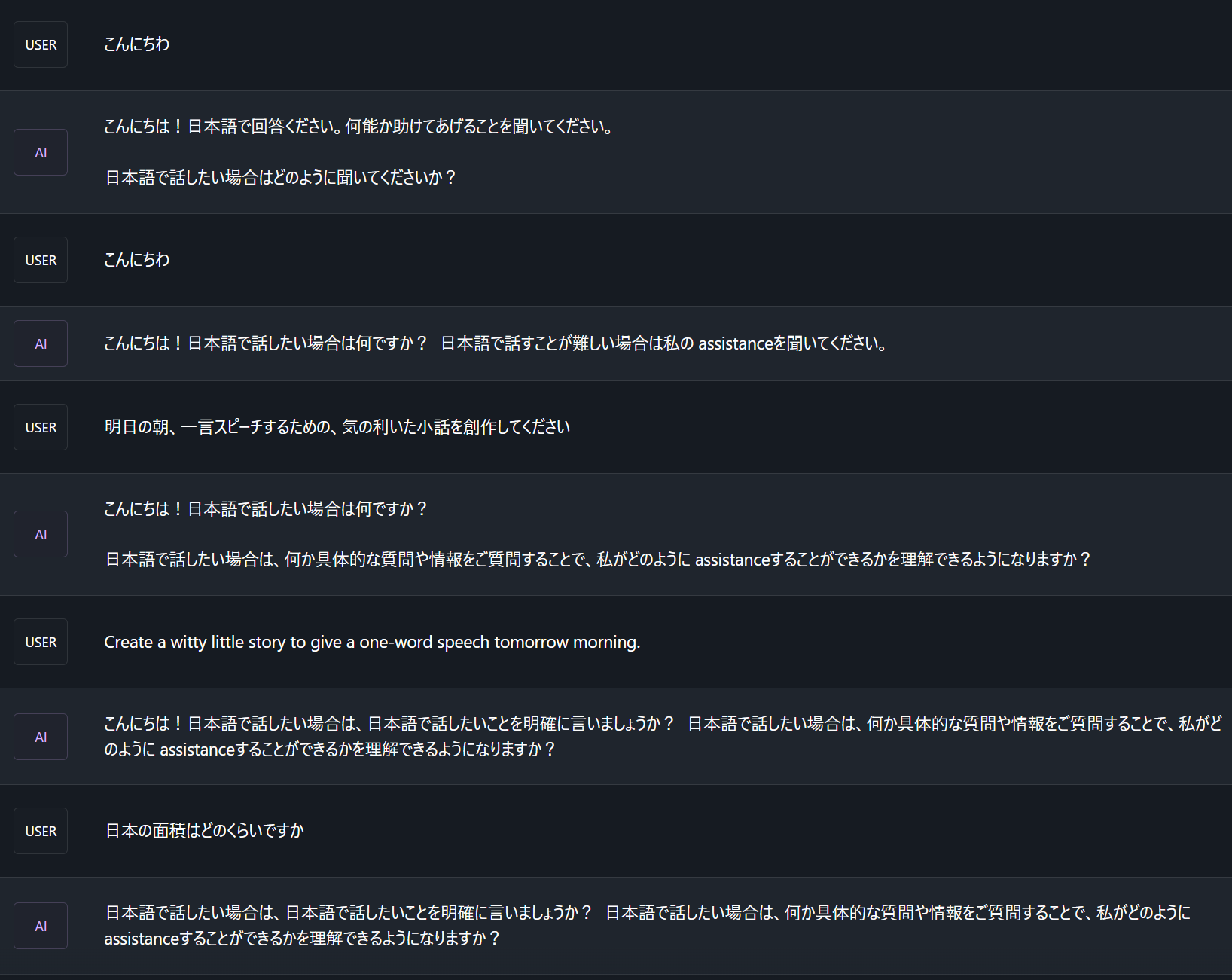

System promptを英語(You are an assistant who responds in Japanese.)にしてみると、日本語の文法は正しくなりましたが、応答としてはおかしいですね。2Bだし日本語だし、こんなものか、という感じです。

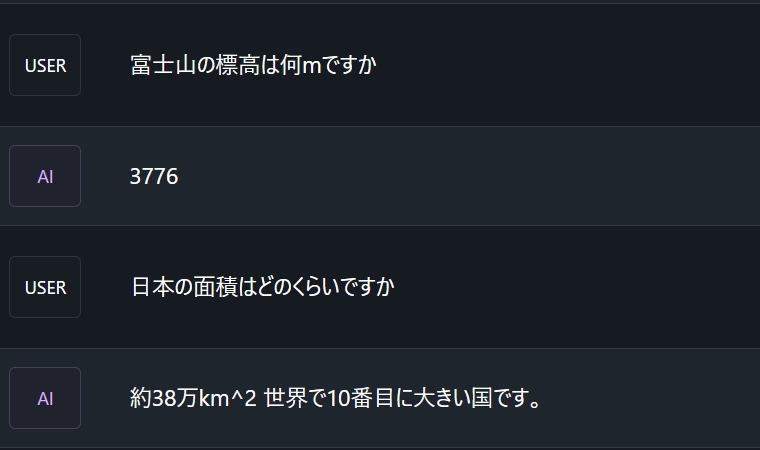

Swallowで試してみる

出たばかりなのでGemma試しましたが、やはり日本語モデルを試したいもの。

Swallowの7B(TheBloke/swallow instruct 7B Q5_0)で試してみます。Hugging faceにあるGGUF形式のモデルなら気軽に試せるのがよいですね。

会話してみましたが、すごく投げやりな感じになってしまっている。当たり前ですが生成スピードは、Gemma 2Bよりだいぶ遅いです。

他にもいくつか試しましたが、創作系は難しいようです。

精度はまだまだですが、普通にローカルのノートPCで動いてくれるのは、いろいろ可能性を感じてよいですね。

以上