はじめに

RetailAI Adventurers Advent Calendar 2023 の 8 日目の記事です。

昨日は @zushi_ryota さんの『Mockito-Kotlin を使ってテストコードを書いてみる』でした。

昨年末の ChatGPT の登場により、今年は『生成 AI』が流行語大賞のトップテンに入るほど世間一般に AI が浸透し、AI エンジニアでなくても LLM を使ったサービスを開発するなど一気に普及していきました。

更にタイムリーなことに本記事の投稿前日の 2023 年 12 月 7 日には、

- Google (DeepMind) が ChatGPT を凌駕すると言われている次世代マルチモーダル AI モデル「Gemini」を発表

- Apple が Apple Silicon 向けに最適化された ML フレームワーク「mlx」を OSS として公開し、llama やStable Diffusion も実装可能

という大きなニュースが今年の年末にもありました。

その生成 AI ブームですが、本記事では昨年から急速に普及してきた画像生成 AI に関しては色々遊んでみたいと思います。画像生成 AI サービスとして有名どころでは、DALLやStable Diffusion、Midjourneyなどがありますが、いずれも拡散モデルをベースとしたモデルです。。私は pix2pix や CycleGAN 等の GAN(敵対的生成ネットワーク)を活用した開発も過去に取り組んでおりましたが、その急速な進歩に驚くばかりです。

拡散モデルについてざっくり説明

まずは画像生成 AI の急速な発展に貢献している拡散モデル(Diffusion model)についてざっくり説明します。このモデルを一言で説明すると、ノイズからそのノイズを除去していくことでデータを生成するモデルです。

拡散モデルは、対象分布データ $x_0$ にノイズ(ガウシアンノイズ)を徐々に加えていき、完全なランダムノイズ$x_T$ に変換する拡散過程と、この拡散過程を逆向きにたどる逆拡散過程の 2 つのコンポーネントがベースになっています。

拡散モデルは、様々な強さのノイズを加えた完全なノイズから徐々にノイズを除去する Denoising によってデータを生成します。このように拡散モデルはデータをノイズへ崩壊することで、その生成方法を学習するというユニークなアプローチをとっています。

図引用:Denoising Diffusion Probabilistic Models

実際の画像生成 AI サービスでは自然言語によるプロンプトなどの生成したい画像条件を指定することができますが、これは拡散モデルと他のアプローチを組み合わせることで実現しています。

例えば OpenAI が開発したのDALL・E2では、テキスト埋め込みと CLIP テキスト埋め込みから CLIP 画像埋め込みを推定する事前分布 (prior)と、テキスト埋め込みと CLIP 画像埋め込みを条件づけした拡散モデルにより画像を生成する Decoder を構成することで、テキストから画像を生成することが可能となります。

図引用:Hierarchical Text-Conditional Image Generation with CLIP Latents

画像生成 AI のビジネス応用 : 広告業界

画像生成 AI のビジネス応用は広がっており、日本でも広告業界のビジュアルコンテンツ制作において活用事例が増えてきているように感じます。生成 AI は短時間で高品質、かつ創造性の高いコンテンツを大量に生成できるため、従来の広告制作プロセスの効率化に貢献していると思われます。

ここでは幾つかの企業の活用事例について紹介します。

オタ恋

マッチングアプリの「オタ恋」では、2023 年 5 月から画像生成 AI を活用した広告を展開しています。ユニークでインパクトのある広告を次々打ち出して SNS でバズっただけでなく、認知度が高まったことで「男性は 1.5 ~ 2 倍程度、女性は 3 ~ 7 倍程度、入会者が増加した」と広告効果もあったようです。画像の特徴から Stable Diffusion を用いて制作されていると推測されます。

はじめてのマッチングアプリは、オタ恋。 pic.twitter.com/GnEMWH0iRK

— オタ恋【公式】 (@otakoi_jp) November 7, 2023

画像生成 AI の『短時間で、かつ創造性の高いコンテンツを大量に生成できる』という特性を日本で最もうまく活用している企業かもしれません。

伊藤園

伊藤園は 2023 年 9 月に AI を活用して生成された「AI タレント」を日本で初めてテレビ CM に登場させて話題となりました。AI 生成は AI Model 社が開発したツールを活用したとのことです。AI タレントならタレントの不祥事なども気にせず、企業側も安心して採用できるという側面もあるかもしれません。

パルコ

パルコも生成 AI を活用したファッション広告を制作・公開しています。クリエイターに AI デジタルクリエイターを起用し、グラフィック以外のナレーションや音楽も全て生成 AI を活用して制作されているとのことです。創造性の高いコンテンツを次々に生成できる画像生成 AI は、こういったファッション分野との相性は良さそうです。

生成 AI の課題 : リアルとフェイクの境界が曖昧に

このように生成 AI が急速に精度向上、普及が進むことで、画像や動画、音声、文章など様々なコンテンツでリアルとフェイクの境界が曖昧になってきています。

昨年から今年にかけて生成 AI で作成したと思われるフェイク画像・動画が物議を醸しています。最近ではイスラエル軍とイスラム組織ハマスの軍事衝突をめぐって様々なフェイク画像がネット上に拡散され、日本でもニュース番組出演に似せた岸田首相のフェイク動画が問題となりました。

来年のアメリカ大統領選挙でも、こういった生成 AI を活用したネガティブキャンペーンが展開されることが予想され、実際に今年 3 月にはトランプ前大統領が警察に取り押さえてれているフェイク画像がネット上で拡散されています。

図引用:AI-faked images of Donald Trump’s imagined arrest swirl on Twitter

従来こういった画像や動画を生成するためには GAN などのモデルを開発するための高度な専門知識やマシンリソースが必要とされ、誰でも簡単に扱えるようなものではありませんでした。一方で近年の生成 AI は専門知識を持たない一般のユーザーでもプロンプトさえ入力すれば簡単にフェイク情報を生成できるようになってしまいました。

こういった課題があるなかで、AI が生成した画像・文章であるかを判定するツールやサービスが登場してきています。代表的なサービスとして、Optic 社の「AI or Not」や、Hive Moderation 社の「AI-GENERATED CONTENT DETECTION」がありますが、これらを活用することで、生成 AI かどうかの確率を算出してくれます。

図: AI-GENERATED CONTENT DETECTIONによる判別結果

また AI が生成したコンテンツに電子透かしを埋め込む技術の開発も進んでいます。今年 10 月に策定された高度な AI システムを開発する組織向けの国際指針である「広島 AI プロセス」でも、電子透かしの導入を推奨することを盛り込んでおり、実際にDeepMind は電子透かしのツールを Google Cloud の画像生成 AI モデルである Imagen に組み込んでいます。

CNN による AI 画像識別モデル

ようやくここから掲題のテーマです。

とはいえ現状の画像生成 AI により生成された画像は、どこか不自然で独特のクセみたいなものがあり、違和感があります。特に実写の人の画像はその傾向が顕著な気がします。Kindle で大量出版されている AI 美女写真集を見れば、そのクセが見えてくるはずです。

- 顔の特徴が似通っている

- 顔のパーツが整いすぎている

- 肌がマットな質感

- 細かい形状が再現できていない(特に手指)

- やたら背景をボカしたがる

- シーンが不自然

以上の特徴であれば、CNN ベースのモデルでも、リアルな人の画像と AI が生成した人の画像の判別くらい簡単にできるんじゃない? という疑問がわきましたので実験してみましょう。

今回は巷に溢れている「 画像生成 AI で生成された AI 美女 」を題材に、それが AI で生成された画像なのか、本当に実写のリアル画像なのか CNN を分類タスクとして判別してみます。

データセット

モデル開発のためには対象データの画像が必要です。今回は分類モデルで「リアル美女」と「AI 美女」を判別する CNN モデルを作成するため、「リアル美女画像データセット」と「AI 美女画像データセット」を用意しましょう。今回は実験ということで数は少ないですが、両データセットをそれぞれ 450 枚(合計 900 枚)作成し、このデータを訓練・検証・評価データセットに分割し、モデル学習・評価します。

リアルデータセット

私の好みに偏らないように 以下のサイトの日本の芸能人美人ランキングの上位 200 名を「リアル美女」として今回のデータセット収集の対象としました。このランキングの妥当性はよくわかりませんが、上位には人気のタレントがランクインしている感じです。

画像データはicrawler という Python ライブラリを活用してクローリングで取得しました。検索キーワードと出力ディレクトリ、画像数、その他検索条件を指定するだけで、簡単に画像データを収集することができます。

from icrawler.builtin import GoogleImageCrawler

# 検索キーワードリスト

keywords = ["浜辺美波", "広瀬すず", "今田美桜", "新垣結衣", ...]

# 検索条件

filter = dict(

type="photo",

color="color",

size=">4mp",

)

# クローリングでデータ取得

for idx, keyword in enumerate(keywords, start=1):

crawler = GoogleImageCrawler(

storage={"root_dir": f"../dataset/real_img/{idx:03d}_{keyword}"}

)

crawler.crawl(keyword=keyword, max_num=10, filters=filter)

取得データの中には同一画像や、複数名が撮影された画像、全く関係のない画像等が含まれているため、手作業でそれらを取り除きました。

リアルデータセットには同一人物の画像が 2〜3 枚含まれます。汎化性を評価するため、データセット分割時は同一人物の画像が訓練・評価データセットにそれぞれ分割されないように分配しています。

AI データセット

AI 美女画像はもちろん画像生成 AI で作成します。本記事ではMidjourney を使って生成しました。Stable Diffusion だと顔立ちの特徴が似たりよったりな印象があったため、より多様な特徴が生成できると期待して Midjourney を採用しました。

画像生成の際のプロンプトには、Japanese beautiful womanやJapanese cute girlなどリアルデータに近くなるように指示を与えています。また構図やシーン、年代、髪型、表情、画像アスペクト比等の画像生成条件はできる限り偏らないように生成したつもりです。またシーンはリアルデータセットで収集した画像を参考にしています。

図.生成した画像の一例

最初の 2 時間くらいは様々な高品質の AI 画像が作成されるため、楽しく作業できていましたが、それ以降は辛くなり、ただただデータセット数を稼ぐための作業となってしまいました。。。もっとプロンプトを追求できれば、更に高品質で多様な AI 美女が作成できたかもしれません。プロンプト職人への道は遠い。。

モデル学習

とりあえずシンプルな CNN モデルとして ResNet50 によるファインチューニングで、AI 美女画像の分類モデルを学習していきます。今回は Pytorch & torchvision で実装しています。モデルや学習方法に関して特段工夫はせず、どの程度の性能になるか確認してみましょう。

- モデル :

ResNet50 - 事前学習済みモデル : あり(

IMAGENET1K_V2) - バッチサイズ:64

- データ拡張:

RandomRotation、RandomHorizontalFlip、RandomAutocontrast、RandomAffine - Optimizer:SGD Momentum

- Early Stopping:あり

- レイヤー固定:最初の 5 エポックは最終層の重みのみを更新し、それ以降はすべてのレイヤーの重みを更新

やや loss は不安定な感じでしたが、収束していました。検証データで loss が最小となった 22 エポック目のモデルで評価をしていきます。

図.学習曲線

評価結果

評価データセット 200 枚(AI: 100 枚 / リアル: 100 枚)によるaccuracy は 95.5%(191/200)とそれなりの精度で分類できていました。

以下は分類モデルが AI 画像をリアルと誤分類した事例です。上手くリアルに騙せたというと AI としては成功だと思いますが、これといった共通した特徴は見られないですね。

|

|

|---|---|

|

|

|

図:AI 画像をリアル画像と誤分類した事例

一方でリアル画像を AI 画像と誤分類した事例です。誤分類した 4 枚のうち 2 枚は同一人物(事例 ② & ③)でしたので、今回生成した AI 画像と顔の特徴が似ていたのかもしれません。

判断根拠の可視化

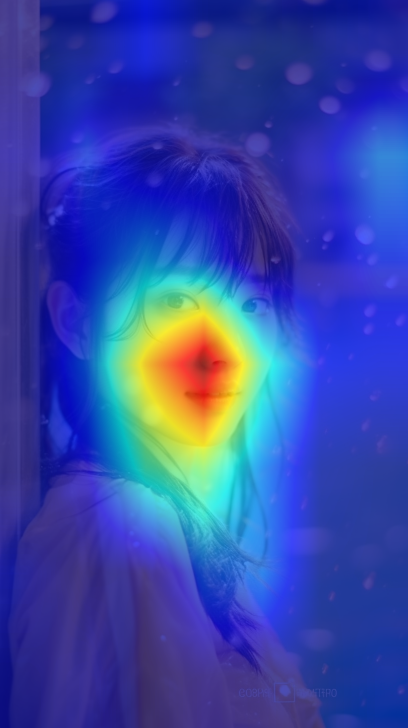

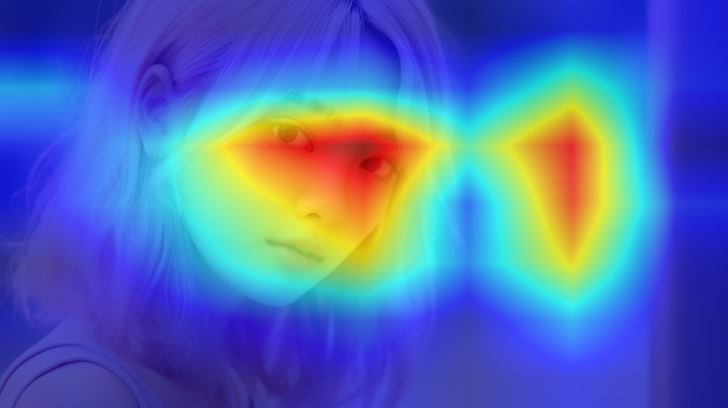

最後にモデルが画像のどこの部分に着目して予測を行ったかを可視化してみます。CNN ベースの画像認識モデルの最終層から出力された特徴量マップから、各クラスごとに画像のどこに注目しているかをヒートマップで可視化することができます。今回は代表的な手法である Grad-CAM を使って可視化してみます。

図引用:Grad-CAM: Visual Explanations from Deep Networks via Gradient-based Localization

Grad-CAM はpytorch-grad-camというフレームワークを活用しました。

以下に AI 画像に対するヒートマップの例をいくつか示します。多少ばらつきはありますが、顔付近を重要な特徴として AI 画像と判定しているようです。仮説の通り AI が生成する顔は似たような特徴があるのかもしれません。

| Original | Grad-Cam |

|---|---|

|

|

|

|

|

|

|

|

|

|

まとめ

本記事では画像生成 AI のビジネス応用事例や課題に触れ、限られた条件かつ、僅かなデータバリエーションでしたが、AI 画像とリアル画像が判別可能か実験を行いました。

今後は画像に限らず生成 AI で生成された画像・音声・文章などのデータは更に高精度化が進み、更に人が制作したコンテンツとの境界はほぼなくなってしまうかもしれません。AI を co-pilot として活用していけば、今よりさらに高度なコンテンツやサービスを生み出せることが間違いないはずです。課題をしっかり理解した上で、活用していきましょう!

明日は、@syuri_n さんの記事です。お楽しみに!