お詫びと訂正

タイトルにて「ワンセグチューナー」と表記しておりますが、正しくは「ワンセグチューナーの技術を応用したSDR受信機」となります。お詫びして訂正いたします。

本題

さて、茶番はこのあたりにして(今回は使わなかったと言うだけで、本物の「ワンセグチューナー」でもフルセグを受信できるはずなので、あながちタイトが誤っているというわけではないのですが、茶番をやりたいための茶番でした)。

今回はデジタル変調の復調を学習することを目的としているので、それ以外の部分(例えば受信機のハードウェアや、リードソロモン誤り訂正のような情報理論的分野)には触れません。また、限定受信を目的としたスクランブルの解除や映像の復号にも一切触れません。一方で、海外の人が作ったGNU Radioのソースコードをコピペして「受信したよ!」と言っても学習という意味では全く意味がありませんから、ISDB-Tの復調に関しては可能な限り自力で頑張ることにします。とはいえ、FFTライブラリのように汎用的なモジュールは積極的に利用します。今回は個人の遊びの範疇なので、このあたりの拘束条件は自分が納得できるように適当に決めています。

お断り

私は教育機関や研究機関、あるいは企業などにおいて放送・通信・情報理論等の分野と関わった経験が一切ありません。誤った解説を多々行っていると思いますがご了承ください。

これからこれらの道へ進みたい方は以降を読まないことをおすすめします。誤った知識を覚えると学習し直すのに数倍の苦労を要します。注意してください。

逆に言えば、完璧な素人でもググったりするだけでもこのくらいはできるよ、ということで、温かい目で見ていただければと思います。

情報源

ISDB-TはARIBから規格が公開されています。ただし英語へ翻訳した版のみ無料で公開されており、オリジナルの日本語版は有料での販売です。

ISDB-T自体(主に送信側の仕様)はSTD-B31で規定されています。

標準規格の入手について(STD-B31)|一般社団法人 電波産業会

受信機はSTD-B21で「望ましい仕様」が公開されています。

標準規格の入手について(STD-B21)|一般社団法人 電波産業会

基本的にはSTD-B31に従って(後ろから)処理していくことになります。

受信処理の基本的な流れはSTD-B21の図「Outline of a receiving block diagram」にブロックダイアグラムが記載されていますが、必ずしもこの通りに処理する必要はなく、SDRで受信する場合は処理方法を変えたほうが楽な部分もあるので、あくまでも参考程度です。

ISDB-Tの受信に使用している個別の技術は他の通信仕様と共通している箇所も多いので、ググれば色々と情報が出てくると思います。

復調するISDB-Tのパラメータ

ISDB-Tは受信のしやすさや誤り訂正の強度に応じて様々な放送モードが規定されています。それらすべてのモードに対応するのは面倒ですし、テスト環境(信号発生器等)もなしに実装するのも困難です。実装したところで使い道もないですし。というわけで、現在放送されているパラメータだけ実装することとします。

具体的には6MHz、モード3、ガードインターバル比1/8、Layer A[ 部分受信、QPSK、2/3、4 ]、Layer B[ 12セグ、64QAM、3/4、2 ]というようなパラメータになります。

開発環境

Windows11のパソコンを使用し、C# 12にて開発を行いました。最初に簡単な動作確認を目的としてBitmapを使用していますが、ISDB-Tの復調に関してはOSに依存した処理は無いはずなので、最近の.NETが走る環境であれば大抵の環境で動くはずです。

C#のusingディレクティブは省略しているので、プログラムを試す場合は必要に応じて追加してください。たいていはVisual Studioがよしなにやってくれるはずです。

今回は実装の簡単さを優先し、パフォーマンス(処理速度)に関してはほとんど考慮していません。そのため、最終的にIQファイルからTSファイルへ変換する速度は実速度の15倍以上(@ Core i7-12700、シングルコア、デバッグビルド)遅いです。

NuGet

NuGetのライブラリをいくつか使用します。

- 最初に動作確認のためにSystem.Drawing.Commonを使用します(必須ではない)。Windows以外の環境では使えないらしいです。

- 複素数およびFFTの取り扱いのためにMathNet.Numericsを使用します。

- 受信したパケットの誤り訂正のためにZXing.Netのリードソロモンデコーダを使用します。

Q. なぜGNU Radioを使わないの?

A. GNU Radioを使ったことがないから

電波の受信

放送の受信には例に漏れずワンセグチューナー系のSDRドングルを使用します。具体的にはRTL-SDR blogのVer.3ドングルを使用しました。この系統のドングルは帯域幅の上限が2.5MHz程度であり、フルセグ放送の5.7MHzを受信するには性能が足りません。一方で現在放送されているISDB-Tは大量のパイロット信号を含むOFDMで構成されており、フレーム構造も相まって、複数の受信機でパラレルに受信するのが容易な仕組みとなっています。そのため、SDRドングルを3本並べることで必要な帯域幅を確保しています。理想的には4本欲しいところですが、3本でも十分実用的に動作します。

ドングルの接続にはRTL-SDR blog版のlibrtlsdrを使用しました。

受信にはバイナリを使用しますが、コマンドの確認のためにソースコードも一緒にダウンロードしておくと便利です。

librtlsdrはいくつかのソフトウェア等が付属しており、その中のrtl_sdr.exeを使用すれば受信データを直接IQファイルのバイナリとして書き出す事ができます。しかしこのソフトウェアは起動に若干の時間がかかり、複数のドングルで並列に受信しようとすると十分な同時性を確保できないため、他の方法を使用する必要があります。

今回はrtl_tcp.exeを使用する方法を採用しました。すなわち時間のかかる起動処理は予め行っておき、複数のドングル(複数のrtl_tcp.exe)へ同時に接続することで、十分な同時性を確保するという手法です。

また、TCP経由で接続することで、受信機と計算処理を行うPCを情報の劣化無しに離れた位置へ設置できるという利点もあります。

サーバー側

rtl_tcpはrtl_tcp.exe -a 192.168.1.201 -p 1234 -d 0のようなコマンドで起動します。-aと-pでIPアドレス/ポートを指定し、-dでデバイス番号を指定します。複数のドングルを使用する場合はそれぞれに異なるデバイス番号とポート番号を指定する必要があります。

アドレスの指定にはIPアドレスの他にコンピューター名も指定できます。アドレスのパースにはgetaddrinfoを使用しているようです。どのような優先度になっているのかよくわかりませんが、自分の環境ではリンクローカルIPv6が使用されました。今回はLAN経由で受信機と解析PCを別の場所に置いていますが、同一のPCで処理する場合は-aを指定しなければ127.0.0.1が使用されます。

-dで指定するデバイス名は、数字を与えればデバイスに割り振られる番号として認識し、文字列を与えるとデバイスに設定された文字列として認識するようです(デバイスの名前はrtl_eeprom.exeで書き換え可能ですが、デバイスを破壊する危険性があるので使う際は注意してください)。今回はすべてのドングルを分配器経由で同じアンテナに接続していますが、デバイス名を使用すれば指向性や帯域の違うアンテナに接続されたドングルを選択して起動することができます。

サーバー側はrtl_tcpが起動していればそれだけでいいのですが、注意点として、ネットワークの帯域幅はドングル1本あたり32Mibps(2.048Mspsの場合)必要なので、今回のように3本並列で使用する場合は100Mbpsでは心もとなく、安心して使うには1GbEが必要です。

ドングル1本ずつポートやデバイス番号を替えて起動するのは面倒なので、バッチファイルを作っておきます。

start "-d 0" "%USERPROFILE%\Downloads\rtl-sdr-blog-1.3.4 Release\x64\rtl_tcp.exe" -a %COMPUTERNAME% -p 1234 -d 0

timeout /t 1 > nul

start "-d 1" "%USERPROFILE%\Downloads\rtl-sdr-blog-1.3.4 Release\x64\rtl_tcp.exe" -a %COMPUTERNAME% -p 1235 -d 1

timeout /t 1 > nul

start "-d 2" "%USERPROFILE%\Downloads\rtl-sdr-blog-1.3.4 Release\x64\rtl_tcp.exe" -a %COMPUTERNAME% -p 1236 -d 2

パスは適当に書き換えてください。

-aにコンピュータ名を挿入しているので、アドレスはいい感じのアドレスが割り振られると思います。固定アドレスで運用したい場合はそのアドレスを指定してください。

途中でtimeoutを挟んでいますが、これは複数のウインドウが連番で起動するようにするためなので、見た目に拘ったりする必要がないなら連続して起動できます。

ドングル等の構成は以下のようになります。

NUCフォームファクタ(モバイルCeleron 2.0GHz)にドングル3本を接続し、テレビ用の分配器を経由してアンテナへ接続します。操作(rtl_tcp.exeの起動やシャットダウン操作等)はリモートデスクトップで行うと割り切れば画面や操作デバイスは不要で、かなりコンパクトな受信機構成となります。サーバー側は信号処理は一切行わず、USBからLANへデータを横流しするだけなので、CPUは1.0GHz程度でアイドルレベルでした(リモートデスクトップのほうが高負荷)。

クライアント側

TCPで接続し、いくつかのコマンドを投げた上で、送られてきたデータをファイルに記録します。

いきなり地デジ放送を受信しても、うまく復調できなかったときに原因の切り分けが困難なので、まずは見た目でわかりやすい電波(FMラジオ)を受信して動作確認を行います。

rtl_tcp.exeのクライアント(複数を並列して記録)

internal class Program

{

static readonly DateTime _startDate = DateTime.Now;

static readonly TimeSpan _rxLength = TimeSpan.Zero;

static readonly string _serverName = "server-name";

static readonly int _portStart = 1234;

const int _syncBufferSize = 4096;

static Program()

{

// 直ちに開始させると少しずれるので、少し遅延させる(環境に応じて調整)

_startDate = DateTime.Now.AddSeconds(1.5);

_startDate -= new TimeSpan(_startDate.TimeOfDay.Ticks % TimeSpan.TicksPerSecond);

(_gain, _sps, _freqs) = (22, (uint)2048e3, [(uint)84.15e6, (uint)84.25e6, (uint)84.35e6]);

}

static readonly uint _gain;

static readonly uint _sps;

static readonly uint[] _freqs;

static int _inhibit;

static void Main()

{

using var tcpClients =

Connect(

_serverName, _portStart, _freqs.Length,

TimeSpan.FromSeconds(0.2))

.Result;

Console.WriteLine($"servers");

foreach (var v in tcpClients)

{

Console.WriteLine($" {v.Client.RemoteEndPoint as IPEndPoint}");

}

Console.WriteLine();

if (tcpClients.Length < _freqs.Length)

{

Console.WriteLine(string.Format(

"{0} 個のサーバーに接続できませんでした",

_freqs.Length - tcpClients.Length));

return;

}

foreach (var a in tcpClients.SkipLast(_freqs.Length))

{ // 必要以上に確保した分は破棄

a.Dispose();

}

_inhibit = _freqs.Length + 1; // 1個多く止めておき、タイマで解除

using CancellationTokenSource cts = new();

Task[] tasks = [

..

tcpClients.Zip(_freqs)

.Select(a =>

{

var filename = $"{_startDate:yyyyMMddTHHmmss}_{a.Second}Hz.wav";

Console.WriteLine($"@\"{Path.GetFullPath(filename)}\",");

return RxIqData(a.First, filename, a.Second, cts.Token);

}),

SamplingTimer(cts.Token),

ShowRxTime(cts.Token),

];

Console.CancelKeyPress += (object? _, ConsoleCancelEventArgs e) =>

{

if (!cts.IsCancellationRequested)

{

cts.Cancel();

e.Cancel = true;

}

};

// Anyで待ってタスクがどれか一つでも落ちたら(e.g. タイマー、通信エラー)CTSで他のタスクも終了させる

Task.WaitAny(tasks);

cts.Cancel();

Task.WaitAll(tasks, 1000);

}

static async Task RxIqData(

TcpClient tcpClient,

string filename,

uint freq,

CancellationToken cancellationToken)

{

using FileStream fs = new(filename, FileMode.Create, FileAccess.Write);

WavHeader.Create(1, 2, _sps, 8).Write(fs);

try

{

using var ns = tcpClient.GetStream();

ns.WriteTimeout = ns.ReadTimeout = 1000;

; void SendCommand(byte cmd, uint arg)

{

var tmp = IPAddress.HostToNetworkOrder((int)arg);

ns.Write([cmd, .. MemoryMarshal.Cast<int, byte>(new(ref tmp))]);

}

SendCommand(0x1, freq);

SendCommand(0x2, _sps);

SendCommand(0x8, 0); // AGC off

SendCommand(0xD, _gain);

Interlocked.Decrement(ref _inhibit);

{

var buff = new byte[_syncBufferSize];

while (0 < _inhibit)

{

for (int n = 0, m; n < buff.Length; n += m)

{

m = await ns.ReadAsync(buff, cancellationToken);

if (m == 0) { throw new IOException(); }

}

}

}

await ns.CopyToAsync(fs, cancellationToken);

}

catch (OperationCanceledException) { }

finally

{

WavHeader.UpdateSubchunk2Size(fs);

}

}

static async Task SamplingTimer(CancellationToken cancellationToken)

{

try

{

var wait = _startDate - DateTime.Now;

if (TimeSpan.Zero < wait)

{

await Task.Delay(wait, cancellationToken);

}

Interlocked.Decrement(ref _inhibit);

await Task.Delay(

TimeSpan.Zero < _rxLength

? _rxLength

: TimeSpan.FromDays(49),

cancellationToken);

}

catch (OperationCanceledException) { }

}

static async Task ShowRxTime(CancellationToken cancellationToken)

{

var start = _startDate;

var len = _rxLength.Ticks;

Console.CursorVisible = false;

while (true)

{

string state;

long ticks;

var now = DateTime.Now;

if (now < start)

{

state = "wait";

ticks = (start - now).Ticks;

}

else

{

state = "rec";

ticks =

0 == len

? (now - start).Ticks

: (start - now).Ticks + len;

}

ticks -= ticks % TimeSpan.TicksPerSecond;

Console.Write($"\r{state,4} {new TimeSpan(ticks)}...\x1B[K");

try

{

await Task.Delay(100, cancellationToken);

}

catch (OperationCanceledException) { break; }

}

Console.WriteLine();

Console.CursorVisible = true;

}

static async Task<IDisposableArray<TcpClient>> Connect(

string serverName,

int portStart,

int portN,

TimeSpan timeout)

{

var addresses = await Dns.GetHostAddressesAsync(serverName);

using CancellationTokenSource cts = new(timeout);

ConcurrentBag<TcpClient> bag = [];

try

{

Parallel.ForEach(

addresses

.SelectMany(address =>

Enumerable.Range(portStart, portN)

.Select(port => (address, port))),

new ParallelOptions { CancellationToken = cts.Token },

async a =>

{

TcpClient client = new();

try

{

await client.ConnectAsync(a.address, a.port, cts.Token);

bag.Add(client);

if (portN <= bag.Count)

{

cts.Cancel();

}

}

catch

{

client.Dispose();

return;

}

});

}

catch (OperationCanceledException) { }

return new([..

bag.OrderBy(a => (a.Client.RemoteEndPoint as IPEndPoint)?.Port ?? 0)]);

}

}

class IDisposableArray<T>(T[] objects) : IDisposable, IEnumerable<T>

where T : IDisposable

{

public int Length => objects.Length;

public void Dispose()

{

foreach (var obj in objects)

{

obj.Dispose();

}

}

public IEnumerator<T> GetEnumerator()

=> ((IEnumerable<T>)objects).GetEnumerator();

IEnumerator IEnumerable.GetEnumerator()

=> objects.GetEnumerator();

}

[StructLayout(LayoutKind.Sequential, Pack = 1)]

record struct WavHeader(

uint ChunkID,

uint ChunkSize,

uint Format,

uint Subchunk1ID,

uint Subchunk1Size,

ushort AudioFormat,

ushort NumChannels,

uint SampleRate,

uint ByteRate,

ushort BlockAlign,

ushort BitsPerSample,

uint Subchunk2ID,

uint Subchunk2Size)

{

public override readonly string ToString()

=> string.Format("{0} {{ {1} }}",

nameof(WavHeader),

string.Join(", ",

$"{nameof(ChunkID)} = \"{Uint2Str(ChunkID)}\"",

$"{nameof(ChunkSize)} = {ChunkSize}",

$"{nameof(Format)} = \"{Uint2Str(Format)}",

$"{nameof(Subchunk1ID)} = \"{Uint2Str(Subchunk1ID)}\"",

$"{nameof(Subchunk1Size)} = {Subchunk1Size}",

$"{nameof(AudioFormat)} = {AudioFormat}",

$"{nameof(NumChannels)} = {NumChannels}",

$"{nameof(SampleRate)} = {SampleRate}",

$"{nameof(ByteRate)} = {ByteRate}",

$"{nameof(BlockAlign)} = {BlockAlign}",

$"{nameof(BitsPerSample)} = {BitsPerSample}",

$"{nameof(Subchunk2ID)} = \"{Uint2Str(Subchunk2ID)}\"",

$"{nameof(Subchunk2Size)} = {Subchunk2Size}"));

public static WavHeader Create(

ushort format,

ushort channels,

uint samplerate,

ushort bitspersample,

ushort? blockalign = null)

=> new(Str2Uint("RIFF"), 0,

Str2Uint("WAVE"),

Str2Uint("fmt "), 16,

format, channels, samplerate,

(blockalign ??= (ushort)((bitspersample + 7) / 8 * channels)) * samplerate,

blockalign.Value, bitspersample,

Str2Uint("data"), uint.MaxValue);

private static uint Str2Uint(string a)

{

Span<byte> tmp = stackalloc byte[4];

if (!Encoding.UTF8.TryGetBytes(a, tmp, out var bytesWritten) ||

bytesWritten != 4)

{

throw new InvalidOperationException();

}

return BitConverter.ToUInt32(tmp);

}

private static string Uint2Str(uint a)

=> Encoding.UTF8.GetString(MemoryMarshal.Cast<uint, byte>(new(ref a)));

public void Write(Stream stream)

=> stream.Write(MemoryMarshal.Cast<WavHeader, byte>(new Span<WavHeader>(ref this)));

public static void UpdateSubchunk2Size(Stream stream)

{

var pos = stream.Position;

var len = pos - 44;

if (len <= uint.MaxValue)

{

stream.Position = 40;

var tmp = (uint)len;

stream.Write(MemoryMarshal.Cast<uint, byte>(new(ref tmp)));

stream.Position = pos;

}

}

public static bool TryLoad(Stream stream, [MaybeNullWhen(false)] out WavHeader header, out bool dataChunk)

{

var pos = stream.Position;

header = new();

dataChunk = false;

var tmp = MemoryMarshal.Cast<WavHeader, byte>(new(ref header));

if (tmp.Length == stream.Read(tmp) &&

Str2Uint("RIFF") == header.ChunkID &&

Str2Uint("WAVE") == header.Format &&

Str2Uint("fmt ") == header.Subchunk1ID &&

header.Subchunk1Size == 16)

{

dataChunk = Str2Uint("data") == header.Subchunk2ID;

return true;

}

stream.Position = pos;

return false;

}

}

このプログラムではヘッダとしてWAVファイルのヘッダを付与し、FMラジオを記録します(適当なところでctrl-cで止めてください)。受信したIQファイルは例えばSDR#のような汎用のSDR復調ソフトウェアで読み込むことができます。

server-nameにはサーバ側のIPアドレスを設定しておきます。コンピュータ名を指定すれば名前解決によってIPアドレスを探しますが、名前解決を行う場合は一旦インターネット上のDNSサーバーに問い合わせを行うらしく、起動時に数秒の待ちが発生します(Google Public DNSであれば1秒弱、ルータ経由のデフォルト設定だと4秒程度、環境依存)。

_startDateに日時を設定しておけば、その時間になってからサンプリングを開始します。_rxLengthと合わせて使えば予約録画的な使い方もできます。ただし待機中もTCP接続を維持しています。

_rxLengthに時間を設定すれば指定時間が経過した時点でサンプリングを終了します。デフォルトでは_rxLengthが未指定で、カウントアップを表示しながら無制限に(ctrl-cが押されるまで)サンプリングを行います。

今回は簡易的な実装なため、起動時から_startDateまでの時間、また_rxLengthの長さは最大で2ヶ月弱程度しか設定できません。普通は問題にならないはずなので、このような実装で妥協しています。

_freqsには受信地点で受信可能なFMラジオの周波数を指定してください。後で確認する際にわかりやすいように、ドングルごとに100kHz差を与え、また50kHzのオフセットを与えることでIQファイルのDCに乗らないようにしています。

WAVファイルはヘッダが32bitのため最大でも4GBがリミットで、そのために64bitへ拡張されたWAV規格もありますが、一部のソフトウェアは通常のWAVで4GBを超えるファイルも取り扱うことが可能であり(SDR#等は非対応)、このプログラムでもそれに則った実装になっています(単にヘッダの32bitデータサイズを無視するだけですが)。例えば2.048Mspsで1時間記録すると15GB程度になり、それが3本ありますから、45GB/h程度のデータレートになります。2層のBlu-rayの容量が50GBですから、Blu-ray1枚で1時間のフルセグ放送の生データを記録できます。通常、2層のBlu-rayには地上デジタル放送を6時間記録できますから、このIQファイルは映像データに比べておよそ6倍程度冗長なデータだと言えます。

FMラジオ(80MHz前後)に対応したアンテナを使用して記録し、汎用のSDRソフトウェアで復調を行うことで正しく受信できているか確認します。古い住宅の場合はアナログ放送を受信するためにVHFアンテナがついていることがあり、TVの送信所とFMラジオの送信所が同じ場所にある場合は、これを使ってFMラジオも受信できます。VHFアンテナを撤去していたり、アナログ放送終了後にアンテナを設置した場合はUHFアンテナしか設置されておらず、FMラジオを受信するには別のアンテナを使用する必要があります。FMラジオを受信するのは受信機の動作確認を行うためなので、あまり強く受信する必要はありません。送信所からそう離れていない場合は窓際にダイポールアンテナを1本立てるだけでも十分受信できると思います。

さて、ネットワーク経由で取得したIQファイルですが、狙い通りに受信できているか(特に時間方向のズレが十分小さいか)、簡単なプログラムでスペクトルを画像化してみたいと思います。

3個のIQファイルからスペクトルを画像化

var FFTpoints = 2048;

var averages = 10;

var N = 2000;

var grid = 100;

var pos = (long)(44 + 4096000 * 1);

var (file1, file2, file3) = (

@"file1.wav",

@"file2.wav",

@"file3.wav");

using var fs1 = OpenFileAndDumpInfo(file1);

using var fs2 = OpenFileAndDumpInfo(file2);

using var fs3 = OpenFileAndDumpInfo(file3);

float[][] magns1 = [], magns2 = [], magns3 = [];

Task.WaitAll([

Task.Run(() => magns1 = PowerSpectrumFromFile(fs1)),

Task.Run(() => magns2 = PowerSpectrumFromFile(fs2)),

Task.Run(() => magns3 = PowerSpectrumFromFile(fs3)),

]);

using Bitmap bmp = Rendering();

bmp.Save("log.png");

; Stream OpenFileAndDumpInfo(string filename)

{

Console.WriteLine(filename);

FileStream fs = new(filename, FileMode.Open, FileAccess.Read);

if (WavHeader.TryLoad(fs, out var header, out var dataChunk))

{

double sps = header.SampleRate;

Console.WriteLine(header);

Console.WriteLine($"{sps / FFTpoints * grid / 1e3} kHz/div, {1 / sps * FFTpoints * averages * grid} sec/div @ {sps / 1e6}Msps");

}

Console.WriteLine();

fs.Position += pos;

return fs;

}

; float[][] PowerSpectrumFromFile(Stream stream)

{

List<float[]> list = new(N);

var buff1 = new byte[2 * FFTpoints];

var buff2 = new Complex32[FFTpoints];

while (list.Count < N)

{

var magSq = new float[FFTpoints];

for (int i = 0; i < averages; i++)

{

if (buff1.Length != stream.Read(buff1))

{ goto exit; }

var cast = MemoryMarshal.Cast<byte, (byte, byte)>(buff1);

for (int j = 0; j < cast.Length; j++)

{

var (a, b) = cast[j];

buff2[j] = new(a - 127.35f, b - 127.35f);

}

for (int j = 0; j < cast.Length; j += 2)

{

buff2[j] *= -Complex32.One;

}

Fourier.Forward(buff2, FourierOptions.Matlab);

for (int j = 0; j < buff2.Length; j++)

{

magSq[j] += buff2[j].MagnitudeSquared;

}

}

for (int i = 0; i < magSq.Length; i++)

{

magSq[i] = float.Pow(magSq[i], 1 / 4f);

}

list.Add(magSq);

}

exit:;

return [.. list];

}

; Bitmap Rendering()

{

var offset = -FloatMin3(

magns1.Min(a => a.Min()),

magns2.Min(a => a.Min()),

magns3.Min(a => a.Min()));

var gain = 255 / (offset + FloatMax3(

magns1.Max(a => a.Max()),

magns2.Max(a => a.Max()),

magns3.Max(a => a.Max())));

Bitmap bmp = new(magns1[0].Length, IntMin3(magns1.Length, magns2.Length, magns3.Length));

var bmpdata = bmp.LockBits(new() { Size = bmp.Size }, ImageLockMode.WriteOnly, PixelFormat.Format32bppArgb);

var line = new int[bmpdata.Width];

for (int y = 0; y < bmpdata.Height; y++)

{

var magn1 = magns1[y];

var magn2 = magns2[y];

var magn3 = magns3[y];

for (int x = 0; x < bmpdata.Width; x++)

{

var a = (byte)((magn1[x] + offset) * gain);

var b = (byte)((magn2[x] + offset) * gain);

var c = (byte)((magn3[x] + offset) * gain);

line[x] = unchecked((int)0xFF000000) | c << 16 | b << 8 | a;

}

Marshal.Copy(line, 0, bmpdata.Scan0 + bmpdata.Stride * y, line.Length);

}

bmp.UnlockBits(bmpdata);

using var g = Graphics.FromImage(bmp);

using Pen pen = new(Color.FromArgb(64, Color.White));

for (int i = 0; i < bmp.Height; i += grid)

{

g.DrawLine(pen, 0, i, bmp.Width, i);

}

g.TranslateTransform(bmp.Width / 2, 0);

g.DrawLine(pen, 0, 0, 0, bmp.Height);

for (int i = grid; i < bmp.Width / 2; i += grid)

{

g.DrawLine(pen, i, 0, i, bmp.Height);

g.DrawLine(pen, -i, 0, -i, bmp.Height);

}

return bmp;

; static float FloatMin3(float a, float b, float c)

=> float.Min(float.Min(a, b), c);

; static float FloatMax3(float a, float b, float c)

=> float.Max(float.Max(a, b), c);

; static int IntMin3(int a, int b, int c)

=> int.Min(int.Min(a, b), c);

}

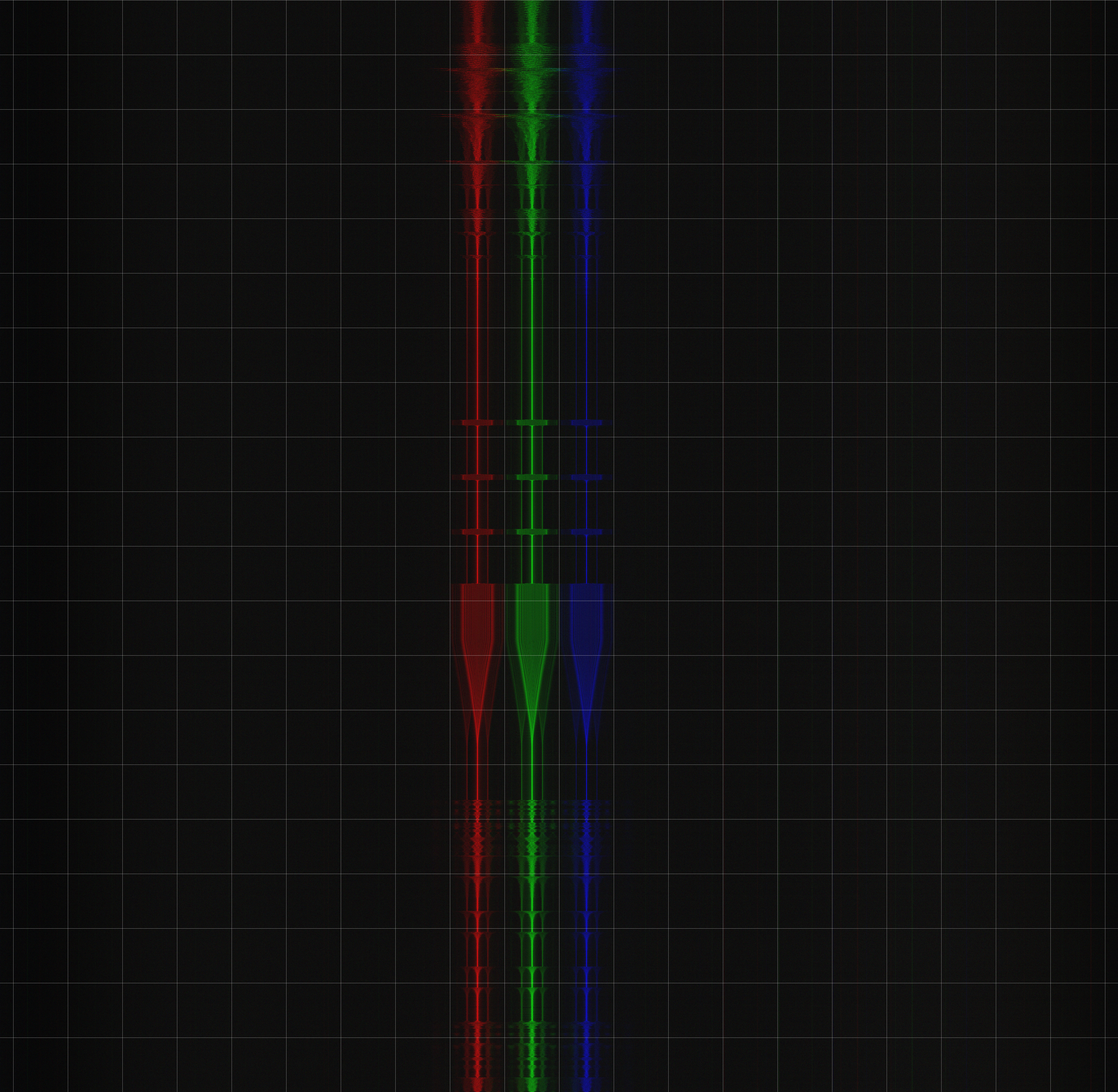

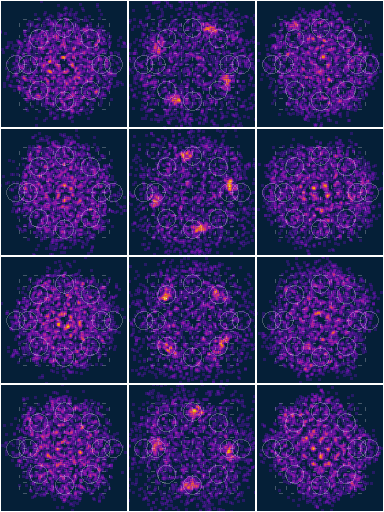

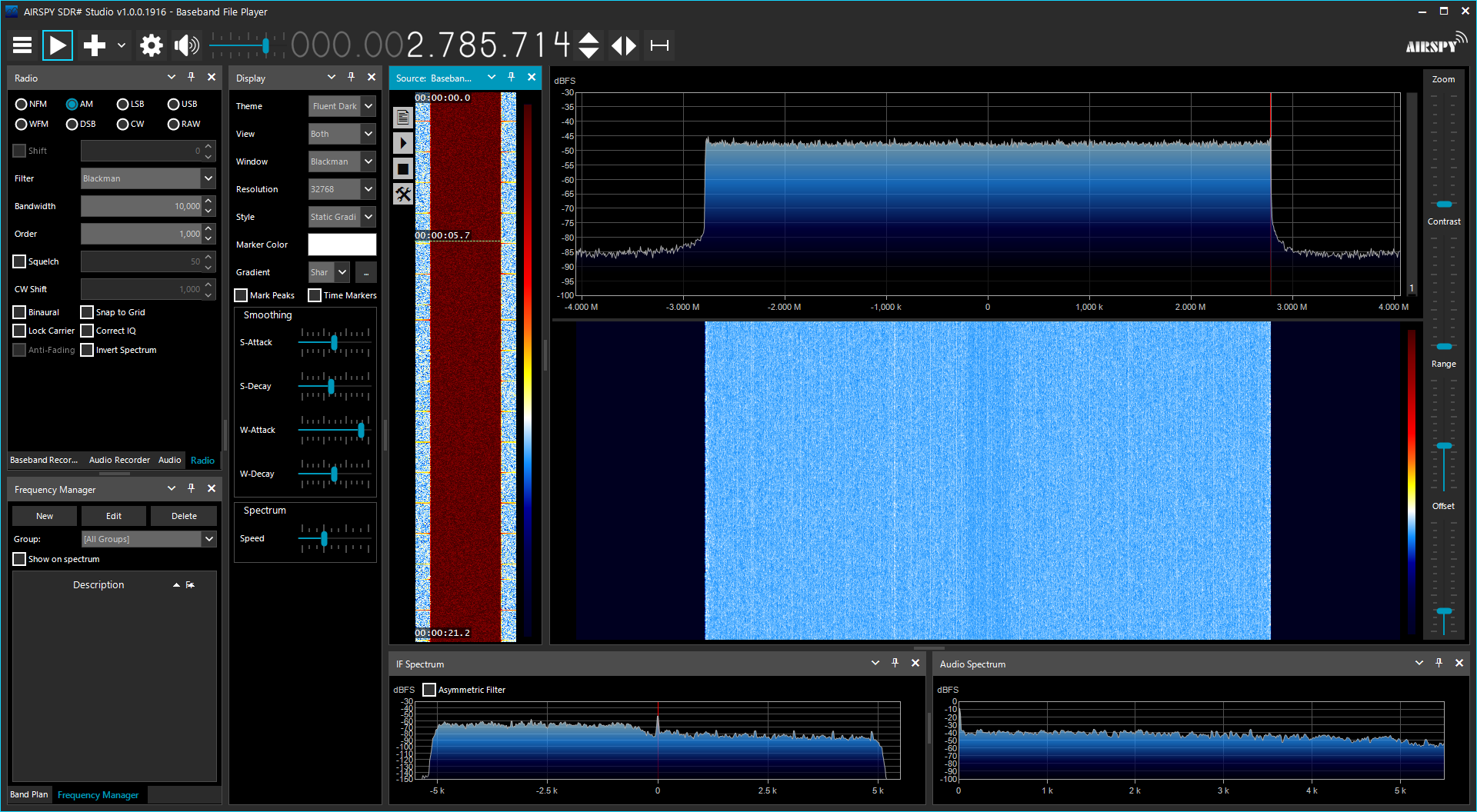

試しに2.048Mspsで取得したFMラジオの電波を画像化してみます。FFTポイント数が2048なので周波数分解能は1kHz、それを10回平均化しているので時間分解能は10ms、高さ2000pxで描画範囲は20秒、という画像になります。3個のIQファイルはそれぞれRGBの輝度で表示されます。

画像はNHK FMを正時に受信したもので、時報の信号が見えています。グリッドは100px間隔です(この画像の場合は100kHz/div, 1sec/div)。前述の記録プログラムでは3本のドングルに100kHz差で周波数を指定していますが、画像でも100px(つまり100kHz)離れて描画されています。

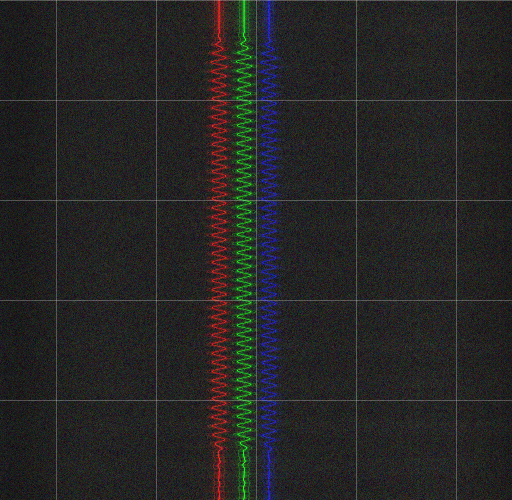

分解能を400kHz/div, 25ms/divへ変更し、時報の440Hz(0.1秒)の部分を画像化したのが以下の画像です。

3chともほぼ同じ位相で受信できており、少なくとも半周期(0.5/440≒1ms)程度の精度でドングル間の同期が取れていることがわかります。毎回ここまで綺麗にそろうことは稀ですが、それでもせいぜい数十ミリ秒前半くらいの程度の差に収まるはずです。ISDB-Tの受信において同時性は1フレーム(日本の場合約230ms)より十分短ければ良いはずなので、おそらく問題ない程度だと思います。

テレビの受信

FMラジオで受信機の動作確認ができたので、いよいよ地デジ放送の受信を行います。

地デジ放送はUHF帯を利用しており、周波数は物理チャンネルという数値で管理されています。放送局と物理チャンネルの組み合わせは地域によって異なりますが、オンラインの一覧表で確認できます。

まず、A-PABのTV放送エリアの地図を使用して、受信可能な放送局・中継局を探します。

A-PAB 放送エリアのめやす

続いて、その放送局・中継局の名前から物理チャンネルを探します。例えばDXアンテナのサポートページにエリア別の一覧があるので、ページ内検索で放送局・中継局の名前を入れたりして探します。

https://qa.dxantenna.co.jp/faq_detail.html?id=2130

現在のところ、物理chは13から52が使用されていて、6MHz間隔(日本の場合)で設置されています。仮に物理ch0番目を想定すると中心周波数は395MHzであり、特定の物理chの中心周波数は395+6*物理ch番号で計算できます。例えば28chであれば395+6*28=563となり、物理28chの中心周波数は563MHzとなります。

ただし、地デジ放送は+1/7MHzのオフセットが加算されるため、実際には395+1/7+6*28≒563.1428MHzのような値になります(このオフセットはアナログ放送(下側chの音声搬送波が近い)との互換性のために付与されたものだそうです)。

地デジ放送は6MHzのチャンネルを14セグメントに分割し、その内の13セグメントを放送に使用し、残りを0.5セグメントずつガードバンドに使用しています。そのため、放送を受信するには6/14*13≒5.571MHzの帯域を受信する必要があり、これを3本のドングルでパラレルに受信するには約1.857MHz間隔で受信を行います。最終的に、例えば物理28chを3本のドングルで受信するには、それぞれ561.29MHz、563.14MHz、565.00MHzを受信することになります。許容できる周波数の誤差はプログラムの実装次第ですが、今回の場合は10kHz程度で丸めてしまって問題ありません。

また、地デジ放送では受信側のサンプリングレートも指定されており、フルセグで放送は512/63MHz≒8.127MHzを使用することが求められています。ただし安価なドングルではこのサンプリングレートは不可能ですから、もっと低いサンプリングレートを選択します。ワンセグ放送を受信する場合は64/63MHz≒1.016MHzを使用できますが、3本のドングルでフルセグ放送を受信する場合はもう一つ上の128/63MHz≒2.032MHzを使用します。サンプリングレートがズレていると後で面倒なので、できるだけ正確に指定します。rtl_tcpでは1Hz分解能で指定できるので、2031746Hzを指定します。

フルセグ放送の受信には帯域幅が広く、指向性があり、利得の高いアンテナが必要です。ダイポールでは利得や指向性が不足し、ログペリでは利得や周波数特性が不足するはずです。アマチュア無線用の430MHz用の八木で地デジ放送を受信しようとするとテレビ放送の帯域では周波数特性がガタガタでデコードが難しくなります。結論として、安物でもいいからテレビ用のアンテナを使用することが唯一の選択肢だと思います(もちろん既設のテレビ視聴用アンテナがあればそれを使うのが一番簡単です)。

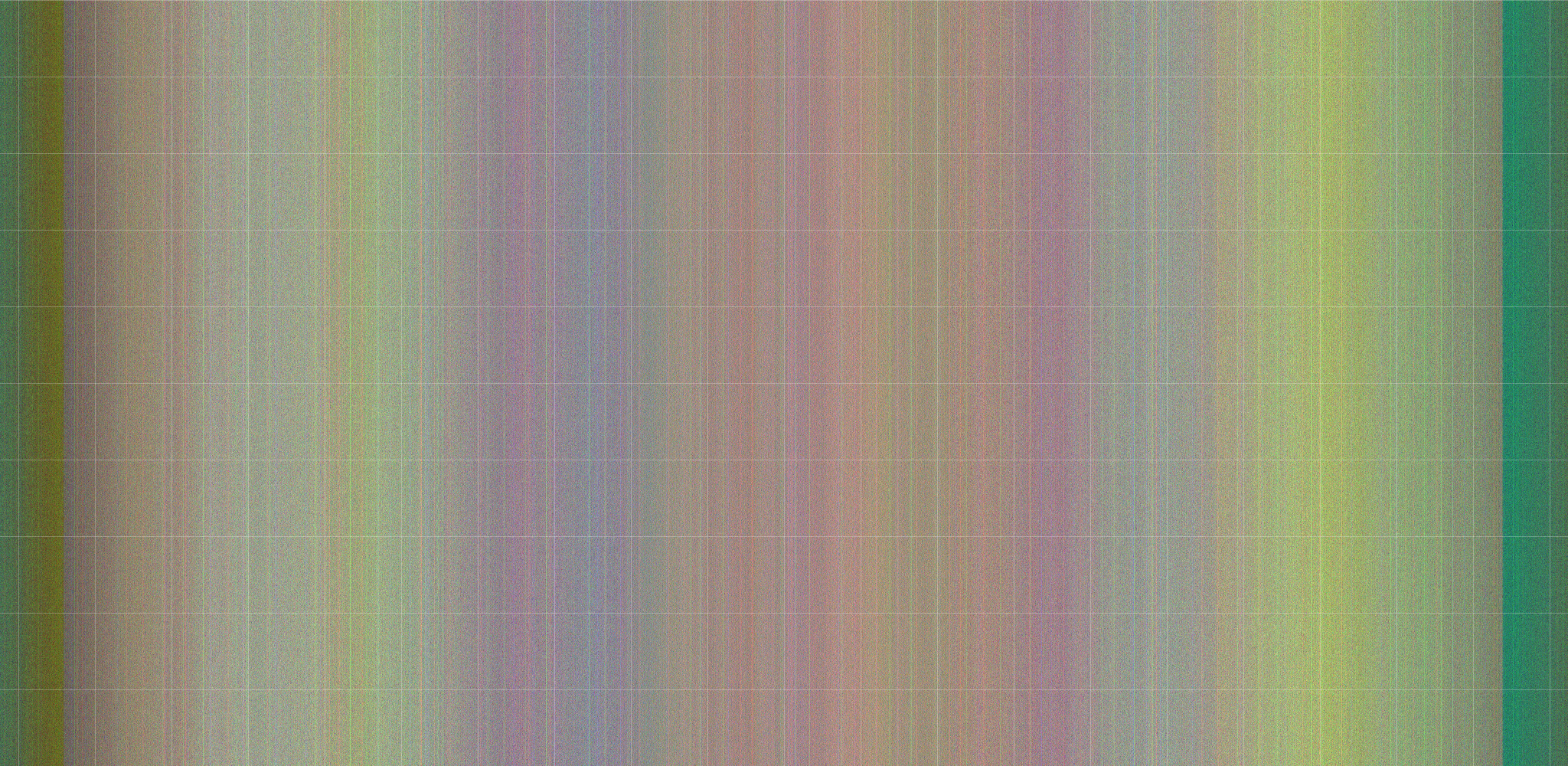

3本のドングルでフルセグ放送を受信した際のスペクトラムは以下のようになります。

時間方向にはほとんど変化がなく、周波数方向では色の変化(伝搬特性や受信機ごとの特性の違い)が見えています。受信機の特性によって見え方が異なりますが、ガードバンドも見えています(右側が顕著)。

ISDB-Tのスペクトラムはあまり面白いものではありません。デコードしていくとだんだん面白くなっていきます(たぶん)。

ISDB-Tのサンプリングレートについて

ISDB-Tのモード3では有効シンボル長が1008マイクロ秒と定められています。この逆数(約0.992kHz)がOFDMのキャリア間隔であり、その整数倍、特にFFTと相性がいいように2^n倍をサンプリングレートとして使用します。例えばフルスペックのフルセグ受信機は8192ポイントのFFTを使用しており、8.127Mspsとなります。今回の場合は2048ポイントのFFTを使用しますから、1/1008u*2048≒2.032Mspsとなります。

他の計算方法として、帯域幅から求めることもできます。例えば6MHz / (14 * 432) ≒ 0.992kHzと計算できます。異なる帯域幅を受信する場合は帯域幅から計算するのが簡単だと思います(例えば 8MHz / (14 * 432) * 1024 ≒ 1.3545Mspsなど)。

ISDB-Tの復調

さて、サンプルデータ(ISDB-Tを記録したIQファイル)を入手したところで、いよいよISDB-Tの復調が始まります。

信号レベルの確認

受信したIQファイルですが、まず初めに信号レベルの確認を行います。

今回はあちこち手抜きなので、SNRが低いデータは正しく復調できません(どんなシステムでもSNRが悪くなれば復調性能は落ちますが、今回のコードはより早く復調性能が落ちます)。ということで、まずは正しい信号レベルであることを確認する必要があります。

信号レベルのヒストグラム化

using StreamWriter sw = new("log.txt");

var (file1, file2, file3) = (

@"file1.wav",

@"file2.wav",

@"file3.wav");

using FileStream fs1 = new(file1, FileMode.Open, FileAccess.Read);

using FileStream fs2 = new(file2, FileMode.Open, FileAccess.Read);

using FileStream fs3 = new(file3, FileMode.Open, FileAccess.Read);

fs1.Position = fs1.Length / 4 * 2;

fs2.Position = fs2.Length / 4 * 2;

fs3.Position = fs3.Length / 4 * 2;

ToHistogram(fs1, out var counter1);

ToHistogram(fs2, out var counter2);

ToHistogram(fs3, out var counter3);

foreach (var (i, (a, b, c)) in counter1.Zip(counter2, counter3).Select((a, i) => (i, a)))

{

sw.WriteLine($"{i}\t{a:0.00E0}\t{b:0.00E0}\t{c:0.00E0}");

}

static void ToHistogram(Stream stream, out float[] dst)

{

var buff = new byte[8192];

var tmp = new int[256];

var N = 0;

for (int i = 0; i < 512; i++, N += buff.Length)

{

if (stream.Read(buff) != buff.Length)

{

break;

}

foreach (var a in buff)

{

tmp[a]++;

}

}

dst = tmp.Select(a => a / (float)N).ToArray();

}

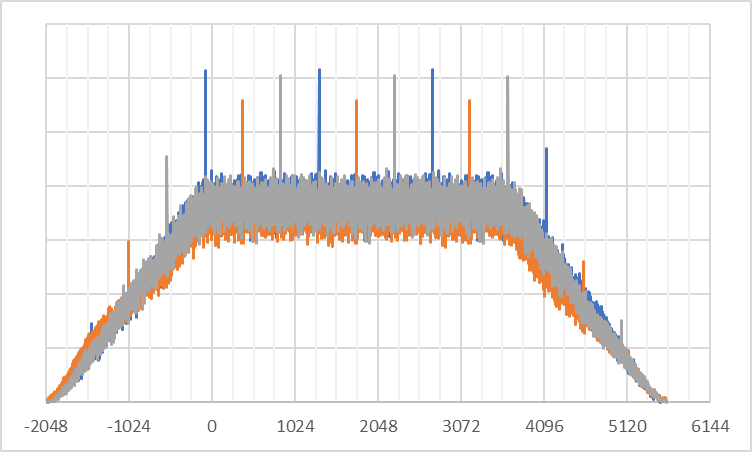

単純にIQファイルをbyte配列として読み出して値の出現回数を数えるだけです。

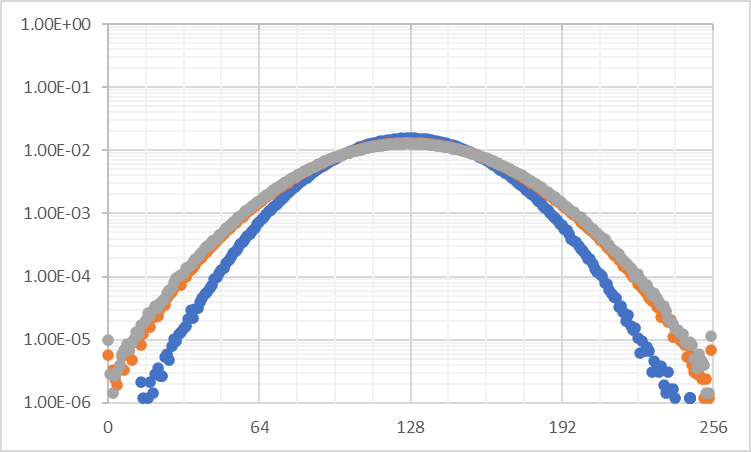

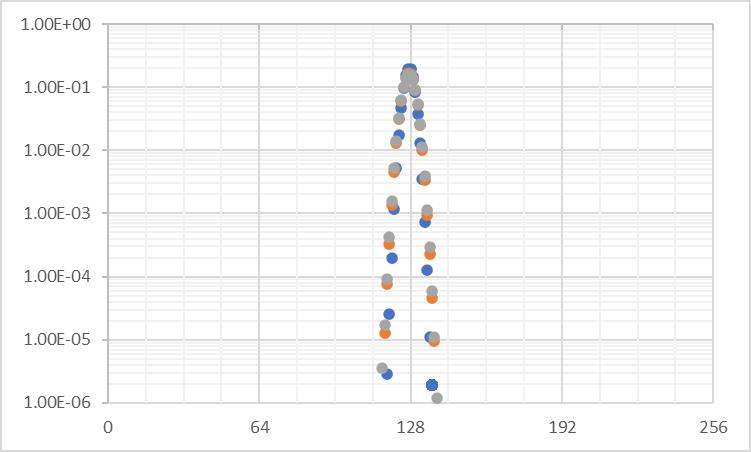

適正な受信レベルの場合、このように山なりというか、正規分布というか、Sinc型というか、とにかくそんな感じの形になります。

山の裾が十分に広がり、飽和したサンプル(0や255の数)が十分に少ない状態を目指します。

ドングルは3本とも同じゲインを設定していますが、青と橙・灰でゲインが異なっているようです。これは青と橙・灰の購入時期が違うため(橙と灰のドングルは同時に購入)ロット差が影響していると考えられます。今回の用途ではこの程度の個体差は問題ありません。

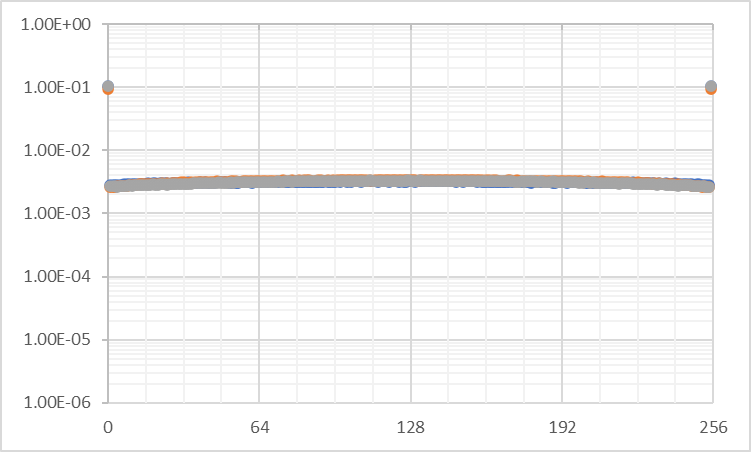

以下の2枚は極端に過小および過大なレベルのヒストグラムです。

過小な場合は中央付近に固まり、過大な場合は両端(飽和して0と255)に固まります。信号レベルが正しくない場合は復調が困難になります。サンプリングのプログラムでgainの値を変えて適正なレベルになるように調整してください。

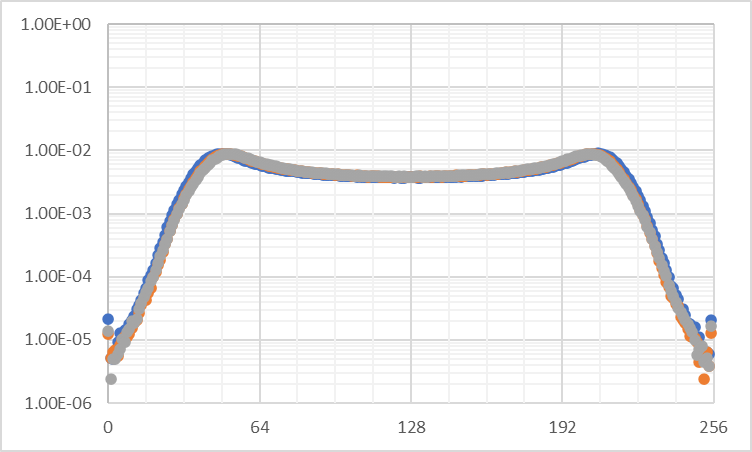

ちなみに、FMラジオを適正なレベルで受信すると以下のようなヒストグラムになります。

シングルキャリアの正弦波なので、両肩上がりの矩形に近い形になります。

シンボルの同期

まずはOFDMのシンボルの同期を行います。ISDB-Tは間欠無くシンボルが連続して送られてくるため、最初に1回同期してしまえば基本的に再同期は必要ありません(放送が中断したり、信号レベルが変化したりして同期が外れたりすると再同期が必要になりますが、今回は考慮しません)。

シンボルの同期

var effectiveSymbolLength = 2048;

var guardIntervalRatio = 8;

using StreamWriter sw = new("log.txt");

var (file1, file2, file3) = (

@"file1.wav",

@"file2.wav",

@"file3.wav");

using ContinuousOFDMSymbolLoader loader1 = new(new FileStream(file1, FileMode.Open, FileAccess.Read) { Position = 2 * 4_063_492 }, guardIntervalRatio, effectiveSymbolLength);

using ContinuousOFDMSymbolLoader loader2 = new(new FileStream(file2, FileMode.Open, FileAccess.Read) { Position = 2 * 4_063_492 }, guardIntervalRatio, effectiveSymbolLength);

using ContinuousOFDMSymbolLoader loader3 = new(new FileStream(file3, FileMode.Open, FileAccess.Read) { Position = 2 * 4_063_492 }, guardIntervalRatio, effectiveSymbolLength);

loader1.SyncSymbol(16, out var correlationValues1);

loader2.SyncSymbol(16, out var correlationValues2);

loader3.SyncSymbol(16, out var correlationValues3);

for (int i = 0; i < correlationValues1.Length; i++)

{

sw.WriteLine(string.Join('\t',

i,

correlationValues1[i],

correlationValues2[i],

correlationValues3[i]));

}

var symbol1 = loader1.TakeSymbol();

var symbol2 = loader2.TakeSymbol();

var symbol3 = loader3.TakeSymbol();

for (int i = 0; i < symbol1.Length; i++)

{

sw.WriteLine(string.Join('\t',

i, "", "", "",

symbol1[i].Magnitude, symbol1[i].Phase / float.Pi * 180,

symbol2[i].Magnitude, symbol2[i].Phase / float.Pi * 180,

symbol3[i].Magnitude, symbol3[i].Phase / float.Pi * 180));

}

class ContinuousOFDMSymbolLoader(Stream stream, int guardIntervalRatio, int effectiveSymbolLength, bool leaveOpen = false) : IDisposable

{

private static readonly Complex32 _offset = new(127.375f, 127.375f);

private readonly Stream _stream = stream;

private readonly int _guardIntervalLength = effectiveSymbolLength / guardIntervalRatio;

private readonly int _effectiveSymbolLength = effectiveSymbolLength;

private readonly bool _leaveOpen = leaveOpen;

private readonly byte[] _rawBuff = new byte[2 * (effectiveSymbolLength / guardIntervalRatio + effectiveSymbolLength)];

public void Dispose()

{

if (!_leaveOpen)

{

_stream.Dispose();

}

}

public void SyncSymbol(int N, out float[] result)

{

var (GIL, ESL) = (_guardIntervalLength, _effectiveSymbolLength);

using var dispose1 = ArrayPoolWrapper.Rent(2 * (N + 1) * (GIL + ESL), out Span<byte> buff1);

Read(buff1);

using var dispose2 = ArrayPoolWrapper.Rent(buff1.Length / 2 - ESL, out Span<Complex32> buff2);

var cast = MemoryMarshal.Cast<byte, (byte, byte)>(buff1);

var offset = _offset;

for (int i = 0; i < buff2.Length; i++)

{

var (a, b) = cast[i];

var (c, d) = cast[i + ESL];

buff2[i] =

(new Complex32(a, b) - offset) *

(new Complex32(c, d) - offset).Conjugate();

}

result = new float[GIL + ESL];

for (int i = 0; i + GIL < buff2.Length; i++)

{

var accum = Complex32.Zero;

for (int j = 0; j < GIL; j++)

{

accum += buff2[i + j];

}

result[i % result.Length] += accum.Magnitude;

}

Seek(result.AsSpan().IndexOf(result.Max()));

}

public Complex32[] TakeSymbol()

{

var (GIL, ESL) = (_guardIntervalLength, _effectiveSymbolLength);

var rawBuff = _rawBuff;

Read(rawBuff);

var cast = MemoryMarshal.Cast<byte, (byte, byte)>(rawBuff);

var accum = Complex32.Zero;

var offset = _offset;

for (int i = 0, j = ESL; i < GIL; i++, j++)

{

var (a, b) = cast[i];

var (c, d) = cast[j];

accum +=

(new Complex32(a, b) - offset) *

(new Complex32(c, d) - offset).Conjugate();

}

var angle = Complex32.FromPolarCoordinates(1 / float.Sqrt(accum.Magnitude), 0);

var speed = Complex32.FromPolarCoordinates(1, accum.Phase / ESL + float.Pi);

var symbol = new Complex32[ESL];

for (int i = 0, j = GIL; i < ESL; i++, j++, angle *= speed)

{

var (a, b) = cast[j];

symbol[i] = (new Complex32(a, b) - offset) * angle;

}

Fourier.Forward(symbol, FourierOptions.Matlab);

return symbol;

}

public void Seek(int samples)

=> _stream.Position += 2 * samples;

private void Read(Span<byte> dst)

{

for (int n = 0, m; n < dst.Length; n += m)

{

m = _stream.Read(dst[n..]);

if (m == 0) { throw new IOException(); }

}

}

}

class ArrayPoolWrapper

{

public static IDisposable Rent<T>(int length, out Span<T> result)

{

var rent = ArrayPool<T>.Shared.Rent(length);

result = rent.AsSpan(0, length);

return new ArrayPoolSharedReturn<T>(rent);

}

private class ArrayPoolSharedReturn<T>(T[]? array) : IDisposable

{

public void Dispose()

{

if (array is T[] a)

{

array = null;

ArrayPool<T>.Shared.Return(a);

}

}

}

}

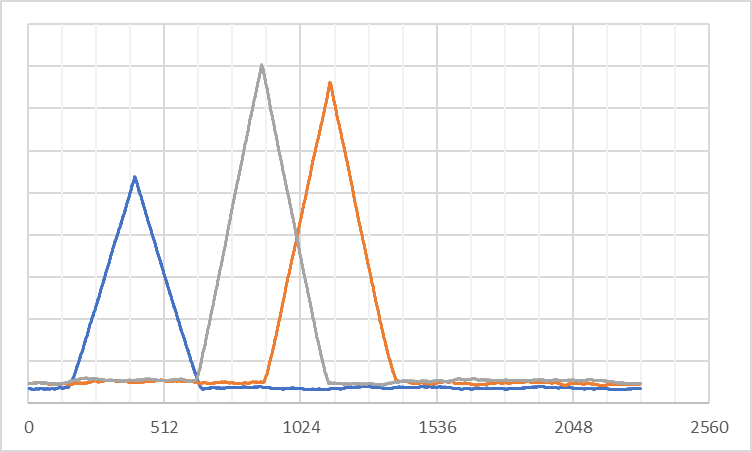

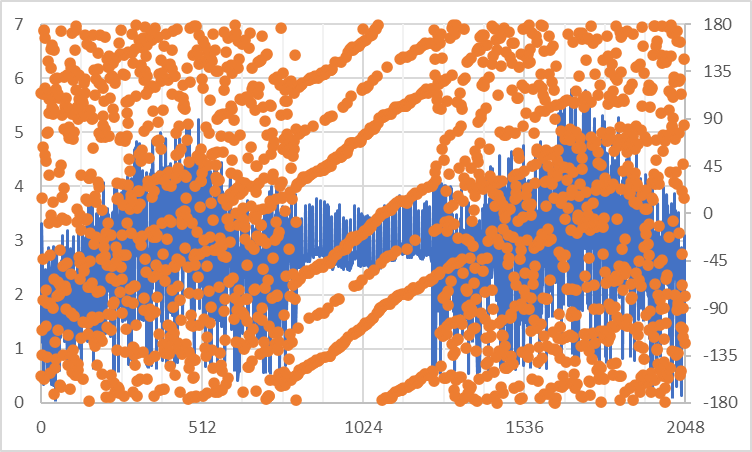

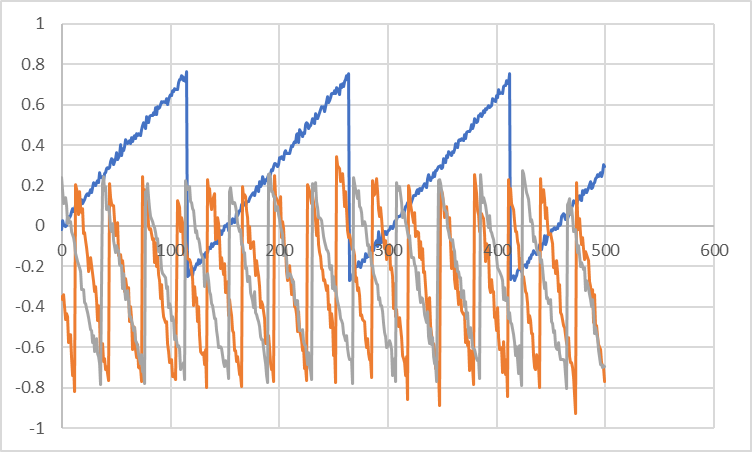

相関値をグラフにすると以下のようになります。

ピーク付近で綺麗な三角形になり、その外側は十分に低いレベルになります。相関値は信号レベル等に影響を受けます。信号レベルが低い(ヒストグラムで山が狭い)青色は相関値も低く、信号レベルが高い(山が広い)灰色は信号レベルも高くなっています。灰色よりも少し山が狭い橙色は相関値でも灰色より少し低い値になっています。

1回目はシンボルに同期していないのでそれぞれの山があちこちに出ていますが、もう一度相関処理を行えば、次はシンボルに同期して(すべて0または1、-1あたりで)山が見えるはずです。前後にずれる場合は受信機のサンプリングレートやクロックのエラーが考えられます。

中央部のセグメントのMagnitude/Phaseをグラフにすると以下のようになります。

中央のセグメントNo.0にQPSK/BPSKらしい形が見えています。その外側は64QAMなのでこの状態では判別しづらいです。

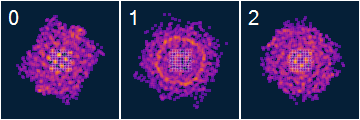

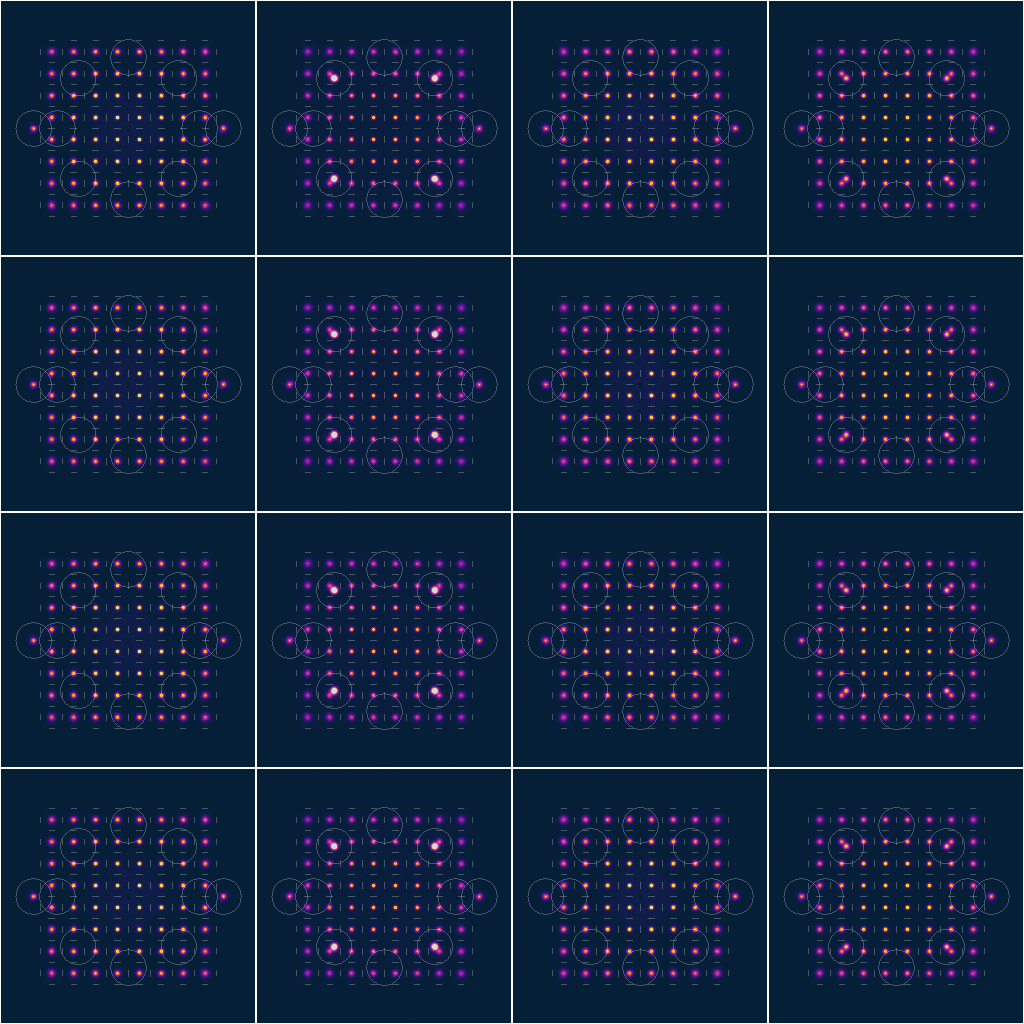

3本のドングルからコンスタレーションを画像化すると以下のようになります。

0から2までそれぞれ低周波側・中間付近・高周波側です。

0番は64QAM/BPSKが見えているような感じがありますが、1番や2番は正しく動いているか怪しいですね。とはいえ、無視して続けます(この時点で綺麗なコンスタレーションが見れるのはだいぶ運がいいです。大抵は中央や右側のように、どう好意的に見てもコンスタレーションに見えない状態になります)。

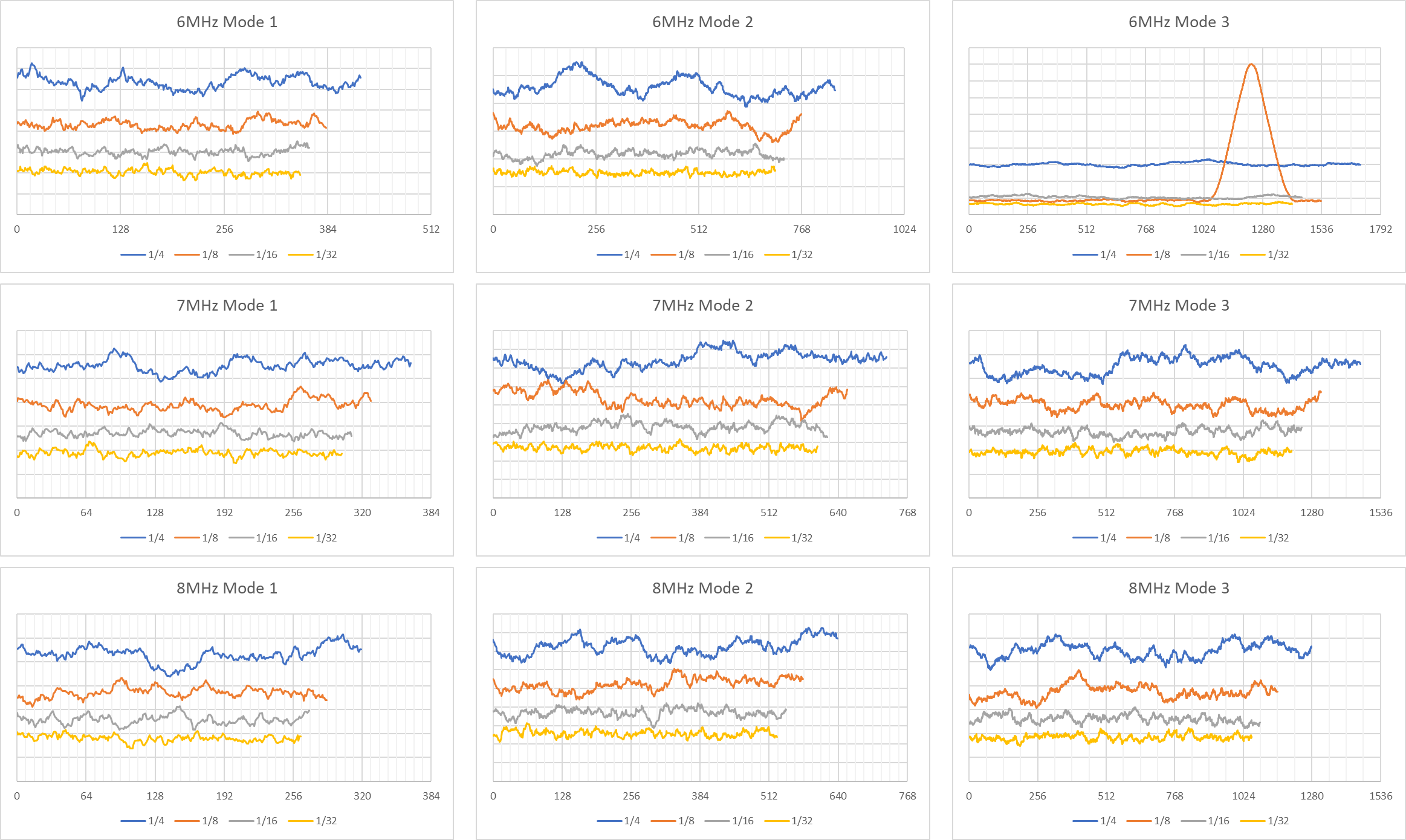

帯域幅やモード、ガードインターバル比の判定

試しに約1.3545MspsでサンプリングしたIQファイルを相関処理してみます。これは帯域幅8MHzのISDB-T(ワンセグ)の受信を目的としたサンプリングレートです。

有効サンプル長とガードインターバル比を変えて、36種類の相関を行っています。正しいパラメータである6MHz, Mode 3, 1/8の相関値のみピークが出て、それ以外ではほぼ平坦な相関値を示しています。ピークとフロアの比が閾値を超えていればそのモードで放送が行われている、というような判定ができると思います。どの組み合わせでも閾値を超えなければ、そのチャンネルでは放送が行われていない、というような判定でチャンネルスキャンを行うこともできるはずです。

このようにして帯域幅、モード、GI比を判定できます。モードやGI比は使用するサンプル数の違いですが、帯域幅が異なる場合はサンプリングレートを正しいものに設定し直す必要があります。

帯域幅の違いはサンプリングレートで、GI比の違いはOFDM復調処理で簡単に吸収できますが、モードが違う場合は処理をかなり変える必要があって、複数モードへの対応は結構面倒そうです。

周波数オフセットの推定

受信周波数を設定する際に10kHzで丸めたので、OFDMのキャリアがズレているはずです。ということでこのズレの量を推定します。周波数を設定する際に1Hzまで設定したとしても、送信側や受信側のクロックエラーでズレたりするので、「ズレないように受信する」より「ズレても問題ように復調する」ほうが楽です。例えば500MHzを受信した際に受信クロックが1ppmズレていると500Hzのズレとなり、キャリア1本分をギリギリ超えるズレになります。また、送信側は、本来は1Hz未満(実際には0.2Hz未満程度らしい)の精度で放送されていますが、送信出力次第では最大で20kHzまで許容されているようです(送信出力が極めて低い場合のみですが)。

「うまく復調できない場合は受信機のクロック補正をうまく受信できるようになるまで調整してください」というのはちょっと無責任だと思うので、ちゃんと処理します。

ISDB-Tではデータキャリアの振幅は平均で1で、補助信号(AC1やTMCCなど)は4/3(約1.33)の強さで出力されています。パイロット信号(Scattered Pilot)も4/3の強さですが、これは4シンボルで繰り返し信号になり、4nシンボルで平均化すれば約1.083程度になります。

ということで、キャリア毎にMagnitudeを4シンボル分平均化し、それに対してAC1/TMCCの配置で相関処理を行います。

周波数オフセットの推定

int[][] _AC1 = {

// AC1_1 AC1_2 AC1_3 AC1_4 AC1_5 AC1_6 AC1_7 AC1_8

[ 10, 28, 161, 191, 277, 316, 335, 425 ], // Seg.11

[ 20, 40, 182, 208, 251, 295, 400, 421 ], // Seg. 9

[ 4, 89, 148, 197, 224, 280, 331, 413 ], // Seg. 7

[ 98, 101, 118, 136, 269, 299, 385, 424 ], // Seg. 5

[ 11, 101, 128, 148, 290, 316, 359, 403 ], // Seg. 3

[ 76, 97, 112, 197, 256, 305, 332, 388 ], // Seg. 1

[ 7, 89, 206, 209, 226, 244, 377, 407 ], // Seg. 0

[ 61, 100, 119, 209, 236, 256, 398, 424 ], // Seg. 2

[ 35, 79, 184, 205, 220, 305, 364, 413 ], // Seg. 4

[ 8, 64, 115, 197, 314, 317, 334, 352 ], // Seg. 6

[ 53, 83, 169, 208, 227, 317, 344, 364 ], // Seg. 8

[ 74, 100, 143, 187, 292, 313, 328, 413 ], // Seg.10

[ 40, 89, 116, 172, 223, 305, 422, 425 ], // Seg.12

};

int[][] _TMCC = {

// TMCC1 TMCC2 TMCC3 TMCC4

[ 70, 133, 233, 410 ], // Seg.11

[ 44, 155, 265, 355 ], // Seg. 9

[ 83, 169, 301, 425 ], // Seg. 7

[ 23, 178, 241, 341 ], // Seg. 5

[ 86, 152, 263, 373 ], // Seg. 3

[ 31, 191, 277, 409 ], // Seg. 1

[ 101, 131, 286, 349 ], // Seg. 0

[ 17, 194, 260, 371 ], // Seg. 2

[ 49, 139, 299, 385 ], // Seg. 4

[ 85, 209, 239, 394 ], // Seg. 6

[ 25, 125, 302, 368 ], // Seg. 8

[ 47, 157, 247, 407 ], // Seg.10

[ 61, 193, 317, 347 ], // Seg.12

};

var _AC1FullSeg =

_AC1.SelectMany((a, i) => a.Select(a => a + i * 432))

.OrderBy(a => a).ToArray();

var _TMCCFullSeg =

_TMCC.SelectMany((a, i) => a.Select(a => a + i * 432))

.OrderBy(a => a)

.ToArray();

var _ACandTMCCFullSeg =

_AC1FullSeg.Concat(_TMCCFullSeg)

.OrderBy(a => a)

.ToArray();

loader1.SyncSymbol(8, out _);

loader2.SyncSymbol(8, out _);

loader3.SyncSymbol(8, out _);

CoarseFrequencyOffset cfo1 = new(_ACandTMCCFullSeg, 1784 + 1872 * -1 - 128, 256, effectiveSymbolLength);

CoarseFrequencyOffset cfo2 = new(_ACandTMCCFullSeg, 1784 + 1872 * +0 - 128, 256, effectiveSymbolLength);

CoarseFrequencyOffset cfo3 = new(_ACandTMCCFullSeg, 1784 + 1872 * +1 - 128, 256, effectiveSymbolLength);

Span<Complex32[]> symbols = new Complex32[4][];

for (int i = 0; i < symbols.Length; i++) { symbols[i] = loader1.TakeSymbol(); }

Console.WriteLine(cfo1.Process(symbols));

for (int i = 0; i < symbols.Length; i++) { symbols[i] = loader2.TakeSymbol(); }

Console.WriteLine(cfo2.Process(symbols));

for (int i = 0; i < symbols.Length; i++) { symbols[i] = loader3.TakeSymbol(); }

Console.WriteLine(cfo3.Process(symbols));

{

var a = cfo1.Magnitudes();

var b = cfo2.Magnitudes();

var c = cfo3.Magnitudes();

for (int i = 0; i < a.Length; i++)

{

sw.WriteLine(string.Join('\t',

i, a[i], b[i], c[i]));

}

}

{

var a = cfo1.Correlation();

var b = cfo2.Correlation();

var c = cfo3.Correlation();

for (int i = 0; i < a.Length; i++)

{

sw.WriteLine(string.Join('\t',

i - effectiveSymbolLength, "", "", "",

a[i], b[i], c[i]));

}

}

class CoarseFrequencyOffset(int[] carriers, int start, int width, int effectiveSymbolLength)

{

private readonly float[] _buff1 = new float[effectiveSymbolLength];

private readonly float[] _buff2 = new float[width];

public int Process(Span<Complex32[]> symbols)

{

var buff1 = _buff1;

Array.Clear(buff1);

foreach (var symbol in symbols)

{

for (int i = 0; i < buff1.Length; i++)

{

buff1[i] += symbol[i].MagnitudeSquared;

}

}

var buff2 = _buff2;

for (int i = 0, j = start; i < buff2.Length; i++, j++)

{

buff2[i] = Correlation(j);

}

return start + buff2.AsSpan().IndexOf(buff2.Max());

}

public float Correlation(int i)

{

var (buff, accum) = (_buff1, 0f);

foreach (var j in carriers)

{

var k = j - i;

if (0 <= k && k < buff.Length)

{

accum += buff[k];

}

}

return accum;

}

public float[] Correlation()

{

var result = new float[_buff1.Length + carriers.Max()];

for (int i = 0, j = -_buff1.Length; i < result.Length; i++, j++)

{

result[i] = Correlation(j);

}

return result;

}

public float[] Magnitudes()

=> _buff1.Select(float.Sqrt).ToArray();

}

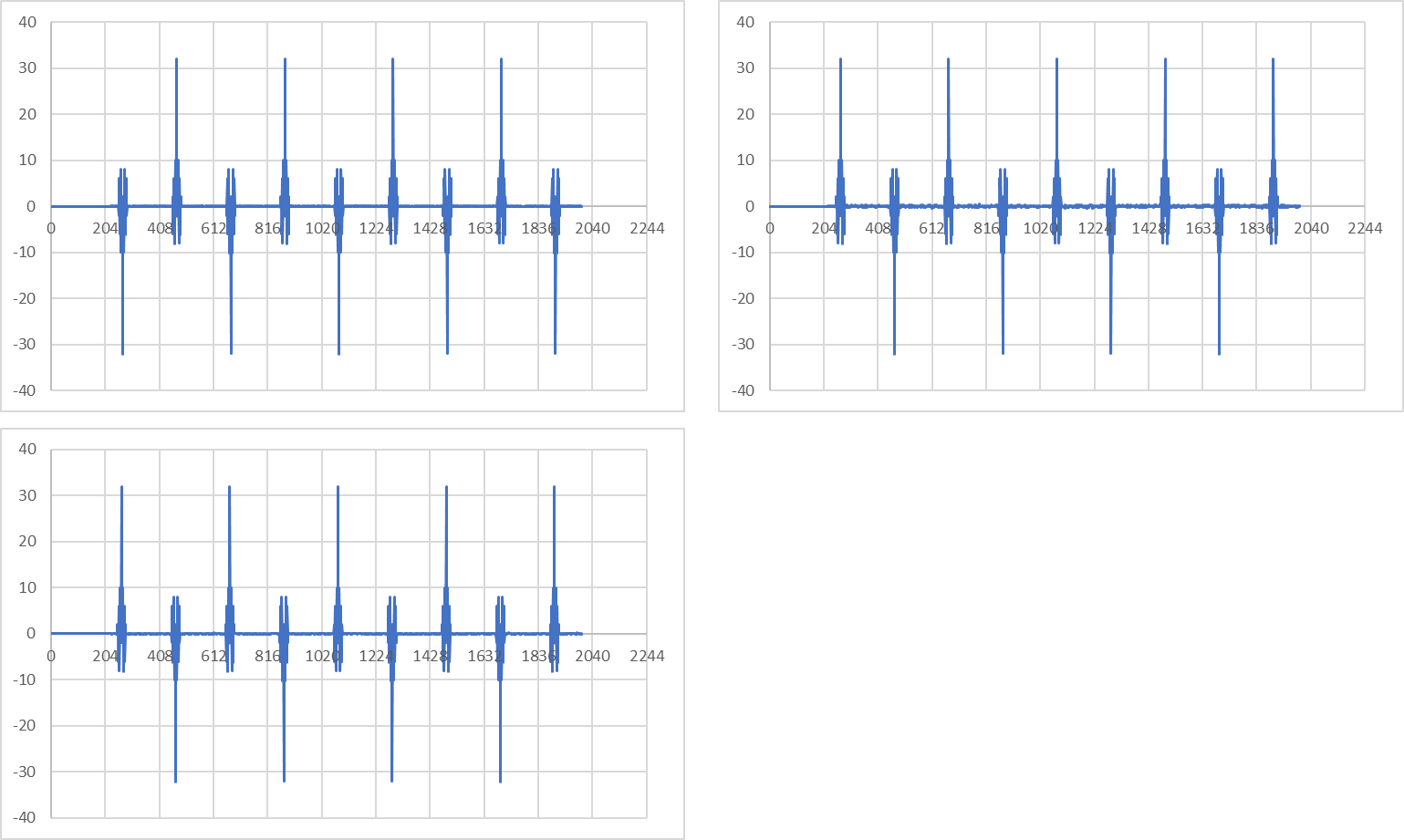

キャリアに対する相関値は以下のようになります。

AC/TMCCの配置は1404本で周期的なので、複数のピークが立ちます。また伝播経路や受信機の周波数特性によってピークが綺麗に出ないことがあるので、相関させる範囲はある程度狭い範囲(今回は±128キャリア)で制限します。キャリア1本あたり約1kHzなので、最大で128kHz程度のズレまでを許容できる、という感じの設定です。

相関結果は一番左側のキャリアの番号で出力されます。今回の場合は受信機1(青色、低周波側)が-83番目のキャリア、受信機2(橙色、中央部)が1779番目のキャリア、受信機3(灰色、高周波側)が3655番目のキャリア、という感じで並んでいます。1番目と2番目の距離は1862本、2番目と3番目の距離は1876本、という感じで受信できています。5616本のキャリアを3分割するので、理論的には1872本間隔で並ぶはずですが、受信する際に周波数を10kHzで丸めたため少しズレた結果になります(実を言うと周波数ズレの吸収がうまく動いている動作確認のためにわざと10kHzで丸めて受信位置をずらしていたわけですが)。

シンボル等化

本来は不要な作業ですが、シンボルの等化(周波数軸での回転の打ち消し)を行います。また、同時にFFT窓の移動の補正も行います。

本物のISDB-T受信機は受信機側のサンプリングクロックを送信機のサンプリングクロックに同期するフィードバックがあるのでFFT窓が移動することはありませんが、今回は予め受信したIQファイルを使用するので、FFT窓を固定することができません。FFT窓がずれると、数サンプル程度であれば周波数軸上でコンスタレーションが回転する程度の影響で済みますが、それでもTMCC(DBPSK)の復調に影響があります。また、さらにずれるとOFDMの復調もできなくなります。

周波数方向のコンスタレーションの回転を推定するには位相が既知の信号が必要です。TMCCはセグメント内で同一の情報が複数本(モード3で4本)挿入されているため、これを基準として使用します。一応、規格的にはセグメント間でのTMCCの同一性は保証されていないため、セグメント内で比較してやる必要があります(日本で使用されている運用ではセグメント間でも同じ信号が出ていますが)。モード3の場合にはセグメント内にTMCCが4本、モード2の場合は2本ありますが、モード1の場合はセグメント内にTMCCが1本しかないので、この用途には使用できません。

AC1はTMCCよりも密に配置されていますが、AC1はキャリア毎に異なるデータを入れることができるので、この用途では使用できません。

シンボルの等化

var _wi = ScatteredPilotPRBS(13 * 432 + 1, 3 / 4f);

static Complex32[] ScatteredPilotPRBS(int N, float gain)

{

ReadOnlySpan<Complex32> LUT = [new(gain, 0), new(-gain, 0)];

var result = new Complex32[N];

for (int i = 0, reg = 0x7FF; i < result.Length; i++, reg >>= 1)

{

result[i] = LUT[reg & 1];

switch (reg & 0b101)

{

case 0b100:

case 0b001:

reg |= 0x800;

break;

}

}

return result;

}

float SymbolEqualize(int leftmost, Span<Complex32> carriers)

{

var segment = (leftmost + carriers.Length / 2 - 432 / 2) / 432;

var tmcc = _TMCC[segment];

var a = segment * 432 + tmcc[tmcc.Length / 2 - 1];

var b = segment * 432 + tmcc[tmcc.Length / 2];

var wi = _wi;

var tmp =

carriers[a - leftmost] * wi[a] *

(carriers[b - leftmost] * wi[b]).Conjugate();

var speed = Complex32.Pow(tmp, 1f / (b - a));

speed /= speed.Magnitude;

var angle = Complex32.Pow(speed, -carriers.Length / 2);

angle /= float.Sqrt(tmp.Magnitude);

for (int i = 0; i < carriers.Length; i++, angle *= speed)

{

carriers[i] *= angle;

}

return carriers.Length * speed.Phase / (float.Pi * 2);

}

float SymbolsEqualize(ReadOnlySpan<(int leftmost, Complex32[] carriers)> symbols)

{

var accum = 0f;

foreach (var (leftmost, carriers) in symbols)

{

accum += SymbolEqualize(leftmost, carriers);

}

return accum / symbols.Length;

}

float LoadSymbol(Span<(int, Complex32[])> dst, ContinuousOFDMSymbolLoader loader, CoarseFrequencyOffset cfo)

{

Span<Complex32[]> tmp = new Complex32[dst.Length][];

for (int i = 0; i < tmp.Length; i++)

{

tmp[i] = loader.TakeSymbol();

}

var leftmost = cfo.Process(tmp);

for (int i = 0; i < dst.Length; i++)

{

dst[i] = (leftmost, tmp[i]);

}

return SymbolsEqualize(dst);

}

Span<(int, Complex32[])> symbols1 = new (int, Complex32[])[4];

Span<(int, Complex32[])> symbols2 = new (int, Complex32[])[4];

Span<(int, Complex32[])> symbols3 = new (int, Complex32[])[4];

for (int i = 0; i < 500; i++)

{

var shift1 = LoadSymbol(symbols1, loader1, cfo1);

var shift2 = LoadSymbol(symbols2, loader2, cfo2);

var shift3 = LoadSymbol(symbols3, loader3, cfo3);

if (shift1 < -0.75) { loader1.Seek(-1); } else if (0.75 < shift1) { loader1.Seek(1); }

if (shift2 < -0.75) { loader2.Seek(-1); } else if (0.75 < shift2) { loader2.Seek(1); }

if (shift3 < -0.75) { loader3.Seek(-1); } else if (0.75 < shift3) { loader3.Seek(1); }

sw.WriteLine(string.Join('\t',

i, shift1, shift2, shift3));

}

シンボルの等化を行なうことでFFT窓のズレも把握できるので、閾値を超えた場合はシークを行うことでフィードバックします。今回は閾値で適当なヒステリシス特性を与え、シークが頻発しないようにしています。

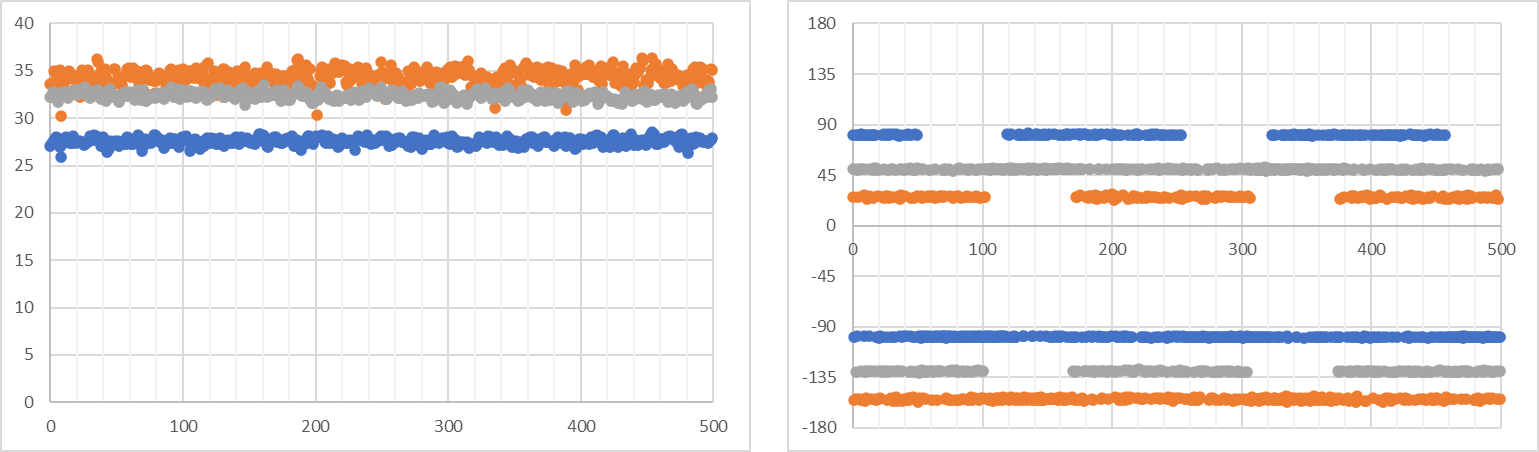

切り出し窓のズレをグラフにすると以下のようになります。

ズレが1サンプル未満に収まるようにフィードバックされています。受信機ごとにクロックがフリーランしているので、受信機ごとに切り出し窓のズレも異なります。ここでも青と橙・灰の2グループ(購入時期の違い)で明確な差が見られます。

コンスタレーションは以下のようになります。

1シンボル単位(2048ポイント)のコンスタレーションなので統計的に見ることができず、雑多な感じが残っていますが。

フレーム同期 (1)

フレームの同期にはいくつかの手法が考えられますが、今回はTMCCの同期信号をアナログ的に加算して判定する手法を用います。DBPSKの復調後に同期ビット列を検出する方法の場合は、クロックエラーの補正やビットエラー対策などの課題があります。アナログ的な判定であればビットエラーをある程度許容した上で、クロックエラーの補正に必要な情報も得られるという一石二鳥の方式です(シンボル等化と同様、クロックエラー補正は本来不要な処理ですが)。

フレームの同期 (1)

SyncFrame syncFrame1 = new(_TMCCFullSeg, _wi);

SyncFrame syncFrame2 = new(_TMCCFullSeg, _wi);

SyncFrame syncFrame3 = new(_TMCCFullSeg, _wi);

for (int i = 0; i < 500; i++)

{

var shift1 = LoadSymbol(symbols1, loader1, cfo1);

var shift2 = LoadSymbol(symbols2, loader2, cfo2);

var shift3 = LoadSymbol(symbols3, loader3, cfo3);

if (shift1 < -0.75) { loader1.Seek(-1); } else if (0.75 < shift1) { loader1.Seek(1); }

if (shift2 < -0.75) { loader2.Seek(-1); } else if (0.75 < shift2) { loader2.Seek(1); }

if (shift3 < -0.75) { loader3.Seek(-1); } else if (0.75 < shift3) { loader3.Seek(1); }

for (int j = 0; j < 4; j++)

{

sw.WriteLine(string.Join('\t',

i * 4 + j,

syncFrame1.Process(symbols1[j]),

syncFrame2.Process(symbols2[j]),

syncFrame3.Process(symbols3[j])));

}

}

{

var a = new Complex32[500];

var b = new Complex32[500];

var c = new Complex32[500];

syncFrame1.CopyTMCC(500, a);

syncFrame2.CopyTMCC(500, b);

syncFrame3.CopyTMCC(500, c);

for (int i = 0; i < a.Length; i++)

{

sw.WriteLine(string.Join('\t',

i, "", "", "",

a[i].Magnitude,

b[i].Magnitude,

c[i].Magnitude,

a[i].Phase / float.Pi * 180,

b[i].Phase / float.Pi * 180,

c[i].Phase / float.Pi * 180));

}

}

partial class SyncFrame;

partial class SyncFrame(int[] _TMCCFullSeg, Complex32[] wi)

{

private readonly (int leftmost, Complex32[] carriers)[] _symbols = new (int, Complex32[])[512];

private readonly Complex32[] _tmccs = Enumerable.Repeat(Complex32.NaN, 512).ToArray();

private int _symbolsIndex = 0;

public float Process((int leftmost, Complex32[] carriers) symbol)

{

AddSymbol(symbol);

var sync = TakeSyncRotate();

return sync.Magnitude * float.Sign(sync.Real);

}

private void AddSymbol((int, Complex32[]) symbol)

{

var (symbols, symbolsIndex) = (_symbols, _symbolsIndex);

var (leftPrev, carrPrev) = symbols[symbolsIndex++];

symbols[_symbolsIndex = symbolsIndex %= symbols.Length] = symbol;

if (carrPrev is null)

{

_tmccs[symbolsIndex] = Complex32.NaN;

}

else

{

var (leftCrnt, carrCrnt) = symbol;

var accum = Complex32.Zero;

foreach (var i in _TMCCFullSeg)

{

var j = i - leftCrnt;

var k = i - leftPrev;

if (0 <= j && j < carrCrnt.Length &&

0 <= k && k < carrPrev.Length)

{

accum +=

carrCrnt[j] *

carrPrev[k].Conjugate();

}

}

_tmccs[symbolsIndex] = accum;

}

}

private Complex32 TakeSyncRotate()

{

Span<Complex32> a = stackalloc Complex32[16];

Span<Complex32> b = stackalloc Complex32[16];

CopyTMCC(16, a);

CopyTMCC(220, b);

for (int i = 0; i < 16; i++)

{

a[i] /= a[i].Magnitude;

b[i] /= b[i].Magnitude;

}

var sum =

a[0] + a[1] + a[4] + a[6] + a[11] + a[15] -

(a[2] + a[3] + a[5] + a[7] + a[8] + a[9] + a[10] + a[12] + a[13] + a[14]) -

(b[0] + b[1] + b[4] + b[6] + b[11] + b[15]) +

(b[2] + b[3] + b[5] + b[7] + b[8] + b[9] + b[10] + b[12] + b[13] + b[14]);

return

sum.IsNaN()

? Complex32.Zero

: sum;

}

public void CopyTMCC(int index, Span<Complex32> dst)

=> _tmccs.CopyFromRingBuffer(dst, _symbolsIndex - index);

}

static class MyExt

{

public static void CopyFromRingBuffer<T>(this T[] src, Span<T> dst, int index)

=> CopyFromRingBuffer((ReadOnlySpan<T>)src, dst, index);

public static void CopyFromRingBuffer<T>(this ReadOnlySpan<T> src, Span<T> dst, int index)

{

index = (index + src.Length) % src.Length;

if (index + dst.Length <= src.Length)

{

src.Slice(index, dst.Length).CopyTo(dst);

}

else

{

var n = src.Length - index;

var m = dst.Length - n;

src[index..].CopyTo(dst);

src[..m].CopyTo(dst[n..]);

}

}

}

2箇所の同期信号を加算していき、そのMagnitudeが閾値を超えたら同期信号を見つけたことにします。アナログ判定なので適当な閾値を選ぶことで多少のビットエラーも許容できます。閾値が低すぎると誤ったフレーム同期を起こしますが、その場合は後続の誤り訂正で訂正できないことで検出できることを期待します。

加算結果をグラフ化すると以下のようになります。

グラフは204シンボル(1フレーム)でグリッドを入れてあります。1フレーム毎に位相が反転して強さが約32のピークが出ています。サイドローブレベルは十分に低く、誤ったフレーム同期の可能性はかなり低そうですね。

TMCCの生データ(DBPSKから差動を除去したBPSK)は以下のようになります(左がMagnitude、右がPhase)。

安定した強さで、位相は2箇所に出ています。ただしこの時点では受信機のクロックエラーに起因するシンボル間での周波数軸上の回転が残っているため、本来は0度、180度の位置に出るはずのコンスタレーションが別の場所に出ています。

固定値でBPSK復調した場合に灰色がビット反転しそうな気配や、フレーム間で60ms程度の時間差があることも推定できます。

フレームの同期 (2)

同期信号を加算した結果にはシンボル間でのコンステレーションの回転の情報が含まれます。ただし、同期信号はビット反転した2種類が使用されているため、シンボル間の回転には180度の曖昧さが含まれます。これを除くため、まずシンボル間の回転を仮定した上でTMCCの復調を行い、続いてTMCCの誤り訂正を試みます。シンボル間の回転が正しければ誤り訂正で正しく修正されますが、ビット反転している場合は正しく誤り訂正が行えません。そのため、取り出したTMCCをビット反転したものでも誤り訂正を試みて、誤りが少ない方を採用し、またそれに合わせてシンボル間回転の曖昧さも除きます。

シンボル間回転の値を得たら、同期信号の適当な1bitを取り出して、それをフレームの極性信号として使用します。1フレームごとに正/負が切り替わるため、複数のドングルで受信したフレームをこの正負情報で同期します。

フレームの同期 (2)

void LoadFrame(

Span<(int, Complex32[])> symbols,

ContinuousOFDMSymbolLoader loader,

CoarseFrequencyOffset cfo,

SyncFrame syncFrame,

ref (int, BigInteger) frameInfo)

{

var shift = LoadSymbol(symbols, loader, cfo);

if (shift < -0.75)

{

loader.Seek(-1);

}

else if (0.75 < shift)

{

loader.Seek(1);

}

for (int i = 0; i < symbols.Length; i++)

{

if (syncFrame.CheckSync(symbols[i], out var sync))

{

frameInfo = sync;

}

}

}

(int syncPhase, BigInteger TMCC) frame1 = default;

(int syncPhase, BigInteger TMCC) frame2 = default;

(int syncPhase, BigInteger TMCC) frame3 = default;

for (int i = 0; i < 500; i++)

{

LoadFrame(symbols1, loader1, cfo1, syncFrame1, ref frame1);

LoadFrame(symbols2, loader2, cfo2, syncFrame2, ref frame2);

LoadFrame(symbols3, loader3, cfo3, syncFrame3, ref frame3);

if (frame1.syncPhase != 0 &&

frame1.syncPhase == frame2.syncPhase &&

frame1.syncPhase == frame3.syncPhase)

{

Console.WriteLine(string.Join(' ',

$"{frame1.syncPhase,2}",

frame1.TMCC.ToString("X46")[^46..],

$"{frame1.TMCC == frame2.TMCC && frame1.TMCC == frame3.TMCC,5}"));

frame1.syncPhase = frame2.syncPhase = frame3.syncPhase = 0;

}

}

partial class SyncFrame

{

public bool CheckSync(

(int leftmost, Complex32[] carriers) symbol,

out (int syncPhase, BigInteger TMCC) result)

{

AddSymbol(symbol);

var syncRotate = TakeSyncRotate();

if (25 < syncRotate.Magnitude)

{

Span<Complex32> a = stackalloc Complex32[184];

CopyTMCC(201, a);

var tmcc1 = DecodeBpsk(a, syncRotate.Conjugate());

var tmcc2 = tmcc1 ^ (BigInteger.One << 184) - 1;

var errorbits1 = DifferenceSetCyclicCode.Instance_273_191.Decode(tmcc1);

var errorbits2 = DifferenceSetCyclicCode.Instance_273_191.Decode(tmcc2);

var pop1 = (int)BigInteger.PopCount(errorbits1);

var pop2 = (int)BigInteger.PopCount(errorbits2);

if (pop1 <= 7 ||

pop2 <= 7)

{

BigInteger tmcc;

(tmcc, syncRotate) =

pop1 < pop2

? (tmcc1 ^ errorbits1, syncRotate)

: (tmcc2 ^ errorbits2, syncRotate * -Complex32.One);

CopyTMCC(220, a[..1]);

var phase = float.Sign((a[0] * syncRotate.Conjugate()).Real);

// 同期信号の最初のビットを取ってきてフレームのPos/Negを判定

result = (phase, tmcc);

return true;

}

}

result = default;

return false;

}

private static BigInteger DecodeBpsk(ReadOnlySpan<Complex32> src, Complex32 rotate)

{

var result = BigInteger.Zero;

for (int i = 0; i < src.Length; i++)

{

if ((src[i] * rotate).Real < 0)

{

result |= BigInteger.One << src.Length - i - 1;

}

}

return result;

}

}

class DifferenceSetCyclicCode

{

private readonly (UInt128, UInt128, int, UInt128[]) _params;

private readonly int _k, _m;

private static DifferenceSetCyclicCode? _instance_21_11;

public static DifferenceSetCyclicCode Instance_21_11 => _instance_21_11 ??= new(

21, 11,

[10, 7, 6, 4, 2, 0],

[[9], [1], [4, 6], [0, 5, 7], [2, 3, 8]]);

private static DifferenceSetCyclicCode? _instance_273_191;

public static DifferenceSetCyclicCode Instance_273_191 => _instance_273_191 ??= new(

273, 191,

[82, 77, 76, 71, 67, 66, 56, 52, 48, 40, 36, 34, 24, 22, 18, 10, 4, 0],

[

[71, 76],

[17],

[5, 23],

[21, 27, 45],

[3, 25, 31, 49],

[16, 40, 42, 66],

[35, 52, 56, 78],

[8, 44, 61, 65],

[2, 11, 47, 64, 68],

[10, 13, 22, 58, 75, 79],

[1, 12, 15, 24, 60, 77, 81],

[30, 32, 43, 46, 55],

[6, 37, 39, 50, 53, 62],

[0, 7, 38, 40, 51, 54, 63],

[18, 19, 26, 57, 59, 70, 73],

[9, 28, 29, 36, 67, 69, 80],

[4, 14, 33, 34, 41, 72, 74],

]);

private DifferenceSetCyclicCode(int m, int k, int[] delta, int[][] bitsum)

=> (_m, _k, _params) = (m, k, (

BitsOr(delta),

UInt128.One << delta.Max(),

(bitsum.Length + 1) / 2,

bitsum.Select(a => BitsOr(a)).ToArray()));

private static UInt128 BitsOr(ReadOnlySpan<int> a)

{

var b = UInt128.Zero;

foreach (var v in a) { b |= UInt128.One << v; }

return b;

}

public UInt128 Encode(in BigInteger data)

{

var (xor, MSB, _, _) = _params;

var (reg, bitPos1) = (UInt128.Zero, BigInteger.One << _k - 1);

for (; !bitPos1.IsZero; bitPos1 >>= 1)

{

reg <<= 1;

var bit1 = (data & bitPos1).IsZero;

var bit2 = (reg & MSB) == 0U;

if (bit1 != bit2) { reg ^= xor; }

}

return reg & (MSB - 1);

}

public BigInteger Decode(in BigInteger data)

{

var (xor, MSB, thr, As) = _params;

var (reg, bitPos1) = (UInt128.Zero, BigInteger.One << _m - 1);

var bitPos2 = bitPos1;

for (; !bitPos1.IsZero; bitPos1 >>= 1)

{

reg <<= 1;

var bit1 = (data & bitPos1).IsZero;

var bit2 = (reg & MSB) == 0U;

if (bit1 != bit2) { reg ^= 1; }

if (!bit2) { reg ^= xor ^ 1; }

}

var result = BigInteger.Zero;

for (; !bitPos2.IsZero; bitPos2 >>= 1)

{

var errors = 0;

foreach (var A in As)

{

if (((int)UInt128.PopCount(reg & A) & 1) != 0)

{ errors++; }

}

if (thr <= errors) { result |= bitPos2; }

reg <<= 1;

var bit2 = (reg & MSB) == 0U;

if (!bit2) { reg ^= xor; }

}

return result;

}

}

ISDB-Tの誤り訂正には(273,191)の差集合巡回符号(それを短縮化した(184,102)短縮化差集合巡回符号)が使用されています。これはアナログテレビの字幕放送から、FM放送やそれを使用したカーナビのシステムなど、放送分野(特にNHKが関わる範囲)で幅広く使われています(他にも放送機器を扱っていたメーカーが開発した産業機器向けリモコン製品でも使われているようです)。

ただ、使用範囲が広い割に情報があまり出てきません。今回はhttps://www.cqpub.co.jp/dwm/contest/2002/dwm48154.pdfおよびhttps://www.jstage.jst.go.jp/article/itej1978/45/8/45_8_970/_pdfを参考にしましたが、実装には自信がありません。どこか間違っている気がしますが、とりあえず動いているので当面は良しとします。

実行すると以下のような結果になるはずです。

1 3D258B4B3FFFFFFFFFFFFFFFFE5E183084EEC4D84AC6F5 True

-1 3D258B4B3FFFFFFFFFFFFFFFFE5E183084EEC4D84AC6F5 True

1 3D258B4B3FFFFFFFFFFFFFFFFE5E183084EEC4D84AC6F5 True

-1 3D258B4B3FFFFFFFFFFFFFFFFE5E183084EEC4D84AC6F5 True

1 3D258B4B3FFFFFFFFFFFFFFFFE5E183084EEC4D84AC6F5 True

-1 3D258B4B3FFFFFFFFFFFFFFFFE5E183084EEC4D84AC6F5 True

1 3D258B4B3FFFFFFFFFFFFFFFFE5E183084EEC4D84AC6F5 True

-1 3D258B4B3FFFFFFFFFFFFFFFFE5E183084EEC4D84AC6F5 True

1 3D258B4B3FFFFFFFFFFFFFFFFE5E183084EEC4D84AC6F5 True

フレームごとに同期信号の位相が反転し、TMCCは常に同じ値が得られ、3個の受信機から得たTMCCが同じ値となります。

なお、TMCCから情報を取り出すと以下のようになります。

{

"SystemIdentification": "DigitalTerestrialTelevisionBroadcastingSystem",

"IndicatorOfTransmissionParameterSwitching": "NormalValue",

"StartupControlSignal": "NoStartupControl",

"CurrentInformation": {

"PartialReceptionFlag": "PartialReceptionAvailable",

"HierarchicalLayerA": {

"CarrierModulationMappingScheme": "QPSK",

"ConvolutionCodingRate": "2/3",

"TimeInterleavingLength": "16/8/4",

"NumberOfSegments": "1Segment"

},

"HierarchicalLayerB": {

"CarrierModulationMappingScheme": "64QAM",

"ConvolutionCodingRate": "3/4",

"TimeInterleavingLength": "8/4/2",

"NumberOfSegments": "12Segments"

},

"HierarchicalLayerC": {

"CarrierModulationMappingScheme": "UnusedHierarchicalLayer",

"ConvolutionCodingRate": "UnusedHierarchicalLayer",

"TimeInterleavingLength": "UnusedHierarchicalLayer",

"NumberOfSegments": "UnusedHierarchicalLayer"

}

},

"NextInformation": {

"PartialReceptionFlag": "PartialReceptionAvailable",

"HierarchicalLayerA": {

"CarrierModulationMappingScheme": "UnusedHierarchicalLayer",

"ConvolutionCodingRate": "UnusedHierarchicalLayer",

"TimeInterleavingLength": "UnusedHierarchicalLayer",

"NumberOfSegments": "UnusedHierarchicalLayer"

},

"HierarchicalLayerB": {

"CarrierModulationMappingScheme": "UnusedHierarchicalLayer",

"ConvolutionCodingRate": "UnusedHierarchicalLayer",

"TimeInterleavingLength": "UnusedHierarchicalLayer",

"NumberOfSegments": "UnusedHierarchicalLayer"

},

"HierarchicalLayerC": {

"CarrierModulationMappingScheme": "UnusedHierarchicalLayer",

"ConvolutionCodingRate": "UnusedHierarchicalLayer",

"TimeInterleavingLength": "UnusedHierarchicalLayer",

"NumberOfSegments": "UnusedHierarchicalLayer"

}

}

}

ここで重要なのはCurrentInformationのPartialReceptionAvailable(ワンセグ放送有効)、LayerAがQPSK, 2/3, 16/8/4, 1Seg、LayerBが64QAM, 3/4, 8/4/2, 12Segs、という部分です。ここが異なる場合は以降の説明と異なる処理を組む必要になります。

変調方式が変わるとTMCCも変わりますが、今回はこのTMCCに対応したデコードロジックを説明していきます。

TMCCの分解

Console.WriteLine(

JsonSerializer.Serialize(

new TMCCInformation(frame1.TMCC),

new JsonSerializerOptions

{

WriteIndented = true,

Converters = { new JsonStringEnumConverter() }

})

.Replace("\": \"_", "\": \"")

.Replace('_', '/'));

public enum SystemIdentification

{

_DigitalTerestrialTelevisionBroadcastingSystem,

_DigitalTerestrialSoundBroadcastingSystem,

_Reserved1,

_Reserved2,

}

public enum IndicatorOfTransmissionParameterSwitching

{

_1FramePriorToSwitching,

_2FramesPriorToSwitching,

_3FramesPriorToSwitching,

_4FramesPriorToSwitching,

_5FramesPriorToSwitching,

_6FramesPriorToSwitching,

_7FramesPriorToSwitching,

_8FramesPriorToSwitching,

_9FramesPriorToSwitching,

_10FramesPriorToSwitching,

_11FramesPriorToSwitching,

_12FramesPriorToSwitching,

_13FramesPriorToSwitching,

_14FramesPriorToSwitching,

_15FramesPriorToSwitching,

_NormalValue,

}

public enum StartupControlSignal

{

_NoStartupControl,

_StartupControlAvailable,

}

public enum PartialReceptionFlag

{

_NoPartialReception,

_PartialReceptionAvailable,

}

public enum CarrierModulationMappingScheme

{

_DQPSK,

_QPSK,

_16QAM,

_64QAM,

_Reserved1,

_Reserved2,

_Reserved3,

_UnusedHierarchicalLayer,

}

public enum ConvolutionCodingRate

{

_1_2,

_2_3,

_3_4,

_5_6,

_7_8,

_Reserved1,

_Reserved2,

_UnusedHierarchicalLayer,

}

public enum TimeInterleavingLength

{

_0_0_0,

_4_2_1,

_8_4_2,

_16_8_4,

_NotUsed,

_Reserved1,

_Reserved2,

_UnusedHierarchicalLayer,

}

public enum NumberOfSegments

{

_Reserved1,

_1Segment,

_2Segments,

_3Segments,

_4Segments,

_5Segments,

_6Segments,

_7Segments,

_8Segments,

_9Segments,

_10Segments,

_11Segments,

_12Segments,

_13Segments,

_Reserved2,

_UnusedHierarchicalLayer,

}

public readonly record struct TransmissionParameterInformation(

CarrierModulationMappingScheme CarrierModulationMappingScheme,

ConvolutionCodingRate ConvolutionCodingRate,

TimeInterleavingLength TimeInterleavingLength,

NumberOfSegments NumberOfSegments)

{

public TransmissionParameterInformation(int rawValue)

: this(

(CarrierModulationMappingScheme)(rawValue >> 10 & 0x7),

(ConvolutionCodingRate)(rawValue >> 7 & 0x7),

(TimeInterleavingLength)(rawValue >> 4 & 0x7),

(NumberOfSegments)(rawValue >> 0 & 0xF))

{ }

}

public readonly record struct Information(

PartialReceptionFlag PartialReceptionFlag,

TransmissionParameterInformation HierarchicalLayerA,

TransmissionParameterInformation HierarchicalLayerB,

TransmissionParameterInformation HierarchicalLayerC);

public readonly record struct TMCCInformation(

SystemIdentification SystemIdentification,

IndicatorOfTransmissionParameterSwitching IndicatorOfTransmissionParameterSwitching,

StartupControlSignal StartupControlSignal,

Information CurrentInformation,

Information NextInformation)

{

public TMCCInformation(BigInteger rawValue) : this(

(SystemIdentification)(int)(rawValue >> 204 - 21 - 1 & 0x3),

(IndicatorOfTransmissionParameterSwitching)(int)(rawValue >> 204 - 25 - 1 & 0xF),

(StartupControlSignal)(int)(rawValue >> 204 - 26 - 1 & 1),

new((PartialReceptionFlag)(int)(rawValue >> 204 - 27 - 1 & 0x1),

new TransmissionParameterInformation((int)(rawValue >> 204 - 40 - 1 & 0x1FFF)),

new TransmissionParameterInformation((int)(rawValue >> 204 - 53 - 1 & 0x1FFF)),

new TransmissionParameterInformation((int)(rawValue >> 204 - 66 - 1 & 0x1FFF))),

new((PartialReceptionFlag)(int)(rawValue >> 204 - 67 - 1 & 0x1),

new TransmissionParameterInformation((int)(rawValue >> 204 - 80 - 1 & 0x1FFF)),

new TransmissionParameterInformation((int)(rawValue >> 204 - 93 - 1 & 0x1FFF)),

new TransmissionParameterInformation((int)(rawValue >> 204 - 106 - 1 & 0x1FFF))))

{ }

}

フレームの結合

受信機ごとに受信したセグメントの等化処理を行った上で、すべてのキャリアを結合し、一つのフレームとしてまとめます。等化処理はセグメントごとに変調モードを読んで処理すべきですが、面倒なのでコヒーレント変調専用に実装しています。

フレームの結合

(int leftmost, Complex32[] carriers)[] equalizedFrame1 = Enumerable.Range(0, 204).Select(_ => (0, (Complex32[])[])).ToArray();

(int leftmost, Complex32[] carriers)[] equalizedFrame2 = Enumerable.Range(0, 204).Select(_ => (0, (Complex32[])[])).ToArray();

(int leftmost, Complex32[] carriers)[] equalizedFrame3 = Enumerable.Range(0, 204).Select(_ => (0, (Complex32[])[])).ToArray();

void LoadFrame(

Span<(int, Complex32[])> symbols,

ContinuousOFDMSymbolLoader loader,

CoarseFrequencyOffset cfo,

SyncFrame syncFrame,

ref (int, BigInteger) frameInfo,

(int, Complex32[])[] frameBuff)

{

var shift = LoadSymbol(symbols, loader, cfo);

if (shift < -0.75)

{

loader.Seek(-1);

}

else if (0.75 < shift)

{

loader.Seek(1);

}

for (int i = 0; i < symbols.Length; i++)

{

if (syncFrame.CheckSync(symbols[i], out var sync))

{

frameInfo = sync;

syncFrame.TakeFrame(frameBuff);

}

}

}

Complex32[][] majorFrame = Enumerable.Range(0, 204).Select(_ => new Complex32[5616]).ToArray();

void CombineFrame()

{

var frame1 = equalizedFrame1;

var frame2 = equalizedFrame2;

var frame3 = equalizedFrame3;

for (int i = 0; i < majorFrame.Length; i++)

{

var n = 0;

int left;

Complex32[] src;

var dst = majorFrame[i];

(left, src) = frame1[i];

src.AsSpan(n - left, 1872).CopyTo(dst.AsSpan(n));

n += 1872;

(left, src) = frame2[i];

src.AsSpan(n - left, 1872).CopyTo(dst.AsSpan(n));

n += 1872;

(left, src) = frame3[i];

src.AsSpan(n - left, 1872).CopyTo(dst.AsSpan(n));

n += 1872;

}

}

for (int i = 0, frameNo = 0; i < 5000 && frameNo < 5; i++)

{

try

{

LoadFrame(symbols1, loader1, cfo1, syncFrame1, ref frame1, equalizedFrame1);

LoadFrame(symbols2, loader2, cfo2, syncFrame2, ref frame2, equalizedFrame2);

LoadFrame(symbols3, loader3, cfo3, syncFrame3, ref frame3, equalizedFrame3);

}

catch (IOException) { break; }

if (frame1.syncPhase != 0 &&

frame1.syncPhase == frame2.syncPhase &&

frame1.syncPhase == frame3.syncPhase)

{

frameNo++;

frame1.syncPhase = frame2.syncPhase = frame3.syncPhase = 0;

CombineFrame();

}

}

partial class SyncFrame

{

public void TakeFrame((int leftmost, Complex32[] carriers)[] frame)

{

_symbols.CopyFromRingBuffer(frame, _symbolsIndex - 221);

Equalize(frame);

}

private void CopyFrame((int leftmost, Complex32[] carriers)[] frame)

=> _symbols.CopyFromRingBuffer(frame, _symbolsIndex - 221);

private void Equalize((int leftmost, Complex32[] carriers)[] frame)

{

for (int symbolNo = 0; symbolNo < frame.Length; symbolNo++)

{

var (leftmost, carriers) = frame[symbolNo];

for (int i = 0; i < 5616; i += 12)

{

var j = i - leftmost;

if (0 <= j && j + 12 < carriers.Length)

{

var a = (

carriers[j + symbolNo % 4 * 3] *

wi[i + symbolNo % 4 * 3]).Reciprocal();

for (int k = 0; k < 12; k++)

{

carriers[j + k] *= a;

}

}

}

}

}

}

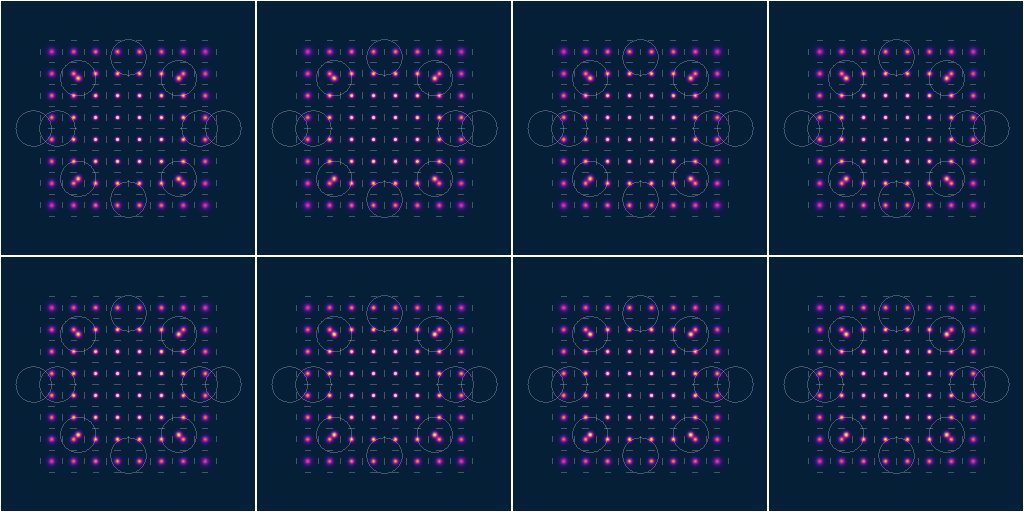

コンスタレーションを画像化すると以下のようになります。

左から順に低周波側、中間付近、高周波付近のそれぞれで受信したコンスタレーションと、すべてのキャリアを結合した際のコンスタレーションです。

星が綺麗ですね。

DBPSK、QPSK、64QAMが綺麗に並んでいて、QAMは中央からの距離に応じて膨らんでいる様子も見えます。

蛇足:WAVファイルへ保存

フルセグメントの全キャリアが得られたので、IFFTやガードインターバル付与を行ってWAVに保存するとフルセグ相当のIQファイルをSDR#等で読み込むことができるようになります。

まあ、見て面白いものではありませんが。

心の目で見るとSeg.No.0のQPSKが他と違うように見えるような気がします。

もちろんこのIQファイルを使用してフルセグのTSを抜くことも可能です。送信波形を直接保存しているのでサンプリングクロックのエラーも無く、非常に処理しやすいです。

データキャリアの抽出、周波数インターリーブの解除

ISDB-Tにはパイロット信号やAC/TMCC等補助的な情報が1/9の割合で挿入されています。これらの補助キャリアを除去してデータキャリアの取り出しを行います。合わせて周波数方向のインターリーブの解除も行います。

都度ロジックで計算しようとするとかなり大変なので、予めルックアップテーブルを作成しておき、それを使用してデータキャリアの抽出やインターリーブ解除を行います。

パイロット信号や補助信号の除去はコンスタレーションを見れば正しく動いているか判断できますが、周波数インターリーブの解除はコンスタレーションを見ても正しいか否かを判断することができません。自前で実装する場合はまずB31に従って正インターリーブを実装し、そのデータを正しく戻せる逆インターリーブを実装するような流れで行います。そしてビタビ復号まで実装し、正しく動けばめでたく一件落着、動かなければ怪しい場所を片っ端から手当たり次第に虱潰しに探す、みたいな流れになります。

データキャリアの抽出、周波数インターリーブの解除

int[][] GenerateDataCarrierLUT()

{

var LUT = Enumerable.Range(0, 4992).ToArray();

InterSegmentCarrierInterleaving(LUT, [1, 12]);

IntraSegmentCarrierInterleaving(LUT);

IntraSegmentRandomizing(LUT);

LogicalToPhysical(LUT);

Inverse(LUT);

return

Enumerable.Range(0, 4)

.Select(i => SkipPilotAcAndTmcc(LUT, i, _ACandTMCCFullSeg))

.ToArray();

; static void InterSegmentCarrierInterleaving(Span<int> LUT, ReadOnlySpan<int> segments)

{

using var dispose = ArrayPoolWrapper.Rent(LUT.Length, out Span<int> tmp);

LUT.CopyTo(tmp);

foreach (var n in segments)

{

var src = tmp[..(n * 384)];

var dst = LUT[..(n * 384)];

for (int i = 0, j = 0, k = 0; i < src.Length; i++, j += n)

{

if (src.Length <= j)

{

j = ++k;

}

dst[i] = src[j];

}

tmp = tmp[src.Length..];

LUT = LUT[dst.Length..];

}

}

; static void IntraSegmentCarrierInterleaving(Span<int> LUT)

{

using var dispose = ArrayPoolWrapper.Rent(LUT.Length, out Span<int> tmp);

LUT.CopyTo(tmp);

for (int i = 0, j = 0; j < LUT.Length; i++, j += 384)

{

var src = tmp.Slice(j, 384);

var dst = LUT.Slice(j, 384);

src[i..].CopyTo(dst);

src[..i].CopyTo(dst[^i..]);

}

}

; static void IntraSegmentRandomizing(Span<int> LUT)

{

int[] intraSegmentCarrierRandomizing = {

62, 13, 371, 11, 285, 336, 365, 220, 226, 92, 56, 46, 120, 175, 298, 352, 172, 235, 53, 164, 368, 187, 125, 82,

5, 45, 173, 258, 135, 182, 141, 273, 126, 264, 286, 88, 233, 61, 249, 367, 310, 179, 155, 57, 123, 208, 14, 227,

100, 311, 205, 79, 184, 185, 328, 77, 115, 277, 112, 20, 199, 178, 143, 152, 215, 204, 139, 234, 358, 192, 309, 183,

81, 129, 256, 314, 101, 43, 97, 324, 142, 157, 90, 214, 102, 29, 303, 363, 261, 31, 22, 52, 305, 301, 293, 177,

116, 296, 85, 196, 191, 114, 58, 198, 16, 167, 145, 119, 245, 113, 295, 193, 232, 17, 108, 283, 246, 64, 237, 189,

128, 373, 302, 320, 239, 335, 356, 39, 347, 351, 73, 158, 276, 243, 99, 38, 287, 3, 330, 153, 315, 117, 289, 213,

210, 149, 383, 337, 339, 151, 241, 321, 217, 30, 334, 161, 322, 49, 176, 359, 12, 346, 60, 28, 229, 265, 288, 225,

382, 59, 181, 170, 319, 341, 86, 251, 133, 344, 361, 109, 44, 369, 268, 257, 323, 55, 317, 381, 121, 360, 260, 275,

190, 19, 63, 18, 248, 9, 240, 211, 150, 230, 332, 231, 71, 255, 350, 355, 83, 87, 154, 218, 138, 269, 348, 130,

160, 278, 377, 216, 236, 308, 223, 254, 25, 98, 300, 201, 137, 219, 36, 325, 124, 66, 353, 169, 21, 35, 107, 50,

106, 333, 326, 262, 252, 271, 263, 372, 136, 0, 366, 206, 159, 122, 188, 6, 284, 96, 26, 200, 197, 186, 345, 340,

349, 103, 84, 228, 212, 2, 67, 318, 1, 74, 342, 166, 194, 33, 68, 267, 111, 118, 140, 195, 105, 202, 291, 259,

23, 171, 65, 281, 24, 165, 8, 94, 222, 331, 34, 238, 364, 376, 266, 89, 80, 253, 163, 280, 247, 4, 362, 379,

290, 279, 54, 78, 180, 72, 316, 282, 131, 207, 343, 370, 306, 221, 132, 7, 148, 299, 168, 224, 48, 47, 357, 313,

75, 104, 70, 147, 40, 110, 374, 69, 146, 37, 375, 354, 174, 41, 32, 304, 307, 312, 15, 272, 134, 242, 203, 209,

380, 162, 297, 327, 10, 93, 42, 250, 156, 338, 292, 144, 378, 294, 329, 127, 270, 76, 95, 91, 244, 274, 27, 51,

};

using var dispose = ArrayPoolWrapper.Rent(LUT.Length, out Span<int> tmp);

LUT.CopyTo(tmp);

for (int i = 0; i < LUT.Length; i += 384)

{

var src = tmp.Slice(i, 384);

var dst = LUT.Slice(i, 384);

for (int j = 0; j < 384; j++)

{

dst[intraSegmentCarrierRandomizing[j]] = src[j];

}

}

}

; static void LogicalToPhysical(Span<int> LUT)

{

using var dispose = ArrayPoolWrapper.Rent(LUT.Length, out Span<int> tmp);

LUT.CopyTo(tmp);

ReadOnlySpan<int> foo = [11, 9, 7, 5, 3, 1, 0, 2, 4, 6, 8, 10, 12];

for (int i = 0; i < foo.Length; i++)

{

tmp.Slice(foo[i] * 384, 384).CopyTo(LUT.Slice(i * 384, 384));

}

}

; static void Inverse(Span<int> items)

{

using var dispose = ArrayPoolWrapper.Rent(items.Length, out Span<int> tmp);

for (int i = 0; i < tmp.Length; i++) { tmp[i] = i; }

items.Sort(tmp);

tmp.CopyTo(items);

}

; static int[] SkipPilotAcAndTmcc(ReadOnlySpan<int> LUT, int symbolN, ReadOnlySpan<int> skips)

{

var sp = symbolN % 4 * 3;

using var dispose = ArrayPoolWrapper.Rent(LUT.Length, out Span<int> tmp);

for (int i = 0, j = 0; i < LUT.Length; i++, j++)

{

while (j % 12 == sp || skips.Contains(j))

{

j++;

}

tmp[i] = j;

}

var result = new int[LUT.Length];

for (int i = 0; i < result.Length; i++)

{

result[i] = tmp[LUT[i]];

}

return result;

}

}

var DataCarrierLUT = GenerateDataCarrierLUT();

Complex32[][] dataCarrierFrame = Enumerable.Range(0, 204).Select(_ => new Complex32[4992]).ToArray();

void TakeDataCarrier()

{

var src = majorFrame;

var dst = dataCarrierFrame;

var LUT = DataCarrierLUT;

for (int i = 0; i < src.Length; i++)

{

var foo = src[i];

var bar = dst[i];

var hoge = LUT[i % LUT.Length];

for (int j = 0; j < bar.Length; j++)

{

bar[j] = foo[hoge[j]];

}

}

}

for (int frameNo = 0; frameNo < 8;)

{

try

{

LoadFrame(symbols1, loader1, cfo1, syncFrame1, ref frame1, equalizedFrame1);

LoadFrame(symbols2, loader2, cfo2, syncFrame2, ref frame2, equalizedFrame2);

LoadFrame(symbols3, loader3, cfo3, syncFrame3, ref frame3, equalizedFrame3);

}

catch (IOException) { break; }

if (frame1.syncPhase == 0 ||

frame1.syncPhase != frame2.syncPhase ||

frame1.syncPhase != frame3.syncPhase)

{ continue; }

frameNo++;

frame1.syncPhase = frame2.syncPhase = frame3.syncPhase = 0;

CombineFrame();

TakeDataCarrier();

}

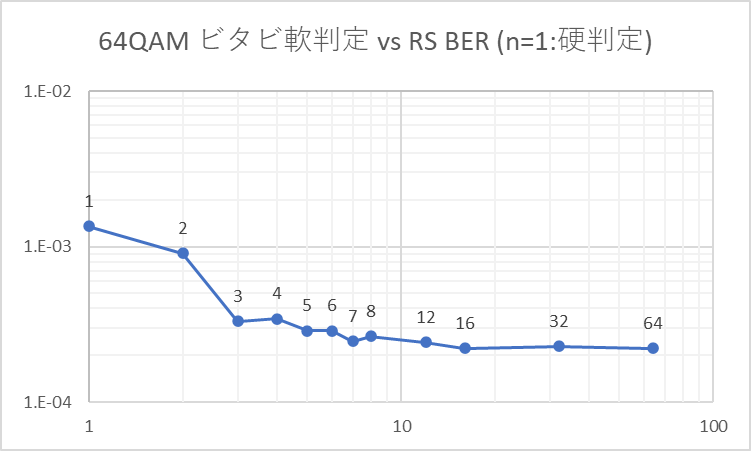

データキャリアを抽出したコンスタレーションは以下のようになります(1フレーム分毎に8フレーム分)。

パイロット信号、AC1、TMCCのBPSKが除去され、QPSK/64QAMだけが見えています。BPSKが除去されたからと言ってデインターリーブも正しく動いているとは限りませんが、とりあえず正しく動いているはずだと期待して次に進みます。

時間インターリーブ解除、階層分割、デマッピング、デパンクチャ、ビタビ復調

時間インターリーブ解除からビタビ復調までは途中で動作確認が難しいので、一気に進めます(だいぶ長い)。

時間デインターリーブ・階層分割も周波数デインターリーブと同様に、B31に従って正変換を実装してから逆変換を実装する、というような流れで実装します(今回はすでに長くなりすぎているので、正しく動いていると考えられる逆変換のコードしか掲載していませんが)。

時間インターリーブ解除、階層分割、デマッピング、デパンクチャ、ビタビ復調

#region 時間デインターリーブ

Queue<Complex32>[] timeDeInterleavingQueues;

{

; static IEnumerable<Queue<Complex32>> F(int I, int n)

=> Enumerable.Range(0, n)

.SelectMany(_ =>

Enumerable.Range(0, 384)

.Select(i => new Queue<Complex32>(new Complex32[I * (95 - i * 5 % 96)])));

timeDeInterleavingQueues = [

.. F(4, 1),

.. F(2, 12),

];

}

void TimeDeInterleaving()

{

var queues = timeDeInterleavingQueues;

foreach (var tmp in dataCarrierFrame)

{

for (int i = 0; i < tmp.Length; i++)

{

var q = queues[i];

q.Enqueue(tmp[i]);

tmp[i] = q.Dequeue();

}

}

}

#endregion

#region 階層分割

var layerACarriers = new Complex32[204 * 384 * 1];

var layerBCarriers = new Complex32[204 * 384 * 12];

void LayerDivision()

{

var dstA = layerACarriers;

var dstB = layerBCarriers;

var dstAPointer = 0;

var dstBPointer = 0;

foreach (var src in dataCarrierFrame)

{

; static void Copy(ReadOnlySpan<Complex32> src, Span<Complex32> dst, ref int srcPointer, ref int dstPointer, int N)

{

src.Slice(srcPointer, N).CopyTo(dst[dstPointer..]);

srcPointer += N;

dstPointer += N;

}

int srcPointer = 0;

Copy(src, dstA, ref srcPointer, ref dstAPointer, 384 * 1);

Copy(src, dstB, ref srcPointer, ref dstBPointer, 384 * 12);

}

}

#endregion

#region デマッピング

var bitDeInterleavingA = new Queue<sbyte>(new sbyte[120]);

var bitDeInterleavingB = (

new Queue<sbyte>(new sbyte[120]),

new Queue<sbyte>(new sbyte[96]),

new Queue<sbyte>(new sbyte[72]),

new Queue<sbyte>(new sbyte[48]),

new Queue<sbyte>(new sbyte[24]));

var layerAPuncturedBits = new sbyte[layerACarriers.Length * 2];

var layerBPuncturedBits = new sbyte[layerBCarriers.Length * 6];

void DemappingA()

{

var src = layerACarriers;

var dst = layerAPuncturedBits;

var d0 = bitDeInterleavingA;

const sbyte zer = 0;

const sbyte one = 2;

for (int i = 0, j = 0; i < src.Length; i++)

{

var a = src[i];

var re = a.Real;

var im = a.Imaginary;

var b0 = 0 < re ? zer : one;

var b1 = 0 < im ? zer : one;

d0.Enqueue(b0); b0 = d0.Dequeue();

dst[j++] = b0;

dst[j++] = b1;

}

}

void DemappingB()

{

var src = layerBCarriers;

var dst = layerBPuncturedBits;

var (d0, d1, d2, d3, d4) = bitDeInterleavingB;

const sbyte zer = 0;

const sbyte one = 2;

var scale = float.Sqrt(42);

for (int i = 0, j = 0; i < src.Length; i++)

{

var a = src[i] * scale;

var re = a.Real;

var im = a.Imaginary;

sbyte b0, b1, b2, b3, b4, b5;

(b0, b2, b4) =

re < -6 ? (one, zer, zer) :

re < -4 ? (one, zer, one) :

re < -2 ? (one, one, one) :

re < -0 ? (one, one, zer) :

re < +2 ? (zer, one, zer) :

re < +4 ? (zer, one, one) :

re < +6 ? (zer, zer, one) :

(zer, zer, zer);

(b1, b3, b5) =

im < -6 ? (one, zer, zer) :

im < -4 ? (one, zer, one) :

im < -2 ? (one, one, one) :

im < -0 ? (one, one, zer) :

im < +2 ? (zer, one, zer) :

im < +4 ? (zer, one, one) :

im < +6 ? (zer, zer, one) :

(zer, zer, zer);

d0.Enqueue(b0); b0 = d0.Dequeue();

d1.Enqueue(b1); b1 = d1.Dequeue();

d2.Enqueue(b2); b2 = d2.Dequeue();

d3.Enqueue(b3); b3 = d3.Dequeue();

d4.Enqueue(b4); b4 = d4.Dequeue();

dst[j++] = b0;

dst[j++] = b1;

dst[j++] = b2;

dst[j++] = b3;

dst[j++] = b4;

dst[j++] = b5;

}

}

#endregion

#region デパンクチャ

var layerADepuncturedBits = new (sbyte, sbyte)[layerAPuncturedBits.Length * 2 / 3];

var layerBDepuncturedBits = new (sbyte, sbyte)[layerBPuncturedBits.Length * 3 / 4];

void DepunctureA()

{

var src = layerAPuncturedBits;

var dst = layerADepuncturedBits;

sbyte X1, Y1, X2, Y2;

X2 = 1;

for (int i = 0, j = 0; i < src.Length;)

{

X1 = src[i++];

Y1 = src[i++];

Y2 = src[i++];

dst[j++] = (X1, Y1);

dst[j++] = (X2, Y2);

}

}

void DepunctureB()

{

var src = layerBPuncturedBits;

var dst = layerBDepuncturedBits;

sbyte X1, Y1, X2, Y2, X3, Y3;

X2 = Y3 = 1;

for (int i = 0, j = 0; i < src.Length;)

{

X1 = src[i++];

Y1 = src[i++];

Y2 = src[i++];

X3 = src[i++];

dst[j++] = (X1, Y1);

dst[j++] = (X2, Y2);

dst[j++] = (X3, Y3);

}

}

#endregion

#region 畳み込み符号、バイナリを16進で保存

var bytedata = new byte[layerBDepuncturedBits.Length / 8];

Convolution convolution = new("171", "133", 0, 2);

void DumpHex204byteBlock(ReadOnlySpan<byte> data, int blockSize)

{

for (int i = 0; i < data.Length;)

{

for (int j = 0; j < blockSize; i++, j++)

{

sw.Write($"{data[i]:X2} ");

}

sw.WriteLine();

}

}

#endregion

for (int frameNo = 0; frameNo < 5;)

{

try

{

LoadFrame(symbols1, loader1, cfo1, syncFrame1, ref frame1, equalizedFrame1);

LoadFrame(symbols2, loader2, cfo2, syncFrame2, ref frame2, equalizedFrame2);

LoadFrame(symbols3, loader3, cfo3, syncFrame3, ref frame3, equalizedFrame3);

}

catch (IOException) { break; }

if (frame1.syncPhase == 0 ||

frame1.syncPhase != frame2.syncPhase ||

frame1.syncPhase != frame3.syncPhase)

{ continue; }

Console.Write(++frameNo);

frame1.syncPhase = frame2.syncPhase = frame3.syncPhase = 0;

CombineFrame();

TakeDataCarrier();

TimeDeInterleaving();

LayerDivision();

DemappingA();

DemappingB();

DepunctureA();

DepunctureB();

List<int> distance = [];

var dst = convolution.Viterbi(layerADepuncturedBits, bytedata, 204, a => { distance.Add(a[56]); return 56; });

sw.WriteLine($"Layer A {distance.Average():0.00}");

DumpHex204byteBlock(dst, 204);

distance.Clear();

dst = convolution.Viterbi(layerBDepuncturedBits, bytedata, 204, a => { distance.Add(a[56]); return 56; });

sw.WriteLine($"Layer B {distance.Average():0.00}");

DumpHex204byteBlock(dst, 204);

Console.WriteLine();

}

class Convolution

{

public (sbyte Zero, sbyte One) Bits { get; init; }

public int K { get; init; }

private readonly uint _G1, _G2, _OR;

private readonly (sbyte X, sbyte Y)[] _table;

private readonly int[] _pathmetrics1, _pathmetrics2;

private int[][] _pointers = [];

#region コンストラクタ

public Convolution(uint G1, uint G2, sbyte bitZero, sbyte bitOne)

{

var log2 = BitOperations.Log2(G1 | G2);

var OR = 1U << log2;

(Bits, K, _G1, _G2, _OR) = ((bitZero, bitOne), log2 + 1, G1, G2, OR);

_table =

Enumerable.Range(0, 1 << K)

.Select(i => (

(BitOperations.PopCount((uint)i & G1) & 1) == 0 ? bitZero : bitOne,

(BitOperations.PopCount((uint)i & G2) & 1) == 0 ? bitZero : bitOne))

.ToArray();

_pathmetrics1 = new int[OR];

_pathmetrics2 = new int[OR];

}

public Convolution(string G1, string G2, sbyte bitZero, sbyte bitOne)

: this(Convert.ToUInt32(G1, 8), Convert.ToUInt32(G2, 8), bitZero, bitOne) { }

#endregion

#region エンコーダ

public (uint reg, (sbyte X, sbyte Y)[]) Encode(in ReadOnlySpan<byte> src, uint reg = 0)

{

var dst = new (sbyte, sbyte)[src.Length * 8];

for (int iSrc = 0, iDst = 0; iSrc < src.Length;)

{

for (int a = 0x80, b = src[iSrc++]; a != 0; a >>= 1)

{

if ((a & b) != 0)

{

reg |= _OR;

}

dst[iDst++] = _table[reg];

reg >>= 1;

}

}

return (reg, dst);

}

#endregion

#region デコーダ

public Span<byte> Viterbi(

in ReadOnlySpan<(sbyte X, sbyte Y)> src,

in Span<byte> dst,

in int blockSize,

in Func<int[], int>? pathSelector = null)

{

int i, j;

for (i = j = 0; i < src.Length; i += blockSize * 8, j += blockSize)

{

Viterbi(

src.Slice(i, blockSize * 8),

dst.Slice(j, blockSize),

pathSelector);

}

return dst[..j];

}

public void Viterbi(

in ReadOnlySpan<(sbyte X, sbyte Y)> src,

in Span<byte> dst,

in Func<int[], int>? pathSelector = null)

{

if (dst.Length * 8 != src.Length)

{

throw new InvalidOperationException();

}

var pointers = _pointers;

var OR = (int)_OR;