はじめに

Power BIのデータフロー。便利なのにあまり活用している話を聞かない。地味だからなのかな。

データフローの魅力を伝えるために、10月のPower BI勉強会で話したことをブログにまとめました。

大前提

データフロー大好き🎉

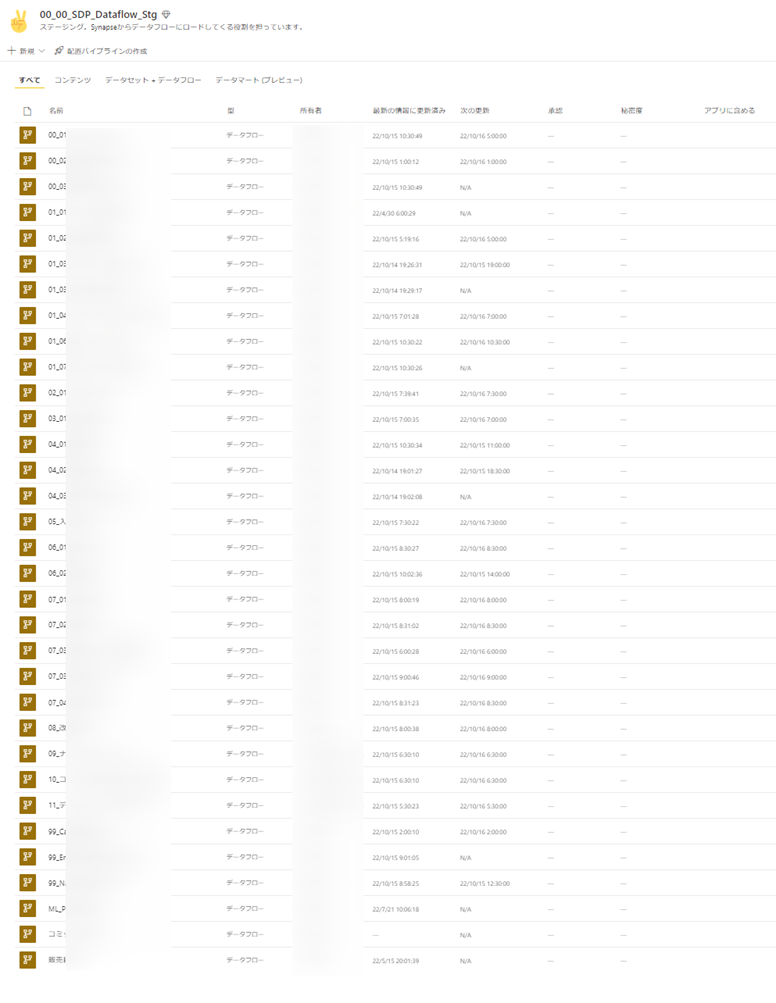

データフローを活用して社内のデータ管理もしています。社内の実環境でも、データフローがたーくさんあり、データ分析基盤のなかで重要な位置づけになっています。

データフローとは(概要)

データの量は増え続けるので、データを整った形式のアクションにつながる情報に変換することが課題です。大量のデータをアクションにつながる分析情報に迅速に変換できるよう、分析を行ったり、ビジュアル、レポート、ダッシュボードに設定したりする準備が整っているデータが必要です。Power BI のビッグ データに対するセルフサービスのデータ準備を使用すると、ほんの数クリックでデータを Power BI の分析情報にできます。

公式ドキュメントには上記のように書いてあり、つまりデータの加工を行う場所・機能であるということがわかります。

更に具体的には、Power BI Serviceからデータフローは作成することができ、ExcelやPower BI DesktopのPower Queryとほぼ同じUIの画面が開きます。Power Query Onlineとも呼びます。

データフローとは(2回目)

先程のドキュメントをさらに読み進めていくと、以下のような記載があります。

-

Power BI 内の多くのデータセットおよびレポートで共有できる再利用可能な変換ロジックを作成します。

-

基になるシステムに接続するのではなく、アナリストにデータフローへの接続を強制することで、信頼できる単一の情報源を作成し、アクセスするデータと、データをレポート作成者に公開する方法を制御することができます。

-

大量のデータを処理して ETL を大規模に実行する場合、Power BI Premium を使用したデータフローはより効率的に拡張され、柔軟性が向上します。 データフローにより、さまざまなクラウドおよびオンプレミスのソースがサポートされます。

-

アナリストが基になるデータ ソースに直接アクセスするのを防ぎます。 レポート作成者はデータフローに基づいて作成できるため、基になるデータソースへのアクセスを少数の個人にのみ許可し、アナリストがデータフローにアクセスし、それに基づいて作成できるようにする方が便利な場合があります。 このアプローチを使用すると、基になるシステムへの負荷が削減され、管理者は、システムが更新から読み込まれるタイミングをより細かく制御できます。

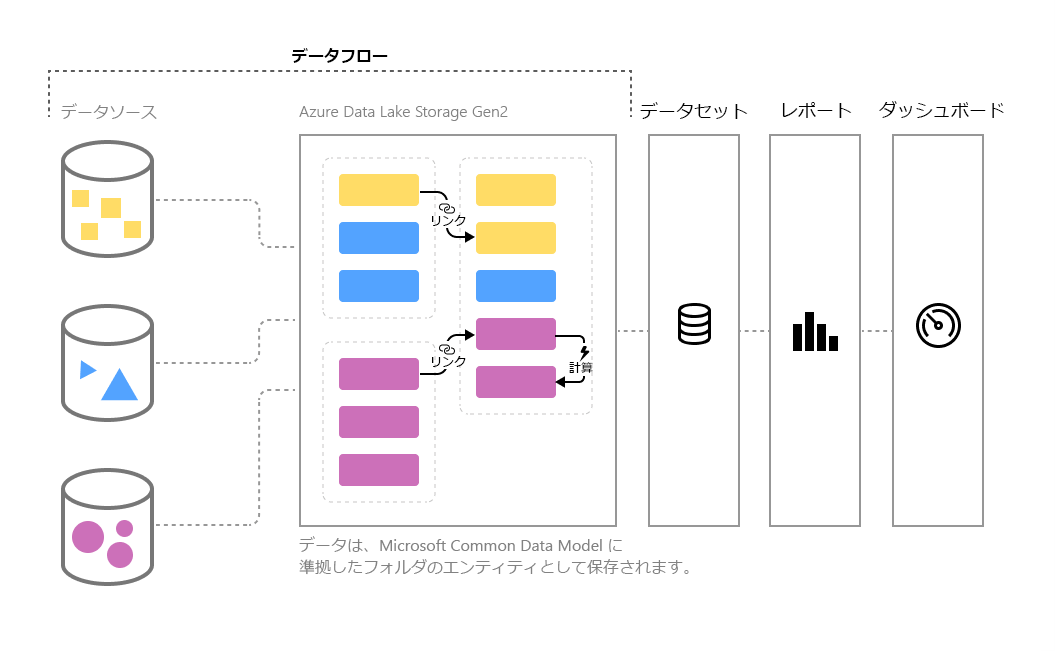

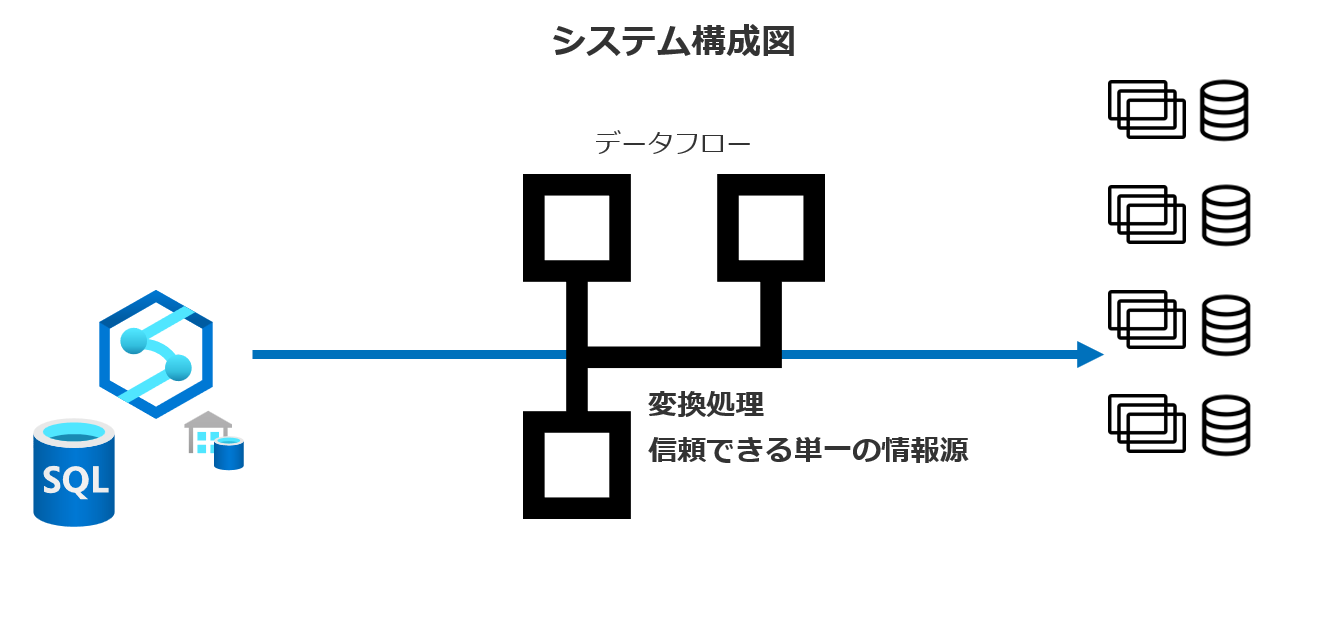

データフロー図解

という、文字でつらつら書いてあることを図解してみます。

上図のようにデータソースにPower BIから直接接続することは往々にしてある形式です。Power BIには豊富なコネクターが用意されています。直接接続できるデータソースが多いのも製品の魅力の一つですよね。

しかし…

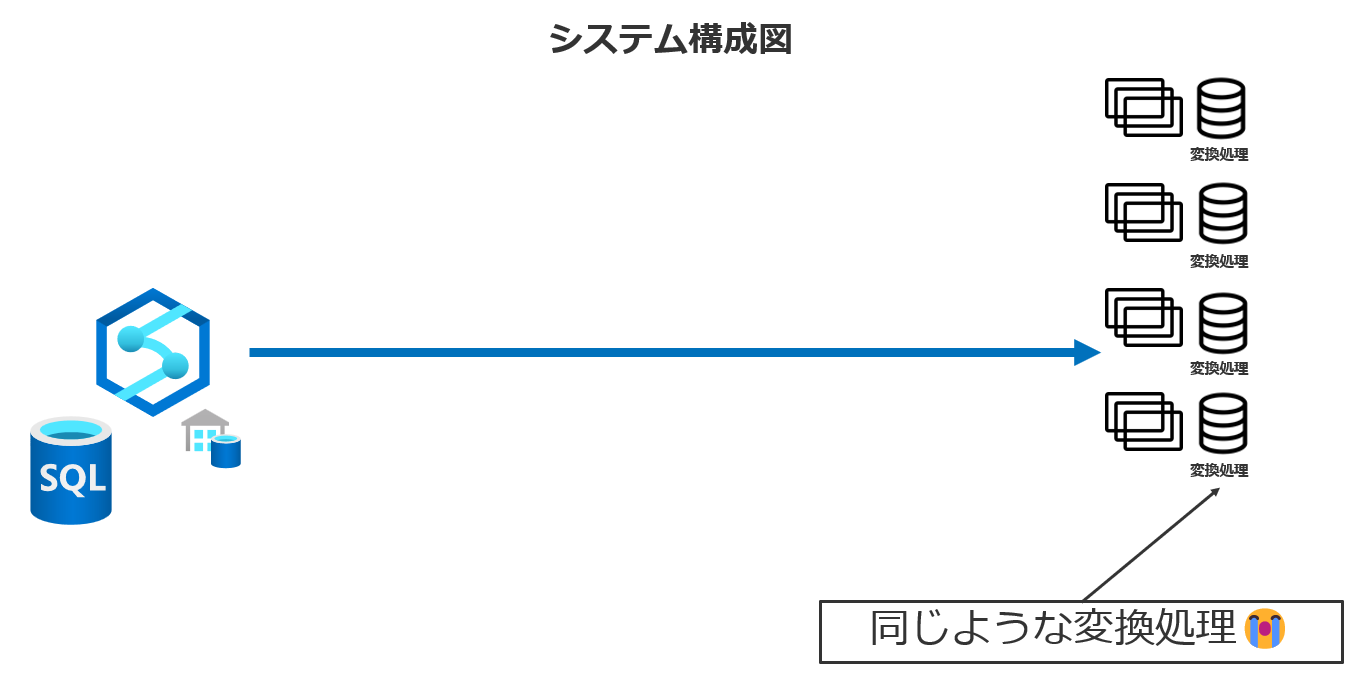

データソースに直接接続してBIを進めていくと、同じようなデータ加工処理がそれぞれのデータセット上で行われていることが起こりえます。同じようなデータ加工処理をそれぞれが行うと、もちろん時間の無駄もありますし、計算リソースの無駄も起こります。さらに、当然、同じ処理をしているとおもっていても、人間ですから、間違うことだってあります。見るレポートによって数字が違うなんてあってはいけないですよね👊

ここででてくるのがDataflowです😁

それぞれ末端のユーザーがしていた同じような加工集計処理を、間に挟んだDataflowで行うことで加工集計を各ユーザーが行う必要がなくなります。便利ですよね。

そして、加工処理を一箇所で行うことになるので、信頼できる単一の情報源になります。再利用可能な変換ロジックですので、このデータをもとにさらに細かくデータ加工を行っていくこともできます。

もちろん、同じように、ユーザーが使いやすそうなテーブルを最上流のデータソース側で作成することも可能です。可能ですが、やはり、時間がかかります😭 データエンジニアに頼んで、数日待って、ようやくデータが完成する。アクセスしてみたら、思ってたのとちょっと違う😭ありますよね。

DataflowはPower Queryと同じUIですから、ユーザー自身でデータの加工集計を行うことができます。思い立ったらすぐ、希望のデータを自分で生み出すことができます。

Dataflowを分析基盤に活用することで、ビジネスを止めることなく、分析可視化を続けられます。加工処理を上流に移すのは、その加工処理が長期的に必要だということが確定したあとにやればいいという考え方もできるかもしれません。

Power BI Premium の Dataflow

Power BI PremiumのライセンスをもっているとDataflowは更に進化します💪

拡張コンピューティング エンジンの使用

- CSVではなくSQL Databaseに保存

- joins や group by 演算など) を実行する計算テーブルのパフォーマンスが向上💪

計算対象エンティティ/リンクされたエンティティ

- 計算列の追加ができる。

- 処理を段階に分けた実装が可能

- メダリオンアーキテクチャをPower BI Service内に作成できる

増分更新

データフローで増分更新の設定が可能

データフローへのダイレクトクエリ

これは純粋に便利😁

データソースへのアクセス負荷軽減も考えられる。

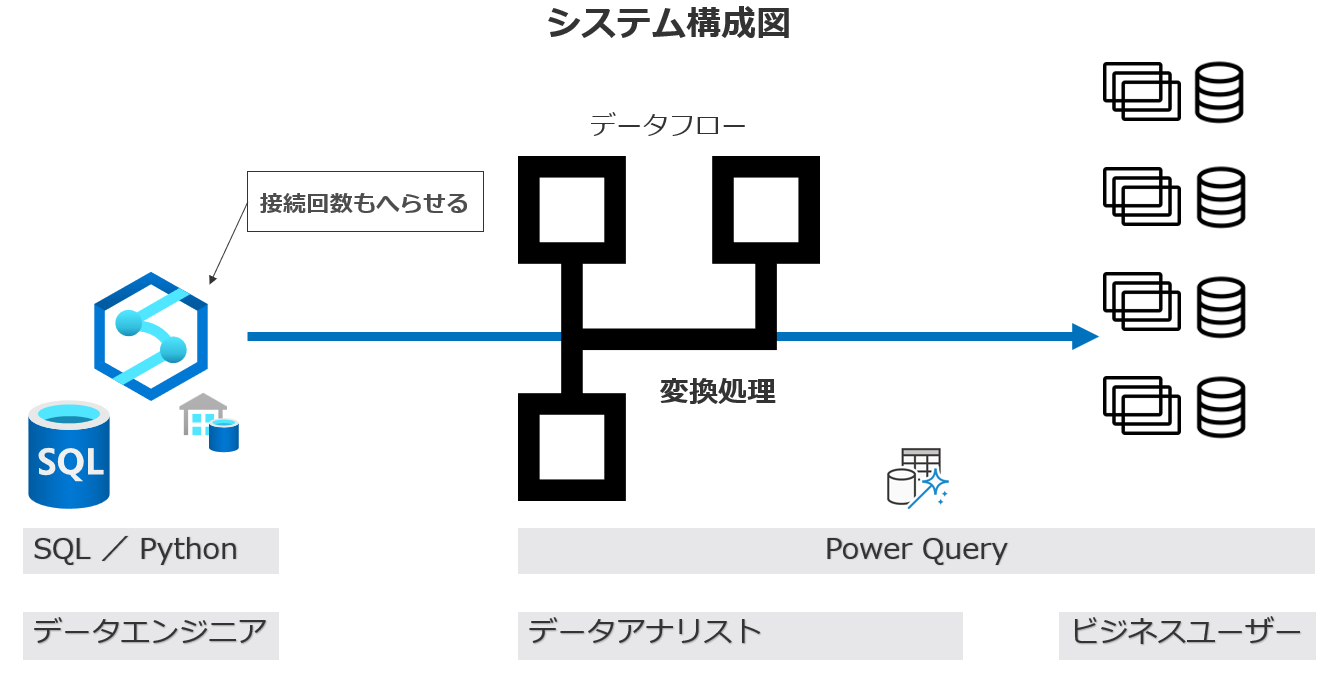

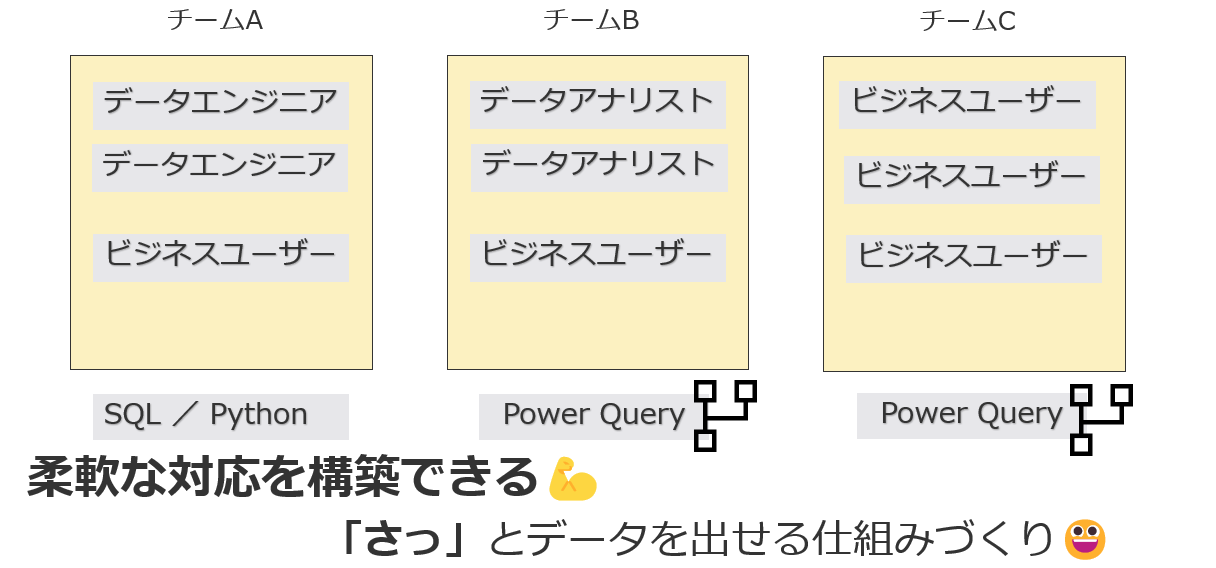

データ加工集計をどこで行うのか

これは答えはなく、社内の組織・チームによって変わってきます。しかし重要なことは上流で行うこと。また、役割分担を明確にすること。

データエンジニアがチーム内にいるのであれば、SQLデータベースが上流となり、必要なスキルはSQLやPythonになるでしょう。

データエンジニアがチーム内にいないのであれば、データフローを活用することで、アナリストやビジネスユーザーだけでもBI・可視化・分析を行うことができるのがPower BIの強みだと考えます🎉

組織やチームに応じて、最適な構成をサッと提供できる管理者も重要な役割になりますね😁

まとめ

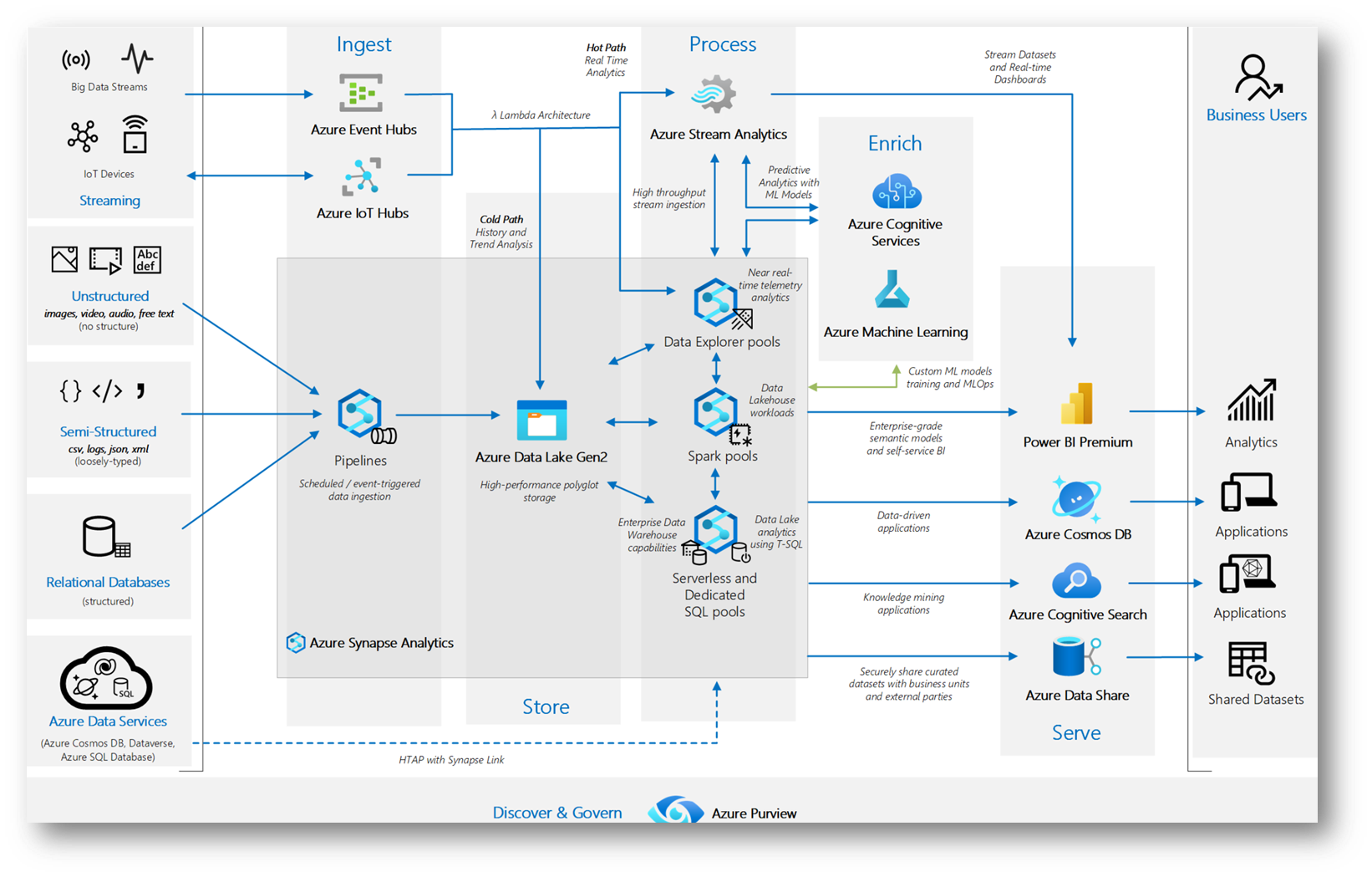

Power BIを可視化ツールと捉えてしまうと思考が止まります。Power BI ServiceはDataflowやDatamartも含めて、幅広い機能を持っています。

こういったアーキテクチャを見ると、Power BIは可視化ツールとして右端の方に置かれていることが多いです。が、実態は、Power BIの世界の中でもETLをすることはできて、アーキテクチャを構成することができてしまいます。

Power BI Premiumの環境だと、Dataflowを活用して、逆にデータベース側の処理能力を落とす=コスト削減を考えることだってできます。

データ分析、データ加工、アーキテクチャ・・終わりはありません、みんなで考えましょう。そして、いいアイデアはぜひシェアし合いましょう!😁

Happy Power BI !🎉