はじめに

GitHub CopilotやCursorなどのAIコードエディタが一時期話題になったものの、無料版だと回数制限などの制限があるらしくソフトウェアエンジニアでもない自分がわざわざ導入して使ってみるほどではないかなと思い今までスルーしていた。

Visual Studio Codeの拡張機能のContinueを使えばローカルLLM対応で自前のPCでAI処理の計算をするのであれば完全無料で使えるとのことなので少しだけ試してみようかなと思い今回インストールした。

今回は本当にただ導入しただけなのでAIコーディングを使いこなせているわけではないので、本業の人からしたら今更かよと思われそうな内容なのはご了承願います。

各種ダウンロード

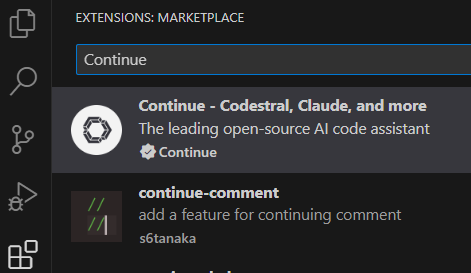

VScode拡張機能Continue

VScodeの拡張機能の検索窓からContinueを検索しインストールする。

ローカルLLMOllama

今回ローカルLLMとしてはOllamaをインストールした。

Ollamaのインストールはwingetコマンドからインストールできる。

Powershellから一行叩くだけで簡単インストールできます。

winget install -e --id Ollama.Ollama

コーディングAIモデルQwen2.5-Coder

Ollama公式サイトによるとQwen2.5-Coderというコーディングに特化したAIモデルがあるらしく試しにインストールしてみた。

参考までに今回はこちらのLLMでの選び方を参考にAIモデルのサイズを選んだ。

以下、LLMでの選び方より引用。

| LLM のパラメータ数 | 必要なメモリ |

|---|---|

| 7B (70億) | 8GB程度 |

| 13B (130億) | 16GB程度 |

| 70B (700億) | 64GB程度 |

現在のPC環境がRTX3060 12GB版を使用しているため7Bを選択した。

Windows Powershellからollama run qwen2.5-coder:7bをコピペしてそのまま貼り付けて実行してAIモデルのダウンロードする。

AIモデルのダウンロードはrunとpullのどちらでもやってもらえるっぽいです。

> ollama run qwen2.5-coder:7b

pulling manifest

pulling 60e05f210007... 100% ▕████████████████████████████████████████████████████████▏ 4.7 GB

pulling 66b9ea09bd5b... 100% ▕████████████████████████████████████████████████████████▏ 68 B

pulling e94a8ecb9327... 100% ▕████████████████████████████████████████████████████████▏ 1.6 KB

pulling 832dd9e00a68... 100% ▕████████████████████████████████████████████████████████▏ 11 KB

pulling d9bb33f27869... 100% ▕████████████████████████████████████████████████████████▏ 487 B

verifying sha256 digest

writing manifest

success

>>>

ここまでできたのでPowershellを閉じた。

OllamaのAIモデル一括更新

OllamaのAIモデルを一括でバージョンアップするスクリプトを発見。

@echo off

setlocal enabledelayedexpansion

rem List all models and skip the first line

for /f "skip=1 tokens=*" %%i in ('ollama list') do (

rem Extract the model name from the output

set "model=%%i"

rem Split the model name from the rest of the line (assuming space-separated)

for /f "tokens=1" %%j in ("!model!") do (

rem Pull the model using ollama

ollama pull %%j

)

)

endlocal

上記の内容でbatファイルを作成した。

Ollamaで導入したAIモデルを一括でアップグレードできる。

ContinueでAIコーディングを試す

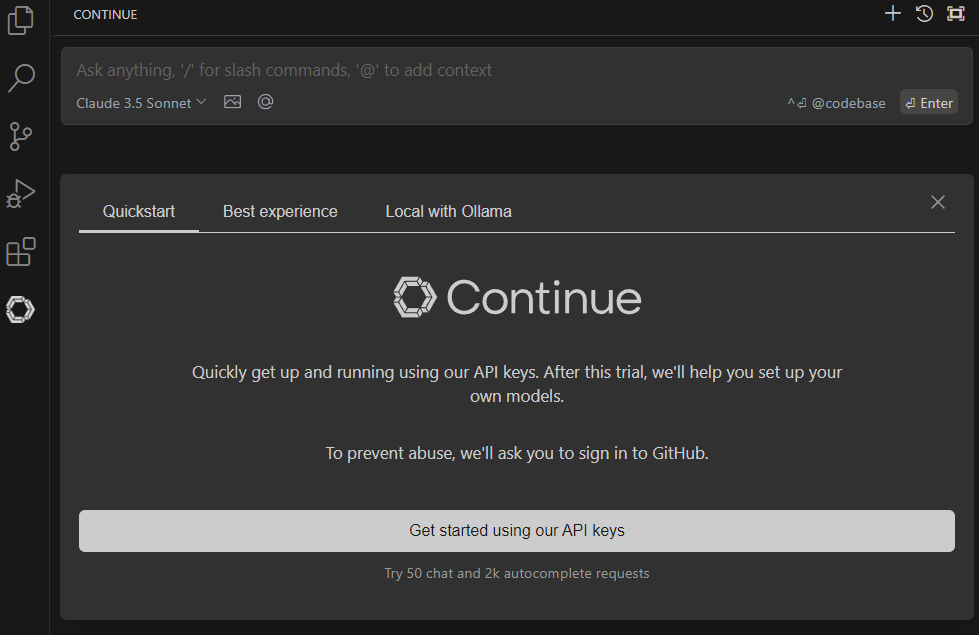

ContinueでローカルLLMのAIモデルを選択

Continueを起動してGet started using our API keysを選択する。

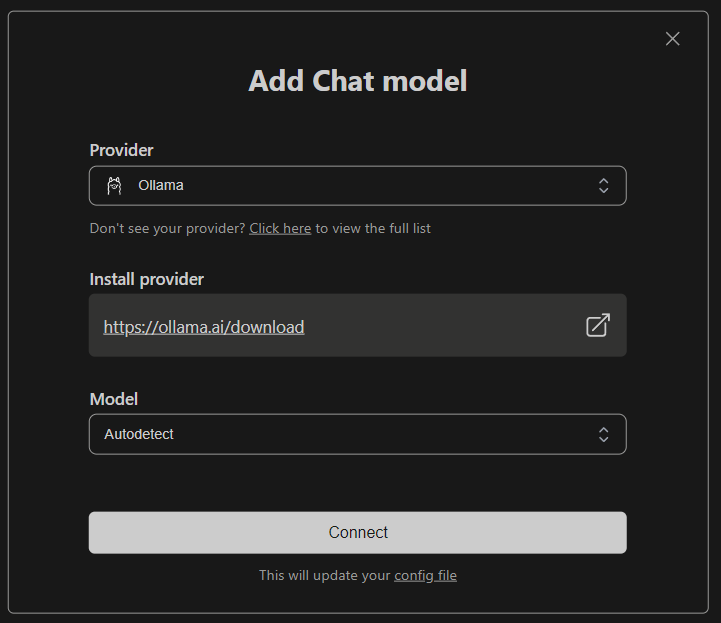

Add Chat modelからOllama、Autodetectを選択する。

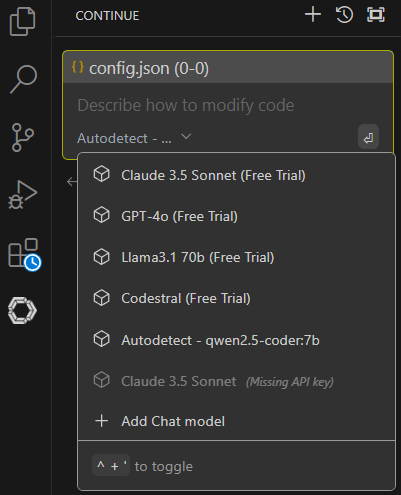

任意のAIモデルを選ぶ、Autodetectで検出されたAutodetect - qwen2.5-code:7bを選択した。

C言語のHello Worldを書かせてみる

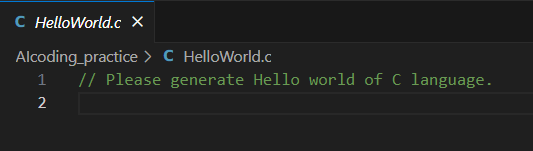

C言語のファイルを作成してプログラミングではおなじみのHello Worldのコードが書けるかを試す。

ここまでは通常通りに作成。

今回はAIcording_practice>HelloWorld.cを作成した。

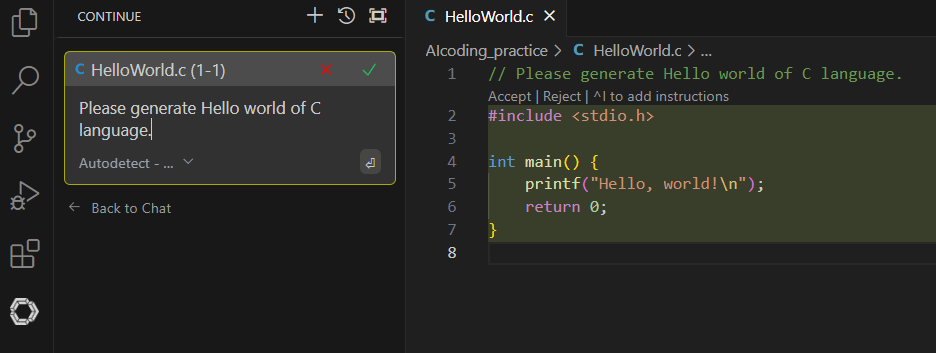

AIでコードを生成したい部分にカーソルがあることを確認してCtrl+Iをし、黄色くハイライトされることを確認する。

また、Modelの部分をAutodetect - qwen2.5-code:7bが選択されていることを確認する。

"Please generate Hello world of C language."を打ち込みSubmitする。

ちなみに後で"C言語のhello worldを生成してほしい。"と日本語でも打ち込んでみたがそちらでも問題なく動作した。

問題なければAcceptをクリックする。

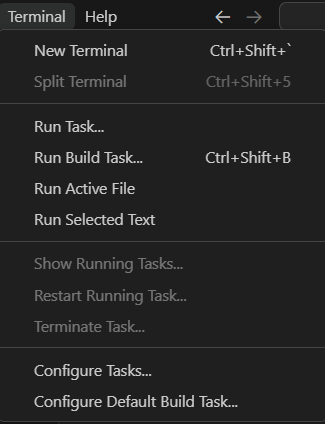

生成したコードを実行

ターミナルを開く。

C言語なのでおなじみのコンパイルをした後、実行する。

> gcc HelloWorld.c -o HelloWorld

> ./HelloWorld

Hello, world!

問題なくHello Worldのコードが生成できることを確認できた。

感想

まだほとんど使っていない状態で感想を書くのもあれですが、簡単なプログラミングであればこのAIコードエディタを使えば普通に生成してくれそうです。

正直いって最初の環境導入さえしてしまえば、恐らく非情報系理系大学のプログラミング講義レベルであればAIコードエディタで瞬殺できてしまうだろう。

某ネット芸人が大学のプログラミングの課題で苦労していることをふと思い出した。

やっぱり最近の大学生はこの手のAIツールを使いこなしプログラミングの課題を一瞬で終わらせているのかがちょっと気になったりした。