この記事はクラスター Advent Calendar 2022の7日目の記事です。

クラスター株式会社のメタバース研究所でリサーチエンジニアをやっているsatomiです。

昨日は@clngnさんのclusterでベストショットを撮る技術2.0でした。

clusterのカメラ機能もアップデートされて、ワールドないでインスタ映えするベストショットを撮る技術はとても有益な情報でしたよね。

さて、この記事ではVR老人会会員である私が30年前のバーチャルリアリティ技術について語ってみたいと思います。

記事の想定読者

- 第2次バーチャルリアリティブームを知りたい人

この記事で説明しないこと

- 最近のバーチャルリアリティの事

私とVRのなれそめ

私が大学院進学を考えていた頃、たまたまバーチャルリアリティ(VR)という新しい技術が話題になっていました。下の写真は、月刊ログイン 1992/4/17号の記事でVPLリサーチと日商エレクトロニクスが業務提携して、日本に本格的にVR装置が導入されようとしている事が大きな話題を伝えています。

私も時を同じくして1992年に東京大学大学院に進学して、運良く廣瀬先生の研究室に所属することが出来ました。ちなみに、当時を思い出してみると、バーチャルリアリティという言葉の訳語が仮想現実感と人工現実感の二種類あると同時に、英語でもVRの他にAR(Artificial Reality)という単語も使われていました。今のARとは全然違う意味で使われていることがちょっと不思議な感じがします。

1992年頃のバーチャルリアリティシステム

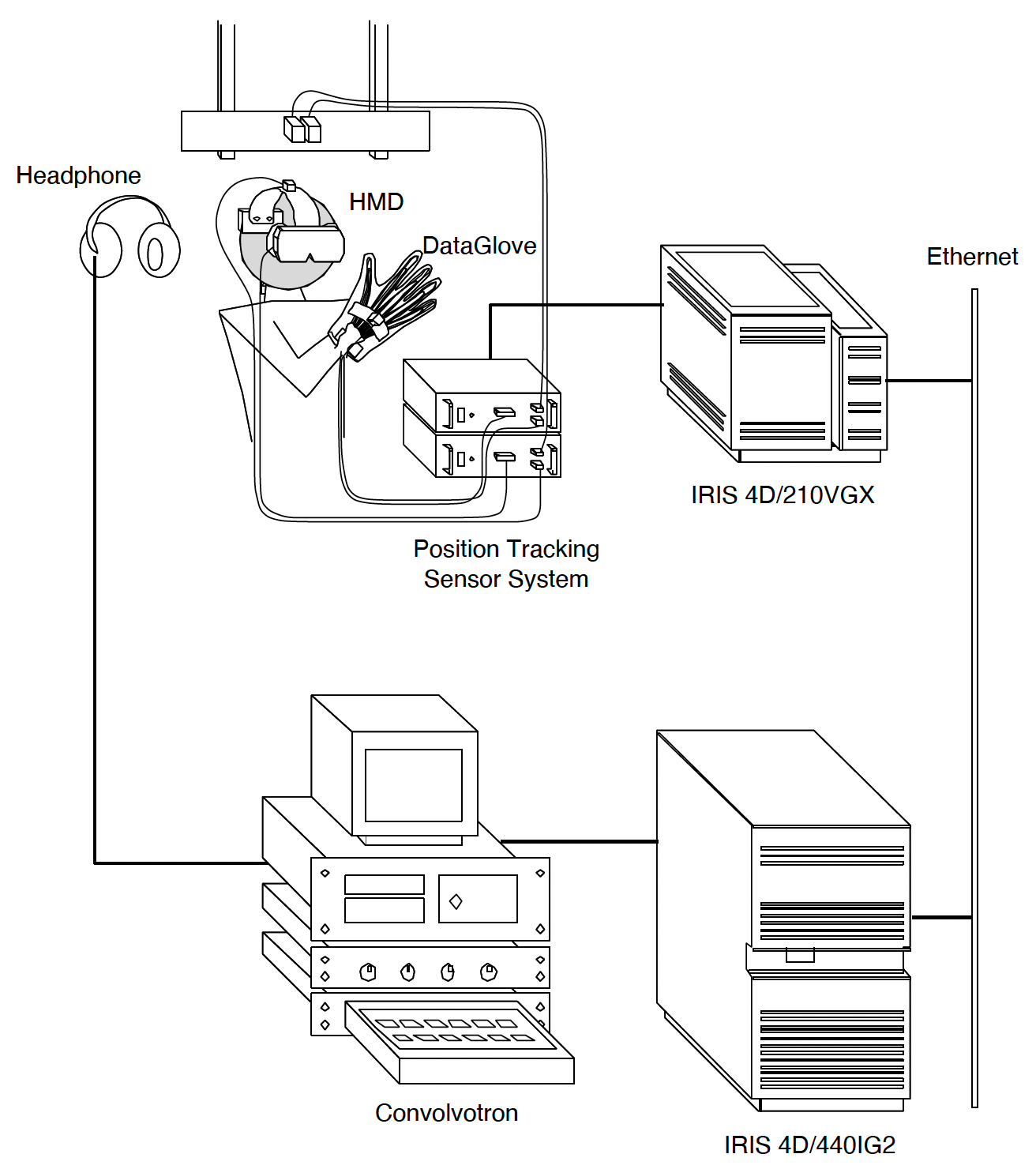

私が研究室に入った頃のバーチャルリアリティのシステム構成が下図のようになります。

システムの構成要素毎に説明すると、

-

HMD (Head Mounted Display)

VRユーザーに画像を提示する装置、現在のMeta Quest 2のディスプレイ部分に相当します。当時はほぼ唯一利用可能だったEyePhoneを利用していました。これについては、後で詳細に触れたいと思います。 -

DataGlove

VRユーザーの手の動きを認識する装置で、手袋に付いている光ファイバーのによって指の曲げ具合を測定します。光ファイバーは湾曲すると光の透過率が変化するので、光の減衰量を測定することで湾曲具合を推定するという原理になっています。因みに、光ファイバーなので手荒に扱うと折れてしまう事が有って、結構慎重に扱う必要が有ったような憶えがあります。

-

Position Tracking Sensor System

磁気を用いた6DoFの位置センサーです。これを頭部や手に付けることによって、VRユーザーの動きを検出します。磁気を使う関係から、実験室のVRユーザーの動く範囲には強磁性体(金属)を置くことが出来ず、木材を利用していたような気がします。

-

IRIS 4D/440IG2

VR空間の映像をリアルタイムに描く為の最先端のSGI製グラフィックスワークステーションです。この頃、初めてテクスチャーマッピング技術が出来るようになったので、VRの世界が一気にリアリティ溢れる世界に変わりました。

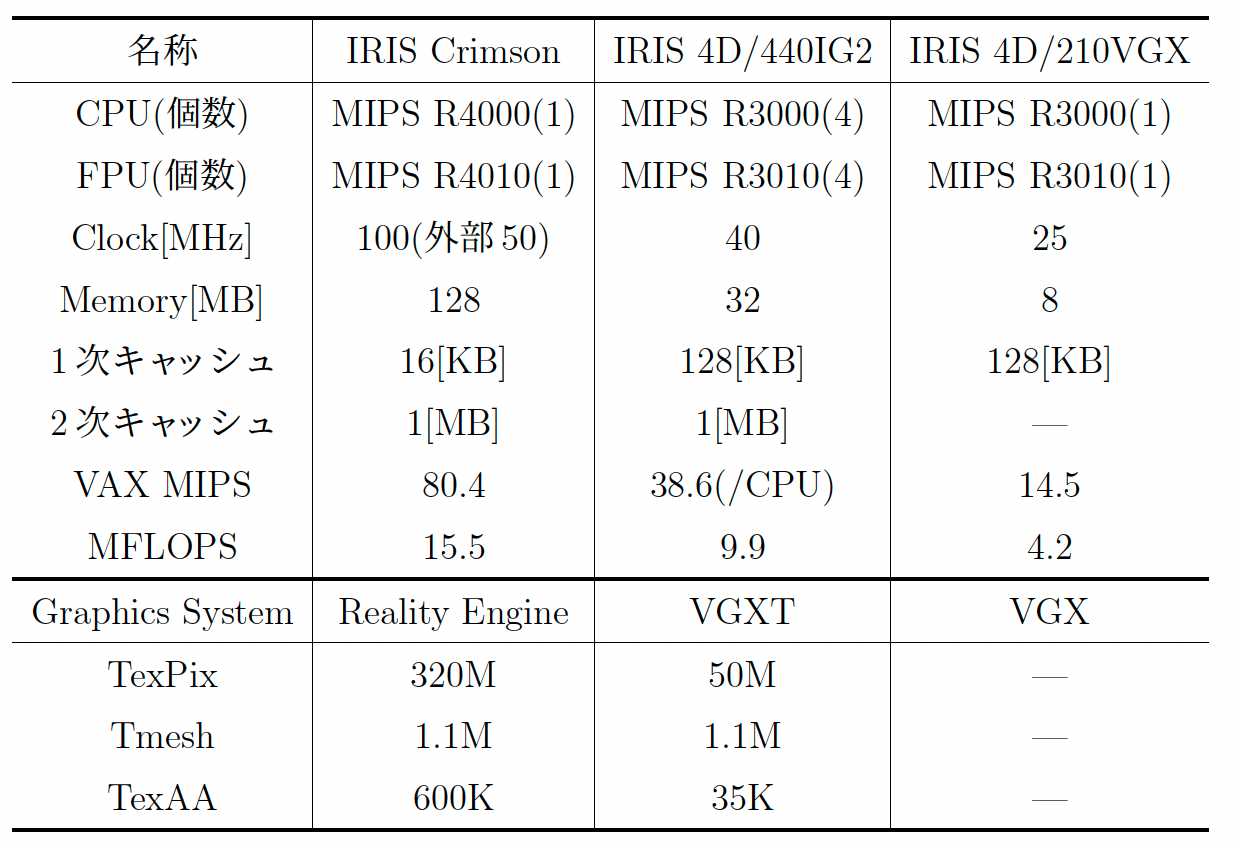

当時利用されていたのは米SGI社のグラフィックスワークステーションで、研究室で利用していたのは下記の様なスペックのワークステーションでした。(因みに、大凡数千万円の価格帯です)

-

Convolvotron

立体音響をリアルタイムで生成出来る高速DSP (Digital Siginal Processor)を搭載した立体音響ディスプレイー装置です。(因みに、本体はIBM PCだったので、DOOMをインストールして遊んでいた事は内緒です)

EyePhoneでみたバーチャルリアリティの世界

30年前に利用可能なHMDは、米VPLリサーチ社のEyePhoneだけでした。研究室でも、当然このEyePhoneをHMDとして利用していました。下の写真は、当時EyePhoneを装着した自分です。修士論文用にポラロイドで撮影した写真をスキャナーでデジタル化した画像データ(EPS: Encapslated PostScript)で、当時Floppy Discに保存して画像ファイルを近年サルベージし、更にPNGに変換したものです...(長い)

EyePhoneの性能については下記の様な仕様になります。多分、現在のVRユーザの驚くべき点はその解像度になります。なぜ、この解像度なのか?という点については、古のパソコンユーザーであればピンとくるかもしれないのですが、これはほぼNTSC信号からも制限が来ています。

当時は、デジタルな画像信号は存在しなくて、全てがアナログな時代でした。つまり、このEyePhoneの両眼の画像については、SGIのグラフィックスワークステーションで描画したイメージを実際のCRTに表示したものを、更にビデオカメラで撮像しそれをNTSCでEyePhoneに送るという事を行っていました(いまだと考えられない方式ですが...)。

その当時のHMDを被って見ていたバーチャルリアリティの世界を皆さんにも体験して頂きたいと思って、clusterの画像でシミュレーションしてみました。

この画像を大まかにEyePhoneの解像度に変換してみたのが次の画像になります。

30年前なので、かなりうろ覚えではありますが、確かに研究室でEyePhoneを被っていた時の画像の印象とそんなに違わないと思っています。

この解像度だと、「当時のVR研究者は何を見ていたんだ!?」という気もしないでもないのですが、それでも当時の記憶では「静止画の世界だったComputer Graphicsの世界に、Diveする事が出来る!」という衝撃的な体験が出来た事がとても記憶に残っています。

おわりに

この記事では30年前のバーチャルリアリティ技術について昔話をしました。

最近の技術を思われがちなバーチャルリアリティも、実は歴史が長いことが分かって頂いた事だと思います。

いまは研究室でしか利用出来ない技術も30年経つと普通の女子高生も触れるようになる(可能性が)あります。ぜひ、ソードアート・オンラインの様な世界も30年経てば実現するのでは無いでしょうか!

明日は@rizumiさんのPC,モバイル,VRに対応したマルチプラットフォームアプリのリリースフローです。clusterの一番の特徴でもあるマルチプラットフォーム対応の裏話を読む事が出来るのが楽しみですね!