原文

DropConnectを用いたニューラルネットワークの正則化(Regularization of Neural Networks using DropConnect)

Li Wan (2013)

1. 要約

- DropConnectは、Dropoutを一般化した手法のことである。

- Dropoutは、設定した割合に応じて、ランダムにユニットを選択し、そのユニットの重みを「ゼロ」にする。

- DropConnectは、上記の「ゼロ」を任意の重みに設定できる。さらに言うと、中間層の線形結合の「結合」に注目し、設定した割合に応じて、ランダムに「結合」を取り上げる。そして、結合に重みをかけて、活性化関数にかける。

2. 骨子の理論

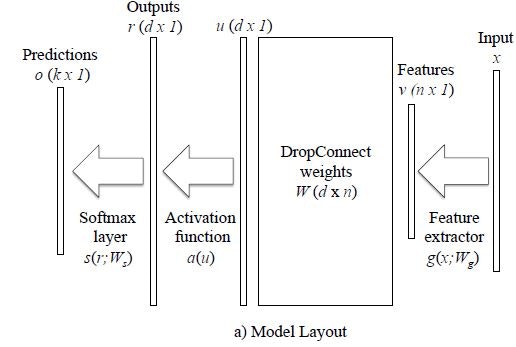

DropConnectのモデルを式に落としこむと次のようになる。;

$$r = a(({\bf M} * {\bf W})v)$$

行列${\bf M}$が、それぞれの結合に対して、指定した重みをかけるか、かけないか決める。

それで処理した線形結合を活性化関数にかけ、アウトプットベクトルrに落としこむ。

下の模式図は、CNNにおいて、特徴抽出した後に、DropConnectを適用したきの場合である。

3. モデル適用例

コード例は、下記リンクよりダウンロード

http:///cs.nyu.edu/~wanli/dropc

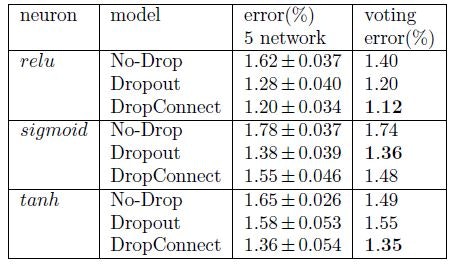

例によって、MNISTによる画像認識精度を対照テクニックとともに比較した。

128枚をセットにした、ミニバッチ学習を施した。

モメンタムを適用し、定数は0.9。

60000枚のトレーニングから、10000枚分テストした。

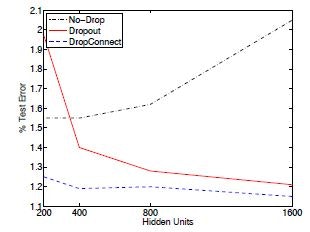

Dropテクニックを使わないと、汎化誤差が目立つ。

だが、テクニックを適用すると、隠れ層のユニットが増えても、過学習になりにくいことが、下図より分かる。