これは、OpenCV Advent Calendar 2015 24日目の記事で筆者の2回目の投稿になります。前回の話は、こちら

関連記事は目次にまとめられています。

はじめに

opencv-contrib 3.1.0のtextモジュールには2種類のアルゴリズムが実装されています。

1つは、文字領域の検出用で、もう一つは、文字の識別用です。

文字識別用OCRTesseractクラスは、有名なOCRソフト、tesseract-ocrのインタフェースのクラスであり、**tesseract-ocrが事前にインストールされていないと使用することはできません。**OCRTesseractの使用方法は簡単で、検出対象の言語を指定しOCRTesseract::createを行い、OCRTesseract::runに文字対象領域のmatを与えると、stringと領域とスコアを得ることができます。

もう一方の今回対象としている文字領域の検出用 ERFilterは、このOCRTesseract用の前処理に当たるもので、Webカメラやimageファイル内のtext領域を検出するためのクラスです。こちらは、Contirbをビルドすれば使用することができます。

cv::text::ERFilterに関する説明はここに記載されています。ERFilterの使用方法の説明に使用した、文字検出のサンプルプログラムは、これです。

Visual Studio 2015で新規プロジェクトを作成し、3.1用のpropatyを設定し、上記プログラムの中身をそのままコピーします。

text検出処理の流れ

文字領域の検出の前処理とし、検出対処の画像を computeNMChannels を使用し、複数の画像を作成します。

computeNMChannels(src, channels);

channelsには、オリジナルのアルゴリズムと異なり、ERFilterではred (R), green (G), blue (B), lightness (L), and gradient magnitude (Grad)の5つの画像が格納されます。

加えて、5つの画像の各画像の値を255から引くことで、各画像の反転画像を作成します

channels.push_back(255-channels[c]);

これにより10画面分の画像が作成されそれれぞれ検出対象として扱われます。

ここでNeumann and Matasの文字領域検出アルゴリズムのベースとなるERFilterの出番となり、第1ステージ、第2ステージのデフォルトの分類器を有する、ERFilterのオブジェクトを作成しています。第1ステージのパラメータは最後に説明します。

Ptr<ERFilter> er_filter1 = createERFilterNM1(loadClassifierNM1("trained_classifierNM1.xml"),16,0.00015f,0.13f,0.2f,true,0.1f);

Ptr<ERFilter> er_filter2 = createERFilterNM2(loadClassifierNM2("trained_classifierNM2.xml"),0.5);

上記カスケード分類器で各チャンネルを対象とし検出処理を実行します

er_filter1->run(channels[c], regions[c]);

er_filter2->run(channels[c], regions[c]);

検出された領域をerGroupingでまとめます。これにより文字候補の領域がgroups_boxesに格納されています。

erGrouping(src, channels, regions, region_groups, groups_boxes, ERGROUPING_ORIENTATION_HORIZ);

erGroupingmのパラメータは、ERGROUPING_ORIENTATION_HORIZは、水平に並んだ文字に適したアルゴリズムであり、ほかに任意の方向の文字に適したアルゴリズムERGROUPING_ORIENTATION_ANYがあります。

最後に検出した領域の個数分loop内でrectangleを描画します。

rectangle(src,groups.at(i).tl(),groups.at(i).br(),Scalar( 0, 255, 255 ), 3, 8 );

以上で説明は終わりです。

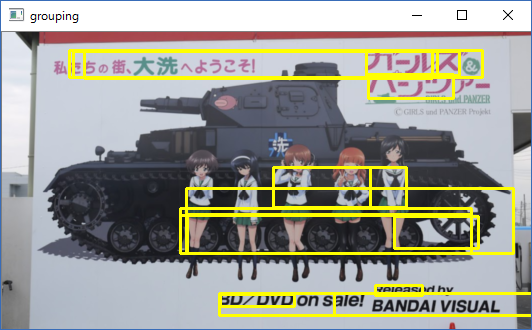

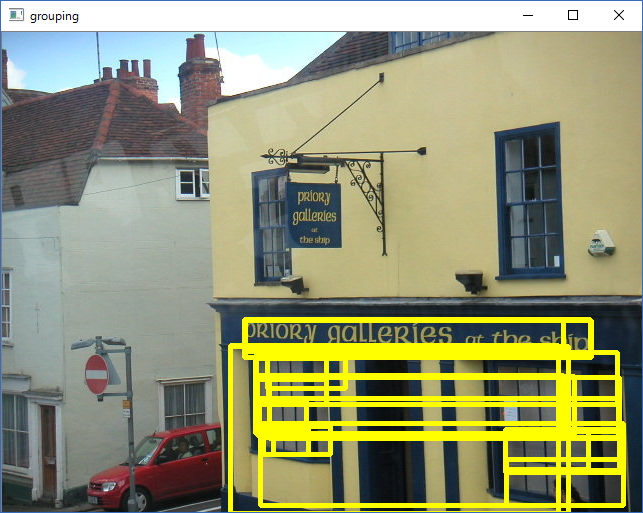

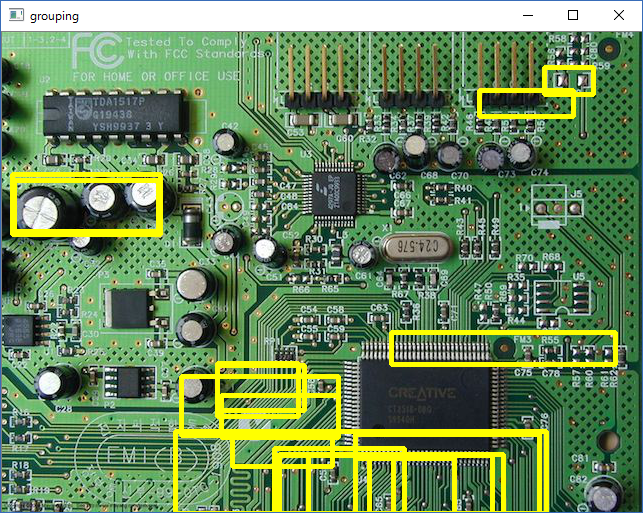

実行結果のサンプル画像

いくつかの画像で試した結果を掲載します。

1 textのサンプルに含まれていた画像 (看板の文字はだめでした)

2 OpenCVのサンプルで使用されている基盤画像 (左上の文字がまったく検出できていない)

3 映画でこわされたホテル壁 (壁のタイルの誤認識が多すぎる)

以上は、サンプルプログラムで設定されたパラメータをそのまま使用したものです。それに対し、冒頭の画像は、4の画像に対して、createERFilterNM1検出器のパラメータ 16,0.00015f,0.13f を 修正したものです。

16の値は、thresholdDelta(Threshold step in subsequent thresholds when extracting the component tree)で小さくすると検出される領域が増えます。

0.00015fは、minArea(The minimum area (% of image size) allowed for retreived ER’s)で

0.13fは、maxArea (The maximum area (% of image size) allowed for retreived ER’s)であり、元の画像に対する検出領域の最小、最大値を指定します。

結果

期待していたほど文字領域の検出能力はよくないなという感想です。

やはり縦エッジが密集している領域を選択する傾向があるのかと推測しています。

テスト環境

Windows10 Pro 64bit

OpenCV 3.1.0 + Contrib 3.1.0

Visual Studio 2015

明日はいよいよ今年最後の記事になります。