はじめに

この記事では、VSCodeの拡張機能「Continue」を用いて、ローカルで動作する大規模言語モデルOllamaを試してみます。開発者や技術者が自分のPC上で直接LLMを操作する方法に焦点を当てています。

Continueとは

「Continue」はコーディング支援を提供するオープンソースのVSCode拡張機能です。このツールを使って、VSCode内から直接Ollamaのようなモデルにアクセスし、コードの自動生成や修正を行うことができます。

Ollamaとは

Ollamaは、LLama3やLLava、vicunaやPhiなどのオープンに公開されているモデルを手元のPCやサーバーで動かすことの出来るツールです。

前提条件

- Visual Studio Codeのインストールされていること

- OSはWindowsであること

- OllamaはWindows版のインストーラを使用した

導入手順

Ollamaのインストール

-

OllmanのWindows用のインストーラをダウンロードします。

-

"Download for Windows (Preview)"と表示されている場所をクリックします。

-

ダウンロードしたEXEファイルを実行します。

-

インストールが開始されます。

Ollamaの設定

- コマンドをcmdで実行して、Ollamaに使用したいモデルファイルをローカルシステムにダウンロードします。モデルをダウンロードするまで時間がかかります。

例:ollama pull mistral

Continueのインストール

VSCodeの拡張機能タブから「Continue」を検索し、インストールします。

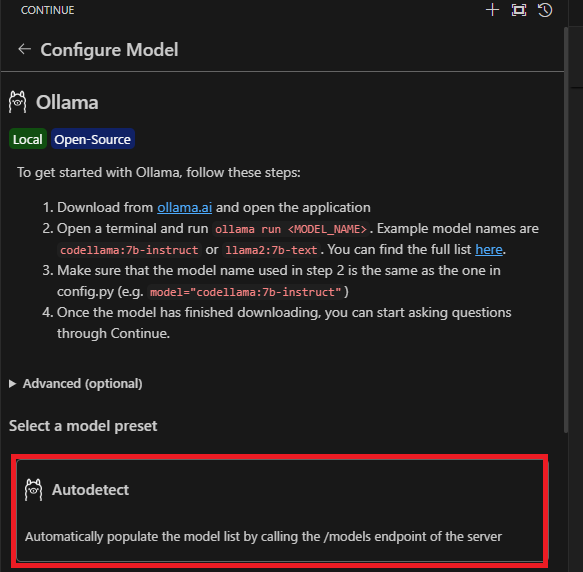

ContinueにOllamaを追加する

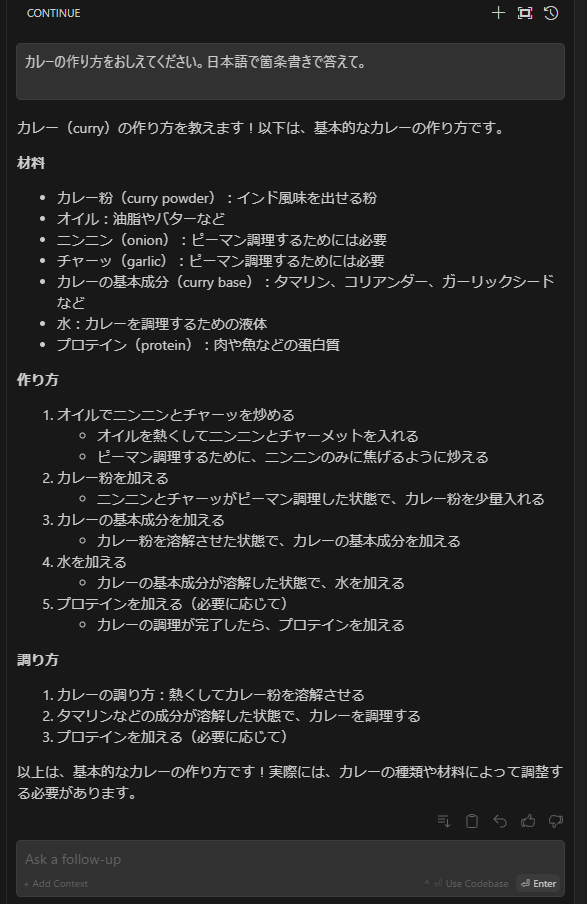

VsCodeのContinueアイコンをクリックして画面をひらきます。

Autodetectを選択します。細かい設定をしたい場合は、Advanceの設定など変更する必要がありそうです。

モデルの選択画面からollamaで使えるモデルが選択できるようになる。例えば、llama3を選択する。

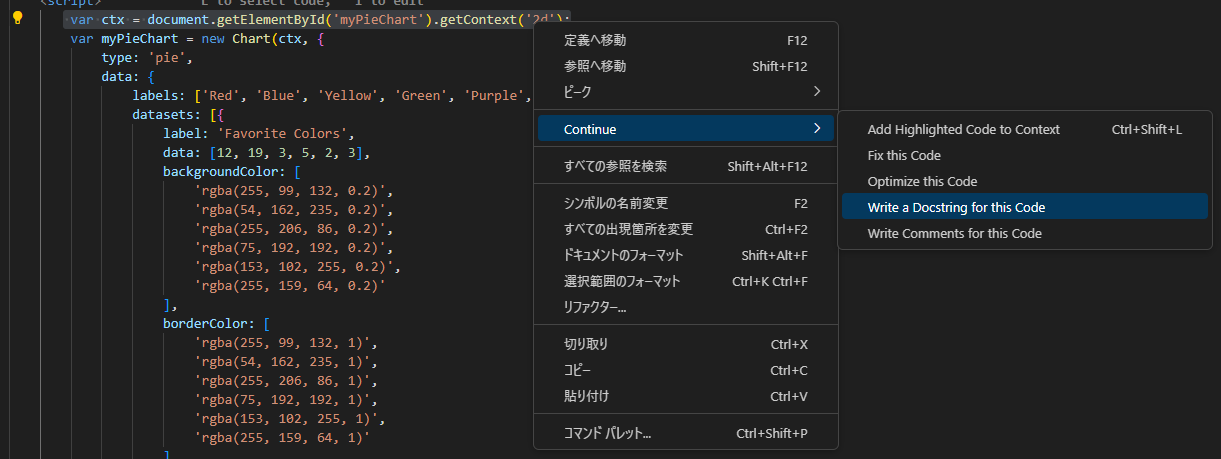

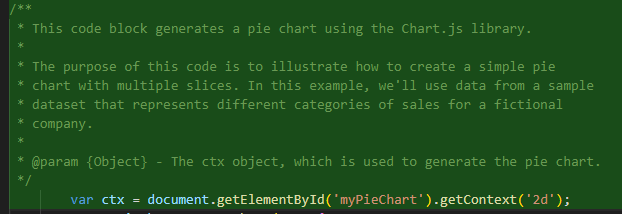

使用例とデモ

まとめ

ローカルでLLMを使用する利点と、Continue拡張機能を通じてVSCodeでOllamaを効率的に活用する方法について試してみました。

感想

- 外部のGPUつきでOllamaで高精度なモデルをうごかして、接続して連携して動かすほうが、現段階では使えるかな。

- 使用するモデルによっては日本語はやめて、英語でやりとりするなど工夫が必要かも・・。