元記事:https://www.scrapestorm.com/jp/tutorial/top-10-web-scraping-tools-for-data-extraction-in-2019/

Webスクレイピングツールは、Webサイトで必要な情報を取得するように開発されています。このようなツールを使用して、データ抽出の時間を大幅に節約できます。

本文はより強い機能を持つ、効率的にデータ抽出できのスクレイピングツールを紹介します。

1.ScrapeStorm

ScrapeStormは、人工知能を基づき、プログラミングしなくても、ほとんどすべてのWebサイトからデータを抽出できると言うWebスクレイピングツールです。

強い機能を持って、使いやすいです。URLを入力だけで、自動的に抽出するデータと次のページボタンを識別できます。複雑なルール設定が必要ないし、ただクリックしてスクレイピンができます。

ScrapeStormは、Windows、Mac、およびLinuxに適応するソフトウェアです。Excel、HTML、Txt、CSVなどのさまざまなファイル形式で結果をダウンロードできます。 さらに、データベースやウェブサイトにデータをエクスポートできます。

特徴:

1)インテリジェントな識別

2)IPローテーションと確認コードの識別

3)データ処理と重複排除

4)ファイルのダウンロード

5)定時的にタスクを起動する

6)自動エクスポート

7)RESTful APIおよびWebhook

8)EコマースのSKUと大きな画像を自動識別できる

長所:

1)使いやすい

2)合理的な価格

3)可視的な操作

4)全てのシステムに適応

短所:

クラウドサービスなし

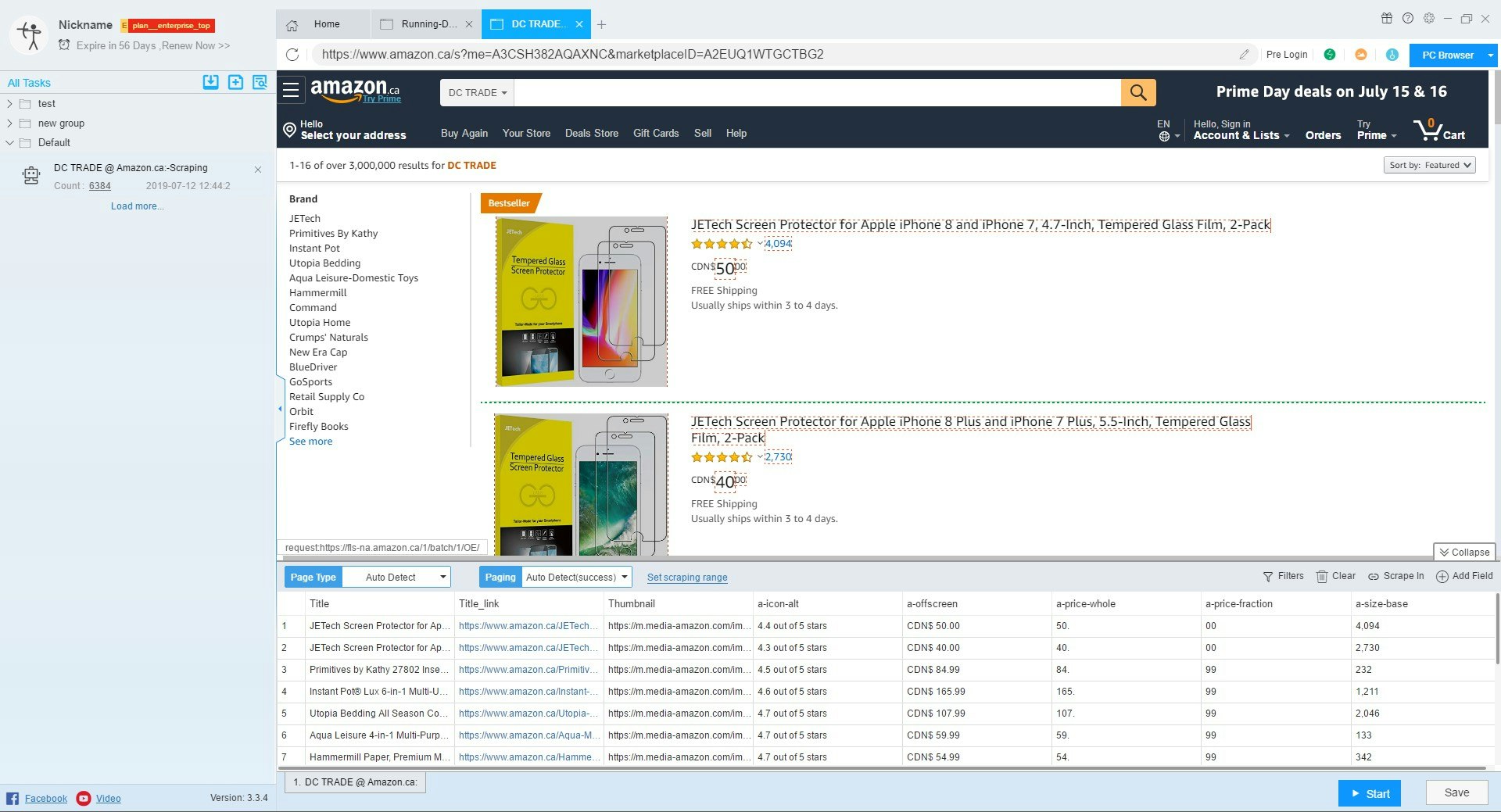

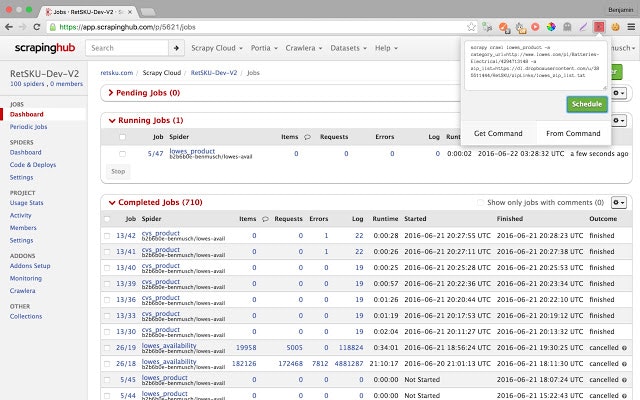

2.ScrapingHub

Scrapinghubとは、インターネットから構造化された情報を抽出するため、いくつかの便利なサービスを提供する、開発者向けのWebスクレイピングプラットフォームです。

特徴:

1)Webページ全体を整理されたコンテンツに変換できる

2)JSオンページの切り替えができる

3)確認コードの処理

長所:

1)50か国以上のIPアドレスがあり、ほとんどのIP禁止問題を解決できる。

2)非常に便利な時間チャートを提供する

3)ログインフォームが処理できる

4)無料プランは、抽出されたデータを7日間クラウドに保存できる

短所:

1)払い戻しなし

2)数多くのアドオンを追加する必要があり、使いにくいです

3)多量のデータを処理できない

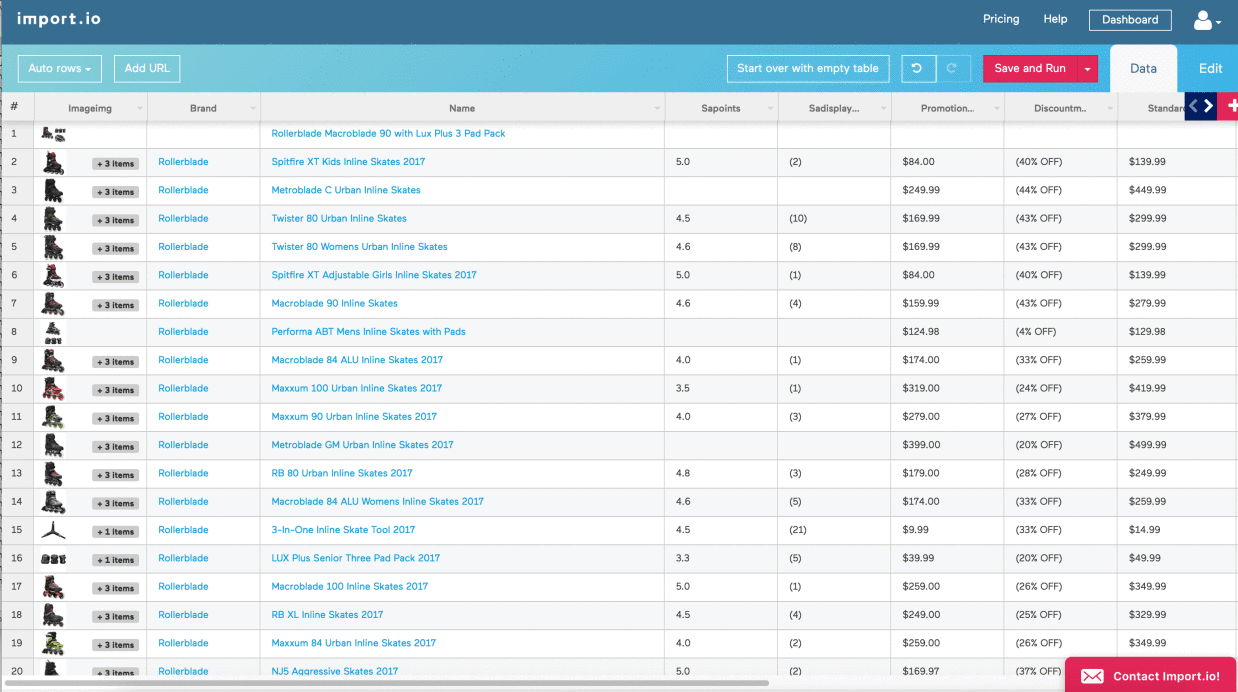

3.Import.io

Import.ioは、Webページ内の半構造化情報を構造化データに変換するプラットフォームであり、Appや他のプラットフォームとの統合など、及びビジネス業務決定の促すに使用できます。

JSON RESTベースおよびストリーミングAPIによるリアルタイムのデータ取得、および多くの通用するプログラミング言語とデータ分析ツールとの統合を提供します。

特徴:

1)クリックだけでトレーニングができる

2)Webインタラクティブとワークフローを自動化する

3)データをスゲジュールしやすいです

長所:

1)ほとんどすべてのシステムに適応する

2)素敵できれいなインターフェースとシンプルなダッシュボード

3)コーディング不要

短所:

1)値段が高い

2)各サブページにはクレジットがかかる

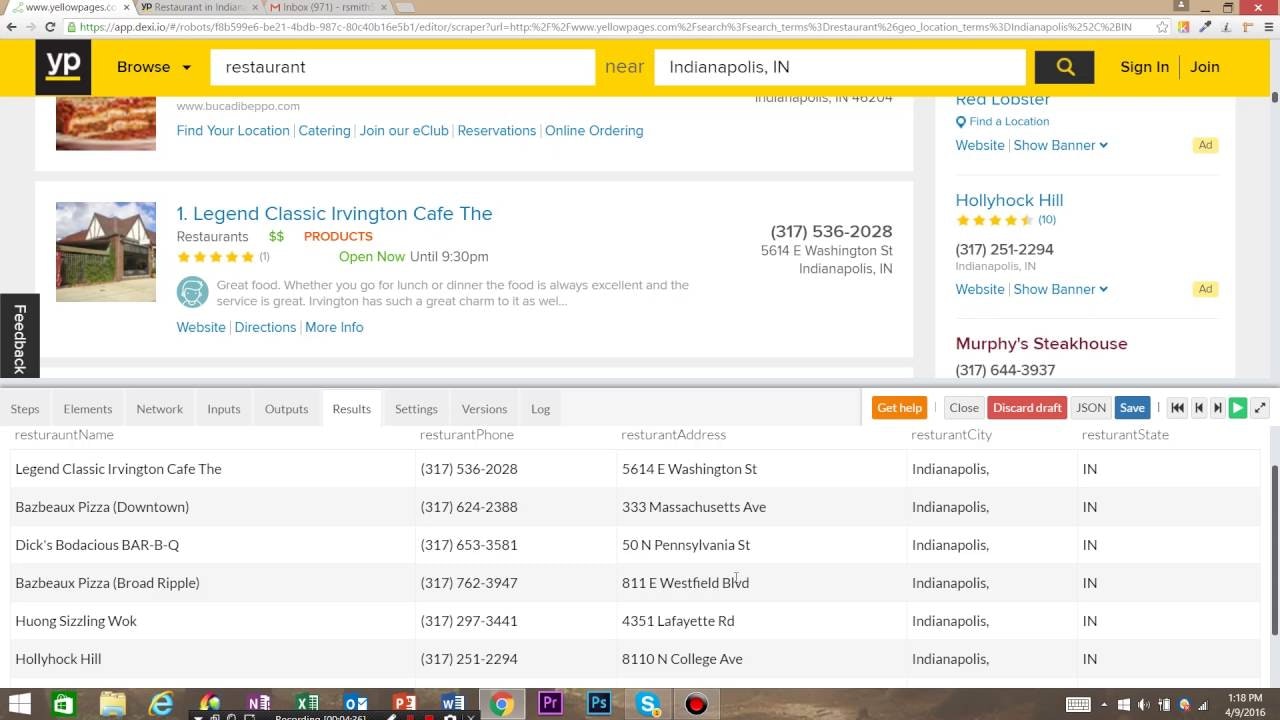

4.Dexi.io

ベテランの専門家向けの自動化Webスクレイピングツールである。Dexi.ioは、最先端の自動化インテリジェントデータマイニング技術により、あらゆるWebソースからデータの抽出と変換を実現しように、最も先進的なWebスクレイピングツールです。

Dexi.ioを使用すると、任意のWebサイトのデータ手動スクレイピングまたはインタラクティブできます。 高級機能とAPIは、データを強力なデータセットまたはソリューションに変換および結合するのに役立ちます。

特徴:

1)すぐに使用できるいくつかの統合を提供する

2)データを自分のシステムに送信する前に自動的に重複排除する

3)ロボットが故障したときにツールを提供する

長所:

1)コーディング不要

2)利用可能なエージェント作成サービスを提供する

短所:

1)開発者以外は使いにくい

2)ロボットのデバッグの問題

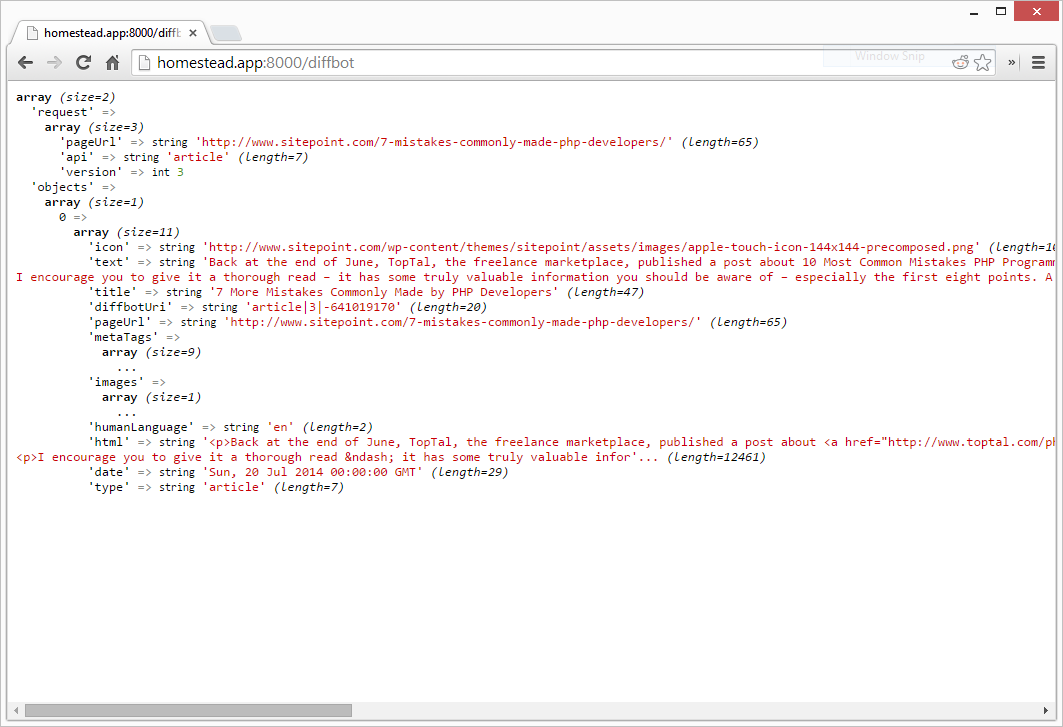

5.Diffbot

Diffbotを使用すると、さまざまなタイプのデータWebから取得できます。高価なWebスクレイピングや手動調査の費用を支払う必要はありません。AIエクストラクターを使用して、任意のURLから構造化データを取得できます。

特徴:

1)強力で正確な言語を通じで、検索する

2)複数のデータソースを提供する

3)AI エクストラクターを使用して、任意のURLから構造化データを抽出できる。

4)包括的な知識グラフ

長所:

1)実体間の関係を発見できる

2)バッチを処理できる

3)必要な答えを照会して取得できる

短所:

1)初期出力は複雑です

2)使用する前に多くのクリーニングが必要

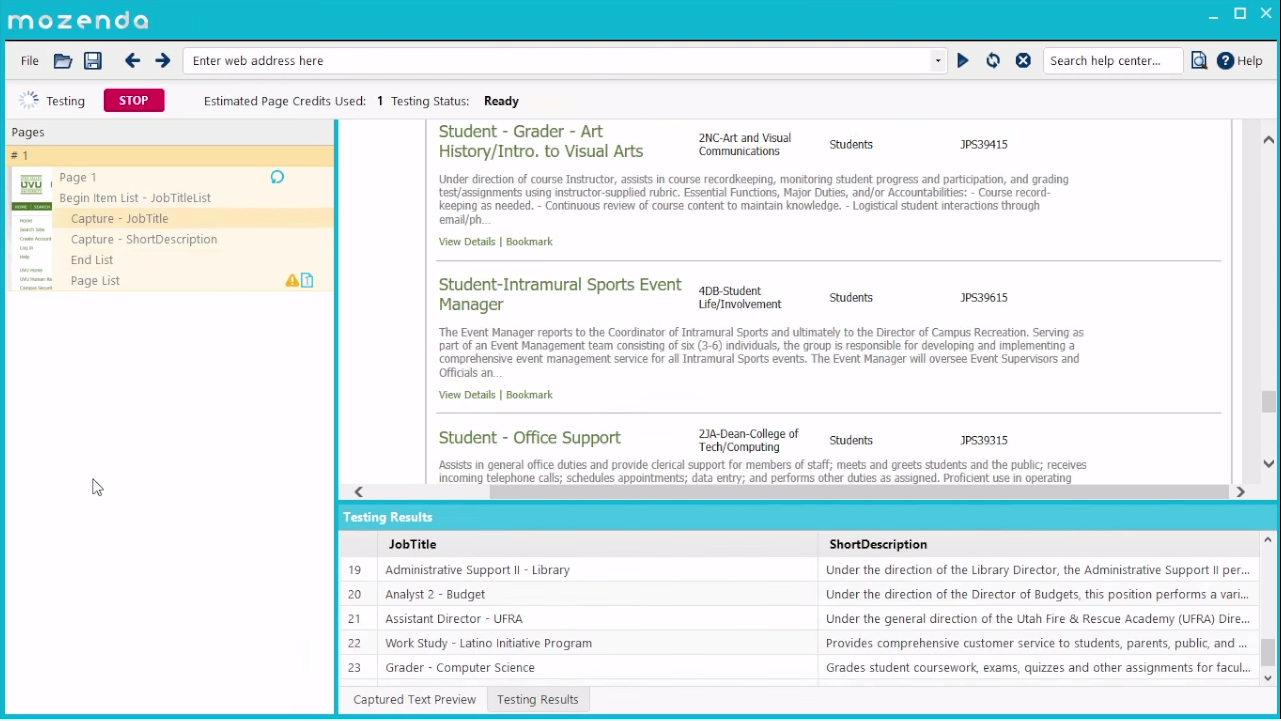

6.Mozenda

Mozendaは、ソフトウェア(SaaSおよびオンプレミスオプション)またはマネージドサービスの’形式で技術を提供します。これにより、人々は非構造化Webデータをキャプチャし、構造化形式に変換でき、企業が使いようになります。

Mozendaは以下のサービスを提供します:1)クラウドホストソフトウェア2)オンプレミスソフトウェア3)データサービス15年以上の経験を持つMozendaは、あらゆるWebサイトからのWebデータ抽出を自動化することを可能にします。

特徴:

1)地理的に異なる場所からWebサイトをスクレイピングする。

2)APIアクセス

3)ポイントアンドクリックインターフェース

4)エージェントが正常に実行されたときに電子メールアラートを受信する

長所:

1)ビジュアルインターフェイス

2)包括的なアクションバー

3)マルチスレッド抽出およびスマートデータ集約

短所:

1)大規模なWebサイトを扱う場合は不安定になる。

2)値段が少し高い

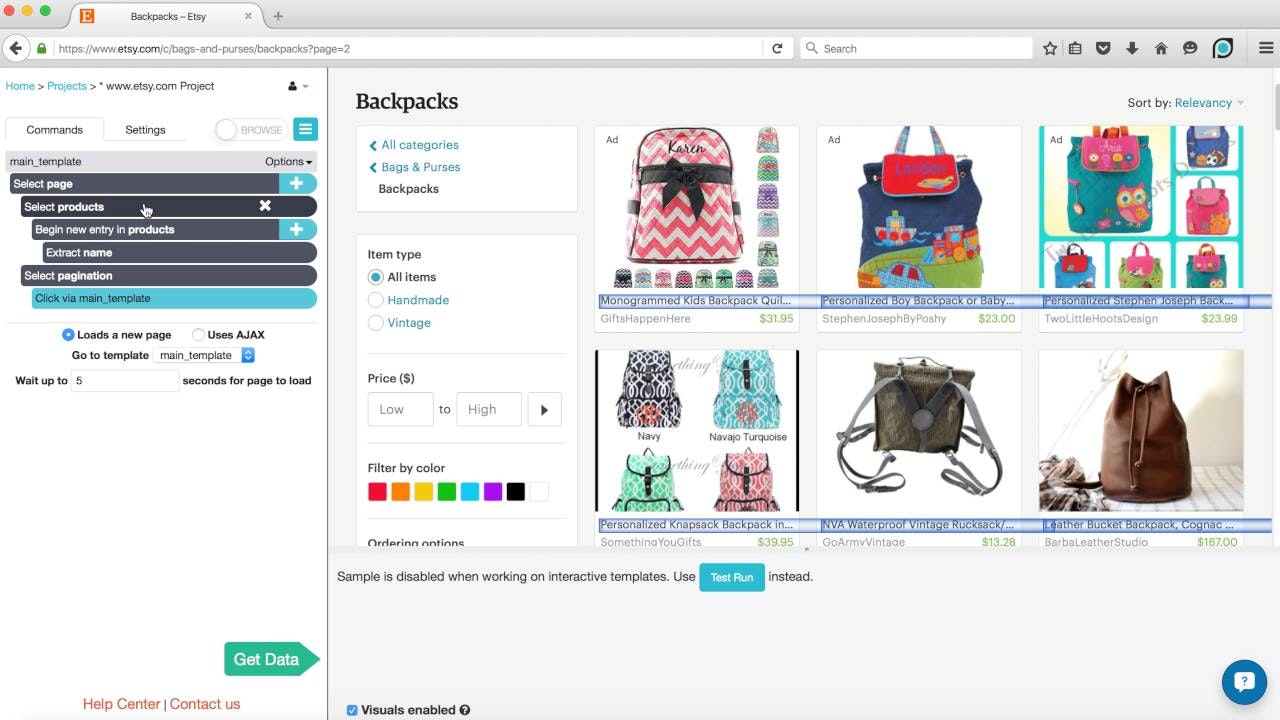

7.ParseHub

ParseHubは、誰でもWebからデータを取得する、視覚的なデータ抽出ツールです。

Webスクレイパーを再度編成する必要はありません。APIを持たないWebサイトからAPIを簡単に作成できます。ParseHubは、インタラクティブなマップ、カレンダー、検索、フォーラム、ネストされたコメント、無限スクロール、認証、ドロップダウン、フォーム、Javascript、Ajaxなどを簡単に処理できます。ParseHubは、全員向けの無料プランと、大規模なデータ抽出ニーズがあり企業向けのエンタープライズプランを提供します。

特徴:

1)スケジュールされた実行

2)自動IPローテーション

3)インタラクティブWebサイト(AJAXおよびJavaScript)

4)Dropboxの統合

5)APIとWebフック

長所:

1)ビジュアルインターフェイス

2)包括的なアクションバー

3)マルチスレッド抽出およびスマートデータ集約

短所:

1)無料プログラム限定

2)複雑なユーザーインターフェイス

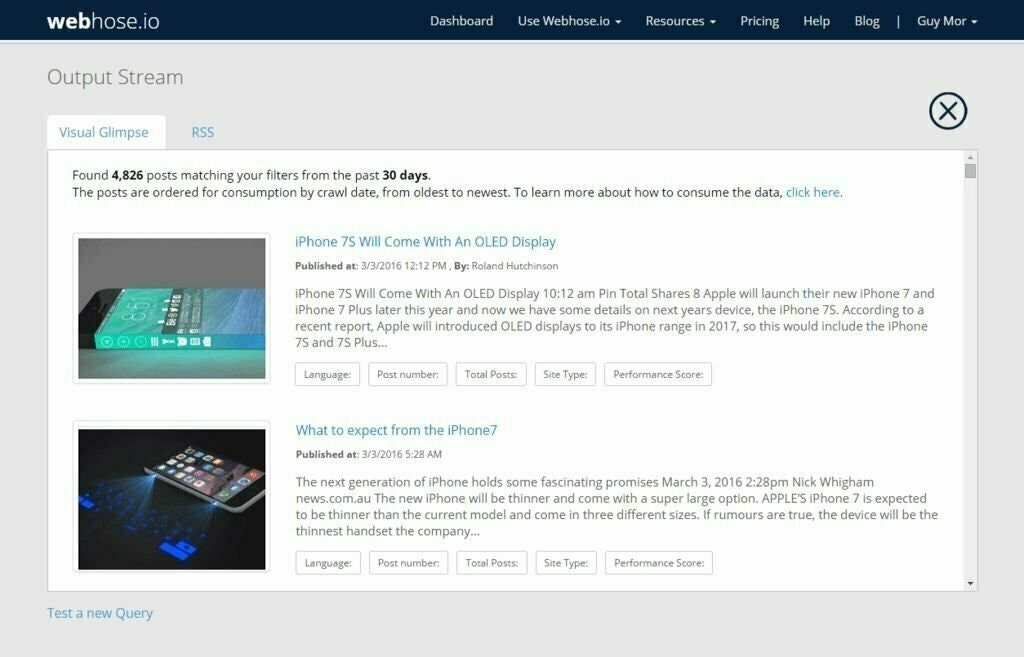

8.Webhose.io

Webhose.io APIは、メッセージボード、ブログ、レビュー、ニュースなどの数十万のグローバルなオンラインソースから、統合が容易な高品質のデータとメタデータを提供します。

Webhose.io APIは、クエリベースのAPIまたはfirehoseを介して利用でき、高カバレッジデータで低遅延を提供し、記録時に新しいソースを追加する効率的な動的機能を備えています。

特徴:

1)JSONおよびXML形式の構造化されたデータセットを取得できる。

2)追加料金を支払うことなく、データフィードの膨大なリポジトリにアクセスできる

3)詳細な分析を実行できる

長所:

1)クエリシステムは使いやすい

2)データプロバイダー全体で一貫している。

短所:

1)素早くマスターできない

2)企業向けではない

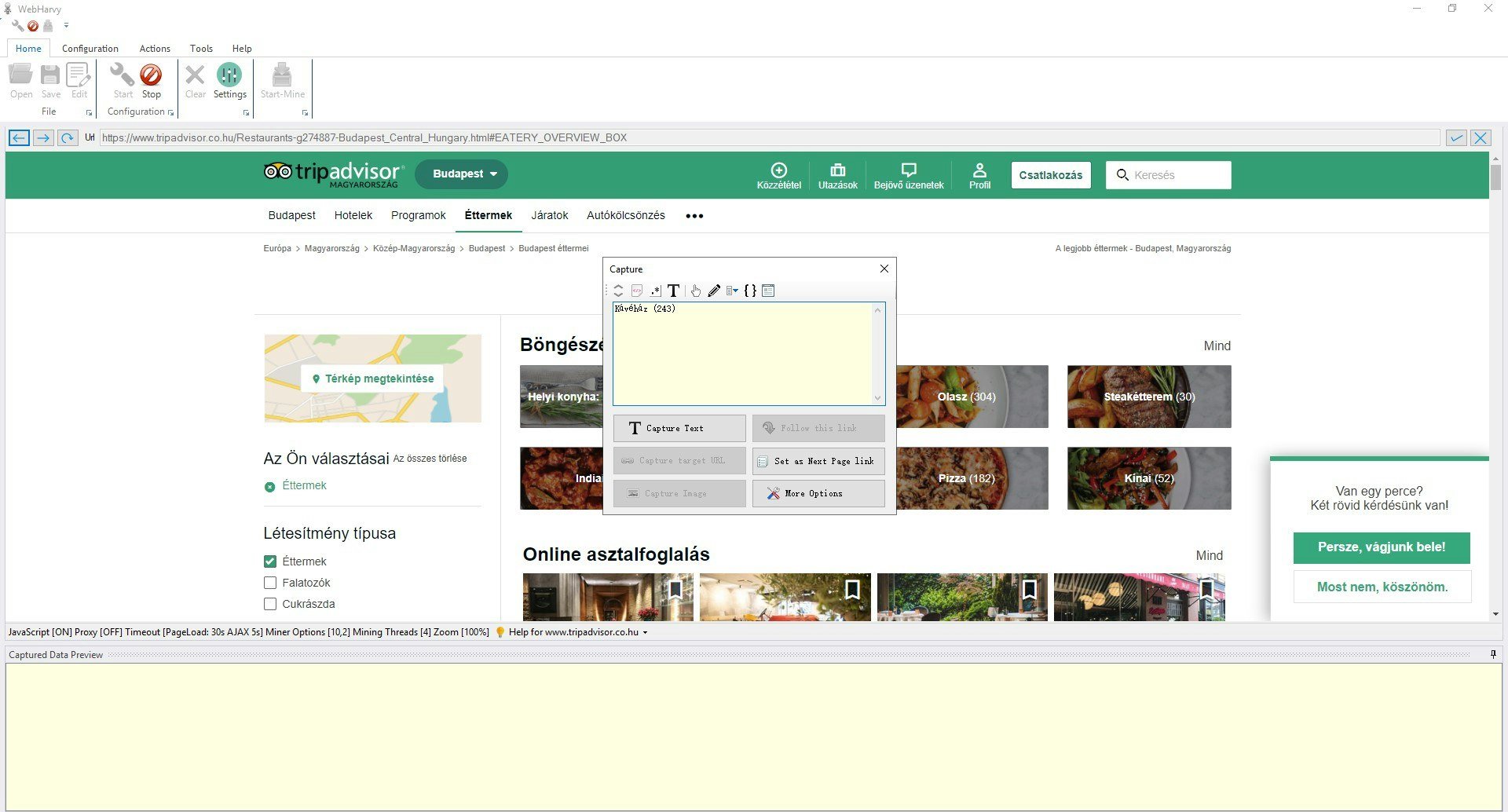

9.WebHarvy

WebHarvyには、Webサイトからデータを簡単に抽出でき、ローカルに保存します。プログラミングとスクリプトが必要なし、全てのWebサイトでデータ抽出できます。WebHarvyで製品リスト/ eコマースWebサイト、イエローページ、不動産リスト、ソーシャルネットワーク、フォーラムなどからデータを抽出できます。クリックだけで必要なデータを選択でき、非常に使いやすいになります。リストの複数のページからデータを抽出します。

特徴:

1)ポイントアンドクリックインターフェース

2)プライバシーを保護する

長所:

1)ビジュアルインターフェイス

2)プログラミングとスクリプトが必要なし

短所:

1)データ抽出のスビートが遅い

2)数日間のスクレイピング後にデータが失われる可能性がある

3)時々スクレイピング停止する

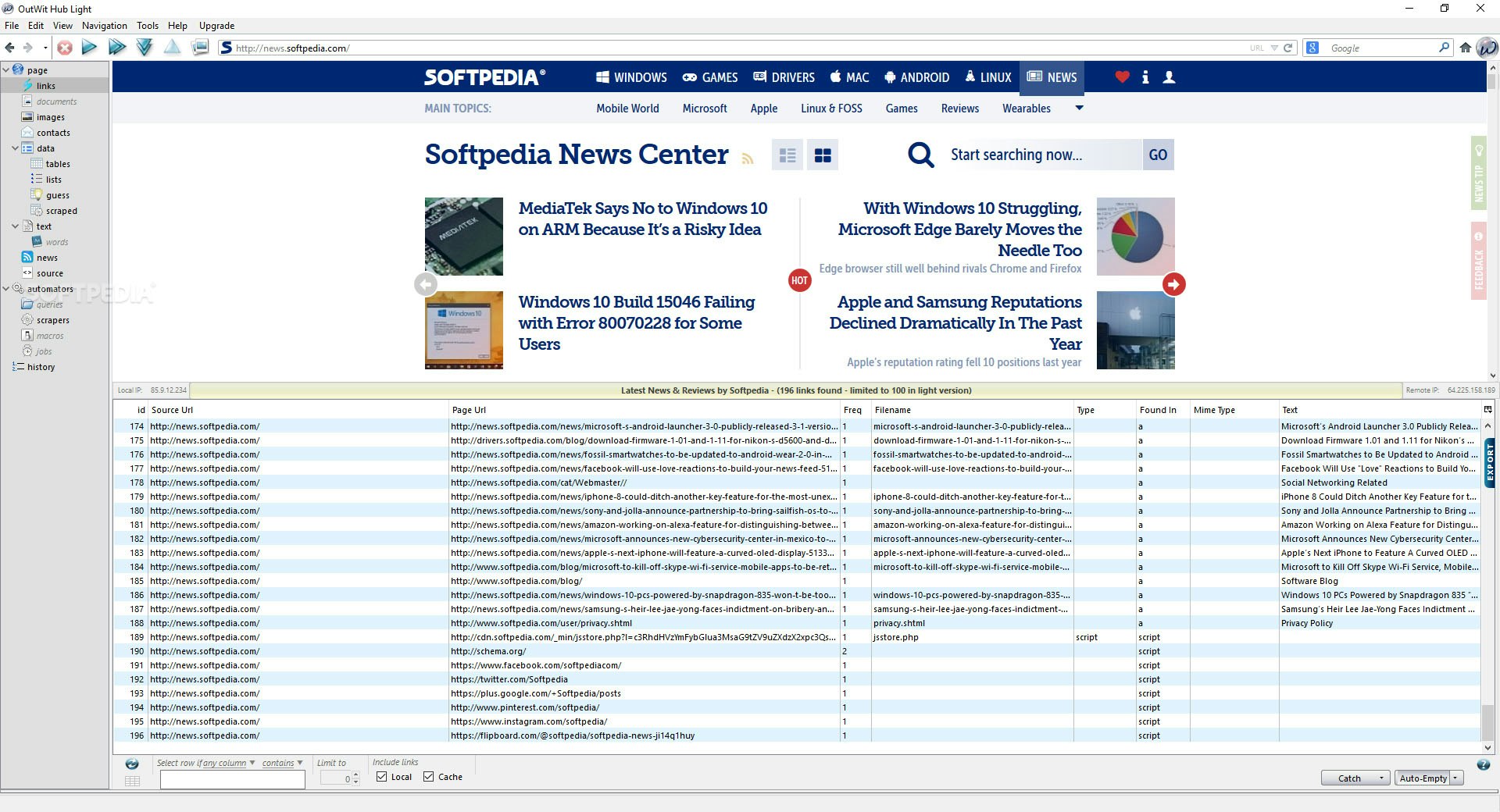

10. Outwit

OutWit Hubは、オンラインリソースまたはローカルリソースから情報を自動的に抽出するように設計されたWebデータ抽出ソフトウェアです。リンク、画像、ドキュメント、連絡先、定期的な語彙とフレーズ、rssフィードを認識して取得し、構造化および非構造化データをスプレッドシートまたはデータベースにエクスポートできるフォーマットされたテーブルに変換します。

特徴:

1)リンク、電子メールアドレス、構造化および非構造化データ、RSSニュースの識別と抽出

2)画像とドキュメントの抽出とダウンロード

3)カスタマイズのWeb探すルールで自動ブラウジング

4)マクロ自動化

5)スゲジュール

長所:

1)プログラミングが必要なし

2)簡潔なユーザーインターフェース

短所:

1)ポイントアンドクリックインターフェースなし

2)チュートリアルを改善する必要がある